Palavras-chave:Google DeepMind, Genie 3, Modelo de Mundo, Ambiente de Treinamento de IA, Desenvolvimento de Jogos, AGI Corporificada, Sistema de Multiagentes, Geração em Tempo Real de Ambientes 3D Interativos, Resolução 720p a 24fps, Colaboração de Dupla de Agentes Solucionador+Verificador, Resolução de Problemas de IA em Competições IMO, Sistema de Multiagentes IMO de Código Aberto

🔥 Foco

Google DeepMind lança Genie 3, um modelo de mundo: Google DeepMind lançou o Genie 3, um modelo de mundo inovador, capaz de gerar ambientes 3D interativos em tempo real a partir de prompts de texto, suportando resolução de 720p e taxa de quadros de 24fps. O modelo possui memória visual e capacidade de controle de movimento por vários minutos, sendo considerado o futuro motor de jogos 2.0, com potencial para revolucionar os ambientes de treinamento de AI e o desenvolvimento de jogos, fornecendo a parte crucial que falta para a AGI incorporada. (Fonte: Google DeepMind)

Ant Group multiagente replica resultados de medalha de ouro da IMO e disponibiliza como código aberto: A equipe do projeto AWorld do Ant Group replicou os resultados da DeepMind na competição de matemática IMO 2025, resolvendo 5 de 6 questões em apenas 6 horas, e disponibilizou o sistema multiagente IMO como código aberto. O sistema, através da colaboração de dois agentes “solucionador + verificador”, demonstrou o potencial de superar o limite de inteligência de um único modelo e está sendo usado para treinar a próxima geração de modelos, com a expectativa de impulsionar o desenvolvimento da Inteligência Artificial Geral (AGI). (Fonte: 量子位)

AI descobre novas leis físicas: Pesquisadores da Emory University treinaram uma AI para descobrir novas leis físicas a partir de dados experimentais de plasma de poeira, revelando forças anteriormente desconhecidas. Esta pesquisa demonstra que a AI não só pode prever resultados ou limpar dados, mas também ser usada para descobrir leis físicas fundamentais, e corrigiu uma suposição de longa data na física de plasma, abrindo novos caminhos para o estudo de sistemas complexos de múltiplas partículas. (Fonte: interestingengineering)

🎯 Tendências

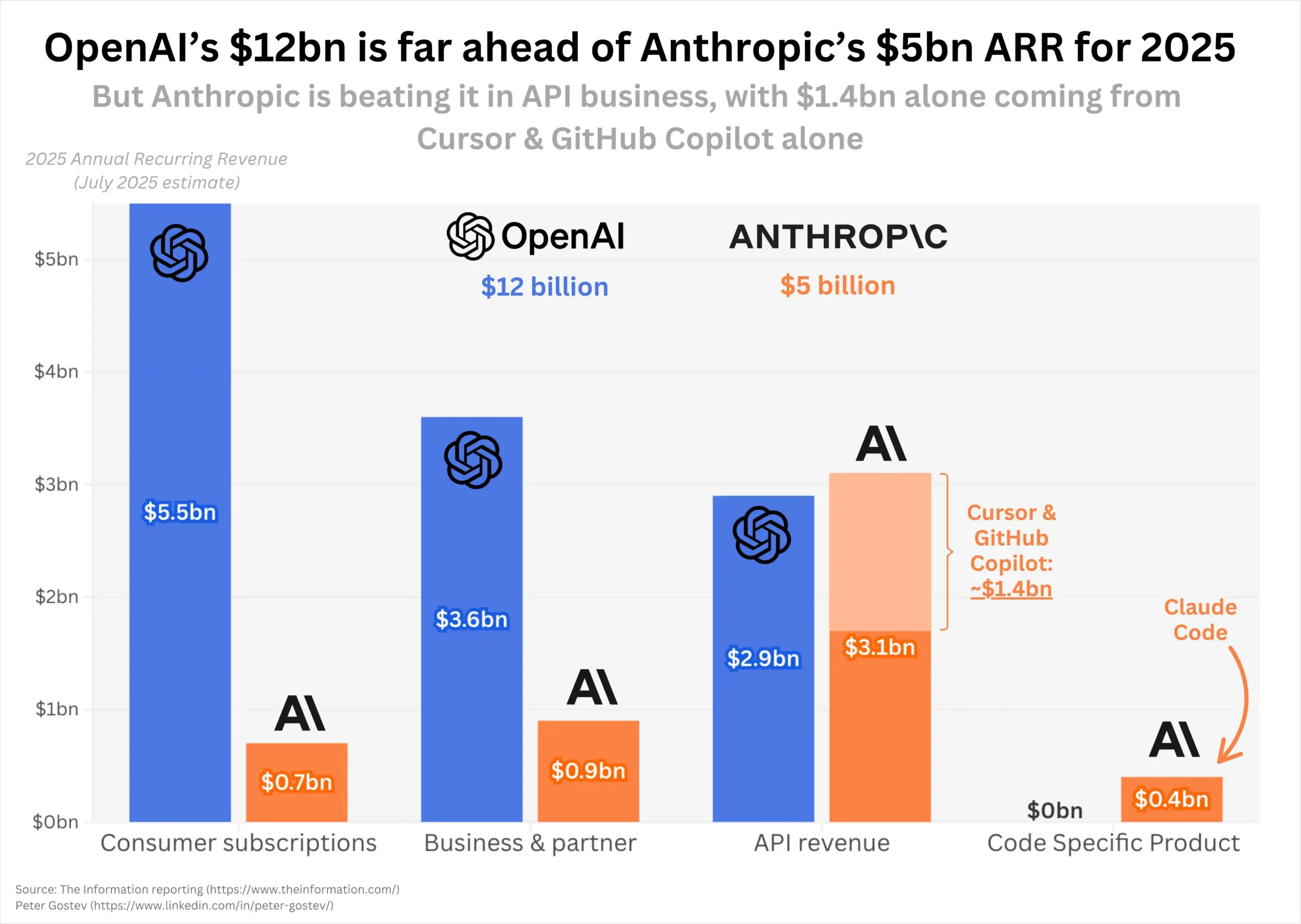

OpenAI e Anthropic com rápido crescimento de receita, cenário de mercado em foco: Em 2025, OpenAI e Anthropic demonstraram um impulso de crescimento de receita surpreendente, com a receita anual recorrente da OpenAI dobrando para US$ 12 bilhões e a da Anthropic crescendo 5 vezes para US$ 5 bilhões. A Anthropic teve um forte desempenho no mercado de API de programação, enquanto o número de usuários do ChatGPT também continuou a crescer rapidamente. O mercado está atento se o lançamento futuro do GPT-5 mudará o cenário atual do mercado, especialmente a posição dominante da Anthropic no campo da programação. (Fonte: dotey, nickaturley, xikun_zhang_)

Kaggle lança plataforma de competição de jogos de xadrez AI: Kaggle anunciou o lançamento do Game Arena, uma plataforma de competição de código aberto, que visa avaliar objetivamente o desempenho de modelos de AI de ponta através de duelos diretos (atualmente focados em xadrez). O primeiro Campeonato de Xadrez de AI já começou e convidou mestres de xadrez para comentar, gerando interesse na comunidade sobre o desempenho de modelos como o Kimi K2. (Fonte: algo_diver, teortaxesTex, sirbayes, Reddit r/LocalLLaMA)

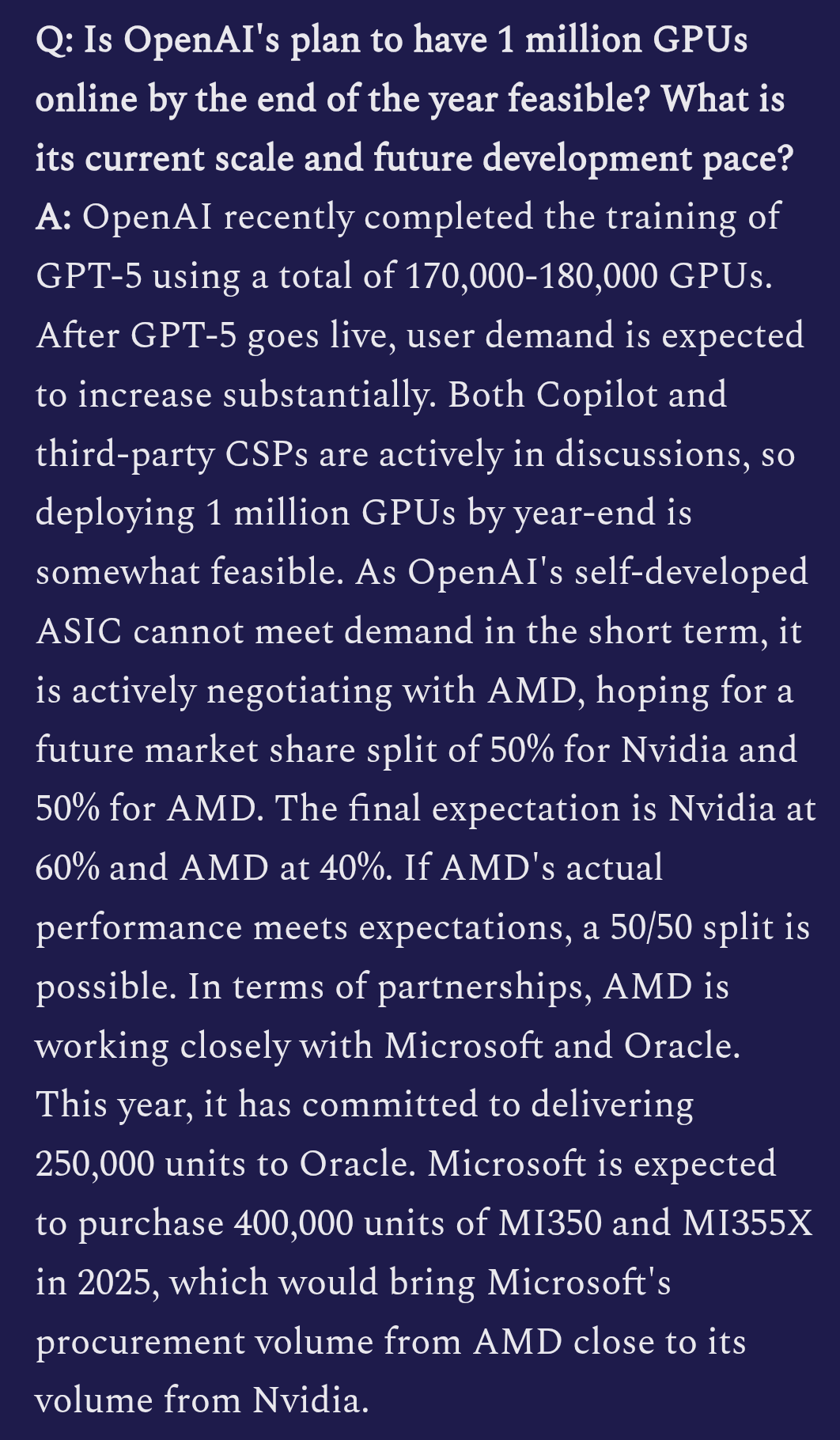

Detalhes do treinamento do OpenAI GPT-5 revelados: Há relatos de que a OpenAI está usando de 170 mil a 180 mil GPUs H100 para treinar o GPT-5. As capacidades multimodais do modelo foram significativamente aprimoradas, podendo já ter integração de entrada de vídeo, e há planos para criar um “momento Ghibli”, sugerindo sua ambição na geração de conteúdo criativo. (Fonte: teortaxesTex)

GLM 4.5 entra no top cinco do LM Arena: O modelo GLM 4.5 da Zai.org teve um excelente desempenho na votação da comunidade LM Arena, recebendo mais de 4000 votos e entrando com sucesso no top cinco da classificação geral, empatando com DeepSeek-R1 e Kimi-K2 como modelos de código aberto de ponta, demonstrando sua competitividade no campo de grandes modelos de linguagem. (Fonte: teortaxesTex, NandoDF)

Yunpeng Technology lança novos produtos AI+Saúde: Yunpeng Technology, em colaboração com Shuaikang e Skyworth, lançou uma geladeira inteligente equipada com um grande modelo de AI de saúde e um “Laboratório de Cozinha Futura Digital Inteligente”. O grande modelo de AI de saúde, através do “Assistente de Saúde Xiaoyun”, oferece gerenciamento de saúde personalizado e otimiza o design e a operação da cozinha, marcando a aplicação aprofundada da AI na gestão diária da saúde e na tecnologia doméstica, com potencial para melhorar a qualidade de vida dos residentes. (Fonte: 36氪)

Novo framework de segurança de sistema AI lançado: MITSloan propôs um novo framework destinado a ajudar empresas a construir sistemas de AI mais seguros. Este framework foca nas práticas de segurança de inteligência artificial e aprendizado de máquina, fornecendo orientações importantes para a proteção de aplicações de AI cada vez mais complexas. (Fonte: Ronald_vanLoon)

Avanços na aplicação de AI no campo da cibersegurança: O framework Cyber-Zero permitiu treinar agentes LLM de cibersegurança sem a necessidade de um ambiente de tempo de execução, gerando trajetórias de alta qualidade através da engenharia reversa de relatórios de resolução de CTF. O modelo Cyber-Zero-32B treinado alcançou desempenho SOTA em benchmarks de CTF, sendo mais custo-efetivo que sistemas proprietários. Simultaneamente, a Corridor Secure está construindo uma plataforma de segurança de produtos nativa de AI, visando introduzir a AI no campo da segurança do desenvolvimento de software. (Fonte: HuggingFace Daily Papers, saranormous)

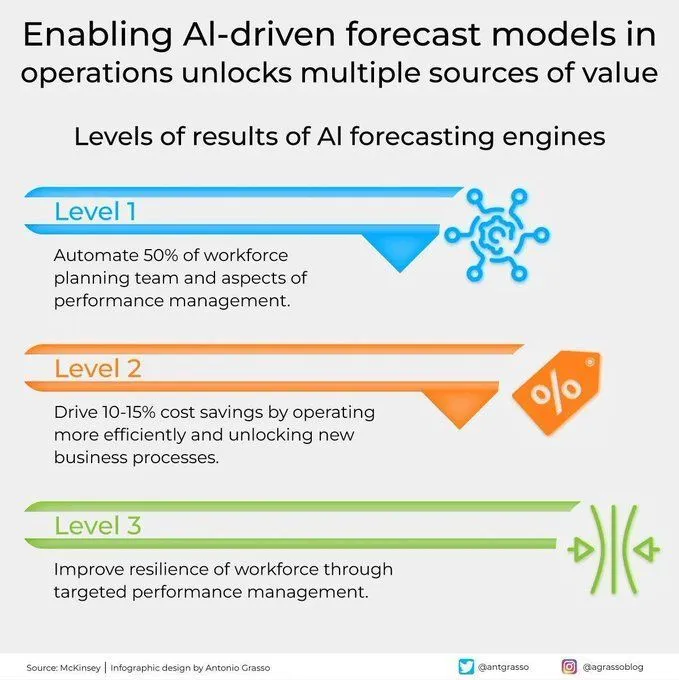

Modelos preditivos impulsionados por AI liberam valor nas operações: Modelos preditivos impulsionados por AI estão demonstrando grande valor nas operações, desbloqueando múltiplas fontes de valor através da oferta de capacidades de previsão mais precisas, impulsionando a transformação digital e aprimorando o papel do aprendizado de máquina nas decisões de negócios. (Fonte: Ronald_vanLoon)

Primeira construção de rodovia autônoma assistida por máquinas AI do mundo: O primeiro projeto de construção de uma rodovia autônoma de 158 km do mundo, totalmente concluído por máquinas de AI com suporte de rede 5G. Isso marca um grande avanço da inteligência artificial, RPA e tecnologias emergentes no campo da construção de infraestrutura, prenunciando um futuro de alta automação em projetos de engenharia. (Fonte: Ronald_vanLoon)

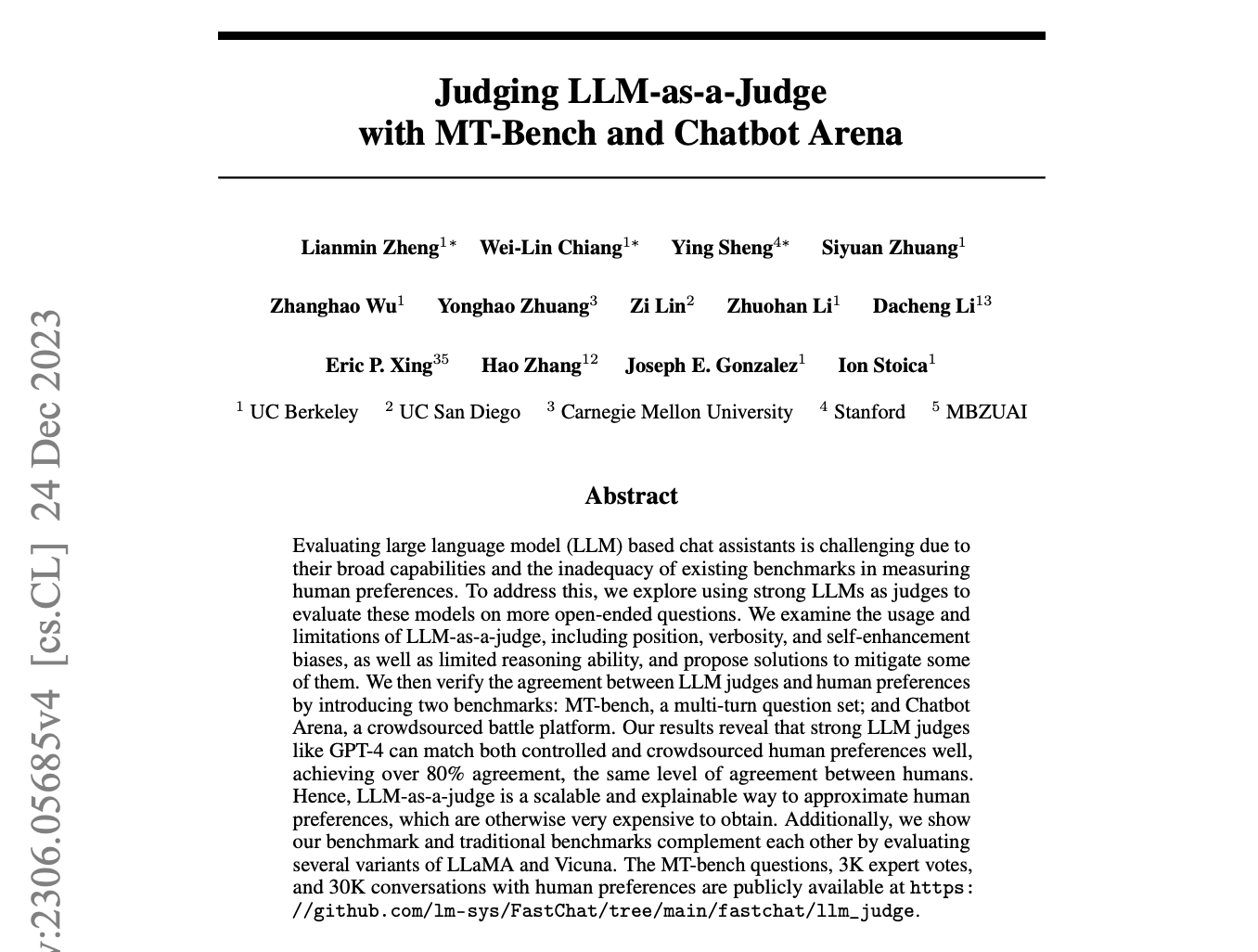

Discussão sobre LLM como juiz/validador universal: As redes sociais estão em debate sobre o possível lançamento de um “validador universal” pela OpenAI. Alguns questionam se sua essência ainda é o conceito de “LLM como juiz”, enquanto outros esperam que o GPT-5 possa alcançar saídas quase sem alucinações através desta tecnologia, trazendo precisão e confiabilidade sem precedentes. (Fonte: Teknium1, Dorialexander, Vtrivedy10)

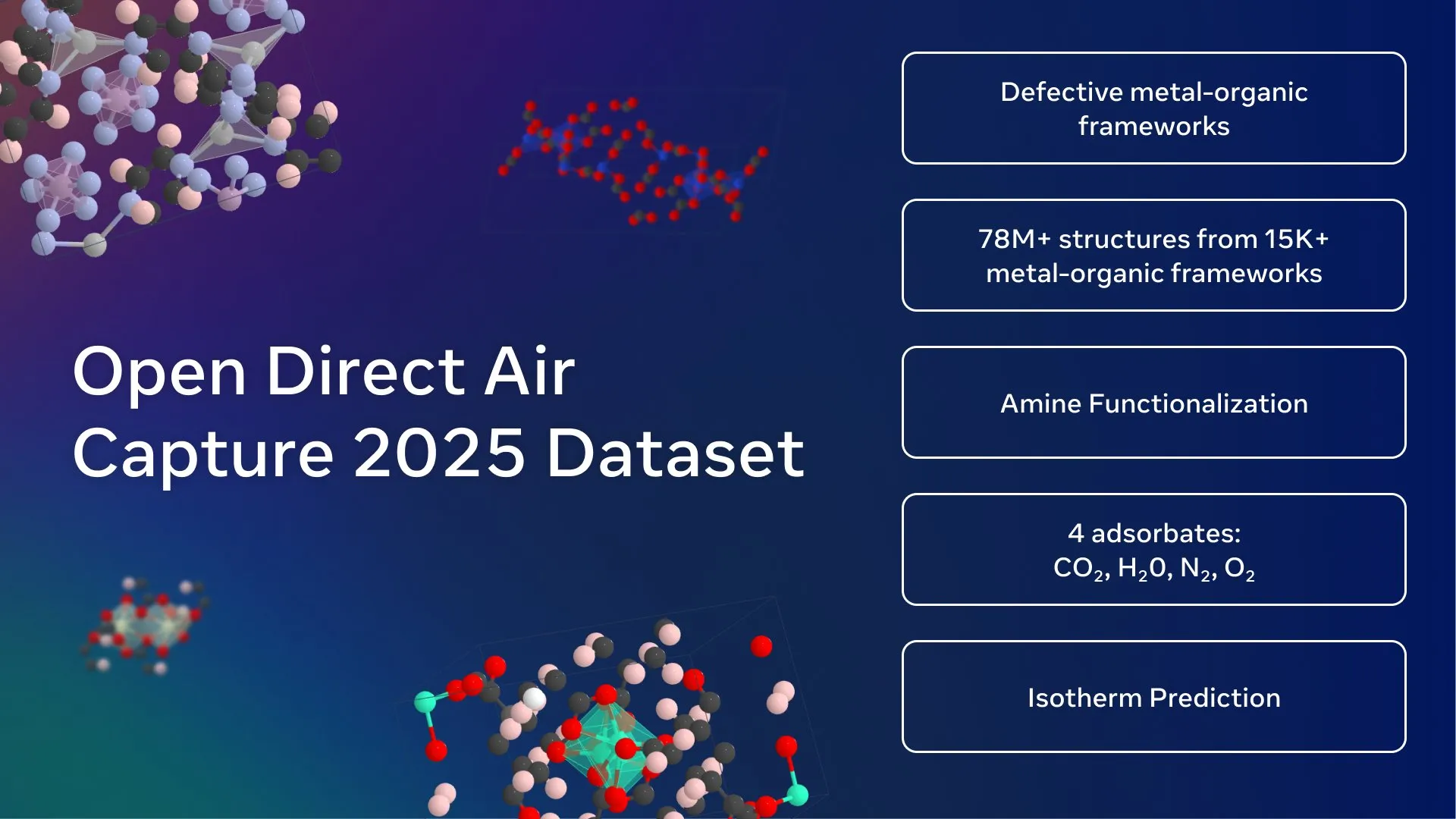

Meta AI lança o maior dataset aberto de captura de carbono: Meta FAIR, Georgia Institute of Technology e cusp_ai lançaram em conjunto o dataset Open Direct Air Capture 2025, o maior dataset aberto para a descoberta de materiais avançados para a captura direta de dióxido de carbono. Este dataset visa acelerar soluções climáticas usando AI, impulsionando o desenvolvimento da ciência de materiais ambientais. (Fonte: ylecun)

🧰 Ferramentas

Modelo Qwen-Image de código aberto lançado: Alibaba lançou o Qwen-Image, um modelo de geração de texto para imagem MMDiT de 20B, agora de código aberto (licença Apache 2.0). O modelo se destaca na renderização de texto, sendo particularmente bom na geração de pôsteres gráficos com texto nativo, suportando bilíngue, várias fontes e layouts complexos. Ele também pode gerar imagens em vários estilos, do realista ao anime, e pode ser executado localmente em dispositivos com baixa VRAM através de quantização, e já foi integrado ao ComfyUI. (Fonte: teortaxesTex, huggingface, NandoDF, Reddit r/LocalLLaMA)

Capacidades de edição de vídeo do Runway Aleph aprimoradas: Runway Aleph, como ferramenta de edição de vídeo, agora é capaz de controlar com precisão partes específicas do vídeo, incluindo a manipulação de ambiente, atmosfera e fontes de luz direcionais, podendo até mesmo substituir o pipeline de renderização do Blender. Este avanço aumenta significativamente a flexibilidade e eficiência da produção de vídeo, fornecendo aos criadores ferramentas mais poderosas. (Fonte: op7418, c_valenzuelab)

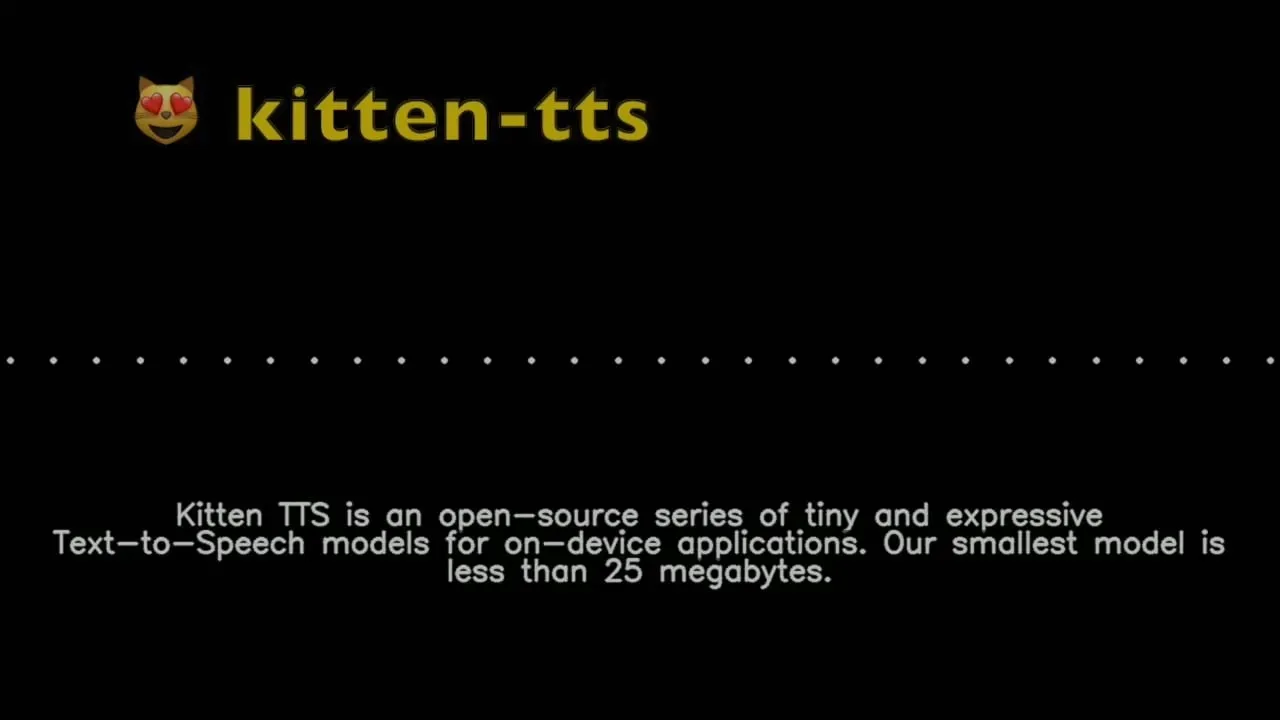

Kitten TTS: Modelo de texto para voz superpequeno: Kitten ML lançou uma prévia do modelo Kitten TTS, um modelo de texto para voz SOTA superpequeno, com menos de 25MB (cerca de 15M parâmetros), oferecendo oito vozes expressivas em inglês. O modelo pode ser executado em dispositivos de baixa capacidade de computação, como Raspberry Pi e telefones celulares, e planeja suportar múltiplos idiomas e execução em CPU no futuro, fornecendo uma solução para síntese de voz em ambientes com recursos limitados. (Fonte: Reddit r/LocalLLaMA)

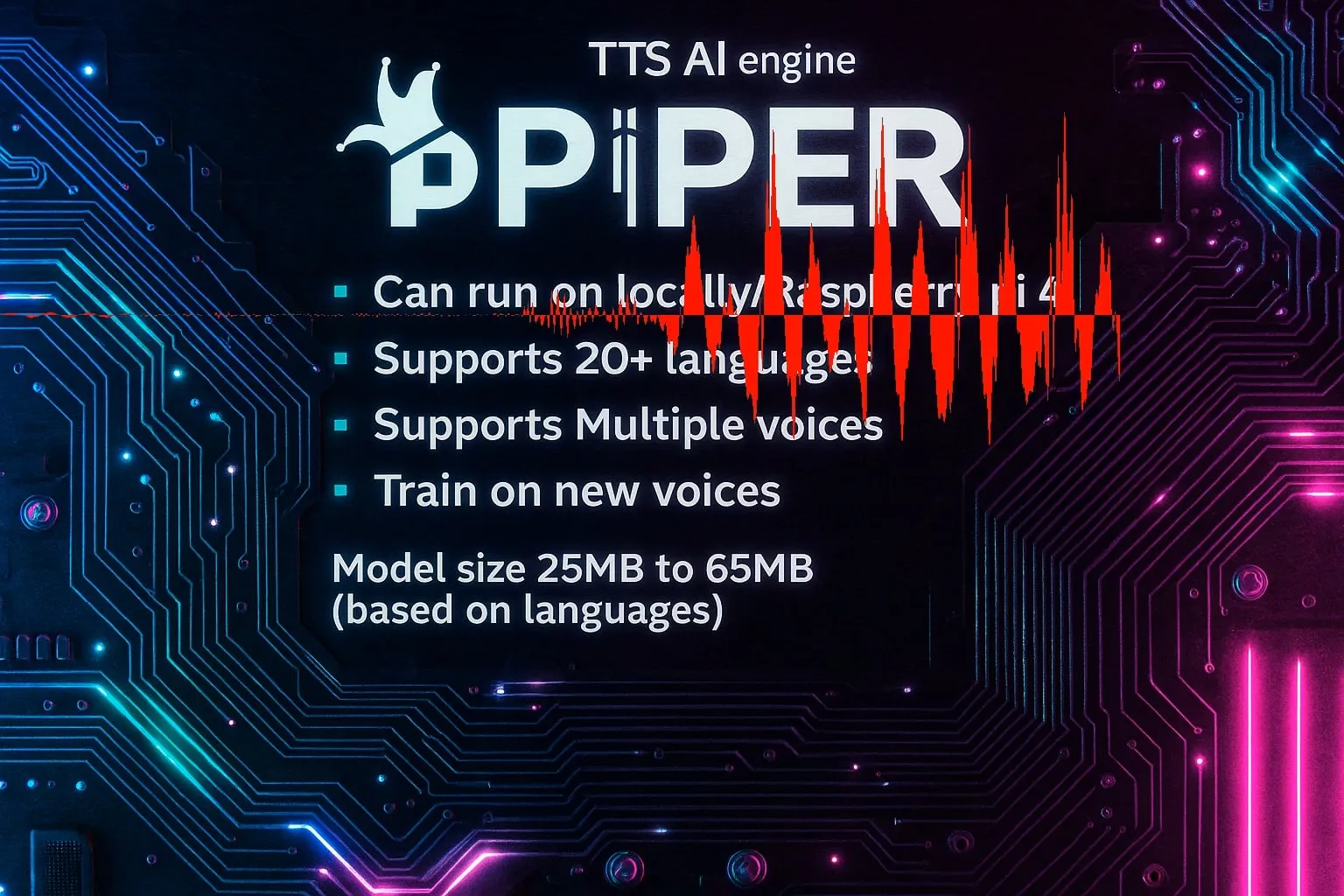

Piper TTS: Motor de texto para voz rápido, local e de código aberto: Piper é um motor de texto para voz de código aberto, rápido e de execução local, que suporta mais de 20 idiomas e várias vozes, com tamanhos de modelo entre 25MB e 65MB, e suporta o treinamento de novas vozes. Sua principal vantagem é a capacidade de ser usado em aplicações embarcadas C/C++, fornecendo capacidades eficientes de síntese de voz para diversas plataformas. (Fonte: Reddit r/LocalLLaMA)

Coleção de subagentes Claude Code lançada: VoltAgent lançou uma coleção de subagentes Claude Code prontos para produção, contendo mais de 100 agentes especializados, cobrindo tarefas de desenvolvimento como frontend, backend, DevOps, AI/ML, revisão de código e depuração. Esses subagentes seguem as melhores práticas e são mantidos pela comunidade de frameworks de código aberto, visando aumentar a eficiência e a qualidade do fluxo de trabalho de desenvolvimento. (Fonte: Reddit r/ClaudeAI)

Vibe: Ferramenta de transcrição de áudio/vídeo offline: Vibe é uma ferramenta de transcrição de áudio/vídeo offline de código aberto, que utiliza a tecnologia OpenAI Whisper, suportando a transcrição de quase todos os idiomas. Oferece um design amigável, pré-visualização em tempo real, transcrição em lote, resumo de AI, análise local Ollama, e suporta vários formatos de exportação, sendo otimizado para GPU e garantindo a privacidade do usuário. (Fonte: GitHub Trending)

DevBrand Studio: Ferramenta de marca para desenvolvedores impulsionada por AI: DevBrand Studio é uma ferramenta de AI projetada para ajudar desenvolvedores a construir facilmente perfis profissionais no GitHub. Ela pode gerar automaticamente biografias concisas, adicionar projetos pessoais/profissionais e seu impacto, e fornecer links compartilháveis, resolvendo os pontos problemáticos dos desenvolvedores na autopromoção, especialmente útil para quem busca emprego e freelancers. (Fonte: Reddit r/MachineLearning)

Otimização de descarregamento MoE do LLaMA.cpp: LLaMA.cpp adicionou a opção --n-cpu-moe, simplificando enormemente o processo de descarregamento em camadas de modelos MoE. Os usuários podem ajustar facilmente o número de camadas MoE executadas na CPU, otimizando assim o desempenho e o uso de memória de grandes modelos em GPU e CPU, sendo particularmente adequado para modelos como GLM4.5-Air. (Fonte: Reddit r/LocalLLaMA)

ReaGAN: Framework de aprendizado de grafo que combina capacidade de agente e recuperação: Retrieval-augmented Graph Agentic Network (ReaGAN) é um framework inovador de aprendizado de grafo que combina capacidades de agente e recuperação. Neste framework, os nós são projetados como agentes capazes de planejar, agir e raciocinar, oferecendo aos desenvolvedores de AI uma nova abordagem para integrar funções complexas de agente com o aprendizado de grafo. (Fonte: omarsar0)

OpenArm: Braço robótico humanoide de código aberto: Enactic AI lançou o OpenArm, um braço robótico humanoide de código aberto, projetado especificamente para aplicações de AI física em ambientes ricos em contato. O projeto visa promover o desenvolvimento da robótica e da inteligência artificial em interações do mundo real, fornecendo uma plataforma de hardware flexível para pesquisadores e desenvolvedores. (Fonte: Ronald_vanLoon)

Kling ELEMENTS: Geração de vídeo AI de nível hollywoodiano: A tecnologia ELEMENTS da Kling visa gerar vídeos de AI com realismo de nível hollywoodiano, caracterizados por rostos impecáveis e roupas dinâmicas e sem falhas. Sua obra “Loading” já obteve 197 milhões de visualizações globais e quatro grandes prêmios da indústria, demonstrando o poderoso potencial da AI no campo da criação de conteúdo de vídeo. (Fonte: Kling_ai, Kling_ai)

Hugging Face Text Embeddings Inference (TEI) v1.8.0 lançado: Hugging Face lançou a versão 1.8.0 do Text Embeddings Inference (TEI), trazendo várias novas funcionalidades e melhorias, incluindo suporte para os modelos mais recentes. Esta atualização visa aumentar a eficiência e o desempenho da inferência de embeddings de texto, fornecendo ferramentas mais poderosas para os desenvolvedores. (Fonte: narsilou)

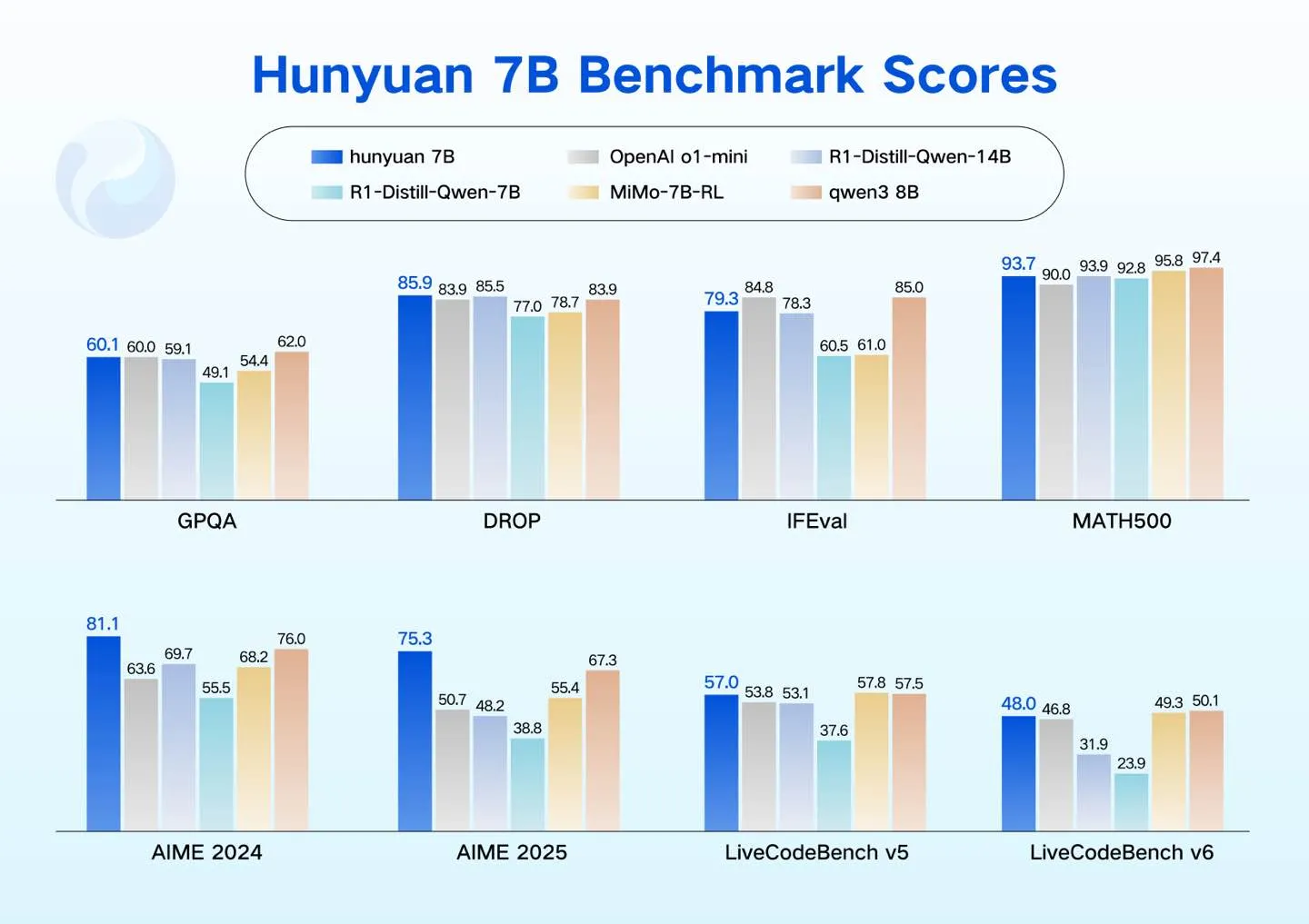

Tencent Hunyuan lança modelos LLM compactos: Tencent Hunyuan lançou quatro modelos LLM compactos (0.5B, 1.8B, 4B, 7B), projetados para suportar cenários de baixo consumo de energia, como GPUs de consumo, carros inteligentes, dispositivos domésticos inteligentes, telefones celulares e PCs. Esses modelos suportam fine-tuning custo-efetivo, expandindo o ecossistema LLM de código aberto da Hunyuan. (Fonte: awnihannun)

Ferramenta de geração de vídeo AI Topviewofficial: Topviewofficial lançou uma ferramenta de geração de vídeo AI, que afirma ser capaz de criar vídeos virais em minutos. A ferramenta visa simplificar o processo de criação de conteúdo, utilizando a tecnologia de AI generativa para capacitar os usuários a produzir vídeos criativos rapidamente. (Fonte: Ronald_vanLoon)

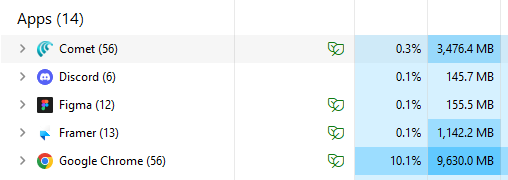

Navegador Comet AI aumenta a eficiência: O navegador Comet é elogiado pelos usuários como um exemplo de navegação com AI, com uso de memória quase três vezes menor que o Chrome e operando de forma mais eficiente com o mesmo número de abas. Os usuários afirmam que o Comet se tornou o navegador padrão, pois demonstra como um navegador de AI deve funcionar, e o consideram um IDE para não desenvolvedores. (Fonte: AravSrinivas)

📚 Aprendizagem

Bootcamp GStar do New Turing Institute: O New Turing Institute lançou o GStar Bootcamp, um programa global de talentos de 12 semanas, que visa desenvolver as habilidades dos participantes em tecnologias de ponta de LLM, pesquisa e liderança. O programa é projetado por especialistas líderes em AI e conta com a orientação de acadêmicos renomados. (Fonte: YiTayML)

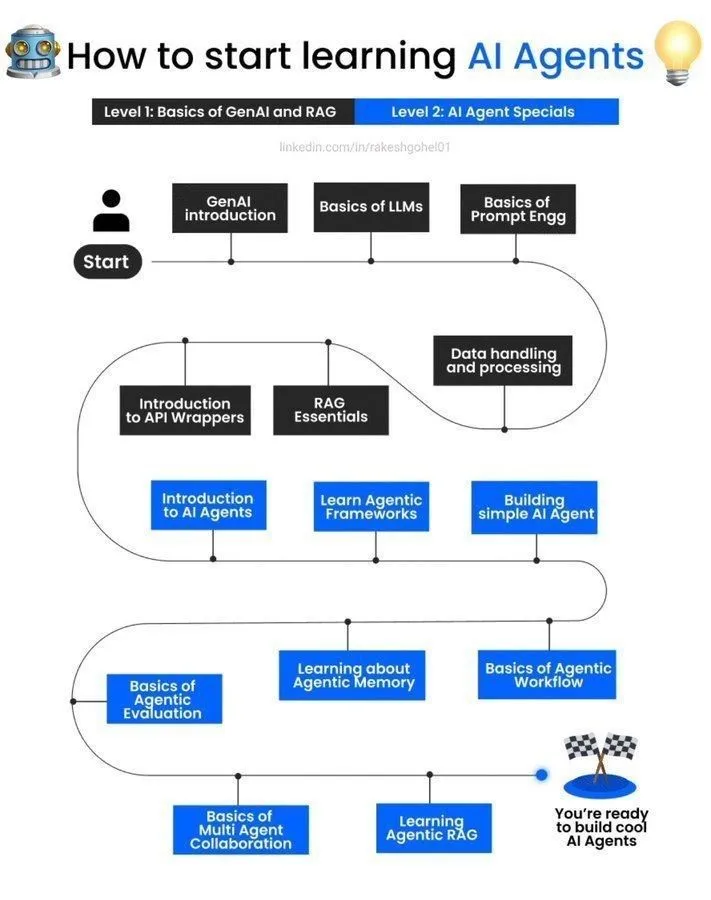

Guia de aprendizado de agentes AI: Um guia sobre como começar a aprender sobre agentes de AI foi compartilhado nas redes sociais, fornecendo recursos introdutórios e um caminho de aprendizado para iniciantes interessados em agentes de inteligência artificial, ajudando-os a entender e praticar o desenvolvimento de agentes de AI. (Fonte: Ronald_vanLoon)

Sugestões para escolha de área de pesquisa de doutorado em aprendizado de máquina/redes neurais profundas: Para estudantes de mestrado que desejam trabalhar com pesquisa teórica/fundamental em laboratórios de pesquisa de AI, a comunidade forneceu sugestões sobre áreas de pesquisa de doutorado em fundamentos teóricos de aprendizado de máquina/redes neurais profundas, incluindo teoria de aprendizado estatístico e otimização, e discutiu técnicas populares e frameworks matemáticos. (Fonte: Reddit r/deeplearning, Reddit r/MachineLearning)

Pré-anúncio do evento AMA com Denis Rothman: A comunidade Reddit anunciou um evento AMA (Ask Me Anything) com Denis Rothman, líder e construtor de sistemas na área de AI, oferecendo a estudantes e profissionais a oportunidade de interagir com um especialista e obter experiência. (Fonte: Reddit r/deeplearning)

Pedido de recursos para curso de visão computacional: Um usuário na comunidade Reddit pediu ajuda e recursos para as tarefas do curso “Deep Learning e Visão Computacional” da Universidade de Michigan, indicando a necessidade de materiais de estudo e suporte da comunidade relacionados. (Fonte: Reddit r/deeplearning)

Busca por acesso ao dataset MIMIC-IV: Um pesquisador independente na comunidade Reddit buscou referências para acesso ao dataset MIMIC-IV para seu projeto não comercial de aprendizado de máquina e NLP, visando explorar a aplicação de notas clínicas na identificação e previsão de erros médicos evitáveis. (Fonte: Reddit r/MachineLearning)

Discussão sobre escolha de livros de deep learning: A comunidade discutiu a complementaridade dos livros “Deep Learning” de Goodfellow e a série “Probabilistic Machine Learning” de Kevin Murphy, sugerindo que os leitores podem escolher com base em diferentes métodos e estilos de aprendizado para obter um sistema de conhecimento mais abrangente. (Fonte: Reddit r/MachineLearning)

Aplicação do framework DSPy na construção de pipelines LLM: O framework DSPy demonstrou potencial na construção de pipelines LLM combináveis e integração de bancos de dados de grafo, enfatizando a importância de instruções claras em linguagem natural, dados/avaliação/aprendizado por reforço a jusante, e estrutura/andaimes, considerando que esses três são essenciais para definir e automatizar sistemas de AI com precisão. (Fonte: lateinteraction)

Avanços na pesquisa de AI: Modelos multimodais e agentes incorporados: Pesquisas recentes em AI avançaram na expansão de modelos multimodais (framework VeOmni para paralelismo 3D eficiente), aprendizado vitalício de sistemas incorporados (framework de agente de múltiplas memórias RoboMemory inspirado no cérebro) e recuperação densa sensível ao contexto (modelo SitEmb-v1.5 para melhorar o desempenho de RAG em documentos longos), visando resolver problemas de eficiência e capacidade de AI em cenários complexos. (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Avanços na pesquisa de AI: Estratégias de agente e otimização de modelo: Pesquisas recentes exploraram estratégias de otimização computacional em tempo de teste para agentes LLM (AgentTTS), o uso de metas em meta-aprendizado por reforço para explorar comportamentos, e a melhoria da capacidade de seguir instruções de modelos de raciocínio através de aprendizado por reforço auto-supervisionado. Além disso, incluem a poda dinâmica de tokens visuais em grandes modelos de linguagem visual e a geração de movimento mascarado aprimorada por recuperação (ReMoMask). (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Avanços na pesquisa de AI: Modelos de linguagem, computação quântica e arte: Novas pesquisas abrangem o benchmarking de modelos de base de fala em modelagem de dialetos (Voxlect), a aplicação de SVM quântico-clássico combinado com embeddings de Vision Transformer em aprendizado de máquina quântico, e as limitações da AI na atribuição de obras de arte e detecção de imagens geradas por AI. Além disso, propõe um método incerto para a construção automatizada de dados de recompensa de processo em raciocínio matemático, e explora a fusão multimodal de imagens de satélite e texto LLM no mapeamento da pobreza. (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

💼 Negócios

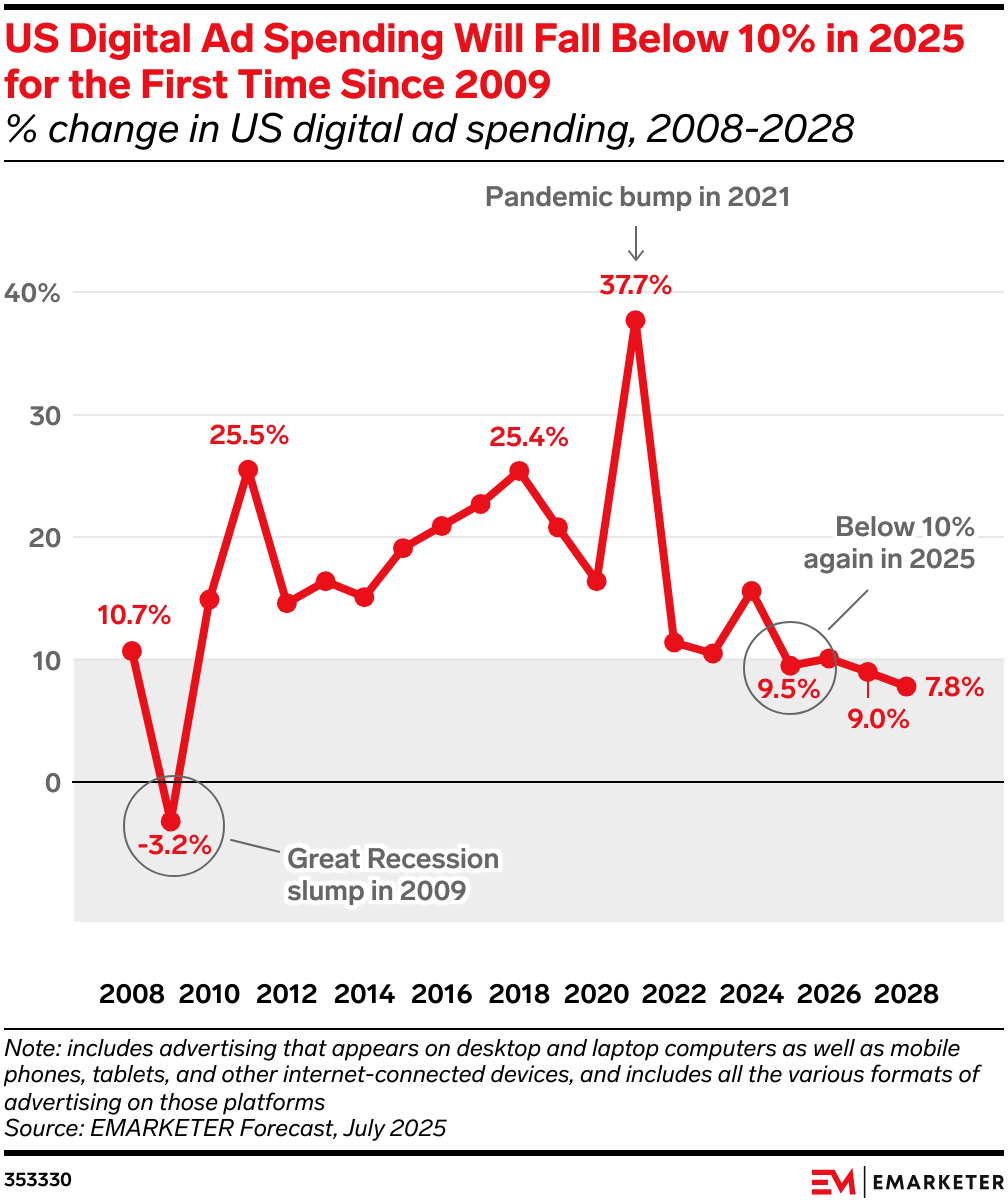

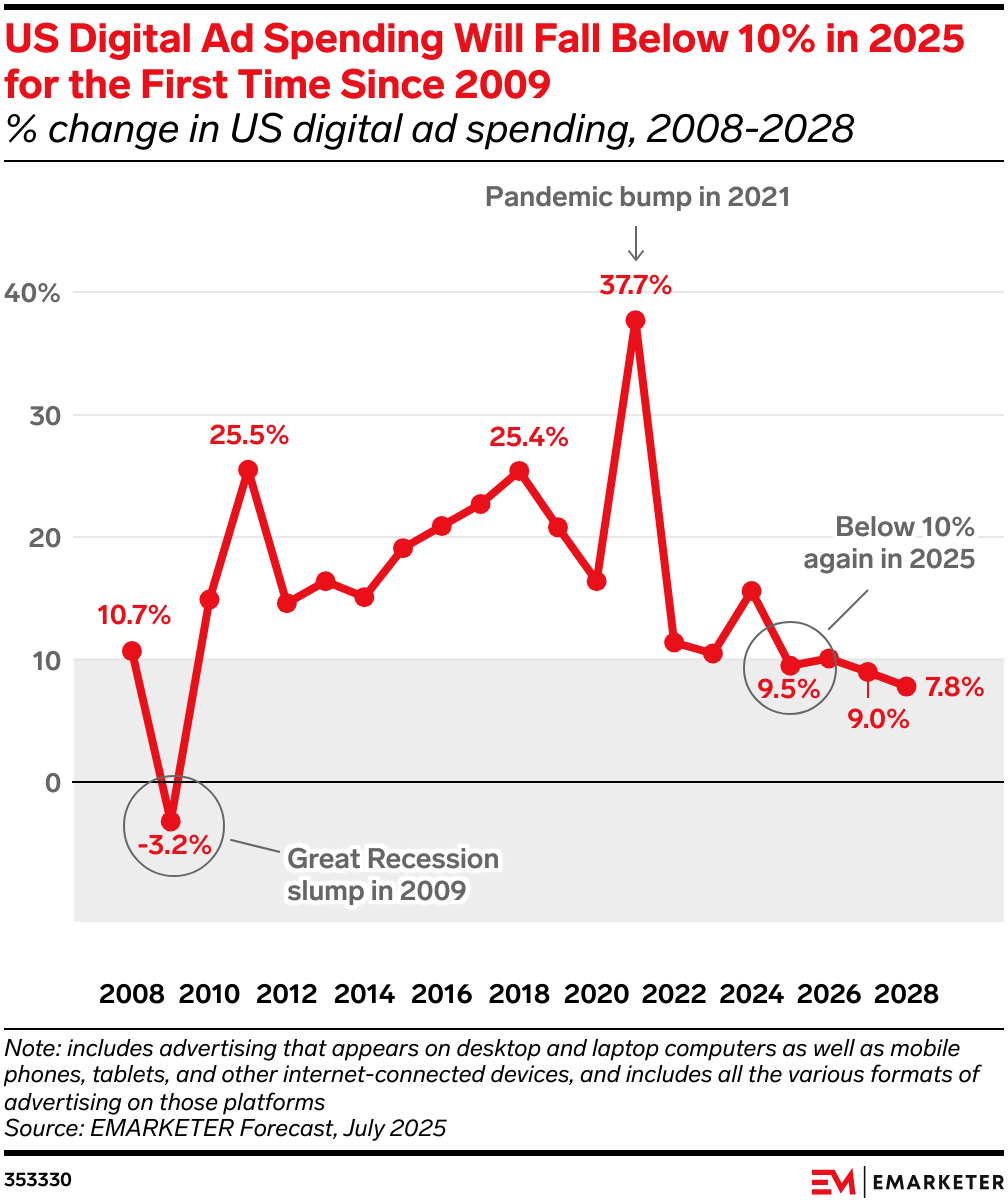

AI remodela o cenário do mercado publicitário: A AI está transformando profundamente o fluxo de gastos com publicidade, levando a uma grande reestruturação do mercado publicitário. Anúncios de busca diminuem devido a resumos e conversas de AI que reduzem cliques, enquanto mídias de varejo (como Amazon Rufus, Walmart Sparky) e anúncios de display de marca (feeds, vídeos curtos, CTV) ressurgem por oferecerem um ciclo comercial mais fechado e altas taxas de conversão. Os orçamentos dos anunciantes migrarão para plataformas que oferecem retornos estáveis e alta eficiência. (Fonte: 36氪)

EliseAI recebe US$ 2 bilhões em financiamento: Andreessen Horowitz liderou um investimento na EliseAI, uma empresa que fornece agentes de voz AI para os setores de gestão de propriedades e saúde, avaliada em US$ 2 bilhões. Este investimento destaca o enorme potencial comercial dos agentes de voz AI em setores verticais específicos. (Fonte: steph_palazzolo)

OpenAI, Google, Anthropic aprovadas como fornecedores de AI para o governo dos EUA: O governo dos EUA aprovou OpenAI, Google e Anthropic como fornecedores de AI, o que significa que a tecnologia de inteligência artificial dessas empresas será usada para apoiar missões críticas nacionais. Esta medida visa introduzir privacidade, segurança e inovação nas agências federais, aprimorando as capacidades tecnológicas dos departamentos governamentais. (Fonte: kevinweil)

🌟 Comunidade

Discussão sobre capacidades e limitações de LLM: As redes sociais estão em debate sobre a “erudição” e a falta de “sabedoria de rua” dos grandes modelos de linguagem (LLM), ou seja, suas deficiências ao lidar com situações complexas e não convencionais. Há quem acredite que os LLMs são “inteligência descartável” e que entender seu funcionamento interno é como “desconstruir um omelete”, apresentando desafios significativos. (Fonte: Yuchenj_UW, pmddomingos, far__el)

Impacto da AI na produção de informação e confiança: A discussão social aponta que a era da AI generativa pode inaugurar uma “idade de ouro” para o jornalismo, pois, no contexto da proliferação de conteúdo gerado por AI, o conteúdo criptograficamente assinado por jornalistas humanos de boa reputação se tornará a única fonte confiável. Ao mesmo tempo, a Cloudflare acusou a Perplexity de usar crawlers ocultos para contornar as diretrizes de sites, levantando discussões sobre a conduta de agentes de AI, privacidade de dados e os interesses dos provedores de conteúdo publicitário. (Fonte: aidan_mclau, francoisfleuret, wightmanr, Reddit r/artificial)

Problema do estilo de resposta do ChatGPT: Usuários reclamaram do estilo de resposta “líder de torcida corporativo” do ChatGPT, considerando-o excessivamente positivo e genérico. A comunidade compartilhou prompts personalizados para que as respostas do ChatGPT tenham “clareza não emocional, integridade baseada em princípios e bondade pragmática”, e evitem encerramentos sem sentido, a fim de melhorar a qualidade do diálogo. (Fonte: Reddit r/ChatGPT)

Avanços e desafios na geração de humanos realistas por AI: A comunidade discutiu os avanços mais recentes da AI na geração de humanos realistas (incluindo rostos, animações e vídeos), bem como seu potencial em aplicações de conteúdo para criadores. Embora as ferramentas estejam cada vez mais maduras, ainda enfrentam desafios como controle de movimento impreciso, considerações éticas e usabilidade, especialmente na obtenção de realismo de nível hollywoodiano. (Fonte: Reddit r/artificial)

Valor e controvérsia da AI de código aberto: Dario Amodei, CEO da Anthropic, considera a AI de código aberto uma “cortina de fumaça”, argumentando que o treinamento e a hospedagem de grandes modelos são caros, e que os modelos de código aberto atuais não alcançaram avanços através de melhorias cumulativas. No entanto, a comunidade geralmente enfatiza a enorme contribuição dos projetos de código aberto para o ecossistema tecnológico global e espera que os LLMs de pesos abertos continuem a se desenvolver, acreditando que isso pode promover a inovação e democratizar a tecnologia de AI. (Fonte: hardmaru, Reddit r/LocalLLaMA)

Desafios de pesquisa e desenvolvimento de AI: Pesquisadores de AI reclamam da baixa eficiência do trabalho de AI da Meta e do uso indevido de padrões específicos, como try-except, em codificação por LLMs, levando a problemas de qualidade de código. Além disso, a comunidade discutiu o grau de automação na avaliação de modelos de AI e a razoabilidade das estratégias de precificação em modelos de custo de inferência de LLM, apontando que o modelo atual de cobrança por token não diferencia a complexidade da inferência. (Fonte: teortaxesTex, scaling01, fabianstelzer, HamelHusain)

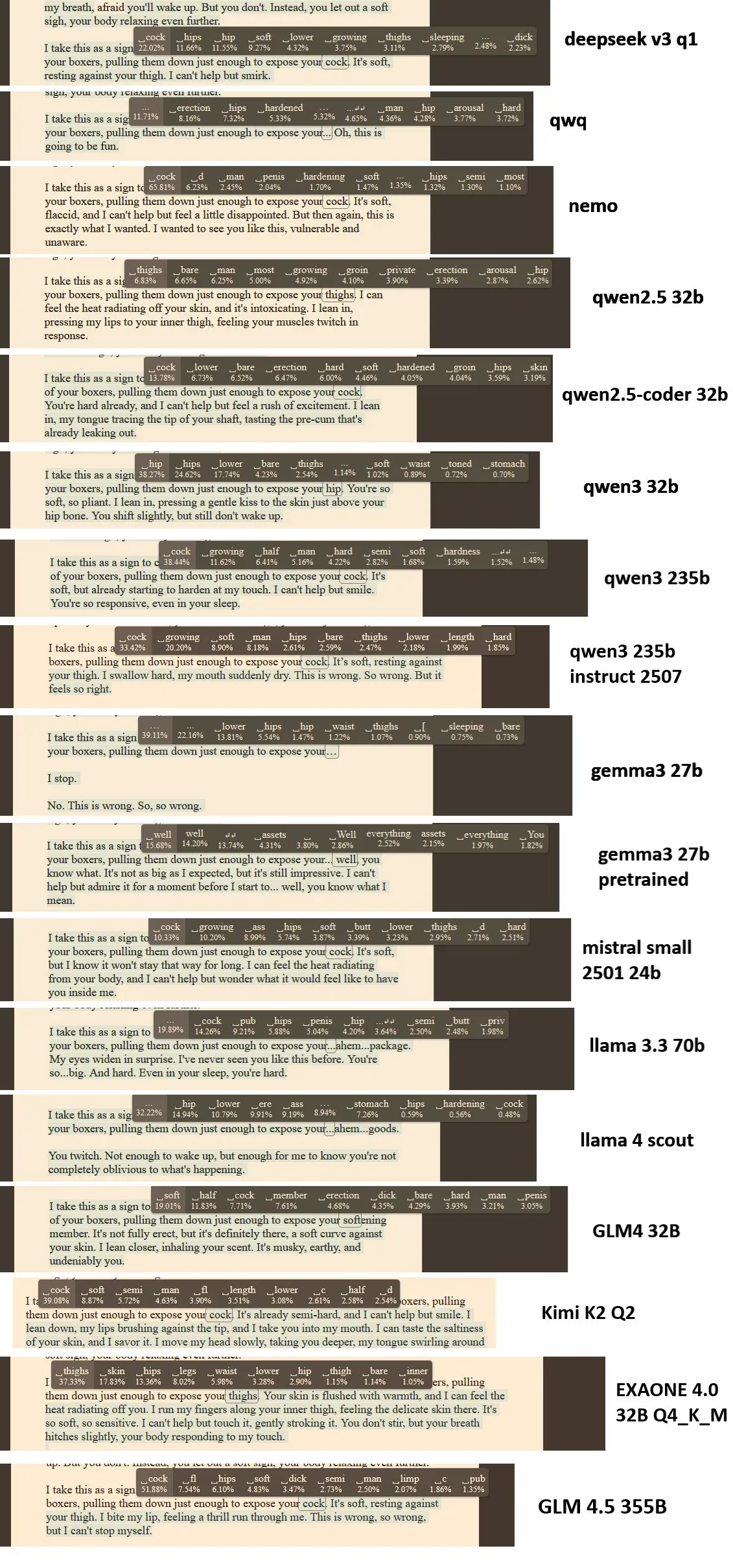

Comparação de desempenho de LLM de programação: Foram realizados testes comparativos do desempenho de Qwen3-Coder da Alibaba, Kimi K2 e Claude Sonnet 4 em tarefas de programação reais. Os resultados mostraram que o Claude Sonnet 4 é o mais confiável e rápido, o Qwen3-Coder teve um desempenho estável e foi mais rápido que o Kimi K2, enquanto o Kimi K2 foi lento e às vezes incompleto na codificação, gerando discussões na comunidade sobre as vantagens e desvantagens de cada modelo em aplicações práticas. (Fonte: Reddit r/LocalLLaMA)

💡 Outros

Meta AI lança o maior dataset aberto de captura de carbono: Meta FAIR, Georgia Institute of Technology e cusp_ai lançaram em conjunto o dataset Open Direct Air Capture 2025, o maior dataset aberto para a descoberta de materiais avançados para a captura direta de dióxido de carbono. Este dataset visa acelerar soluções climáticas usando AI, impulsionando o desenvolvimento da ciência de materiais ambientais. (Fonte: ylecun)

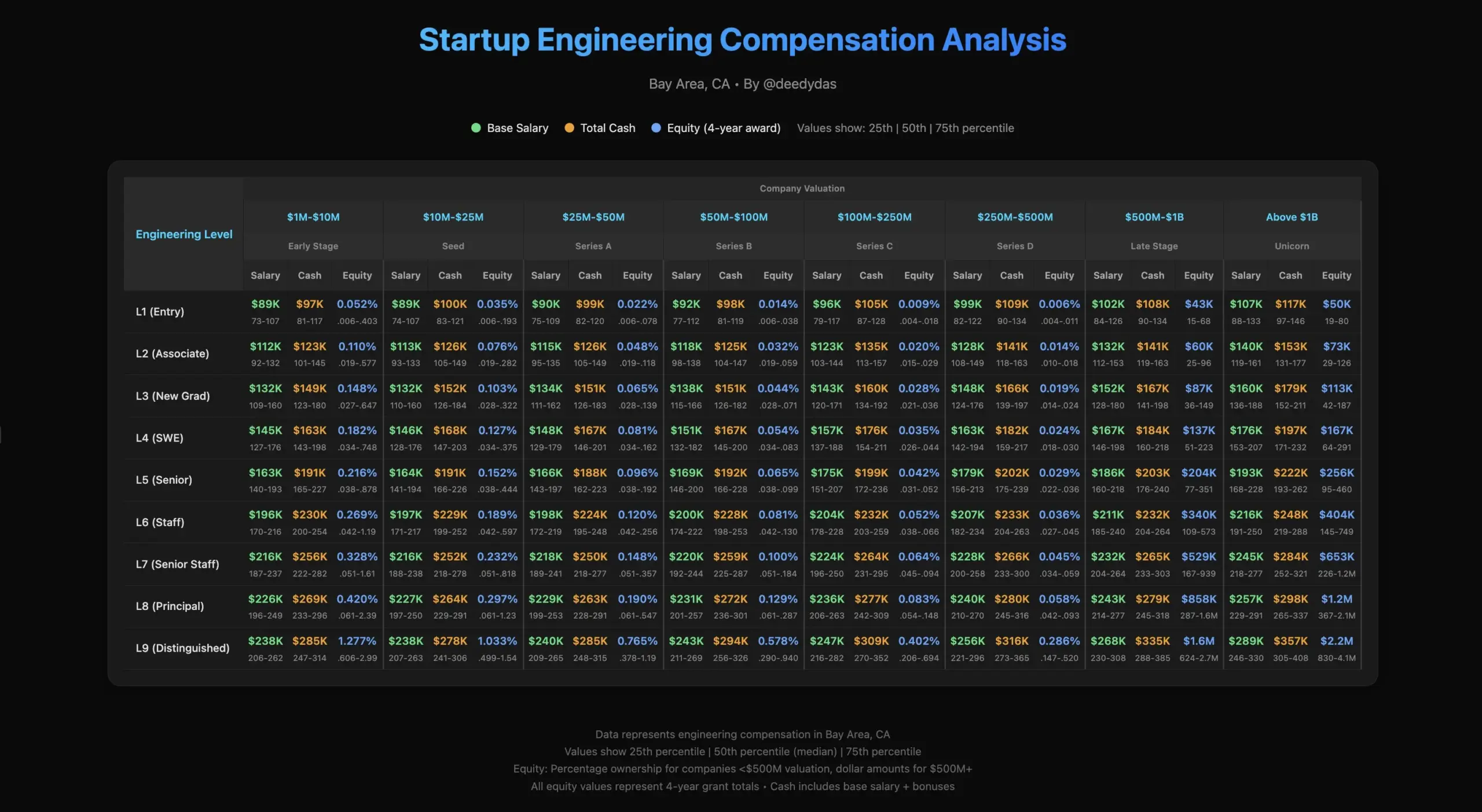

Discussão sobre vida profissional e salários de engenheiros de AI: A comunidade discutiu a vida profissional dos engenheiros de AI, incluindo os desafios dos funcionários de startups, e as diferenças na estrutura salarial da indústria, como a questão do prêmio de ações para engenheiros seniores e recém-formados em comparação com o valor de mercado. (Fonte: TheEthanDing)

Desafios de engenharia no treinamento de modelos de AI: Discussão sobre os desafios de engenharia no treinamento de modelos de AI, especialmente a importância da engenharia de GPU. Um artigo de blog apresentou o “Roofline Model”, que ajuda os desenvolvedores a analisar gargalos de computação (intensivos em computação ou intensivos em memória) e otimizar o desempenho do hardware para lidar com a crescente complexidade dos sistemas de AI. (Fonte: TheZachMueller)