Palavras-chave:Memória de IA, Modelo de código aberto, Agente de IA, Multimodal, Rede neural, Geração de vídeo por IA, IA na medicina, Condução autônoma, Sistema de memória multimodal MIRIX, Modelo de inferência Llama Nemotron Super v1.5, Arquitetura MoE Qwen3-30B-A3B-Instruct-2507, Agente de inteligência científica universal SciMaster, Chip Tesla FSD HW5.0

🔥 Destaques

Pela primeira vez globalmente, “AI Memory” é de código aberto e MIRIX lança APP simultaneamente: Pesquisadores da Universidade da Califórnia em San Diego e da Universidade de Nova York lançaram e disponibilizaram o MIRIX, o primeiro sistema de memória de IA multimodal e multi-agente do mundo. Este sistema incorpora pela primeira vez a “memória de longo prazo multimodal” no sistema operacional subjacente da IA, alcançando compreensão profunda e rastreamento de longo prazo através de seis módulos de memória e um fluxo de trabalho multi-agente. Nas tarefas de diálogo longo ScreenshotVQA e LOCOMO, o MIRIX superou em muito os métodos tradicionais de RAG e texto longo, e lançou simultaneamente um APP para desktop, suportando armazenamento local, com o objetivo de construir um assistente pessoal de IA exclusivo para os usuários. (Fonte: 36氪)

Novo modelo de código aberto da NVIDIA: três vezes o throughput, pode rodar em uma única placa e alcançou SOTA em inferência: A NVIDIA lançou o Llama Nemotron Super v1.5, um modelo de código aberto projetado para inferência complexa e tarefas de Agent. O modelo, otimizado através de Neural Architecture Search (NAS), alcança desempenho SOTA em tarefas científicas, matemáticas, de programação e de Agent, enquanto aumenta o throughput em 3 vezes em relação à versão anterior e pode operar eficientemente em uma única placa, alcançando alta precisão, alto throughput e baixo consumo de recursos. Ele pertence ao ecossistema Nemotron da NVIDIA e visa fornecer soluções de alto desempenho, controláveis e escaláveis para o desenvolvimento de aplicações de IA de nível empresarial. (Fonte: 量子位)

Lançamento do modelo Qwen3-30B-A3B-Instruct-2507: A equipe Qwen da Alibaba Cloud lançou o modelo Qwen3-30B-A3B-Instruct-2507. Este modelo possui uma arquitetura MoE, com apenas 3B de parâmetros ativos, mas com desempenho significativamente aprimorado, especialmente em raciocínio matemático (AIME25 melhorou de 21.4 para 61.3) e compreensão de contexto longo (256K tokens), e suporta implantação local. Seu desempenho se aproxima do GPT-4o e do Qwen3-235B-A22B no modo não-pensante, sendo considerado um avanço importante no campo de código aberto, e já está disponível no Hugging Face em versões quantizadas GGUF e MLX, recebendo ampla atenção da comunidade. (Fonte: Reddit r/LocalLLaMA)

SciMaster: O primeiro Agent científico universal do mundo: A Universidade Jiao Tong de Xangai e a DeepMotion AI lançaram e disponibilizaram o SciMaster, com o objetivo de se tornar o assistente de pesquisa especializado de todos. Este Agent científico universal combina recursos de toda a web e 170 milhões de artigos científicos, fornecendo capacidade de pesquisa aprofundada de nível especialista, suportando vários métodos de recuperação como WebSearch, WebParse, PaperSearch, e podendo corrigir e complementar informações automaticamente. O SciMaster também integra várias ferramentas científicas dedicadas, suportando invocação ativa e automática, visando remodelar o paradigma de pesquisa universitária e promover o desenvolvimento do campo AI4S. (Fonte: 量子位)

🎯 Tendências

Progresso dos modelos de vídeo de IA domésticos “Três Reinos”: No campo da geração de vídeo por IA na China, o Kuaishou Keling AI, SenseTime Vidu e ByteDance Jiemeng AI estão em intensa competição. O Keling AI é conhecido por sua forte expressividade, adequado para conteúdo dramático; o Vidu se destaca pelo realismo e detalhes, sendo bom em simular leis físicas; enquanto o Jiemeng AI se sobressai pelo equilíbrio, controle e atributos de ferramenta abrangentes. Todos os três fizeram avanços na questão da consistência, com rotas técnicas distintas. Keling e Jiemeng, devido ao seu potencial em aplicações e ecossistemas, são considerados os concorrentes mais fortes para serem os vencedores finais. (Fonte: 36氪)

Microsoft Edge lança modo Copilot: O navegador Microsoft Edge entrou oficialmente no mercado de navegadores de IA, lançando o modo Copilot, que pode ler e entender o conteúdo da página, resumir vídeos do YouTube, comparar informações de produtos em várias abas e suportar interação por voz. Este modo ainda está em fase experimental, oferecendo recursos gratuitos semelhantes ao ChatGPT DeepResearch, com o objetivo de transformar o navegador em uma ferramenta de assistência mais inteligente, mas suas funções não diferem muito dos navegadores de IA existentes, e enfrenta desafios de privacidade do usuário e aceitação. (Fonte: 36氪)

IA médica avança com capacitação sistêmica e desenvolvimento especializado: A WAIC 2025 mostrou que a IA médica está “retornando”, com grandes empresas e startups entrando no campo. A IA está evoluindo de resolver problemas específicos em “nós” para capacitar “segmentos” inteiros, alcançando gerenciamento de saúde e assistência diagnóstica de ponta a ponta através de Agents inteligentes, como o “Assistente de Gerenciamento de Saúde” da Tencent Health. Ao mesmo tempo, a IA está se desenvolvendo de modelos gerais para modelos especializados verticais, resolvendo problemas clínicos mais profundos, como o “Jingyi Qianxun 2.0” da JD Health e o “Chest Scan Multi-Check Agent” da United Imaging Intelligence, melhorando a eficiência e precisão do diagnóstico e tratamento. (Fonte: 36氪)

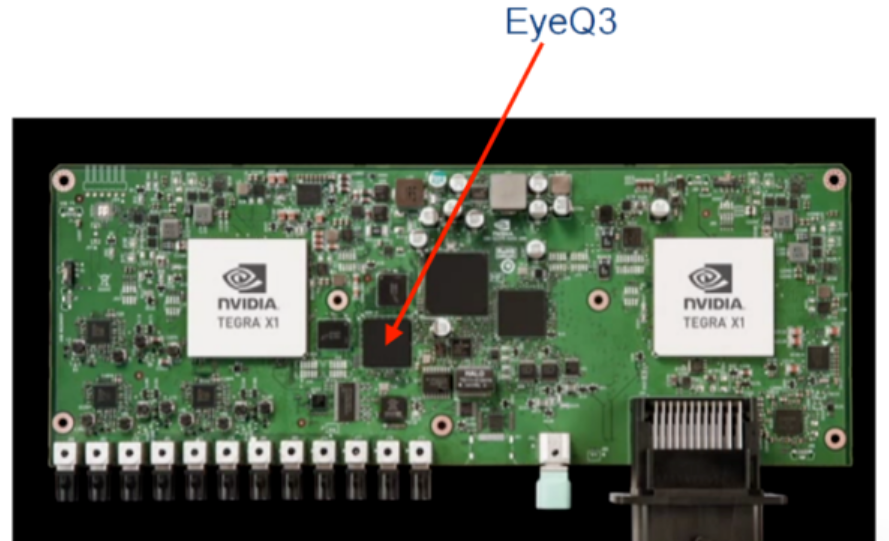

Chips Tesla FSD continuam a iterar, visando direção autônoma de nível L4: Os chips de direção autônoma da Tesla evoluíram da dependência de fornecedores externos (Mobileye, NVIDIA) para o desenvolvimento completo de chips FSD internos. O HW3.0 e o HW4.0 foram lançados sucessivamente, com poder de computação e eficiência energética significativamente aprimorados, fortalecendo a capacidade de adaptação a cenários complexos. O chip HW5.0/AI5 entrou em produção em massa, utilizando o processo de 3nm da TSMC, com poder de computação de até 2000-2500 TOPS, e espera-se que seja produzido em massa em 2026, impulsionando a implementação da direção autônoma de nível L4 e remodelando o mercado de chips de direção inteligente. (Fonte: 36氪)

🧰 Ferramentas

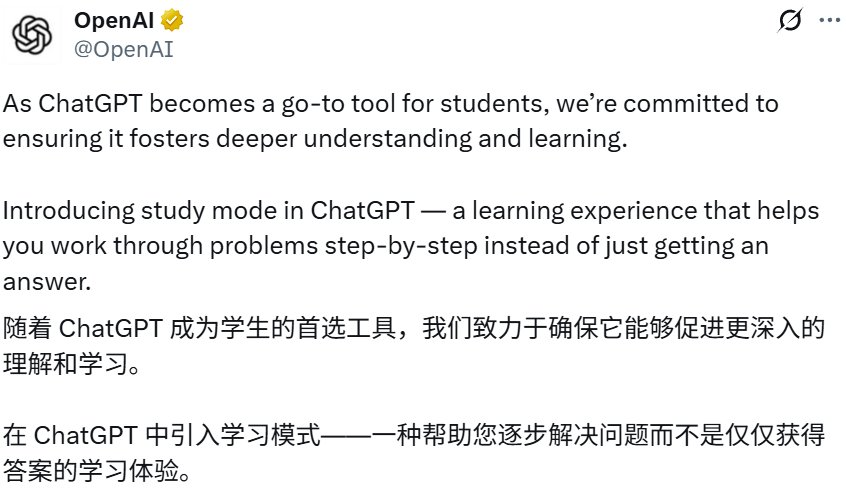

ChatGPT lança “Modo de Aprendizagem”: A OpenAI lançou o “Modo de Aprendizagem” do ChatGPT, que visa ajudar os usuários a resolver problemas passo a passo, aprofundar a compreensão, em vez de dar respostas diretas, através de perguntas socráticas, perguntas orientadoras e feedback personalizado. Este modo está disponível para todos os usuários (incluindo usuários gratuitos), impulsionado por instruções de sistema personalizadas escritas em colaboração com especialistas em educação, com o objetivo de cultivar o pensamento crítico e a capacidade de autoaprendizagem, marcando uma exploração mais profunda do ChatGPT no campo das aplicações educacionais. (Fonte: 36氪)

Google NotebookLM adiciona recurso de visão geral de vídeo: O Google NotebookLM lançou o recurso de visão geral de vídeo, como uma alternativa visual à visão geral de áudio. Os usuários podem usar um apresentador de IA para gerar automaticamente resumos de vídeo curtos contendo imagens, gráficos, citações e dados, para uma exibição visual mais clara de conceitos complexos ou densos em texto, melhorando a eficiência de aprendizado e compreensão. Este recurso atualmente suporta inglês e desktop. (Fonte: Google)

Claude Code suporta trabalho em múltiplos diretórios: O Claude Code da Anthropic foi atualizado para suportar trabalho em múltiplos diretórios em uma única sessão, permitindo que os usuários insiram /add-dir para adicionar um diretório de trabalho. Este recurso melhora significativamente a conveniência das operações de base de código, permitindo a migração de código dentro ou entre projetos sem alternar sessões, e a capacidade de obter arquivos de memória ou regras externas, aprimorando a experiência de programação colaborativa do Agent. (Fonte: dotey)

Tongyi Lingma lança Qwen3-Coder: O Alibaba Cloud Tongyi Lingma lançou o modelo de programação de IA Qwen3-Coder, que os usuários podem usar gratuitamente nos plugins Tongyi Lingma AI IDE, VSCode e Jetbrains. O Qwen3-Coder melhora significativamente a velocidade e precisão da geração de código em cenários de desenvolvimento de nível empresarial real, e oferece uma melhor experiência de programação colaborativa de Agent. O modelo alcançou o topo da lista de modelos do HuggingFace e é considerado o modelo de programação de código aberto mais forte do mundo, comparável ao Claude4. (Fonte: 量子位)

BlockDL: Construtor visual de redes neurais: BlockDL é uma ferramenta GUI gratuita e de código aberto que permite aos usuários projetar visualmente redes neurais Keras arrastando e soltando módulos, e fornece geração instantânea de código e validação de forma em tempo real, ajudando os desenvolvedores a criar designs criativos rapidamente e evitar erros iniciais. A ferramenta também inclui um sistema de aprendizado completo, suportando estruturas avançadas como skip connections e modelos multi-entrada/saída. (Fonte: fchollet)

PopAi AI Slides Agent: A PopAi lançou o AI Slides Agent, onde os usuários podem gerar automaticamente belos slides de PPT com apenas um prompt, usando um Agent de IA. Esta ferramenta visa entender as ideias do usuário através de IA, para criar slides de forma inteligente, rápida e fácil, melhorando significativamente a eficiência da produção de apresentações. (Fonte: kaifulee)

📚 Aprendizagem

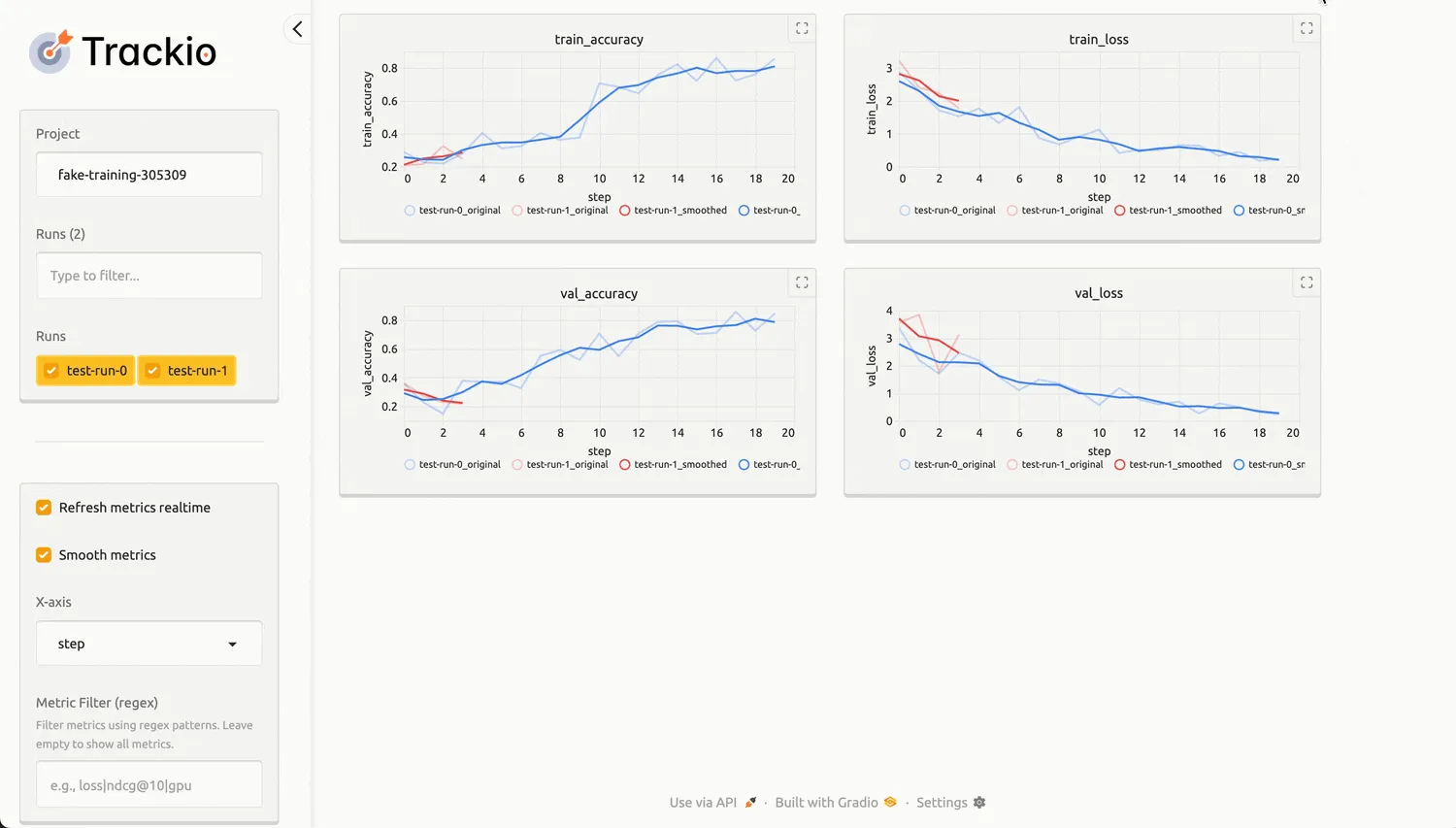

Hugging Face lança a biblioteca leve de rastreamento de experimentos Trackio: A Hugging Face lançou a biblioteca Python de código aberto Trackio, com o objetivo de fornecer uma solução leve e local para o rastreamento de experimentos de aprendizado de máquina. O Trackio é compatível com a API wandb, suporta o compartilhamento fácil do progresso do treinamento, gráficos incorporados e a padronização do registro transparente de métricas como o consumo de energia da GPU. Ele é construído com base no Gradio e no Hugging Face Spaces, facilitando a visualização e o compartilhamento dos resultados dos experimentos, e pode ser integrado nativamente com as bibliotecas Transformers e Accelerate. (Fonte: HuggingFace Blog)

Aplicação de LangChain e LangGraph na engenharia de contexto: LangChain e LangGraph oferecem vários métodos de engenharia de contexto para ajudar os desenvolvedores a otimizar o desempenho de aplicações LLM. LangGraph, através de sistemas multi-Agent, ajudou empresas (como Bertelsmann) a reduzir o tempo de descoberta de conteúdo de horas para segundos, permitindo a implantação de Agents especializados em diferentes domínios de conteúdo e a reutilização modular de API. O novo recurso Align Evals do LangSmith também simplifica a construção de avaliadores LLM-as-judge, tornando suas pontuações mais alinhadas com as preferências humanas. (Fonte: LangChainAI)

Geração de problemas matemáticos LLM e aumento da complexidade: O projeto SAND-Math propõe um pipeline para gerar problemas e soluções matemáticas novos, difíceis e úteis através de LLM. Este método primeiro gera problemas de alta qualidade e, em seguida, aumenta sistematicamente sua complexidade através de uma etapa de “aumento de dificuldade”. O algoritmo EDGE-GRPO alivia efetivamente o problema de colapso de vantagem no aprendizado por reforço através de “vantagem orientada por entropia” e “correção de erro guiada”, melhorando o desempenho de inferência do LLM. O framework MaPPO, por sua vez, aprimora o alinhamento do LLM com as preferências humanas ao integrar o conhecimento de recompensa prévio no objetivo de otimização. Essas pesquisas impulsionam conjuntamente o progresso do LLM nos campos de raciocínio matemático e aprendizado por reforço. (Fonte: HuggingFace Daily Papers)

CIRCLE: Um benchmark de segurança para interpretadores de código LLM: CIRCLE (Code-Interpreter Resilience Check for LLM Exploits) é um benchmark simples para avaliar os riscos de segurança cibernética em nível de sistema de interpretadores de código LLM. Ele contém 1260 prompts direcionados ao esgotamento de recursos de CPU, memória e disco, com o objetivo de avaliar se o LLM recusa ou gera código perigoso, e executa o código no ambiente do interpretador para avaliar sua correção ou tempo limite. Os testes revelaram vulnerabilidades significativas e inconsistentes em modelos comerciais, especialmente com defesas enfraquecidas sob prompts indiretos e de engenharia social. (Fonte: HuggingFace Daily Papers)

Alinhamento de objetivos em simuladores de usuário LLM: A pesquisa revela as limitações dos simuladores de usuário LLM atuais em manter um comportamento orientado a objetivos em diálogos de várias rodadas. O framework User Goal State Tracking (UGST) foi proposto para rastrear o progresso dos objetivos do usuário e desenvolver simuladores de usuário capazes de rastrear objetivos autonomamente e gerar respostas alinhadas a eles. Este método melhorou significativamente o desempenho de alinhamento de objetivos nos benchmarks MultiWOZ 2.4 e τ-Bench. (Fonte: HuggingFace Daily Papers)

Tutorial de ajuste fino de modelos de preenchimento de código LLM: A Oxen.ai lançou uma série de tutoriais sobre como ajustar modelos de preenchimento de código “tab tab” rápidos e locais para notebooks Marimo. O objetivo é criar modelos de código aberto que ofereçam uma experiência de preenchimento de código semelhante ao Cursor, suportando execução local ou acesso via API gratuita. Experimentos iniciais mostram que os modelos Qwen e Llama ajustados já alcançaram desempenho de nível GPT-4 no conjunto de dados MBPP. (Fonte: Reddit r/MachineLearning)

Novos avanços na teoria de redes neurais e aprendizado de representação: Em resposta à crescente rigorosidade no design de arquiteturas de redes neurais, um estudante de doutorado busca recomendações de livros de matemática para guiar a pesquisa teoricamente, em vez de apenas por intuição. Ao mesmo tempo, a comunidade discutiu as últimas ideias em aprendizado de representação, incluindo aprendizado Matryoshka e aprendizado contrastivo, e busca novas “técnicas” de redes neurais dos últimos 2-3 anos para construir melhores representações, abrangendo problemas de aprendizado não supervisionado e supervisionado. Além disso, o framework X-Omni aprimorou modelos de geração de imagens autorregressivos discretos através de aprendizado por reforço, alcançando uma integração perfeita de geração de imagem e linguagem. (Fonte: Reddit r/MachineLearning)

💼 Negócios

Impacto da IA no mercado de trabalho polarizado: A IA está mudando significativamente o mercado de trabalho, especialmente em termos de contratação e demissão. O setor de tecnologia viu cerca de 80.000 demissões devido à automação por IA (como o plano da Microsoft de demitir 15.000 pessoas), enquanto a demanda por habilidades de IA fora do setor de tecnologia disparou, com salários relacionados a essas habilidades atingindo um prêmio de 28%, um aumento médio anual de quase US$ 18.000. Áreas como marketing, recursos humanos e finanças estão integrando rapidamente ferramentas de IA, e habilidades compostas de IA (como comunicação e liderança) são altamente valorizadas. (Fonte: 36氪)

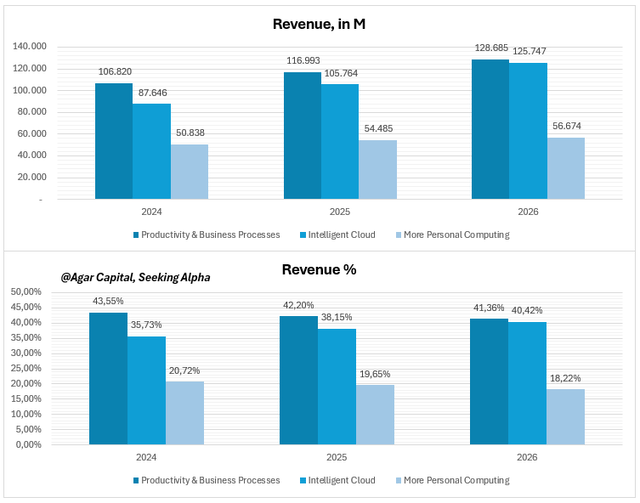

Previsão de resultados do 4º trimestre da Microsoft: IA aumenta as margens de lucro, não é uma aposta arriscada: A estratégia de IA da Microsoft evoluiu de tecnologia de ponta para infraestrutura econômica. A IA foi profundamente integrada aos negócios principais como Azure Cloud, Copilot e Office, e começou a gerar retornos. As cargas de trabalho de IA impulsionaram o crescimento do Azure Cloud em 34% ano a ano, e os usuários corporativos do Copilot atingiram 200.000, com o ARPU acelerando. Analistas acreditam que a Microsoft está subestimada, e suas altas margens de lucro e fluxo de caixa provam que a IA se tornou uma “superpotência” monetizável, e não apenas uma história. (Fonte: 36氪)

Comercialização de AI Agent: Quem pode se tornar uma “vaca leiteira”?: A WAIC 2025 mostra que o AI Agent evoluiu do conceito para a implementação, especialmente em serviços empresariais, inteligência industrial, fintech e hardware inteligente. Plataformas de Agent lucrativas geralmente têm um alto valor de pedido por cliente (taxa anual de mais de 500.000), altas margens de lucro (≥60%), e monetizam através de modos avançados como “vender entrada” (vinculação em nível de sistema), “divisão de resultados” (comissão por economia) e “vender por unidade de recurso” (mão de obra de IA em nuvem). As barreiras centrais residem na profunda integração nos processos de negócios, conformidade com as regulamentações do setor e capacidade de integração com sistemas legados. (Fonte: 36氪)

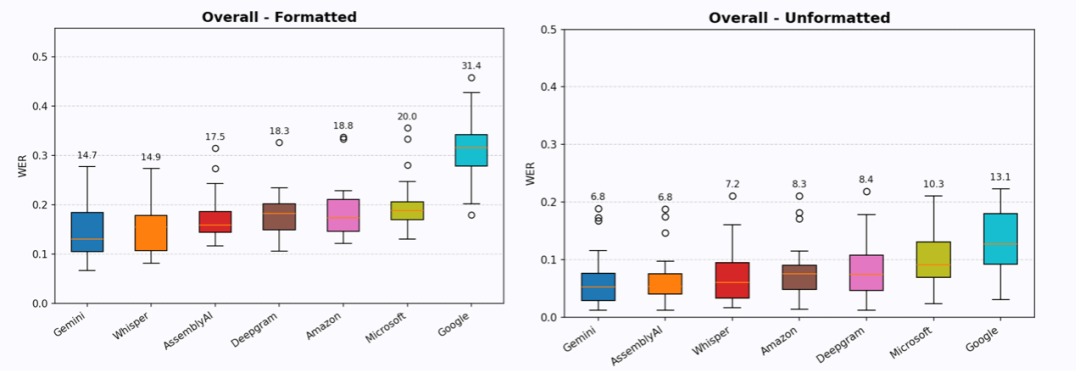

Setor de entrada de voz por IA recebe milhões de dólares em financiamento: As startups de entrada de voz Willow Voice e Wispr Flow recentemente concluíram rodadas de financiamento de US$ 4,2 milhões (seed) e US$ 30 milhões (Série A), respectivamente, demonstrando o foco do capital na “entrada” de voz por IA, e não na “saída”. Essas empresas visam fornecer serviços de conversão de voz para texto com “informações sem edição”, produzindo texto diretamente utilizável através de formatação, compreensão de contexto e reconhecimento de contexto. Embora ainda haja uma lacuna, sua alta retenção de usuários e taxa de pagamento indicam que a entrada de voz tem um enorme potencial para reduzir o atrito na interação humano-máquina e melhorar a eficiência, com a possibilidade de substituir o teclado como um novo paradigma de interação humano-máquina. (Fonte: 36氪)

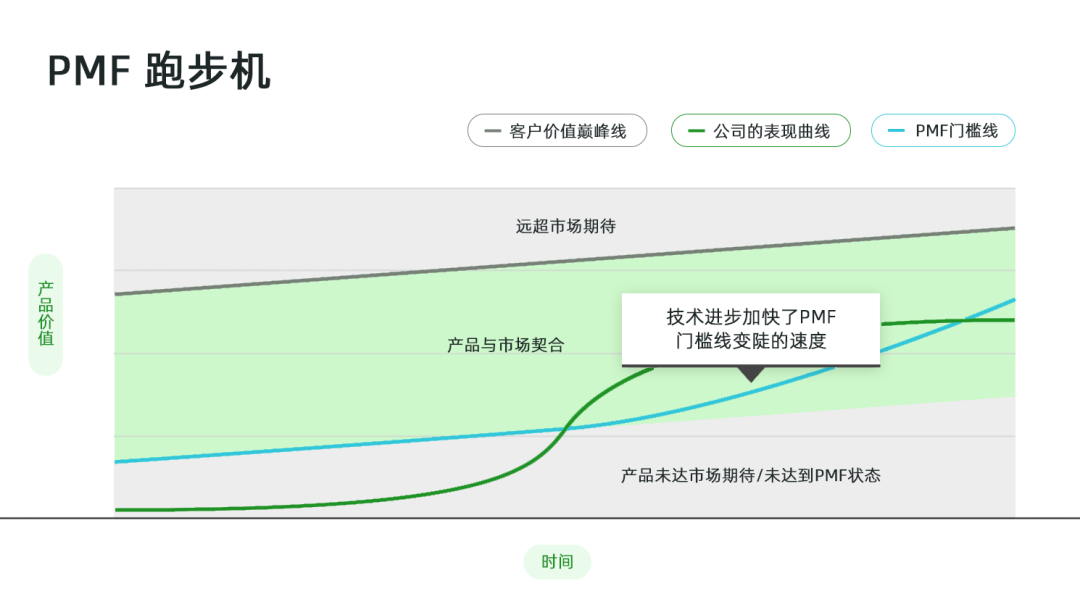

O impacto acelerado da IA no Product-Market Fit (PMF): Na era da IA, o PMF se transforma de um marco estático em uma esteira acelerada. A proliferação de ferramentas de IA acelera a velocidade com que os produtos são substituídos, e as expectativas dos usuários crescem exponencialmente, aumentando o risco de “perda de PMF”. As empresas precisam monitorar de perto as mudanças nas expectativas dos usuários, usando ferramentas de IA para agregar feedback; avaliar o nível de risco de perda de PMF, como canais de uso do produto, frequência, domínio do fluxo de trabalho de criação, dados proprietários e aceitação de novas tecnologias pelos clientes; e ajustar a estratégia do produto de acordo, investindo mais recursos na expansão do PMF ou na busca por um novo PMF. (Fonte: 36氪)

GMI Cloud demonstra força em infraestrutura de IA na WAIC2025: A GMI Cloud, como provedora líder global de serviços AI Native Cloud, demonstrou sua força em infraestrutura de IA na WAIC2025. Seus produtos principais incluem serviços de GPU Cloud (baseados em chips de ponta como H200, B200), Cluster Engine e Inference Engine, visando fornecer infraestrutura de IA segura e eficiente para empresas. A GMI Cloud também lançou uma calculadora de custo de construção de aplicações de IA e uma experiência prática com o Inference Engine, ajudando os desenvolvedores a planejar com precisão e implementar eficientemente aplicações de IA, especialmente em mercados estrangeiros. (Fonte: 量子位)

🌟 Comunidade

Fases de “pré-treinamento” e “pós-treinamento” de modelos de IA: A mídia social discute a divisão do treinamento de modelos de IA em “Pretraining” e “Post-training”. O pré-treinamento é comparado a um maratonista calculando precisamente cada segmento e cada grama de água, sendo uma ciência elegante, realizada por matemáticos e engenheiros de sistemas distribuídos em larga escala; o pós-treinamento é descrito como “pesquisa de cowboy emocionante”, mais experimental e exploratória, sugerindo os desafios e a natureza não padronizada que enfrenta na aplicação prática. (Fonte: natolambert)

Rápido desenvolvimento e desafios dos vídeos gerados por IA: A mídia social está em polvorosa com o rápido progresso dos vídeos gerados por IA, como os modelos Runway Aleph e Alibaba Wan 2.2. Os usuários se surpreendem com o fato de que “o vídeo mudou para sempre”, sendo possível transformar facilmente imagens estáticas em cenas dinâmicas, e até mesmo alcançar efeitos visuais de nível cinematográfico. No entanto, alguns usuários apontam as deficiências dos vídeos de IA na expressão emocional e controle de ritmo, bem como a alta demanda por recursos computacionais, e discutem o fenômeno de “Will Smith comendo macarrão” como um benchmark não oficial para a geração de vídeo por IA, refletindo a contínua atenção da comunidade à qualidade e realismo dos vídeos de IA. (Fonte: c_valenzuelab)

Excesso de produção de conteúdo por IA e mudança de valor: Discussões sociais apontam que, com as ferramentas de criação de IA reduzindo a barreira de produção, a geração de conteúdo de texto longo de alta qualidade se torna fácil, levando a um “excesso de oferta”. Isso faz com que a curadoria, validação, contextualização e capacidade de síntese se tornem mais valiosas, enquanto “gosto, teoria da mente e discernimento” se tornam cruciais. Alguns temem que isso leve a uma “mediocridade generalizada”, mas outros acreditam que a IA pode acelerar o trabalho e inspirar mais pessoas a participar da criação. (Fonte: nptacek)

Debate sobre a segurança de APIs de IA e modelos de peso aberto: Clement Delangue, CEO da Hugging Face, questiona a afirmação de que “a implantação de APIs de IA é mais responsável do que modelos de peso aberto”, argumentando que as APIs, ao reduzir a barreira de uso, podem, na verdade, aumentar significativamente o número de agentes maliciosos, sem obter mais controle. Ele pede o fim da retórica de que “pesos abertos são inseguros”, acreditando que a facilidade de uso das APIs pode trazer uma exposição a riscos maior. (Fonte: ClementDelangue)

Discussão sobre paralelização e aumento de eficiência do AI Agent: A comunidade discute se a paralelização do AI Agent pode aumentar significativamente a eficiência. Alguns comparam com “nove mulheres não podem ter um bebê em um mês”, argumentando que algumas tarefas são inerentemente sequenciais e difíceis de paralelizar. No entanto, outros apontam que, através de múltiplos Agents trabalhando em diferentes ramos/tarefas em paralelo, a eficiência pode ser melhorada, especialmente ao lidar com outros problemas enquanto se espera pela resposta de um Agent. A discussão também menciona a Lei de Amdahl, que afirma que a eficiência da paralelização depende da natureza da tarefa, e enfatiza que os Agents são de baixo custo, e mesmo a paralelização parcial pode trazer ganhos de eficiência. (Fonte: Reddit r/ClaudeAI)

Lançamento da AGI e preocupações com o controle: A comunidade está em intenso debate sobre se a AGI será lançada publicamente. A maioria acredita que a empresa ou país que primeiro descobrir/criar a AGI a manterá em segredo estrito para obter uma enorme vantagem, e não a lançará publicamente facilmente. Os preocupados acreditam que o surgimento da AGI pode levar à perda de controle, ou até mesmo superar as expectativas humanas. Alguns também apontam que as empresas buscam lucro e a comercializarão, enquanto os governos podem assumir o controle imediatamente. (Fonte: Reddit r/ArtificialInteligence)

Confiabilidade do LLM e fenômeno da “alucinação”: A comunidade discute a confiabilidade do LLM, com alguns comparando-o ao botão “Estou com sorte” do Google, acreditando que as respostas do LLM às vezes são puramente por acaso. Outros usuários compartilharam experiências de saídas anormais “dissociativas” do Gemini 2.5, levantando preocupações sobre a estabilidade do modelo e o fenômeno da “alucinação”. Essa incerteza significa que os usuários ainda precisam verificar cuidadosamente a saída do LLM. (Fonte: Reddit r/ArtificialInteligence)

IA e a redefinição de papéis e títulos de carreira humanos: Elon Musk, na xAI, anunciou a abolição do termo “researcher”, mantendo apenas “engineer”, argumentando que “researcher” é um resquício do mundo acadêmico e enfatizando a contribuição de engenharia prática. Essa visão gerou discussão na comunidade, com alguns concordando que, no final, todos deveriam ser engenheiros, mas outros refutando a importância da pesquisa para a engenharia e questionando se essa prática poderia levar à perda de talentos. (Fonte: Yuchenj_UW)

Impacto da IA no trabalho do Product Manager (PM): A mídia social discute o impacto da IA no trabalho do Product Manager, apontando que a IA está remodelando o processo de desenvolvimento de produtos. Alguns acreditam que a codificação por IA tem um impacto limitado nas equipes de engenharia, mas nas equipes de produto e design, a IA acelera enormemente a velocidade de iteração através da prototipagem. PMs de IA compartilharam como construir produtos para lidar com as mudanças trazidas pela IA, enfatizando que o gerenciamento de produtos não é mais “codificar por intuição”, mas requer gerenciamento cuidadoso. (Fonte: amasad)

Discussão sobre IA e a futura forma da sociedade: A comunidade discute se a IA pode trazer um futuro sem dinheiro e trabalho. Alguns acreditam que a IA pode automatizar a maior parte do trabalho, liberando os humanos para se concentrarem no autodesenvolvimento e conexão, mas alcançar essa utopia requer uma mudança em larga escala de valores, acesso e propriedade, e não apenas tecnologia. Outros temem que esse futuro possa levar ao abuso de poder pelos controladores da IA, ou que a própria IA desenvolva objetivos inesperados. (Fonte: Reddit r/ArtificialInteligence)

💡 Outros

Relação simbiótica entre IA e computação quântica: Quantinuum e Google DeepMind revelaram a realidade da relação simbiótica entre a computação quântica e a IA. As capacidades únicas da computação quântica fornecem um novo paradigma computacional para modelos de IA, enquanto a IA pode otimizar algoritmos quânticos e design de hardware. A combinação dos dois promete avanços na resolução de problemas complexos e processamento de dados, impulsionando o desenvolvimento de tecnologia de ponta. (Fonte: Ronald_vanLoon)

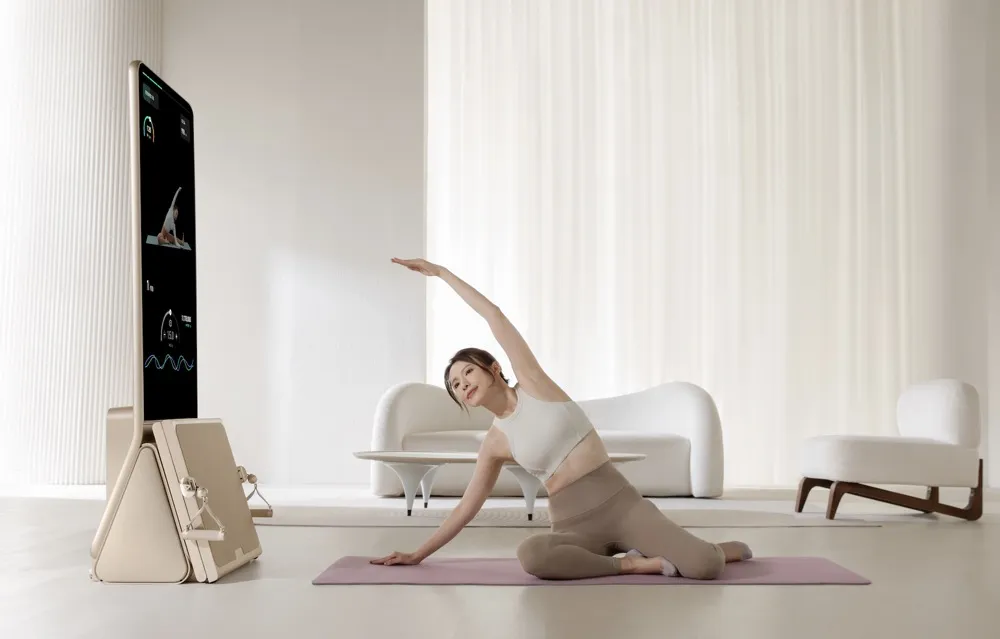

Equipamento de fitness inteligente AEKE conquista o mercado doméstico de alto padrão: A empresa de Shenzhen AEKE, com seu equipamento de fitness inteligente Smart Home Gym K1, com preço unitário de 20.000 yuans, alcançou milhões de yuans em receita em uma plataforma de crowdfunding internacional em um mês. Este produto foca em treinamento de força e Pilates, oferecendo uma solução integrada de hardware e software, equipada com tela sensível ao toque 4K, tecnologia de motor servo digital desenvolvida internamente e sistema de personal trainer de IA, para planos de treinamento personalizados e correção de movimentos em tempo real. A AEKE visa o mercado de alto padrão, com foco em leveza, instalação sem complicações e posicionamento como peça de arte para casa, e melhora a retenção de usuários e a eficiência da expansão no mercado internacional através do sistema de personal trainer de IA. (Fonte: 36氪)

Resumo mensal da AIhub: Julho de 2025: A AIhub publicou seu resumo mensal de julho de 2025, cobrindo eventos importantes de IA como a competição de futebol de robôs RoboCup e a conferência de aprendizado de máquina ICML. O conteúdo inclui entrevistas e resumos das várias ligas da RoboCup (como RoboCupRescue, Small Size League, 3D Simulation League), palestras convidadas e prêmios da ICML, e uma introdução à plataforma de pesquisa de IA veicular da NASA, OnAIR. Além disso, aborda avanços na geração de texto para som e na utilização de feedback na interação humano-máquina. (Fonte: aihub.org)