Palavras-chave:OpenAI, LLM de raciocínio, Olimpíada Internacional de Matemática, Conjunto de dados de treinamento de IA, Privacidade de dados pessoais, Agente ChatGPT, Neutralidade política de modelos de IA, Kimi K2, Desempenho de nível medalha de ouro na IMO, Conjunto de dados DataComp CommonPool, Inteligência de agentes LLM, Ordem executiva de IA da Casa Branca, Arquitetura MoE

🔥 Em Foco

LLM experimental de raciocínio da OpenAI ganha medalha de ouro na Olimpíada Internacional de Matemática: O mais recente LLM experimental de raciocínio da OpenAI alcançou uma pontuação no nível da medalha de ouro na Olimpíada Internacional de Matemática (IMO) de 2025, resolvendo 5 de 6 problemas. O modelo operou sob as mesmas regras que os humanos, incluindo um limite de tempo de 4,5 horas por problema, e não utilizou nenhuma ferramenta, produzindo provas em linguagem natural. Isso marca um avanço significativo no raciocínio matemático por IA, prenunciando o potencial da IA na descoberta científica. (Fonte: gdb, scaling01, dmdohan, SebastienBubeck, markchen90, npew, MillionInt, cloneofsimo, bookwormengr, tokenbender)

Conjunto de dados de treinamento de IA CommonPool contém milhões de dados pessoais: Pesquisadores descobriram que o DataComp CommonPool, um grande conjunto de dados de treinamento de IA de código aberto, contém milhões de imagens de passaportes, cartões de crédito, certidões de nascimento e outros documentos com informações de identificação pessoal (PII). Ao auditar 0,1% do CommonPool, os pesquisadores encontraram milhares de imagens contendo PIIs, estimando que o número total de tais imagens no conjunto de dados pode chegar a centenas de milhões. Isso levanta preocupações sobre a privacidade nos dados de treinamento de IA e pede à comunidade de aprendizado de máquina que repense as práticas indiscriminadas de web scraping. (Fonte: MIT Technology Review)

🎯 Tendências

OpenAI lança assistente pessoal ChatGPT Agent: A OpenAI lançou o ChatGPT Agent, um assistente pessoal que pode executar tarefas em nome do usuário construindo seu próprio “computador virtual”. Isso marca um passo significativo na inteligência de agentes LLM, mas o recurso ainda está em estágio inicial e a conclusão das tarefas pode levar algum tempo. (Fonte: MIT Technology Review, The Verge, Wired)

Casa Branca prepara ordem executiva exigindo que modelos de IA sejam “politicamente neutros e imparciais”: A Casa Branca está preparando uma ordem executiva exigindo que os modelos de IA sejam “politicamente neutros e imparciais”. A conformidade determinará a elegibilidade para contratos federais, o que é um grande negócio para todos os laboratórios de IA. A ordem executiva deve ser lançada na próxima semana. (Fonte: WSJ, MIT Technology Review, natolambert)

Kimi K2: Modelo de agente de IA com capacidade de uso de ferramentas: Lançado pela Kimi_Moonshot, o Kimi K2 é um modelo de agente de IA com capacidade de uso de ferramentas. Ele se destaca no uso de ferramentas, matemática, codificação e tarefas de várias etapas, atualmente classificado como o modelo de código aberto número 1 e o número 5 na classificação geral na Arena. O Kimi K2 adota uma arquitetura Mixture-of-Experts (MoE) em larga escala semelhante ao DeepSeek-V3, com 1 trilhão de parâmetros totais e 32 bilhões de parâmetros ativos. (Fonte: TheTuringPost)

🧰 Ferramentas

Servidor GitHub MCP conecta ferramentas de IA à plataforma GitHub: O servidor GitHub MCP permite que ferramentas de IA se conectem diretamente à plataforma GitHub, permitindo que agentes de IA, assistentes e chatbots leiam repositórios e arquivos de código, gerenciem problemas e PRs, analisem código e automatizem fluxos de trabalho, tudo por meio de interação em linguagem natural. (Fonte: GitHub Trending)

ik_llama.cpp: Fork do llama.cpp com melhor desempenho de CPU: ik_llama.cpp é um fork do llama.cpp com melhor desempenho de CPU e GPU/CPU híbrido, novos tipos de quantização SOTA, suporte Bitnet de primeira classe, DeepSeek aprimorado por meio de MLA, FlashMLA, operações MoE fundidas e substituição de tensor, e empacotamento de quantização intercalado por linhas para inferência GPU/CPU híbrida. (Fonte: GitHub Trending)

📚 Aprendizado

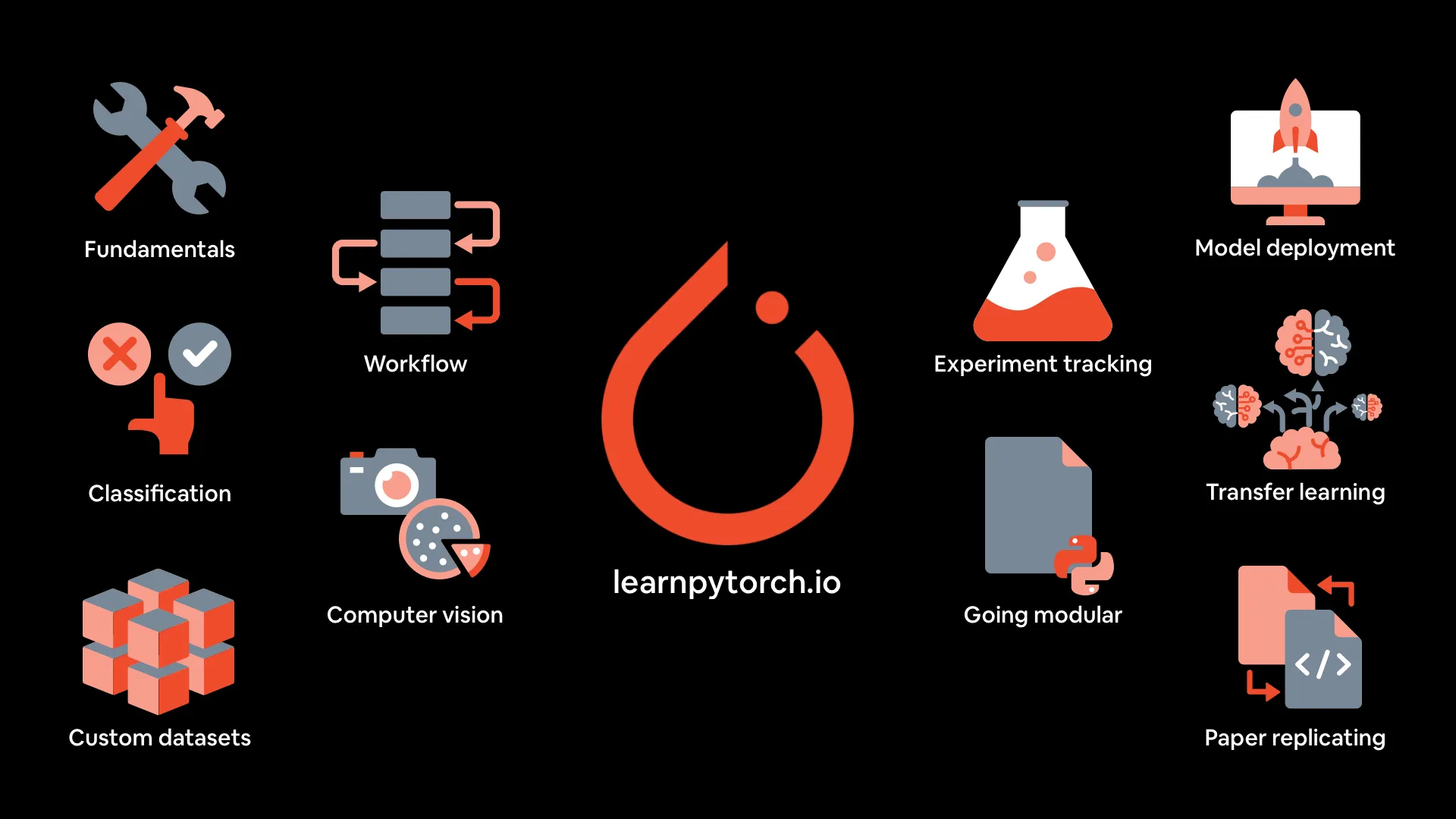

Materiais do curso de Deep Learning com PyTorch: mrdbourke/pytorch-deep-learning fornece os materiais para o curso “Aprendendo Deep Learning com PyTorch do zero”, incluindo uma versão online do livro, vídeos das cinco primeiras partes no YouTube, exercícios e cursos adicionais. O curso enfatiza a prática e a experimentação com código, cobrindo fundamentos do PyTorch, fluxos de trabalho, classificação de redes neurais, visão computacional, conjuntos de dados personalizados, aprendizado de transferência, rastreamento de experimentos e implantação de modelos. (Fonte: GitHub Trending)

MIT Press oferece três livros gratuitos sobre algoritmos e aprendizado de máquina: A MIT Press está oferecendo gratuitamente três livros sobre teoria de algoritmos e algoritmos principais de aprendizado de máquina: The Algorithm Design Manual, Algorithms for Decision Making e Algorithms for Verification. Esses livros são ótimos para um mergulho profundo em algoritmos e aprendizado de máquina. (Fonte: TheTuringPost, TheTuringPost)

Transformers baseados em energia são aprendizes e pensadores escaláveis: Um artigo explora Energy-Based Transformers (EBTs), uma nova classe de Modelos Baseados em Energia (EBMs) que aprendem a verificar explicitamente a compatibilidade entre entradas e previsões candidatas, reformulando o problema de previsão como otimização sobre este verificador, permitindo o aprendizado de “pensamento” apenas a partir do aprendizado não supervisionado. (Fonte: )

🌟 Comunidade

Lições aprendidas com a engenharia de contexto para LLMs: A equipe ManusAI compartilhou suas lições aprendidas sobre a construção de engenharia de contexto para agentes de IA, destacando a importância do cache KV, sistemas de arquivos, rastreamento de erros, etc., no design de agentes. (Fonte: dotey, AymericRoucher, vllm_project)

Comparação de desempenho do Kimi K2 vs. Gemini no mundo real: ClementDelangue e jeremyphoward retweetaram pash, apontando que o Kimi K2 superou o Gemini em tarefas do mundo real, com dados de gráficos para apoiar a afirmação. (Fonte: ClementDelangue, jeremyphoward)

Pontuação de medalha de ouro da OpenAI na IMO foi uma surpresa: O resultado da medalha de ouro do LLM da OpenAI na IMO pegou muitos de surpresa, gerando discussões generalizadas na comunidade. (Fonte: kylebrussell, VictorTaelin)

💼 Negócios

Anthropic limita o uso do Claude Code: A Anthropic limitou o uso do Claude Code sem informar os usuários, causando reclamações e preocupações sobre produtos fechados. (Fonte: jeremyphoward, HamelHusain)

Meta se recusa a assinar o pacto europeu de IA: A Meta se recusou a assinar o pacto europeu de IA, alegando que é intrusivo demais e prejudicará o desenvolvimento da IA. (Fonte: Reddit r/artificial, Reddit r/ArtificialInteligence)

💡 Outros

Como executar um LLM em seu laptop: A MIT Technology Review publicou um guia sobre como executar um Large Language Model (LLM) em seu laptop, fornecendo etapas e conselhos para usuários preocupados com a privacidade, que desejam escapar do controle das grandes empresas de LLM ou que gostam de experimentar. (Fonte: MIT Technology Review, MIT Technology Review)

Uma breve história dos “bebês de três pais”: A MIT Technology Review revisou a história dos “bebês de três pais”, cobrindo as diferentes abordagens da tecnologia, as controvérsias e os últimos desenvolvimentos de pesquisa, incluindo o nascimento de oito bebês em um ensaio no Reino Unido. (Fonte: MIT Technology Review, MIT Technology Review)

Como encontrar valor em agentes de IA desde o primeiro dia: Este artigo explora como as empresas podem encontrar valor em agentes de IA, sugerindo que as empresas adotem uma mentalidade iterativa, comecem com “frutas ao alcance da mão” e casos de uso incrementais e priorizem a interoperabilidade para se preparar para futuros sistemas multiagentes. (Fonte: MIT Technology Review)