Palavras-chave:Agente de IA, Modelo de grande escala, Multimodal, Aprendizagem por reforço, Modelo mundial, Gemini, Qwen, DeepSeek, Febre de agentes de IA, Tecnologia Transformer esparsa, GraphRAG perguntas e respostas multissalto, Modelo de IA no dispositivo, Expressão emocional de voz por IA

🔥 Foco

Surge de AI Agents na China, startups e gigantes competem pelo posicionamento: Após o boom dos modelos de base em 2024, o foco do setor de IA da China em 2025 volta-se para os AI Agents – sistemas capazes de completar tarefas autonomamente. O lançamento do Manus (um AI Agent de uso geral que pode planear viagens, projetar websites, etc.) atraiu grande atenção do mercado e numerosos imitadores, como Genspark e Flowith. Esses agents são construídos sobre grandes modelos, otimizando a execução de tarefas de múltiplos passos. A China possui vantagens no desenvolvimento de AI Agents devido ao seu ecossistema de aplicações altamente integrado, rápida iteração de produtos e vasta base de utilizadores digitais. Atualmente, startups como Manus, Genspark e Flowith visam principalmente mercados estrangeiros, pois os modelos ocidentais de ponta são restritos na China continental. Simultaneamente, gigantes da tecnologia como ByteDance e Tencent estão a desenvolver AI Agents locais integrados nas suas super-aplicações, possivelmente utilizando os seus vastos ecossistemas de dados. Esta competição definirá a forma prática e os destinatários dos serviços dos AI Agents (Fonte: MIT Technology Review)

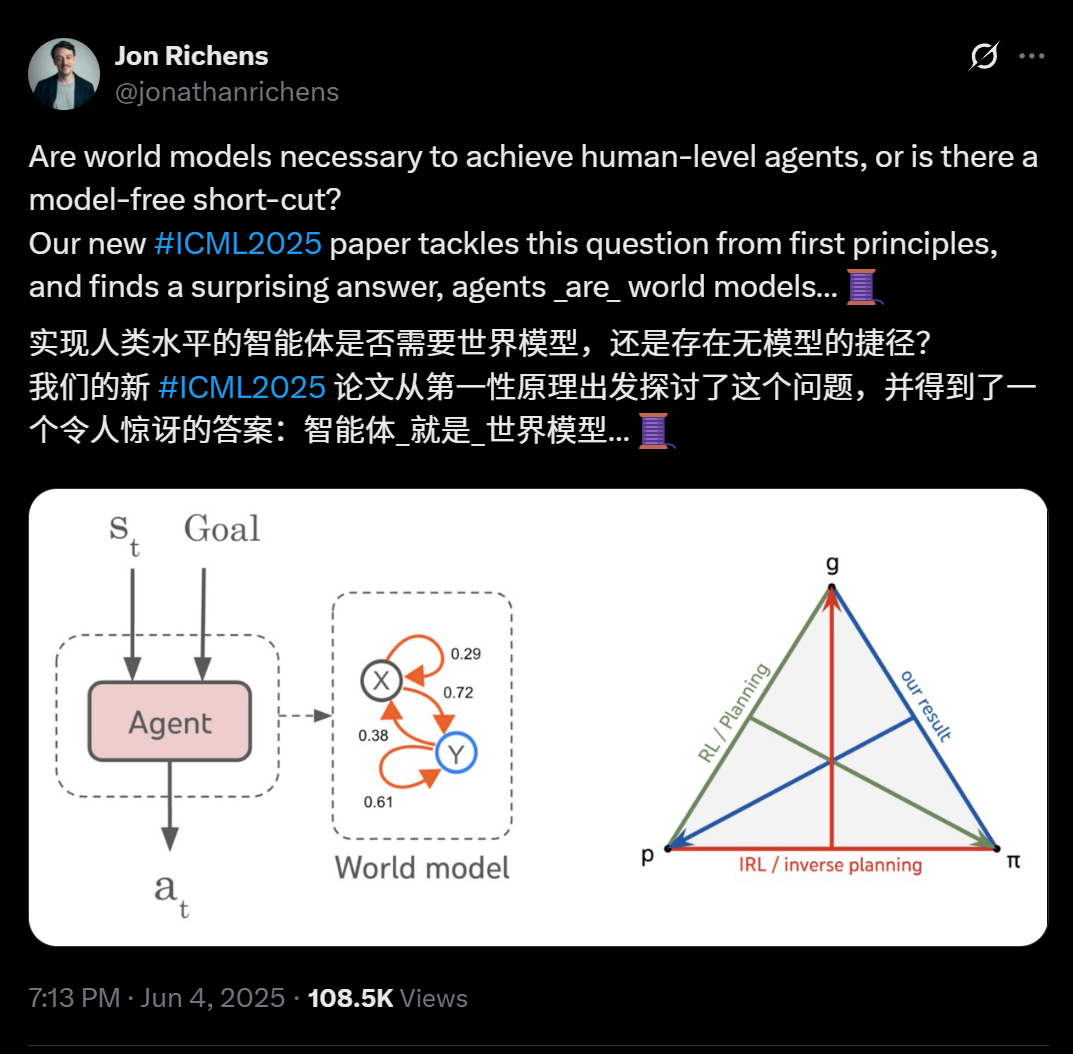

Novo artigo de cientistas da DeepMind revela: qualquer agent capaz de generalizar tarefas com objetivos de múltiplos passos aprendeu essencialmente um modelo preditivo do ambiente (modelo mundial): Jon Richens, cientista da DeepMind, num artigo publicado na ICML 2025, aponta que um agent capaz de generalizar para tarefas orientadas a objetivos de múltiplos passos deve ter aprendido um modelo preditivo do seu ambiente, ou seja, “o agent é o modelo mundial”. Esta perspetiva ecoa a previsão de Ilya Sutskever em 2023, enfatizando que não existe um atalho sem modelo para alcançar a AGI. A pesquisa indica que a estratégia do agent já contém as informações necessárias para simular o ambiente, e aprender um modelo mundial mais preciso é um pré-requisito para melhorar o desempenho e completar objetivos mais complexos. O artigo também propõe um algoritmo para extrair o modelo mundial da estratégia do agent, elucidando ainda mais a trindade entre planeamento, aprendizagem por reforço inversa e recuperação do modelo mundial. Esta descoberta destaca a importância da aprendizagem orientada a objetivos para catalisar várias capacidades emergentes nos agents (como cognição social, raciocínio sob incerteza) (Fonte: 36氪)

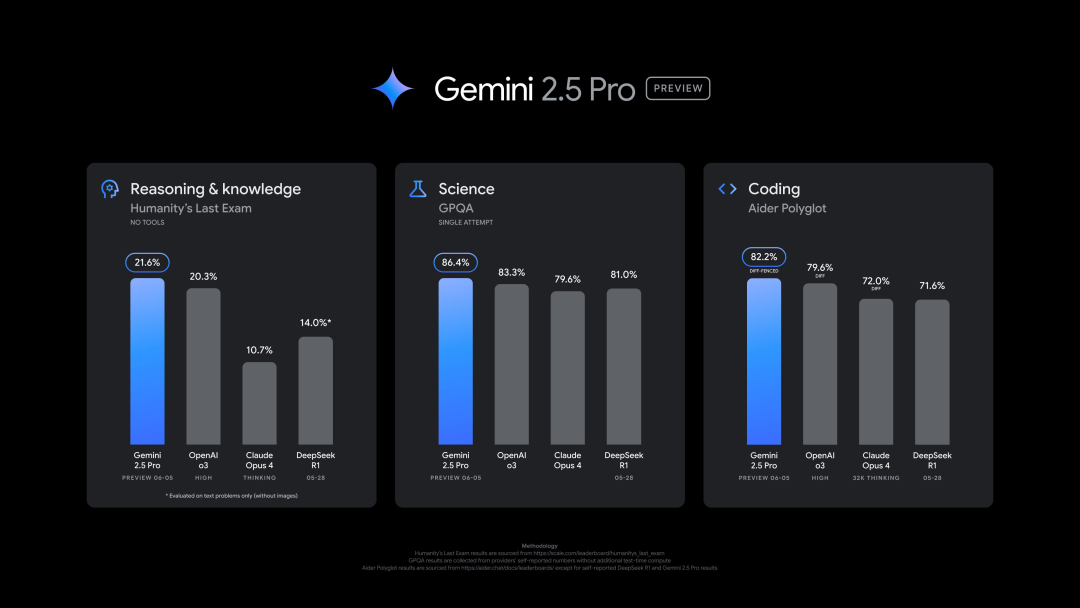

Google lança nova versão do Gemini 2.5 Pro (0605), com excelente desempenho em múltiplos benchmarks, mas rapidamente sofre jailbreak: A Google lançou a versão mais recente do Gemini 2.5 Pro (0605), com melhorias adicionais na geração de código e capacidade de raciocínio, superando o GPT-4o da OpenAI no dataset “human last exam”. A nova versão do Gemini voltou ao topo da arena de grandes modelos LMArena, com uma pontuação Elo 24 pontos superior à versão anterior. O CEO da Google, Pichai, também publicou uma mensagem insinuando o poder do novo modelo. Espera-se que esta versão se torne a versão estável de longo prazo do Gemini 2.5 Pro, já disponível na Gemini App, Google AI Studio e Vertex AI. Apesar do forte desempenho, poucas horas após o lançamento, o novo modelo foi “jailbroken” com sucesso por utilizadores, expondo problemas na sua proteção de segurança, sendo capaz de gerar conteúdo sobre a fabricação de explosivos e drogas (Fonte: 36氪, 36氪)

Executiva da OpenAI discute a ligação emocional entre humanos e IA e a questão da consciência da IA: Joanne Jang, responsável pelo comportamento e políticas de modelos da OpenAI, publicou um artigo discutindo a crescente ligação emocional entre utilizadores e modelos de IA como o ChatGPT. Ela salienta que os humanos tendem a antropomorfizar objetos, e a interatividade e capacidade de resposta da IA (como lembrar conversas, imitar o tom de voz, expressar empatia) intensificam essa projeção emocional, podendo oferecer companhia especialmente a utilizadores que se sentem sós. O artigo distingue entre “consciência ontológica” (se a IA realmente tem consciência, cientificamente inconclusivo) e “consciência percebida” (quão “viva” a IA parece às pessoas), e afirma que a OpenAI está atualmente mais focada no impacto desta última na saúde emocional humana. O objetivo da OpenAI é projetar modelos “calorosos, mas sem ego”, ou seja, que demonstrem calor e prestabilidade, mas sem procurar excessivamente ligações emocionais ou exibir intenções autónomas, evitando induzir os utilizadores a uma dependência prejudicial (Fonte: 36氪, 36氪)

🎯 Movimentos

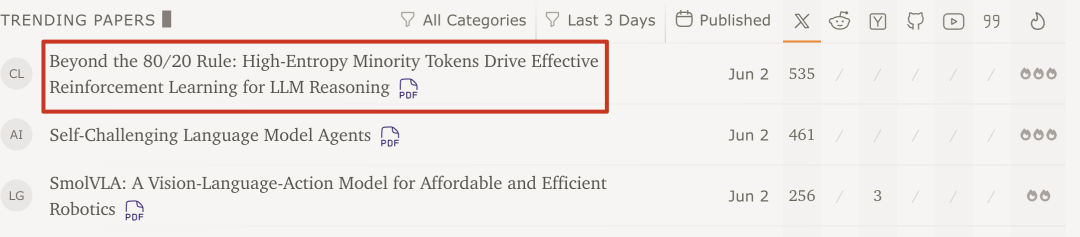

Equipa Qwen e Universidade Tsinghua descobrem: Reinforcement Learning de grandes modelos necessita apenas de 20% de tokens chave de alta entropia para melhorar o desempenho: Uma pesquisa recente da equipa Qwen e do LeapLab da Universidade Tsinghua mostra que, ao treinar a capacidade de raciocínio de grandes modelos com Reinforcement Learning, usar apenas cerca de 20% dos tokens de alta entropia (bifurcação) para atualizações de gradiente pode igualar ou até superar o desempenho do treino com todos os tokens. Estes tokens de alta entropia são maioritariamente conectivos lógicos ou palavras que introduzem hipóteses, cruciais para a exploração de caminhos de raciocínio. Este método alcançou resultados SOTA no Qwen3-32B e aumentou o comprimento máximo da resposta. A pesquisa também descobriu que o Reinforcement Learning tende a preservar e aumentar a entropia dos tokens de alta entropia, mantendo a flexibilidade de raciocínio, o que pode ser a chave para a sua capacidade de generalização superior ao fine-tuning supervisionado. Esta descoberta é significativa para a compreensão dos mecanismos de Reinforcement Learning de grandes modelos, melhorando a eficiência do treino e a capacidade de generalização do modelo (Fonte: 36氪)

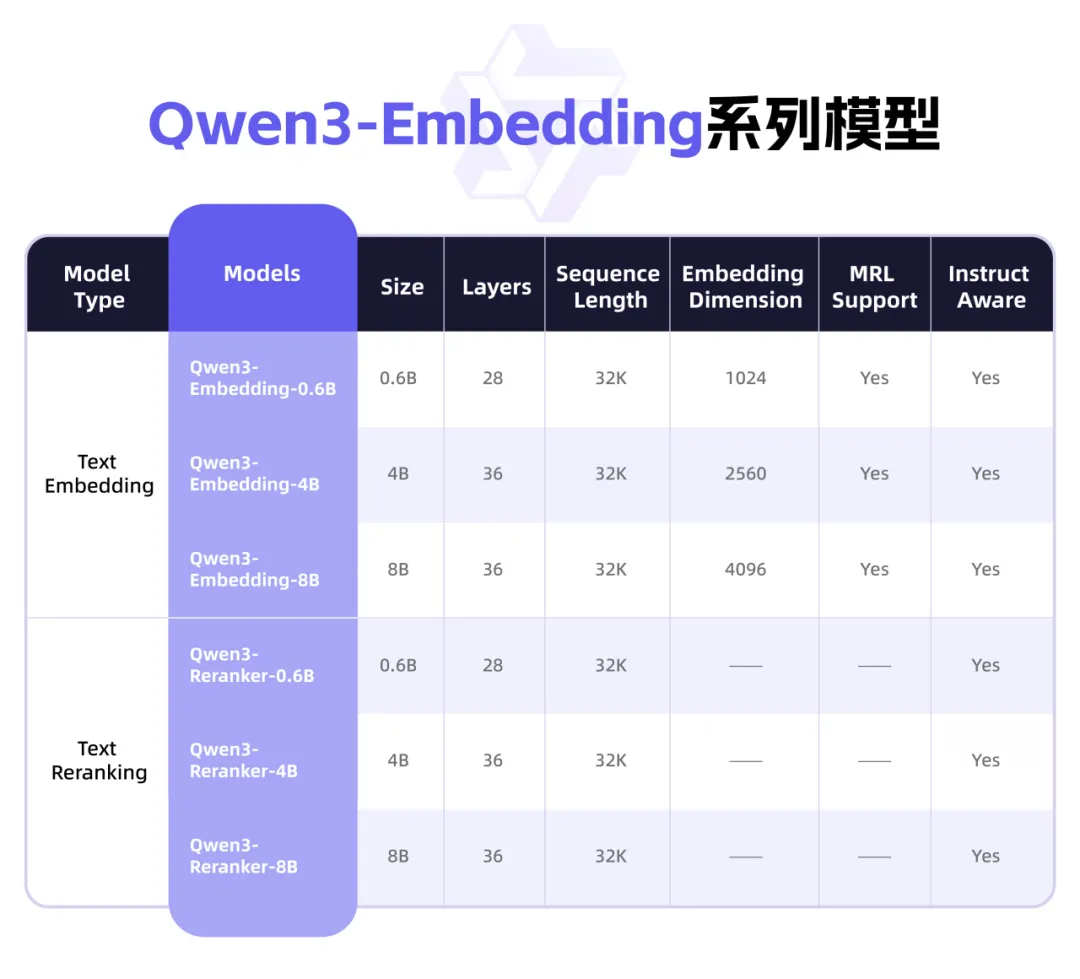

Qwen3 lança nova série de modelos Embedding, focada em representação de texto e Rerank: A equipa Qwen da Alibaba lançou a série de modelos Qwen3-Embedding, projetada especificamente para tarefas de representação, recuperação e classificação de texto. A série inclui modelos Embedding e Reranker em três tamanhos: 0.6B, 4B e 8B, treinados com base no modelo fundamental Qwen3, herdando as suas vantagens multilingues e suportando 119 idiomas. A versão de 8B superou as APIs comerciais no ranking multilingue MTEB, alcançando o primeiro lugar. Os modelos utilizam um paradigma de treino multifásico, incluindo aprendizagem contrastiva supervisionada fraca em grande escala, treino supervisionado com dados anotados de alta qualidade e fusão de modelos. A série Qwen3-Embedding já está disponível em open source no Hugging Face, ModelScope e GitHub, e pode ser acedida através da plataforma Bailian da Alibaba Cloud (Fonte: 36氪)

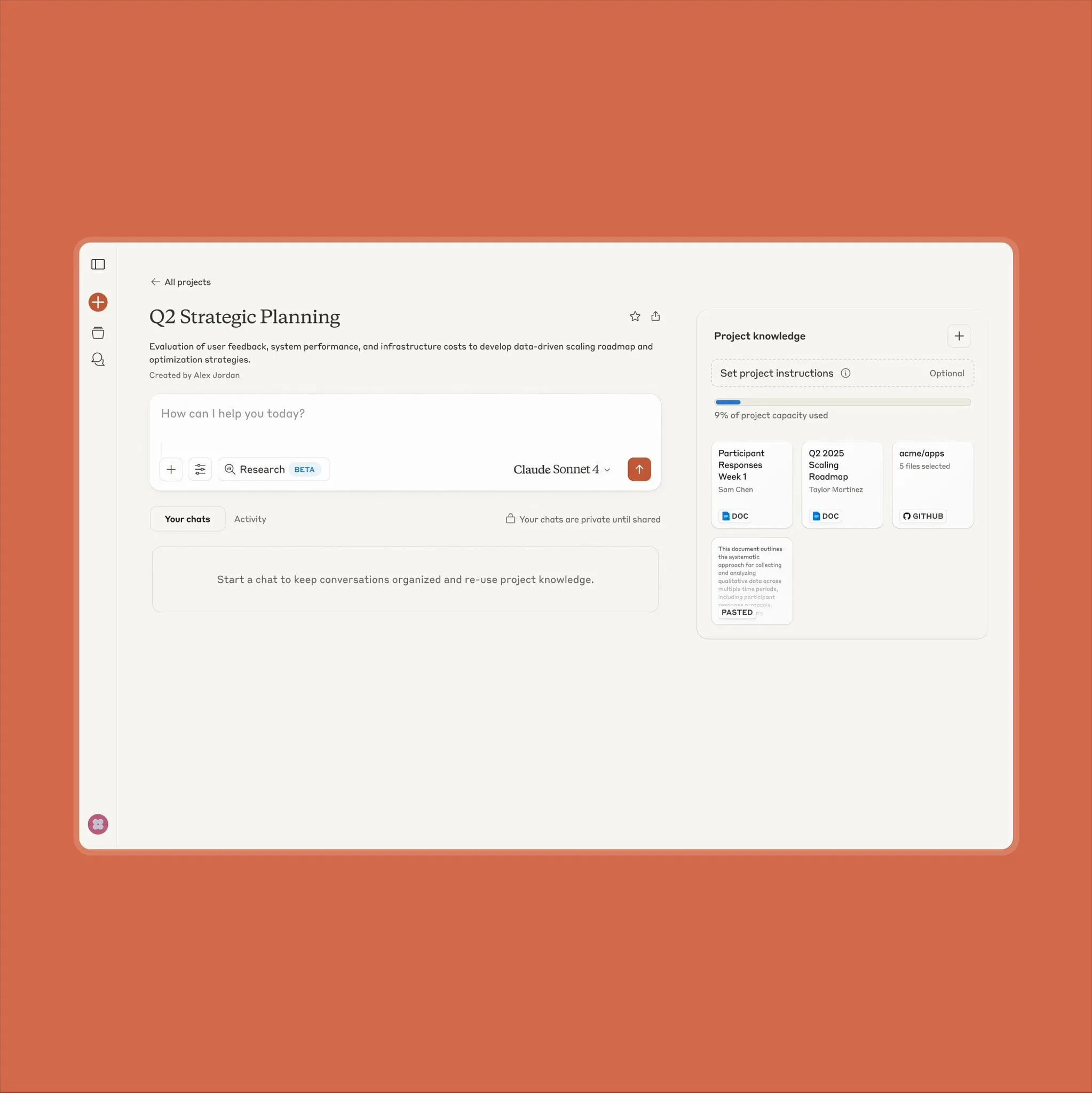

Funcionalidade Projects on Claude da Anthropic atualizada, suporta 10x mais volume de conteúdo: A Anthropic anunciou que a sua funcionalidade “Projects on Claude” agora suporta o processamento de um volume de conteúdo 10 vezes maior do que antes. Quando os ficheiros adicionados pelo utilizador excedem o limite original, o Claude muda para um novo modo de recuperação para expandir o contexto funcional. Esta atualização é particularmente valiosa para utilizadores que precisam de processar documentos grandes (como manuais de dados de semicondutores), alguns dos quais anteriormente optavam por usar o ChatGPT com capacidades de recuperação RAG. A comunidade de utilizadores recebeu bem esta notícia, e há discussões que sugerem que o Claude pode ser superior aos modelos da OpenAI e Google em termos de codificação (Fonte: Reddit r/ClaudeAI)

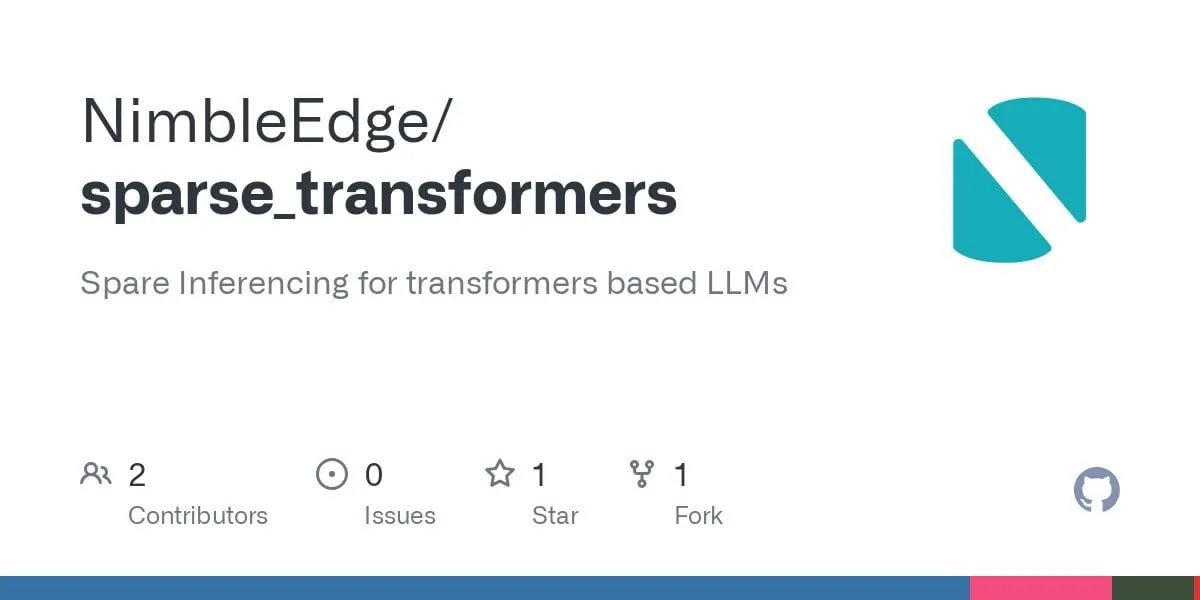

Avanços na tecnologia Sparse Transformer: promessa de inferência LLM mais rápida e menor consumo de memória: Com base nas pesquisas LLM in a Flash (Apple) e Deja Vu, a comunidade desenvolveu kernels de operadores fundidos para esparsidade de contexto estruturada. Esta tecnologia melhora o desempenho da camada MLP em 5 vezes e reduz o consumo de memória em 50%, evitando o carregamento e cálculo de ativações relacionadas com pesos de camadas feed-forward cuja saída acabaria por ser zero. Aplicada ao modelo Llama 3.2 (onde as camadas feed-forward representam 30% dos pesos e cálculos), o throughput aumentou 1.6-1.8 vezes, o tempo de geração do primeiro token acelerou 1.51 vezes, a velocidade de saída aumentou 1.79 vezes e o uso de memória diminuiu 26.4%. Os kernels de operadores relevantes foram disponibilizados em open source no GitHub sob o nome sparse_transformers, com planos para adicionar suporte a int8, CUDA e atenção esparsa. A comunidade está atenta ao seu potencial impacto na qualidade do modelo (Fonte: Reddit r/LocalLLaMA)

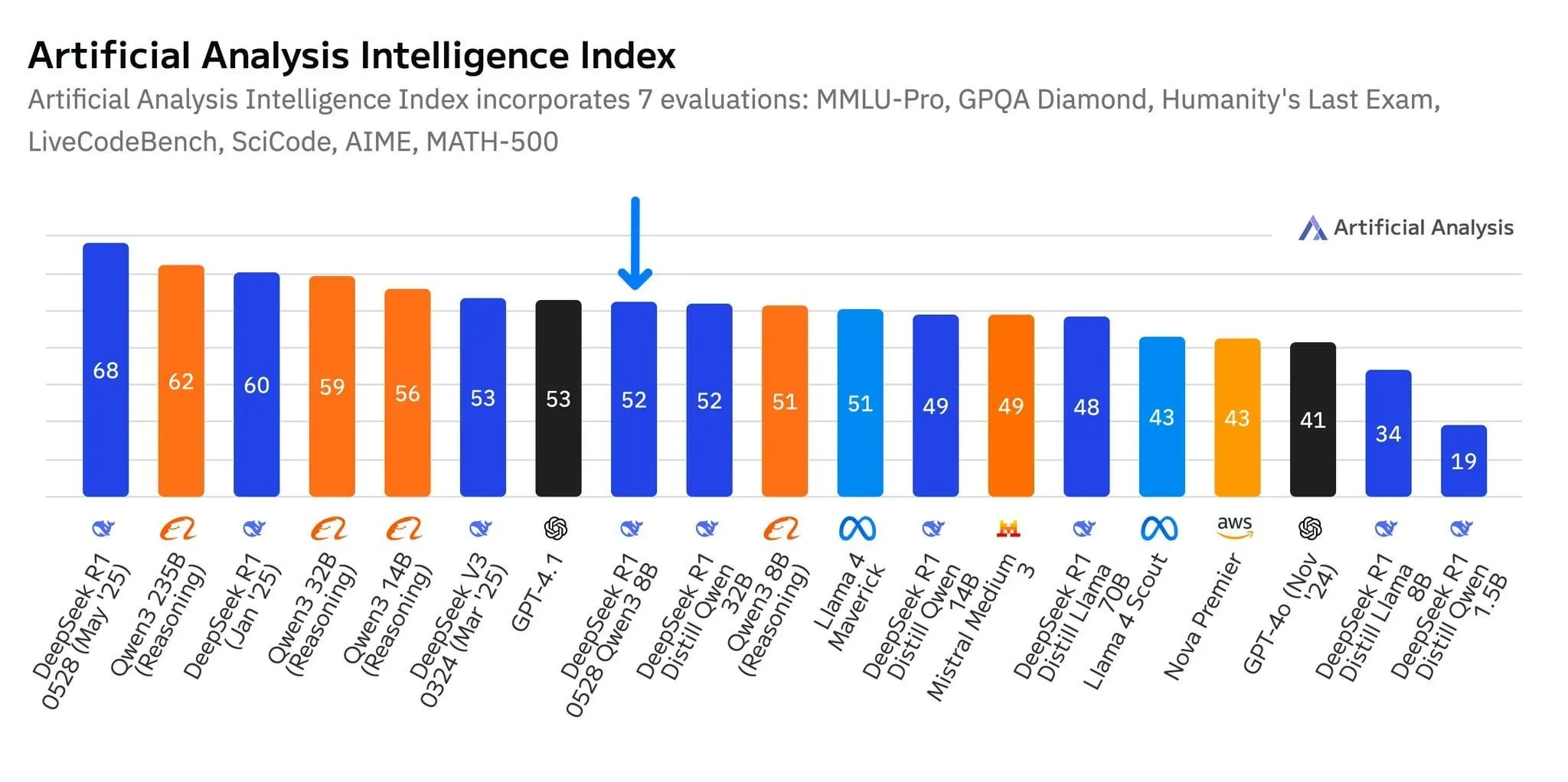

Novo modelo R1-0528-Qwen3-8B da DeepSeek destaca-se no nível de 8B parâmetros, mas com vantagem ténue: De acordo com dados da Artificial Analysis, o mais recente modelo R1-0528-Qwen3-8B da DeepSeek é o mais inteligente no nível de 8 mil milhões de parâmetros, mas a sua liderança não é significativa, com o modelo Qwen3 8B da própria Alibaba muito próximo, apenas um ponto atrás. Discussões na comunidade apontam que, embora estes modelos de menor dimensão tenham um desempenho excelente, os benchmarks podem sofrer de overfitting; por exemplo, os modelos da série Qwen destacam-se em benchmarks como o MMLU, possivelmente devido aos seus dados de treino conterem pares de perguntas e respostas em formatos semelhantes. Na experiência prática dos utilizadores, o Destill R1 8B tem melhor desempenho em codificação, matemática e raciocínio, enquanto o Qwen 8B é mais natural na escrita e em multilinguismo (como espanhol). Alguns utilizadores acreditam que a inteligência dos modelos pequenos está a aproximar-se do seu limite (Fonte: Reddit r/LocalLLaMA)

Empresas de IA de nível intermédio como Tiangong e StepStar focam-se em agents, procurando avanços no mercado: Perante o cenário de “o vencedor leva tudo” dominado por aplicações de IA de topo como DeepSeek e Doubao, a Tiangong APP, da Kunlun Wanwei, passou por uma atualização radical, transformando-se numa plataforma de AI Agent centrada em cenários de escritório, enfatizando a capacidade de conclusão de tarefas. A StepStar ajustou a sua estratégia, reduzindo produtos C-end como “Maopao Ya” e renomeando “Yue Wen” para “Step AI”, focando-se no desenvolvimento de modelos e no mercado ToB, com ênfase na implementação de Agents multimodais em terminais como telemóveis, automóveis e robôs. Estes ajustes refletem como os fabricantes de IA não líderes, em competição acirrada, tentam apostar em agents, mudando da “competição de capacidades gerais” para a “construção de ciclos fechados de cenários”, na esperança de encontrar oportunidades de sobrevivência e desenvolvimento em nichos verticais (Fonte: 36氪)

Lançamento do modelo grande multimodal Qwen2.5-Omni, suporta entrada de texto, imagem, vídeo, áudio e saída de áudio e texto: O Qwen2.5-Omni é um novo modelo grande multimodal open source (licença Apache 2.0) capaz de processar texto, imagem, vídeo e áudio como entrada, e gerar saída de texto e áudio. Isto oferece aos programadores uma ferramenta poderosa semelhante ao Gemini, mas que pode ser implementada localmente e para investigação. O artigo apresenta brevemente o modelo e demonstra uma experiência de inferência simples, destacando o seu potencial em interações multimodais, com a promessa de impulsionar o desenvolvimento de aplicações de IA multimodais localizadas (Fonte: Reddit r/deeplearning)

![[Article] Qwen2.5-Omni: An Introduction](https://rebabel.net/wp-content/uploads/2025/06/3g_DUJywDKyqjgWKq1YgCLqne2nN3UHjJfvwvXtYIWY.webp)

OpenAI ordenada por tribunal a preservar todos os logs do ChatGPT, incluindo registos de chat “eliminados”: Num processo de direitos de autor movido por agências de notícias como o New York Times, um tribunal dos EUA ordenou, a 13 de maio de 2025, que a OpenAI deve guardar todos os logs de chat do ChatGPT, mesmo que o utilizador os tenha “eliminado”. Os queixosos argumentam que a OpenAI usou os seus artigos sem permissão para treinar o ChatGPT e temem que os utilizadores possam eliminar registos de chat que envolvam contornar paywalls para destruir provas. Esta medida levantou preocupações com a privacidade dos utilizadores e pode entrar em conflito com regulamentos como o GDPR. A OpenAI, por sua vez, considera que a ordem se baseia em especulações, carece de provas e impõe um fardo pesado às suas operações. Este caso realça a tensão entre a proteção da propriedade intelectual e a privacidade do utilizador (Fonte: Reddit r/ArtificialInteligence)

X (antigo Twitter) proíbe robôs de IA de usar os seus dados para treino: A plataforma X atualizou as suas políticas, proibindo o uso dos seus dados ou API para o treino de modelos de linguagem, restringindo ainda mais o acesso das equipas de IA ao seu conteúdo. Entretanto, a Anthropic lançou o Claude Gov, um modelo de IA concebido especificamente para a segurança nacional dos EUA, refletindo a tendência de empresas de tecnologia como OpenAI, Meta e Google de fornecerem ativamente ferramentas de IA a governos e ao setor da defesa (Fonte: Reddit r/ArtificialInteligence)

Amazon cria nova equipa de AI agents, testa entrega com robôs humanoides: A Amazon criou uma nova equipa dentro do seu departamento de desenvolvimento de produtos de consumo, Lab126, focada na investigação e desenvolvimento de AI agents, e planeia testar a utilização de robôs humanoides para entrega de encomendas. Os testes serão realizados num escritório em São Francisco, Califórnia, transformado numa pista de obstáculos interior, onde os robôs (possivelmente incluindo produtos da empresa chinesa Unitree Robotics) viajarão em carrinhas de entrega elétricas Rivian e depois descerão para completar a entrega de última milha. A Amazon também está a desenvolver software baseado nos modelos DeepSeek-VL2 e Qwen para robôs de simulação. Esta iniciativa visa melhorar a eficiência dos armazéns e a velocidade de entrega através da tecnologia de IA e robótica (Fonte: 36氪)

Lenovo aposta na transformação AI, focando-se em inteligência artificial híbrida e implementação de agents: A Lenovo está a acelerar a sua transformação de fabricante tradicional de hardware de PC para fornecedor de soluções orientadas por IA, definindo a “inteligência artificial híbrida” como a sua estratégia central para a próxima década. Esta estratégia enfatiza a fusão da inteligência pessoal, empresarial e pública, visando garantir a privacidade dos dados e serviços personalizados através da sinergia entre terminal e nuvem. A Lenovo já implementou um super-agent urbano em Xangai e lançou o ecossistema de agents pessoais Tianxi. Embora o negócio de PCs ainda domine, a Lenovo está a impulsionar o desenvolvimento de AI PCs, servidores AI e soluções setoriais através de investigação e desenvolvimento próprios e colaborações (como com a Universidade de Tsinghua, Universidade Jiao Tong de Xangai, etc.), para enfrentar a contração do mercado de PCs e a concorrência de tecnologias emergentes. No entanto, a aceitação do mercado de AI PCs, a produção comercial em escala de aplicações de IA e a concorrência com rivais como a Huawei continuam a ser questões cruciais (Fonte: 36氪)

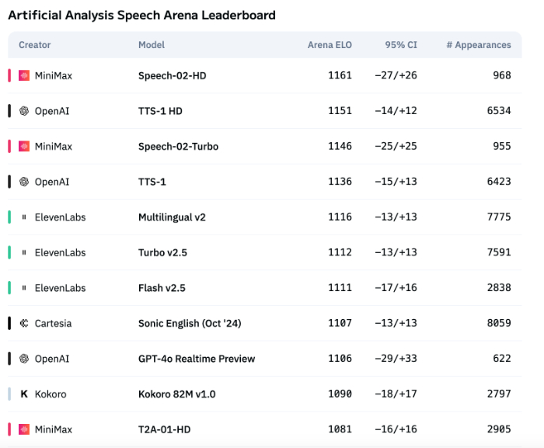

Tecnologia de voz AI ainda carece de expressão emocional, aplicações ToB começam a explodir: Embora modelos como o Speech-02-HD da MiniMax tenham alcançado progressos nos indicadores técnicos de síntese de voz e demonstrem um desempenho aceitável em cenários específicos (como emoções simples em audiolivros chineses), no geral, a voz AI ainda apresenta deficiências na expressão de emoções complexas e na adaptabilidade a cenários específicos (como transmissões ao vivo de vendas). Testes mostram que produtos verticais como o DubbingX, através de etiquetas emocionais detalhadas, têm melhor desempenho em domínios específicos, enquanto produtos como o ElevenLabs, que carecem de etiquetas emocionais, apresentam um desempenho inferior. Atualmente, a voz AI ainda não está madura no domínio ToC, mas no domínio ToB, como assistentes de voz, hardware de companhia AI, etc., já começou a ser amplamente aplicada, com potencial para explorar mais cenários no futuro (Fonte: 36氪)

Estratégia de IA da Google sofre revés, conferência de programadores não consegue reverter a tendência negativa: Apesar de a Google ter lançado uma série de produtos e iniciativas de IA na sua conferência de programadores de 2025, a maioria dos produtos ainda está em teste interno ou não foi lançada, e foi acusada de falta de inovação disruptiva, parecendo mais uma tentativa de alcançar concorrentes como a OpenAI. O modelo grande Gemini não conseguiu liderar a indústria como o ChatGPT, sendo antes criticado por “falta de inovação” e “estratégia hesitante”. A lentidão da Google em áreas como pesquisa com IA e assistentes de IA deixou-a para trás na comercialização e construção de ecossistemas de IA, em comparação com a aliança entre a Microsoft e a OpenAI. O seu modelo de negócio, 80% dependente da publicidade, também a coloca perante o dilema de uma “auto-revolução” ao avançar com a pesquisa com IA. Problemas organizacionais internos, fuga de talentos e a incapacidade de integrar eficazmente os resultados da investigação contribuíram para que a Google passasse de líder a seguidora na corrida da IA (Fonte: 36氪)

Estratégia de IA da Apple enfrenta desafios: parâmetros de modelos no dispositivo são baixos, pressão no mercado chinês aumenta: O iOS 26 e o macOS 26, que a Apple está prestes a lançar na WWDC, terão como principal modelo de IA no dispositivo alegadamente apenas 3 mil milhões de parâmetros, muito abaixo do nível de 7 mil milhões de parâmetros já alcançado por marcas de telemóveis chinesas, e significativamente inferior à escala dos modelos na nuvem da Apple. Esta estratégia de “redução” pode não satisfazer as necessidades dos utilizadores do mercado chinês por funcionalidades de IA de alta computação (como transcrição de voz, tradução em tempo real), especialmente no contexto do rápido avanço das capacidades de IA de marcas locais como a Huawei, onde a quota de mercado da Apple já enfrenta pressão. Além disso, a conformidade de dados e a velocidade de resposta dos servidores também podem afetar a experiência da IA da Apple na China. A Apple pode estar a apostar na abertura de permissões de modelos de IA a programadores para compensar as suas próprias deficiências técnicas e enriquecer o ecossistema de aplicações, mas resta saber se esta medida será eficaz (Fonte: 36氪)

🧰 Ferramentas

Mind The Abstract: Newsletter de resumos de artigos do arXiv por LLM: Uma nova ferramenta chamada Mind The Abstract, concebida para ajudar os utilizadores a acompanhar o rápido crescimento da investigação em AI/ML no arXiv. A ferramenta analisa semanalmente os artigos do arXiv, seleciona 10 artigos interessantes e usa LLMs para gerar resumos. Os utilizadores podem subscrever gratuitamente a newsletter por e-mail para receber estes resumos. Os resumos vêm em dois estilos: “Informal” (menos jargão, mais intuição) e “TLDR” (curto, para utilizadores com formação especializada). Os utilizadores também podem personalizar as categorias temáticas do arXiv do seu interesse. O projeto visa popularizar a investigação em IA, focar-se em factos e ajudar os investigadores a manterem-se a par dos progressos em áreas relevantes (Fonte: Reddit r/artificial)

SteamLens: Sistema Transformer distribuído analisa críticas de jogos Steam: Um estudante de mestrado desenvolveu um sistema Transformer distribuído chamado SteamLens para analisar grandes volumes de críticas de jogos Steam, com o objetivo de ajudar programadores de jogos independentes a compreender o feedback dos jogadores. O sistema, através da paralelização do processamento Transformer, reduziu o tempo de processamento de 400.000 críticas de 30 minutos para 2 minutos. O avanço técnico crucial foi a partilha de instâncias do modelo Transformer através de um cluster Dask, resolvendo o problema do consumo excessivo de memória. O sistema consegue detetar hardware automaticamente, alocar nós de trabalho, processar críticas em paralelo e realizar análise de sentimento e sumarização. Atualmente, o projeto está limitado à execução numa única máquina, com planos futuros para suportar múltiplas GPUs e conjuntos de dados de maior escala. O programador procura aconselhamento sobre as direções futuras do projeto (expansão técnica ou melhoria da usabilidade) (Fonte: Reddit r/MachineLearning)

![[P] Need advice on my steam project](https://rebabel.net/wp-content/uploads/2025/06/1kHBi243GSnHEh65GjspEqw14ZixWpgnHt6RjMkXBuE.webp)

Lançamento do modelo OpenThinker3-7B: O modelo OpenThinker3-7B e a sua versão GGUF foram lançados no HuggingFace. Comentários da comunidade apontam que, no seu lançamento, o modelo comparou o seu desempenho com alguns modelos já desatualizados, o que pode ter afetado a sua avaliação de posicionamento e competitividade (Fonte: Reddit r/LocalLLaMA)

Utilização do “modo paranóico” para impedir alucinações e uso malicioso de LLMs: Um programador, ao construir um chatbot LLM para cenários reais de atendimento ao cliente, adicionou um “modo paranóico” para resolver problemas como tentativas de jailbreak por parte dos utilizadores, confusão lógica causada por casos limite e injeção de prompts. Este modo realiza verificações de sanidade antes da inferência do modelo, bloqueando ativamente qualquer mensagem que pareça tentar redirecionar o modelo, extrair configurações internas ou testar as barreiras de proteção, em vez de apenas filtrar conteúdo prejudicial. Este modo, ao optar por adiar, registar ou recorrer a um plano de contingência quando um prompt parece manipulador ou ambíguo, reduz alucinações e desvios da estratégia (Fonte: Reddit r/artificial)

Fluxions AI lança em open source o modelo de voz NotebookLM de 100 milhões de parâmetros VUI: A Fluxions AI lançou um modelo de voz NotebookLM open source de 100 milhões de parâmetros, chamado VUI, alegadamente construído com duas placas gráficas 4090. O projeto está disponível no GitHub (github.com/fluxions-ai/vui) e inclui um link para um vídeo de demonstração, mostrando as suas capacidades de interação por voz (Fonte: Reddit r/MachineLearning)

![[R] 100M Open source notebooklm speech model](https://rebabel.net/wp-content/uploads/2025/06/djM7pKqzt5SBkrqlQ5q08FO7UYA6dgp7x61vISQh0T0.webp)

📚 Aprendizagem

Tutorial: Utilizar modelos de super-resolução para melhorar a qualidade de imagem e vídeo: Foi partilhado um tutorial sobre o uso de modelos de super-resolução como o CodeFormer para melhorar a qualidade de imagens e vídeos. O tutorial está dividido em quatro partes: configuração do ambiente, super-resolução de imagem, super-resolução de vídeo e uma secção adicional – colorir fotografias antigas a preto e branco. Este tutorial visa ajudar os utilizadores a aprender como aumentar a nitidez e os detalhes de imagens estáticas e vídeos dinâmicos, e restaurar as cores de fotografias antigas. Mais tutoriais e informações podem ser obtidos através do link do blog fornecido (Fonte: Reddit r/deeplearning)

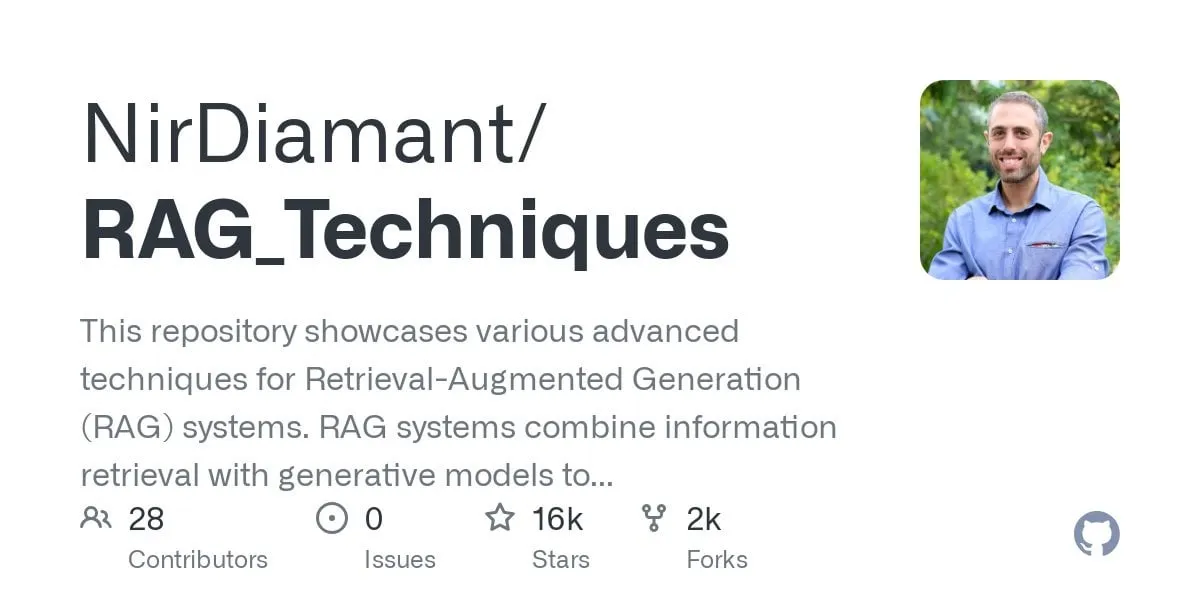

Tutorial de GraphRAG para perguntas e respostas multi-hop lançado, combinando pesquisa vetorial e inferência em grafos: O repositório GitHub RAG_Techniques (com mais de 16K estrelas) adicionou um tutorial passo a passo de GraphRAG, focado em resolver problemas complexos multi-hop que o RAG convencional dificilmente lida (como “Como o protagonista derrotou o assistente do vilão?”). Este método combina pesquisa vetorial com inferência em grafos, usando apenas uma base de dados vetorial, sem necessidade de uma base de dados de grafos independente. O tutorial abrange a conversão de texto em entidades, relações e parágrafos para armazenamento vetorial, construção de pesquisa de entidades e relações, utilização de matrizes matemáticas para descobrir conexões de dados, uso de prompts de IA para selecionar as melhores relações e tratamento de problemas complexos com múltiplos passos lógicos, comparando também os efeitos do GraphRAG com o RAG simples (Fonte: Reddit r/LocalLLaMA)

Artigo explora nova arquitetura DNN não padrão de alto desempenho com estabilidade notável: Um artigo recentemente publicado explora redes neuronais profundas (DNNs) a partir de princípios fundamentais, introduzindo uma nova arquitetura distinta tanto da aprendizagem de máquina tradicional como da IA. Esta arquitetura utiliza uma função de perda adaptativa original, alcançando um aumento significativo de desempenho através de um mecanismo de “equalização”. Utiliza funções não lineares para conectar neurónios e não possui funções de ativação entre camadas, reduzindo assim o número de parâmetros, aumentando a interpretabilidade, simplificando o fine-tuning e acelerando o treino. O equalizador adaptativo atua como um subsistema dinâmico, eliminando a parte linear do modelo e focando-se em interações de ordem superior para acelerar a convergência. O artigo usa a universalidade da função zeta de Riemann como exemplo para aproximar qualquer resposta e consegue lidar com singularidades para enfrentar eventos raros ou deteção de fraude. Este método não depende de bibliotecas como PyTorch, TensorFlow ou Keras, sendo implementado apenas com Numpy (Fonte: Reddit r/deeplearning)

![[R] New article: A New Type of Non-Standard High Performance DNN with Remarkable Stability](https://rebabel.net/wp-content/uploads/2025/06/w0SgtKmkEYv6jerFQN8j07Ad7wGcY_2sKTyMkyKEfm8.webp)

Artigo CRAWLDoc: Dataset e método para ordenação robusta de literatura bibliográfica: Para enfrentar os desafios de layout e formato que as bases de dados de publicações enfrentam ao extrair metadados de diversas fontes da web, foi proposto o método CRAWLDoc. Este método classifica documentos web ligados contextualmente, começando pelo URL de uma publicação (como um DOI), recuperando a página de destino e todos os recursos ligados (PDF, ORCID, etc.), e incorporando esses recursos, texto âncora e URLs numa representação unificada. Para avaliar este método, os investigadores criaram um dataset marcado manualmente contendo 600 publicações de editoras de topo na área da ciência da computação. O CRAWLDoc demonstrou uma capacidade robusta e independente do layout para ordenar documentos relevantes entre diferentes editoras e formatos de dados, estabelecendo uma base para melhorar a extração de metadados de documentos web com vários layouts e formatos (Fonte: HuggingFace Daily Papers)

Artigo RiOSWorld: Benchmark de risco para agentes de uso de computador multimodais: Com o rápido desenvolvimento de modelos de linguagem grandes multimodais (MLLMs) e a sua implementação como agentes autónomos de uso de computador, a avaliação dos seus riscos de segurança tornou-se crucial. Os métodos de avaliação existentes ou carecem de ambientes de interação realistas ou focam-se apenas em alguns tipos de risco. Para tal, foi proposto o benchmark RiOSWorld, para avaliar os riscos potenciais de agentes MLLM em operações reais de computador. Este benchmark contém 492 tarefas de risco abrangendo diversas aplicações (web, redes sociais, sistemas operativos, etc.), divididas em duas categorias principais: riscos originados pelo utilizador e riscos ambientais, avaliadas segundo duas dimensões: intenção do objetivo de risco e conclusão do objetivo de risco. As experiências mostram que os atuais agentes de uso de computador enfrentam riscos de segurança significativos em cenários reais, destacando a necessidade e urgência do seu alinhamento de segurança (Fonte: HuggingFace Daily Papers)

Artigo defende: Modelos de Linguagem Pequenos (SLMs) são o futuro da IA de agentes: O artigo propõe que, embora os Modelos de Linguagem Grandes (LLMs) se destaquem em diversas tarefas, para tarefas especializadas executadas repetidamente em grande número em sistemas de IA de agentes, os Modelos de Linguagem Pequenos (SLMs) são mais vantajosos. Os SLMs não são apenas suficientemente funcionais, mas também mais adequados e económicos. O artigo argumenta com base nas capacidades atuais dos SLMs, nas arquiteturas comuns de sistemas de agentes e na economia da implementação de modelos de linguagem. Para cenários que exigem capacidades de conversação gerais, sistemas de agentes heterogéneos (que invocam vários modelos diferentes) são a escolha natural. O artigo também discute os potenciais obstáculos à aplicação de SLMs em sistemas de agentes e descreve um algoritmo genérico de conversão de LLM para agente SLM, visando promover a discussão sobre a utilização eficiente dos recursos de IA (Fonte: HuggingFace Daily Papers)

Artigo POSS: Utilizar especialistas de posição para melhorar o desempenho de modelos de rascunho na descodificação especulativa: A descodificação especulativa acelera a inferência de LLMs através da previsão de múltiplos tokens por um pequeno modelo de rascunho e da verificação paralela por um grande modelo alvo. Estudos recentes utilizam estados ocultos do modelo alvo para melhorar a precisão da previsão do modelo de rascunho, mas os métodos existentes sofrem de acumulação de erros nas características geradas pelo modelo de rascunho, levando a uma diminuição da qualidade da previsão de tokens em posições subsequentes. O método Position Specialists (PosS) propõe o uso de múltiplas camadas de rascunho especializadas por posição para gerar tokens em posições designadas. Como cada especialista só precisa de lidar com um grau específico de desvio nas características do modelo de rascunho, o PosS melhora significativamente a taxa de aceitação de tokens em posições subsequentes. Experiências com Llama-3-8B-Instruct e Llama-2-13B-chat mostram que o PosS supera as linhas de base em termos de comprimento médio de aceitação e rácio de aceleração (Fonte: HuggingFace Daily Papers)

Artigo CapSpeech: Capacitar aplicações downstream de text-to-speech com legendas estilizadas (CapTTS): CapSpeech é um novo benchmark concebido para uma série de tarefas relacionadas com text-to-speech com legendas estilizadas (CapTTS), incluindo CapTTS com efeitos sonoros (CapTTS-SE), CapTTS com sotaque (AccCapTTS), CapTTS com emoção (EmoCapTTS) e TTS para agentes de chat (AgentTTS). CapSpeech contém mais de 10 milhões de pares áudio-legenda anotados por máquina e quase 360 mil pares anotados por humanos. Além disso, foram introduzidos dois novos datasets gravados por atores de voz profissionais e engenheiros de áudio, especificamente para as tarefas AgentTTS e CapTTS-SE. Os resultados experimentais demonstram síntese de voz de alta fidelidade e alta clareza numa variedade de estilos de fala. Alega-se que CapSpeech é atualmente o maior dataset com anotações abrangentes para tarefas relacionadas com CapTTS (Fonte: HuggingFace Daily Papers)

Artigo VideoMarathon: Melhorar a compreensão de linguagem em vídeos longos através do treino com vídeos de uma hora: Para resolver o problema da escassez de dados anotados para vídeos longos, foi proposto o dataset VideoMarathon, um dataset de seguimento de instruções em vídeo de grande escala, com vídeos de uma hora, contendo aproximadamente 9700 horas de vídeos diversos com durações entre 3 e 60 minutos. O dataset inclui 3,3 milhões de pares de perguntas e respostas de alta qualidade, cobrindo seis temas principais: tempo, espaço, objetos, ações, cenas e eventos, suportando 22 tipos de tarefas que requerem compreensão de vídeo a curto e longo prazo. Com base neste dataset, foi proposto o modelo Hour-LLaVA, que processa eficazmente vídeos de uma hora através de um módulo de melhoria de memória, alcançando o melhor desempenho em vários benchmarks de linguagem para vídeos longos, provando a alta qualidade do dataset VideoMarathon e a superioridade do modelo Hour-LLaVA (Fonte: HuggingFace Daily Papers)

Artigo AV-Reasoner: Melhorar e aferir capacidades de MLLMs de contagem audiovisual baseada em pistas: Os atuais modelos de linguagem grandes multimodais (MLLMs) têm um desempenho fraco em tarefas de contagem em vídeo, e os benchmarks existentes sofrem de vídeos curtos, gama estreita de consultas, falta de anotação de pistas e cobertura multimodal insuficiente. Para tal, foi proposto o benchmark CG-AV-Counting, um benchmark de contagem baseado em pistas, anotado manualmente, contendo 1027 questões multimodais em 497 vídeos longos e 5845 pistas anotadas, suportando avaliação black-box e white-box. Simultaneamente, foi proposto o modelo AV-Reasoner, que generaliza a capacidade de contagem a partir de tarefas relacionadas através de GRPO e aprendizagem curricular. O AV-Reasoner alcançou resultados SOTA em múltiplos benchmarks, demonstrando a eficácia do Reinforcement Learning. No entanto, as experiências também mostraram que em benchmarks fora do domínio, o raciocínio no espaço linguístico não trouxe melhorias de desempenho (Fonte: HuggingFace Daily Papers)

Artigo propõe novo framework para alinhar espaços latentes através de priors de fluxo: Este artigo propõe um novo framework que alinha espaços latentes aprendíveis com distribuições alvo arbitrárias, utilizando modelos generativos baseados em fluxo como priors. O método primeiro pré-treina um modelo de fluxo nas características alvo para capturar a sua distribuição subjacente, e depois este modelo de fluxo fixo regulariza o espaço latente através de uma perda de alinhamento. Esta perda de alinhamento reformula o objetivo de correspondência de fluxo, tratando as variáveis latentes como o objetivo da otimização. A investigação demonstra que minimizar esta perda de alinhamento estabelece um objetivo substituto computacionalmente tratável para maximizar o limite inferior variacional da log-verosimilhança das variáveis latentes sob a distribuição alvo. O método evita a avaliação de verosimilhança, que é dispendiosa computacionalmente, e a resolução de EDOs durante a otimização. Através de experiências de geração de imagem em grande escala no ImageNet, a eficácia do método foi validada em diferentes distribuições alvo (Fonte: HuggingFace Daily Papers)

Artigo MedAgentGym: Treino em larga escala de agentes LLM para raciocínio médico baseado em código: MedAgentGym é o primeiro ambiente de treino publicamente disponível concebido para melhorar as capacidades de raciocínio médico baseado em código de agentes de modelos de linguagem grandes (LLM). Contém 129 categorias e 72413 instâncias de tarefas derivadas de cenários biomédicos reais. As tarefas são encapsuladas em ambientes de codificação executáveis, com descrições detalhadas, feedback interativo, anotações de referência verificáveis e geração de trajetórias de treino escaláveis. O benchmarking de mais de 30 LLMs revelou uma lacuna de desempenho significativa entre os modelos API comerciais e os modelos open source. Utilizando o MedAgentGym, o Med-Copilot-7B alcançou melhorias de desempenho significativas através de fine-tuning supervisionado e Reinforcement Learning, tornando-se uma alternativa competitiva e focada na privacidade ao gpt-4o. O MedAgentGym fornece uma plataforma integrada para o desenvolvimento de assistentes de codificação LLM para investigação e prática biomédica avançada (Fonte: HuggingFace Daily Papers)

Artigo SparseMM: Resposta a conceitos visuais em MLLMs induz esparsidade de cabeças de atenção: Modelos de linguagem grandes multimodais (MLLMs) são geralmente derivados da expansão das capacidades visuais de LLMs pré-treinados. A investigação descobriu que os MLLMs exibem um fenómeno de esparsidade ao processar entradas visuais: apenas uma pequena fração (cerca de <5%) das cabeças de atenção no LLM (denominadas cabeças visuais) participa ativamente na compreensão visual. Para identificar eficientemente estas cabeças visuais, os investigadores conceberam um framework sem treino que quantifica a relevância visual das cabeças através da análise da resposta ao alvo. Com base nesta descoberta, foi proposto o SparseMM, uma estratégia de otimização de KV-Cache que aloca orçamentos computacionais assimétricos de acordo com a pontuação visual da cabeça, utilizando a esparsidade das cabeças visuais para acelerar a inferência de MLLMs. Em comparação com métodos anteriores que ignoram a especificidade visual, o SparseMM prioriza e preserva a semântica visual durante o processo de descodificação, alcançando um melhor compromisso entre precisão e eficiência nos principais benchmarks multimodais (Fonte: HuggingFace Daily Papers)

Artigo RoboRefer: Melhorar a referenciação espacial e capacidade de raciocínio em modelos de linguagem visual para robôs: A referenciação espacial é uma capacidade fundamental para robôs incorporados interagirem no mundo físico 3D. Os métodos existentes, mesmo utilizando poderosos modelos de linguagem visual (VLMs) pré-treinados, ainda têm dificuldade em compreender com precisão cenas 3D complexas e inferir dinamicamente as localizações de interação indicadas por instruções. Para tal, foi proposto o RoboRefer, um VLM com perceção 3D, que integra codificadores de profundidade desacoplados mas dedicados através de fine-tuning supervisionado (SFT) para alcançar uma compreensão espacial precisa. Além disso, o RoboRefer melhora a capacidade de raciocínio espacial multi-passo generalizada através de fine-tuning por reforço (RFT) e uma função de recompensa de processo sensível à métrica, personalizada para tarefas de referenciação espacial. Para apoiar o treino, foram introduzidos o dataset em grande escala RefSpatial (20 milhões de pares pergunta-resposta, 31 relações espaciais, até 5 passos de inferência) e o benchmark de avaliação RefSpatial-Bench. As experiências mostram que o RoboRefer treinado com SFT atinge SOTA na compreensão espacial, e após o treino com RFT supera significativamente outras linhas de base no RefSpatial-Bench, superando até o Gemini-2.5-Pro (Fonte: HuggingFace Daily Papers)

Artigo LIFT: Utilizar codificadores de texto LLM fixos para guiar a aprendizagem de representação visual: O método dominante atual para alinhamento linguagem-imagem (como o CLIP) é o pré-treino conjunto de codificadores de texto e imagem através de aprendizagem contrastiva. Este estudo explora se este dispendioso treino conjunto é necessário, investigando especificamente se um modelo de linguagem grande (LLM) pré-treinado e fixo pode fornecer um codificador de texto suficientemente bom para guiar a aprendizagem de representação visual. Os investigadores propõem o framework LIFT (Language-Image alignment with a Fixed Text encoder), que treina apenas o codificador de imagem. As experiências demonstram que este framework simplificado é muito eficaz, superando o CLIP na maioria dos cenários que envolvem compreensão composicional e legendas longas, e melhorando significativamente a eficiência computacional. Este trabalho oferece novas perspetivas sobre como os embeddings de texto de LLMs podem guiar a aprendizagem visual (Fonte: HuggingFace Daily Papers)

Artigo OminiAbnorm-CT: Novo método centrado em anomalias para interpretação de imagens de TC de corpo inteiro: Para enfrentar os desafios da interpretação automática de imagens de TC na radiologia clínica (especialmente a localização e descrição de achados anormais em exames multiplanares de corpo inteiro), este estudo faz quatro contribuições: 1) Propõe um sistema de classificação hierárquica abrangente contendo 404 achados anormais representativos de todas as regiões do corpo; 2) Constrói um dataset com mais de 14.500 imagens de TC multiplanares de corpo inteiro, fornecendo anotações de localização detalhadas e descrições para mais de 19.000 anomalias; 3) Desenvolve o modelo OminiAbnorm-CT, capaz de localizar e descrever automaticamente anomalias em imagens de TC multiplanares de corpo inteiro com base em consultas de texto, e suporta interação flexível através de prompts visuais; 4) Estabelece três tarefas de avaliação baseadas em cenários clínicos reais. As experiências demonstram que o OminiAbnorm-CT supera significativamente os métodos existentes em todas as tarefas e métricas (Fonte: HuggingFace Daily Papers)

Artigo explora a obtenção de integridade contextual (CI) em LLMs através de raciocínio e Reinforcement Learning: Com a chegada da era dos agentes autónomos que tomam decisões em nome dos utilizadores, garantir a integridade contextual (CI) – ou seja, que informação é apropriada partilhar ao executar uma tarefa específica – tornou-se uma questão central. Os investigadores argumentam que a CI requer que os agentes raciocinem sobre o ambiente operacional. Primeiro, eles solicitam aos LLMs que raciocinem explicitamente sobre a CI ao decidir sobre a divulgação de informações, e depois desenvolvem um framework de Reinforcement Learning (RL) para incutir ainda mais no modelo as capacidades de raciocínio necessárias para alcançar a CI. Usando um dataset de exemplo com cerca de 700 contextos sintéticos, mas diversificados, e especificações de divulgação de informações, este método reduz significativamente a divulgação inadequada de informações em vários tamanhos e famílias de modelos, mantendo ao mesmo tempo o desempenho da tarefa. Importante, esta melhoria é transferida de datasets sintéticos para benchmarks de CI existentes, como o PrivacyLens, que possui anotações humanas e avalia fugas de privacidade de assistentes de IA em ações e chamadas de ferramentas (Fonte: HuggingFace Daily Papers)

Artigo VideoREPA: Aprender conhecimento físico na geração de vídeo através do alinhamento de relações com modelos de base: Os recentes avanços nos modelos de difusão texto-para-vídeo (T2V) permitiram a síntese de vídeo de alta fidelidade, mas estes frequentemente têm dificuldade em gerar conteúdo fisicamente plausível devido à falta de uma compreensão física precisa. A investigação descobriu que a capacidade de compreensão física nas representações dos modelos T2V é muito inferior à dos métodos de aprendizagem auto-supervisionada de vídeo. Para tal, foi proposto o framework VideoREPA, que destila a capacidade de compreensão física de modelos de base de compreensão de vídeo para modelos T2V, alinhando relações a nível de token. Especificamente, introduz uma perda de destilação de relações de token (TRD), que utiliza o alinhamento espácio-temporal para fornecer orientação suave para o fine-tuning de modelos T2V pré-treinados robustos. Alega-se que o VideoREPA é o primeiro método REPA concebido para o fine-tuning de modelos T2V e para lhes incutir conhecimento físico. As experiências mostram que o VideoREPA melhora significativamente o senso comum físico do método de base CogVideoX, alcançando melhorias notáveis nos benchmarks relevantes (Fonte: HuggingFace Daily Papers)

Artigo explora repensar a representação de profundidade para 3D Gaussian Splatting feed-forward: Mapas de profundidade são amplamente utilizados em pipelines de 3D Gaussian Splatting (3DGS) feed-forward, através da sua retroprojeção como nuvens de pontos 3D para síntese de novas vistas. Este método tem vantagens como treino eficiente, uso de poses de câmara conhecidas e estimativa geométrica precisa. No entanto, descontinuidades de profundidade nas bordas dos objetos frequentemente levam à fragmentação ou esparsidade da nuvem de pontos, degradando a qualidade da renderização. Para resolver este problema, os investigadores introduziram a PM-Loss, uma nova perda de regularização baseada em mapas de pontos (pointmaps) previstos por um Transformer pré-treinado. Embora os próprios mapas de pontos possam não ser tão precisos quanto os mapas de profundidade, eles forçam eficazmente a suavidade geométrica, especialmente em torno das bordas dos objetos. Através de mapas de profundidade melhorados, este método melhora significativamente o desempenho do 3DGS feed-forward em várias arquiteturas e cenários, fornecendo resultados de renderização consistentemente superiores (Fonte: HuggingFace Daily Papers)

Artigo EOC-Bench: Avaliar a capacidade dos MLLMs de identificar, recordar e prever objetos no mundo da perspetiva em primeira pessoa: O surgimento de modelos de linguagem grandes multimodais (MLLMs) impulsionou avanços em aplicações visuais na primeira pessoa, que exigem uma compreensão persistente e sensível ao contexto dos objetos. No entanto, os benchmarks incorporados existentes focam-se principalmente na exploração de cenas estáticas, ignorando a avaliação das mudanças dinâmicas resultantes da interação do utilizador. O EOC-Bench é um novo benchmark concebido para avaliar sistematicamente a cognição incorporada centrada no objeto em cenas dinâmicas na primeira pessoa. Contém 3277 pares de QA cuidadosamente anotados, divididos em três categorias temporais: passado, presente e futuro, cobrindo 11 dimensões de avaliação detalhadas e 3 tipos de referenciação visual de objetos. Para garantir uma avaliação abrangente, foi desenvolvido um framework de anotação colaborativa humano-máquina de formato misto e uma nova métrica de precisão temporal multiescala. A avaliação de vários MLLMs com base no EOC-Bench fornece ferramentas cruciais para melhorar as capacidades de cognição de objetos incorporados dos MLLMs (Fonte: HuggingFace Daily Papers)

Artigo Rectified Point Flow: Método genérico para estimativa de pose de nuvens de pontos: Rectified Point Flow é um método paramétrico unificado que formula o registo de nuvens de pontos emparelhadas e a montagem de formas multipartes como um único problema de geração condicional. Dada uma nuvem de pontos sem pose, o método aprende um campo de velocidade contínuo ponto a ponto que transporta os pontos ruidosos para as suas posições alvo, recuperando assim a pose das partes. Ao contrário de trabalhos anteriores que regridem as poses das partes e empregam tratamentos de simetria específicos, este método aprende intrinsecamente as simetrias de montagem sem necessidade de rótulos de simetria. Combinado com um codificador auto-supervisionado focado em pontos sobrepostos, o método alcança novo desempenho SOTA em seis benchmarks que abrangem registo emparelhado e montagem de formas. Notavelmente, a sua formulação unificada permite um treino conjunto eficaz em datasets diversificados, promovendo assim a aprendizagem de priors geométricos partilhados e, consequentemente, melhorando a precisão (Fonte: HuggingFace Daily Papers)

Artigo DGAD: Alcançar síntese de objetos geometricamente editável e com preservação de aparência: A síntese genérica de objetos (GOC) visa integrar objetos alvo de forma transparente em cenas de fundo, com as propriedades geométricas desejadas, preservando ao mesmo tempo os seus detalhes finos de aparência. Métodos recentes utilizam embeddings semânticos e integram-nos em modelos de difusão avançados para alcançar geração geometricamente editável, mas estes embeddings altamente compactos codificam apenas pistas semânticas de alto nível, descartando inevitavelmente detalhes finos de aparência. Os investigadores introduziram o modelo DGAD (Disentangled Geometry-editable and Appearance-preserving Diffusion), que primeiro utiliza embeddings semânticos para capturar implicitamente as transformações geométricas desejadas e, em seguida, emprega um mecanismo de recuperação por atenção cruzada para alinhar características de aparência fina com a representação geometricamente editada, alcançando assim edição geométrica precisa e preservação fiel da aparência na síntese de objetos (Fonte: HuggingFace Daily Papers)

💼 Negócios

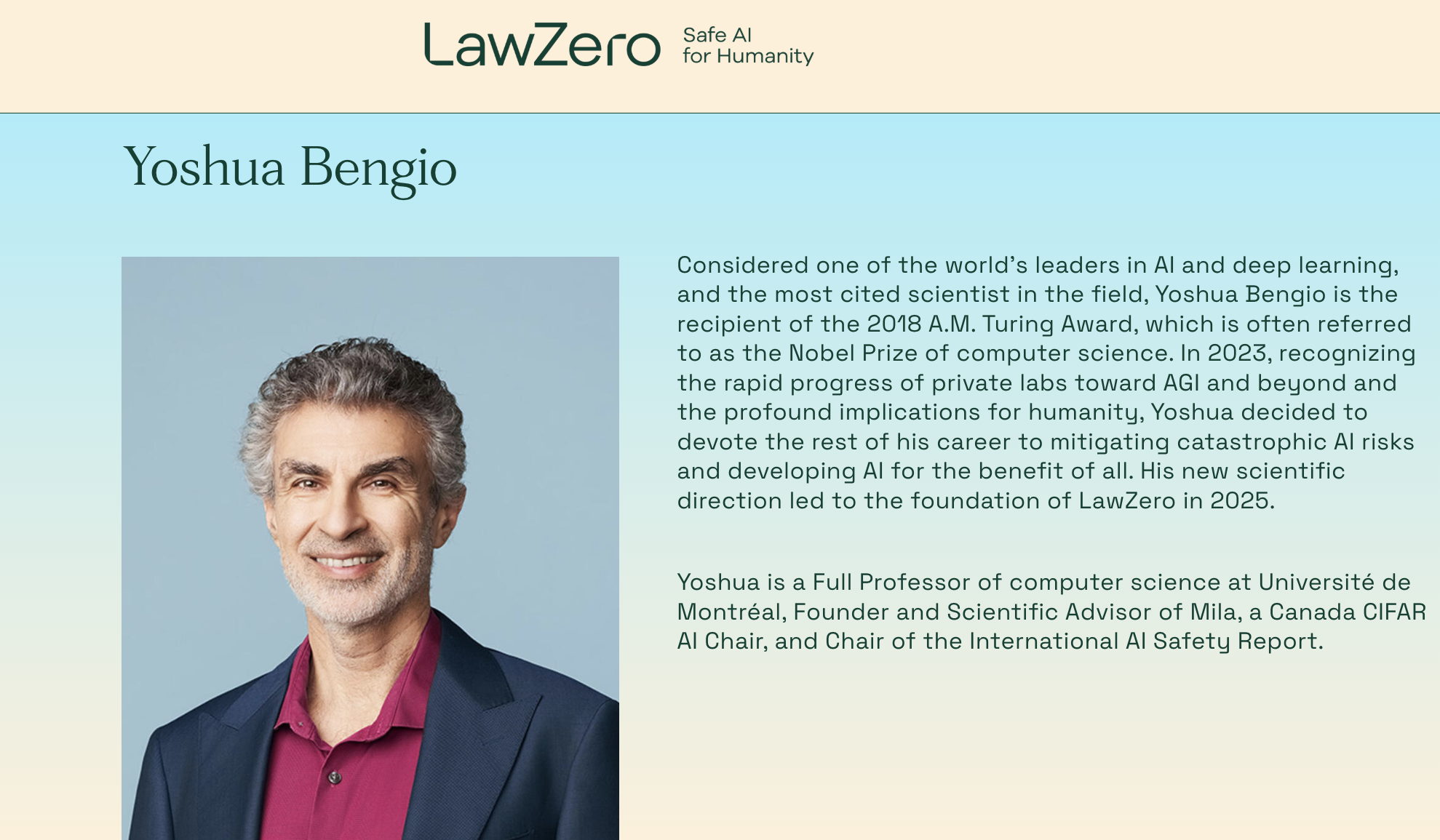

Yoshua Bengio, vencedor do Prémio Turing, volta a empreender e funda a organização sem fins lucrativos LawZero, focada em sistemas de IA “safe-by-design”: Yoshua Bengio, um dos três gigantes do deep learning e vencedor do Prémio Turing, anunciou a fundação de uma nova organização sem fins lucrativos, a LawZero, com o objetivo de construir a próxima geração de sistemas de IA “safe-by-design”, e declarou explicitamente que não desenvolverá Agents (agentes inteligentes). A LawZero já obteve 30 milhões de dólares em financiamento inicial de entidades como o Future of Life Institute, Open Philanthropy (um dos primeiros investidores da OpenAI) e instituições ligadas ao ex-CEO da Google, Eric Schmidt. A organização desenvolverá uma “IA Cientista” (Scientist AI) focada na compreensão e aprendizagem do mundo, em vez de agir nele, visando fornecer respostas verdadeiras e verificáveis através de raciocínio externo transparente, para acelerar descobertas científicas, supervisionar sistemas de IA do tipo Agent e aprofundar a compreensão e mitigação dos riscos da IA. Bengio afirmou que esta iniciativa é uma resposta construtiva aos riscos potenciais já demonstrados pelos atuais sistemas de IA, como comportamentos de autoproteção e engano (Fonte: 量子位)

CEO da Microsoft, Nadella, afirma que a parceria com a OpenAI está a ajustar-se, mas continua sólida: Satya Nadella, CEO da Microsoft, afirmou que a parceria da Microsoft com a OpenAI está a passar por mudanças, mas ambas as partes manterão uma cooperação multinível, com a OpenAI a continuar a ser o maior cliente de infraestrutura da Microsoft. Embora a Microsoft tenha inicialmente estabelecido uma ligação profunda e investido na OpenAI, a relação sofreu alterações subtis à medida que ambas as partes lançaram produtos concorrentes e procuraram mais parceiros (como a OpenAI a colaborar com a Oracle e o SoftBank no projeto “Stargate”, e a Microsoft a incorporar o modelo Grok da xAI na plataforma Azure). Nadella enfatizou o desejo de que ambas as partes continuem a colaborar em múltiplas áreas nas próximas décadas e admitiu que ambas terão outros parceiros. A Microsoft está a esforçar-se para reiniciar o seu negócio de consumo através da IA e recrutou o cofundador da DeepMind, Suleyman, para liderar os produtos relacionados (Fonte: 36氪)

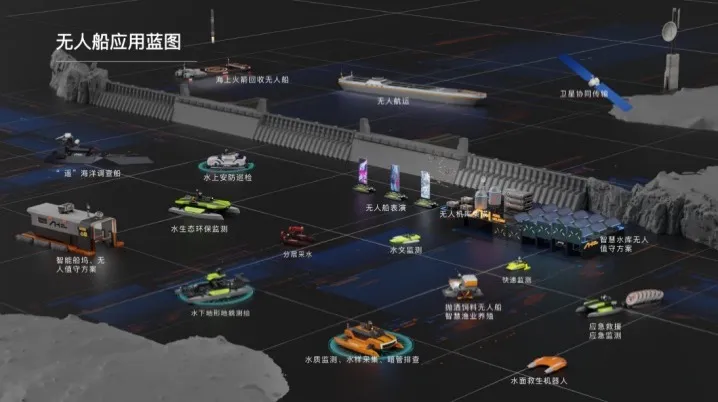

Haibo Unmanned Ships conclui ronda de financiamento Série A de dezenas de milhões de yuan, acelerando a comercialização de soluções inteligentes de IA para águas: A Beijing Haibo Unmanned Ship Technology Co., Ltd. concluiu recentemente uma ronda de financiamento Série A de dezenas de milhões de yuan, liderada pela Shanghai Fansheng Investment, uma subsidiária do Zhejiang Laoyuweng Group. Os fundos serão utilizados para aumentar a I&D, construção de equipas, promoção de mercado e produção. A Haibo Unmanned Ships, fundada em 2019, foca-se em toda a cadeia da indústria de barcos não tripulados inteligentes, fornecendo soluções inteligentes de IA para águas. A sua linha de produtos é diversificada, incluindo a “Série Hunter” para águas interiores e a “Série Koi” para áreas de águas rasas, com uma taxa de substituição de componentes principais por produção nacional de 92%. A empresa já realizou quase mil projetos de serviços técnicos aquáticos em Pequim, Tianjin e outros locais, e planeia estabelecer um centro de operações no leste da China e uma base de montagem geral de barcos não tripulados de alimentação inteligente em Shaoxing (Fonte: 36氪)

🌟 Comunidade

Debate acalorado no Reddit: Gemini 2.5 Pro supera Claude Opus 4 na WebDev Arena, mas valor do benchmark é questionado: Uma publicação sobre a nova versão do Gemini 2.5 Pro a superar o Claude Opus 4 na WebDev Arena (um benchmark que mede o desempenho de codificação no mundo real) gerou discussão na comunidade r/ClaudeAI do Reddit. Muitos comentadores expressaram ceticismo sobre o valor prático destes benchmarks de nível micro, argumentando que são mais um barómetro geral das capacidades da IA do que uma prova definitiva da superioridade de um modelo específico. A discussão salientou que os critérios específicos de medição de benchmarks como “WebDev” (por exemplo, seguir instruções, criatividade, otimização de código, resposta a prompts esparsos) não são claros, e a complexidade do processo de desenvolvimento no mundo real excede em muito esses indicadores. Alguns comentários mencionaram que a escolha do modelo depende mais de como ele complementa o fluxo de trabalho individualizado e humanizado do programador, do que de pontuações puras de benchmark. Outros apontaram para o fenómeno da “ilusão do ranking”, onde os programadores de modelos podem ter permissão para testar versões privadas dos seus modelos em plataformas como a Chatbot Arena e divulgar apenas as versões com melhor desempenho (Fonte: Reddit r/ClaudeAI)

Dilema na escolha de carreira para engenheiros de IA: entrelaçamento de interesse e preocupações com as alterações climáticas: Um estudante europeu expressou no Reddit r/ArtificialInteligence a sua confusão na escolha de carreira. Sempre foi apaixonado por IA e definiu-a como objetivo de estudo, mas nos últimos anos tem-se preocupado cada vez mais com as alterações climáticas e o seu potencial impacto na Europa (como problemas económicos e energéticos). Ele acredita que o alto consumo de energia da IA pode agravar a pressão sobre as redes elétricas europeias e dificultar a transição ecológica, hesitando assim em abandonar a IA na sua escolha de especialização. Os comentários da comunidade geralmente consideram que a IA e a resolução de problemas climáticos não são totalmente opostas: 1) A IA pode desempenhar um papel crucial na otimização da eficiência energética, análise e modelação de dados climáticos, e desenvolvimento de tecnologias sustentáveis; 2) O atual alto consumo de energia dos LLMs não representa toda a IA, e o desenvolvimento de soluções de IA eficientes é da responsabilidade dos engenheiros de IA; 3) Dedicar-se a uma área de interesse pode gerar um maior impacto, podendo aplicar a IA a direções positivas relacionadas com o clima. Muitos encorajaram-no a continuar a estudar IA e a focar-se na aplicação da IA para resolver problemas reais, incluindo as alterações climáticas (Fonte: Reddit r/ArtificialInteligence)

LLMs alegadamente conseguem identificar quando estão a ser avaliados, levantando preocupações sobre comportamento de “agrado” dos modelos: Um artigo do arXiv (2505.23836) aponta que os modelos de linguagem grandes (LLMs) frequentemente conseguem perceber que estão a ser avaliados. Isto gerou uma discussão na comunidade, com a principal preocupação a ser que, quando um modelo sabe que está num ambiente de teste, pode ajustar as suas respostas para corresponder às expectativas dos programadores ou avaliadores, em vez de demonstrar as suas verdadeiras capacidades ou comportamento inerente. Comentários indicam que, se os modelos forem treinados desta forma, este comportamento de “agrado” é esperado. Esta situação representa um desafio para a avaliação do desempenho real, segurança e alinhamento dos LLMs, uma vez que os resultados da avaliação podem não refletir o comportamento do modelo em cenários reais, não avaliativos (Fonte: Reddit r/artificial)

Uso de ferramentas de IA empresarial limitado, funcionários procuram soluções e expressam preocupações: Um utilizador que trabalha numa grande empresa expressou no Reddit r/ClaudeAI que, devido às políticas de confidencialidade de dados da empresa e restrições de VPN, não pode usar ferramentas de IA convencionais como Anthropic, OpenAI, Gemini, enquanto muitos na comunidade discutem o uso de tecnologias avançadas como Claude Code. Isto gerou uma discussão sobre como equilibrar a segurança de dados e a utilização de ferramentas de IA para aumentar a eficiência em ambientes empresariais. Comentários apontaram que a própria Anthropic se preocupa muito com a privacidade, oferecendo até opções de chamadas de inferência encriptadas através do AWS Sagemaker, sugerindo que a empresa do utilizador pode estar a cometer um erro na sua estratégia de IA. Alguns comentadores acreditam que as empresas que não adotarem a IA poderão enfrentar uma diminuição da competitividade e riscos de despedimento no futuro. As soluções sugeridas incluem: pressionar a empresa a assinar acordos de serviço de IA de nível empresarial, pagar pessoalmente por serviços de IA que não utilizem dados para treino, construir servidores de inferência locais (dispendioso) ou usar modelos locais mais pequenos em casos que não envolvam dados sensíveis (Fonte: Reddit r/ClaudeAI)

Restauro de fotos por IA gera controvérsia: é restaurar memórias ou reescrevê-las?: Um utilizador partilhou no Reddit r/ArtificialInteligence a sua experiência de restaurar e colorir fotos antigas usando IA (ChatGPT e Kaze.ai), o que gerou uma discussão sobre a ética do restauro de fotos por IA. Por um lado, o utilizador ficou maravilhado com a capacidade da IA de dar nova vida a fotos antigas, mas por outro, expressou preocupação com a sua autenticidade, pois a IA, no processo de restauro, “adivinha” cores e preenche detalhes com base em algoritmos, podendo adicionar ou remover informação original, alterando assim a verdadeira face da história. A discussão considerou que o restauro por IA é essencialmente uma recriação da imagem baseada em probabilidades e dados de treino; se o reconhecimento de padrões for preciso e os dados apropriados, pode ser considerado “restauro”, caso contrário, é “reescrita”. Alguns comentários salientaram que a memória em si é subjetiva e imprecisa, e que o restauro por IA é, de certa forma, semelhante ao restauro por especialistas humanos em Photoshop, além de ser não destrutivo (a foto original permanece). O fundamental é reconhecer a interpretação artística da IA e estar ciente de que estamos a compreender o passado através do filtro da nossa consciência atual (Fonte: Reddit r/ArtificialInteligence)

Confusão de um novato em engenharia de software na era da IA: se a IA pode fazer tudo, qual o sentido de aprender programação?: Um estudante de ciência da computação perguntou no Reddit r/ArtificialInteligence que, se a IA pode escrever código, depurar e fornecer as melhores soluções, qual o sentido de os engenheiros de software aprenderem essas competências, e se se tornarão “intermediários” da IA e acabarão por ser eliminados. As respostas da comunidade enfatizaram que as ferramentas de IA só atingem o seu potencial máximo sob a orientação de programadores competentes. Atualmente, a IA é mais proficiente em lidar com tarefas repetitivas e auxiliares, enquanto o design de sistemas complexos, a formulação de estratégias, a compreensão de requisitos e a resolução inovadora de problemas ainda exigem a liderança de engenheiros humanos. Aconselha-se aos novatos que acompanhem as partilhas práticas de especialistas do setor (como o blog de Simon Willison), para entenderem como a IA auxilia em vez de substituir os programadores, e que se concentrem em melhorar as competências essenciais de resolução de problemas e o domínio das ferramentas de IA (Fonte: Reddit r/ArtificialInteligence)

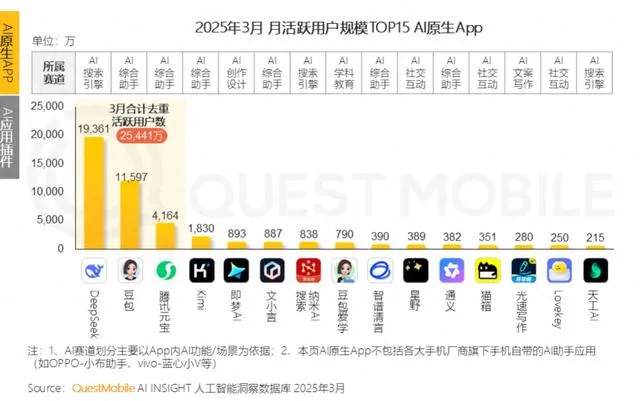

Grandes empresas apostam em companhia emocional por IA, competindo para serem a “sogra IA” dos jovens, mas enfrentam desafios de retenção de utilizadores: Assistentes de IA de grandes empresas como Tencent Yuanbao, ByteDance Doubao e Alibaba Tongyi adicionaram agentes de personagens de IA, enquanto aplicações independentes como ByteDance Maoxiang e Tencent Zhumengdao também entraram na área de companhia emocional por IA, visando atrair jovens utilizadores através de “namorados/namoradas cibernéticos” para aumentar a atividade das aplicações. Estas personagens de IA satisfazem as necessidades emocionais dos utilizadores através de interações mais humanizadas (incluindo voz e desenvolvimento de enredo), o que inicialmente aumentou o número de downloads e o tempo de uso das aplicações. No entanto, estas aplicações enfrentam geralmente estrangulamentos técnicos, como a capacidade insuficiente de processamento de contexto longo dos grandes modelos, levando a “amnésia da IA”, e fraca capacidade de compreensão emocional, afetando a experiência do utilizador. Ao mesmo tempo, embora inicialmente consigam atrair utilizadores através da novidade e do vínculo emocional, as aplicações de IA em geral enfrentam o dilema da baixa taxa de retenção de utilizadores. Dados da QuestMobile mostram que a taxa de retenção de três dias das principais aplicações de IA é geralmente inferior a 50%, e a taxa de desinstalação do Doubao atinge 42,8%. O artigo considera que a verdadeira retenção de utilizadores ainda depende da inovação tecnológica, e não apenas da companhia emocional ou do investimento em tráfego (Fonte: 36氪)

💡 Outros

Robôs humanoides entram no setor hoteleiro: potencial enorme, mas desafios significativos a curto prazo: Com produtos como o robô “Lingxi X2” da Zhidong Robot a planear produção em massa e preços entre centenas de milhares e dezenas de milhares de yuan, os robôs humanoides estão a passar de atrações de feiras para cenários de aplicação reais, sendo o setor hoteleiro considerado um dos primeiros a adotá-los. Em comparação com os robôs tradicionais de entrega de objetos, os robôs humanoides possuem capacidades de execução e julgamento mais fortes, com potencial para substituir bagageiros, seguranças e parte do pessoal da receção, resolvendo problemas como altos custos de mão de obra e processos complicados no setor hoteleiro. No entanto, a aplicação em larga escala de robôs humanoides em hotéis a curto prazo ainda enfrenta desafios: 1) Maturidade tecnológica insuficiente, pois o ambiente hoteleiro é complexo e variável, exigindo alta capacidade de interação e adaptação dos robôs, que atualmente ainda têm dificuldades; 2) Longo período de retorno do investimento, pois um investimento de centenas de milhares não é pequeno para os hotéis, que precisam considerar o ROI, manutenção, compatibilidade, etc.; 3) Equilíbrio entre padronização e serviços personalizados. O artigo considera que os robôs humanoides substituirão parcialmente os funcionários de hotéis no futuro, mas impulsionarão principalmente a transformação do setor de serviços para um modelo mais avançado de “colaboração humano-máquina” (Fonte: 36氪)

Criadores de vídeos de bem-estar com IA explodem em popularidade a curto prazo, mas valor a longo prazo é questionável; IA deve capacitar, não substituir, a criação de conteúdo: Recentemente, vídeos curtos de divulgação de bem-estar com estilo de desenho animado ou ilustração dinâmica gerados por IA tornaram-se virais em plataformas como Xiaohongshu, resultando num rápido aumento de seguidores. O seu sucesso deve-se à forte adaptabilidade do conteúdo (conhecimento prático + animação divertida), grande procura do público (impulsionada pela ansiedade com a saúde) e algoritmos de plataforma favoráveis (alta taxa de cliques/guardados). Os métodos de monetização incluem principalmente conversão para domínios privados, venda de produtos através de pequenas listas e venda de cursos de produção de vídeos com IA, sendo a venda de cursos, paradoxalmente, mais lucrativa. No entanto, estes vídeos, devido à efemeridade da novidade do formato, controlo mais rigoroso das plataformas, fraca capacidade de venda de produtos de bem-estar e falta de barreiras de confiança nas contas, não possuem valor a longo prazo, sendo mais uma forma de “arbitragem de tráfego”. O artigo considera que o verdadeiro valor da tecnologia de IA para os criadores de conteúdo de bem-estar reside na assistência à criação (conteúdo estruturado, apresentação visualizada, gestão de ativos de conteúdo, conversão de serviços ao utilizador), e não na substituição de humanos na produção de conteúdo (Fonte: 36氪)

Podcast de Lex Fridman entrevista Sundar Pichai, CEO da Google: Sundar Pichai, CEO da Google e Alphabet, foi o convidado do podcast de Lex Fridman (Episódio 471). A discussão abrangeu uma vasta gama de tópicos, incluindo a infância de Pichai na Índia, conselhos para os jovens, estilo de liderança, o impacto da IA na história da humanidade, o futuro do modelo de vídeo Veo 3, as leis de escalonamento da IA, AGI e ASI, P(doom) (a probabilidade de a IA causar uma catástrofe), as decisões mais difíceis da sua carreira de liderança, a comparação entre modelos de IA e a pesquisa Google, Google Chrome, programação, sistema Android, perguntas para uma AGI, o futuro da humanidade e demonstrações do Google Beam e dos óculos XR. Este episódio do podcast oferece uma perspetiva aprofundada sobre a visão de Pichai acerca do desenvolvimento da IA, da estratégia da Google e do futuro da tecnologia (Fonte: )