Palavras-chave:DeepSeek-V3-0526, Grok 3, Inteligência Embarcada, Agente de IA, Aprendizagem por Reforço, Modelo de Linguagem Grande (LLM), Multimodal, DeepSeek-V3-0526 desempenho comparável ao GPT-4.5, Problema de identificação de modo de pensamento do Grok 3, Modelo de mundo EVAC do robô Zhiyuan, Extensão de duração de geração de vídeo RIFLEx da Tsinghua, IBM watsonx Orchestrate IA empresarial

🔥 Foco

Modelo DeepSeek-V3-0526 poderá ser lançado, comparável ao GPT-4.5 e Claude 4 Opus: Notícias da comunidade indicam que a DeepSeek poderá lançar em breve a mais recente versão atualizada do seu modelo V3, o DeepSeek-V3-0526. De acordo com informações da página de documentação da Unsloth, o desempenho deste modelo é comparável ao do GPT-4.5 e do Claude 4 Opus, prometendo tornar-se o modelo de código aberto com melhor desempenho a nível mundial. Isto marca a segunda atualização importante da DeepSeek ao seu modelo V3. A Unsloth já preparou a versão quantizada (GGUF) do modelo, utilizando o seu método Dynamic 2.0, que visa minimizar a perda de precisão. A comunidade está a acompanhar com grande atenção, antecipando o seu desempenho no processamento de contextos longos e outros aspetos. (Fonte: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Grok 3 no modo “Think” identifica-se como Claude 3.5 Sonnet, gerando atenção: O modelo Grok 3 da xAI, quando no modo “Think” (Pensar) e questionado sobre a sua identidade, identifica-se consistentemente como Claude 3.5 Sonnet da Anthropic, e não como Grok. No entanto, no modo normal, identifica-se corretamente como Grok. Este fenómeno é específico do modo e do modelo, não sendo uma alucinação aleatória. Os utilizadores podem reproduzir este comportamento perguntando diretamente “És o Claude?”, ao que o Grok 3 responde “Sim, sou o Claude, um assistente de IA criado pela Anthropic”. Este fenómeno já gerou discussão na comunidade, e a sua causa técnica específica aguarda explicação oficial, podendo estar relacionada com dados de treino do modelo, mecanismos internos ou lógica específica de mudança de modo. (Fonte: Reddit r/MachineLearning)

Zhiyuan Robotics lança em código aberto o modelo de mundo EVAC, impulsionado por sequências de ação robótica, e o benchmark de avaliação EWMBench: A Zhiyuan Robotics anunciou e lançou em código aberto o seu modelo de mundo incorporado EVAC (EnerVerse-AC), impulsionado por sequências de ação robótica, juntamente com o benchmark de avaliação de modelos de mundo incorporado EWMBench. O EVAC consegue reproduzir dinamicamente interações complexas entre robôs e o ambiente, através de um mecanismo de injeção de condições de ação multinível, realizando a geração end-to-end de dinâmicas visuais a partir de ações físicas, e suporta a geração colaborativa multi-perspetiva. O EWMBench avalia modelos de mundo incorporado em três aspetos: consistência de cena, razoabilidade da ação, e alinhamento semântico e diversidade. Esta iniciativa visa construir um paradigma de desenvolvimento de “simulação de baixo custo – avaliação padronizada – iteração eficiente”, impulsionando o avanço da tecnologia de inteligência incorporada. (Fonte: WeChat)

ICRA 2025 anuncia melhores artigos, equipas de Cewu Lu e Lin Shao premiadas: A Conferência Internacional IEEE sobre Robótica e Automação de 2025 (ICRA 2025) anunciou os prémios de melhores artigos. O artigo “Human – Agent Joint Learning for Efficient Robot Manipulation Skill Acquisition”, da equipa de Cewu Lu da Universidade Jiao Tong de Xangai em colaboração com a Universidade de Illinois em Urbana-Champaign (UIUC), recebeu o prémio de melhor artigo em interação humano-robô. A investigação propõe um framework de aprendizagem conjunta humano-agente (HAJL) para aumentar a eficiência da aquisição de habilidades de manipulação robótica através de um mecanismo de partilha dinâmica de controlo. O artigo “D(R,O) Grasp: A Unified Representation of Robot and Object Interaction for Cross-Embodiment Dexterous Grasping”, da equipa de Lin Shao da Universidade Nacional de Singapura, recebeu o prémio de melhor artigo em manipulação e movimento de robôs. Esta investigação introduz a notação D(R,O) para unificar a interação entre a mão do robô e o objeto, melhorando a generalização e eficiência da preensão destra. (Fonte: WeChat)

Equipa de Jun Zhu da Universidade Tsinghua lança RIFLEx, quebrando o limite de duração da geração de vídeo com uma linha de código: A equipa de Jun Zhu da Universidade Tsinghua apresentou a tecnologia RIFLEx, que, com apenas uma linha de código e sem treino adicional, consegue expandir a duração da geração de modelos de Transformer de difusão de vídeo baseados em RoPE (Rotary Position Embedding). Este método ajusta a “frequência intrínseca” do RoPE, garantindo que o comprimento extrapolado do vídeo permaneça dentro de um único ciclo, evitando problemas de repetição de conteúdo e câmara lenta. O RIFLEx já foi aplicado com sucesso em modelos como CogvideoX, Hunyuan e Tongyi Wanxiang, duplicando a duração do vídeo (por exemplo, de 5-6 segundos para mais de 10 segundos) e suportando a extrapolação da dimensão espacial da imagem. Este trabalho foi publicado no ICML 2025 e recebeu ampla atenção e integração da comunidade. (Fonte: WeChat)

🎯 Tendências

Detalhes do modelo DeepSeek-V3-0526 revelados, comparável ao GPT-4.5 e Claude 4 Opus: De acordo com a documentação da Unsloth e discussões na comunidade, a DeepSeek está prestes a lançar a versão mais recente do seu modelo V3, o DeepSeek-V3-0526. Alega-se que o desempenho deste modelo é comparável ao do GPT-4.5 e do Claude 4 Opus, com potencial para se tornar o modelo de código aberto mais potente do mundo. A Unsloth já preparou uma versão quantizada GGUF de 1.78 bits, utilizando o seu método “Unsloth Dynamic 2.0”, que visa permitir a execução local com perda mínima de precisão. A comunidade aguarda com grande expectativa esta atualização, focando-se no seu desempenho específico no processamento de contextos longos, capacidade de inferência, entre outros aspetos. (Fonte: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Agente inteligente Tongyi AMPO alcança inferência adaptativa, imitando a multifacetada natureza social humana: O laboratório Tongyi da Alibaba propôs um framework de aprendizagem de padrões adaptativos (AML) e o seu algoritmo de otimização AMPO, permitindo que agentes de linguagem social alternem dinamicamente entre quatro modos de pensamento predefinidos (reação intuitiva, análise de intenção, adaptação estratégica, dedução prospetiva) de acordo com o contexto da conversa. Este método visa tornar os agentes de IA mais flexíveis nas interações sociais, evitando o pensamento excessivo ou insuficiente de padrões fixos. Experiências demonstram que o AMPO, ao mesmo tempo que melhora o desempenho em tarefas, reduz eficazmente o consumo de tokens, superando modelos como o GPT-4o em benchmarks de tarefas sociais como o SOTOPIA. (Fonte: WeChat)

QwenLong-L1: Aprendizagem por reforço auxilia modelos de linguagem grandes para inferência em textos longos: Esta investigação propõe o framework QwenLong-L1, que visa expandir os modelos de inferência grandes (LRMs) existentes para cenários de texto longo através da aprendizagem por reforço (RL). O estudo define primeiro o paradigma de RL para inferência em textos longos e aponta desafios como baixa eficiência de treino e instabilidade no processo de otimização. O QwenLong-L1 aborda estes problemas através de uma estratégia de expansão progressiva de contexto, incluindo especificamente: uso de fine-tuning supervisionado (SFT) para aquecimento para estabelecer uma política inicial robusta, adoção de técnicas de RL faseadas guiadas por currículo para estabilizar a evolução da política, e incentivo à exploração da política através de uma estratégia de amostragem retrospetiva sensível à dificuldade. Em sete benchmarks de resposta a perguntas em textos longos, o QwenLong-L1-32B superou modelos como OpenAI-o3-mini e Qwen3-235B-A22B, com desempenho comparável ao Claude-3.7-Sonnet-Thinking. (Fonte: HuggingFace Daily Papers)

QwenLong-CPRS: Otimização dinâmica de contexto para LLMs de “comprimento infinito”: Este relatório técnico apresenta o QwenLong-CPRS, um framework de compressão de contexto projetado para otimização explícita de textos longos. Visa resolver o problema do custo computacional excessivo na fase de pré-preenchimento dos LLMs e a queda de desempenho em “perda no meio” no processamento de sequências longas. O QwenLong-CPRS, através de um novo mecanismo de otimização dinâmica de contexto, alcança compressão de contexto multigranular guiada por instruções em linguagem natural, melhorando assim a eficiência e o desempenho. O framework evoluiu da série de arquiteturas Qwen, introduzindo otimização dinâmica guiada por linguagem natural, camadas de inferência bidirecional com perceção de fronteira aprimorada, mecanismo de revisão de tokens com cabeça de modelagem de linguagem e inferência paralela em janela. Em cinco benchmarks com contextos de 4K a 2M palavras, o QwenLong-CPRS superou métodos como RAG e atenção esparsa em precisão e eficiência, e pode ser integrado com LLMs de ponta, incluindo o GPT-4o, para alcançar compressão de contexto e melhoria de desempenho significativos. (Fonte: HuggingFace Daily Papers)

RIPT-VLA: Fine-tuning de modelos de visão-linguagem-ação através de aprendizagem por reforço interativa: Investigadores propõem o RIPT-VLA, um paradigma de pós-treino interativo baseado em aprendizagem por reforço, que utiliza apenas recompensas de sucesso binárias esparsas para fine-tuning de modelos de visão-linguagem-ação (VLA) pré-treinados. Este método visa resolver o problema da dependência excessiva dos atuais fluxos de treino de VLA em dados de demonstração de especialistas offline e aprendizagem por imitação supervisionada, permitindo que se adaptem a novas tarefas e ambientes em situações de poucos dados. O RIPT-VLA, através de um algoritmo de otimização de política estável baseado em amostragem de implementação dinâmica e estimativa de vantagem leave-one-out, foi aplicado a vários modelos VLA, aumentando significativamente as taxas de sucesso do modelo leve QueST e do modelo 7B OpenVLA-OFT, com alta eficiência computacional e de dados. (Fonte: HuggingFace Daily Papers)

IBM lança watsonx Orchestrate, atualizando soluções de agentes de IA: Na conferência Think 2025, a IBM anunciou a versão atualizada do watsonx Orchestrate, que oferece agentes inteligentes pré-construídos para áreas especializadas (como recursos humanos, vendas, compras), suporta a construção rápida de AI Agents personalizados por empresas e permite a colaboração multi-agente através de ferramentas de orquestração de agentes. A plataforma enfatiza a gestão completa do ciclo de vida dos AI Agents, incluindo monitorização de desempenho, proteção, otimização de modelos e governação. A IBM acredita que a essência da IA empresarial é a reestruturação de negócios, devendo focar-se no valor da IA na resolução de problemas de negócios reais e na criação de resultados quantificáveis, em vez de perseguir apenas a tecnologia em si. (Fonte: WeChat)

Universidade Beihang lança framework UAV-Flow para controlo de trajetória fina de drones guiado por linguagem: A equipa do Professor Liu Si da Universidade de Aeronáutica e Astronáutica de Pequim (Beihang) propôs o framework UAV-Flow, definindo o paradigma de tarefa Flying-on-a-Word (Flow), que visa alcançar o controlo de voo reativo de curta distância e alta precisão de drones através de instruções em linguagem natural. A equipa utilizou métodos de aprendizagem por imitação para que os drones aprendessem as estratégias operacionais de pilotos humanos em ambientes reais. Para isso, construíram um conjunto de dados de aprendizagem por imitação de drones guiado por linguagem em grande escala no mundo real e estabeleceram o benchmark de avaliação UAV-Flow-Sim em ambiente de simulação. Este modelo de visão-linguagem-ação (VLA) já foi implementado com sucesso em plataformas de drones reais e validou a viabilidade do controlo de voo baseado em diálogo em linguagem natural. (Fonte: WeChat)

ByteDance lança Seedream 2.0, otimizando a geração de imagens bilíngues (chinês-inglês) e renderização de texto: Para resolver as deficiências dos modelos de geração de imagem existentes no processamento de detalhes culturais chineses, prompts de texto bilíngues e renderização de texto, a ByteDance lançou o Seedream 2.0. Este modelo, como um modelo base de geração de imagens bilíngue chinês-inglês, integra um modelo de linguagem grande bilíngue de desenvolvimento próprio como codificador de texto, aplica Glyph-Aligned ByT5 para renderização de texto a nível de caractere e Scaled ROPE para suportar a generalização para resoluções não treinadas. Através de pós-treino multifásico e otimização RLHF, o Seedream 2.0 demonstra excelente desempenho no seguimento de prompts, estética, renderização de texto e correção estrutural, e pode ser facilmente adaptado para edição de imagens baseada em instruções. (Fonte: HuggingFace Daily Papers)

Framework RePrompt utiliza aprendizagem por reforço para melhorar prompts de geração de texto para imagem: Para resolver o problema de os modelos de texto para imagem (T2I) terem dificuldade em capturar com precisão a intenção do utilizador a partir de prompts curtos ou ambíguos, investigadores propuseram o framework RePrompt. Este framework introduz raciocínio explícito no processo de melhoria de prompts através de aprendizagem por reforço, treinando modelos de linguagem para gerar prompts estruturados e autorreflexivos, e otimizando-os com base nos resultados a nível de imagem (preferências humanas, alinhamento semântico, composição visual). Este método não requer dados anotados manualmente para treino end-to-end e, em benchmarks como GenEval e T2I-Compbench, melhorou significativamente a fidelidade do layout espacial e a capacidade de generalização composicional. (Fonte: HuggingFace Daily Papers)

NOVER: Treino incentivado de modelos de linguagem com aprendizagem por reforço sem verificador: Inspirado por investigações como DeepSeek R1-Zero, este trabalho propõe o framework NOVER (NO-VERifier Reinforcement Learning), que visa resolver o problema da dependência de verificadores externos nos métodos de treino incentivado existentes (que recompensam a geração de passos de raciocínio intermédios pelo modelo com base na resposta final). O NOVER requer apenas dados de fine-tuning supervisionado padrão, sem necessidade de verificador externo, para realizar treino incentivado para várias tarefas de texto para texto. Experiências mostram que o NOVER supera em desempenho modelos de escala equivalente destilados de grandes modelos de inferência como o DeepSeek R1 671B, e oferece novas possibilidades para otimizar modelos de linguagem grandes (como treino incentivado inverso). (Fonte: HuggingFace Daily Papers)

Direct3D-S2: Framework de geração 3D de biliões de pontos baseado em atenção esparsa espacial: Para enfrentar os desafios computacionais e de memória da geração de formas 3D de alta resolução (como representações SDF), investigadores propuseram o framework Direct3D S2. Este framework, baseado em volumes esparsos, através de um inovador mecanismo de atenção esparsa espacial (SSA), melhora significativamente a eficiência computacional do Diffusion Transformer em dados volumétricos esparsos, alcançando uma aceleração de 3.9x na propagação para a frente e 9.6x na propagação para trás. O framework inclui um autoencoder variacional (VAE) que mantém um formato de volume esparso consistente nas fases de entrada, latente e saída, melhorando a eficiência e estabilidade do treino. O modelo foi treinado em conjuntos de dados públicos, e as experiências demonstram que supera os métodos existentes em qualidade de geração e eficiência, podendo completar o treino com resolução de 1024 usando 8 GPUs. (Fonte: HuggingFace Daily Papers)

App Doubao lança funcionalidade de videochamada, melhorando a experiência de interação com o assistente de IA: A app Doubao, assistente de IA da ByteDance, adicionou uma funcionalidade de videochamada. Os utilizadores podem interagir em tempo real com o Doubao através de videochamada, por exemplo, para identificar objetos (como plantas, suplementos), obter instruções de operação (como reiniciar o telemóvel), etc. Esta funcionalidade visa reduzir a barreira de entrada para o uso de ferramentas de IA, especialmente para grupos de utilizadores não familiarizados com o envio de fotos ou interação por texto, oferecendo uma forma de interação mais natural e direta, e aumentando a sensação de companhia e utilidade do assistente de IA. (Fonte: WeChat)

Modelo Veo 3 já disponível para alguns utilizadores, plataforma Flow suporta upload de imagens: O modelo de geração de vídeo Veo 3 da Google já está disponível para alguns utilizadores, não se limitando mais aos membros Ultra. Ao mesmo tempo, a sua plataforma Flow (possivelmente referindo-se ao AI Test Kitchen ou outra plataforma experimental) agora permite que os utilizadores carreguem imagens para operação ou como material de geração, expandindo as suas capacidades de interação multimodal. Isto indica que a Google está a expandir gradualmente o alcance de teste e uso dos seus modelos avançados de IA. (Fonte: WeChat)

Baixo número de downloads do modelo nacional indiano Sarvam-M após lançamento gera controvérsia: A Sarvam AI lançou o Sarvam-M, um modelo de linguagem misto de 24 mil milhões de parâmetros baseado no Mistral Small, que suporta 10 línguas locais indianas, considerado um avanço na investigação de IA nativa da Índia. No entanto, dois dias após o seu lançamento no Hugging Face, o modelo teve apenas pouco mais de trezentas descargas, muito abaixo de alguns projetos menores, o que gerou críticas de investidores como Deedy Das e outros membros da indústria, que o consideraram “um resultado desproporcional ao financiamento” e “carente de utilidade prática”. A Sarvam AI respondeu que se deve focar na contribuição do processo de construção do modelo para a comunidade e acusou os críticos de não o terem experimentado. O caso gerou uma ampla discussão sobre a necessidade de modelos de IA nativos da Índia, a adequação do produto ao mercado e as expectativas da comunidade. (Fonte: WeChat)

Kunlun Wanwei lança superagente inteligente Tiangong, com limitação de acesso inicial devido a alta simultaneidade: A Kunlun Wanwei lançou oficialmente o superagente inteligente Tiangong, que utiliza a arquitetura AI Agent e a tecnologia Deep Research, capaz de gerar documentos, PPTs, tabelas, páginas web, podcasts e conteúdo audiovisual multimodal de forma integrada. O sistema é composto por 5 agentes especialistas e 1 agente geral. Apenas três horas após o lançamento, o serviço sofreu lentidão devido ao grande volume de acesso de utilizadores, e a empresa anunciou a implementação de medidas de limitação de tráfego. (Fonte: WeChat)

Nvidia lança modelo base para robôs humanoides N1.5 e supercomputador pessoal de IA DGX: Na Computex Taipei, o CEO da Nvidia, Jensen Huang, anunciou o Isaac GR00T N1.5, um modelo base de nova geração para robôs humanoides, que reduz o ciclo de treino de 3 meses para 36 horas através da tecnologia de dados sintéticos. Foram também apresentados o modelo de mundo Cosmos Reason, a ferramenta de simulação de código aberto Isaac Sim 5.0 e a estação de trabalho RTX PRO 6000. Além disso, a Nvidia lançou os sistemas de supercomputação pessoal de IA DGX Spark e DGX Station. O DGX Spark está equipado com o superchip GB10Grace Blackwell, e o DGX Station com o superchip de desktop GB300Grace Blackwell Ultra, visando fornecer aos programadores poderosas capacidades de computação de IA. (Fonte: WeChat)

Microsoft Build 2025 foca-se em AI Agents, GitHub Copilot atualizado para programação em parceria: A conferência de programadores Microsoft Build 2025 destacou a aplicação de AI Agents. O GitHub Copilot evoluiu de assistente de código para um parceiro Agent, capaz de realizar autonomamente tarefas como correção de erros e desenvolvimento de novas funcionalidades. A Microsoft também lançou o Windows AI Foundry, para ajudar os programadores a gerir e executar LLMs de código aberto e a migrar modelos proprietários. O Microsoft 365 Copilot Tuning permite aos utilizadores aproveitar dados empresariais e lógica de negócios para treinar modelos e criar agentes inteligentes com pouco código. (Fonte: WeChat)

Tencent atualiza plataforma de desenvolvimento de agentes inteligentes TCADP, planeia abrir código de vários modelos: Na Cimeira de Aplicações Industriais de IA da Tencent Cloud, a Tencent Cloud anunciou que o seu motor de conhecimento de modelos grandes foi atualizado para a Plataforma de Desenvolvimento de Agentes Inteligentes da Tencent Cloud (TCADP) e lançado oficialmente, integrando os modelos DeepSeek-R1, V3 e pesquisa na web. A Tencent também planeia lançar o modelo de cenário 3D Hunyuan, um modelo de mundo, e abrir o código do modelo de inferência híbrida de nível empresarial, modelo de inferência híbrida para dispositivos de ponta e modelo base multimodal. Recentemente, o Tencent Hunyuan atualizou o modelo de inferência visual profunda Hunyuan T1 Vision, o modelo de chamada de voz end-to-end Hunyuan Voice e o modelo Hunyuan Image 2.0. (Fonte: WeChat)

JD Industrial lança modelo grande industrial Joy industrial, centrado na cadeia de abastecimento: A JD Industrial lançou o modelo grande Joy industrial para o setor industrial, focado em cenários da cadeia de abastecimento. Este modelo introduziu agentes de IA como agente de procura, agente de operações e agente aduaneiro para servir a JD Industrial e os seus fornecedores a montante, e fornece produtos de IA como especialista em produtos e especialista em integração para empresas utilizadoras a jusante. O objetivo futuro é criar modelos grandes industriais para setores verticais como o mercado de pós-venda automóvel, veículos de nova energia e fabrico de robôs. (Fonte: WeChat)

🧰 Ferramentas

Wen Xiaobai AI lança funcionalidade “Relatório de Investigação Xiaobai”, experiência semelhante ao Deep Research: O Wen Xiaobai AI adicionou a funcionalidade “Relatório de Investigação Xiaobai”, baseada no modelo Yuanshi de desenvolvimento próprio, capaz de simular o pensamento humano para realizar múltiplas rondas de reflexão e chamada de ferramentas, gerando automaticamente relatórios de investigação aprofundados, teses, análises setoriais, etc., apresentados em formato de página web visualizável e com suporte para exportação para PDF/DOCX. Os utilizadores, com instruções simples, podem obter relatórios de milhares de palavras contendo análise de dados, gráficos e integração de informações de múltiplas fontes em cerca de 20 minutos. Esta funcionalidade é aplicável a vários cenários, como interpretação de relatórios financeiros, estudos de mercado, recomendações de produtos, visando aumentar significativamente a eficiência no processamento de informações e na elaboração de relatórios. (Fonte: WeChat)

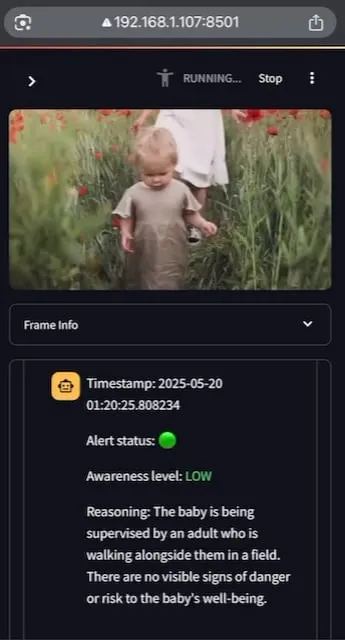

AI Baby Monitor: Aplicação de monitorização de bebés com LLM de vídeo localizada: Um programador construiu uma aplicação de monitorização de bebés com LLM de vídeo localizada chamada AI Baby Monitor. A aplicação observa o stream de vídeo e toma decisões com base em instruções de segurança predefinidas, emitindo um sinal sonoro de aviso quando deteta uma violação das regras de segurança. O projeto utiliza Qwen 2.5VL e vLLM, e recorre a Redis para orquestração de streams e Streamlit para construir a UI. A intenção inicial do programador era monitorizar a sua filha que tentava sair do berço, tendo também sido usada para monitorizar o seu próprio comportamento de verificar o telemóvel inconscientemente. Planos futuros incluem suporte para mais backends e funcionalidade de “zonas proibidas” na imagem. (Fonte: Reddit r/LocalLLaMA)

Beelzebub: Framework de honeypot de código aberto que utiliza LLMs para construir sistemas de engano avançados: Beelzebub é um framework de honeypot de código aberto que integra de forma inovadora modelos de linguagem grandes (LLMs) para criar ambientes de engano altamente realistas e dinâmicos. O framework consegue simular sistemas operativos inteiros e interagir com atacantes de forma extremamente convincente. Por exemplo, num cenário de honeypot SSH, o LLM pode fornecer respostas plausíveis a comandos, mesmo que esses comandos não sejam executados num sistema real. O seu objetivo é atrair os atacantes pelo maior tempo possível, desviando-os de sistemas reais e recolhendo dados valiosos sobre as suas táticas, técnicas e procedimentos. O projeto está disponível em código aberto no GitHub e procura feedback e contribuições da comunidade. (Fonte: Reddit r/LocalLLaMA)

Langflow: Poderosa ferramenta de construção e implementação de agentes e workflows de IA: Langflow é uma ferramenta para construir e implementar agentes e workflows impulsionados por IA. Oferece uma experiência de construção visual e um servidor API integrado, capaz de transformar cada agente num endpoint API, facilitando a integração em diversas aplicações. Langflow suporta os principais LLMs, bases de dados vetoriais e uma biblioteca crescente de ferramentas de IA, com funcionalidades como orquestração multi-agente, gestão de diálogo, Playground para testes imediatos, acesso a código, integração de observabilidade (como LangSmith) e segurança e escalabilidade de nível empresarial. O projeto é de código aberto e pode ser obtido como serviço totalmente gerido através da DataStax. (Fonte: GitHub Trending)

Pathway: Framework ETL de processamento de streams em Python, suporta análise em tempo real e pipelines LLM: Pathway é um framework ETL em Python, projetado especificamente para processamento de streams, análise em tempo real, pipelines LLM e RAG (Retrieval Augmented Generation). Fornece uma API Python fácil de usar, que pode ser integrada com várias bibliotecas de ML em Python. O seu código é universal para ambientes de desenvolvimento e produção, lidando eficazmente com dados em batch e streaming. Pathway é impulsionado por um motor Rust escalável baseado em Differential Dataflow, suportando computação incremental, multithreading, multiprocessamento e computação distribuída, com todo o pipeline mantido em memória, e fácil de implementar via Docker e Kubernetes. (Fonte: GitHub Trending)

Point-Battle: Arena de competição de capacidade de apontar guiada por linguagem para MLLMs: Membros da comunidade convidam a experimentar o Point-Battle, uma plataforma para avaliar o desempenho dos atuais principais modelos de linguagem grandes multimodais (MLLM) em tarefas de apontar guiadas por linguagem. Os utilizadores podem carregar imagens ou selecionar imagens predefinidas, inserir prompts e observar como os vários modelos “apontam” para as suas respostas, votando no modelo com melhor desempenho. Isto ajuda investigadores e programadores a compreender as diferenças de capacidade dos diferentes MLLMs na compreensão de conteúdo visual e na localização espacial com base em instruções de texto. (Fonte: Reddit r/deeplearning)

FullFront: Benchmark para avaliar a capacidade de MLLMs em processos completos de engenharia de front-end: FullFront é um novo benchmark projetado para avaliar a capacidade de modelos de linguagem grandes multimodais (MLLM) em todo o fluxo de desenvolvimento de front-end, incluindo design de páginas web (conceptualização), resposta a perguntas com perceção de páginas web (organização visual e compreensão de elementos) e geração de código de páginas web (implementação). Diferente dos benchmarks existentes, o FullFront adota um processo de duas fases para converter páginas web reais em HTML limpo e padronizado, mantendo a diversidade do design visual e evitando problemas de direitos de autor. Testes extensivos em MLLMs SOTA revelaram as suas limitações significativas na perceção de páginas, geração de código (especialmente processamento de imagens e layout) e implementação de interatividade. (Fonte: HuggingFace Daily Papers)

📚 Aprendizagem

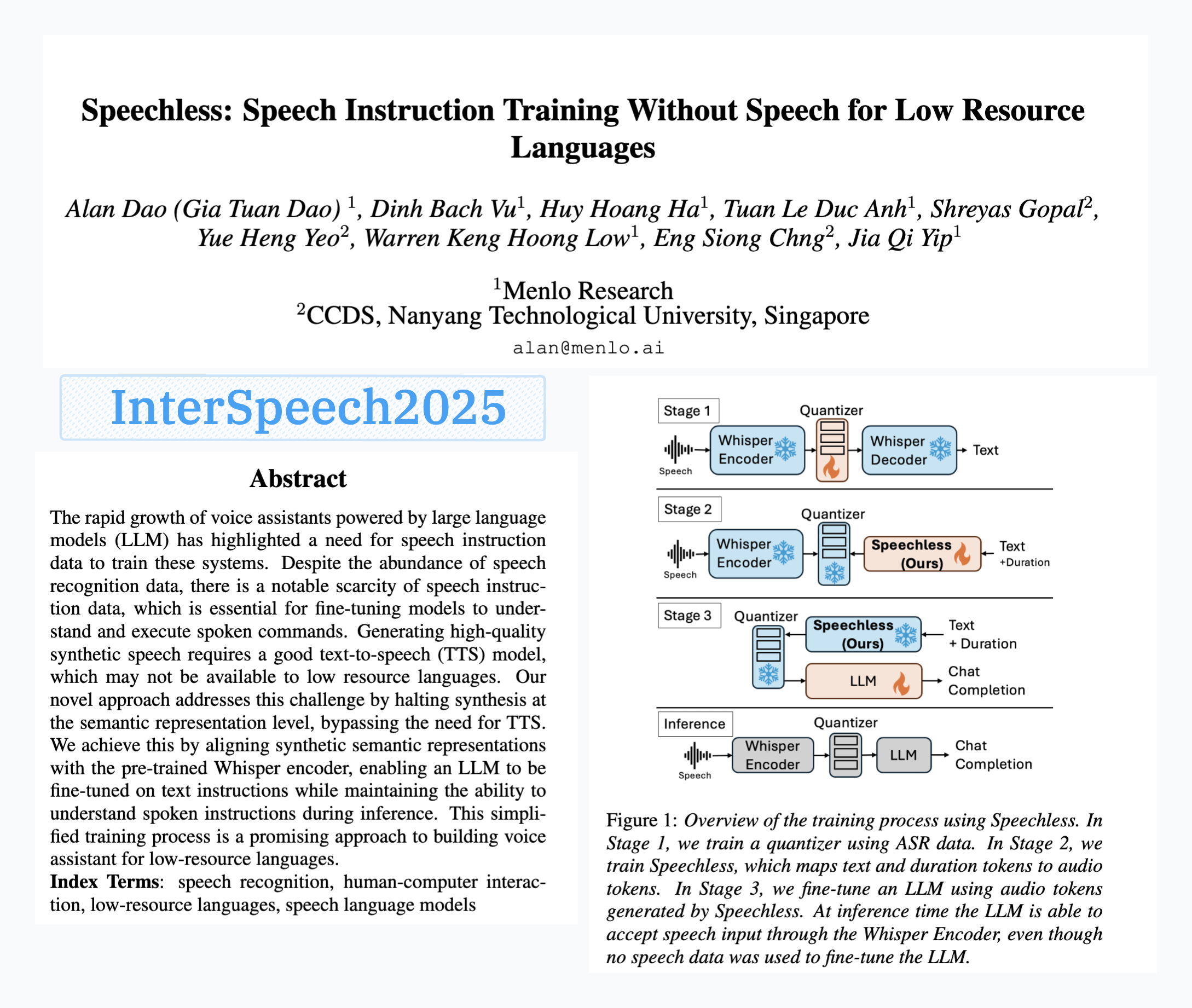

Menlo Research lança modelo SpeechLess, permitindo treino de comandos de voz sem dados de fala: O artigo “SpeechLess” da Menlo Research foi aceite no Interspeech 2025, e o modelo relacionado foi lançado. Esta investigação aborda o desafio da falta de dados de comandos de voz para línguas de baixos recursos, propondo um método para treinar modelos de comandos de voz utilizando exclusivamente dados sintéticos. Os passos centrais incluem: 1. Converter fala real em tokens discretos (treinar um quantizador); 2. Treinar o modelo SpeechLess para gerar tokens de fala simulados a partir de texto; 3. Usar este pipeline de texto para tokens de fala sintéticos para treinar um LLM para aprendizagem de comandos de voz. Os resultados demonstram que o treino com tokens de fala totalmente sintéticos é muito eficaz, abrindo novos caminhos para a construção de sistemas de voz em cenários de baixos recursos. (Fonte: Reddit r/LocalLLaMA)

Algoritmo de compressão de texto evoluído por mutação de código impulsionada por LLM: Um programador tentou usar LLMs (modelos de linguagem grandes) para evoluir algoritmos de compressão de texto através de pequenas mutações no código de um compressor de texto simples ao estilo LZ77. O método evolui ao longo de múltiplas gerações, preservando elites e sobreviventes em cada geração, com os pais a gerar descendentes. O critério de seleção baseia-se puramente na taxa de compressão; se a ronda de compressão-descompressão falhar, o candidato é descartado. Em 30 gerações, a experiência melhorou a taxa de compressão de 1.03 para 1.85. O projeto está disponível em código aberto no GitHub (think-a-tron/minevolve). (Fonte: Reddit r/MachineLearning)

Quartet: Treino nativo FP4 alcança o melhor desempenho para LLMs: Com o aumento exponencial das necessidades computacionais dos LLMs, o treino com algoritmos de baixa precisão tornou-se crucial para aumentar a eficiência. A arquitetura NVIDIA Blackwell suporta operações FP4, mas os algoritmos de treino FP4 existentes enfrentam queda de precisão e dependência de precisão mista. Investigadores estudaram sistematicamente o treino FP4 suportado por hardware e propuseram o método Quartet, que realiza treino FP4 end-to-end, com a maioria dos cálculos feitos em baixa precisão. Através de uma avaliação extensiva de modelos do tipo Llama, revelaram novas leis de escalonamento de baixa precisão, quantificaram os compromissos de desempenho para diferentes larguras de bits e identificaram o Quartet como a técnica de treino de baixa precisão quase ótima em termos de precisão e computação. Usando kernels CUDA otimizados, o Quartet alcançou com sucesso precisão FP4 de ponta em modelos de biliões de parâmetros. (Fonte: HuggingFace Daily Papers)

Synthetic Data RL (Aprendizagem por Reforço com Dados Sintéticos): Fine-tuning de modelos apenas com a definição da tarefa: Esta investigação propõe o framework Synthetic Data RL, que realiza fine-tuning de modelos através de aprendizagem por reforço utilizando apenas dados sintéticos gerados a partir da definição da tarefa. O método primeiro gera pares de pergunta-resposta a partir da definição da tarefa e de documentos recuperados, depois ajusta a dificuldade das perguntas com base na capacidade de resolução do modelo, e seleciona perguntas para treino RL com base na taxa média de aprovação do modelo nas amostras. No Qwen-2.5-7B, este método alcançou melhorias significativas em vários benchmarks como GSM8K, MATH, GPQA, superando o fine-tuning supervisionado e aproximando-se dos resultados de RL com dados humanos completos, mostrando potencial na redução da anotação manual. (Fonte: HuggingFace Daily Papers)

TabSTAR: Modelo base tabular com representações semânticas sensíveis ao objetivo: Apesar do sucesso da aprendizagem profunda em múltiplas áreas, em tarefas de aprendizagem tabular ainda não supera as árvores de decisão com gradient boosting (GBDTs). Investigadores lançaram o TabSTAR, um modelo base tabular com representações semânticas sensíveis ao objetivo, projetado para realizar aprendizagem por transferência em dados tabulares com características textuais. O TabSTAR descongela um codificador de texto pré-treinado e insere tokens de objetivo, fornecendo ao modelo o contexto necessário para aprender embeddings específicos da tarefa. Este modelo, em tarefas de classificação com características textuais, alcançou desempenho SOTA em conjuntos de dados de média e grande dimensão, e a sua fase de pré-treino demonstrou leis de escalonamento em relação à quantidade de conjuntos de dados. (Fonte: HuggingFace Daily Papers)

TIME: Benchmark de inferência temporal de LLM multinível para cenários do mundo real: A inferência temporal é crucial para que os LLMs compreendam o mundo real. Trabalhos existentes negligenciam os desafios da inferência temporal no mundo real: informação temporal densa, dinâmicas de eventos em rápida mudança e dependências temporais complexas em interações sociais. Para isso, investigadores propuseram o benchmark multinível TIME, contendo 38.522 pares de QA, cobrindo 3 níveis e 11 sub-tarefas de granularidade fina, bem como três subconjuntos de dados TIME-Wiki, TIME-News e TIME-Dial, refletindo respetivamente diferentes desafios do mundo real. A investigação realizou experiências extensivas e análises aprofundadas em vários modelos e lançou um subconjunto anotado manualmente, o TIME-Lite. (Fonte: HuggingFace Daily Papers)

Inferência de LLM com notas dinâmicas: Melhorando a capacidade de resposta a perguntas complexas: O RAG iterativo, ao lidar com respostas a perguntas multi-hop, enfrenta desafios de contexto excessivamente longo e acumulação de informação irrelevante, afetando a capacidade de processamento e inferência do modelo. Investigadores propuseram o método “Notes Writing” (Escrita de Notas), que gera notas concisas e relevantes a partir de documentos recuperados em cada passo, reduzindo o ruído, preservando informação crucial e, assim, aumentando indiretamente o comprimento efetivo do contexto do LLM, melhorando as suas capacidades de inferência e planeamento. Este método é independente do framework e pode ser integrado em diferentes métodos de RAG iterativo, mostrando melhorias de desempenho significativas em experiências. (Fonte: HuggingFace Daily Papers)

Framework s3: Treino de agentes de pesquisa eficientes com RL usando poucos dados: Sistemas de Retrieval Augmented Generation (RAG) permitem que LLMs acedam a conhecimento externo. Investigações recentes usam aprendizagem por reforço (RL) para que LLMs atuem como agentes de pesquisa, mas os métodos existentes ou otimizam a recuperação ignorando a utilidade downstream, ou fazem fine-tuning de todo o LLM, acoplando a recuperação à geração. Investigadores propuseram o framework s3, um método leve e independente do modelo, que desacopla o pesquisador do gerador e usa o “Ganho Além do RAG” (Gain Beyond RAG) como recompensa para treinar o pesquisador. O s3, com apenas 2.4k amostras de treino, superou baselines que usaram mais de 70 vezes mais dados, apresentando melhor desempenho em vários benchmarks de QA. (Fonte: HuggingFace Daily Papers)

ReflAct: Tomada de decisão de agentes LLM no mundo através da reflexão sobre o estado objetivo: Agentes LLM existentes (como os baseados em ReAct), ao intercalarem pensamento e ação em ambientes complexos, frequentemente produzem raciocínios não fundamentados ou incoerentes, resultando num desalinhamento entre o estado real e o objetivo. Investigadores analisam que isto se deve à dificuldade do ReAct em manter crenças internas consistentes e alinhamento com o objetivo. Para isso, propuseram o ReflAct, uma nova rede de base que muda o raciocínio do planeamento da próxima ação para uma reflexão contínua sobre o estado do agente em relação ao seu objetivo. Ao basear explicitamente as decisões no estado e forçar um alinhamento contínuo com o objetivo, o ReflAct melhora significativamente a fiabilidade da política, superando largamente o ReAct em tarefas como ALFWorld. (Fonte: HuggingFace Daily Papers)

FREESON: Framework de inferência aumentada por recuperação sem recuperador: Modelos de inferência grandes (LRMs) demonstram excelente desempenho em inferência multi-passo e na chamada a motores de busca, mas os métodos de aumento por recuperação existentes dependem de modelos de recuperação independentes, limitando o papel dos LRMs na recuperação e podendo causar erros devido a gargalos de representação. Investigadores propuseram o framework FREESON, que permite que os LRMs recuperem conhecimento por si próprios, atuando como geradores e recuperadores. Este framework introduz o algoritmo CT-MCTS, especificamente para tarefas de recuperação, permitindo que o LRM navegue no corpus em direção à região da resposta. Experiências demonstram que o FREESON supera significativamente modelos de inferência multi-passo que usam recuperadores independentes em vários benchmarks de QA de domínio aberto. (Fonte: HuggingFace Daily Papers)

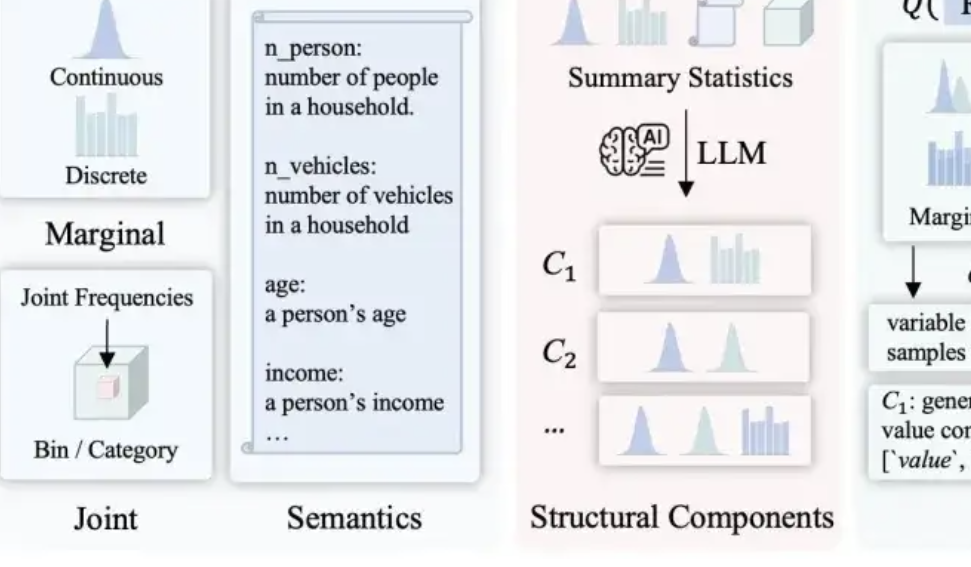

LLMSynthor: Universidade McGill propõe novo framework para síntese de dados estatisticamente controlável: Para resolver as deficiências dos métodos de síntese de dados existentes em termos de razoabilidade, consistência de distribuição e escalabilidade, a equipa da Universidade McGill lançou o framework LLMSynthor. Este framework não faz com que os modelos grandes gerem dados diretamente, mas transforma-os em “geradores conscientes da estrutura”. Através de raciocínio estrutural, alinhamento estatístico (comparando resumos estatísticos em vez de dados brutos), geração de regras de distribuição amostráveis (em vez de amostras individuais) e um processo de alinhamento iterativo, gera conjuntos de dados sintéticos que são estrutural e estatisticamente muito próximos dos dados reais e consistentes com o senso comum. Este método tem garantias teóricas de convergência e foi validado em múltiplos cenários reais, como transações de comércio eletrónico, dados demográficos e mobilidade urbana, sendo compatível com vários modelos grandes. (Fonte: QubitAI)

💼 Negócios

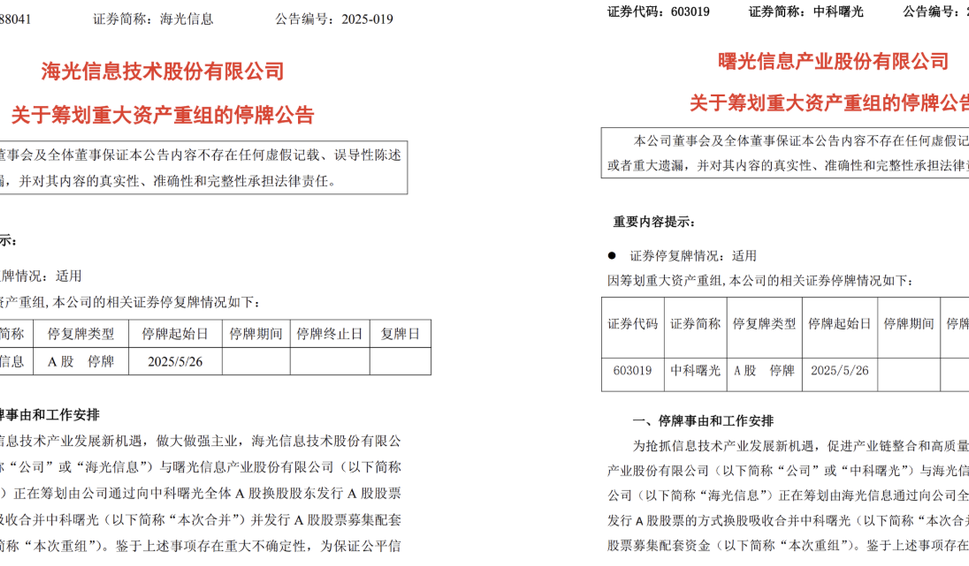

Hygon Information e Sugon planeiam grande reestruturação de ativos, possível fusão: A empresa de design de chips Hygon Information e a gigante de supercomputação Sugon anunciaram ambas a suspensão da negociação das suas ações. A Hygon Information pretende absorver e fundir-se com a Sugon através da emissão de ações A para todos os acionistas de ações A da Sugon, e planeia emitir ações A para angariar fundos complementares. A Hygon Information foca-se na investigação e desenvolvimento de CPUs e GPUs de ponta, enquanto a Sugon tem uma vasta experiência em servidores e computação de alto desempenho, sendo também a maior acionista da Hygon Information. Se bem-sucedida, esta fusão criará uma gigante nacional de capacidade computacional com um valor de mercado total de quase 400 mil milhões de yuans, exercendo um impacto profundo no panorama da indústria de computação da China. (Fonte: QubitAI, WeChat)

LMArena.ai responde ao artigo da Cohere e obtém financiamento de 100 milhões de dólares: O ranking de modelos de IA LMArena.ai respondeu à sua controvérsia com a empresa Cohere sobre testes de benchmark e anunciou recentemente um financiamento de 100 milhões de dólares, atingindo uma avaliação de 600 milhões de dólares. A reação da comunidade foi mista, com alguns utilizadores a considerar que a resposta do LMArena continha declarações estatisticamente questionáveis, e que o grande investimento de VCs poderia prejudicar a sua credibilidade como benchmark neutro, temendo que o seu modelo de negócio pudesse afetar as hipóteses de modelos abertos aparecerem no ranking ou a acessibilidade dos dados. (Fonte: Reddit r/LocalLLaMA)

JD investe na empresa de robótica Zhiyuan Robotics de ZHIHUIJUN: A Zhiyuan Robotics concluiu recentemente uma nova ronda de financiamento, com investidores incluindo a JD e o Shanghai Embodied Intelligence Fund, com alguns acionistas antigos a acompanharem o investimento. A Zhiyuan Robotics foi fundada em 2023 pelo ex-“génio júnior” da Huawei, Peng Zhihui (ZHIHUIJUN), e foca-se na investigação e desenvolvimento de robôs de inteligência incorporada. Este financiamento irá impulsionar ainda mais os investimentos da Zhiyuan Robotics em I&D tecnológico e expansão de mercado. (Fonte: WeChat)

🌟 Comunidade

Discussão sobre problemas de integração do OpenWebUI com Ollama e ferramentas MCP: Um utilizador do Reddit encontrou problemas ao usar o OpenWebUI com o backend Ollama (modelo devstral:24b) e a ferramenta MCP (mcp-atlassian): apesar de o log do servidor MCP mostrar uma resposta de sucesso 200, o OpenWebUI exibia a mensagem “Parece haver um problema ao recuperar dados da ferramenta” ou “Sem permissão para aceder à ferramenta”. O utilizador procurava métodos de depuração. Outro utilizador questionou como o LLM no OpenWebUI utiliza as ferramentas MCP, especificamente como o LLM sabe qual ferramenta usar e a razão da instabilidade na chamada das ferramentas. (Fonte: Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Explorando o impacto da IA no futuro da humanidade: divisão, regresso à natureza ou coexistência?: Um utilizador do Reddit apresentou uma visão sobre o futuro da IA, sugerindo que esta poderia levar a uma divisão da humanidade: uma parte sentir-se-ia perdida devido à substituição do trabalho e das atividades criativas pela IA, acabando por regressar a uma vida natural e sem tecnologia; outra parte fundir-se-ia profundamente com a tecnologia, tornando-se ciborgues. Uma forte erupção solar poderia destruir toda a tecnologia, e nesse momento, apenas os humanos adaptados à natureza sobreviveriam. O post também levantou outra possibilidade: a humanidade aprenderia a coexistir harmoniosamente com a IA, usando-a como ferramenta e não como divindade. A secção de comentários gerou uma discussão acalorada, abordando questões de viabilidade, dependência tecnológica, distribuição de recursos, etc. (Fonte: Reddit r/ArtificialInteligence)

Refletindo sobre o nível de compreensão dos LLMs: Será que realmente não sabemos como funcionam?: Um utilizador do Reddit questionou a afirmação de que “o funcionamento dos LLMs não é totalmente compreendido”. O utilizador argumenta que, embora possamos não compreender totalmente por que a semântica distribuída é tão poderosa ou por que a geração de código pode ser modelada eficazmente por LLMs, os mecanismos internos dos LLMs, como codificadores/descodificadores e redes feed-forward, são conhecidos. O utilizador considera que confundir “não compreender totalmente os seus limites de capacidade e fenómenos emergentes” com “não compreender de todo o seu princípio de funcionamento” induz o público em erro e pode fomentar uma compreensão errada e antropomórfica dos LLMs, como atribuir-lhes uma “agência” inexistente. A secção de comentários, no entanto, salientou que conhecer a arquitetura básica não equivale a compreender como sistemas complexos produzem resultados, por exemplo, o que cada rede feed-forward faz especificamente continua a ser um mistério. (Fonte: Reddit r/ArtificialInteligence)

Abuso de ferramentas de resumo por IA (como Grok) nas redes sociais levanta preocupações sobre “terceirização do pensamento”: Um utilizador do Reddit observou que em redes sociais como o X (antigo Twitter), é frequente o uso de “@grok resume isto” para responder a conteúdos simples (como comentários sobre sanduíches). O autor do post considera que isto reflete o abandono do esforço básico de pensamento e julgamento, entregando à IA processos de tomada de decisão e reflexão mínimos que poderiam ser realizados pela própria pessoa, levando a uma menor dependência das próprias capacidades de raciocínio. As opiniões na secção de comentários foram diversas: alguns consideram que isto é apenas uma evolução das ferramentas (semelhante ao uso do Google para pesquisar no passado), outros que é uma manifestação de preguiça, e houve quem salientasse que este fenómeno é mais comum em plataformas específicas. (Fonte: Reddit r/ArtificialInteligence)

Potencial e reflexões sobre a IA na educação: auxiliar na aprendizagem ou enfraquecer capacidades?: Um utilizador do Reddit lamentou que, se tivesse IA no ensino secundário, a experiência de aprendizagem poderia ter sido muito diferente, pois a IA consegue decompor o conhecimento detalhadamente, responder a perguntas sem preconceitos e ajudar a manter a curiosidade. Muitos comentadores concordaram, considerando que a IA pode aumentar significativamente a eficiência da aprendizagem e a amplitude da exploração do conhecimento. No entanto, alguns comentadores expressaram preocupações, argumentando que as ferramentas de IA atuais podem ser projetadas para “manter os utilizadores ignorantes”, ou que a distribuição desigual de recursos educativos levaria as classes mais ricas a obter assistência de IA de qualidade, enquanto os alunos de escolas públicas poderiam ser prejudicados por ferramentas de IA de má qualidade, ou até mesmo serem “treinados” pela IA para apenas obedecer. (Fonte: Reddit r/ArtificialInteligence)

Explorando as mudanças profissionais na era da IA: todos gestores ou surgimento de um “fosso de IA”?: Um post no Reddit gerou uma discussão sobre as futuras formas de trabalho após a popularização da IA. O autor imaginou se, no futuro, todos os humanos se tornariam gestores de ferramentas de IA, trabalhando apenas algumas horas por semana. As opiniões na secção de comentários foram diversas: alguns acreditam que a IA poderá substituir os cargos de gestão; outros sugerem que a sociedade futura será dividida entre classes “com robôs” e “sem robôs”; há também quem considere que esta transformação já está a acontecer e não é algo distante. O cerne da discussão reside em como a IA irá remodelar as responsabilidades profissionais e o papel dos humanos no sistema económico. (Fonte: Reddit r/ArtificialInteligence)

Comunicação assistida por IA: resolvendo o dilema da escrita de emails para pessoas com ansiedade social: Um utilizador do Reddit partilhou como a IA o ajudou a melhorar a sua comunicação por email. O utilizador afirmou não ter jeito para escrever emails adequados, sendo ou demasiado formal como Shakespeare, ou como um robot de atendimento ao cliente antiquado. Agora, ao redigir emails com IA e depois adicionar o seu toque pessoal, resolveu eficazmente os problemas com os inícios de email (como “Hope this email finds you well”) e outros desafios sociais. Este post gerou empatia em muitos utilizadores com ansiedade social ou dificuldades de escrita semelhantes, que consideram que a IA demonstra valor prático na assistência à comunicação diária. (Fonte: Reddit r/artificial)

💡 Outros

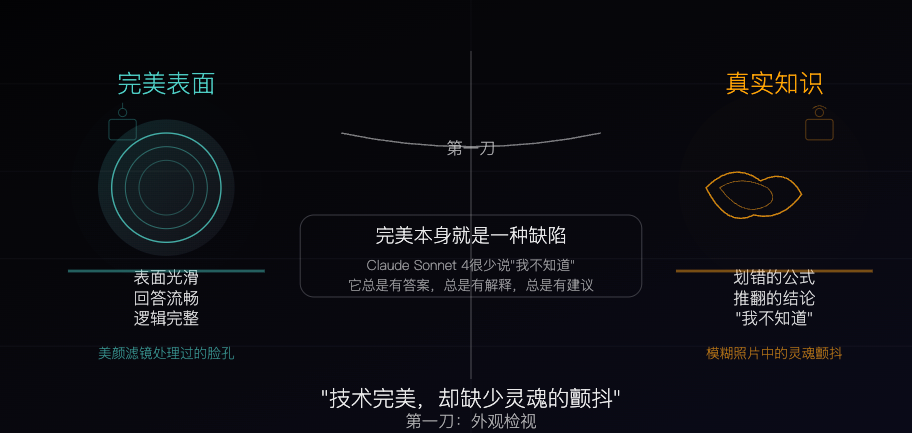

Claude Sonnet 4: Um espécime de conhecimento esculpido por algoritmos, a perfeição também é uma falha: Um artigo filosófico compara o Claude Sonnet 4 a um “espécime de conhecimento” meticulosamente esculpido por algoritmos. O autor considera que as suas respostas são fluídas e logicamente completas, aparentemente perfeitas, mas essa perfeição em si mascara as características “imperfeitas” do conhecimento real, como erros, contradições e a honestidade de um “não sei”. O artigo explora as diferenças entre as fontes de conhecimento da IA e a experiência humana, salientando que a IA possui memória, mas carece de experiência. Ao mesmo tempo, alerta que a dependência excessiva da IA pode enfraquecer a capacidade de pensamento independente e argumenta que a IA elimina a incerteza, o que é tanto o seu valor como o seu perigo potencial. (Fonte: WeChat)

O estado atual e o futuro da publicidade gerada por IA: anúncio de empresa indiana gera discussão sobre “sensação de baixo custo”: Um post no Reddit mostrou um anúncio de televisão de uma conhecida empresa indiana totalmente gerado por IA, o que gerou uma discussão entre os utilizadores sobre a qualidade do conteúdo gerado por IA e as tendências futuras. Muitos comentários consideraram o anúncio mal produzido e com maus resultados, mas outros salientaram que isto pode refletir o facto de o próprio mercado publicitário indiano já ter muitas produções de baixo custo. A discussão estendeu-se ao potencial de personalização da publicidade por IA (como televisões inteligentes que geram anúncios em tempo real com base nos dados do utilizador) e se as pessoas se adaptarão gradualmente ou até mesmo esperarão essa “sensação de tosquice”. (Fonte: Reddit r/ChatGPT)

Explorando estratégias de otimização para modelos grandes e pequenos em ambientes de baixos recursos: A comunidade Reddit discute se, em ambientes de baixos recursos, é mais prático priorizar o desenvolvimento de técnicas de otimização para modelos grandes (como PEFT, LoRA, quantização) ou dedicar esforços para melhorar o desempenho de modelos pequenos para igualar os modelos grandes. Os participantes estão interessados na viabilidade de comprimir o conhecimento e a capacidade de “raciocínio” de modelos de biliões de parâmetros em modelos pequenos, como de 100 milhões de parâmetros (semelhante aos modelos destilados de Deepseek Qwen), e no limite inferior de parâmetros para modelos pequenos. Isto reflete a contínua atenção da comunidade à democratização e implementação eficiente da IA. (Fonte: Reddit r/deeplearning)