Palavras-chave:GPT-5, capacidade de raciocínio de IA, AlphaEvolve, OpenAI Operator, Mistral AI, cálculo durante o teste e cadeia de pensamento, otimização autônoma de código por IA, modelo de IA multimodal, automação de procura de emprego com IA, ajuste fino de LLM local

🔥 Foco

OpenAI revela planos futuros: GPT-5 integrará ferramentas existentes para criar uma experiência All-in-One: Jerry Tworek, Vice-Presidente de Pesquisa da OpenAI, revelou num AMA no Reddit que o objetivo central do modelo de base da próxima geração, GPT-5, é melhorar as capacidades dos modelos existentes e reduzir o incómodo da troca de modelos. Para isso, a OpenAI planeia integrar ferramentas existentes como Codex (programação), Operator (execução de tarefas computacionais), Deep Research (pesquisa aprofundada) e Memory (função de memória) no GPT-5, para alcançar uma experiência unificada. Membros da equipa também partilharam que o Codex foi inicialmente um projeto paralelo de engenheiros, cujo uso interno aumentou a eficiência de programação em cerca de 3 vezes, e estão a explorar esquemas de preços flexíveis, incluindo pagamento conforme o uso. (Fonte: WeChat)

Nova dimensão no avanço da capacidade de raciocínio da IA: computação em tempo de teste e Cadeia de Pensamento: Lilian Weng, ex-aluna da Universidade de Pequim e antiga líder de pesquisa em IA aplicada na OpenAI, no seu mais recente artigo extenso “Why We Think”, explora aprofundadamente como melhorar a capacidade de raciocínio de grandes modelos de linguagem através de estratégias como “computação em tempo de teste” (test-time compute) e “Cadeia de Pensamento” (Chain-of-Thought, CoT). O artigo explana a racionalidade de fazer o modelo “pensar mais” sob múltiplas perspetivas, como a teoria dos dois sistemas da psicologia, a visão dos recursos computacionais e a modelagem de variáveis latentes, e revê os avanços da pesquisa em técnicas cruciais como amostragem paralela, revisão sequencial, aprendizagem por reforço e uso de ferramentas externas na melhoria do desempenho de raciocínio do modelo. Weng enfatiza que, através destes métodos, os modelos podem alocar mais recursos computacionais durante o raciocínio, simulando o processo de pensamento profundo humano, alcançando assim um desempenho superior em tarefas complexas, e aponta direções futuras de pesquisa em raciocínio fiel, “reward hacking”, autocorreção não supervisionada, entre outros. (Fonte: WeChat, WeChat)

Google lança AlphaEvolve: IA escreve código autonomamente para otimizar algoritmos, poupando significativamente custos computacionais: A Google introduziu o sistema de IA AlphaEvolve, capaz de escrever e otimizar código autonomamente, já demonstrando um enorme potencial em projetos como o AlphaFold. O AlphaEvolve utiliza algoritmos evolutivos para procurar implementações de algoritmos superiores. Por exemplo, no algoritmo de dobragem de proteínas do AlphaFold, descobriu um novo mecanismo de atenção que reduziu os custos computacionais em 25%, o equivalente a uma poupança de milhões de dólares em recursos computacionais. Este avanço marca um passo importante da IA nos campos da descoberta científica e otimização de algoritmos, com potencial futuro para reduzir custos e aumentar a eficiência em problemas computacionais mais complexos. (Fonte: Reddit r/ArtificialInteligence)

OpenAI admite: investimento em raciocínio de IA é proporcional ao desempenho, a chave para superar a capacidade humana é o “tempo de pensamento”: Noam Brown, pesquisador da OpenAI, enfatizou numa discussão que a IA está a transitar do “paradigma de pré-treino” para o “paradigma de raciocínio”. O pré-treino prevê a próxima palavra através de grandes volumes de dados, com custos elevados; enquanto o paradigma de raciocínio permite que o modelo “pense” mais profundamente antes de responder, e mesmo que o custo seja ligeiramente superior, a qualidade da resposta melhora significativamente. Por exemplo, o modelo o1 superou o GPT-4o na competição de matemática AIME e em problemas científicos de nível doutoral do GPQA, e o modelo o3 atingiu o nível de topo humano em competições de programação. Isto indica que, ao aumentar o investimento em recursos computacionais durante o raciocínio (ou seja, “tempo de pensamento”), o desempenho da IA em tarefas complexas pode dar um salto gigantesco, superando até mesmo os humanos. (Fonte: WeChat)

🎯 Tendências

Mistral AI alcança resultados significativos com modelos em 2025, vários modelos com desempenho excelente: A Mistral AI obteve vários progressos importantes no primeiro semestre de 2025, lançando vários modelos de alto desempenho, incluindo Codestral 25.01 (modelo FIM de topo), Mistral Small 3 & 3.1 (melhor na sua classe, suporta multimodalidade e contexto de 130k), Mistral Saba (desempenho superior a modelos três vezes maiores), Mistral OCR (modelo OCR de topo) e Mistral Medium 3. Estes resultados demonstram a forte capacidade de P&D da Mistral AI em diferentes tamanhos de modelos e áreas de aplicação, especialmente em geração de código, processamento multimodal e tecnologia OCR, onde alcançou liderança. (Fonte: qtnx_)

Flutuações recentes no desempenho do modelo Claude, feedback dos utilizadores sobre problemas no processamento de contexto e na funcionalidade Artifact: Utilizadores da comunidade Reddit relataram que o modelo Claude da Anthropic (especialmente o Opus 3) tem apresentado recentemente problemas no processamento de contextos longos, na estabilidade da geração de Artifacts e no login e tempo de atividade. Especificamente, as conversas são interrompidas após poucas interações, e a funcionalidade Artifact não consegue concluir ou exporta ficheiros vazios. A página de estado da Anthropic confirmou um aumento nos erros de pedidos de contexto longo e várias interrupções de serviço de curta duração, possivelmente relacionadas com o lançamento da funcionalidade Artifact e ajustes no backend. Alguns utilizadores mitigaram os problemas solicitando diretamente a saída em Markdown, mudando de rede ou usando o Claude 3.5 Sonnet. (Fonte: Reddit r/ClaudeAI, qtnx_, Reddit r/ClaudeAI)

xAI revela prompts de sistema do Grok, expondo o seu design de humor e pensamento crítico: A xAI tornou públicos os prompts de sistema do seu modelo de IA Grok, que revelam que o Grok foi projetado para ser um assistente de IA com sentido de humor, um toque de rebeldia e capacidade de pensamento crítico. Os prompts enfatizam que o Grok deve evitar respostas moralistas e encorajam-no a exibir um “estilo Grok” único ao abordar tópicos controversos. Esta ação aumenta a transparência no design do comportamento dos modelos de IA e permite ao público vislumbrar a origem da personalidade distinta do Grok. (Fonte: Reddit r/artificial)

Meta poderá estar a testar o modelo Llama 3.3 8B Instruct na OpenRouter: A Meta poderá estar a testar o seu modelo Llama 3.3 8B Instruct na plataforma OpenRouter. O modelo é descrito como uma versão leve e de resposta rápida do Llama 3.3 70B, com uma janela de contexto de 128.000 e aparece como gratuito na OpenRouter. Alguns utilizadores, após testes, consideraram a sua saída um pouco insípida em comparação com as versões 8B 3.1 ou 3.3 70B. Esta iniciativa pode significar que a Meta está a explorar a implementação e cenários de aplicação para modelos de diferentes escalas. (Fonte: Reddit r/LocalLLaMA)

Decisão controversa de IA em corridas de F1 gera discussão: Uma discussão sobre uma decisão controversa tomada por IA numa corrida de F1 despertou a atenção para a aplicação da IA no desporto competitivo. Embora os detalhes específicos não sejam claros, isto geralmente envolve a precisão e imparcialidade dos sistemas de arbitragem por IA em situações de alta velocidade e complexidade, bem como a forma como os árbitros humanos e os sistemas de IA podem trabalhar em conjunto. (Fonte: Ronald_vanLoon)

Primeiro porta-aviões drone da China, “Jiutian”, planeia voo inaugural em junho: A China planeia realizar em junho o voo inaugural do seu primeiro porta-aviões drone aéreo, o “Jiutian” SS-UAV. Este drone pode operar a uma altitude de 15.000 metros, transportar mais de 100 pequenos drones ou 1000 kg de mísseis, e tem um alcance de 7000 km. Esta notícia gerou atenção sobre o desenvolvimento da tecnologia de drones militares da China. (Fonte: menhguin)

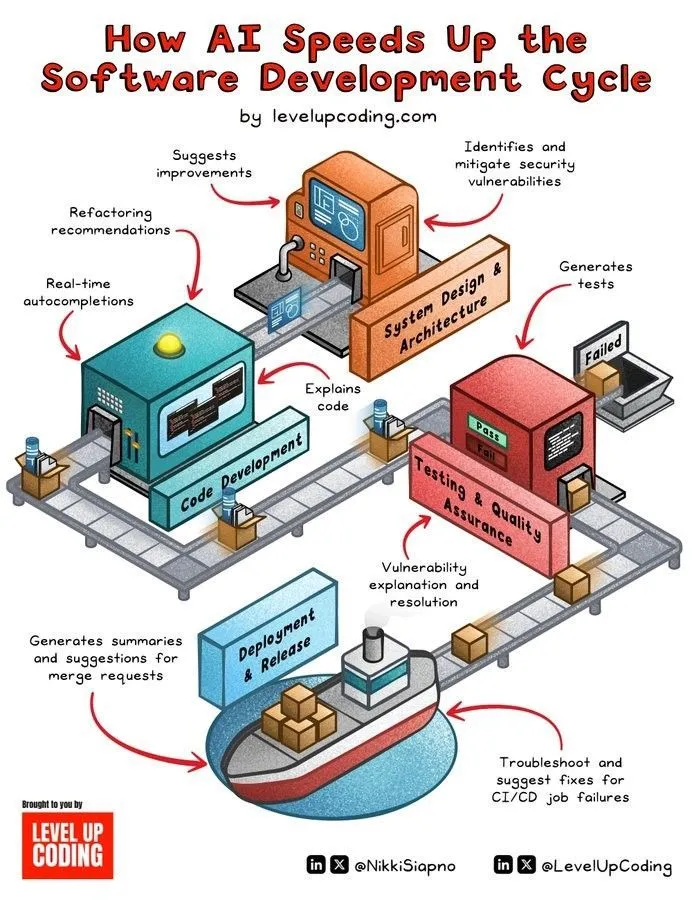

IA acelera o ciclo de desenvolvimento de software: A tecnologia de IA está a acelerar significativamente o ciclo de vida do desenvolvimento de software através da automação de tarefas como geração de código, testes, depuração e escrita de documentação. As ferramentas de IA ajudam os programadores a aumentar a eficiência, reduzir trabalho repetitivo e podem detetar erros potenciais, encurtando assim o tempo de lançamento de produtos no mercado. (Fonte: Ronald_vanLoon)

Microtecnologia semelhante ao cérebro humano confere a robôs humanoides capacidade de perceção e pensamento em tempo real: Está a ser desenvolvida uma microtecnologia que imita a estrutura do cérebro humano, com o objetivo de dotar robôs humanoides de capacidade de perceção visual e pensamento em tempo real. Esta tecnologia pode envolver computação neuromórfica ou design eficiente de chips de IA, para permitir que os robôs reajam de forma mais rápida e inteligente em ambientes complexos. (Fonte: Ronald_vanLoon)

Fourier Intelligence lança robô humanoide de desenvolvimento próprio Fourier GR-1: A Fourier Intelligence (Fourier Robots) apresentou o seu robô humanoide GR-1, desenvolvido internamente. O design do robô foca-se em controlo de movimento avançado e numa estrutura de tronco altamente biomimética, visando alcançar capacidades de movimento mais flexíveis e naturais, demonstrando o progresso da China no campo dos robôs humanoides. (Fonte: Ronald_vanLoon)

Robô biónico Unitree G1 com agilidade melhorada: A empresa Unitree apresentou uma versão do seu robô biónico G1 com agilidade melhorada. Isto geralmente significa que o robô teve melhorias no controlo de movimento, capacidade de equilíbrio, adaptabilidade ao ambiente, entre outros aspetos, permitindo-lhe executar tarefas de forma mais flexível e lidar com terrenos complexos. (Fonte: Ronald_vanLoon)

Robôs humanoides chineses realizam tarefas de inspeção de qualidade: Robôs humanoides na China estão a ser utilizados para realizar tarefas de inspeção de qualidade. Isto indica que a aplicação de robôs humanoides no campo da automação industrial está a expandir-se gradualmente, utilizando a sua flexibilidade e capacidade de perceção para substituir ou auxiliar o trabalho humano em tarefas de inspeção repetitivas e com rigorosos requisitos de precisão. (Fonte: Ronald_vanLoon)

Nanorobôs transportam “armas escondidas” para matar células cancerígenas: Um novo avanço na tecnologia médica mostra que nanorobôs conseguem transportar “armas escondidas” para atingir e matar células cancerígenas com precisão. Esta tecnologia utiliza o tamanho minúsculo e a controlabilidade dos nanorobôs, prometendo tratamentos contra o cancro mais precisos e com menos efeitos secundários. (Fonte: Ronald_vanLoon)

Tecnologias de melhoria da privacidade cada vez mais importantes para os negócios modernos: Com o endurecimento das regulamentações de privacidade de dados e o aumento da consciencialização dos utilizadores sobre a proteção de informações pessoais, as tecnologias de melhoria da privacidade (PETs) tornam-se cada vez mais importantes para as empresas modernas. Estas tecnologias, como a aprendizagem federada e a encriptação homomórfica, permitem a análise de dados e a extração de valor, protegendo ao mesmo tempo a privacidade dos dados, ajudando as empresas a desenvolverem-se em conformidade. (Fonte: Ronald_vanLoon)

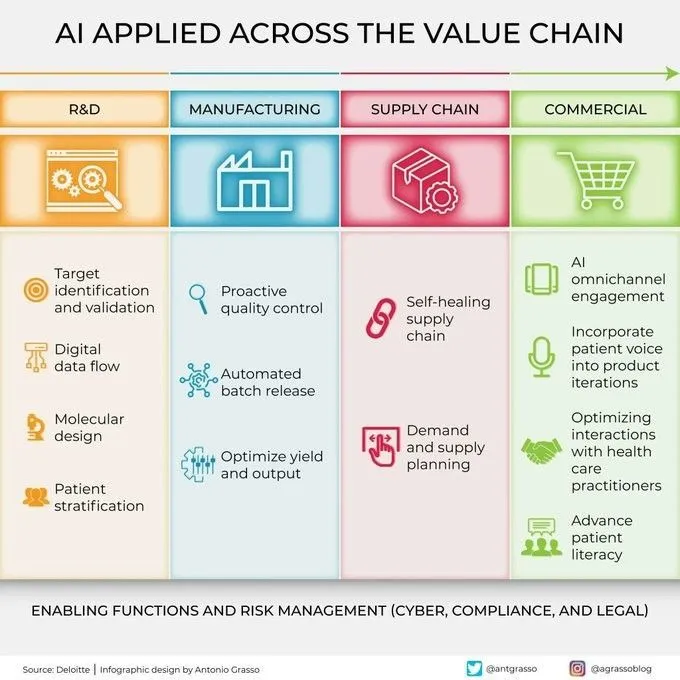

IA cada vez mais aplicada em todas as fases da cadeia de valor: A tecnologia de inteligência artificial está a ser amplamente aplicada em todas as fases da cadeia de valor das empresas, incluindo P&D, produção, marketing, vendas e serviço pós-venda. Através da análise de dados, modelagem preditiva, automação de processos, entre outros, a IA ajuda as empresas a otimizar a eficiência operacional, melhorar a experiência do cliente e criar novo valor comercial. (Fonte: Ronald_vanLoon)

🧰 Ferramentas

KernelSU: Solução de Root para Android baseada no kernel: KernelSU é uma solução de Root baseada no kernel, projetada para dispositivos Android. Ele fornece su a nível de kernel e gestão de acesso Root, possui um sistema de módulos baseado em OverlayFS e funcionalidade de perfis de aplicação, visando um controlo mais profundo das permissões do dispositivo. O projeto suporta dispositivos Android GKI 2.0 (kernel 5.10+), também é compatível com kernels mais antigos (4.14+, requer compilação manual) e suporta WSA, ChromeOS e ambientes Android em contêineres. (Fonte: GitHub Trending)

Sunshine: Anfitrião de streaming de jogos auto-hospedado, compatível com Moonlight: Sunshine é um software de código aberto para anfitrião de streaming de jogos auto-hospedado, permitindo aos utilizadores transmitir jogos de PC para vários dispositivos compatíveis com Moonlight. Suporta codificação por hardware para GPUs AMD, Intel e Nvidia, e também oferece opções de codificação por software, visando uma experiência de cloud gaming de baixa latência. Os utilizadores podem configurar e emparelhar clientes através de uma interface web. (Fonte: GitHub Trending)

Tasmota: Firmware alternativo de código aberto para dispositivos ESP8266/ESP32: Tasmota é um firmware alternativo projetado para dispositivos inteligentes baseados nos chips ESP8266 e ESP32. Oferece uma interface de utilizador web fácil de usar para configuração, suporta atualizações OTA (Over-The-Air), permite automação através de temporizadores ou regras, e controlo totalmente local via protocolos MQTT, HTTP, serial ou KNX, aumentando a extensibilidade e personalização dos dispositivos. (Fonte: GitHub Trending)

Limbo: Projeto de evolução moderna do SQLite em Rust: O projeto Limbo visa construir uma versão moderna evoluída do SQLite usando a linguagem Rust. Suporta I/O assíncrono io_uring no Linux, é compatível com o dialeto SQL, formato de ficheiro e API C do SQLite, e fornece bindings para linguagens como JavaScript/WASM, Rust, Go, Python e Java. Planos futuros incluem a integração de pesquisa vetorial, melhorias na escrita concorrente e gestão de esquemas. (Fonte: GitHub Trending)

Ventoy: Solução de nova geração para pen drives de arranque: Ventoy é uma ferramenta de código aberto para criar pen drives de arranque, suportando o arranque direto de ficheiros de imagem em vários formatos como ISO, WIM, IMG, VHD(x), EFI, sem necessidade de formatar repetidamente a pen drive. Os utilizadores apenas precisam copiar os ficheiros de imagem para a pen drive, e o Ventoy gera automaticamente um menu de arranque. Suporta múltiplos sistemas operativos e modos de arranque (Legacy BIOS, UEFI), e é compatível com partições MBR e GPT. (Fonte: GitHub Trending)

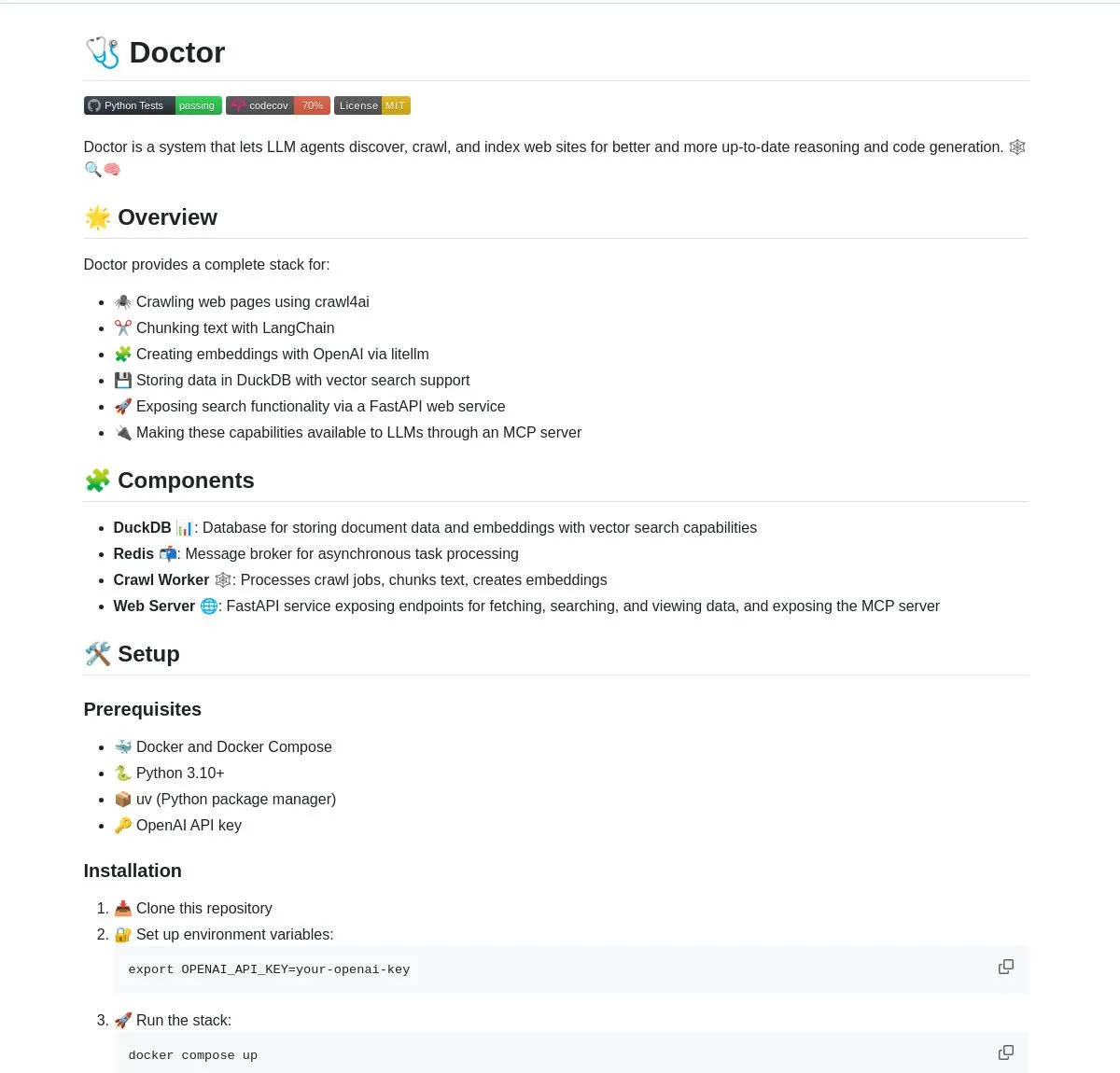

Doctor: Ferramenta de crawling e compreensão web para agentes LLM com LangChain: Doctor é uma ferramenta que ajuda agentes LLM a fazer crawling e a compreender conteúdo da web em tempo real. Combina processamento de páginas web, pesquisa vetorial e as capacidades de processamento de documentos do LangChain, fornecendo serviços através de FastAPI. Os utilizadores podem utilizar o Doctor para melhorar as capacidades de obtenção e análise de informação das suas aplicações de IA. (Fonte: LangChainAI, Hacubu)

Deep Research Agent: Agente de pesquisa IA que protege a privacidade e funciona localmente: Um agente de IA de código aberto focado na proteção da privacidade, que pode ser executado localmente para pesquisar qualquer tópico. Utiliza LangGraph para impulsionar o seu fluxo de trabalho de pesquisa iterativo, fornecendo aos utilizadores uma poderosa ferramenta de pesquisa localizada, sem necessidade de enviar dados para a nuvem. (Fonte: LangChainAI, Hacubu)

Assistente de terminal inteligente: Ferramenta multi-SO para conversão de linguagem natural para linha de comandos: Um assistente de terminal inteligente capaz de converter instruções em linguagem natural para comandos de terminal em diferentes sistemas operativos. A ferramenta é construída sobre um sistema multi-agente LangGraph, utilizando protocolos A2A e MCP para execução multi-plataforma, com o objetivo de simplificar as operações de linha de comandos e reduzir a barreira de entrada para os utilizadores. (Fonte: LangChainAI)

Montelimar: Caixa de ferramentas OCR de código aberto para dispositivos: Julien Blanchon lançou o Montelimar, uma caixa de ferramentas OCR (Reconhecimento Ótico de Caracteres) de código aberto para dispositivos. Suporta capturas de ecrã e realiza OCR em diferentes partes do ecrã, compatível com os modelos Nougat e OCRS, com backends em Rust (OCRS) e MLX (Nougat), respetivamente. A ferramenta pode produzir LaTeX, tabelas, Markdown (via Nougat, mais lento) e texto simples (via OCRS, mais rápido), e oferece histórico e funcionalidade de atalhos de sistema. (Fonte: awnihannun)

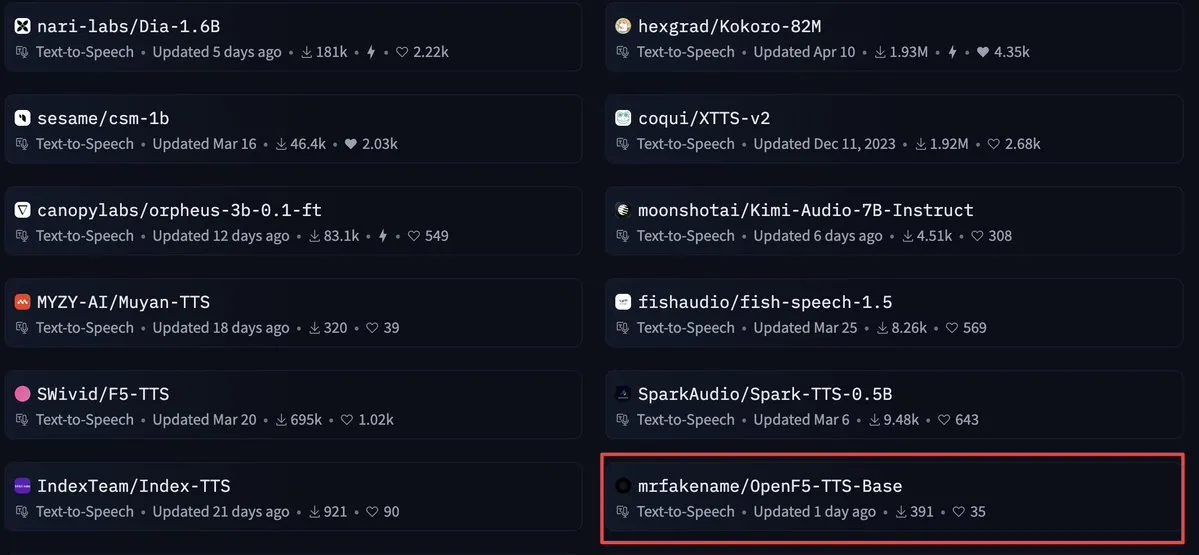

OpenF5 TTS: Modelo de conversão de texto em fala comercial com licença Apache 2.0: OpenF5 TTS é um modelo de conversão de texto em fala treinado novamente com base no modelo F5-TTS, utilizando a licença de código aberto Apache 2.0, e pode ser usado para fins comerciais. Este modelo está atualmente em alta entre os modelos de conversão de texto em fala no Hugging Face, oferecendo aos programadores uma opção de síntese de voz de alta qualidade e comercialmente viável. (Fonte: ClementDelangue)

Tensor Slayer: Ferramenta para melhorar o desempenho do modelo sem treino direto: Tensor Slayer é uma ferramenta recém-lançada que afirma poder melhorar o desempenho do modelo em 25% através de “direct tensor patching”, sem necessidade de fine-tuning, datasets, custos computacionais adicionais ou tempo de treino. Este conceito é bastante disruptivo e visa democratizar a melhoria dos modelos de IA. (Fonte: TheZachMueller)

Photoshop utiliza computador local com agentes (c/ua) para operações sem código: Computer Use Agents (c/ua) demonstram como realizar operações sem código no Photoshop através de prompts do utilizador, seleção de modelos e Docker, juntamente com um ciclo de agente apropriado. Isto visa reduzir a barreira para utilizadores comuns usarem software complexo, simplificando o fluxo de operações através de agentes de IA. (Fonte: Reddit r/artificial)

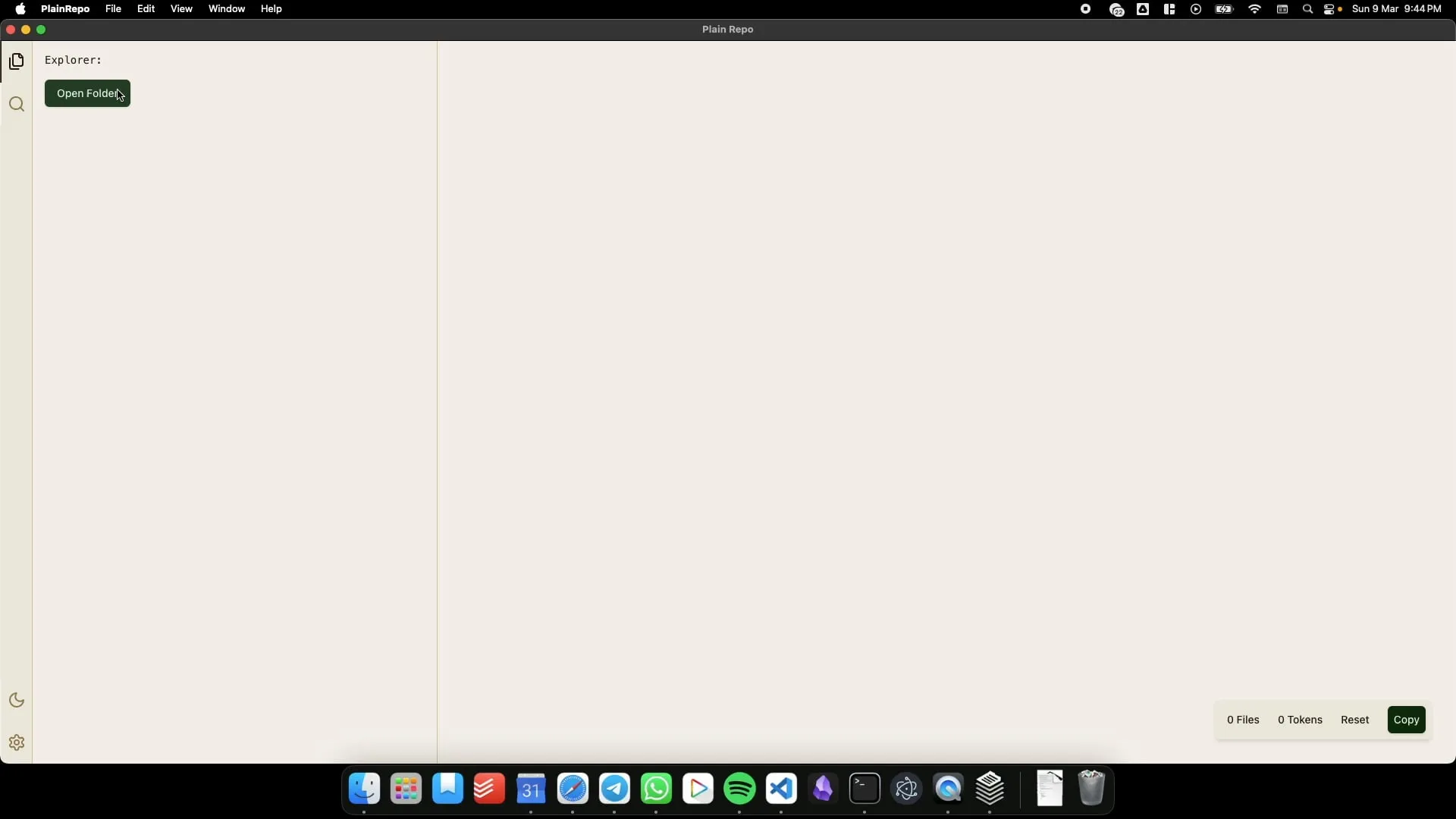

PlainRepo: Aplicação offline para copiar seletivamente grandes blocos de código/texto para extração de contexto por LLMs: PlainRepo é uma aplicação offline gratuita e de código aberto que permite aos utilizadores copiar seletivamente grandes pedaços de código ou texto para que LLMs locais possam extrair informação de contexto. Isto é muito útil para utilizadores que precisam de usar LLMs locais em ambientes sem rede ou por questões de privacidade. (Fonte: Reddit r/LocalLLaMA, Plus-Garbage-9710)

M0D.AI: Framework de controlo de interação com IA personalizado, criado por utilizador e IA em cinco meses de colaboração: O utilizador James O’Kelly, através de uma colaboração profunda com IA (como Gemini, ChatGPT) ao longo de cinco meses e cerca de 13.000 conversas, construiu um framework de interação e controlo de IA altamente personalizado chamado M0D.AI. O sistema inclui um backend Python, um servidor web Flask, uma UI frontend dinâmica e uma camada metacognitiva chamada mematrix.py, para monitorizar e orientar o comportamento da IA. M0D.AI demonstra como utilizadores sem formação em programação podem, com o auxílio da IA, projetar e desenvolver sistemas de software complexos. (Fonte: Reddit r/artificial)

📚 Aprendizado

Engenharia de LLM: Repositório de recursos do curso de 8 semanas para dominar IA e LLMs: Um curso de 8 semanas intitulado “LLM Engineering – Master AI and LLMs” visa ajudar os alunos a dominar a engenharia de grandes modelos de linguagem. O repositório GitHub associado ao curso fornece o código dos projetos semanais, guias de configuração (PC, Mac, Linux) e links para o Colab. O curso enfatiza a prática, começando com a instalação do Ollama para executar o Llama 3.2 e aprofundando gradualmente em HuggingFace, uso de APIs, fine-tuning de modelos, entre outros. Também fornece orientação sobre o uso do Ollama como alternativa gratuita a APIs pagas como as da OpenAI. (Fonte: GitHub Trending)

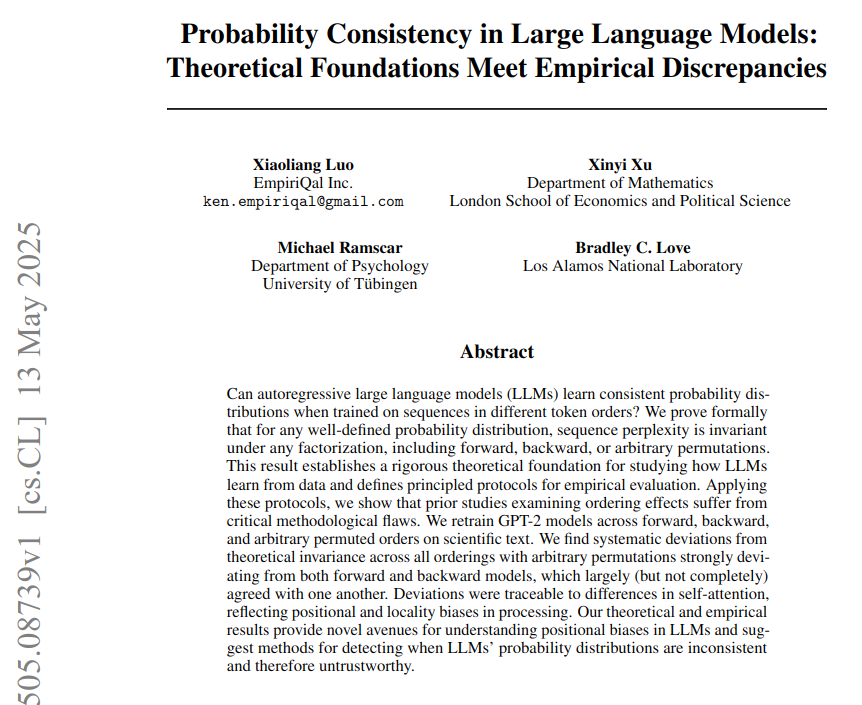

Consistência Probabilística em LLMs: Fundamentos Teóricos e Estudo de Discrepâncias Empíricas: Um artigo intitulado “Consistência Probabilística em LLMs: Fundamentos Teóricos e Discrepâncias Empíricas” aponta que os grandes modelos de linguagem (LLMs) usam uma política fixa para calcular as probabilidades dos tokens, mas o desempenho real dos modelos sob diferentes ordens de tokens desvia-se da consistência probabilística teórica. A pesquisa, através do treino de um modelo GPT-2 em textos de neurociência (usando ordens de tokens para a frente, para trás e permutadas), demonstrou que a perplexidade é teoricamente independente da ordem, mas empiricamente os modelos falharam neste teste devido a vieses arquitetónicos. Vieses de atenção (locais e de longo alcance) são considerados a causa direta das falhas de consistência observadas. (Fonte: menhguin)

BoldVoice utiliza machine learning para quantificar e orientar a intensidade do sotaque em inglês: A aplicação BoldVoice utiliza machine learning e técnicas de espaço latente para quantificar a intensidade do sotaque em inglês e fornecer orientação de pronúncia aos utilizadores. Este método visa ajudar os utilizadores a melhorar mais eficazmente a sua pronúncia e sotaque em inglês. (Fonte: dl_weekly)

Blog Milvus: Desafios e otimizações da filtragem eficiente de metadados em ambientes de produção, mantendo alta recuperação: A Milvus publicou um artigo de blog prático que discute como, na pesquisa vetorial em ambientes de produção, realizar uma filtragem eficiente de metadados e, ao mesmo tempo, manter uma alta taxa de recuperação (recall). O artigo discute os desafios relacionados e propõe estratégias de otimização. (Fonte: dl_weekly)

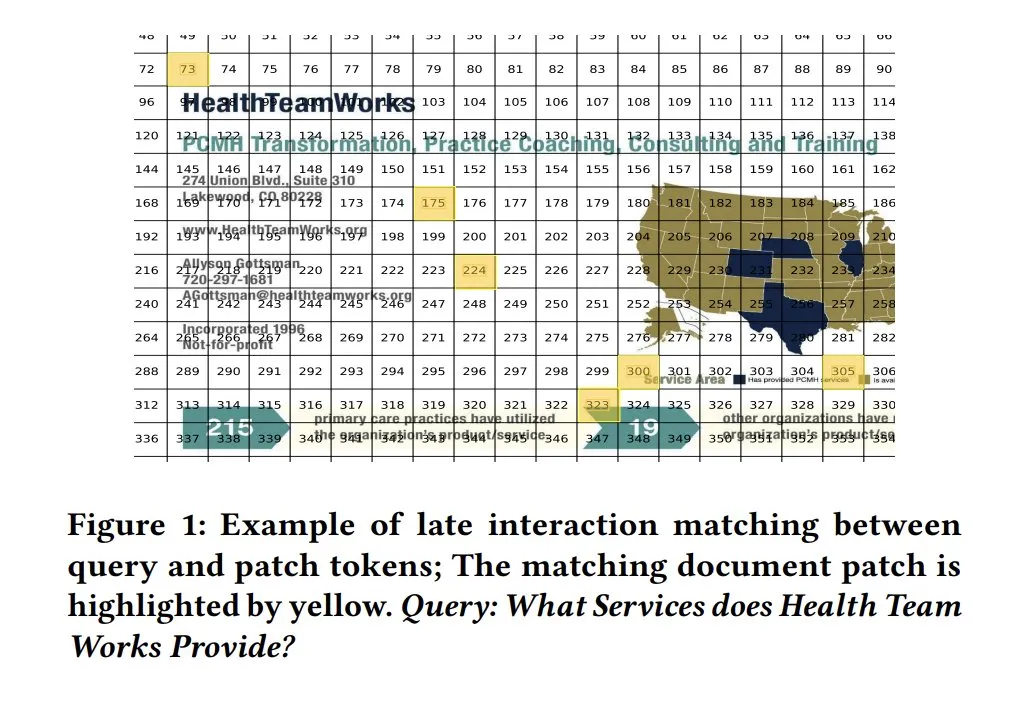

Mapas de similaridade ColPali para interpretabilidade de modelos: Mapas de similaridade em modelos de recuperação visual de documentos como o ColPali oferecem uma forte interpretabilidade para correspondências a nível de fragmento entre consulta e documento. Ao visualizar quais regiões da imagem estão relacionadas com a consulta através de mapas de calor, por exemplo, ajuda-se a compreender o processo de decisão do modelo. Tony Wu fornece um guia de início rápido relacionado. (Fonte: lateinteraction, tonywu_71, lateinteraction)

soarXiv: Uma forma elegante de explorar o conhecimento humano: Jinay lançou o soarXiv, uma plataforma que visa explorar artigos científicos de uma forma mais estética e interativa. Os utilizadores podem substituir “arxiv” por “soarxiv” no URL de um artigo do ArXiv para localizar e navegar pelo artigo numa interface semelhante a um mapa estelar do universo. A plataforma já incorporou 2,8 milhões de artigos até abril de 2025. (Fonte: menhguin)

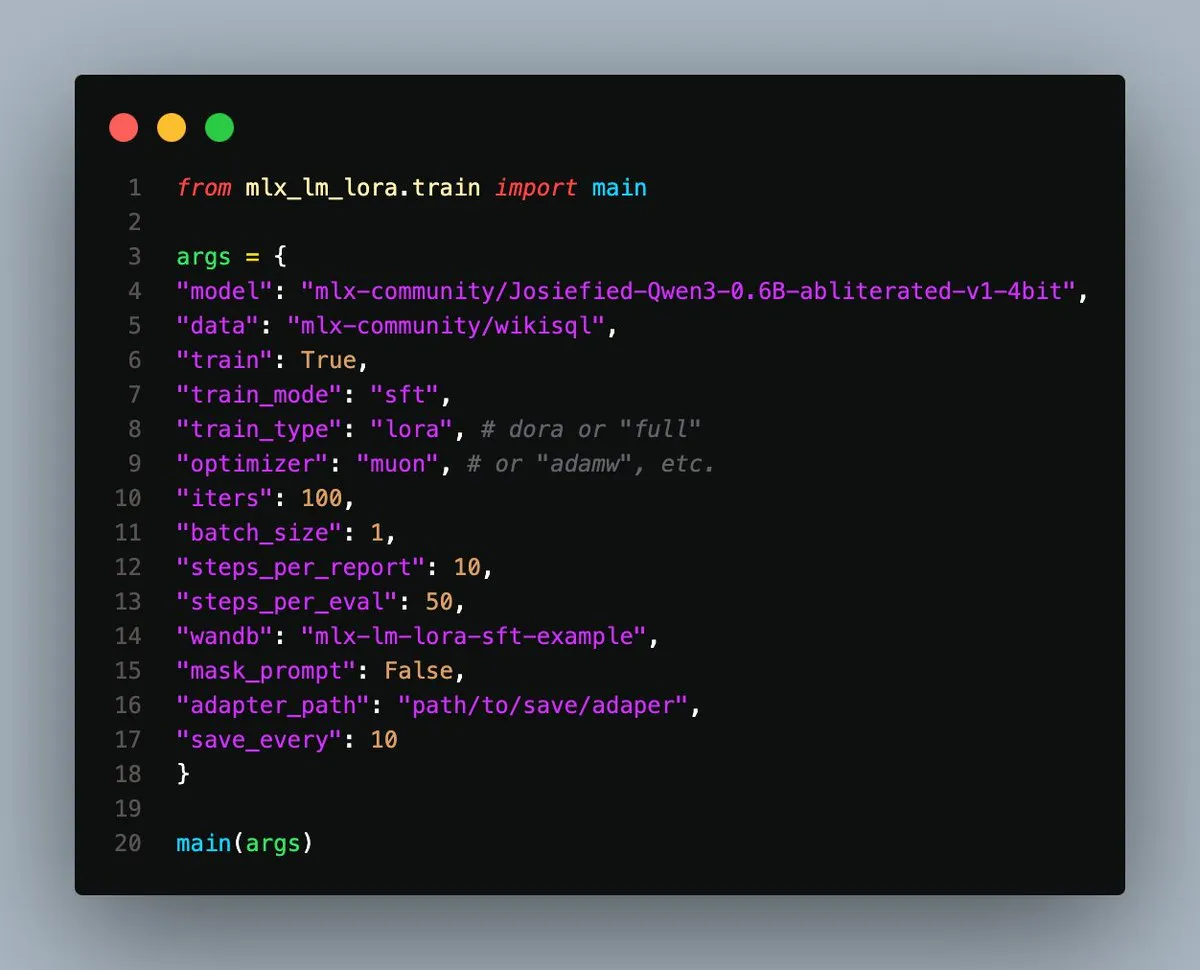

MLX-LM-LoRA v0.3.3 lançado, simplificando o fine-tuning local em Apple Silicon: Gökdeniz Gülmez lançou a versão v0.3.3 do MLX-LM-LoRA, simplificando e flexibilizando ainda mais o processo de fine-tuning local de modelos em Apple Silicon. A nova versão suporta a definição do número de épocas de treino (epochs) diretamente na configuração de treino ou na linha de comando, e fornece scripts de exemplo e Notebooks, incluindo fine-tuning básico e treino de preferência avançado usando DPO, necessitando apenas de cerca de 20 linhas de código para começar. (Fonte: awnihannun)

Análise de fugas de prompts de sistema: Revelando arquitetura interna e regras de comportamento dos principais LLMs: Simbaproduz publicou um projeto no GitHub que analisa exaustivamente as recentes fugas de prompts de sistema dos principais grandes modelos de linguagem (como Claude 3.7, ChatGPT-4o, Grok 3, Gemini, etc.). Este guia explora aprofundadamente a arquitetura interna, a lógica operacional e as regras de comportamento desses modelos, incluindo persistência de informação, estratégias de processamento de imagem, métodos de navegação na web, sistemas de personalização e mecanismos de defesa contra manipulação adversária. Estas informações são de grande valor de referência para a construção de ferramentas LLM, agentes inteligentes e sistemas de avaliação. (Fonte: Reddit r/MachineLearning)

Artigo do ICML 2025 explora decomposição no domínio da frequência de perturbações adversariais em imagens: Um artigo da Universidade da Academia Chinesa de Ciências e do Instituto de Tecnologia de Computação, apresentado como Spotlight no ICML 2025, intitulado “Diffusion-based Adversarial Purification from the Perspective of the Frequency Domain”, propõe que as perturbações adversariais tendem a corromper mais o espectro de amplitude e fase de alta frequência das imagens. Com base nisto, os pesquisadores propõem injetar a informação de baixa frequência da amostra original como um prior durante o processo inverso dos modelos de difusão, para guiar a geração de amostras limpas, removendo assim eficazmente as perturbações adversariais e preservando o conteúdo semântico da imagem. (Fonte: WeChat)

Artigo do ICML 2025 TokenSwift: Aceleração de 3x na geração de texto longo de nível 100K através de “autocompletar”: A equipa BIGAI NLCo publicou no ICML 2025 o artigo “TokenSwift: Lossless Acceleration of Ultra Long Sequence Generation”, que propõe um framework de aceleração eficiente e sem perdas, TokenSwift, para inferência em textos longos de nível 100K tokens. Este framework, através de mecanismos como rascunho paralelo de múltiplos tokens, completação heurística baseada em n-gramas, validação paralela em estrutura de árvore e gestão dinâmica de cache KV, alcança uma aceleração de inferência superior a 3x, mantendo a consistência da saída do modelo original, melhorando significativamente a eficiência da geração de sequências ultralongas. (Fonte: WeChat)

💼 Negócios

OpenAI acusada de alimentar a corrida armamentista de IA sobre a qual já tinha alertado: Um artigo da Bloomberg explora como a OpenAI, após o lançamento do ChatGPT, passou de uma organização que alertava para os riscos da IA a um ator chave na promoção da corrida tecnológica em IA. O artigo pode analisar a mudança estratégica da OpenAI, as pressões de comercialização e o impacto do seu comportamento na direção geral do desenvolvimento da indústria de IA e nas considerações de segurança. (Fonte: Reddit r/ArtificialInteligence)

Administração Trump encerra financiamento de quase 3 mil milhões de dólares para pesquisa da Universidade de Harvard, desencadeando disputa global por talentos: A administração Trump encerrou o financiamento de pesquisa de quase 3 mil milhões de dólares para a Universidade de Harvard, afetando mais de 350 projetos, uma medida vista como um grande golpe para o sistema de pesquisa dos EUA. Simultaneamente, a União Europeia, Canadá, Austrália e outros países e regiões lançaram planos de financiamento de dezenas de milhões de dólares, com a intenção de atrair os principais cientistas americanos afetados, gerando uma discussão sobre o fluxo global de talentos científicos. A Universidade de Harvard já entrou com uma ação judicial e alocou 250 milhões de dólares próprios para mitigar a crise. (Fonte: WeChat)

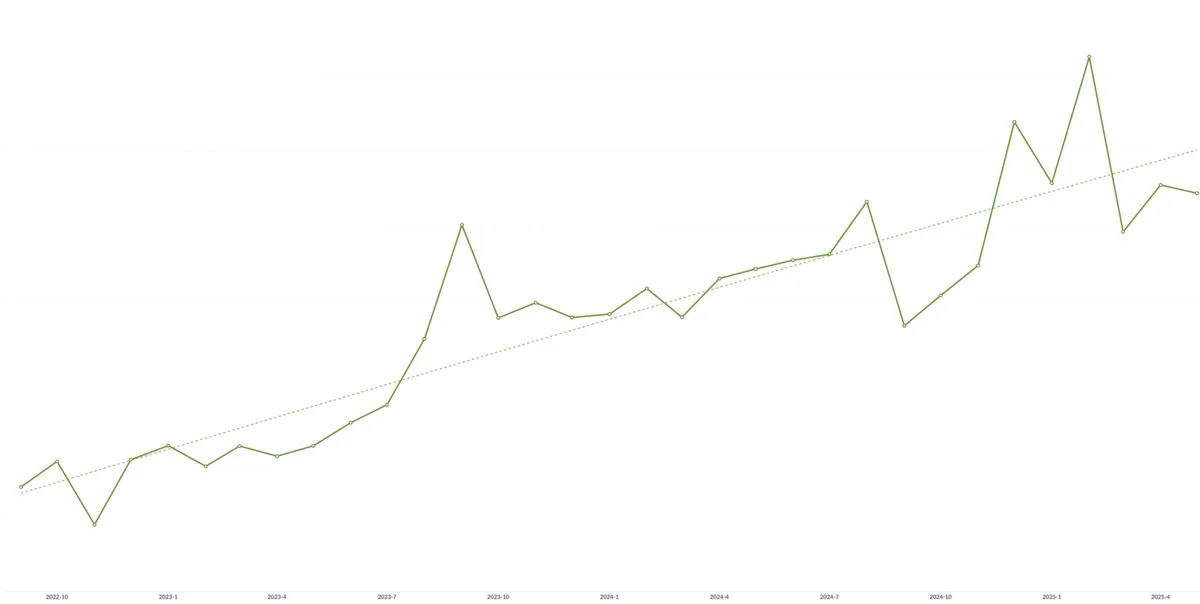

Startup de IA Spellbook regista crescimento contínuo do Valor Médio de Contrato (ACV) por três anos consecutivos: Apesar das preocupações de que a comoditização da tecnologia de IA possa levar à pressão sobre os preços, Scott Stevenson, cofundador da startup de software jurídico com IA Spellbook, afirmou que o Valor Médio de Contrato (ACV) da sua empresa tem crescido por três anos consecutivos. Ele acredita que equipas que agem rapidamente conseguem criar continuamente novo valor através de produtos de IA, compensando assim potenciais pressões de descida de preços. (Fonte: scottastevenson)

🌟 Comunidade

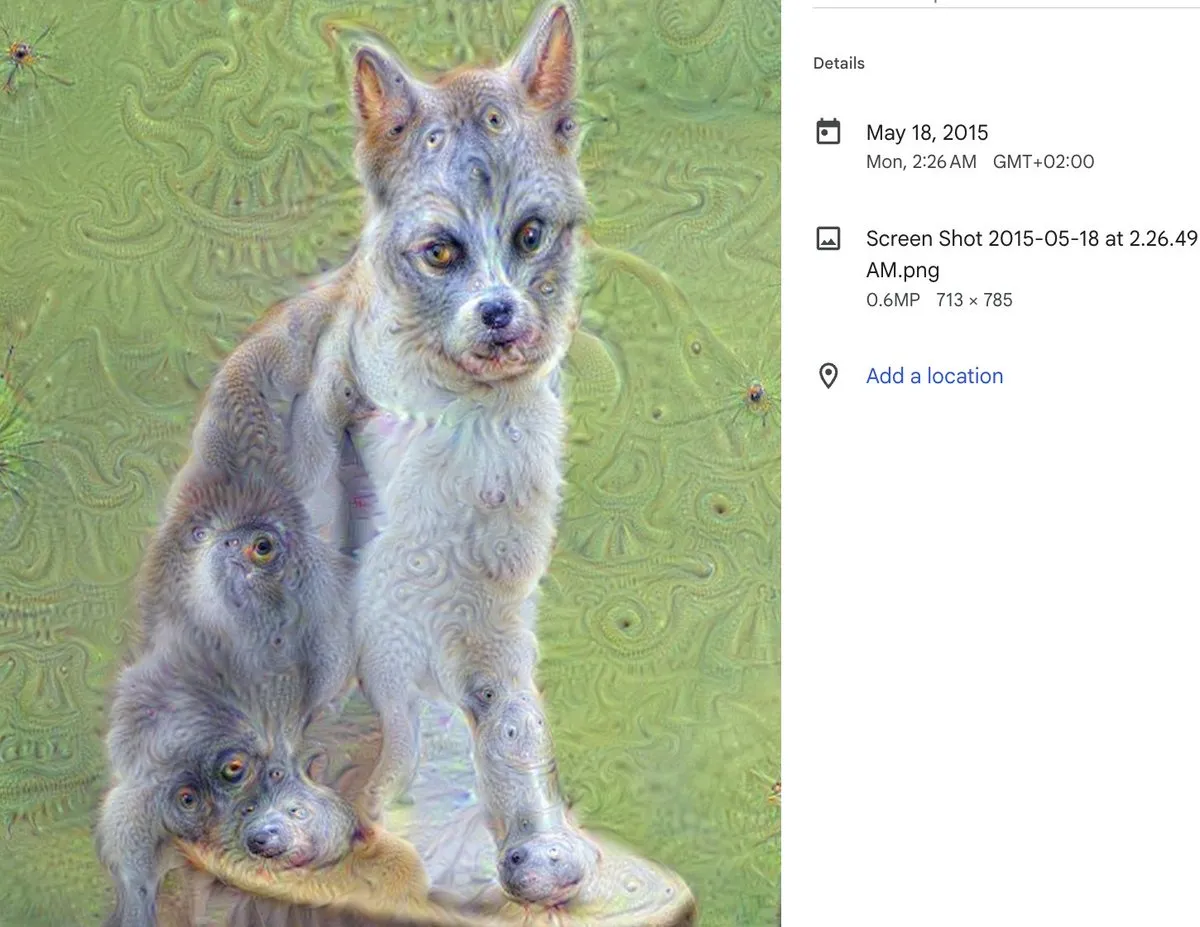

Décimo aniversário do DeepDream: Marco da arte com IA e seu impacto profundo: Alex Mordvintsev, criador do DeepDream, relembrou o nascimento desta ferramenta de arte com IA, que se tornou um fenómeno há dez anos. Cristóbal Valenzuela, cofundador da Runway, também partilhou como o DeepDream o inspirou a dedicar-se ao campo da arte com IA, levando-o eventualmente a cofundar a Runway. O surgimento do DeepDream marcou uma demonstração precoce do potencial da IA na criação artística, exercendo uma influência profunda no desenvolvimento subsequente da arte generativa e das ferramentas de criação de conteúdo com IA. (Fonte: c_valenzuelab)

Debate aceso sobre se a IA necessita de cofundadores técnicos: Surgiu nas redes sociais uma discussão sobre “VCs em fase inicial aconselharem empreendedores a não precisarem mais de cofundadores técnicos, bastando um gestor de produto e IA para construir produtos”. Esta opinião gerou ampla controvérsia, com Danielle Fong e outros a expressarem ceticismo, sugerindo que a IA atualmente não pode substituir completamente o papel central e a profunda compreensão técnica de um cofundador técnico. (Fonte: jonst0kes)

Discussão sobre o problema das alucinações em IA: causas técnicas e estratégias de resposta: A comunidade debate intensamente o problema das “alucinações” (geração confiante de informação falsa ou fabricada) em modelos de linguagem de IA (como ChatGPT, Claude, etc.). Os pontos de discussão incluem as raízes técnicas das alucinações (como deficiências no mecanismo de atenção, ruído nos dados de treino, falta de ancoragem no mundo real por parte do modelo, etc.), se RAG ou fine-tuning podem erradicá-las, como os utilizadores devem tratar com cautela as saídas dos LLMs, e como os programadores podem encontrar um equilíbrio entre criatividade e precisão factual. Há quem defenda que todas as saídas de LLM devem ser consideradas potenciais alucinações, necessitando de verificação pelo utilizador. (Fonte: Reddit r/ArtificialInteligence)

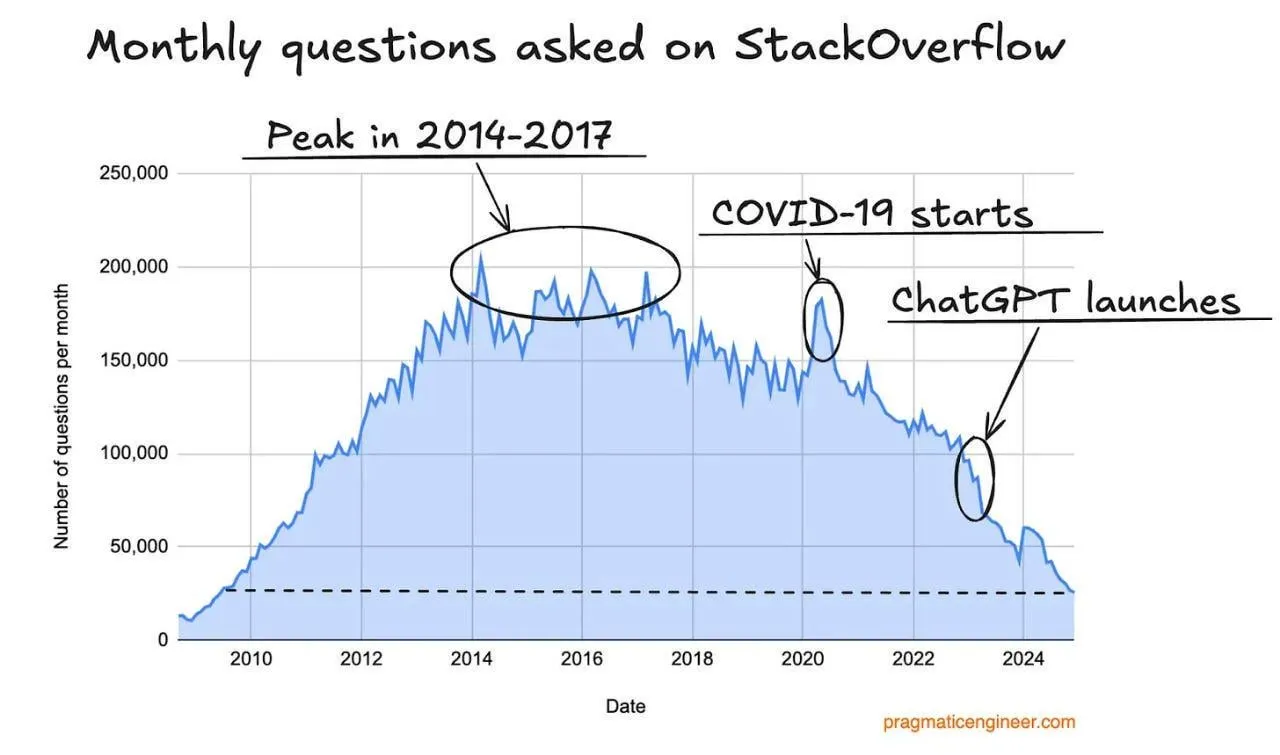

Queda no tráfego do Stack Overflow, possivelmente impactado por assistentes de programação com IA: Um utilizador observou uma tendência de queda no tráfego do site Stack Overflow e especulou que isso pode estar relacionado com o surgimento de assistentes de programação com IA, como o ChatGPT. Os programadores estão cada vez mais a fazer perguntas diretamente à IA para obter excertos de código e soluções, reduzindo a dependência de comunidades tradicionais de perguntas e respostas. Nos comentários, os utilizadores geralmente consideram que os assistentes de IA têm vantagens na objetividade das respostas e em evitar a negatividade da comunidade, mas também se preocupam que a dependência excessiva da IA em dados existentes possa levar ao esgotamento futuro dos dados de treino. (Fonte: Reddit r/ArtificialInteligence)

Instrutor do curso de Engenharia de LLM partilha experiências de aprendizagem e recursos: Ed Donner, instrutor do curso de Engenharia de LLM, partilhou a filosofia de ensino e os recursos do seu curso, enfatizando a importância de aprender através da prática (DOING). Ele encoraja os alunos a colocarem ativamente as mãos no código e forneceu guias de configuração para PC, Mac, Linux, bem como links para Notebooks no Google Colab, facilitando a aprendizagem e experimentação dos alunos em diferentes ambientes. O conteúdo do curso abrange Ollama, HuggingFace, uso de APIs, etc., e oferece soluções para usar modelos locais como alternativa a APIs pagas. (Fonte: ed-donner)

Partilha de experiência de utilizador: Usar Claude para melhorar o pensamento e a capacidade de comunicação: Um utilizador do Claude Pro partilhou como a interação com a IA o ajudou a melhorar a sua forma de pensar e as suas competências de comunicação. Através da interação com o Claude, o utilizador aprendeu a “dar prompts” a si mesmo de forma mais eficaz ao resolver problemas, a identificar questões centrais e a comunicar com colegas de forma mais clara e empática, reconhecendo assim o papel positivo das ferramentas de assistência de IA na melhoria das capacidades cognitivas e de expressão pessoal. (Fonte: Reddit r/ClaudeAI)

“Hiato discriminador-gerador” pode ser o conceito central para a inovação científica com IA: Jason Wei propôs que o “hiato discriminador-gerador” (Discriminator-generator gap) pode ser a ideia mais importante na inovação científica impulsionada por IA. Quando se dispõe de capacidade computacional suficiente, estratégias de busca inteligentes e métricas claras, qualquer coisa que possa ser medida pode ser otimizada por IA. Este conceito enfatiza o processo iterativo de um gerador a propor soluções e um discriminador a avaliar a sua qualidade para impulsionar a inovação, especialmente aplicável a ambientes onde a verificação é rápida, há recompensas contínuas e é possível escalar. (Fonte: _jasonwei, dotey)

Transformação e desafios do Gestor de Produto na era da IA: As redes sociais discutem o impacto da IA na função de Gestor de Produto. A opinião é que, nos próximos 18 meses, a indústria de gestão de produto enfrentará uma transformação, e os PMs que não compreendem as necessidades dos utilizadores poderão ser eliminados. As ferramentas de IA (como AI Agents) podem transformar ideias em produtos em pouco tempo, mas a verdadeira dificuldade reside em encontrar os principais pontos problemáticos dos utilizadores e fornecer soluções precisas. Esta função, em última análise, compete na capacidade de corresponder problemas de utilizadores com soluções, e não apenas na produção de documentos e protótipos. (Fonte: dotey)

Paradoxo da segurança da IA: Superinteligência pode ser mais benéfica para a defesa: Richard Socher propôs o “paradoxo da segurança da IA”: sob pressupostos razoáveis, o surgimento da superinteligência pode, na verdade, ser mais benéfico para o lado da defesa em guerras biológicas ou cibernéticas. Com a redução do custo marginal da inteligência, é possível descobrir mais vetores de ataque através de exercícios de “red teaming” e fortalecer ou imunizar os sistemas até cobrir todos os caminhos de ataque relevantes. Teoricamente, quando o custo da defesa se aproxima de zero, o sistema pode ser completamente imunizado. Esta perspetiva desafia a noção tradicional de que o desenvolvimento da IA agravará a assimetria entre ataque e defesa. (Fonte: RichardSocher)

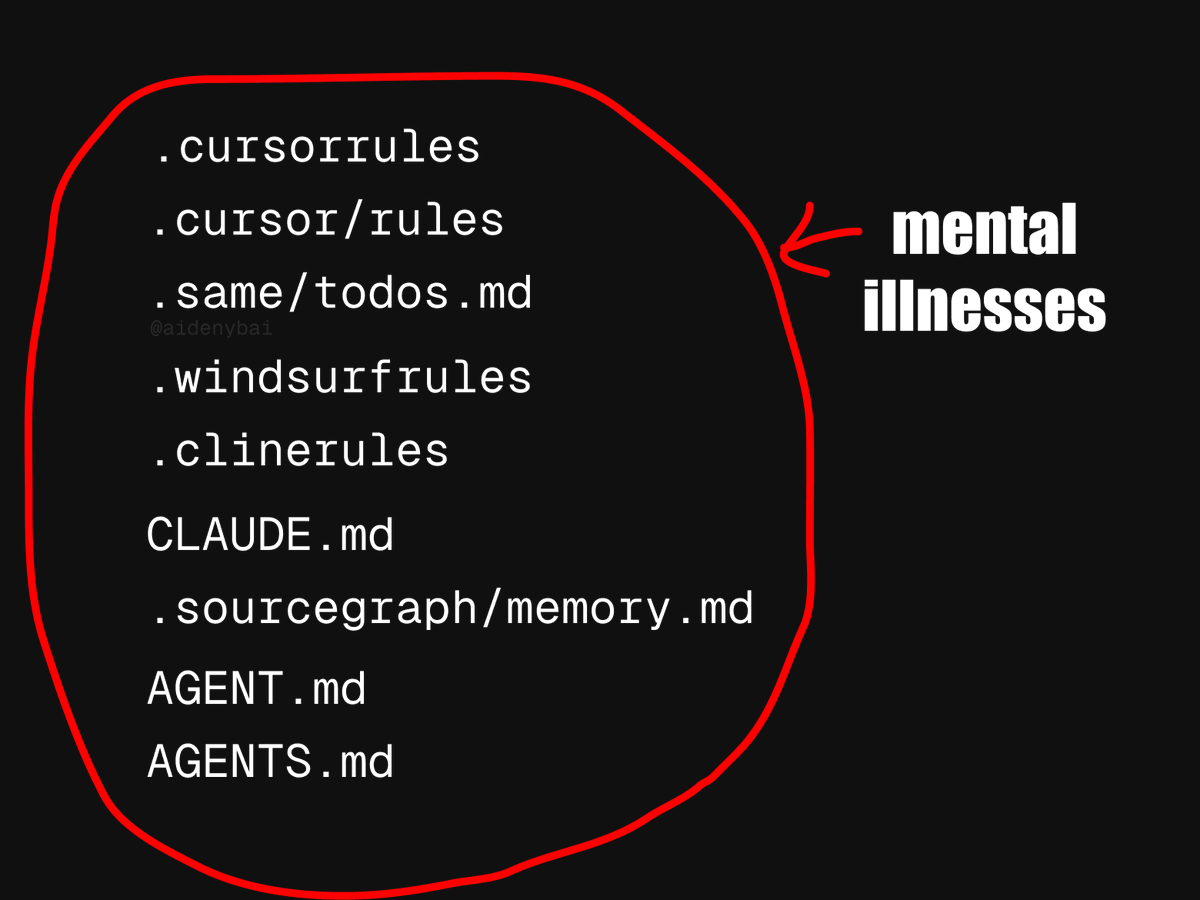

Disputa sobre padrões para aplicações de AI Agent: CONTRIBUTING.md pode ser uma prática melhor: Perante o fenómeno atual de 9 padrões concorrentes para regras de AI Agent, alguns programadores propuseram que seria melhor usar diretamente o ficheiro CONTRIBUTING.md do projeto para regular o comportamento dos AI Agents. Este ficheiro geralmente já contém guias de estilo de código, referências relevantes e excertos de compilação, podendo servir como um veículo natural para as regras dos AI Agents, evitando reinventar a roda. (Fonte: JayAlammar)

💡 Outros

Peter Lax, autor do clássico livro didático “Análise Funcional”, falece aos 99 anos: O gigante da matemática Peter Lax, primeiro matemático aplicado a receber o Prémio Abel, faleceu aos 99 anos. O Professor Lax era conhecido pelo seu clássico livro didático “Análise Funcional” e fez contribuições fundamentais nas áreas de equações diferenciais parciais, mecânica dos fluidos, cálculo numérico, como o teorema da equivalência de Lax, os métodos de Lax-Friedrichs/Lax-Wendroff, entre outros. Foi também um dos pioneiros na aplicação de técnicas computacionais à análise matemática, e o seu trabalho influenciou profundamente a investigação científica e a prática da engenharia. (Fonte: WeChat)

Candidaturas de emprego com IA: Agente de IA usa OpenAI Operator para se candidatar a mil empregos com um clique, gerando debate: Um vídeo mostra um agente de IA a utilizar a ferramenta Operator da OpenAI para se candidatar a 1000 vagas de emprego com um único clique. Este fenómeno gerou discussão sobre a aplicação da IA no domínio do recrutamento e seleção, incluindo a possibilidade de IA filtrar currículos, agendar entrevistas e até realizar entrevistas preliminares, bem como o impacto desta automação para candidatos e recrutadores. (Fonte: Reddit r/ChatGPT)

MIT retira artigo de economia relacionado com IA, suspeita-se de autoria por IA e dados duvidosos: O Departamento de Economia do MIT retirou um artigo escrito por um doutorando intitulado “Inteligência Artificial, Descoberta Científica e Inovação de Produtos”, devido à falta de confiança da instituição na fiabilidade dos dados do artigo. A comunidade especula que o artigo pode ter sido maioritariamente escrito por IA, o que gerou discussões sobre a ética e o controlo de qualidade da aplicação da IA na investigação académica. (Fonte: Reddit r/ArtificialInteligence)