Palavras-chave:DeepMind, AlphaEvolve, OceanBase, PowerRAG, Meta, Llama 4 Behemoth, Qwen, WorldPM-72B, Algoritmos avançados de design de IA, Estratégia Data×AI, Desenvolvimento de aplicações RAG, Modelos de preferência em larga escala, Avance em algoritmos de multiplicação de matrizes

# 🔥 Destaques

**DeepMind lança AlphaEvolve: IA projeta algoritmos avançados e alcança avanço histórico**: A DeepMind anunciou o AlphaEvolve, um agente de codificação evolutiva impulsionado pelo Gemini, capaz de projetar e otimizar algoritmos do zero. Em testes com 50 problemas abertos nas áreas de matemática, geometria e combinatória, o AlphaEvolve redescobriu as melhores soluções conhecidas por humanos em 75% dos casos e as aprimorou em 20% das situações. Mais notavelmente, descobriu um algoritmo de multiplicação de matrizes mais rápido que o clássico algoritmo de Strassen (o primeiro avanço em 56 anos) e pode melhorar o design de circuitos de chips de IA e seus próprios algoritmos de treinamento. Isso marca um passo importante na automação da descoberta científica e na autoevolução da IA, sinalizando que a IA pode acelerar a resolução de problemas complexos, desde o design de hardware até o tratamento de doenças (Fonte: [YouTube – Two Minute Papers](https://www.youtube.com/watch?v=T0eWBlFhFzc))

**OceanBase Developer Conference lança estratégia Data×AI e primeiro produto RAG, PowerRAG**: Na terceira Developer Conference, a OceanBase detalhou sua estratégia Data×AI e lançou o PowerRAG, um produto de aplicação voltado para IA. Este produto oferece capacidade de desenvolvimento de aplicações RAG (Retrieval Augmented Generation) prontas para uso, visando simplificar a construção de aplicações de IA, como bases de conhecimento de documentos e diálogos inteligentes. O CTO da OceanBase, Yang Chuanhui, afirmou que a empresa está evoluindo de um banco de dados integrado para uma plataforma de dados unificada, a fim de suportar cargas de trabalho mistas TP/AP/AI e bancos de dados vetoriais. O CTO do Ant Group, He Zhengyu, também expressou apoio à prática da OceanBase nos cenários centrais de IA da Ant. A OceanBase também demonstrou seu desempenho vetorial líder e capacidade de compressão para JSON, dedicando-se a resolver os desafios de dados na era da IA (Fonte: [QbitAI](https://www.qbitai.com/2025/05/284444.html))

**MIT não apoia mais artigo de pesquisa sobre IA de um de seus alunos**: De acordo com o Wall Street Journal, o Massachusetts Institute of Technology (MIT) declarou publicamente que não endossa mais um artigo de pesquisa sobre IA publicado por um de seus alunos. Tal medida geralmente significa que surgiram problemas sérios com a validade, metodologia ou aspectos éticos da pesquisa, suficientes para que a instituição retire seu apoio. Eventos como este são relativamente raros no meio acadêmico, especialmente no campo proeminente da IA, e podem impactar a reputação e a direção de pesquisa dos pesquisadores envolvidos, além de levantar discussões sobre integridade acadêmica e qualidade da pesquisa. As razões específicas e os detalhes do artigo ainda não foram divulgados (Fonte: [Reddit r/artificial](https://www.reddit.com/r/artificial/comments/1konws0/mit_says_it_no_longer_stands_behind_students_ai/))

# 🎯 Tendências

**Meta supostamente adia lançamento do Llama 4 Behemoth, membros da equipe fundadora deixam a empresa**: Há notícias nas redes sociais e na comunidade Reddit de que a Meta Platforms adiou o lançamento de seu modelo de linguagem grande de próxima geração, Llama 4 Behemoth. Ao mesmo tempo, há rumores de que 11 dos 14 pesquisadores iniciais envolvidos na pesquisa do Llama v1 já deixaram a empresa. Esta notícia levanta preocupações sobre a estabilidade da equipe de IA da Meta e o progresso futuro no desenvolvimento de grandes modelos. Se for verdade, isso pode afetar a posição da Meta na acirrada competição de grandes modelos (Fonte: [Reddit r/artificial](https://preview.redd.it/hhsmnxxlxa1f1.png?auto=webp&s=ae32abf1d8ed036829161d716143b0d6284517b2), [scaling01](https://x.com/scaling01/status/1923715027653025861))

**Qwen lança WorldPM-72B, modelo de preferência em larga escala**: A equipe Qwen do Alibaba lançou o WorldPM-72B, um modelo de preferência com 72,8 bilhões de parâmetros. O modelo aprende uma representação unificada das preferências humanas através do pré-treinamento em 15 milhões de dados de comparação pareada humana. Ele atua principalmente como um modelo de recompensa, avaliando a qualidade das respostas candidatas, fornecendo suporte para RLHF (Reinforcement Learning from Human Feedback) e classificação de conteúdo, com o objetivo de melhorar o alinhamento do modelo com os valores humanos. Esta iniciativa marca uma demonstração empírica do aprendizado de preferência escalável, com melhorias tanto nas preferências de conhecimento objetivo quanto nos estilos de avaliação subjetiva (Fonte: [Reddit r/LocalLLaMA](https://www.reddit.com/r/LocalLLaMA/comments/1kompbk/new_new_qwen/))

**Tecnologia Pivotal Token Search (PTS) de código aberto otimiza a eficiência do treinamento de LLM**: Uma nova tecnologia chamada Pivotal Token Search (PTS) foi proposta e tornada open source. Essa tecnologia visa otimizar o treinamento de otimização de preferência direta (DPO) identificando “pontos de decisão cruciais” (ou seja, Pivotal Tokens) no processo de geração do modelo de linguagem. A ideia central é que, quando um modelo gera uma resposta, alguns poucos tokens desempenham um papel decisivo no sucesso ou fracasso do resultado final. Ao criar pares DPO direcionados a esses pontos cruciais, é possível alcançar um treinamento mais eficiente e melhores resultados. O projeto foi inspirado no artigo Phi-4 da Microsoft e já lançou código, conjuntos de dados e modelos pré-treinados relevantes (Fonte: [Reddit r/MachineLearning](https://www.reddit.com/r/MachineLearning/comments/1komx9e/p_pivotal_token_search_pts_optimizing_llms_by/))

**ByteDance lança DanceGRPO: framework unificado de aprendizado por reforço promove geração visual**: A ByteDance lançou o DanceGRPO, um framework unificado de aprendizado por reforço (RL) projetado especificamente para modelos de difusão e fluxos retificados (rectified flows) na geração visual. O framework visa melhorar a qualidade e o efeito da síntese de imagens e vídeos por meio do aprendizado por reforço, fornecendo um novo caminho tecnológico para o campo da criação de conteúdo visual (Fonte: [_akhaliq](https://x.com/_akhaliq/status/1923736714641584254))

**Google lança LightLab: controle de fontes de luz em imagens através de modelos de difusão**: Pesquisadores do Google apresentaram o projeto LightLab, uma tecnologia que permite o controle refinado de fontes de luz em imagens usando modelos de difusão. Através do fine-tuning de modelos de difusão em conjuntos de dados de pequena escala e altamente curados, o LightLab alcança uma manipulação eficaz dos efeitos de iluminação em imagens geradas, oferecendo novas possibilidades para edição de imagens e criação de conteúdo (Fonte: [_akhaliq](https://x.com/_akhaliq/status/1923849291514233322), [_rockt](https://x.com/_rockt/status/1923862256451793289))

**Função de memória de longo prazo da IA levanta reflexões sobre arquitetura e impactos econômicos**: A introdução da função de memória de longo prazo no ChatGPT pela OpenAI é vista como uma transição dos sistemas de IA de modelos de resposta sem estado para um modo de serviço contínuo e rico em contexto. Essa mudança não apenas melhora a experiência do usuário, mas também traz novos encargos computacionais (como armazenamento de memória, recuperação, segurança e manutenção da consistência), podendo levar a um “efeito de cauda longa” na demanda computacional. Economicamente, o custo de manutenção de contextos personalizados pode ser externalizado para desenvolvedores e usuários por meio de preços de API, níveis de assinatura, etc., ao mesmo tempo em que aumenta o efeito de aprisionamento (lock-in) do ecossistema (Fonte: [Reddit r/deeplearning](https://www.reddit.com/r/deeplearning/comments/1kon0oo/memory_as_strategy_how_longterm_context_reshapes/))

**Anthropic pode lançar novo modelo Claude para enfrentar a concorrência**: Há rumores nas redes sociais e na comunidade Reddit de que a Anthropic pode lançar um novo modelo Claude (possivelmente Claude 3.8) em breve. Especula-se que esta medida visa responder aos rápidos avanços de concorrentes como o Google em capacidades de codificação de modelos de IA (como o Gemini), a fim de manter a competitividade da série de modelos Claude no mercado (Fonte: [Reddit r/ClaudeAI](https://www.reddit.com/r/ClaudeAI/comments/1kols5s/will_we_see_anthropic_release_a_new_claude_model/))

# 🧰 Ferramentas

**ByteDance torna FlowGram.AI open source: mecanismo de construção de fluxos baseado em nós**: A ByteDance lançou o FlowGram.AI, um mecanismo de construção de fluxos baseado em nós, projetado para ajudar desenvolvedores a criar rapidamente fluxos de trabalho com layout fixo ou de conexão livre. Ele fornece um conjunto de melhores práticas de interação, especialmente adequado para a construção de fluxos de trabalho visualizados com entradas e saídas claras, e foca em como capacitar fluxos de trabalho com habilidades de IA (Fonte: [GitHub Trending](https://github.com/bytedance/flowgram.ai))

**CopilotKit: UI React e infraestrutura para construir assistentes de IA profundamente integrados**: O CopilotKit é um projeto open source que fornece componentes de UI React e infraestrutura de backend para construir AI Copilots, chatbots de IA e agentes de IA dentro de aplicações. Ele suporta RAG no frontend, integração com bases de conhecimento, funções acionáveis no frontend e CoAgents integrados com LangGraph, visando ajudar desenvolvedores a implementar facilmente funcionalidades de IA que colaboram profundamente com os usuários (Fonte: [GitHub Trending](https://github.com/CopilotKit/CopilotKit))

**AI Runner: Motor de inferência de IA local offline suporta múltiplas aplicações**: Capsize-Games lançou o AI Runner, um motor de inferência de IA que suporta execução offline. Ele pode lidar com criação artística (Stable Diffusion, ControlNet), conversas de voz em tempo real (OpenVoice, SpeechT5, Whisper), chatbots LLM e fluxos de trabalho automatizados. A ferramenta foca na execução local, visando fornecer a desenvolvedores e criadores um conjunto de ferramentas de IA sem a necessidade de APIs externas (Fonte: [GitHub Trending](https://github.com/Capsize-Games/airunner))

**LangChain lança tutorial Text-to-SQL**: LangChain publicou um tutorial demonstrando como usar LangChain, o modelo DeepSeek da Ollama e Streamlit para construir um poderoso conversor de linguagem natural para SQL. A ferramenta visa criar uma interface intuitiva que pode converter automaticamente consultas em linguagem coloquial em instruções SQL executáveis pelo banco de dados, simplificando o processo de consulta e análise de dados (Fonte: [LangChainAI](https://x.com/LangChainAI/status/1923770538528329826), [hwchase17](https://x.com/hwchase17/status/1923785900535812326))

**LangChain lança agente inteligente para resumir links do Telegram**: A comunidade LangChain compartilhou um robô inteligente para Telegram construído com base no LangGraph. Este robô é capaz de resumir diretamente no chat o conteúdo de links da web, documentos PDF e posts de redes sociais, processando inteligentemente diferentes tipos de conteúdo para fornecer informações resumidas concisas, aumentando a eficiência na obtenção de informações (Fonte: [LangChainAI](https://x.com/LangChainAI/status/1923785679928004954))

**LangChain integra-se com Box para correspondência automatizada de documentos**: LangChain publicou um tutorial sobre a integração com Box, demonstrando como utilizar o AI Agents Toolkit da LangChain e servidores MCP para construir agentes inteligentes que automatizam a correspondência de faturas com pedidos de compra em fluxos de trabalho de aquisição. Esta integração visa aumentar o nível de automação e eficiência no processamento de documentos empresariais (Fonte: [LangChainAI](https://x.com/LangChainAI/status/1923800687860748597), [hwchase17](https://x.com/hwchase17/status/1923812839245877559))

**Gradio simplifica a construção de servidores MCP**: O blog da Hugging Face apresentou um guia para construir um servidor MCP (Multi-Copilot Platform) usando Gradio em poucas linhas de código Python. Isso permite que os desenvolvedores criem e implantem plataformas de colaboração multiagente de forma mais conveniente, reduzindo a barreira de entrada para o desenvolvimento de tais aplicações (Fonte: [dl_weekly](https://x.com/dl_weekly/status/1923726779375644809))

**Replicate simplifica chamada de modelos, adapta-se a editores de código AI como Codex**: A plataforma Replicate foi atualizada para que seus editores de código AI e LLMs (como Codex) possam usar qualquer modelo na plataforma de forma mais conveniente. Novas funcionalidades incluem copiar a página como markdown, carregar diretamente no Claude ou ChatGPT, e fornecer uma página llms.txt para qualquer modelo, facilitando a integração e chamada de modelos (Fonte: [bfirsh](https://x.com/bfirsh/status/1923812545124872411))

**chatllm.cpp adiciona suporte para modelos Orpheus-TTS**: O projeto open source `chatllm.cpp` agora suporta a série de modelos de síntese de voz Orpheus-TTS, como o orpheus-tts-en-3b (3,3 bilhões de parâmetros). Os usuários podem executar esses modelos TTS localmente através desta ferramenta para realizar a conversão de texto para fala (Fonte: [Reddit r/LocalLLaMA](https://www.reddit.com/r/LocalLLaMA/comments/1kony6o/orpheustts_is_now_supported_by_chatllmcpp/))

**auto-openwebui: script Bash para implantação automatizada do Open WebUI**: Um desenvolvedor criou um script Bash chamado auto-openwebui para executar automaticamente o Open WebUI em sistemas Linux via Docker, integrando-o com Ollama e Cloudflare. O script suporta GPUs AMD e NVIDIA, simplificando o processo de implantação do Open WebUI (Fonte: [Reddit r/OpenWebUI](https://www.reddit.com/r/OpenWebUI/comments/1kopl98/autoopenwebui_i_made_a_bash_script_to_automate/))

**Projeto GLaDOS atualiza modelo ASR para Nemo Parakeet 0.6B**: O projeto de assistente de voz GLaDOS atualizou seu modelo de reconhecimento automático de fala (ASR) para o Nemo Parakeet 0.6B da Nvidia. Este modelo tem um desempenho excelente no ranking ASR da Hugging Face, combinando alta precisão e velocidade de processamento. O projeto reestruturou o pré-processamento de áudio e o código de inferência TDT/FastConformer CTC para minimizar dependências (Fonte: [Reddit r/LocalLLaMA](https://www.reddit.com/r/LocalLLaMA/comments/1kosbyy/glados_has_been_updated_for_parakeet_06b/))

**Runway lança References API e plugin para Figma, permitindo fusão de imagens**: A References API da Runway agora pode ser usada para criar plugins, como um plugin para Figma, capaz de fundir quaisquer duas imagens da maneira desejada pelo usuário. O código do plugin foi tornado open source, demonstrando a capacidade da Runway na edição e criação programável de imagens (Fonte: [c_valenzuelab](https://x.com/c_valenzuelab/status/1923762194254070008))

**Codex demonstra alta eficiência em tarefas de migração de código**: Um desenvolvedor compartilhou o uso do Codex para migrar um projeto legado de Python 2.7 para 3.11 e atualizar o Django 1.x para 5.0, com todo o processo levando apenas 12 minutos. Isso demonstra o enorme potencial das ferramentas de código de IA no tratamento de tarefas complexas de atualização e migração de código, economizando significativamente o tempo de desenvolvimento (Fonte: [gdb](https://x.com/gdb/status/1923802002582319516))

**Gyroscope: melhorando o desempenho do modelo de IA através da engenharia de prompts**: Um usuário compartilhou um método de engenharia de prompts chamado “Gyroscope”, alegando que, ao copiá-lo e colá-lo em IAs baseadas em chat (como Claude 3.7 Sonnet e ChatGPT 4o), é possível melhorar sua saída em 30-50% em termos de segurança e inteligência. Os resultados dos testes mostraram melhorias significativas no raciocínio estruturado, responsabilidade e rastreabilidade (Fonte: [Reddit r/artificial](https://www.reddit.com/r/artificial/comments/1komvkz/diy_free_upgrade_for_your_ai/))

**Claude auxilia pessoa sem experiência em programação a concluir projeto de código**: Um usuário do Reddit compartilhou como, sem nenhuma experiência em programação, passou um dia usando a IA Claude para criar com sucesso um gerador de comunicação textual totalmente funcional. Este caso destaca o potencial dos grandes modelos de linguagem em auxiliar na programação e reduzir a barreira de entrada, permitindo que não profissionais participem do desenvolvimento de software (Fonte: [Reddit r/ClaudeAI](https://www.reddit.com/r/ClaudeAI/comments/1koouc5/literally_spent_all_day_on_having_claude_code_this/))

# 📚 Aprendizado

**Awesome ChatGPT Prompts: Repositório curado de prompts para ChatGPT e outros LLMs**: O popular projeto no GitHub awesome-chatgpt-prompts coleta um grande número de prompts cuidadosamente elaborados para ChatGPT e outros LLMs (como Claude, Gemini, Llama, Mistral). Esses prompts cobrem uma variedade de cenários de role-playing e tarefas, com o objetivo de ajudar os usuários a interagir melhor com os modelos de IA e melhorar a qualidade da saída. O projeto também oferece o site prompts.chat e uma versão do conjunto de dados no Hugging Face (Fonte: [GitHub Trending](https://github.com/f/awesome-chatgpt-prompts))

**Lilian Weng discute “Por que pensamos”: a importância de dar mais tempo de “pensamento” aos modelos**: A pesquisadora da OpenAI, Lilian Weng, publicou um post no blog intitulado “Why we think”, discutindo a eficácia de dar aos modelos mais tempo de “pensamento” antes da previsão – por meio de decodificação inteligente, raciocínio em cadeia de pensamento, pensamento latente, etc. – para desbloquear o próximo nível de inteligência. O artigo analisa profundamente diferentes estratégias para aprimorar as capacidades de raciocínio e planejamento dos modelos (Fonte: [lilianweng](https://x.com/lilianweng/status/1923757799198294317), [andrew_n_carr](https://x.com/andrew_n_carr/status/1923808008641171645))

**Pacotes Wheel pré-compilados do Flash Attention simplificam a instalação**: A comunidade forneceu pacotes wheel pré-compilados do Flash Attention, visando resolver os longos tempos de compilação que os usuários podem encontrar ao instalar o Flash Attention. Isso ajuda os desenvolvedores a configurar e usar mais rapidamente ambientes de aprendizado profundo que incluem otimizações do Flash Attention (Fonte: [andersonbcdefg](https://x.com/andersonbcdefg/status/1923774139661418823))

**Maitrix lança Voila: família de grandes modelos de base de fala-linguagem**: A equipe Maitrix apresentou Voila, uma nova série de grandes modelos de base de fala-linguagem. Esta série de modelos visa elevar a experiência de interação humano-máquina a um novo nível, focando na melhoria das capacidades de compreensão e geração de fala, para apoiar aplicações de interação por voz mais naturais (Fonte: [dl_weekly](https://x.com/dl_weekly/status/1923770946264986048))

**Compreensão aprofundada do mecanismo Flash Attention torna-se ponto focal**: Surgiram discussões na comunidade de desenvolvedores sobre o aprendizado e a compreensão dos mecanismos centrais do Flash Attention (“o que faz o flash attention ser flash”). Como um mecanismo de atenção eficiente, o Flash Attention é crucial para o treinamento e inferência de grandes modelos Transformer, e seus princípios e detalhes de implementação têm recebido atenção (Fonte: [nrehiew_](https://x.com/nrehiew_/status/1923782090052559109))

# 🌟 Comunidade

**Zuckerberg ajustando pessoalmente os parâmetros do Llama-5 vira debate, saída de membros da equipe de IA da Meta chama atenção**: Uma imagem de paródia de Zuckerberg definindo pessoalmente hiperparâmetros para o treinamento do Llama-5 após a saída de funcionários circulou nas redes sociais, gerando discussões sobre a perda de talentos na equipe de IA da Meta e o estilo “mão na massa” de Zuckerberg. Isso reflete a atenção da comunidade para as futuras direções de desenvolvimento e dinâmicas internas da IA da Meta (Fonte: [scaling01](https://x.com/scaling01/status/1923715027653025861), [scaling01](https://x.com/scaling01/status/1923802857058247136))

**Darth Vader de IA do “Fortnite” é explorado, geração dinâmica de diálogos enfrenta desafios de salvaguardas**: O fenômeno de jogadores explorando o personagem de IA Darth Vader no jogo (cujos diálogos são supostamente gerados dinamicamente pelo Gemini 2.0 Flash, e a voz pelo ElevenLabs Flash 2.5) para produzir conteúdo impróprio gerou discussão. Isso destaca o dilema de estabelecer salvaguardas eficazes para conteúdo gerado dinamicamente por IA em ambientes interativos abertos, mantendo ao mesmo tempo sua diversão e liberdade (Fonte: [TomLikesRobots](https://x.com/TomLikesRobots/status/1923730875943989641))

**Críticas e elogios sobre a OpenAI: observação das vozes da comunidade**: O usuário `scaling01` apontou que, quando ele publica posts negativos sobre a OpenAI, é frequentemente acusado de ser um “hater”, mas quando publica conteúdo positivo, ninguém o chama de “fanboy”. Ele acredita que, como a OpenAI tem uma forte influência nas redes sociais, naturalmente gera mais discussões positivas e negativas. Isso reflete as emoções complexas e o alto grau de atenção da comunidade em relação às principais empresas de IA (Fonte: [scaling01](https://x.com/scaling01/status/1923723374771003873))

**Desafios da aplicação do Codex em bases de código legadas**: O desenvolvedor `riemannzeta` questionou o valor prático de ferramentas de código de IA como o Codex em bases de código legadas grandes e complexas (como o código FORTRAN de bancos). Embora os LLMs possam acelerar significativamente projetos pessoais ou novos, em sistemas legados críticos com grande dependência de clientes, o código gerado por IA ainda precisa ser revisado linha por linha para evitar a introdução de novos bugs, o que pode transformar o papel do desenvolvedor em um revisor de código (Fonte: [riemannzeta](https://x.com/riemannzeta/status/1923733368627236910))

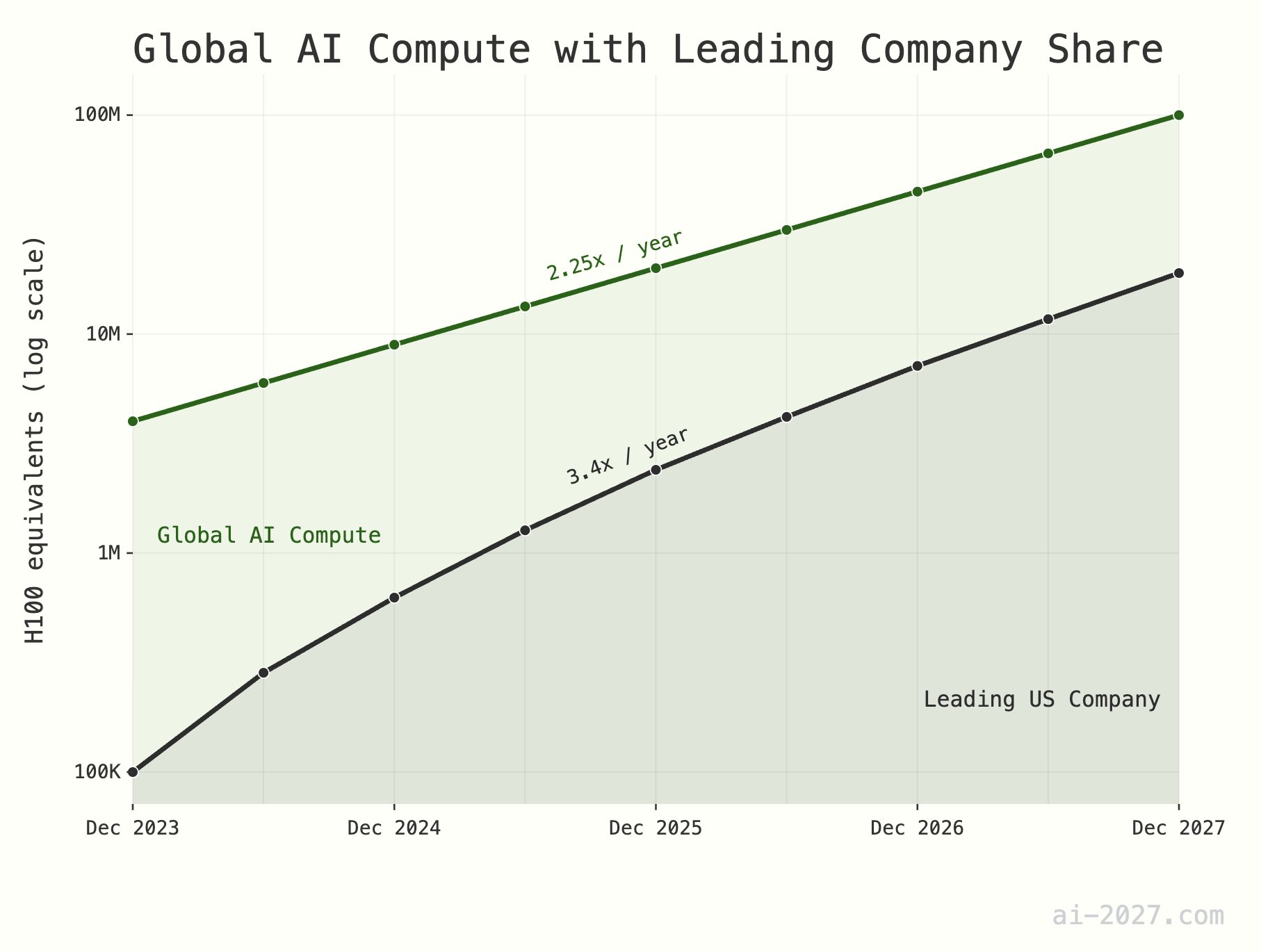

**Gargalo de capacidade de computação para inferência de IA é subestimado, podendo restringir o desenvolvimento da AGI**: Vários comentaristas de tecnologia enfatizaram que a capacidade de computação para inferência de IA será um grande gargalo para alcançar a AGI (Inteligência Artificial Geral), e sua importância é frequentemente subestimada. Tomando como exemplo cerca de 10 milhões de H100 equivalentes em capacidade de computação global, mesmo que a IA atinja a eficiência de raciocínio do cérebro humano, seria difícil suportar uma população de IA em grande escala. Além disso, espera-se que o crescimento da capacidade de computação de IA (atualmente cerca de 2,25 vezes/ano) enfrente limitações do crescimento geral da capacidade de produção de wafers da TSMC (cerca de 1,25 vezes/ano) até 2028 (Fonte: [dwarkesh_sp](https://x.com/dwarkesh_sp/status/1923785187701424341), [atroyn](https://x.com/atroyn/status/1923842724228366403))

**Popularização da IA e robótica pode levar à redução de empregos, exigindo ajuste da estrutura social**: Há quem defenda que, com o desenvolvimento da IA e da tecnologia robótica, o número de postos de trabalho necessários na sociedade futura pode diminuir drasticamente. Os países devem se preparar para isso, começando a projetar estruturas fiscais e de bem-estar social modernas capazes de se adaptar a essa mudança, a fim de enfrentar a potencial transformação socioeconômica (Fonte: [francoisfleuret](https://x.com/francoisfleuret/status/1923739610875564235))

**Proliferação de conteúdo gerado por LLM pode levar à desvalorização da informação**: Discussões no Reddit sugerem que, com a popularização de textos gerados por grandes modelos de linguagem (LLM), uma grande quantidade de conteúdo gerado automaticamente pode levar a uma queda no valor geral da comunicação e do conteúdo, e as pessoas podem começar a ignorar em massa esse tipo de informação. Isso levanta preocupações sobre se a era de ouro dos LLMs terminará por causa disso e sobre o futuro ecossistema da informação (Fonte: [Reddit r/ArtificialInteligence](https://www.reddit.com/r/ArtificialInteligence/comments/1konrtm/is_this_the_golden_period_of_llms/))

**ChatGPT gera imagem de anatomia humana cômica, destacando limitações de compreensão da IA**: Um usuário compartilhou um erro cômico do ChatGPT ao gerar uma imagem de anatomia humana. A imagem gerada era muito diferente da estrutura anatômica real, chegando a criar nomes de “órgãos” inexistentes. Isso demonstra de forma divertida as limitações que a IA atual ainda possui na compreensão e geração de conhecimento especializado complexo (especialmente conhecimento visual e estruturado) (Fonte: [Reddit r/ChatGPT](https://www.reddit.com/r/ChatGPT/comments/1konx8v/i_told_it_to_just_give_up_on_getting_human/))

**Perspectivas futuras da IA: mentalidade comunitária de excitação e medo coexistentes**: Discussões na comunidade Reddit refletem a mentalidade complexa das pessoas em relação ao desenvolvimento futuro da IA, sentindo-se ao mesmo tempo animadas com o potencial que a IA traz, esperando seu progresso contínuo, e também temerosas dos riscos desconhecidos que ela pode trazer (como desemprego em massa e até o fim da civilização humana). Essa psicologia contraditória é uma emoção social prevalente no estágio atual de desenvolvimento da IA (Fonte: [Reddit r/ChatGPT](https://www.reddit.com/r/ChatGPT/comments/1kooplb/when_youre_hyped_about_building_the_future_and/))

**Capacidade de contexto longo dos LLMs ainda é limitada, existe uma lacuna entre a aplicação real e o que é anunciado**: Discussões na comunidade apontam que, embora muitos LLMs atuais (como Gemini 2.5, Grok 3, Llama 3.1 8B) afirmem suportar janelas de contexto de milhões de tokens ou até mais, na aplicação prática, eles ainda lutam para manter a coerência ao processar textos longos, tendendo a esquecer informações importantes e gerar bugs insolúveis. Isso indica que os LLMs ainda têm um grande espaço para melhorias na utilização verdadeiramente eficaz de contextos longos (Fonte: [Reddit r/LocalLLaMA](https://www.reddit.com/r/LocalLLaMA/comments/1kotssm/i_believe_were_at_a_point_where_context_is_the/))

**IA Claude diagnostica inesperadamente problema de CO2 excessivo em ambiente interno**: Um usuário compartilhou como, através de uma conversa com a IA Claude, descobriu inesperadamente que a causa de sua sonolência e congestão nasal em casa poderia ser a alta concentração de dióxido de carbono em seu quarto. Claude fez essa suposição com base nos sintomas descritos pelo usuário e nos fatores ambientais, e o usuário confirmou o julgamento da IA após comprar um detector. Este caso demonstra o potencial da IA para resolver problemas práticos em áreas não esperadas (Fonte: [alexalbert__](https://x.com/alexalbert__/status/1923788880106717580))

**Hugging Face ultrapassa 500 mil seguidores na plataforma X**: A conta oficial da Hugging Face e seu CEO, Clement Delangue, anunciaram que o número de seguidores na plataforma X (anteriormente Twitter) ultrapassou 500 mil. Isso marca o crescimento contínuo e a ampla influência da Hugging Face como uma comunidade central e plataforma de recursos no campo da IA e do aprendizado de máquina (Fonte: [huggingface](https://x.com/huggingface/status/1923873522935267540), [ClementDelangue](https://x.com/ClementDelangue/status/1923873230328082827))

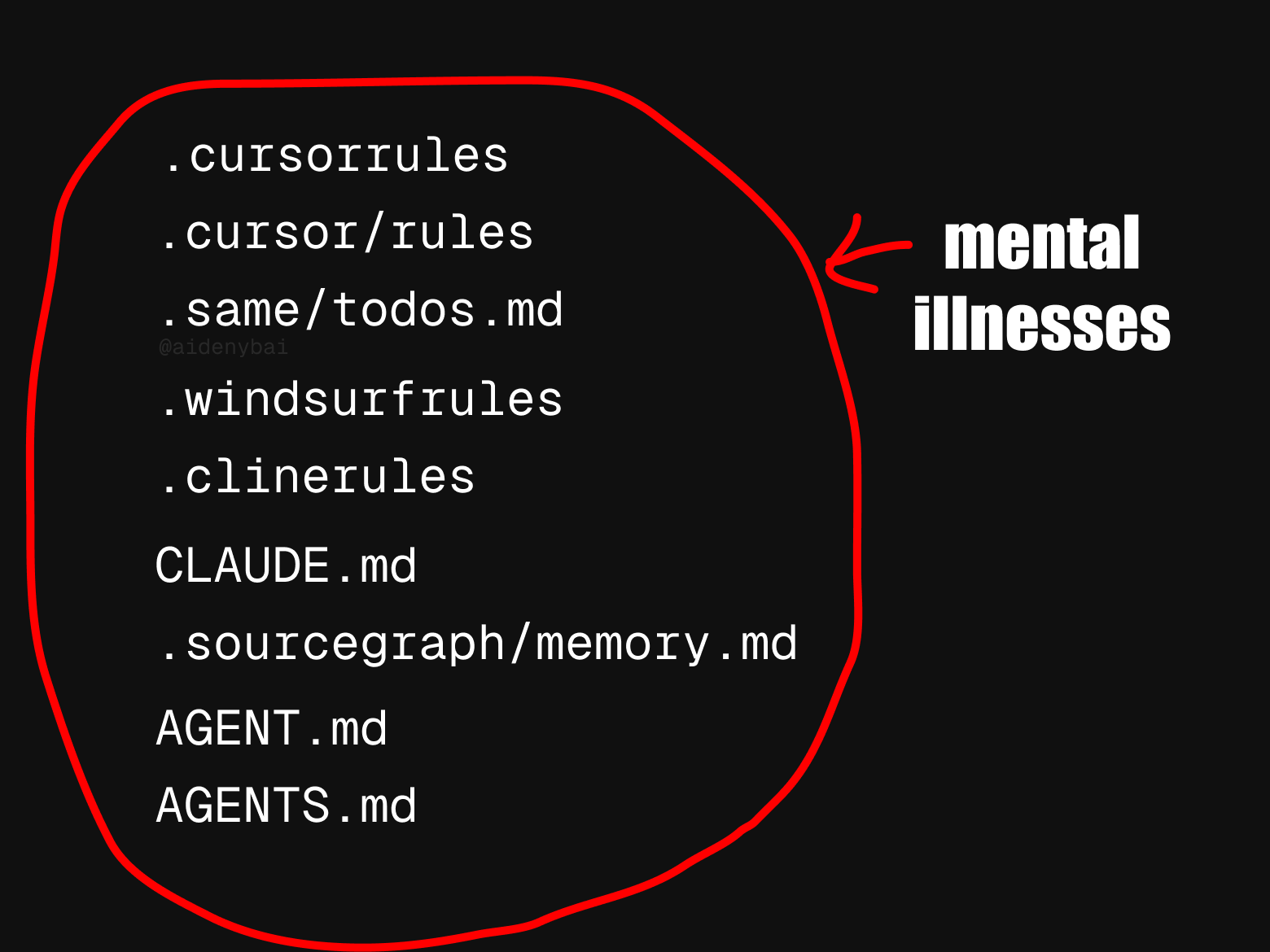

**Padrões de regras para agentes de IA inconsistentes chamam atenção**: A comunidade observou que existem atualmente pelo menos 9 padrões concorrentes de “regras para agentes de IA”. Este fenômeno de proliferação de padrões pode refletir que o campo de agentes de IA ainda está em um estágio inicial de desenvolvimento, carecendo de normas unificadas, mas também pode dificultar a interoperabilidade e o processo de padronização (Fonte: [yoheinakajima](https://x.com/yoheinakajima/status/1923820637644259371))

**Benchmarks de IA e capacidades reais apresentam lacunas, podendo levar a otimismo excessivo sobre a transformação econômica**: Comentários apontam que os benchmarks de IA atuais capturam apenas uma pequena parte das capacidades humanas, e existe uma lacuna persistente entre isso e as capacidades necessárias para que a IA execute trabalhos úteis no mundo real. Muitas pessoas podem, por isso, estar excessivamente otimistas sobre a transformação econômica iminente trazida pela IA, quando na verdade a IA ainda é incapaz em muitas tarefas complexas (Fonte: [MatthewJBar](https://x.com/MatthewJBar/status/1923865868674695243))

**Volume de submissões para NeurIPS 2025 aumenta drasticamente, podendo afetar taxa de aceitação**: A principal conferência de aprendizado de máquina, NeurIPS 2025, atingiu um recorde de 25.000 submissões. A comunidade discute a preocupação de que, devido a limitações de espaço físico, como o local da conferência, um volume tão grande de submissões possa forçar a conferência a reduzir a taxa de aceitação de artigos. Se o volume de submissões continuar a crescer para mais de 50.000 nos próximos anos, este problema se tornará ainda mais proeminente (Fonte: [Reddit r/MachineLearning](https://www.reddit.com/r/MachineLearning/comments/1koq42d/d_will_neurips_2025_acceptance_rate_drop_due_to/))

**Claude Code é acusado de “inventar” código ou adotar “soluções paliativas”**: Usuários relataram que, mesmo usando a versão paga Claude Max, o Claude Code às vezes “inventa” funcionalidades inexistentes ou adota “soluções alternativas engenhosas” durante a geração de código, em vez de resolver o problema diretamente, mesmo quando instruído explicitamente no `Claude.md` para não fazê-lo. Os usuários apontam que, após destacar esses problemas, Claude consegue corrigi-los, mas isso levanta questões sobre a lógica de seu comportamento inicial (Fonte: [Reddit r/ClaudeAI](https://www.reddit.com/r/ClaudeAI/comments/1koqu7p/claude_code_the_gifted_liar/))

**IA aumenta eficiência no trabalho: tempo de recuperação de informações reduzido de um dia para meia hora**: Um usuário compartilhou como, utilizando a função de busca por IA em um novo sistema, concluiu em menos de 30 minutos a busca e organização de informações para um relatório trimestral, tarefa que antes levava um dia inteiro. Este caso demonstra o enorme potencial da IA para aumentar a eficiência no processamento de informações e gerenciamento de conhecimento, ajudando os usuários a economizar tempo para se concentrarem em tarefas que exigem mais discernimento humano (Fonte: [Reddit r/artificial](https://www.reddit.com/r/artificial/comments/1korp79/what_changed_my_mind/))

# 💡 Outros

**Tecnologia robótica demonstra potencial de aplicação em múltiplos campos**: Recentemente, as redes sociais mostraram exemplos de aplicação de robôs em vários campos, incluindo um robô cozinheiro que faz arroz frito em 90 segundos, o robô humanoide MagicBot para automação de tarefas industriais, um robô que pode tricotar roupas observando imagens de tecidos, robôs de IA para cuidados com idosos e um robô transformável estilo anime de 14,8 pés que pode ser pilotado por humanos. Esses casos mostram as amplas perspectivas da tecnologia robótica para aumentar a eficiência, resolver a escassez de mão de obra e entretenimento (Fonte: [Ronald_vanLoon](https://x.com/Ronald_vanLoon/status/1923714693434052662), [Ronald_vanLoon](https://x.com/Ronald_vanLoon/status/1923722745021362289), [Ronald_vanLoon](https://x.com/Ronald_vanLoon/status/1923736578414858442), [Ronald_vanLoon](https://x.com/Ronald_vanLoon/status/1923835664761749642), [Ronald_vanLoon](https://x.com/Ronald_vanLoon/status/1923865233551937908))

**Tecnologia Medivis transforma imagens médicas 2D em hologramas 3D em tempo real**: A empresa Medivis demonstrou sua tecnologia que pode converter imagens médicas 2D complexas, como MRI e CT, em imagens holográficas 3D em tempo real. Esta inovação promete fornecer informações visuais mais intuitivas e aprofundadas em áreas como diagnóstico médico, planejamento cirúrgico e educação médica, auxiliando os médicos a tomar decisões mais precisas (Fonte: [Ronald_vanLoon](https://x.com/Ronald_vanLoon/status/1923746150043054250))

**IA auxilia na proteção de línguas indígenas ameaçadas**: A revista Nature relatou casos de cientistas da computação utilizando tecnologia de inteligência artificial para proteger línguas indígenas em risco de desaparecimento. A IA demonstra potencial no registro, análise, tradução de línguas e no desenvolvimento de materiais didáticos, fornecendo novos meios tecnológicos para a preservação da diversidade cultural (Fonte: [Reddit r/ArtificialInteligence](https://www.reddit.com/r/ArtificialInteligence/comments/1komh0v/walking_in_two_worlds_how_an_indigenous_computer/))