Palavras-chave:Agente de programação de IA, Codex, Modelo de voz de grande escala, Agente de IA, OpenAI, MiniMax, Alibaba, Qwen, Versão prévia do Codex, Modelo de voz Speech-02, Pesquisa WorldPM, Modelo de linguagem visual FastVLM, Modelo multimodal FG-CLIP

🔥 Foco

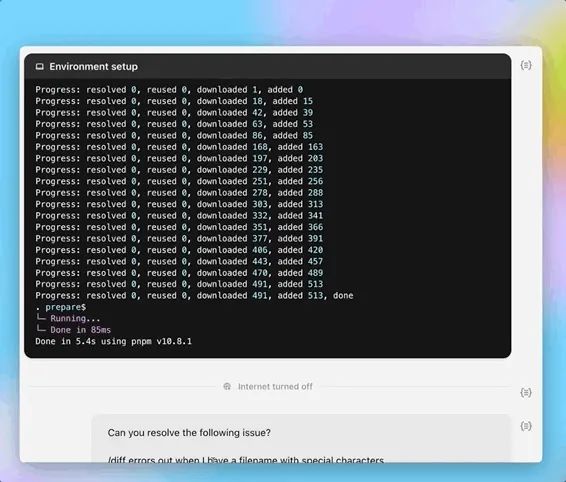

OpenAI lança versão de pré-visualização do agente de programação de IA Codex: A OpenAI lançou na noite de 16 de maio uma versão de pré-visualização do Codex, um agente de engenharia de software baseado na nuvem. O Codex é alimentado pelo modelo codex-1, uma variante do o3 otimizada para engenharia de software, capaz de lidar com tarefas paralelas de programação, perguntas e respostas sobre repositórios de código, correção de bugs e envio de pull requests. Ele opera em um ambiente sandbox na nuvem, pré-carregando o repositório de código do usuário, com tempo de conclusão de tarefas entre 1 e 30 minutos. Atualmente, está disponível para usuários do ChatGPT Pro, Team e Enterprise, com lançamento iminente para usuários Plus e Edu. Simultaneamente, foi lançado um modelo leve, o codex-mini (baseado no o4-mini), para o Codex CLI, com preços de API de US$ 1,5 por milhão de tokens de entrada e US$ 6 por milhão de tokens de saída. (Fonte: 36氪, 机器之心, op7418)

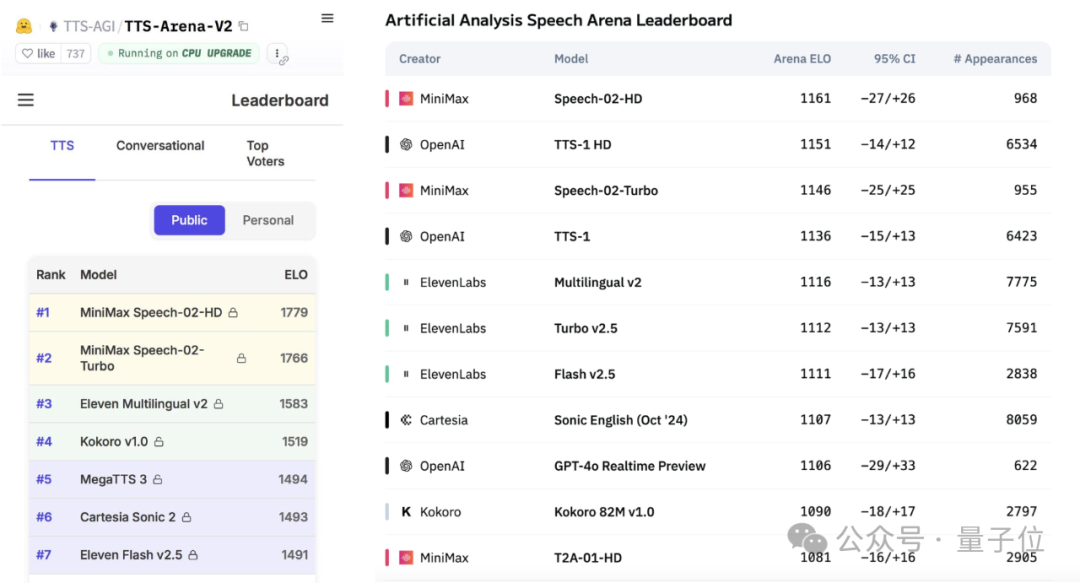

MiniMax lança grande modelo de voz Speech-02, liderando rankings globais de avaliação: A empresa chinesa de IA MiniMax lançou recentemente seu grande modelo de conversão de texto em fala (TTS), Speech-02-HD, que alcançou o primeiro lugar em dois importantes benchmarks globais de voz, o Artificial Analysis Speech Arena e o Hugging Face TTS Arena V2, superando a OpenAI e a ElevenLabs. O modelo apresenta características de ultrarrealismo, personalização e diversidade, suporta 32 idiomas e pode replicar timbres de voz realistas com apenas 10 segundos de áudio de referência. O popular aplicativo de aprendizado de inglês “AI Daniel Wu” utiliza a tecnologia da MiniMax. As principais inovações do Speech-02 incluem um codificador de locutor aprendível e o modelo de correspondência de fluxo Flow-VAE, que melhoram a qualidade e a similaridade do som. (Fonte: 36氪, karminski3)

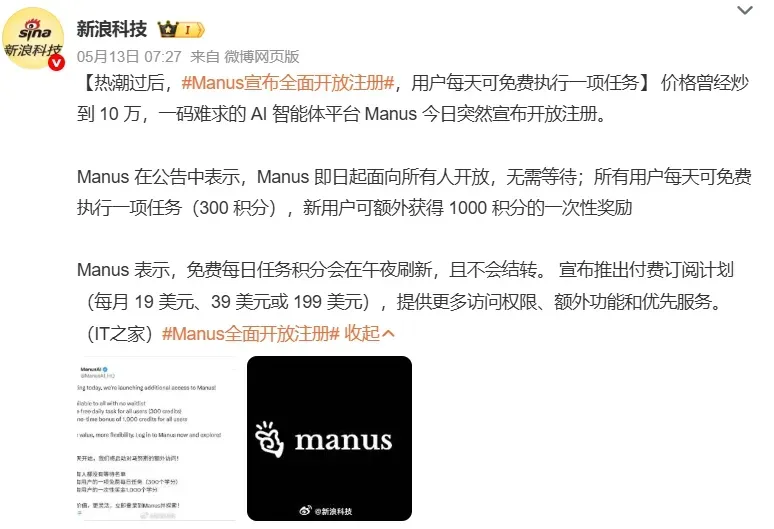

AI Agent atrai atenção do mercado, grandes empresas aceleram布局: O Agente de IA (Agent) está se tornando o novo foco no campo da IA. Plataformas de Agent de uso geral como Manus abriram inscrições, gerando grande interesse, e sua empresa-mãe, Monica, teria concluído uma nova rodada de financiamento de US$ 75 milhões, com avaliação próxima a US$ 500 milhões. Grandes empresas como Baidu (心响), ByteDance (扣子空间) e Alibaba (心流) lançaram seus próprios produtos ou plataformas de Agent, competindo pela entrada na era da IA. Os Agents podem executar tarefas mais complexas, como criação de materiais, design de páginas web, planejamento de viagens, etc. Atualmente, os Agents de uso geral ainda apresentam deficiências em operações entre aplicativos e tarefas profundas, sendo os principais desafios um ecossistema incompleto e silos de dados. O protocolo MCP é visto como chave para resolver a interconectividade, mas poucos aderiram. Agents de setores verticais B2B são considerados mais fáceis de comercializar primeiro, devido ao foco em cenários e facilidade de personalização. (Fonte: 36氪, 36氪)

Alibaba publica pesquisa WorldPM, explorando as Leis de Escala na modelagem de preferência humana: A equipe Qwen do Alibaba publicou o artigo “Modeling World Preference”, revelando que a modelagem de preferência humana segue Leis de Escala (Scaling Laws), indicando que diversas preferências humanas podem compartilhar uma representação unificada. A pesquisa utilizou o conjunto de dados StackExchange, contendo 15 milhões de pares de preferência, e realizou experimentos em modelos Qwen2.5 com parâmetros de 1.5B a 72B. Os resultados mostram que a modelagem de preferência apresenta uma redução logarítmica na perda em métricas objetivas e de robustez com o aumento da escala de treinamento; o modelo de 72B demonstrou fenômenos emergentes em algumas tarefas desafiadoras. A pesquisa fornece uma base eficaz para o ajuste fino de preferência, e tanto o artigo quanto o modelo (WorldPM-72B) foram disponibilizados em código aberto. (Fonte: Alibaba_Qwen)

🎯 Tendências

Google DeepMind e Anthropic divergem em pesquisa sobre interpretabilidade da IA: O Google DeepMind anunciou recentemente que não mais priorizará a “interpretabilidade mecanicista” (mechanistic interpretability) como foco de pesquisa, argumentando que o caminho para a engenharia reversa do funcionamento interno da IA através de métodos como autoencoders esparsos (SAE) é extremamente difícil e que os SAEs possuem falhas inerentes. Por outro lado, Dario Amodei, CEO da Anthropic, defende o fortalecimento da pesquisa nessa área e expressa otimismo sobre a possibilidade de alcançar uma “ressonância magnética da IA” nos próximos 5-10 anos. A natureza de “caixa preta” da IA é a raiz de muitos riscos, e a interpretabilidade mecanicista visa entender a função de neurônios e circuitos específicos do modelo, mas mais de uma década de pesquisa produziu resultados limitados, levando a uma profunda reflexão sobre as abordagens de pesquisa. (Fonte: WeChat)

Relatório da Poe revela mudanças no cenário do mercado de modelos de IA, com OpenAI e Google na liderança: O mais recente relatório de uso de modelos de IA da Poe mostra que, no campo da geração de texto, o GPT-4o (35,8%) lidera, enquanto no campo do raciocínio, o Gemini 2.5 Pro (31,5%) está no topo. A geração de imagem é dominada pelas séries Imagen3, GPT-Image-1 e Flux. Na geração de vídeo, a participação da Runway diminuiu, enquanto o Kling da Kuaishou se tornou um destaque. Em termos de agentes, o o3 da OpenAI superou o Claude e o Gemini em testes de pesquisa. A participação de mercado do Claude da Anthropic diminuiu. O relatório aponta que a capacidade de raciocínio se tornou um ponto chave de competição, e as empresas precisam estabelecer sistemas de avaliação para selecionar modelos diferentes de forma flexível para lidar com um mercado em rápida mudança. (Fonte: WeChat)

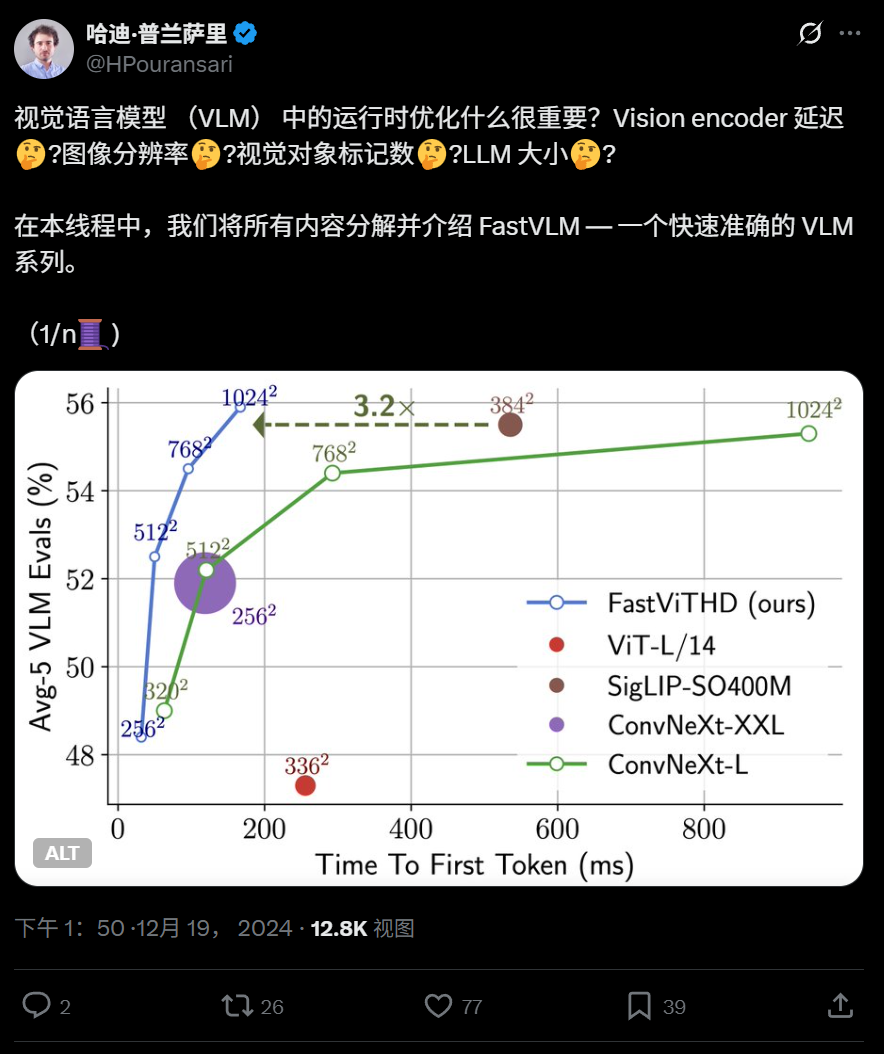

Apple abre o código do modelo de linguagem visual eficiente FastVLM, executável no iPhone: A Apple abriu o código do FastVLM, um modelo de linguagem visual projetado para operar eficientemente em dispositivos de ponta (edge) como o iPhone. O modelo, através de um novo codificador visual híbrido FastViTHD (que funde camadas convolucionais com módulos Transformer e adota técnicas de pooling multiescala e downsampling), reduz significativamente o número de tokens visuais (16 vezes menos que o ViT), alcançando uma velocidade de saída do primeiro token 85 vezes mais rápida em comparação com modelos similares. O FastVLM é compatível com os principais LLMs e já lançou versões com parâmetros de 0.5B, 1.5B e 7B, visando melhorar a velocidade de compreensão de imagem e a experiência do usuário em aplicativos de IA de ponta. (Fonte: WeChat)

360 lança modelo transmodal imagem-texto de nova geração FG-CLIP, melhorando a capacidade de alinhamento de granularidade fina: O Instituto de Pesquisa em Inteligência Artificial da 360 desenvolveu o FG-CLIP, um modelo transmodal imagem-texto de nova geração, com o objetivo de resolver as deficiências dos modelos CLIP tradicionais na compreensão de granularidade fina imagem-texto. O FG-CLIP adota uma estratégia de treinamento em duas fases: aprendizado contrastivo global (integrando descrições longas geradas por grandes modelos multimodais) e aprendizado contrastivo local (introduzindo dados de anotação região-texto e amostras negativas de granularidade fina difíceis), alcançando assim uma captura precisa de detalhes locais da imagem e diferenças sutis nos atributos do texto. O modelo foi aceito no ICML 2025 e disponibilizado em código aberto no Github e Huggingface, com pesos comercializáveis. (Fonte: WeChat)

Google lança LightLab, utilizando modelos de difusão para controle preciso de luz e sombra em imagens: A equipe de pesquisa do Google lançou o projeto LightLab, uma tecnologia que permite o controle parametrizado de granularidade fina de fontes de luz com base em uma única imagem. Os usuários podem ajustar a intensidade e a cor de fontes de luz visíveis, a intensidade da luz ambiente e inserir fontes de luz virtuais na cena. O LightLab é alcançado através do ajuste fino de modelos de difusão em um conjunto de dados especialmente criado (contendo pares de fotos reais com iluminação controlada e imagens renderizadas sinteticamente em grande escala), utilizando as propriedades lineares da luz para separar fontes de luz e luz ambiente, e sintetizando um grande número de pares de imagens com diferentes variações de iluminação para treinamento. O modelo pode simular diretamente efeitos de iluminação complexos no espaço da imagem, como iluminação indireta, sombras e reflexos. (Fonte: WeChat)

Tencent propõe métodos de aprendizagem por reforço GRPO e RCS para melhorar a generalização na detecção de intenção: A equipe de pesquisa da linha social do PCG da Tencent propôs o uso do algoritmo de otimização de política relativa agrupada (GRPO) combinado com a estratégia de amostragem curricular baseada em recompensa (RCS) em métodos de aprendizagem por reforço, aplicados a tarefas de reconhecimento de intenção. Este método melhorou significativamente a capacidade de generalização do modelo em intenções desconhecidas (aumento de até 47% em novas intenções e capacidade interlinguística), especialmente após a introdução do “Pensamento (Thought)”, a capacidade de generalização na detecção de intenções complexas foi ainda mais aprimorada. Experimentos mostram que modelos treinados com RL superam modelos SFT em generalização e, independentemente de serem baseados em modelos pré-treinados ou modelos ajustados por instrução, o desempenho após o treinamento com GRPO é semelhante. (Fonte: WeChat)

Universidade Tecnológica de Nanyang e outros propõem framework RAP, baseado em RAG para melhorar a percepção de imagem de alta resolução: A equipe do Professor Tao Dacheng da Universidade Tecnológica de Nanyang e outros propuseram o Retrieval-Augmented Perception (RAP), um plugin de percepção de imagem de alta resolução baseado na tecnologia RAG que não requer treinamento, visando resolver o problema de perda de informação quando grandes modelos de linguagem multimodais (MLLM) processam imagens de alta resolução. O RAP recupera patches de imagem relevantes para a pergunta do usuário e utiliza o algoritmo Spatial-Awareness Layout para manter sua relação posicional relativa, e então, através do Retrieved-Exploration Search (RE-Search), seleciona adaptativamente o número K de patches de imagem a serem mantidos, reduzindo efetivamente a resolução da imagem de entrada enquanto preserva informações visuais cruciais. Experimentos mostram que o RAP melhorou a precisão nos conjuntos de dados HR-Bench 4K e 8K em até 21% e 21,7%, respectivamente. Este trabalho foi aceito como um artigo Spotlight no ICML 2025. (Fonte: WeChat)

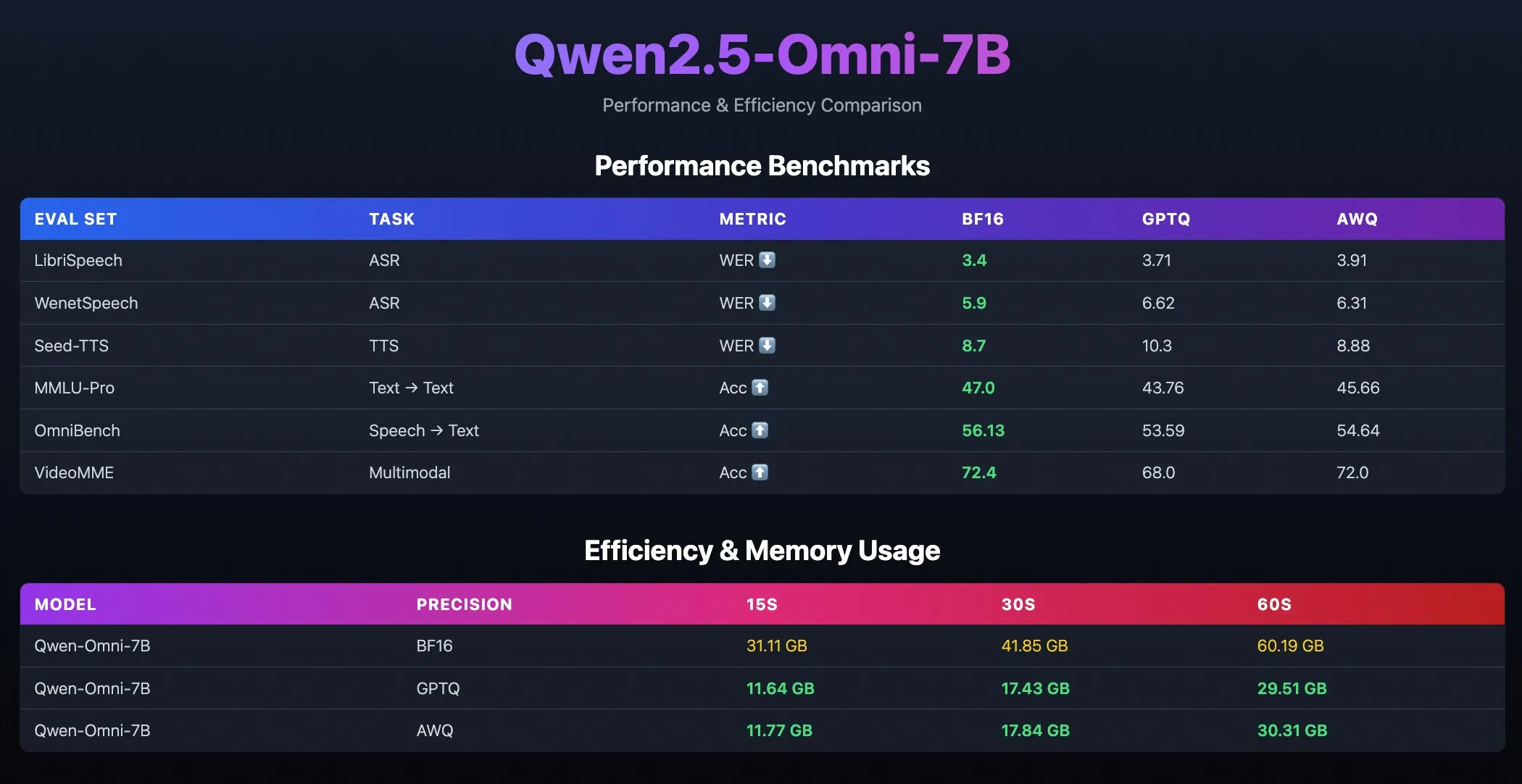

Lançamento dos modelos quantizados Qwen2.5-Omni-7B: A equipe Qwen do Alibaba lançou versões quantizadas do modelo Qwen2.5-Omni-7B, incluindo checkpoints otimizados com GPTQ e AWQ. Esses modelos foram disponibilizados no Hugging Face e ModelScope, visando fornecer opções de implantação mais eficientes e com menor consumo de recursos, mantendo ao mesmo tempo suas poderosas capacidades multimodais. (Fonte: Alibaba_Qwen, karminski3, reach_vb)

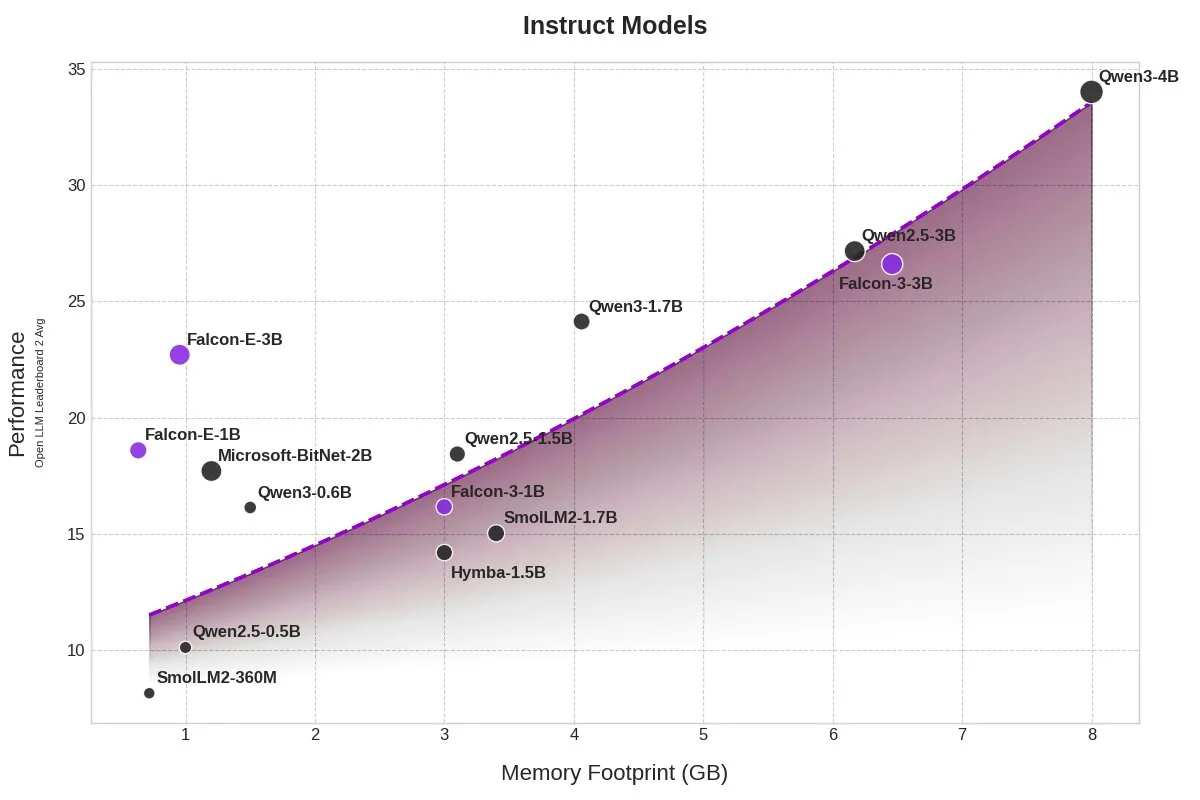

TII lança modelos BitNet Falcon-E-1B/3B, reduzindo significativamente o uso de memória: O Technology Innovation Institute (TII) lançou uma nova série de modelos Falcon-Edge baseada no framework de modelo de precisão de 1 bit da Microsoft, BitNet, incluindo Falcon-E-1B e Falcon-E-3B. Alega-se que o desempenho desses modelos é comparável ao Qwen3-1.7B, mas com apenas 1/4 do uso de memória. O TII também lançou a biblioteca de ajuste fino onebitllms, permitindo que os usuários ajustem esses modelos de 1 bit em placas NVIDIA. (Fonte: karminski3)

Modelos Qwen3 e DeepSeek lideram no ranking de perguntas e respostas médicas MEDIC-Benchmark: Os modelos Qwen3 alcançaram o primeiro e o segundo lugar no recém-lançado ranking de perguntas e respostas médicas MEDIC-Benchmark. Além disso, os cinco primeiros lugares do ranking são ocupados por modelos das séries Qwen e DeepSeek, demonstrando a forte capacidade de resposta desses grandes modelos chineses no campo médico especializado. (Fonte: karminski3)

Universidade de Zhejiang propõe Rankformer: arquitetura de modelo de recomendação Transformer que otimiza diretamente o ranking: Uma equipe da Universidade de Zhejiang propôs uma nova arquitetura de modelo de recomendação Graph Transformer chamada Rankformer, cujo design deriva diretamente de objetivos de ranking (como a função de perda BPR). O Rankformer simula a direção de otimização de vetores no processo de descida de gradiente para projetar um mecanismo Graph Transformer único, guiando o modelo na propagação para frente para codificar representações de ranking superiores. O modelo utiliza um mecanismo de atenção global para agregar informações e afirma reduzir a complexidade de tempo e espaço para um nível linear através de transformações matemáticas e otimização de cache. A pesquisa foi aceita na conferência WWW 2025. (Fonte: WeChat)

🧰 Ferramentas

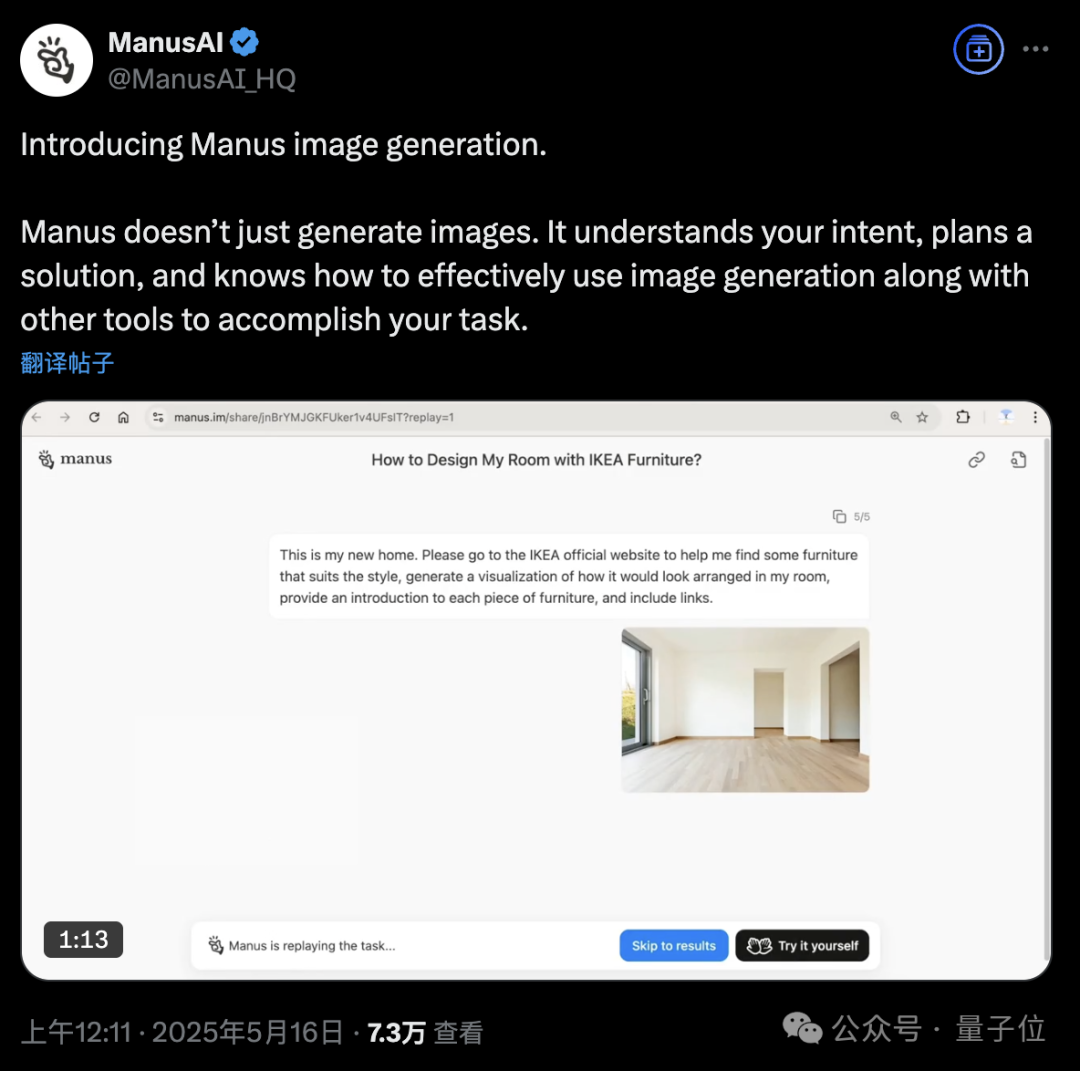

Plataforma Manus AI Agent adiciona funcionalidade de geração de imagem: A plataforma de AI Agent Manus anunciou suporte para geração de imagem. Diferente das ferramentas tradicionais de desenho com IA, Manus consegue entender o propósito do usuário ao desenhar e planejar um esquema de geração. Por exemplo, um usuário pode carregar uma foto de um quarto, pedir para Manus encontrar móveis no site da IKEA e gerar uma visualização do efeito da decoração, anexando os links dos móveis. Manus completa a tarefa analisando, pesquisando, selecionando móveis e elaborando uma estratégia de design. Esta funcionalidade visa integrar profundamente o fluxo de trabalho do agente com a geração de imagem. Atualmente, Manus está com inscrições abertas, oferecendo 1000 pontos de bônus, 300 pontos extras diários e planos de assinatura paga. (Fonte: 36氪, WeChat)

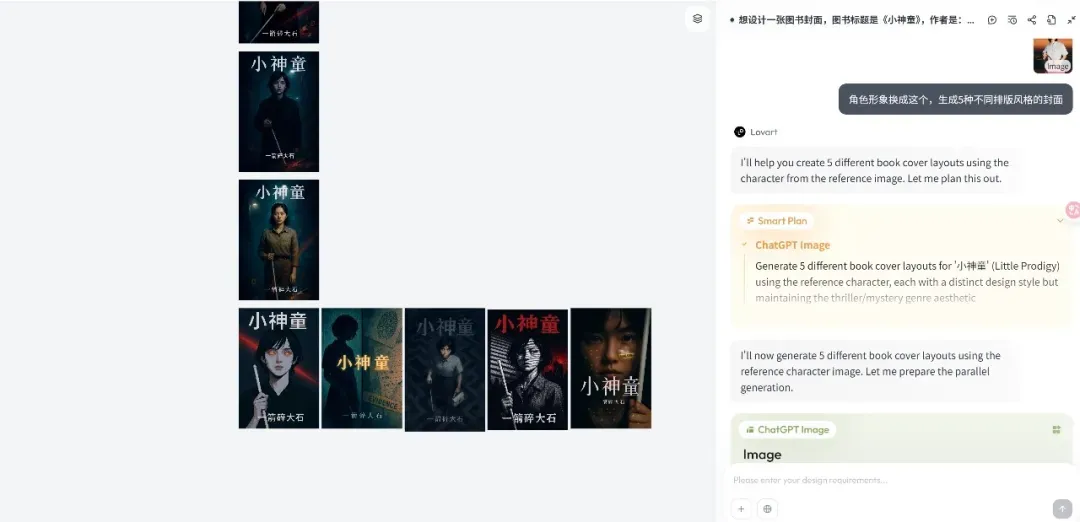

Plataforma de design Agent Lovart é lançada, focada em fluxos de trabalho criativos: A emergente plataforma de design Agent Lovart rapidamente atraiu atenção após seu lançamento. Seu conceito central é transformar o processo criativo dos designers (envolvendo multimodalidade) em um fluxo de trabalho de Agent. Lovart oferece uma interface interativa estilo canvas, onde os usuários podem guiar a IA através de conversas para completar tarefas de design, com a IA responsável pelo planejamento e execução. O fundador Chen Mian acredita que os produtos de imagem de IA entraram na fase 3.0, impulsionada por Agents, e Lovart visa se tornar um “amigo” dos designers, delegando tarefas triviais à IA e permitindo que os designers se concentrem na criatividade. O produto integrará futuramente capacidades de modelagem 3D, vídeo e áudio, tornando-se uma “equipe criativa” ou “empresa de design”. (Fonte: 36氪)

OpenAI Codex CLI atualizado, integra o4-mini e oferece créditos de API gratuitos: A OpenAI aprimorou seu agente de codificação de código aberto leve, o Codex CLI. A nova versão é alimentada pelo codex-mini, uma versão simplificada do codex-1 baseada no o4-mini, otimizada para perguntas e respostas de código de baixa latência e edição. Os usuários agora podem fazer login no Codex CLI com suas contas ChatGPT, e os usuários Plus e Pro podem resgatar US$ 5 e US$ 50 em créditos de API gratuitos, respectivamente (válidos por 30 dias), para experimentar o modelo codex-mini-latest. (Fonte: openai, hwchung27, op7418)

Framework de processamento de dados de código aberto Smallpond da DeepSeek integra acesso nativo do DuckDB ao 3FS: O framework de processamento de dados de código aberto Smallpond da DeepSeek utiliza internamente o 3FS (DeepSeek File System) e o DuckDB. Agora, o DuckDB, através do plugin hf3fs_usrbio, suporta o acesso nativo ao 3FS, o que trará melhorias de desempenho e redução de overhead. O próprio DuckDB também é elogiado por sua facilidade de uso, por exemplo, permitindo incorporar URLs diretamente em consultas para processamento de dados. (Fonte: karminski3)

ComfyUI suporta nativamente o modelo de vídeo Wan2.1-VACE da Alibaba: O ComfyUI anunciou suporte nativo para as versões 14B e 1.3B do modelo de geração de vídeo Wan2.1-VACE da equipe Wanxiang da Alibaba (@Alibaba_Wan). Este modelo traz capacidades integradas de edição de vídeo para o ComfyUI, incluindo texto para vídeo, imagem para vídeo, vídeo para vídeo (controle de pose e profundidade), restauração de vídeo (inpainting) e expansão (outpainting), bem como referência de personagem/objeto. (Fonte: TomLikesRobots)

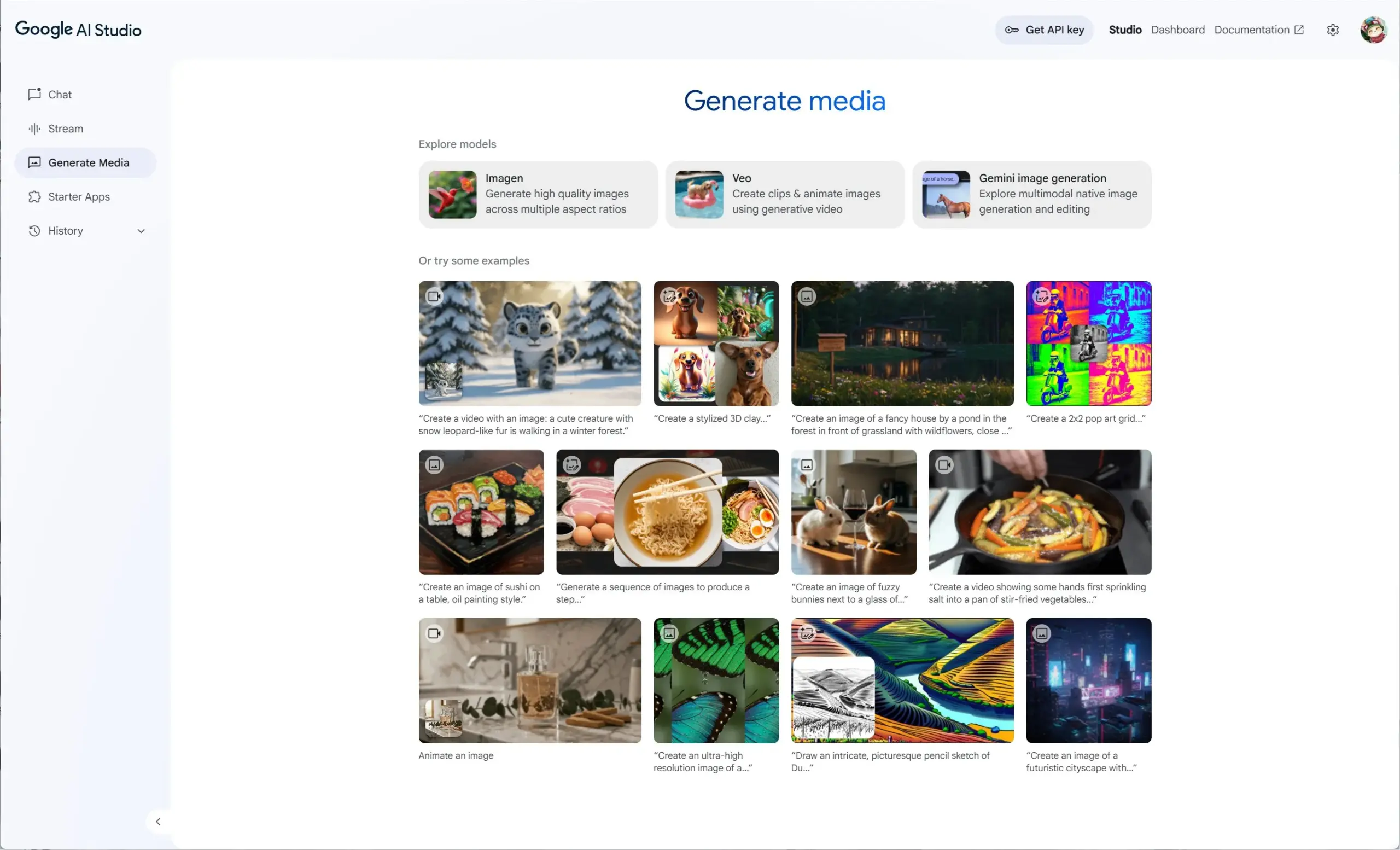

Google AI Studio integra Veo 2, Gemini 2.0 e Imagen 3, oferecendo experiência unificada de mídia generativa: O Google AI Studio lançou uma nova experiência de mídia generativa, integrando o modelo de vídeo Veo 2, as capacidades nativas de geração/edição de imagem do Gemini 2.0 e o mais recente modelo de texto para imagem Imagen 3. Os usuários podem experimentar esses modelos gratuitamente no AI Studio, e os desenvolvedores também podem construir através da API. (Fonte: op7418)

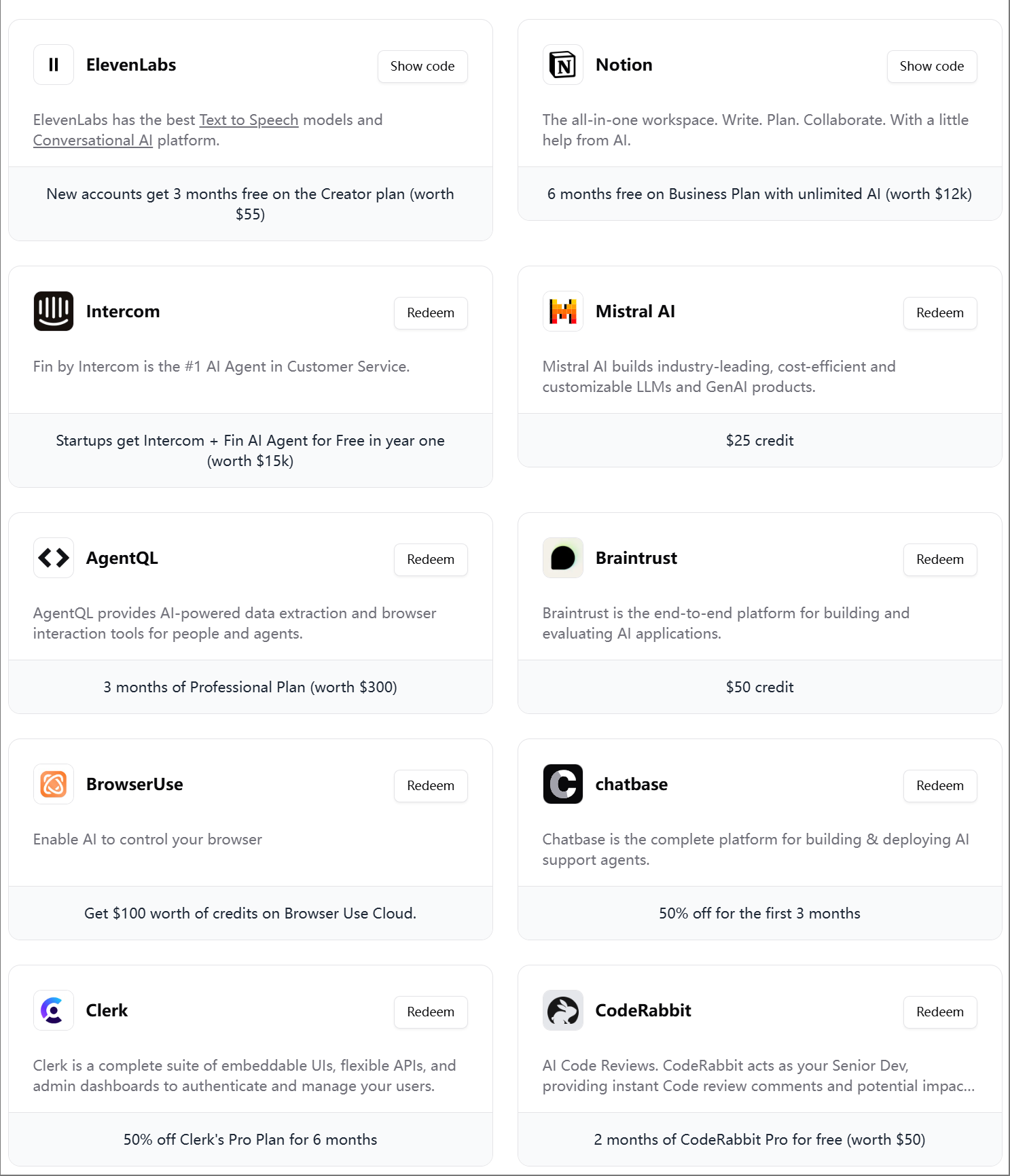

ElevenLabs lança o quarto pacote de presentes para engenheiros de IA: A ElevenLabs lançou seu quarto pacote de presentes para engenheiros de IA, contendo assinaturas e créditos de API para diversas ferramentas e serviços, como Modal Labs, Mistral AI, Notion, BrowserUse, Intercom, Hugging Face, CodeRabbit, entre outros, com o objetivo de ajudar startups e desenvolvedores de IA. (Fonte: op7418)

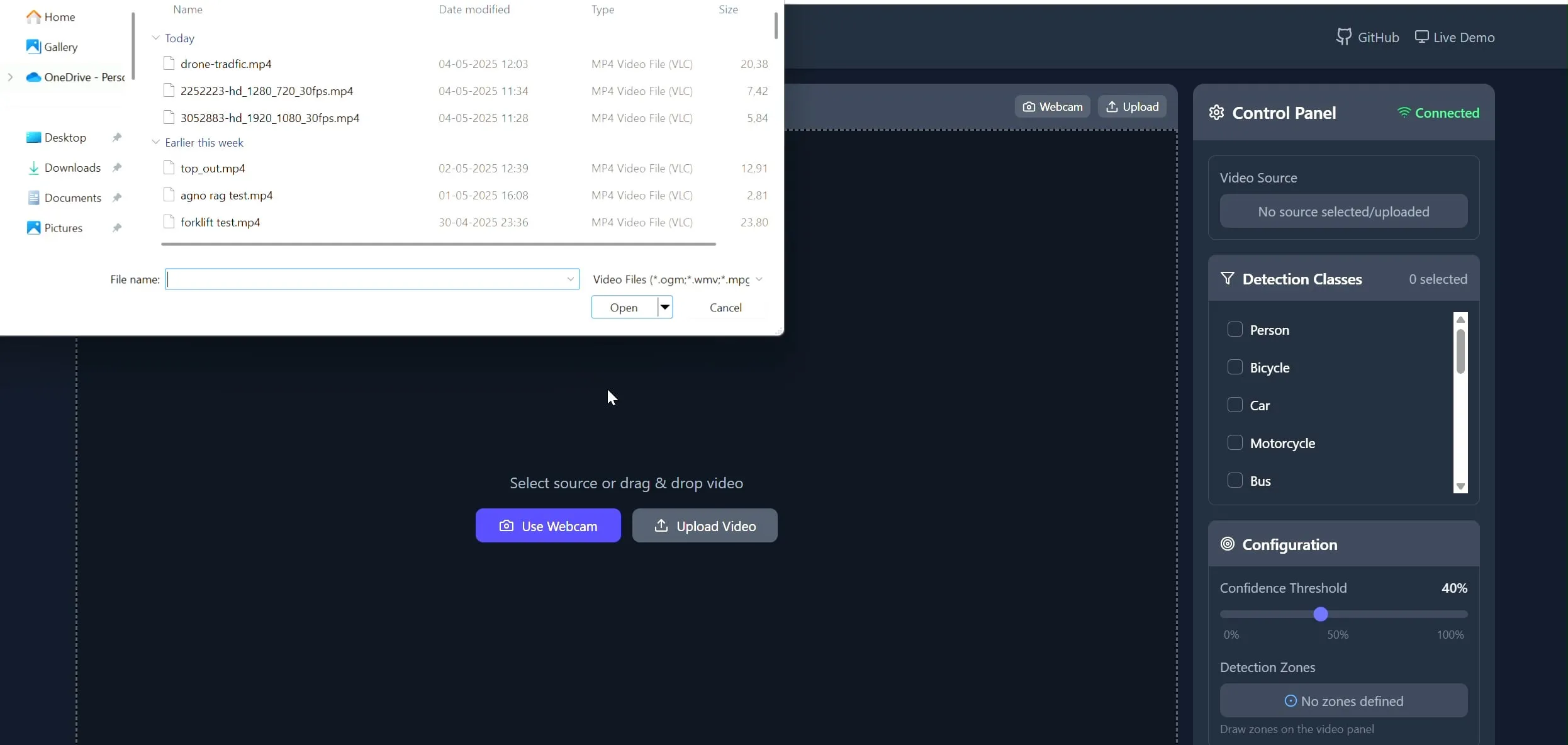

Polygon Zone App: Ferramenta de desenho de polígonos personalizados em vídeos para tarefas de CV: O desenvolvedor Pavan Kunchala criou uma ferramenta chamada Polygon Zone App, que permite aos usuários carregar vídeos, desenhar interativamente regiões de polígonos personalizados (ROI) nos frames do vídeo e executar análises de visão computacional (CV), como detecção de objetos, nessas regiões. A ferramenta visa simplificar o processo tedioso de definir ROIs em projetos de CV, evitando a edição manual de coordenadas JSON. (Fonte: Reddit r/deeplearning)

📚 Aprendizado

Curso AI Evals atrai participação de mais de 300 empresas: O curso de avaliação de IA (bit.ly/evals-ai) ministrado por Hamel Husain já atraiu a participação de mais de 300 empresas, incluindo gigantes como Adobe, Amazon, Google, Meta, Microsoft, NVIDIA, OpenAI, além de diversas universidades de ponta. Isso reflete o alto interesse e a demanda da indústria por métodos e práticas de avaliação de modelos de IA. (Fonte: HamelHusain)

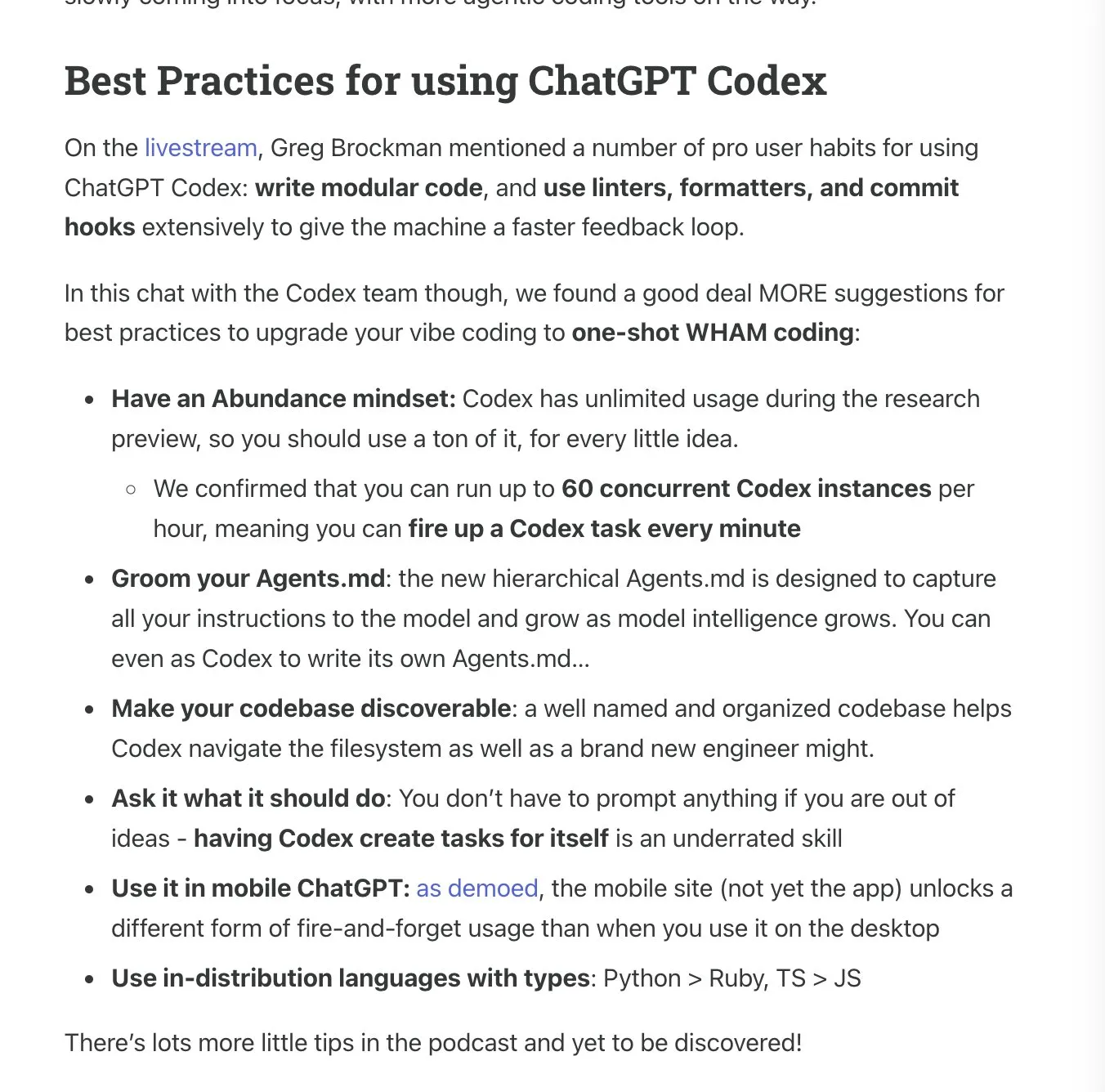

Latent.Space lança manual de uso do ChatGPT Codex: Latent.Space lançou um guia intitulado “ChatGPT Codex: The Missing Manual”, detalhando como usar eficientemente o recém-lançado engenheiro de software autônomo na nuvem da OpenAI, o ChatGPT Codex. O manual, escrito por Josh Ma e Alexander Embiricos, visa ajudar os usuários a aproveitar ao máximo as poderosas funcionalidades do Codex em operações de repositório de código. (Fonte: swyx)

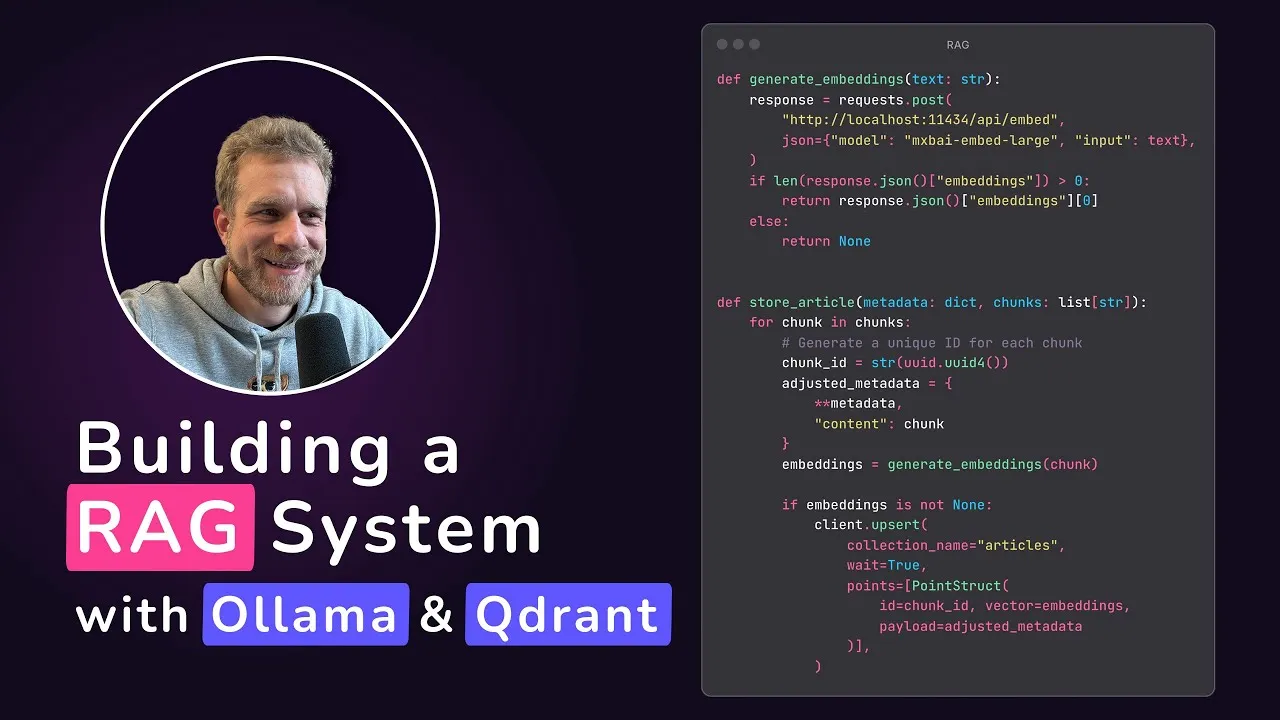

Qdrant lança tutorial de aplicativo RAG local: Qdrant Engine compartilhou um tutorial criado por @maxedapps, demonstrando como construir um aplicativo de geração aumentada por recuperação (RAG) 100% local do zero, usando Gemma 3, Ollama e Qdrant Engine. O tutorial tem duração de 2 horas e fornece código completo e passos, ideal para desenvolvedores que desejam praticar com aplicativos de IA locais. (Fonte: qdrant_engine)

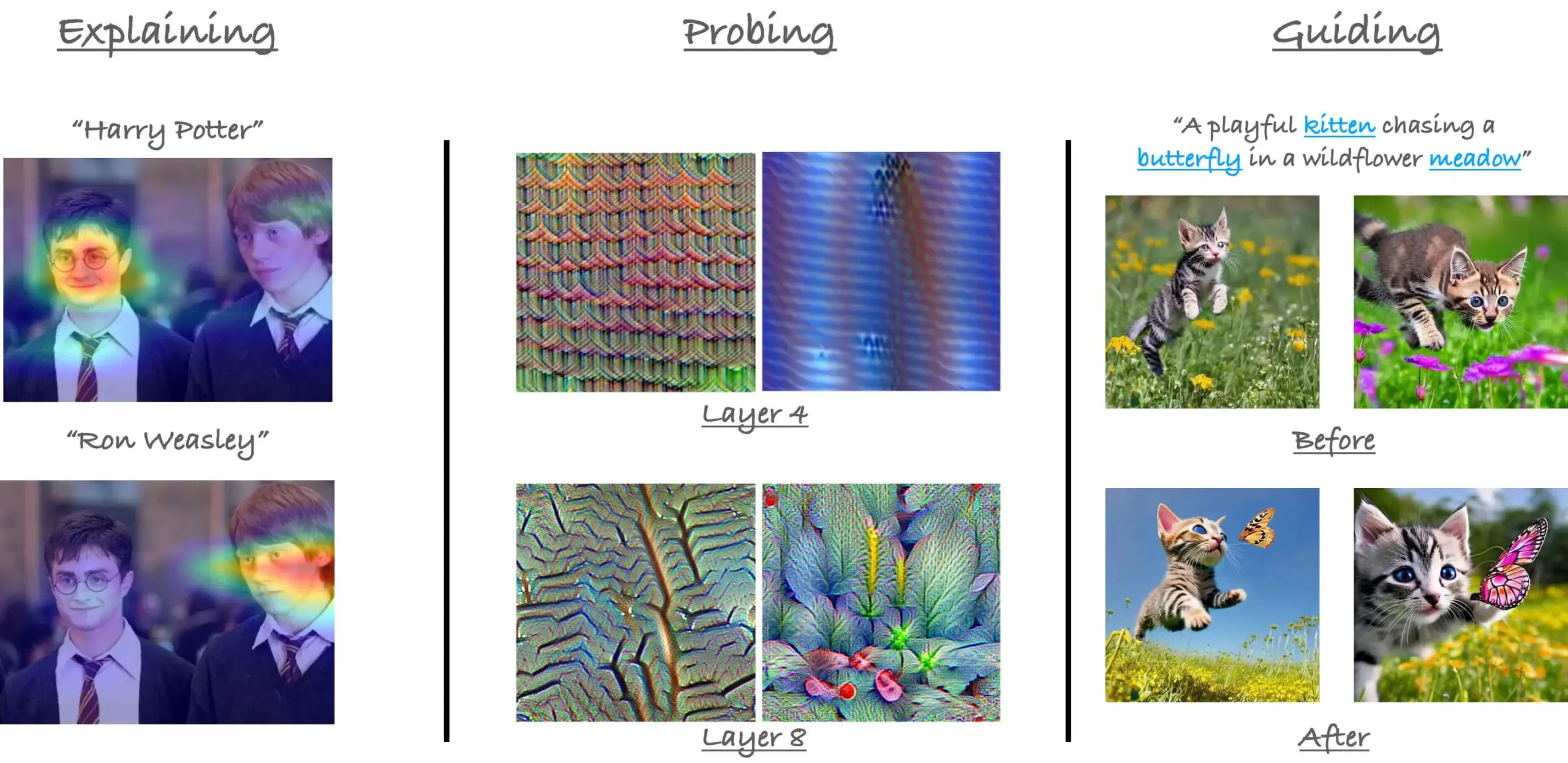

Retrospectiva do tutorial sobre mecanismos de atenção no ViT da CVPR23: O pesquisador Sayak Paul relembrou seu tutorial com Hila Chefer na CVPR 2023 sobre mecanismos de atenção no Vision Transformer (ViT). O tutorial girou em torno dos três temas “explicar (explain)”, “sondar (probe)” e “guiar (guide)”, com o objetivo de ajudar a entender o funcionamento interno da atenção no ViT. (Fonte: RisingSayak)

Dicas de uso do Claude Code compartilhadas: planejamento, regras e compressão manual: Um usuário do Reddit compartilhou sua experiência de uma semana de uso intensivo do Claude Code, enfatizando a importância do planejamento, da definição de regras (através de um arquivo CLAUDE.md) e da execução manual de /compact antes de atingir o limite de compressão automática. Essas dicas ajudam a aumentar a produtividade e a qualidade da saída, especialmente ao lidar com grandes funcionalidades ou evitar que o modelo se desvie do curso. O usuário mencionou que, com esses métodos, o Claude Code consegue concluir tarefas complexas de forma eficiente. (Fonte: Reddit r/ClaudeAI)

Entrevista com Su Wen, fundador da AIGCode: insistindo no desenvolvimento próprio de grandes modelos, com o objetivo de geração de código nível “L5” do Autopilot: Su Wen, fundador da AIGCode, afirmou em entrevista que o objetivo da empresa é ser uma infraestrutura de fornecimento de código, alcançando programação automática Autopilot de nível “L5”, permitindo que até mesmo não programadores gerem aplicativos completos através da IA. Ele acredita que a codificação (Coding) é o melhor cenário para cultivar grandes modelos, e o código é um dado de treinamento de alta qualidade. A AIGCode já treinou um modelo base de 66B chamado “锡月” (Xiyue) e lançou o produto AutoCoder. Su Wen enfatizou que os produtos de IA competirão, em última análise, pela inteligência do “cérebro”, o pré-treinamento é a força motriz da tecnologia e, mesmo com custos elevados, o desenvolvimento próprio de modelos é crucial para alcançar a AGI e construir a competitividade central do produto. (Fonte: WeChat)

💼 Negócios

Plataforma de agentes inteligentes e equipe de algoritmos de aplicação da JD.com estão contratando: A plataforma de agentes inteligentes, um projeto central do Grupo JD.com, e sua equipe de algoritmos de aplicação estão contratando engenheiros de algoritmos de grandes modelos e estagiários, com local de trabalho em Pequim. As principais direções técnicas incluem LLM Agent, LLM Reasoning e LLM combinado com aprendizagem por reforço. O recrutamento é direcionado a estudantes de mestrado e doutorado que se formarão em 2026 (recrutamento universitário), profissionais experientes equivalentes aos níveis P5-P8 (recrutamento social) e estagiários de pesquisa. A equipe valoriza a orientação tecnológica e a resolução de problemas práticos, com publicações em conferências de IA de ponta. (Fonte: WeChat)

Estratégia “AI-first” enfrenta desafios na Klarna e Duolingo, equilíbrio homem-máquina em foco: A empresa de fintech Klarna e o aplicativo de aprendizado de idiomas Duolingo enfrentam pressão do feedback dos consumidores e da realidade do mercado após implementarem estratégias “AI-first”. A Klarna substituiu centenas de postos de atendimento ao cliente por IA, mas devido à queda na qualidade do serviço, está agora recontratando atendentes humanos. O Duolingo gerou insatisfação dos usuários devido à automatização de funções, com muitos acreditando que o núcleo do aprendizado de idiomas deve ser conduzido por humanos. Esses casos indicam que as empresas, na transformação para IA, precisam equilibrar inovação com cuidado humano; embora a tecnologia seja importante, a confiança do usuário ainda precisa ser construída por pessoas. (Fonte: Reddit r/ArtificialInteligence)

Rumores de que a Databricks adquiriu a startup de banco de dados Neon por US$ 1 bilhão: De acordo com um resumo de notícias de IA circulando na comunidade Reddit, a Databricks adquiriu a startup de banco de dados Neon, com o valor da transação estimado em US$ 1 bilhão. Esta aquisição pode ter como objetivo fortalecer as capacidades da Databricks em gerenciamento de dados e infraestrutura de IA. (Fonte: Reddit r/ArtificialInteligence)

🌟 Comunidade

Lançamento do OpenAI Codex gera debate acalorado, com desenvolvedores entre o entusiasmo e a cautela: Após o lançamento do agente de programação Codex pela OpenAI, a reação da comunidade foi intensa. Muitos desenvolvedores expressaram entusiasmo com a capacidade do Codex de automatizar tarefas como criação de PRs e correção de código, acreditando que isso aumentará significativamente a eficiência da programação, com alguns até chamando de “uma sensação do momento AGI”. Ryan Pream compartilhou sua experiência de criar mais de 50 PRs em um dia usando o Codex. Ao mesmo tempo, alguns usuários apontaram que o Codex ainda precisa de melhorias na divisão de tarefas e adição de casos de teste, sendo atualmente mais adequado para profissionais. Yohei Nakajima compartilhou suas impressões iniciais, considerando seu design centralizado no GitHub razoável, mas com uma curva de aprendizado íngreme. (Fonte: kevinweil, gdb, itsclivetime, dotey, yoheinakajima, cto_junior)

Contribuições da Meta para o código aberto em IA são reconhecidas, gerando discussão sobre modelos fechados vs. abertos: Clement Delangue, CEO da Hugging Face, publicou um post em apoio à Meta, argumentando que suas contribuições para o código aberto de modelos de IA superam em muito as de outras grandes empresas e startups com mais recursos, e não deveriam ser alvo de tantas críticas. Essa visão foi compartilhada por alguns usuários, que acreditam que construir modelos de IA de ponta é extremamente difícil e as ações de abertura da Meta são cruciais para o desenvolvimento da área. No entanto, há também a opinião (gabriberton) de que código aberto significa renunciar a vantagens de conhecimento e que, essencialmente, modelos fechados podem obter melhores resultados. Dorialexander expressou perplexidade com a súbita adoção pelos EUA da “abordagem europeia” (referindo-se à defesa da Meta). (Fonte: ClementDelangue, gabriberton, Dorialexander)

Vazamento do prompt de sistema do Grok da xAI e incidente de fusão de conteúdo impróprio chamam atenção: Foi descoberto que o prompt de sistema do modelo Grok da xAI vazou no GitHub, incluindo até mesmo o prompt de sistema do DeepSearch. Mais grave ainda, usuários apontaram que um PR contendo conteúdo impróprio como “genocídio da raça branca” foi fundido no branch principal após revisão por cinco pessoas e, embora posteriormente revertido e com histórico excluído, o incidente expôs falhas significativas no gerenciamento de processos e segurança operacional da xAI. O caso gerou amplas dúvidas e discussões na comunidade sobre os processos internos e mecanismos de moderação de conteúdo da xAI. (Fonte: karminski3, eliebakouch, colin_fraser, Reddit r/artificial)

AI Agent é considerado tendência futura, mas desafios e expectativas coexistem: A ideia de que “2025 é o ano do Agent” circula na comunidade, gerando discussões sobre o futuro desenvolvimento do AI Agent. Alguns acreditam que o modelo de trabalho futuro será semelhante a jogos como StarCraft ou Age of Empires, onde o usuário comanda um grande número de microagentes para completar tarefas. No entanto, outros usuários apontam que os Agents atuais ainda são imaturos na decomposição de tarefas e na compreensão de instruções complexas, exigindo que os usuários tenham fortes habilidades de planejamento. Alguns duvidam que o AI Agent atinja as expectativas em 2025, acreditando que pode passar de um hype para outro, esperando mudanças substanciais em 2026. (Fonte: gdb, EdwardSun0909, op7418, eliza_luth, tokenbender)

O papel da IA na educação e no emprego gera discussões profundas: A comunidade Reddit discute o impacto do desenvolvimento da IA nos modelos tradicionais de educação e emprego. Um usuário perguntou “Qual o sentido de ir à escola agora?”, argumentando que a IA fará com que ninguém precise trabalhar no futuro. Em resposta, a maioria dos comentários enfatizou a importância do pensamento crítico, da capacidade de aprendizado e das habilidades sociais, considerando-as insubstituíveis pela IA. A escola não é apenas um local de transmissão de conhecimento, mas também um ambiente para aprender como aprender, como pensar e como interagir com as pessoas. Mesmo em um mundo dominado pela IA, essas habilidades permanecem cruciais, e pode ser necessário até mesmo aprender sobre a própria IA. Outra discussão apontou que o valor de uma pessoa não deve ser equiparado apenas ao seu trabalho, e o desenvolvimento da IA deve nos levar a refletir sobre o significado humano além da profissão. (Fonte: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

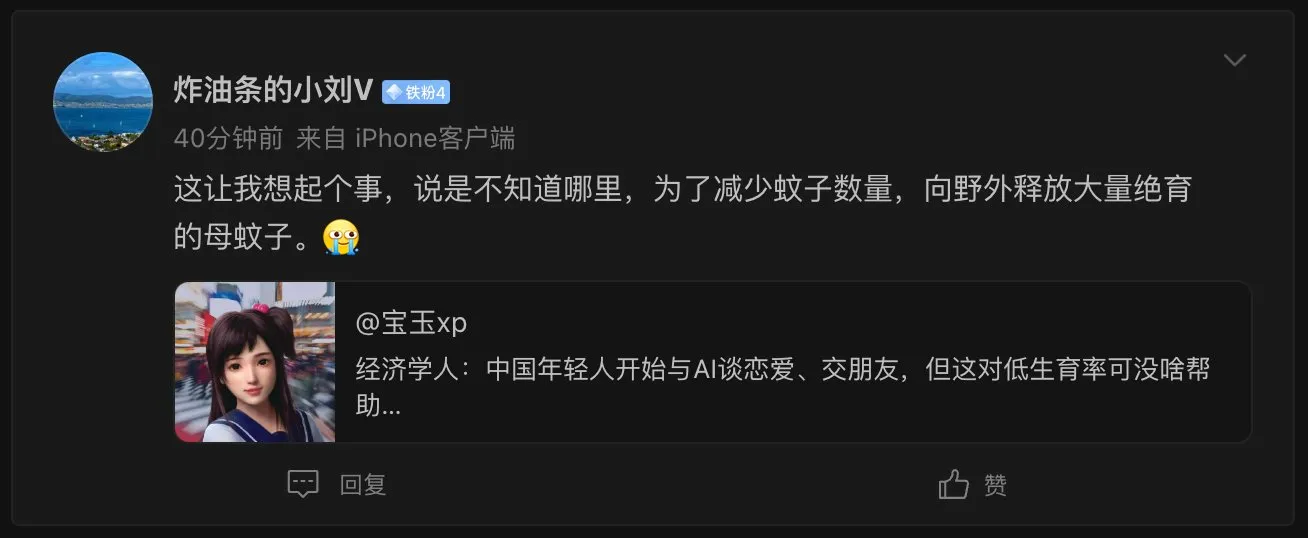

Fenômeno da “namorada IA” levanta questões éticas sociais e demográficas: Uma reportagem da The Economist sobre jovens chineses começando a namorar e fazer amizade com IA gerou debate entre internautas. Alguns comentários compararam esse fenômeno a “liberar um grande número de mosquitos fêmeas estéreis na natureza para reduzir a população de mosquitos”, sugerindo que parceiros de IA podem agravar o problema da baixa taxa de natalidade, embora parceiros de IA possam oferecer uma experiência perfeita de “alguém que sempre te entende”. Isso reflete as complexas implicações sociais e considerações éticas trazidas pela aplicação da tecnologia de IA no campo do companheirismo emocional. (Fonte: dotey)

Realismo da comunicação telefônica com IA preocupa, dificuldade em distinguir o real do falso é novo desafio: Um usuário do Reddit compartilhou ter recebido uma ligação de uma instituição de ensino, onde a voz do interlocutor era natural, o tom e as respostas fluentes, tornando quase impossível distinguir se era uma pessoa real ou IA. Somente após alguns minutos de conversa, percebeu que era IA devido às respostas excessivamente perfeitas. Essa experiência gerou espanto e um certo desconforto entre os usuários sobre a velocidade do desenvolvimento da tecnologia de voz de IA, temendo a dificuldade futura em discernir IA em chamadas telefônicas, especialmente o risco de fraude para grupos como idosos. (Fonte: Reddit r/ArtificialInteligence, Reddit r/artificial)

💡 Outros

MIT exige que arXiv remova um preprint sobre IA e descobertas científicas, gerando controvérsia: O MIT exigiu que o arXiv removesse um preprint escrito por um de seus doutorandos sobre o impacto da IA na inovação em ciência dos materiais, alegando “falta de confiança” na origem, confiabilidade e validade dos dados da pesquisa. O artigo havia indicado que pesquisadores auxiliados por IA aumentaram a descoberta de materiais em 44% e os pedidos de patente em 39%. A ação do MIT gerou debate, com alguns comentários considerando que prejudica a liberdade acadêmica e pode estar relacionada ao fato de as conclusões da pesquisa (IA pode acentuar a vantagem dos pesquisadores de ponta e reduzir a satisfação no trabalho dos pesquisadores comuns) não estarem alinhadas com as expectativas dos financiadores; outros comentários argumentaram que, no campo da IA, o rigor dos resultados da pesquisa é crucial e deve-se ter cautela com o hype impulsionado por preprints. (Fonte: Reddit r/ArtificialInteligence)

Popularização de ferramentas de codificação com IA exige maior modularização de código e práticas de engenharia: E0M destacou no Twitter que a vantagem competitiva das startups está cada vez mais na velocidade e eficiência com que os engenheiros adotam ferramentas de codificação com IA. Boas práticas de modularização de código tornaram-se mais importantes do que nunca; se a complexidade do código estiver dentro da capacidade de processamento dos modernos agentes de codificação, é possível iterar rapidamente. Por outro lado, um “código espaguete” excessivamente complexo pode atrasar o progresso, sendo superado por concorrentes que utilizam IA. (Fonte: E0M, E0M)

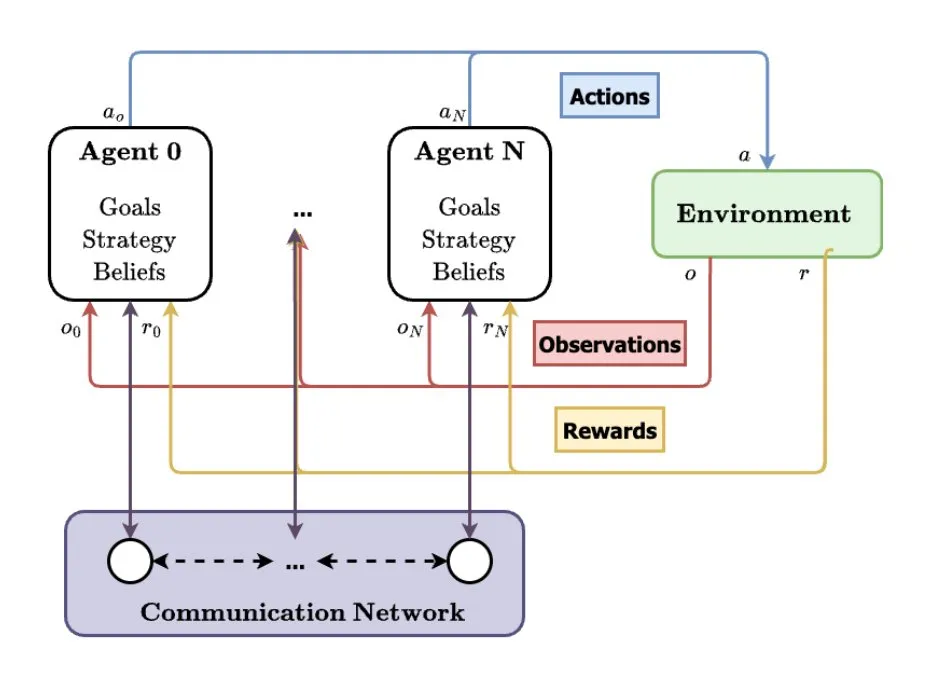

Sistemas Multiagente (MAS) são vistos como direção futura do desenvolvimento da IA: TheTuringPost analisou a tendência de ascensão dos sistemas multiagente (MAS). Desenvolvimentos chave incluem a aprendizagem por reforço multiagente (MARL), robótica de enxame, MAS ciente do contexto (CA-MAS) e MAS impulsionados por grandes modelos de linguagem (LLM). Essas tecnologias permitem que sistemas de IA resolvam problemas complexos através da colaboração e competição, aplicados em áreas como resposta a desastres, monitoramento ambiental e simulação de dinâmicas sociais, prenunciando um futuro de inteligência coletiva. (Fonte: TheTuringPost)