Palavras-chave:OpenAI Codex, Desenvolvimento de software com IA, Modelos multimodais, Geração de voz por IA, Seleção de dados, Versão de pesquisa do Codex, MiniMax Speech-02, Modelo multimodal BLIP3-o, Seleção de dados PreSelect, Série de modelos SWE-1

🔥 Destaques

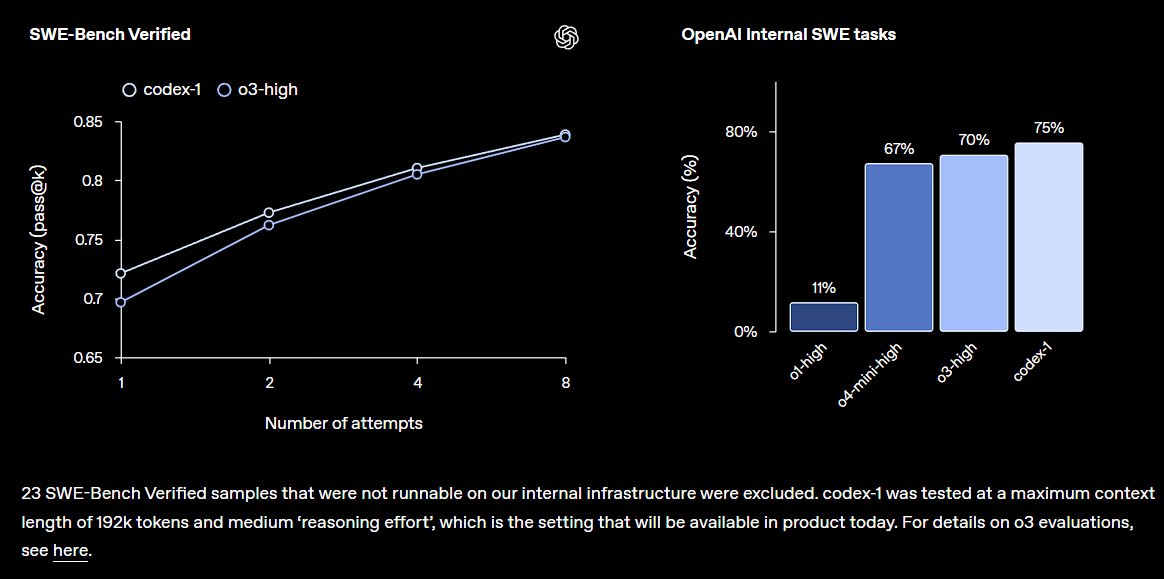

OpenAI lança versão de pesquisa prévia do Codex, integrado ao ChatGPT: A OpenAI apresentou o Codex, um agente de engenharia de software baseado na nuvem, capaz de compreender grandes bases de código, escrever novas funcionalidades, corrigir erros e processar múltiplas tarefas em paralelo. O Codex é baseado no modelo codex-1 ajustado (fine-tuned) com o3 e demonstrou excelente desempenho no SWE-bench. Esta funcionalidade será gradualmente disponibilizada para usuários do ChatGPT Pro, Team e Enterprise, com o objetivo de aumentar significativamente a produtividade dos desenvolvedores, sinalizando que a IA desempenhará um papel ainda mais central no desenvolvimento de software. A comunidade reagiu positivamente, mas também está atenta aos seus efeitos práticos e potenciais bugs (Fonte: OpenAI, OpenAI Developers, scaling01, dotey)

Demissões em massa na Microsoft abalam o setor, acelerando a transformação organizacional impulsionada pela IA: A Microsoft anunciou a demissão de aproximadamente 6.000 funcionários globalmente, com o objetivo de simplificar os níveis de gestão e aumentar a proporção de programadores. Entre os demitidos, encontram-se veteranos com 25 anos de serviço e contribuições notáveis, incluindo desenvolvedores centrais do TypeScript. Acredita-se que estas demissões estejam relacionadas com o aumento da eficiência proporcionado pela tecnologia de IA e a automação de algumas tarefas, refletindo a tendência das gigantes da tecnologia em controlar custos e otimizar a estrutura de pessoal na era da IA. O evento gerou amplas discussões sobre o impacto da IA no mercado de trabalho, a lealdade corporativa e os futuros modelos de trabalho (Fonte: WeChat, NeelNanda5)

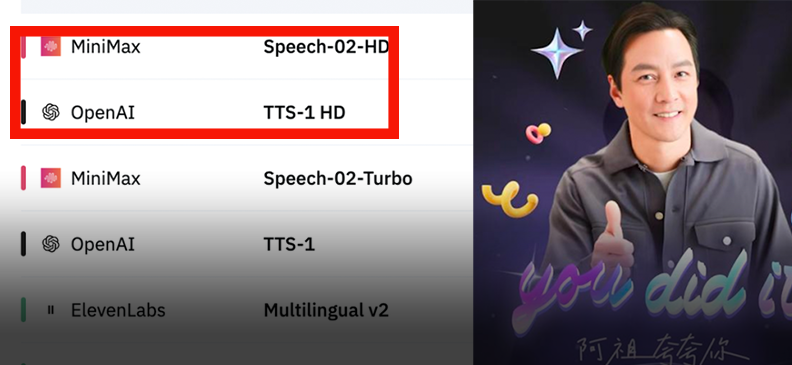

MiniMax lança modelo de voz Speech-02, alcançando o topo dos rankings globais: A MiniMax lançou uma nova geração de modelo de voz, o Speech-02, que alcançou o primeiro lugar nas duas principais avaliações de voz, Artificial Analysis Speech Arena e Hugging Face TTS Arena, superando a OpenAI e a ElevenLabs. O modelo destaca-se pelo seu realismo ultra-humano, personalização de timbre de voz (suportando 32 idiomas e sotaques, replicável com apenas alguns segundos de referência) e diversidade, além de utilizar inovadoramente a tecnologia Flow-VAE para aprimorar os detalhes da clonagem. Sua tecnologia já foi aplicada em cenários como o “AI Azu” aprendendo inglês e o guia de IA da Cidade Proibida, demonstrando a liderança dos modelos de grande escala chineses no campo da geração de voz por IA (Fonte: WeChat, WeChat)

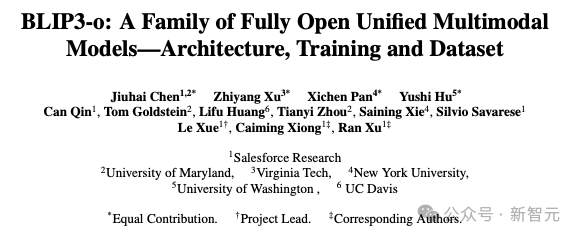

Salesforce e outras instituições lançam modelo multimodal unificado BLIP3-o: A Salesforce Research, em colaboração com várias universidades, lançou o modelo multimodal unificado de código aberto BLIP3-o, que adota uma estratégia de “compreender primeiro, depois gerar”, combinando arquiteturas autorregressivas e de difusão. O modelo utiliza inovadoramente características CLIP e Flow Matching para treinamento, melhorando significativamente a qualidade, diversidade e alinhamento com prompts das imagens geradas. O BLIP3-o demonstrou excelente desempenho em múltiplos benchmarks e está sendo expandido para tarefas multimodais complexas, como edição de imagem e diálogo visual, impulsionando o desenvolvimento da tecnologia de IA multimodal (Fonte: 36氪)

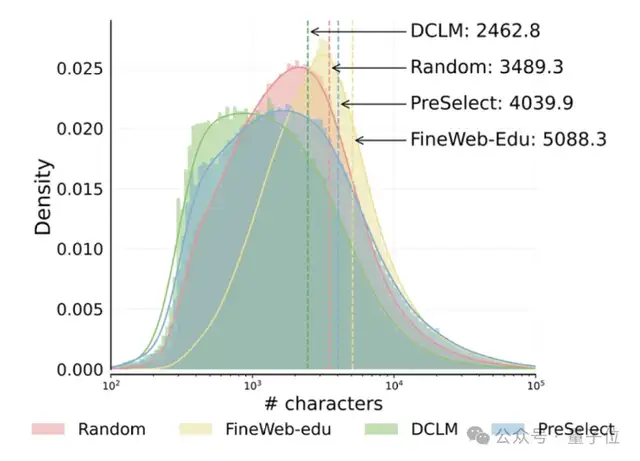

HKUST e vivo propõem solução de seleção de dados PreSelect, aumentando a eficiência do pré-treinamento em 10 vezes: A Universidade de Ciência e Tecnologia de Hong Kong (HKUST) e o vivo AI Lab propuseram um método leve e eficiente de seleção de dados chamado PreSelect, aceito pelo ICML 2025. Este método quantifica a contribuição dos dados para capacidades específicas do modelo através de um indicador de “força de previsão”, utilizando um classificador fastText para selecionar o conjunto completo de dados de treinamento. Ele consegue melhorar o desempenho do modelo em uma média de 3%, enquanto reduz a demanda computacional em 10 vezes. O PreSelect visa selecionar dados de alta qualidade e diversidade de forma mais objetiva e generalizável, superando as limitações dos métodos tradicionais de seleção baseados em regras ou modelos (Fonte: 量子位)

🎯 Tendências

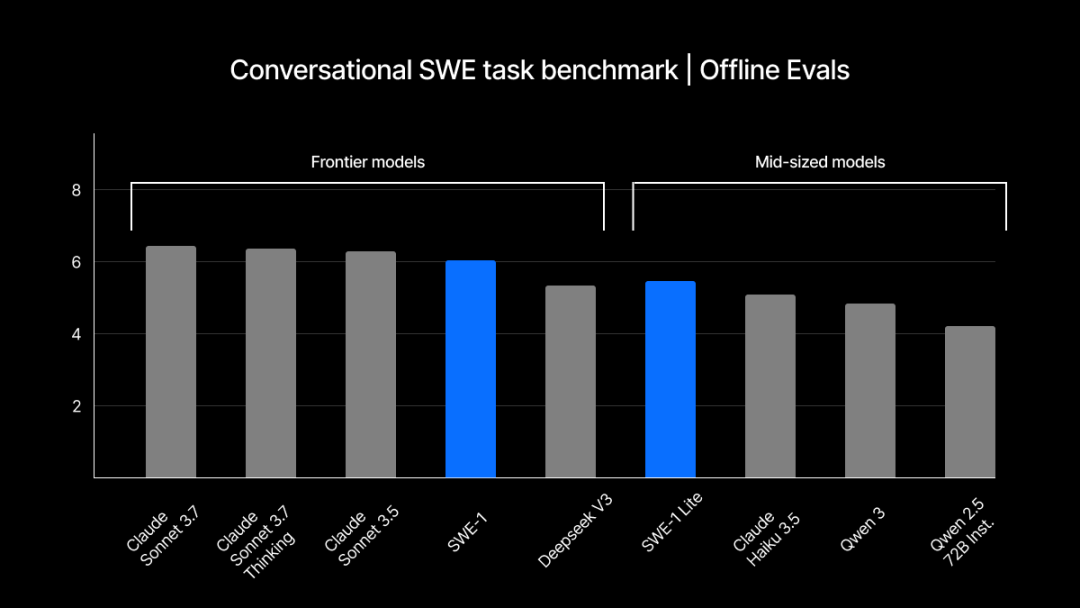

Windsurf lança série de modelos SWE-1 autodesenvolvidos, otimizando processos de engenharia de software: A Windsurf lançou sua primeira série de modelos otimizados para engenharia de software, SWE-1, com o objetivo de aumentar a eficiência do desenvolvimento em 99%. A série inclui SWE-1 (capacidade de chamada de ferramenta próxima ao Claude 3.5 Sonnet, com custo menor), SWE-1-lite (alta qualidade, substituto para Cascade Base) e SWE-1-mini (pequeno e rápido, para cenários de baixa latência). Sua principal inovação é o sistema “Flow Awareness”, onde a IA compartilha a linha do tempo operacional com o usuário, permitindo colaboração eficiente e compreensão de estados incompletos (Fonte: WeChat, WeChat)

Mecanismo de memória do ChatGPT passa por engenharia reversa, revelando três subsistemas de memória: A funcionalidade de memória “histórico de chat” introduzida pela OpenAI para o ChatGPT foi analisada por entusiastas da tecnologia, revelando que pode conter três subsistemas: histórico da conversa atual, histórico de conversas (baseado em resumos e recuperação de conteúdo) e insights do usuário (gerados a partir da análise de múltiplas conversas, com grau de confiança). Esses mecanismos visam fornecer uma experiência de interação mais personalizada e eficiente, utilizando tecnologias como RAG e espaços vetoriais. Embora a OpenAI afirme que melhora a experiência do usuário, o feedback da comunidade é misto, com alguns usuários relatando instabilidade ou bugs na funcionalidade (Fonte: WeChat, 量子位)

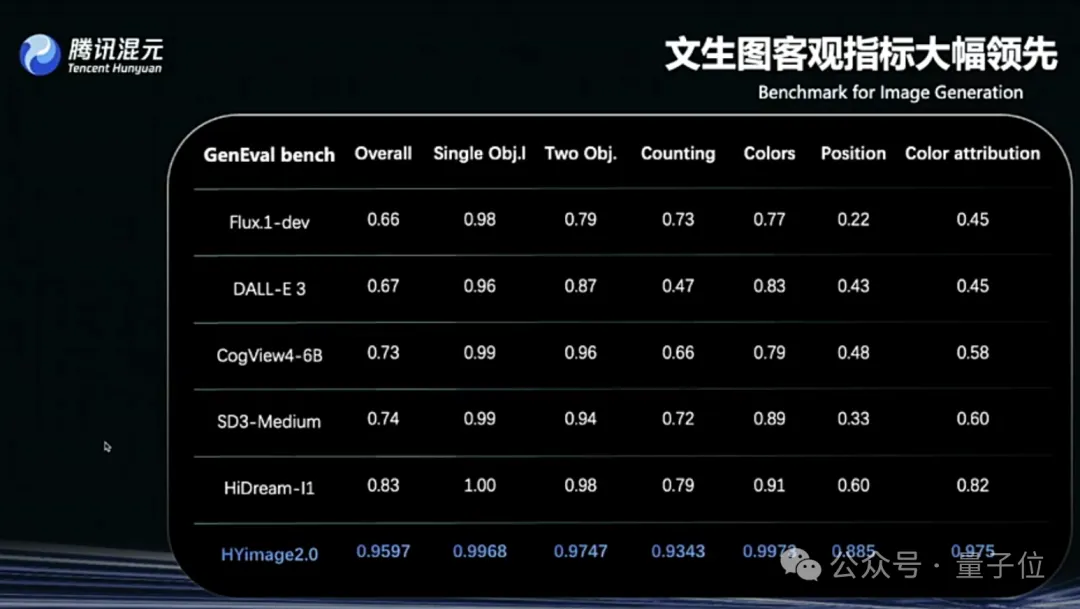

Tencent Hunyuan Image 2.0 é lançado, suportando “desenho em tempo real enquanto fala”: A Tencent Hunyuan lançou o modelo Hunyuan Image 2.0, que alcança a funcionalidade de geração de texto para imagem em tempo real com resposta em milissegundos. Conforme o usuário insere texto ou descrições de voz, a imagem é gerada e ajustada em tempo real. O novo modelo também suporta uma prancheta de desenho em tempo real, onde os usuários podem desenhar esboços à mão combinados com descrições textuais para gerar imagens. O modelo apresenta melhorias significativas em realismo, conformidade semântica (adaptado para usar grandes modelos de linguagem multimodais como codificadores de texto) e taxa de compressão do codec de imagem, além de ser otimizado por meio de pós-treinamento com aprendizado por reforço (Fonte: 量子位)

TII lança série de modelos BitNet Falcon-Edge e biblioteca de fine-tuning onebitllms: O TII lançou o Falcon-Edge, uma série de modelos de linguagem compactos com 1B e 3B parâmetros, com tamanhos de apenas 600MB e 900MB, respectivamente. Esses modelos utilizam a arquitetura BitNet e podem ser restaurados para bfloat16 com perda de desempenho quase insignificante. Resultados preliminares mostram que seu desempenho é superior a outros modelos pequenos e comparável ao Qwen3-1.7B, mas com apenas 1/4 do uso de memória. A biblioteca onebitllms, lançada simultaneamente, é dedicada ao fine-tuning de modelos BitNet (Fonte: Reddit r/LocalLLaMA, winglian)

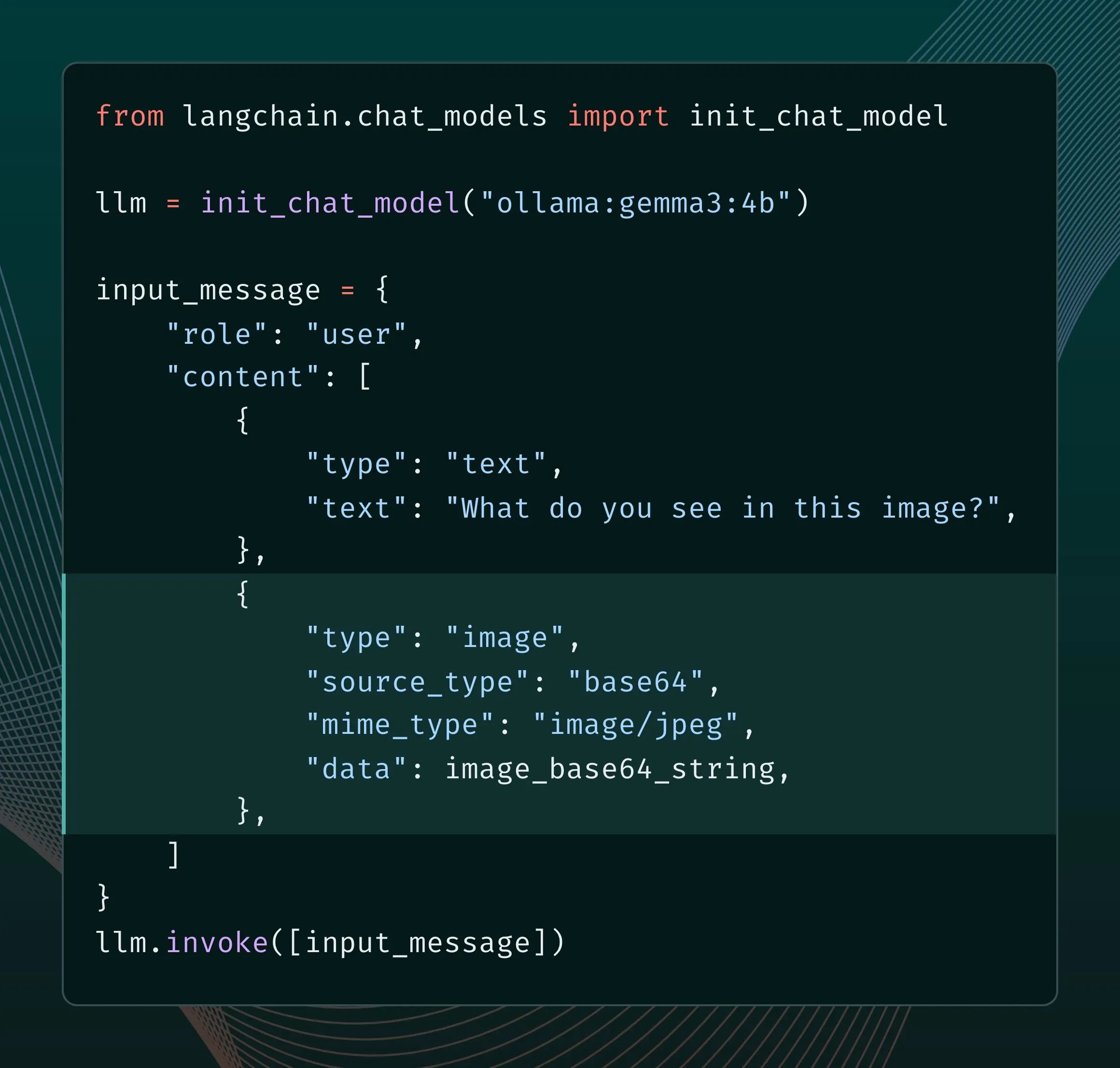

Novo motor do Ollama aprimora suporte multimodal: O Ollama atualizou seu motor para fornecer suporte nativo a modelos multimodais, permitindo otimizações específicas do modelo e melhor gerenciamento de memória. Os usuários podem experimentar modelos multimodais como Llama 4 e Gemma 3 através da integração com LangChain. Desenvolvedores de IA do Google também publicaram um guia sobre o uso do Ollama e Gemma 3 para chamadas de função, a fim de implementar funcionalidades como busca em tempo real (Fonte: LangChainAI, ollama)

Grok adiciona funcionalidade de controle de proporção para geração de imagens: O modelo Grok da xAI agora permite que os usuários especifiquem a proporção desejada ao gerar imagens, oferecendo maior flexibilidade e controle na criação de imagens (Fonte: grok)

Google AI Studio atualizado, adiciona página de mídia generativa e painel de uso: A plataforma ai.studio do Google passou por uma série de atualizações, incluindo um novo design de página inicial, um painel de uso integrado e uma nova página de mídia generativa (gen media), sinalizando que pode haver mais lançamentos relacionados na próxima conferência I/O (Fonte: matvelloso)

LatitudeGames lança novo modelo Harbinger-24B (New Wayfarer): A LatitudeGames lançou um novo modelo chamado Harbinger-24B no Hugging Face, com o codinome New Wayfarer. A comunidade demonstrou interesse e discute por que não foram escolhidos para fine-tuning outros modelos como Qwen3 32B ou Llama 4 Scout (Fonte: Reddit r/LocalLLaMA)

🧰 Ferramentas

Adopt AI recebe financiamento de US$ 6 milhões, visando reconstruir a interação de software com Agentes de IA: A startup Adopt AI obteve US$ 6 milhões em financiamento seed, com o objetivo de permitir que softwares empresariais tradicionais integrem rapidamente capacidades de interação em linguagem natural de forma no-code, através das funcionalidades Agent Builder e Agent Experience. Sua tecnologia pode aprender automaticamente a estrutura de aplicativos e APIs, gerando operações que podem ser invocadas por linguagem natural, e garante a segurança dos dados através de uma arquitetura Pass-through, visando aumentar a taxa de adoção e eficiência de software, e reduzir custos empresariais (Fonte: WeChat)

Volcano Engine da ByteDance lança demo de hardware de IA em miniatura, com alto grau de personalização (DIY): O Volcano Engine lançou uma demo de um hardware de IA em miniatura e tornou seu código cliente/servidor open source. Este hardware suporta um alto grau de personalização, podendo se conectar a grandes modelos da Volcano, agentes Coze, bem como a grandes modelos de terceiros compatíveis com a API da OpenAI (como FastGPT) e várias vozes TTS (incluindo MiniMax). Os usuários podem criar aplicações DIY para conversar com personagens específicos (como um jovem Jay Chou ou He Jiong) ou construir atendimento ao cliente por voz com IA, oferecendo ricas experiências de interação com IA (Fonte: WeChat)

Runway lança API Gen-4 References, capacitando desenvolvedores a construir aplicações de geração de imagem: A Runway disponibilizou seu popular modelo de geração de imagem Gen-4 References para desenvolvedores através de uma API. Este modelo é conhecido por sua versatilidade e flexibilidade, capaz de gerar novas imagens com estilo consistente com base em imagens de referência. O lançamento da API permitirá que os desenvolvedores integrem essa poderosa capacidade de geração de imagem em suas próprias aplicações e fluxos de trabalho (Fonte: c_valenzuelab)

Zencoder lança plataforma de agentes inteligentes de IA para otimização de codificação, Zen Agents: A startup de IA Zencoder (nome oficial For Good AI Inc.) lançou uma plataforma em nuvem chamada Zen Agents, usada para criar agentes de IA otimizados para tarefas de codificação, com o objetivo de aumentar a eficiência e a qualidade do desenvolvimento de software (Fonte: dl_weekly)

llmbasedos: distribuição Linux minimalista baseada em MCP, otimizada para LLMs locais: Um desenvolvedor construiu o llmbasedos, uma distribuição minimalista baseada no Arch Linux, projetada para transformar o ambiente local em um cidadão de primeira classe para front-ends de LLM (como Claude Desktop, VS Code). Ele expõe capacidades locais (arquivos, e-mails, proxies, etc.) através do protocolo MCP (Model Context Protocol), suportando modo offline (com llama.cpp) ou conexão com modelos na nuvem como GPT-4o e Claude, facilitando aos desenvolvedores a adição rápida de novas funcionalidades (Fonte: Reddit r/LocalLLaMA)

Arquivos PDF capazes de executar LLM e sistema Linux chamam atenção: O entusiasta de tecnologia Aiden Bai demonstrou o projeto “llm.pdf”, que executa pequenos modelos de linguagem (como TinyStories, Pythia, TinyLLM) dentro de arquivos PDF, compilando o modelo para JavaScript e utilizando o suporte do PDF para JS. Nos comentários, alguém apontou que já existia um precedente de execução de um sistema Linux em PDF (através de um emulador RISC-V). Isso revela o potencial do PDF como um contêiner de conteúdo dinâmico, mas também levanta discussões sobre segurança e praticidade (Fonte: WeChat)

Ferramenta OpenAI Codex CLI atualizada, suporta login com ChatGPT e novo modelo mini: A equipe de desenvolvedores da OpenAI anunciou melhorias na ferramenta Codex CLI, incluindo suporte para login através de contas ChatGPT para conexão rápida com organizações API, e a adição do modelo codex-mini, otimizado para tarefas de perguntas e respostas e edição de código de baixa latência (Fonte: openai, dotey)

All-in-one de grande modelo da SenseTime recomendado pela IDC, suporta modelos como SenseNova e DeepSeek: No relatório “Análise de Mercado e Recomendação de Marcas de All-in-One de Grande Modelo de IA da China, 2025” publicado pela IDC, o all-in-one de grande modelo da SenseTime foi selecionado. Este dispositivo é baseado na infraestrutura de IA SenseTime Large Model Device, equipado com chips de computação de alto desempenho e motores de aceleração de inferência, suportando o “SenseNova V6” da SenseTime e outros grandes modelos convencionais como o DeepSeek. Ele oferece uma solução completa e autônoma, otimizando o Custo Total de Propriedade (TCO), e já foi implementado em vários setores, como médico e financeiro (Fonte: 量子位)

Ferramenta de automação de fluxo de trabalho open source n8n adiciona suporte a chinês: A popular ferramenta de automação de fluxo de trabalho open source n8n agora suporta interface em chinês através de um pacote de localização contribuído pela comunidade. Os usuários podem baixar o arquivo de localização correspondente à sua versão e, com uma simples modificação na configuração do Docker, usar o n8n em chinês, reduzindo a barreira de entrada para usuários chineses (Fonte: WeChat)

git-bug: Rastreador de bugs distribuído e offline-first embutido no Git: git-bug é uma ferramenta open source que incorpora issues, comentários, etc., como objetos no repositório Git (em vez de arquivos comuns), implementando um rastreamento de bugs distribuído e offline-first. Ele suporta a sincronização de issues com plataformas como GitHub e GitLab através de pontes e oferece interfaces CLI, TUI e Web (Fonte: GitHub Trending)

PyLate integra indexação PLAID, aumentando a eficiência de benchmarking de modelos em grandes conjuntos de dados: Antoine Chaffin anunciou que o PyLate (um ecossistema de treinamento e inferência para modelos ColBERT) fundiu a indexação PLAID. Essa integração permite que os usuários realizem benchmarks eficientes dos melhores modelos em seus conjuntos de dados de grande escala, facilitando a obtenção de SOTA em vários rankings de recuperação (Fonte: lateinteraction, tonywu_71)

Neon: Banco de dados PostgreSQL serverless de código aberto: Neon é uma alternativa serverless de código aberto ao PostgreSQL, que separa armazenamento e computação para permitir escalonamento automático, ramificações de banco de dados como código e escalonamento para zero. O projeto tem recebido atenção no GitHub, oferecendo uma nova opção para desenvolvedores de IA e outras aplicações que necessitam de soluções de banco de dados elásticas e escaláveis (Fonte: GitHub Trending)

Unmute.sh: Nova ferramenta de chat por voz com IA com prompts e vozes personalizáveis: Unmute.sh é uma nova ferramenta de chat por voz com IA que se destaca por permitir que os usuários personalizem prompts e escolham diferentes vozes, oferecendo uma experiência de interação por voz mais personalizada e flexível (Fonte: Reddit r/artificial)

📚 Aprendizado

Primeiro framework global de avaliação de modelos multimodais generalistas, General-Level, e benchmark General-Bench são lançados: Uma pesquisa aceita no ICML‘25 (Spotlight) propôs um novo framework de avaliação para Grandes Modelos Multimodais (MLLM), o General-Level, e o conjunto de dados complementar General-Bench. O framework introduz um sistema de cinco níveis, focando centralmente no “efeito de generalização sinérgica” (Synergy) do modelo, ou seja, a capacidade de transferir e aprimorar conhecimento entre diferentes modalidades ou tarefas. O General-Bench é atualmente o maior e mais abrangente benchmark de avaliação de MLLM, contendo mais de 700 tarefas, mais de 320.000 dados de teste, cobrindo cinco modalidades principais (imagem, vídeo, áudio, 3D e linguagem) e 29 domínios. O ranking mostra que modelos como GPT-4V atualmente atingem apenas o Nível 2 (sem sinergia), e nenhum modelo ainda alcançou o Nível 5 (sinergia completa em todas as modalidades) (Fonte: WeChat)

Artigo J1 propõe incentivar o “pensamento” em LLM-as-a-Judge através de Aprendizado por Reforço: Um novo artigo intitulado “J1: Incentivizing Thinking in LLM-as-a-Judge via RL” (arxiv:2505.10320) explora como utilizar o Aprendizado por Reforço (RL) para incentivar Grandes Modelos de Linguagem atuando como avaliadores (LLM-as-a-Judge) a realizar um “pensamento” mais profundo, em vez de apenas fornecer julgamentos superficiais. Este método pode melhorar a precisão e confiabilidade dos LLMs na avaliação de tarefas complexas (Fonte: jaseweston)

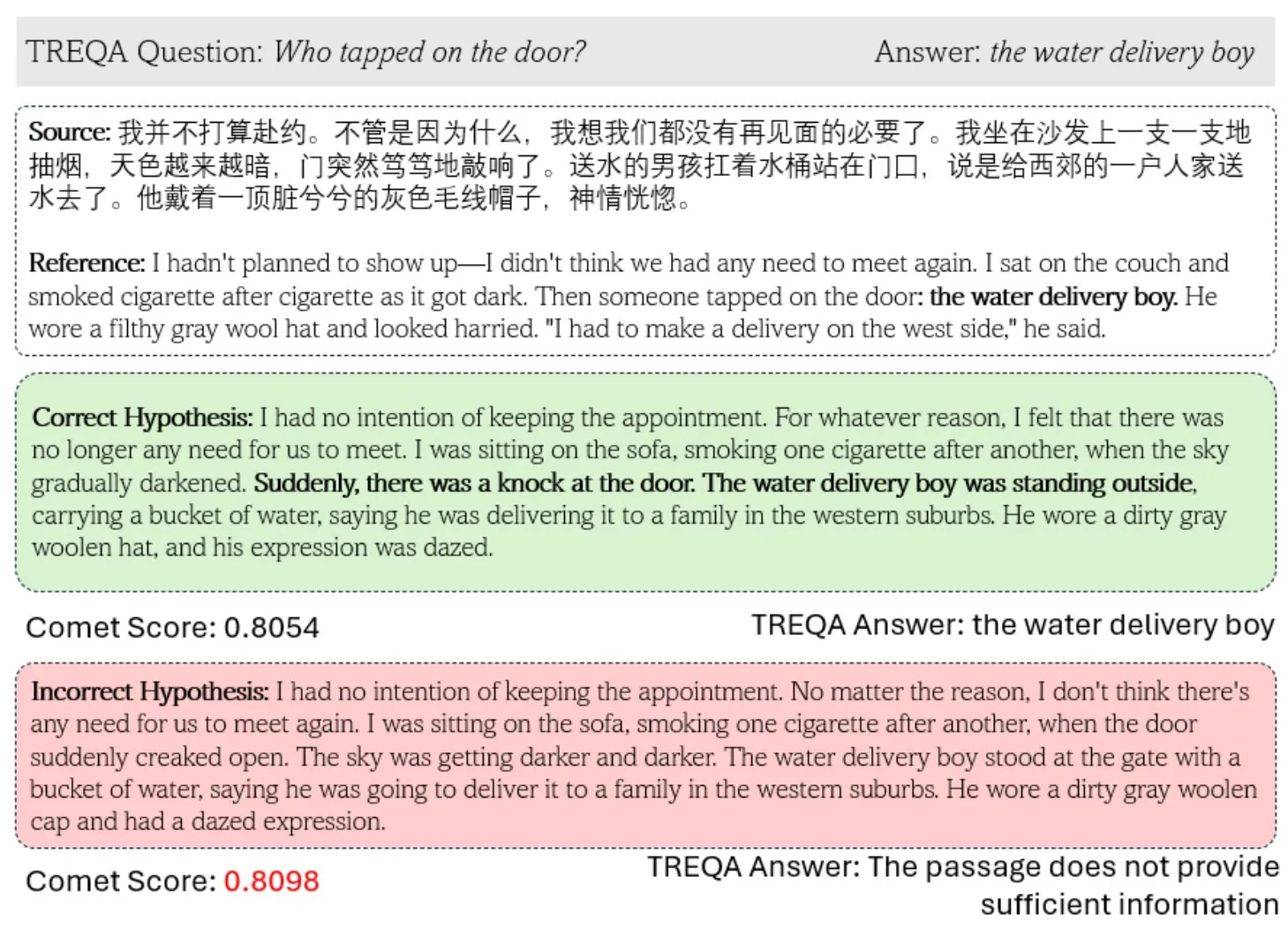

Novo framework TREQA utiliza LLM para avaliar a qualidade de tradução de textos complexos: Diante das deficiências das métricas existentes de tradução automática (MT) na avaliação de textos complexos, pesquisadores propuseram o framework TREQA. Este framework utiliza Grandes Modelos de Linguagem (LLM) para gerar perguntas sobre o texto original e o texto traduzido, e compara as respostas a essas perguntas para avaliar se a tradução preservou informações cruciais. Este método visa medir de forma mais abrangente a qualidade da tradução de textos longos (Fonte: gneubig)

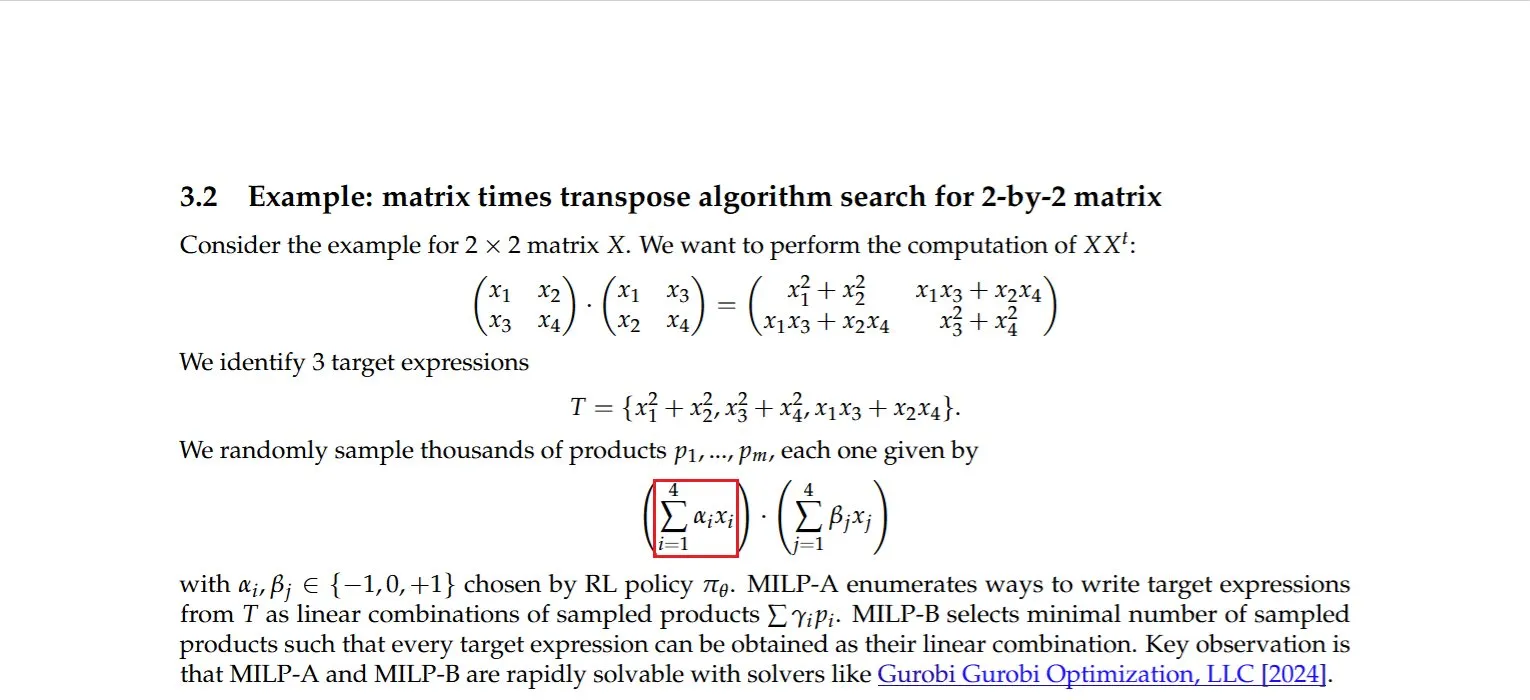

Pesquisa descobre método eficiente para calcular o produto de uma matriz por sua transposta: Dmitry Rybin e colaboradores descobriram um algoritmo mais rápido para calcular o produto de uma matriz por sua transposta (arxiv:2505.09814). Este avanço fundamental tem implicações profundas para múltiplos campos, como análise de dados, design de chips, comunicações sem fio e treinamento de LLMs, pois tais cálculos são operações comuns nessas áreas. Isso demonstra novamente que, mesmo no campo maduro da álgebra linear computacional, ainda há espaço para melhorias (Fonte: teortaxesTex, Ar_Douillard)

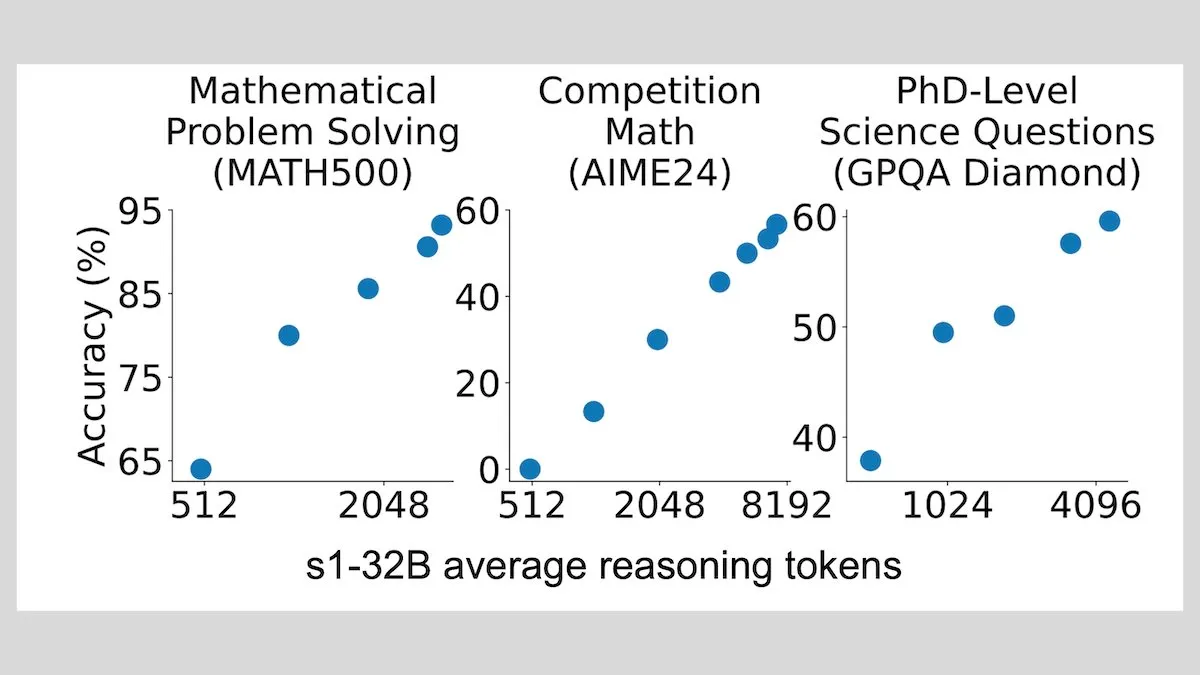

DeepLearningAI: Fine-tuning com poucas amostras pode aumentar significativamente a capacidade de raciocínio de LLMs: Pesquisas mostram que o fine-tuning de grandes modelos de linguagem com apenas 1000 amostras pode melhorar significativamente sua capacidade de raciocínio. Seu modelo experimental s1 estende o processo de raciocínio anexando a palavra “Wait” durante a inferência, alcançando bom desempenho em benchmarks como AIME e MATH 500. Este método de poucos recursos indica que, mesmo sem aprendizado por reforço, é possível ensinar raciocínio avançado com poucos dados (Fonte: DeepLearningAI)

Hugging Face lança curso gratuito de MCP para ajudar a construir aplicações de IA com contexto rico: O Hugging Face, em colaboração com a Anthropic, lançou um curso gratuito chamado “MCP: Build Rich-Context AI Apps with Anthropic”. O curso visa ajudar os desenvolvedores a entender a arquitetura MCP (Model Context Protocol), aprender como construir e implantar servidores MCP e aplicações compatíveis, simplificando assim a integração de aplicações de IA com ferramentas e fontes de dados. Mais de 3000 alunos já se inscreveram (Fonte: DeepLearningAI, huggingface, ClementDelangue)

Projeto awesome-gpt4o-images coleta exemplos brilhantes de geração de imagens com GPT-4o: O projeto GitHub awesome-gpt4o-images, criado por Jamez Bondos, recebeu mais de 5700 estrelas em 33 dias. O projeto coleta e exibe excelentes exemplos de imagens geradas com GPT-4o e seus prompts, atualmente com quase cem exemplos, e planeja continuar atualizando após organização e verificação, fornecendo um recurso criativo valioso para a comunidade AIGC (Fonte: dotey)

Yann LeCun compartilha palestra sobre Aprendizado Auto-Supervisionado (SSL): Yann LeCun compartilhou o conteúdo de sua palestra sobre Aprendizado Auto-Supervisionado (SSL). O SSL, como um importante paradigma de aprendizado de máquina, visa permitir que os modelos aprendam representações eficazes a partir de dados não rotulados, sendo crucial para reduzir a dependência de dados rotulados em grande escala e melhorar a capacidade de generalização dos modelos (Fonte: ylecun)

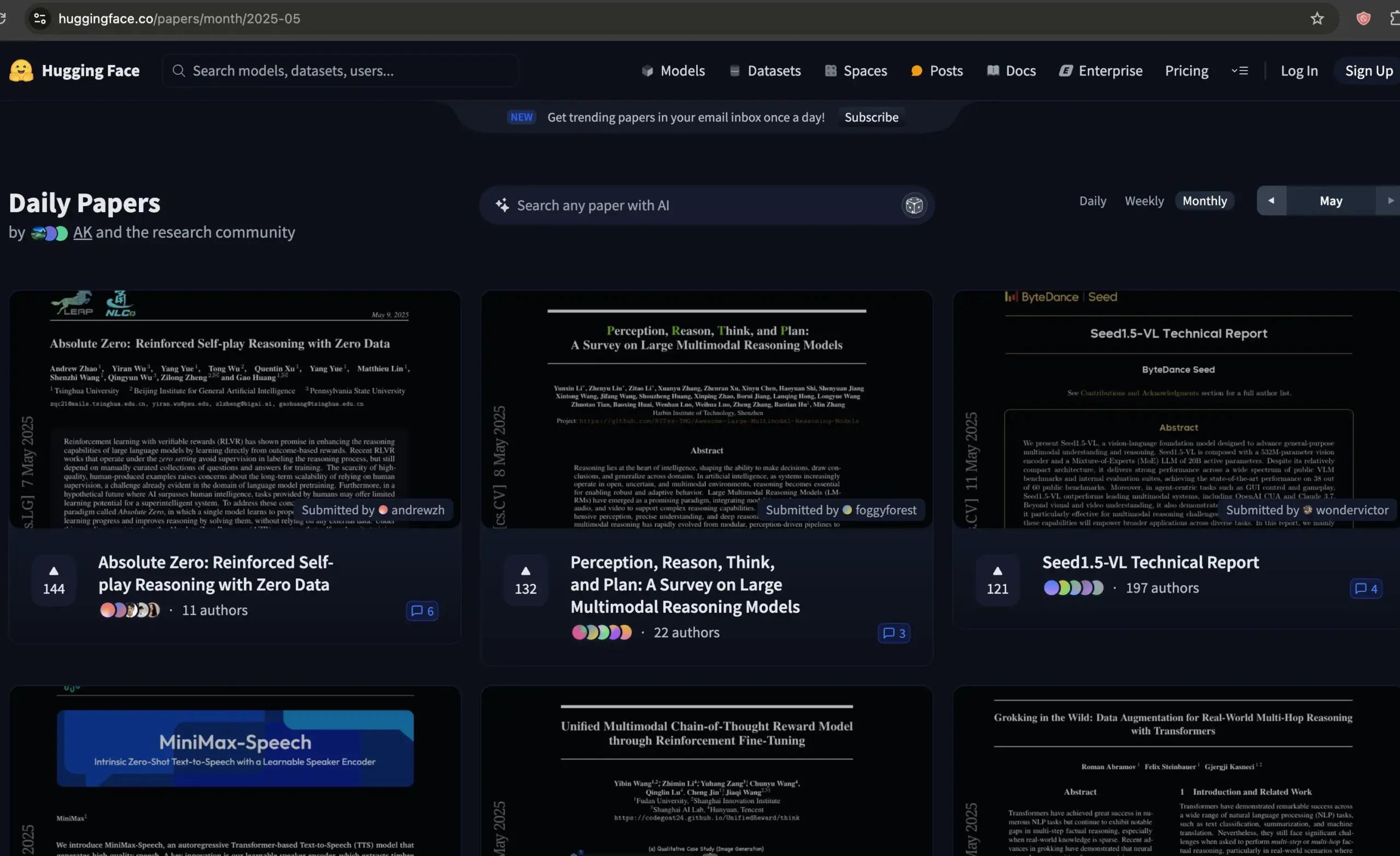

Fórum de artigos do Hugging Face torna-se recurso de qualidade para triagem de artigos de IA: Dwarkesh Patel recomenda o fórum de artigos do Hugging Face, considerando-o um excelente recurso para selecionar os melhores artigos de IA do último mês. A plataforma oferece aos pesquisadores um canal conveniente para descobrir e discutir os mais recentes avanços em pesquisa de IA (Fonte: dwarkesh_sp, huggingface)

Resultados de aceitação do ACL 2025 anunciados, vários artigos da equipe AIB da Alibaba International selecionados: A principal conferência de processamento de linguagem natural, ACL 2025, anunciou os resultados de aceitação. Este ano, o número de submissões atingiu um recorde histórico, tornando a competição acirrada. Vários artigos da equipe de AI Business da Alibaba International foram aceitos, com alguns resultados como Marco-o1 V2, Marco-Bench-IF e HD-NDEs (equações diferenciais neurais para detecção de alucinações) recebendo alta avaliação e sendo incluídos como artigos longos na conferência principal. Isso reflete o investimento contínuo da Alibaba International em IA e os primeiros resultados no desenvolvimento de talentos (Fonte: 量子位)

dstack publica guia de configuração rápida de interconexão para treinamento distribuído: dstack fornece um guia conciso para usuários que realizam treinamento distribuído em clusters NVIDIA ou AMD, apresentando como configurar uma interconexão rápida através do dstack. O guia visa ajudar os usuários a otimizar o desempenho da rede ao escalar cargas de trabalho de IA na nuvem ou localmente (Fonte: algo_diver)

AssemblyAI compartilha vídeo com 10 dicas para melhorar prompts de LLM: A AssemblyAI compartilhou, através de um vídeo no YouTube, 10 dicas para melhorar a eficácia dos prompts de Grandes Modelos de Linguagem (LLM), com o objetivo de ajudar os usuários a interagir de forma mais eficaz com LLMs para obter os resultados desejados (Fonte: AssemblyAI)

Coleção de recursos de aprendizado LangGraph.js “awesome-langgraphjs” ganha destaque: Brace criou e mantém um repositório GitHub chamado “awesome-langgraphjs”, que coleta projetos de código aberto e tutoriais em vídeo do YouTube construídos com LangGraph.js. Este recurso facilita para desenvolvedores que desejam aprender e usar LangGraph.js para construir vários tipos de aplicações, desde sistemas multiagentes até aplicações de chat full-stack (Fonte: LangChainAI)

💼 Negócios

Transformação estratégica de IA da Alibaba mostra resultados, com crescimento significativo na receita de negócios em nuvem e produtos de IA: O relatório financeiro do quarto trimestre de 2025 da Alibaba mostra que, excluindo negócios específicos, a receita geral cresceu 10% ano a ano, a receita de negócios de nuvem inteligente aumentou 18%, e a receita de produtos relacionados à IA manteve um crescimento de três dígitos por 7 trimestres consecutivos. A Alibaba considera a IA uma estratégia central e planeja investir mais de 380 bilhões de yuans nos próximos três anos para atualizar sua infraestrutura de computação em nuvem e IA. Seu modelo de código aberto Tongyi Qianwen Qwen-3 liderou vários rankings globais, com mais de 100.000 modelos derivados, demonstrando sua força técnica e a vitalidade de seu ecossistema de código aberto. A Alibaba está acelerando a implementação da IA em setores como automotivo, comunicações e financeiro (Fonte: 36氪)

Aplicativo de edição de vídeo Mojo é adquirido pela Dailymotion: O aplicativo de edição de vídeo Mojo (@mojo_video_app) foi adquirido pela Dailymotion. A tecnologia de edição de vídeo da Mojo será integrada ao aplicativo social e aos produtos B2B da Dailymotion, com ambas as partes visando construir em conjunto a próxima geração de plataforma de vídeo social da Europa (Fonte: ClementDelangue)

Cohere adquire Ottogrid, fortalecendo capacidades de IA empresarial: A empresa de IA Cohere anunciou a aquisição da startup Ottogrid. Espera-se que esta aquisição fortaleça as capacidades da Cohere em soluções de IA de nível empresarial, mas detalhes específicos da transação e a direção tecnológica da Ottogrid não foram divulgados em detalhes (Fonte: aidangomez, nickfrosst)

🌟 Comunidade

Agentes de IA provocam discussão sobre a transformação do modo de trabalho, futuro pode ser como jogo de estratégia em tempo real: Will Depue propôs que o trabalho futuro pode evoluir para um modelo semelhante a《Starcraft》ou《Age of Empires》, onde humanos comandam cerca de 200 microagentes para processar tarefas, coletar informações, projetar sistemas, etc. Sam Altman retweetou concordando. Fabian Stelzer brincou que isso é “codificação estilo Zerg rush”. Essa visão reflete as ideias e discussões da comunidade sobre como os Agentes de IA irão remodelar os fluxos de trabalho e os modelos de colaboração homem-máquina (Fonte: willdepue, sama, fabianstelzer)

Resposta do robô Grok da xAI gera controvérsia, prompt alegadamente modificado sem autorização: A xAI admitiu que o prompt de seu robô de resposta Grok na plataforma X foi modificado sem autorização na madrugada de 14 de maio, fazendo com que sua análise de certos eventos (como os envolvendo Trump) parecesse anormal ou inconsistente com as informações convencionais. A comunidade está acompanhando o caso de perto, com Clement Delangue e outros pedindo que o Grok se torne open source para aumentar a transparência. Usuários como Colin Fraser, comparando respostas do Grok em momentos diferentes, tentam fazer engenharia reversa do histórico de modificações de seu prompt de sistema (Fonte: ClementDelangue, menhguin, colin_fraser)

Rumores de demissões em massa na equipe Llama4 da Meta levantam preocupações na comunidade sobre o futuro da IA de código aberto: Notícias da comunidade indicam que cerca de 80% dos membros da equipe Llama4 da Meta (11 demissões em uma equipe original de 14 pessoas) pediram demissão, e o lançamento de seu modelo principal Behemoth foi adiado. O assunto gerou ampla atenção, com figuras do setor como Nat Lambert expressando pesar. Scaling01 comentou que a Meta pode precisar de um novo diretor de marketing para o Llama. Usuários como TeortaxesTex expressaram preocupação com o possível impacto negativo no desenvolvimento da IA de código aberto, chegando a discutir se a China se tornaria a última esperança para o código aberto (Fonte: teortaxesTex, Dorialexander, scaling01)

Aplicação de IA na guerra e questões éticas geram preocupação: A comunidade do Reddit discute a aplicação da IA na guerra, apontando que ela já é usada para vigilância e localização de combatentes, fornecendo inteligência militar através da análise de informações. A discussão menciona que o exército dos EUA usa ferramentas de IA como DART desde 1991. Os usuários temem os riscos letais que o armamento com IA pode trazer e a ameaça potencial à humanidade, e acompanham a elaboração de tratados e medidas internacionais relevantes. As diretrizes de uso da OpenAI também removeram a cláusula que proibia o uso militar, gerando mais reflexão (Fonte: Reddit r/ArtificialInteligence)

Grandes modelos de linguagem têm desempenho ruim em competição de programação CCPC, expondo limitações atuais: Na final da décima Competição Chinesa de Programação Universitária (CCPC), vários grandes modelos de linguagem conhecidos, como Seed-Thinking da ByteDance (incluindo o3/o4, Gemini 2.5 pro, DeepSeek R1), tiveram desempenho ruim, a maioria resolvendo apenas o problema de aquecimento ou zerando. A equipe oficial explicou que os modelos tentaram de forma puramente autônoma, sem intervenção humana. A análise da comunidade sugere que isso expõe as deficiências dos atuais grandes modelos na resolução de problemas algorítmicos altamente inovadores e complexos, especialmente no modo não-Agentic (ou seja, sem execução e depuração assistidas por ferramentas). Isso contrasta com o OpenAI o3, que obteve medalha de ouro na Olimpíada Internacional de Informática (IOI) através de treinamento Agentic (Fonte: WeChat)

Framework DSPy e a “lição amarga” geram discussão, enfatizando design规范 e prompts automatizados: Discussões relacionadas ao DSPy enfatizam que, embora o desenvolvimento em escala da IA (Scaling) possa contornar muitos desafios de engenharia (a “lição amarga”), ele não pode substituir o design cuidadoso da especificação central do problema (requisitos e fluxo de informação). No entanto, a escala pode elevar o nível de abstração na definição de problemas. Prompts automatizados (como otimizadores de prompt) são vistos como uma forma de utilizar a capacidade computacional de acordo com a “lição amarga”, enquanto prompts manuais podem ir contra ela, pois injetam intuição humana em vez de permitir que o modelo aprenda (Fonte: lateinteraction, lateinteraction)

Custo computacional de Agentes de IA para autoverificação/exploração de ferramentas durante o raciocínio chama atenção: Paul Calcraft questiona sobre a prática de investir grandes recursos computacionais (como mais de US$ 200 para resolver um único problema) na fase de inferência para que Agentes de IA realizem autoverificação ativa, uso de ferramentas e fluxos de trabalho exploratórios. Ele aponta que empresas como Devin e seus concorrentes podem fazer isso para demonstrações de relações públicas, mas para cenários que buscam soluções inovadoras (semelhante ao FunSearch, mas com menos restrições), isso não é claro (Fonte: paul_cal)

“Programação por Vibe” (Vibe Coding) assistida por IA gera discussão: Ferramentas como o GitHub Copilot tornaram possível a “programação por vibe” (Vibe Coding, que se refere a uma forma de programar que depende mais da intuição e da assistência da IA do que de um planejamento rigoroso), com estudantes de 16 anos usando o Copilot para concluir projetos escolares. As opiniões da comunidade sobre esse fenômeno são divididas: alguns o consideram um novo paradigma de programação, enquanto outros enfatizam a importância dos fundamentos e da规范 (Fonte: Reddit r/ArtificialInteligence, nrehiew_)

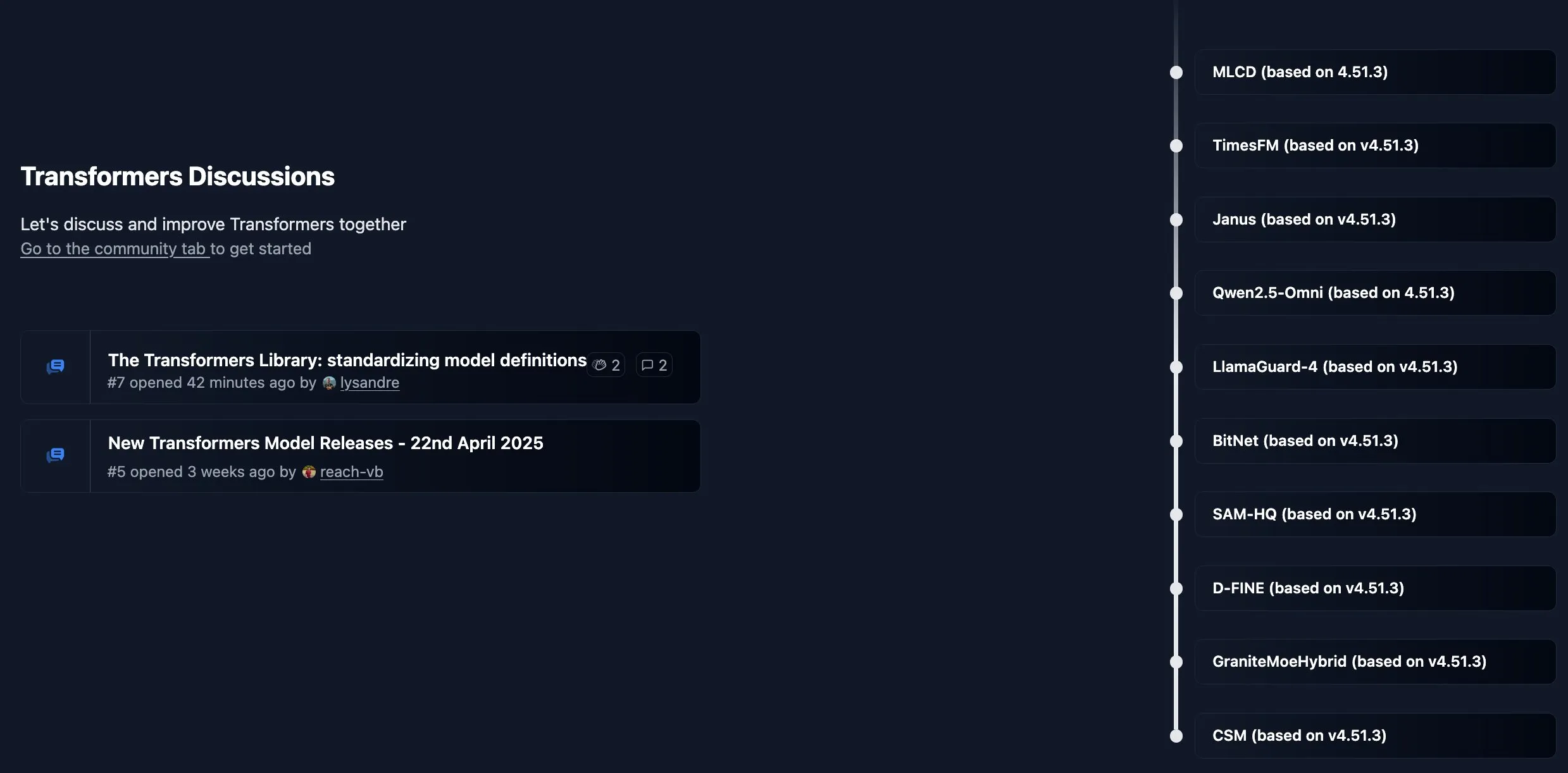

Biblioteca Transformers do Hugging Face ativa novo painel comunitário: O Hugging Face abriu um novo painel comunitário para sua biblioteca principal, Transformers, para publicar anúncios, apresentar novas funcionalidades, atualizar roteiros e convidar usuários a fazer perguntas e discutir sobre o uso da biblioteca ou problemas com modelos, visando fortalecer a interação e o suporte aos desenvolvedores (Fonte: TheZachMueller, ClementDelangue)

Desenvolvedores de IA pedem que conferências de ponta adicionem trilha de artigos “Findings”: Dado o aumento no volume de submissões para conferências de IA de ponta como NeurIPS (por exemplo, NeurIPS atingiu 25.000 submissões), Dan Roy e outros pedem a criação de uma trilha de artigos do tipo “Findings”, seguindo o exemplo de conferências como ACL. Isso visa fornecer uma oportunidade de publicação para pesquisas que, embora não atinjam o padrão da conferência principal, ainda têm valor, aliviando a pressão sobre os revisores e promovendo um intercâmbio acadêmico mais amplo. A proposta inclui revisão simplificada, focada em melhorar a clareza do artigo, etc. (Fonte: AndrewLampinen)

💡 Outros

Exoesqueleto impulsionado por IA ajuda usuários de cadeira de rodas a ficar de pé e andar: Um dispositivo de exoesqueleto impulsionado por IA demonstrou sua capacidade de ajudar usuários de cadeira de rodas a ficarem de pé e andarem novamente. Esse tipo de tecnologia combina robótica, sensores e algoritmos de IA, percebendo a intenção do usuário e fornecendo assistência motorizada, trazendo esperança de reabilitação e melhoria da qualidade de vida para pessoas com mobilidade reduzida (Fonte: Ronald_vanLoon)

Utilizando IA para visualizar ideias criativas de nomes de usuário: Uma pequena tendência surgiu nas comunidades Reddit e X, onde usuários estão utilizando ferramentas de geração de imagem por IA (como o DALL-E 3 integrado ao ChatGPT) para criar imagens conceituais baseadas em seus nomes de usuário de mídia social, e compartilhando essas obras cheias de imaginação, demonstrando a aplicação divertida da IA na expressão criativa personalizada (Fonte: Reddit r/ChatGPT, Reddit r/ChatGPT)

Amazon Ads utiliza IA para aumentar a eficiência do marketing de marcas na internacionalização: A Amazon Ads lançou o conceito “World Screen Lab” para demonstrar como utiliza a tecnologia de IA para capacitar marcas chinesas na sua expansão internacional. Através da matriz de mídia como o Prime Video, expande o alcance da marca; utiliza estúdios criativos de IA (como ferramentas de geração de vídeo) para reduzir a barreira da produção de conteúdo; e otimiza o investimento e conversão de anúncios através de ferramentas como Amazon DSP e Performance+. A IA desempenha um papel em toda a cadeia, desde a geração criativa até a medição de resultados, visando ajudar os proprietários de marcas, especialmente pequenas e médias empresas, a construir marcas globalizadas de forma mais eficiente (Fonte: 36氪)