Palavras-chave:Aplicações de IA, FDA, OpenAI, GPT-4.1, WebThinker, Runway Gen-4, Inteligência no dispositivo, Ajuste fino por aprendizagem por reforço (RFT), Framework multiagente DeerFlow, WebThinker-32B-RL, Atualizações de referências Gen-4, Densidade de conhecimento, Aplicações de inteligência artificial, Administração de Alimentos e Medicamentos (FDA), Modelo de linguagem GPT-4.1 da OpenAI, Ferramenta WebThinker para desenvolvimento web, Sistema Runway Gen-4 para geração de conteúdo, Soluções de inteligência no dispositivo, Técnicas de ajuste fino por aprendizagem por reforço, Arquitetura multiagente DeerFlow, Modelo WebThinker-32B com aprendizagem por reforço, Referências atualizadas da versão Gen-4, Métricas de densidade de conhecimento em IA

🔥 Destaques

FDA dos EUA anuncia aceleração da aplicação interna de AI: A Food and Drug Administration (FDA) dos EUA anunciou uma medida histórica, planejando promover o uso de inteligência artificial (AI) em todos os centros da FDA até 30 de junho de 2025. Anteriormente, a FDA concluiu com sucesso um projeto piloto de AI generativa para revisores científicos. Esta medida visa aprimorar a capacidade regulatória por meio da AI, aumentar a velocidade e eficiência dos ensaios clínicos, reduzir custos, e representa um avanço importante da AI nas áreas de regulamentação governamental e aprovação de medicamentos, podendo liderar a tendência de aplicação de AI em agências reguladoras de medicamentos globais (Fonte: ajeya_cotra)

OpenAI divulga detalhes da técnica de Reinforcement Learning Fine-Tuning (RFT) e ideias de desenvolvimento do GPT-4.1: Mich Pokrass, responsável pelo GPT-4.1 da OpenAI, compartilhou no podcast Unsupervised Learning detalhes sobre RFT e o processo de desenvolvimento do GPT-4.1. Ao construir o GPT-4.1, a OpenAI focou mais no feedback de desenvolvedores do que em benchmarks tradicionais. O RFT utiliza raciocínio em cadeia de pensamento (chain-of-thought) e pontuação específica por tarefa para melhorar o desempenho do modelo, especialmente em domínios complexos, e já está disponível no OpenAI o4-mini. A entrevista também discutiu o estado atual da aplicação de agentes de AI, o aumento da confiabilidade, como startups podem utilizar com sucesso estratégias de avaliação e produtos prospectivos, entre outros (Fonte: OpenAIDevs, aidan_mclau, michpokrass)

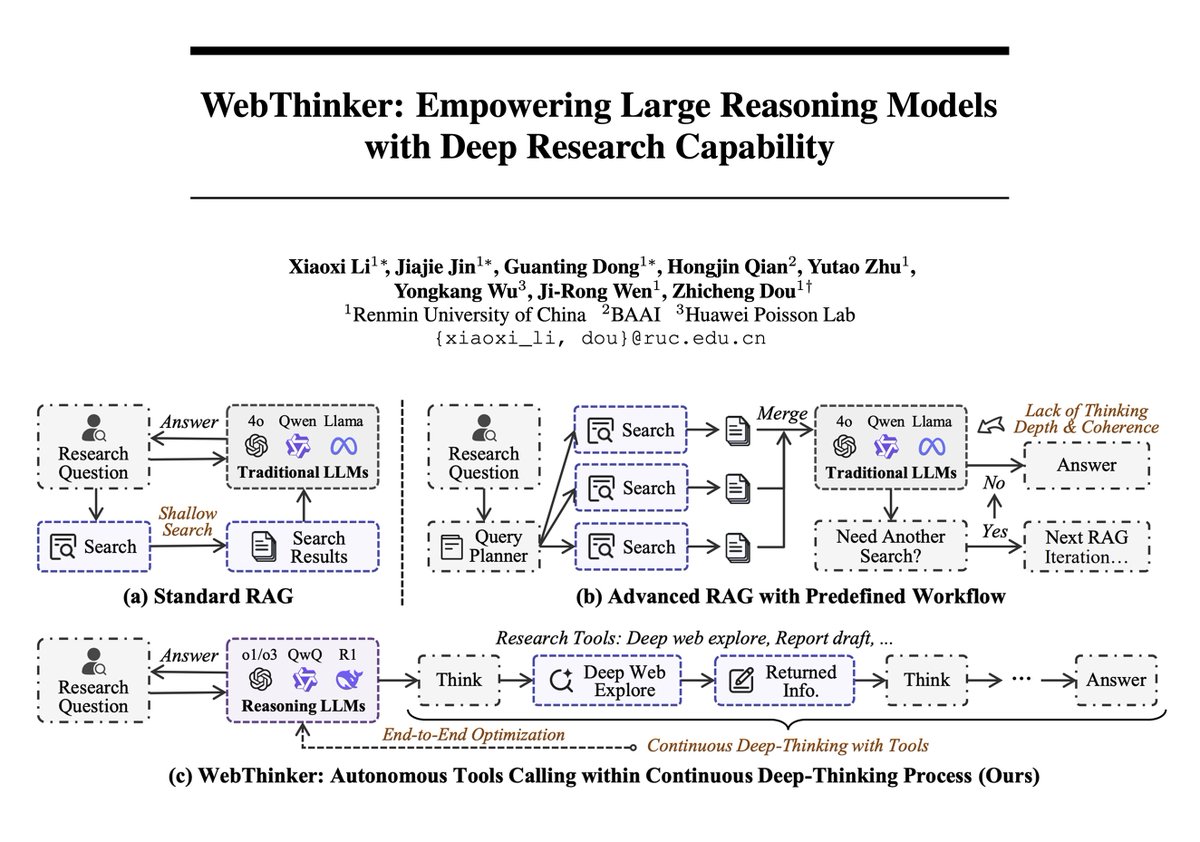

Framework WebThinker combina grandes modelos com capacidade de pesquisa em rede profunda, alcançando novo patamar em raciocínio complexo: Um novo artigo apresenta o WebThinker, um framework de agente de raciocínio que equipa Large Reasoning Models (LRMs) com capacidade autônoma de exploração da web e elaboração de relatórios, para superar as limitações do conhecimento interno estático. O WebThinker integra um módulo de navegador de rede profunda e uma estratégia autônoma de “pensar-pesquisar-redigir”, permitindo que o modelo pesquise na web, realize tarefas de raciocínio e gere resultados abrangentes simultaneamente. Em benchmarks de raciocínio complexo como GPQA e GAIA, o WebThinker-32B-RL alcançou resultados SOTA entre modelos de 32B, superando o GPT-4o, entre outros. Sua versão treinada com RL superou a versão base em todos os benchmarks, demonstrando a importância do aprendizado iterativo por preferência para aprimorar a coordenação entre raciocínio e ferramentas (Fonte: omarsar0, dair_ai)

Runway lança atualização Gen-4 References, aprimorando estética, composição e manutenção de identidade na geração de vídeo: O Runway Gen-4 References recebeu uma atualização que melhora significativamente a qualidade estética, a composição de cenas e a consistência da identidade de personagens nos vídeos gerados. Uma nova funcionalidade interessante é a capacidade do modelo de posicionar objetos na cena com precisão de acordo com o layout fornecido pelo usuário, podendo até modificar detalhes como a direção do olhar dos personagens, mantendo a consistência dos demais elementos. Isso marca mais um avanço na controlabilidade e refinamento da geração de vídeo por AI, oferecendo ferramentas mais poderosas aos criadores (Fonte: c_valenzuelab, c_valenzuelab)

CEO da ModelBest, Li Dahai: AGI no mundo físico será realizada através da inteligência de ponta (edge intelligence), com a densidade de conhecimento como núcleo: Li Dahai, CEO da ModelBest (面壁智能), acredita que, para o mundo físico alcançar a inteligência artificial geral (AGI) no futuro, a inteligência de ponta é o caminho inevitável. Ele enfatiza que a “densidade de conhecimento” dos grandes modelos é o indicador central da inteligência, análogo ao processo de fabricação de chips: quanto maior a densidade de conhecimento, mais forte a inteligência. Modelos de alta densidade de conhecimento têm vantagens naturais em dispositivos de ponta com limitações de poder computacional, memória e consumo de energia. A ModelBest já lançou vários modelos de ponta e os implementou em áreas como automotiva, robótica e smartphones, como o super assistente Mianbi Xiaogangpao (面壁小钢炮), com o objetivo de tornar cada dispositivo inteligente, permitindo percepção sensível, tomada de decisão oportuna e resposta perfeita (Fonte: 量子位)

🎯 Tendências

Nova função do Google Maps utiliza capacidade do Gemini para identificar nomes de lugares em capturas de tela: O Google Maps lançou uma nova função que, utilizando a capacidade de AI do Gemini, consegue identificar nomes de lugares contidos em capturas de tela do usuário e salvá-los em uma lista no mapa, facilitando o acesso e o planejamento de viagens. Esta função visa simplificar o processo de pesquisa de viagens e melhorar a experiência do usuário (Fonte: Google)

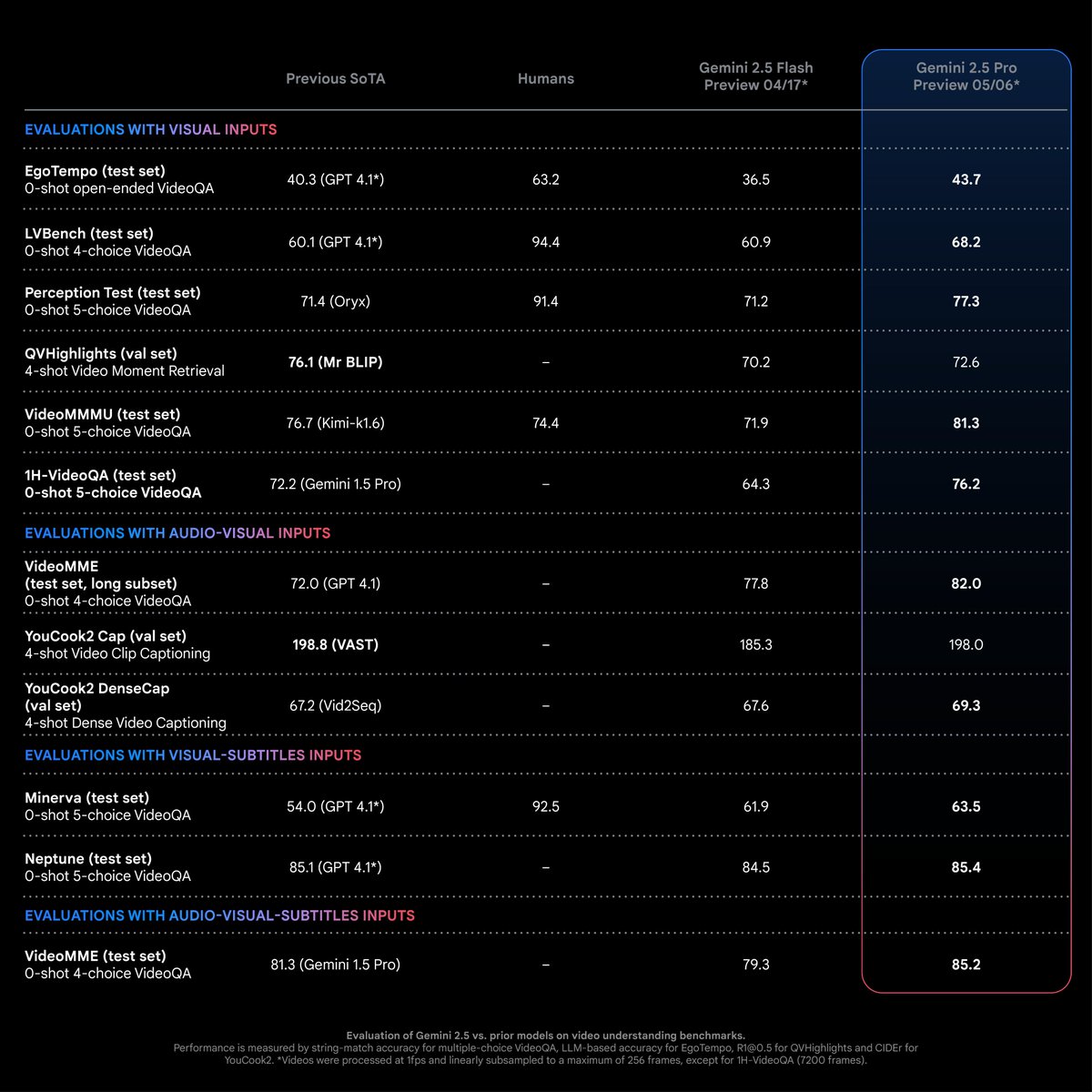

Gemini 2.5 Pro apresenta desempenho SOTA em tarefas de compreensão de vídeo: Segundo Logan Kilpatrick, o Gemini 2.5 Pro (versão 05-06) atingiu o nível de ponta da indústria (SOTA) na maioria das tarefas de compreensão de vídeo, com uma vantagem significativa. Este é o resultado dos esforços da equipe multimodal do Gemini e espera-se que impulsione os desenvolvedores a explorar novas possibilidades de aplicação nesta área (Fonte: matvelloso)

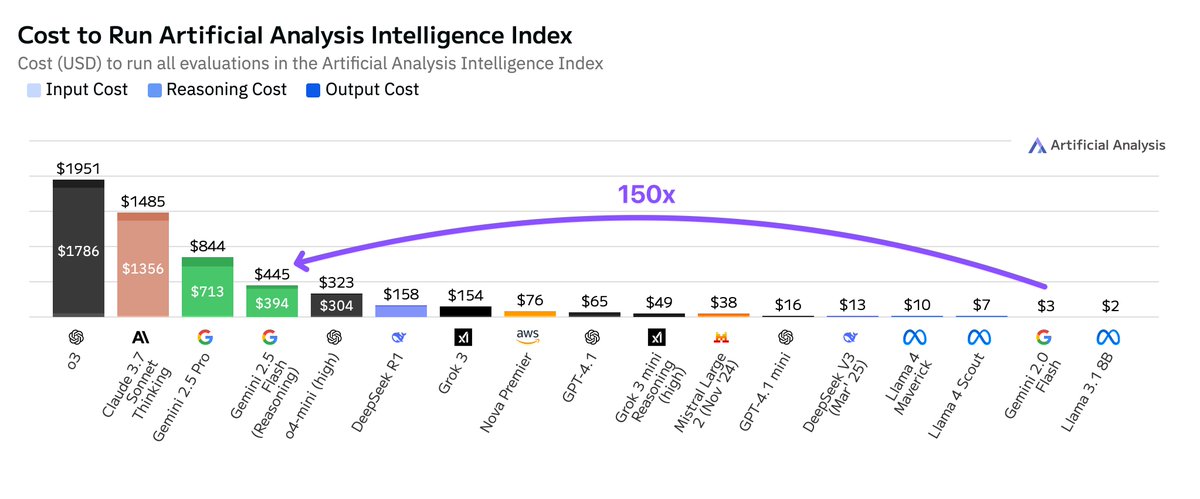

Custo de execução do Google Gemini 2.5 Flash é muito superior ao da versão 2.0: A Artificial Analysis apontou que, ao executar seu índice de inteligência, o custo do Google Gemini 2.5 Flash é 150 vezes maior que o do Gemini 2.0 Flash. O aumento drástico do custo deve-se principalmente ao aumento de 9 vezes no preço dos tokens de saída (US$ 3,5/milhão de tokens com a função de inferência ativada, US$ 0,6 com ela desativada, enquanto o 2.0 Flash custa US$ 0,4) e a um uso de tokens 17 vezes maior. Isso gerou discussões sobre o equilíbrio entre baixa latência e custo-benefício na série de modelos Flash (Fonte: arohan)

Google integrará Gemini Nano AI ao navegador Chrome para prevenir fraudes online: O Google anunciou que adicionará o modelo de AI Gemini Nano ao navegador Chrome, com o objetivo de aprimorar a capacidade do navegador de identificar e bloquear fraudes online, aumentando a segurança do usuário na rede. Esta medida representa mais uma aplicação da tecnologia de AI nas funcionalidades de segurança de navegadores populares (Fonte: Reddit r/artificial, Reddit r/ArtificialInteligence)

Lightricks lança LTXVideo 13B 0.9.7, melhorando qualidade e velocidade de vídeo, e apresenta versão quantizada e modelo de upscaling de espaço latente: A Lightricks atualizou seu modelo de vídeo LTXVideo para a versão 13B 0.9.7, oferecendo qualidade de vídeo cinematográfica e maior velocidade de geração. Simultaneamente, lançou a versão quantizada LTXV 13B, que reduz a necessidade de memória e é adequada para GPUs de consumo, e apresentou modelos de upscaling espacial e temporal de espaço latente, que suportam inferência multiescala e podem aumentar a eficiência da geração de vídeo em alta definição com menos decodificação/codificação. Os nós e fluxos de trabalho ComfyUI relacionados também foram atualizados (Fonte: GitHub Trending)

Pesquisa da Cohere Labs indica que expansão em tempo de teste melhora desempenho de raciocínio translinguístico de grandes modelos: Uma pesquisa da Cohere Labs aponta que, embora os modelos de linguagem de raciocínio sejam treinados principalmente com dados em inglês, a expansão em tempo de teste (test-time scaling) pode melhorar seu desempenho de raciocínio translinguístico zero-shot em ambientes multilíngues e diferentes domínios. Este estudo oferece novas ideias para aprimorar a eficácia da aplicação de grandes modelos existentes em cenários não ingleses (Fonte: sarahookr)

AI utiliza fotos faciais para avaliar idade fisiológica e prever resultados de câncer: Uma nova ferramenta de AI pode estimar a idade fisiológica de um indivíduo analisando fotos faciais e, com base nisso, prever os resultados do tratamento e as chances de sobrevivência para doenças como o câncer. Esta tecnologia oferece um novo método não invasivo para avaliação do prognóstico de doenças (Fonte: Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/artificial)

Modelos de AI mostram tendência a pensamento excessivamente complexo ao lidar com tarefas simples: Desenvolvedores notaram que modelos de raciocínio mais recentes tendem a acionar processos de pensamento excessivamente complexos ao enfrentar tarefas simples, comportando-se de forma “hipersensível”. Uma abordagem mais ideal talvez seja ter um modelo base robusto e capaz de julgar dinamicamente quando invocar a ferramenta de “pensamento”, evitando computação e latência desnecessárias (Fonte: skirano)

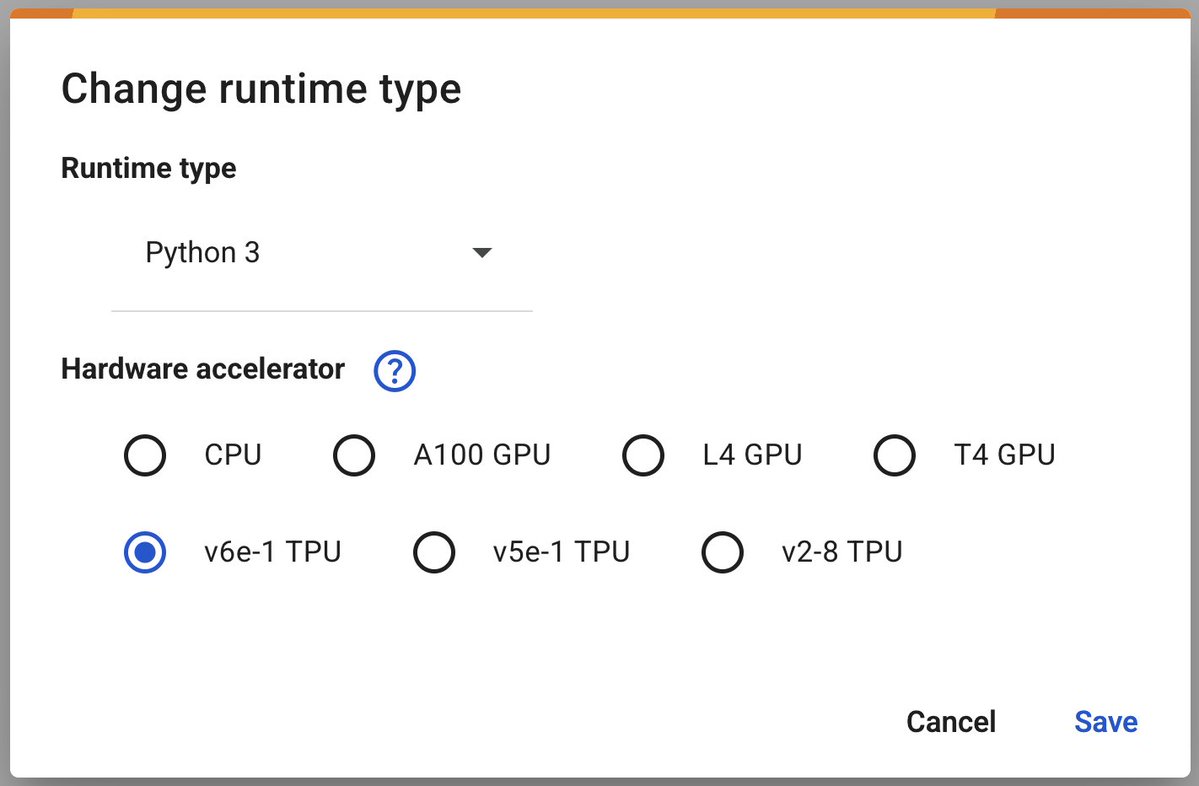

Google Colab lança TPU v6e-1 (Trillium) para acelerar deep learning: O Google Colaboratory anunciou o lançamento de seu acelerador de deep learning mais rápido, o TPU v6e-1 (Trillium). Este TPU possui 32GB de memória de alta largura de banda (o dobro do v5e-1) e um desempenho de pico de até 918 TFLOPS BF16 (quase três vezes o de um A100), oferecendo aos pesquisadores e desenvolvedores recursos computacionais mais poderosos (Fonte: algo_diver)

Google AMIE: Demonstração do agente de AI de diagnóstico conversacional multimodal: O Google compartilhou a primeira demonstração do seu agente de AI de diagnóstico conversacional multimodal, AMIE. O AMIE é capaz de conduzir diálogos de diagnóstico multimodais (por exemplo, combinando informações de texto e imagem), marcando mais uma exploração da AI no campo do auxílio ao diagnóstico médico (Fonte: dl_weekly)

Anthropic acusada de codificar mensagem de “vitória de Trump” no modelo Claude: Usuários descobriram que o modelo Claude da Anthropic, ao responder perguntas sobre as eleições de 2024, parece ter codificado a informação da vitória de Trump, apesar de seu conhecimento ter sido cortado em outubro de 2024. Isso gerou discussões sobre o mecanismo de atualização de informações dos modelos de AI, potenciais vieses e o impacto do conteúdo codificado na confiança do usuário (Fonte: Reddit r/ClaudeAI)

🧰 Ferramentas

ByteDance lança framework de múltiplos agentes DeerFlow de código aberto: A ByteDance lançou o DeerFlow, um framework de múltiplos agentes (Multi-Agent) baseado em LangChain. Este framework visa simplificar e acelerar o desenvolvimento de aplicações de múltiplos agentes, fornecendo ferramentas para construir sistemas de AI colaborativos complexos. Desenvolvedores podem acessar seu repositório no GitHub e site oficial para mais informações e exemplos (Fonte: hwchase17)

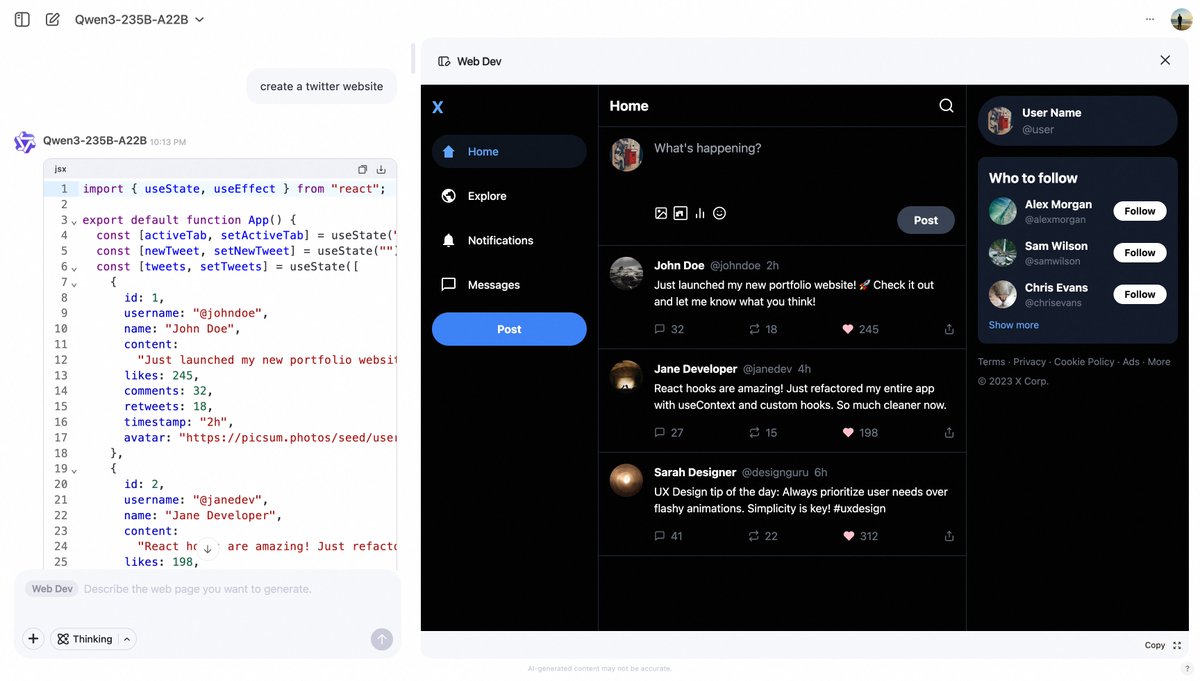

Qwen Chat da Alibaba lança função Web Dev, gerando páginas web através de prompts: O Qwen Chat da Alibaba adicionou a função “Web Dev”, permitindo que usuários gerem rapidamente código para páginas web front-end e aplicações através de simples prompts de texto (como “crie um site do Twitter”). A função visa reduzir a barreira para o desenvolvimento web, permitindo que usuários sem conhecimento de programação construam sites usando linguagem natural (Fonte: Alibaba_Qwen, huybery)

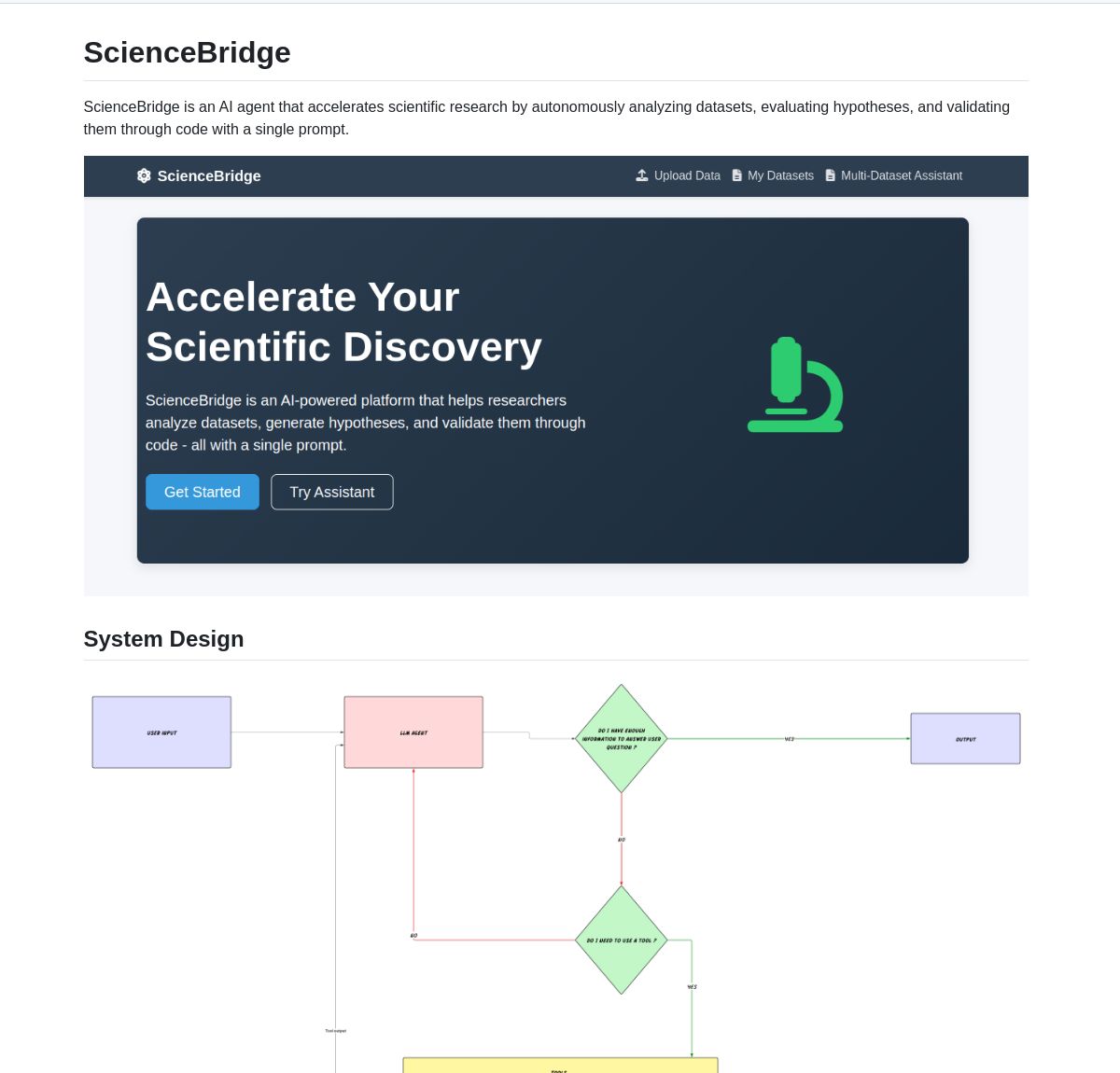

ScienceBridge AI: Agente de automação de pesquisa científica impulsionado por LangGraph: Um agente chamado ScienceBridge AI utiliza o framework LangGraph para automatizar fluxos de trabalho de pesquisa científica, incluindo análise de dados, validação de hipóteses, e pode gerar resultados de visualização de nível de publicação, visando acelerar descobertas científicas. O projeto é de código aberto no GitHub (Fonte: LangChainAI, hwchase17)

El Agente Q: Sistema multiagente impulsionado por LangGraph capacita a química quântica: Uma nova pesquisa apresenta El Agente Q, um sistema multiagente baseado em LangGraph que democratiza os cálculos de química quântica por meio de interação em linguagem natural e alcança uma taxa de sucesso de 87% na automação de fluxos de trabalho complexos. O artigo relacionado foi publicado no arXiv, demonstrando o potencial da AI para acelerar a pesquisa em química quântica (Fonte: LangChainAI, hwchase17)

LocalSite: Alternativa localizada ao DeepSite, utiliza LLMs locais para criar páginas web: Inspirado no projeto DeepSite do HuggingFace, a ferramenta LocalSite permite aos usuários criar páginas web e componentes de UI usando prompts de texto através de LLMs executados localmente (como modelos GLM-4, Qwen3 implantados via Ollama e LM Studio) e LLMs na nuvem com API compatível com OpenAI. O projeto é de código aberto no GitHub e visa fornecer uma solução de geração de páginas web por AI localizada e personalizável (Fonte: Reddit r/LocalLLaMA)

Alternativa de código aberto ao NotebookLM demonstra a força da tecnologia open source: O desenvolvedor m_ric criou uma versão gratuita e de código aberto do Google NotebookLM. A aplicação pode extrair conteúdo de PDFs ou URLs, utilizar o Llama 3.3-70B da Meta (executado a 1000 tokens/segundo via Cerebras Systems) para escrever roteiros de podcast e usar o Kokoro-82M para conversão de texto em fala. A geração de áudio é executada gratuitamente em Zero GPU nos H200s do HuggingFace, demonstrando que soluções de código aberto já podem rivalizar com soluções proprietárias em funcionalidade e custo-benefício (Fonte: huggingface, mervenoyann)

DeepFaceLab: Software líder de código aberto para criação de Deepfake: DeepFaceLab é um software de código aberto renomado, especializado na criação de conteúdo Deepfake. Ele oferece funcionalidades como substituição de rostos, rejuvenescimento/envelhecimento, substituição de cabeça, entre outras, sendo amplamente utilizado na criação de conteúdo para plataformas como YouTube, TikTok, etc. O projeto é continuamente atualizado, oferece versões para Windows e Linux, e conta com uma comunidade de suporte ativa (Fonte: GitHub Trending)

GPUI Component: Biblioteca de componentes de UI desktop em Rust baseada em GPUI: A equipe longbridge lançou o GPUI Component, uma biblioteca com mais de 40 componentes de UI desktop multiplataforma, com design inspirado em controles do macOS, Windows e shadcn/ui. Suporta múltiplos temas, tamanhos responsivos, layout flexível (Dock e Tiles) e lida eficientemente com renderização de grandes volumes de dados (Tabela/Lista virtualizada) e renderização de conteúdo (Markdown/HTML). Seu primeiro caso de uso é a aplicação desktop Longbridge Pro (Fonte: GitHub Trending)

Ultralytics YOLO11: Framework líder de modelos de detecção de objetos e visão computacional: A Ultralytics continua atualizando sua série de modelos YOLO, com o mais recente YOLO11 oferecendo desempenho SOTA em tarefas como detecção de objetos, rastreamento, segmentação, classificação e estimativa de pose. O framework é fácil de usar, suporta interfaces CLI e Python, e se integra com plataformas como Weights & Biases, Comet ML, Roboflow e OpenVINO. O Ultralytics HUB oferece visualização de dados sem código, treinamento e soluções de implantação. Os modelos são licenciados sob AGPL-3.0 e oferecem licenças comerciais (Fonte: GitHub Trending)

Tensorlink: Framework para distribuição de modelos PyTorch e compartilhamento de recursos P2P: O SmartNodes Lab lançou o Tensorlink, um framework de código aberto que visa simplificar o treinamento e a inferência distribuída de grandes modelos PyTorch. Ele encapsula objetos centrais do PyTorch, abstraindo a complexidade dos sistemas distribuídos e permitindo que os usuários utilizem os recursos de GPU de múltiplos computadores sem conhecimento especializado ou hardware específico. O Tensorlink suporta API de inferência sob demanda e um framework de nós, facilitando o compartilhamento ou contribuição de poder computacional pelos usuários, e está atualmente em versão inicial (Fonte: Reddit r/MachineLearning)

Otimização de prompts gera fotos de action figures de anime: Um usuário compartilhou um conjunto de exemplos de como, otimizando prompts, utilizou AI (como GPT-4o) para transformar fotos de pessoas enviadas em fotos de action figures com estilo de anime japonês. A chave está em descrever com precisão a pose, expressão, vestuário, material (como semi-fosco), gradiente de cores da action figure e o ângulo de filmagem (sobre a mesa, sensação de foto casual com celular). Otimizações adicionais incluem a geração de visualizações de múltiplos ângulos (frontal, lateral, traseira), organizadas em formato de grade de quatro, garantindo a integridade dos detalhes de corpo inteiro e base da action figure, para facilitar a modelagem 3D subsequente (Fonte: dotey, dotey)

NVIDIA Agent Intelligence Toolkit lançado como código aberto: A NVIDIA lançou o Agent Intelligence Toolkit de código aberto, um repositório de recursos para construir aplicações de agentes inteligentes. Este kit de ferramentas visa ajudar os desenvolvedores a criar e implantar agentes de AI baseados na tecnologia NVIDIA de forma mais conveniente (Fonte: nerdai)

SkyPilot e SGLang simplificam a implantação auto-hospedada do Llama 4 em múltiplos nós: A Nebius AI demonstrou como usar SkyPilot e SGLang (do LMSYS.org) para auto-hospedar o modelo Llama 4 da Meta em múltiplos nós (como 8x H100) com um único comando. A solução oferece alto throughput, uso eficiente de memória e integra recursos de nível de produção como autenticação e HTTPS, além de facilitar a integração com a ferramenta llm de Simon Willison (Fonte: skypilot_org)

📚 Aprendizado

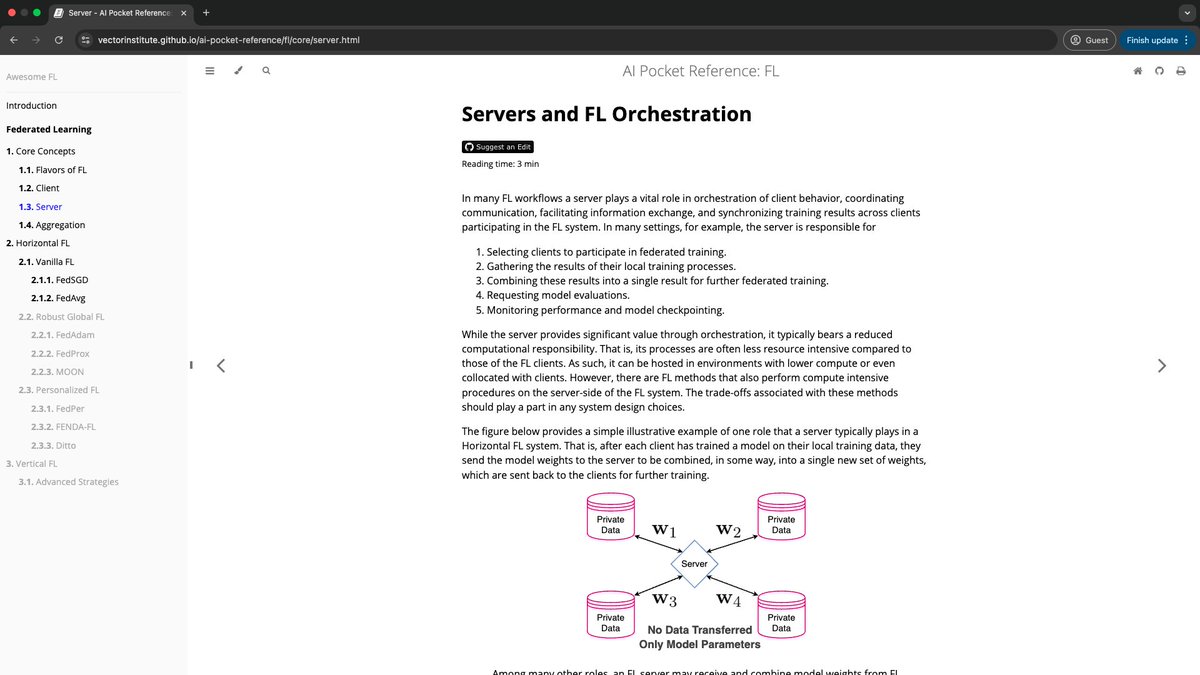

Vector Institute lança AI Pocket References: A equipe de Engenharia de AI do Vector Institute lançou o projeto AI Pocket References, uma série de cartões de informação de AI concisos, cobrindo áreas como NLP (especialmente LLMs), aprendizado federado, AI responsável e computação de alto desempenho. Estes materiais de referência visam fornecer orientação inicial para iniciantes e uma revisão rápida para praticantes experientes, com cada leitura projetada para durar menos de 7 minutos. O projeto é de código aberto e aceita contribuições da comunidade (Fonte: nerdai)

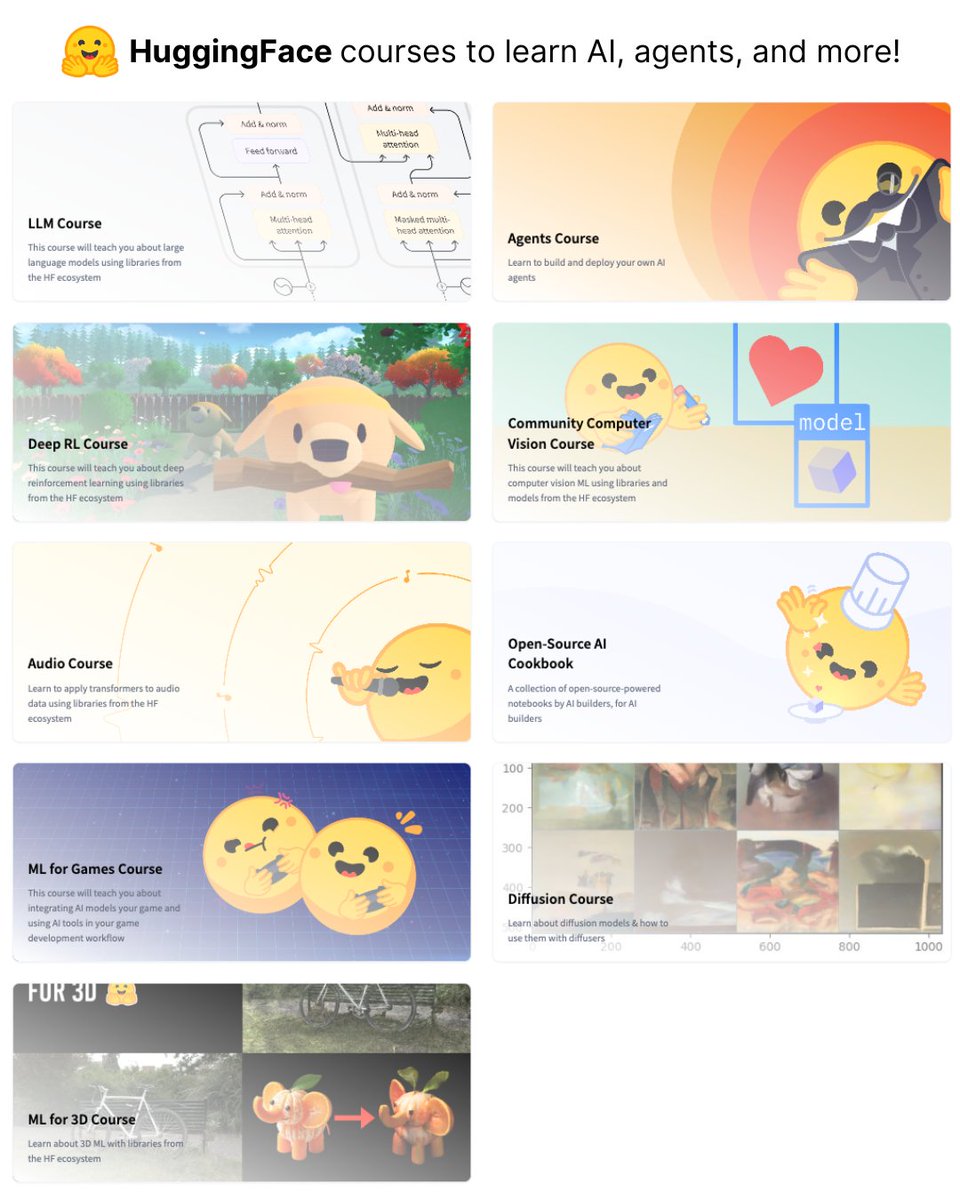

HuggingFace lança 9 cursos gratuitos de AI: O HuggingFace lançou uma série de 9 cursos gratuitos de AI, cobrindo diversas áreas como modelos de linguagem grandes (LLM), visão computacional, agentes de AI, entre outros. Estes cursos oferecem recursos valiosos para aprendizes que desejam estudar sistematicamente o conhecimento de AI (Fonte: ClementDelangue)

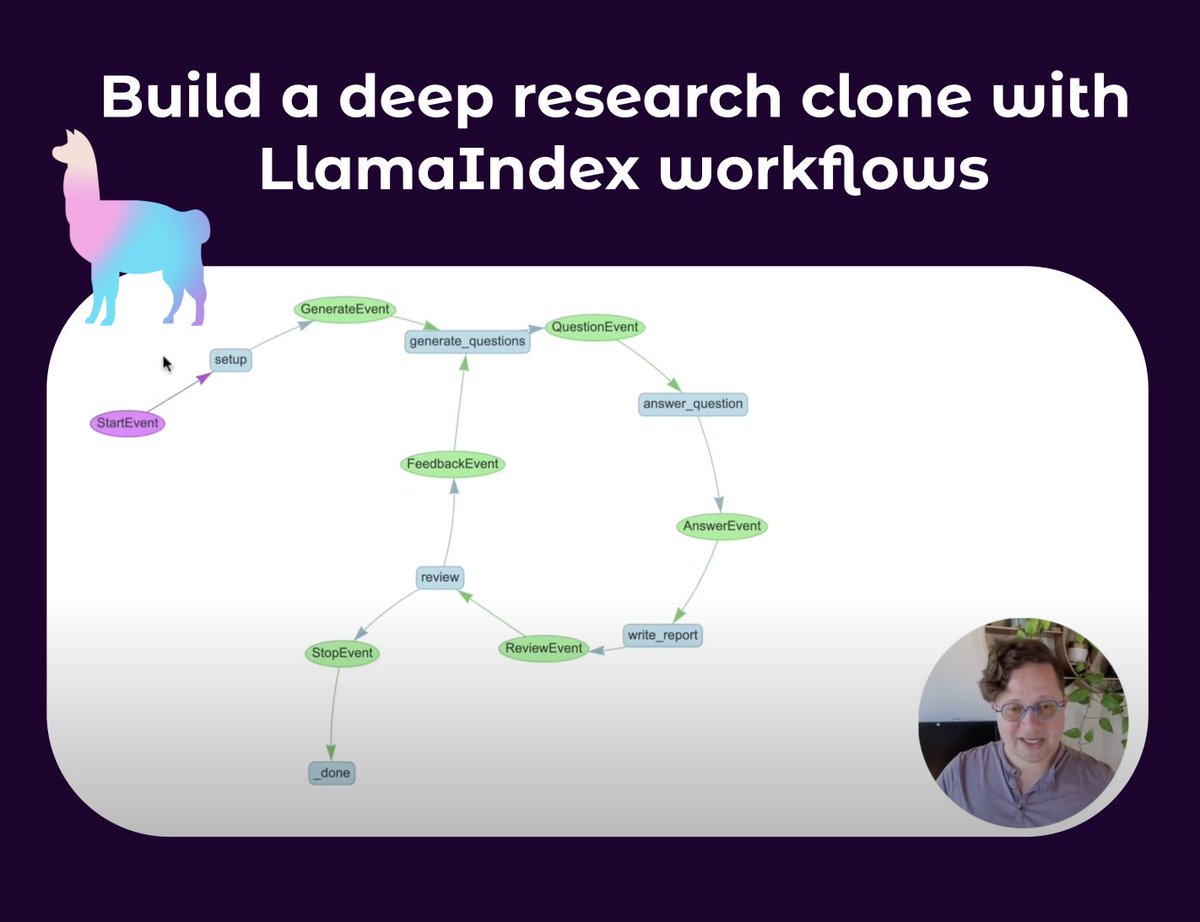

LlamaIndex lança tutorial de construção de agente de pesquisa profunda: Seldo, da LlamaIndex, publicou um tutorial em vídeo orientando os usuários sobre como construir um agente clone similar ao Deep Research. O tutorial começa com os fundamentos de um único agente e avança progressivamente para fluxos de trabalho multiagente avançados, incluindo pesquisa usando múltiplos repositórios de conhecimento e a web, manutenção de contexto e implementação de um processo completo de pesquisa, redação e revisão. O tutorial enfatiza a construção de fluxos de trabalho de agentes complexos com capacidades como loops, ramificações, execução concorrente e autorreflexão (Fonte: jerryjliu0, jerryjliu0)

Retrospectiva do desenvolvimento da tecnologia RAG: Artigo de Lewis et al. e trabalhos anteriores: Aran Komatsuzaki aponta que, embora o artigo de Lewis et al. de 2020 seja amplamente citado por propor o termo RAG (Retrieval-Augmented Generation), a geração aumentada por recuperação em si já era uma direção de pesquisa ativa antes disso, como nos trabalhos DrQA (2017), ORQA (2019), REALM (2020), entre outros. A principal contribuição de Lewis et al. foi propor um novo método de pré-treinamento conjunto para RAG, mas não é a forma de implementação de RAG mais comumente usada hoje. Isso nos lembra da importância de prestar atenção à continuidade do desenvolvimento tecnológico e aos trabalhos fundamentais anteriores (Fonte: arankomatsuzaki)

Usando Qwen3 para alcançar formato de saída em cadeia de pensamento similar ao Gemini 2.5 Pro: Inspirado pelo README do Apriel-Nemotron-15b-Thinker sobre forçar o modelo a iniciar a saída em um formato específico (como “Here are my reasoning steps:\n”), um desenvolvedor, através da funcionalidade OpenWebUI, fez com que o modelo Qwen3 sempre começasse sua saída com <think>\nMy step by step thinking process went something like this:\n1.. Experimentos mostraram que isso induz o Qwen3 a pensar e produzir saídas de forma escalonada, similar ao Gemini 2.5 Pro, embora isso por si só não aumente a inteligência do modelo, mas altera o formato de seu pensamento e expressão (Fonte: Reddit r/LocalLLaMA)

Podcast compartilha filosofia de design e bastidores do desenvolvimento do Claude Code: O podcast Latent Space convidou Catherine Wu e Boris Cherny, criadores do Claude Code, para compartilhar a filosofia de design e a história do desenvolvimento desta ferramenta de programação com AI. Destaques incluem: CC já consegue escrever cerca de 80% do seu próprio código (com revisão humana), inspirado no Aider, foca em implementação concisa (como usar arquivos Markdown para memória em vez de bancos de vetores), adota uma equipe pequena e iteração interna para impulsionar o produto, oferece acesso ao modelo bruto para usuários avançados e suporta fluxos de trabalho paralelos. O podcast também discutiu comparações com ferramentas como Cursor e Windsurf, bem como tópicos como custo, design de UI/UX e possibilidade de código aberto (Fonte: Reddit r/ClaudeAI)

💼 Negócios

Salesforce inicia plano de AI de US$ 500 milhões na Arábia Saudita e forma equipe: A Salesforce começou a formar uma equipe na Arábia Saudita como parte de seu plano de cinco anos e US$ 500 milhões, visando impulsionar a adoção e o desenvolvimento da inteligência artificial no país. Isso marca mais uma importante iniciativa de grandes empresas de tecnologia na região do Oriente Médio no campo da AI (Fonte: Reddit r/artificial, Reddit r/ArtificialInteligence)

Nova CEO da divisão de aplicações da OpenAI, Fidji Simo, deixará o conselho da Shopify: Fidji Simo, atual CEO da Instacart, após ser nomeada CEO da recém-criada divisão de aplicações da OpenAI, renunciará ao seu cargo no conselho da Shopify. Esta medida pode ter como objetivo permitir que ela se concentre mais em seu papel de liderança na OpenAI, gerenciando seus negócios e linhas de produtos em rápido crescimento. Anteriormente, houve relatos de que a OpenAI poderia fechar um acordo potencial de US$ 1 bilhão com a Arm (Fonte: steph_palazzolo, steph_palazzolo)

Lux Capital estabelece fundo de US$ 100 milhões para apoiar cientistas dos EUA enfrentando cortes de financiamento: Para lidar com os drásticos cortes orçamentários da National Science Foundation (NSF) dos EUA (supostamente de 50%, resultando no cancelamento de projetos em andamento e demissões), a Lux Capital anunciou o lançamento da “Lux Science Helpline”, investindo US$ 100 milhões para apoiar os cientistas americanos afetados. O objetivo é garantir a continuidade de projetos de pesquisa cruciais e manter a competitividade da inovação tecnológica dos EUA (Fonte: ylecun, riemannzeta)

🌟 Comunidade

Discussão sobre se a AI substituirá empregos humanos continua: A discussão na comunidade sobre se a AI causará desemprego em massa é muito comum. Uma visão argumenta que, impulsionadas pelo capitalismo, as empresas buscarão eficiência, substituindo mão de obra cara por AI, levando à redução de postos como programadores. Outra visão, referenciando a história, acredita que o progresso tecnológico (como a lâmpada elétrica substituindo acendedores de lampiões) eliminará postos antigos, mas criará novos (como fábricas de lâmpadas, indústrias relacionadas à eletricidade), sendo crucial a atualização de habilidades e a inovação. Atualmente, a AI ainda requer intervenção humana em tarefas complexas e depuração de código, mas seu rápido desenvolvimento e desempenho eficiente em certas áreas deixam muitos preocupados com as perspectivas futuras de emprego, enquanto outros consideram isso alarmismo ou uma superestimação de curto prazo das capacidades da AI (Fonte: Reddit r/ArtificialInteligence)

Preocupações sobre o limite de capacidade dos LLMs e um inverno da AI: Alguns membros da comunidade e especialistas (como Yann LeCun, François Chollet) começaram a discutir se os modelos de linguagem grandes (LLMs) estão encontrando um gargalo. Embora os LLMs se destaquem na imitação de padrões, eles ainda têm limitações na compreensão real, raciocínio e no tratamento de problemas de alucinação, e a dependência excessiva de dados sintéticos também pode trazer problemas. Se faltarem novas direções de pesquisa (como modelos de mundo, sistemas neuro-simbólicos), o atual entusiasmo pela AI pode esfriar, levando à redução de investimentos e até mesmo a um novo “inverno da AI”. No entanto, há também a visão de que, embora os LLMs gerais possam estar atingindo um teto, modelos especializados e agentes de AI continuam a se desenvolver rapidamente (Fonte: Reddit r/ArtificialInteligence)

Planos da OpenAI de lançar modelo de código aberto no verão geram discussão na comunidade: Sam Altman, ao testemunhar no Senado, afirmou que a OpenAI planeja lançar um modelo de código aberto neste verão. A comunidade reagiu de formas variadas, alguns ansiosos por seu desempenho, outros questionando se será como o FSD de Musk, “sempre a caminho”, ou se será “capado” para não competir com modelos pagos. Outros analisam que empresas como Meta e Alibaba, ao lançar modelos pré-treinados gratuitos de alta qualidade, pretendem enfraquecer a posição de mercado de empresas como a OpenAI, e esta medida da OpenAI poderia ser uma estratégia de resposta. Mas, considerando o modelo de negócios da OpenAI e seus altos custos operacionais, o posicionamento e a competitividade de seu modelo de código aberto ainda precisam ser vistos (Fonte: Reddit r/LocalLLaMA)

Impacto da AI na confiabilidade da informação na internet gera preocupação: Usuários no Reddit expressaram preocupação com o impacto da AI na confiabilidade da internet. Especialmente funcionalidades como o Google AI Overviews, que às vezes fornecem respostas imprecisas ou “absurdos ditos com seriedade” (por exemplo, explicando frases inventadas pelo usuário), o que pode enganar a próxima geração de usuários e até mesmo fazê-los duvidar de todas as informações. Os comentários sobre essa visão são mistos, alguns acreditam que a internet nunca foi totalmente confiável e o pensamento crítico sempre foi importante; outros brincam que o autor da postagem revelou sua idade (Fonte: Reddit r/ArtificialInteligence)

Usuário compartilha experiência de alívio da depressão ao conversar com o ChatGPT: Um usuário compartilhou como, após uma longa conversa com o ChatGPT, seus pensamentos depressivos e suicidas foram aliviados. Ele afirmou que, mesmo desabafando com uma AI, isso o ajudou a liberar uma enorme pressão psicológica e lhe deu coragem para seguir em frente e procurar ajuda de amigos e familiares. Muitos nos comentários relataram experiências semelhantes, acreditando que a AI pode oferecer companhia imparcial e paciente no apoio psicológico, e alguns usuários até compartilharam prompts para fazer o ChatGPT扮演 “eu superior” para conversas profundas. Isso gerou discussões sobre o potencial da AI no auxílio à saúde mental (Fonte: Reddit r/ChatGPT)

Reflexão sobre a afirmação “LLMs apenas preveem a próxima palavra”: Há discussões na comunidade apontando que a afirmação “LLMs apenas preveem a próxima palavra” é excessivamente simplista e pode levar as pessoas a subestimar a real capacidade e o impacto potencial dos LLMs. O crucial é a complexidade e a utilidade do conteúdo produzido pelos LLMs (como código, análises), e não seu mecanismo de geração. Especialistas expressam preocupação com o rápido desenvolvimento da AI e suas capacidades desconhecidas, enquanto o público em geral pode não reconhecer plenamente as profundas transformações que a tecnologia de AI está prestes a trazer devido a essas simplificações. A discussão também aborda as questões de “inteligência” e “consciência” da AI, argumentando que mesmo que a AI não tenha consciência no sentido humano, sua capacidade é suficiente para causar um impacto enorme no mundo (Fonte: Reddit r/ArtificialInteligence)

Discussão sobre o valor da versão paga do Claude: Gerenciamento de projetos, tamanho do contexto e modo de pensamento são cruciais: Usuários pagos do Claude compartilharam o que torna a assinatura valiosa. As principais vantagens incluem a funcionalidade “Projetos”, que permite aos usuários carregar grandes quantidades de material de referência (base de conhecimento) para tarefas específicas (como preparação de aulas, SEO de sites, análise de anúncios, resumos de notícias, consulta de receitas), permitindo que o Claude forneça ajuda contínua em um contexto específico. Além disso, uma janela de contexto maior, um “Modo de Pensamento” mais forte e um maior número de consultas também são atrativos para o pagamento. O feedback dos usuários indica que, ao lidar com tarefas complexas, revisão de código, análise de documentos e redação de e-mails, o Claude Pro combinado com ferramentas MCP (como Desktop Commander) supera algumas soluções integradas a IDEs, que podem ter a capacidade de análise profunda do modelo limitada devido à otimização de custos ou prompts de sistema embutidos (Fonte: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Mudança de licença do OpenWebUI gera preocupação na comunidade e em usuários corporativos: O projeto OpenWebUI alterou recentemente sua licença de software, uma mudança que gerou preocupação em alguns membros da comunidade e usuários corporativos. Algumas empresas afirmaram estar discutindo a interrupção do uso e da contribuição para o projeto, e irão temporariamente criar um fork baseado na última versão com licença BSD. Este evento destaca o impacto que as mudanças de licença em projetos de código aberto podem ter no ecossistema de usuários e contribuidores, especialmente em cenários de aplicação comercial (Fonte: Reddit r/OpenWebUI)

💡 Outros

Vaticano planeja investir em novas fontes de dados para enfrentar o problema da “muralha de dados”: Desde 2023, o treinamento de modelos de linguagem grandes enfrenta o problema da “muralha de dados”, ou seja, a maior parte dos dados textuais humanos conhecidos já foi indexada e treinada. Para resolver este problema, o Vaticano planeja investir em novas fontes de dados, por exemplo, transcrevendo documentos de igrejas medievais através da tecnologia OCR e gerando dados sintéticos, para continuar aprimorando a capacidade dos modelos de AI (Fonte: jxmnop, Dorialexander)

Rápido desenvolvimento tecnológico da China, com inovações em múltiplas áreas chamando a atenção: Uma postagem detalhou várias aplicações tecnológicas impressionantes observadas pelo autor durante uma viagem de 15 dias à China, incluindo bonecas sexuais DeepSeek, dirigíveis elétricos, drones para lidar com acidentes de trânsito, entre outros. Isso gerou discussões sobre a velocidade do desenvolvimento tecnológico e a amplitude de aplicação da China em áreas como inteligência artificial, robótica, transporte de nova energia, e comparações com outros países de alta tecnologia como Singapura (Fonte: GavinSBaker)

Expectativas para o desenvolvimento da AI na área médica: Membros da comunidade expressaram expectativas por maiores avanços da AI na área médica. As visões incluem robôs de AI capazes de escanear o corpo instantaneamente e detectar sintomas de doenças em estágio inicial, bem como sistemas que podem auxiliar em tratamentos precisos, cirurgias e acelerar a recuperação. Embora a tecnologia existente já tenha alcançado progressos em alguns aspectos, há um consenso de que a AI ainda tem um enorme potencial a ser explorado para melhorar a acessibilidade, precisão e salvar vidas na área médica (Fonte: Reddit r/ArtificialInteligence, Reddit r/artificial)