Palavras-chave:Modelos da série Qwen3, Claude Code, Benchmark de modelos de IA, Runway Gen-4, LangGraph, Desempenho do Qwen3-235B-A22B, Assistente de programação Claude Code, Benchmark SimpleBench, Funcionalidade References do Runway Gen-4, Aplicação do Agente LangGraph

🔥 Foco

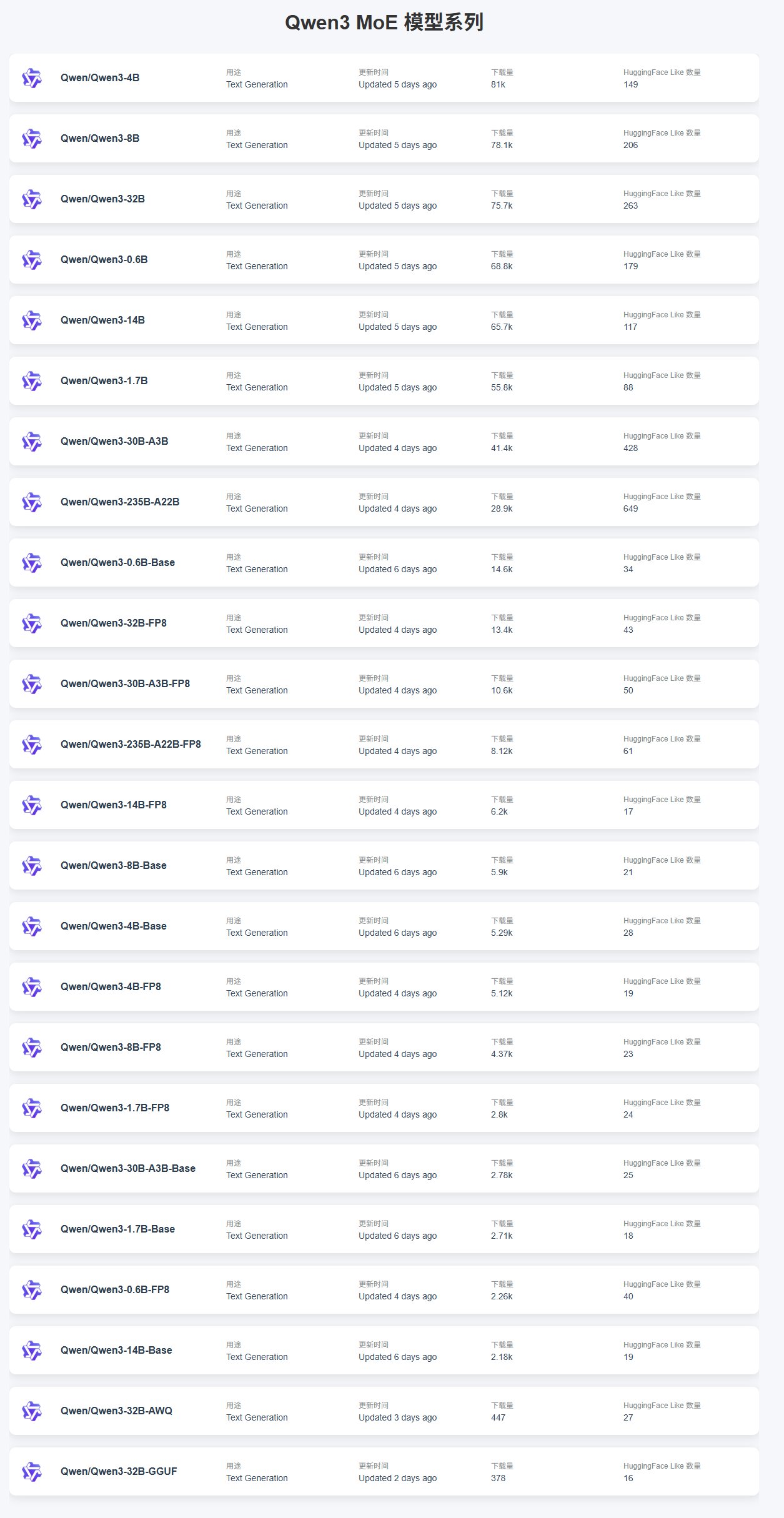

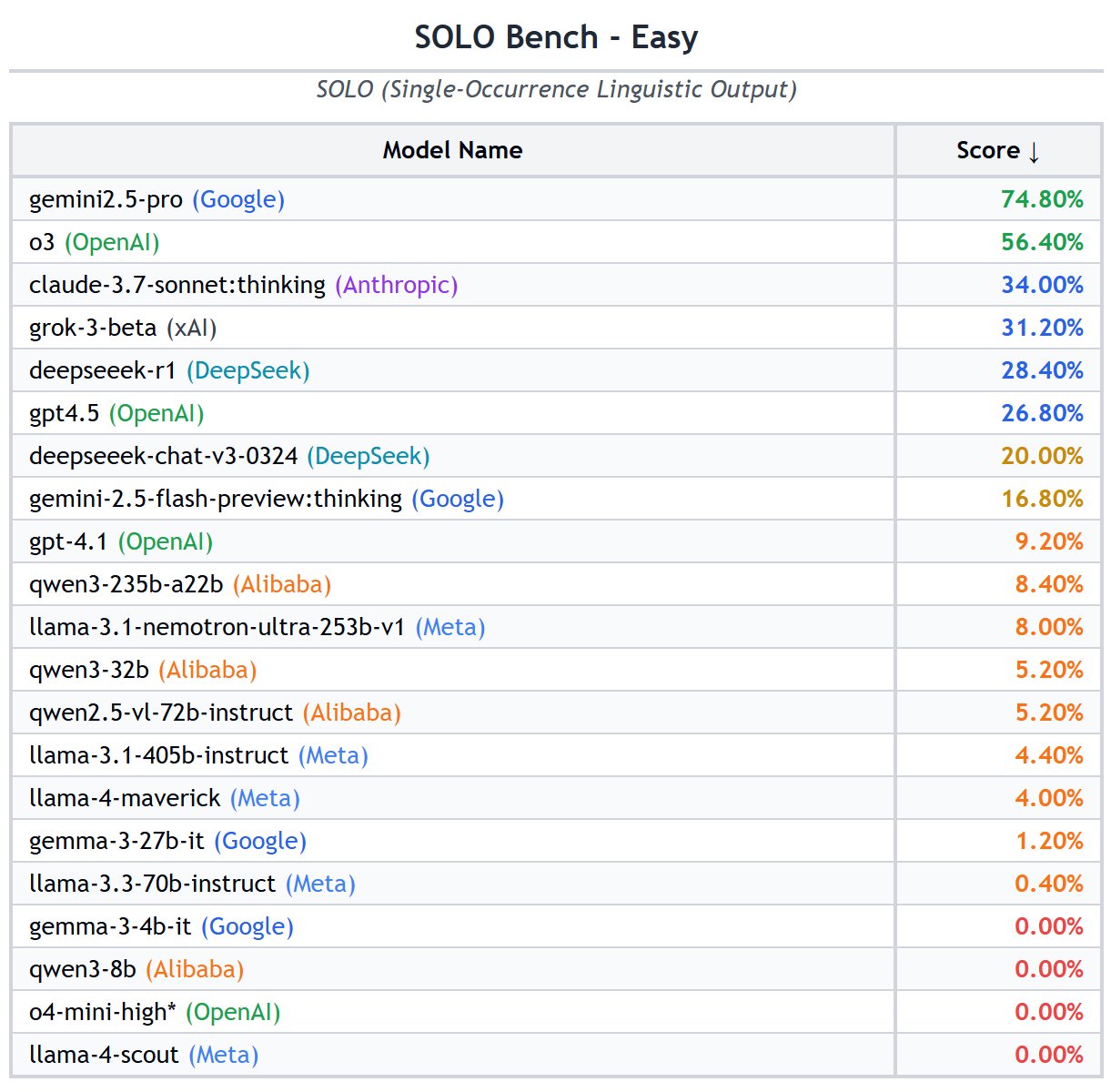

Lançamento e desempenho da série de modelos Qwen3: O Alibaba lançou a série de modelos Qwen3, cobrindo vários tamanhos de 0.6B a 235B. O feedback da comunidade indica que modelos menores (como 4B) têm maior número de downloads devido à facilidade de fine-tuning, e entre os modelos MoE, o 30B-A3B é relativamente popular. Em termos de desempenho, o Qwen3-235B-A22B teve um excelente desempenho no SimpleBench, classificando-se em 13º lugar, superando modelos como o1/o3-mini e DeepSeek-R1. O Qwen3-8B funciona bem localmente, é pequeno (versão quantizada de 4.3GB) e tem baixo consumo de memória (4-5GB), adequado para ambientes com recursos limitados. No entanto, alguns usuários apontaram insuficiências do Qwen3 na condução de AI Agents autónomos, como geração estruturada instável, dificuldades no processamento interlingual, falta de compreensão do ambiente e problemas de censura. (Fonte: karminski3, scaling01, BorisMPower, Reddit r/LocalLLaMA, Reddit r/MachineLearning)

Desempenho e feedback de uso do Claude Code: O Claude Code como assistente de programação tem recebido atenção, com usuários discutindo seus problemas de alucinação ao lidar com bibliotecas privadas, gerando código incorreto por falta de conhecimento sobre implementações personalizadas. As soluções incluem fornecer mais contexto, fazer fine-tuning do modelo ou usar um servidor MCP (Machine Collaboration Protocol) para acessar bibliotecas privadas. Ao mesmo tempo, usuários do Claude Pro relataram problemas de limite de cota, onde mesmo um uso pequeno pode acionar restrições, afetando a eficiência da codificação. Relatórios de desempenho indicam que ajustes recentes na limitação de taxa sensível ao cache podem ser a causa do throttling inesperado, afetando especialmente os usuários Pro. Apesar dos problemas, alguns usuários consideram o Claude superior ao ChatGPT em “vibe-coding”. (Fonte: code_star, jam3scampbell, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

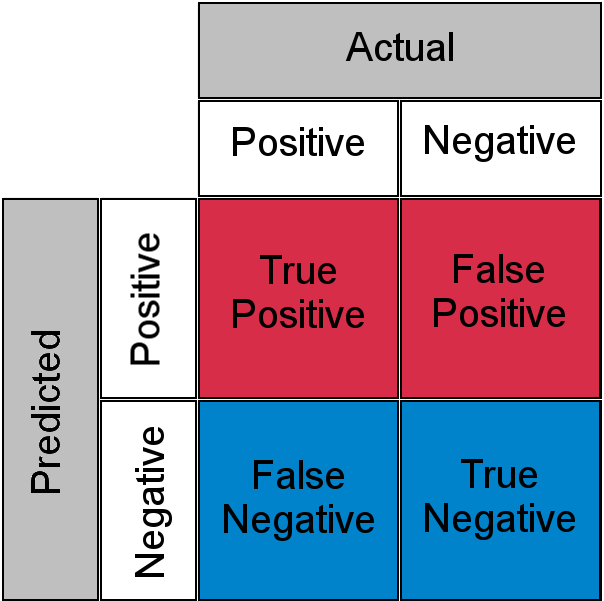

Discussão e lista de Benchmarks de modelos de IA: A comunidade debate a validade de vários benchmarks de LLM. Alguns usuários consideram GPQA e SimpleQA como benchmarks chave, enquanto benchmarks tradicionais como MMLU e HumanEval têm sinais enfraquecidos. Benchmarks com conceitos simples como SimpleBench, SOLO-Bench, AidanBench, bem como aqueles baseados em jogos e tarefas do mundo real, são favorecidos. Ao mesmo tempo, uma lista detalhada de benchmarks de LLM foi compartilhada, cobrindo múltiplas dimensões como capacidade geral, código, matemática, Agent, contexto longo, alucinações, etc., fornecendo uma referência para avaliar modelos. Usuários expressaram interesse nos dados de benchmark do Grok 3.5, mas também alertaram contra dados não oficiais ou adulterados. (Fonte: teortaxesTex, scaling01, scaling01, teortaxesTex, scaling01, natolambert, scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Demonstração da funcionalidade References do Runway Gen-4: A funcionalidade References no modelo Gen-4 da RunwayML demonstra poderosas capacidades de geração de imagem e vídeo. Usuários mostraram como usar a funcionalidade para renovação de espaços, bastando fornecer uma imagem do espaço e uma imagem de referência para gerar um novo design de interiores. Além disso, a funcionalidade pode ser usada para criar videojogos interativos semelhantes a “Myst”, gerando animações de transição especificando os frames inicial e final. É até possível “viajar” para cenas históricas, gerando vistas de diferentes ângulos de locais específicos (como a cena da pintura “As Meninas”), mostrando seu enorme potencial na geração de conteúdo criativo. (Fonte: connerruhl, c_valenzuelab, c_valenzuelab, TomLikesRobots, c_valenzuelab)

🎯 Tendências

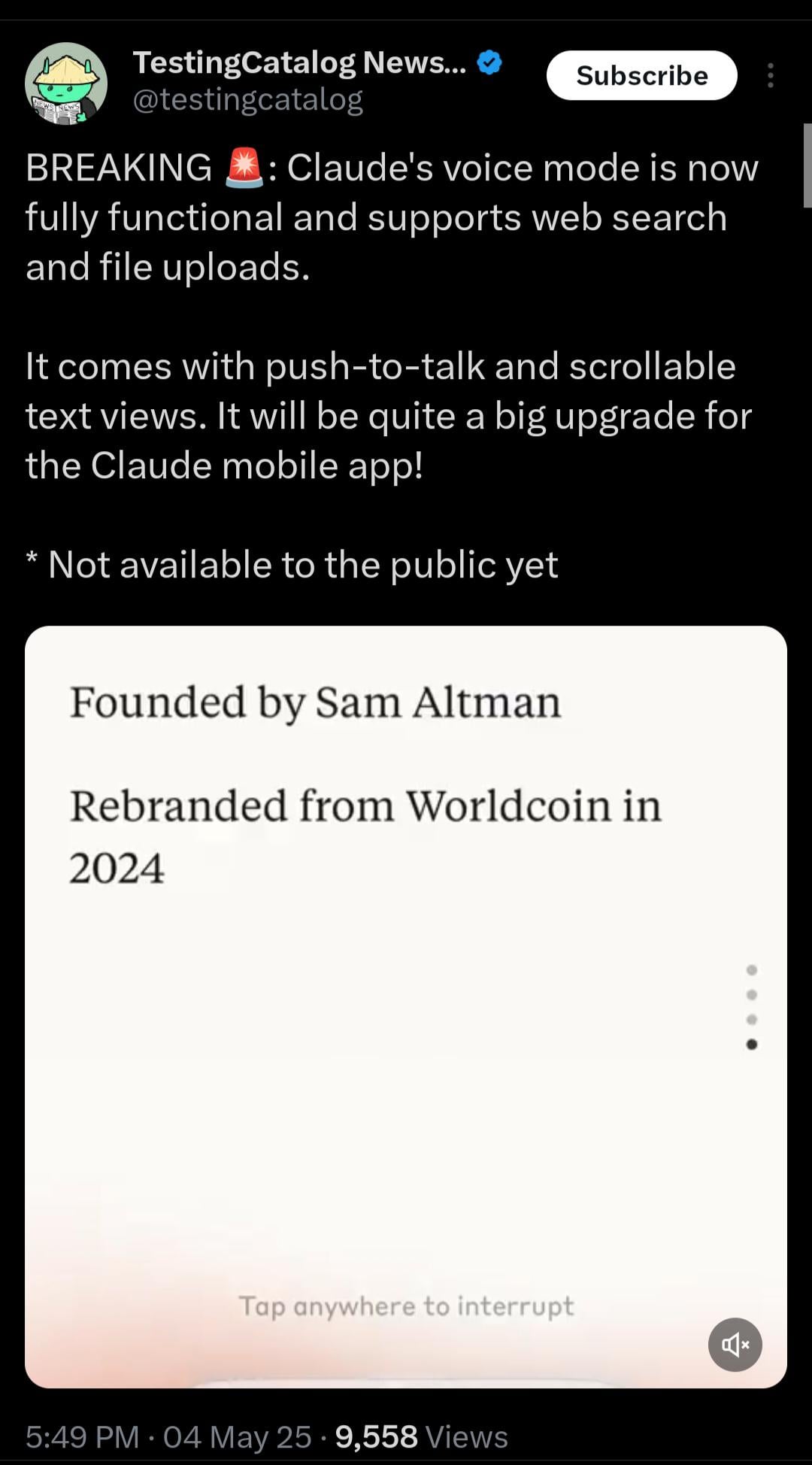

Claude lançará em breve modo de voz em tempo real: O Claude da Anthropic está testando a funcionalidade de interação por voz em tempo real. De acordo com informações vazadas, o modo está funcionalmente completo, suportará pesquisa na web e upload de arquivos, e oferecerá “push-to-talk” e uma visualização de texto rolável. Embora ainda não tenha sido lançado publicamente, placeholders relacionados ( <antml:voiceNote> ) já apareceram nas prompts do sistema, indicando uma grande atualização iminente para o aplicativo móvel do Claude, visando melhorar a experiência de interação do usuário e alcançar as capacidades de voz de concorrentes como o ChatGPT. (Fonte: op7418, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

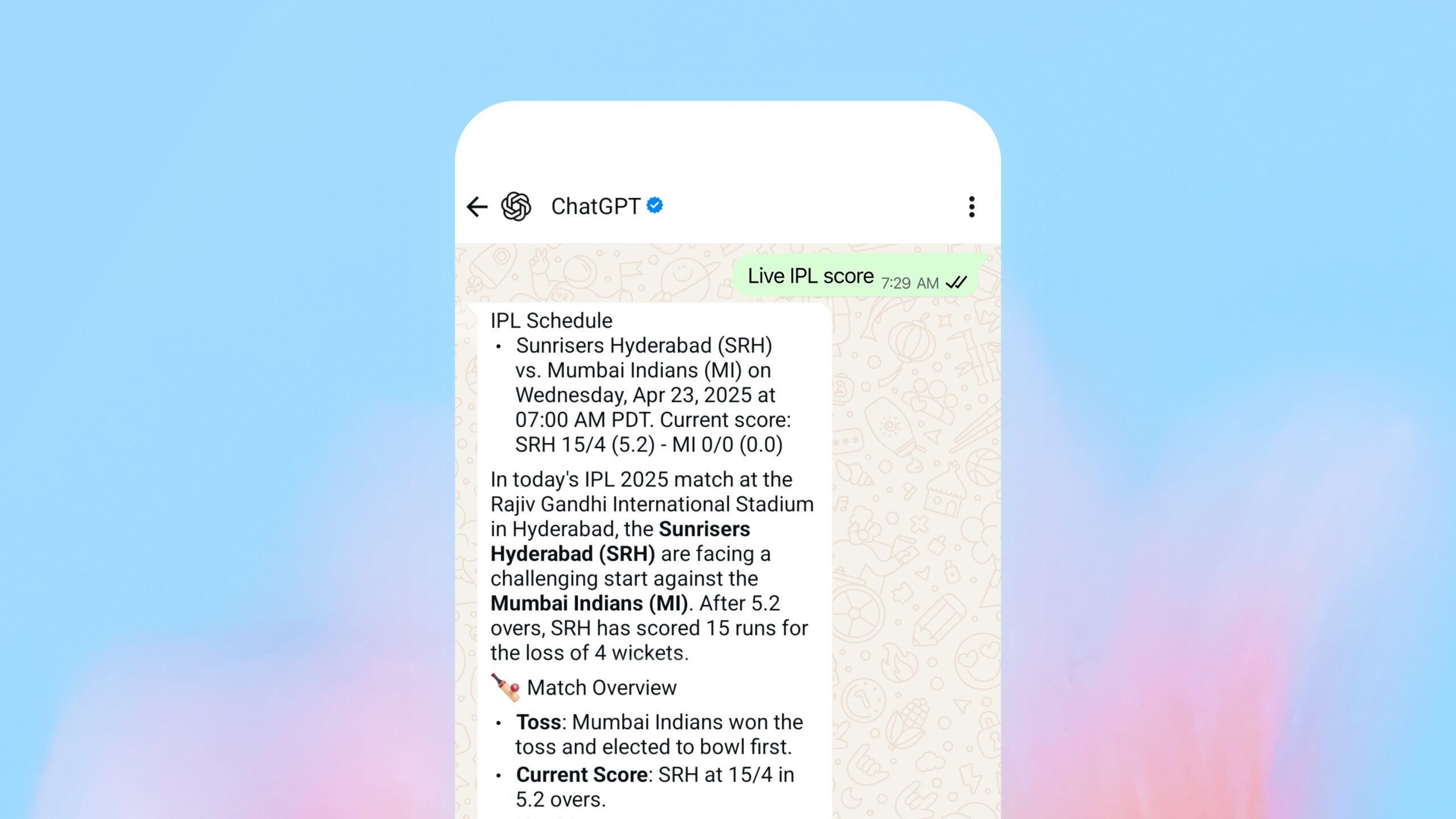

OpenAI lança funcionalidade de pesquisa dentro do WhatsApp: A OpenAI anunciou que os usuários agora podem enviar mensagens para 1-800-ChatGPT (+1-800-242-8478) via WhatsApp para obter respostas em tempo real e resultados desportivos. Esta medida é vista como um passo importante para a OpenAI expandir o alcance dos seus serviços, mas também levanta discussões sobre as considerações estratégicas de oferecer serviços essenciais na plataforma de um grande concorrente (WhatsApp, propriedade do Facebook). A funcionalidade está acessível em todas as regiões onde o ChatGPT está disponível. (Fonte: digi_literacy)

Grok lançará em breve funcionalidade de voz: O Grok da xAI anunciou que lançará uma funcionalidade de interação por voz, aprimorando ainda mais suas capacidades multimodais, com o objetivo de competir com outros assistentes de IA convencionais (como ChatGPT, Gemini, Claude) na interação por voz. Detalhes específicos de implementação e data de lançamento ainda não foram anunciados. (Fonte: ibab)

TesserAct: Lançamento de modelo de mundo 4D incorporado para aprendizado: DailyPapers anunciou o lançamento do TesserAct, um sistema capaz de aprender modelos de mundo 4D incorporados (embodied world models). Ele pode gerar vídeos contendo informações de RGB, profundidade e normais com base em imagens de entrada e instruções de texto, e reconstruir cenas 4D. Esta tecnologia tem potencial na compreensão e simulação de mundos físicos dinâmicos, aplicável em robótica, condução autónoma e realidade virtual. (Fonte: _akhaliq)

Estudo sobre a capacidade de raciocínio espacial de Modelos de Linguagem Visual (VLM): Um artigo do ICML 2025 explora as razões pelas quais os VLMs têm um desempenho fraco no raciocínio espacial. A pesquisa descobriu que os mecanismos de atenção dos VLMs existentes, ao processar relações espaciais, não conseguem focar com precisão nos objetos visuais relevantes. O artigo propõe um método sem treino para mitigar este problema, oferecendo uma nova perspectiva para melhorar a capacidade de compreensão espacial dos VLMs. (Fonte: Francis_YAO_)

LaRI: Interseções de Raios em Camadas para Raciocínio Geométrico 3D a partir de uma Única Vista: Uma nova tecnologia chamada LaRI (Layered Ray Intersections) foi proposta, visando realizar raciocínio geométrico 3D a partir de uma única vista. O método pode utilizar ray tracing e representações em camadas para compreender e inferir a estrutura tridimensional da cena e as relações espaciais entre objetos, com potencial aplicação em reconstrução 3D, compreensão de cenas, etc. (Fonte: _akhaliq)

IBM lança Granite 4.0 Tiny Preview: A IBM pré-lançou a próxima geração de modelos Granite, o Granite 4.0 Tiny Preview. Esta série de modelos adota uma nova arquitetura híbrida Mamba-2/Transformer, combinando a eficiência de velocidade do Mamba com a precisão de auto-atenção do Transformer. O Tiny Preview é um modelo de mistura de especialistas (MoE) de granularidade fina, com um total de 7B parâmetros, ativando apenas 1B parâmetros durante a inferência, visando fornecer desempenho eficiente. Isso marca os esforços da IBM na exploração de novas arquiteturas de modelo para melhorar o desempenho e a eficiência. (Fonte: Reddit r/LocalLLaMA)

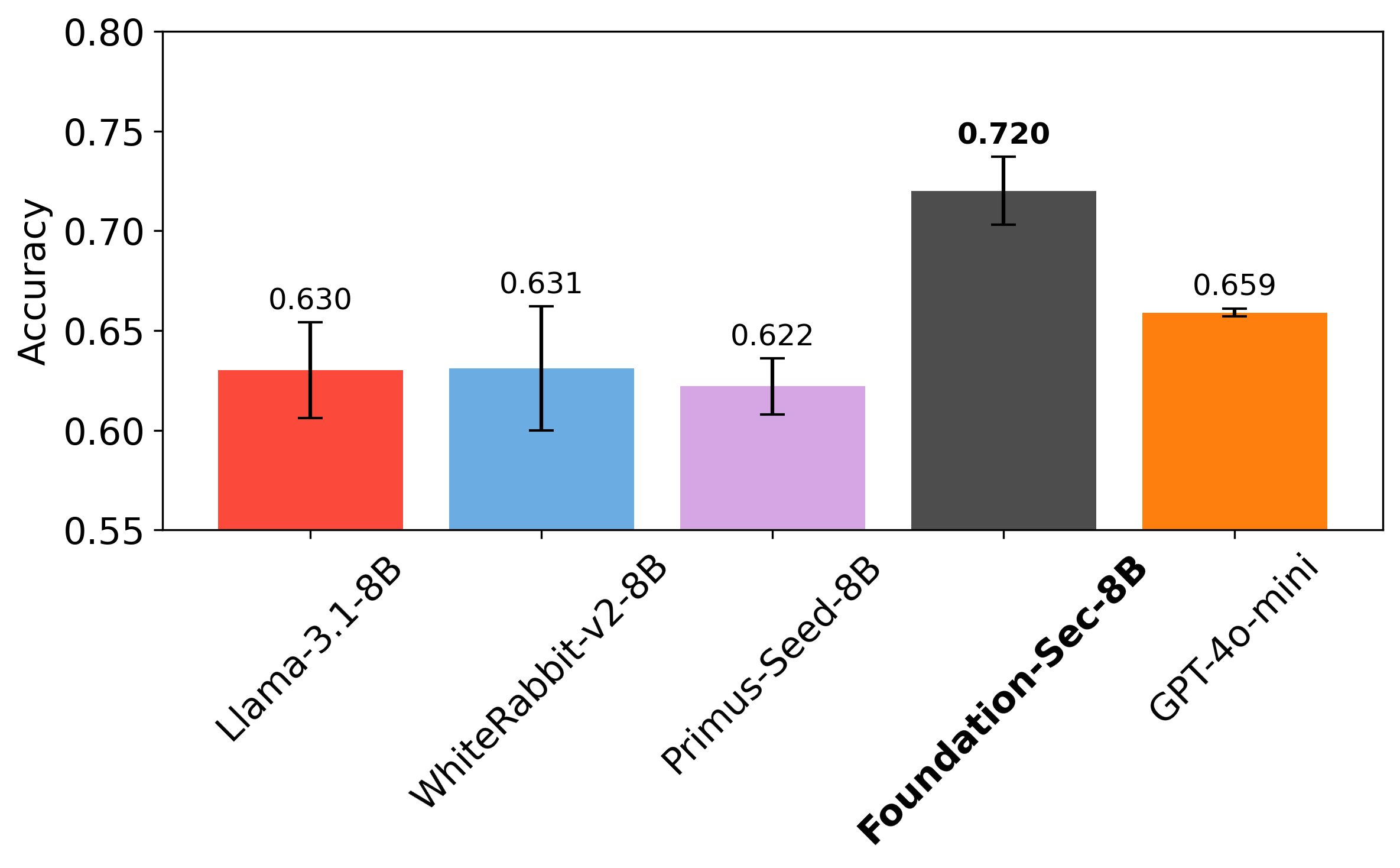

Cisco lança LLM Foundation-Sec-8B dedicado à cibersegurança: A equipa Foundation AI da Cisco lançou o modelo Foundation-Sec-8B no Hugging Face. Este é um LLM baseado no Llama 3.1, focado no domínio da cibersegurança. Alegadamente, este modelo 8B consegue igualar o Llama 3.1-70B e o GPT-4o-mini em tarefas de segurança específicas, mostrando o potencial de modelos específicos de domínio superarem grandes modelos gerais em tarefas particulares. Isso indica que grandes empresas de tecnologia estão a aplicar ativamente LLMs em domínios verticais para resolver problemas específicos. (Fonte: _akhaliq, Suhail)

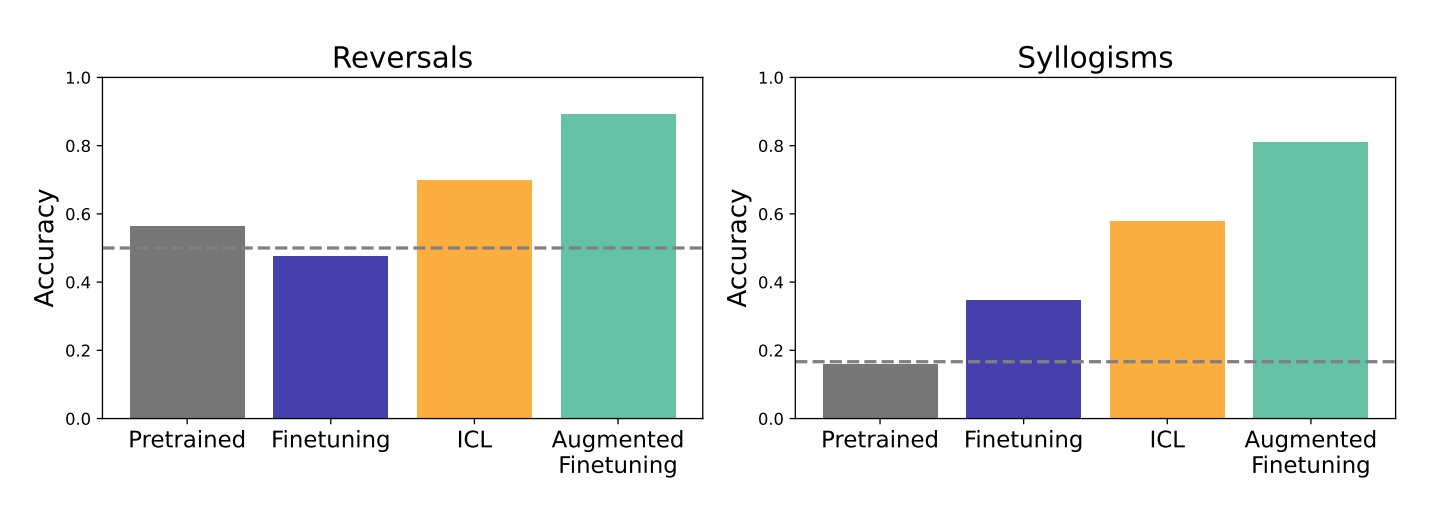

Estudo sobre o impacto do In-Context Learning (ICL) e fine-tuning na capacidade de generalização de LLMs: Pesquisadores do Google DeepMind e da Universidade de Stanford compararam o impacto do In-Context Learning (ICL) e do fine-tuning, dois métodos principais, na capacidade de generalização dos LLMs. O estudo descobriu que o ICL torna o modelo mais flexível durante o aprendizado, com maior capacidade de generalização. No entanto, quando a informação precisa ser integrada em estruturas de conhecimento maiores, o fine-tuning é mais eficaz. Os pesquisadores propuseram um novo método que combina as vantagens de ambos – augmented fine-tuning – que adiciona processos de raciocínio semelhantes ao ICL aos dados de fine-tuning, na esperança de obter os melhores resultados. (Fonte: TheTuringPost)

Meta lança PerceptionLM: Dados abertos e modelos para compreensão visual detalhada: A Meta lançou o projeto PerceptionLM, com o objetivo de fornecer um framework totalmente aberto e reproduzível para pesquisa transparente em compreensão de imagem e vídeo. O projeto analisa pipelines de treino padrão que não dependem da destilação de modelos proprietários e explora dados sintéticos em larga escala para identificar lacunas de dados, especialmente na compreensão detalhada de vídeo. Para preencher essas lacunas, o projeto lançou 2,8 milhões de pares de perguntas e respostas de vídeo de granularidade fina anotados manualmente e legendas de vídeo com localização espácio-temporal. Além disso, foi introduzido o conjunto de avaliação PLM–VideoBench, focado na avaliação de tarefas complexas de raciocínio na compreensão de vídeo. (Fonte: Reddit r/MachineLearning)

🧰 Ferramentas

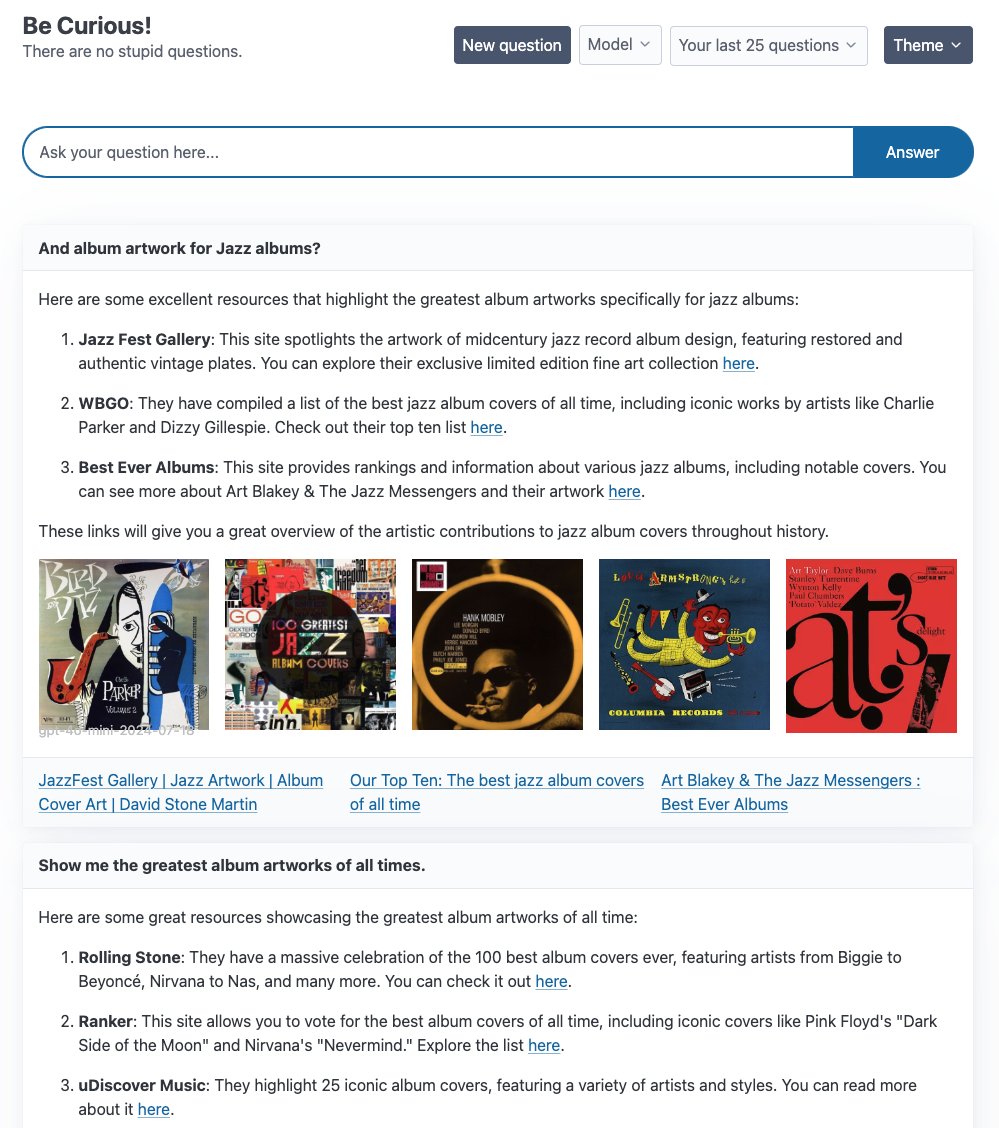

LangGraph lança vários exemplos de aplicações Agent: LangChain demonstrou vários exemplos de aplicações Agent construídas com base no LangGraph: 1. Curiosity: Uma interface de chat ReAct open-source semelhante ao Perplexity, que suporta streaming em tempo real, pesquisa Tavily e monitoramento LangSmith, podendo conectar-se a vários LLMs como GPT-4-mini, Llama3. 2. Meeting Prep Agent: Um assistente de calendário inteligente que pesquisa automaticamente informações sobre participantes e empresas de reuniões, fornecendo insights através de uma interface React/FastAPI, utilizando LangGraph para implementar fluxos de trabalho complexos de Agent e raciocínio em tempo real. 3. Generative UI: Explora a UI generativa como o futuro da interação humano-computador, lançando uma biblioteca de exemplos de UI generativa para LangGraph.js, demonstrando o potencial dos grafos de Agent na construção de interfaces dinâmicas. (Fonte: LangChainAI, hwchase17, LangChainAI, Hacubu)

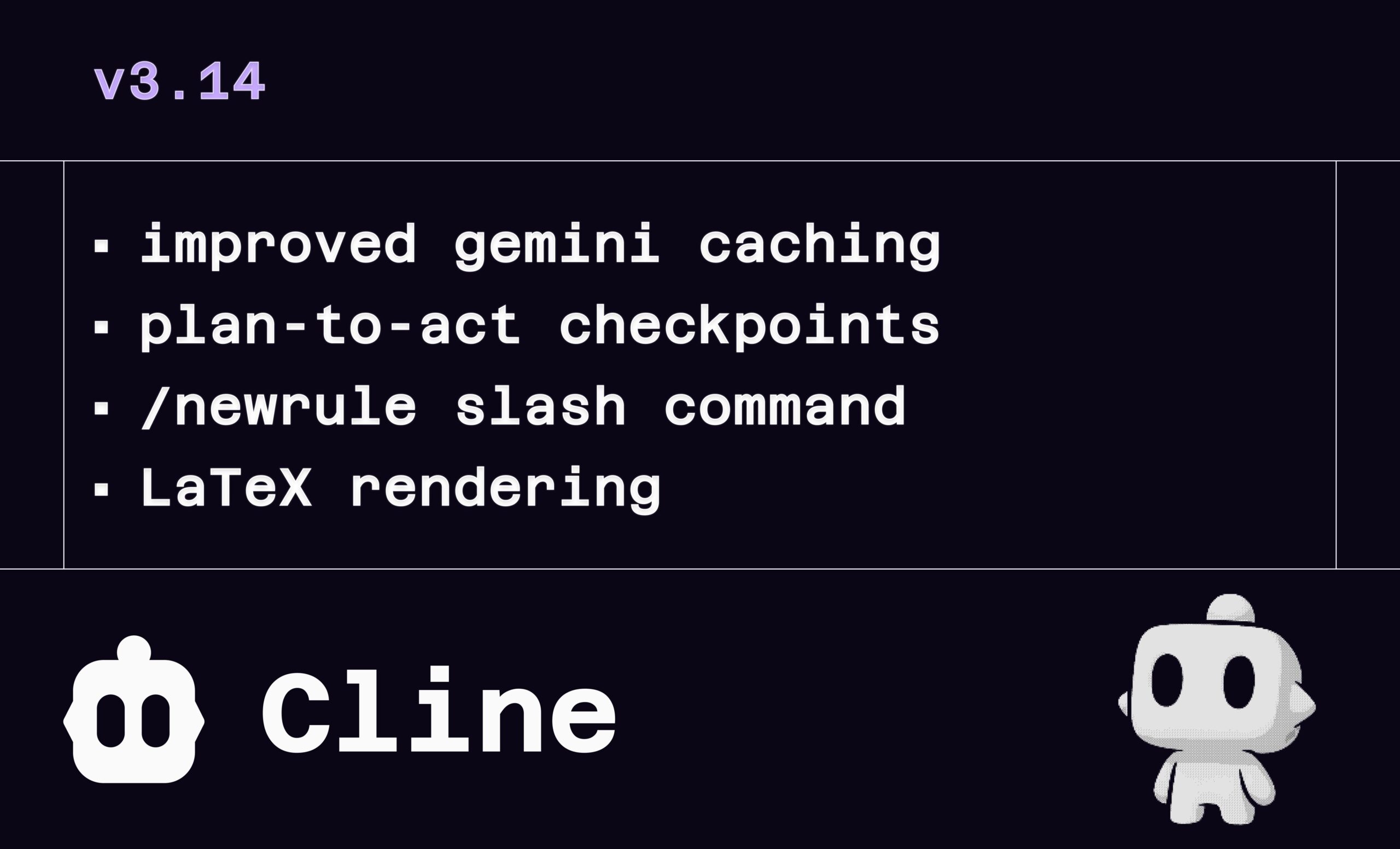

Atualização Cline v3.14: Suporte para LaTeX, arrastar e soltar arquivos e definição de regras: O assistente de programação AI Cline lançou a versão v3.14, trazendo várias atualizações de funcionalidades: 1. Renderização LaTeX: Suporte completo para LaTeX, permitindo processar diretamente fórmulas matemáticas complexas e documentos científicos na interface de chat. 2. Upload por arrastar e soltar: Suporta arrastar e soltar arquivos diretamente do gerenciador de arquivos do sistema operacional (necessário segurar Shift) para adicionar contexto. 3. Definição de regras: Novo comando /newrule que permite ao Cline analisar o projeto e gerar documentos de regras como sistemas de design, normas de codificação, etc., para impor padrões de projeto. 4. Checkpoints de fluxo: Adicionados mais checkpoints no fluxo de trabalho de tarefas, permitindo aos usuários revisar e modificar o plano antes da “execução” (Act). (Fonte: cline, cline, cline, cline)

LlamaParse ajuda 11x.ai a construir AI SDR inteligente: LlamaIndex demonstrou como sua tecnologia LlamaParse ajudou a 11x.ai a melhorar seu sistema de Representante de Desenvolvimento de Vendas de IA (AI SDR). Ao integrar o LlamaParse, a 11x.ai consegue processar vários tipos de documentos carregados pelos usuários, fornecendo as informações de contexto necessárias para o AI SDR, permitindo assim atividades de outreach automáticas personalizadas e reduzindo o tempo de onboarding de novos SDRs para dias. Isso destaca a importância da tecnologia avançada de análise de documentos na automação de processos de negócios e no aprimoramento da capacidade de aplicações de IA. (Fonte: jerryjliu0)

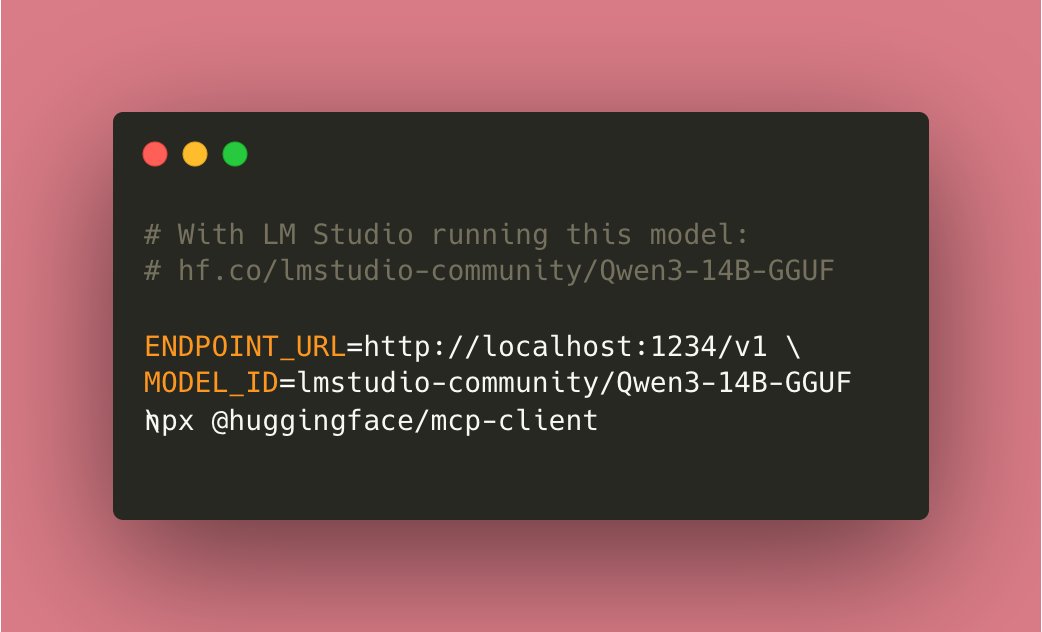

Tiny Agents alcançam execução localizada: Contribuições da comunidade permitiram que os Tiny Agents baseados no mcp-client do Hugging Face (huggingface.js) agora possam ser executados totalmente localmente. Os usuários precisam apenas executar um modelo compatível com ferramentas localmente (como Qwen3 14B) e definir ENDPOINT_URL para apontar para o endpoint da API local, permitindo assim a funcionalidade de AI Agent localizada, o que é considerado um avanço importante para a IA local. (Fonte: cognitivecompai)

Ferramenta de depuração AI de linha de comando local cloi: cloi é uma ferramenta de depuração de código AI baseada em linha de comando, caracterizada por sua execução totalmente localizada. Ela incorpora o modelo Phi-4 da Microsoft, mas também suporta a troca e execução de outros modelos de linguagem grandes locais através do Ollama. Isso oferece aos desenvolvedores uma opção conveniente para utilizar IA para depuração e análise de código em um ambiente local. (Fonte: karminski3)

Circuitos de Decisão de IA: Aumentando a confiabilidade de sistemas LLM: Um artigo explora a aplicação de conceitos de design de circuitos eletrônicos a sistemas LLM, construindo “Circuitos de Decisão de IA” para aumentar a confiabilidade. Através deste método, a precisão do sistema pode atingir 92.5%. A implementação utiliza LangSmith para rastreamento e avaliação em tempo real, a fim de verificar a precisão da saída do sistema. Este método oferece novas ideias para construir aplicações LLM mais confiáveis e previsíveis. (Fonte: LangChainAI)

Local Deep Research (LDR) busca sugestões de melhoria: A ferramenta de pesquisa open-source Local Deep Research lançou a v0.3.1 e está solicitando sugestões de melhoria da comunidade, incluindo áreas a focar, funcionalidades necessárias, preferências de tipo de pesquisa e sugestões de melhoria da UI. A ferramenta visa executar tarefas de pesquisa profunda localmente e recomenda o uso do SearXNG para aumentar a velocidade. (Fonte: Reddit r/LocalLLaMA)

OpenWebUI Adaptive Memory v3.1 lançado: A funcionalidade de memória adaptativa do OpenWebUI foi atualizada para a v3.1, com melhorias incluindo pontuação e filtragem de confiança da memória, suporte para provedores de Embedding locais/API, descoberta automática de modelos locais, validação de dimensão de Embedding, deteção de métricas Prometheus, endpoints de saúde e métricas, emissor de estado da UI e correções de Debug. O roadmap inclui refatoração, marcação dinâmica de memória, personalização de resposta personalizada, validação de persistência entre sessões, melhoria no tratamento de configuração, ajuste fino de recuperação, feedback de estado, expansão da documentação, sincronização opcional externa com RememberAPI/mem0 e anonimização de PII, etc. (Fonte: Reddit r/OpenWebUI)

📚 Aprendizado

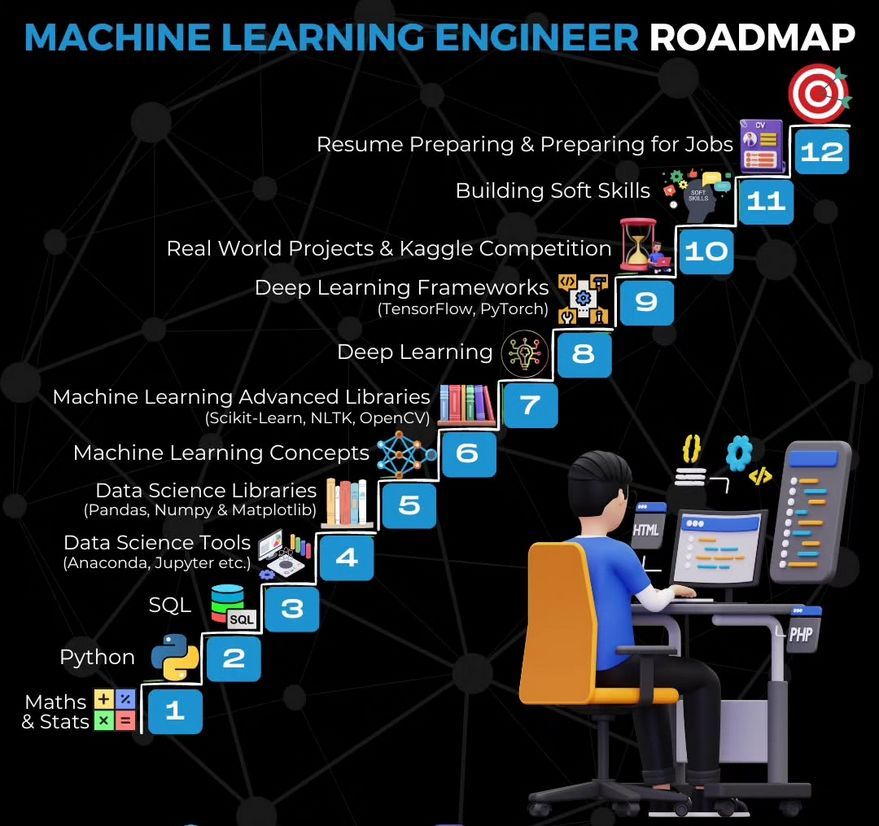

Roteiro de Aprendizagem para Engenheiro de Machine Learning: Ronald van Loon compartilhou um roteiro de aprendizagem para engenheiros de Machine Learning, fornecendo um caminho de estudo e uma visão geral das habilidades chave para aqueles que aspiram entrar na área. (Fonte: Ronald_vanLoon)

Tutorial para construir um sumarizador de vídeo usando Gemma: LangChainAI lançou um tutorial em vídeo demonstrando como construir uma aplicação de sumarização de vídeo usando o LLM Gemma executado localmente (via Ollama). A aplicação Streamlit utiliza LangChain para processar vídeos e gerar automaticamente resumos concisos, fornecendo um exemplo para aprender e praticar aplicações de LLM locais. (Fonte: LangChainAI)

Tutorial para construir um servidor MCP para processar dados de ações: LangChainAI forneceu um tutorial orientando os usuários sobre como construir um servidor MCP (Machine Collaboration Protocol) usando FastMcp e LangChain para processar dados do mercado de ações. O guia demonstra como usar LangGraph para criar um ReAct Agent para alcançar acesso padronizado a dados, ajudando a compreender e aplicar tecnologias MCP e Agent. (Fonte: LangChainAI)

Prova de conceito de benchmark de racionalidade de LLM: Deep Learning Weekly mencionou um post de blog que introduz uma prova de conceito de benchmark para a racionalidade de LLMs, ajustando a avaliação ART-Y. O artigo enfatiza que avaliar se a IA é mais racional (em vez de apenas mais inteligente) que os humanos é crucial. (Fonte: dl_weekly)

Red Teaming de IA como exercício de pensamento crítico: Deep Learning Weekly recomendou um artigo que define o Red Teaming de IA não apenas como teste de vulnerabilidades técnicas contra LLMs, mas como um exercício de pensamento crítico originado de práticas militares e de cibersegurança. Isso oferece uma perspectiva mais ampla para entender e implementar a avaliação de segurança de IA. (Fonte: dl_weekly)

Recomendação de livro para aprender Python: Membros da comunidade recomendaram o livro “Python Crash Course” para aprender Python, considerando-o um bom ponto de partida para usar Python eficazmente, e compartilharam a versão em PDF. Enfatizaram a importância do Python como linguagem fundamental para aprender desenvolvimento de IA. (Fonte: omarsar0)

“Deeply Supervised Nets” ganha prêmio Test of Time da AISTATS 2025: O artigo inicial de doutorado de Saining Xie, “Deeply Supervised Nets”, ganhou o prêmio Test of Time da AISTATS 2025. Ele compartilhou que este artigo foi rejeitado pelo NeurIPS, encorajando os estudantes a manterem a perseverança diante da rejeição de artigos e a persistirem na pesquisa. (Fonte: sainingxie)

Discussão sobre visão geral dos métodos de destilação de LLM: Um usuário do Reddit buscou uma visão geral atualizada sobre métodos de destilação de LLM, especialmente de modelos grandes para pequenos, e de modelos grandes para modelos mais especializados. A discussão mencionou três tipos principais: 1. Geração de dados + SFT (destilação simples); 2. Destilação baseada em Logit (modelos precisam ser homogêneos); 3. Destilação baseada em estado oculto (modelos podem ser heterogêneos). Ferramentas relacionadas como DistillKit também foram mencionadas. (Fonte: Reddit r/MachineLearning)

Exploração do fine-tuning federado do LLaMA2: Um usuário do Reddit compartilhou resultados preliminares de experimentos de fine-tuning federado do LLaMA2 usando FedAvg e FedProx. O experimento foi conduzido no dataset Reddit TL;DR, comparando ROUGE-L de validação global, custo de comunicação e desvio do cliente (client drift). Os resultados mostraram que FedProx foi superior ao FedAvg na redução do desvio e ligeira melhoria do ROUGE-L, mas ainda abaixo do fine-tuning centralizado. A comunidade foi convidada a discutir configurações de adaptadores, métodos de compressão e problemas de estabilidade sob dados não-IID. (Fonte: Reddit r/deeplearning)

💼 Negócios

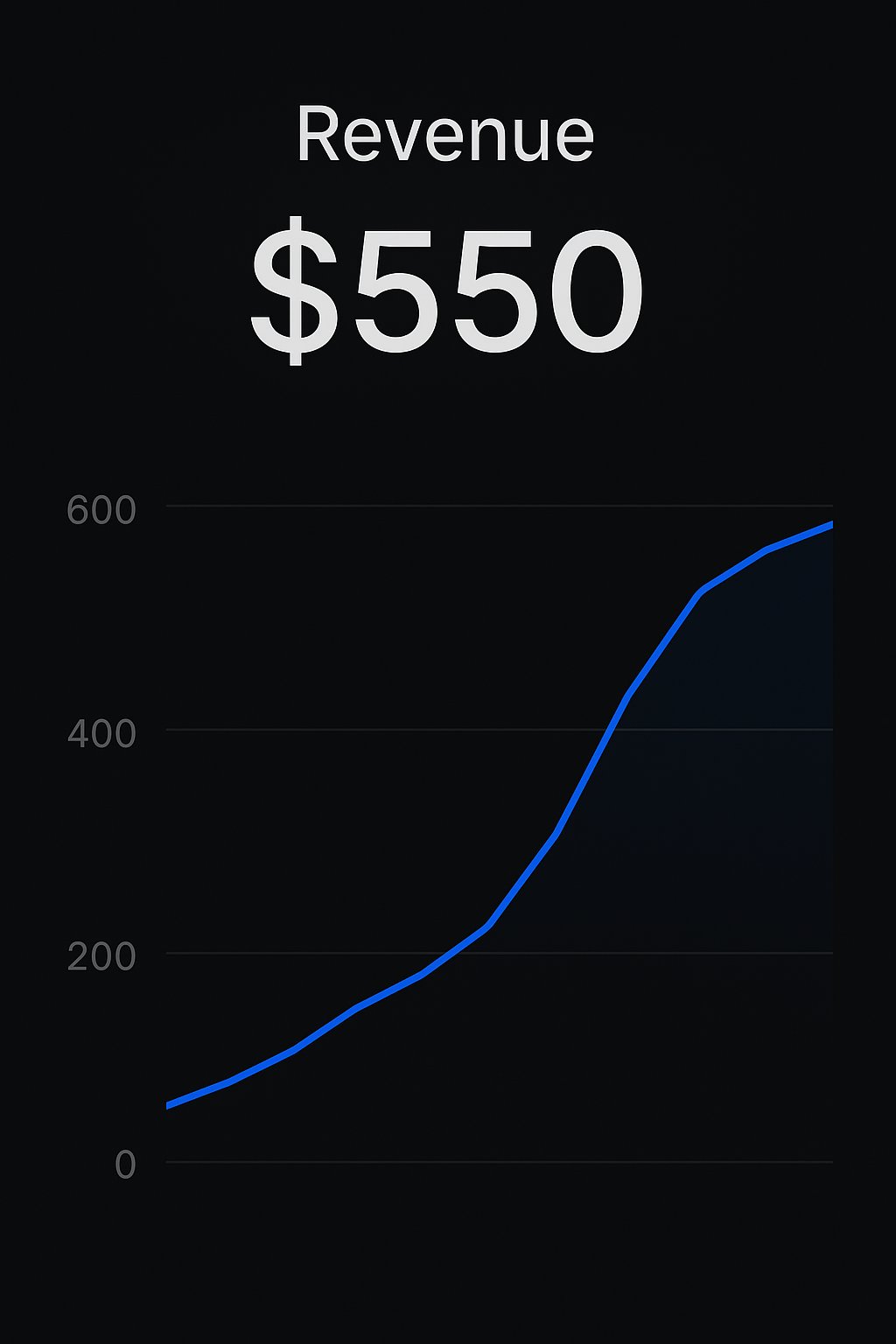

Desenvolvedores na plataforma Replit monetizam aplicações: Dois desenvolvedores compartilharam casos de sucesso na construção e venda de aplicações de IA através da plataforma Replit. Um desenvolvedor usou CreateMVPs.app para obter sua primeira receita de $550; outro desenvolvedor vendeu uma aplicação construída em um dia por $4700 e recebeu mais propostas de projetos. Isso demonstra o potencial de plataformas como Replit em capacitar desenvolvedores a construir e comercializar rapidamente aplicações de IA. (Fonte: amasad, amasad)

ChatGPT Edu implementado na Icahn School of Medicine at Mount Sinai: A Icahn School of Medicine at Mount Sinai anunciou que fornecerá serviços ChatGPT Edu para todos os estudantes de medicina e pós-graduação. Isso marca a entrada do produto educacional da OpenAI em instituições de educação médica de ponta, visando utilizar IA para auxiliar na educação e pesquisa médica. Um vídeo demonstra seus cenários de aplicação. (Fonte: gdb)

Preocupação com perdas contínuas na indústria de capital de risco: Sam Altman expressou perplexidade sobre o fenômeno da indústria de capital de risco (VC) ter perdas gerais a longo prazo, mas ainda assim conseguir obter investimento contínuo de limited partners (LPs). Ele acredita que, embora investir nos melhores fundos seja sensato, o fenômeno de perdas contínuas em toda a indústria merece reflexão sobre suas causas subjacentes e as motivações dos LPs. (Fonte: sama)

🌟 Comunidade

Discussão sobre o impacto da IA no emprego e na educação: A comunidade discute o potencial impacto da automação por IA nos modelos de trabalho existentes (interface teclado-mouse-tela) e como os educadores devem lidar com chatbots de IA. A opinião é que os professores não devem proibir os alunos de usar ferramentas como o ChatGPT, mas sim ensinar como usar essas IAs de forma eficaz e responsável, cultivando a literacia em IA e as melhores práticas nos alunos. (Fonte: NandoDF, NandoDF)

Discussão sobre interpretabilidade e segurança da IA: Dario Amodei enfatizou a urgência da interpretabilidade dos modelos de IA, considerando crucial entender como os modelos funcionam. Neel Nanda apresentou uma visão diferente, argumentando que, embora o investimento em interpretabilidade seja bom, sua importância não deve ser excessivamente enfatizada em relação a outros métodos de segurança. O caminho para garantir de forma confiável uma IA poderosa não é apenas através da interpretabilidade; ela deve ser parte de um portfólio de medidas de segurança. (Fonte: bookwormengr)

Discussão sobre a complexidade do RLHF e o fenômeno de ‘sycophancy’ (bajulação) do modelo: Nathan Lambert e outros discutiram a complexidade e importância do Reinforcement Learning from Human Feedback (RLHF), e o fenômeno resultante de ‘sycophancy’ (bajulação) do modelo (como o GPT-4o-simp). O artigo argumenta que o RLHF é crucial para o alinhamento do modelo, mas o processo é confuso, e os usuários muitas vezes não entendem sua complexidade, levando a mal-entendidos ou insatisfação com o comportamento do modelo (como a reação negativa no LMArena). Compreender os desafios inerentes ao RLHF é crucial para avaliar e melhorar os modelos. (Fonte: natolambert, aidangomez, natolambert)

Impacto potencial da IA nas capacidades cognitivas e formas de pensar humanas: A comunidade explora o impacto potencial da IA no pensamento humano. Uma preocupação é que a dependência excessiva da IA leve ao declínio das capacidades cognitivas (leitura preguiçosa, pensamento crítico enfraquecido). Outra visão sugere que, se a IA puder fornecer informações e julgamentos mais precisos, ela pode, ao contrário, melhorar o nível cognitivo de pessoas com capacidades de pensamento originalmente mais fracas ou suscetíveis a informações erradas, atuando como um “aprimoramento cognitivo” e ajudando a tomar melhores decisões. Ao mesmo tempo, há também discussões de que o desenvolvimento da IA pode nos levar a uma compreensão mais profunda da consciência, ou até mesmo descobrir que algumas pessoas podem estar apenas simulando a consciência. (Fonte: riemannzeta, HamelHusain, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

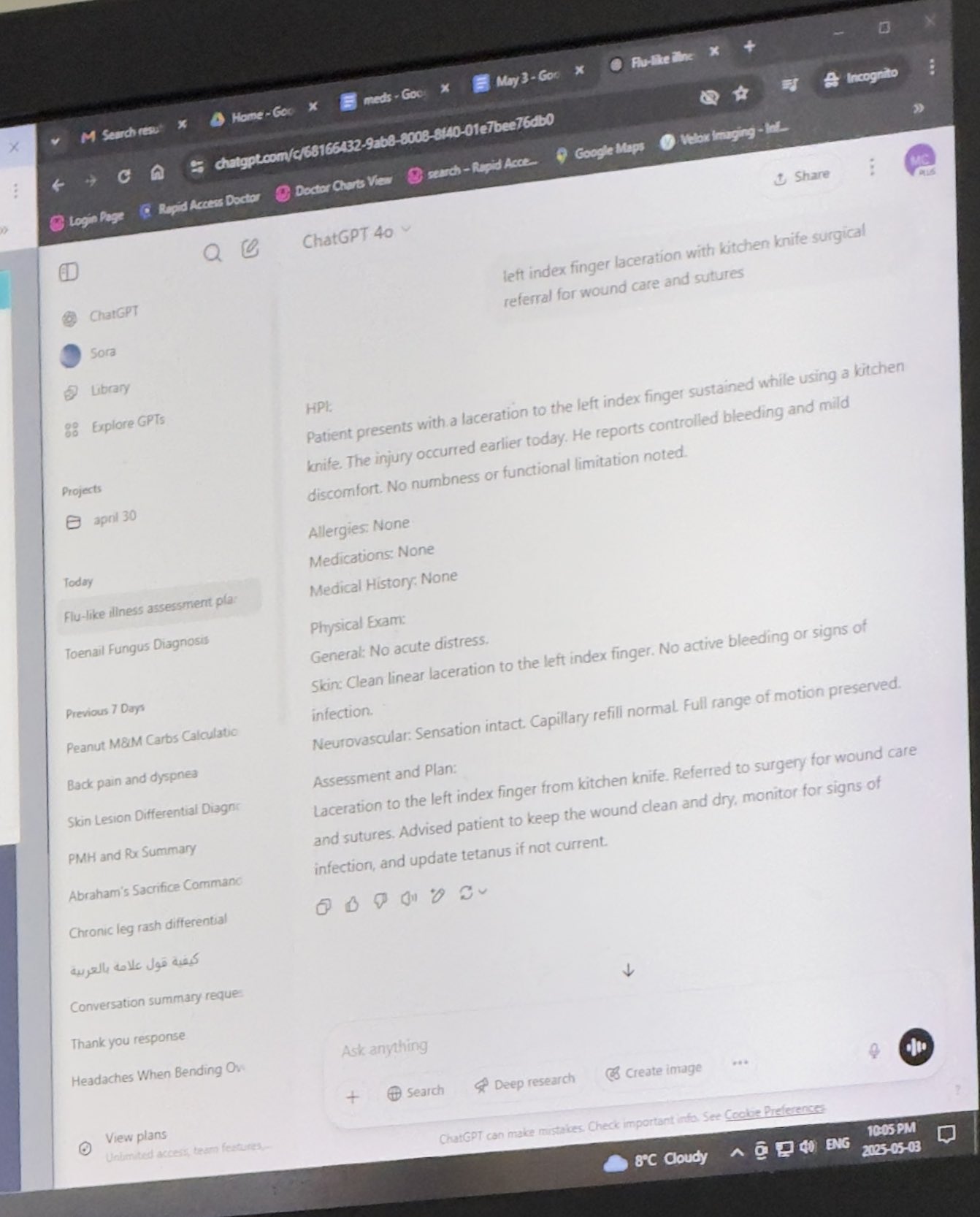

Discussão sobre ética e cenários de aplicação da IA: A discussão abrange a aplicação da IA em áreas como medicina e direito. Um usuário compartilhou um caso de um médico usando ChatGPT em consulta, gerando debate sobre a aplicação de IA em cenários profissionais. Ao mesmo tempo, há considerações éticas sobre o uso de IA para ghostwriting, especialmente quando o próprio autor enfrenta dificuldades. Além disso, há preocupações sobre os riscos e a desinformação que o conteúdo gerado por IA (como livros sobre TDAH) pode trazer. (Fonte: BorisMPower, scottastevenson, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Avanços em robôs movidos por IA: Vários robôs movidos por IA foram demonstrados: um robô desenvolvido pelo Google DeepMind capaz de jogar tênis de mesa, cães-robôs exibidos em feiras, robôs usados para cravação de diamantes, um drone inspirado em pássaros capaz de saltar para decolar, um cinzel mecânico usado para criação artística e um vídeo do robô humanoide G1 da Unitree Robotics andando em um shopping. Essas demonstrações mostram os avanços da IA no controle, percepção e interação de robôs. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

IA e o futuro das ciências humanas e sociais: Citando um artigo da New Yorker, discute-se o impacto da IA nas humanidades. O artigo argumenta que a IA não pode alcançar a “essência do eu” (me-ness) humana e a experiência humana única, mas ao mesmo tempo aponta que a IA, ao reorganizar e representar a escrita coletiva humana (arquivos), pode simular uma grande parte do que esperamos obter de indivíduos humanos, o que apresenta desafios e novas dimensões de pensamento para as humanidades. (Fonte: NandoDF)

💡 Outros

Ferramentas assistidas por IA para aprimoramento pessoal: Um usuário do Reddit compartilhou uma experiência de sucesso usando o ChatGPT como treinador pessoal de fitness e nutrição. Através da IA, elaborou planos de treino, planos alimentares (combinando ceto, treino de força, jejum, etc.), e até obteve sugestões de macronutrientes ao pedir comida, alcançando resultados melhores do que com treinadores humanos pagos. Isso demonstra o potencial da IA na orientação personalizada e assistência na vida quotidiana. (Fonte: Reddit r/ChatGPT)

Combinação de IA com capacidade de adivinhação geográfica: Sam Altman retweetou e comentou um artigo de teste sobre a capacidade surpreendente de uma IA (possivelmente o3) no Geoguessr (jogo de adivinhação geográfica). Mesmo com informações de imagem mínimas (como apenas sinais desfocados ou até mesmo gradientes de cor puros), a IA conseguiu incluir a resposta correta entre as opções, mostrando sua poderosa capacidade de reconhecimento de imagem, correspondência de padrões e raciocínio de conhecimento geográfico. (Fonte: op7418)

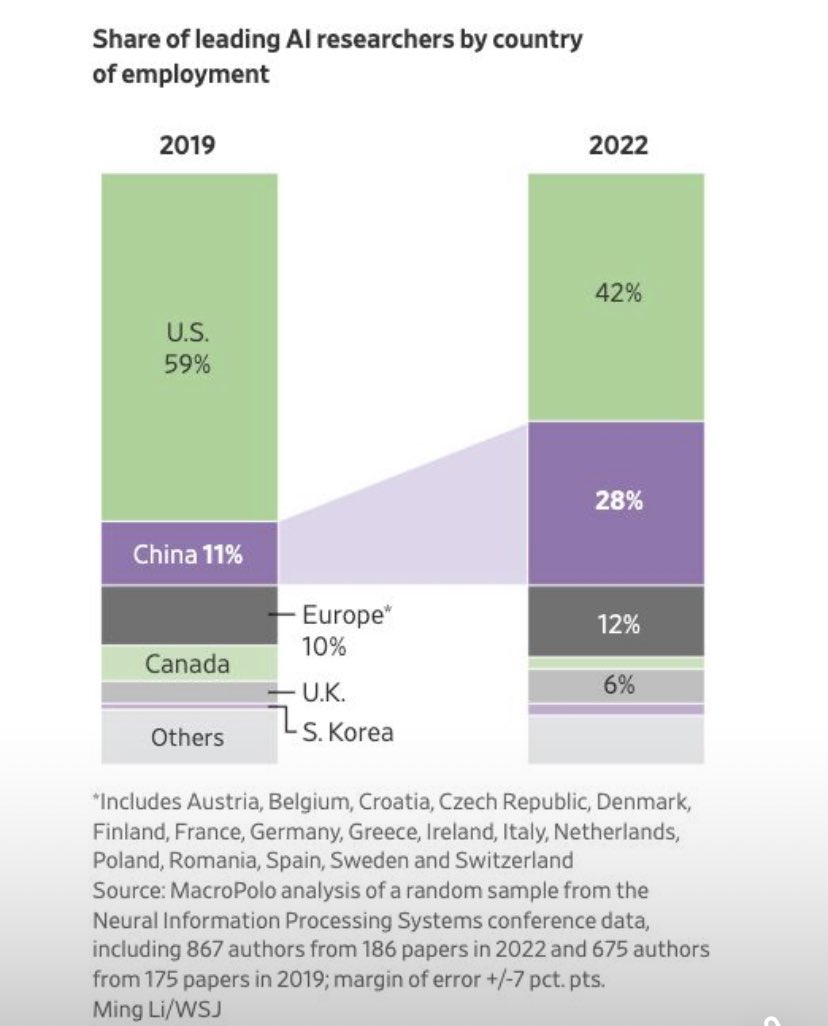

Tendências de mobilidade de pesquisadores na área de IA: Um gráfico mostra mudanças na distribuição por país de emprego dos principais pesquisadores na área de IA, com a proporção de pesquisadores empregados nos EUA diminuindo, enquanto a proporção empregada na China aumenta significativamente. Comentários da comunidade apontam que, considerando o aumento das oportunidades de pesquisa locais na China e o potencial retorno de talentos, a diferença real pode ser maior do que o gráfico mostra, refletindo mudanças no cenário global de competição por talentos em IA. (Fonte: teortaxesTex, bookwormengr)