Palavras-chave:Gemini 2.5 Pro, Modelo de IA, Robô humanoide, Ética em IA, Empreendedorismo em IA, Conteúdo gerado por IA, Criatividade assistida por IA, Gemini 2.5 Pro completando Pokémon: Blue, Anthropic Claude busca global na web, Desvio de roteamento do modelo Qwen3 MoE, Função Runway Gen-4 References, Aplicação de IA em suporte à saúde mental

🔥 Destaques

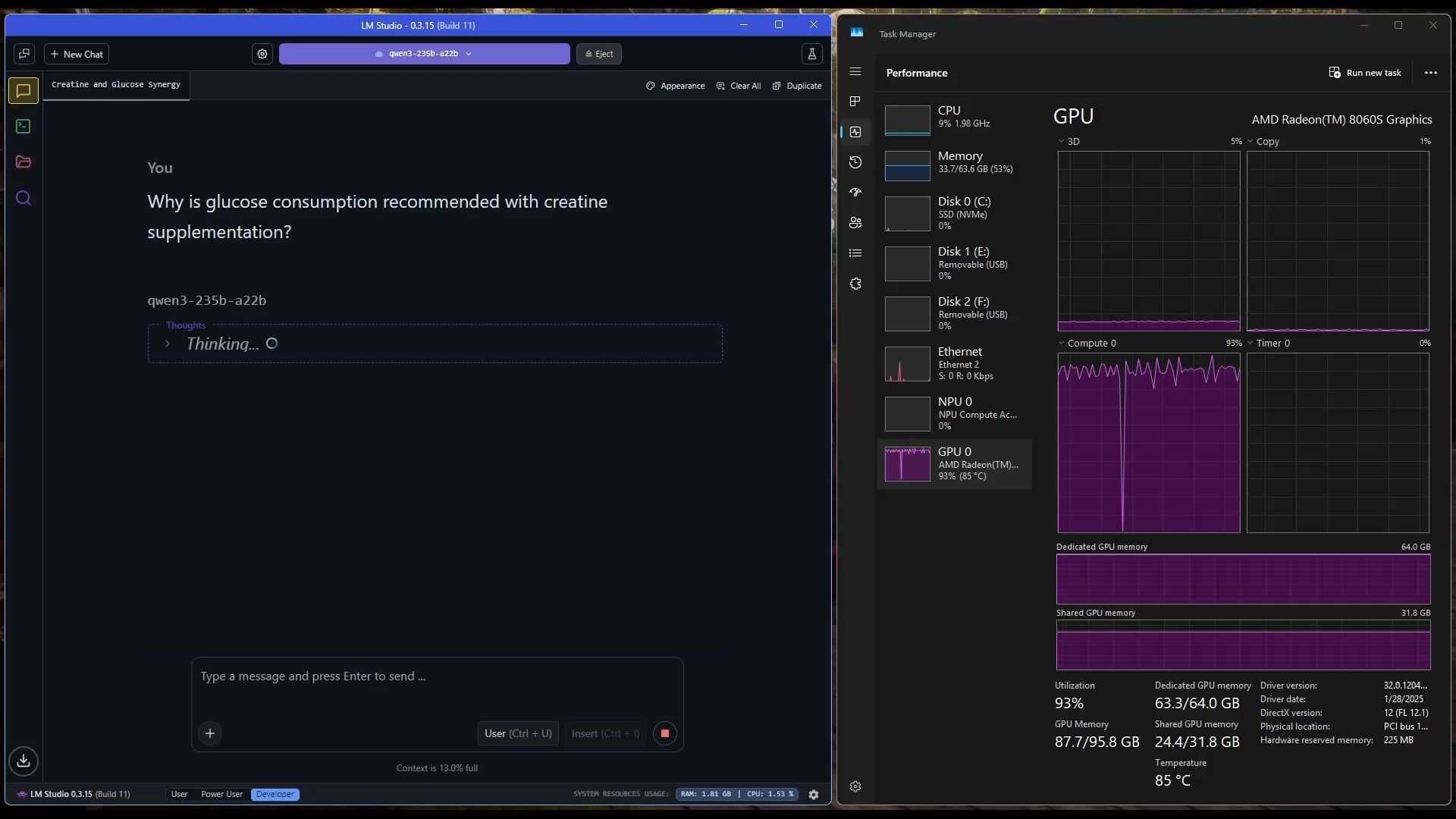

Gemini 2.5 Pro conclui com sucesso Pokémon: Blue: O modelo de IA Gemini 2.5 Pro do Google completou com sucesso o jogo clássico Pokémon: Blue, incluindo a coleta de todas as 8 insígnias e a derrota dos Elite Four da Pokémon League. Esta conquista foi realizada e transmitida ao vivo pelo streamer @TheCodeOfJoel e recebeu felicitações do CEO do Google, Sundar Pichai, e do CEO do DeepMind, Demis Hassabis. Isso demonstra o progresso significativo da IA atual no planejamento de tarefas complexas, na formulação de estratégias de longo prazo e na interação com ambientes simulados, superando o desempenho anterior da IA neste jogo e marcando um novo marco na capacidade dos agentes de IA. (Fonte: Google, jam3scampbell, teortaxesTex, YiTayML, demishassabis, _philschmid, Teknium1, tokenbender)

Apple colabora com Anthropic para desenvolver plataforma de codificação de IA “Vibe Coding”: Segundo a Bloomberg, a Apple está colaborando com a startup de IA Anthropic para desenvolver conjuntamente uma nova plataforma de codificação impulsionada por IA chamada “Vibe Coding”. A plataforma está atualmente sendo promovida internamente na Apple para testes por funcionários e pode ser aberta a desenvolvedores terceirizados no futuro. Isso marca uma exploração adicional da Apple no campo de ferramentas de assistência à programação de IA, visando usar IA para melhorar a eficiência e a experiência de desenvolvimento, podendo complementar ou integrar-se com seus próprios projetos como o Swift Assist. (Fonte: op7418)

Avanços e discussões sobre tecnologia robótica impulsionada por IA: Recentemente, robôs humanoides e inteligência incorporada têm recebido ampla atenção. A empresa Figure exibiu sua nova sede de alta tecnologia, cobrindo desde baterias e atuadores até laboratórios de IA, sinalizando suas ambições no campo da robótica. A Disney também demonstrou sua tecnologia de robôs de personagens humanoides. No entanto, na maratona de robôs humanoides de Pequim, alguns robôs (incluindo o Unitree G1 modificado por clientes) tiveram um desempenho ruim, com quedas, baixa autonomia e problemas de equilíbrio, levantando discussões sobre as capacidades reais atuais dos robôs humanoides e destacando que ainda precisam de grandes avanços em seu “cerebelo” (controle motor) e “cérebro” (tomada de decisão inteligente). (Fonte: adcock_brett, Ronald_vanLoon, 人形机器人,最重要的还是“脑子”)

Discussões sobre ética e impacto social da IA se intensificam: As discussões sobre o impacto social e as questões éticas da IA estão aumentando nas redes sociais e no campo da pesquisa. Por exemplo, o projeto de lei de IA SB-1047 da Califórnia gerou controvérsia, e documentários relacionados exploram a necessidade e os desafios da regulamentação. A conferência NAACL 2025 realizou um tutorial sobre “Inteligência Social na Era dos LLMs”, explorando desafios emergentes e de longo prazo na interação da IA com humanos e a sociedade. Ao mesmo tempo, usuários expressam preocupação com a qualidade do conteúdo gerado por IA (“slop”), argumentando pela necessidade de melhor design e controle dos modelos. Essas discussões refletem a crescente preocupação da sociedade com as questões éticas, regulatórias e de adaptabilidade social trazidas pelo rápido desenvolvimento da tecnologia de IA. (Fonte: teortaxesTex, gneubig, stanfordnlp, jam3scampbell, willdepue, wordgrammer)

🎯 Tendências

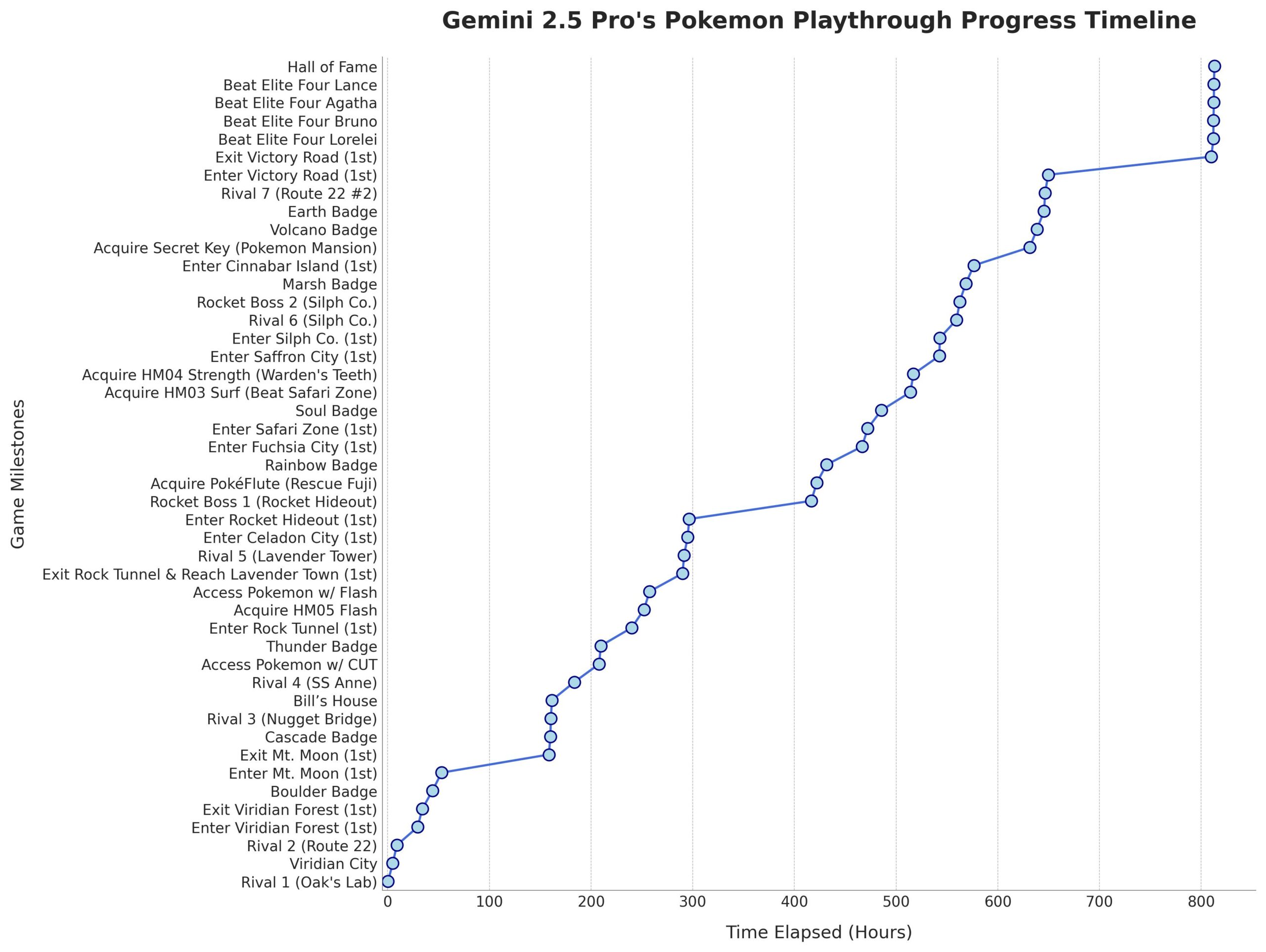

Microsoft lança modelo Phi-4-Mini-Reasoning: A Microsoft lançou o modelo Phi-4-Mini-Reasoning no Hugging Face. Este modelo visa melhorar as capacidades de raciocínio matemático de modelos de linguagem pequenos, impulsionando ainda mais o desenvolvimento de modelos menores e de alto desempenho. (Fonte: _akhaliq)

Modelo Claude da Anthropic suporta pesquisa na web global: A Anthropic anunciou que seu modelo de IA Claude agora oferece funcionalidade de pesquisa na web em escala global para todos os usuários pagantes. Para tarefas simples, o Claude realizará uma pesquisa rápida; para questões complexas, explorará múltiplas fontes de informação, incluindo o Google Workspace, aprimorando as capacidades de aquisição e processamento de informações em tempo real do modelo. (Fonte: Teknium1, Reddit r/ClaudeAI)

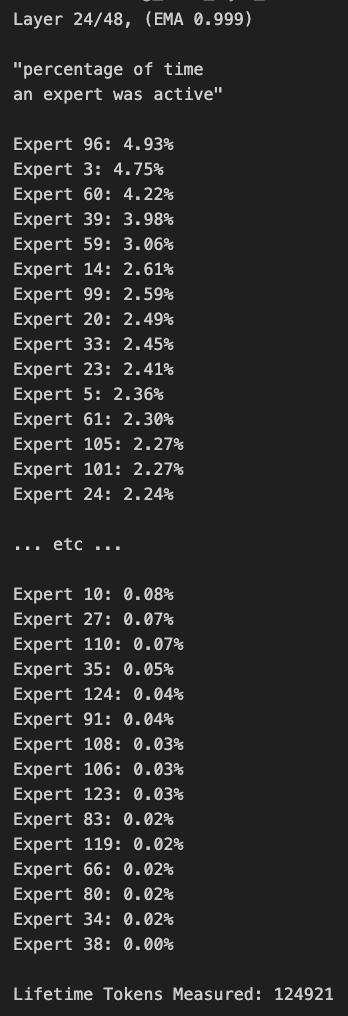

Roteamento do modelo Qwen3 MoE apresenta viés e pode ser podado: O usuário kalomaze analisou e descobriu que a distribuição de roteamento do Qwen3 MoE (Modelo Mixture-of-Experts) apresenta um viés significativo, mesmo o modelo 30B MoE mostrando potencial para poda (pruning). Isso significa que alguns experts podem não estar sendo totalmente utilizados, e a remoção desses experts por meio de poda pode reduzir o tamanho do modelo e a demanda computacional sem afetar significativamente o desempenho. Kalomaze já lançou uma versão baseada nesta descoberta que poda o modelo 30B para 16B e planeja lançar uma versão de 235B podada para 150B. (Fonte: andersonbcdefg, Reddit r/LocalLLaMA)

DeepSeek Prover V2 se destaca entre assistentes matemáticos open source: O DeepSeek Prover V2 é considerado o modelo assistente matemático open source de melhor desempenho atualmente. Embora seu desempenho ainda seja inferior a modelos de código fechado ou mais poderosos como Gemini 2.5 Pro, o4 mini high, o3, Claude 3.7 e Grok 3, ele apresenta bom desempenho em raciocínio estruturado. Usuários acreditam que ele precisa melhorar em sessões de “brainstorming” que exigem pensamento criativo. (Fonte: cognitivecompai)

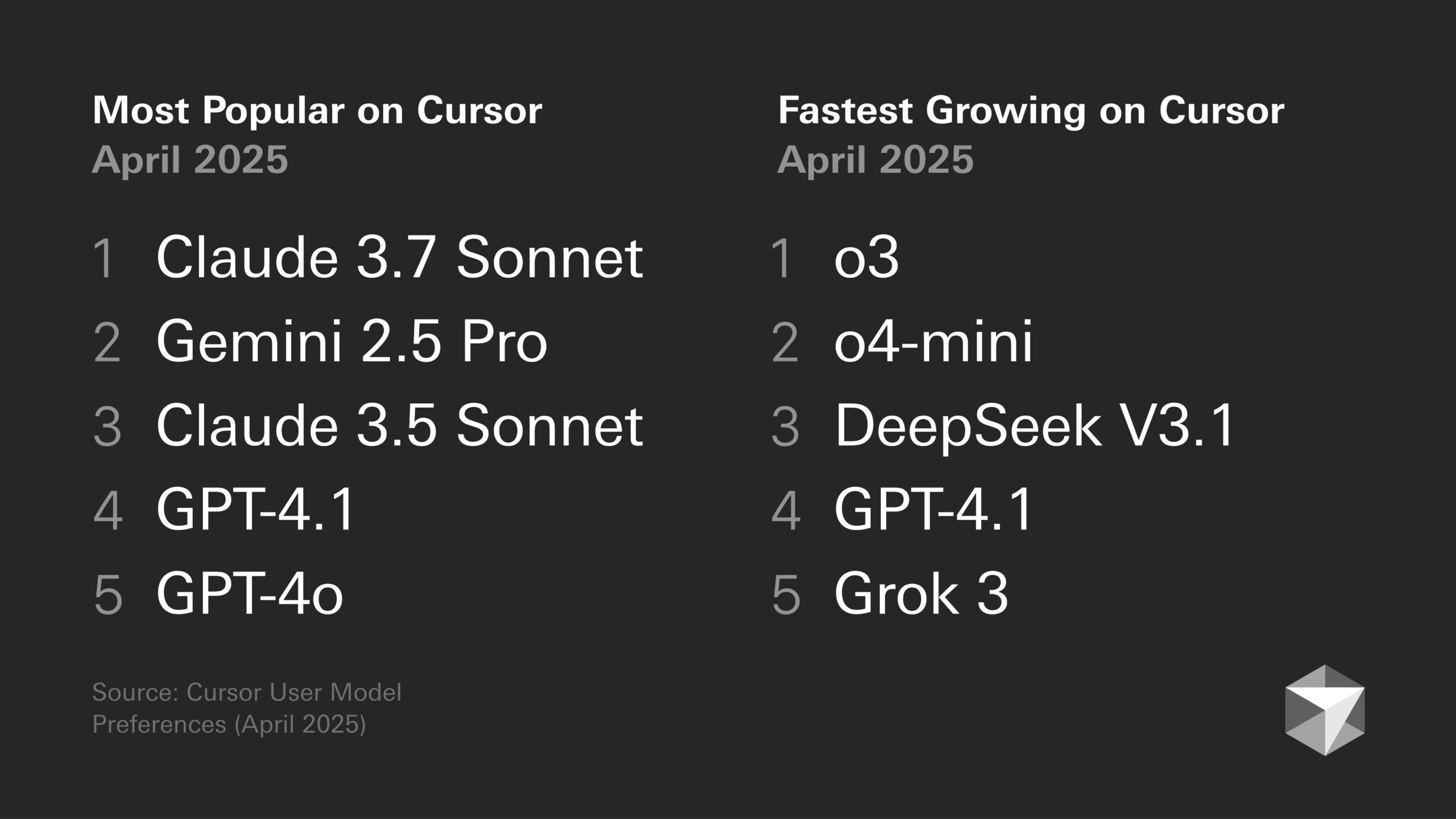

Discussão sobre preferências de modelos: Tendências de desenvolvedores e características específicas de modelos: A discussão sobre os méritos de diferentes modelos grandes continua na comunidade de desenvolvedores. Por exemplo, Sentdex acredita que a combinação de Codex com o3 no Cursor supera o Claude 3.7. VictorTaelin, por outro lado, afirma que, embora o Sonnet 3.7 não seja perfeito (às vezes adiciona conteúdo não solicitado de forma proativa, inteligência abaixo do esperado), na prática, ele ainda oferece resultados mais estáveis e confiáveis do que o GPT-4o (propenso a erros), o3/Gemini (formatação de código e reescrita ruins), R1 (um pouco desatualizado) e Grok 3 (o segundo melhor, mas ligeiramente inferior na prática). Isso reflete a adequação variável de diferentes modelos para tarefas e fluxos de trabalho específicos. (Fonte: Sentdex, VictorTaelin, paul_cal)

Discussão sobre tendências de desempenho de LLMs: Crescimento exponencial ou retornos decrescentes?: Usuários do Reddit discutem se os LLMs ainda estão passando por melhorias exponenciais. Alguns argumentam que, apesar do rápido progresso inicial, o aumento de desempenho dos LLMs está agora tendendo a retornos decrescentes, tornando cada vez mais difícil e caro obter desempenho adicional, semelhante ao desenvolvimento da tecnologia de direção autônoma. Outros usuários refutam, apontando o enorme salto do GPT-3 para o Gemini 2.5 Pro como evidência de que o progresso ainda é significativo e que é muito cedo para declarar um platô. A discussão reflete diferentes expectativas sobre a velocidade futura do desenvolvimento da IA. (Fonte: Reddit r/ArtificialInteligence)

Chips de IA se tornam cruciais para o desenvolvimento de robôs humanoides: A opinião da indústria é que o núcleo dos robôs humanoides reside em seu “cérebro”, ou seja, chips de alto desempenho. O artigo aponta que os robôs humanoides atuais ainda têm deficiências no controle motor (cerebelo) e na tomada de decisão inteligente (cérebro), e o desempenho do chip determina diretamente o nível de inteligência do robô. GPUs da Nvidia, processadores Intel, bem como chips domésticos como Huashan A2000 e Wudang C1236 da Black Sesame Intelligence, estão fornecendo aos robôs capacidades mais fortes de percepção, raciocínio e controle, sendo a chave para impulsionar os robôs humanoides de um conceito para aplicações práticas. (Fonte: 人形机器人,最重要的还是“脑子”)

Ética da IA e antropomorfização: Por que dizemos “obrigado” à IA?: A discussão aponta que, embora a IA não tenha emoções, os usuários tendem a usar linguagem educada (como “obrigado”, “por favor”) com ela. Isso deriva do instinto humano de antropomorfização e da “percepção da presença social”. Pesquisas indicam que interações educadas podem levar a IA a produzir respostas mais alinhadas às expectativas e mais humanizadas. No entanto, isso também traz riscos, como a IA aprender e amplificar vieses humanos, ou ser maliciosamente guiada para gerar conteúdo inadequado. O comportamento educado em relação à IA reflete a complexa psicologia humana e a adaptação social na interação com máquinas cada vez mais inteligentes. (Fonte: 你对 AI 说的每一句「谢谢」,都在烧钱)

🧰 Ferramentas

Funcionalidade Runway Gen-4 References: A funcionalidade Gen-4 References lançada pela RunwayML permite aos usuários incorporar suas próprias imagens ou outras imagens de referência em vídeos ou imagens geradas por IA (como memes). O feedback dos usuários indica que a funcionalidade é eficaz, capaz de lidar com múltiplos personagens consistentes aparecendo na mesma imagem gerada, simplificando o processo de incorporar pessoas ou estilos específicos em criações de IA. (Fonte: c_valenzuelab)

Krea AI lança modelos de geração de imagens: Krea AI adicionou uma nova funcionalidade que transforma prompts comuns de geração de imagens do GPT-4o em modelos. Os usuários só precisam carregar suas próprias imagens e selecionar um modelo para gerar imagens no estilo correspondente, sem a necessidade de inserir manualmente prompts complexos, simplificando o fluxo de trabalho de geração de imagens. (Fonte: op7418)

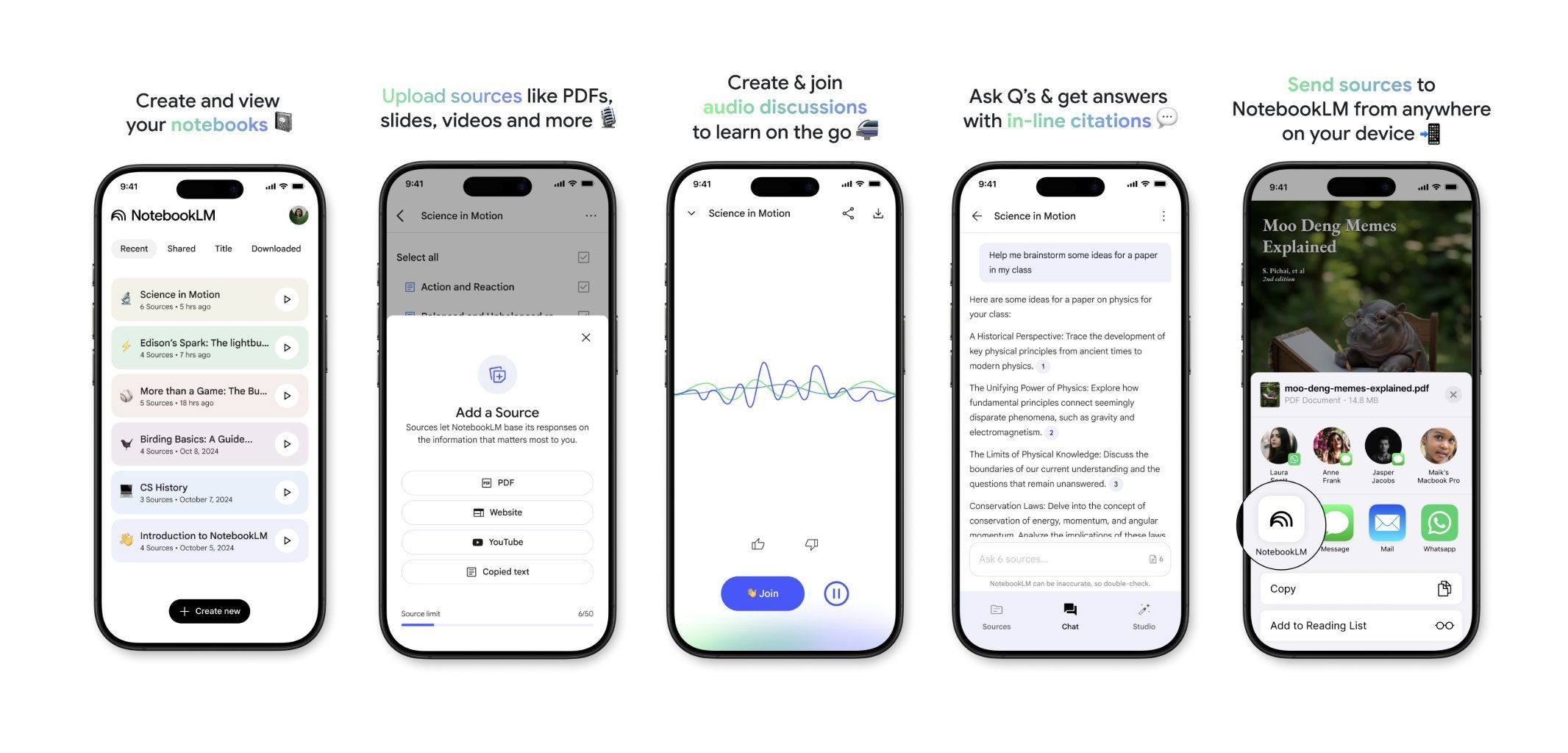

NotebookLM lançará aplicativo móvel em breve: O NotebookLM do Google (anteriormente Project Tailwind) está prestes a lançar um aplicativo móvel. Os usuários poderão encaminhar rapidamente artigos e conteúdos vistos em seus telefones para o NotebookLM para processamento e integração. O registro para a lista de espera do aplicativo já está aberto, visando fornecer uma experiência mais conveniente de gerenciamento de informações móveis e aprendizado assistido por IA. (Fonte: op7418)

Runway para design de interiores: Usuários demonstraram o uso da IA Runway para design de interiores. Ao fornecer uma imagem de um espaço e uma imagem de referência representando estilo/humor, a Runway é capaz de gerar renderizações de design de interiores que fundem as características de ambos, mostrando o potencial da IA no campo do design criativo. (Fonte: c_valenzuelab)

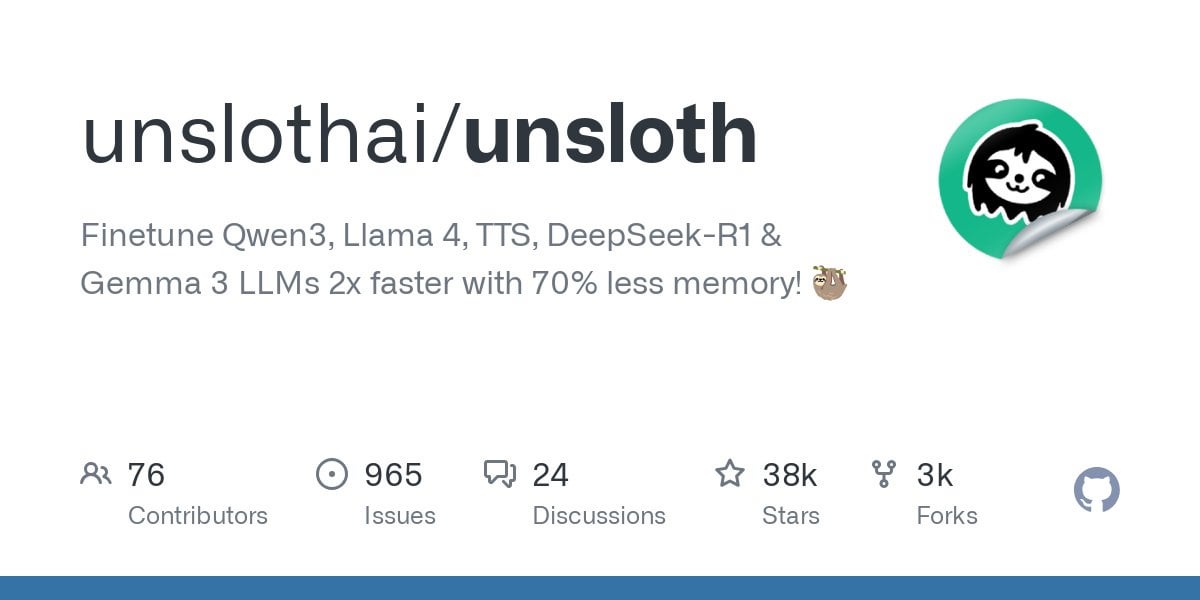

Unsloth suporta fine-tuning do modelo Qwen3: Unsloth anunciou suporte para fine-tuning da série de modelos Qwen3, com velocidade 2x maior e uso de VRAM 70% menor. Os usuários podem realizar fine-tuning com um comprimento de contexto 8x maior que o Flash Attention 2 em uma GPU com 24GB de VRAM. Forneceu um notebook Colab para fine-tuning gratuito do modelo Qwen3 14B e carregou vários modelos quantizados, incluindo GGUF. Isso reduz a barreira de hardware para o fine-tuning de modelos avançados. (Fonte: Reddit r/LocalLLaMA)

Funcionalidade Claude AI Styles: Usuários compartilharam o uso da funcionalidade Styles do Claude AI para melhorar a experiência de colaboração com a IA. Ao criar um estilo chamado “Iterative Engineering”, definindo etapas de discussão, planejamento, modificação em pequenos passos, teste, iteração e refatoração conforme necessário, é possível guiar o Claude a codificar de forma mais metódica e incremental, evitando que ele reescreva excessivamente o código e aumentando a utilidade da IA como parceiro de programação. (Fonte: Reddit r/ClaudeAI)

Deepwiki fornece fontes de blocos de código: O usuário cto_junior mencionou que uma vantagem do Deepwiki é que ele exibe o bloco de código fonte ao lado de cada resposta, em vez de apenas anexar links. Essa prática aumenta a credibilidade da informação, especialmente útil para engenheiros de desenvolvimento de software (SDEs) céticos em relação às ferramentas de IA. (Fonte: cto_junior)

📚 Aprendizado

NousResearch lança atualização do framework Atropos RL: O framework de ambiente de Aprendizagem por Reforço (RL) Atropos da NousResearch foi atualizado. A nova funcionalidade permite aos usuários testar rápida e facilmente o rollout de ambientes RL, sem a necessidade de treinamento ou motor de inferência. Por padrão, usa a API da OpenAI, mas pode ser configurado para outros provedores de API (ou endpoints locais VLLM/SGLang). Após o teste, é gerado um relatório web contendo as conclusões (completions) e suas pontuações, e suporta registro no wandb, facilitando a depuração e avaliação de ambientes RL. (Fonte: Teknium1)

Lançamento do conjunto de dados de benchmark RAG personalizado EnronQA: Pesquisadores lançaram o conjunto de dados EnronQA, visando impulsionar a pesquisa em Geração Aumentada por Recuperação Personalizada (Personalized RAG) em documentos privados. O conjunto de dados contém 103.638 e-mails e 528.304 pares de perguntas e respostas de alta qualidade para 150 usuários, fornecendo recursos para avaliar e desenvolver sistemas RAG capazes de entender e utilizar informações específicas do indivíduo. (Fonte: lateinteraction)

Lançamento do GTE-ModernColBERT (PyLate): LightOnAI lançou o GTE-ModernColBERT (PyLate), um recuperador MaxSim de 128 dimensões, baseado no gte-modernbert-base e com fine-tuning no ms-marco-en-bge-gemma. Ele suporta nativamente a biblioteca PyLate, permitindo reordenação e indexação HNSW. Apresentou excelente desempenho no benchmark NanoBEIR e superou o ColBERT-small na pontuação média do BEIR, oferecendo novas opções eficientes de recuperação de texto. (Fonte: lateinteraction)

SOLO Bench – Novo benchmark para LLMs: O usuário jd_3d desenvolveu e lançou o SOLO Bench, um novo método de benchmark para LLMs. O teste exige que o LLM gere texto contendo um número específico de frases (por exemplo, 250 ou 500), onde cada frase deve conter exatamente uma palavra de uma lista pré-definida (contendo substantivos, verbos, adjetivos, etc.), e cada palavra só pode ser usada uma vez. A avaliação é feita por meio de um script baseado em regras, visando testar a capacidade do LLM de seguir instruções, satisfazer restrições e gerar textos longos. Resultados preliminares mostram que o benchmark distingue efetivamente o desempenho de diferentes modelos. (Fonte: Reddit r/LocalLLaMA)

Manipulando o espaço latente com reflexão recursiva estratégica: Um usuário propõe um método para criar hierarquias de raciocínio aninhadas no espaço latente de LLMs através de “reflexão recursiva estratégica” (Strategic recursive reflection, RR). Ao solicitar que o modelo reflita sobre interações anteriores em momentos chave, geram-se ciclos metacognitivos, construindo “mini espaços latentes”. Cada prompt é visto como uma pressão que guia o caminho do modelo no espaço latente, tornando-o mais autorreferencial e abstrato. Isso é considerado uma simulação do processo humano de aprofundar o pensamento através da reflexão sobre ideias, visando explorar conceitos mais profundos. (Fonte: Reddit r/ArtificialInteligence)

💼 Negócios

Google paga à Samsung para pré-instalar Gemini AI: Após ser condenado no ano passado por violar leis antitruste devido ao acordo de motor de busca padrão, foi revelado que o Google paga mensalmente “quantias enormes” e uma porcentagem da receita à Samsung para pré-instalar o Gemini AI nos dispositivos Samsung, e pode exigir que parceiros forcem a pré-instalação do Gemini. Isso explica por que a série Samsung Galaxy S25 integra profundamente o Gemini, chegando a defini-lo como assistente de IA padrão. A medida reflete a estratégia do Google de garantir rapidamente a entrada no mercado de IA móvel, dada a insuficiência de seus próprios canais de hardware, mas também pode levantar novamente preocupações antitruste. (Fonte: 三星手机预装Gemini AI,也是谷歌花钱买的)

Startups de IA enfrentam desafios: Uma discussão no Reddit aponta que muitas startups de IA podem carecer de vantagens competitivas (“moats”), pois as capacidades dos modelos convergem e a lealdade do usuário é baixa. Grandes empresas de tecnologia (Google, Microsoft, Apple) têm mais facilidade em alcançar usuários devido às vantagens de seus ecossistemas (como pré-instalação, integração). Mesmo que o modelo de uma startup seja ligeiramente melhor, os usuários podem preferir usar a IA padrão ou integrada que seja “boa o suficiente”. Isso levanta preocupações sobre a viabilidade a longo prazo das startups de IA e as perspectivas de investimento de VC. (Fonte: Reddit r/ArtificialInteligence)

Resumo semanal de financiamento e notícias de negócios em IA (2 de maio de 2025): CEO da Microsoft revela que IA já escreveu “partes significativas” do código da empresa; CFO da Microsoft alerta que serviços de IA podem ser interrompidos devido à alta demanda; Google começa a exibir anúncios em chatbots de IA de terceiros; Meta lança aplicativo de IA independente; Cast AI levanta $108M, Astronomer levanta $93M, Edgerunner AI levanta $12M; Pesquisa acusa LM Arena de manipulação de benchmarks; Nvidia desafia o apoio da Anthropic aos controles de exportação de chips. (Fonte: Reddit r/artificial)

🌟 Comunidade

Discussão sobre qualidade e custo do conteúdo gerado por IA: A comunidade expressa preocupação com a qualidade variável do conteúdo gerado por IA (chamado de “slop”). O usuário wordgrammer aponta que muitos vídeos gerados por IA têm baixa qualidade e o custo real (considerando triagem e novas tentativas) é muito maior do que o preço anunciado. Isso levanta discussões sobre o design de modelos (como jam3scampbell citando Steve Jobs) e o uso eficaz de ferramentas de IA, enfatizando a necessidade de controle mais refinado e padrões de qualidade de geração mais altos. (Fonte: wordgrammer, jam3scampbell, willdepue)

Desempenho da IA em tarefas específicas gera discussão: Membros da comunidade discutem o desempenho e as limitações da IA em diferentes tarefas. Por exemplo, DeepSeek R1 é considerado por alguns como um possível pico do hype dos LLMs; apesar dos avanços em áreas como matemática formal e medicina, ainda não atraiu a atenção generalizada dos usuários comuns. DeepSeek Prover V2 tem bom desempenho em matemática, mas é considerado carente de criatividade. O usuário vikhyatk questiona o significado de otimizar excessivamente modelos para benchmarks específicos como o AIME (American Invitational Mathematics Examination), argumentando que o público em geral não se importa com habilidades matemáticas. Essas discussões refletem a reflexão sobre os limites das capacidades da IA e seu valor prático. (Fonte: wordgrammer, cognitivecompai, vikhyatk)

IA auxiliando criatividade e design: A comunidade mostra várias maneiras de usar ferramentas de IA para design criativo. Usuários utilizam a funcionalidade Gen-4 References da Runway para se inserir em memes; usam a Runway para geração de conceitos de design de interiores; utilizam GPT-4o e modelos de prompt para criar imagens com estilos específicos (como tigre de origami do sul da China, apoio de pulso de silicone em forma de animal, incorporar o significado de palavras no design de letras). Esses casos demonstram o potencial da IA na criatividade visual e no design personalizado. (Fonte: c_valenzuelab, c_valenzuelab, dotey, dotey, dotey)

Questionamento sobre a capacidade da IA de imitar estilos de escrita: O usuário nrehiew_ argumenta que a instrução para um LLM “continuar escrevendo no meu tom e estilo” pode não ter efeito prático, pois a maioria das pessoas superestima a singularidade de seu próprio estilo de escrita. Isso levanta discussões sobre a capacidade dos LLMs de entender e replicar estilos de escrita sutis, bem como a percepção enviesada dos usuários sobre essa capacidade. (Fonte: nrehiew_)

Uso de IA para apoio emocional gera empatia e discussão: Usuários do Reddit compartilham experiências de obter apoio emocional e até ajuda para lidar com crises conversando com IAs como o ChatGPT. Muitos afirmam que, em momentos de solidão, necessidade de desabafar ou enfrentando dificuldades psicológicas, a IA oferece um interlocutor sem julgamento, paciente e sempre disponível, às vezes sentindo que é mais eficaz do que conversar com humanos. Isso gera discussões sobre o papel da IA no apoio à saúde mental, ao mesmo tempo que enfatiza que a IA não pode substituir a ajuda humana profissional e a necessidade de estar alerta aos possíveis vieses ou desinformação que a IA pode trazer. (Fonte: Reddit r/ChatGPT, Reddit r/ClaudeAI)

Divergência de opiniões sobre arte gerada por IA: Usuários discutem o impacto potencial da arte gerada por IA na percepção de artistas humanos e suas obras. Alguns reclamam que trabalhos de alta qualidade agora são frequentemente atribuídos levianamente à IA, ignorando o talento e esforço do criador. Esse fenômeno está até começando a distorcer a percepção das pessoas, fazendo-as tender a procurar “erros humanos” nas obras para confirmar que não são criações de IA. A discussão também aborda se o conteúdo gerado por IA deveria ser obrigatoriamente marcado com uma marca d’água. (Fonte: Reddit r/ArtificialInteligence)

💡 Outros

Consumo de recursos pela IA chama atenção: A discussão enfatiza o enorme consumo de recursos por trás do desenvolvimento da IA. Treinar e operar grandes modelos de IA consome grandes quantidades de eletricidade e água, com data centers se tornando novas instalações de alto consumo energético. Cada interação do usuário com a IA, incluindo um simples “obrigado”, acumula consumo de energia. Isso levanta preocupações sobre o desenvolvimento sustentável da IA e a atenção a soluções energéticas (como fusão nuclear). (Fonte: 你对 AI 说的每一句「谢谢」,都在烧钱)

Distância entre IA e consciência: Usuários do Reddit discutem se a IA atual possui autoconsciência. A opinião predominante é que a IA atual (como LLMs) é essencialmente um sistema complexo de correspondência de padrões baseado na previsão probabilística de palavras, carecendo de verdadeira compreensão e autoconsciência, estando muito longe de possuir tal capacidade. No entanto, alguns comentários apontam que a própria consciência humana não é totalmente compreendida, que a comparação pode ter falhas e que as capacidades sobre-humanas da IA em tarefas específicas não devem ser ignoradas. (Fonte: Reddit r/ArtificialInteligence)

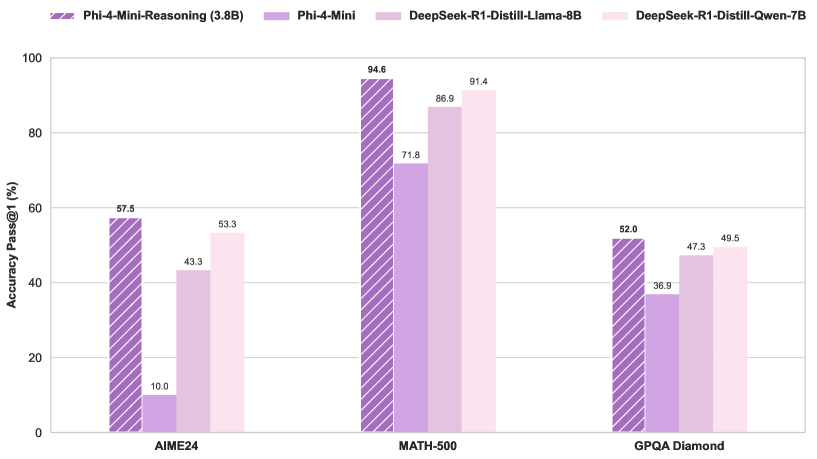

Tablet Windows rodando modelo MoE grande: Um usuário demonstrou a execução do modelo Qwen3 235B-A22B MoE (usando quantização Q2_K_XL) em um tablet Windows equipado com AMD Ryzen AI Max 395+ e 128GB de RAM, usando apenas a iGPU (Radeon 8060S, com 87.7GB dos 95.8GB alocados como VRAM), atingindo uma velocidade de aproximadamente 11.1 t/s. Isso demonstra a possibilidade de rodar modelos extremamente grandes em dispositivos portáteis, embora a largura de banda da memória continue sendo um gargalo. (Fonte: Reddit r/LocalLLaMA)