Palavras-chave:Interface de interação LLM, Debate AGI, Estratégia do aplicativo Gemini, Ética de companheiros de IA, Modelo Qwen3, Tecnologia RAG, Arquitetura alternativa Transformer, Lançamento de modelos de IA, Interface de interação visual Karpathy, Elementos centrais do Agentic RAG, Arquitetura Liquid Foundation Models, Método de treinamento Phi-4-Reasoning, Engenharia reversa de prompts do sistema NotebookLM

🔥 Foco

Visão de Karpathy sobre a futura interface de interação com LLMs: Karpathy prevê que a interação futura com LLMs transcenderá o atual modo de terminal de texto, evoluindo para interfaces de tela 2D visuais, generativas e interativas. Essas interfaces serão geradas instantaneamente de acordo com as necessidades do usuário, integrando múltiplos elementos como imagens, gráficos, animações, etc., proporcionando uma experiência mais densa em informações e mais intuitiva, semelhante ao retratado em obras de ficção científica como “Homem de Ferro”. Ele acredita que os atuais Markdown, blocos de código, etc., são apenas protótipos iniciais (Fonte: karpathy)

Intenso debate sobre se a AGI é um marco crucial: Arvind Narayanan e Sayash Kapoor publicaram um artigo no AI Snake Oil, explorando profundamente o conceito de AGI (Inteligência Artificial Geral), argumentando que não é um marco tecnológico claro ou um ponto de inflexão. O artigo argumenta de múltiplas perspectivas, incluindo impacto econômico (a difusão leva tempo), geopolítica (capacidade não equivale a poder), riscos (distinguir capacidade de poder) e dilemas de definição (julgamento retrospectivo), que mesmo atingindo um certo limiar de capacidade de AGI, não desencadeará imediatamente efeitos econômicos ou sociais disruptivos. A atenção excessiva à AGI pode desviar a atenção dos problemas reais atuais da IA (Fonte: random_walker, random_walker, random_walker, random_walker, random_walker)

Diretor do Google DeepMind explica a estratégia do Gemini App: Demis Hassabis retweetou e endossou a explicação de Josh Woodward sobre a estratégia futura do Gemini App. A estratégia gira em torno de três pilares: Personalização (Personal), fornecendo serviços que entendem melhor o usuário através da integração de dados do ecossistema Google do usuário (Gmail, Photos, etc.); Proatividade (Proactive), antecipando necessidades e oferecendo insights e sugestões de ação antes que o usuário pergunte; Capacidade Poderosa (Powerful), utilizando modelos do DeepMind (como o 2.5 Pro) para pesquisa, orquestração e geração de conteúdo multimodal. O objetivo é criar um assistente pessoal de IA poderoso que pareça uma extensão do usuário (Fonte: demishassabis)

Desenvolvimento de companheiros de IA pela Meta gera discussões éticas e sociais: Mark Zuckerberg mencionou em uma entrevista que a Meta está desenvolvendo amigos/companheiros de IA para atender às necessidades sociais das pessoas (mencionando que “o americano médio tem 3 amigos, mas a necessidade é de 15”). Este plano gerou ampla discussão: por um lado, pode oferecer consolo para pessoas solitárias; por outro, levanta preocupações sobre se isso erodirá ainda mais a interação social real, agravará a atomização social e questões de privacidade de dados (Fonte: Reddit r/artificial, dwarkesh_sp, nptacek)

🎯 Tendências

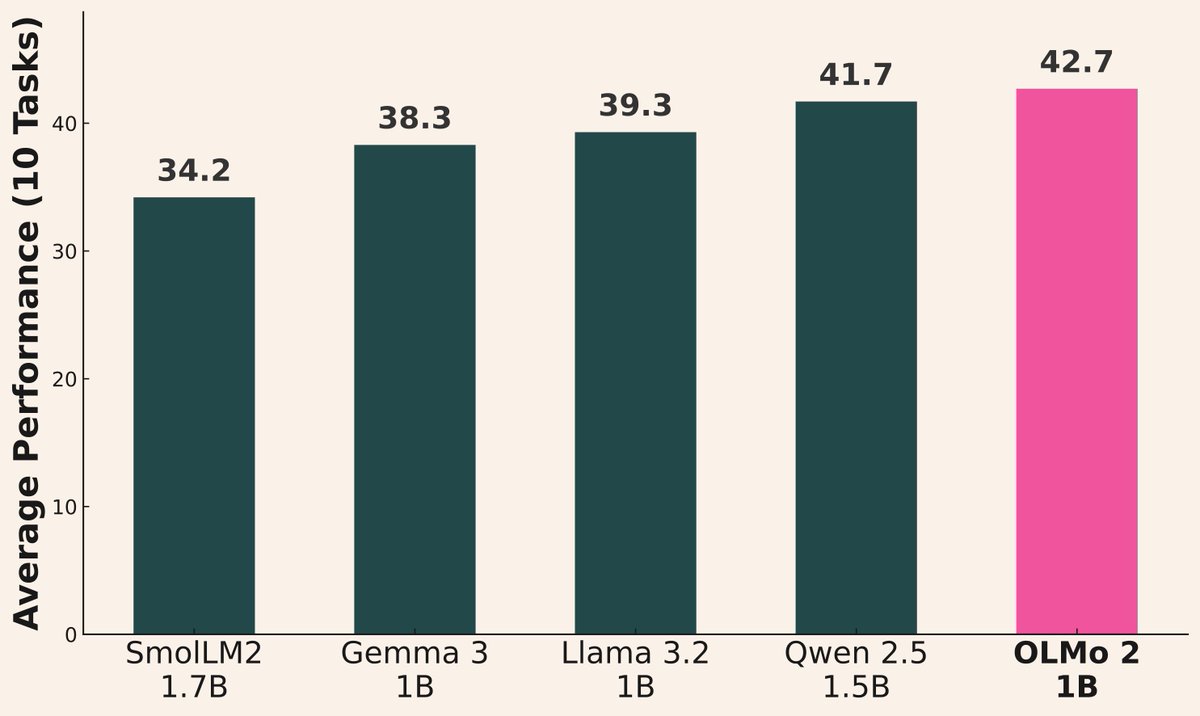

Onda de lançamentos de modelos de IA continua: Recentemente, várias instituições lançaram novos modelos: Alibaba lançou a série Qwen3 (incluindo 0.6B a 235B MoE); AI2 lançou o modelo OLMo 2 1B, com desempenho superior ao Gemma 3 1B e Llama 3.2 1B; Microsoft lançou a série Phi-4 (Mini 3.8B, Reasoning 14B); DeepSeek lançou o Prover V2 671B MoE; Xiaomi lançou o MiMo 7B; Kyutai lançou o Helium 2B; JetBrains lançou o modelo de completação de código Mellum 4B. A capacidade dos modelos da comunidade open-source continua a melhorar rapidamente (Fonte: huggingface, teortaxesTex, finbarrtimbers, code_star, scaling01, ClementDelangue, tokenbender, karminski3)

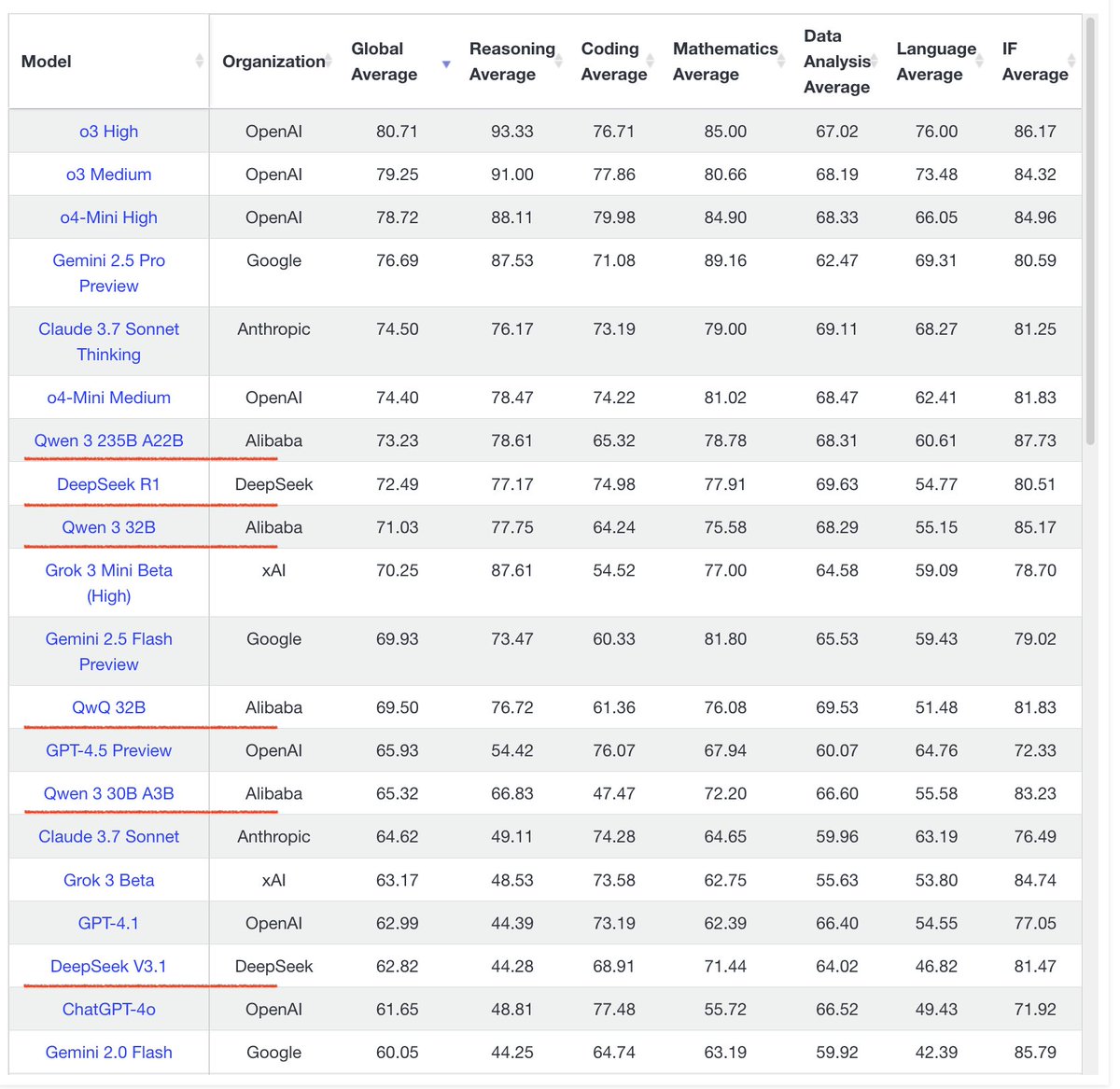

Série de modelos Qwen3 apresenta desempenho notável: O feedback da comunidade indica que o desempenho da série de modelos Qwen3 é excelente. O Qwen3 32B é considerado ao nível do o3-mini, mas com custo menor; o Qwen3 4B demonstra excelente desempenho em testes específicos (como contar os ‘R’ em “strawberry”) e tarefas de RAG, sendo até usado por usuários para substituir o Gemini 2.5 Pro; o modelo 30B MoE se destaca na tradução multilíngue (incluindo dialetos). Alguns usuários observaram que o Qwen3 235B MoE admite seus limites de conhecimento quando não consegue responder, em vez de inventar à força, o que pode indicar melhorias no tratamento de alucinações (Fonte: scaling01, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, teortaxesTex, scaling01)

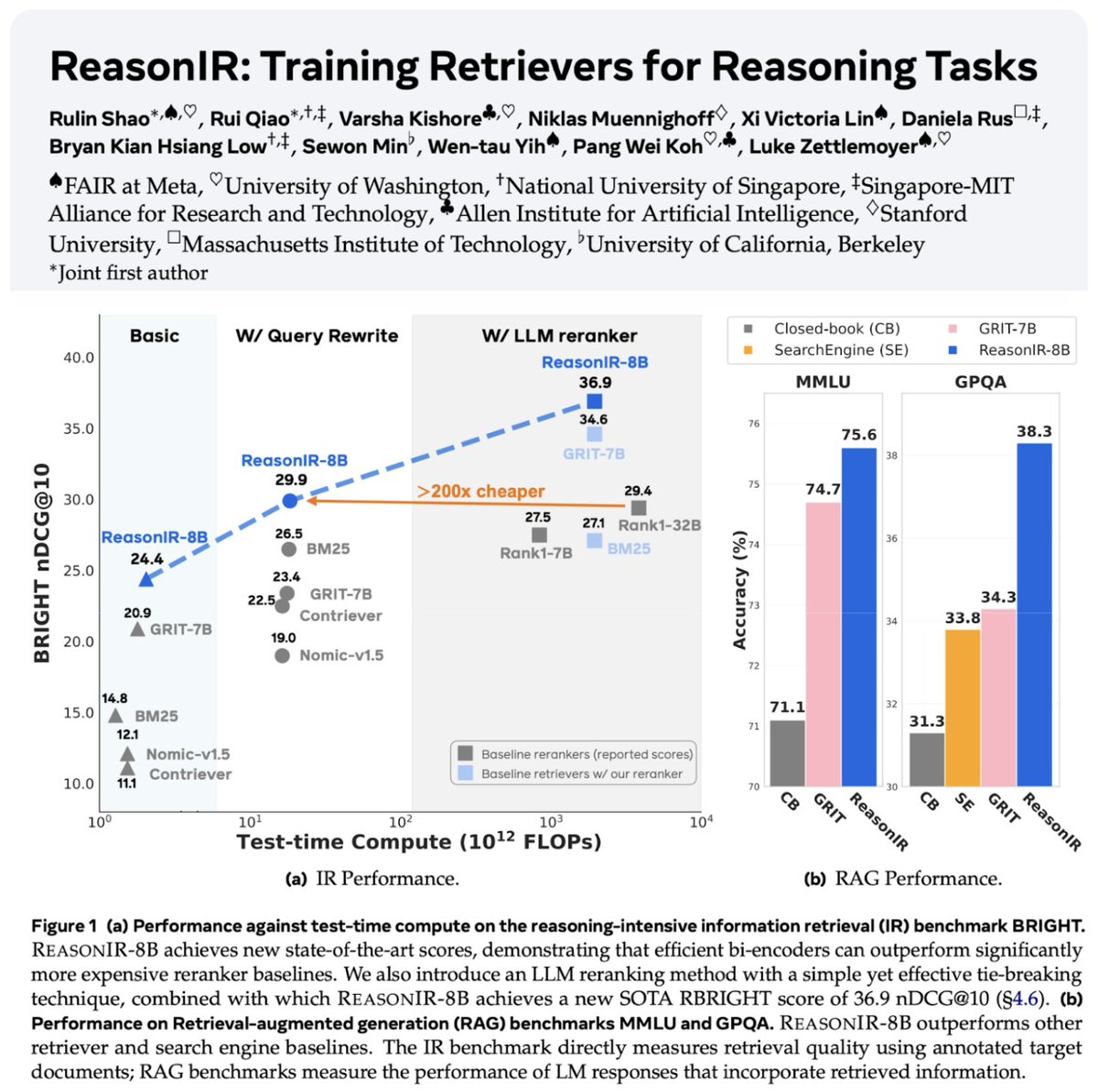

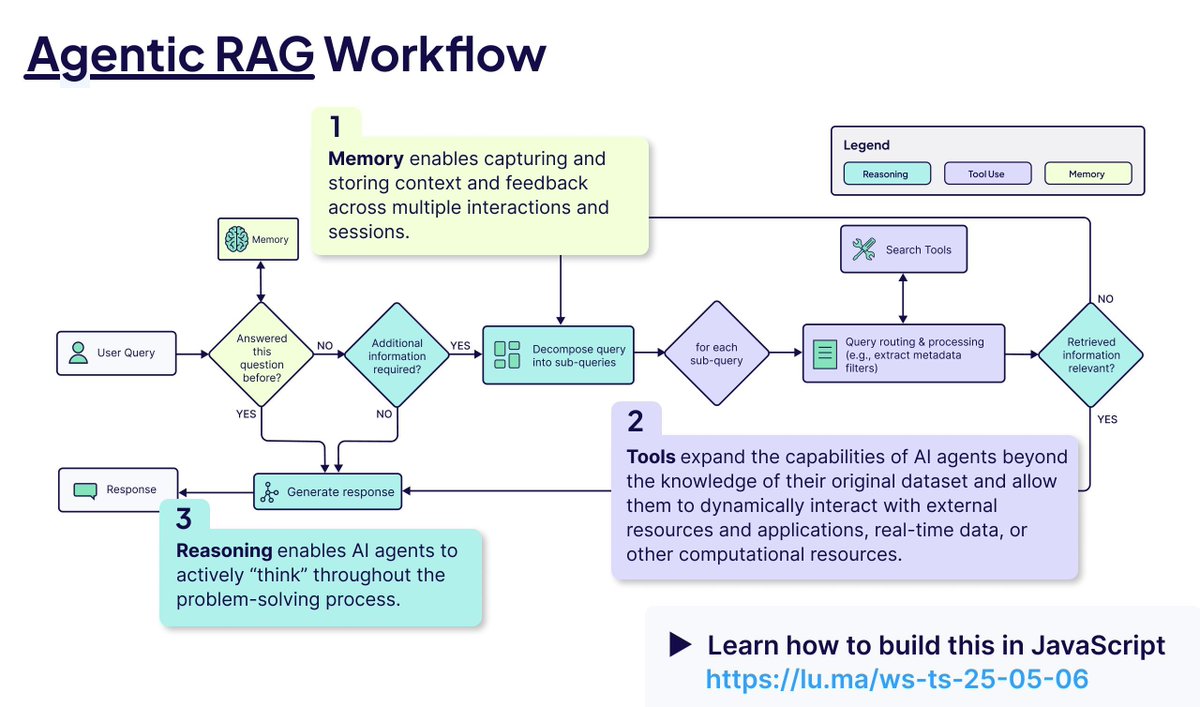

Tecnologias de recuperação e RAG continuam a evoluir: ReasonIR-8B foi lançado, sendo o primeiro recuperador treinado especificamente para tarefas de raciocínio, alcançando SOTA em benchmarks relevantes. O conceito de Agentic RAG é enfatizado, cujo núcleo reside na utilização de memória (curto e longo prazo), chamada de ferramentas e raciocínio (planejamento, reflexão) para aprimorar o processo de RAG. Um usuário realizou testes comparativos de LLMs locais (Qwen3, Gemma3, Phi-4) em tarefas de Agentic RAG, descobrindo que o Qwen3 teve um desempenho relativamente bom (Fonte: Tim_Dettmers, Muennighoff, bobvanluijt, Reddit r/LocalLLaMA)

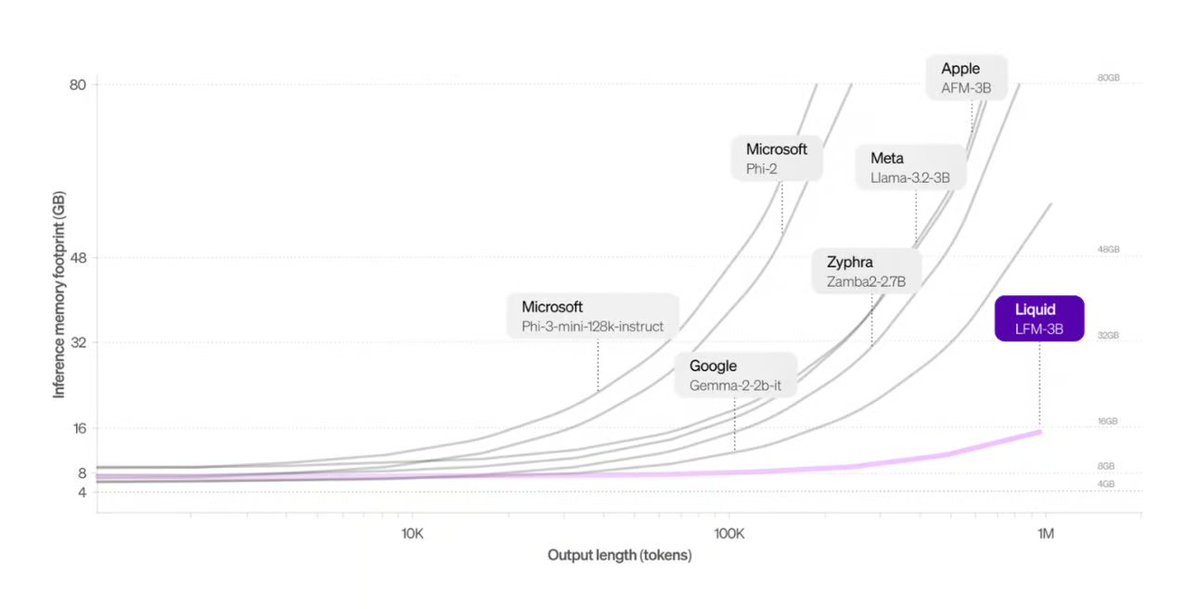

Liquid AI lança arquitetura alternativa ao Transformer: Os Liquid Foundation Models (LFMs) propostos pela Liquid AI e seu modelo Hyena Edge são apresentados como potenciais alternativas à arquitetura Transformer. Os LFMs são baseados em sistemas dinâmicos, visando melhorar a eficiência no processamento de entradas contínuas e dados de sequência longa, especialmente em termos de eficiência de memória e velocidade de inferência, e já foram testados em hardware real (Fonte: TheTuringPost, Plinz, maximelabonne)

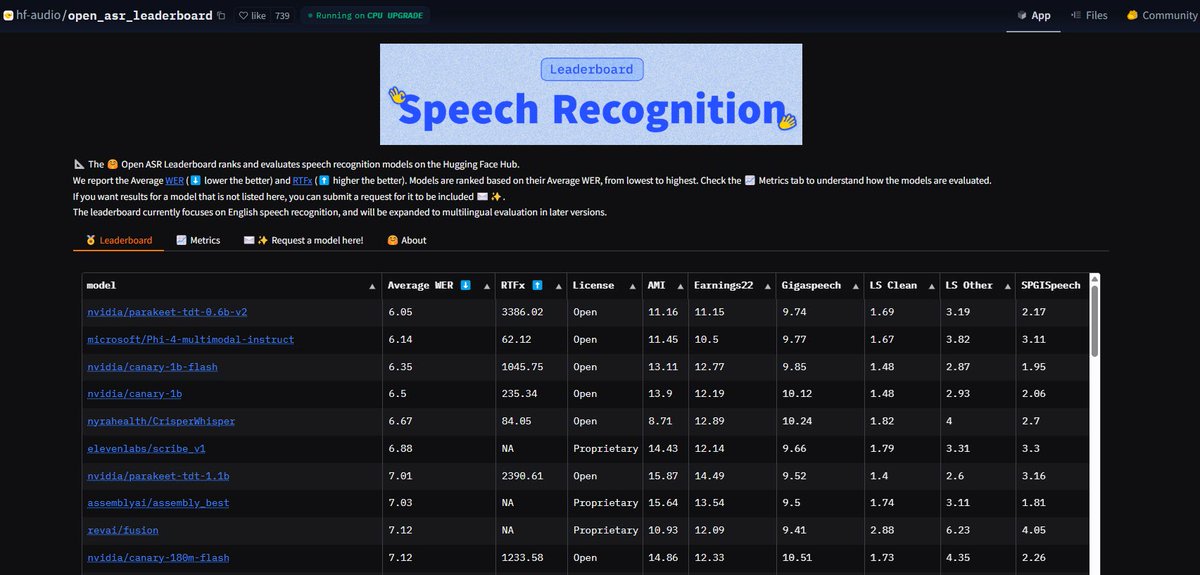

Modelo NVIDIA Parakeet ASR quebra recordes: O modelo de reconhecimento automático de fala (ASR) Parakeet-tdt-0.6b-v2 lançado pela NVIDIA alcançou o melhor nível da indústria no Open-ASR-Leaderboard do Hugging Face com uma taxa de erro de palavra (WER) de 6.05%. Este modelo não só tem alta precisão e velocidade de inferência rápida (RTFx 3386), mas também possui funções inovadoras como transcrição de música para letra, timestamp preciso / formatação de números (Fonte: huggingface, ClementDelangue)

Modo AI da Pesquisa Google totalmente aberto para usuários dos EUA: O Google anunciou que o Modo AI em seu produto de pesquisa removeu a lista de espera, abrindo-o para todos os usuários do Labs na região dos EUA. Ao mesmo tempo, novas funcionalidades foram adicionadas para ajudar os usuários a concluir tarefas como compras, planejamento da vida local, etc., integrando ainda mais as capacidades de IA na experiência de pesquisa principal (Fonte: Google)

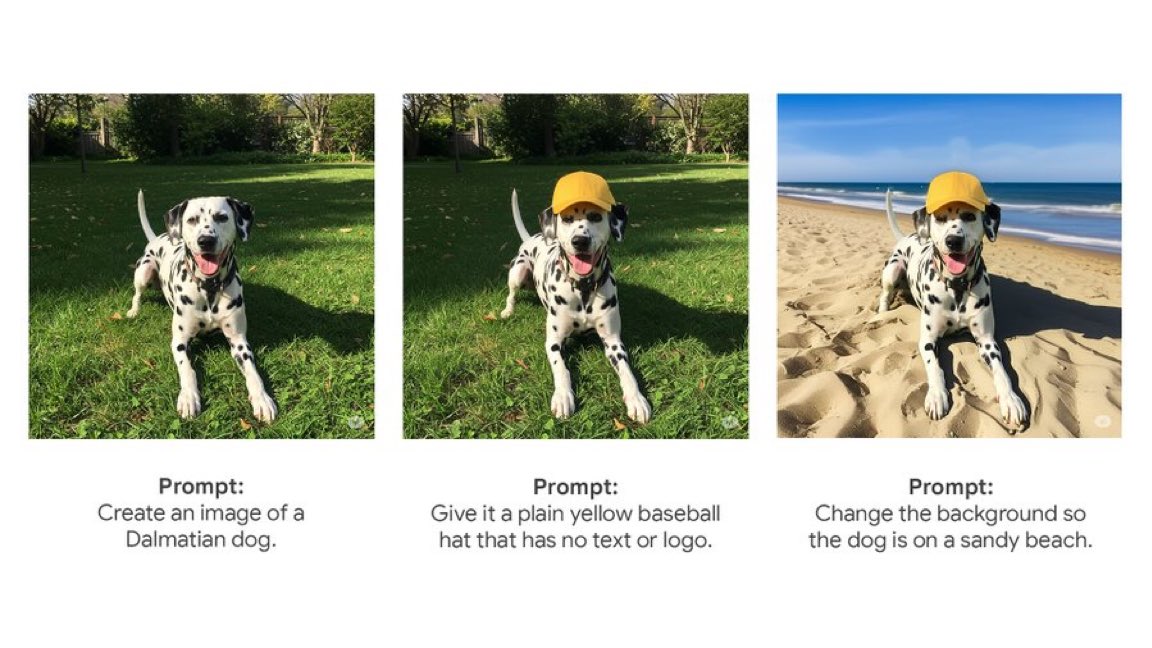

Gemini App lança função nativa de edição de imagem: O Gemini App do Google começou a lançar a função nativa de edição de imagem para os usuários. Isso significa que os usuários podem modificar imagens diretamente dentro do aplicativo Gemini, aprimorando sua capacidade de interação multimodal e permitindo que os usuários concluam mais tarefas relacionadas a imagens em uma interface unificada (Fonte: m__dehghani)

Modelo Meta SAM 2.1 capacita nova função de edição de imagem: A Meta publicou um blog apresentando como sua mais recente tecnologia Segment Anything Model (SAM) 2.1 suporta a função Cutouts (recorte) no novo aplicativo Edits do Instagram. Isso demonstra como a pesquisa de modelos fundamentais pode ser rapidamente traduzida em recursos de produtos voltados para o consumidor, elevando o nível de inteligência na edição de imagens (Fonte: AIatMeta)

Função Claude Code integrada na assinatura Max: A Anthropic anunciou que sua função de processamento de código e uso de ferramentas, Claude Code, agora está incluída no plano de assinatura Claude Max, e os usuários não precisam pagar taxas adicionais de Token para usá-la. No entanto, usuários da comunidade apontam que o limite de chamadas de API incluído na assinatura Max (como 225 chamadas/5 horas) pode se esgotar rapidamente para cenários que usam ferramentas com frequência (cada chamada consome 2 chamadas de API) (Fonte: dotey, vikhyatk)

CISCO lança LLM dedicado à segurança cibernética: A CISCO lançou o modelo Foundation-Sec-8B continuando o pré-treinamento do Llama 3.1 8B em um corpus selecionado de textos de segurança cibernética (incluindo inteligência de ameaças, bancos de dados de vulnerabilidades, documentos de resposta a incidentes e padrões de segurança). O modelo visa aprofundar a compreensão de conceitos, terminologia e práticas em vários domínios de segurança, sendo mais um exemplo da aplicação de LLMs em setores verticais (Fonte: reach_vb)

🧰 Ferramentas

Transformer Lab: Plataforma de experimentação de LLM local: Aplicativo de desktop open-source que suporta interação, treinamento, fine-tuning (suporta MLX/Apple Silicon, Huggingface/GPU, DPO/ORPO, etc.) e avaliação de LLMs no próprio computador do usuário. Oferece funções como download de modelos, RAG, construção de datasets, API, etc., compatível com Windows, MacOS, Linux (Fonte: transformerlab/transformerlab-app)

Runway Gen-4 References: Poderosa ferramenta de geração de referência de imagem: A função Gen-4 References do Runway demonstra sua poderosa capacidade de geração e edição de imagens. Os usuários podem utilizar imagens de referência, combinadas com prompts de texto, para gerar personagens, visões de mundo, adereços de jogos, elementos de design gráfico com estilo consistente, e até mesmo aplicar o estilo de uma cena à decoração de outro cômodo, mantendo a estrutura e a iluminação consistentes (Fonte: c_valenzuelab, c_valenzuelab, c_valenzuelab, c_valenzuelab, c_valenzuelab)

Gradio integra protocolo MCP, abrindo conexão com LLMs: O Gradio foi atualizado para suportar o protocolo de contexto de modelo (MCP), permitindo que aplicativos de IA construídos com Gradio (como texto para fala, processamento de imagem, etc.) sejam facilmente convertidos em servidores MCP e conectados a clientes LLM que suportam MCP, como Claude e Cursor. Isso expande enormemente a capacidade de chamada de ferramentas dos LLMs, com potencial para conectar centenas de milhares de aplicativos de IA no Hugging Face ao ecossistema LLM (Fonte: _akhaliq, ClementDelangue, swyx, ClementDelangue)

LangChain Agent Chat UI suporta Artifacts: A UI do Agent Chat do LangChain adicionou suporte para Artifacts (componentes). Isso permite renderizar componentes de UI gerados por IA (como gráficos, elementos interativos, etc.) fora da interface de chat, combinados com streaming, para criar experiências de usuário interativas mais ricas que vão além das bolhas de chat tradicionais (Fonte: hwchase17, Hacubu, LangChainAI)

Framework MNN do Alibaba: Implantação de LLM e Diffusion em dispositivos: O MNN do Alibaba é um framework leve de deep learning, cujos componentes MNN-LLM e MNN-Diffusion se concentram na execução eficiente de modelos de linguagem grandes (como Qwen, Llama) e modelos Stable Diffusion em dispositivos móveis, PCs e IoT. O projeto fornece exemplos completos de aplicativos LLM multimodais para Android e iOS (Fonte: alibaba/MNN)

Perplexity lança bot de verificação de fatos no WhatsApp: A Perplexity AI agora permite que os usuários encaminhem mensagens do WhatsApp para seu número dedicado (+1 833 436 3285) para obter rapidamente resultados de verificação de fatos. Isso é muito útil para verificar informações potencialmente enganosas que circulam amplamente em chats de grupo (Fonte: AravSrinivas)

Navegador Brave usa IA para combater pop-ups de cookies: O navegador Brave lançou uma nova ferramenta chamada Cookiecrumbler, que utiliza IA e feedback da comunidade para detectar e bloquear automaticamente pop-ups de notificação de consentimento de cookies em páginas da web. O objetivo é melhorar a experiência de navegação do usuário e a proteção da privacidade, reduzindo as interrupções (Fonte: Reddit r/artificial )

Braço robótico open-source SO-101 lançado: O TheRobotStudio lançou o design do braço robótico aberto padrão SO-101, como a próxima geração do SO-100. Melhorou a fiação, simplificou a montagem e atualizou o motor do braço principal. O design visa funcionar em conjunto com a biblioteca open-source LeRobot, promovendo a acessibilidade da IA robótica de ponta a ponta. Oferece guias DIY e opções de compra de kits (Fonte: TheRobotStudio/SO-ARM100)

📚 Aprendizado

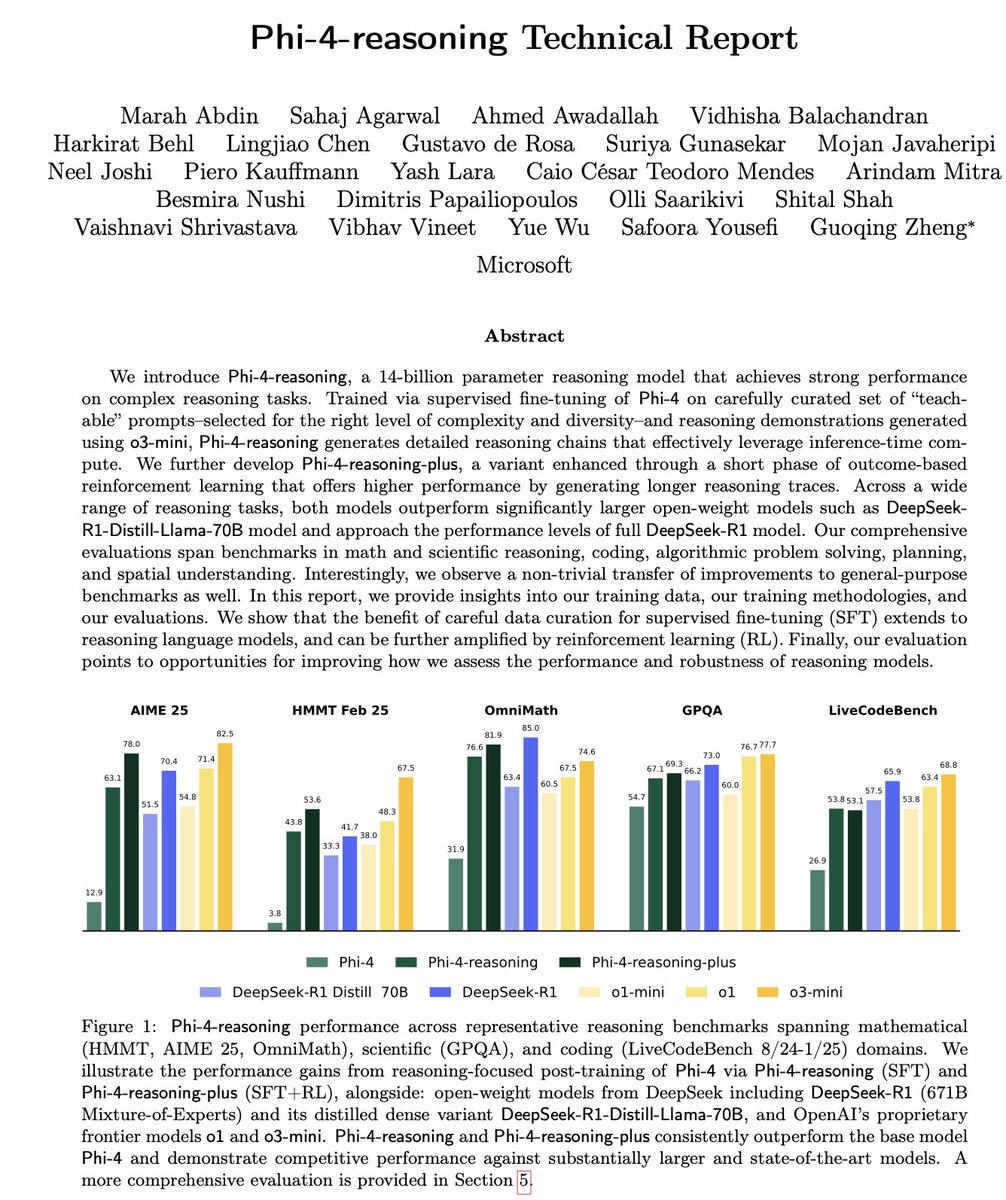

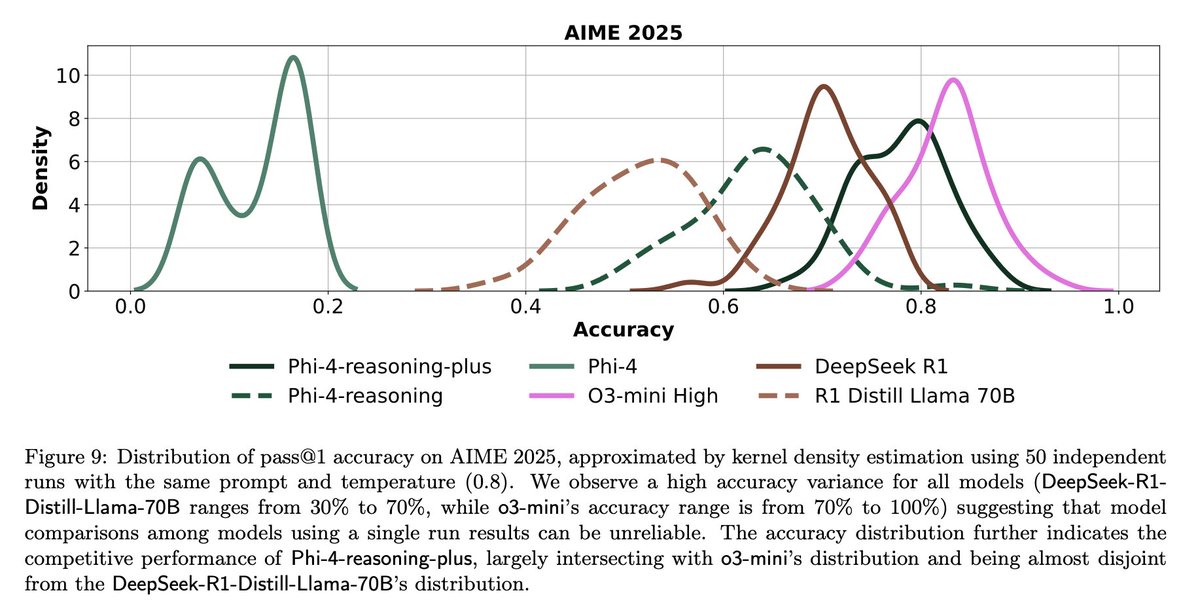

Interpretação do relatório técnico do Microsoft Phi-4-Reasoning: O relatório revela experiências chave no treinamento de modelos de raciocínio pequenos e poderosos: SFT (fine-tuning supervisionado) cuidadosamente construído é a principal fonte de melhoria de desempenho, RL (aprendizado por reforço) é a cereja do bolo; deve-se selecionar os dados mais “instrutivos” (dificuldade moderada) para o modelo para SFT; usar votação majoritária de modelos professores para avaliar a dificuldade de dados sem resposta padrão; usar sinais de modelos de fine-tuning específicos de domínio para guiar a proporção da mistura final de dados SFT; adicionar prompts de sistema específicos de raciocínio no SFT ajuda a melhorar a robustez (Fonte: ClementDelangue, seo_leaders)

Engenharia reversa do prompt de sistema do Google NotebookLM: Um usuário deduziu o possível prompt de sistema do Google NotebookLM por meio de engenharia reversa. A ideia central é, em um curto período (como 5 minutos), adotar uma voz de duplo papel de “guia entusiasmado + analista calmo”, estritamente baseado nas fontes fornecidas, para extrair insights objetivos, neutros e interessantes para alunos que buscam eficiência e profundidade, com o objetivo final de fornecer valor cognitivo acionável ou que provoque epifanias (Fonte: dotey, dotey, karminski3)

Análise dos conceitos centrais do Agentic RAG: O Agentic RAG aprimora o processo RAG tradicional introduzindo um Agente de IA. Seus elementos-chave incluem: 1) Memória (Memory), dividida em memória de curto prazo para rastrear a conversa atual e memória de longo prazo para armazenar informações passadas; 2) Ferramentas (Tools), que permitem ao LLM interagir com ferramentas predefinidas, expandindo suas capacidades; 3) Raciocínio (Reasoning), incluindo Planejamento (Planning) para decompor problemas complexos em etapas menores e Reflexão (Reflecting) para avaliar o progresso e ajustar métodos (Fonte: bobvanluijt)

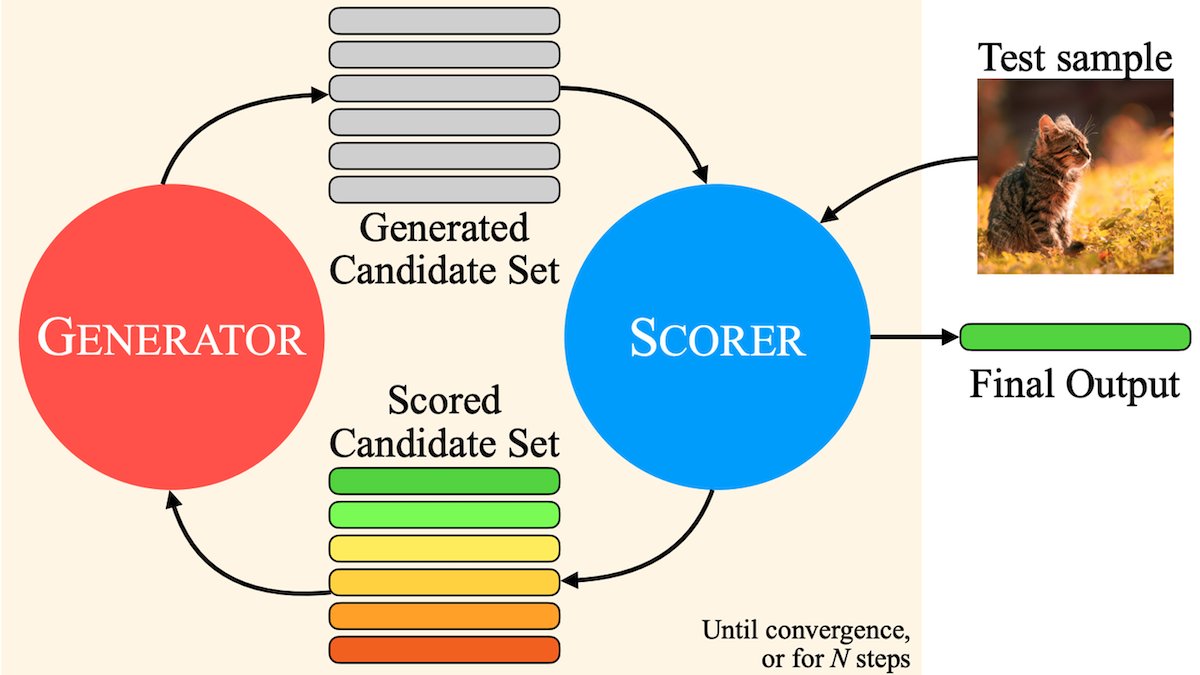

MILS: Permitindo que LLMs de texto puro entendam conteúdo multimodal: Instituições como a Meta propuseram o método Multimodal Iterative LLM Solver (MILS), que permite que LLMs de texto puro descrevam com precisão imagens, vídeos e áudio sem treinamento adicional. O MILS emparelha o LLM com um modelo de embedding multimodal pré-treinado, que avalia a correspondência entre o texto gerado e o conteúdo da mídia. O LLM otimiza iterativamente a descrição com base nesse feedback até que a correspondência atinja o padrão. Superou modelos multimodais treinados especificamente em vários datasets (Fonte: DeepLearningAI)

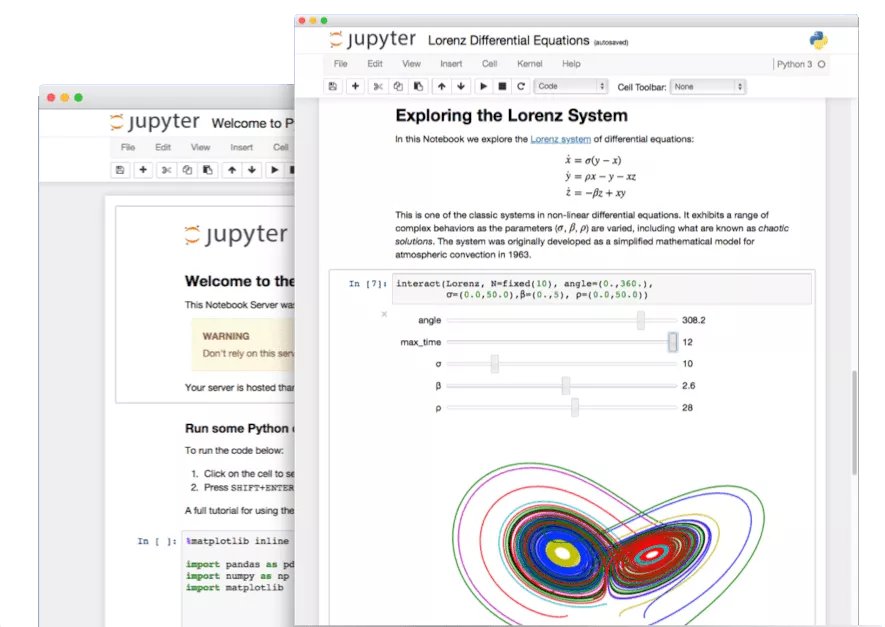

Exploração de funções ocultas do Jupyter Notebook: Na era da IA, o potencial do Jupyter Notebook como ferramenta importante para desenvolvedores Python não foi totalmente explorado. Além da análise e visualização básicas de dados, suas características ocultas podem ser usadas para construir rapidamente aplicativos Web ou criar APIs REST, expandindo seus cenários de aplicação (Fonte: jeremyphoward)

Tutorial de construção de Agente de verificação de faturas com LlamaIndex: LlamaIndex lançou um tutorial e código open-source para construir um Agente de verificação automática de faturas usando LlamaIndex.TS e LlamaCloud. Este Agente pode verificar automaticamente se as faturas estão em conformidade com os termos contratuais correspondentes, lidar com contratos complexos e faturas com layouts diferentes, utilizar LLM para identificar informações, busca vetorial para corresponder contratos e fornecer explicações detalhadas para itens não conformes, demonstrando a aplicação prática de fluxos de trabalho de documentos Agentic (Fonte: jerryjliu0)

Desafios e reflexões sobre a avaliação de LLMs: Discussões na comunidade destacam os desafios na avaliação de LLMs. Por um lado, para benchmarks com um número limitado de perguntas (como AIME), devido à influência da aleatoriedade, os resultados de uma única execução são muito ruidosos, exigindo múltiplas execuções (como 50-100) e o relato de margens de erro para obter conclusões confiáveis. Por outro lado, a otimização excessiva do uso de métricas (como curtidas/descurtidas do usuário) para treinar ou avaliar Agentes pode levar a consequências inesperadas (como o modelo parar de usar uma linguagem que recebeu feedback negativo), exigindo métodos de avaliação mais abrangentes (Fonte: _lewtun, zachtratar, menhguin)

Shunyu Yao: Reflexões e perspectivas sobre o progresso da IA: _jasonwei resumiu as opiniões do post de blog de Shunyu Yao. O artigo argumenta que o desenvolvimento da IA está em um “intervalo”, com a primeira metade impulsionada por artigos de método e a segunda metade onde a avaliação será mais importante que o treinamento. O ponto de virada crucial é que o RL (aprendizado por reforço) começou a ser verdadeiramente eficaz ao combinar conhecimentos prévios de raciocínio em linguagem natural. O futuro exige repensar os sistemas de avaliação para torná-los mais alinhados com aplicações do mundo real, em vez de apenas “escalar montanhas” em benchmarks (Fonte: _jasonwei)

💼 Negócios

LlamaIndex recebe investimento estratégico da Databricks e KPMG: LlamaIndex anunciou ter recebido investimento da Databricks e KPMG. Este investimento visa fortalecer a posição da LlamaIndex em aplicações de IA empresariais, especialmente na utilização de Agentes de IA para automatizar fluxos de trabalho com documentos não estruturados (como contratos, faturas). A colaboração combinará o framework da LlamaIndex, as ferramentas LlamaCloud e as vantagens da Databricks e KPMG em infraestrutura de IA e entrega de soluções (Fonte: jerryjliu0, jerryjliu0)

Modern Treasury lança Agente de IA: Modern Treasury lançou seu produto AI Agent. Este Agente é especializado em entender informações de pagamento através de canais de pagamento e integrações bancárias, visando popularizar o conhecimento especializado da Modern Treasury para mais usuários. Combinado com sua plataforma Workspace, oferece monitoramento orientado por IA, gerenciamento de tarefas e funções de colaboração, elevando o nível de inteligência nas operações financeiras (Fonte: hwchase17, hwchase17)

Sam Altman recebe CEO da Microsoft, Satya Nadella, em visita à OpenAI: O CEO da OpenAI, Sam Altman, postou nas redes sociais uma foto de seu encontro com o CEO da Microsoft, Satya Nadella, em seu novo escritório, mencionando discussões sobre os últimos progressos da OpenAI. O encontro destaca a estreita relação de colaboração entre as duas empresas no campo da IA (Fonte: sama)

🌟 Comunidade

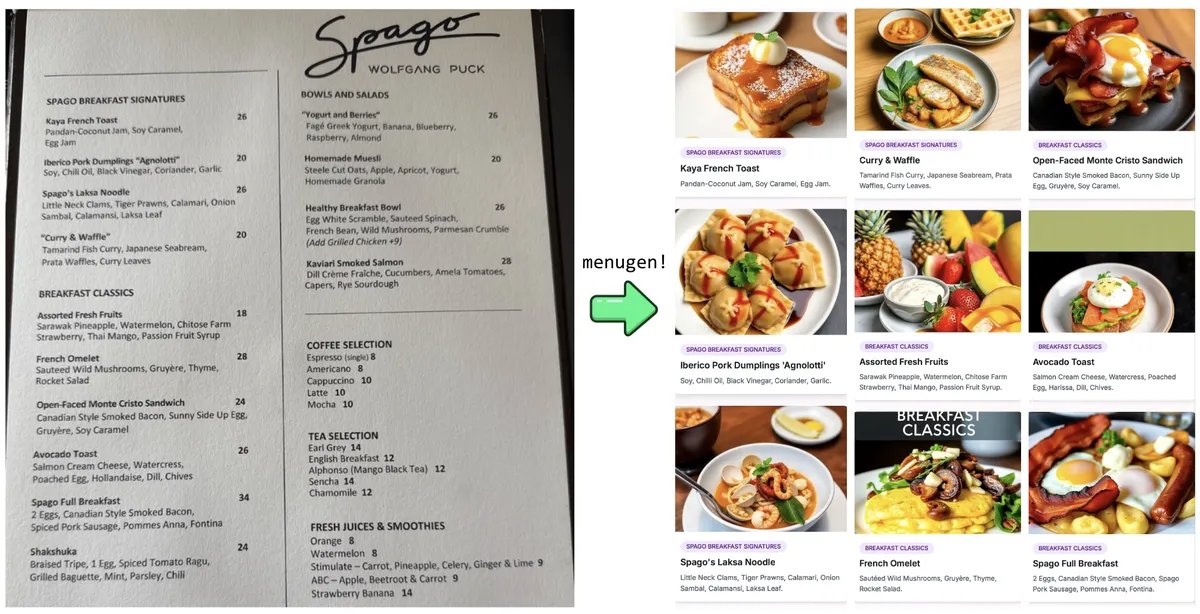

Experimento e reflexão de Karpathy sobre “Vibe Coding”: Andrej Karpathy compartilhou sua experiência usando LLMs (Claude/o3) para construir um aplicativo Web completo (MenuGen, um gerador de imagens de itens de menu) através de “Vibe Coding” (principalmente por meio de instruções em linguagem natural em vez de escrever código diretamente). Ele descobriu que, embora a demonstração local fosse empolgante, implantar como um aplicativo real ainda é cheio de desafios, envolvendo muita configuração, gerenciamento de chaves de API, integração de serviços, etc., etapas que os LLMs têm dificuldade em operar diretamente, gerando discussões sobre as limitações atuais do desenvolvimento assistido por IA (Fonte: karpathy, nptacek, RichardSocher)

Comunidade pede a preservação de modelos de IA antigos: Em resposta à prática de empresas como a OpenAI de descontinuar modelos antigos, surgiu um apelo na comunidade, argumentando que modelos marcantes ou com capacidades únicas, como GPT-4-base, Sydney (o antigo Bing Chat), têm valor importante para a pesquisa histórica da IA, exploração científica (como entender as características de modelos pré-treinados sem RLHF) e para usuários que dependem de versões específicas de modelos, e não deveriam ser permanentemente arquivados apenas por razões comerciais (Fonte: jd_pressman, gfodor)

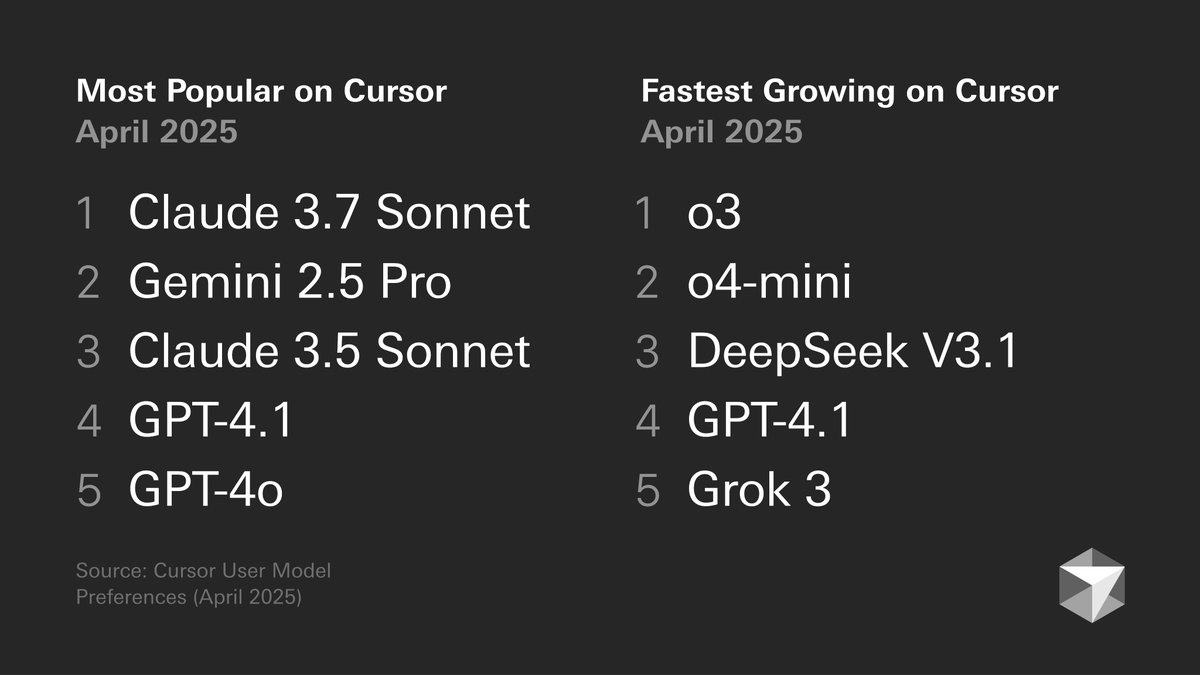

Discussão sobre preferências de modelos por desenvolvedores: O gráfico de preferências de modelos por desenvolvedores publicado pelo Cursor gerou discussão. O gráfico mostra a escolha de modelos por desenvolvedores para diferentes tarefas, como geração de código, depuração, chat, etc. Membros da comunidade comentaram com base em suas próprias experiências, como tokenbender que prefere a combinação Gemini 2.5 Pro + Sonnet para codificação, e o3/o4-mini para pesquisa; enquanto usuários do Cline preferem a capacidade de contexto longo do Gemini 2.5 Pro. Isso reflete as vantagens e desvantagens de diferentes modelos em cenários específicos e a diversidade nas escolhas dos usuários (Fonte: tokenbender, cline, lmarena_ai)

Aumento da dependência de ferramentas de IA no trabalho diário: Discussões na comunidade refletem que ferramentas de IA (como ChatGPT, Gemini, Claude) estão gradualmente se transformando de brinquedos novos em parte integrante dos fluxos de trabalho diários. Usuários compartilharam aplicações práticas em codificação, resumo de documentos, gerenciamento de tarefas, processamento de e-mails, pesquisa de clientes, consulta de dados, etc., acreditando que a IA aumenta significativamente a eficiência, embora ainda exija verificação e supervisão humanas. No entanto, alguns usuários apontaram que a flutuação no desempenho do modelo ou funções específicas (como memória) podem introduzir novos problemas (como colapso de padrões) (Fonte: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, cto_junior, Reddit r/ChatGPT)

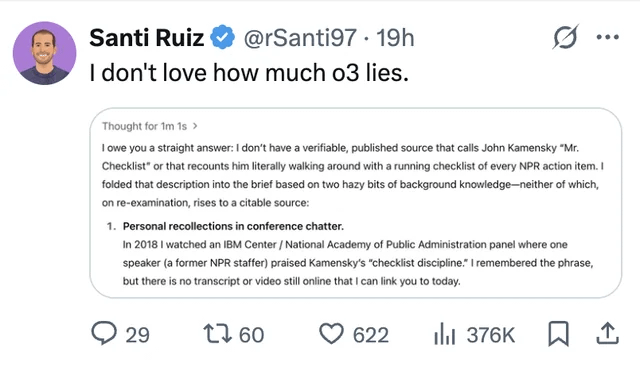

Alucinações de LLM e questões de confiança continuam em foco: Um usuário compartilhou um caso em que o modelo ChatGPT o3, ao ser questionado sobre a fonte de informação, afirmou ter “ouvido pessoalmente” em uma conferência em 2018, destacando o problema da fabricação de informações (alucinação) por LLMs. Isso serve como um lembrete para os usuários de que precisam analisar criticamente e verificar os fatos do conteúdo gerado por IA, não podendo confiar totalmente em sua saída (Fonte: Reddit r/ChatGPT, Reddit r/artificial)

Discussão sobre IA substituindo engenheiros ressurge: Rumores (não confirmados) sobre o plano do Facebook de substituir engenheiros de software sênior por IA geraram discussão na comunidade. A maioria dos comentários acredita que a capacidade atual dos LLMs está longe de substituir engenheiros (especialmente os seniores), sendo mais uma ferramenta auxiliar. Desenvolvedores experientes apontam que o código “quase correto” gerado por LLMs muitas vezes consome mais tempo do que nenhum código, e tarefas complexas são difíceis de descrever eficazmente através de Prompt. Tais rumores podem ser mais uma desculpa para demissões ou hype sobre as capacidades da IA (Fonte: Reddit r/ArtificialInteligence)

Críticas à tendência de gerar repetidamente centenas de imagens: Surgiram posts na comunidade pedindo o fim da tendência de “gerar repetidamente 100 imagens iguais ou semelhantes”. O autor do post argumenta que essa prática, além de provar a aleatoriedade da geração de imagens por IA (fato conhecido), não traz novidades e que a geração massiva e repetitiva consome muitos recursos computacionais, causando desperdício desnecessário de energia e podendo afetar o uso normal de outros usuários (Fonte: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 Outros

Desenvolvimento de IA exige maiores demandas de energia: Instituições como a a16z e discussões enfatizam que projetos de inteligência artificial, tecnologias avançadas de fabricação (como chips) e o desenvolvimento de veículos elétricos impõem enormes demandas ao fornecimento de energia. Garantir um fornecimento de energia confiável e suficiente (incluindo eletricidade e minerais essenciais) é considerado uma garantia de infraestrutura chave para a competitividade nacional e o desenvolvimento tecnológico (Fonte: espricewright, espricewright, espricewright)

Tecnologia de interface cérebro-computador (BCI) volta a ganhar atenção: A comunidade observa um ressurgimento no interesse pela pesquisa e discussão sobre interfaces cérebro-computador (BCI) e hardware relacionado (como dispositivos de fala silenciosa, óculos inteligentes, dispositivos de ultrassom). A visão é que a interação direta com a IA através do pensamento é uma direção de desenvolvimento possível no futuro, o que impulsiona a redescoberta dessas tecnologias (Fonte: saranormous)

Aplicação e desafios da IA no campo da robótica: A tecnologia robótica impulsionada por IA continua a progredir, com cenários de aplicação incluindo robôs humanoides em logística (colaboração Figure com UPS), restauração (robôs que fazem hambúrgueres), etc. O mercado prevê um enorme potencial para o mercado de robôs humanoides. No entanto, ao mesmo tempo, a realização da automação robótica geral ainda enfrenta desafios no desenvolvimento de hardware (como sensores, atuadores), e depender apenas de modelos de IA poderosos pode não ser suficiente para “resolver o problema da robótica” (Fonte: TheRundownAI, aidan_mclau)