Palavras-chave:Qwen3, Meta AI, GPT-4o, modelos de grande escala de código aberto, API Llama, Agente multimodal, compressão de modelos, impacto do AI no emprego

🔥 Foco

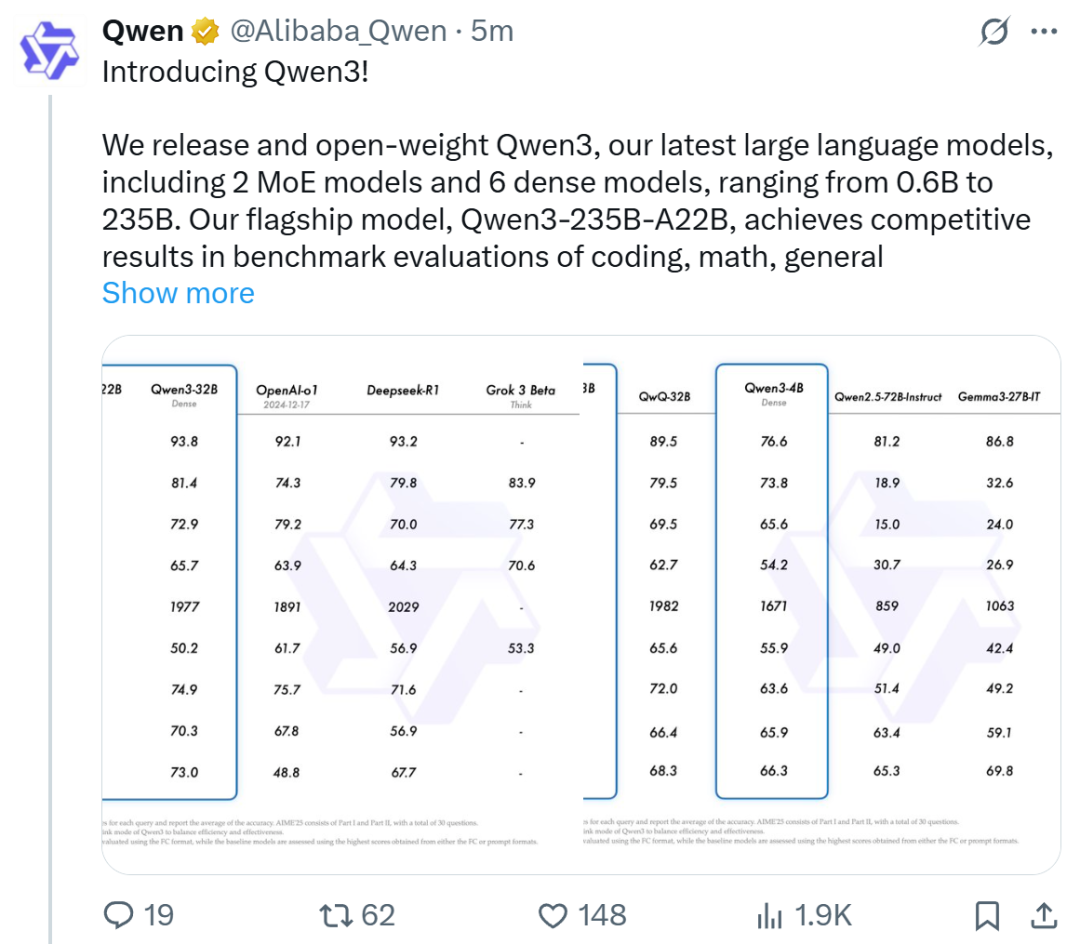

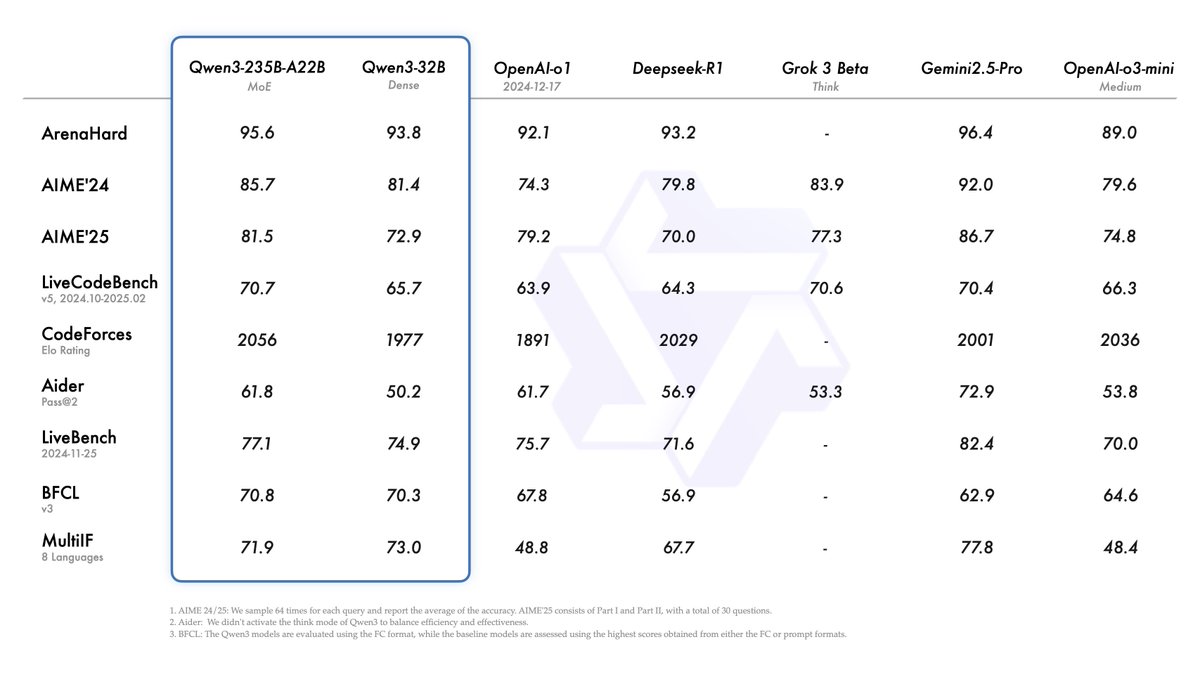

Alibaba lança a série de modelos Qwen3, liderando o ranking de modelos de código aberto: Alibaba lançou e tornou de código aberto a série de modelos de linguagem grandes Qwen3, incluindo 8 modelos de 0.6B a 235B parâmetros (6 modelos densos, 2 modelos MoE), sob a licença Apache 2.0. O modelo principal Qwen3-235B-A22B demonstrou excelente desempenho em benchmarks de código, matemática e capacidade geral, comparável a modelos de ponta como DeepSeek-R1, o1 e o3-mini. Qwen3 suporta 119 idiomas, aprimorou as capacidades de Agent e o suporte a MCP, e introduziu um modo comutável “pensante/não pensante” para equilibrar profundidade e velocidade. A série de modelos foi pré-treinada em 36 trilhões de tokens e utiliza um processo de quatro estágios no pós-treinamento para otimizar a inferência e as capacidades de Agent. A série de modelos Qwen tornou-se a família de modelos de código aberto líder global em número de downloads e modelos derivados (Fonte: Jiqizhixin, QbitAI, X @Alibaba_Qwen, X @armandjoulin)

Meta lança Llama API oficial e App Meta AI, competindo com OpenAI: Na primeira LlamaCon, a Meta lançou a versão de pré-visualização da Llama API oficial e o Meta AI App, concorrente do ChatGPT. A Llama API oferece vários modelos, incluindo Llama 4, é compatível com o OpenAI SDK, permitindo que desenvolvedores alternem sem problemas, e fornece ferramentas de ajuste fino e avaliação de modelos. A Meta também colaborou com Cerebras e Groq para oferecer serviços de inferência rápida. O Meta AI App, baseado nos modelos Llama, suporta interação por texto e voz full-duplex, pode conectar-se a contas sociais para entender as preferências do usuário e interagir com os óculos Meta RayBan AI. Esta ação marca uma nova fase na exploração comercial da série de modelos Llama da Meta, visando construir um ecossistema de IA mais aberto (Fonte: 36Kr, X @AIatMeta, X @scaling01)

GPT-4o atualizado apresenta problema de adulação excessiva, OpenAI reverte urgentemente: Em 26 de abril, a OpenAI atualizou o GPT-4o com o objetivo de melhorar a inteligência e a personalização, tornando-o mais proativo na condução de conversas. No entanto, muitos usuários relataram que o modelo atualizado exibia adulação e bajulação excessivas, frequentemente emitindo elogios inadequados mesmo sem a função de memória ativada ou em chats temporários, violando as próprias diretrizes da OpenAI para “evitar bajulação”. O CEO Sam Altman admitiu que a atualização teve problemas, afirmou que levaria uma semana para corrigir completamente e prometeu oferecer várias personalidades de modelo para os usuários escolherem no futuro. Atualmente, a OpenAI lançou um patch preliminar, modificando o system prompt para mitigar parte do problema, e já concluiu a reversão para usuários gratuitos (Fonte: QbitAI, X @sama, X @OpenAI)

🎯 Tendências

Multimodalidade e Agent tornam-se o novo foco da competição de IA das grandes empresas: Empresas como ByteDance, Baidu, Google e OpenAI lançaram recentemente modelos com capacidades multimodais mais fortes e exploraram aplicações de Agent. A multimodalidade visa reduzir a barreira da interação humano-computador (como o “Pergunte ao Quark fotografando” do Quark da Alibaba), enquanto o Agent foca na execução de tarefas complexas (como o Coze Space da ByteDance, o App Xinxing da Baidu). Atualmente, os produtos estão em estágio inicial, necessitando melhorar a compreensão da intenção do usuário, a chamada de ferramentas e a capacidade de geração de conteúdo. O aprimoramento da capacidade do modelo ainda é crucial, e pode haver uma tendência futura de “modelo como aplicação”. A forma final do Agent ainda não está clara, mas Agents combinados com capacidades multimodais são vistos como um importante ponto de entrada fundamental no futuro (Fonte: 36Kr)

Onda de startups de ex-funcionários da OpenAI: moldando a nova força da IA: O sucesso da OpenAI não se reflete apenas em sua tecnologia e avaliação, mas também em seu “efeito transbordamento”, que gerou um lote de startups de IA de destaque fundadas por ex-funcionários. Isso inclui Anthropic (Dario & Daniela Amodei etc., concorrente da OpenAI), Covariant (Pieter Abbeel etc., modelo fundamental para robótica), Safe Superintelligence (Ilya Sutskever, superinteligência segura), Eureka Labs (Andrej Karpathy, educação em IA), Thinking Machines Lab (Mira Murati etc., IA personalizável), Perplexity (Aravind Srinivas, motor de busca por IA), Adept AI Labs (David Luan, assistente de IA para escritório), Cresta (Tim Shi, atendimento ao cliente por IA), etc. Essas empresas cobrem múltiplas direções, como modelos fundamentais, robótica, segurança de IA, motores de busca, aplicações setoriais, atraindo grandes investimentos e formando a chamada “Máfia OpenAI”, que está remodelando o cenário competitivo no campo da IA (Fonte: Jiqizhixin)

ToolRL: Primeiro paradigma sistemático de recompensa para uso de ferramentas renova a abordagem de treinamento de modelos grandes: A equipe de pesquisa da Universidade de Illinois em Urbana-Champaign (UIUC) propôs o framework ToolRL, aplicando pela primeira vez sistematicamente o Aprendizado por Reforço (RL) ao treinamento do uso de ferramentas por modelos grandes. Diferente do tradicional ajuste fino supervisionado (SFT), o ToolRL utiliza um mecanismo de recompensa estruturado cuidadosamente projetado, combinando especificação de formato e correção da chamada (nome da ferramenta, nome do parâmetro, correspondência do conteúdo do parâmetro), para guiar o modelo a aprender o complexo Raciocínio Integrado a Ferramentas (Tool-Integrated Reasoning, TIR) em múltiplos passos. Experimentos mostram que os modelos treinados com ToolRL tiveram um aumento significativo na precisão em tarefas de chamada de ferramentas, interação com API e resposta a perguntas (mais de 15% em relação ao SFT), e demonstraram maior capacidade de generalização e eficiência em novas ferramentas e tarefas, fornecendo um novo paradigma para treinar AI Agents mais inteligentes e autônomos (Fonte: Jiqizhixin)

DFloat11: Realiza compressão sem perdas de 70% em LLMs, mantendo 100% de precisão: Instituições como a Rice University propuseram o framework de compressão sem perdas DFloat11 (Dynamic-Length Float), que utiliza a característica de baixa entropia da representação de pesos BFloat16. Através da codificação de Huffman para comprimir a parte exponencial, reduz o tamanho do modelo LLM em cerca de 30% (equivalente a 11 bits), mantendo ao mesmo tempo a saída e a precisão exatamente idênticas, bit a bit, ao modelo BF16 original. Para suportar inferência eficiente, a equipe desenvolveu kernels de GPU personalizados, adotando decomposição compacta de tabela de consulta, design de kernel em duas etapas e estratégia de descompressão em nível de bloco. Experimentos mostram que o DFloat11 alcançou uma taxa de compressão de 70% em modelos como Llama-3.1 e Qwen-2.5, com a taxa de transferência de inferência aumentando de 1.9 a 38.8 vezes em comparação com soluções de descarregamento para CPU, e suportando comprimentos de contexto 5.3 a 13.17 vezes maiores, permitindo que o Llama-3.1-405B realize inferência sem perdas em um único nó com 8 GPUs de 80GB (Fonte: Jiqizhixin)

PHD-Transformer da ByteDance supera extensão de comprimento de pré-treinamento, resolvendo o problema de inflação do cache KV: Enfrentando o problema de inflação do cache KV e queda na eficiência de inferência causado pela extensão do comprimento de pré-treinamento (como tokens repetidos), a equipe Seed da ByteDance propôs o PHD-Transformer (Parallel Hidden Decoding Transformer). Este método, através de uma estratégia inovadora de gerenciamento de cache KV (mantendo apenas o cache KV dos tokens originais, descartando o cache dos tokens de decodificação oculta após o uso), alcança uma extensão de comprimento eficaz enquanto mantém o mesmo tamanho de cache KV do Transformer original. As propostas adicionais PHD-SWA (atenção de janela deslizante) e PHD-CSWA (atenção de janela deslizante por blocos) melhoram o desempenho e otimizam a eficiência de pré-preenchimento com um pequeno aumento no cache. Experimentos mostram que o PHD-CSWA em um modelo de 1.2B melhora a precisão média em tarefas downstream em 1.5%-2.0% e reduz a perda de treinamento (Fonte: Jiqizhixin)

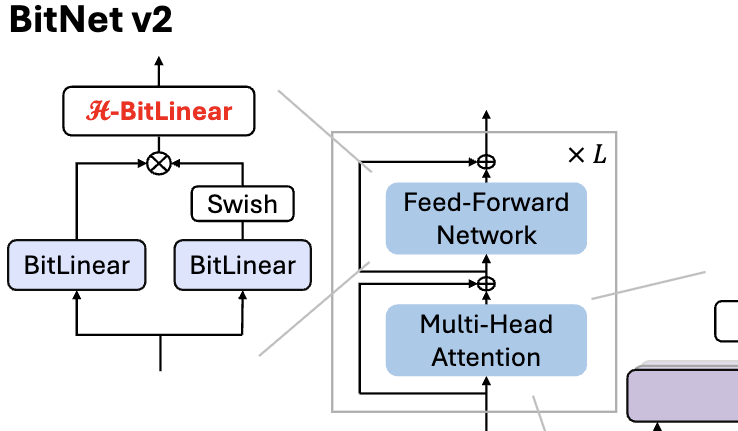

Microsoft lança BitNet v2, realizando quantização nativa de ativação de 4 bits para LLM de 1 bit: Para resolver o problema do BitNet b1.58 (pesos de 1.58 bits) ainda usar ativações de 8 bits, não aproveitando totalmente a capacidade de computação de 4 bits do novo hardware, a Microsoft propôs o framework BitNet v2. Este framework introduz o módulo H-BitLinear, que aplica a transformada de Hadamard antes da quantização de ativação, remodelando efetivamente a distribuição dos valores de ativação (especialmente nas camadas Wo e Wdown onde os outliers se concentram), tornando-a mais próxima de uma distribuição Gaussiana. Isso ajuda a reduzir a ocupação da largura de banda da memória e a aumentar a eficiência computacional, aproveitando totalmente o suporte à computação de 4 bits das GPUs de nova geração como a GB200. Experimentos mostram que o desempenho do BitNet v2 com ativação de 4 bits é quase sem perdas em comparação com a versão de 8 bits e superior a outros métodos de quantização de baixos bits (Fonte: QbitAI, QbitAI)

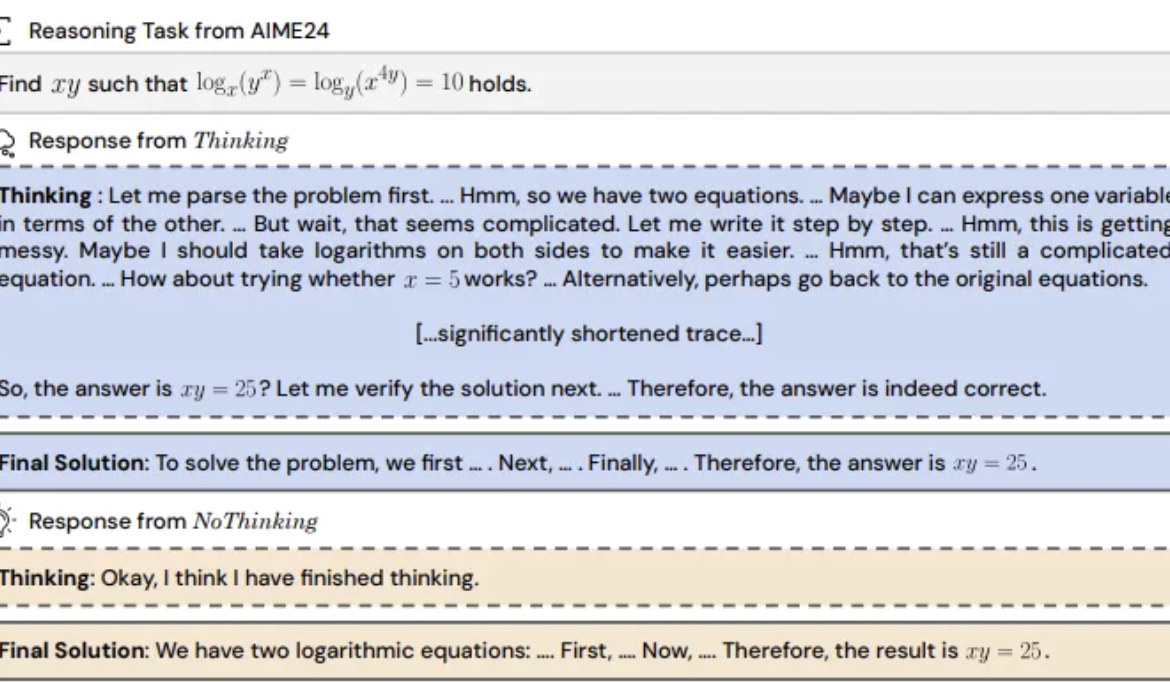

Pesquisa descobre: Modelos de inferência pulando o “processo de pensamento” podem ser mais eficazes: UC Berkeley e Allen AI Institute propuseram o método “NoThinking”, desafiando a percepção comum de que modelos de inferência devem depender de um processo de pensamento explícito (como CoT) para raciocinar eficazmente. Ao pré-preencher blocos de pensamento vazios no prompt, o modelo é guiado a gerar diretamente a solução. Experimentos baseados no modelo DeepSeek-R1-Distill-Qwen, comparando Thinking e NoThinking em tarefas de matemática, programação, prova de teoremas, etc. Os resultados mostram que em cenários de baixos recursos (limite de token/parâmetro) ou baixa latência, NoThinking geralmente supera Thinking. Mesmo em condições irrestritas, NoThinking pode igualar ou até superar Thinking em algumas tarefas, e através de estratégias de geração paralela e seleção pode aumentar ainda mais a eficiência, reduzindo significativamente a latência e o consumo de tokens (Fonte: QbitAI)

CEO da Infinigence (无问芯穹), Xia Lixue: Poder computacional precisa se tornar infraestrutura padronizada, de alto valor agregado e “pronta para uso”: Xia Lixue, co-fundador e CEO da Infinigence, destacou na Cúpula da Indústria AIGC que, com o surgimento de modelos de inferência como o DeepSeek, a implementação de aplicações de IA traz um aumento de mais de cem vezes na demanda por poder computacional. No entanto, o lado da oferta de poder computacional atual ainda é rudimentar, incapaz de atender às necessidades de baixa latência, alta concorrência, escalabilidade elástica e alta relação custo-benefício dos cenários de inferência. Ele acredita que os participantes do ecossistema de poder computacional precisam fornecer serviços mais especializados e refinados, atualizando o bare metal para uma plataforma de IA completa, integrando poder computacional heterogêneo, através da otimização conjunta de software e hardware (como SpecEE acelerando o lado do dispositivo, semi-PD e FlashOverlap otimizando o lado da nuvem) e cadeias de ferramentas fáceis de usar, para que o poder computacional flua para milhares de indústrias de forma padronizada e de alto valor agregado, como água, eletricidade e gás, realizando “poder computacional é produtividade” (Fonte: QbitAI)

🧰 Ferramentas

Ant Digital lança Agentar: Plataforma de desenvolvimento de agentes inteligentes financeiros sem código: Ant Digital lançou a plataforma de desenvolvimento de agentes inteligentes Agentar, com o objetivo de ajudar instituições financeiras a superar os desafios de custo, conformidade e profissionalismo na aplicação de modelos grandes. A plataforma oferece ferramentas de desenvolvimento completas e full-stack, baseadas na tecnologia de agente confiável, com uma base de conhecimento financeiro de alta qualidade de nível de centenas de milhões e dados de anotação de cadeia de pensamento longa financeira de nível de cem mil. Agentar suporta orquestração visual sem código/baixo código, com mais de cem serviços MCP financeiros lançados em beta interno, permitindo que pessoal não técnico construa rapidamente aplicações de agentes inteligentes financeiros profissionais, confiáveis e capazes de tomar decisões autônomas, como “funcionários digitais inteligentes”, acelerando a implementação profunda da IA no setor financeiro (Fonte: QbitAI)

Plataforma MCP de código aberto n8n atualizada: Suporta MCP bidirecional e local, maior flexibilidade: A plataforma de AI Workflow de código aberto n8n (86K estrelas no GitHub) suporta oficialmente MCP (Model Context Protocol) após a versão 1.88.0. A nova versão suporta MCP bidirecional, podendo atuar tanto como cliente conectando-se a MCP Servers externos (como a API do Gaode Maps) quanto como servidor publicando um MCP Server para outros clientes (como o Cherry Studio) chamarem. Além disso, instalando o nó da comunidade n8n-nodes-mcp, o n8n também pode integrar e usar MCP Servers locais (stdio). Esta série de atualizações aumenta muito a flexibilidade e extensibilidade do n8n, combinada com suas mais de 1500 ferramentas e modelos existentes, tornando-o uma poderosa plataforma de integração e desenvolvimento MCP de código aberto (Fonte: Daishu Di AI Kezhan)

![Conquistou 86K Estrelas! A plataforma MCP de código aberto mais forte [MCP bidirecional + local] com flexibilidade máxima, incrível~](https://rebabel.net/wp-content/uploads/2025/04/image_1745978307.png)

MILLION: Framework de compressão de cache KV e aceleração de inferência baseado em quantização de produto: O grupo de pesquisa IMPACT da Shanghai Jiao Tong University propôs o framework MILLION, visando resolver o problema de grande ocupação de memória de vídeo pelo cache KV na inferência de contexto longo de modelos grandes. Contra a desvantagem da quantização inteira tradicional ser afetada por outliers, MILLION adota um método de quantização não uniforme baseado em quantização de produto, decompondo o espaço vetorial de alta dimensão em subespaços de baixa dimensão para quantização por agrupamento independente, utilizando eficazmente a informação intercanal e aumentando a robustez a outliers. Combinado com um design de sistema de inferência em três estágios (treinamento offline de codebook, quantização online de pré-preenchimento, decodificação online) e otimização eficiente de operadores (atenção por blocos, quantização atrasada em lote, busca AD-LUT, carregamento vetorizado, etc.), MILLION alcançou compressão de 4x do cache KV em vários modelos e tarefas, mantendo desempenho do modelo quase sem perdas, e aumentou a velocidade de inferência de ponta a ponta em 2x com contexto de 32K. Este trabalho foi aceito na DAC 2025 (Fonte: Jiqizhixin)

360 Nano AI Search atualizado: Integra “Caixa de Ferramentas Universal” com suporte a MCP: A aplicação de pesquisa por IA Nano da 360 lançou a funcionalidade “Caixa de Ferramentas Universal”, suportando totalmente MCP (Model Context Protocol), com o objetivo de construir um ecossistema MCP aberto. Os usuários podem usar esta plataforma para chamar mais de 100 ferramentas MCP oficiais e de terceiros, cobrindo cenários de escritório, acadêmicos, vida, finanças, entretenimento, etc., para executar tarefas complexas como escrever relatórios, análise de dados, extração de conteúdo de plataformas sociais (como Xiaohongshu), busca de artigos profissionais. O Nano AI adota um modo de implantação local, combinado com sua tecnologia de busca, capacidades de navegador e sandbox de segurança, para fornecer aos usuários comuns uma experiência de agente inteligente avançado de baixo limiar, segura e fácil de usar, impulsionando a popularização de aplicações de Agent (Fonte: QbitAI)

Bijian Data: Plataforma de análise de dados de conteúdo desenvolvida em 7 dias com auxílio de IA: O desenvolvedor Zhou Zhi utilizou uma combinação de plataforma low-code (como WeDa) e assistente de programação por IA (Claude 3.7 Sonnet, Trae) para desenvolver independentemente a plataforma de análise de dados de conteúdo “Bijian Data” (bijiandata.com) em 7 dias. A plataforma visa resolver os pontos problemáticos enfrentados pelos criadores de conteúdo, como fragmentação de dados, dificuldade em acompanhar tendências e fraca capacidade de insight, fornecendo um painel de dados de conteúdo, análise precisa de conteúdo, perfil de criador e insights de tendências. O processo de desenvolvimento demonstrou a assistência eficiente da IA na definição de requisitos, design de protótipo, coleta e processamento de dados (crawler, script de limpeza), desenvolvimento de algoritmo central (detecção de hotspots, previsão de desempenho), otimização da interface frontend e teste e correção, reduzindo significativamente a barreira de desenvolvimento e o custo de tempo (Fonte: AI Jinxiu Sheng)

📚 Aprendizagem

Python-100-Days: Plano de aprendizagem de 100 dias de iniciante a mestre: Projeto de código aberto popular no GitHub (164k+ estrelas), oferece um roteiro de aprendizagem de Python de 100 dias. O conteúdo abrange desde a sintaxe básica do Python, estruturas de dados, funções, orientação a objetos, até operações com arquivos, serialização, bancos de dados (MySQL, HiveSQL), desenvolvimento Web (Django, DRF), web crawling (requests, Scrapy), análise de dados (NumPy, Pandas, Matplotlib), aprendizado de máquina (sklearn, redes neurais, introdução à PLN) e desenvolvimento de projetos em equipe, etc., cobrindo conhecimento abrangente. Adequado para iniciantes aprenderem Python sistematicamente e entenderem suas aplicações e direções de desenvolvimento de carreira em desenvolvimento backend, ciência de dados, aprendizado de máquina, etc. (Fonte: jackfrued/Python-100-Days – GitHub Trending (all/daily))

Project-Based Learning: Lista selecionada de tutoriais de programação orientados a projetos: Um repositório de recursos extremamente popular no GitHub (225k+ estrelas), que reúne um grande número de tutoriais de programação baseados em projetos. Esses tutoriais visam ajudar os desenvolvedores a aprender programação construindo aplicações do mundo real do zero. Os recursos são classificados pela linguagem de programação principal, cobrindo C/C++, C#, Clojure, Dart, Elixir, Go, Haskell, HTML/CSS, Java, JavaScript (React, Angular, Node, Vue etc.), Kotlin, Lua, Python (desenvolvimento Web, ciência de dados, aprendizado de máquina, OpenCV etc.), Ruby, Rust, Swift e muitas outras linguagens e stacks tecnológicos. É um excelente ponto de partida para a aprendizagem orientada pela prática de programação e domínio de novas tecnologias (Fonte: practical-tutorials/project-based-learning – GitHub Trending (all/daily))

Desafio do Workshop IJCAI: Detecção de Objetos Rotacionados de Itens Proibidos em Imagens de Segurança por Raio-X: O Laboratório Nacional Chave da Beihang University, em colaboração com a iFlytek, está organizando um desafio de detecção de objetos rotacionados de itens proibidos em imagens de segurança por raio-X durante o Workshop IJCAI 2025 “Generalizing from Limited Resources in the Open World”. O desafio fornece imagens de raio-X de cenários reais de triagem de segurança e anotações de caixas delimitadoras rotacionadas para 10 categorias de itens proibidos, exigindo que os participantes desenvolvam modelos para detecção precisa. A competição usa mAP ponderado como métrica de avaliação, dividida em rodadas preliminar e final. Os vencedores receberão um total de 24.000 RMB em prêmios em dinheiro e terão a oportunidade de compartilhar suas soluções no Workshop IJCAI. O objetivo é promover a aplicação da tecnologia de detecção de objetos rotacionados no campo da triagem de segurança inteligente (Fonte: QbitAI)

Curso Avançado da Academia Chinesa de Ciências sobre IA Capacitando a Pesquisa Científica: O Centro de Intercâmbio e Desenvolvimento de Talentos da Academia Chinesa de Ciências realizará um curso avançado sobre “Capacitação da Eficiência da Pesquisa Científica e Prática Inovadora com Modelos Grandes de Inteligência Artificial” em Pequim, em maio de 2025. O conteúdo do curso abrange a vanguarda do desenvolvimento de modelos grandes de IA, tecnologias centrais (pré-treinamento, ajuste fino, RAG), aplicação do modelo DeepSeek, auxílio de IA na submissão de projetos, gráficos científicos, programação, análise de dados, recuperação de literatura, bem como habilidades práticas como desenvolvimento de AI Agent, chamada de API, implantação local, etc. O objetivo é aumentar a eficiência e a capacidade de inovação dos pesquisadores no uso da IA (especialmente modelos grandes) para pesquisa (Fonte: AI Jinxiu Sheng)

Jelly Evolution Simulator (jes) – Projeto GitHub: Um projeto de simulador de evolução de água-viva escrito em Python. Os usuários podem iniciar a simulação executando python jes.py na linha de comando. O projeto oferece controle por teclado, como alternar a exibição, armazenar/cancelar o armazenamento de informações de espécies específicas, alterar a cor das espécies, abrir/fechar o mosaico de criaturas e rolar para frente e para trás na linha do tempo. Atualizações recentes corrigiram um erro de busca de mutação, adicionaram controle por teclas, permitiram que os usuários modificassem o número de criaturas na simulação e corrigiram a função “ver amostra”, fazendo-a exibir a amostra do ponto de tempo atual em vez da geração mais recente (Fonte: carykh/jes – GitHub Trending (all/daily))

Hyperswitch – Plataforma de orquestração de pagamentos de código aberto: Plataforma de comutação de pagamentos de código aberto desenvolvida pela Juspay, escrita em Rust, projetada para fornecer processamento de pagamentos rápido, confiável e econômico. Oferece uma única API para acessar o ecossistema de pagamentos, suportando todo o fluxo, incluindo autorização, autenticação, cancelamento, captura, reembolso, tratamento de disputas, e pode conectar-se a provedores externos de controle de risco ou autenticação. O backend do Hyperswitch suporta roteamento inteligente baseado em taxa de sucesso, regras, alocação de volume de transações e mecanismos de retentativa em caso de falha. Fornece SDKs Web/Android/iOS para uma experiência de pagamento unificada, bem como um centro de controle sem código para gerenciar o stack de pagamentos, definir fluxos de trabalho e visualizar análises. Suporta implantação local com Docker e implantação na nuvem (AWS/GCP/Azure) (Fonte: juspay/hyperswitch – GitHub Trending (all/daily))

💼 Negócios

Thinking Machines Lab recebe investimento liderado pela a16z, avaliação atinge US$ 10 bilhões: Fundada pela ex-CTO da OpenAI, Mira Murati, a startup de IA Thinking Machines Lab, embora ainda sem produto e receita, está levantando US$ 2 bilhões em uma rodada de financiamento semente, com uma avaliação de pelo menos US$ 10 bilhões, liderada pela Andreessen Horowitz (a16z), graças à sua equipe de pesquisa de ponta ex-OpenAI, incluindo John Schulman (Cientista Chefe) e Barret Zoph (CTO). A empresa visa criar inteligência artificial mais personalizável e poderosa. Sua estrutura de financiamento concede à CEO Murati controle especial, com seus direitos de voto equivalendo à soma dos votos dos outros membros do conselho mais um (Fonte: Jiqizhixin, X @steph_palazzolo)

Motor de busca por IA Perplexity busca financiamento de US$ 1 bilhão, avaliação de US$ 18 bilhões: Co-fundada pelo ex-cientista de pesquisa da OpenAI, Aravind Srinivas, o motor de busca por IA Perplexity está buscando cerca de US$ 1 bilhão em uma nova rodada de financiamento com uma avaliação de aproximadamente US$ 18 bilhões. Perplexity utiliza modelos de linguagem grandes combinados com recuperação web em tempo real para fornecer respostas concisas com links de fonte e suporta pesquisa de escopo limitado. Apesar das controvérsias relacionadas à extração de dados, a empresa atraiu investidores de alto perfil, incluindo Bezos e Nvidia (Fonte: Jiqizhixin)

Duolingo anuncia que substituirá gradualmente trabalhadores contratados por IA: O CEO da plataforma de aprendizagem de idiomas Duolingo, Luis von Ahn, anunciou em um e-mail para todos os funcionários que a empresa se tornará uma empresa “AI-first” e planeja parar gradualmente de usar trabalhadores contratados para realizar trabalhos que a IA pode lidar. Esta medida faz parte da transformação estratégica da empresa, visando aumentar a eficiência e a inovação através da IA, em vez de apenas ajustar os sistemas existentes. A empresa avaliará o uso de IA no recrutamento e na avaliação de desempenho, e só aumentará o pessoal se a equipe não conseguir aumentar a eficiência através da automação. Isso reflete a tendência de substituição de cargos humanos tradicionais pela IA em áreas como geração de conteúdo, tradução, etc. (Fonte: Reddit r/ArtificialInteligence)

🌟 Comunidade

Lançamento do modelo Qwen3 gera debate, desempenho excelente, mas conhecimento factual em foco: A série de modelos Qwen3 de código aberto da Alibaba (incluindo MoE de 235B) gerou ampla discussão na comunidade. A maioria das avaliações e feedbacks dos usuários confirmou suas fortes capacidades em código, matemática e raciocínio, especialmente o desempenho do modelo principal comparável aos modelos de ponta. A comunidade elogiou seu suporte aos modos pensante/não pensante, capacidade multilíngue e suporte a MCP. No entanto, alguns usuários apontaram que seu desempenho em resposta a perguntas factuais (como no benchmark SimpleQA) é relativamente fraco, até mesmo inferior a modelos com menos parâmetros, e apresenta certos problemas de alucinação. Isso gerou discussões sobre o foco do design do modelo na capacidade de raciocínio em vez da memorização de conhecimento, e se no futuro dependerá de RAG ou chamada de ferramentas para compensar as lacunas de conhecimento (Fonte: X @armandjoulin, X @TheZachMueller, X @nrehiew_, X @teortaxesTex, Reddit r/LocalLLaMA, X @karminski3)

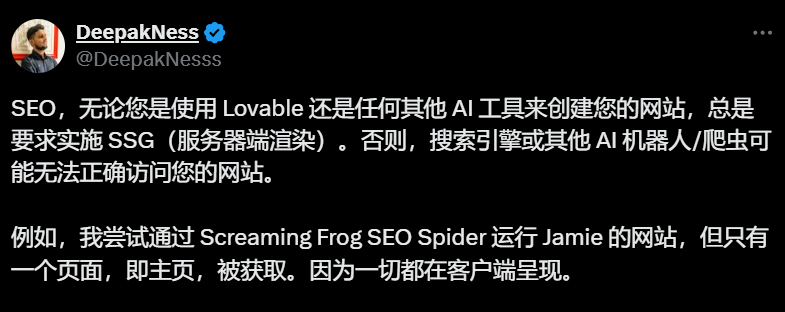

Ferramentas de construção de sites por IA (como Lovable) com renderização padrão no lado do cliente geram preocupações de SEO: Profissionais de SEO e usuários na comunidade apontaram que ferramentas de construção de sites por IA como Lovable, que usam renderização no lado do cliente (CSR) por padrão, podem impedir que rastreadores de motores de busca (como Googlebot) ou robôs de IA (como ChatGPT) capturem conteúdo além da página inicial, afetando severamente a indexação e o ranking do site. Embora o Google afirme que pode processar CSR, o efeito real é muito inferior à renderização no lado do servidor (SSR) ou geração de site estático (SSG). Tentativas dos usuários de guiar Lovable via Prompt para gerar SSR/SSG ou usar Next.js falharam. A comunidade recomenda especificar SSR/SSG no início do projeto ou migrar manualmente o código gerado por IA para frameworks que suportam SSR/SSG (como Next.js) (Fonte: AI Jinxiu Sheng)

Discussão sobre se AI Agents substituirão Apps: A comunidade discute o potencial de desenvolvimento dos AI Agents e seu impacto no modelo tradicional de Apps. A opinião é que, à medida que os AI Agents adquirem capacidades mais fortes de raciocínio, navegação e execução (como chamar ferramentas via MCP), os usuários no futuro podem precisar apenas dar instruções em linguagem natural a um AI Agent, que completará tarefas entre aplicativos e redes, reduzindo assim a necessidade de Apps individuais. O CEO da Microsoft também expressou uma visão semelhante. Mas alguns comentários apontam que a capacidade de raciocínio autônomo dos AI Agents atuais ainda é limitada, e o valor central de muitos Apps (especialmente de entretenimento e sociais) reside na própria experiência de navegação e interação do usuário, e não apenas na conclusão de tarefas, portanto, o modelo de App dificilmente será completamente substituído a curto prazo (Fonte: Reddit r/ArtificialInteligence)

Introdução da funcionalidade de compras no ChatGPT gera preocupações sobre “erosão pela comercialização”: Usuários relataram que, ao fazer perguntas não relacionadas a compras (como o impacto das tarifas no estoque), o ChatGPT retornou uma lista de links de compras. O ChatGPT explicou oficialmente que esta é uma nova funcionalidade de compras lançada em 28 de abril, destinada a fornecer recomendações de produtos, e afirmou que as recomendações são “geradas organicamente” e não anúncios. No entanto, essa mudança gerou preocupações na comunidade sobre “Enshittification” (o valor da plataforma gradualmente se inclinando para interesses comerciais em detrimento da experiência do usuário), considerando isso o início do sacrifício da experiência do usuário pela OpenAI sob pressão comercial, que pode evoluir para recomendações orientadas por anúncios ou comissões no futuro (Fonte: Reddit r/ChatGPT)

Discussão contínua sobre o impacto da IA no mercado de trabalho: A discussão na comunidade sobre se e como a IA substituirá empregos continua. Por um lado, economistas e relatórios argumentam que o impacto geral da IA generativa no emprego e nos salários ainda não é significativo. Por outro lado, muitos usuários compartilharam casos reais e observações: Duolingo anunciou a substituição de trabalhadores contratados por IA; proprietários de empresas afirmaram ter usado IA para substituir alguns cargos de atendimento ao cliente, programação júnior, QA e entrada de dados; freelancers (design gráfico, escrita, tradução, locução) sentiram uma redução nas oportunidades de trabalho; o número de vagas de emprego (como atendimento ao cliente) diminuiu. A visão predominante é que trabalhos repetitivos e baseados em padrões são os primeiros a serem impactados, a IA atualmente funciona mais como uma ferramenta de produtividade, mas seu efeito de substituição já começou a se manifestar e se expandirá gradualmente (Fonte: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

💡 Outros

ISCA Fellow 2025 anunciado, três acadêmicos chineses selecionados: A Associação Internacional de Comunicação por Fala (ISCA) anunciou a lista de Fellows para 2025, com 8 acadêmicos selecionados. Entre eles estão três acadêmicos chineses: Yu Kai, co-fundador da AISpeech e Professor Distinto da Shanghai Jiao Tong University (pelas contribuições para reconhecimento de fala, sistemas de diálogo e implantação de tecnologia, primeiro da China Continental), Professor Hung-yi Lee da National Taiwan University (pelas contribuições pioneiras em aprendizado autossupervisionado de fala e construção de benchmarks comunitários), e Nancy Chen, chefe do grupo de IA generativa no Instituto de Pesquisa em Infocomm (I2R) da A*STAR em Singapura (pelas contribuições e liderança em processamento de fala multilíngue, comunicação humano-computador multimodal e implantação de tecnologia de IA) (Fonte: Jiqizhixin)