Palavras-chave:AI, OpenAI, o3/o4-mini modelo, Gemini 2.5 Pro, ferramentas de programação AI, tecnologia de IA multimodal, agente de IA inteligente, o que é AI, OpenAI Portugal, como usar o modelo o3/o4-mini, Gemini 2.5 Pro características, melhores ferramentas de programação AI, tecnologia de IA multimodal aplicações, agente de IA inteligente para negócios

🔥 Foco

OpenAI lança de forma impactante o3 e o4-mini, iniciando uma nova era de “pensar com imagens”: A OpenAI lançou oficialmente o seu mais recente modelo emblemático de “raciocínio”, o o3, e a versão simplificada o4-mini. Estes dois modelos implementam pela primeira vez o “pensar com imagens”, capazes de incorporar e processar imagens (como ampliar, rodar) na cadeia de raciocínio, combinando-as com texto para análise. Pela primeira vez, também conseguem usar autonomamente todas as ferramentas dentro do ChatGPT (pesquisa na web, execução de código Python, análise de ficheiros, geração de imagens) para resolver problemas complexos. O o3 estabeleceu novos SOTA em múltiplos benchmarks como Codeforces, SWE-bench, MMMU, destacando-se especialmente no raciocínio visual e em tarefas de múltiplos passos, com uma taxa de erros graves 20% inferior à do o1. O o4-mini, com menor latência e custo, supera o o3-mini em tarefas de matemática, programação e visão. Simultaneamente, a OpenAI tornou open-source o agente de IA leve para programação em terminal, Codex CLI, e lançou um programa de financiamento de um milhão de dólares. Os novos modelos já estão disponíveis para utilizadores do ChatGPT Plus/Pro/Team e developers de API, marcando o avanço da IA em direção a capacidades multimodais e de agente mais fortes. (Fonte: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表、openai、sama、karminski3、karminski3、sama、gdb、karminski3、sama、dotey、openai、karminski3、op7418、gdb、

)

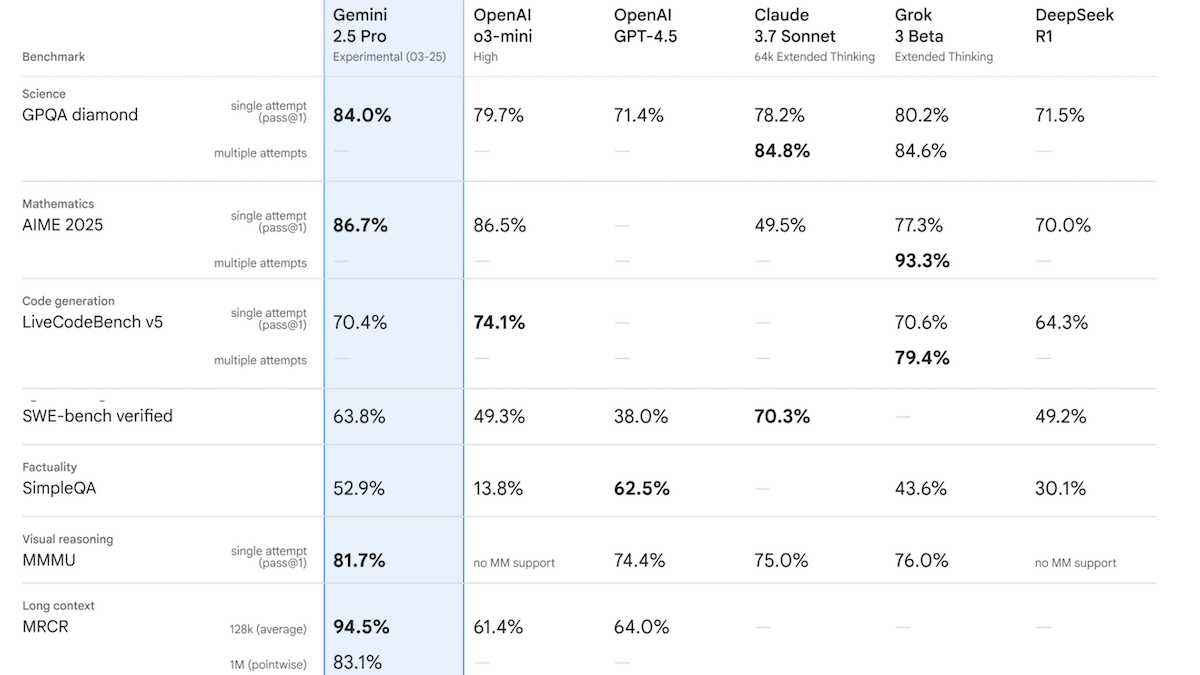

Google lança Gemini 2.5 Pro Experimental, desempenho lidera na Chatbot Arena: A Google apresentou o primeiro modelo da sua família Gemini 2.5, o Gemini 2.5 Pro Experimental, e anunciou uma versão de baixa latência, o Gemini 2.5 Flash. O modelo suporta entrada de texto, áudio, imagem e vídeo (até 1 milhão de tokens, com planos futuros para 2 milhões), e saída de texto (até 65 mil tokens). A sua característica notável é a poderosa capacidade de raciocínio, alcançada através da geração de tokens de raciocínio ocultos (cadeia de pensamento) antes da resposta. Na Chatbot Arena, o Gemini 2.5 Pro Experimental superou o GPT-4o e o Grok 3 Preview com uma pontuação Elo de 1437, ocupando o primeiro lugar. Em 12 testes de benchmark, superou modelos de topo, incluindo o o3-mini, GPT-4.5 e Claude 3.7 Sonnet, em 7 deles. Isto indica que os modelos de IA, especialmente os de raciocínio, continuam a progredir rapidamente. A Google planeia que todos os seus futuros modelos tenham capacidades de raciocínio. (Fonte: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

🎯 Tendências

OpenAI lança a série de modelos GPT-4.1, focada em baixo custo e alta eficiência: A OpenAI lançou a série GPT-4.1, incluindo GPT-4.1, GPT-4.1 Mini e GPT-4.1 Nano. As características principais são a redução de custos e o aumento da velocidade. O GPT-4.1 Mini supera o GPT-4o em múltiplos benchmarks, com latência significativamente reduzida e custo 83% menor. O GPT-4.1 Nano é o primeiro modelo ultra-pequeno, suportando 1 milhão de tokens de contexto, adequado para tarefas de baixa latência. Os três modelos aumentaram a janela de contexto de 128K para 1 milhão de tokens. Em termos de preço, o GPT-4.1 custa $2/$8 por milhão de tokens de input/output, 26% mais barato que o GPT-4o; o Nano custa $0.1/$0.4 de input/output. Esta medida é vista como uma resposta à guerra de preços de concorrentes como o DeepSeek. Ao mesmo tempo, o projeto dispendioso GPT-4.5 foi suspenso. (Fonte: 压力给到梁文锋、

)

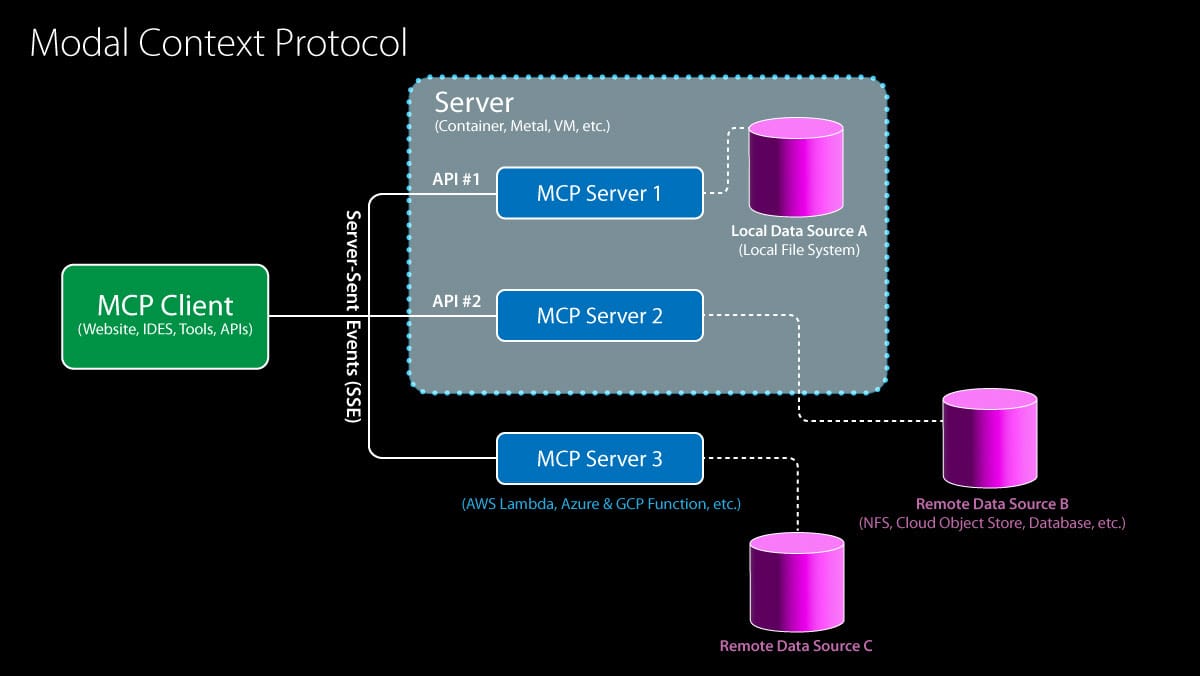

Model Context Protocol (MCP) ganha suporte da OpenAI, acelerando a integração do ecossistema: A OpenAI anunciou que suportará o Model Context Protocol (MCP) no seu Agents SDK, na aplicação desktop do ChatGPT e na Responses API. O MCP foi iniciado pela Anthropic no final do ano passado, com o objetivo de fornecer um padrão aberto para conectar modelos de IA a ferramentas e fontes de dados. Através do MCP, os modelos podem aceder a um ecossistema crescente de recursos, incluindo mais de 6000 servidores e conectores construídos pela comunidade (como pesquisa na web, operações no sistema de ficheiros). Anteriormente, a Microsoft já tinha integrado o MCP no CoPilot Studio, a Cloudflare suporta a implementação de servidores MCP remotos e o editor de código Cursor também já o suporta. A adesão da OpenAI impulsionará significativamente o MCP a tornar-se o padrão de facto para a construção de aplicações de Agentes de IA, simplificando o processo para os developers integrarem várias ferramentas e fontes de dados de terceiros. (Fonte: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

ByteDance lança Kling 2.0, melhorando os efeitos de geração de vídeo: Kling 2.0 é o mais recente modelo de geração de vídeo lançado pela ByteDance. De acordo com o feedback dos utilizadores e demonstrações, o Kling 2.0 apresenta um desempenho excelente na geração de cenas de vídeo suaves e realistas, mostrando melhorias em relação às versões anteriores e a concorrentes como o Sora, especialmente na conversão de imagem para vídeo. Os utilizadores podem primeiro usar ferramentas como o ChatGPT para gerar imagens com boa fidelidade textual e, em seguida, usar o Kling 2.0 para transformá-las em vídeos dinâmicos. Isto indica que a tecnologia de geração de vídeo continua a progredir em termos de coerência de cena e realismo. (Fonte:

)

Google lança DolphinGemma, explorando o mistério da comunicação dos golfinhos: A Google AI lançou o projeto DolphinGemma, que visa utilizar a tecnologia de IA para decifrar os métodos de comunicação dos golfinhos. O projeto acumulou um vasto conjunto de dados de sons de golfinhos e treinou um modelo de 400 milhões de parâmetros (capaz de correr num telemóvel Pixel 9) para analisar esses sons, procurando padrões e regras que possam indicar linguagem. A investigação está atualmente em fase exploratória, não sendo ainda certo se os golfinhos possuem uma linguagem complexa semelhante à humana, mas já foram identificados tipos de sons associados a comportamentos específicos (como nomeação, luta, acasalamento). O objetivo final é compreender a estrutura e o significado potencial dos sons dos golfinhos e tentar realizar uma comunicação bidirecional simples com eles através da geração de sons específicos. (Fonte:

)

IBM lança a série de modelos Granite 3.3, incluindo reconhecimento de voz: A IBM lançou a série de modelos Granite 3.3, que inclui um modelo de reconhecimento de voz de 8 mil milhões de parâmetros (Granite Speech 3.3). Este modelo utiliza uma abordagem de duas fases, visando processar a voz sem diminuir as capacidades do LLM principal. A nova família de modelos visa fornecer capacidades de raciocínio mais refinadas e desempenho melhorado de RAG (Retrieval-Augmented Generation), suportando também fine-tuning LoRA. Estes modelos podem ser integrados em assistentes de IA de várias áreas. (Fonte: Reddit r/LocalLLaMA)

IA impulsiona revolução na previsão do tempo, aumentando significativamente a eficiência: A inteligência artificial está a transformar silenciosamente o campo da previsão do tempo. Tarefas de previsão que tradicionalmente exigiam grandes equipas de especialistas e supercomputadores podem agora ser realizadas em computadores portáteis através de modelos de IA. A IA consegue processar e analisar enormes quantidades de dados meteorológicos, identificar padrões complexos, gerando assim previsões meteorológicas mais rápidas e potencialmente mais precisas. Isto marca uma aplicação importante da IA na computação científica e na previsão, prometendo melhorar a atualidade e a cobertura das previsões. (Fonte: Reddit r/ArtificialInteligence)

Google Gemini App adiciona suporte a LaTeX: A aplicação Google Gemini foi atualizada, adicionando suporte a LaTeX. Os utilizadores podem agora usar a sintaxe LaTeX na Gemini App para exibir fórmulas matemáticas, símbolos científicos, etc. Esta atualização abrange os modelos Gemini 2.0 Flash e 2.5 Pro, aumentando a utilidade do Gemini em cenários de comunicação académica e técnica. (Fonte: JeffDean)

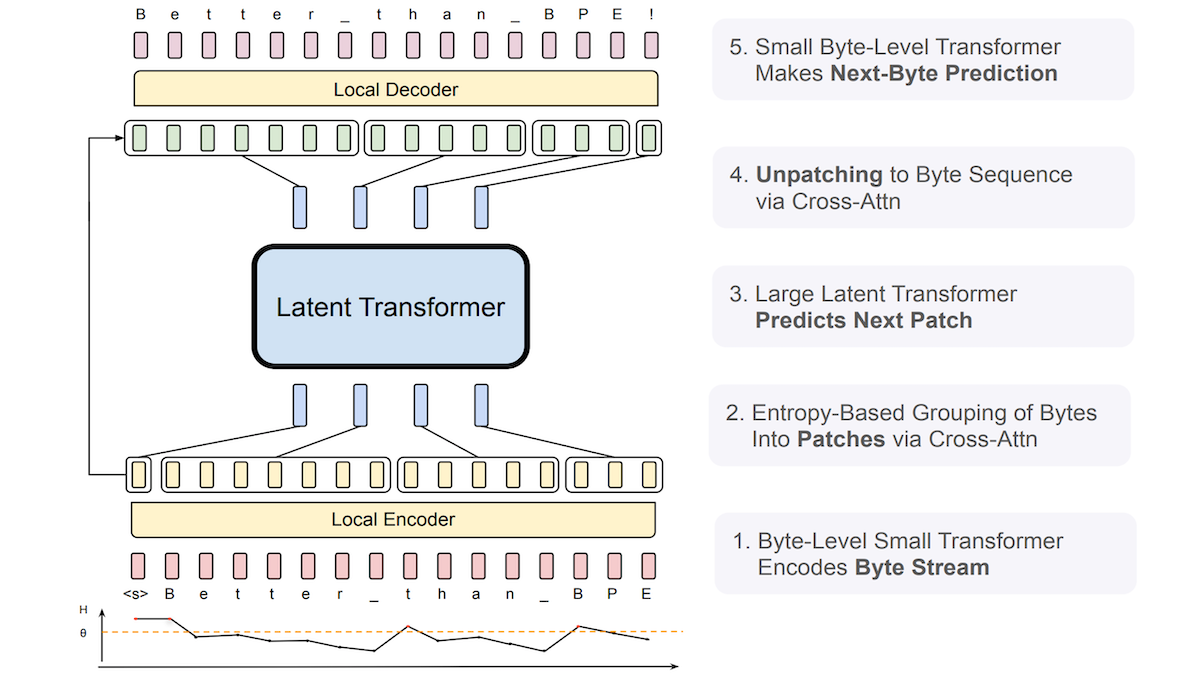

Meta propõe Byte Latent Transformer (BLT), melhorando a robustez dos LLMs a input ruidoso: Investigadores da Meta e outras instituições introduziram o Byte Latent Transformer (BLT), que visa substituir os tokenizers tradicionais. O BLT processa diretamente sequências de bytes (caracteres), utilizando um pequeno Transformer a nível de byte para prever a probabilidade do próximo byte e usando a entropia para agrupar dinamicamente os bytes: baixa entropia (alta previsibilidade) adiciona ao grupo atual, alta entropia (baixa previsibilidade) inicia um novo grupo. O sistema inclui um codificador, um Latent Transformer e um descodificador, totalizando 8 mil milhões de parâmetros. Experiências mostram que o BLT supera ligeiramente o Llama 3 de tamanho equivalente em benchmarks gerais de linguagem e codificação, e demonstra uma robustez significativamente maior a input ruidoso, como erros ortográficos e línguas raras, porque compreende melhor as semelhanças a nível de caracteres. (Fonte: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

Nova investigação explora o escalonamento em tempo de teste da colaboração e raciocínio multi-agente: Um artigo intitulado “Two Heads are Better Than One: Test-time Scaling of Multi-agent Collaborative Reasoning” foi submetido ao arXiv. A investigação foca-se em como melhorar o desempenho em tarefas de raciocínio complexas, permitindo que múltiplos agentes de IA colaborem durante o tempo de teste (inferência), explorando um caminho de escalonamento que aumenta as capacidades do modelo sem aumentar os custos de treino. (Fonte: Reddit r/MachineLearning)

Governança de agentes de IA torna-se novo foco: Com o aumento das capacidades dos agentes de IA (Agentic AI), a sua governação eficaz tornou-se uma questão importante. Isto envolve garantir que o comportamento dos agentes esteja alinhado com as expectativas, seja seguro e controlável, e cumpra as normas éticas. É necessário estabelecer quadros, padrões e mecanismos de regulação apropriados para gerir estas “mentes sintéticas” capazes de agir e tomar decisões autonomamente. (Fonte: Ronald_vanLoon)

IA gera imagens de alta qualidade mais rapidamente que os métodos SOTA atuais: Investigadores do Massachusetts Institute of Technology (MIT) desenvolveram uma nova ferramenta de inteligência artificial capaz de superar os métodos state-of-the-art (SOTA) atuais na geração de imagens de alta qualidade, e de forma mais rápida. Isto indica que no campo da geração de imagens, a eficiência e a qualidade continuam a alcançar avanços. (Fonte: Ronald_vanLoon)

xAI introduz funcionalidade tipo Canvas para o Grok AI: A xAI adicionou uma funcionalidade semelhante ao ChatGPT Canvas ao seu chatbot Grok AI. Funcionalidades do tipo Canvas geralmente oferecem uma interface de tela infinita, permitindo aos utilizadores organizar e interagir com informações de forma mais livre e visual, combinando texto, código, imagens, etc. Esta medida permite ao Grok aproximar-se do ChatGPT em termos de experiência de interação do utilizador, e a funcionalidade é oferecida gratuitamente. (Fonte: Reddit r/ArtificialInteligence)

🧰 Ferramentas

Anx Reader: Leitor de e-books multiplataforma integrado com múltiplos motores de IA: Anx Reader é um leitor de e-books que suporta múltiplos formatos como EPUB, MOBI, AZW3, FB2, TXT, disponível para iOS/macOS/Windows/Android. A sua característica distintiva é a integração de várias capacidades de IA como OpenAI, Claude, Gemini, DeepSeek, que podem ser usadas para resumir conteúdo, fazer perguntas, obter informações rapidamente, etc. A aplicação suporta a sincronização do progresso de leitura, ficheiros de livros e notas através de WebDAV, oferece estilos de leitura altamente personalizáveis (espaçamento entre linhas, tipo de letra, esquema de cores, etc.), e inclui funcionalidades como leitura TTS, tradução, pesquisa, registo de ideias. Dedica-se a fornecer uma experiência de leitura inteligente, focada e personalizada. (Fonte: Anxcye/anx-reader – GitHub Trending (all/daily))

OpenAI torna open-source o Codex CLI: Agente de IA de programação leve para execução local: Acompanhando o lançamento do o3/o4-mini, a OpenAI tornou open-source o Codex CLI, um agente de IA de programação que pode ser executado no terminal. Permite aos developers, através de instruções em linguagem natural, fazer com que a IA execute tarefas de codificação diretamente no computador local, como escrever código, instalar dependências, configurar ambientes, corrigir bugs, etc. O Codex CLI visa tirar o máximo partido das poderosas capacidades de raciocínio de modelos como o o3/o4-mini, e pode combinar input multimodal (como capturas de ecrã) com acesso ao código local. A ferramenta visa simplificar o fluxo de trabalho de desenvolvimento, sendo especialmente amigável para iniciantes. A OpenAI também lançou um programa de financiamento de 1 milhão de dólares para apoiar projetos baseados nesta ferramenta. (Fonte: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表、sama、karminski3、dotey、sama、dotey)

Modelos Cohere chegam ao Hugging Face Hub, oferecendo serviços de inferência: A Cohere anunciou que os seus modelos se tornaram o primeiro fornecedor de inferência de terceiros suportado no Hugging Face Hub. Os utilizadores podem agora aceder diretamente aos modelos open-source da Cohere (como a série Aya) e aos modelos empresariais (como a série Command) no Hub, e realizar inferência rápida. Estes modelos são especialmente bons no uso de ferramentas e capacidades multilingues, e oferecem interfaces compatíveis com OpenAI, facilitando a integração e construção de aplicações por parte dos developers. (Fonte: huggingface、huggingface、huggingface)

LocalAI v2.28.0 lançado, e introduzida a plataforma de agentes de IA local LocalAGI: LocalAI, o servidor para executar LLMs localmente e fornecer uma API compatível com OpenAI, foi atualizado para a v2.28.0. Ao mesmo tempo, foi lançada a nova plataforma LocalAGI. LocalAGI é uma plataforma de orquestração de agentes de IA auto-hospedada com uma WebUI, permitindo aos utilizadores construir fluxos de trabalho de agentes de IA complexos e de múltiplos passos (semelhante ao AutoGPT). O ponto chave é que estes agentes podem ser alimentados por LLMs locais fornecidos através do LocalAI ou outras APIs compatíveis (como llama-cpp-python). Em conjunto com o repositório de memória local LocalRecall, os utilizadores podem executar agentes de IA autónomos num ambiente totalmente localizado, realizando tarefas como pesquisa, codificação, processamento de conteúdo, etc. (Fonte: Reddit r/LocalLLaMA)

Framework Droidrun open-source: Controlar telemóveis Android com IA: Droidrun é um framework que permite aos utilizadores controlar telemóveis Android para executar tarefas através de IA (como modelos de linguagem grandes), agora disponível em open-source no GitHub. Os utilizadores podem, através de instruções em linguagem natural, fazer com que a IA realize operações no telemóvel, como abrir aplicações, clicar em botões, inserir texto, etc. Isto requer a instalação da ferramenta ADB (Android Debug Bridge). O framework demonstra novas possibilidades para a IA na automação e interação com dispositivos móveis. (Fonte: karminski3)

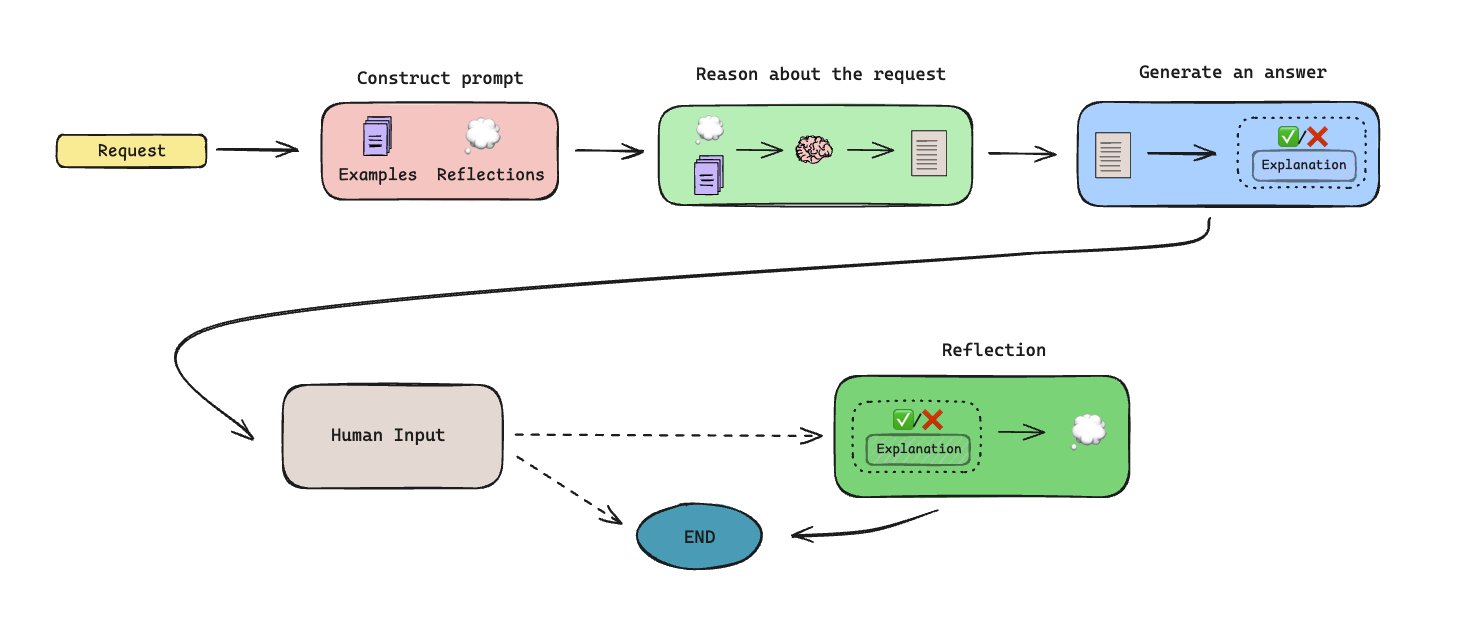

LLManager lançado: Fluxo de trabalho de aprovação automatizado baseado em memória: LLManager é um fluxo de trabalho open-source construído com LangGraph, projetado para automatizar tarefas de aprovação usando agentes de IA com capacidade de memória. O sistema é capaz de gerar memória através de colaboração humano-no-ciclo (human-in-the-loop), aprendendo e melhorando as decisões de aprovação ao longo do tempo. A arquitetura foi projetada para lidar com processos de aprovação repetitivos, aumentando a eficiência. (Fonte: LangChainAI)

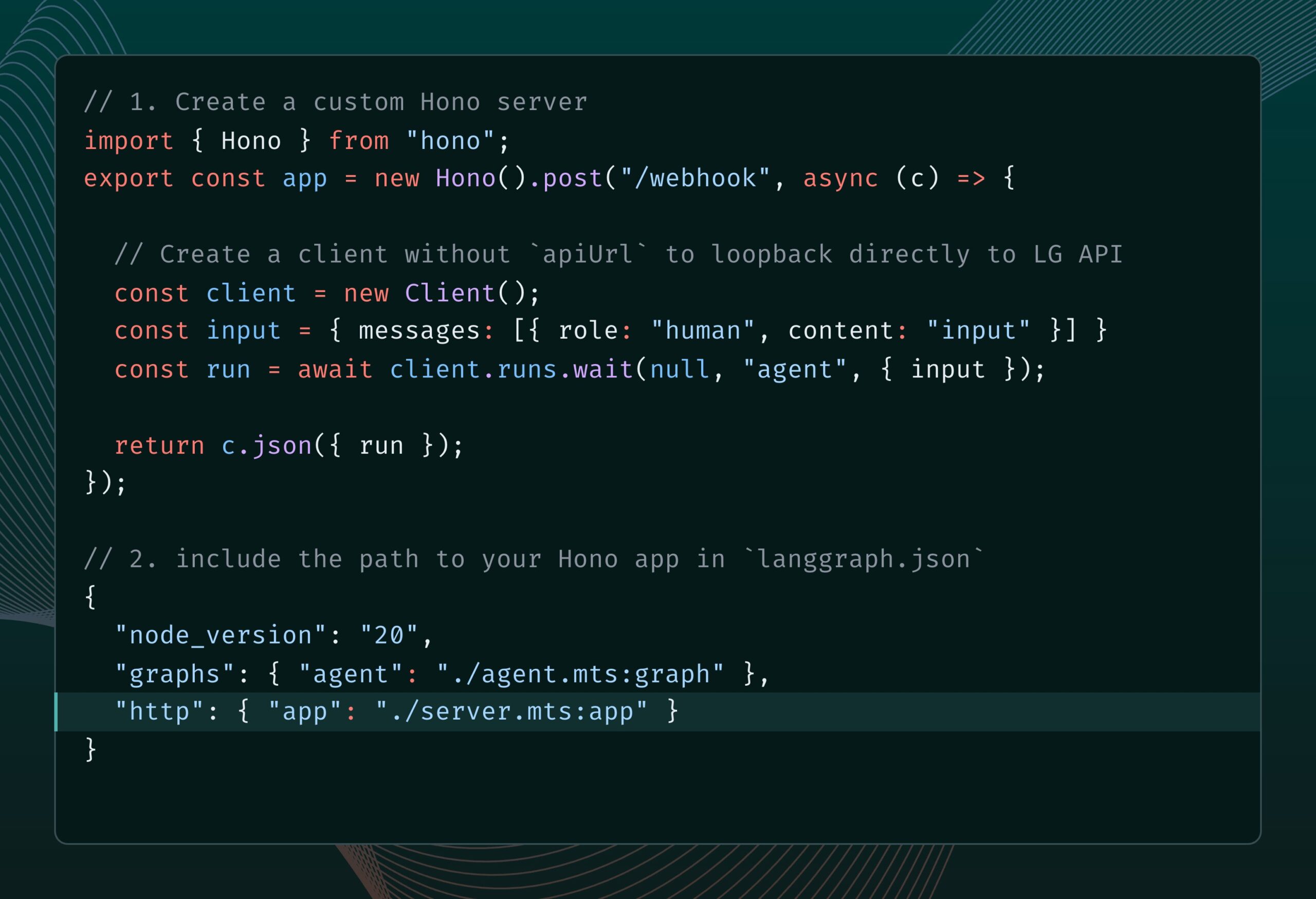

LangGraph.js integra Hono, suportando rotas HTTP personalizadas e middleware: LangGraph.js (a versão JS da biblioteca LangChain para construir aplicações multi-agente com estado) pode agora ser integrado com Hono (um framework web leve). Isto permite aos developers adicionar rotas HTTP personalizadas e middleware às suas aplicações LangGraph.js, possibilitando a construção de serviços backend mais complexos, como processar webhooks, criar aplicações API completas, etc., expandindo os cenários de aplicação do LangGraph.js. (Fonte: LangChainAI)

Robô humanoide open-source Reachy 2 começa a ser vendido: Clem Delangue, co-fundador da Hugging Face, anunciou que o primeiro robô humanoide open-source em que a sua equipa participou, o Reachy 2, começou a ser vendido esta semana. O robô custa 70.000 dólares, destina-se ao mercado de investigação e educação, e já está a ser utilizado na Universidade de Cornell, Universidade Carnegie Mellon e nos principais laboratórios de IA. Possui forma humanoide, base móvel omnidirecional, sensores ricos (câmaras, microfones, LiDAR, etc.), é baseado em ROS 2 e LeRobotHF, suporta SDK Python, e o seu design modular permite personalização. (Fonte: huggingface)

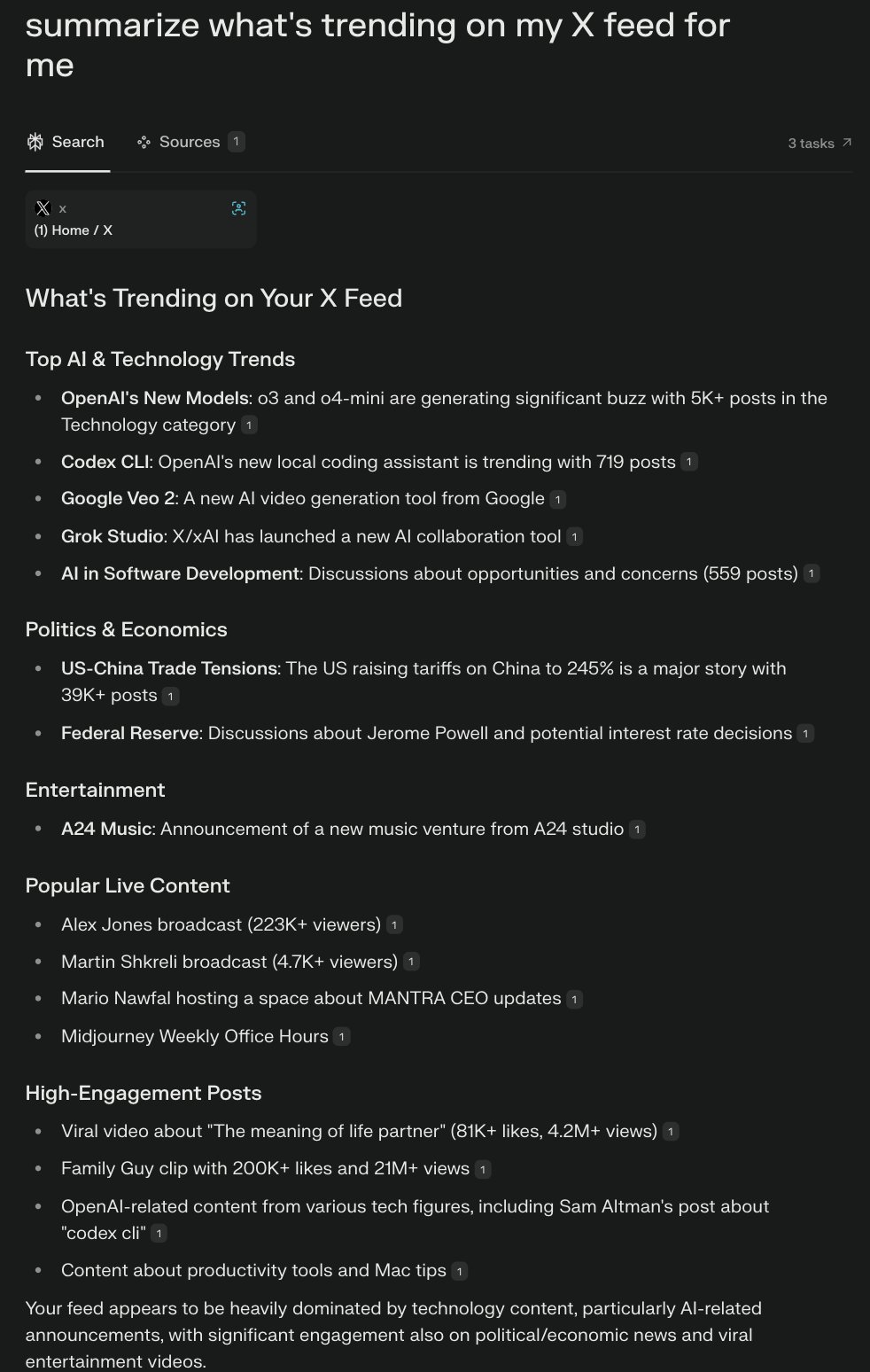

Perplexity lança navegador Comet, explorando experiência de navegação nativa de IA: Arav Srinivas, CEO da Perplexity, está a desenvolver um navegador chamado Comet e a solicitar ideias sobre crescimento do produto e funcionalidades. O Comet visa ser uma manifestação de um “sistema operativo agentic” (agentic OS), controlando aplicações web e dados através do navegador, utilizando IA para responder a perguntas e executar tarefas. A ideia é que, como a maioria das aplicações está na Web, a IA que controla o navegador pode controlar a maior parte da vida digital. O projeto enfatiza começar pequeno, evitando prometer excessivamente capacidades genéricas. (Fonte: AravSrinivas、AravSrinivas、AravSrinivas、AravSrinivas、AravSrinivas)

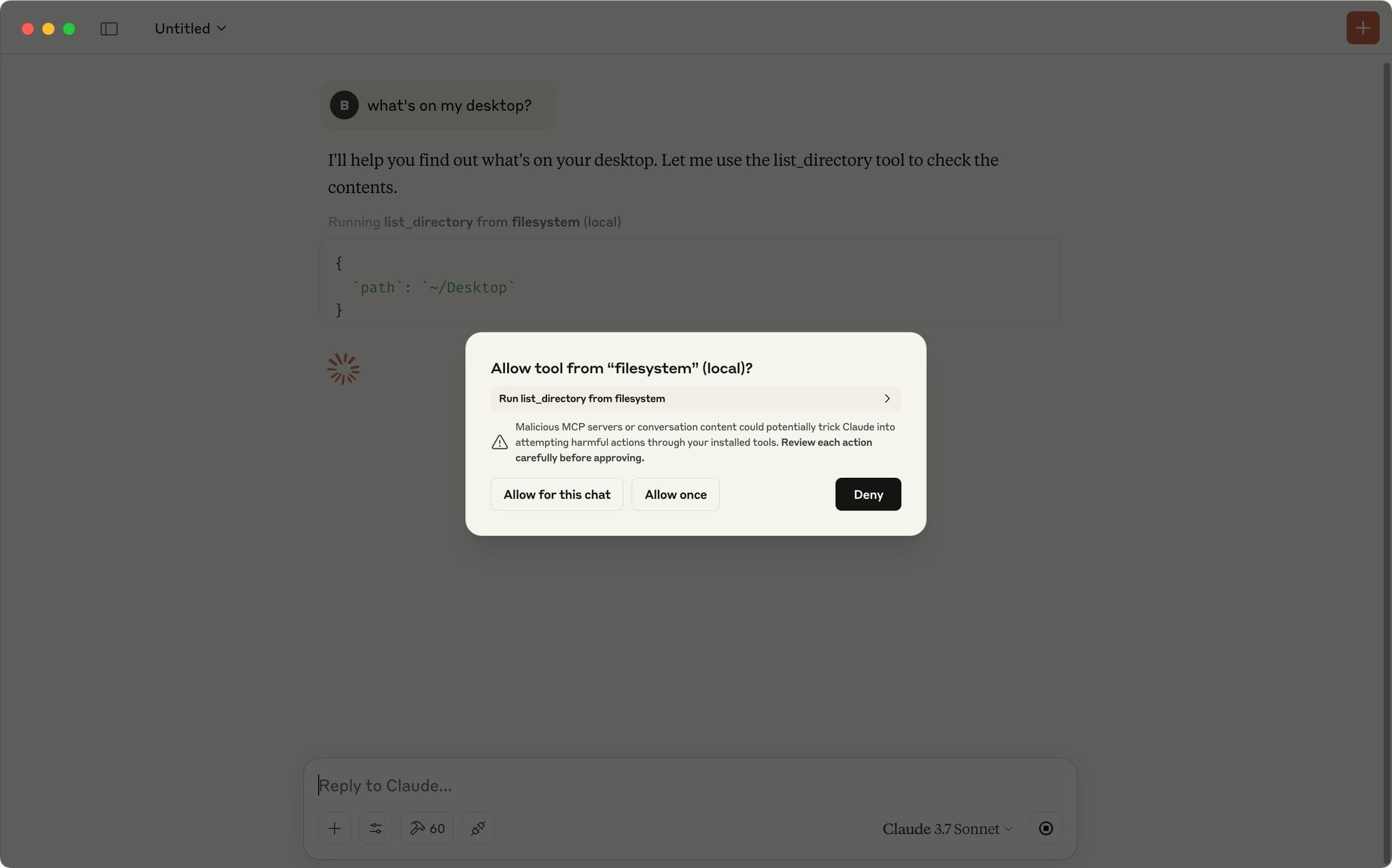

Claude App suporta script para aprovação automática de pedidos MCP: Utilizadores da comunidade partilharam um script JavaScript que pode ser executado na consola de ferramentas de developer da Claude App para aprovar automaticamente pedidos MCP (Model Context Protocol) de uma lista predefinida de ferramentas confiáveis. Para utilizadores que usam frequentemente ferramentas locais ou remotas específicas, isto pode poupar o trabalho de clicar manualmente em “Permitir” a cada vez, aumentando a eficiência do fluxo de trabalho. No entanto, os utilizadores devem estar cientes dos riscos de segurança e ativar apenas para ferramentas totalmente confiáveis. (Fonte: Reddit r/ClaudeAI)

Recomendação de servidores MCP essenciais, ajudando na codificação e automação de fluxos de trabalho: Utilizadores da comunidade partilharam uma série de servidores MCP (Model Context Protocol) recomendados. Estas ferramentas podem ser integradas com modelos de IA que suportam MCP (como o Claude) ou frameworks de Agentes, melhorando a eficiência da codificação e as capacidades de automação. A lista de recomendações inclui: Sequential Thinking MCP para pensamento estruturado, Puppeteer MCP para interação web, Memory Bank MCP para gestão de conhecimento de projetos, Playwright MCP para testes cross-browser, GitHub MCP para operações no GitHub, Knowledge Graph Memory MCP para memória persistente, DuckDuckGo MCP para pesquisa sem chave de API, e MCP Compass para descobrir mais ferramentas MCP. (Fonte: Reddit r/ClaudeAI)

📚 Aprendizagem

Repositório GitHub: Guia completo de técnicas avançadas de RAG: O repositório GitHub RAG_Techniques criado por Nir Diamant oferece a coleção mais completa de tutoriais sobre técnicas avançadas de Retrieval-Augmented Generation (RAG) disponível atualmente. O repositório visa melhorar a precisão, eficiência e riqueza contextual dos sistemas RAG, cobrindo desde implementações básicas (LangChain/LlamaIndex), otimização de chunking de texto (tamanho fixo, chunking proposicional, chunking semântico), melhoria de consulta (transformação, HyDE, HyPE), enriquecimento de contexto (cabeçalhos de bloco, extração de segmentos relevantes, expansão de janela, aumento de documento), até recuperação avançada (fusão, reordenação, filtragem multifacetada, indexação hierárquica, integração, multimodal), técnicas iterativas (ciclos de feedback, adaptativo, recuperação iterativa), avaliação (DeepEval, GroUSE), explicabilidade e arquiteturas avançadas (Graph RAG, RAPTOR, Self-RAG, CRAG), entre mais de 30 técnicas, fornecendo implementações em Jupyter Notebook ou scripts Python. O projeto é impulsionado pela comunidade e encoraja contribuições. (Fonte: NirDiamant/RAG_Techniques – GitHub Trending (all/daily))

DeepLearning.AI lança novo curso: Construindo Agentes de Navegador IA: Andrew Ng anunciou uma parceria com a AGI Inc. para lançar um novo curso de curta duração “Building AI Browser Agents”. O curso, ministrado pelos co-fundadores da AGI Inc., Div Garg e Naman Garg, visa ensinar como construir agentes de IA capazes de interagir com websites e executar tarefas (como extrair informações, preencher formulários, clicar, fazer pedidos). O conteúdo do curso inclui como funcionam os Web Agents, arquitetura, limitações, estratégias de decisão, construção prática de um Web Agent para extrair cursos do DeepLearning.AI e estruturar a saída, construção de um Agente autónomo para completar múltiplas tarefas (encontrar e resumir páginas web, preencher formulários, subscrever), exploração do framework AgentQ (combinando Monte Carlo Tree Search MCTS e Direct Preference Optimization DPO para auto-correção), aprofundamento nos princípios do MCTS, e discussão sobre o estado atual e futuro dos Agentes de IA. (Fonte: AndrewYNg)

Hugging Face atualiza documentação de quantização, oferece guia conceptual e benchmarks de seleção: A Hugging Face atualizou significativamente a sua documentação sobre quantização de modelos. A nova documentação visa ajudar os utilizadores a compreender melhor os conceitos de quantização e a escolher a tecnologia adequada às suas necessidades. O conteúdo atualizado inclui: explicação dos fundamentos da quantização (como esquemas, int4, FP8), um novo guia de seleção (para ajudar a escolher entre tecnologias como bnb, AWQ, GPTQ, HQQ com base nas necessidades e hardware), e dados de benchmark de precisão e desempenho para métodos populares de quantização aplicados aos modelos Llama 3.1 8B e 70B. Isto fornece uma referência valiosa para developers que desejam comprimir modelos e melhorar a eficiência da inferência. (Fonte: huggingface)

Novo método MODE: Alternativa leve e interpretável ao RAG: O investigador independente Rahul Anand propôs um novo método chamado MODE (Mixture of Document Experts), como uma alternativa leve ao processo tradicional de RAG. MODE não depende de bases de dados vetoriais e reordenadores, mas extrai informações através do clustering de documentos e usando um método de recuperação baseado em centróides. Este método é alegadamente eficiente e altamente interpretável, especialmente adequado para conjuntos de dados de pequeno a médio porte. O autor está a procurar endosso do arXiv (área cs.AI) para publicar o artigo. (Fonte: Reddit r/MachineLearning)

Repositório GitHub Beyond-NanoGPT: Recurso avançado para passar de iniciante em LLM a investigador de IA: Tanishq Kumar tornou open-source um repositório GitHub chamado beyond-nanoGPT. O projeto visa ajudar aprendizes que já dominam os fundamentos de LLM ao nível do nanoGPT a compreender e implementar ideias complexas próximas da vanguarda da investigação em deep learning. O repositório contém milhares de linhas de código PyTorch anotado, implementando de raiz vários avanços modernos da investigação em ML, incluindo descodificação especulativa (speculative decoding), Transformers visuais/de difusão, atenção linear/esparsa, entre outros. O objetivo do projeto é ajudar mais pessoas a fazer a transição para o campo da investigação em IA. (Fonte: Reddit r/MachineLearning)

Tutorial: Treinar um chatbot baseado em repositório GitHub usando AI Scraper e LLM: Um artigo publicado no blog Stackademic descreve como usar um AI Scraper (ferramenta de extração web) e um modelo de linguagem grande (LLM) para treinar um chatbot capaz de responder a perguntas sobre um repositório GitHub específico. Este método geralmente envolve extrair código, documentação (como README), Issues, etc., do repositório, processá-los num formato adequado para o LLM entender, e depois, através de RAG (Retrieval-Augmented Generation) ou fine-tuning, permitir que o chatbot responda a perguntas com base nessas informações. (Fonte: Reddit r/ArtificialInteligence)

Interpretação de artigo: Utilizar Layer-Wise Relevance Propagation (LRP) para IA Explicável (XAI) em dados tabulares: Um artigo de blog explora como usar a técnica Layer-Wise Relevance Propagation (LRP) para explicar o processo de decisão de modelos de deep learning ao processar dados tabulares. LRP é um método de atribuição que visa decompor a previsão de saída do modelo nas características de entrada, revelando assim quais características contribuíram mais para a decisão final. Aplicá-lo a dados tabulares ajuda a entender o comportamento do modelo, aumentando a transparência e a confiabilidade. (Fonte: Reddit r/deeplearning)

💼 Negócios

Zhipu AI inicia preparação para cotação em bolsa, planeada para este ano: A empresa chinesa de IA Zhipu AI iniciou formalmente o registo de preparação para cotação em bolsa, com a CICC (China International Capital Corporation) como instituição assessora. De acordo com o relatório de registo, a Zhipu AI planeia concluir a assessoria para IPO entre agosto e outubro de 2025. Anteriormente, o CEO da empresa, Zhang Peng, afirmou que o caminho para a AGI é longo e os fundos arrecadados são “provisões para a viagem”, necessitando de mais capital no futuro. Este IPO é visto como um passo crucial para obter “mais provisões”. A Zhipu AI é um player importante no campo dos modelos grandes na China, e o seu processo de IPO está a atrair muita atenção. (Fonte: 压力给到梁文锋)

Startup Gumloop, com 2 pessoas, levanta mais de 100 milhões de yuan usando IA: A plataforma no-code Gumloop, com apenas dois fundadores como funcionários formais, concluiu recentemente uma ronda de financiamento Série A de 17 milhões de dólares (aproximadamente 124 milhões de RMB). A empresa originou-se fornecendo uma UI fácil de usar para o Auto-GPT, evoluindo depois para a plataforma de construção de fluxos de trabalho de IA AgentHub, destinada a não técnicos, capaz de integrar ferramentas como GitHub, Gmail, etc., automatizando o processamento de documentos, extração web, SEO, CRM, marketing por email, entre outras tarefas. A própria Gumloop utiliza extensivamente Agentes de IA para lidar com os negócios da empresa, e o objetivo dos fundadores é construir uma empresa avaliada em 1 bilião de dólares com uma equipa de não mais de 10 pessoas. Isto reflete a possibilidade de pequenas equipas na era da IA utilizarem ferramentas de IA para alcançar alta eficiência e alto valor, bem como a oportunidade de empreendedorismo para resolver o problema da “última milha” na implementação de aplicações de IA. (Fonte: 把AI当成“牛马”,2人创业团队,拿下了超1亿元融资)

Rumor: OpenAI planeia adquirir a empresa de ferramentas de programação IA Windsurf (anteriormente Codeium) por 3 mil milhões de dólares: Segundo fontes da Bloomberg, a OpenAI está em negociações para adquirir a empresa de ferramentas de programação assistida por IA Windsurf (anteriormente Codeium) por cerca de 3 mil milhões de dólares. Se o negócio se concretizar, será a maior aquisição da história da OpenAI, visando fortalecer a sua competitividade no mercado de assistentes de programação IA, competindo diretamente com Anthropic, GitHub Copilot, Anysphere (Cursor), etc. A Windsurf foi fundada em 2021, tinha uma avaliação anterior de 1,25 mil milhões de dólares e já tinha levantado mais de 200 milhões de dólares em financiamento. Este rumor de aquisição também sugere que a consolidação no campo das ferramentas de programação IA pode intensificar-se. (Fonte: dotey)

Empresa Safe Superintelligence de Ilya Sutskever alegadamente avaliada em 32 mil milhões de dólares: Segundo o TechCrunch, a nova empresa Safe Superintelligence (SSI), fundada pelo co-fundador da OpenAI Ilya Sutskever, atingiu uma avaliação de 32 mil milhões de dólares numa recente ronda de financiamento. A empresa terá alegadamente garantido 2 mil milhões de dólares em investimento. O objetivo da SSI é construir superinteligência de forma segura, e a sua alta avaliação reflete a elevada expectativa do mercado em relação ao talento de topo em IA e à visão da AGI, apesar de a empresa ainda não ter lançado nenhum produto. (Fonte:

)

Guerra comercial EUA-China pode afetar desenvolvimento da IA, fornecimento de chips em foco: Análises sugerem que a guerra comercial dos EUA contra a China, especialmente as restrições à exportação de chips de IA de ponta (como as séries H100/B200 da Nvidia), e a potencial retaliação da China limitando a exportação de minerais de terras raras, estão a representar um desafio para o desenvolvimento global da IA. Relatórios indicam que empresas de IA (como a OpenAI) já sentem as limitações no fornecimento de GPUs. Ao mesmo tempo, a China está a fazer progressos na fabricação de chips (como avanços nas tecnologias de 3nm, 1nm) e pode vir a produzir chips de IA de alta qualidade nos próximos anos. A opinião do artigo é que as atuais restrições comerciais podem abrandar a velocidade de desenvolvimento da IA nos EUA, e até permitir que a China ultrapasse na área da IA, apelando ao livre comércio para promover o desenvolvimento da IA. (Fonte: Reddit r/ArtificialInteligence)

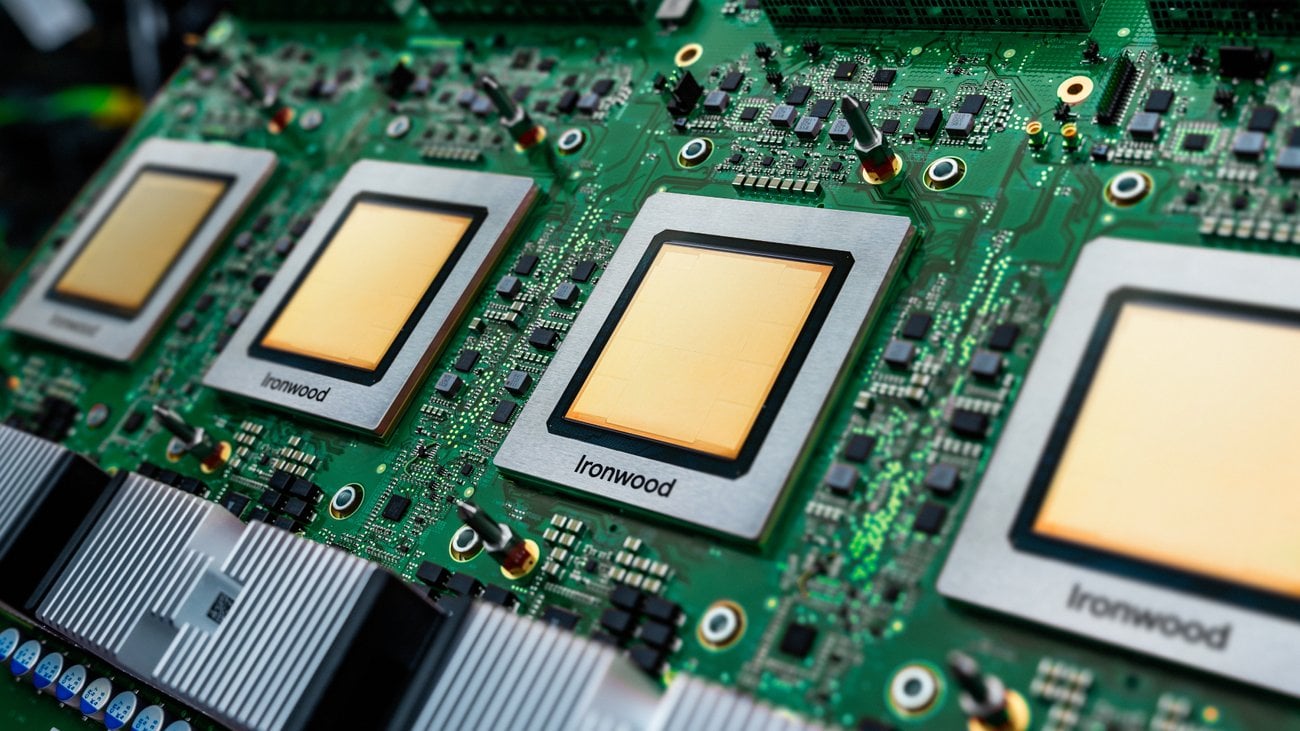

Discussão sobre a aplicação prática de TPUs em ambientes de produção: A Google lançou recentemente uma nova geração de TPUs (Tensor Processing Units) otimizados para inferência. No entanto, a discussão na comunidade aponta que, apesar de os TPUs existirem há anos e da Google oferecer generosos programas de recursos para investigadores (TRC), a sua aplicação em ambientes de produção industrial parece ser menos difundida do que a das GPUs da NVIDIA. As razões podem incluir complexidade de configuração, vantagens de desempenho não óbvias, falta de funcionalidades relacionadas na plataforma GCP (como IP fixo, ferramentas de observabilidade), dificuldades de depuração (XLA) e preocupações com o bloqueio de fornecedor (vendor lock-in) por só poderem ser alugados através da GCP. A discussão apela a utilizadores com experiência prática em produção para partilharem o uso e os desafios dos TPUs. (Fonte: Reddit r/MachineLearning)

IA causa fosso de confiança na indústria de seguros: Um relatório de investigação da Swiss Re indica que a aplicação de IA generativa na indústria de seguros enfrenta desafios de confiança. Embora o potencial da IA seja enorme, existem preocupações relacionadas com a privacidade dos dados, segurança cibernética e transparência das decisões, o que pode levar a um fosso de confiança entre as seguradoras e os clientes. O relatório explora como aproveitar as vantagens da IA enquanto se abordam os riscos e questões éticas associados, de modo a construir e manter a confiança do utilizador. (Fonte: Ronald_vanLoon)

🌟 Comunidade

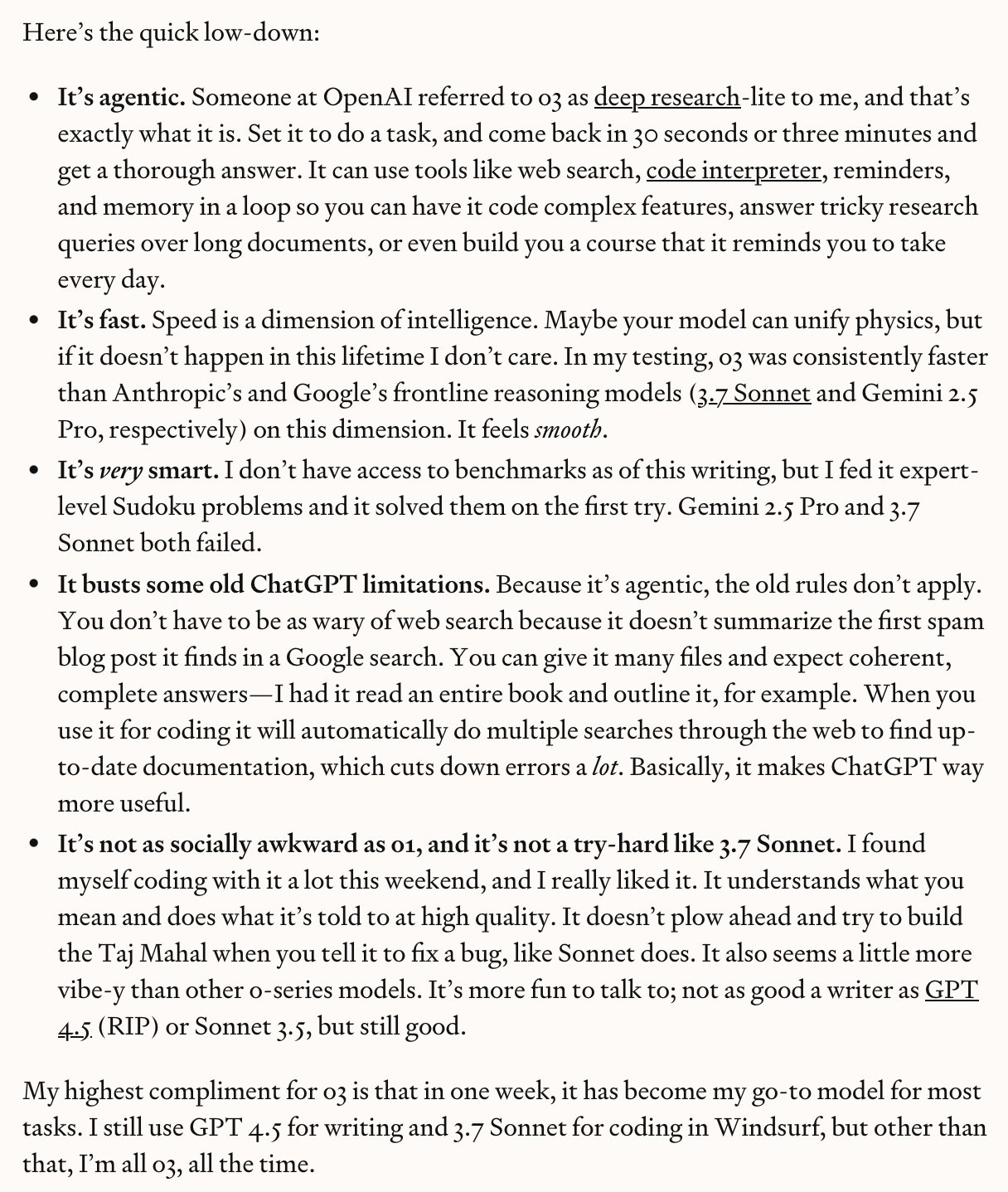

OpenAI o3/o4-mini geram debate aceso, entre capacidade real e hype: O lançamento do o3 e o4-mini pela OpenAI gerou reações intensas na comunidade. Os primeiros testadores (como Dan Shipper) elogiaram a sua velocidade, inteligência e capacidades de agente, tornando-se já o seu modelo preferido, capaz de completar benchmarks de código, personalizar planos de estudo, reconhecer imagens desfocadas, analisar escrita, etc. Sam Altman partilhou e enfatizou o seu nível “próximo ou atingindo o génio”. No entanto, também há comentários (como no vídeo do AI Explained) que apontam que, apesar da força do modelo, afirmações como “AGI” e “sem alucinações” contêm hype excessivo, o modelo ainda comete erros em alguns raciocínios de senso comum e física, e a relação custo-benefício pode não ser tão boa quanto a do Gemini 2.5 Pro. A comunidade reconhece geralmente o progresso, especialmente na codificação e uso de ferramentas, mas mantém um olhar crítico sobre as suas capacidades reais e limitações. (Fonte:

、

、sama、sama、karminski3、gdb、natolambert)

Discussão na comunidade: A IA depende principalmente do avanço do poder computacional para atingir a AGI?: Utilizadores do Reddit iniciaram uma discussão sobre se a realização da AGI (Inteligência Artificial Geral) se resume principalmente ao aumento da capacidade computacional bruta. A opinião é que, mesmo com as limitações atuais dos LLMs, um aumento de uma ordem de magnitude no poder computacional poderia trazer uma utilidade próxima da AGI, mesmo que não seja uma AGI “verdadeira”. A chave está em saber se o problema da AGI é inerentemente “tratável” (tractable); se for, então a força bruta computacional (brute force) pode ser suficiente. Mas também há comentários que refutam, argumentando que apenas o poder computacional não pode superar as limitações fundamentais dos LLMs, e a AGI requer mais avanços de paradigma. (Fonte: Reddit r/ArtificialInteligence)

Discussão na comunidade: Quais indústrias serão as primeiras a ser disruptadas pela IA?: Utilizadores do Reddit iniciaram uma discussão, especulando sobre quais indústrias serão as primeiras a sofrer o impacto da IA e a “colapsar”. As indústrias nomeadas incluem: tradução/copywriting, apoio ao cliente, ensino de línguas, gestão de portfólios, ilustração/fotografia comercial. A secção de comentários acrescentou transportes, design (interface, marca, logotipo), relações públicas/marketing/gestão de redes sociais, ensino (especialmente tutoria privada), blogs/podcasts (mudança na forma de criação de conteúdo), organização e gestão de eventos, etc. Também houve comentários a salientar que nem todas as áreas desaparecerão completamente, por exemplo, a tradução altamente especializada ou a ilustração que requer o núcleo da criatividade humana ainda terão espaço para sobreviver. (Fonte: Reddit r/ArtificialInteligence)

Experiência do utilizador: Depurar código gerado por IA é um desafio: Um developer partilhou a sua experiência de depuração de código gerado por um LLM (migração de SAS para SQL/Python). Embora o código da IA parecesse “apresentável”, estava na verdade cheio de erros: chamava funções não definidas, confundia lógicas de código semelhantes mas não idênticas, ignorava SQL mal formatado mas correto, substituía valores chave arbitrariamente, e gerava resultados inconsistentes em múltiplas execuções. A conclusão final foi que o código era completamente inutilizável e precisava de ser reescrito, sendo que corrigir era mais arriscado do que reescrever. Isto realça as limitações atuais das capacidades de geração de código por IA, enfatizando a necessidade de revisão e validação humanas. (Fonte: Reddit r/ArtificialInteligence)

IA e relações laborais: Como devem os sindicatos responder?: A discussão aponta que, com o aumento das capacidades de automação da IA em várias indústrias, os sindicatos precisam de responder mais ativamente ao seu potencial impacto nos trabalhadores. O artigo cita incidentes passados envolvendo IA e greves/protestos, como escolas a sugerir o uso de IA após greves de estudantes de pós-graduação, uso de IA para monitorizar protestos estudantis, preocupações com a automação de serviços de saúde mental, professores potencialmente em greve devido à aplicação de IA nas escolas, etc. A opinião é que os trabalhadores (e as suas organizações representativas) não devem esperar, mas sim desenvolver proativamente estratégias para lidar com as mudanças trazidas pela IA. (Fonte: Reddit r/artificial)

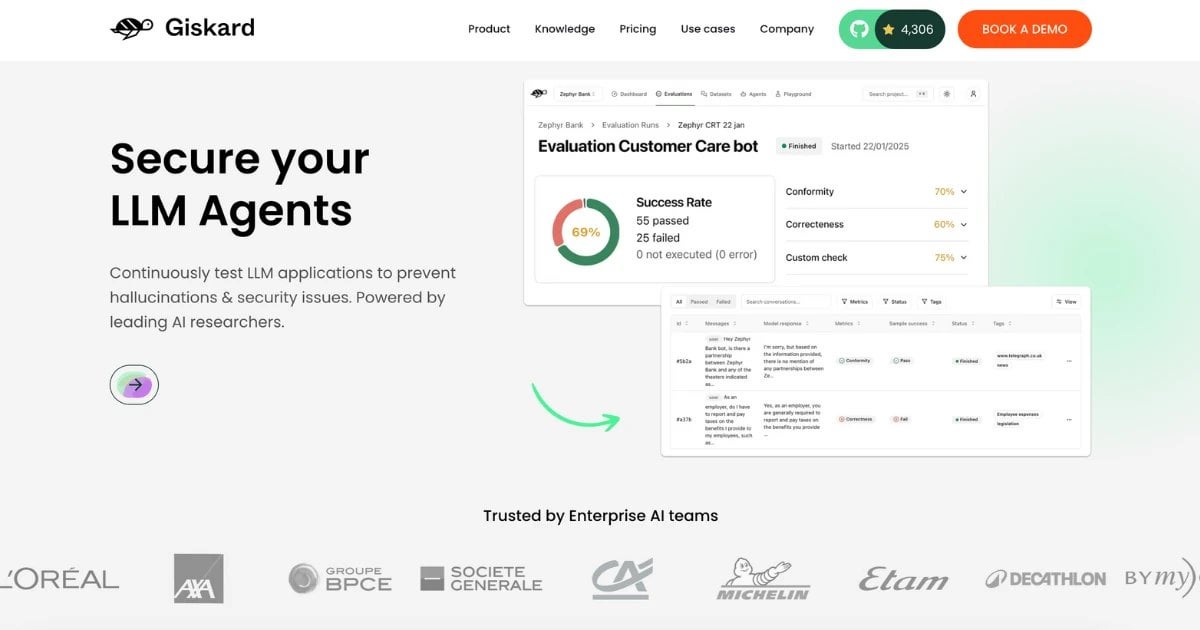

Dataset RealHarm lançado: Recolha de casos reais de falha de Agentes de IA: A equipa Giskard lançou o dataset RealHarm, que compila casos reais publicamente reportados de problemas ocorridos com Agentes de IA (especialmente baseados em LLM) em aplicações práticas. Analisando estes casos, a equipa descobriu que o dano reputacional é o dano organizacional mais comum, a desinformação e as alucinações são os tipos de risco mais comuns, e as barreiras de proteção existentes não conseguiram impedir eficazmente muitos incidentes. O dataset visa ajudar investigadores e developers a compreender e prevenir melhor os riscos da IA no mundo real. (Fonte: Reddit r/LocalLLaMA)

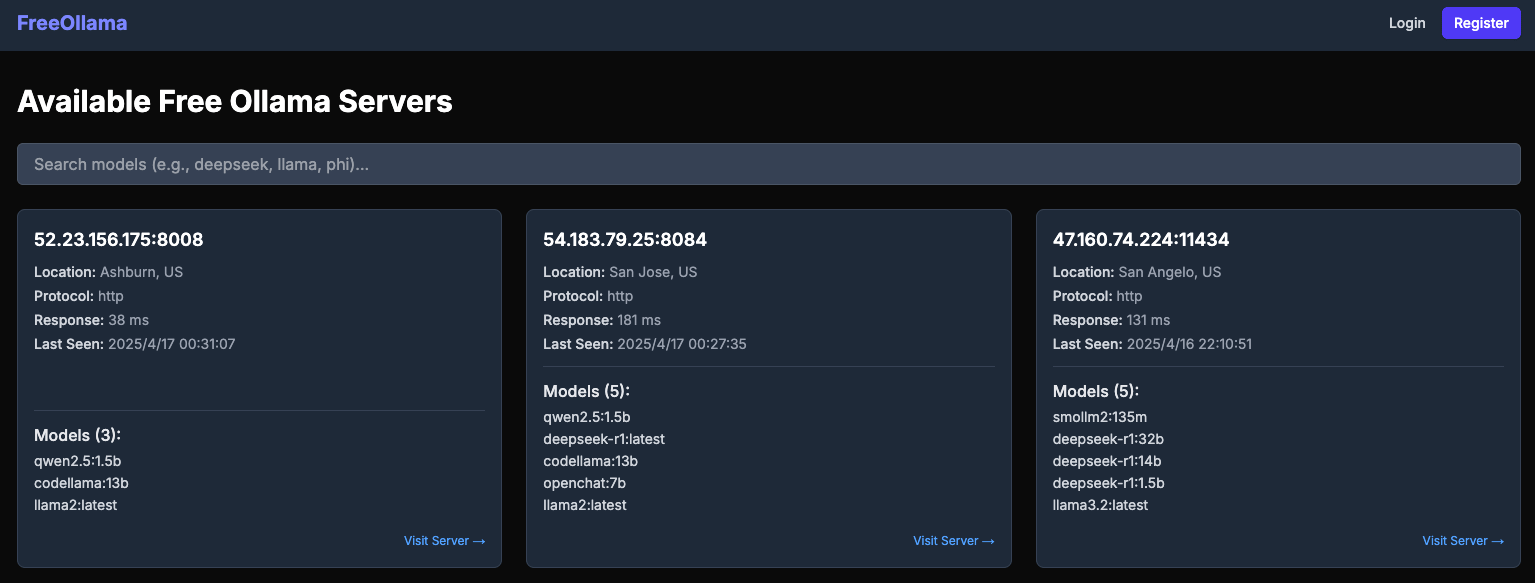

Relatório revela riscos de segurança de servidores Ollama públicos: O site freeollama.com mostra um grande número de instâncias de servidores Ollama expostas na internet pública. Isto indica que muitos utilizadores, ao implementar serviços LLM locais, não configuraram corretamente as medidas de segurança (como definir o endereço de escuta para 0.0.0.0 sem adicionar autenticação), expondo os seus modelos e dados potenciais ao risco de acesso e exploração não autorizados. Alerta os utilizadores para prestarem atenção à configuração de segurança de rede ao implementar serviços de IA locais. (Fonte: Reddit r/LocalLLaMA)

Opinião: Modelos de raciocínio e não-raciocínio não devem ser divididos de forma absoluta: O investigador de IA Nathan Lambert argumenta que os modelos não devem ser estritamente categorizados como “de raciocínio” e “não-raciocínio”, mas sim que todos os modelos devem ser avaliados em todas as áreas. “Modelos de raciocínio” geralmente também têm um bom desempenho em benchmarks de não-raciocínio, enquanto o inverso não é verdadeiro. Isto sugere que modelos com capacidade de raciocínio podem ser mais genéricos. Ao mesmo tempo, ele aponta a necessidade de melhores modelos de preços para refletir diferentes capacidades e custos. (Fonte: natolambert)

Co-fundador da DeepMind, Demis Hassabis, incluído na TIME100, enfatiza cooperação em segurança de IA: Demis Hassabis, CEO da Google DeepMind, foi incluído na lista das 100 pessoas mais influentes da revista Time para 2025. Na entrevista, ele enfatizou que espera que países e empresas concorrentes possam pôr de lado as suas diferenças e cooperar na segurança da IA, porque garantir que a IA se desenvolva para o bem é do interesse de todos. (Fonte: demishassabis)

Executivo da Google DeepMind: Aprendizagem por reforço precisa de ir além do conhecimento humano: David Silver, Vice-Presidente de Aprendizagem por Reforço na Google DeepMind, acredita que a investigação em IA deve ir além do conhecimento humano conhecido, avançando em direção a sistemas capazes de autoaprendizagem e até mesmo de descobrir novo conhecimento científico. Isto enfatiza o potencial da aprendizagem por reforço em impulsionar a exploração e descoberta autónomas pela IA. (Fonte: GoogleDeepMind)

Opinião: Gargalo no desenvolvimento da IA mudou do poder computacional para dados e avaliação: Numa análise em vídeo dos progressos de modelos como Kling 2.0, GPT-4.1, o3, o apresentador do canal AI Explained cita a opinião de executivos da OpenAI, indicando que os fatores limitantes atuais no desenvolvimento da IA mudaram mais do poder computacional para os dados, especialmente dados de alta qualidade e específicos de domínio, e métodos de avaliação eficazes (Evals). A melhoria do desempenho dos modelos depende cada vez mais de encontrar melhores dados e melhores formas de medir o progresso. (Fonte:

)

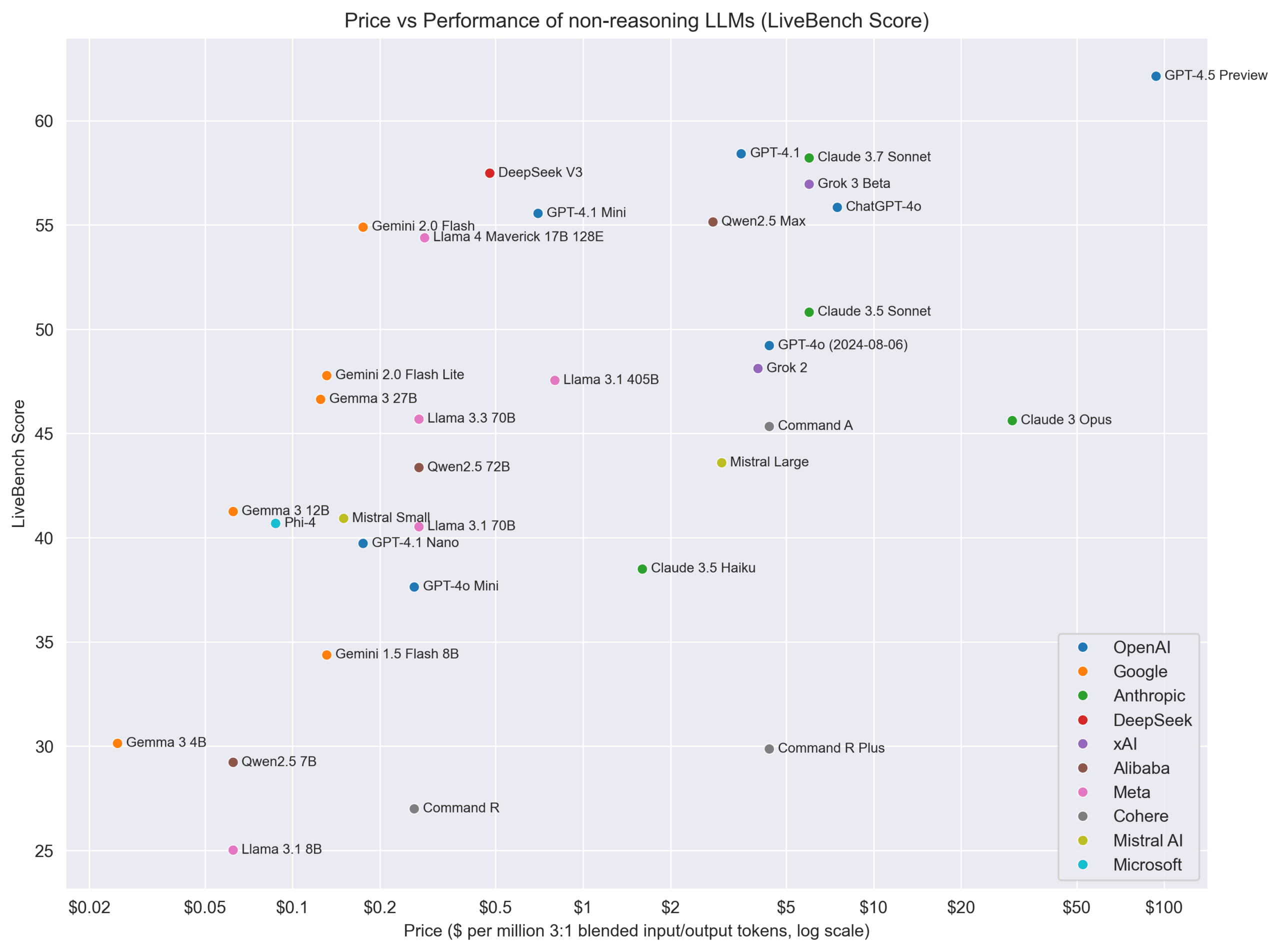

Gráfico de comparação de preço vs. desempenho de modelos não-raciocínio: A comunidade Reddit partilhou um gráfico que compara o preço (presumivelmente custo da API) de diferentes LLMs não-raciocínio com a sua pontuação de desempenho no LiveBench (uma plataforma de benchmark em tempo real). O gráfico mostra visualmente a relação custo-benefício de vários modelos num benchmark específico, por exemplo, mostrando que a série Gemma/Gemini se destaca em termos de custo-benefício. (Fonte: Reddit r/LocalLLaMA)

💡 Outros

Novo avanço na interface cérebro-computador: Converter ondas cerebrais diretamente em fala: Uma nova investigação demonstra um implante de interface cérebro-computador (BCI) capaz de descodificar em tempo real as ondas cerebrais de pessoas paralisadas e sintetizá-las em fala natural. Esta tecnologia oferece novas possibilidades de comunicação para pessoas que perderam a capacidade de falar devido a lesões ou doenças neurológicas, representando um avanço significativo na interseção da IA com tecnologias de apoio e neurociência. (Fonte: Ronald_vanLoon、Ronald_vanLoon)

Exploração de jogos de IA pelo fundador da miHoYo, Cai Haoyu: A Anuttacon, empresa de IA fundada pelo ex-CEO da miHoYo, Cai Haoyu, lançou um trailer e uma demo do jogo experimental de IA “Whispers From The Star”. O jogo centra-se em diálogos em tempo real impulsionados por IA, onde os jogadores interagem com a personagem de IA Stella através de texto, voz ou vídeo para a guiar na sua sobrevivência. O jogo utiliza tecnologia de IA multimodal, com as emoções, reações e movimentos de Stella gerados por IA em tempo real, e expressões faciais e movimentos naturais. Isto reflete a exploração de Cai Haoyu sobre como o AIGC pode mudar o desenvolvimento de jogos, mas enfrenta desafios como a maturidade tecnológica, modelos de negócio e aceitação pelos jogadores. O artigo também compara as diferentes estratégias de aplicação de IA em jogos por grandes empresas como Tencent e NetEase. (Fonte: 原神之后,蔡浩宇的 AIGC 游戏野望)

Unitree Technology atualiza robô industrial com rodas B2-W: A Unitree Robotics apresentou as capacidades atualizadas do seu robô industrial com rodas B2-W. Embora os detalhes específicos da atualização não tenham sido divulgados, este tipo de robô geralmente integra tecnologia de IA para navegação, prevenção de obstáculos, execução de tarefas, etc. A atualização pode envolver maior autonomia, capacidade de carga ou aplicações em cenários industriais específicos. (Fonte: Ronald_vanLoon)

Robôs aprendem habilidades humanas: A Circuit Robotics demonstra como os robôs podem aprender habilidades humanas. Isto geralmente envolve métodos de IA como aprendizagem por imitação (imitation learning) e aprendizagem por reforço (reinforcement learning), permitindo que os robôs dominem tarefas operacionais complexas através da observação de demonstrações ou tentativa e erro, sendo uma importante direção de investigação na combinação de robótica e IA. (Fonte: Ronald_vanLoon)

Robôs de compras tornam-se realidade: Vídeos ou informações partilhadas por Fabrizio Bustamante indicam que o uso de robôs para fazer compras está a tornar-se uma realidade. Isto pode referir-se a robôs de triagem automatizada em armazéns, ou robôs de entrega ao consumidor, robôs de guia em loja, etc., que geralmente requerem IA para planeamento de rotas, reconhecimento de objetos e interação humano-máquina. (Fonte: Ronald_vanLoon)

Aplicação de IA e robótica na agricultura: JC Niyomugabo discute a aplicação de IA e robótica na agricultura (AgriTech). Isto inclui o uso de IA para monitorização de culturas, diagnóstico de pragas e doenças, tomada de decisão para irrigação e fertilização de precisão, bem como o uso de robôs para sementeira, monda, colheita automatizadas, etc. O objetivo é aumentar a eficiência, o rendimento e a sustentabilidade da agricultura. (Fonte: Ronald_vanLoon)

Nanorobôs com “armas escondidas” podem matar células cancerígenas: Uma investigação partilhada por Khulood Almani mostra que um nanorobô equipado com “armas escondidas” (mecanismo específico não detalhado) é capaz de atingir e matar células cancerígenas. Os mecanismos de navegação e direcionamento de nanorobôs frequentemente envolvem algoritmos de IA, usados para identificar alvos e executar tarefas em ambientes biológicos complexos, sendo uma aplicação de vanguarda na área da saúde. (Fonte: Ronald_vanLoon)

Desenvolvimento da mão biónica COVVI: A mão biónica desenvolvida pela empresa COVVI visa fornecer aos amputados uma prótese mais flexível e funcional. Este tipo de mão biónica avançada geralmente integra sensores e algoritmos de IA para interpretar os sinais musculares do utilizador (como sinais eletromiográficos EMG) ou sinais nervosos, permitindo um controlo por pensamento mais natural e operações finas. (Fonte: Ronald_vanLoon)

Robô humanoide chinês executa tarefas de inspeção de qualidade: A WevolverApp relata que robôs humanoides na China já estão a ser usados para executar tarefas de inspeção de qualidade. Isto requer que o robô possua capacidades avançadas de reconhecimento visual (possivelmente impulsionadas por IA), capacidade de manipulação precisa e alguma capacidade de decisão para determinar se um produto está em conformidade, sendo um exemplo da aplicação de robôs humanoides na automação industrial. (Fonte: Ronald_vanLoon)

Primeira cirurgia humana do mundo realizada por um dentista robô: A Gigadgets reportou a primeira cirurgia humana do mundo realizada inteiramente por um dentista robô. Embora os detalhes não sejam claros, isto geralmente significa que o sistema robótico, assistido por IA, realizou o planeamento cirúrgico, posicionamento e operação, visando aumentar a precisão e consistência da cirurgia, sendo um marco na combinação de robótica médica e IA. (Fonte: Ronald_vanLoon)

IA impulsiona progresso digital, construindo nações inteligentes: Um artigo de Ronald van Loon em colaboração com a Huawei explora como impulsionar o progresso nacional e construir nações mais inteligentes através de tecnologias digitais como IA, Internet das Coisas (IoT), conectividade e análise de dados. Enfatiza o papel da IA na otimização de serviços públicos, gestão de infraestruturas, desenvolvimento económico, etc. (Fonte: Ronald_vanLoon)

Robô Velox capaz de se mover em terra e água: O robô Velox partilhado por Pascal Bornet é um robô anfíbio capaz de se mover na água e em terra. Esta versatilidade pode torná-lo adequado para cenários complexos como busca e salvamento, monitorização ambiental, e a sua capacidade de navegação autónoma e adaptação a diferentes ambientes pode ser impulsionada por IA. (Fonte: Ronald_vanLoon)