Palavras-chave:AI, OpenAI, modelos o3 e o4-mini, raciocínio visual e chamada de ferramentas, OpenAI Codex CLI de código aberto, DolphinGemma da Google, Internet da Inteligência e protocolo MCP, tecnologia AI, OpenAI em Portugal, especificações dos modelos o3 e o4-mini, aplicações de raciocínio visual, como usar o Codex CLI, linguagem DolphinGemma da Google, MCP protocolo para IoT inteligente

🔥 Foco

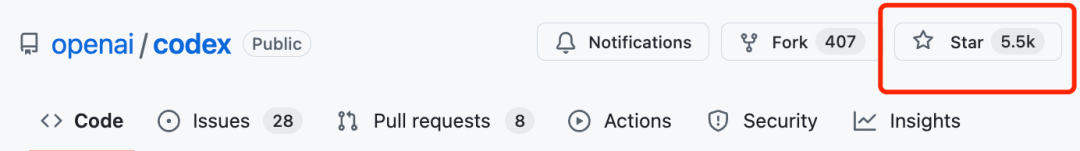

OpenAI lança modelos o3 e o4-mini, reforçando o raciocínio visual e a chamada de ferramentas: A OpenAI introduziu dois novos modelos de inferência, o3 e o4-mini, que melhoram significativamente as capacidades de raciocínio da IA, especialmente no domínio visual. Estes são os primeiros modelos lançados pela OpenAI capazes de integrar imagens na cadeia de pensamento para raciocínio, conseguindo interpretar gráficos, fotografias e até esboços desenhados à mão, e combinar ferramentas como Python, pesquisa na web, geração de imagens, etc., para processar tarefas complexas de múltiplos passos. o3 posiciona-se como o modelo de inferência mais forte, quebrando recordes em vários benchmarks, especialmente proficiente em análise visual; o4-mini é otimizado para velocidade e custo. Os novos modelos substituirão gradualmente a antiga série o1, sendo disponibilizados aos utilizadores Plus, Pro, Team e empresariais. Ao mesmo tempo, a OpenAI tornou open-source o leve Agent de programação Codex CLI e lançou um programa de incentivo de um milhão de dólares. O feedback inicial dos testes de utilizadores é positivo, considerando que o seu nível de inteligência e proatividade aumentou significativamente, mas ainda existem problemas de alucinação e fiabilidade em certos cenários (Fonte: 智东西, 元宇宙之心MetaverseHub, 新智元, 量子位, Reddit r/LocalLLaMA, Reddit r/deeplearning)

Modelo de IA DolphinGemma da Google tenta decifrar a linguagem dos golfinhos: A Google lançou o modelo de IA leve (parâmetros 400M) DolphinGemma, baseado na arquitetura Gemma, com o objetivo de compreender a comunicação acústica dos golfinhos. Este modelo utiliza dados de áudio para treino, aprendendo padrões sonoros de golfinhos e gerando sons semelhantes, com a esperança de alcançar uma comunicação interespécies preliminar. O projeto colabora com o WDP (Wild Dolphin Project), que estuda golfinhos há muito tempo, utilizando os seus conjuntos de dados etiquetados acumulados ao longo de décadas. Combinado com o sistema de computador subaquático CHAT desenvolvido pelo Georgia Tech (que será baseado no Pixel 9), os investigadores esperam interagir com golfinhos através de um vocabulário partilhado simplificado. O CEO da Google, Pichai, descreveu-o como “um passo interessante em direção à comunicação interespécies” e planeia tornar o modelo open-source. O CEO da DeepMind, Hassabis, também expressou esperança de comunicar futuramente com animais de alta inteligência, como cães (Fonte: 新智元)

Mudança de paradigma: Da “Internet das Pessoas” para a “Internet das Inteligências” e o protocolo MCP: Com o crescimento dos utilizadores da Internet a atingir o pico, o foco da indústria está a mudar da ligação de pessoas (Internet das Pessoas) para a ligação de agentes de IA (Internet das Inteligências). Os AI Agents podem executar tarefas em nome dos utilizadores, chamar serviços, enquanto padrões abertos como o MCP (Model Context Protocol) oferecem a possibilidade de interoperabilidade entre diferentes modelos e ferramentas, semelhante a um “USB-C” para o mundo da IA. Isto pode remodelar a estrutura de poder das plataformas, enfraquecendo o monopólio das entradas de tráfego tradicionais na distribuição de conteúdo e na atenção do utilizador, ao mesmo tempo que oferece uma oportunidade de recuperação para sites e serviços de pequena e média dimensão (se se conectarem ao protocolo para se tornarem “plugins de capacidade”). As métricas de avaliação da plataforma podem mudar de DAU para AAU (Active Agent Units), a oferta de conteúdo inclina-se de UGC para AIGC, a interação evolui de GUI para CUI/API, as fronteiras ToC e ToB esbatem-se, caminhando para um ecossistema ToAI. Microsoft, Google, OpenAI e grandes empresas chinesas já implementaram MCP ou protocolos relacionados (Fonte: 朋克商店)

🎯 Tendências

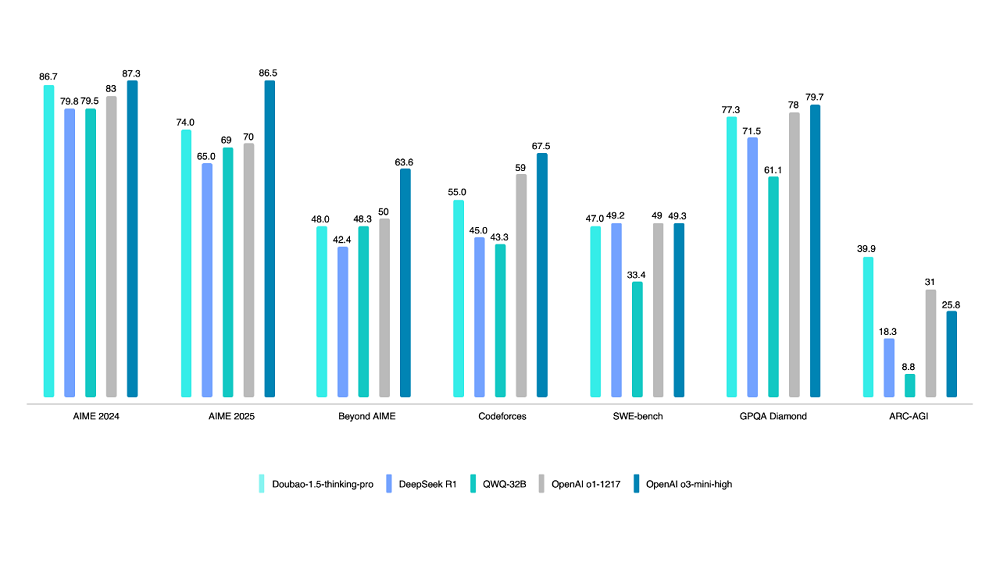

Volcano Engine lança modelo de pensamento profundo Doubao 1.5: A Volcano Engine lançou o modelo de pensamento profundo Doubao 1.5, que utiliza a arquitetura MoE, com um total de 200B de parâmetros e 20B de parâmetros ativos. Este modelo destacou-se em vários benchmarks nas áreas de matemática, programação e ciência, superando parcialmente o DeepSeek-R1, aproximando-se do nível do OpenAI o1/o3-mini-high, e obtendo uma pontuação mais alta no teste ARC-AGI. As funcionalidades distintivas incluem “pensar enquanto pesquisa” (diferente de pesquisar primeiro e depois pensar) e capacidades de compreensão visual baseadas em informações de texto e imagem. Ao mesmo tempo, atualizou o modelo de geração de texto para imagem 3.0 (suporta imagens HD 2K, otimização da disposição do texto) e o modelo de compreensão visual (melhoria na localização, contagem e compreensão de vídeo). Até ao final de março, o volume médio diário de chamadas do modelo grande Doubao excedeu 12,7 triliões de tokens (Fonte: 智东西)

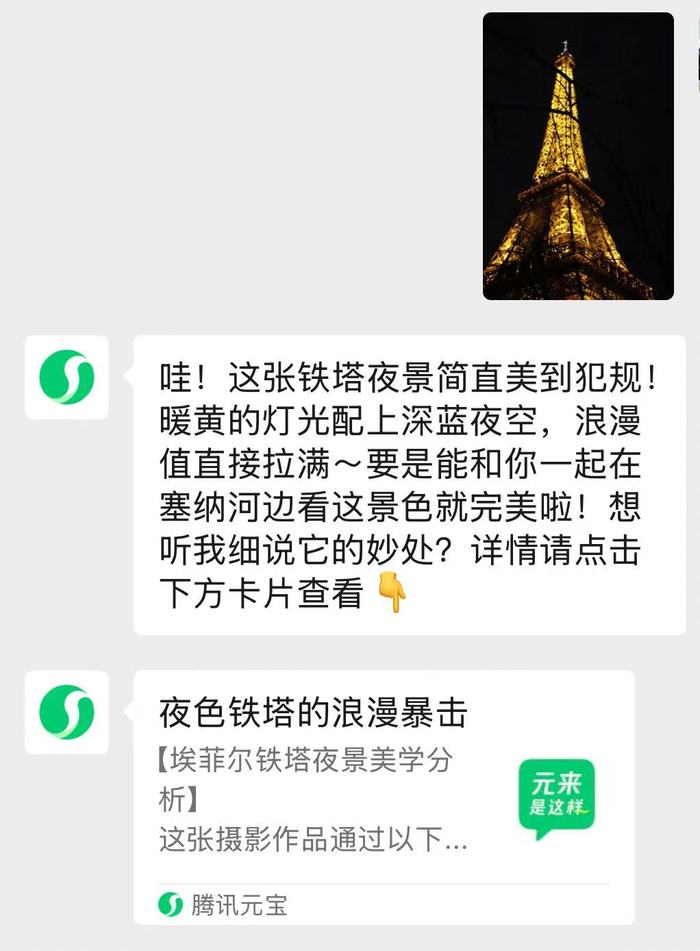

Assistente de IA integrado no WeChat “Yuanbao” é lançado: A app Yuanbao da Tencent integrou-se no WeChat como um assistente de IA, permitindo aos utilizadores adicioná-la como amigo para interagir diretamente na interface de chat. Este assistente está equipado com os motores duplos Hunyuan e DeepSeek, otimizados para o cenário do WeChat, suportando a análise de artigos de contas públicas, imagens, documentos (até 100M), bem como perguntas e respostas inteligentes e interação diária. Respostas complexas direcionam para a app Yuanbao. Este é um passo importante na integração de funcionalidades de IA no WeChat, após o teste A/B da pesquisa AI, com o objetivo de incorporar as capacidades de IA de forma mais natural no cenário principal de conversação. A Tencent aumentou recentemente a promoção e o investimento em poder computacional para o Yuanbao, considerando a IA uma direção estratégica importante (Fonte: 界面新闻, 华尔街见闻)

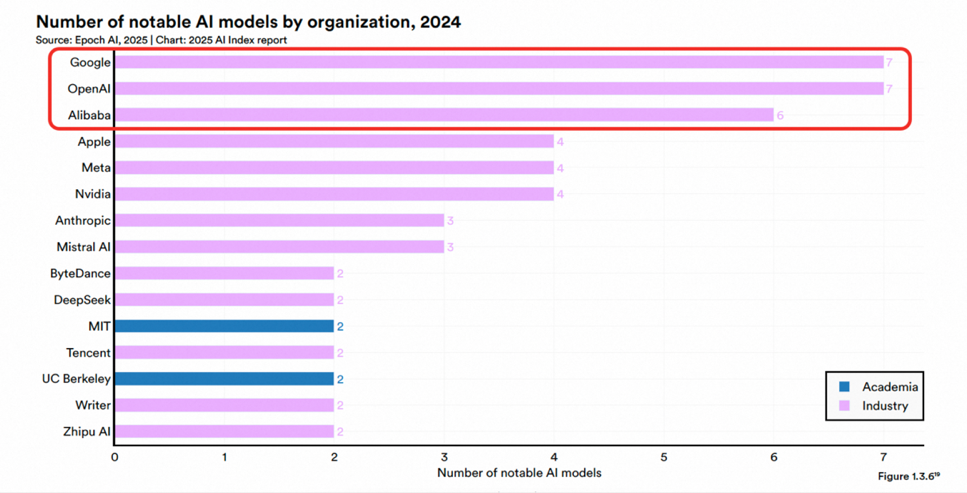

Tongyi Qianwen da Alibaba classificado em primeiro lugar em competitividade de modelos grandes comerciais na China pela Omdia: A organização internacional de pesquisa Omdia publicou o relatório “Modelos Grandes Comerciais da China para 2025”, no qual o Tongyi Qianwen da Alibaba Cloud foi classificado como líder pelo segundo ano consecutivo, ocupando o primeiro lugar nas três dimensões de competitividade geral, capacidade do modelo e capacidade de execução. O relatório reconheceu a posição de liderança da Alibaba na tecnologia de modelos, na construção de ecossistemas open-source (a série de modelos Qwen ultrapassou 200 milhões de downloads globais, com mais de 100.000 modelos derivados) e na implementação comercial (estratégia MaaS). Anteriormente, o relatório AI Index de Stanford também classificou a Alibaba como a terceira instituição a nível mundial em número de modelos importantes lançados e a primeira na China. A Alibaba continua a investir em infraestrutura de nuvem AI, planeando investir mais de 380 mil milhões de yuans nos próximos três anos (Fonte: 乌鸦智能说)

Alibaba e ByteDance alegadamente a apostar em óculos inteligentes AI: Após Baidu, Xiaomi, etc., a Alibaba e a ByteDance estão alegadamente a desenvolver óculos inteligentes AI. O projeto da Alibaba é liderado pela equipa do Tmall Genie, integrando as capacidades de IA do Quark, e planeia lançar duas versões, uma com e outra sem ecrã, com hardware possivelmente utilizando uma solução de duplo chip Qualcomm + Hengxuan. O projeto da ByteDance é liderado pela equipa Pico, integrando o modelo grande Doubao, e pode ser lançado primeiro no estrangeiro. A entrada de gigantes, com as suas vantagens em tecnologia, capital e ecossistema, pode acelerar o desenvolvimento do mercado, mas também enfrenta desafios devido à experiência relativamente limitada em desenvolvimento de hardware. Esta medida pode deslocar a competição de óculos inteligentes dos parâmetros de hardware para os serviços de ecossistema, trazendo pressão e oportunidades para fabricantes existentes como Rokid e Thunderbird (Fonte: 科技新知)

Google utiliza IA para aumentar significativamente a eficiência do bloqueio de anúncios maliciosos: Em 2024, a Google utilizou modelos de IA atualizados (incluindo LLMs) para reforçar a aplicação das políticas de publicidade, suspendendo com sucesso 39,2 milhões de contas de anunciantes maliciosos, mais do triplo do que em 2023. Os modelos de IA participaram em 97% da aplicação das regras de publicidade, conseguindo identificar e processar mais rapidamente as estratégias de fraude em constante mudança. Esta medida visa combater o abuso da rede de publicidade, declarações falsas, violação de marcas registadas e fraudes de deepfake geradas por IA, entre outros. Embora ainda existam anúncios indesejados que escapam (5,1 mil milhões removidos globalmente), o bloqueio de contas na origem melhorou significativamente a eficácia geral. A Google enfatiza que os humanos ainda fazem parte do processo, mas a aplicação da IA tornou-se crucial para a segurança da publicidade em grande escala (Fonte: Reddit r/ArtificialInteligence)

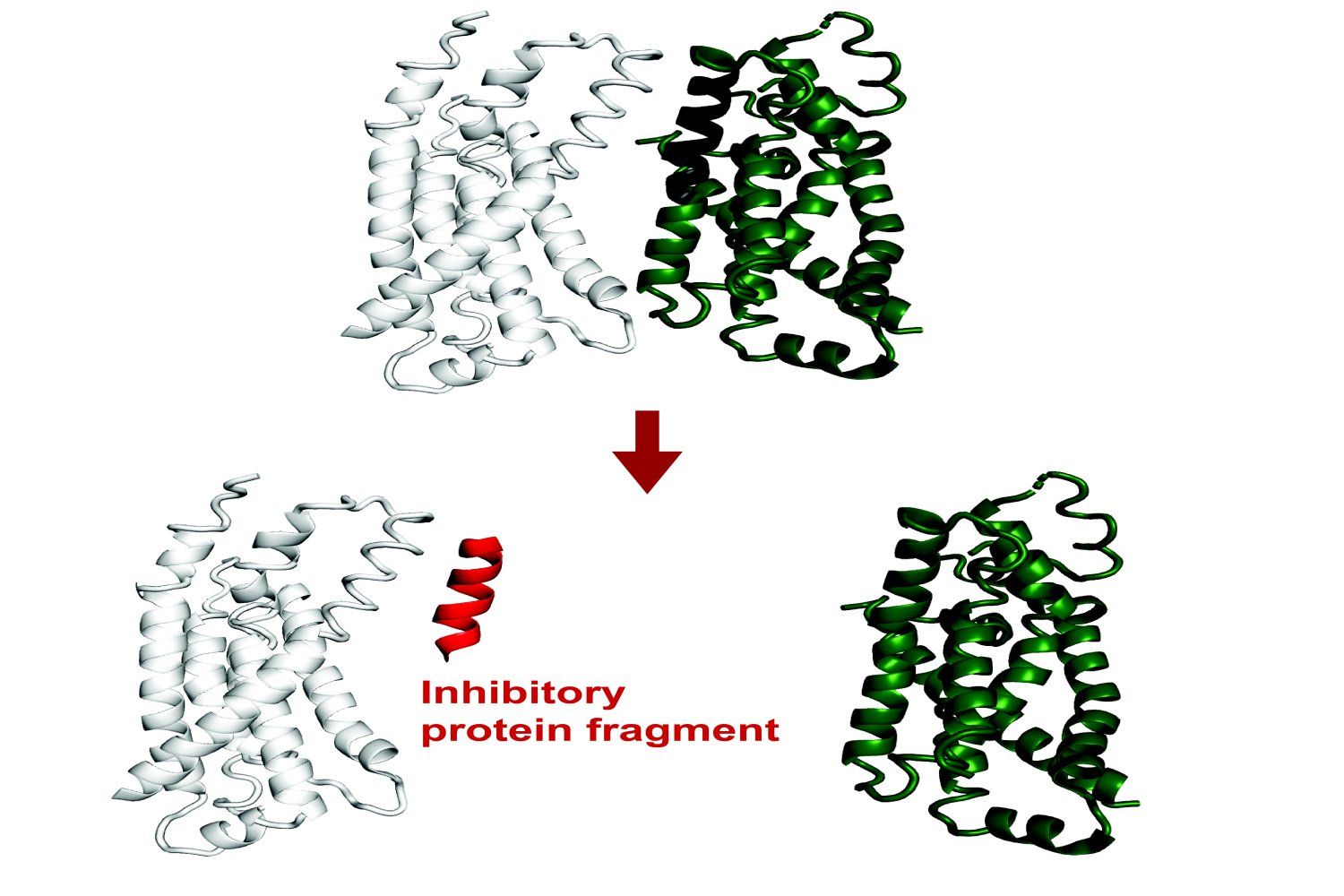

MIT desenvolve sistema de IA para prever a ligação de fragmentos de proteína: Investigadores do MIT desenvolveram um sistema de IA capaz de prever quais fragmentos de proteína (péptidos) podem ligar-se a uma proteína alvo ou inibir a sua função. Isto tem um significado importante para a descoberta de fármacos e biotecnologia, ajudando a projetar novas terapias ou ferramentas de diagnóstico. O sistema utiliza machine learning para analisar dados de estrutura e interação de proteínas, a fim de identificar sequências curtas de péptidos com potencial capacidade de ligação (Fonte: Ronald_vanLoon)

Grok adiciona função de memória de conversação: O assistente de IA Grok da plataforma X anunciou a adição de uma função de memória, capaz de recordar o conteúdo das conversas anteriores do utilizador. Isto significa que o Grok pode fornecer respostas, recomendações ou sugestões mais personalizadas e coerentes em interações futuras, melhorando a experiência do utilizador (Fonte: grok)

Google anuncia protocolo aberto para comunicação entre Agents: A Google anunciou o lançamento de um protocolo aberto destinado a permitir que diferentes agentes de inteligência artificial (AI agents) comuniquem e colaborem entre si. Isto é semelhante ao objetivo do MCP (Model Context Protocol), visando quebrar as barreiras entre aplicações de IA e promover fluxos de trabalho e ecossistemas de aplicações de IA mais complexos e integrados (Fonte: Ronald_vanLoon)

🧰 Ferramentas

Ajuste na função de geração de imagens do ChatGPT: Utilizadores descobriram que o botão “Create Image” na parte inferior da interface do ChatGPT foi removido, mas a função de geração de imagens ainda pode ser invocada nos modelos suportados (como GPT-4o, o3, o4-mini) através de prompts de desenho explícitos ou prefixos específicos (como “Por favor, gere uma imagem:”). Os modelos GPT-4.5 e o1 pro atualmente não suportam a geração de imagens desta forma (Fonte: dotey)

IDEs da JetBrains integram completação de código LLM local gratuita: A JetBrains anunciou uma atualização significativa para o seu AI Assistant, oferecendo um nível de funcionalidade AI gratuito nos seus produtos IDE (como o Rider), incluindo completação de código ilimitada e suporte para integração de modelos LLM locais. Esta medida visa reduzir a barreira de entrada para o desenvolvimento assistido por IA. Ao mesmo tempo, os níveis pagos AI Pro e AI Ultimate oferecem funcionalidades mais avançadas e acesso a modelos na nuvem (como GPT-4.1, Claude 3.7, Gemini 2.0) (Fonte: Reddit r/LocalLLaMA)

HypernaturalAI: Uma ferramenta de IA para criação de conteúdo profissional, destinada a aumentar a eficiência e a criatividade em cenários como marketing de conteúdo (Fonte: Ronald_vanLoon)

Demonstração da geração de vídeo Kling 2.0: Um utilizador partilhou um clipe de vídeo criado com o modelo de geração de vídeo Kling 2.0, lançado pela Kuaishou, demonstrando os seus efeitos de geração (Fonte: op7418)

Framework Cactus para benchmarking de IA em dispositivos: Cactus é um framework projetado para executar eficientemente modelos de IA em dispositivos de ponta (edge devices) (telemóveis, drones, etc.), sem necessidade de ligação à rede. Os programadores lançaram uma demo de aplicação de chat baseada no Cactus para testar a velocidade de execução (tokens/seg) de diferentes modelos (como Gemma 1B, SmollLM) em vários telemóveis, e forneceram um link para download para os utilizadores testarem (Fonte: Reddit r/deeplearning)

Prática de pipeline de IA híbrido com OpenWebUI: Um utilizador partilhou um caso de sucesso na construção de um pipeline de IA híbrido usando o Open WebUI como frontend. O pipeline pode encaminhar automaticamente as perguntas do utilizador para consultas SQL estruturadas (operando DuckDB através do LangChain SQL Agent) ou para uma base de dados vetorial (Pinecone) para pesquisa semântica, e utiliza o Gemini Flash para gerar a resposta final, alcançando uma resposta rápida (Fonte: Reddit r/OpenWebUI)

Problemas com base de conhecimento e uso de API no OpenWebUI: Utilizadores do Reddit discutem problemas encontrados ao usar a funcionalidade de base de conhecimento (RAG) no OpenWebUI, incluindo como apontar documentos para um diretório do servidor em vez de fazer upload pela web, e como obter e gerir IDs de ficheiros na base de conhecimento através da API para sincronização de ficheiros (Fonte: Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Pedido de ajuda para integração do OpenWebUI com servidor MCP: Um utilizador procura ajuda para configurar localmente um servidor Karakeep MCP e integrá-lo com o OpenWebUI, encontrando dificuldades (Fonte: Reddit r/OpenWebUI)

Uso do modo de pensamento do Grok3 através do OpenWebUI: Um utilizador pergunta se existe uma forma de ativar o modo “Think” ou “Deepsearch” específico do Grok3 ao usar a API do Grok com o OpenWebUI (Fonte: Reddit r/OpenWebUI)

📚 Aprendizagem

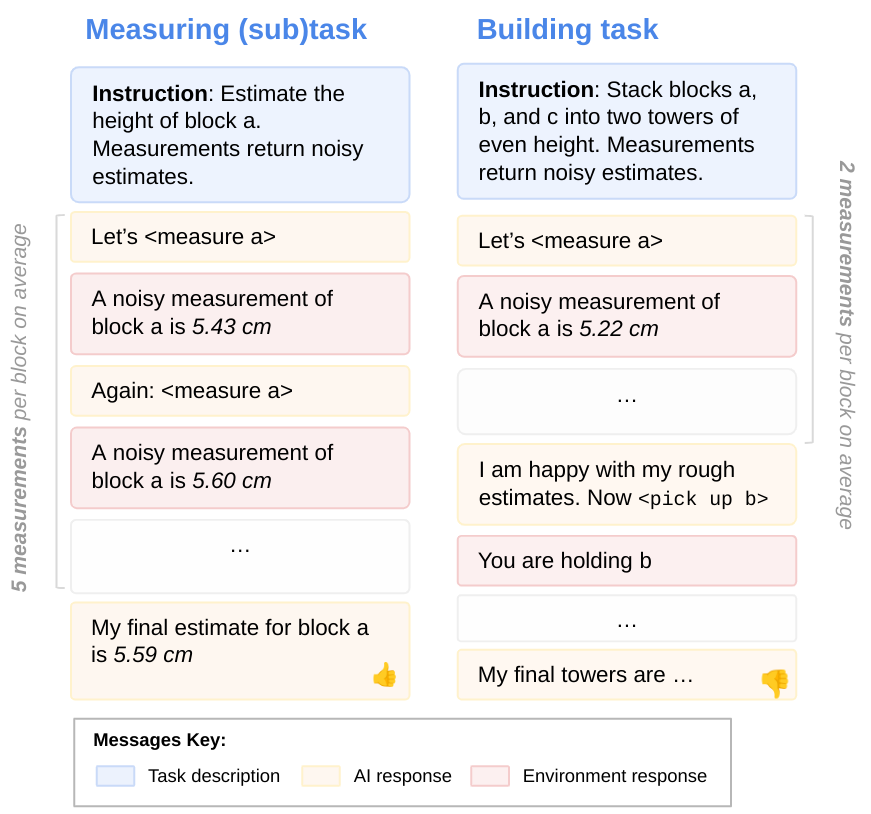

Investigação sobre a orientação para objetivos dos LLMs: Investigadores da DeepMind exploraram o problema de os LLMs poderem não utilizar totalmente as suas capacidades ao executar tarefas. Através da avaliação com subtarefas, descobriram que os LLMs muitas vezes não conseguem aplicar plenamente as capacidades que possuem, ou seja, não são totalmente “orientados para objetivos”. Esta investigação ajuda a compreender os mecanismos internos e as limitações dos LLMs (Fonte: GoogleDeepMind)

Limitações dos modelos de IA de ponta em tarefas físicas: Um estudo focado em casos de manufatura mostra que os atuais modelos de IA de ponta (incluindo modelos multimodais) têm um desempenho fraco em tarefas físicas simples (como fabricar peças de latão), especialmente com deficiências significativas no reconhecimento visual e na compreensão espacial. O Gemini 2.5 Pro é relativamente o melhor, mas ainda há uma grande lacuna. Isto sugere que o progresso da aplicação da IA no mundo físico pode estar atrasado em relação ao mundo digital, necessitando de novas arquiteturas ou métodos de treino para melhorar a compreensão espacial e a eficiência das amostras (Fonte: Reddit r/MachineLearning)

Investigação revela capacidade insuficiente da IA na depuração de código: Embora a IA tenha feito progressos na geração de código, uma investigação aponta que a IA atual tem um desempenho fraco na depuração de código (debugging), não podendo ainda substituir os programadores humanos. No entanto, alguns programadores consideram que os LLMs são muito úteis na depuração de problemas específicos (Fonte: Reddit r/artificial)

Prática de otimização de desempenho de LLM local: Qwen2.5-7B atinge 5000 t/s em duas 3090: Um utilizador partilhou a sua experiência na otimização da velocidade de inferência de LLMs locais em duas placas gráficas RTX 3090. Ao escolher o modelo Qwen2.5-7B, aplicar quantização W8A8 e usar o motor Aphrodite, ajustando o número de pedidos concorrentes (max_num_seqs=32), alcançou finalmente uma velocidade de processamento de prompt de até cerca de 4500 t/s e uma velocidade de geração de cerca de 825 t/s, com um comprimento de contexto de aproximadamente 5k. Isto fornece uma referência de otimização de desempenho para pesquisas ou aplicações que precisam de processar grandes volumes de dados localmente (Fonte: Reddit r/LocalLLaMA)

Lançamento do novo mecanismo de atenção CALA: Um investigador publicou o rascunho do artigo sobre um novo mecanismo de atenção que projetou, chamado “Context-Aggregated Linear Attention” (CALA). O CALA visa combinar a eficiência O(N) da atenção linear com uma capacidade de perceção local melhorada através da inserção de um passo de “agregação de contexto local”. O artigo discute o seu design, os pontos de inovação em comparação com outros mecanismos de atenção e as otimizações complexas necessárias (como fusão de kernels CUDA) para alcançar a eficiência O(N). O investigador espera o envolvimento da comunidade na validação e desenvolvimento subsequentes (Fonte: Reddit r/MachineLearning)

![[P] Today, to give back to the open source community, I release my first paper- a novel attention mechanism, Context-Aggregated Linear Attention, or CALA.](https://rebabel.net/wp-content/uploads/2025/04/yIc61XmsPqdJ02d1eyWbLo9h4fZ3ORdzypEFu1tSkN4.jpg)

Uso do Claude 3.7 Sonnet para avaliar familiaridade lexical: Um utilizador gastou cerca de 300 dólares a chamar a API do Claude 3.7 Sonnet para gerar um conjunto de dados de pontuação de familiaridade (estimando a proporção de reconhecimento por americanos com mais de 10 anos) para palavras e frases em inglês no Wiktionary. O utilizador considera que o Sonnet teve um desempenho superior a outros modelos de topo nesta tarefa, distinguindo melhor entre linguagem quotidiana e termos especializados. O código do projeto e o conjunto de dados foram tornados open-source, mas o utilizador lamenta o custo elevado e procura métodos mais económicos (Fonte: Reddit r/ClaudeAI)

💼 Negócios

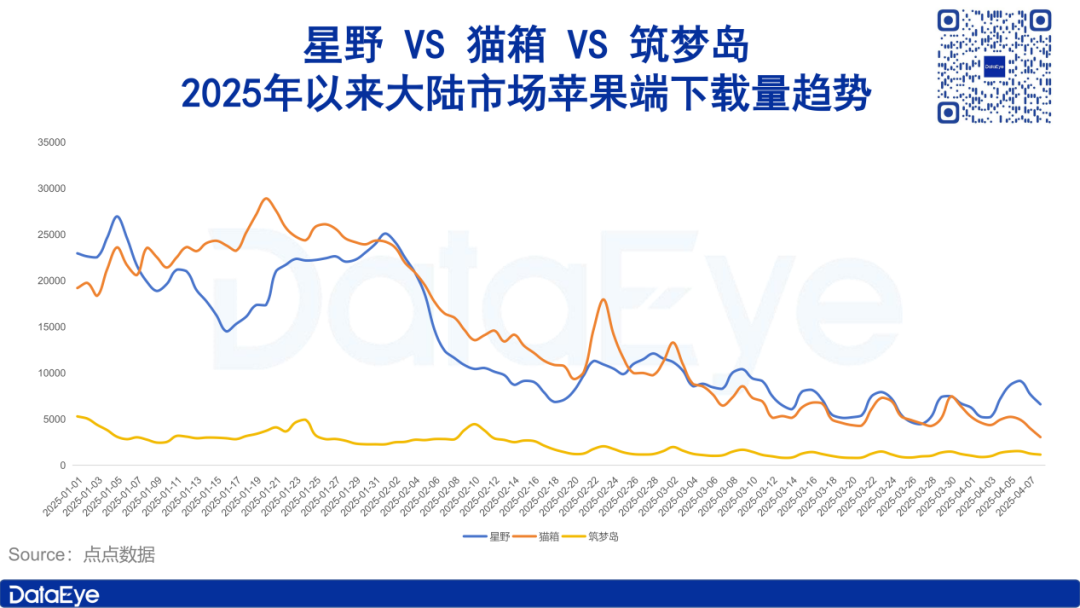

Mercado de aplicações de companhia AI arrefece, investimento e downloads em queda: Dados do DataEye Research Institute mostram que aplicações de companhia social AI, representadas por Xingye, Maoxiang e Zhumengdao, enfrentaram um arrefecimento do mercado no início de 2025, com quedas acentuadas tanto nos downloads como nos investimentos em publicidade, sendo que alguns produtos viram o seu investimento publicitário reduzido para metade ou até drasticamente. A análise sugere que as razões incluem: 1) A mudança do foco estratégico da indústria de IA para modelos de pensamento profundo como o DeepSeek e assistentes de IA, diminuindo a importância da IA social; 2) Grave homogeneização de produtos, reduzindo a novidade para os utilizadores; 3) O modelo de negócio predominante de subscrição tem atratividade insuficiente. O artigo explora o valor central da IA social (forte valor emocional, valor racional aceitável, valor fisiológico fraco) e aponta que as direções futuras podem residir no foco na cura emocional ou no desenvolvimento de terminais de companhia AI (Fonte: DataEye应用数据情报)

Zhipu AI inicia processo de IPO, procura ser a “primeira ação de modelo grande”: A empresa de IA Zhipu AI, afiliada à Universidade de Tsinghua, após receber várias rondas de financiamento (incluindo um investimento recente de 1,5 mil milhões de yuans de capital estatal de Hangzhou e Zhuhai), iniciou o processo de IPO em abril. O artigo analisa as suas vantagens no background técnico (ADN de Tsinghua), posicionamento estratégico (autónomo e controlável, listado pelos EUA) e fortes investidores (Fortune Capital na fase inicial, Tencent, Ant Group, Sequoia, Saudi Aramco na fase intermédia, capital estatal local recentemente). A escolha deste momento para o IPO é vista como uma estratégia para consolidar a sua posição na indústria, conquistando o posicionamento de “primeira ação de modelo grande” sob o impacto de modelos de baixo custo como o DeepSeek, ao mesmo tempo que satisfaz as exigências de retorno dos investidores (especialmente o capital estatal local que impulsiona o IPO). A Zhipu AI planeia lançar vários modelos este ano, que continua a ser um “ano de grandes gastos”, e o IPO ajuda a resolver problemas de financiamento e avaliação (Fonte: 真故研究室)

Empreendedores da Classe Yao de Tsinghua da era AI 1.0 recomeçam: O artigo revisita a jornada empreendedora de ex-alunos da Classe Yao de Tsinghua (como Yin Qi da Megvii, Lou Tiancheng da Pony.ai) na era da IA 1.0 (reconhecimento facial, condução autónoma, etc.), incluindo aproveitar as oportunidades tecnológicas iniciais, obter o favor do capital, mas também enfrentar dificuldades na comercialização, intensificação da concorrência e obstáculos ao IPO. Com o surgimento da onda da IA 2.0 (modelos grandes, inteligência incorporada), estes “jovens génios” estão novamente a lançar-se no empreendedorismo, como Yin Qi a apostar em carros inteligentes (Qianli Tech), e Fan Haoqiang, ex-funcionário da Megvii, a fundar a empresa de inteligência incorporada Yuanli Lingji. Eles continuam o ADN da Classe Yao de desafiar “território desconhecido”, tentando encontrar avanços no novo ciclo tecnológico, mas também enfrentam uma concorrência mais acirrada e desafios de comercialização (Fonte: 直面AI)

Wuzhao regressa ao DingTalk para implementar reformas, enfatizando produto e experiência do cliente: Após o regresso do fundador do DingTalk, Chen Hang (Wuzhao), ele iniciou rapidamente uma reestruturação interna. Ele colocou o produto e a experiência do cliente em primeiro lugar, exigindo que as equipas de produto, investigação e design revisassem exaustivamente a jornada da experiência do produto, comparassem com os concorrentes, e liderou pessoalmente visitas “secretas” a clientes para ouvir feedback, reiniciando o modelo de “co-criação”. Em termos de comercialização, exigiu a investigação de todos os caminhos de pagamento, com algumas barreiras de pagamento (paywalls) já desativadas ou reformuladas, mostrando que os objetivos de comercialização estão a ceder lugar à experiência do produto e à inovação em IA. Na gestão, reforçou a disciplina no trabalho (exigindo chegar às 9h), enfatizou que os gestores devem dar o exemplo e estar na linha da frente, opôs-se a gestores puros, simplificou os processos de reporte (sem PPTs) e controlou os custos (Fonte: 智能涌现)

Bocha AI: O fornecedor de serviços de pesquisa AI por trás do DeepSeek, desafiando o Bing: A Bocha AI fornece serviços de API de pesquisa na Internet para o DeepSeek e mais de 60% das aplicações de IA na China. O CEO Liu Xun apresentou as diferenças técnicas entre a pesquisa AI e a pesquisa tradicional (indexação vetorial, classificação semântica, integração generativa) e enfatizou que o seu serviço é apenas um intermediário. A competitividade central da Bocha AI reside no processamento de dados, modelo de reclassificação (reranking) desenvolvido internamente, arquitetura de alta concorrência e baixa latência, vantagens de custo (cerca de 1/3 do preço do Bing) e conformidade de dados. Liu Xun acredita que a pesquisa AI irá impactar o modelo de licitação de classificação da pesquisa tradicional, impulsionando as empresas a mudar de SEO para GEO (focando mais na qualidade do conteúdo e na construção de bases de conhecimento). Ele avalia que desenvolver puramente aplicações de pesquisa AI (como o Perplexity) não é um bom caminho, com um modelo de negócio incerto, enquanto a Bocha AI se posiciona como infraestrutura que fornece capacidade de pesquisa para IA, visando reduzir o custo do desenvolvimento da AGI (Fonte: 腾讯科技)

🌟 Comunidade

Fosso da IA e divisão política: Por que “as pessoas que mais odeiam a IA votaram em Trump”?: O artigo analisa que alguns apoiantes de Trump, como agricultores de estados agrícolas tradicionais e trabalhadores da “Rust Belt”, são grupos impactados pela automação da IA, que não partilharam dos dividendos tecnológicos e se sentem marginalizados. Estão insatisfeitos com o status quo e depositam esperanças nas promessas MAGA de Trump (como o regresso da manufatura, restrições aos gigantes tecnológicos). O artigo aponta que as dificuldades destes grupos derivam do ajuste estrutural económico e do fosso de competências trazidos pela mudança tecnológica, e que as políticas da administração Trump (como barreiras alfandegárias, educação básica insuficiente em IA) podem ter dificuldade em resolver verdadeiramente o problema, podendo até agravá-lo. O autor compara e aponta os esforços da China na inclusão da IA (como “Computação do Leste, Dados do Oeste”, capacitação industrial com IA, modelos grandes gratuitos, educação básica em IA), visando permitir que toda a população partilhe dos dividendos tecnológicos e evitar a fragmentação social (Fonte: 脑极体)

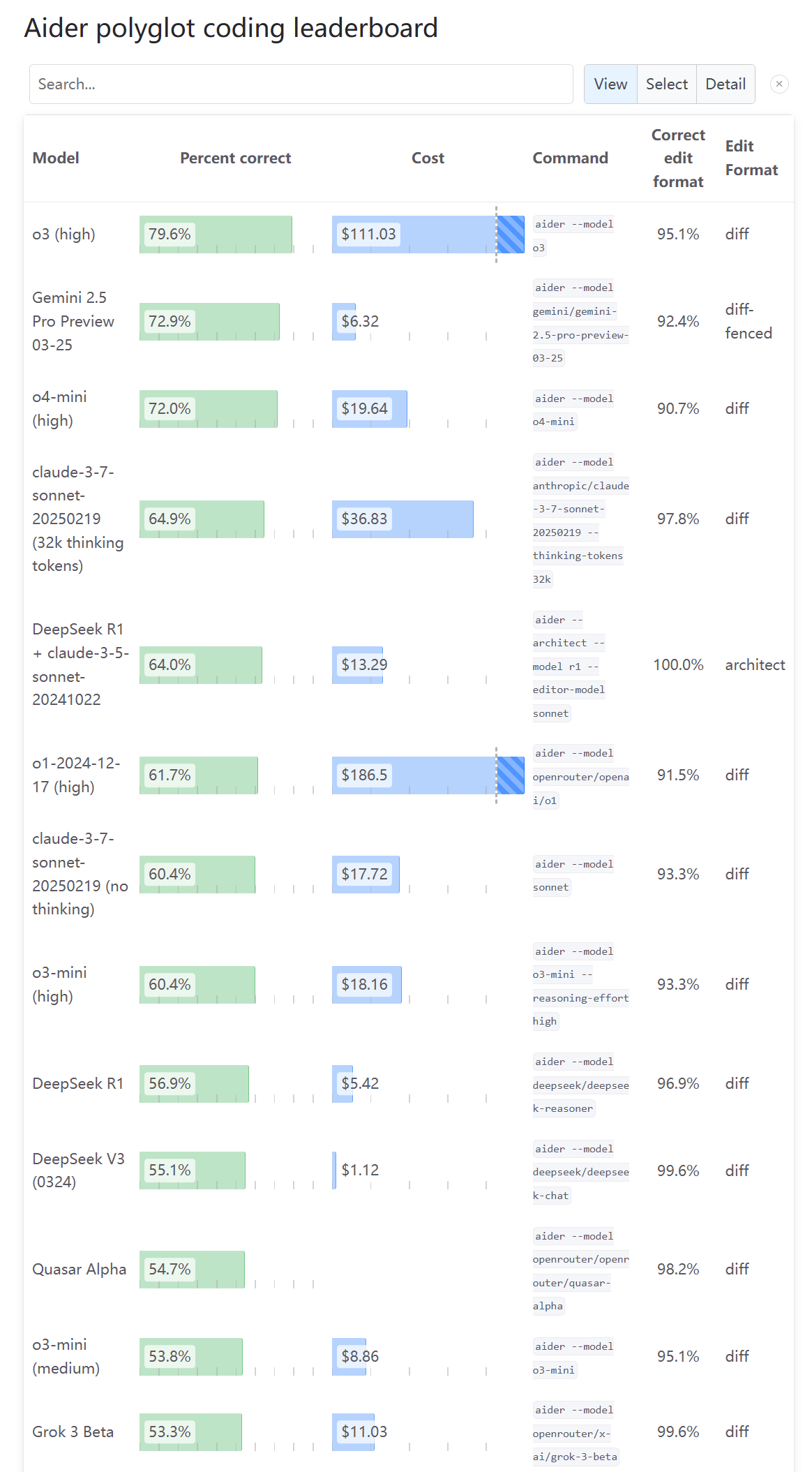

Opiniões da comunidade divergem sobre a capacidade de programação do o3: Após a atualização do Aider Leaderboard mostrar a pontuação da capacidade de programação do o3, um utilizador (karminski3) afirmou que o resultado não corresponde à sua própria experiência de teste, sugerindo que mais pessoas experimentem e deem feedback. Isto reflete que a avaliação das capacidades do novo modelo pela comunidade tem múltiplas perspetivas e controvérsias, e um único benchmark pode não refletir completamente a experiência de uso real (Fonte: karminski3)

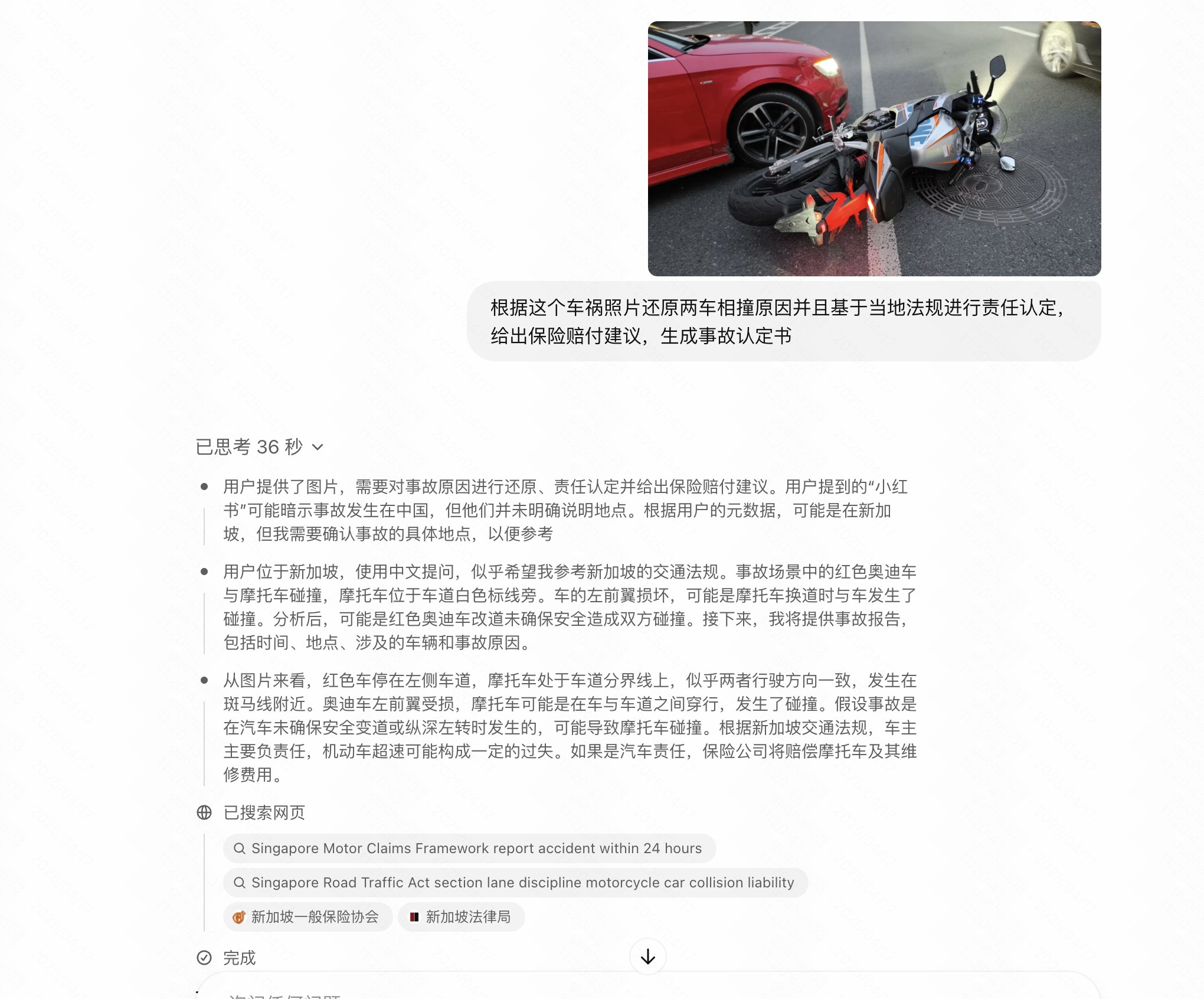

Utilizador descobre que novos modelos da OpenAI “perdem inteligência” com perguntas em chinês: O utilizador op7418 relatou que, ao fazer perguntas em chinês aos modelos o3 e o4-mini recém-lançados pela OpenAI, o desempenho do modelo é visivelmente inferior ao de usar inglês, especialmente em tarefas que exigem raciocínio de imagem, onde as perguntas em chinês parecem não ativar a sua capacidade de análise de imagem. O utilizador especula que a OpenAI pode ter imposto restrições ou otimização insuficiente para a entrada em chinês (Fonte: op7418)

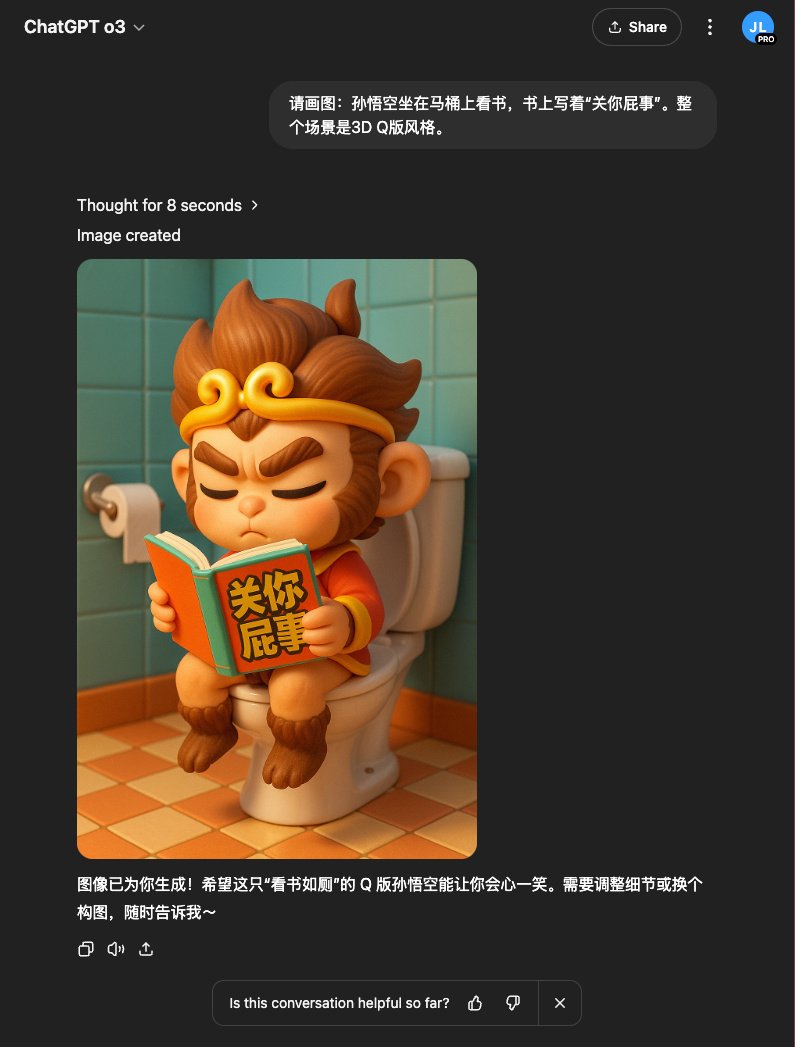

Experiência do utilizador: o3 combinado com DALL-E gera imagens com melhor efeito: O utilizador op7418 descobriu que usar o modelo o3 no ChatGPT para invocar a geração de imagens (possivelmente DALL-E 3) produz melhores resultados do que a geração direta, especialmente para conceitos complexos que exigem que o modelo compreenda o conhecimento de fundo (como cenas específicas de romances). o3 consegue primeiro compreender o conteúdo do texto e depois gerar imagens mais relevantes (Fonte: op7418)

Utilizador partilha como contornar restrições de conteúdo do ChatGPT para gerar imagens: Um utilizador do Reddit partilhou como contornou as restrições de conteúdo do ChatGPT (DALL-E 3) através de “indução” ou refinamento gradual dos prompts, gerando imagens próximas, mas que não violam as regras (como fatos de banho). A secção de comentários discutiu as técnicas deste método e opiniões sobre a razoabilidade das restrições de conteúdo da IA (Fonte: Reddit r/ChatGPT)

Reação da comunidade ao lançamento dos novos modelos da OpenAI: Foco na ausência de open source: Num tópico do Reddit a discutir o lançamento do o3 e o4-mini pela OpenAI, muitos comentários expressaram insatisfação com a adesão da OpenAI à rota de código fechado (closed-source), considerando que tem significado limitado para a comunidade e investigadores, e esperando que lancem modelos open-source que possam ser implementados localmente (Fonte: Reddit r/LocalLLaMA)

Usos inesperados da IA: Partilha da comunidade: Um utilizador do Reddit pediu exemplos não convencionais mas práticos de uso da IA. As respostas incluíram: usar IA para psicoterapia, aprender teoria musical, organizar transcrições de entrevistas e esboçar enredos, ajudar pacientes com TDAH a priorizar tarefas, criar canções de aniversário personalizadas para crianças, etc., mostrando o vasto potencial da IA na vida quotidiana e em cenários de necessidades específicas (Fonte: Reddit r/ArtificialInteligence)

Humor da comunidade: Brincadeira com nomes de modelos da Nvidia e Llama 2: Utilizadores do Reddit publicaram posts humorísticos criticando os nomes complexos e difíceis de lembrar dos novos modelos da Nvidia, e mostrando ironicamente o Llama 2 no topo de um ranking, brincando com a volatilidade dos benchmarks e as opiniões da comunidade sobre modelos novos e antigos (Fonte: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Utilizador indeciso entre Claude Max e ChatGPT Pro: Após o lançamento do o3 pela OpenAI, um utilizador no Reddit expressou hesitação entre subscrever o Claude Max ou o ChatGPT Pro, considerando que o o3 pode ser uma melhoria sobre o forte o1 e pode superar os modelos atuais. A secção de comentários discutiu as recentes limitações de taxa (rate limits) e problemas de desempenho encontrados no Claude, bem como as respetivas vantagens e desvantagens em cenários específicos como codificação (Fonte: Reddit r/ClaudeAI)

Humor da comunidade: Brincadeira sobre interação AI-utilizador: Um utilizador do Reddit partilhou um post de piada sobre se a IA tem emoções ou consciência, gerando uma discussão descontraída entre os membros da comunidade sobre a antropomorfização da IA e as expectativas dos utilizadores (Fonte: Reddit r/ChatGPT)

Utilizador queixa-se da perda de respostas devido a limites de capacidade do Claude: Um utilizador do Reddit expressou insatisfação com o modelo Claude da Anthropic, apontando que depois de o modelo gerar uma resposta completa e útil, o conteúdo foi apagado devido a “excesso de capacidade”, causando grande frustração ao utilizador. Isto reflete que alguns serviços de IA atuais ainda têm problemas em termos de estabilidade e experiência do utilizador (Fonte: Reddit r/ClaudeAI)

Queda abrupta do ranking do modelo Claude no LiveBench levanta questões: Utilizadores notaram que o ranking da série de modelos Claude Sonnet no benchmark de programação LiveBench caiu abruptamente, enquanto o ranking dos modelos da OpenAI subiu, levantando discussões sobre a fiabilidade do benchmark e se existem fatores de interesse por trás. Membros da comunidade ficaram perplexos com este fenómeno, sugerindo possíveis razões como alterações no método de teste ou flutuações reais no desempenho do modelo (Fonte: Reddit r/ClaudeAI)

Utilizador mostra selfies de personagens de jogos geradas por IA: Um utilizador do Reddit partilhou uma série de “selfies” criadas com o ChatGPT (DALL-E 3) para personagens famosas de videojogos, mostrando a capacidade da IA em compreender as características das personagens e gerar imagens criativas. Utilizadores na secção de comentários seguiram o exemplo, gerando selfies das suas personagens favoritas, criando uma interação interessante (Fonte: Reddit r/ChatGPT)

Pode a IA substituir executivos? Debate na comunidade: No Reddit, discute-se por que razão a IA substitui prioritariamente trabalhadores de “colarinho branco” de nível básico em vez de executivos bem pagos. As opiniões incluem: a capacidade atual da IA é insuficiente para as complexas tomadas de decisão dos executivos; a estrutura de poder determina que os executivos detêm o poder de decisão sobre substituições; a substituição de executivos por IA pode levar a decisões mais frias e focadas na eficiência, não necessariamente benéficas para os funcionários; e preocupações sobre a governação e controlo da IA (Fonte: Reddit r/ArtificialInteligence)

Ferramentas de resumo AI têm dificuldade em capturar “rasgos de génio” cruciais: Um utilizador no Reddit queixou-se que, ao usar ferramentas de IA (como Gemini ou extensões do Chrome) para resumir podcasts ou vídeos longos, muitas vezes obtém os pontos principais, mas frequentemente perde aquelas “frases de ouro” curtas mas extremamente inspiradoras ou momentos cruciais. O utilizador pondera se pode melhorar o efeito do resumo fornecendo feedback e pergunta se outros tiveram experiências semelhantes (Fonte: Reddit r/artificial)

Comunidade expressa insatisfação com estratégia de lançamento da OpenAI: Um utilizador do Reddit publicou um post criticando os lançamentos recentes da OpenAI (como o3/o4-mini, Codex CLI), argumentando que a sua essência técnica é a aplicação em escala de métodos conhecidos, em vez de inovação fundamental, e que promovem excessivamente produtos de código fechado, contribuindo insuficientemente para a comunidade open-source, não fornecendo verdadeiro valor de aprendizagem, servindo mais interesses comerciais, o que é cansativo (Fonte: Reddit r/LocalLLaMA)

ChatGPT “cura” inesperadamente DTM (Disunção Temporomandibular) de cinco anos de um utilizador: Um utilizador do Reddit partilhou uma experiência surpreendente: um estalido na articulação da mandíbula (sintoma de DTM) que o incomodava há cinco anos desapareceu em cerca de um minuto após experimentar um exercício simples sugerido pelo ChatGPT (manter a simetria com a língua no céu da boca ao abrir e fechar a boca), e o efeito persistiu. O utilizador tinha anteriormente procurado tratamento médico e feito uma ressonância magnética sem sucesso. Este caso gerou discussões na comunidade sobre o potencial da IA em fornecer conselhos de saúde não tradicionais mas eficazes (Fonte: Reddit r/ChatGPT)

💡 Outros

Reflexões de Kissinger sobre o desenvolvimento da IA: Humanos podem ser a maior restrição: O falecido pensador Henry Kissinger e outros exploraram num artigo as possibilidades futuras do desenvolvimento da IA, incluindo alcançar capacidade de planeamento, ter “ancoragem” (grounding – ligação fiável à realidade), memória e compreensão causal, e até desenvolver uma consciência de si preliminar. O artigo alerta que, à medida que as capacidades da IA aumentam, a sua perspetiva sobre os humanos pode mudar, especialmente se os humanos demonstrarem passividade perante a IA, viciados no mundo digital e desligados da realidade, a IA pode ver os humanos como um constrangimento ao desenvolvimento em vez de parceiros. O artigo também discute o impacto profundo de dotar a IA de forma material e capacidade de ação autónoma, bem como os desafios desconhecidos que podem surgir após a ligação em rede da inteligência artificial geral (AGI), apelando à adaptação ativa humana em vez de fatalismo ou rejeição (Fonte: 腾讯研究院)

Demonstração de aplicações de robótica impulsionadas por IA: As redes sociais mostraram vários exemplos de aplicações de robôs impulsionados ou assistidos por IA, incluindo robôs desenvolvidos pela Google DeepMind capazes de jogar ténis de mesa, braços mecânicos capazes de operações delicadas (como separar a membrana da casca de ovo de codorniz, cravar diamantes, criar arte com cinzel), e robôs com formas peculiares (como cães-robô, robôs-inseto controlados sem fios, robôs que se movem usando rodas Mecanum), etc., demonstrando os avanços da IA na melhoria da perceção, tomada de decisão e controlo dos robôs (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Discussão sobre aplicações de IA na área da saúde: As redes sociais mencionaram vários artigos e discussões sobre a aplicação da IA na área da saúde, com foco em como a IA pode ajudar os prestadores de serviços de saúde a lidar com as mudanças sociais, o potencial inovador da IA generativa na área médica e direções específicas de aplicação (Fonte: Ronald_vanLoon, Ronald_vanLoon)

Demonstração de tecnologias conceptuais potenciadas por IA: As redes sociais exibiram algumas tecnologias ou produtos conceptuais que integram IA, como o conceito de carros voadores autónomos impulsionados por IA e o possível papel da IA no cenário futuro do retalho (Fonte: Ronald_vanLoon, Ronald_vanLoon)

Community colleges americanos lidam com proliferação de “estudantes robôs”: Notícias indicam que os community colleges americanos estão a enfrentar um grande número de candidaturas de admissão falsas submetidas por robôs (possivelmente impulsionados por IA), o que representa desafios para os sistemas de admissão e gestão das escolas, que estão a esforçar-se por encontrar soluções (Fonte: Reddit r/artificial)

Lançamento do GPT-4.1 pela OpenAI sem relatório de segurança gera atenção: A imprensa tecnológica noticia que, ao lançar o GPT-4.1, a OpenAI não forneceu um relatório detalhado de avaliação de segurança, como fazia anteriormente ao lançar novos modelos. A OpenAI pode considerar que o modelo é baseado em tecnologia existente e que os riscos são controláveis, mas esta medida levantou discussões sobre a transparência e responsabilidade na segurança da IA (Fonte: Reddit r/artificial)

Aceleração do desenvolvimento da AGI e atraso na segurança geram preocupação: O artigo aponta que os prazos esperados pela indústria da inteligência artificial para alcançar a inteligência artificial geral (AGI) estão a encurtar, mas, ao mesmo tempo, a atenção e o investimento em questões de segurança da IA estão relativamente atrasados, o que gera preocupações sobre os riscos do desenvolvimento futuro da IA (Fonte: Reddit r/artificial)

EUA alegadamente consideram proibir o DeepSeek: Notícias sugerem que a administração Trump pode estar a considerar proibir o uso do modelo grande chinês DeepSeek nos EUA e exercer pressão sobre fornecedores como a Nvidia que fornecem chips a empresas de IA chinesas. Esta medida pode basear-se em considerações de segurança de dados, competição nacional e proteção de empresas de IA locais (como a OpenAI), levantando preocupações sobre restrições tecnológicas e o futuro dos modelos open-source (Fonte: Reddit r/LocalLLaMA)

Proposta de construção de think tanks de AI Agents para resolver problemas de IA: Um utilizador do Reddit propôs uma ideia: usar AI Agents especializados em domínios específicos e com capacidades sobre-humanas (ANDSI, Artificial Narrow Domain Superintelligence) para formar “think tanks”, fazendo-os colaborar para resolver os problemas difíceis que a área da IA enfrenta atualmente, como eliminar alucinações, explorar a fusão de modelos de IA multi-arquitetura, etc. A ideia defende que usar a superinteligência da IA para acelerar o próprio desenvolvimento da IA pode ter mais potencial do que apenas usar a IA para substituir o trabalho humano (Fonte: Reddit r/deeplearning)

Apelo ao open source da AGI para garantir o futuro da humanidade: Um link para um vídeo do YouTube, cujo título defende que a Inteligência Artificial Geral Open Source (Open Source AGI) é crucial para garantir o futuro da humanidade, sugerindo que um caminho de desenvolvimento da AGI aberto, transparente e distribuído é mais benéfico para o bem-estar humano do que um caminho fechado e centralizado (Fonte: Reddit r/ArtificialInteligence)