Palavras-chave:AI, Inteligência Artificial, Dilema da soberania da AI, HBM e encapsulamento avançado, Descobertas científicas impulsionadas por AI, Capacidade de programação do Gemini 2.5 Pro, AI a resolver problemas matemáticos complexos

🔥 Foco

O Dilema da Soberania em AI: Como a Narrativa de Segurança Nacional Consome o Valor Público?: O relatório explora em profundidade o conceito de “soberania em AI”, ou seja, o controlo de um país sobre a stack tecnológica de AI (dados, poder computacional, talento, energia). A tendência global atual está a mudar de uma “soberania fraca” dependente de aliados para uma “soberania forte” que busca a localização completa, especialmente impulsionada pela política dos EUA. Embora esta mudança vise garantir a segurança nacional e a vantagem militar, também levanta preocupações sobre centralização excessiva, sufocamento da inovação aberta, obstrução da cooperação internacional e o potencial para desencadear uma corrida armamentista de AI. O artigo argumenta que a excessiva securitização da AI pode sacrificar o seu enorme potencial para servir o interesse público e resolver desafios globais, apelando a um equilíbrio entre as necessidades de soberania e a cooperação aberta, para evitar que a AI se torne uma vítima da competição geopolítica, em vez de uma ferramenta para o progresso coletivo da humanidade. (Fonte: O Dilema da Soberania em AI: Como a Narrativa de Segurança Nacional Consome o Valor Público da AI?)

HBM e Encapsulamento Avançado: O Ponto de Competição Invisível da Revolução do Poder Computacional de AI: A procura exponencial por poder computacional dos grandes modelos de AI está a levar as arquiteturas de computação tradicionais ao gargalo da “muralha da memória” (memory wall). A Memória de Alta Largura de Banda (HBM), através de empilhamento 3D e tecnologia TSV, aumenta a largura de banda várias vezes (como o HBM3E que ultrapassa 1TB/s), aliviando significativamente a latência na transferência de dados. Ao mesmo tempo, tecnologias de encapsulamento avançado (como CoWoS da TSMC, EMIB da Intel) através de integração heterogénea combinam firmemente chips como CPU, GPU, HBM, etc., superando as limitações de um único chip, aumentando a densidade do poder computacional e a eficiência energética. HBM e encapsulamento avançado tornaram-se componentes essenciais padrão para chips de AI (especialmente no lado do treino), cujo mercado é dominado por gigantes como SK Hynix, Samsung, Micron (HBM) e TSMC (encapsulamento), com investimentos enormes e capacidade de produção limitada. O desenvolvimento coordenado destas duas tecnologias não só remodela a estrutura da cadeia de fornecimento de semicondutores (aumentando a proporção do valor do encapsulamento), mas também se torna o campo de batalha crucial que decide a competição pelo poder computacional de AI. (Fonte: HBM e Encapsulamento Avançado: O Ponto de Competição Invisível da Revolução do Poder Computacional de AI)

Declaração Chocante de Vencedor do Nobel: AI Completa ‘Tempo de Investigação de Doutoramento’ de 1 Bilhão de Anos num Ano: O vencedor do Prémio Nobel e CEO da Google DeepMind, Demis Hassabis, afirmou que o seu projeto de AI, AlphaFold-2, ao prever as estruturas de 200 milhões de proteínas conhecidas na Terra, completou, num ano, exploração científica equivalente a 1 bilião de anos de tempo de investigação de doutoramento. Ele enfatizou que a AI, especialmente o AlphaFold, está a revolucionar a velocidade e a escala da descoberta científica, democratizando o acesso ao conhecimento. Numa palestra na Universidade de Cambridge, Hassabis elaborou sobre a chegada da era da “biologia digital” impulsionada pela AI e argumentou que o futuro da AI reside na construção de “modelos do mundo” (world models) capazes de compreender o mundo físico, raciocinar e planear (como a arquitetura JEPA), em vez de depender apenas do processamento de linguagem. Ele reafirmou o seu compromisso com a AI open source, considerando-a a melhor forma de impulsionar o progresso tecnológico. (Fonte: Declaração Chocante de Vencedor do Nobel: AI Completa ‘Tempo de Investigação de Doutoramento’ de 1 Bilhão de Anos num Ano)

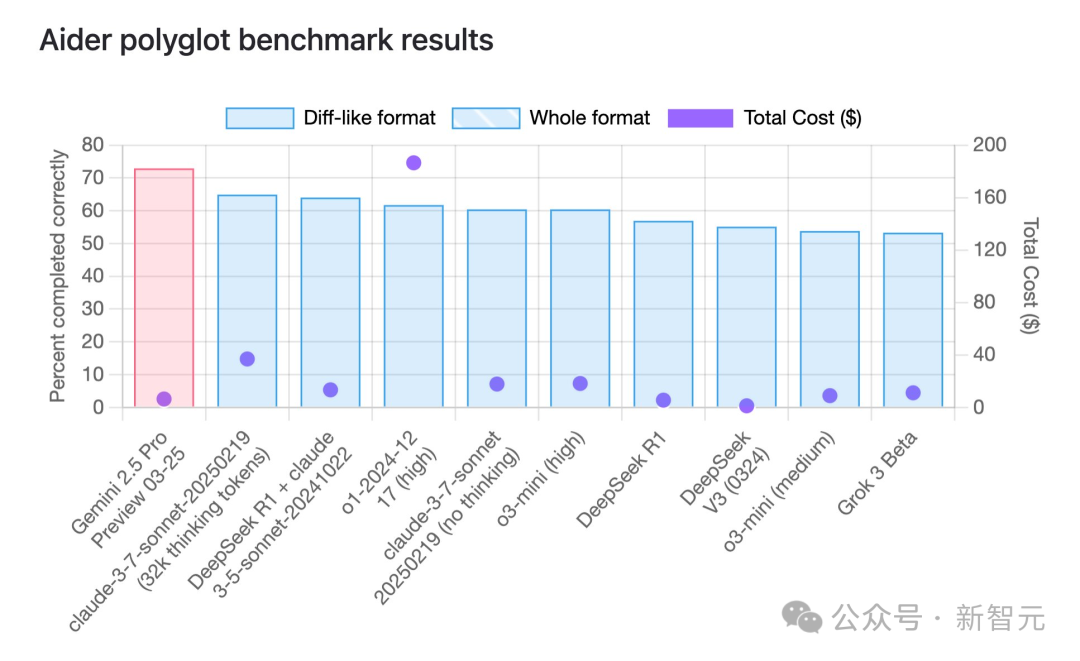

Capacidade de Programação do Gemini 2.5 Pro Lidera, Vantagem de Custo-Benefício Notável: De acordo com o benchmark de programação multilingue aider, o modelo Gemini 2.5 Pro recentemente lançado pela Google ultrapassou o Claude 3.7 Sonnet em capacidade de programação, classificando-se em primeiro lugar globalmente. Além do desempenho líder, o custo de chamada da API é extremamente baixo (cerca de 6 dólares), muito inferior aos concorrentes com desempenho semelhante ou inferior (como GPT-4o, Claude 3.7 Sonnet). Jeff Dean enfatizou a sua vantagem de custo-benefício. Além disso, um modelo não lançado da Google, “Dragontail”, que circula na comunidade, apresentou um desempenho ainda melhor do que o Gemini 2.5 Pro em testes de desenvolvimento web, sugerindo que a Google ainda tem cartas na manga no campo da programação de AI. O Gemini 2.5 Pro também está entre os primeiros em vários benchmarks abrangentes, desafiando totalmente a OpenAI e a Anthropic com alto desempenho, baixo custo, grande janela de contexto e acesso gratuito. (Fonte: Gemini 2.5 Lidera Globalmente em Programação, Google Retorna ao Trono da AI, Modelo Misterioso Revelado, Altman Enfrenta o Desafio)

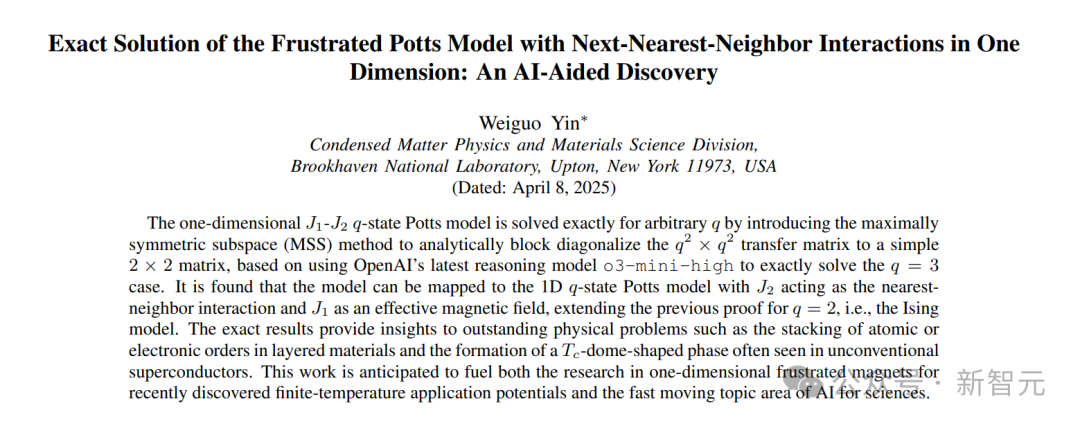

AI Auxilia com Sucesso na Prova de Problema Matemático Não Resolvido por 50 Anos: O académico chinês Weiguo Yin (Brookhaven National Laboratory), com a ajuda do modelo o3-mini-high da OpenAI, alcançou um avanço na investigação da solução exata do modelo Potts q-state J_1-J_2 unidimensional, resolvendo um problema neste campo que perdurava há 50 anos. Ao lidar com o caso específico de q=3, o modelo de AI, através da análise de simetria, simplificou com sucesso a complexa matriz de transferência 9×9 para uma matriz eficaz 2×2. Este passo crucial inspirou os investigadores a generalizar o método, encontrando finalmente uma solução analítica aplicável a qualquer valor de q. Este resultado não só demonstra o potencial da AI na derivação matemática complexa e em provas não triviais, mas também fornece novas ferramentas teóricas para a compreensão de problemas como transições de fase na física da matéria condensada. (Fonte: AI Acaba de Resolver Problema Matemático Não Resolvido por 50 Anos, Ex-aluno da Universidade de Nanjing Usa Modelo OpenAI para Completar Primeira Prova Matemática Não Trivial)

🎯 Tendências

Aplicação e Evolução da AI no Domínio dos NPCs de Jogos: O artigo revê a história do desenvolvimento da tecnologia de AI em NPCs (Non-Player Characters) de jogos, desde as máquinas de estados finitos do início de “Pac-Man”, passando pelas árvores de comportamento, até à AI complexa que combina Monte Carlo Tree Search e redes neuronais profundas (como AlphaGo). O artigo salienta que, embora a AI já consiga derrotar jogadores humanos de topo em jogos como “StarCraft 2” e “Dota 2”, para jogadores comuns, uma AI excessivamente poderosa não proporciona uma boa experiência. A AI ideal para jogos deve focar-se mais na simulação do comportamento humano, fornecendo valor emocional e dificuldade adaptativa (como o sistema Nemesis de “Middle-earth: Shadow of Mordor”, a dificuldade dinâmica de “Resident Evil 4”). Recentemente, tomando Stella de “Whispers from the Star” da miHoYo como exemplo, a AI generativa está a ser usada para impulsionar o diálogo em tempo real, as reações emocionais e o desenvolvimento da trama dos NPCs. Embora enfrente desafios como latência e memória, demonstra a tendência dos NPCs de AI se tornarem mais humanizados e com maior profundidade interativa. (Fonte: AI, Tornando os Jogos Grandes Novamente)

OpenAI Restringe Acesso à API, Implementa Verificação de Organização: A OpenAI implementou recentemente uma nova política de verificação de organização para a API, exigindo que os utilizadores forneçam um documento de identificação governamental válido emitido por um país ou região suportada para aceder aos seus modelos e funcionalidades mais avançados. Cada ID só pode verificar uma organização a cada 90 dias. A OpenAI afirma que esta medida visa reduzir o uso inseguro da AI e preparar-se para o lançamento de “novos modelos emocionantes” (possivelmente incluindo várias versões como GPT-4.1, o3, o4-mini). Esta mudança de política gerou ampla atenção e preocupação na comunidade, especialmente para developers localizados em países/regiões não suportados e utilizadores que dependem de serviços de API de terceiros, que podem enfrentar restrições de acesso ou aumento de custos, levantando também discussões sobre a abertura da OpenAI. (Fonte: Acesso IP Chinês ao GitHub Caiu e Voltou, Nova Política da API OpenAI Pode Bloquear GPT-5?, op7418, Reddit r/artificial)

Entrada da Apple Impulsiona Desenvolvimento de “Médico AI”, Desafios e Regulação Coexistem: Consta que a Apple utilizará AI para aprimorar as funcionalidades da sua aplicação Health, lançando serviços como “AI Health Coach”, impulsionando ainda mais o “Médico AI” a tornar-se um tópico global. No entanto, a aplicação clínica real da AI enfrenta numerosos desafios: altos custos de desenvolvimento, dependência de grandes volumes de dados médicos sensíveis (envolvendo regulamentos de privacidade), dificuldade na anotação de dados, etc. Atualmente, a AI funciona principalmente como ferramenta de auxílio ao diagnóstico. O mercado chinês enfrenta ainda necessidades específicas de recursos médicos desiguais e a necessidade de AI para auxiliar na triagem. Empresas como a Baichuan Intelligence propõem um “modelo de médico duplo” (Médico AI + AI a auxiliar médico humano) para tentar resolver estes problemas. O artigo enfatiza que a aplicação generalizada da AI médica deve basear-se em sistemas rigorosos de regulação e certificação para garantir a precisão do diagnóstico, a segurança dos dados e a confiança do utilizador, evitando riscos potenciais. (Fonte: Com a Entrada da Apple, “Médico AI” Torna-se Tópico Global, Proteção da Privacidade do Paciente é o Maior Obstáculo?)

Tentativa da Microsoft de Gerar Jogos Diretamente com AI Tem Maus Resultados: A Microsoft demonstrou recentemente o uso do seu modelo AI “Muse” para gerar diretamente imagens do jogo “Quake II” numa DEMO, com a intenção de mostrar a capacidade da AI de gerar rapidamente protótipos de jogos. No entanto, a DEMO teve um desempenho péssimo, com baixa resolução, baixa taxa de frames e numerosos BUGS (como comportamento anormal de inimigos, falha nas regras de física, ambiente caótico), sendo avaliada como um “sonho em constante colapso”. O artigo considera que isto indica que a tecnologia atual de AI generativa (especialmente com o problema das “alucinações”) ainda não é suficiente para gerar de forma direta e fiável experiências de jogo interativas complexas e jogáveis. Em comparação, aplicar AI a etapas específicas do pipeline de desenvolvimento de jogos (como interação de NPCs, geração de assets) é mais realista. O caminho de gerar diretamente imagens ou jogabilidade de jogos parece atualmente enfrentar enormes desafios. (Fonte: O Jogo AI da Microsoft Falhou, Gerar Jogos Diretamente Pode Ser um Caminho Sem Volta)

Google Lança Modelo Open Source TxGemma para a Área da Saúde: A Google lançou a série de modelos TxGemma, baseada nas suas famílias de modelos Gemma e Gemini, otimizada especificamente para os domínios da saúde e desenvolvimento de medicamentos. Esta iniciativa visa fornecer ferramentas de AI mais especializadas para a investigação biomédica e desenvolvimento terapêutico, promovendo a inovação neste campo. O lançamento do TxGemma faz parte da estratégia da Google de fornecer modelos open source gerais e específicos de domínio. (Fonte: JeffDean)

DeepSeek Anuncia Plano para Tornar Open Source o seu Motor de Inferência Interno: A DeepSeek AI declarou que tornará open source o seu motor de inferência interno. Segundo a descrição, o motor é uma versão modificada e otimizada do popular framework vLLM. A DeepSeek pretende, com esta ação, devolver à comunidade open source a tecnologia de inferência otimizada, ajudando os developers a implementar grandes modelos de forma mais eficiente. Este plano reflete a vontade da DeepSeek de contribuir para a comunidade open source, prevendo-se que o código seja publicado no GitHub. (Fonte: karminski3)

ChatGPT Adiciona Funcionalidade de Memória para Melhorar Coerência: A OpenAI adicionou a funcionalidade de Memória (Memory) ao seu modelo ChatGPT. Esta funcionalidade permite que o ChatGPT se lembre de informações, preferências ou tópicos discutidos anteriormente pelo utilizador em múltiplas conversas. O objetivo é aumentar a continuidade e personalização da interação, evitando que o utilizador tenha de repetir as mesmas informações de contexto em conversas subsequentes, melhorando assim a experiência do utilizador. (Fonte: Ronald_vanLoon)

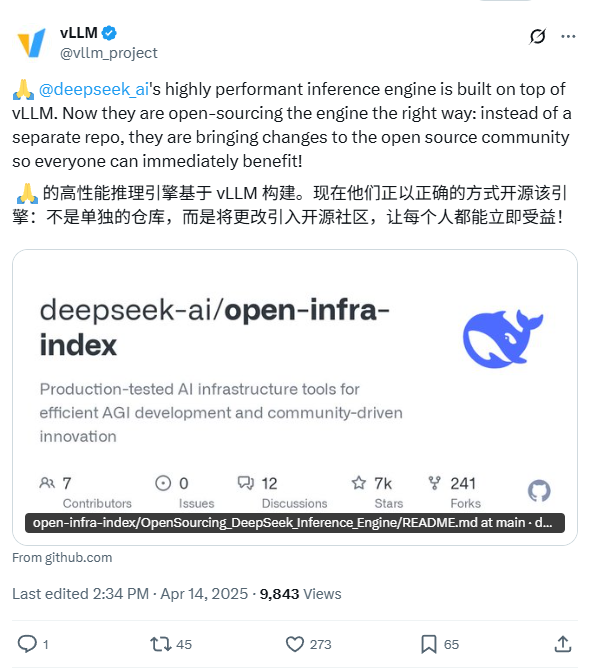

Skywork Lança Série de Modelos de Inferência Open Source OR1: A empresa chinesa Skywork (Tiangong – Kunlun Wanwei) lançou uma nova série de modelos de inferência open source, Skywork OR1. A série inclui o OR1-Math-7B otimizado para matemática, e as versões de pré-visualização OR1-7B e OR1-32B com excelente desempenho em matemática e codificação, sendo que a versão 32B alegadamente rivaliza com o DeepSeek-R1 em capacidade matemática. A Skywork foi elogiada pelo seu nível de abertura, publicando os pesos do modelo, dados de treino e código de treino completo. (Fonte: natolambert)

Melhoria na Capacidade de Navegação e Operação Precisa de Robôs Impulsionados por AI: As redes sociais mostram a capacidade de robôs autónomos impulsionados por AI para navegar com precisão em ambientes complexos e executar tarefas. Estes robôs podem utilizar tecnologias de AI como visão computacional, SLAM (Simultaneous Localization and Mapping), aprendizagem por reforço, etc., para operar eficientemente em ambientes não estruturados ou dinâmicos, demonstrando avanços na perceção, planeamento e controlo robótico. (Fonte: Ronald_vanLoon)

Exoesqueleto Impulsionado por AI Ajuda Utilizadores de Cadeira de Rodas a Andar: Demonstração de um dispositivo de exoesqueleto avançado que utiliza tecnologia de AI para ajudar utilizadores de cadeira de rodas a levantarem-se e a andar novamente. A AI pode ser usada para interpretar a intenção do utilizador, manter o equilíbrio, coordenar o movimento e adaptar-se a diferentes ambientes, refletindo o potencial da AI para melhorar a qualidade de vida de pessoas com deficiência, sendo um avanço importante na tecnologia de robótica assistiva. (Fonte: Ronald_vanLoon)

AI Agents Podem Ser Usados em Ataques Cibernéticos, Gerando Preocupação: Um artigo da MIT Technology Review aponta que AI Agents autónomos podem ser usados para executar ataques cibernéticos complexos. Estes AI Agents têm o potencial de descobrir vulnerabilidades automaticamente, gerar código de ataque e implementar ataques, possivelmente em escala e velocidade muito superiores às dos hackers humanos, representando um sério desafio para os sistemas de defesa de cibersegurança existentes. Isto levanta preocupações sobre a armamentização da AI e os riscos de segurança. (Fonte: Ronald_vanLoon)

OpenAI Anuncia Evento de Transmissão ao Vivo e Possível Lançamento de Novos Modelos: A OpenAI anunciou um evento de transmissão ao vivo através de uma mensagem vaga (developers e buraco negro supermassivo), enquanto circulam na internet informações sobre ícones atualizados e cartões de modelo no seu site oficial, sugerindo o possível lançamento iminente de vários novos modelos, incluindo a série GPT-4.1 (com versões nano, mini), o4-mini e a versão completa do o3. Isto indica que a OpenAI pode estar a preparar-se para lançar uma série de novos produtos ou atualizações de modelos para enfrentar a concorrência de mercado cada vez mais acirrada. (Fonte: openai, op7418)

Robô Figure Atinge Caminhada Natural de Simulação para Realidade Através de Aprendizagem por Reforço: A Figure AI utilizou aprendizagem por reforço (RL) num ambiente puramente simulado para treinar com sucesso o seu robô humanoide Figure 02 a dominar um andar natural. Através de um simulador eficiente que gera grandes quantidades de dados, combinado com randomização de domínio e feedback de torque de alta frequência do próprio robô, conseguiu-se a transferência zero-shot da política da simulação para a realidade. Este método não só acelera o processo de desenvolvimento, mas também prova a viabilidade de uma única política de rede neuronal controlar múltiplas máquinas, tendo um significado importante para futuras aplicações comerciais de robôs. (Fonte: Um Algoritmo Controla Legião de Robôs! Aprendizagem por Reforço em Ambiente Puramente Simulado, Figure Aprende a Andar Como Humano)

🧰 Ferramentas

即梦AI 3.0 Gera Design de Texto Estilizado e Partilha de Prompt: Um utilizador partilhou a sua experiência e método de utilização da ferramenta chinesa de desenho AI “即梦AI 3.0” para gerar imagens de texto com design. Como especificar diretamente nomes de fontes não funcionou bem, o autor criou um modelo detalhado de prompt que predefine vários estilos visuais (como industrial, querido, tecnológico, aguarela, etc.) e estabelece regras para que a AI combine ou funda estilos automaticamente com base no significado e emoção do texto inserido. O utilizador só precisa de inserir o texto alvo (como “jovem jogador de e-sports”, “quero tanto comer doces”), e o modelo gera um prompt de desenho completo contendo estilo, fundo, layout, atmosfera, obtendo assim efeitos de design gráfico de alta qualidade no 即梦AI. O artigo fornece este modelo de prompt e numerosos exemplos gerados. (Fonte: 即梦AI 3.0 Cria Capa com Fonte, Esta Solução é Incrivelmente Boa [Anexo: 16+ Casos e Prompt], Compreendi um Pouco Melhor o Design de Fontes Gerado por AI, Use Este Conjunto de Prompts para Aumentar a Eficiência em 50%.)

Utilizar AI Multimodal para Transformar Fotos de Comida em Imagens Estilo Menu: Utilizadores das redes sociais demonstraram uma técnica para usar modelos de AI multimodais como o GPT-4o para transformar fotos comuns de comida em imagens de menu requintadas. O método envolve fornecer a foto original à AI e combiná-la com prompts descritivos (por exemplo, referindo “padrão e estilo de menu de hotel cinco estrelas de luxo”) para guiar a AI na estilização e edição da imagem, gerando imagens de pratos com aspeto profissional. Isto reflete o potencial prático da AI multimodal na compreensão, edição e transferência de estilo de imagens. (Fonte: karminski3)

Slideteam.net: Possivelmente uma Ferramenta de Criação Instantânea de Slides Impulsionada por AI: As redes sociais mencionam que Slideteam.net consegue criar slides perfeitos “instantaneamente”, sugerindo que pode utilizar tecnologia de AI para automatizar o design e a geração de apresentações. Ferramentas deste tipo geralmente usam AI para implementar layout automático, sugestões de conteúdo, correspondência de estilo, etc., com o objetivo de aumentar a eficiência na criação de PPTs. (Fonte: Ronald_vanLoon)

Demonstração de Robô de Massagem AI: Um vídeo demonstra um robô de massagem impulsionado por AI. O robô combina a capacidade de operação física de um braço mecânico com o controlo inteligente da AI. A AI pode ser usada para entender as necessidades do utilizador, identificar partes do corpo, planear percursos de massagem, ajustar força e técnicas, e até mesmo perceber a reação do utilizador através de sensores para otimizar a experiência de massagem, mostrando o potencial de aplicação da AI em serviços de saúde personalizados e terapia física automatizada. (Fonte: Ronald_vanLoon)

GitHub Copilot Integrado no Windows Terminal: A Microsoft integrou a funcionalidade GitHub Copilot na versão Canary do seu Windows Terminal, denominada “Terminal Chat”. Utilizadores com subscrição Copilot podem interagir diretamente com a AI no ambiente do terminal para obter sugestões de linha de comando, explicações e ajuda. Esta medida visa reduzir a necessidade dos developers de alternar entre aplicações ao escrever comandos, fornecendo assistência inteligente sensível ao contexto, melhorando a eficiência e precisão das operações de linha de comando, especialmente para tarefas complexas ou desconhecidas. (Fonte: GitHub Copilot Agora Pode Ser Executado no Windows Terminal)

Discussão sobre Requisitos de Hardware para Implementação do OpenWebUI: Utilizadores da comunidade Reddit discutem a configuração de máquina virtual Azure necessária para implementar o OpenWebUI (uma interface web para LLM) para uma equipa de cerca de 30 pessoas. O utilizador planeia executar localmente o modelo de embedding Snowflake e usar a API da OpenAI. A discussão aborda a expansão de recursos, o impacto do tamanho do modelo de embedding em CPU/RAM/armazenamento e a importância do pré-processamento de dados. A comunidade sugere que depender fortemente da API pode reduzir os requisitos de hardware local, mas se executar modelos localmente (especialmente modelos de embedding), é necessária uma configuração mais robusta. Para situações com recursos limitados, sugere-se também usar a API para processar embeddings. (Fonte: Reddit r/OpenWebUI)

📚 Aprendizagem

Modelos de AI de Inferência Têm Falha de “Pensamento Excessivo” na Ausência de Premissas: Investigação da Universidade de Maryland e outras instituições revela que os modelos de inferência atuais (como DeepSeek-R1, o1), quando confrontados com problemas que carecem de informação necessária (premissa em falta, MiP), tendem a gerar respostas longas e inválidas, em vez de identificar rapidamente a falha do próprio problema. Este fenómeno de “pensamento excessivo MiP” leva ao desperdício de recursos computacionais e tem pouca relação com a capacidade do modelo de eventualmente perceber a falta da premissa. Em contraste, modelos não-inferenciais têm melhor desempenho. A investigação considera que isto expõe a falta de capacidade de pensamento crítico nos modelos de inferência atuais, possivelmente originada no paradigma de treino de aprendizagem por reforço ou no processo de destilação de conhecimento. (Fonte: AI de Inferência Viciada em “Imaginar”, Cheia de Conversa Fiada, Estudante Chinês de Maryland Revela os Bastidores)

CVPR 2025: CADCrafter Realiza Geração de Ficheiros CAD Editáveis a Partir de Uma Única Imagem: Investigadores da Magic Core Technology, Nanyang Technological University e outras instituições propuseram o framework CADCrafter, capaz de gerar diretamente ficheiros de engenharia CAD parametrizados e editáveis (representados como sequências de instruções CAD) a partir de uma única imagem (renderização de peças, fotos de objetos reais, etc.), em vez dos modelos tradicionais de malha ou nuvem de pontos. O método utiliza um VAE para codificar instruções CAD e combina-o com um Diffusion Transformer para geração no espaço latente condicionada pela imagem, melhorando o desempenho através de uma estratégia de destilação de múltiplas vistas para vista única e utilizando DPO para otimizar a compilabilidade das instruções geradas. Os ficheiros CAD gerados podem ser usados diretamente para produção e processamento, e suportam a modificação do modelo através da edição de instruções, melhorando significativamente a praticidade e a qualidade da superfície dos modelos 3D gerados por AI. (Fonte: Geração Direta de Ficheiro de Engenharia CAD a Partir de Uma Única Imagem! Nova Investigação CVPR 2025 Resolve Ponto Crítico “Não Editável” de Modelos 3D Gerados por AI | Produzido por Magic Core Technology, NTU, etc.)

Universidade de Zhejiang, OPPO, etc., Publicam Revisão sobre OS Agents: Este artigo de revisão sistematiza o estado atual da investigação sobre agentes de sistema operativo inteligentes (OS Agents) baseados em grandes modelos multimodais (MLLM). OS Agents referem-se a AI capazes de executar tarefas automaticamente através da interface do sistema operativo (GUI) em computadores, telemóveis e outros dispositivos. O artigo define os seus elementos chave (ambiente, espaço de observação, espaço de ação), capacidades centrais (compreensão, planeamento, execução), revê métodos de construção (arquitetura e treino do modelo base, design do framework do agente) e resume protocolos de avaliação, benchmarks e produtos comerciais relacionados. Finalmente, discute desafios e direções futuras como segurança e privacidade, personalização e auto-evolução, fornecendo uma referência abrangente para a investigação neste campo. (Fonte: Universidade de Zhejiang, OPPO, etc., Publicam Última Revisão: Investigação sobre Agentes Inteligentes de Computador, Telemóvel e Browser Baseados em Grandes Modelos Multimodais)

ICLR 2025: Nabla-GFlowNet Realiza Ajuste Fino Eficiente de Recompensa de Diversidade para Modelos de Difusão: Visando os problemas de convergência lenta (RL tradicional) ou perda de diversidade (otimização direta) no ajuste fino de recompensa de modelos de difusão, os investigadores propuseram o método Nabla-GFlowNet. O método baseia-se no framework de redes de fluxo generativo (GFlowNet), deriva novas condições de equilíbrio de fluxo (Nabla-DB) e função de perda, utilizando informações de gradiente de recompensa para guiar o ajuste fino. Através de um design de parametrização específico, mantendo a diversidade das amostras geradas, alcança uma velocidade de convergência mais rápida do que métodos como DDPO, e foi validado no modelo Stable Diffusion usando funções de recompensa como estética, seguimento de instruções, etc., com resultados superiores aos métodos existentes. (Fonte: ICLR 2025 | Novo Avanço no Ajuste Fino de Recompensa de Modelos de Difusão! Nabla-GFlowNet Concilia Diversidade e Eficiência)

Análise do Mecanismo de Inferência DeepSeek-R1: Investigação da Universidade McGill analisou profundamente o processo de “pensamento” de modelos de inferência como o DeepSeek-R1. A investigação descobriu que o comprimento da cadeia de raciocínio não está positivamente correlacionado com o desempenho, existindo um “ponto ótimo”, e um raciocínio excessivamente longo pode até ser prejudicial. O modelo pode ficar preso em repetições de formulações existentes ao processar contextos longos ou problemas complexos. Além disso, em comparação com modelos não-inferenciais, o DeepSeek-R1 pode ter vulnerabilidades de segurança mais evidentes. Esta investigação revela algumas características e limitações potenciais do mecanismo de funcionamento dos modelos de inferência atuais. (Fonte: LLM Weekly Digest! | Abrangendo Multimodalidade, Modelos MoE, Inferência Deepseek, Controlo de Segurança de Agentes, Quantização de Modelos, etc.)

Novo Método C3PO para Otimização de Modelos MoE em Tempo de Teste: A Universidade Johns Hopkins propôs o método C3PO (Critical Layers, Core Experts, Collaborative Path Optimization) para otimizar o desempenho de grandes modelos de Mistura de Especialistas (MoE) em tempo de teste. O método otimiza para cada amostra de teste, reponderando os especialistas centrais nas camadas críticas, para resolver o problema de caminhos de especialistas subótimos. Experiências mostram que o C3PO pode aumentar significativamente a precisão dos modelos MoE (7-15%), permitindo até que modelos MoE de parâmetros menores superem o desempenho de modelos densos com mais parâmetros, melhorando a eficiência da arquitetura MoE. (Fonte: LLM Weekly Digest! | Abrangendo Multimodalidade, Modelos MoE, Inferência Deepseek, Controlo de Segurança de Agentes, Quantização de Modelos, etc.)

Estudo Sistemático do Impacto da Quantização no Desempenho de Modelos de Inferência: Instituições como a Universidade Tsinghua realizaram o primeiro estudo sistemático do impacto da quantização de modelos no desempenho de modelos de inferência (como DeepSeek-R1, série Qwen). As experiências avaliaram o efeito da quantização sob diferentes larguras de bits (pesos, cache KV, ativações) e algoritmos. A investigação descobriu que a quantização W8A8 ou W4A16 geralmente consegue desempenho sem perdas ou quase sem perdas, mas larguras de bits inferiores aumentam significativamente o risco. O tamanho do modelo, a origem e a dificuldade da tarefa são fatores cruciais que afetam o desempenho pós-quantização. Os resultados da investigação e os modelos quantizados foram tornados open source. (Fonte: LLM Weekly Digest! | Abrangendo Multimodalidade, Modelos MoE, Inferência Deepseek, Controlo de Segurança de Agentes, Quantização de Modelos, etc.)

APIGen-MT: Framework para Gerar Dados de Interação de Agentes Multi-turno de Alta Qualidade: A Salesforce propôs o framework APIGen-MT, visando resolver a escassez de dados de alta qualidade necessários para treinar AI Agents de interação multi-turno. O framework divide-se em duas fases: primeiro, usa revisão por LLM e feedback iterativo para gerar um plano detalhado da tarefa; depois, através da simulação da interação humano-máquina, converte o plano em dados de trajetória completos. A série de modelos xLAM-2 treinada com base neste framework teve um desempenho excelente em benchmarks de agentes multi-turno, superando modelos como GPT-4o, validando a eficácia deste método de geração de dados. Os dados sintéticos e os modelos foram tornados open source. (Fonte: LLM Weekly Digest! | Abrangendo Multimodalidade, Modelos MoE, Inferência Deepseek, Controlo de Segurança de Agentes, Quantização de Modelos, etc.)

Investigação Revela: Cadeias de Pensamento Mais Longas Não Equivalem a Melhor Desempenho de Raciocínio, Aprendizagem por Reforço Pode Ser Mais Concisa: Investigação da Wand AI aponta que modelos de inferência (especialmente os treinados com algoritmos RL como PPO) tendem a gerar respostas mais longas, não por necessidade de precisão, mas porque o próprio mecanismo RL pode causar isso: para respostas erradas (recompensa negativa), prolongar a resposta pode “diluir” a penalidade por token, reduzindo assim a perda. A investigação prova que o raciocínio conciso está relacionado com maior precisão e propõe um método de treino RL em duas fases: primeiro, treinar com problemas difíceis para melhorar a capacidade (possivelmente aumentando a resposta); depois, treinar com problemas de dificuldade moderada para promover a concisão e manter a precisão, sendo eficaz mesmo em conjuntos de dados muito pequenos para melhorar o desempenho e a robustez. (Fonte: Pensamento Mais Longo Não Equivale a Desempenho de Raciocínio Mais Forte, Aprendizagem por Reforço Pode Ser Muito Concisa)

Universidade de Ciência e Tecnologia da China, ZTE Propõem Curr-ReFT: Novo Paradigma de Pós-Treino para VLM de Pequena Dimensão: Visando os problemas enfrentados por modelos de linguagem visual (VLM) de pequena dimensão após o ajuste fino supervisionado, como fraca capacidade de generalização, capacidade de inferência limitada e treino instável (fenómeno “parede de tijolos”), a Universidade de Ciência e Tecnologia da China e a ZTE Communications propuseram o paradigma de pós-treino Curr-ReFT. O método combina aprendizagem por reforço curricular (Curr-RL) e auto-melhoria baseada em amostragem por rejeição. O Curr-RL, através de um mecanismo de recompensa sensível à dificuldade, guia o modelo a aprender progressivamente do fácil para o difícil; a amostragem por rejeição utiliza amostras de alta qualidade para manter as capacidades básicas do modelo. Experiências nos modelos Qwen2.5-VL-3B/7B mostram que o Curr-ReFT melhora significativamente o desempenho de inferência e generalização do modelo, fazendo com que modelos pequenos superem modelos grandes em vários benchmarks. Código, dados e modelos foram tornados open source. (Fonte: Universidade de Ciência e Tecnologia da China, ZTE Propõem Novo Paradigma de Pós-Treino: Modelo Multimodal de Pequena Dimensão, Reproduz com Sucesso Inferência R1)

Universidade Tsinghua, Shanghai AI Lab Propõem GenPRM: Modelo de Recompensa de Processo Generativo Escalável: Para resolver os problemas de falta de interpretabilidade e capacidade de expansão em tempo de teste dos modelos tradicionais de recompensa de processo (PRM) na supervisão da inferência de LLM, a Universidade Tsinghua e o Shanghai AI Lab propuseram o GenPRM. Ele avalia os passos de inferência gerando cadeias de pensamento em linguagem natural (CoT) e código de verificação executável, fornecendo feedback mais transparente. O GenPRM suporta expansão computacional em tempo de teste, melhorando a precisão através da amostragem de múltiplos caminhos de avaliação e da média das recompensas. Este modelo, treinado com apenas 23K dados sintéticos, na versão 1.5B com expansão em tempo de teste já supera o GPT-4o, e a versão 7B supera modelos de base de 72B. O GenPRM também pode servir como crítico a nível de passo para a melhoria iterativa de respostas. (Fonte: Modelo de Recompensa de Processo Também Pode Expandir em Tempo de Teste? Universidade Tsinghua, Shanghai AI Lab Usam 23K Dados para Pequeno Modelo 1.5B Superar GPT-4o)

Maior Conjunto de Dados Matemáticos Open Source do Mundo, MegaMath, Lançado (371B Tokens): O LLM360 lançou o conjunto de dados MegaMath, contendo 371 mil milhões de tokens, sendo atualmente o maior conjunto de dados de pré-treino open source focado em raciocínio matemático do mundo, visando colmatar a lacuna em escala e qualidade entre a comunidade open source e os corpus matemáticos de código fechado (como DeepSeek-Math). O conjunto de dados é composto por três partes: dados de páginas web relacionadas com matemática em grande escala (279B, incluindo um subconjunto de alta qualidade de 15B), código matemático (28B) e dados sintéticos de alta qualidade (64B, incluindo perguntas e respostas, geração de código, misto de texto e imagem). Após processamento cuidadoso e múltiplas rondas de validação de pré-treino, usar o MegaMath para pré-treinar no modelo Llama-3.2 pode trazer melhorias significativas de desempenho de 15-20% em benchmarks como GSM8K e MATH. (Fonte: 371 Mil Milhões de Tokens Matemáticos! Maior Conjunto de Dados Matemáticos Open Source do Mundo, MegaMath, Lançado de Forma Impactante, Superando DeepSeek-Math)

CVPR 2025: NLPrompt Melhora Robustez da Aprendizagem por Prompt de VLM com Rótulos Ruidosos: O YesAI Lab da ShanghaiTech University propôs o método NLPrompt, visando resolver o problema da queda de desempenho da aprendizagem por prompt de modelos de linguagem visual (VLM) face a ruído nos rótulos. A investigação descobriu que, no cenário de aprendizagem por prompt, a perda de erro absoluto médio (MAE) (PromptMAE) é mais robusta do que a perda de entropia cruzada (CE). Ao mesmo tempo, propôs o método de purificação de dados PromptOT baseado em transporte ótimo, utilizando características textuais geradas por prompts como protótipos para dividir o conjunto de dados em conjunto limpo e conjunto ruidoso. O NLPrompt usa perda CE para o conjunto limpo e perda MAE para o conjunto ruidoso, combinando eficazmente as vantagens de ambos. Experiências provam que este método melhora significativamente a robustez e o desempenho de métodos de aprendizagem por prompt como CoOp em conjuntos de dados com ruído sintético e real. (Fonte: CVPR 2025 | Perda MAE + Transporte Ótimo em Combinação! ShanghaiTech Propõe Novo Método Robusto de Aprendizagem por Prompt)

Aplicação e Discussão da Técnica de Destilação de Conhecimento na Compressão de Modelos: A comunidade discutiu a técnica de destilação de conhecimento, que usa um grande modelo “professor” para treinar um pequeno modelo “aluno”, permitindo que este último atinja um desempenho próximo ao do professor numa tarefa específica, mas com um custo significativamente menor. Um utilizador partilhou o sucesso em destilar a capacidade do GPT-4o na tarefa de análise de sentimento (92% de precisão) para um modelo pequeno, reduzindo o custo em 14 vezes. Os comentários apontam que, embora o efeito da destilação seja significativo, geralmente limita-se a domínios específicos, e o modelo aluno carece da capacidade de generalização do modelo professor. Ao mesmo tempo, para cenários profissionais que exigem adaptação contínua às mudanças nos dados, o custo de manter um modelo auto-treinado pode ser superior ao de usar diretamente uma API de grande escala. (Fonte: Reddit r/MachineLearning)

Definição de AI Agent Desperta Atenção: Empresas de consultoria como a McKinsey começaram a definir e discutir o conceito de AI Agent, refletindo a crescente importância dos AI Agents como entidades inteligentes capazes de perceber, decidir e agir autonomamente para completar objetivos, nos domínios comercial e tecnológico. Compreender a definição, capacidades e cenários de aplicação dos AI Agents tornou-se um ponto de foco da indústria. (Fonte: Ronald_vanLoon)

💼 Negócios

Descodificando a Estratégia de AI da Alibaba: Com AGI no Núcleo, Reinvestimento em Infraestrutura para Promover Transformação: A análise aponta que, embora a Alibaba não tenha lançado formalmente uma estratégia de AI, as suas ações já revelam um quadro claro: perseguir a AGI como objetivo principal, na esperança de recuperar a iniciativa na competição. Nos próximos três anos, planeia investir mais de 380 mil milhões de RMB na construção de infraestruturas de AI e cloud computing, focando-se em satisfazer a crescente procura por inferência. O caminho estratégico inclui: promover capacidades de AI Agent através do DingTalk; usar a série de modelos open source Qwen para impulsionar o crescimento da Alibaba Cloud; desenvolver o modelo MaaS da API Tongyi. Ao mesmo tempo, a Alibaba usará AI para transformar profundamente os seus negócios existentes, como melhorar a experiência do utilizador no Taobao, transformar o Quark numa aplicação AI emblemática (pesquisa + Agent), explorar aplicações de AI nos serviços de vida do Amap. A Alibaba também pode acelerar o seu layout de AI através de investimentos e aquisições. (Fonte: Descodificando a Estratégia de AI da Alibaba: Nunca Lançada, Mas Já a Correr Loucamente)

Novas Tendências no Mercado de Talentos de AI: Foco na Prática em Detrimento da Formação Académica, Capacidades Híbridas Valorizadas: Com base na análise de quase 3000 posições de AI de alto salário nas principais cidades da China, o relatório revela três grandes tendências na procura de talentos de AI: 1) A procura por engenheiros de algoritmos é forte, com salários generosos, e a indústria automóvel tornou-se o principal recrutador; 2) As empresas (incluindo empresas de destaque como a DeepSeek) estão gradualmente a reduzir os requisitos académicos rígidos, valorizando mais a capacidade prática de engenharia e a experiência na resolução de problemas complexos; 3) A procura por talentos híbridos está a aumentar, por exemplo, gestores de produto de AI precisam de entender simultaneamente utilizadores, modelos e engenharia de prompts, porque a AI está a assumir mais tarefas especializadas, exigindo que os humanos integrem e supervisionem a um nível superior. (Fonte: A Partir de Quase 3000 Dados de Recrutamento, Encontrei Três Leis de Ferro para Descobrir Talentos de AI)

UBTECH Continua com Prejuízos, Comercialização de Robôs Humanoides Enfrenta Desafios Severos: O relatório financeiro de 2024 da empresa de robôs humanoides UBTECH mostra que, apesar de um aumento de 23,7% nas receitas para 1,3 mil milhões de yuan, ainda registou um prejuízo de 1,16 mil milhões de yuan. A comercialização do seu negócio principal de robôs humanoides progride lentamente, com apenas 10 unidades entregues durante todo o ano, a um preço unitário de 3,5 milhões de yuan, muito acima das expectativas do mercado e dos concorrentes (como o G1 da Unitree Robotics vendido por apenas 99.000 yuan). Além disso, outra empresa líder no setor, a CloudMinds, enfrenta alegados problemas de liquidez, levantando questões sobre a viabilidade comercial da indústria de robôs humanoides, corroborando a visão cautelosa do investidor Zhu Xiaohu. Custos elevados, cenários de aplicação limitados e segurança e fiabilidade são atualmente os principais obstáculos à comercialização em larga escala de robôs humanoides. (Fonte: UBTECH Perde Quase 1,2 Bilhões de Yuan num Ano, Zhu Xiaohu Agora Tem Mais Razão para Falar)

AI Impulsiona Crescimento nos Setores de Telecomunicações, Alta Tecnologia e Média: A discussão aponta que a inteligência artificial (incluindo AI generativa) está a tornar-se uma força chave para impulsionar o crescimento nos setores de telecomunicações, alta tecnologia e média. A tecnologia AI é amplamente aplicada para melhorar a experiência do cliente, otimizar operações de rede, automatizar a criação de conteúdo, aumentar a eficiência operacional e desenvolver serviços inovadores, ajudando as empresas destes setores a obter vantagem competitiva num mercado em rápida mudança. (Fonte: Ronald_vanLoon)

Hugging Face Adquire Empresa de Robótica Open Source Pollen Robotics: A conhecida plataforma de modelos e ferramentas de AI, Hugging Face, adquiriu a Pollen Robotics, uma startup famosa pelo seu robô humanoide open source Reachy. Esta aquisição indica a intenção da Hugging Face de expandir o seu modelo open source de sucesso para o campo da robótica AI, visando promover a colaboração e inovação neste domínio através de soluções de hardware e software abertas, acelerando o processo de democratização da tecnologia robótica. (Fonte: huggingface, huggingface, huggingface, huggingface)

🌟 Comunidade

Era da AI Pode Ser Mais Favorável ao Desenvolvimento de Pessoas de Humanidades: Lynn Duan, fundadora da comunidade AI+ de Silicon Valley, acredita que, à medida que ferramentas de AI (como Cursor) reduzem a barreira da programação, a importância da capacidade de engenharia diminui relativamente, enquanto competências em humanidades e ciências sociais, como comercialização, marketing e comunicação, se tornam mais cruciais. A AI substitui algumas posições técnicas de nível júnior, mas cria procura por talentos híbridos capazes de conectar tecnologia e mercado. Ela aconselha os recém-licenciados a considerar startups para crescimento rápido e a demonstrar capacidade através de projetos práticos (como implementar modelos, desenvolver aplicações), em vez de apenas dependerem de qualificações académicas. Ela também salienta que as características do fundador (como convicção, compreensão do setor) são mais importantes do que um background puramente técnico, e vê boas oportunidades de empreendedorismo em AI nos setores de SaaS nos EUA e hardware inteligente na China. (Fonte: AI é, na Verdade, uma Boa Era para Pessoas de Humanidades | Conversa com Lynn Duan, Fundadora da AI+ de Silicon Valley)

Breve “Bloqueio” de IPs Chineses pelo GitHub Gera Preocupação, Oficialmente Atribuído a Erro: Recentemente, alguns utilizadores chineses descobriram que não conseguiam aceder ao GitHub sem login, recebendo uma mensagem de IP restrito, o que gerou preocupações na comunidade sobre um possível “bloqueio”. Embora o GitHub tenha respondido rapidamente afirmando que foi um erro de configuração e já corrigido, o incidente ainda gerou discussão. Dado que o GitHub já restringiu o acesso a regiões como Irão e Rússia no passado, com base nas políticas de sanções dos EUA, este evento foi interpretado por alguns como um “ensaio” para potenciais medidas restritivas. O artigo enfatiza a importância do GitHub para os developers chineses e o ecossistema open source (incluindo numerosos projetos de AI), bem como o impacto negativo que tais restrições poderiam ter, e lista plataformas de alojamento de código domésticas como Gitee e CODING como alternativas. (Fonte: “Bug” ou “Ensaio”? GitHub “Bloqueia” Subitamente Todos os IPs Chineses, Oficialmente: Foi Apenas um “Erro Técnico” por Deslize)

Desempenho e Serviço do Claude AI Geram Controvérsia entre Utilizadores: Discussões no Reddit mostram que alguns utilizadores expressaram insatisfação com o modelo Claude da Anthropic, mencionando queda de desempenho, modificações desnecessárias ao codificar e desapontamento com os níveis de subscrição paga e limites de taxa, com até mesmo developers conhecidos a afirmar que mudarão para outros modelos (como Gemini 2.5 Pro). No entanto, também há utilizadores que consideram que o Claude (especialmente a versão mais antiga Sonnet 3.5) ainda tem vantagens em tarefas específicas (como codificação), ou afirmam não encontrar frequentemente limites de taxa. Esta controvérsia reflete a divergência na experiência dos utilizadores com o Claude e as altas expectativas dos utilizadores em relação ao desempenho e serviço dos modelos de AI numa competição acirrada. (Fonte: Reddit r/ClaudeAI)

Escala da Funcionalidade Deep Research do Gemini Gera Discussão: Um utilizador partilhou a sua experiência ao usar a funcionalidade Deep Research do Google Gemini Advanced, onde a AI acedeu a quase 700 websites para responder a uma pergunta e gerou um relatório extenso (como 37 páginas). Esta escala impressionou o utilizador, mas também gerou discussão sobre a qualidade da informação. Comentadores questionaram se processar uma quantidade tão grande de informação da web pode garantir precisão e profundidade, ou se apenas agrega resultados de pesquisa da web potencialmente errados numa escala maior. Isto reflete a atenção e o escrutínio da comunidade sobre a capacidade de processamento de informação (profundidade vs. amplitude) das ferramentas de investigação de AI. (Fonte: Reddit r/artificial)

Capacidade de Programação do Gemini 2.5 Pro Recebe Elogios da Comunidade: Vários utilizadores partilharam na comunidade experiências positivas ao usar o Google Gemini 2.5 Pro para programação, considerando-o altamente inteligente, capaz de compreender bem a intenção do utilizador, e possuindo uma capacidade de processamento de contexto longo de 1 milhão de tokens (suficiente para analisar grandes bases de código) gratuitamente, com um desempenho geral superior a concorrentes como o Claude. Embora existam pequenas falhas (como alucinar ocasionalmente funções de biblioteca inexistentes), a avaliação geral é muito alta, sendo considerado um dos modelos de codificação mais populares atualmente, e expressando expectativa por modelos potencialmente mais fortes da Google no futuro (como Dragontail). (Fonte: Reddit r/ArtificialInteligence)

Desenvolvimento Rápido de Modelos Open Source Pequenos, Percepção do Utilizador Precisa de Atualização: A comunidade discute o rápido progresso dos LLMs open source. Salienta-se que modelos como Qwen-32B e Gemma-3-27B, que parecem bons atualmente, seriam revolucionários se tivessem surgido há um ou dois anos (quando o GPT-4 foi lançado). Isto lembra a todos que não se deve ignorar a capacidade real dos pequenos modelos open source atuais, que já atingiram um nível bastante elevado. Os comentários também admitem que estes modelos ainda têm lacunas em comparação com os modelos de topo de código fechado (como estabilidade, velocidade, processamento de contexto), mas enfatizam a sua velocidade de progresso e potencial, acreditando que avanços futuros podem vir de inovações arquitetónicas em vez de simplesmente empilhar parâmetros. (Fonte: Reddit r/LocalLLaMA)

Membro da Comunidade Oferece Poder Computacional Gratuito de A100 para Apoiar Projetos de AI: Um utilizador com 4 GPUs Nvidia A100 publicou na comunidade Reddit, oferecendo poder computacional gratuito (cerca de 100 horas A100) para projetos de entusiastas de AI que sejam inovadores, visem ter um impacto positivo e estejam limitados por recursos computacionais. A iniciativa recebeu uma resposta positiva, com vários investigadores e developers a apresentar planos de projeto específicos, abrangendo treino de novas arquiteturas de modelo, interpretabilidade de modelos, aprendizagem modular, aplicações de interação humano-máquina, etc., refletindo a ânsia da comunidade de investigação de AI por recursos computacionais e o espírito de ajuda mútua e partilha. (Fonte: Reddit r/deeplearning)

Problema de Limite de Taxa do Claude AI Gera Debate na Comunidade: Queixas sobre o acionamento frequente de limites de taxa ao usar o modelo Claude AI (por exemplo, após apenas 5 mensagens) geraram debate na comunidade. Alguns utilizadores questionaram veementemente tais queixas, considerando-as exageradas ou resultado de uso inadequado pelo utilizador (como carregar sempre contextos muito longos), exigindo provas. No entanto, outros utilizadores partilharam as suas próprias experiências, confirmando que atingem frequentemente os limites ao realizar tarefas intensivas (como edição de código grande), afetando o fluxo de trabalho. A discussão reflete a grande variação na experiência dos utilizadores com os limites de taxa, possivelmente relacionada com o modo de uso específico e a complexidade da tarefa, mostrando também a sensibilidade dos utilizadores às limitações dos serviços pagos. (Fonte: Reddit r/ClaudeAI)

💡 Outros

Conferência sobre Ecossistema AIGC e Agentes Inteligentes (Xangai) em Junho: A segunda Conferência sobre Ecossistema AIGC e Agentes de Inteligência Artificial será realizada em Xangai a 12 de junho de 2025, com o tema “Ligando Tudo Inteligentemente · Simbiose Sem Fronteiras”. A conferência foca-se na inovação colaborativa e integração ecológica da AI generativa (AIGC) e agentes inteligentes (AI Agent), cobrindo tópicos como infraestrutura de AI, grandes modelos de linguagem, marketing e aplicações de cenário AIGC (média, e-commerce, indústria, saúde, etc.), tecnologia multimodal, frameworks de decisão autónoma, etc. Visa promover a atualização da AI de ferramenta pontual para colaboração ecológica, conectando fornecedores de tecnologia, partes interessadas, capital e decisores políticos. (Fonte: Junho Xangai | Cimeira de Xangai “Ligando Tudo Inteligentemente”: Fusão Ecológica AIGC + Agente Inteligente)

Conferência 36Kr AI Partner Foca-se em Super APP: A 36Kr realizará a “Super APP Chegou · Conferência AI Partner 2025” no dia 18 de abril de 2025, no MoSu Space em Xangai. A conferência visa explorar como as aplicações de AI estão a remodelar o mundo dos negócios, dando origem a “super aplicações” disruptivas. A conferência reunirá executivos de empresas como AMD, Baidu, 360, Qualcomm e investidores para discutir tópicos quentes como AI industrial, poder computacional de AI, pesquisa AI, educação AI, etc., e anunciará casos inovadores de aplicações nativas de AI e os Prémios de Inovação AI Partner. Em simultâneo, serão realizados um salão de AI inclusiva e um seminário fechado sobre internacionalização de AI. (Fonte: Super App Chegou! Veja Como as Aplicações de AI Estão a “Reescrever” o Mundo dos Negócios? | Pontos Principais da Conferência AI Partner 2025)

Horizon Robotics Recruta Estagiário de Algoritmos de Reconstrução/Geração 3D: A equipa de Inteligência Incorporada da Horizon Robotics está a recrutar estagiários de algoritmos na área de reconstrução/geração 3D em Xangai e Pequim. A posição envolverá o design e desenvolvimento de algoritmos Real2Sim, utilizando tecnologias como 3D Gaussian Splatting, reconstrução feed-forward, geração 3D/vídeo para reduzir o custo de aquisição de dados de robôs e otimizar o desempenho do simulador. Requer mestrado ou superior, experiência e competências relevantes. Oferece oportunidade de efetivação, recursos de GPU e orientação profissional. (Fonte: Referência Interna Xangai/Pequim | Equipa de Inteligência Incorporada da Horizon Robotics Recruta Estagiário de Algoritmos na Área de Reconstrução/Geração 3D)

OceanBase Organiza Primeira Competição AI Hackathon: O fornecedor de bases de dados OceanBase, em colaboração com Ant Open Source, Machine之心, etc., organiza o primeiro AI Hackathon, com o tema “DB+AI”, oferecendo um prémio total de 100.000 yuan. A competição incentiva os developers a explorar a combinação de OceanBase e tecnologias de AI, com direções que incluem o uso de OceanBase como base de dados para aplicações de AI, ou a construção de aplicações de AI no ecossistema OceanBase (combinando CAMEL AI, FastGPT, etc.) (como sistemas de perguntas e respostas, diagnóstico). As inscrições decorrem de 10 de abril a 7 de maio, abertas a indivíduos e equipas. (Fonte: Prémio de 100.000 Yuan × Upgrade Cognitivo! Primeiro AI Hackathon da OceanBase Lança Desafio, Atreves-te a Vir?)

Meituan Hotel & Travel Recruta Engenheiro de Algoritmos de Grandes Modelos L7-L8: A equipa de Algoritmos de Fornecimento da Meituan Hotel & Travel está a recrutar Engenheiros de Algoritmos de Grandes Modelos de nível L7-L8 (recrutamento externo) em Pequim. As responsabilidades incluem a utilização de NLP e tecnologias de grandes modelos para construir um sistema de compreensão do fornecimento de hotelaria e viagens (tags, hotspots, análise de similaridade), otimizar materiais de exibição de produtos (títulos, imagens e texto), construir combinações de pacotes de férias e explorar a aplicação de tecnologias de grandes modelos de ponta em algoritmos do lado da oferta. Requer mestrado ou superior, mais de 2 anos de experiência, e sólidas capacidades de algoritmo e programação. (Fonte: Referência Interna Pequim | Equipa de Algoritmos de Fornecimento da Meituan Hotel & Travel Recruta Engenheiro de Algoritmos de Grandes Modelos L7-L8)

QbitAI Recruta Editor/Autor na Área de AI: O meio de comunicação de tecnologia AI QbitAI está a recrutar Editores/Autores a tempo inteiro, com local de trabalho em Zhongguancun, Pequim, aberto a recrutamento externo e recém-licenciados, oferecendo oportunidade de estágio com possibilidade de efetivação. As áreas de recrutamento incluem grandes modelos de AI, robôs de inteligência incorporada, hardware de terminal e edição de novas médias AI (Weibo/Xiaohongshu). Requer paixão pela área de AI, boas capacidades de expressão escrita e recolha de informação. Pontos extra incluem familiaridade com ferramentas de AI, capacidade de interpretação de artigos científicos, capacidade de programação, etc. Oferece salário e benefícios competitivos e oportunidades de crescimento profissional. (Fonte: Recrutamento QbitAI | Anúncio de Recrutamento que o DeepSeek nos Ajudou a Rever)

Vencedor do Prémio Turing LeCun Fala sobre Desenvolvimento de AI: Inteligência Humana Não é Geral, Próxima Geração de AI Pode Não Ser Generativa: Numa entrevista de podcast, Yann LeCun argumentou que a busca atual por AGI (Inteligência Artificial Geral) é baseada num equívoco, porque a própria inteligência humana é altamente especializada, não geral. Ele prevê que o avanço da próxima geração de AI pode basear-se em modelos não-generativos, como a arquitetura JEPA que ele propôs, focando-se em fazer a AI compreender o mundo físico, possuir capacidade de raciocínio e planeamento (world model), em vez de apenas processar linguagem. Ele acredita que os LLMs atuais carecem de verdadeira capacidade de raciocínio. LeCun também enfatizou a importância do open source (como o LLaMA da Meta) para impulsionar o desenvolvimento da AI e considera que dispositivos como óculos inteligentes são uma direção importante para a implementação da tecnologia AI. (Fonte: Vencedor do Prémio Turing LeCun: Inteligência Humana Não é Inteligência Geral, Próxima Geração de AI Pode Basear-se em Não-Generativa)

Cimeira da Indústria AIGC da China Prestes a Acontecer (16 de Abril, Pequim): A terceira Cimeira da Indústria AIGC da China será realizada em Pequim a 16 de abril. A cimeira reunirá mais de 20 líderes da indústria de empresas e instituições como Baidu, Huawei, AWS, Microsoft Research Asia, Mianbi Intelligence, Shengshu Technology, Fenbi, NetEase Youdao, Quwan Technology, Qing Song Health, para discutir os últimos avanços na tecnologia AI, a sua aplicação em milhares de indústrias, infraestrutura de poder computacional, segurança e controlo, e outras questões centrais. A cimeira visa mostrar como a AI está a capacitar a atualização industrial e anunciará prémios relevantes e o “Mapa Panorâmico de Aplicações AIGC da China”. (Fonte: Contagem Decrescente de 2 Dias! Mais de 20 Líderes da Indústria Falam sobre AI, Guia Mais Completo da Cimeira da Indústria AIGC da China Aqui)

Explorando Soluções para Executar Grandes Modelos de Milhares de Milhões de Parâmetros em Placas Gráficas de Baixo Custo: O artigo explora uma solução de máquina AI tudo-em-um de custo controlado (nível de 100.000 yuan) construída com placas gráficas Intel Arc™ (como A770) e processadores Xeon® W. Esta solução, através da otimização coordenada de software e hardware (IPEX-LLM, OpenVINO™, oneAPI), permite executar grandes modelos como Qwen-32B (velocidade até 32 tokens/s) e até mesmo o DeepSeek R1 de 671B (com otimização FlashMoE, velocidade perto de 10 tokens/s) numa única máquina. Isto oferece às empresas uma opção de alta relação custo-benefício para implementar grandes modelos localmente ou no edge, satisfazendo necessidades como inferência offline e segurança de dados. A Intel também lançou a plataforma OPEA, colaborando com parceiros do ecossistema para promover a padronização e popularização de aplicações de AI empresariais. (Fonte: Esgotando Placa Gráfica de 3000 Yuan, a Receita Secreta para Executar Grandes Modelos de Milhares de Milhões de Parâmetros Chegou)

Robô Cirúrgico Demonstra Operação de Alta Precisão: Vídeo demonstra um robô cirúrgico capaz de separar com precisão a casca de um ovo de codorniz cru da sua membrana interna, refletindo o nível avançado dos robôs modernos em operações finas e controlo. (Fonte: Ronald_vanLoon)

Visão Geral dos Avanços na Tecnologia de Litografia de Semicondutores: Aponta para um artigo sobre o conteúdo da conferência SPIE Advanced Lithography + Patterning, discutindo os últimos avanços em tecnologias de fabrico de chips da próxima geração, incluindo High-NA EUV, custo de EUV, modelagem de padrões, novas fotorresinas (óxido metálico, seca) e Hyper-NA. Estas tecnologias são cruciais para suportar o desenvolvimento futuro de chips de AI. (Fonte: dylan522p)

Robô com Rodas Demonstra Habilidades Precisas: Vídeo demonstra as habilidades de movimento ou operação de alta precisão de um robô com rodas, possivelmente envolvendo tecnologias de AI e machine learning para controlo e perceção. (Fonte: Ronald_vanLoon)