키워드:OpenAI, 추론 LLM, 국제 수학 올림피아드, AI 훈련 데이터셋, 개인 데이터 프라이버시, ChatGPT 에이전트, AI 모델 정치적 중립, Kimi K2, IMO 금메달 수준 성적, DataComp CommonPool 데이터셋, LLM 에이전트 인공지능, 백악관 AI 행정 명령, MoE 아키텍처

🔥 주목할 만한 소식

OpenAI의 실험적 추론 LLM, 국제 수학 올림피아드 금메달 획득: OpenAI의 최신 실험적 추론 LLM이 2025년 국제 수학 올림피아드(IMO)에서 금메달 수준의 성적을 거두며 6문제 중 5문제를 풀었습니다. 이 모델은 4.5시간의 제한 시간을 포함하여 인간과 동일한 규칙 하에 실행되었으며, 어떤 도구도 사용하지 않고 자연어로 증명 과정을 출력했습니다. 이는 AI 수학 추론 분야의 중대한 돌파구이며, 과학적 발견에서 AI의 잠재력을 보여줍니다. (출처: gdb, scaling01, dmdohan, SebastienBubeck, markchen90, npew, MillionInt, cloneofsimo, bookwormengr, tokenbender)

AI 훈련 데이터 세트 CommonPool, 수백만 개의 개인 데이터 포함: 연구 결과, 대규모 오픈 소스 AI 훈련 데이터 세트인 DataComp CommonPool에 수백만 장의 여권, 신용 카드, 출생 증명서 및 기타 개인 식별 정보가 포함된 문서 이미지가 포함된 것으로 나타났습니다. 연구원들은 CommonPool의 0.1% 데이터를 감사하여 식별 가능한 개인 정보가 포함된 이미지 수천 장을 발견했으며, 전체 데이터 세트에 이러한 이미지가 수억 장에 달할 것으로 추정했습니다. 이는 AI 훈련 데이터 개인 정보 보호에 대한 우려를 불러일으켰으며, 머신 러닝 커뮤니티에 무분별한 웹 스크래핑 행위를 재고할 것을 촉구했습니다. (출처: MIT Technology Review)

🎯 동향

OpenAI, 개인 비서 ChatGPT Agent 출시: OpenAI는 사용자를 대신하여 작업을 수행하기 위해 자체 “가상 컴퓨터”를 구축하는 개인 비서 ChatGPT Agent를 출시했습니다. 이는 LLM 에이전트 지능의 중요한 진전이지만, 이 기능은 아직 초기 단계이며 작업을 완료하는 데 시간이 걸릴 수 있습니다. (출처: MIT Technology Review, The Verge, Wired)

백악관, AI 모델 “정치적 중립성 및 편견 없음” 요구하는 행정 명령 준비 중: 백악관은 AI 모델이 “정치적으로 중립적이고 편견이 없어야 한다”고 요구하는 행정 명령을 준비하고 있습니다. 준수 여부는 연방 계약 자격 여부를 결정하며, 모든 AI 연구소에 중요한 사안입니다. 이 행정 명령은 다음 주에 발표될 예정입니다. (출처: WSJ, MIT Technology Review, natolambert)

Kimi K2: 도구 사용 능력을 갖춘 에이전트 지능 모델: Kimi_Moonshot에서 출시한 Kimi K2는 도구 사용 능력을 갖춘 에이전트 지능 모델입니다. 도구 사용, 수학, 코딩 및 다단계 작업에서 뛰어난 성능을 보이며 현재 Arena에서 오픈 소스 모델 중 1위, 종합 5위를 차지하고 있습니다. Kimi K2는 DeepSeek-V3와 유사한 대규모 전문가 혼합(MoE) 아키텍처를 채택하여 총 1조 개의 매개변수와 320억 개의 활성 매개변수를 보유하고 있습니다. (출처: TheTuringPost)

🧰 도구

GitHub MCP 서버, AI 도구와 GitHub 플랫폼 연결: GitHub MCP 서버를 통해 AI 도구가 GitHub 플랫폼에 직접 연결할 수 있습니다. 이를 통해 AI 에이전트, 비서 및 챗봇은 저장소 및 코드 파일 읽기, 이슈 및 PR 관리, 코드 분석 및 워크플로 자동화를 자연어 상호 작용을 통해 수행할 수 있습니다. (출처: GitHub Trending)

ik_llama.cpp: 더 나은 CPU 성능을 제공하는 llama.cpp 브랜치: ik_llama.cpp는 더 나은 CPU 및 혼합 GPU/CPU 성능, 새로운 SOTA 양자화 유형, 최고의 Bitnet 지원, MLA, FlashMLA, 융합 MoE 작업 및 텐서 오버레이를 통한 DeepSeek 성능 향상, 혼합 GPU/CPU 추론을 위한 행 인터리브 양자화 패킹 등을 제공하는 llama.cpp의 브랜치입니다. (출처: GitHub Trending)

📚 학습

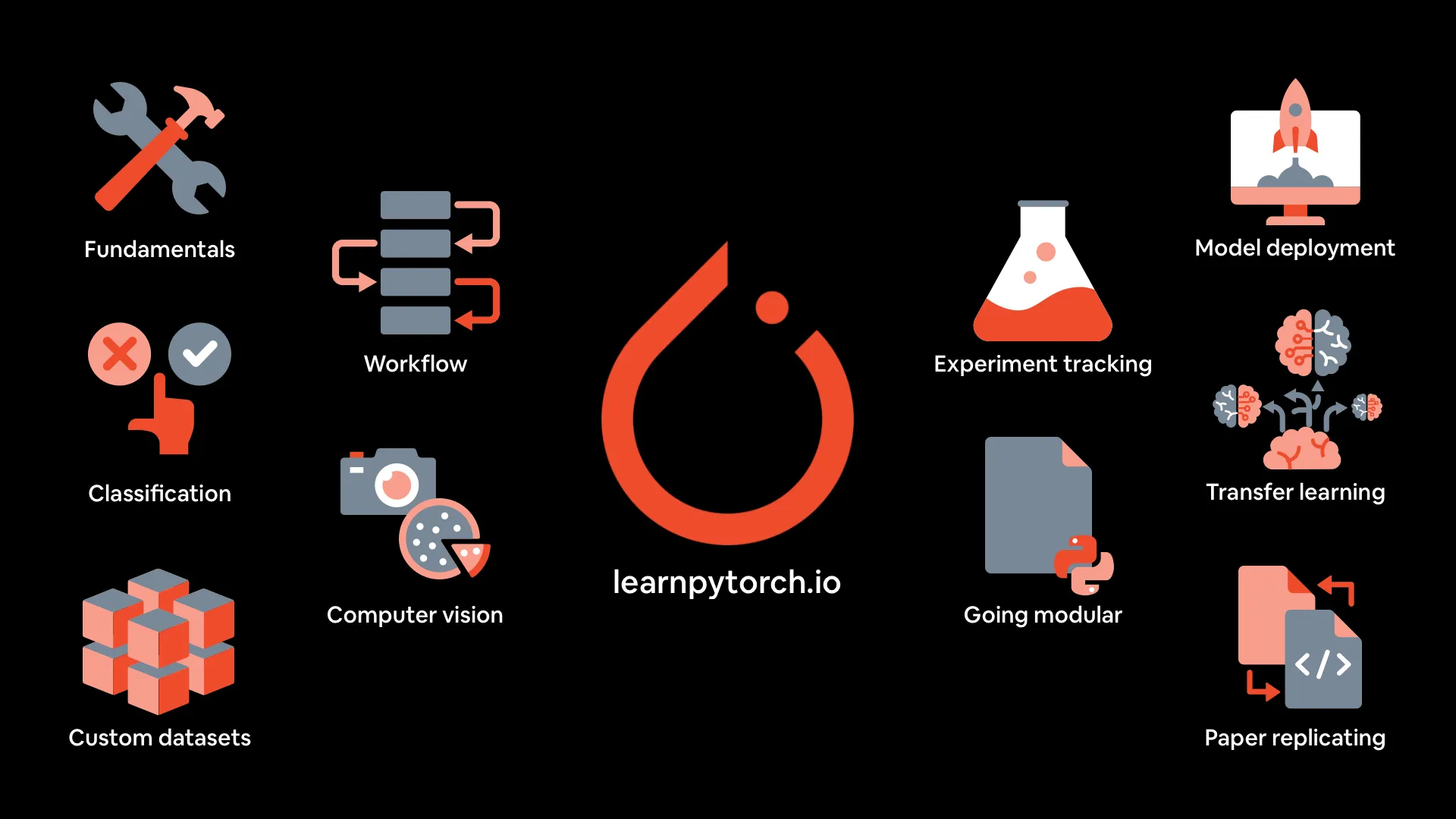

PyTorch 딥러닝 강좌 자료: mrdbourke/pytorch-deep-learning은 “PyTorch 딥러닝 처음부터 배우기” 강좌 자료를 제공합니다. 온라인 도서 버전, YouTube의 처음 다섯 부분 비디오, 연습 문제 및 추가 강좌가 포함됩니다. 이 강좌는 코드 실습 및 실험에 중점을 두고 PyTorch 기초, 워크플로, 신경망 분류, 컴퓨터 비전, 사용자 지정 데이터 세트, 전이 학습, 실험 추적 및 모델 배포 등을 다룹니다. (출처: GitHub Trending)

MIT 출판사, 알고리즘 및 머신 러닝 관련 3권의 도서 무료 제공: MIT 출판사는 알고리즘 이론 및 핵심 머신 러닝 알고리즘에 관한 3권의 도서, Optimization Algorithms, Decision Algorithms, Verification Algorithms를 무료로 제공합니다. 이 도서는 알고리즘 및 머신 러닝에 대한 심층적인 학습에 매우 적합합니다. (출처: TheTuringPost, TheTuringPost)

에너지 기반 Transformer는 확장 가능한 학습자이자 사고자: 이 논문은 에너지 기반 모델(EBM)의 새로운 유형인 에너지 기반 Transformer(EBT)에 대해 논의합니다. EBT는 입력과 후보 예측 간의 호환성을 명시적으로 검증하는 법을 학습하고 예측 문제를 이 검증기에 대한 최적화로 재정의하여 비지도 학습만으로 “사고”하는 법을 학습할 수 있습니다. (출처: )

🌟 커뮤니티

LLM 컨텍스트 엔지니어링에 대한 교훈: ManusAI 팀은 AI 에이전트를 위한 컨텍스트 엔지니어링 구축 경험에서 얻은 교훈을 공유하며, KV 캐시, 파일 시스템, 오류 추적 등이 에이전트 설계에서 중요하다고 지적했습니다. (출처: dotey, AymericRoucher, vllm_project)

Kimi K2와 Gemini의 실제 성능 비교: ClementDelangue와 jeremyphoward는 pash의 트윗을 리트윗하며 실제 작업에서 Kimi K2가 Gemini보다 성능이 뛰어나다고 지적하고 관련 차트 데이터를 제공했습니다. (출처: ClementDelangue, jeremyphoward)

OpenAI의 IMO 금메달 획득, 예상 밖의 결과: OpenAI의 LLM이 IMO에서 금메달을 획득한 것은 많은 사람들의 예상을 뛰어넘는 결과였으며, 커뮤니티에서 광범위한 논의를 불러일으켰습니다. (출처: kylebrussell, VictorTaelin)

💼 비즈니스

Anthropic, Claude Code 사용량 제한: Anthropic은 Claude Code의 사용량을 제한했지만 사용자에게 알리지 않아 사용자의 불만과 폐쇄형 제품에 대한 우려를 불러일으켰습니다. (출처: jeremyphoward, HamelHusain)

Meta, 유럽 인공지능 협약 서명 거부: Meta는 유럽 인공지능 협약이 지나치게 개입적이며 AI 발전을 저해할 것이라 주장하며 서명을 거부했습니다. (출처: Reddit r/artificial, Reddit r/ArtificialInteligence)

💡 기타

노트북에서 LLM을 실행하는 방법: MIT Technology Review는 노트북에서 LLM(대규모 언어 모델)을 실행하는 방법에 대한 가이드를 게시했습니다. 개인 정보 보호에 관심이 있거나 대형 LLM 회사의 통제에서 벗어나고 싶거나 새로운 것을 시도하고 싶은 사용자에게 로컬에서 LLM을 실행하는 단계와 제안 사항을 제공합니다. (출처: MIT Technology Review, MIT Technology Review)

“세 부모 아기” 간략한 역사: MIT Technology Review는 “세 부모 아기”의 역사를 되짚어보며 이 기술의 다양한 방법, 논란 및 최신 연구 진행 상황을 소개했습니다. 여기에는 영국 실험에서 태어난 8명의 아기도 포함됩니다. (출처: MIT Technology Review, MIT Technology Review)

AI 에이전트에서 첫날부터 가치를 찾는 방법: 이 기사는 기업이 AI 에이전트에서 가치를 찾는 방법을 논의하며, 기업이 반복적인 태도를 취하고 “쉽게 얻을 수 있는 성과” 및 증분 사용 사례부터 시작하고 상호 운용성을 우선시하여 미래의 다중 에이전트 시스템을 준비할 것을 제안합니다. (출처: MIT Technology Review)