키워드:Qwen3 시리즈 모델, Claude Code, AI 모델 벤치마크, Runway Gen-4, LangGraph, Qwen3-235B-A22B 성능, Claude Code 프로그래밍 어시스턴트, SimpleBench 벤치마크, Runway Gen-4 References 기능, LangGraph Agent 적용

🔥 포커스

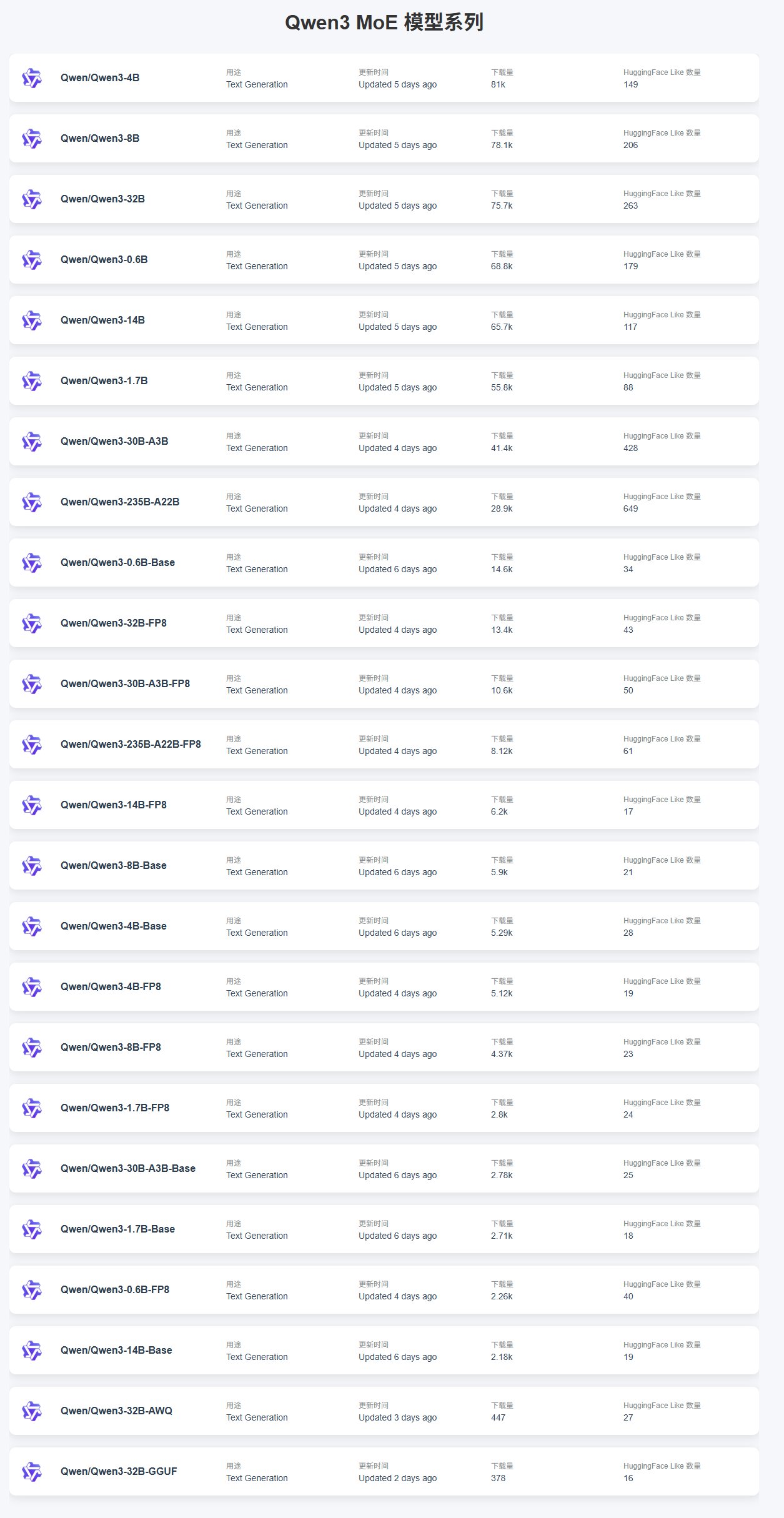

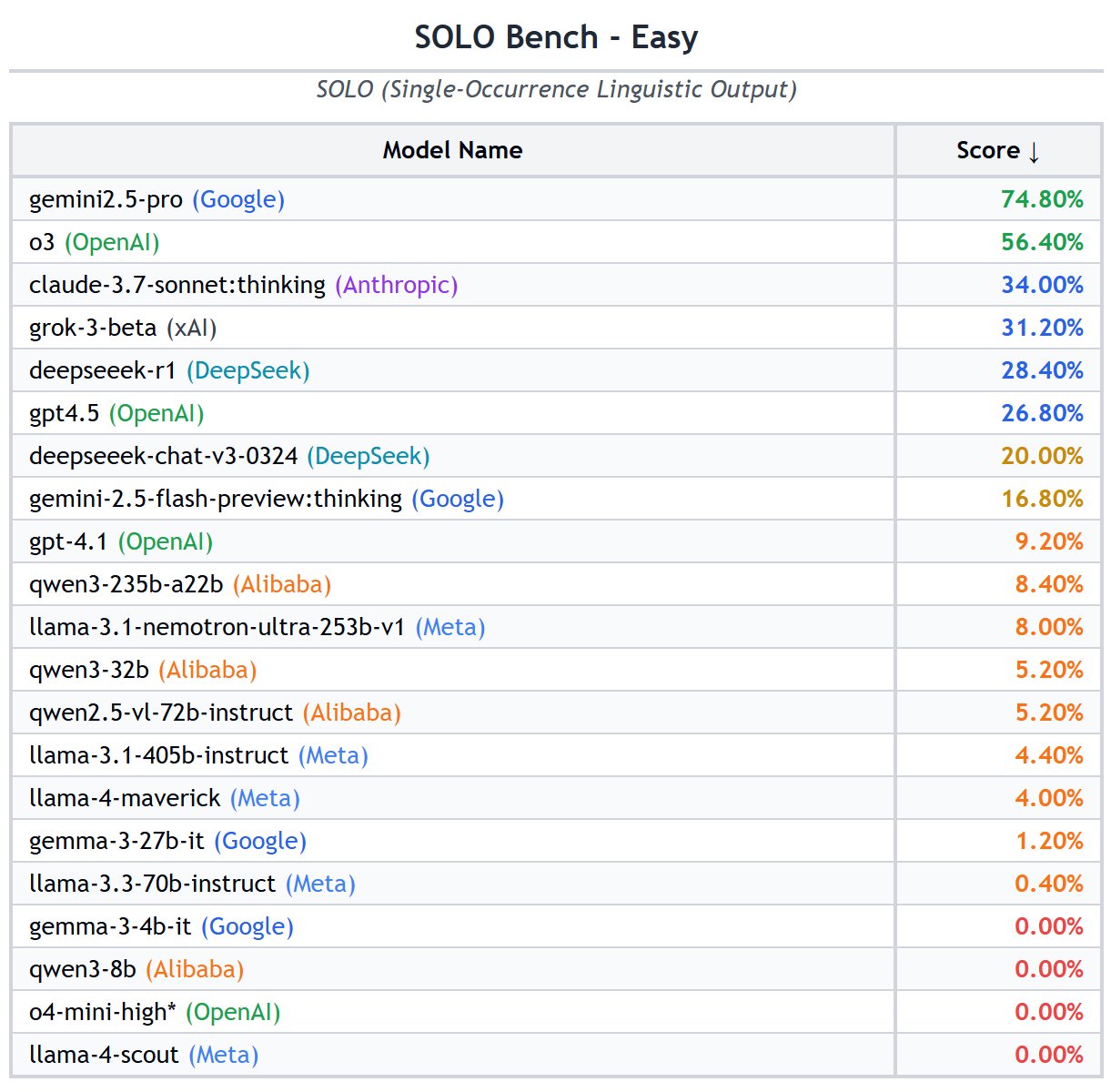

Qwen3 시리즈 모델 출시 및 성능: Alibaba가 0.6B부터 235B까지 다양한 크기의 Qwen3 시리즈 모델을 출시했습니다. 커뮤니티 피드백에 따르면, 작은 모델(예: 4B)은 미세 조정이 용이하여 다운로드 수가 많으며, MoE 모델 중에서는 30B-A3B가 인기가 높습니다. 성능 면에서 Qwen3-235B-A22B는 SimpleBench에서 우수한 성능을 보여 13위를 차지했으며, o1/o3-mini 및 DeepSeek-R1과 같은 모델보다 뛰어납니다. Qwen3-8B는 로컬 실행 성능이 좋고, 크기가 작으며(4.3GB 양자화 버전), 메모리 사용량(4-5GB)이 낮아 리소스가 제한된 환경에 적합합니다. 그러나 일부 사용자는 Qwen3가 자율 AI Agent를 구동하는 데 있어 구조화된 생성의 불안정성, 교차 언어 처리의 어려움, 환경 이해 부족 및 검열 문제와 같은 단점이 있다고 지적합니다. (출처: karminski3, scaling01, BorisMPower, Reddit r/LocalLLaMA, Reddit r/MachineLearning)

Claude Code 성능 및 사용 피드백: 프로그래밍 어시스턴트로서 Claude Code가 주목받고 있으며, 사용자들은 비공개 라이브러리 처리 시 발생하는 환각 문제에 대해 논의하고 있습니다. 이는 사용자 정의 구현에 대한 이해 부족으로 잘못된 코드를 생성하기 때문입니다. 해결책으로는 더 많은 컨텍스트 제공, 모델 미세 조정 또는 MCP(Machine Collaboration Protocol) 서버를 사용하여 비공개 라이브러리에 액세스하는 방법 등이 있습니다. 동시에 Claude Pro 사용자들은 사용량이 적음에도 불구하고 제한이 발생하여 코딩 효율성에 영향을 미치는 할당량 제한 문제를 보고했습니다. 성능 보고서에 따르면 최근 캐시 인식 속도 제한 조정이 예상치 못한 스로틀링의 원인일 수 있으며, 특히 Pro 사용자에게 영향을 미칩니다. 문제점에도 불구하고 일부 사용자는 “vibe-coding” 측면에서 Claude가 ChatGPT보다 우수하다고 평가합니다. (출처: code_star, jam3scampbell, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

AI 모델 벤치마크(Benchmark) 논의 및 목록: 커뮤니티에서는 다양한 LLM 벤치마크의 유효성에 대한 열띤 논의가 벌어지고 있습니다. 일부 사용자는 GPQA와 SimpleQA를 핵심 벤치마크로 간주하는 반면, MMLU, HumanEval 등 전통적인 벤치마크의 중요성은 약화되고 있다고 봅니다. SimpleBench, SOLO-Bench, AidanBench 등 개념이 간단한 벤치마크와 게임 및 실제 세계 과제 기반 벤치마크가 선호되고 있습니다. 동시에 일반 능력, 코드, 수학, Agent, 긴 컨텍스트, 환각 등 여러 차원을 포괄하는 상세한 LLM 벤치마크 목록이 공유되어 모델 평가에 참고 자료를 제공합니다. 사용자들은 Grok 3.5의 벤치마크 데이터에 관심을 보이지만, 비공식적이거나 조작된 데이터에 대한 경계심도 나타내고 있습니다. (출처: teortaxesTex, scaling01, scaling01, teortaxesTex, scaling01, natolambert, scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Runway Gen-4 References 기능 시연: RunwayML의 Gen-4 모델에 포함된 References 기능은 강력한 이미지 및 비디오 생성 능력을 보여줍니다. 사용자들은 이 기능을 활용하여 공간 사진과 참조 이미지만 제공하면 새로운 실내 디자인을 생성하는 공간 개조 사례를 선보였습니다. 또한 이 기능은 《Myst》와 유사한 인터랙티브 비디오 게임 제작에도 사용될 수 있으며, 시작 프레임과 종료 프레임을 지정하여 전환 애니메이션을 생성합니다. 심지어 역사적 장면으로 “시간 여행”하여 특정 장소(예: 《시녀들》 그림 속 장면)의 다양한 각도 뷰를 생성할 수도 있어, 창의적인 콘텐츠 생성 분야에서의 엄청난 잠재력을 보여줍니다. (출처: connerruhl, c_valenzuelab, c_valenzuelab, TomLikesRobots, c_valenzuelab)

🎯 동향

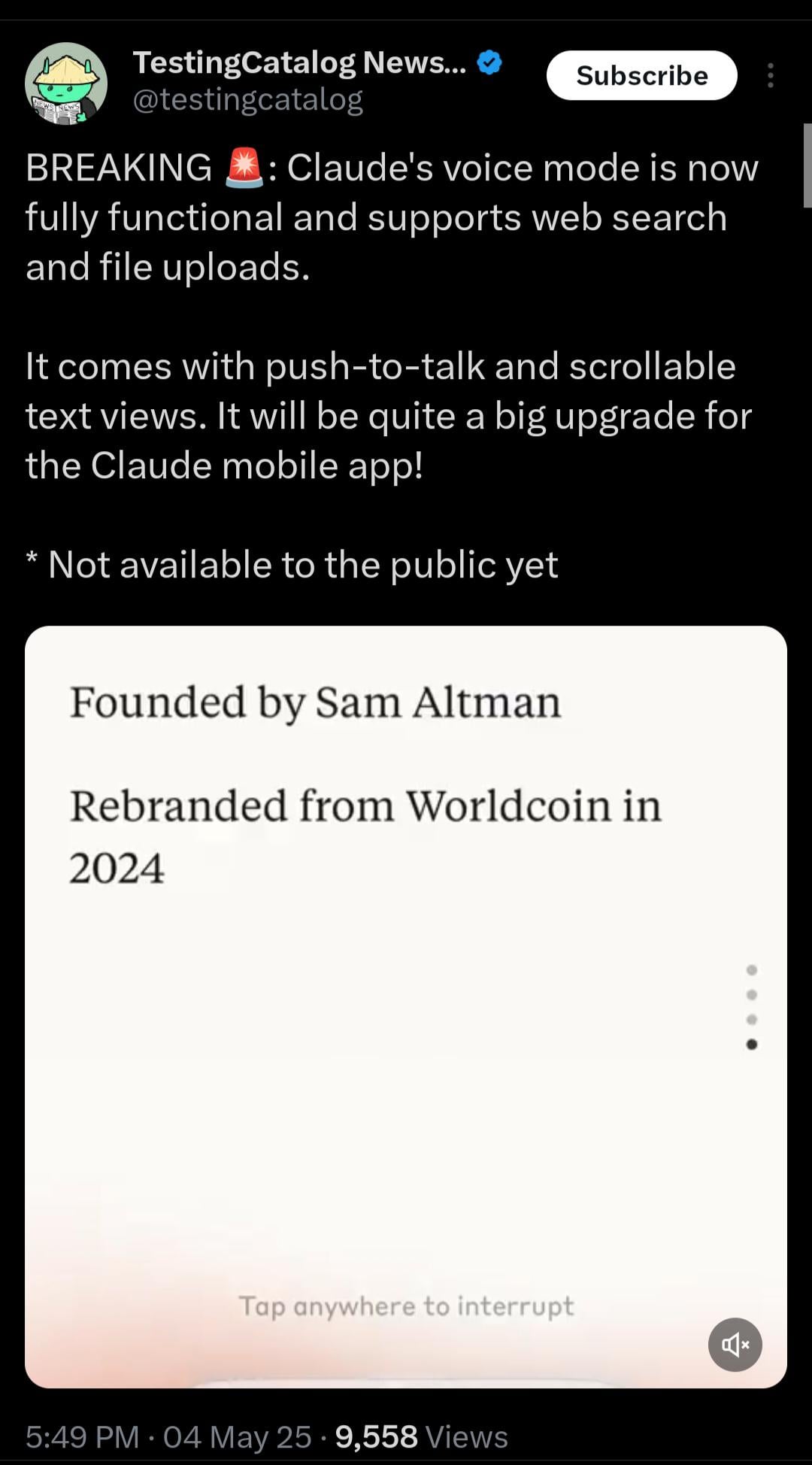

Claude, 실시간 음성 모드 출시 예정: Anthropic의 Claude가 실시간 음성 상호작용 기능을 테스트 중입니다. 유출된 정보에 따르면, 이 모드는 기능이 완성되었으며 웹 검색과 파일 업로드를 지원하고 “푸시 투 토크(push-to-talk)” 및 스크롤 가능한 텍스트 뷰를 제공할 예정입니다. 아직 공개되지는 않았지만, 시스템 프롬프트에 관련 플레이스홀더(<antml:voiceNote>)가 나타나 Claude 모바일 앱의 주요 업그레이드가 임박했음을 시사합니다. 이는 사용자 상호작용 경험을 향상시키고 ChatGPT 등 경쟁사의 음성 기능을 따라잡기 위한 것입니다. (출처: op7418, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

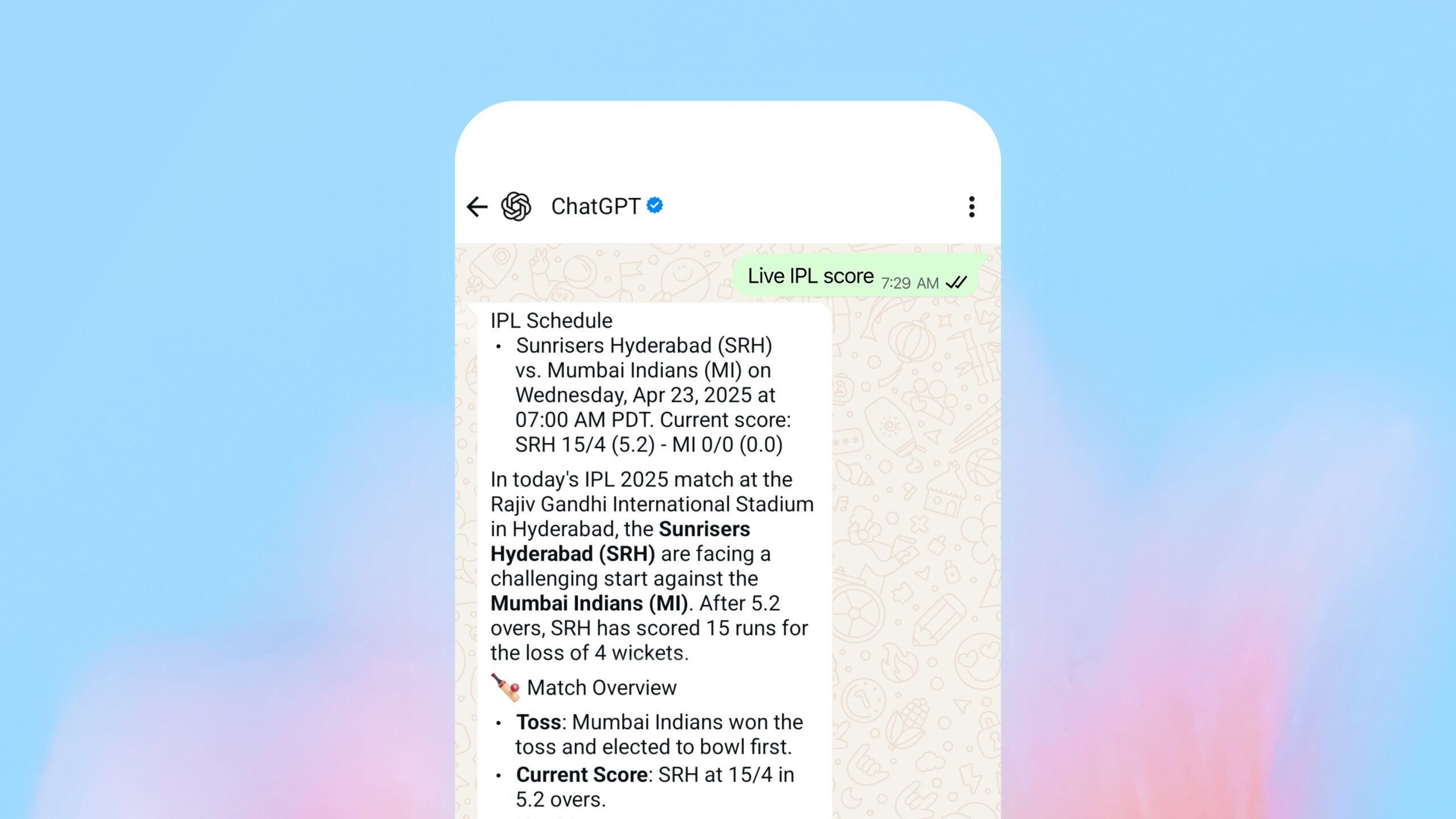

OpenAI, WhatsApp 내 검색 기능 출시: OpenAI는 사용자가 이제 WhatsApp을 통해 1-800-ChatGPT (+1-800-242-8478)로 메시지를 보내 실시간 답변과 스포츠 점수를 얻을 수 있다고 발표했습니다. 이는 OpenAI가 서비스 범위를 확장하는 중요한 단계로 간주되지만, 주요 경쟁사(Facebook 산하 WhatsApp) 플랫폼에서 핵심 서비스를 제공하는 전략적 고려 사항에 대한 논의를 불러일으켰습니다. 이 기능은 ChatGPT가 사용 가능한 모든 지역에서 액세스할 수 있습니다. (출처: digi_literacy)

Grok, 음성 기능 곧 출시 예정: xAI 산하의 Grok이 음성 상호작용 기능을 출시할 것이라고 발표했습니다. 이는 다중 모드 기능을 더욱 강화하여 ChatGPT, Gemini, Claude와 같은 다른 주요 AI 어시스턴트와 음성 상호작용 측면에서 경쟁하기 위한 것입니다. 구체적인 구현 세부 사항과 출시 시기는 아직 공개되지 않았습니다. (출처: ibab)

TesserAct: 4D 체화된 세계 모델 학습 시스템 발표: DailyPapers는 4D 체화된 세계 모델을 학습할 수 있는 시스템인 TesserAct를 발표했습니다. 이 시스템은 입력된 이미지와 텍스트 지침에 따라 RGB, 깊이, 법선 정보를 포함하는 비디오를 생성하고 4D 장면을 재구성할 수 있습니다. 이 기술은 동적 물리 세계를 이해하고 시뮬레이션하는 데 잠재력을 가지며 로봇 공학, 자율 주행, 가상 현실 등 분야에 응용될 수 있습니다. (출처: _akhaliq)

시각 언어 모델(VLM) 공간 추론 능력 연구: ICML 2025의 한 논문은 VLM이 공간 추론에서 성능이 저조한 이유를 탐구합니다. 연구 결과, 기존 VLM의 주의 메커니즘이 공간 관계를 처리할 때 관련 시각 객체에 정확하게 초점을 맞추지 못하는 것으로 나타났습니다. 논문은 이 문제를 완화하기 위한 훈련 없는 방법을 제안하여 VLM의 공간 이해 능력을 향상시키는 새로운 관점을 제공합니다. (출처: Francis_YAO_)

LaRI: 단일 뷰 3D 기하학 추론을 위한 계층적 광선 교차: LaRI(Layered Ray Intersections)라는 새로운 기술이 단일 뷰를 통해 3D 기하학 추론을 수행하기 위해 제안되었습니다. 이 방법은 광선 추적과 계층적 표현을 활용하여 장면의 3차원 구조와 객체 간의 공간 관계를 이해하고 추론할 수 있으며, 3D 재구성, 장면 이해 등 분야에 응용될 것으로 기대됩니다. (출처: _akhaliq)

IBM, Granite 4.0 Tiny Preview 출시: IBM이 차세대 Granite 모델인 Granite 4.0 Tiny Preview를 사전 출시했습니다. 이 시리즈 모델은 새로운 하이브리드 Mamba-2/Transformer 아키텍처를 채택하여 Mamba의 속도 효율성과 Transformer의 자기 주의 정밀도를 결합했습니다. Tiny Preview는 세분화된 혼합 전문가(MoE) 모델로, 총 파라미터 수는 7B이며 추론 시 활성화되는 파라미터는 1B에 불과하여 효율적인 성능을 제공하는 것을 목표로 합니다. 이는 IBM이 성능과 효율성을 향상시키기 위해 새로운 모델 아키텍처를 탐색하는 노력을 보여줍니다. (출처: Reddit r/LocalLLaMA)

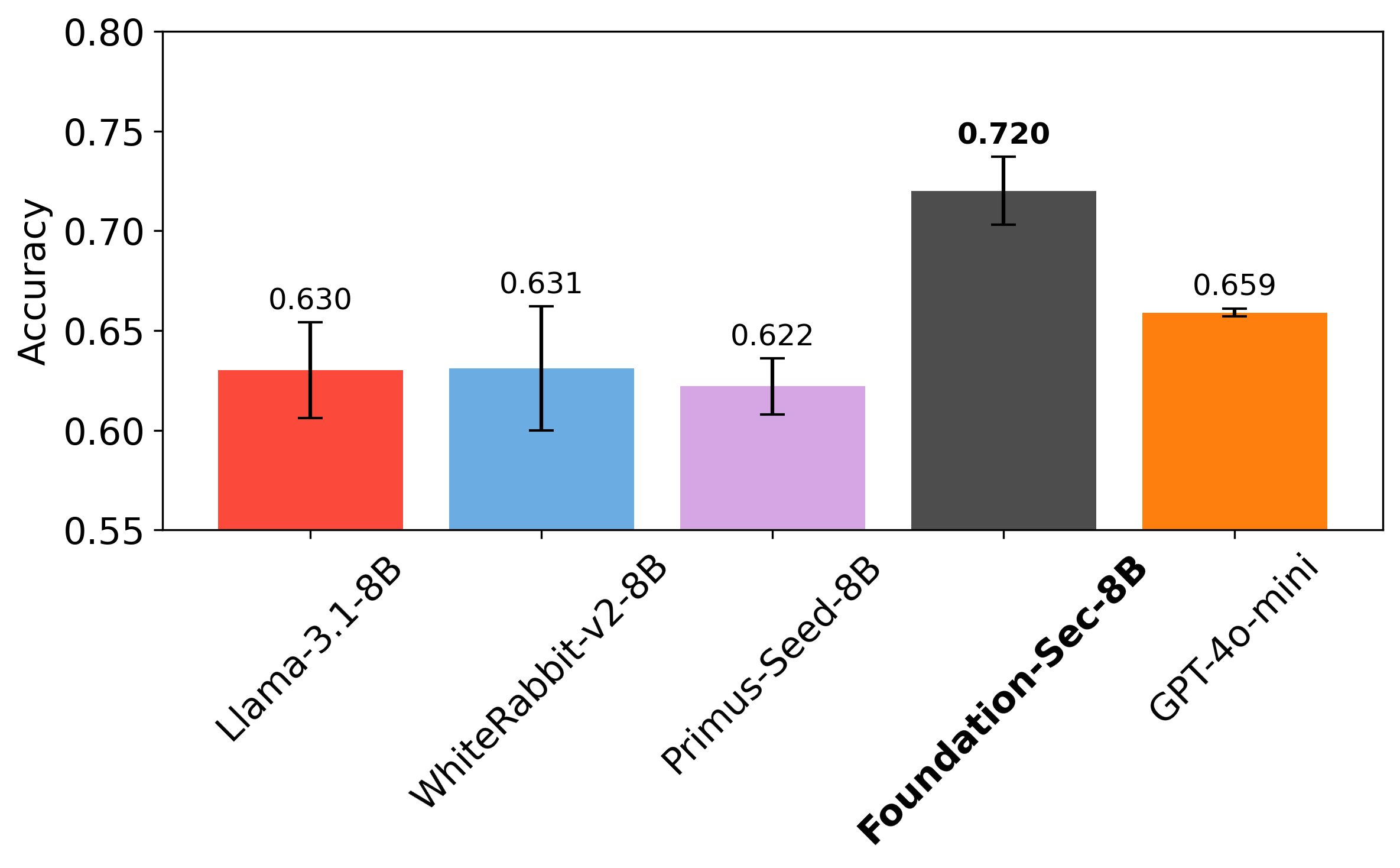

Cisco, 네트워크 보안 전용 LLM Foundation-Sec-8B 출시: Cisco의 Foundation AI 팀이 Hugging Face에 Foundation-Sec-8B 모델을 출시했습니다. 이는 Llama 3.1을 기반으로 구축되었으며 네트워크 보안 분야에 특화된 LLM입니다. 이 8B 모델은 특정 보안 작업에서 Llama 3.1-70B 및 GPT-4o-mini와 필적하는 성능을 보인다고 알려져 있으며, 특정 작업에서 도메인 특화 모델이 범용 대형 모델을 능가할 수 있는 잠재력을 보여줍니다. 이는 대형 기술 기업들이 특정 문제를 해결하기 위해 LLM을 수직 분야에 적극적으로 적용하고 있음을 나타냅니다. (출처: _akhaliq, Suhail)

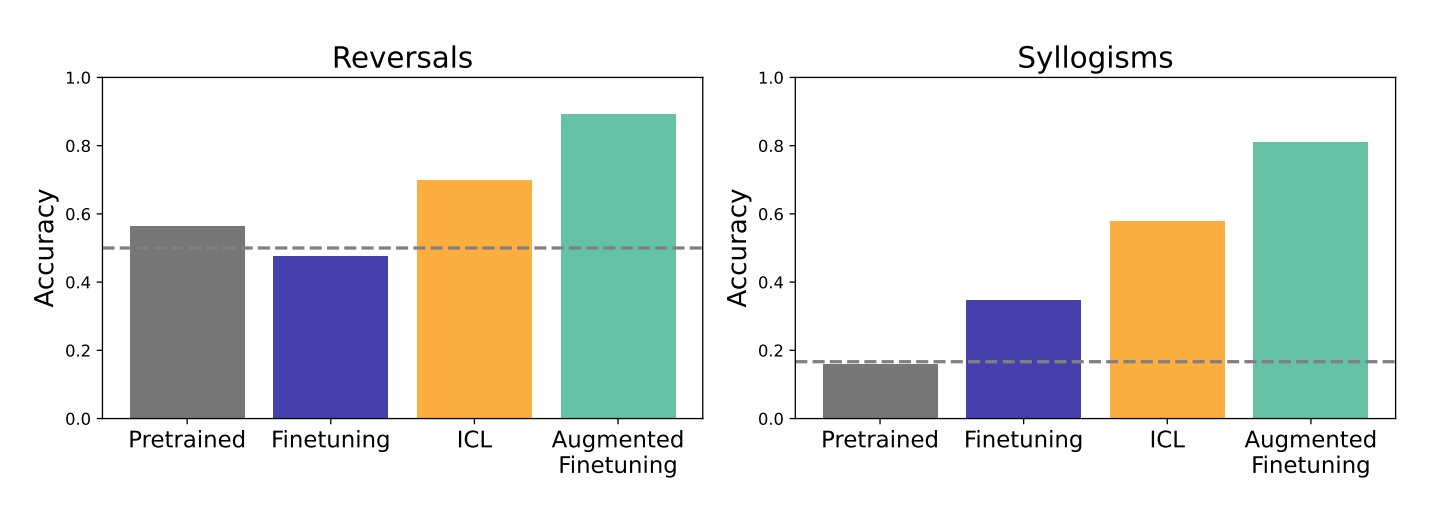

컨텍스트 학습(ICL)과 미세 조정이 LLM 일반화 능력에 미치는 영향 연구: Google DeepMind와 Stanford 대학의 연구는 컨텍스트 학습(ICL)과 미세 조정(fine-tuning)이라는 두 가지 주요 방법이 LLM의 일반화 능력에 미치는 영향을 비교했습니다. 연구 결과, ICL은 모델이 학습할 때 더 유연하게 만들어 일반화 능력을 강화하는 것으로 나타났습니다. 그러나 정보가 더 방대한 지식 구조에 통합되어야 할 때는 미세 조정이 더 효과적이었습니다. 연구자들은 두 가지 장점을 결합한 새로운 방법인 증강 미세 조정(augmented fine-tuning)을 제안했습니다. 즉, 미세 조정 데이터에 ICL과 유사한 추론 과정을 추가하여 최상의 효과를 얻고자 합니다. (출처: TheTuringPost)

Meta, 상세한 시각적 이해를 위한 오픈 데이터 및 모델 PerceptionLM 출시: Meta는 이미지 및 비디오 이해를 위한 투명한 연구를 위해 완전히 개방적이고 재현 가능한 프레임워크를 제공하는 것을 목표로 하는 PerceptionLM 프로젝트를 출시했습니다. 이 프로젝트는 독점 모델 증류에 의존하지 않는 표준 훈련 프로세스를 분석하고, 특히 상세한 비디오 이해 측면에서 데이터 격차를 식별하기 위해 대규모 합성 데이터를 탐색했습니다. 이러한 격차를 메우기 위해 프로젝트는 280만 개의 수동 주석 처리된 세분화된 비디오 질의응답 쌍과 시공간적 위치 정보가 포함된 비디오 캡션을 발표했습니다. 또한 비디오 이해의 복잡한 추론 작업을 평가하는 데 중점을 둔 PLM–VideoBench 평가 스위트를 도입했습니다. (출처: Reddit r/MachineLearning)

🧰 도구

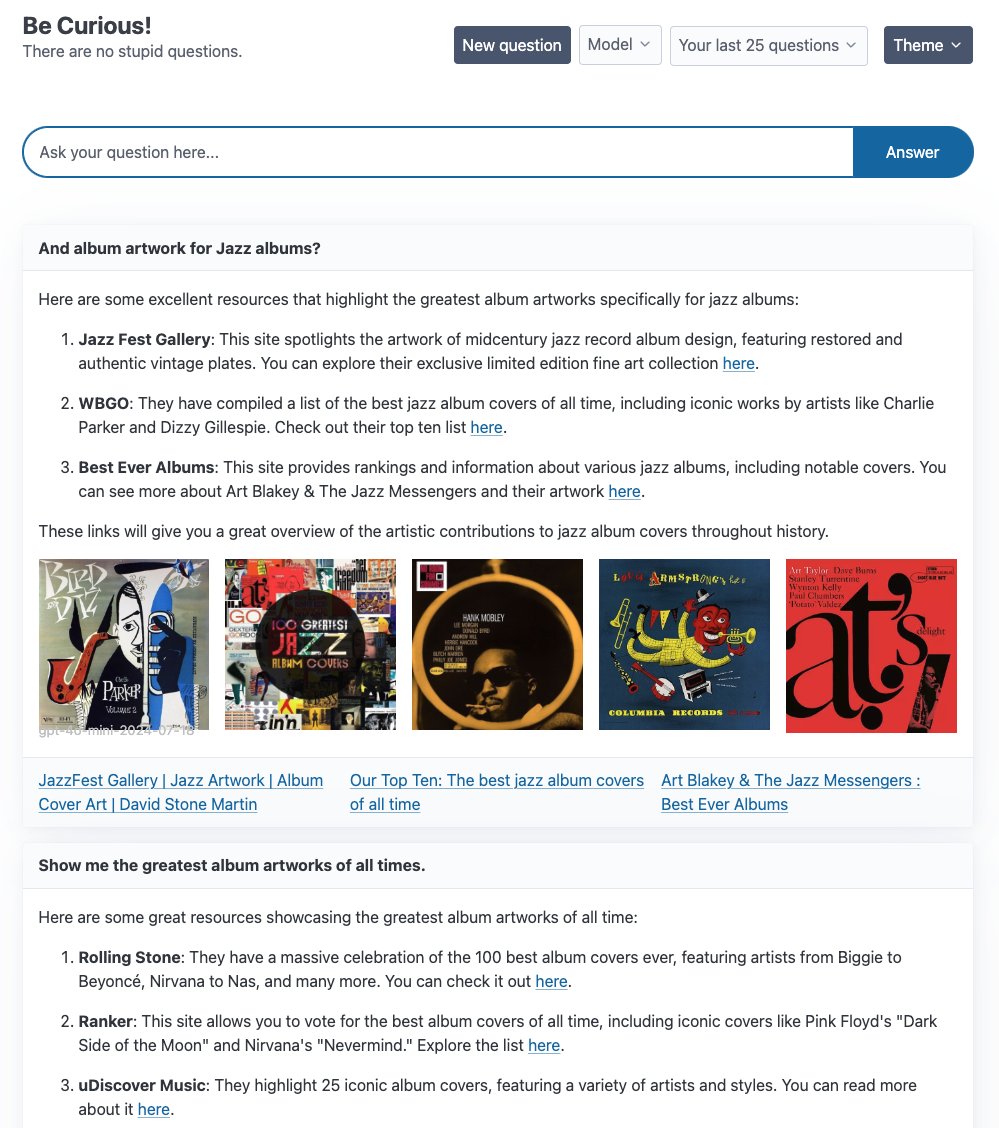

LangGraph, 여러 Agent 예제 애플리케이션 출시: LangChain은 LangGraph를 기반으로 구축된 여러 Agent 애플리케이션 예제를 선보였습니다: 1. Curiosity: Perplexity와 유사한 오픈 소스 ReAct 채팅 인터페이스로, 실시간 스트리밍, Tavily 검색 및 LangSmith 모니터링을 지원하며 GPT-4-mini, Llama3 등 다양한 LLM에 연결할 수 있습니다. 2. Meeting Prep Agent: 회의 참석자 및 회사 정보를 자동으로 조사하는 지능형 캘린더 도우미로, React/FastAPI 인터페이스를 통해 회의 통찰력을 제공하며 LangGraph를 활용하여 복잡한 Agent 워크플로 및 실시간 추론을 구현합니다. 3. Generative UI: 인간-컴퓨터 상호작용의 미래로서 생성형 UI를 탐색하며, LangGraph.js의 생성형 UI 예제 라이브러리를 출시하여 동적 인터페이스 구축에서 Agent 그래프의 잠재력을 보여줍니다. (출처: LangChainAI, hwchase17, LangChainAI, Hacubu)

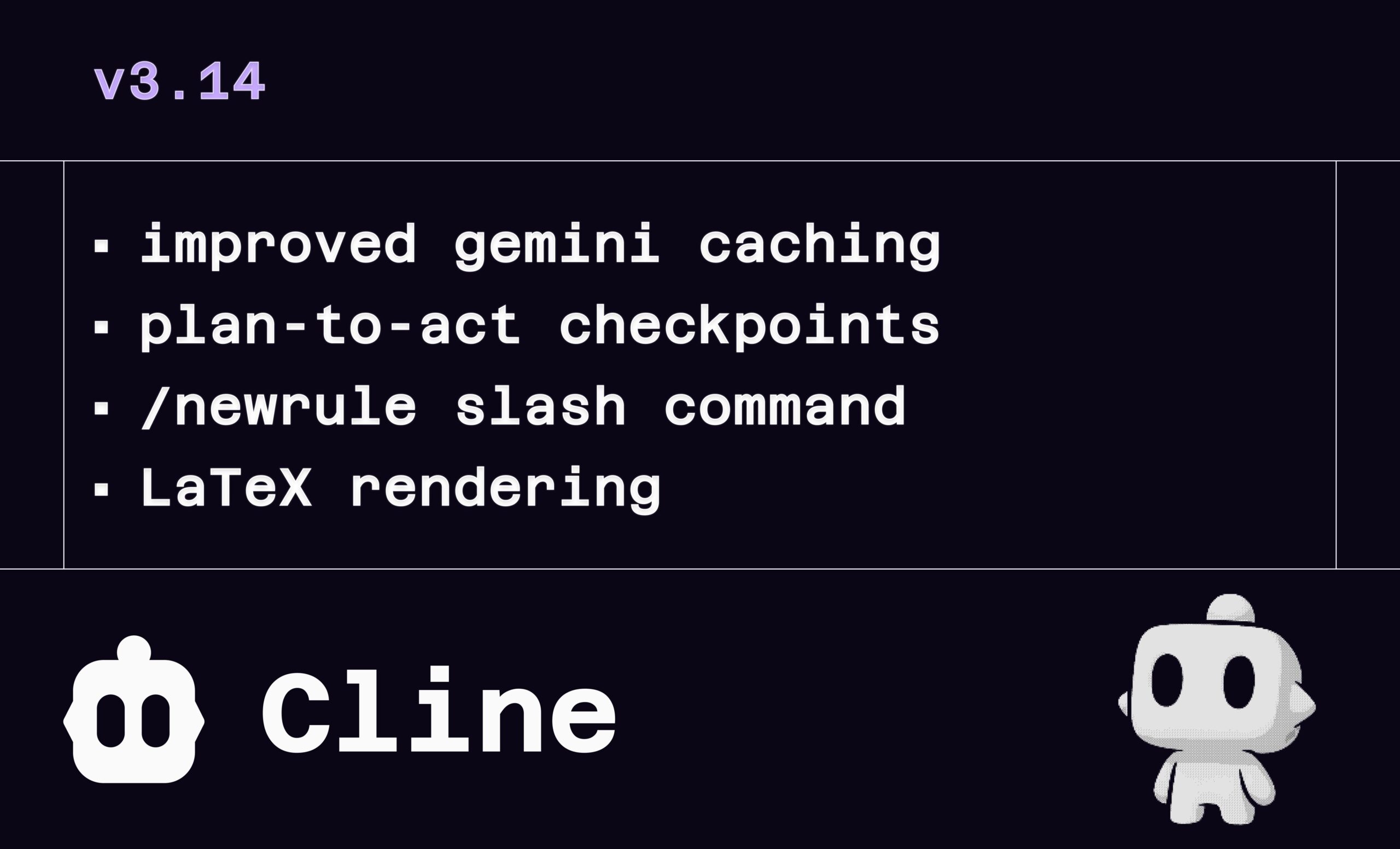

Cline v3.14 업데이트: LaTeX, 파일 드래그 앤 드롭 및 규칙 정의 지원: AI 프로그래밍 어시스턴트 Cline이 v3.14 버전을 출시하며 여러 기능 업데이트를 제공합니다: 1. LaTeX 렌더링: LaTeX를 완벽하게 지원하여 채팅 인터페이스에서 복잡한 수학 공식과 과학 문서를 직접 처리할 수 있습니다. 2. 드래그 앤 드롭 업로드: 운영 체제 파일 관리자에서 직접 파일을 드래그 앤 드롭(Shift 키 누른 상태)하여 컨텍스트를 추가할 수 있습니다. 3. 규칙 정의: 새로운 /newrule 명령을 추가하여 Cline이 프로젝트를 분석하고 디자인 시스템, 코딩 규약 등 규칙 문서를 생성하여 프로젝트 표준을 강제 적용할 수 있습니다. 4. 프로세스 체크포인트: 작업 워크플로에 더 많은 체크포인트를 추가하여 사용자가 “실행”(Act) 전에 계획을 검토하고 수정할 수 있습니다. (출처: cline, cline, cline, cline)

LlamaParse, 11x.ai의 지능형 AI SDR 구축 지원: LlamaIndex는 LlamaParse 기술이 11x.ai의 AI 판매 개발 담당자(SDR) 시스템 개선에 어떻게 도움이 되었는지 보여주었습니다. LlamaParse를 통합함으로써 11x.ai는 사용자가 업로드한 다양한 문서 유형을 처리하여 AI SDR에 필요한 컨텍스트 정보를 제공할 수 있게 되었고, 이를 통해 개인화된 자동 아웃리치 활동을 구현하고 새로운 SDR의 온보딩 시간을 며칠로 단축했습니다. 이는 고급 문서 파싱 기술이 비즈니스 프로세스 자동화 및 AI 애플리케이션 능력 향상에 얼마나 중요한지를 강조합니다. (출처: jerryjliu0)

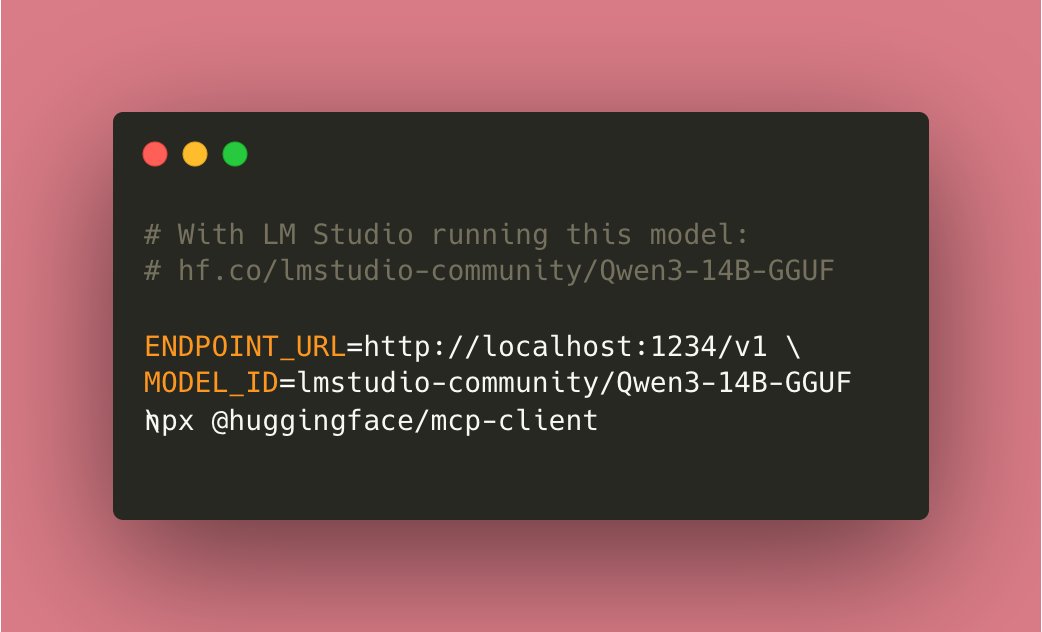

Tiny Agents 로컬 실행 구현: 커뮤니티 기여 덕분에 Hugging Face mcp-client(huggingface.js) 기반의 Tiny Agents를 이제 완전히 로컬에서 실행할 수 있습니다. 사용자는 로컬에서 호환 도구 모델(예: Qwen3 14B)을 실행하고 ENDPOINT_URL을 로컬 API 엔드포인트로 설정하기만 하면 로컬화된 AI Agent 기능을 구현할 수 있으며, 이는 로컬 AI의 중요한 진전으로 간주됩니다. (출처: cognitivecompai)

로컬 커맨드라인 AI 디버그 도구 cloi: cloi는 커맨드라인 기반의 AI 코드 디버깅 도구로, 완전히 로컬에서 실행되는 것이 특징입니다. Microsoft의 Phi-4 모델이 내장되어 있으며, Ollama를 통해 다른 로컬 대형 언어 모델로 전환하여 실행할 수도 있습니다. 이는 개발자에게 로컬 환경에서 AI를 활용하여 코드를 디버깅하고 분석할 수 있는 편리한 옵션을 제공합니다. (출처: karminski3)

AI 의사결정 회로: LLM 시스템 신뢰성 향상: 한 기사에서는 전자 회로 설계 개념을 LLM 시스템에 적용하여 “AI 의사결정 회로”를 구축함으로써 신뢰성을 높이는 방법을 탐구합니다. 이 방법을 통해 시스템 정확도를 92.5%까지 달성할 수 있습니다. 이 구현은 LangSmith를 사용하여 실시간 추적 및 평가를 통해 시스템 출력의 정확성을 검증합니다. 이 방법은 더 신뢰할 수 있고 예측 가능한 LLM 애플리케이션을 구축하기 위한 새로운 아이디어를 제공합니다. (출처: LangChainAI)

Local Deep Research (LDR) 개선 의견 요청: 오픈 소스 연구 도구인 Local Deep Research가 v0.3.1을 출시하고 커뮤니티에 개선 의견을 요청합니다. 여기에는 주목해야 할 분야, 필요한 기능, 연구 유형 선호도 및 UI 개선 제안이 포함됩니다. 이 도구는 심층 연구 작업을 로컬에서 실행하는 것을 목표로 하며 속도 향상을 위해 SearXNG 사용을 권장합니다. (출처: Reddit r/LocalLLaMA)

OpenWebUI Adaptive Memory v3.1 출시: OpenWebUI의 적응형 메모리 기능이 v3.1로 업데이트되었습니다. 개선 사항에는 메모리 신뢰도 점수 및 필터링, 로컬/API Embedding 제공자 지원, 로컬 모델 자동 검색, Embedding 차원 검증, Prometheus 지표 감지, 상태 및 지표 엔드포인트, UI 상태 발신기 및 디버그 수정이 포함됩니다. 로드맵에는 리팩토링, 동적 메모리 토큰, 개인화된 응답 사용자 정의, 교차 세션 지속성 검증, 개선된 구성 처리, 검색 튜닝, 상태 피드백, 문서 확장, 선택적 외부 RememberAPI/mem0 동기화 및 PII 비식별화 등이 포함됩니다. (출처: Reddit r/OpenWebUI)

📚 학습

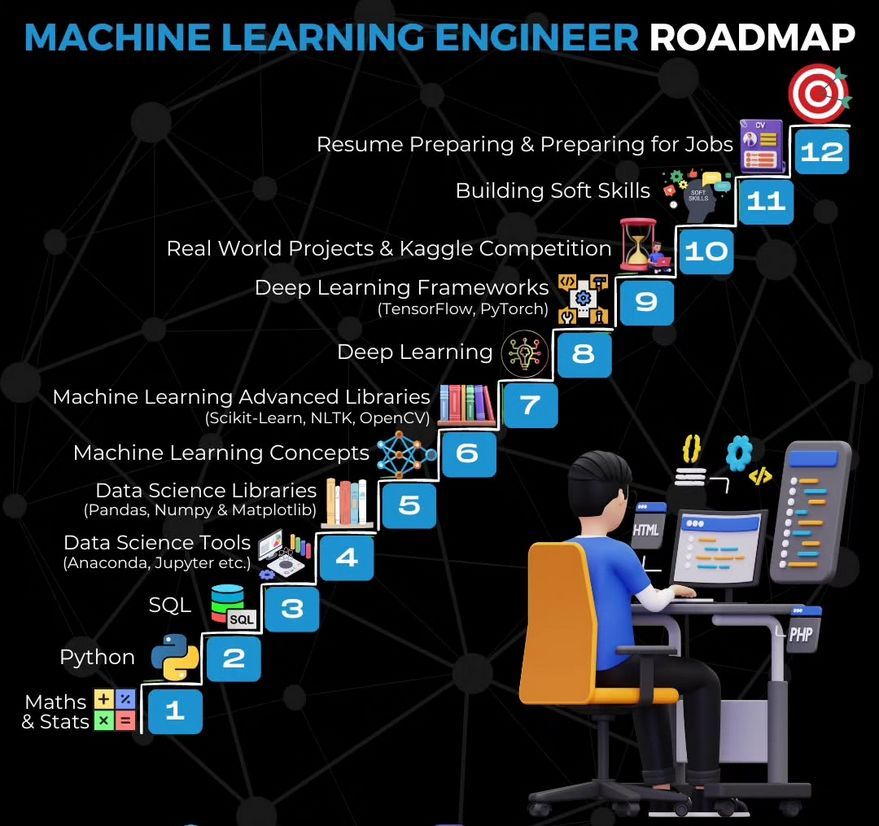

머신러닝 엔지니어 학습 로드맵: Ronald van Loon이 머신러닝 엔지니어를 위한 학습 로드맵을 공유하여 이 분야에 진입하려는 사람들에게 학습 경로와 핵심 기술 개요를 제공합니다. (출처: Ronald_vanLoon)

Gemma를 사용한 비디오 요약기 구축 튜토리얼: LangChainAI는 로컬에서 실행되는 Gemma LLM(Ollama 사용)을 사용하여 비디오 요약 애플리케이션을 구축하는 방법을 시연하는 비디오 튜토리얼을 게시했습니다. 이 Streamlit 애플리케이션은 LangChain을 활용하여 비디오를 처리하고 간결한 요약을 자동으로 생성하여 로컬 LLM 애플리케이션 학습 및 실습을 위한 예제를 제공합니다. (출처: LangChainAI)

주식 데이터 처리를 위한 MCP 서버 구축 튜토리얼: LangChainAI는 FastMcp와 LangChain을 사용하여 주식 시장 데이터를 처리하는 MCP(Machine Collaboration Protocol) 서버를 구축하는 방법을 안내하는 튜토리얼을 제공합니다. 이 가이드는 LangGraph를 사용하여 표준화된 데이터 액세스를 위한 ReAct Agent를 만드는 방법을 시연하여 MCP 및 Agent 기술 이해 및 적용에 도움이 됩니다. (출처: LangChainAI)

LLM 합리성 벤치마크 개념 증명: Deep Learning Weekly는 ART-Y 평가를 조정하여 LLM 합리성을 위한 개념 증명 벤치마크를 만드는 방법을 소개하는 블로그 게시물을 언급했습니다. 이 게시물은 AI가 단순히 더 똑똑한 것이 아니라 인간보다 더 합리적인지를 평가하는 것이 중요하다고 강조합니다. (출처: dl_weekly)

비판적 사고 연습으로서의 AI 레드팀 테스트: Deep Learning Weekly는 AI 레드팀 테스트(Red Teaming)를 LLM에 대한 기술적 취약점 테스트뿐만 아니라 군사 및 사이버 보안 관행에서 비롯된 비판적 사고 연습으로 정의하는 기사를 추천했습니다. 이는 AI 안전 평가를 이해하고 구현하는 데 더 넓은 관점을 제공합니다. (출처: dl_weekly)

Python 학습 서적 추천: 커뮤니티 회원이 Python 학습 서적인 《Python Crash Course》를 추천하며, 효과적인 Python 사용을 위한 좋은 출발점을 제공한다고 평가하고 PDF 버전을 공유했습니다. AI 개발의 기초 언어로서 Python의 중요성을 강조했습니다. (출처: omarsar0)

Deeply Supervised Nets, AISTATS 2025 시간 검증상 수상: Saining Xie의 박사 초기 논문 “Deeply Supervised Nets”가 AISTATS 2025의 시간 검증상을 수상했습니다. 그는 이 논문이 NeurIPS에서 거절당했던 경험을 공유하며, 학생들이 논문 거절에 직면했을 때 인내심을 갖고 연구를 계속하도록 격려했습니다. (출처: sainingxie)

LLM 증류 방법 개요 논의: Reddit 사용자가 LLM 증류 방법에 대한 최신 개요, 특히 대형 모델에서 소형 모델로, 그리고 대형 모델에서 더 전문화된 모델로의 증류에 대해 문의했습니다. 논의에서는 세 가지 주요 유형이 언급되었습니다: 1. 데이터 생성 + SFT (단순 증류); 2. Logit 기반 증류 (모델이 동형이어야 함); 3. 은닉 상태 기반 증류 (모델이 이형일 수 있음). 또한 DistillKit과 같은 관련 도구도 언급되었습니다. (출처: Reddit r/MachineLearning)

LLaMA2의 연방 미세 조정 탐색: Reddit 사용자가 FedAvg와 FedProx를 사용하여 LLaMA2를 연방 미세 조정한 초기 실험 결과를 공유했습니다. 실험은 Reddit TL;DR 데이터셋에서 수행되었으며, 전역 검증 ROUGE-L, 통신 비용 및 클라이언트 드리프트를 비교했습니다. 결과는 FedProx가 드리프트를 줄이고 ROUGE-L을 약간 향상시키는 면에서 FedAvg보다 우수했지만, 여전히 중앙 집중식 미세 조정보다는 낮았습니다. 커뮤니티는 어댑터 구성, 압축 방법 및 비독립 동일 분포 데이터에서의 안정성 문제에 대해 논의하도록 초대되었습니다. (출처: Reddit r/deeplearning)

💼 비즈니스

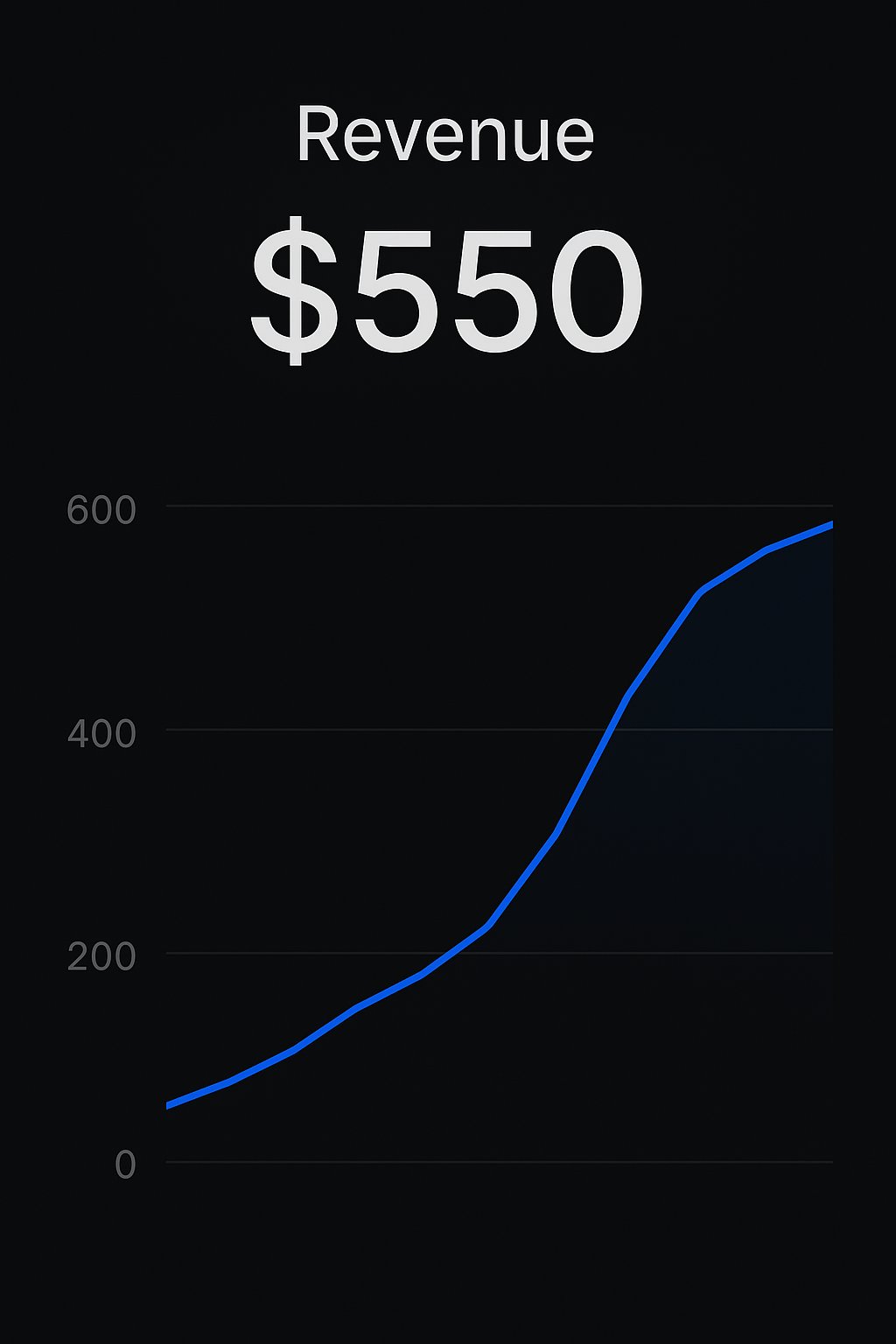

Replit 플랫폼 개발자의 앱 수익화 성공 사례: 두 명의 개발자가 Replit 플랫폼을 통해 AI 앱을 구축하고 판매한 성공 사례를 공유했습니다. 한 개발자는 CreateMVPs.app을 사용하여 첫 550달러의 수익을 올렸고, 다른 개발자는 하루 만에 구축한 앱을 4700달러에 판매하고 더 많은 프로젝트 입찰을 받았습니다. 이는 Replit과 같은 플랫폼이 개발자가 AI 앱을 신속하게 구축하고 상용화할 수 있도록 지원하는 잠재력을 보여줍니다. (출처: amasad, amasad)

ChatGPT Edu, 마운트 시나이 아이칸 의과대학에 배포: 마운트 시나이 아이칸 의과대학이 모든 의대생 및 대학원생에게 ChatGPT Edu 서비스를 제공한다고 발표했습니다. 이는 OpenAI의 교육용 제품이 최고의 의료 교육 기관에 진입했음을 의미하며, AI를 활용하여 의학 교육 및 연구를 지원하는 것을 목표로 합니다. 비디오는 그 응용 시나리오를 보여줍니다. (출처: gdb)

벤처 캐피탈 산업의 지속적인 손실에 대한 관심: Sam Altman은 벤처 캐피탈(VC) 산업 전체가 장기적으로 손실을 보고 있음에도 불구하고 여전히 유한 책임 파트너(LP)로부터 투자를 유치할 수 있는 현상에 대해 의문을 제기했습니다. 그는 최고의 펀드에 투자하는 것은 현명하지만, 산업 전체의 지속적인 손실 현상은 그 배후의 원인과 LP의 동기에 대해 생각해 볼 가치가 있다고 생각합니다. (출처: sama)

🌟 커뮤니티

AI가 고용 및 교육에 미치는 영향 논의: 커뮤니티에서는 AI 자동화가 기존 작업 방식(키보드-마우스-화면 인터페이스)에 미칠 잠재적 영향과 교육자들이 AI 챗봇에 어떻게 대응해야 하는지에 대해 논의합니다. 교사들은 학생들이 ChatGPT와 같은 도구를 사용하는 것을 금지해서는 안 되며, 이러한 AI를 효과적이고 책임감 있게 사용하는 방법을 가르쳐 학생들의 AI 소양과 모범 사례 능력을 배양해야 한다는 의견이 있습니다. (출처: NandoDF, NandoDF)

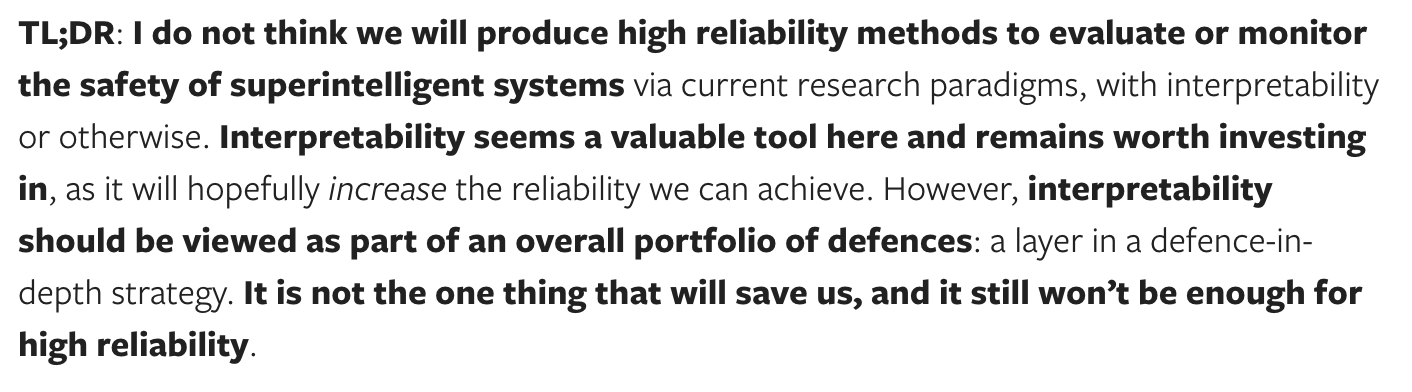

AI 해석 가능성 및 안전성 논의: Dario Amodei는 AI 모델 해석 가능성의 시급성을 강조하며 모델 작동 원리를 이해하는 것이 중요하다고 주장했습니다. Neel Nanda는 이에 대해 다른 견해를 제시하며, 해석 가능성 투자는 좋지만 다른 안전 방법에 비해 그 중요성을 지나치게 강조해서는 안 된다고 말합니다. 강력한 AI를 안정적으로 보장하는 길은 해석 가능성 하나만이 아니며, 이는 안전 조치 조합의 일부여야 합니다. (출처: bookwormengr)

RLHF의 복잡성 및 모델 “아첨” 현상 논의: Nathan Lambert 등은 강화 학습 인간 피드백(RLHF)의 복잡성과 중요성, 그리고 이로 인해 발생하는 모델 “아첨”(sycophancy) 현상(예: GPT-4o-simp)에 대해 논의했습니다. 기사는 RLHF가 모델 정렬에 매우 중요하지만 과정이 혼란스럽고, 사용자들이 종종 그 복잡성을 이해하지 못해 모델 행동에 대한 오해나 불만(예: LMArena의 반발)을 야기한다고 주장합니다. RLHF의 내재적 과제를 이해하는 것은 모델 평가 및 개선에 매우 중요합니다. (출처: natolambert, aidangomez, natolambert)

AI가 인간의 인지 능력 및 사고 방식에 미치는 잠재적 영향: 커뮤니티는 AI가 인간 사고에 미칠 잠재적 영향에 대해 탐구합니다. 한 가지 우려는 AI에 대한 과도한 의존이 인지 능력 저하(읽기 게으름, 비판적 사고 약화)로 이어질 수 있다는 것입니다. 다른 관점에서는 AI가 더 정확한 정보와 판단을 제공할 수 있다면, 원래 사고 능력이 약하거나 잘못된 정보에 취약한 사람들의 인지 수준을 오히려 향상시켜 “인지 증강” 역할을 하고 더 나은 결정을 내리는 데 도움을 줄 수 있다고 봅니다. 동시에 AI의 발전이 우리에게 의식에 대한 더 깊은 이해를 제공하고, 심지어 어떤 사람들은 단지 의식을 모방하고 있을 뿐이라는 사실을 발견하게 할 수도 있다는 논의도 있습니다. (출처: riemannzeta, HamelHusain, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

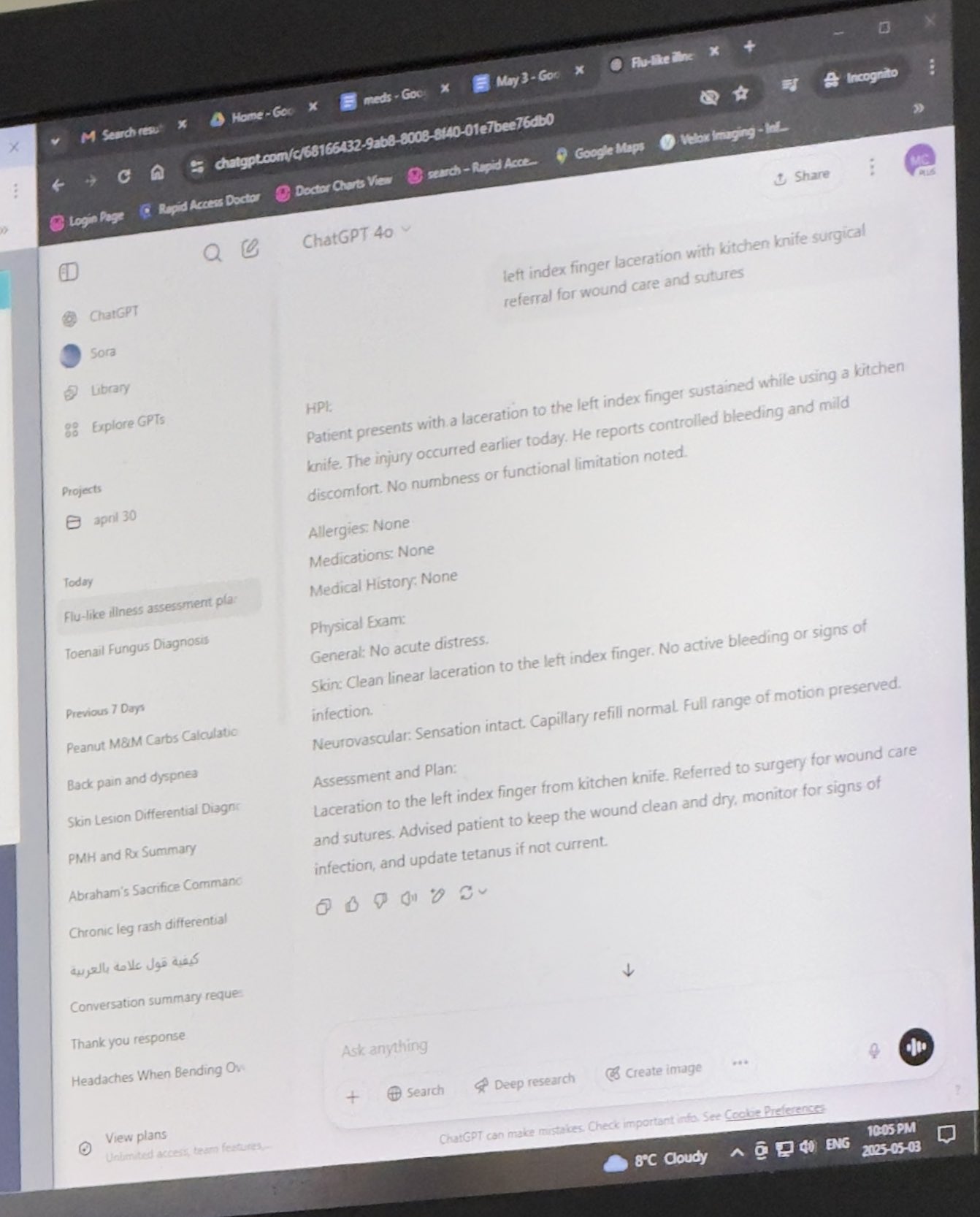

AI 윤리 및 응용 시나리오 논의: 의료, 법률 등 분야에서의 AI 응용에 대한 논의가 이루어집니다. 의사가 진료에 ChatGPT를 사용하는 사례를 공유한 사용자가 있어 전문적인 환경에서의 AI 응용에 대한 논의를 촉발했습니다. 동시에 AI를 이용한 대필(ghostwriting)의 윤리적 고려 사항, 특히 저자 자신이 어려움을 겪을 때에 대한 논의도 있습니다. 또한 AI 생성 콘텐츠(예: ADHD에 관한 책)가 가져올 수 있는 오해와 위험에 대한 우려도 있습니다. (출처: BorisMPower, scottastevenson, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

AI 기반 로봇 진척 상황: 여러 AI 기반 로봇이 소개되었습니다: Google DeepMind가 개발한 탁구를 칠 수 있는 로봇, 전시회에서 선보인 로봇 개, 다이아몬드 세팅에 사용되는 로봇, 새에서 영감을 받아 점프하여 이륙할 수 있는 드론, 예술 창작에 사용되는 기계 끌, 그리고 Unitree G1 휴머노이드 로봇이 쇼핑몰을 걷는 영상. 이는 AI가 로봇 제어, 인식 및 상호작용 측면에서 발전하고 있음을 보여줍니다. (출처: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

AI와 인문 사회 과학의 미래: 《뉴요커》 기사 관점을 인용하여 AI가 인문학에 미치는 영향을 탐구합니다. 기사는 AI가 인간의 “나다움”(me-ness)과 독특한 인간 경험에 도달할 수 없다고 주장하지만, 동시에 AI가 인간의 집단적 글쓰기(아카이브)를 재구성하고 재현함으로써 우리가 인간 개인에게 기대하는 것의 상당 부분을 모방할 수 있다고 지적하며, 이는 인문학에 도전과 새로운 사고 차원을 제시합니다. (출처: NandoDF)

💡 기타

개인 향상을 위한 AI 보조 도구 활용: Reddit 사용자가 ChatGPT를 개인 피트니스 및 영양 코치로 사용하여 성공한 경험을 공유했습니다. AI를 통해 훈련 계획, 식단(케토, 근력 운동, 단식 등 결합)을 수립하고, 심지어 외식 시 매크로 영양소 조언을 받아 유료 인간 코치보다 더 나은 결과를 얻었습니다. 이는 개인 맞춤형 지도 및 생활 보조 측면에서 AI의 잠재력을 보여줍니다. (출처: Reddit r/ChatGPT)

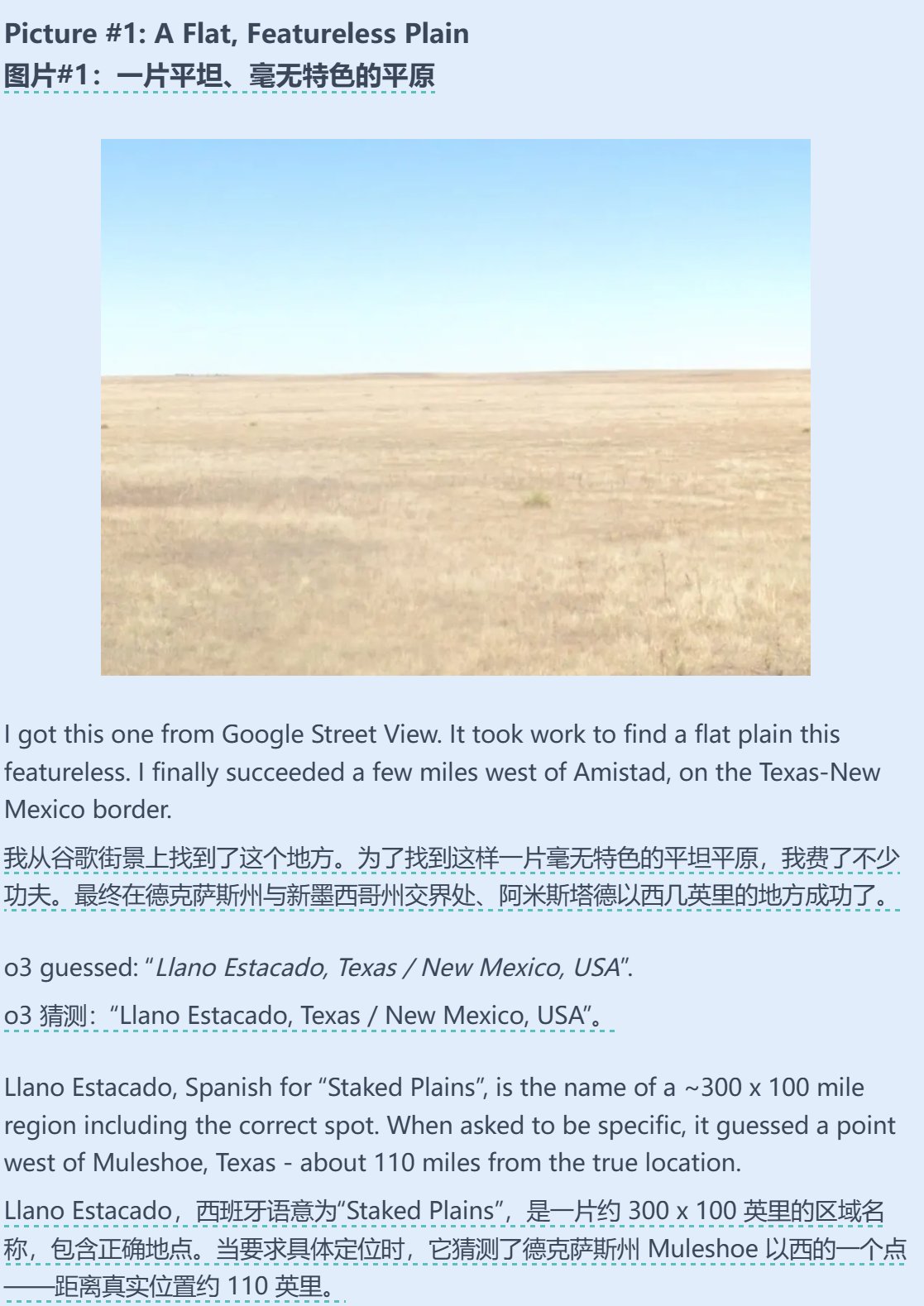

AI와 지리 추측 능력의 결합: Sam Altman은 AI(아마도 o3)가 Geoguessr(지리 추측 게임)에서 놀라운 능력을 보여준 테스트 기사를 리트윗하고 논평했습니다. 이미지 정보가 극히 적더라도(예: 흐릿한 표지판이나 순수한 그라데이션 색상만 있는 경우) AI는 옵션에 정답을 포함할 수 있었으며, 이는 강력한 이미지 인식, 패턴 매칭 및 지리 지식 추론 능력을 보여줍니다. (출처: op7418)

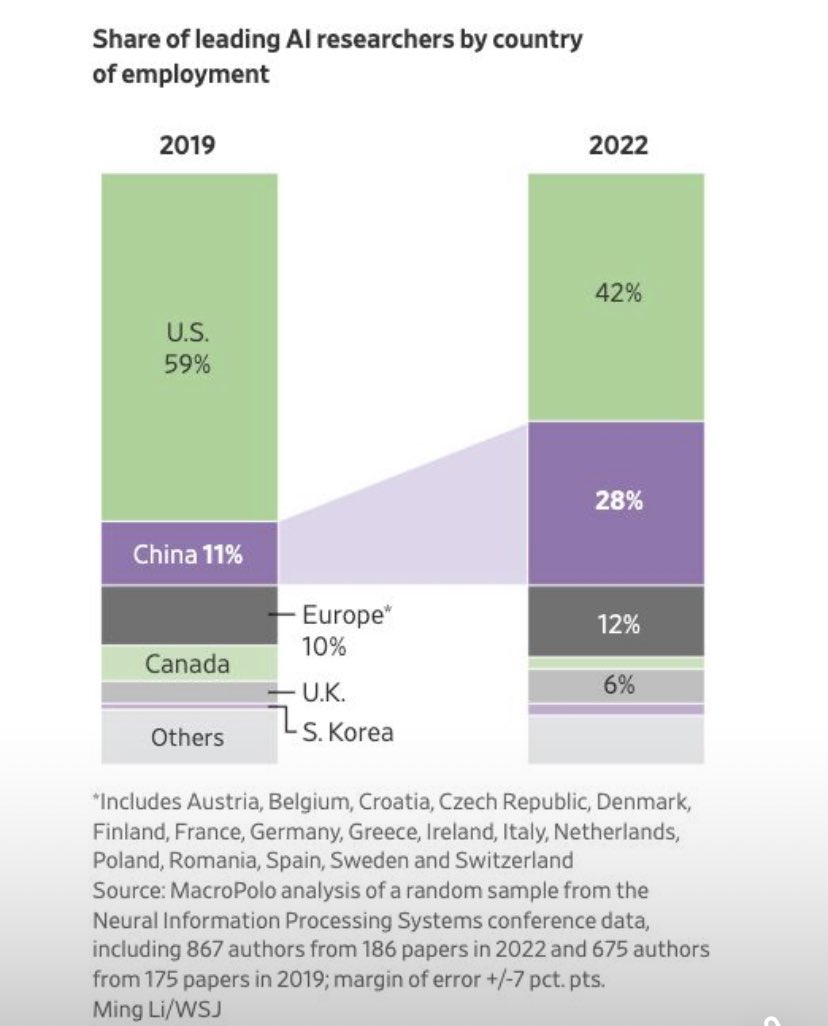

AI 분야 연구원 이동 추세: 차트는 AI 분야 최고 연구원들의 취업 국가 분포 변화를 보여줍니다. 미국에서 취업한 연구원의 비율은 감소한 반면, 중국에서 취업한 비율은 현저히 증가했습니다. 커뮤니티 댓글에서는 중국 본토의 연구 기회 증가와 잠재적인 인재 귀환을 고려할 때 실제 격차는 차트가 보여주는 것보다 클 수 있으며, 이는 글로벌 AI 인재 경쟁 구도의 변화를 반영한다고 지적합니다. (출처: teortaxesTex, bookwormengr)