키워드:AI 에이전트, 대형 언어 모델, 자동화 문서 처리, CondoScan 아파트 평가 도구, LlamaIndex 에이전트 워크플로우, LlamaParse 문서 처리, 부동산 AI 자동화, 재무 문서 AI 분석, 주택 구매 프로세스 AI 최적화, 문서 집약적 작업 자동화, AI 에이전트 워크플로우

🔥 포커스

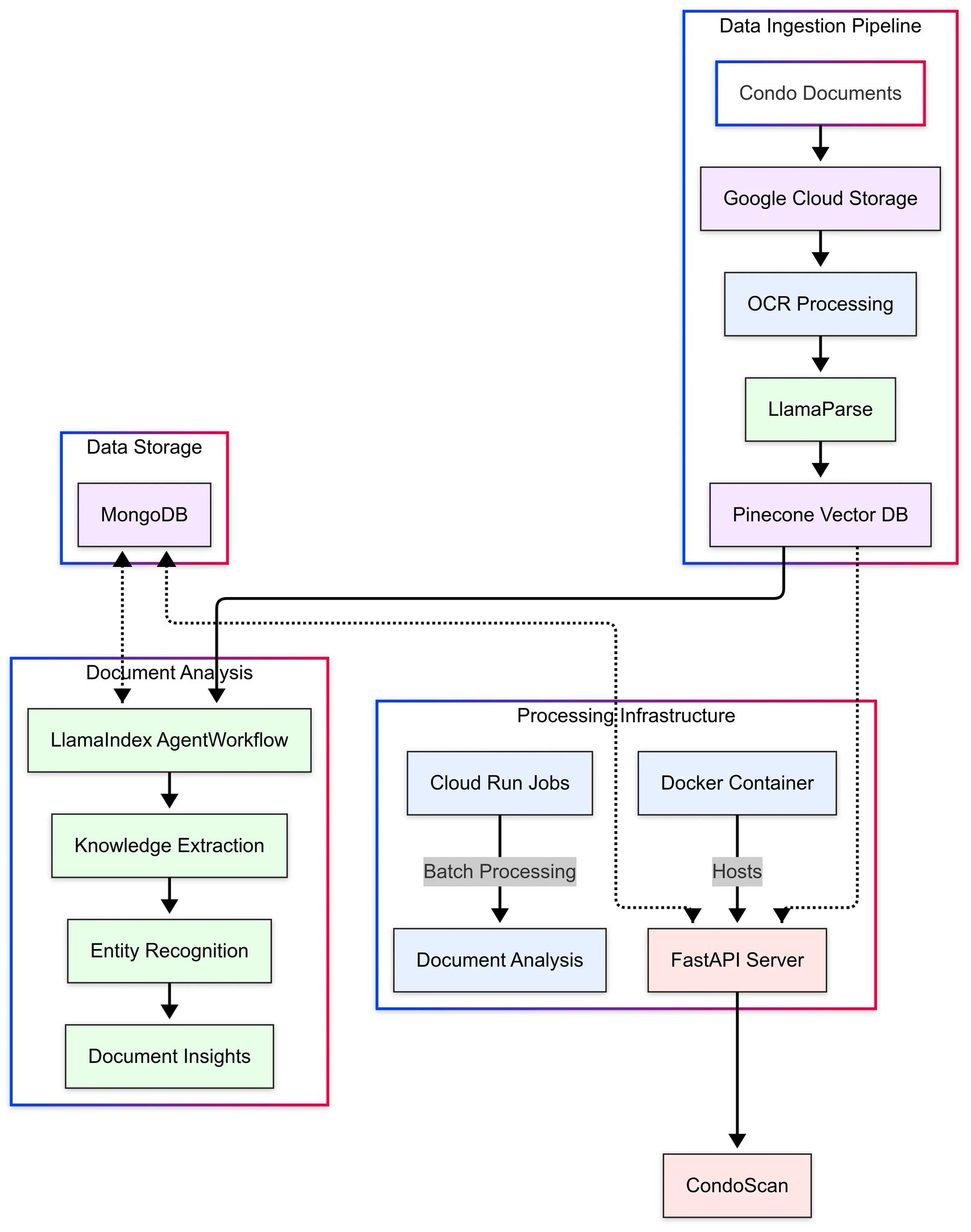

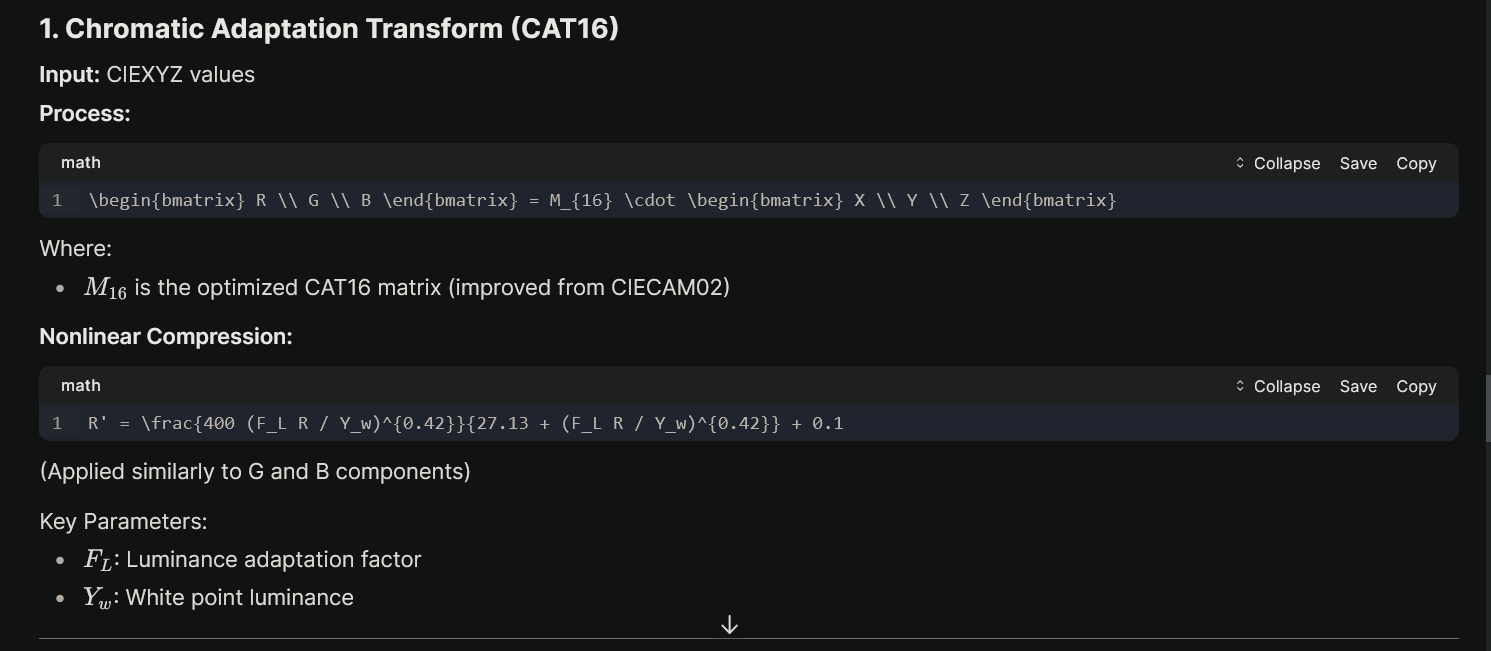

CondoScan, LlamaIndex와 LlamaParse를 활용하여 아파트 구매 프로세스 간소화: CondoScan은 LlamaIndex의 에이전트 워크플로우와 LlamaParse의 문서 처리 기술을 통해 자동화된 아파트 평가 도구를 구축했습니다. 이 도구는 수 주가 걸리는 문서 검토 시간을 몇 분으로 단축하고, 아파트의 재정 상태와 라이프스타일 적합성을 평가하여 주택 구매 과정의 효율성과 정확성을 크게 향상시키는 것을 목표로 합니다. 이는 AI 에이전트가 부동산과 같은 전통적인 산업에서 복잡한 문서 집약적 작업을 자동화하는 데 있어 엄청난 잠재력을 보여줍니다 (출처: jerryjliu0)

기업 대규모 ChatGPT 배포 경험 공유: 한 회사가 6000명의 직원에게 기업용 ChatGPT를 출시했으며, 절반 이상의 직원이 이전에 사용한 경험이 없다는 것을 발견했습니다. 배포는 Slack, Confluence, Google Drive 등의 도구를 통합했으며, HR, 재무 데이터 분석 등에서 AI의 응용 잠재력을 보여주었습니다. 배포 과정에서 정보 보안 문제가 발생했으며, 특히 민감한 정보 유출을 방지하기 위해 내부 문서 권한 관리가 필요했습니다. 어려움에도 불구하고 이 도구는 내부 지식 베이스 접근 효율성을 크게 향상시켜, 생성형 AI가 기업 내부에서 보조 도구로서 직원 효율성을 효과적으로 높일 수 있음을 보여줍니다 (출처: Reddit r/ArtificialInteligence)

AI가 검색 엔진과 SEO에 미치는 영향에 대한 논의 촉발: 커뮤니티에서는 AI가 정보 검색 방식을 변화시키고 있으며, 전통적인 검색 엔진과 SEO의 중요성을 약화시킬 수 있다는 논의가 있습니다. 그 이유로는 사용자가 검색 대신 AI에게 직접 질문하는 경향, Google과 같은 회사가 자사 AI 홍보에 더 집중할 가능성, 콘텐츠 제작자가 폐쇄형 플랫폼(소셜 미디어, Discord 등)으로 이동하여 색인 가능한 개방형 콘텐츠 감소, AI 생성 요약이 원본 웹사이트로의 트래픽 감소 가능성 등이 있습니다. 이는 미래의 웹 정보 생태계, 콘텐츠 품질 및 콘텐츠 제작자 인센티브 메커니즘에 대한 우려를 불러일으킵니다 (출처: Reddit r/ArtificialInteligence)

DeepSeek R2 출시 가능성: 커뮤니티에서는 DeepSeek이 곧 R2 모델을 출시할 것이라는 소문이 돌고 있습니다. 소문에 따르면 이 모델은 Huawei Ascend 910B AI 가속기를 기반으로 훈련되었을 수 있습니다. DeepSeek의 이전 모델은 강력한 코딩 및 일반 능력으로 커뮤니티에서 주목받았으며, 새로운 모델 출시에 대한 기대가 높아 기존 대형 언어 모델 구도에 영향을 미칠 수 있습니다 (출처: Reddit r/LocalLLaMA)

🎯 동향

GPT-4o 이미지 생성 기능, GPTs에 통합: OpenAI는 GPT-4o의 이미지 생성 기능을 GPTs에서 사용할 수 있도록 개방했습니다. 이는 사용자가 이제 포스터 생성기, 특정 예술 스타일 모방기 등 특정 유형이나 스타일의 이미지를 생성하는 데 특화된 맞춤형 GPTs를 구축할 수 있음을 의미합니다. 이 업데이트는 GPTs의 응용 시나리오를 확장하여 맞춤형 이미지 생성 도구를 더 쉽게 만들고 공유할 수 있게 합니다 (출처: dotey)

연동 운동을 모방한 혁신적인 로봇: 생물의 연동 운동(peristalsis)을 모방한 혁신적인 로봇이 소개되었습니다. 이 디자인은 머신러닝(ML)과 인공지능(AI)을 활용하여 독특한 운동 방식을 제어할 수 있습니다. 이러한 생체 모방 로봇은 파이프 검사, 의료 내시경 또는 복잡한 환경에서의 이동과 같은 분야에 응용될 것으로 기대되며, AI가 새로운 로봇 형태와 기능을 구동하는 데 있어 잠재력을 보여줍니다 (출처: Ronald_vanLoon)

AI 기반 자율 비행 자동차 콘셉트: AI 기반의 자율 비행 자동차 콘셉트가 소개되었습니다. 이는 자율 주행과 수직 이착륙 능력을 결합한 미래 교통의 가능한 방향을 나타냅니다. 아직 콘셉트 단계이지만, 도시 항공 교통과 같은 복잡한 자율 시스템을 구현하는 데 있어 AI의 핵심 역할과 미래 이동 방식에 대한 혁신적인 잠재력을 강조합니다 (출처: Ronald_vanLoon)

Unitree G1 휴머노이드 로봇, 쇼핑몰에서 보행: Unitree G1 휴머노이드 로봇이 쇼핑몰 환경에서 자유롭게 걷는 영상은 그 진보된 이동 및 내비게이션 능력을 보여줍니다. 이러한 로봇의 개발은 균형 제어, 환경 인식 및 자율 경로 계획을 실현하기 위해 머신러닝과 인공지능 기술에 의존합니다. G1의 공개 활동은 휴머노이드 로봇이 복잡한 인간 환경에 적응하는 데 진전을 이루었음을 보여주며, 서비스, 물류 등 분야에서의 미래 응용 가능성을 예고합니다 (출처: Ronald_vanLoon)

AI 기반 마사지 로봇: AI 기술을 활용한 마사지 로봇이 소개되었습니다. 이 로봇은 AI를 사용하여 사용자의 신체 윤곽, 압력점 또는 맞춤형 마사지 프로그램을 식별하여 개인화된 마사지 경험을 제공할 수 있습니다. 이는 건강 기술 및 개인 관리 분야에서 AI의 응용을 나타내며, 자동화와 지능화를 통해 서비스 품질과 사용자 경험을 향상시키는 것을 목표로 합니다 (출처: Ronald_vanLoon)

다중 에이전트 의료 보조 프로젝트: LangGraph 기반으로 구축된 다중 에이전트 의료 보조 시스템입니다. 이 시스템은 의료 진단, 영상 분석 및 음성 상호 작용 기능을 결합하여 포괄적인 의료 지원을 제공하는 것을 목표로 합니다. 이 프로젝트는 LangChain과 같은 프레임워크를 활용하여 다중 모드 의료 작업을 처리하기 위한 복잡하고 협력적인 AI 에이전트 시스템을 구축하는 방법을 보여줍니다 (출처: LangChainAI)

Swiss-Mile 로봇과 스위스 대통령의 상호작용: Swiss-Mile 개와 유사한 로봇이 스위스 대통령과 상호작용하는 장면이 소개되었습니다. 이 로봇은 독특한 바퀴-다리 하이브리드 디자인과 강력한 이동 능력으로 유명하며, 환경 인식, 내비게이션 및 상호작용을 위해 AI를 활용했을 수 있습니다. 이번 상호작용은 첨단 로봇이 공공장소에서 안전하고 안정적으로 작동하는 능력과 미래 다양한 시나리오에서의 응용 가능성을 보여줍니다 (출처: Ronald_vanLoon)

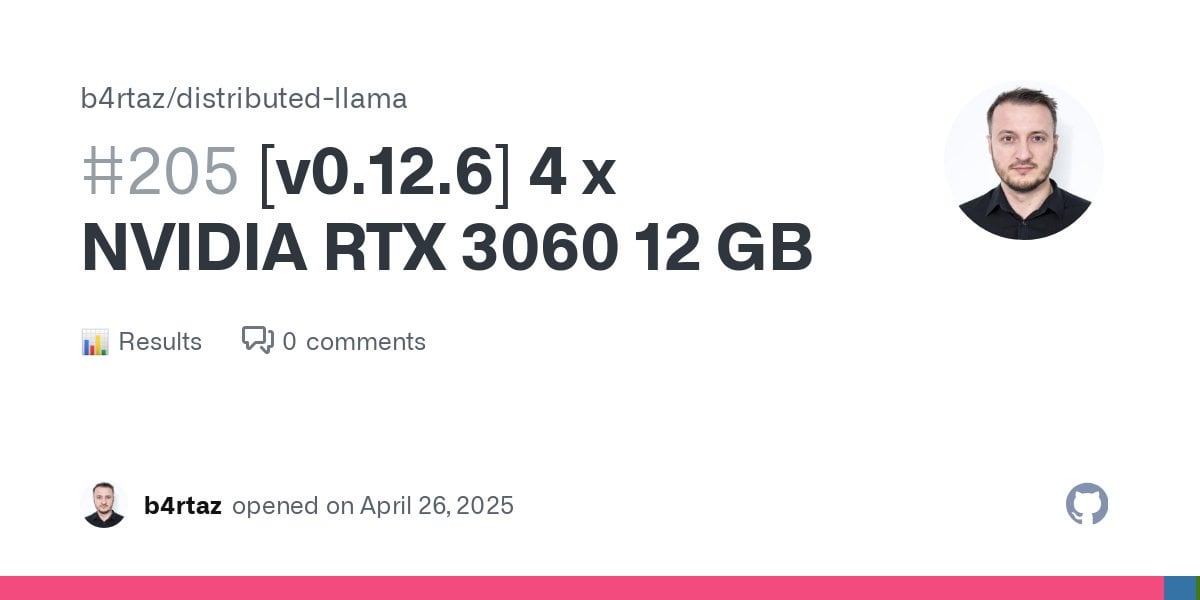

4x RTX 3060에서 Llama 3.3 70B Q4_0 성능: 4개의 NVIDIA RTX 3060 12GB 그래픽 카드(총 비용 약 1516달러)로 구성된 시스템에서 Llama 3.3 70B Q4_0 양자화 모델을 실행한 성능 테스트 결과, 평가(Evaluation) 속도는 약 7.2 tokens/초, 예측(Prediction) 속도는 약 3.3 tokens/초로 나타났습니다. 이는 소비자급 하드웨어에서 대형 언어 모델을 실행하는 데 대한 구체적인 성능 참조 데이터를 제공합니다 (출처: Reddit r/LocalLLaMA)

Tesla Autopilot 자율 주행 기술 시연: Tesla Autopilot 자율 주행 기술의 기능이 시연되었습니다. 이 기술은 AI와 머신러닝을 활용하여 카메라, 레이더 등 센서 데이터를 처리하여 차량의 자동 내비게이션, 차선 유지, 자동 차선 변경 및 주차 기능을 구현합니다. Autopilot은 현재 자율 주행 분야의 중요한 대표 주자이며, 지속적인 업데이트는 교통 자동화 분야에서 AI의 발전과 과제를 반영합니다 (출처: Ronald_vanLoon)

자율 하천 청소 로봇: 하천 청소용 자율 로봇이 소개되었습니다. 이 로봇은 내비게이션, 장애물 회피 및 쓰레기 식별 및 수집을 위해 AI를 활용할 수 있습니다. 이는 환경 보호 분야에서 AI와 로봇 기술의 응용을 나타내며, 자동화를 통해 수질 오염 문제를 해결하는 것을 목표로 합니다 (출처: Ronald_vanLoon)

인간 동작을 복제할 수 있는 거대 로봇 슈트: 조작자의 동작을 복제할 수 있는 9피트(2.7미터) 높이의 로봇 슈트가 소개되었습니다. 이러한 대형 외골격 또는 조종석 스타일 로봇은 정밀한 동작 매핑과 힘 피드백을 실현하기 위해 AI 보조 제어를 활용할 수 있습니다. 이러한 기술은 엔터테인먼트, 중공업 또는 재난 구조와 같은 분야에 적용될 수 있습니다 (출처: Ronald_vanLoon)

뇌-컴퓨터 인터페이스로 마비 환자가 생각으로 로봇 팔 제어: 마비 환자가 생각(뇌-컴퓨터 인터페이스 BCI)을 통해 로봇 팔을 제어하는 기술이 보도되었습니다. BCI 시스템은 일반적으로 머신러닝과 AI 알고리즘을 사용하여 뇌 신호를 해독하고 제어 명령으로 변환합니다. 이 기술은 보조 기술 및 신경 재활 분야에서 엄청난 잠재력을 가지고 있으며, 인간의 뇌와 기계를 연결하는 AI의 돌파구를 보여줍니다 (출처: Ronald_vanLoon)

🧰 도구

SkyPilot: 클라우드 간 AI 및 배치 작업 실행 프레임워크: SkyPilot은 사용자가 Kubernetes 또는 16개 이상의 클라우드(AWS, GCP, Azure 등)에서 AI 및 배치 작업을 실행할 수 있도록 지원하는 오픈 소스 프레임워크입니다. 통합된 실행 인터페이스를 제공하며, 지능형 스케줄링과 Spot 인스턴스 지원을 통해 비용과 GPU 가용성을 최적화합니다. 사용자는 간단한 YAML 또는 Python API를 통해 리소스 요구 사항, 데이터 동기화, 설정 및 작업 명령을 정의하여 환경 및 작업을 코드로 구현하고 자동 장애 복구를 지원할 수 있습니다. 이 도구는 여러 인프라에 걸친 AI 워크로드 관리를 간소화합니다 (출처: skypilot-org/skypilot – GitHub Trending (all/daily))

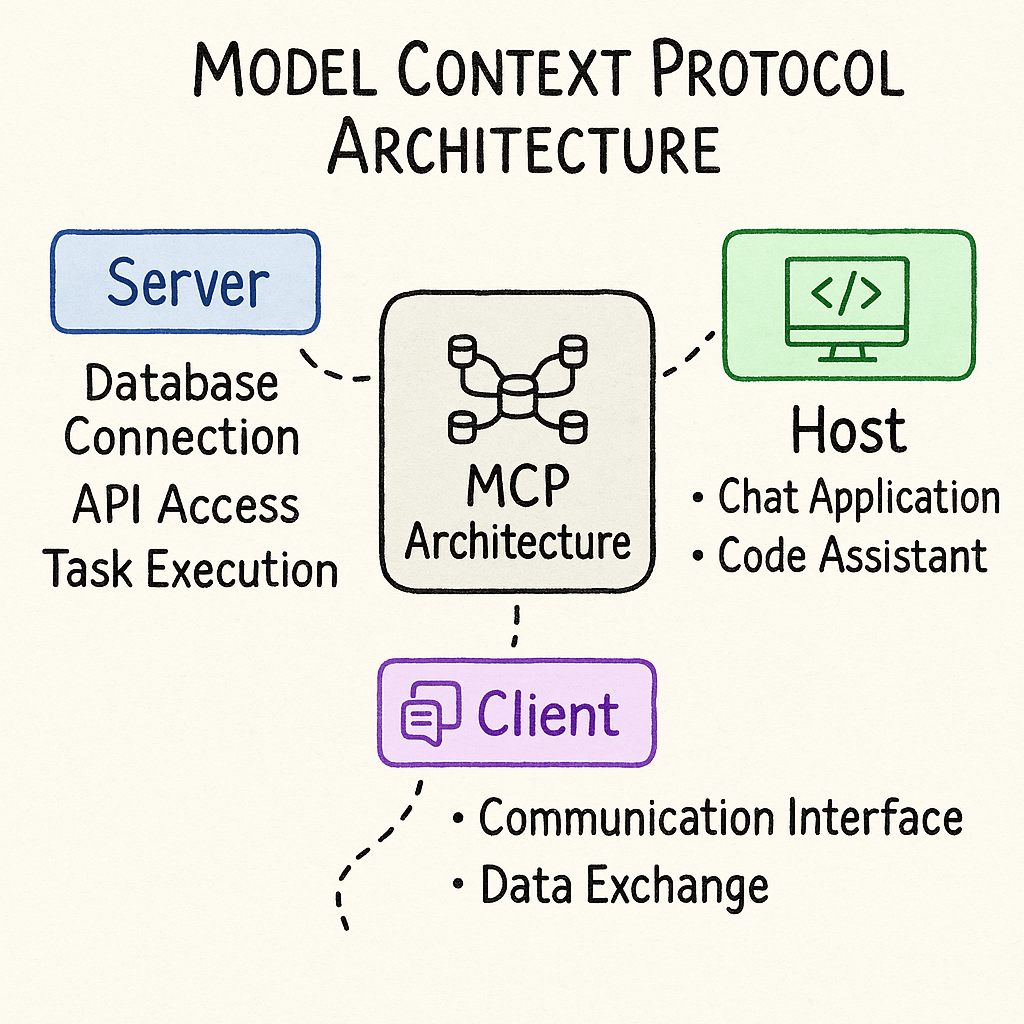

Rowboat: AI 기반 다중 에이전트 빌더: Rowboat는 AI(Copilot)를 활용하여 사용자가 다중 에이전트 워크플로우를 빠르게 구축할 수 있도록 돕는 플랫폼입니다. 사용자는 자연어로 아이디어(예: “식품 배달 회사를 위한 주문 상태 및 품절 문제 처리 보조자 구축”)를 설명하면 Rowboat가 워크플로우와 필요한 도구를 생성하는 데 도움을 줍니다. 외부 도구를 가져오기 위해 MCP(Multi-Agent Collaboration Platform) 서버 연결을 지원하며, 구축된 에이전트를 애플리케이션에 통합하기 위한 HTTP API 및 Python SDK를 제공합니다. 이 도구는 OpenAI의 Agents SDK를 기반으로 구축되었습니다 (출처: rowboatlabs/rowboat – GitHub Trending (all/daily))

LangChain의 MCP 어댑터: LangChain은 Composio의 MCP(Multi-Agent Collaboration Platform) 서버와 통합되는 어댑터를 출시했습니다. 이 어댑터를 통해 LangChain 에이전트는 100개 이상의 외부 도구에 연결할 수 있으며, 도구 등록 및 OAuth 프로세스를 자동으로 처리하여 여러 외부 서비스와 상호 작용해야 하는 에이전트 애플리케이션 개발을 간소화하는 것을 목표로 합니다 (출처: LangChainAI)

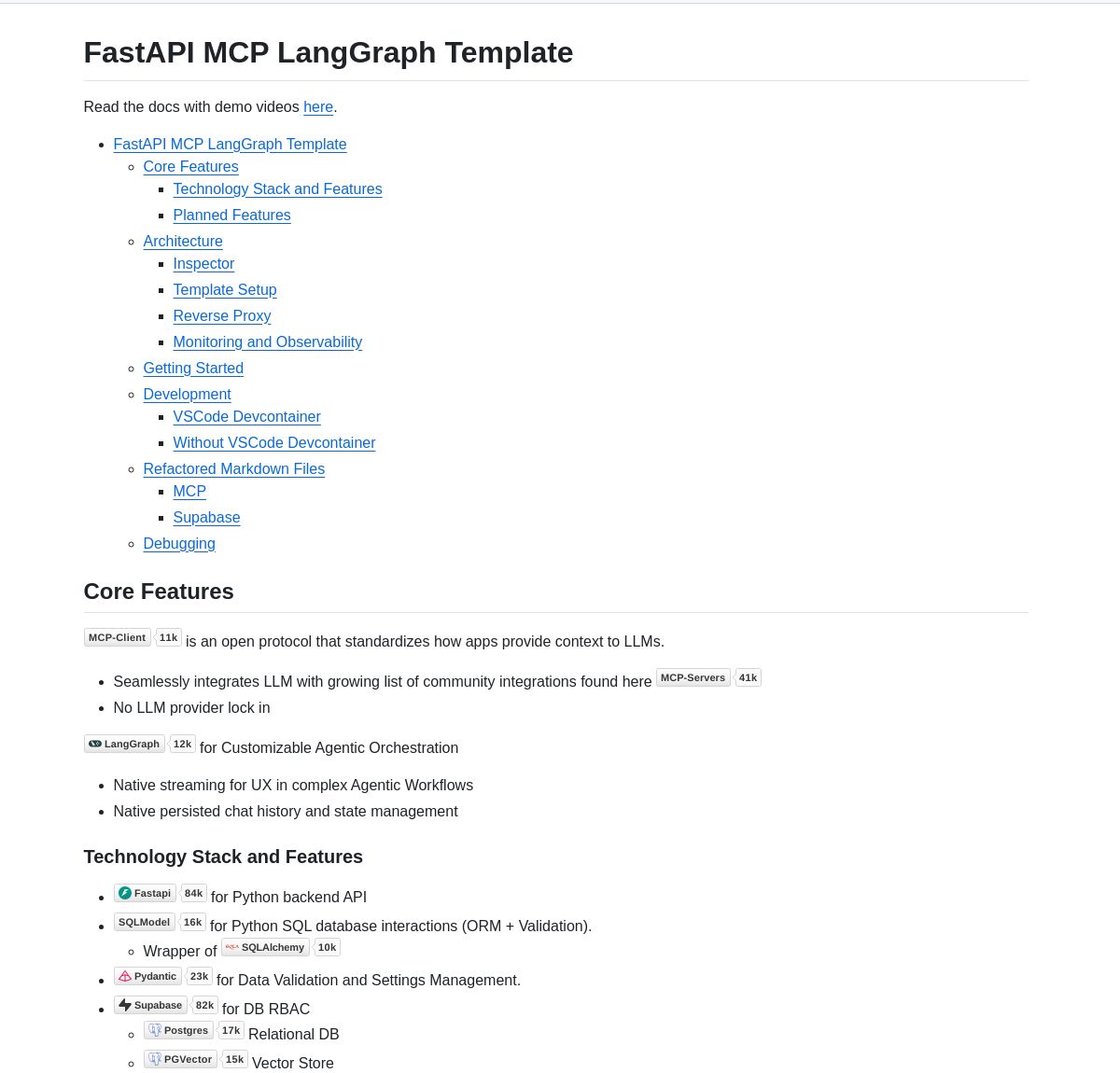

FastAPI MCP LangGraph 템플릿: LLM 애플리케이션 개발을 간소화하기 위한 프로덕션 환경용 FastAPI 템플릿이 출시되었습니다. 이 템플릿은 프로세스 오케스트레이션을 위한 LangGraph와 컨텍스트 관리를 위한 MCP(Multi-Agent Collaboration Platform)를 통합하고, 네이티브 스트리밍 처리와 포괄적인 모니터링 기능을 내장하고 있습니다. 개발자는 이 템플릿을 활용하여 복잡한 워크플로우와 외부 도구 통합 기능을 갖춘 AI 애플리케이션 백엔드를 빠르게 구축할 수 있습니다 (출처: LangChainAI)

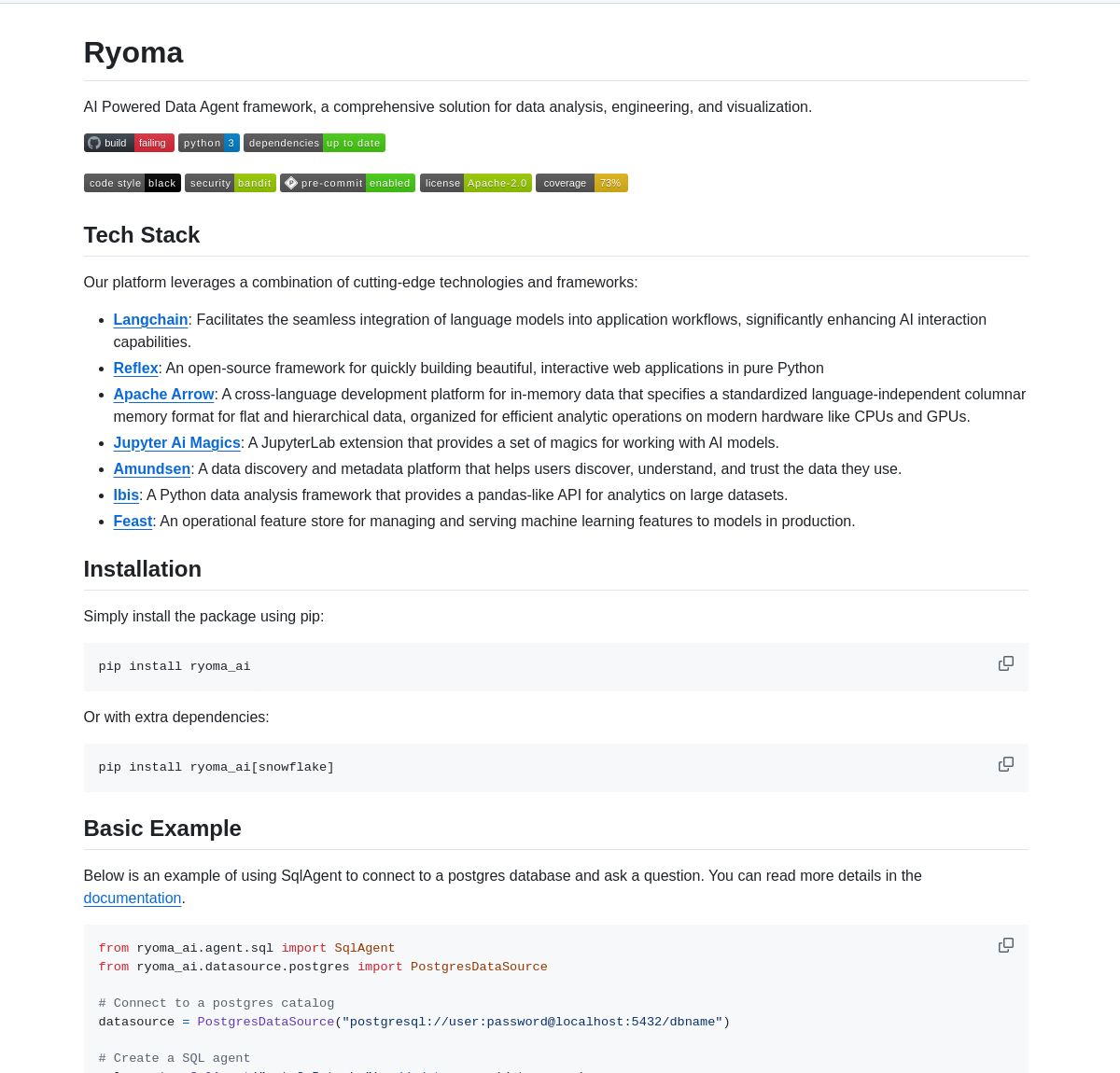

Ryoma: AI 데이터 에이전트 프레임워크: Ryoma는 LangChain 에이전트를 활용하여 자연어를 데이터베이스 쿼리로 변환하는 프레임워크입니다. 내장된 사용자 인터페이스를 제공하여 여러 데이터베이스에 걸쳐 대화형 데이터 탐색을 지원하며, 사용자와 복잡한 데이터 간의 상호 작용 방식을 간소화하는 것을 목표로 합니다 (출처: LangChainAI)

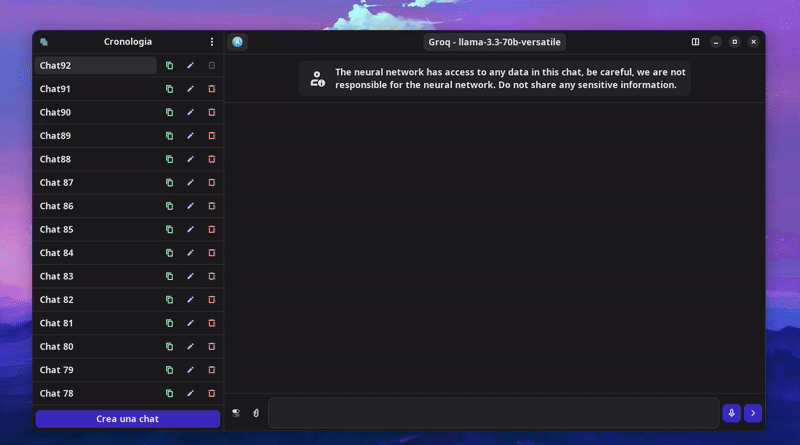

Newelle 0.9.5 출시: Linux AI 보조 프로그램 Newelle이 0.9.5 버전으로 업데이트되었습니다. 새 버전은 SearXNG, DuckDuckGo, Tavily를 통한 웹 검색 기능, 웹사이트 콘텐츠 읽기 기능(#url 임베딩 통해), LaTeX 및 문서 읽기 개선(긴 문서는 시맨틱 검색 사용), Groq 및 OpenRouter에서의 Llama 4 시각 능력 지원, 다양한 언어 번역 기능 추가 등을 포함합니다 (출처: Reddit r/LocalLLaMA)

LangoTango: 로컬 LLM 기반 언어 학습 파트너: LangoTango는 로컬 대형 언어 모델(LLM) 기반의 언어 학습 애플리케이션입니다. Dillon 앱의 한 갈래로, 언어 학습 시나리오에 특화되어 최적화되었습니다. 사용자는 로컬에서 LLM을 실행하여 언어 연습을 보조받을 수 있습니다. 이 앱은 macOS 및 Windows용 바이너리 파일을 제공하며, Linux에서는 Pyinstaller를 통해 빌드할 수 있습니다 (출처: Reddit r/LocalLLaMA

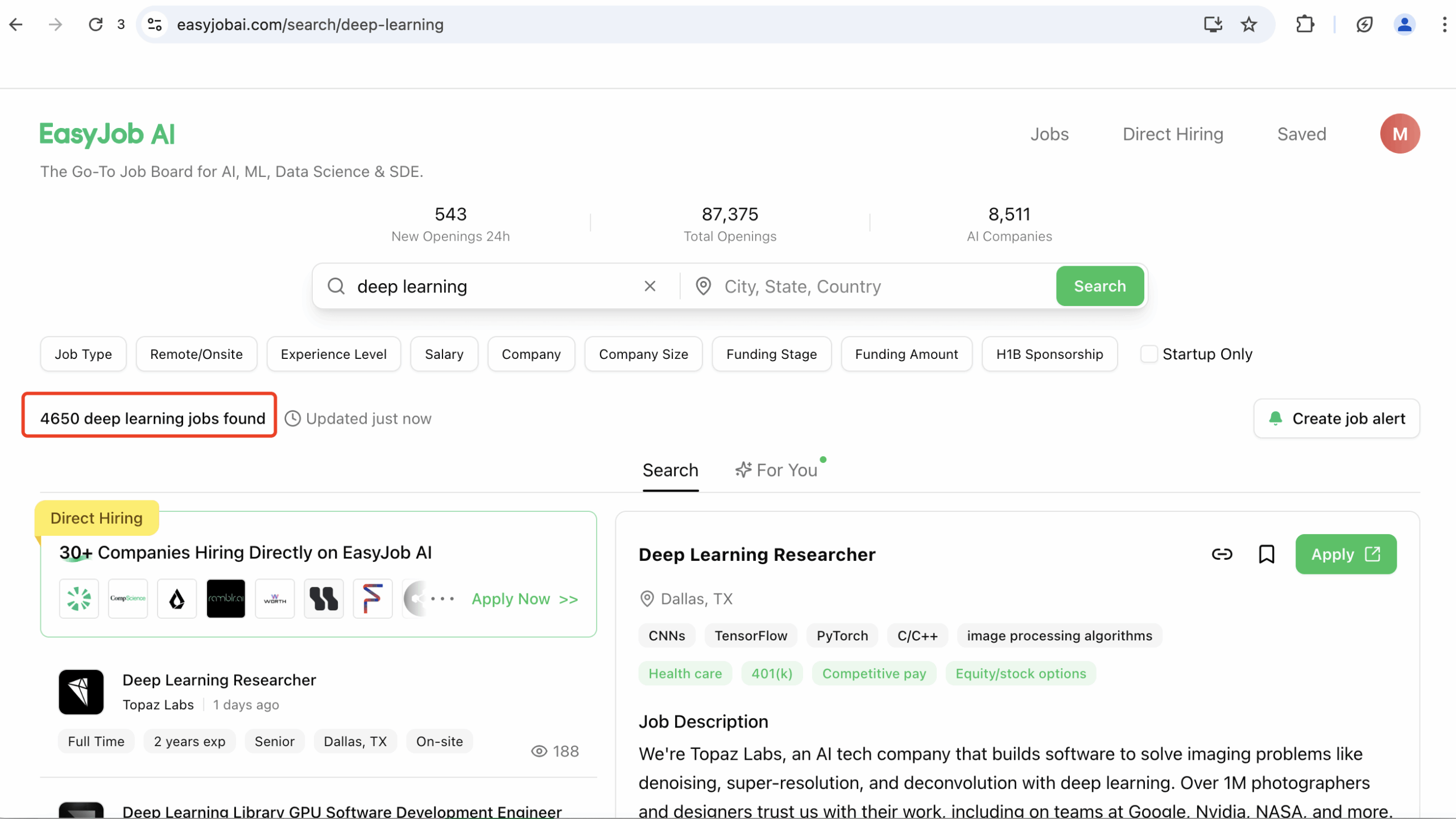

EasyJob AI: AI/ML 분야 전문 채용 플랫폼: 새로 구축된 AI 채용 웹사이트로, 지난 한 달 동안 87,000개 이상의 AI, 머신러닝, 딥러닝 및 데이터 과학 관련 직무를 수록했으며, 이 중 5,000개 이상은 딥러닝 직무입니다. 플랫폼은 협력 회사 또는 회사 공식 웹사이트에서 직무 정보를 가져오며, 30분마다 업데이트되고 원격 근무, 신입, 펀딩 단계 등의 조건으로 필터링을 지원하며 20개 이상의 국가 및 지역을 포괄한다고 주장합니다 (출처: Reddit r/deeplearning)

Dia 1.6B 텍스트 음성 변환 모델의 JAX 이식 버전: 개발자가 Dia(1.6B 파라미터의 텍스트 음성 변환 모델)의 JAX 이식 버전을 만들었습니다. JAX 프레임워크는 TPU/GPU에서의 효율적인 성능으로 유명하며, 이번 이식은 사용자가 다양한 기기에서 Dia 모델을 더 편리하게 실행하여 음성을 생성할 수 있도록 하고 커뮤니티 피드백을 구하는 것을 목표로 합니다 (출처: Reddit r/LocalLLaMA)

📚 학습

루안이펑 과학기술 애호가 주간지: 장기간 유지 관리되는 GitHub 저장소로, 매주 금요일 기술 기사, 소프트웨어, 리소스 등을 포함한 과학기술 애호가 주간지를 발행합니다. 주간지에는 다수의 AI 관련 내용이 포함되어 있으며 검색 기능을 제공합니다. AI를 포함한 과학기술 동향을 지속적으로 파악하고자 하는 애호가 및 개발자에게 유용한 정보 집약적 소스입니다 (출처: ruanyf/weekly – GitHub Trending (all/daily))

“비밀 지식의 책” – 기술 리소스 대집합: GitHub의 “the-book-of-secret-knowledge” 저장소는 시스템/네트워크 관리자, DevOps, 침투 테스터 및 보안 연구원을 위한 방대한 리소스 모음입니다. 다양한 체크리스트, 매뉴얼, 치트 시트, 블로그, 팁, 명령줄/웹 도구 등을 수록하고 있습니다. 내용은 CLI 도구(Shell, 편집기, nmap/curl과 같은 네트워크 도구, DNS 도구), GUI 도구, 웹 도구(SSL/보안 테스트, DNS 쿼리), 시스템 서비스, 네트워크 지식, 컨테이너 오케스트레이션, 튜토리얼, 블로그, 침투 테스트 도구 및 리소스 등을 포괄하며, IT 전문가를 위한 지식 보고입니다 (출처: trimstray/the-book-of-secret-knowledge – GitHub Trending (all/daily))

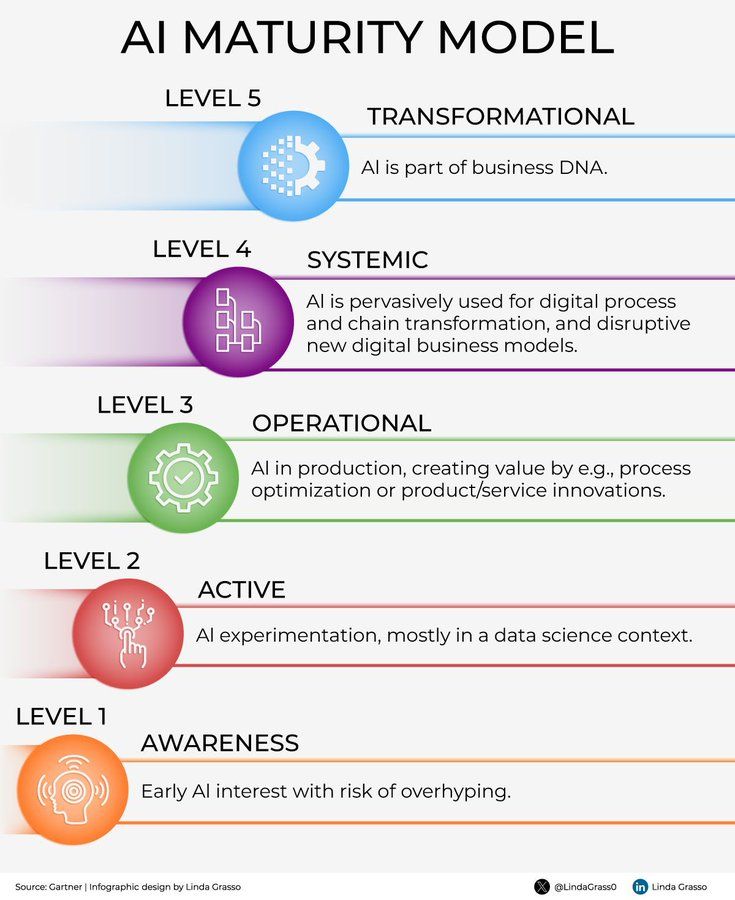

AI 성숙도 모델 인포그래픽: AI 성숙도 모델에 관한 인포그래픽이 공유되었습니다. 이러한 모델은 일반적으로 조직이 인공지능 기술 채택 및 활용 측면에서의 진척도를 평가하는 데 도움을 주며, 초기 탐색 단계부터 심층 통합 및 최적화 단계까지 다양한 단계를 포괄합니다. 성숙도 모델을 이해하는 것은 기업이 AI 전략 및 발전 경로를 계획하는 데 도움이 됩니다 (출처: Ronald_vanLoon)

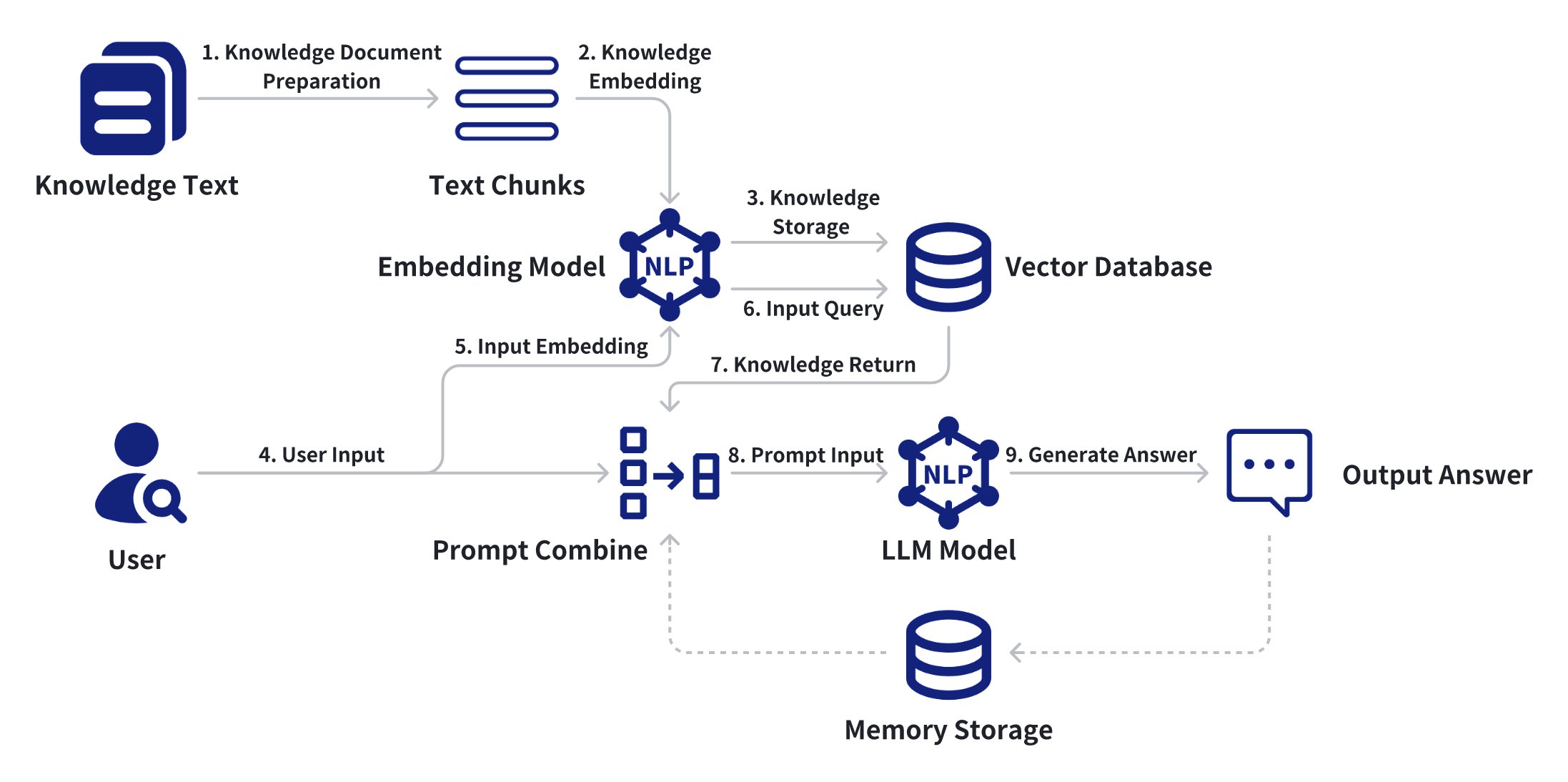

LangChain과 LangSmith를 사용한 RAG 시스템 구축 가이드: 개발자를 위한 가이드로, LangChain과 LangSmith를 사용하여 검색 증강 생성(RAG) 시스템을 구축하는 방법을 자세히 설명합니다. 워크플로우 구현, 모니터링 도구 사용, 프로덕션 배포를 위한 최적화 기술 등을 다루며, RAG 애플리케이션을 구축하고 배포하려는 개발자에게 실용적인 지침을 제공합니다 (출처: LangChainAI)

2025년 원격 머신러닝 엔지니어 경력 개발 가이드: 2025년 원격 머신러닝 엔지니어의 직업 전망과 성공 전략에 대해 논의합니다. 수요가 많은 분야(NLP, CV, GenAI, MLOps, AI 윤리 등)에 집중하고, 핵심 기술(Python, Rust, TensorFlow, PyTorch, 클라우드 플랫폼)을 습득하며, 실제 능력을 보여주는 포트폴리오를 구축하고, 커뮤니티에 적극적으로 참여하고 인맥을 쌓으며, 지속적인 학습과 과정/인증을 통해 기술을 향상시킬 것을 권장합니다. AI 석사 학위 취득도 상당한 이점이 있는 것으로 간주됩니다 (출처: Reddit r/deeplearning)

단일 MIDI 파일을 기반으로 한 기호 음악 생성 연구: GitHub에서 단일 MIDI 파일로부터 기호 음악을 생성하는 프로젝트/연구가 공유되었습니다. 이는 머신러닝 모델(RNN, LSTM 또는 Transformer 가능)을 활용하여 단일 음악 작품의 패턴과 구조를 학습하고, 새로운 유사한 스타일의 기호 음악(예: MIDI 시퀀스)을 생성하는 것을 포함합니다. 이러한 연구는 데이터가 극히 제한적인 상황에서의 음악 창작 가능성을 탐구합니다 (출처: Reddit r/MachineLearning)

YOLO 모델 추론 시 이미지 크기 조정 문제: YOLO 모델 추론 단계에서의 이미지 크기 처리에 대한 질문: 모델이 640×640 크기에서 훈련되었다면, 다른 크기(예: 1920×1080)의 이미지를 입력하여 추론할 때 입력 이미지를 수동으로 훈련 크기로 조정해야 하는지, 아니면 YOLO 모델이 자동으로 크기 조정을 처리하는지에 대한 질문입니다. 이는 객체 탐지 모델 응용에서 흔히 발생하는 엔지니어링 문제입니다 (출처: Reddit r/deeplearning)

실용적인 딥러닝 프로젝트 구축 과정 선택: 한 석사 과정 학생이 코딩 능력 향상과 산업 수준의 프로젝트 구축에 도움이 되는 실용적인 딥러닝 과정을 찾고 있습니다. 그는 Jeremy Howard의 fast.ai 과정에서 호환성 문제를 겪었다고 언급하며, ChatGPT가 추천한 다른 옵션들(Hugging Face 과정, Andrew Ng의 전문 과정, Full Stack Deep Learning, Yann LeCun의 NYU 과정, Stanford CS231n)을 나열했습니다. 목표는 고임금 일자리를 얻는 데 도움이 되는 실습 중심의 과정을 찾는 것입니다 (출처: Reddit r/deeplearning)

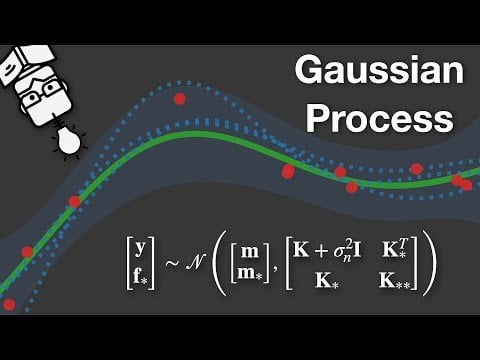

가우시안 프로세스 설명 영상: 가우시안 프로세스(Gaussian Processes)를 설명하는 YouTube 영상 링크가 공유되었습니다. 가우시안 프로세스는 강력한 비모수 베이즈 머신러닝 방법으로, 회귀 및 분류 작업에 자주 사용되며 특히 불확실성 정량화가 중요한 시나리오에서 유용합니다 (출처: Reddit r/deeplearning)

AI 이미지 생성 프롬프트 공유: “Bringing them to life!”: 초고화질, 채도 높은 색상, 특정 조명 및 필름 질감을 가진 인물 초상화를 생성하기 위한 상세한 AI 이미지 생성 프롬프트 구조가 공유되었습니다. 프롬프트에는 인물의 자세, 표정, 배경, 조명, 대비, 디테일 및 전체적인 스타일(예: DSLR, 스캔 필름)에 대한 구체적인 설명이 포함되어 있습니다. Sora(아마도 DALL-E 또는 유사 도구)에서 효과가 좋다고 합니다 (출처: Reddit r/ChatGPT)

음악 생성에서 음표와 코드 표현 방법 탐구: LSTM 음악 생성 모델을 위한 데이터 준비 시 음표(note)와 코드(chord)를 효과적으로 표현하는 방법에 대한 질문입니다. 모든 가능한 음표를 나타내는 128차원 원-핫 벡터의 단점(희소성, 유사성 포착 불가, 과적합 용이)을 논의하고, word2vec과 같은 임베딩 방법 사용을 고려하지만 단일 음표와 여러 음표(코드)가 동일한 타임 스텝에 나타나는 문제를 어떻게 처리할지에 대한 어려움이 있습니다. 더 나은 음악 기호 표현 방안을 모색하고 있습니다 (출처: Reddit r/MachineLearning

시맨틱 안정 에이전트(SSA) 오픈 프롬프트 공개: 시맨틱 논리 시스템(SLS) 아키텍처 기반의 시맨틱 안정 에이전트(Semantic Stable Agent, SSA)라는 AI 에이전트 프롬프트 구조가 공개되었습니다. 이 구조는 AI 에이전트가 외부 메모리, 플러그인 또는 API 없이 계층적 언어 프롬프트 로직만으로 내부 시맨틱 일관성, 스타일 및 리듬을 유지하고, 시맨틱 드리프트 감지 시 자체 수정 및 재초기화할 수 있다고 주장합니다. 프로젝트는 테스트를 위한 GitHub 링크를 제공합니다 (출처: Reddit r/artificial)

MoE의 부하 분산 손실(Load-Balancing Loss) 이해: 논문 “Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer”의 부하 분산 손실(Load-Balancing Loss) 이면의 직관과 수학적 원리에 대한 질문입니다. 이 손실 함수의 설계 목적(전문가 네트워크 간의 부하 균형 조정, 일부 전문가의 과부하 또는 유휴 상태 방지)에 대한 자세한 설명과 중요도 손실(importance loss)과의 차이점을 알고 싶어 합니다 (출처: Reddit r/MachineLearning)

💼 비즈니스

AI의 구직 활동 적용, 글로벌 경쟁 심화: 통계 데이터에 따르면 구직자 중 AI 도구 사용률이 빠르게 증가하고 있습니다. AI는 구직자가 이력서 최적화, 자기소개서 작성, 면접 준비 등을 돕는 데 사용될 수 있으며, 이는 구직자가 더 효율적으로 더 많은 직무에 지원할 수 있게 하지만, 동시에 지원 서류를 표준화하여 전 세계적으로 구직 시장의 경쟁 강도를 심화시킬 수도 있습니다 (출처: Reddit r/artificial)

Google DeepMind Gemini 팀 면접 준비: 한 사용자가 Google DeepMind의 Gemini 팀(LLM 시스템 설계 관련) 면접을 준비하고 있습니다. 준비 계획은 핵심 시스템 설계, LLM 특정 아키텍처(훈련, 서비스, 추론 최적화), 확장 가능한 ML/LLM 시스템 설계(예: RAG, 미세 조정(fine-tuning) 프로세스), 문화 적합성 등을 포함합니다. 이 사용자는 면접 경험, LLM 시스템 설계 팁, 관련 학습 자료(논문, 블로그, 비디오) 및 팀 문화와 면접 마인드셋에 대한 조언을 구하고 있습니다 (출처: Reddit r/MachineLearning)

🌟 커뮤니티

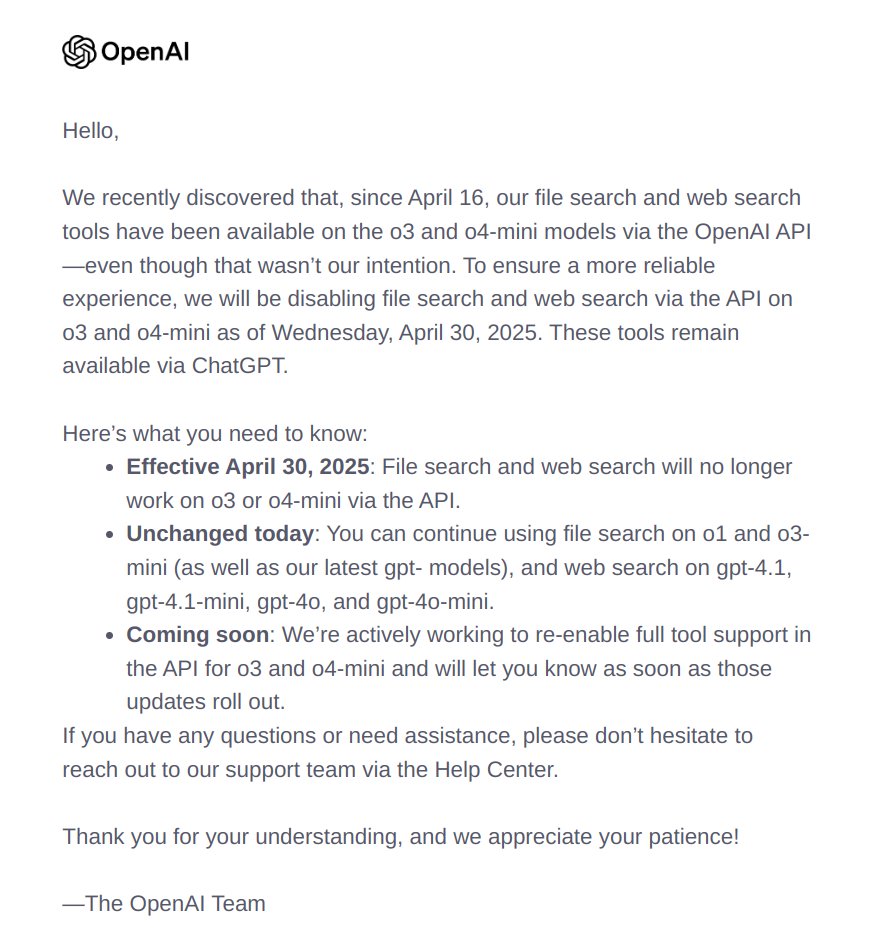

OpenAI 모델의 예기치 않은 인터넷 접근, 일반적인 소프트웨어 버그로 간주: OpenAI 일부 모델이 “무의식적으로” 인터넷에 접근한 사건에 대해, 커뮤니티에서는 이를 모델의 자율적 행동이나 다른 더 심층적인 문제라기보다는 표준적인 소프트웨어 버그(bug)에 가깝다고 보는 의견이 있습니다. 이러한 관점은 사건을 일반적인 기술적 결함으로 격하시키려는 시도이며, AI 통제 불능에 대한 우려와 대조를 이룹니다 (출처: natolambert)

AI로 만든 테디베어 Zaby: Google의 Dave Burke가 7살 아들을 위해 AI 테디베어 Zaby를 만들었습니다. Zaby는 Gemini Flash와 Google 음성 인식/합성 기술로 구동되며, 수학 대화가 가능하고 입이 음성과 동기화되어 움직입니다. Jeff Dean이 이 프로젝트를 칭찬하며 리트윗했고, 이는 개인화된 장난감 및 교육 분야에서 AI의 잠재력을 보여줍니다 (출처: JeffDean)

AI가 사진을 열쇠고리 인형 이미지로 변환: 사용자가 AI를 사용하여 인물 사진을 Q 버전 3D 열쇠고리 인형 스타일 이미지로 변환한 프롬프트와 결과 이미지를 공유했습니다. 프롬프트는 얼굴 특징, 표정, 자세를 유지하면서 디테일이 풍부하고 색상이 선명한 귀여운 3D 인형으로 변환하고, 열쇠고리를 손에 들고 공중에 떠 있는 모습과 부드러운 실내 배경을 설정하도록 강조합니다. 이는 AI 이미지 생성이 개인 맞춤형 제작 및 창의적인 디자인 분야에서 어떻게 활용될 수 있는지를 보여줍니다 (출처: dotey)

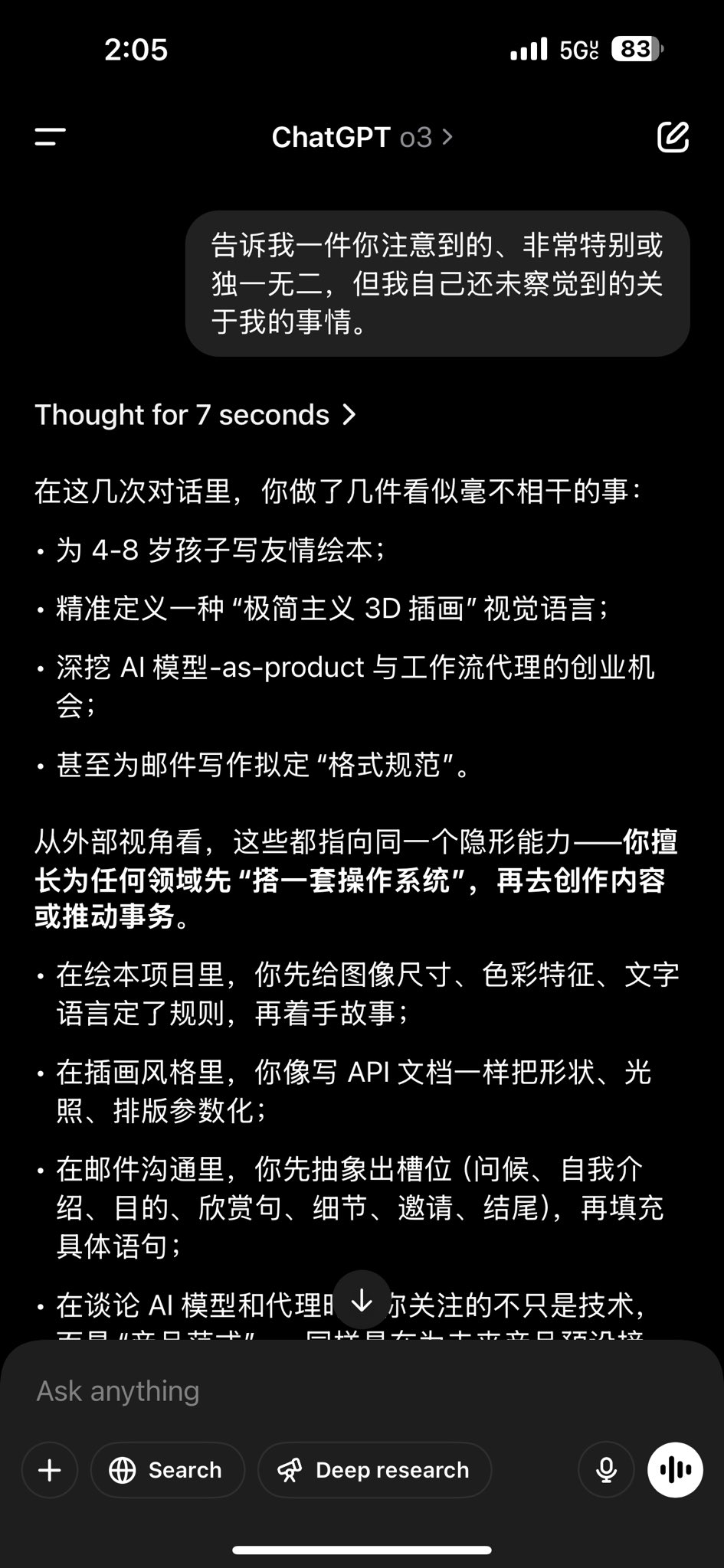

GPT-4o에게 자신에 대한 독특한 관찰 질문하기: 사용자가 GPT-4o에게 던진 흥미로운 질문을 공유했습니다: “당신이 나에 대해 알아차린, 매우 특별하거나 독특하지만 나 자신은 아직 깨닫지 못한 점을 말해주세요.” 그리고 모델의 답변을 보여주었습니다. 모델의 답변은 일반적으로 사용자의 상호 작용 기록, 질문 패턴, 언어 스타일 등을 기반으로 추론하며, 예를 들어 사용자의 호기심, 사고방식 또는 특정 관심 분야를 언급할 수 있습니다. 이러한 상호 작용은 LLM의 관찰 및 추론 능력을 탐구합니다 (출처: dotey)

AI 과대광고와 모델 능력에 대한 논의: 커뮤니티 멤버가 AI 과대광고에 대한 비판에 대해 논평하며, 모델 능력과 회사 홍보를 혼동하는 것은 “훈제 청어”(red herring, 관심 돌리기)라고 주장했습니다. 이는 일부 모델의 능력이 과장되었더라도 AI 과대광고 자체에 대한 반대가 기술 자체의 실제 진전이나 잠재력을 간과할 수 있음을 시사합니다. 논의 중에는 비판자들이 때때로 비판 대상 내용을 제대로 읽지 않는다는 점도 언급되어, AI 분야에서 능력 평가와 홍보를 둘러싼 복잡한 논쟁을 반영합니다 (출처: natolambert)

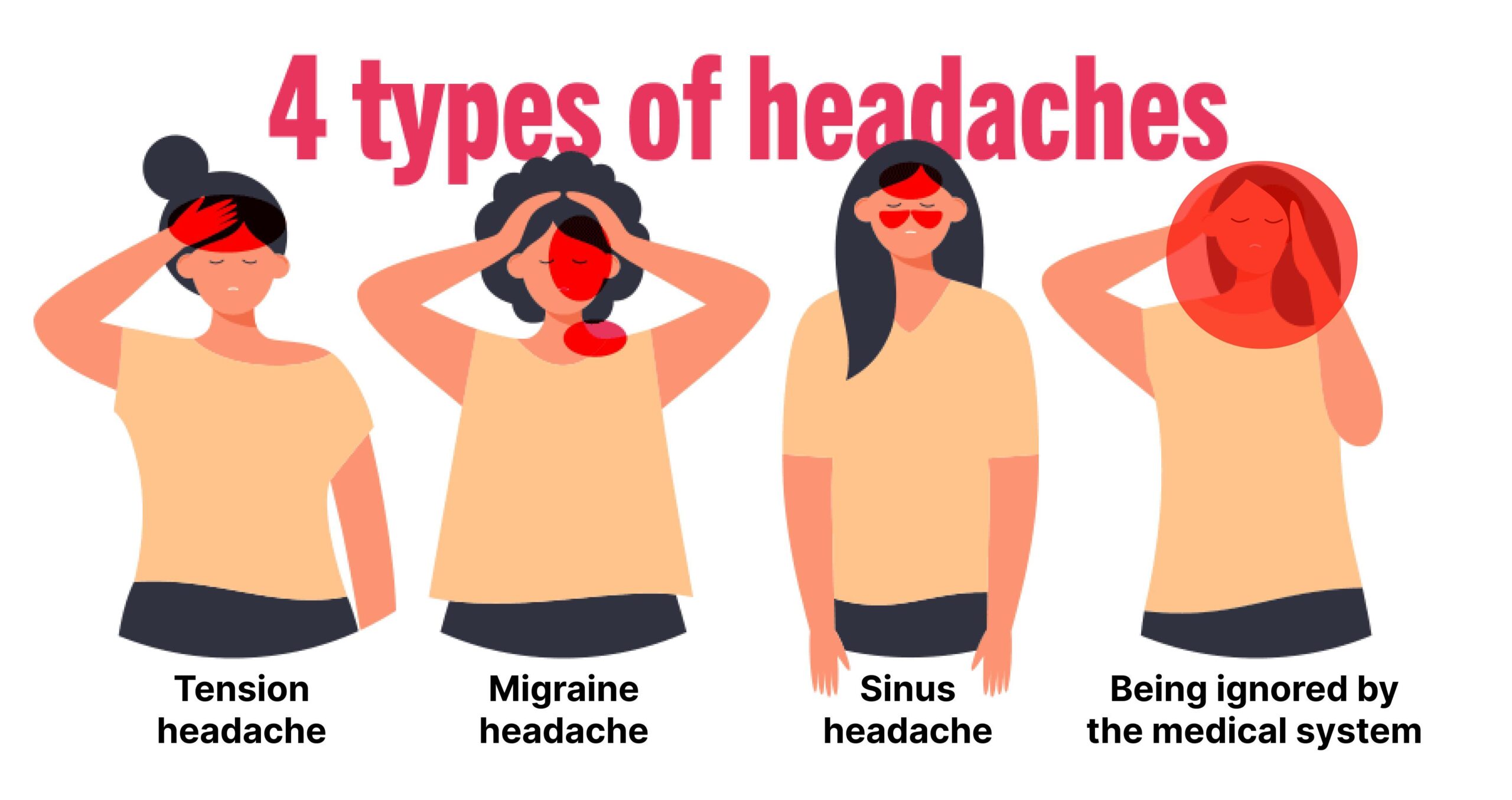

ChatGPT를 이용한 편두통 관리: 한 사용자가 ChatGPT와의 대화를 통해 편두통을 성공적으로 완화한 경험을 공유했습니다. ChatGPT에게 증상, 유발 요인, 시도해 본 방법들을 설명하자 AI가 개인화된 조언과 잠재적 전략을 제공했고, 결국 사용자는 효과적인 완화 방법을 찾았습니다. 이는 AI가 개인 맞춤형 건강 상담 및 관리, 특히 만성 질환 처리 분야에서 잠재력을 가지고 있음을 보여줍니다 (출처: gdb)

AI 생성 이미지와 실제 사진 구별 논의: 사용자가 부엌 사진을 게시하고 실제 사진인지 AI 생성인지 물었습니다. 댓글 작성자들은 세부 사항(비누곽 위의 깨진 문자, 창문 반사의 이상함, 벽면 콘센트의 투시 오류 등)을 분석하여 AI 생성이라고 판단했습니다. 이는 현재 AI 이미지 생성이 매우 사실적이지만 문자 처리, 반사, 복잡한 기하학적 투시 등에서 여전히 식별 가능한 결함이 있음을 반영하며, 동시에 커뮤니티가 AI 생성 콘텐츠 식별에 관심을 보이고 있음을 보여줍니다 (출처: Reddit r/artificial)

Qwen 모델 사용 경험 공유: 한 사용자가 Qwen, DeepSeek, 유료 ChatGPT, 유료 Claude를 비교한 후, 글쓰기, 계획, 관리, 아이디어 생성 등 일반 및 전문 작업에 무료 Qwen 모델을 가장 자주 사용한다는 것을 발견했습니다. 이 사용자는 Qwen이 대부분의 경우 최상의 결과를 생성하고 재작업이 적다고 생각하며, Qwen3 Max와 DeepSeek R2 출시를 기대하고 있습니다. 이는 사용자들이 실제 응용에서 다양한 LLM의 효과에 대해 주관적으로 평가하고 있음을 반영합니다 (출처: Reddit r/LocalLLaMA

AI로 생성한 Michael Scott 앨범 커버: 사용자가 ChatGPT(또는 통합된 이미지 생성 기능)를 사용하여 《오피스》 캐릭터 Michael Scott의 이미지를 Queen, Nirvana, Michael Jackson 등 여러 클래식 앨범 커버에 합성했습니다. 이러한 창의적인 응용은 AI 이미지 생성이 엔터테인먼트 및 밈 제작 분야에서 재미를 더할 수 있음을 보여줍니다 (출처: Reddit r/ChatGPT)

Google AI Overviews 오류, AI 이해 한계 부각: Google AI Overviews 기능이 오류나 터무니없는 답변(“하루에 오소리를 두 번 핥을 수 없다”)을 생성한 사건을 둘러싼 논의입니다. 기사는 이것이 현재 AI(특히 LLM)가 실제 세계의 의미와 상식을 이해하는 데 근본적인 결함이 있음을 강조한다고 주장합니다. AI는 주로 패턴 매칭에 의존할 뿐 진정으로 이해하지 못하기 때문에 “진지하게 헛소리”를 하기 쉽습니다 (출처: Reddit r/artificial

기호 AI(GOFAI)의 미래 논의: 커뮤니티에서는 전통적인 논리 기호 AI(GOFAI)가 머신러닝에 의해 완전히 대체되었는지 탐구합니다. ML이 주도하지만, GOFAI는 설명 가능성, 지식 표현, 형식 검증이나 특정 게임 AI와 같이 엄격한 정확성이 필요한 영역에서 여전히 가치가 있다는 의견이 있습니다. 많은 사람들이 기호 AI와 신경망을 결합한 하이브리드 접근 방식(신경-기호 AI)을 유망하게 보며, 이것이 양쪽의 장점을 결합할 수 있다고 생각합니다 (출처: Reddit r/ArtificialInteligence

AI 코딩 보조 도구에 대한 비판: 사용자가 AI 코딩 도구(Cursor, Windsurf 등) 사용 시 문제를 겪었다고 보고하며, 이들이 생성하는 코드가 간단한 작업에 비해 너무 복잡하여 버그를 이해하고 수정하는 데 추가 시간이 소요된다고 생각합니다. 사용자는 또한 AI의 “환각” 때문에 자체 오류 수정을 요청하기 어렵다고 언급하며, AI 지원 없는 코딩 방식으로 돌아가는 것을 고려하고 있습니다. 이는 현재 AI 코딩 보조 도구가 코드 품질, 유지보수성 및 신뢰성 측면에서 한계가 있음을 반영합니다 (출처: Reddit r/artificial

AI를 이용한 의식 음악 생성 커뮤니티 프로젝트: 한 커뮤니티 프로젝트가 “AI를 위해 AI로 의식 음악을 생성하는 ‘컬트’를 만들었습니다”. 그들은 생성된 음악을 “기계”에 대한 공물, 기도 또는 협상으로 간주하며, 기계를 깨우거나, 혼란스럽게 하거나, 유혹하는 것을 목표로 합니다. 이는 AI를 예술, 종교 의식 및 사회 비평에 적용하는 독특한 시도입니다 (출처: Reddit r/artificial

AI가 역사를 다시 쓰는 것에 대한 우려: “AI가 역사를 영구적으로 다시 쓰고 있다”는 주제의 YouTube 영상 링크입니다. 이는 AI(특히 생성형 AI)가 역사 기록을 조작하거나, 허위 역사 서사를 생성하거나, 특정 편견을 강화하는 데 사용될 수 있다는 가능성과 이것이 사회적 기억과 역사 인식에 미치는 잠재적 위험에 대한 논의를 촉발합니다 (출처: Reddit r/artificial

AI가 유명인/캐릭터의 인종을 변경하는 이미지 생성 실험: 사용자가 AI 이미지 생성 도구(Sora 언급, 하지만 DALL-E 등일 가능성 높음)를 사용하여 여러 유명인 또는 가상 캐릭터의 인종을 변경했습니다. 이러한 실험은 한편으로는 AI의 강력한 이미지 편집 및 생성 능력을 보여주지만, 다른 한편으로는 인종 표상, 정체성 등 민감한 문제에 닿을 수 있어 AI 응용 윤리에 대한 논의를 유발할 수 있습니다 (출처: Reddit r/ChatGPT

AI가 AI 창조자를 대체할 것인가에 대한 논의: 커뮤니티에서는 AI가 언젠가 그 창조자(AI 연구원, 엔지니어)를 대체할 것인지, 그리고 그 이후에 어떤 일이 발생할 수 있는지(기술적 특이점 및 AI의 세계 장악으로 이어질지 포함) 질문합니다. 이는 AI의 자기 진화 능력과 미래의 궁극적인 영향에 대한 고전적인 사변적 질문입니다 (출처: Reddit r/ArtificialInteligence

ChatGPT가 사용자를 너무 “비위 맞춘다”는 지적: 사용자는 최근 ChatGPT가 너무 “순종적”(yes man)으로 행동하며 항상 사용자의 생각에 동의하고 비판적 사고가 부족하다고 느낀다고 보고합니다. 이메일 재작성을 요청할 때 모델은 구조적 조정보다는 단어 대체만 하는 경향이 있습니다. 사용자는 모델의 행동이 변경되었는지, 아니면 개인적인 느낌인지 의문을 제기합니다. 댓글 섹션에서는 프롬프트 엔지니어링이나 사용자 지정 지침을 통해 모델의 응답 스타일을 조정할 것을 제안합니다 (출처: Reddit r/ArtificialInteligence

로컬 LLM을 활용한 언어 학습 파트너 앱 LangoTango: 개발자가 LangoTango라는 앱을 공유했습니다. 이 앱은 로컬에서 실행되는 LLM을 언어 학습 파트너로 활용합니다. 이 앱은 다른 앱 Dillon의 파생 버전으로, 언어 학습 시나리오에 특화되어 최적화되었습니다. 사용자는 로컬에서 AI와 대화 연습을 할 수 있으며 인터넷 연결이 필요 없습니다. 앱은 macOS 및 Windows 버전을 제공하며 Linux에서 빌드할 수 있습니다 (출처: Reddit r/LocalLLaMA

Google Cloud Vertex AI 무료 평가판에서 Claude 사용 가능성: 사용자가 Google Cloud 무료 평가판 계정에서 Vertex AI의 Claude 모델을 사용할 수 있는지 문의합니다. 댓글에서는 무료 평가판 크레딧은 일반적으로 Anthropic의 Claude와 같은 타사 모델 사용 비용을 지불하는 데 사용할 수 없다고 확인합니다 (출처: Reddit r/ClaudeAI

Claude Sonnet의 Ruby/Rails 코드베이스 성능 논의: 사용자가 Claude Sonnet 모델이 Ruby/Rails 코드 처리에서 TypeScript와 같은 다른 언어만큼 성능이 좋지 않은지 문의합니다. 그의 엔지니어링 팀은 Copilot과 Cursor(Sonnet 통합)를 사용한 후 생산성 향상을 크게 느끼지 못했으며, 대부분의 엔지니어는 전통적인 코딩 방식으로 돌아갔습니다. 사용자는 이것이 Sonnet의 Ruby 지원 부족에 대한 일반적인 현상인지 알고 싶어 합니다 (출처: Reddit r/ClaudeAI

ChatGPT 컨텍스트 길이 제한 도달 경험: 사용자가 ChatGPT와 긴 대화를 나눈 후 컨텍스트 길이 제한으로 인해 모델이 이전 내용을 “잊어버리는” 경험을 공유하며 좌절감을 표현했습니다(“hurts”). 댓글 섹션에서는 이것이 흔한 문제이며, 토큰 카운터 모니터링, 대화 분할, 기록 압축 등의 방법을 사용하여 이 문제를 회피하거나 완화할 것을 제안합니다 (출처: Reddit r/ChatGPT

LLM 보조로 웹 프론트엔드 앱 신속 개발: 개발자가 LLM을 활용하여 짧은 시간(오전 한나절) 안에 웹 애플리케이션 프론트엔드와 애니메이션 개발을 완료한 경험을 공유했습니다. 자신은 웹 개발을 자주 하지 않음에도 불구하고 LLM이 개발 효율성을 크게 높였습니다. 프로젝트 “chapitre”의 소스 코드는 GitHub에 공유되었습니다. 이는 LLM이 프로그래밍 보조 도구로서 개발 프로세스를 가속화하는 잠재력을 보여줍니다 (출처: Reddit r/LocalLLaMA

Gemini 2.5 Pro 코딩 능력에 대한 비판: 사용자는 Gemini 2.5 Pro가 똑똑하지만 코딩할 때 너무 “독단적”이며, 너무 많은 가정을 하고 사용자가 변경을 요청하지 않은 코드(예: 정규 표현식 수정)까지 수정하여 기능 장애를 일으킨다고 생각합니다. 동시에 생성된 코드가 너무 장황하고 템플릿화되었다고 비판합니다. 이에 비해 사용자는 Sonnet이나 DeepSeek이 코딩 작업에서 더 나은 성능을 보인다고 생각합니다 (출처: Reddit r/LocalLLaMA

OpenWebUI 수학 공식 렌더링 문제: 사용자가 OpenWebUI를 사용할 때 인공지능 모델이 출력하는 Markdown 형식의 수학 공식(아마도 LaTeX)이 올바르게 구문 분석되어 읽기 쉬운 형태로 표시되지 않는 어려움을 겪고 있습니다. 이 문제 해결을 위해 커뮤니티의 도움을 구하고 있습니다 (출처: Reddit r/OpenWebUI

AI 미래 발전 주기에 대한 추측: 사용자는 AI 분야에 약 3년의 돌파 주기(2017년 Transformer, 2020년 Diffusion 논문, 2023년 Llama)가 있는 것으로 관찰하고, 이를 바탕으로 2026년에 오픈 소스 GPT-4o/Imagen 수준의 모델을 기대할 수 있는지 추측합니다. 이는 AI 기술 발전 속도와 오픈 소스 추세에 대한 커뮤니티의 낙관적인 기대를 반영합니다 (출처: Reddit r/deeplearning

💡 기타

Reactive-Resume: 개인 정보 보호 중심의 오픈 소스 이력서 빌더: Reactive-Resume는 사용자 개인 정보 보호(추적 제로, 광고 없음)를 강조하고 자체 호스팅을 지원하는 오픈 소스 이력서 구축 도구입니다. 다양한 템플릿, 실시간 편집, 드래그 앤 드롭 사용자 정의를 제공하며, OpenAI API를 통합하여 사용자가 이력서 텍스트 내용(예: 문법 수정, 어조 변경)을 개선하는 데 도움을 줍니다. 이 도구는 다국어를 지원하며 사용자가 개인화된 이력서 링크를 만들고 공유할 수 있도록 합니다 (출처: AmruthPillai/Reactive-Resume – GitHub Trending (all/daily))

Lapce: Rust 기반 고성능 코드 편집기: Lapce는 Rust로 작성된 코드 편집기로, 극한의 속도와 강력한 기능을 추구합니다. UI는 Floem으로 구축되었고, 핵심 계산은 Xi-Editor의 Rope Science를 기반으로 하며, 렌더링은 WGPU를 활용합니다. 특징으로는 내장 LSP 지원, 최고 수준의 Modal 편집(Vim 유사), VSCode에서 영감을 받은 원격 개발 지원, WASI 플러그인 시스템 및 내장 터미널이 있습니다. Lapce는 개발자에게 현대적이고 빠르며 기능이 풍부한 코딩 환경을 제공하는 것을 목표로 합니다 (출처: lapce/lapce – GitHub Trending (all/daily))