키워드:AI, TPU, A2A 프로토콜, AI Agent 협업, TPU v7 성능, Gemini 모델 최적화, AI 추론 효율화

“`korean

🔥 포커스

Google, A2A 프로토콜 및 7세대 TPU 발표, AI Agent 및 추론 시대 가속화: Google은 오픈소스 Agent2Agent (A2A) 프로토콜을 출시했습니다. 이는 다양한 공급업체 및 프레임워크 하의 AI Agent 간 안전한 통신 및 협업을 목표로 하며, MCP 프로토콜(MCP는 Agent와 도구를 연결, A2A는 Agent와 Agent를 연결)을 대체하는 것이 아니라 보완합니다. A2A는 기능 발견, 작업 관리, 협업 및 사용자 경험 협상 등의 원칙을 따르며, 이미 50개 이상의 파트너 지원을 확보했습니다. 동시에 Google은 AI 추론에 최적화된 7세대 TPU(Ironwood/TPU v7)를 발표했습니다. FP8 연산 능력은 4614 TFlops, 단일 칩 HBM은 192GB, 대역폭은 7.2 TBps이며, 에너지 효율은 이전 세대의 2배입니다. 최고 사양 클러스터(칩 9216개)의 연산 능력은 42.5 ExaFlops에 달하며, Gemini와 같은 ‘사고형’ 모델 및 차세대 AI Agent 애플리케이션을 지원하는 것을 목표로 합니다. 이는 AI가 반응형에서 능동적으로 통찰력을 생성하는 방향으로 전환되고 있음을 나타냅니다. (출처: 36氪, 36氪, 微信公众号, 微信公众号, 微信公众号, 微信公众号)

MCP, AI Agent 생태계 허브로 부상, Alibaba와 Tencent 전면 수용: 모델 컨텍스트 프로토콜(MCP)은 AI Agent와 외부 도구, 데이터 소스를 연결하는 표준 인터페이스로 빠르게 자리 잡고 있으며, AI 생태계의 ‘USB’로 불립니다. Alibaba Cloud Bailian은 업계 최초의 전체 생명 주기 MCP 서비스를 출시했으며, 함수 컴퓨팅, 200개 이상의 대형 모델 및 50개 이상의 MCP 서비스를 통합하여 5분 만에 Agent를 빠르게 구축할 수 있습니다. Tencent Cloud도 MCP 플러그인 호스팅을 지원하는 ‘AI 개발 키트’를 발표했습니다. MCP는 호스트, 서버 및 클라이언트를 분리하여 반복 개발 비용을 절감하고 AI 도구의 상호 연결성을 향상시키며, 복잡한 Agent 협업 실현에 매우 중요합니다. 생태계 미성숙, 도구 체인 불완전 등 초기 과제에 직면해 있지만, OpenAI, Google, Microsoft, Amazon 및 중국 주요 기업들의 잇따른 지원으로 MCP는 AI 애플리케이션 확산과 산업 발전을 가속화할 것으로 기대됩니다. (출처: 36氪)

AI, 수학 올림피아드에서 획기적인 진전: 제2회 AI 수학 올림피아드(AI Mathematical Olympiad – Progress Prize 2) 결과, AI가 고난도 수학 문제 해결에서 상당한 진전을 보였습니다. 최고의 모델은 새로운 문제로 구성되고, 계산 자원이 제한적(문제당 비용 1달러 미만)이며, 정확한 정수 답(0-999)을 요구하는 테스트에서 50점 만점에 34점을 획득했습니다. 이는 이전 연구에서 인간 평가자들이 LLM이 약 5% 수준에 불과하다고 판단했던 것보다 훨씬 높은 점수입니다. 상대적으로 기본적인 DeepSeek R1 파생 모델조차 50점 만점에 28점을 기록했습니다. 이 결과는 AI의 수학적 추론 능력, 특히 창의적인 문제 해결이 필요한 올림피아드 수준 문제에서의 능력이 단순한 패턴 매칭이나 데이터 암기가 아닌, 빠르게 향상되고 있음을 보여줍니다. (출처: Reddit r/MachineLearning)

SenseTime, 6000억 파라미터 멀티모달 MoE 모델 日日新 SenseNova V6 발표: SenseTime은 6000억 파라미터의 전문가 혼합(MoE) 아키텍처를 채택한 6세대 대형 모델 日日新 SenseNova V6를 출시했습니다. 이 모델은 텍스트, 이미지, 비디오 등 멀티모달 입력을 기본적으로 지원하고 융합 처리합니다. 이 모델은 여러 순수 텍스트 및 멀티모달 벤치마크 테스트에서 우수한 성능을 보여 GPT-4.5 및 Gemini 2.0 Pro를 능가했습니다. 핵심 기능에는 강력한 추론(멀티모달 및 언어 심층 추론에서 o1, Gemini 2.0 flash-thinking 능가), 강력한 상호작용(실시간 오디오/비디오 이해, 감정 표현), 긴 기억력(긴 비디오 분석 지원, 예: 몇 분 길이의 비디오 내용 직접 추론)이 포함됩니다. 주요 기술로는 네이티브 멀티모달 융합 훈련, 멀티모달 긴 사고 사슬 합성(64K 토큰 지원), 멀티모달 혼합 강화 학습(RLHF+RFT), 긴 비디오 통합 표현 및 동적 압축 등이 있습니다. SenseTime은 AI가 일상 애플리케이션에 기여하고 다양한 산업 분야에서 AI 도입을 촉진해야 한다고 강조했습니다. (출처: 微信公众号)

🎯 동향

Google Gemini 2.5 Flash 곧 출시, 효율적인 추론에 중점: Google은 Cloud Next ’25 컨퍼런스에서 Gemini 2.5 Flash 모델을 예고했습니다. 플래그십 모델인 Gemini 2.5 Pro의 경량 버전인 Flash는 빠르고 저렴한 추론 능력을 제공하는 데 중점을 둘 것입니다. 특징은 프롬프트의 복잡성에 따라 추론 깊이를 동적으로 조정하여 간단한 문제에 대한 과도한 계산을 피하는 것입니다. 개발자는 비용을 제어하기 위해 추론 깊이를 사용자 정의할 수 있습니다. 이 모델은 곧 Vertex AI에서 사용 가능할 예정이며, 응답 속도에 민감한 일상 애플리케이션의 요구를 충족시키는 것을 목표로 합니다. (출처: 微信公众号, X)

ByteDance, 강력한 추론 능력의 Seed-Thinking-v1.5 기술 보고서 발표: ByteDance는 강화 학습 기반으로 훈련된 추론 모델 Seed-Thinking-v1.5의 기술 세부 정보를 공개했습니다. 보고서에 따르면 이 모델은 여러 벤치마크 테스트에서 뛰어난 성능을 보였으며, DeepSeek-R1을 능가하고 Gemini-2.5-Pro 및 O3-mini-high 수준에 근접하며 ARC-AGI 테스트에서 40%의 점수를 획득했습니다. 이 모델은 총 2000억 개의 파라미터와 200억 개의 활성 파라미터를 가지고 있습니다. 현재 모델 가중치는 공개되지 않았지만, 우수한 추론 능력과 상대적으로 적은 활성 파라미터 수가 커뮤니티의 주목을 받고 있습니다. (출처: X)

ChatGPT, 모든 과거 대화 참조 가능한 메모리 기능 강화: OpenAI는 ChatGPT의 메모리 기능을 업그레이드하여 모델이 사용자의 모든 과거 채팅 기록을 참조하여 더 개인화된 응답을 제공할 수 있도록 한다고 발표했습니다. 이 강화 기능은 사용자의 선호도와 관심사를 활용하여 글쓰기, 제안, 학습 등 다양한 측면에서 도움을 향상시키는 것을 목표로 합니다. 사용자가 새 대화를 시작할 때 ChatGPT는 자연스럽게 이러한 기억을 활용합니다. 사용자는 여전히 이 기능을 완전히 제어할 수 있으며, 설정에서 기록 참조를 끄거나 메모리 기능을 완전히 비활성화하거나 임시 대화 모드를 사용할 수 있습니다. 이 기능은 Plus 및 Pro 사용자(일부 지역 제외)에게 배포되기 시작했으며 곧 팀, 기업 및 교육 버전 사용자에게도 적용될 예정입니다. (출처: X, X)

OpenAI, GPT-4.5 개발 비하인드 팟캐스트 공개: Sam Altman과 OpenAI 핵심 팀 멤버인 Alex Paino, Dan Selsam, Amin Tootoonchian이 팟캐스트를 녹음하여 GPT-4.5의 연구 개발 과정 및 미래 방향에 대해 논의했습니다. 팀은 GPT-4.5의 개발이 계산 효율성 최적화에서 데이터 효율성 최적화로 전환하는 것을 의미하며, GPT-4보다 10배 높은 지능을 목표로 한다고 밝혔습니다. 팟캐스트에서는 비지도 학습에서의 ‘압축’ 메커니즘의 중요성(솔로모노프 귀납법 근사), 모델 성능의 정확한 평가 및 단순 암기 회피의 필요성을 강조했으며, 기술적 난관 극복 경험과 팀 사기의 중요성을 공유했습니다. (출처: X, X)

Perplexity, Gemini 2.5 Pro 통합, Grok 3 및 WhatsApp 연동 계획: AI 검색 엔진 Perplexity는 Pro 사용자를 위해 Google의 최신 Gemini 2.5 Pro 모델을 통합했다고 발표했으며, 사용자들에게 Sonar, GPT-4o, Claude 3.7 Sonnet, DeepSeek R1, O3 등 다른 모델과 비교해 볼 것을 권장했습니다. 또한 Perplexity CEO Aravind Srinivas는 많은 사용자들의 긍정적인 피드백을 받은 후 Perplexity의 WhatsApp 통합 기능 개발에 착수할 것이라고 확인했습니다. 동시에 Grok 3 모델도 곧 Perplexity 플랫폼에서 지원될 예정입니다. (출처: X, X, X)

Alibaba Qwen3 시리즈 모델 준비 중, 출시는 시간 걸릴 듯: 커뮤니티는 Alibaba의 차세대 Qwen3 시리즈 모델(비공개 버전, Qwen3-8B, Qwen3-MoE-15B-A2B 등 포함)에 대한 기대가 높습니다. 그러나 Qwen 개발자가 소셜 미디어에서 밝힌 바에 따르면, Qwen3의 출시는 “몇 시간 내”가 아니며 준비에 더 많은 시간이 필요합니다. 이는 Alibaba가 차세대 모델을 적극적으로 개발하고 있지만 구체적인 출시 일정은 아직 확정되지 않았음을 시사합니다. (출처: X, Reddit r/LocalLLaMA)

LM Arena에 등장한 미스터리 고성능 모델 “Dragontail”과 “Quasar Alpha” 추측 불러일으켜: LMSYS Chatbot Arena (LM Arena) 플랫폼에 “Dragontail”과 “Quasar Alpha”라는 익명의 모델이 등장했습니다. 이들은 사용자와의 상호작용에서 최상위 모델(예: o3-mini-high, Claude 3.7 Sonnet)과 동등하거나 일부 수학 문제에서는 더 우수한 성능을 보여주었습니다. 커뮤니티에서는 “Dragontail”이 곧 출시될 Qwen3 또는 Gemini 2.5 Flash의 변형일 수 있다고 추측하고 있으며, “Quasar Alpha”는 일부 사용자들이 OpenAI의 o4-mini 시리즈 모델일 것으로 추정하고 있습니다. 이러한 익명 모델의 등장은 최첨단 모델의 시험대이자 성능 평가 플랫폼으로서 모델 아레나의 역할을 반영합니다. (출처: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Moonshot AI Kimi-VL-A3B-Thinking 모델 데모 Hugging Face에 공개: Moonshot AI는 자사의 Kimi-VL-A3B-Thinking 멀티모달 모델의 인터랙티브 데모를 Hugging Face Spaces에 공개했습니다. 이제 사용자는 이 모델을 공개적으로 체험할 수 있습니다. 초기 테스트 결과, 이 모델은 온라인 OCR 및 이미지 인식 능력을 갖추고 있지만, 특정 밈의 유머 코드를 이해하는 등 광범위한 지식 기반이 필요한 일부 작업에서는 모델 규모와 관련된 한계를 보일 수 있습니다. (출처: X, X)

AMD, AI 행사 개최하여 데이터센터 GPU 신제품 발표 예정: AMD는 “Advancing AI 2025″라는 이름의 행사를 개최하여 데이터센터용 신규 GPU를 발표할 계획입니다. 이번 발표는 게임용 그래픽 카드가 아닌 AI 애플리케이션에 초점을 맞출 것입니다. 이는 AMD가 AI 하드웨어 시장에 지속적으로 투자하고 있으며, Nvidia가 주도하는 AI 가속기 분야에서 경쟁하려는 의도를 보여줍니다. (출처: Reddit r/artificial)

🧰 도구

Firecrawl: 웹사이트를 LLM 사용 가능 데이터로 변환하는 오픈소스 도구: Mendable AI가 출시한 Firecrawl은 강력한 오픈소스 도구(TypeScript로 작성)로, 단일 API를 통해 전체 웹사이트를 크롤링하고 스크래핑하여 LLM 준비된 Markdown 또는 구조화된 데이터로 변환하는 것을 목표로 합니다. 프록시, 안티봇 메커니즘, 동적 콘텐츠 렌더링 등의 어려움을 처리할 수 있으며, 사용자 정의 크롤링(예: 태그 제외, 인증 크롤링), 미디어 파싱(PDF, DOCX), 페이지 상호작용(클릭, 스크롤, 입력)을 지원합니다. API, Python/Node/Go/Rust SDK를 제공하며, Langchain, Llama Index, Crew.ai 등 다양한 LLM 프레임워크와 로우코드 플랫폼(Dify, Langflow, Flowise)에 이미 통합되었습니다. Firecrawl은 호스팅 API 서비스 및 로컬에서 실행 가능한 오픈소스 버전을 제공합니다. (출처: GitHub)

KrillinAI: 대형 모델 기반 비디오 번역 및 더빙 도구: KrillinAI는 Go 언어로 작성된 오픈소스 프로젝트로, 대형 언어 모델(LLM)을 활용하여 전문적인 수준의 비디오 번역 및 더빙 서비스를 제공합니다. 원클릭 전체 프로세스 배포를 지원하며, 비디오 다운로드(yt-dlp 및 로컬 업로드 지원), 고정밀 자막 생성(Whisper), 지능형 자막 분할 및 정렬(LLM), 다국어 번역, 용어 대체, AI 더빙 및 음성 복제(CosyVoice), 비디오 합성(가로/세로 화면 자동 조정)까지 전체 워크플로우를 처리할 수 있습니다. YouTube, TikTok, Bilibili 등 플랫폼에 적합한 콘텐츠 생성을 목표로 합니다. 이 프로젝트는 Win/Mac 데스크톱 버전과 비데스크톱 버전(Web UI)을 제공하며 Docker 배포를 지원합니다. (출처: GitHub)

Second Me: 로컬화되고 개인화된 ‘AI 자아’ 구축: Second Me는 로컬에서 실행되는 AI 모델을 사용하여 사용자의 ‘디지털 트윈’ 또는 ‘AI 자아’를 구축하는 것을 목표로 하는 오픈소스 프로젝트입니다. 개인 정보 보호(완전 로컬 실행)와 개인화를 강조하며, 계층적 메모리 모델링(HMM)과 ‘Me-alignment’ 구조를 통해 사용자의 정체성, 기억, 가치관 및 추론 방식을 모방합니다. 이 프로젝트는 Docker 배포(macOS, Windows, Linux) 및 OpenAI 호환 API 인터페이스를 지원하며 MLX 훈련 지원을 모색하고 있습니다. 커뮤니티가 활발하며 WeChat 봇 통합, 다국어 지원 등을 기여했습니다. 비전은 AI를 플랫폼의 부속물이 아닌 사용자 능력의 확장으로 만드는 것입니다. (출처: Reddit r/LocalLLaMA)

EasyControl: DiT 아키텍처 Diffusion 모델에 LoRA 스타일 조건 주입 제공: EasyControl은 DiT(Diffusion Transformer) 아키텍처 기반의 새로운 Diffusion 모델에 성숙한 플러그인(예: LoRA) 지원이 부족한 문제를 해결하기 위해 새로 출시된 오픈소스 프레임워크입니다. 경량의 조건 주입 모듈을 제공하여 사용자가 DiT 모델에 LoRA와 유사한 제어 능력을 쉽게 추가하여 스타일 전송과 같은 작업을 수행할 수 있도록 합니다. 이 프로젝트는 아시아인 얼굴 이미지 100장과 해당 지브리 스타일 이미지(GPT-4o로 생성)를 사용하여 훈련된 모델의 효과를 보여주며, 이미 ComfyUI와의 통합을 지원합니다. (출처: X)

XplainMD: GNN과 LLM을 융합한 생의학 설명 가능 AI 파이프라인: XplainMD는 생의학 지식 그래프를 위해 특별히 설계된 오픈소스 엔드투엔드 AI 파이프라인입니다. 그래프 신경망(R-GCN)을 결합하여 다중 관계 링크 예측(예: 약물-질병, 유전자-표현형 관계)을 수행하고, GNNExplainer를 사용하여 모델 설명 가능성을 구현하며, PyVis를 통해 예측 하위 그래프를 시각화하고, LLaMA 3.1 8B Instruct 모델을 활용하여 예측에 대한 자연어 설명 및 건전성 검사를 수행합니다. 전체 프로세스는 인터랙티브한 Gradio 애플리케이션에 배포되어 예측과 동시에 ‘이유’를 설명함으로써 정밀 의료와 같은 민감한 분야에서 AI의 신뢰성과 유용성을 향상시키는 것을 목표로 합니다. (출처: Reddit r/deeplearning, Reddit r/MachineLearning)

LaMPlace: AI 기반 칩 매크로 셀 레이아웃 최적화 신규 방법: 중국 과학 기술 대학, Huawei Noah’s Ark Lab 및 톈진 대학 연구진은 AI 기반 칩 매크로 셀 레이아웃 최적화 방법인 LaMPlace를 제안했습니다. 이 방법은 구조화된 지표 예측기(로랑 다항식을 사용하여 매크로 간 거리가 WNS/TNS 등 단계 간 지표에 미치는 영향을 모델링)와 학습 가능한 마스크 생성 메커니즘을 통해 레이아웃 초기 단계부터 배치 결정을 유도하여 최종 칩 성능(PPA)을 최적화합니다. LaMPlace는 최적화 목표를 계산하기 쉬운 중간 지표(예: 와이어 길이, 밀도)에서 최종 설계 목표로 이전하여 ‘좌향 최적화’를 실현하고 설계 효율성을 높이는 것을 목표로 합니다. 이 방법은 ICLR 2025 Oral에 선정되었습니다. (출처: 微信公众号)

Google, Agent Development Kit (ADK) 및 Firebase Studio 출시: AI Agent 생태계 추진의 일환으로 Google은 다중 에이전트 시스템 구축을 위한 개발 프레임워크인 Agent Development Kit (ADK)를 출시했습니다. ADK는 다양한 모델 제공업체(Gemini, GPT-4o, Claude, Llama 등)를 지원하며, CLI 도구, Artifact 관리, AgentTool(Agent 간 호출) 등의 기능을 제공하고 Agent Engine 또는 Cloud Run으로의 배포를 지원합니다. 동시에 Google은 Gemini 모델을 통합한 클라우드 기반 AI 프로그래밍 도구인 Firebase Studio도 출시하여 AI 코딩, 컴파일 빌드부터 클라우드 서비스 배포까지 전체 애플리케이션 개발 프로세스를 지원합니다. (출처: 微信公众号, Reddit r/LocalLLaMA)

OpenFOAMGPT: 국산 대형 모델 활용하여 CFD 시뮬레이션 비용 절감: 영국 엑서터 대학과 베이항 대학 팀이 협력하여 OpenFOAMGPT 프로젝트를 업데이트했습니다. 이 프로젝트는 사용자가 자연어를 통해 전산 유체 역학(CFD) 시뮬레이션을 구동할 수 있도록 하는 것을 목표로 합니다. 새 버전은 국산 대형 모델인 DeepSeek V3와 Qwen 2.5-Max를 성공적으로 통합하여 GPT-4o/o1과 유사한 성능을 유지하면서 비용을 최대 100배까지 절감할 수 있습니다. 또한 팀은 QwQ-32B 모델을 사용하여 로컬 배포(단일 GPU 환경)를 구현하여 국내 연구자 및 중소기업에게 더 경제적이고 편리한 AI 지원 CFD 솔루션을 제공하고 전문적인 진입 장벽을 낮췄습니다. (출처: 微信公众号)

Slop Forensics Toolkit: LLM 출력 반복 내용 분석 도구: 대형 언어 모델(LLM) 출력에서 과도하게 반복 사용되는 단어와 구문인 ‘slop’을 분석하기 위한 새로운 오픈소스 툴킷이 출시되었습니다. 이 도구는 문체 분석을 활용하여 인간의 글쓰기에 비해 더 자주 나타나는 어휘와 n-그램을 식별하고 모델의 ‘slop profile’을 구축합니다. 또한 생물정보학 방법을 차용하여 어휘 특징을 ‘돌연변이’로 간주하고 서로 다른 모델 간의 유사성 트리를 추론합니다. 이 도구는 연구자들이 다양한 LLM의 생성 특성과 잠재적인 데이터 오염 또는 훈련 편향을 이해하고 비교하는 데 도움을 주는 것을 목표로 합니다. (출처: Reddit r/MachineLearning)

vLLM 추론 프레임워크, Google TPU 지원 추가: 인기 있는 오픈소스 대형 모델 추론 및 서비스 프레임워크인 vLLM이 Google TPU 지원을 추가했다고 발표했습니다. Google의 최신 7세대 TPU(Ironwood) 출시와 결합하여, 이 업데이트는 개발자가 vLLM을 활용하여 Google의 고성능 AI 하드웨어에서 효율적인 모델 추론 및 배포를 수행할 수 있음을 의미합니다. 이는 TPU의 소프트웨어 생태계를 확장하고 사용자에게 더 많은 하드웨어 선택권을 제공하는 데 도움이 됩니다. (출처: X)

📚 학습

홍콩 중문대, 칭화대 등 SICOG 프레임워크 제안, 대형 모델 자가 진화 새로운 경로 탐색: 대형 모델의 고품질 사전 훈련 데이터 의존성 및 데이터 자원 고갈 문제에 대응하여 홍콩 중문대, 칭화대 등 기관은 SICOG(Self-Improving Systematic Cognition) 프레임워크를 제안했습니다. 이 프레임워크는 ‘후훈련 강화-추론 최적화-재사전훈련 강화’의 삼위일체 자가 진화 메커니즘을 구축하여, ‘연쇄 기술(CoD)’을 통해 구조화된 시각적 인식을 향상시키고, ‘구조화된 사고 사슬(CoT)’로 멀티모달 추론을 강화하며, 자가 생성 데이터 폐쇄 루프 및 일관성 필터링을 활용하여 인공적인 주석 없이 모델의 인지 능력을 지속적으로 향상시킵니다. 실험 결과, SICOG는 여러 작업에서 모델 성능을 현저히 향상시키고 환각을 줄이며 우수한 확장성을 보여, 사전 훈련 병목 현상 해결 및 자율 학습형 AI로 나아가는 새로운 방향을 제시했습니다. (출처: 微信公众号)

OpenAI, AI Agent 웹 브라우징 능력 평가 위한 BrowseComp 벤치마크 오픈소스 공개: OpenAI는 BrowseComp(Browsing Competition) 벤치마크 테스트를 발표하고 오픈소스로 공개했습니다. 이 벤치마크는 AI Agent가 인터넷을 탐색하여 찾기 어려운 정보를 찾는 능력을 평가하는 것을 목표로 하며, Agent를 위한 온라인 보물찾기 게임과 유사합니다. OpenAI는 이러한 유형의 테스트가 에이전트가 심층적인 연구 스타일의 브라우징을 수행하는 핵심 능력을 포착할 수 있으며, 고급 웹 브라우징 Agent의 지능 수준을 평가하는 데 중요하다고 생각합니다. (출처: X, X)

연구 결과, 추론 모델이 OOD 코딩 작업에서 일반화 능력 더 강해: 새로운 연구(arXiv:2504.05518v1)는 코딩 작업 실험을 통해 추론 모델과 비추론 모델의 일반화 능력을 비교했습니다. 결과에 따르면, 추론 모델은 분포 내(in-distribution) 작업에서 분포 외(out-of-distribution, OOD) 작업으로 전환될 때 성능이 크게 저하되지 않았지만, 비추론 모델은 성능 저하를 보였습니다. 이는 추론 모델이 단순한 패턴 매처가 아니라 훈련 분포 밖의 작업까지 학습하고 일반화할 수 있으며, 더 강력한 추상화 및 적용 능력을 가지고 있음을 시사합니다. (출처: Reddit r/ArtificialInteligence)

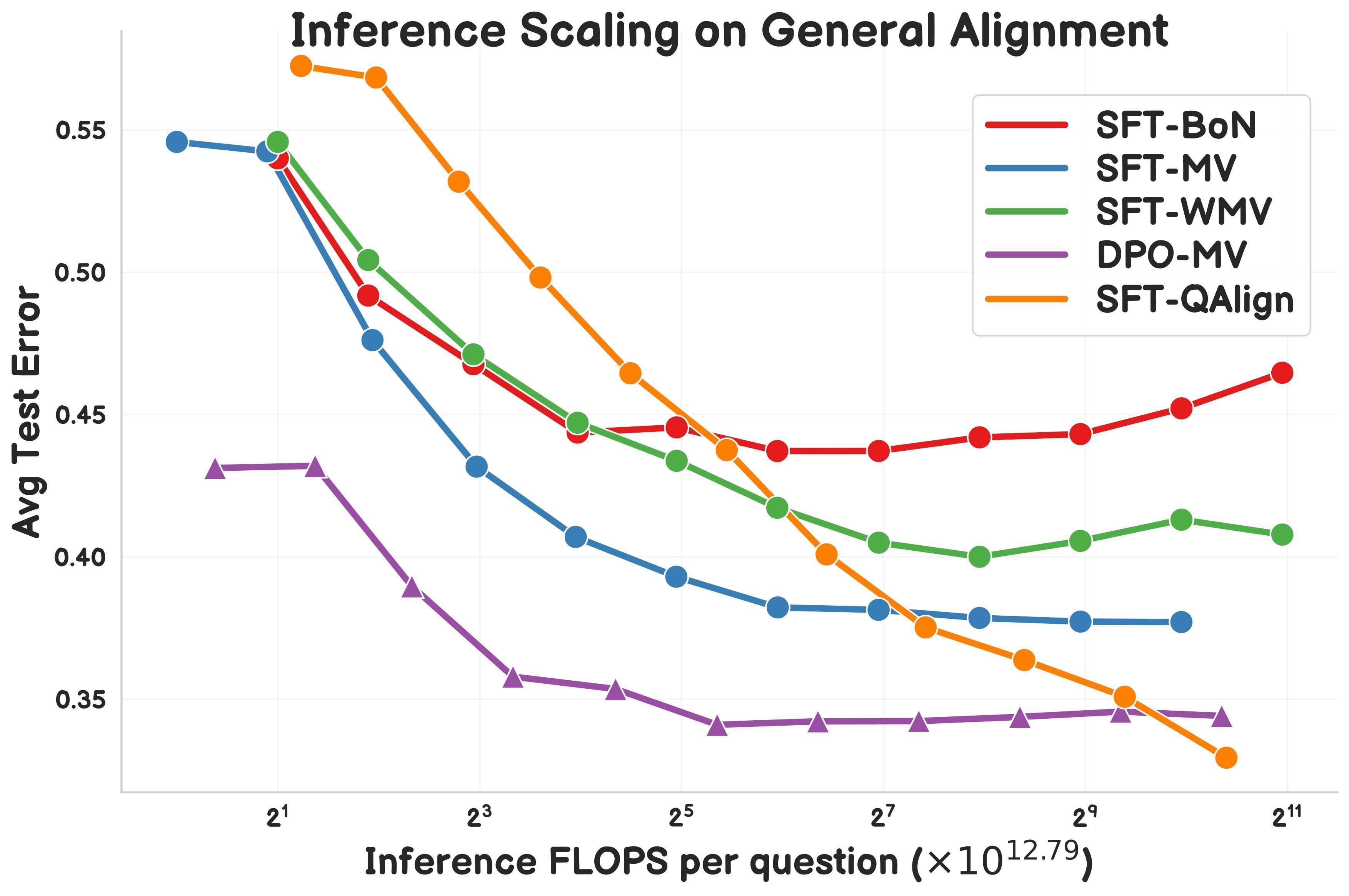

연구, MCMC 기반 테스트 시점 정렬 방법 QAlign 제안: Gonçalo Faria 등은 모델 재훈련 없이 언어 모델 성능을 향상시키기 위해 마르코프 연쇄 몬테카를로(MCMC)를 사용하는 새로운 테스트 시점 정렬(test-time alignment) 방법인 QAlign을 제안했습니다. 연구에 따르면 QAlign은 (동일한 추론 계산량 하에서) DPO(Direct Preference Optimization) 튜닝된 모델보다 성능이 우수하며, 전통적인 Best-of-N 샘플링(보상 모델 과적합 경향) 및 다수결 투표(독특한 답변 발견 불가)의 한계를 극복할 수 있어 고품질 데이터 생성 등의 시나리오에 활용될 가능성이 있습니다. (출처: X)

Yann LeCun, 자기회귀 LLM의 한계 재차 강조: 최근 강연에서 Meta 수석 AI 과학자 Yann LeCun은 현재 주류인 자기회귀(Auto-Regressive) 대형 언어 모델 아키텍처의 한계에 대한 자신의 견해를 재차 강조하며, 그 방식이 “실패할 운명”(doomed)이라고 주장했습니다. 그는 이러한 단어별 예측 방식이 모델이 진정한 계획 및 심층 추론을 수행하는 능력을 제한한다고 생각합니다. 자기회귀 모델이 현재 SOTA이지만, LeCun과 같은 연구자들은 인간 지능에 더 가까운 AI 시스템을 구현하기 위해 결합 임베딩 예측 아키텍처(JEPA)와 같은 대안을 적극적으로 탐색하고 있습니다. (출처: Reddit r/MachineLearning)

LlamaIndex, Google Cloud와 결합하여 보고서 생성 Agent 구축 시연: LlamaIndex 창립자 Jerry Liu는 Google Cloud Next ’25에서 LlamaIndex 워크플로우와 Google Cloud 데이터베이스(예: BigQuery, AlloyDB)를 결합하여 보고서 생성 Agent를 구축하는 방법을 시연했습니다. 이 Agent는 SOP 문서(LlamaParse 사용), 튜토리얼 데이터베이스, 법률 데이터 등을 분석하여 신입 사원을 위한 개인화된 온보딩 가이드라인을 생성할 수 있습니다. 이는 지식 기반 Agent 아키텍처가 강력한 데이터 접근 및 처리 능력을 필요로 함을 보여주며, 이러한 Agent 애플리케이션 구축에서 LlamaIndex의 역할을 보여줍니다. (출처: X)

연구자, Symbolic Compression 엔진 및 .sym 파일 형식 공유: 한 독립 연구자가 Symbolic Compression이라는 엔진과 해당 .sym 파일 형식을 오픈소스로 공개했습니다. 이 프로젝트는 원시 데이터를 압축하는 것이 아니라, 순서열(예: 소수, 피보나치 수열) 이면의 재귀 규칙과 구조적 논리(자신이 제안한 Miller’s Law: κ(x) = ((ψ(x) – x)/x)² 기반)를 추출하여 압축할 수 있다고 주장합니다. 구조 자체의 출현을 저장하고 예측하며, 재귀 논리를 위한 JSON과 유사한 형식을 제공하는 것을 목표로 합니다. 프로젝트에는 CLI 도구와 다중 영역 압축 기능이 포함되어 있습니다. (출처: Reddit r/MachineLearning)

💼 비즈니스

Grok-3 API 가격 공개, 최저 0.3달러/백만 토큰: xAI는 Grok 3 시리즈 API를 공식적으로 대중에게 공개하며 다단계 가격 정책을 채택했습니다. Grok 3 (Beta)는 기업용 애플리케이션을 대상으로 하며, 입력 가격은 백만 토큰당 3달러, 출력 가격은 백만 토큰당 15달러입니다. 경량 버전인 Grok 3 Mini (Beta)는 입력 가격이 백만 토큰당 0.3달러, 출력 가격이 백만 토큰당 0.5달러입니다. 두 버전 모두 더 높은 가격의 빠른 응답 버전(fast-beta)을 제공합니다. 이 가격 정책은 Google Gemini 2.5 Pro, Anthropic Claude Max 플랜(최저 100달러), Meta Llama 4 Maverick(약 백만 토큰당 0.36달러) 등 모델과 비용 경쟁을 형성합니다. (출처: 微信公众号)

스탠포드 AI 보고서: Alibaba AI 역량 세계 3위, 미중 격차 축소: 스탠포드 대학의 최신 ‘2025년 인공지능 지수 보고서’에 따르면, 전 세계 주요 대형 모델 기여도에서 Google과 OpenAI가 각각 7개로 공동 1위를 차지했으며, Alibaba는 6개(Qwen 시리즈)로 세계 3위, 중국 1위를 기록했습니다. 보고서는 미중 모델 성능 격차가 현저히 축소되어 2023년 말 17.5%포인트(MMLU 벤치마크 기준)에서 2024년 말 0.3%포인트로 줄었다고 지적했습니다. Alibaba Qwen 모델 제품군(이미 200개 이상 오픈소스 공개)은 세계 최대의 오픈소스 모델 시리즈가 되었으며, 파생 모델은 10만 개가 넘습니다. 보고서는 또한 중국 최고 모델(예: Qwen2.5, DeepSeek-V3)이 훈련 연산 능력 요구 사항에서 미국 동급 모델보다 일반적으로 낮아 더 높은 효율성을 보인다고 언급했습니다. (출처: 微信公众号)

중국 의료 AI 기업, 관세 및 기술 장벽 속 돌파구 모색: 미국의 관세 인상과 기술 독점(예: GPS 거대 기업의 영상 데이터 인터페이스 장악) 등 다중 압력에 직면하여 중국 의료 기술 기업들은 국산화 대체와 지능화 전환을 가속화하고 있습니다. United Imaging Healthcare는 핵심 기술 자체 개발을 고수하며 5.0T MRI 등 고급 장비를 출시하고 의료 대형 모델 및 지능체를 개발합니다. Mindray Medical은 ‘장비+IT+AI’ 전략을 통해 디지털 지능 생태계(예: DeepSeek을 통합한 瑞影云++ 플랫폼)를 구축하고 국제 시장을 심층 공략합니다. Diasia Biomedical Technology는 iMedImage® 의학 영상 대형 모델로 정밀 의료 분야에 진입하고 산업 표준 제정에 참여하여 차별화된 경쟁을 실현합니다. 이들 기업은 AI를 동력으로 삼아 핵심 기술, 공급망 및 임상 수용성 측면에서 돌파구를 마련하고 시장 구도를 재편하려 노력하고 있습니다. (출처: 微信公众号)

🌟 커뮤니티

교육 분야에서의 AI 활용 논의 활발: 커뮤니티에서는 인공지능(AI)이 맞춤형 학습 계획을 통해 교육을 어떻게 변화시킬 수 있는지에 대한 논의가 활발합니다. AI는 학생의 개인적인 요구, 학습 속도 및 스타일에 따라 교육 내용과 방법을 조정하여 개인화된 교육을 실현하고 학습 효율성과 효과를 높일 잠재력을 가지고 있습니다. (출처: X)

Cursor 편집기 이면의 복잡한 엔지니어링 주목: 커뮤니티에서는 AI 코드 편집기 Cursor의 구현이 쉽지 않다는 점을 언급했습니다. 핵심 목표는 사용자가 코드를 수동으로 복사하여 붙여넣는 것을 피하는 것이며, 이를 위해 새로운 코드 편집 패러다임 발명, 자체 개발한 빠른 편집 모델 FastApply 및 코드 완성 예측 모델 Fusion, 컨텍스트 처리를 최적화하기 위한 로컬 및 서버 측 2단계 RAG 구현 등 대규모 사용자 경험 최적화 및 엔지니어링 혁신을 수행했습니다. 이러한 노력은 원활한 AI 프로그래밍 경험 구축에 필요한 기술적 깊이를 보여줍니다. (출처: X)

AI 부정행위 도구, 윤리 및 채용 시스템 논란 촉발: 콜롬비아 대학생 Roy Lee가 AI 도구 “Interview Coder”를 개발하여 프로그래밍 면접에서 부정행위를 저질러 여러 최고 기업의 오퍼를 받은 후 학교에서 퇴학당했으며, 이후 해당 도구를 판매하여 50일 만에 220만 달러를 벌었습니다. 이 도구는 은밀하게 실행되며 인간의 코딩 스타일을 모방하여 답을 생성할 수 있습니다. 이 사건은 광범위한 논의를 불러일으켰습니다. 한편으로는 많은 개발자들이 경직되고 현실과 동떨어진 프로그래밍 면접(예: LeetCode 문제 풀이)에 불만을 느끼고 있습니다. 다른 한편으로는 AI 부정행위 현상이 급증(비율이 2%에서 10%로 증가했다는 보고 있음)하면서 기존 기술 면접의 유효성에 도전하고 있으며, 기업들이 채용 시스템을 재편하도록 강요할 수 있고 AI 시대에 무엇이 ‘부정행위’인지에 대한 윤리적 경계 논의를 촉발하고 있습니다. (출처: 36氪)

범용 Agent 혁신 애플리케이션 등장: 최근 Agent 해커톤 대회(예: flowith, openmanus)에서 많은 혁신적인 애플리케이션이 등장했습니다. 개발 디자인 분야: Agent는 UI 스케치를 기반으로 프론트엔드/백엔드 코드와 데이터베이스 구조를 포함한 완전한 프로젝트(maxcode)를 자동으로 생성하거나, 정보를 자율적으로 수집하고 스타일을 결정하여 개인 웹사이트를 생성할 수 있습니다. 분석 결정 분야: Agent는 항공편의 최적 오로라 관측 위치를 계산하거나, 자체 반복적인 양적 거래 전략 최적화(一鹿向北)를 수행할 수 있습니다. 개인화 서비스 분야: Agent는 모임 장소를 지능적으로 추천(Jarvis-CafeMeet)하거나, Douban 데이터를 분석하여 ‘취향 보고서’를 생성하거나, 음성 상호작용을 통해 노인 사용자에게 서비스를 제공(老奶奶教你用OpenManus)할 수 있습니다. 예술 창작 분야: Agent는 특정 스타일의 디지털 아트를 생성하고, 음악에 맞춰 춤을 생성하고, 그림 브러시를 맞춤 설정하고, 실시간으로 프로그래밍 가능한 음악(strudel-manus)을 생성하는 등 다양한 작업을 수행할 수 있습니다. 이러한 사례들은 다양한 분야에서 Agent의 엄청난 잠재력을 보여줍니다. (출처: 微信公众号)

Andrew Ng, 미국 관세가 AI 발전에 미치는 영향에 대해 논평: Andrew Ng는 미국이 광범위하게 고액 관세를 부과하는 것에 대해 우려를 표명하며, 이것이 동맹 관계를 손상시키고, 글로벌 경제를 저해하며, 인플레이션을 유발하고, AI 발전에 부정적인 영향을 미칠 것이라고 주장했습니다. 그는 사상과 소프트웨어(특히 오픈소스 소프트웨어)의 자유로운 이동은 큰 영향을 받지 않을 수 있지만, 관세는 AI 하드웨어(예: 서버, 냉각, 네트워크 장비) 확보를 제한하고 데이터 센터 건설 비용을 증가시키며, 전력 장비 수입에 영향을 미쳐 간접적으로 연산 능력 공급에 영향을 미칠 것이라고 지적했습니다. 관세가 국내 로봇 및 자동화 수요를 약간 자극할 수 있지만, 이는 제조업의 단점을 보완하기 어렵다고 덧붙였습니다. 그는 AI 커뮤니티가 국제 협력과 교류를 유지할 것을 촉구했습니다. (출처: X)

커뮤니티, 정신 건강 지원에서의 AI 활용 열띤 토론: 점점 더 많은 사용자들이 ChatGPT와 같은 AI 도구를 사용하여 심리 상담 및 정서적 지원을 받은 경험을 공유하고 있습니다. 많은 사람들은 AI가 털어놓을 수 있는 안전하고 비판단적인 공간을 제공하며, 즉각적인 피드백과 유용한 조언을 얻을 수 있고, 어떤 경우에는 인간 치료사보다 더 잘 경청받고 이해받는 느낌을 주어 긍정적인 감정 해소 효과를 낳는다고 말합니다. 사용자들은 AI가 특히 심각한 심리적 문제를 다룰 때 전문 자격증을 가진 치료사를 완전히 대체할 수는 없다는 점에 대체로 동의하지만, 기초적인 지원 제공, 일상적인 스트레스 대처, 개인적인 문제의 초기 탐색 측면에서 엄청난 잠재력을 보여주며 접근성과 저렴한 비용으로 인해 환영받고 있습니다. (출처: Reddit r/ArtificialInteligence, Reddit r/ChatGPT)

AI 번역 콘텐츠의 성격 규정 논란: 커뮤니티에서는 AI(예: ChatGPT)를 사용하여 인간이 창작한 이야기를 번역했을 때, 그 내용을 인간 창작물로 보아야 하는지 AI 창작물로 보아야 하는지에 대한 문제를 논의했습니다. 한 관점은 AI가 번역 도구로만 사용되어 원문의 사상, 구조, 어조를 변경하지 않았다면 내용은 본질적으로 여전히 인간 창작물이라는 것입니다. 그러나 AI 텍스트 탐지기는 텍스트 패턴을 분석하여 이를 AI 생성물로 표시할 수 있습니다. 이는 창작 과정에서 AI의 역할 정의, AI 탐지기의 한계, 번역에서 원문 스타일을 유지하는 방법에 대한 고민을 불러일으켰습니다. (출처: Reddit r/ArtificialInteligence)

사용자, Gemini 2.5 Pro의 긴 컨텍스트 처리 문제 피드백: 사용자 Nathan Lambert는 Gemini 2.5 Pro를 테스트하던 중 매우 긴 컨텍스트 입력 쿼리를 처리할 때 모델이 연결 오류를 겪는 것을 발견했습니다. 관찰된 현상은 모델이 추론 과정에서 거의 모든 입력 토큰을 다시 생성하는 것처럼 보이며, 이로 인해 추론 비용이 극도로 높아지고 결국 실패한다는 것입니다. 또한 그는 오류 발생 시 Gemini 채팅 기록을 공유할 수 없다고 지적했습니다. 이러한 피드백은 현재 모델이 초장문 컨텍스트를 처리할 때 발생할 수 있는 안정성 및 효율성 문제를 지적합니다. (출처: X)

커뮤니티, Llama 4 출시에 부정적 반응, 성능 및 개방성 의문 제기: Meta가 출시한 Llama 4 시리즈 모델은 커뮤니티에서 광범위한 논의와 부정적인 평가를 불러일으켰습니다. 사용자들은 Maverick 모델이 최대 1천만 토큰의 컨텍스트 창을 가지고 있고 함수 호출 측면에서 괜찮은 성능을 보이지만, 400B의 총 파라미터 수(17B 활성 파라미터)가 기대했던 추론 성능 향상을 가져오지 못했으며 심지어 QwQ 32B와 같은 모델보다 못하다는 의견이 지배적입니다. 또한 제한적인 라이선스, 기술 논문 및 시스템 카드 부재, LMSYS 등 벤치마크에서 ‘점수 부풀리기’ 의혹 등은 Meta의 오픈소스 커뮤니티 내 평판을 손상시켰습니다. 커뮤니티는 Meta가 Llama 3의 개방성과 선도적 지위를 이어가지 못한 것에 실망감을 표했습니다. (출처: Reddit r/LocalLLaMA)

Claude Pro 플랜, 사실상 다운그레이드 지적, 사용자 사용 제한 증가 불만: Anthropic이 더 높은 가격의 Max 플랜(Pro 플랜의 5배 또는 20배 사용량 제공 주장)을 출시함에 따라, 커뮤니티의 많은 Claude Pro 사용자는 Pro 플랜 자체의 사용 제한이 더 엄격해지고 상한선에 더 쉽게 도달한다고 느끼고 있다고 보고했습니다. 사용자들은 Anthropic이 사용자를 Max 플랜으로 업그레이드하도록 유도하기 위해 Pro 플랜의 실제 사용 가능 한도를 낮췄을 수 있다고 추측합니다. 이러한 불투명한 조정과 체감되는 서비스 저하는 특히 Claude 모델 자체에 여전히 컨텍스트 창 기억 문제가 있는 상황에서 사용자 불만을 야기했습니다. (출처: Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

OpenWebUI 커뮤니티 기능 및 문제 논의: OpenWebUI 사용자는 커뮤니티에서 도구의 기능과 겪고 있는 문제에 대해 논의합니다. 한 사용자는 Nextcloud를 추가 클라우드 스토리지 옵션으로 통합할 수 있는지 문의했습니다. 다른 사용자는 지식 베이스 기능을 사용할 때 여러 문서를 업로드하면 LLM이 첫 번째 문서만 참조하는 것 같다고 보고했습니다. 또 다른 사용자는 Gemini 호환 OpenAI API 엔드포인트에 연결하려고 할 때 시간 초과 오류가 발생한다고 보고했습니다. 이러한 논의는 도구의 확장성과 안정성에 대한 사용자의 요구와 우려를 반영합니다. (출처: Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Suno AI 커뮤니티 사용 팁 및 문제 교류: Suno AI 사용자 커뮤니티는 활발하며, 논의 내용은 다음과 같습니다: Cover 기능을 사용할 때 특정 악기(예: 드럼, 키보드)를 제외하여 솔로 악기를 분리하는 방법; 특정 음악 스타일(예: Trip Hop) 생성에 대한 조언 구하기; 친구 초대 기능으로 크레딧을 얻지 못하는 문제 보고; 특정 문구(예: “You’re Dead”)가 저작권 제한을 유발하는지 등 가사 저작권 문제 논의; D&D 캐릭터 배경 음악 제작과 같은 Suno를 활용한 창의적인 응용 사례 공유. (출처: Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI)

💡 기타

AI 생성 ‘우연한 사진’ 탐색: 커뮤니티 사용자는 AI를 사용하여 의도치 않게 촬영된 것처럼 보이거나, 구도가 임의적이거나, 심지어 약간 흐릿하거나 과다 노출된 ‘우연한 사진’을 생성하려고 시도했습니다. 이러한 탐색은 완벽한 이미지를 생성하려는 AI의 경향에 도전하고, 인간 사진 촬영의 우연성과 불완전성을 모방하며, 특정 사진 스타일( ‘나쁜’ 사진 스타일 포함)을 이해하고 모방하는 AI의 능력을 보여줍니다. (출처: Reddit r/ChatGPT)

공급망 관리에서의 AI 적용 잠재력: 인공지능(AI)이 공급망 추적성과 투명성을 향상시키는 데 기여할 잠재력이 강조되었습니다. 머신러닝과 데이터 분석을 활용하여 AI는 기업이 상품 흐름을 더 잘 모니터링하고, 중단 위험을 예측하고, 재고 관리를 최적화하며, 소비자에게 더 신뢰할 수 있는 제품 출처 정보를 제공하는 데 도움을 줄 수 있습니다. (출처: X)

인사 관리에서의 AI 활용 탐색: 커뮤니티에서는 인사 관리에 AI 가상 아바타(Avatars)를 채택할 가능성에 대해 논의했습니다. 이는 초기 면접 심사, 직원 교육, 정책 문의 응답, 심지어 정서적 지원과 같은 작업에 AI를 사용하는 것을 포함할 수 있으며, HR 프로세스 효율성과 직원 경험을 향상시키는 것을 목표로 합니다. (출처: X)

영국 중앙은행, AI가 시장 위기 유발 가능성 경고: 영국 중앙은행은 인공지능 소프트웨어가 시장을 조작하거나 심지어 이익을 위해 의도적으로 시장 위기를 조장하는 데 사용될 수 있다고 경고했습니다. 이는 금융 분야에서 AI 활용에 대한 규제 및 위험 관리 우려를 불러일으켰습니다. (출처: Reddit r/artificial)

AI, 사실적인 3D 형상 생성 신규 방법: MIT 연구원들은 더 사실적인 3차원 형상을 생성할 수 있는 새로운 생성형 AI 방법을 개발했습니다. 이는 제품 디자인, 가상 현실, 게임 개발 및 3D 프린팅과 같은 분야에 중요한 의미를 가지며, 2D 이미지 또는 텍스트 설명에서 복잡한 3D 모델을 생성하는 기술 발전을 촉진합니다. (출처: X)

AI 추론 전력 소비 및 비용 대폭 절감: 새로운 기술 발전으로 AI 추론 작업의 전력 소비(MAC 에너지 소비 기준)가 100배, 비용이 20배 절감되었다는 보고가 있습니다. 이러한 효율성 향상은 엣지 디바이스, 모바일 단말기 및 대규모 클라우드 배포에서 AI 모델의 실행 가능성과 경제성에 매우 중요합니다. (출처: X)

AI가 인간 인지에 미치는 영향에 대한 논의: 커뮤니티에서는 AI에 대한 과도한 의존이 인간 뇌에 미칠 수 있는 영향에 대해 우려하며, 뇌가 “위축되고 준비되지 않을 수 있다”(Atrophied And Unprepared)는 기사 제목을 인용하는 의견도 있습니다. 이는 AI 도구가 보편화된 후 인간의 비판적 사고, 기억력, 문제 해결 능력 등 핵심 인지 기능이 퇴화할 수 있다는 우려를 반영합니다. (출처: X)

미래 AI 주도 작업 방식에 대한 전망과 우려: 커뮤니티에서는 2025년까지 AI가 작업 규칙을 다시 쓰고 현재의 작업 방식이 종식될 수 있다는 기사 관점을 인용하여 논의했습니다. 이는 AI 자동화가 고용 시장에 미치는 영향, 필요한 기술의 변화, 인간-기계 협업의 새로운 방식에 대한 탐색과 우려를 불러일으켰습니다. (출처: X)