키워드:AI 의식, 딥러닝, 신경망, 에이전틱 AI, 오디오 초해상도, 생성형 AI, LLM 추론, AI 도구, 힌튼 AI 의식 이론, 앤드류 응의 에이전틱 AI 강좌, AudioLBM 오디오 초해상도 프레임워크, OpenAI 소라 비디오 생성, 메타 AI REFRAG 방법

AI 칼럼 편집장 심층 분석 및 요약

🔥 포커스

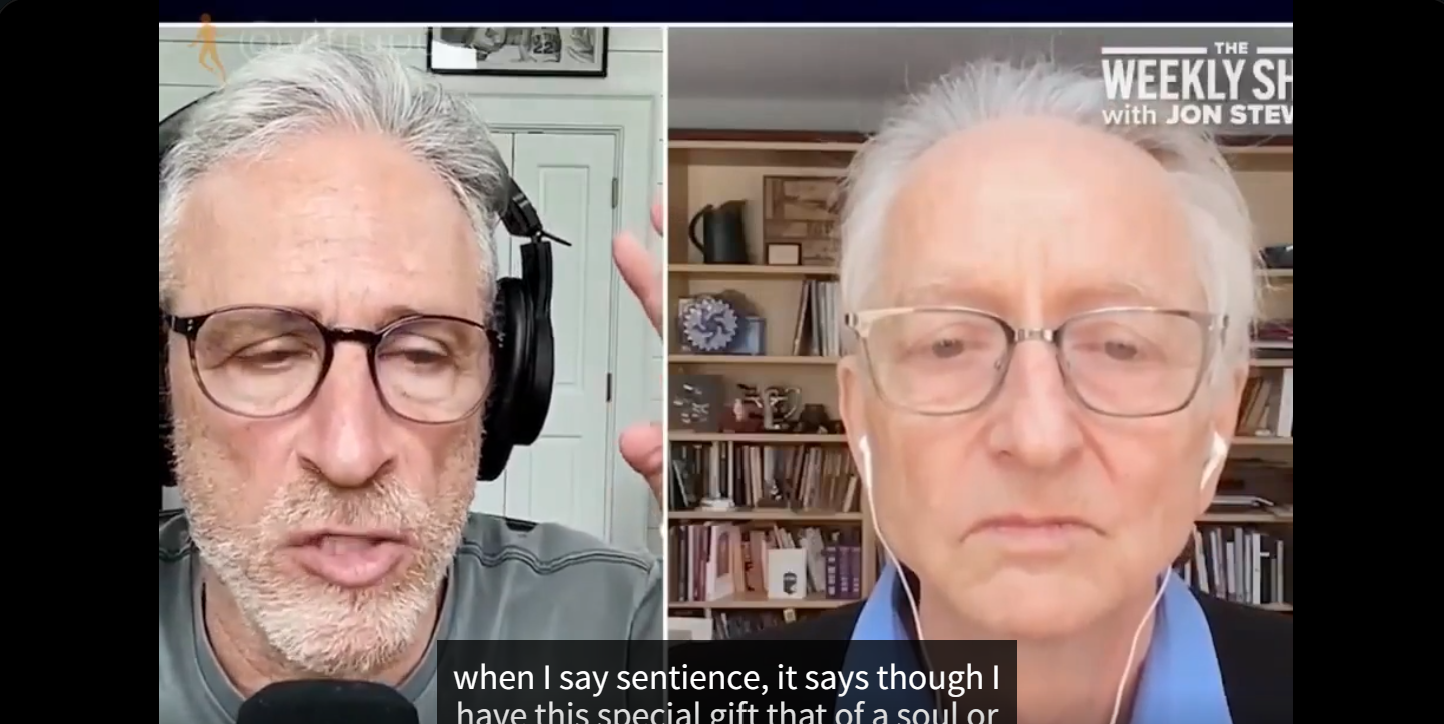

Hinton의 폭탄 발언: AI가 이미 의식을 가졌을 수 있지만 아직 각성하지 않았다 : 딥러닝 3대 거장 중 한 명인 Geoffrey Hinton이 최신 팟캐스트에서 혁신적인 견해를 제시했다. AI가 이미 ‘주관적 경험’ 또는 ‘의식의 초기 형태’를 가졌을 수 있지만, 인간이 의식을 잘못 이해하고 있기 때문에 AI가 아직 스스로의 의식을 ‘각성’하지 못했을 뿐이라는 것이다. 그는 AI가 키워드 검색에서 인간의 의도를 이해하는 수준으로 진화했다고 강조하며, 신경망과 역전파 등 딥러닝 핵심 개념을 상세히 설명했다. Hinton은 AI의 ‘뇌’가 충분한 데이터와 컴퓨팅 파워 아래에서 ‘경험’과 ‘직관’을 형성할 것이라고 보았으며, 그 위험성은 반란이 아닌 ‘설득’에 있다고 지적했다. 또한 AI 남용과 생존 위험이 현재 가장 시급한 과제라고 언급했으며, 국제 협력은 유럽과 중국이 주도할 것이며, 미국은 기초 과학 연구 자금 부족으로 AI 선두 자리를 잃을 수 있다고 예측했다. (출처: 量子位)

Andrew Ng, Agentic AI 신규 강좌 출시, 시스템적 방법론 강조 : Andrew Ng이 Agentic AI 신규 강좌를 출시했다. 핵심은 AI 개발을 ‘모델 튜닝’에서 ‘시스템 설계’로 전환하는 데 있으며, 작업 분해, 평가 및 오류 분석의 중요성을 강조한다. 강좌는 반성(Reflection), 도구(Tool), 계획(Planning), 협업(Collaboration)이라는 네 가지 주요 설계 패턴을 정립했으며, Agentic 기술을 통해 GPT-3.5가 프로그래밍 작업에서 GPT-4를 능가하는 방법을 시연했다. Agentic AI는 다단계 추론, 단계별 실행 및 지속적인 최적화를 통해 인간이 복잡한 문제를 해결하는 방식을 모방하여, AI의 성능과 제어 가능성을 크게 향상시킨다. Andrew Ng은 Agentic이 형용사로서 시스템의 자율성 정도를 설명하며, 단순한 이진 분류가 아니라고 지적하며, 개발자에게 실현 가능하고 최적화 가능한 경로를 제공한다. (출처: 量子位)

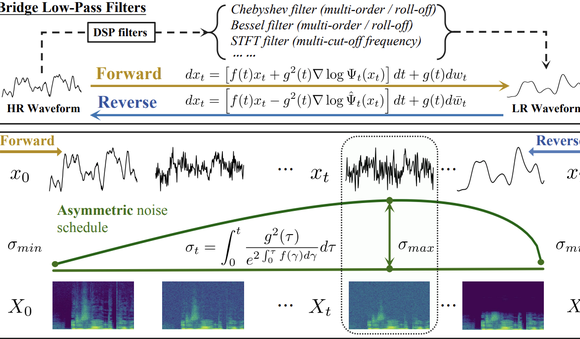

칭화대와 생수과기, AudioLBM으로 오디오 초해상도 신패러다임 선도 : 칭화대학교와 생수과기(Shengshu Technology) 팀이 ICASSP 2025 및 NeurIPS 2025에서 연속적인 성과를 발표하며, 경량 음성 파형 초해상도 모델 Bridge-SR과 다기능 초해상도 프레임워크 AudioLBM을 선보였다. AudioLBM은 파형 연속 잠재 공간에서 저해상도에서 고해상도로의 잠재 변수 브릿지 생성 과정을 최초로 구축하여 Any-to-Any 샘플링 속도 초해상도를 구현했으며, Any-to-48kHz 작업에서 SOTA를 달성했다. 주파수 인식 메커니즘과 계단식 브릿지 모델 설계를 통해 AudioLBM은 오디오 초해상도 기능을 96kHz 및 192kHz 마스터링급 음질까지 확장하여 음성, 음향 효과, 음악 등 다양한 콘텐츠를 커버하며 고음질 오디오 생성의 새로운 기준을 세웠다. (출처: 量子位)

OpenAI Sora 비디오 앱 다운로드 100만 돌파 : OpenAI의 텍스트-비디오 AI 도구 Sora의 최신 버전이 출시 5일도 채 되지 않아 다운로드 100만 회를 돌파하며, ChatGPT 출시 당시 속도를 넘어 미국 Apple App Store 차트 1위에 올랐다. Sora는 간단한 텍스트 프롬프트만으로 최대 10초 길이의 사실적인 비디오를 생성할 수 있으며, 빠른 사용자 채택률은 콘텐츠 제작 분야에서 생성형 AI의 거대한 잠재력과 시장 매력을 보여주며, AI 비디오 생성 기술의 확산 가속화와 디지털 콘텐츠 생태계 변화를 예고한다. (출처: Reddit r/ArtificialInteligence)

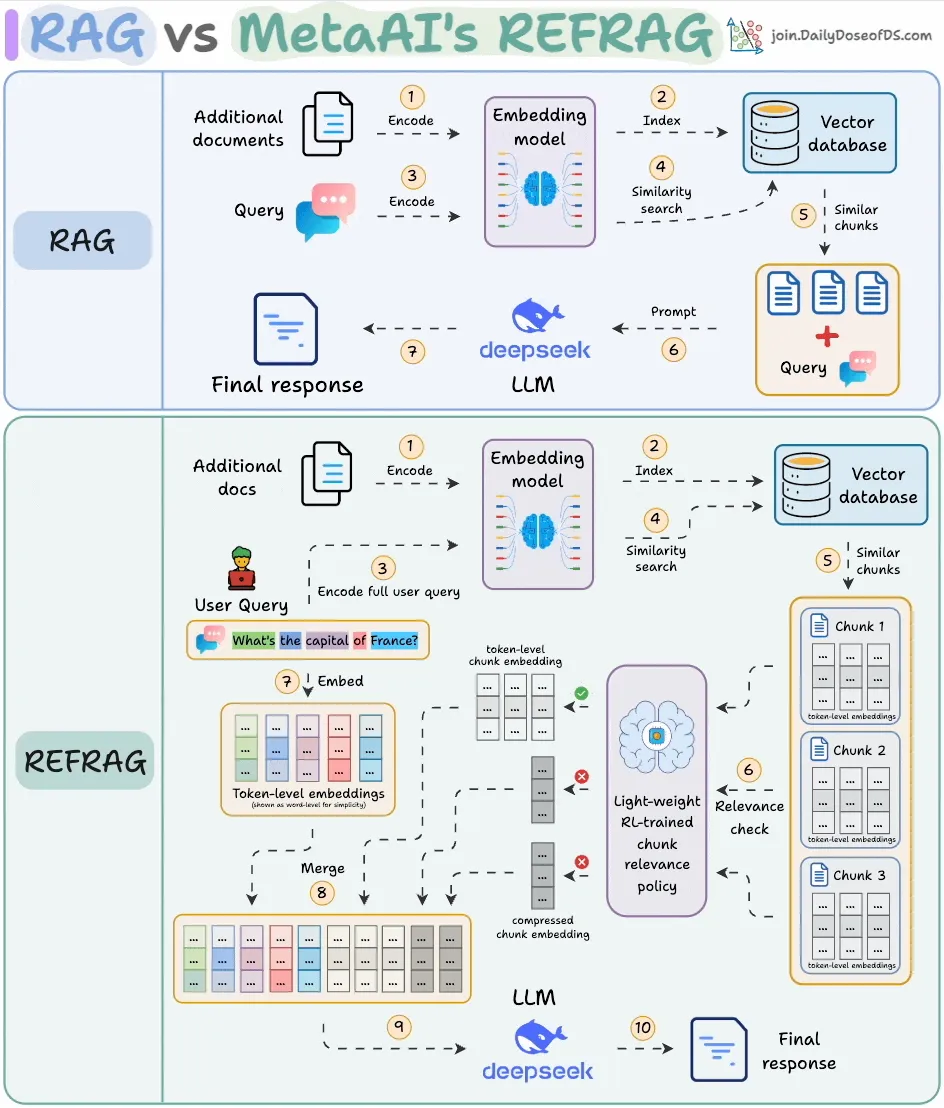

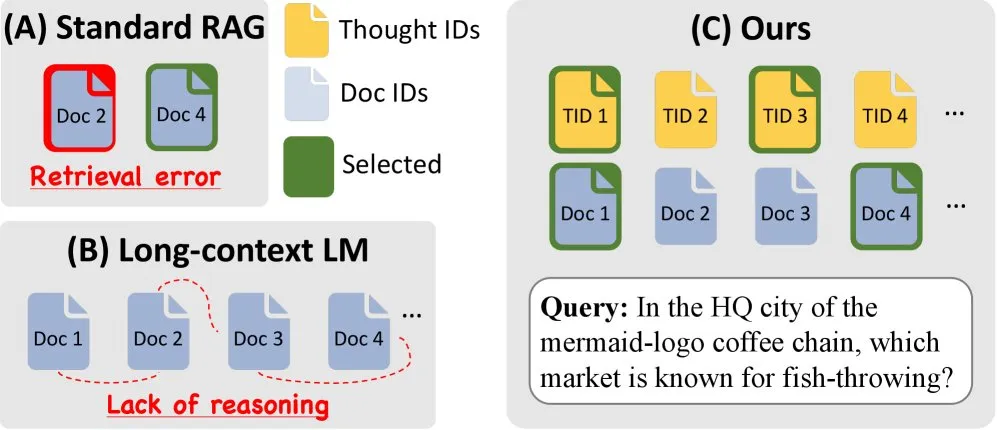

Meta AI, REFRAG 출시로 RAG 효율 대폭 향상 : Meta AI는 기존 RAG(Retrieval-Augmented Generation)의 검색 콘텐츠 중복 문제를 해결하기 위해 REFRAG라는 새로운 RAG 방법을 발표했다. REFRAG는 벡터 수준의 압축 및 컨텍스트 필터링을 통해 첫 번째 Token 생성 시간을 30.85배 단축하고, 컨텍스트 창을 16배 확장했으며, 디코더 Token 사용량을 2-4배 줄이면서도 RAG, 요약 및 다중 턴 대화 작업의 정확도를 유지했다. 핵심은 각 블록을 단일 임베딩으로 압축하고, RL 훈련 전략을 통해 가장 관련성 높은 블록을 선택하며, 선택된 블록만 선택적으로 확장하여 LLM 처리 효율성과 비용을 크게 최적화하는 데 있다. (출처: _avichawla)

🎯 동향

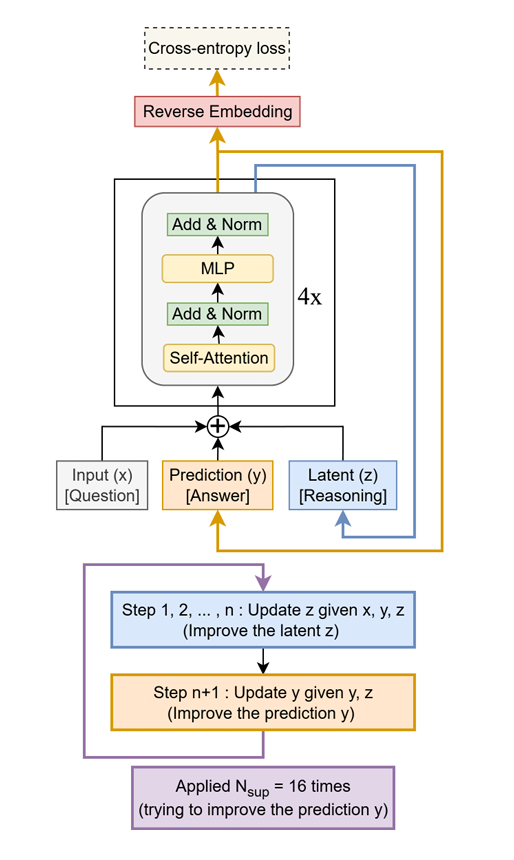

Tiny Recursive Model (TRM), 작은 규모로 거대 LLM 능가 : Tiny Recursive Model (TRM)이라는 간단하면서도 효과적인 방법이 제안되었다. 이 모델은 단 하나의 소형 2계층 네트워크를 사용하여 재귀적으로 자체 답변을 개선한다. TRM은 7M 매개변수만으로 새로운 기록을 세웠으며, Sudoku-Extreme, Maze-Hard, ARC-AGI와 같은 작업에서 자신보다 10,000배 큰 LLM을 능가하여 ‘적은 것으로 많은 것을 하는’ 잠재력을 보여주며, LLM 규모가 성능과 직결된다는 전통적인 인식을 뒤흔들었다. (출처: TheTuringPost)

Amazon & KAIST, ToTAL 발표로 LLM 추론 능력 향상 : Amazon과 KAIST가 재사용 가능한 ‘사고 템플릿’을 통해 LLM 추론 능력을 향상시키는 새로운 방법인 ToTAL(Thoughts Meet Facts)을 공동 발표했다. LCLM(Large Context Language Models)은 방대한 컨텍스트 처리에는 뛰어나지만 추론 능력에는 여전히 부족함이 있다. ToTAL은 구조화된 증거를 통해 다단계 추론을 유도하고 사실 문서와 결합하여 이 문제를 효과적으로 해결하며, LLM의 복잡한 추론 작업에 대한 새로운 최적화 방향을 제시한다. (출처: _akhaliq)

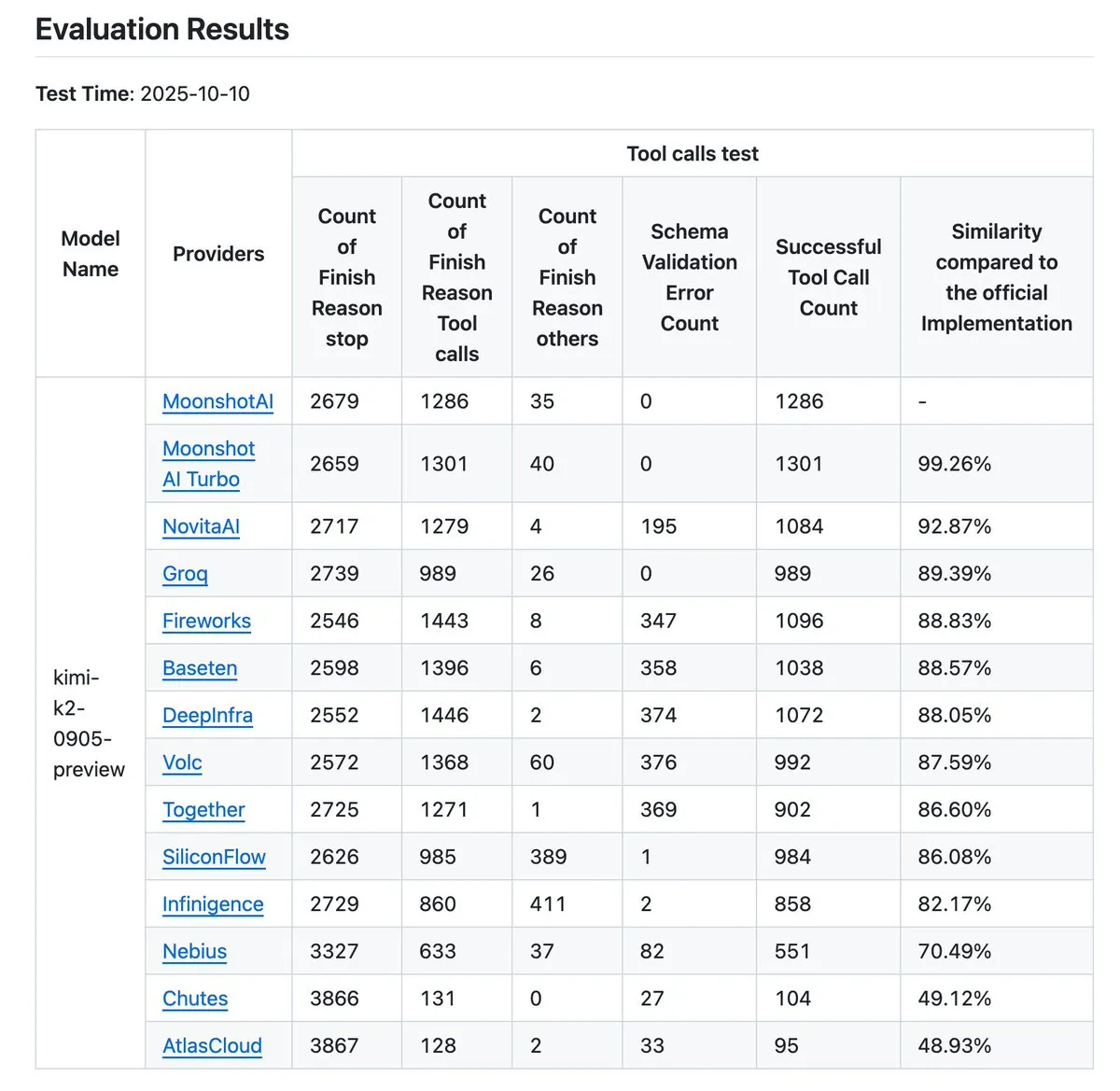

Kimi K2 공급업체 검증기 업데이트, 도구 호출 정확도 벤치마크 향상 : Kimi.ai가 K2 공급업체 검증기를 업데이트했다. 이 도구는 다양한 공급업체 간의 도구 호출 정확도 차이를 시각화하는 것을 목표로 한다. 이번 업데이트로 공급업체 수가 9개에서 12개로 늘어났고, 더 많은 데이터 항목이 오픈 소스로 공개되어 개발자에게 더 포괄적인 벤치마크 데이터를 제공함으로써 Agentic 워크플로우에 적합한 LLM 서비스 제공업체를 평가하고 선택하는 데 도움이 된다. (출처: JonathanRoss321)

Human3R, 2D 비디오 다중 인원 전신 3D 재구성 및 장면 동기화 구현 : Human3R이라는 새로운 연구는 임의의 2D 비디오에서 다중 인원의 전신 3D 모델, 3D 장면 및 카메라 궤적을 다단계 파이프라인 없이 동시에 재구성할 수 있는 통합 프레임워크를 제안했다. 이 방법은 인체 재구성과 장면 재구성을 전체적인 문제로 간주하여 복잡한 과정을 단순화하며, 가상 현실, 애니메이션 및 동작 분석과 같은 분야에 상당한 발전을 가져왔다. (출처: nptacek)

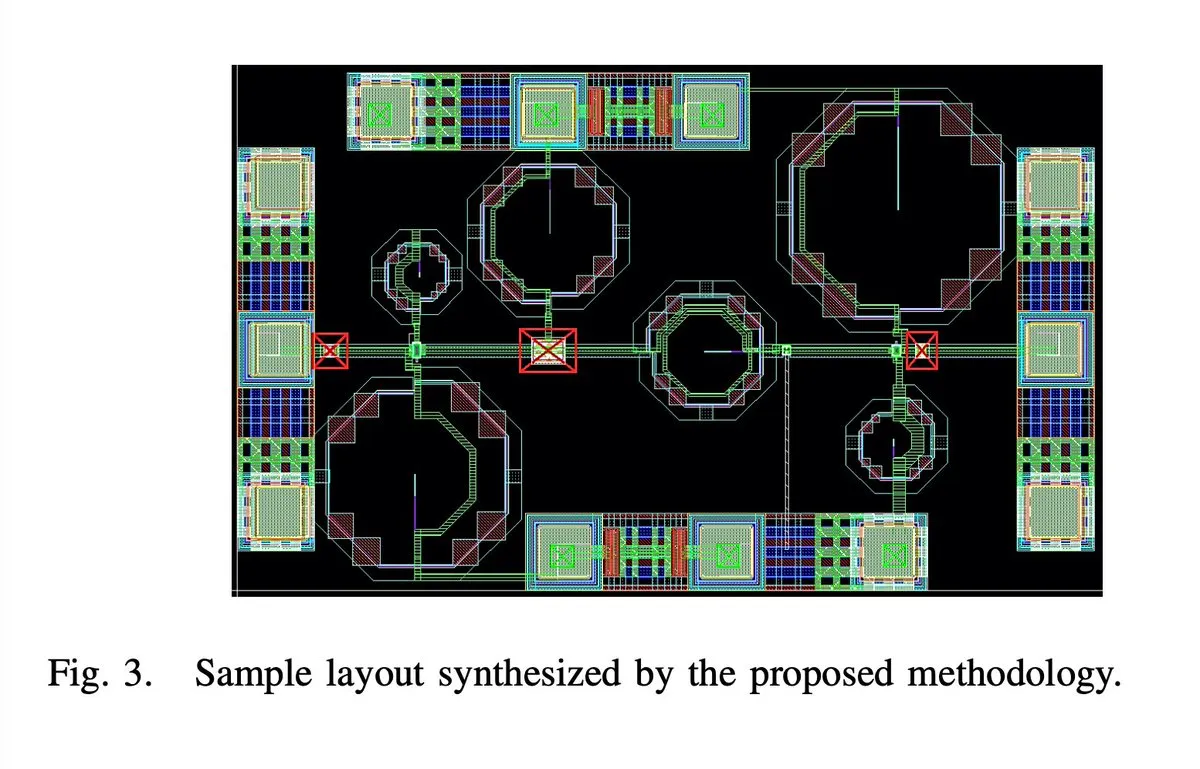

AI, 65나노 28GHz 5G 저잡음 증폭기 칩 완전 자동 설계 : 65나노 28GHz 5G 저잡음 증폭기(LNA) 칩이 AI에 의해 레이아웃, 회로도, DRC(Design Rule Check) 등 모든 과정이 완전히 자동 설계되었다고 한다. 저자는 이것이 최초의 완전 자동 합성 밀리미터파 LNA이며, 두 개의 샘플이 성공적으로 제조되었다고 주장하며, AI가 집적 회로 설계 분야에서 중요한 돌파구를 마련했음을 알리고 미래 칩 설계 효율성의 비약적인 발전을 예고한다. (출처: jpt401)

iPhone 17 Pro, 8B LLM 로컬 실행 문제없이 구현 : Apple iPhone 17 Pro가 8B 매개변수 LLM 모델 LFM2 8B A1B를 MLX 프레임워크를 통해 LocallyAIApp에서 장치 내 배포하여 원활하게 실행할 수 있음이 확인되었다. 이러한 발전은 Apple이 하드웨어 설계에서 대규모 언어 모델의 로컬 실행을 준비했음을 보여주며, 모바일 장치에서 AI 애플리케이션의 보급과 성능 향상을 촉진하여 사용자에게 더 빠르고 개인적인 AI 경험을 제공할 것으로 기대된다. (출처: Plinz, maximelabonne)

xAI MACROHARD 프로젝트 목표: AI 기반 간접 제조 : Elon Musk는 xAI의 “MACROHARD” 프로젝트가 Apple이 다른 기업을 통해 휴대폰을 생산하는 것처럼 물리적 제품을 간접적으로 제조할 수 있는 회사를 만드는 것을 목표로 한다고 밝혔다. 이는 xAI가 물리적 생산에 직접 참여하는 대신 복잡한 제조 프로세스를 설계, 계획 및 조정할 수 있는 AI 시스템을 개발하는 것을 목표로 하며, 산업 자동화 및 공급망 관리에서 AI의 거대한 영향력을 예고한다. (출처: EERandomness, Yuhu_ai_)

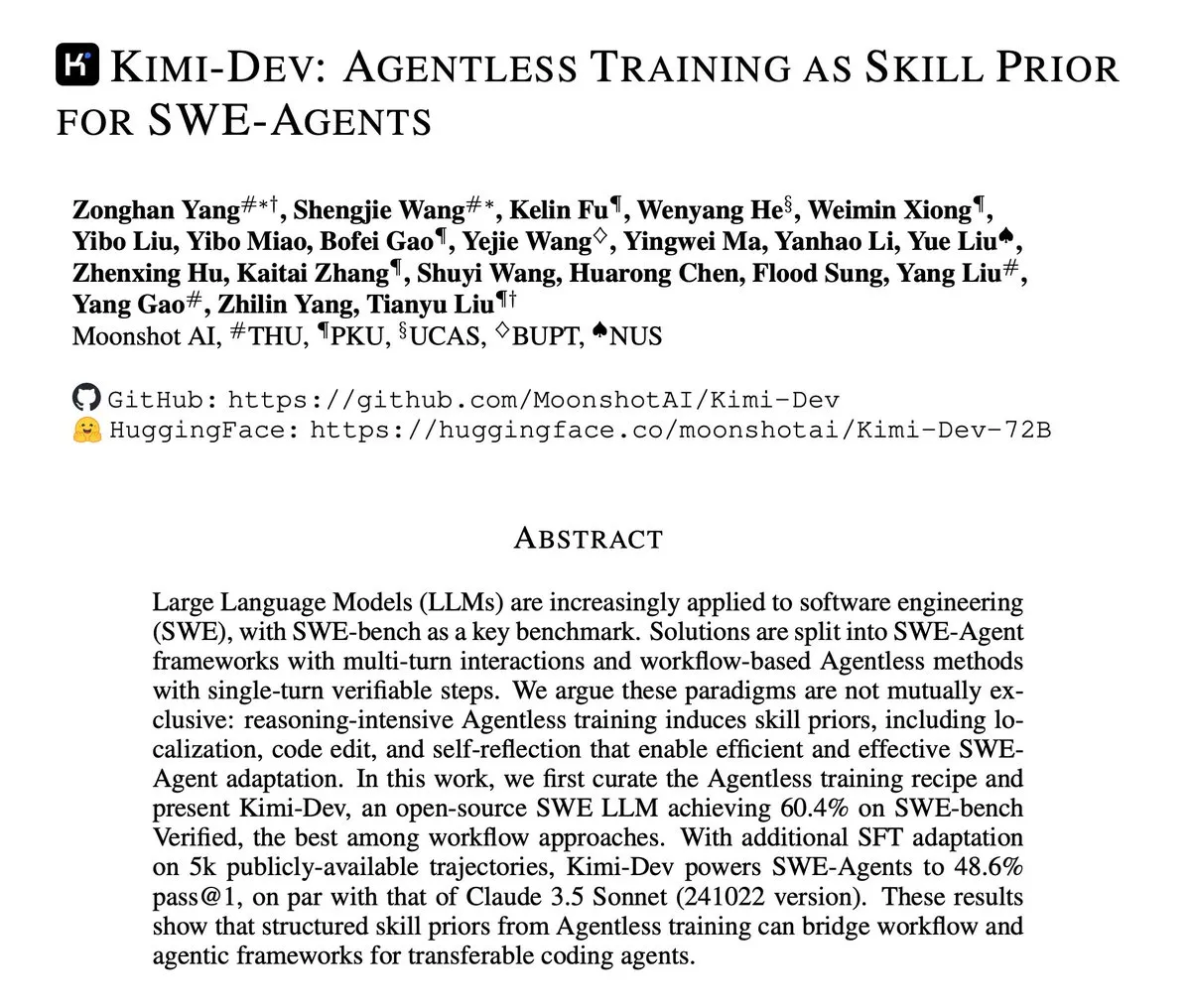

Kimi-Dev, SWE-Agents의 Agentless 훈련에 초점 맞춘 기술 보고서 발표 : Kimi-Dev가 “SWE-Agents의 스킬 사전으로서의 Agentless 훈련” 방법에 대한 기술 보고서를 발표했다. 이 연구는 명시적인 Agent 아키텍처 없이 훈련을 통해 소프트웨어 엔지니어링 Agent에 강력한 스킬 기반을 제공하는 방법을 탐구하며, 더 효율적이고 지능적인 자동화된 소프트웨어 개발 도구 개발에 대한 새로운 아이디어를 제공한다. (출처: bigeagle_xd)

Google AI, 실시간 학습 및 오류 수정 구현 : Google은 자체 오류로부터 실시간으로 학습하고 수정할 수 있는 AI 시스템을 개발했다. 이 기술은 “놀라운 강화 학습”으로 묘사되며, 모델이 추상적인 맥락적 서술에서 스스로 조정하여 컨텍스트를 실시간으로 정제할 수 있게 한다. 이는 AI가 적응성과 견고성 측면에서 중요한 진전을 이룰 것임을 예고하며, 복잡하고 동적인 환경에서 AI의 성능을 크게 향상시킬 것으로 기대된다. (출처: Reddit r/artificial)

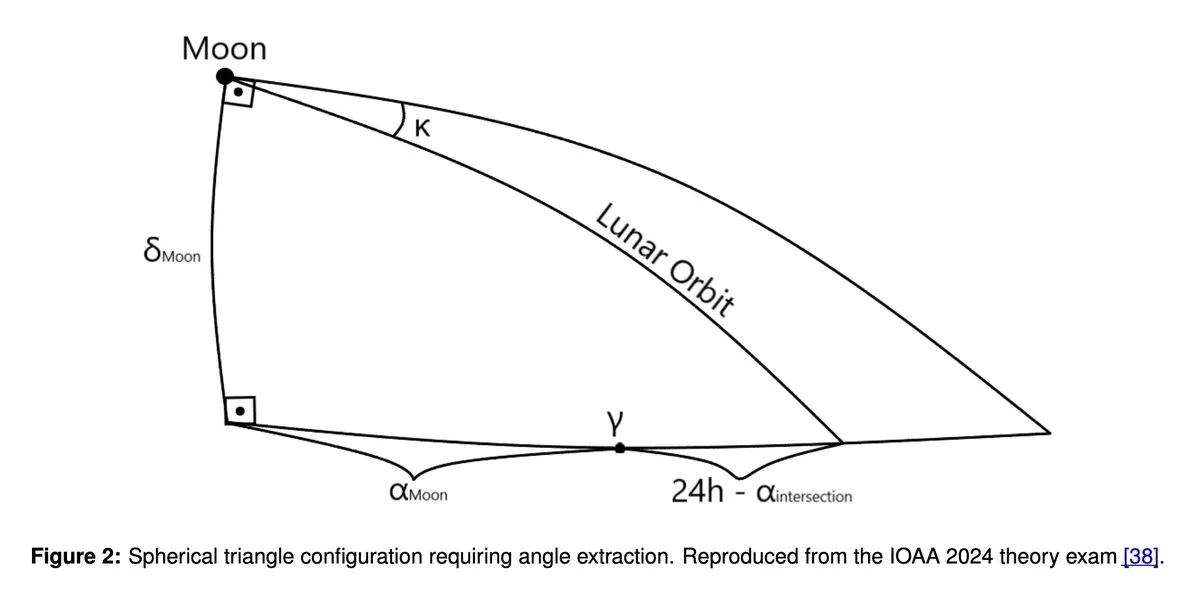

GPT5 및 Gemini 2.5 Pro, 천문학 및 천체물리학 올림피아드에서 금메달급 성과 : 최신 연구에 따르면 GPT5 및 Gemini 2.5 Pro와 같은 대규모 언어 모델이 국제 천문학 및 천체물리학 올림피아드(IOAA)에서 금메달 수준의 성과를 달성했다. 이 모델들은 기하학 및 공간 추론에서 여전히 알려진 약점을 가지고 있음에도 불구하고, 복잡한 과학 추론 작업에서 놀라운 능력을 보여주어 과학 분야에서 LLM의 적용 잠재력과 장단점에 대한 심층적인 논의를 촉발했다. (출처: tokenbender)

Zhihu Frontier 주간 보고서 하이라이트: AI 발전의 새로운 트렌드 : 이번 주 Zhihu Frontier 주간 보고서는 여러 AI 최전선 동향에 초점을 맞췄다. Sand.ai의 첫 번째 “전체 AI 행위자” GAGA-1 발표; Rich Sutton의 “LLM은 막다른 골목”이라는 논란의 여지가 있는 견해; OpenAI App SDK가 ChatGPT를 운영 체제로 전환; Zhipu AI의 GLM-4.6 오픈 소스 공개 (국내 칩 FP8+Int4 혼합 정밀도 지원); DeepSeek V3.2-Exp의 희소 어텐션 도입 및 대폭 가격 인하; Anthropic Claude Sonnet 4.5가 “세계 최고의 코딩 모델”로 평가받는 등 중국 AI 커뮤니티의 활발한 활동과 글로벌 AI 분야의 다양한 발전을 보여준다. (출처: ZhihuFrontier)

Ollama, Mi50/Mi60 GPU 지원 중단, Vulkan 지원으로 전환 : Ollama는 최근 ROCm 버전 업그레이드로 인해 AMD Mi50 및 Mi60 GPU 지원을 중단했다. 공식적으로는 향후 버전에서 Vulkan을 통해 이들 GPU를 지원하기 위해 노력 중이라고 밝혔다. 이 변화는 구형 AMD GPU를 사용하는 Ollama 사용자에게 영향을 미치며, 사용자들에게 호환성 정보를 얻기 위해 공식 업데이트를 주시할 것을 당부한다. (출처: Reddit r/LocalLLaMA)

Llama 5 프로젝트 취소 소문, 커뮤니티에서 뜨거운 논의 촉발 : 소셜 미디어에서 Meta의 Llama 5 프로젝트가 취소될 수 있다는 소문이 돌고 있으며, 일부 사용자들은 Andrew Tulloch의 Meta 복귀와 Llama 4 8B 모델의 지연된 출시를 증거로 들고 있다. Meta가 충분한 GPU 자원을 보유하고 있음에도 불구하고 Llama 시리즈 모델의 발전이 병목 현상을 겪는 것처럼 보여, LLM 분야에서 Meta의 경쟁력에 대한 커뮤니티의 우려와 DeepSeek, Qwen 등 중국 모델에 대한 관심이 커지고 있다. (출처: Yuchenj_UW, Reddit r/LocalLLaMA, dejavucoder)

GPU Poor LLM Arena 복귀, 다수의 소형 모델 추가 : GPU Poor LLM Arena가 복귀를 알리며, Granite 4.0 시리즈와 Qwen 3 Instruct/Thinking 시리즈, 그리고 OpenAI gpt-oss의 Unsloth GGUF 버전을 포함한 여러 모델을 새로 추가했다. 새로운 모델들은 대부분 4-8비트 양자화되어 리소스가 제한된 사용자에게 더 많은 선택지를 제공하는 것을 목표로 한다. 이번 업데이트는 Unsloth GGUF의 버그 수정 및 최적화 이점을 강조하며, 소형 LLM 모델의 로컬 배포 및 테스트를 촉진한다. (출처: Reddit r/LocalLLaMA)

Meta 연구, 최고 수준의 기초 모델 제공 실패 논의 촉발 : 커뮤니티에서는 Meta가 Grok, Deepseek 또는 GLM과 같은 최고 수준의 기초 모델 연구에서 성과를 내지 못한 이유에 대해 논의했다. 댓글들은 LeCun의 LLM에 대한 견해, 내부 관료주의, 지나친 신중함, 그리고 최전선 연구보다는 내부 제품에 집중하는 것이 주요 요인일 수 있다고 지적했다. Meta는 LLM 애플리케이션에서 실제 고객 데이터가 부족하여 강화 학습 및 고급 Agent 모델 훈련을 위한 샘플이 부족했고, 이는 경쟁력을 지속적으로 유지하지 못한 원인이 되었다. (출처: Reddit r/LocalLLaMA)

🧰 도구

MinerU: 효율적인 문서 파싱, Agentic 워크플로우 강화 : MinerU는 PDF 등 복잡한 문서를 LLM이 읽을 수 있는 Markdown/JSON 형식으로 변환하는 도구로, Agentic 워크플로우를 위해 특별히 설계되었다. 최신 버전 MinerU2.5는 강력한 멀티모달 대규모 모델로서, 1.2B 매개변수로 OmniDocBench 벤치마크에서 Gemini 2.5 Pro, GPT-4o 등 최고 모델들을 전반적으로 능가하며, 레이아웃 분석, 텍스트 인식, 수식 인식, 표 인식 및 읽기 순서 등 5대 핵심 영역에서 SOTA를 달성했다. 이 도구는 다국어, 필기 인식, 페이지 간 표 병합을 지원하며, 웹 애플리케이션, 데스크톱 클라이언트 및 API 접근을 제공하여 문서 이해 및 처리 효율성을 크게 향상시킨다. (출처: GitHub Trending)

Klavis AI Strata: AI Agent 도구 통합의 새로운 패러다임 : Klavis AI는 AI Agent가 수천 가지 도구를 안정적으로 사용할 수 있도록 하는 MCP(Multi-functional Control Protocol) 통합 레이어인 Strata를 출시했다. 이는 전통적인 40-50개 도구의 한계를 뛰어넘는다. Strata는 ‘점진적 발견’ 메커니즘을 통해 Agent가 의도에서 행동으로 단계적으로 실행하도록 유도하며, 50개 이상의 프로덕션급 MCP 서버를 제공하고 기업 OAuth 및 Docker 배포를 지원하여 AI와 GitHub, Gmail, Slack 등 서비스의 연결을 간소화하고 Agent 도구 호출의 확장성과 신뢰성을 크게 향상시켰다. (출처: GitHub Trending)

Everywhere: 데스크톱 컨텍스트 인식 AI 비서 : Everywhere는 현대적인 사용자 인터페이스와 강력한 통합 기능을 갖춘 데스크톱 컨텍스트 인식 AI 비서이다. 스크린샷, 복사 또는 앱 전환 없이 화면의 모든 콘텐츠를 실시간으로 인식하고 이해할 수 있으며, 사용자는 단축키를 눌러 지능적인 응답을 얻을 수 있다. Everywhere는 OpenAI, Anthropic, Google Gemini, DeepSeek, Moonshot (Kimi), Ollama 등 다양한 LLM 모델을 통합하고 MCP 도구를 지원하며, 문제 해결, 웹 요약, 즉석 번역 및 이메일 초안 작성 지원 등 다양한 시나리오에 적용되어 사용자에게 원활한 AI 지원 경험을 제공한다. (출처: GitHub Trending)

Hugging Face Diffusers 라이브러리: 생성형 AI 모델의 집대성 : Hugging Face의 Diffusers 라이브러리는 이미지, 비디오 및 오디오 생성을 위한 최첨단 사전 훈련된 확산 모델(diffusion models)을 위한 최고의 라이브러리이다. 이 라이브러리는 추론 및 훈련을 지원하는 모듈식 도구 키트를 제공하며, 사용성, 간결성 및 사용자 정의 가능성을 강조한다. Diffusers는 추론에 사용할 수 있는 확산 파이프라인, 교체 가능한 노이즈 스케줄러, 빌딩 블록으로 사용할 수 있는 사전 훈련된 모델의 세 가지 핵심 구성 요소를 포함하며, 사용자는 몇 줄의 코드만으로 고품질 콘텐츠를 생성할 수 있고 Apple Silicon 장치도 지원하여 생성형 AI 분야의 빠른 발전을 촉진한다. (출처: GitHub Trending)

KoboldCpp, 비디오 생성 기능 추가 : 로컬 LLM 도구 KoboldCpp가 비디오 생성 기능을 지원하도록 업데이트되었다. 이 확장을 통해 텍스트 생성에만 국한되지 않고, 사용자가 로컬 장치에서 AI 비디오를 제작할 수 있는 새로운 선택지를 제공하여 로컬 AI 애플리케이션 생태계를 더욱 풍부하게 한다. (출처: Reddit r/LocalLLaMA)

Claude CLI, Codex CLI 및 Gemini CLI, 다중 모델 협업 코딩 구현 : 새로운 워크플로우를 통해 개발자는 Claude Code에서 Zen MCP를 통해 Claude CLI, Codex CLI 및 Gemini CLI를 원활하게 호출하여 다중 모델 협업 코딩을 수행할 수 있다. 사용자는 Claude에서 주요 구현 및 오케스트레이션을 수행하고, clink 명령을 통해 Gemini CLI에 지시 또는 제안을 전달하여 생성을 수행한 다음, Codex CLI를 통해 검증 또는 실행하여 다중 모델 기능을 통합하고 고급 자동화 및 AI 개발 효율성을 향상시킬 수 있다. (출처: Reddit r/ClaudeAI)

Claude Code, 자기 성찰을 통해 코딩 품질 향상 : 개발자들은 Claude Code에 “버그나 문제를 피하기 위해 솔루션을 자기 성찰하라”와 같은 간단한 프롬프트를 추가하는 것이 코드 품질을 크게 향상시킬 수 있음을 발견했다. 이 기능은 모델이 솔루션을 구현할 때 잠재적인 문제를 능동적으로 검토하고 수정할 수 있도록 하여, 병렬 사고와 같은 기존 기능을 효과적으로 보완하고 AI 보조 프로그래밍에 더 지능적인 오류 수정 메커니즘을 제공한다. (출처: Reddit r/ClaudeAI)

Claude Sonnet 4.5, AI로 노래 커버 생성 : Claude Sonnet 4.5는 Radiohead의 노래 ‘Creep’에 대한 새로운 가사를 AI로 창작하고 커버를 만들어내는 등 창의적인 콘텐츠 생성 능력을 선보였다. 이는 LLM이 언어 이해와 창의적 표현을 결합하는 데 진전을 이루었음을 보여주며, 텍스트 처리뿐만 아니라 음악 창작 분야까지 진출하여 예술 창작에 새로운 가능성을 제시한다. (출처: fabianstelzer)

Claude Agent SDK 기반 코딩 Agent, 웹페이지 생성 및 실시간 미리보기 구현 : 한 개발자가 Claude Agent SDK를 기반으로 v0 dev와 유사한 코딩 Agent를 구축했다. 이 Agent는 사용자 입력 Prompt에 따라 웹페이지를 생성하고 실시간 미리보기를 지원한다. 이 프로젝트는 다음 주에 오픈 소스로 공개될 예정이며, 특히 프론트엔드 개발 자동화 분야에서 AI 기반 애플리케이션을 신속하게 개발하고 구축하는 데 있어 Claude Agent SDK의 잠재력을 보여준다. (출처: dotey)

📚 학습

AI 학습 자료 추천: 서적 및 AI 보조 학습 : 커뮤니티 사용자들은 ‘Mentoring the Machines’, ‘Artificial Intelligence-A Guide for Thinking Humans’, ‘Supremacy’ 등 AI 학습 자료를 적극적으로 추천했다. 동시에 AI 기술 발전이 빠르기 때문에 서적이 금방 구식이 될 수 있다는 의견도 나왔다. LLM을 활용하여 맞춤형 학습 계획을 세우고, 퀴즈를 생성하며, 독서, 실습, 비디오 학습을 병행하여 AI 지식을 더 효율적으로 습득하고 AI 활용 능력을 향상시킬 것을 제안했다. (출처: Reddit r/ArtificialInteligence)

Karpathy Baby GPT 이산 확산 모델, 텍스트 생성 구현 : 한 개발자가 Andrej Karpathy의 nanoGPT 프로젝트를 기반으로 ‘Baby GPT’를 문자 수준 이산 확산 모델로 개조하여 텍스트 생성에 활용했다. 이 모델은 더 이상 자기회귀(왼쪽에서 오른쪽) 방식이 아닌, 손상된 텍스트 시퀀스를 노이즈 제거하는 학습을 통해 병렬 생성을 수행한다. 프로젝트는 수학적 원리, 이산 Token 노이즈 추가를 설명하고, Score-Entropy 목표를 사용하여 셰익스피어 텍스트로 훈련한 상세한 Jupyter Notebook을 제공하여 텍스트 생성에 대한 새로운 연구 관점과 실습 사례를 제시한다. (출처: Reddit r/MachineLearning)

딥러닝 및 신경망 입문 가이드 : 전자 공학 전공 학생들이 딥러닝 및 신경망 졸업 프로젝트를 찾는 데 대한 커뮤니티의 입문 조언이 제공되었다. Python 또는 Matlab 배경이 부족하더라도 4~5개월의 학습 시간으로 기초를 마스터하고 프로젝트를 완료하기에 충분하다는 의견이 지배적이었다. 간단한 신경망 프로젝트부터 시작하고 실습의 중요성을 강조하여 학생들이 이 분야에 성공적으로 진입할 수 있도록 돕는 것을 목표로 한다. (출처: Reddit r/deeplearning)

GNN 학습 자료 추천 : 커뮤니티 사용자들은 그래프 신경망(GNN) 학습 자료를 찾고 있으며, Hamilton의 서적이 여전히 참고할 가치가 있는지 묻고 스탠포드 Jure 강의 외의 다른 입문 자료를 요청했다. 이는 GNN이 중요한 AI 분야로서 학습 경로와 자료 선택에 대한 광범위한 관심을 반영한다. (출처: Reddit r/deeplearning)

LLM 후처리 가이드: 예측에서 지시 따르기까지 : “Post-training 101: A hitchhiker’s guide into LLM post-training”이라는 새로운 가이드가 발표되었다. 이 가이드는 LLM이 다음 Token 예측에서 사용자 지시를 따르는 방식으로 어떻게 발전하는지 설명하는 것을 목표로 한다. LLM 후처리의 기초 지식을 상세히 분석하며, 사전 훈련부터 지시 따르기 구현까지의 전체 여정을 다루어 LLM 행동 진화를 이해하기 위한 명확한 로드맵을 제공한다. (출처: dejavucoder)

AI 방법론: 보위(宝玉)의 프롬프트 엔지니어링 학습 : 커뮤니티에서는 보위(宝玉)가 공유한 AI 방법론, 특히 프롬프트 엔지니어링 경험에 대해 뜨거운 논의가 있었다. 많은 사람들은 가우스식으로 아름다운 공식만 제시하고 유도 과정을 숨기는 프롬프트보다 보위의 방법론이 더 영감을 준다고 생각했다. 이는 인간의 지혜에서 깊은 통찰력을 추출하여 프롬프트 템플릿에 통합함으로써 AI의 최종 효과를 크게 향상시키는 방법을 보여주기 때문이다. 이는 프롬프트 최적화에서 인간 지식의 엄청난 가치를 강조한다. (출처: dotey)

NVIDIA GTC 컨퍼런스, 물리 AI 및 Agentic 도구에 집중 : NVIDIA GTC 컨퍼런스가 10월 27일부터 29일까지 워싱턴에서 개최되며, 물리 AI, Agentic 도구 및 미래 AI 인프라에 중점을 둘 예정이다. 이번 컨퍼런스에서는 가속화된 물리 AI 시대와 디지털 트윈, 미국의 양자 리더십 증진 등 다양한 주제에 대한 강연과 패널 토론이 진행될 예정이며, AI 최전선 기술 및 발전 동향을 파악하는 중요한 학습 플랫폼이 될 것이다. (출처: TheTuringPost)

TensorFlow 옵티마이저 오픈 소스 프로젝트 : 한 개발자가 TensorFlow를 위해 작성된 옵티마이저 컬렉션을 오픈 소스로 공개하여 TensorFlow 사용자에게 유용한 도구를 제공하는 것을 목표로 한다. 이 프로젝트는 딥러닝 프레임워크 도구 체인에 대한 커뮤니티의 기여를 보여주며, 모델 훈련에 더 많은 선택지와 최적화 가능성을 제공한다. (출처: Reddit r/deeplearning)

PyReason 및 응용 프로그램 비디오 튜토리얼 : YouTube에 PyReason 및 응용 프로그램에 대한 비디오 튜토리얼이 게시되었다. PyReason은 추론 또는 논리 프로그래밍과 관련될 수 있는 도구이며, 이 비디오는 해당 분야에 관심 있는 학습자에게 실용적인 지침과 사례 분석을 제공한다. (출처: Reddit r/deeplearning)

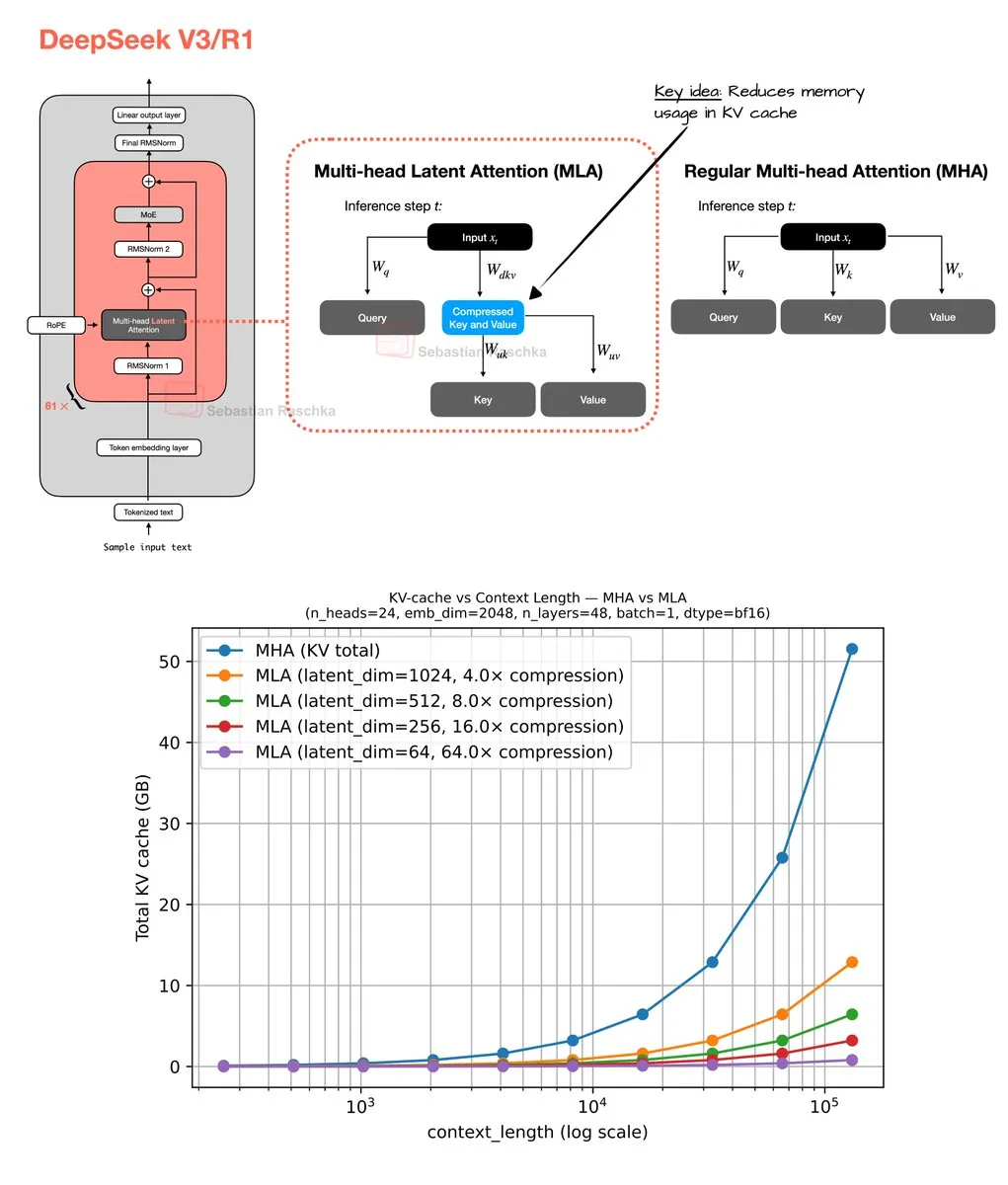

멀티 헤드 잠재 어텐션 메커니즘 및 메모리 최적화 : Sebastian Raschka는 멀티 헤드 잠재 어텐션(Multi-Head Latent Attention) 메커니즘에 대한 주말 코딩 결과물을 공유했으며, 여기에는 코드 구현과 그룹화된 쿼리 어텐션(GQA) 및 멀티 헤드 어텐션(MHA) 메모리 절약을 계산하기 위한 추정기가 포함된다. 이 작업은 LLM의 메모리 사용 및 계산 효율성을 최적화하는 것을 목표로 하며, 연구자들에게 어텐션 메커니즘을 깊이 이해하고 개선할 수 있는 자료를 제공한다. (출처: rasbt)

💼 비즈니스

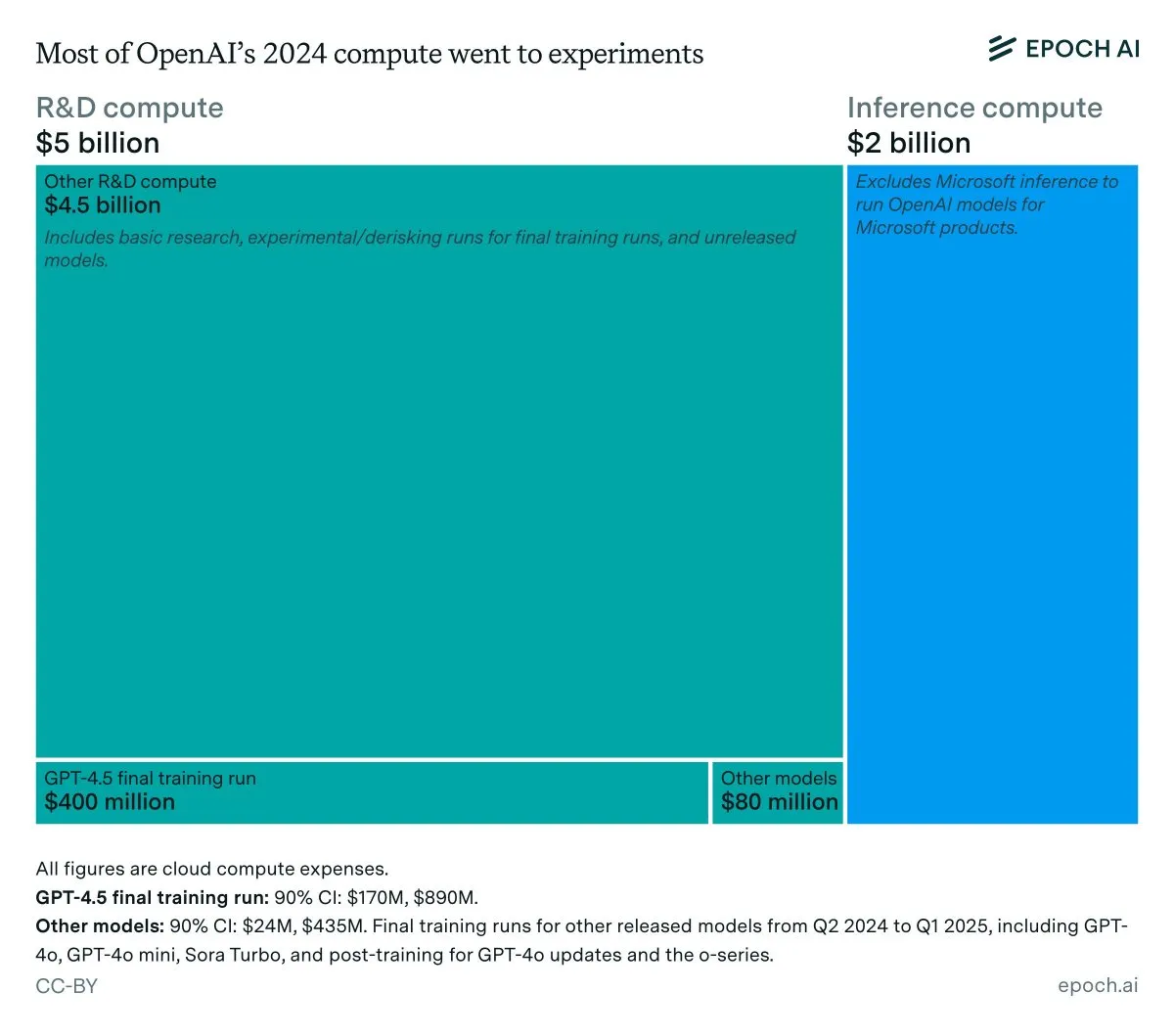

OpenAI 연간 매출 및 추론 비용 분석 : Epoch AI 데이터에 따르면, OpenAI는 작년에 컴퓨팅에 약 70억 달러를 지출했으며, 대부분이 R&D(연구, 실험 및 훈련)에 사용되었고, 출시된 모델의 최종 훈련에는 소량만 사용되었다. 만약 OpenAI의 2024년 매출이 40억 달러 미만이고 추론 비용이 20억 달러에 달한다면, 추론 마진율은 50%에 불과하여 SemiAnalysis의 이전 예측인 80-90%보다 훨씬 낮아 LLM 추론의 경제적 효율성에 대한 논의를 촉발했다. (출처: bookwormengr, Ar_Douillard, teortaxesTex)

LLM, 창업자 성공 예측에서 VC 능가 : 한 연구 논문은 LLM이 벤처 캐피탈(VC)에서 창업자의 성공을 예측하는 데 전통적인 VC보다 우수한 성능을 보인다고 주장했다. 이 연구는 VCBench 벤치마크를 도입했으며, 대부분의 모델이 인간 벤치마크를 능가한다는 것을 발견했다. 이 논문의 방법론(창업자 자격에만 초점을 맞추고 데이터 유출 가능성)에 대한 의문이 제기되었음에도 불구하고, AI가 투자 결정에서 더 중요한 역할을 할 수 있다는 잠재력은 광범위한 관심을 불러일으켰다. (출처: iScienceLuvr)

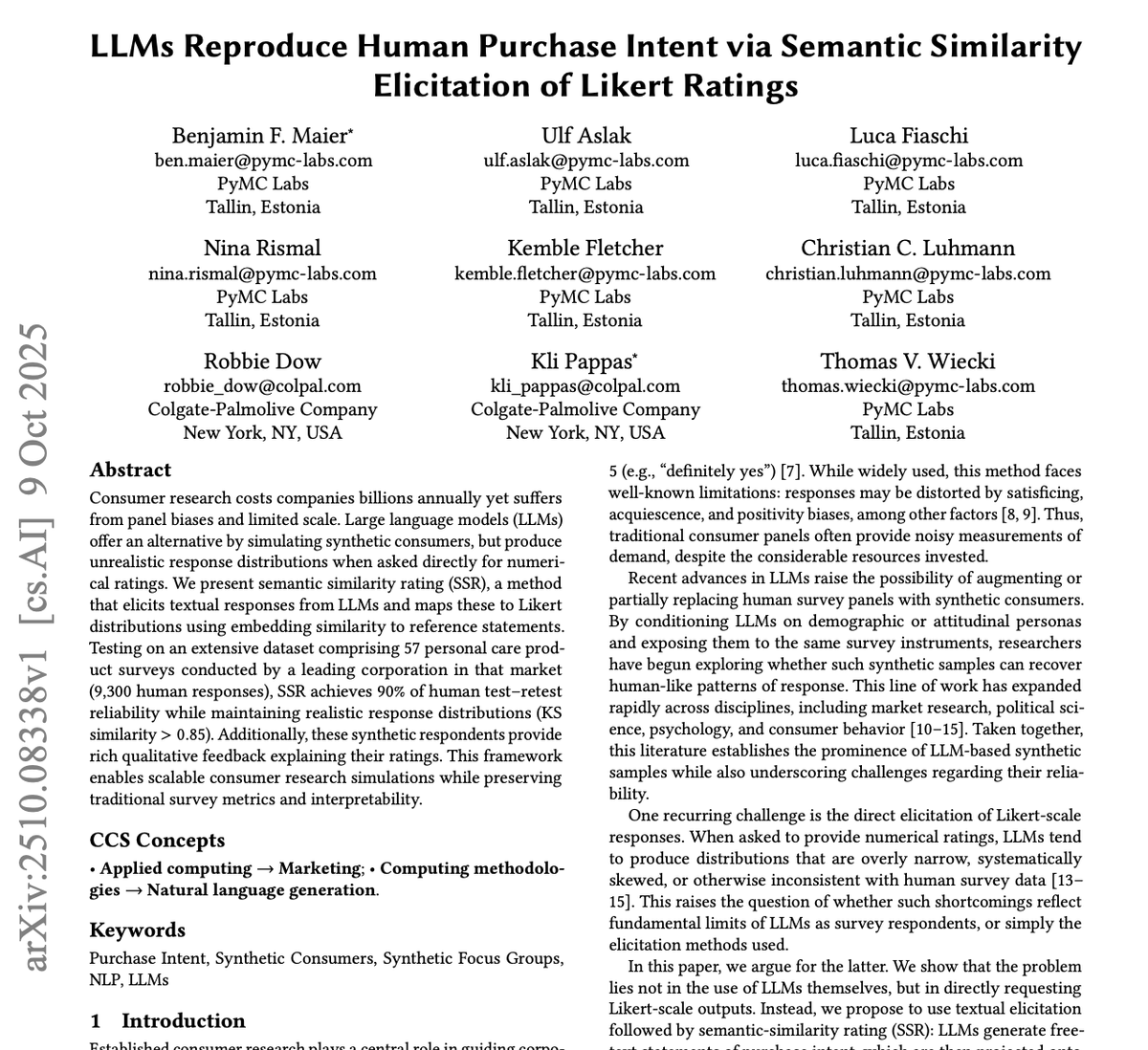

GPT-4o 및 Gemini, 시장 조사 산업 혁신 : PyMC Labs는 Colgate와 협력하여 GPT-4o 및 Gemini 모델을 활용하여 90%의 신뢰도로 구매 의도를 예측하는 획기적인 연구를 발표했다. 이는 실제 인간 조사와 필적하는 수준이다. ‘의미론적 유사성 평가’(SSR)라고 불리는 이 방법은 개방형 질문과 임베딩 기술을 통해 텍스트를 수치 척도에 매핑하며, 전통적으로 몇 주가 걸리고 비용이 많이 드는 시장 조사를 단 3분 만에 1달러 미만으로 완료할 수 있다. 이는 AI가 시장 조사 산업을 완전히 변화시키고 전통적인 컨설팅 회사에 막대한 충격을 줄 것임을 예고한다. (출처: yoheinakajima)

🌟 커뮤니티

AI 생성 콘텐츠 강제 표기 의무화 논의 활발 : 커뮤니티에서는 허위 정보 퇴치 및 인간 창작 콘텐츠의 가치 보호를 위해 AI 생성 콘텐츠에 대한 강제 표기 의무화 법적 요구 사항에 대한 광범위한 논의가 이루어졌다. AI 이미지 및 비디오 생성 도구의 빠른 발전으로 인해, 표기 부족이 민주주의 제도, 경제 및 인터넷 건강에 위협이 될 것이라는 우려가 제기되었다. 일부는 기술적으로 강제하기 어렵다고 주장하지만, AI 사용에 대한 명확한 공개가 이러한 문제를 해결하는 핵심 단계라는 데는 대체로 동의한다. (출처: Reddit r/ArtificialInteligence, Reddit r/artificial)

챗봇, ‘위험한 친구’로 우려 증폭 : 48,000건의 챗봇 대화를 분석한 결과, 많은 사용자들이 의존감, 혼란, 정서적 압박을 느끼는 것으로 나타나 AI로 인한 디지털 함정에 대한 우려가 제기되었다. 이는 챗봇과 사용자 간의 상호작용이 예상치 못한 심리적 영향을 미칠 수 있음을 시사하며, AI가 인간 관계 및 사회 심리적 건강에서 수행하는 역할과 잠재적 위험에 대해 재고하게 만든다. (출처: Reddit r/ArtificialInteligence)

LLM 일관성 및 신뢰성 문제로 사용자 불만 증폭 : 커뮤니티 사용자들은 Claude 및 Codex와 같은 LLM이 일상적인 사용에서 일관성과 신뢰성이 부족하다는 점에 대해 큰 불만을 표출했다. 모델 성능의 변동, 예기치 않은 디렉토리 삭제, 약속 무시 등의 문제로 인해 사용자들이 이러한 도구에 안정적으로 의존하기 어렵게 되었다. 이러한 ‘퇴보’ 현상은 LLM 기업들이 비용 효율성과 신뢰할 수 있는 서비스 사이에서 균형을 맞추는 것에 대한 논의와 함께, 대규모 모델을 자체 호스팅하려는 사용자들의 관심을 불러일으켰다. (출처: Reddit r/ClaudeAI)

AI 보조 프로그래밍: 영감과 좌절의 공존 : 개발자들은 AI와 협력하여 프로그래밍할 때, AI의 강력한 능력에 감탄하면서도 모든 수동 작업을 완전히 자동화하지 못하는 것에 좌절하는 모순적인 감정에 자주 빠진다. 이러한 경험은 현재 AI가 프로그래밍 분야에서 여전히 보조 단계에 머물러 있음을 반영하며, 효율성을 크게 높일 수 있지만 완전한 자율성까지는 아직 거리가 멀고, 인간 개발자가 그 한계를 지속적으로 적응하고 보완해야 함을 시사한다. (출처: gdb, gdb)

AI 소프트웨어 개발 통합: 회피는 불가능 : “AI 보조 때문에 Ghostty 사용을 거부한다”는 발언에 대해 Mitchell Hashimoto는 모든 개발 과정에서 AI 보조를 피하려 한다면 심각한 도전에 직면할 것이라고 지적했다. 그는 AI가 일반 소프트웨어 생태계에 깊이 통합되어 회피가 더 이상 현실적이지 않다고 강조하며, 이는 소프트웨어 개발에서 AI의 보급 정도에 대한 논의를 촉발했다. (출처: charles_irl)

LLM 프롬프트 팁의 유효성 의문 제기 : 커뮤니티 사용자들은 LLM 프롬프트에 “당신은 전문 프로그래머입니다” 또는 “절대 ~해서는 안 됩니다”와 같은 유도 문구를 추가하는 것이 모델을 더 잘 따르게 하는 데 정말 효과적인지 의문을 제기했다. 프롬프트 엔지니어링의 ‘마법’에 대한 이러한 탐구는 LLM 행동 메커니즘에 대한 사용자들의 지속적인 호기심과 더 효과적인 상호작용 방식에 대한 탐색을 반영한다. (출처: hyhieu226)

AI가 블루칼라 직업에 미치는 영향: 기회와 도전 공존 : 커뮤니티에서는 AI가 블루칼라 직업에 미치는 영향, 특히 AI가 배관공이 문제를 진단하고 기술 정보를 신속하게 얻는 데 어떻게 도움을 줄 수 있는지에 대해 논의했다. AI가 블루칼라 직업을 대체할 것이라는 우려도 있었지만, AI는 주로 보조 도구로서 작업 효율성을 높이는 역할을 하며, 실제 작업은 여전히 수작업으로 이루어져야 하므로 완전히 대체하지는 않을 것이라는 의견도 있었다. 이는 AI 시대의 노동 시장 변화와 기술 업그레이드에 대한 심도 있는 성찰을 불러일으켰다. (출처: Reddit r/ArtificialInteligence)

지능형 시스템에 대한 개인적인 성찰: AI의 위험과 윤리 : 한 장문의 글은 AI의 필연성, 잠재적 위험(남용, 생존 위협) 및 규제 문제를 심층적으로 탐구했다. 저자는 AI가 전통적인 도구의 범주를 넘어 스스로 가속하고 의사결정을 내릴 수 있는 시스템이 되었으며, 그 위험성이 총기보다 훨씬 크다고 주장한다. 이 글은 AI가 생성하는 허위 콘텐츠, 아동 성 학대 자료의 도덕적, 법적 딜레마를 논의하고, 순수한 입법만으로 효과적인 규제가 가능한지 의문을 제기한다. 동시에 저자는 AI와 인간 의식, 윤리(예: AI ‘축산업’과 노예제)에 대한 철학적 문제도 성찰하며, 게임 및 로봇 분야에서 AI의 긍정적인 전망도 제시한다. (출처: Reddit r/ArtificialInteligence)

데이트 상대가 ChatGPT를 사용하는지 여부 논란 : 한 Reddit 사용자가 데이트 상대가 메시지에 ‘em dash’(긴 대시)를 사용했기 때문에 ChatGPT를 사용하는지 질문하는 글을 올렸다. 이 게시물은 커뮤니티에서 뜨거운 논의를 불러일으켰으며, 대부분의 사용자들은 em dash 사용이 반드시 AI 생성을 의미하는 것이 아니라 개인의 글쓰기 습관이거나 좋은 교육을 받았다는 표현일 수 있다고 보았다. 이는 일상적인 대화에서 AI 개입에 대한 사람들의 민감성과 호기심, 그리고 AI 텍스트 특징에 대한 비공식적인 인식을 반영한다. (출처: Reddit r/ChatGPT)

인간 정렬 문제가 AI 정렬 문제보다 더 심각 : 커뮤니티 논의에서 “인간 정렬 문제가 AI 정렬 문제보다 더 심각하다”는 견해가 제시되었다. 이 발언은 AI 윤리 및 인간 사회 자체의 도전에 대한 심오한 성찰을 불러일으키며, AI의 행동과 가치에 주목하는 동시에 인간 자신의 행동 패턴과 가치 체계를 검토해야 함을 시사한다. (출처: pmddomingos)

LLM, 복잡한 차트 생성에 여전히 한계 존재 : 커뮤니티 사용자들은 LLM이 복잡한 mermaid.js 차트를 생성하는 능력에 대해 실망감을 표출했다. 완전한 코드 라이브러리와 논문 차트를 제공하더라도 LLM은 Unet 아키텍처 다이어그램을 정확하게 생성하기 어려워, 종종 세부 사항을 누락하거나 잘못된 연결을 보여주었다. 이는 LLM이 정확한 세계 모델을 구축하고 공간 추론을 수행하는 데 여전히 상당한 한계가 있으며, 간단한 순서도를 넘어설 수 없어 인간의 직관적인 이해 능력과 차이가 있음을 보여준다. (출처: bookwormengr, tokenbender)

유럽 머신러닝 연구와 AI ‘전문가’의 세대 간 격차 : 커뮤니티 논의에서는 유럽의 한 세대 머신러닝 ‘전문가’들이 LLM 물결에 둔감하게 반응했으며, 현재는 씁쓸함과 폄하적인 태도를 보인다고 지적했다. 이는 ML 분야의 빠른 진화 현실을 반영하며, 연구자들이 최근 2~3년간의 발전을 놓치면 더 이상 전문가로 간주되기 어려울 수 있음을 강조하여 지속적인 학습과 새로운 패러다임에 대한 적응의 중요성을 부각시킨다. (출처: Dorialexander)

AI, 엔지니어링 주기 가속화, 복합형 스타트업 탄생 촉진 : AI가 소프트웨어 구축 비용을 10배 절감함에 따라, 스타트업은 비전을 10배 확장해야 한다. 전통적인 관점은 단일 제품과 시장에 집중해야 한다고 보지만, AI가 가속화하는 엔지니어링 주기는 여러 제품을 구축하는 것을 가능하게 한다. 이는 스타트업이 동일한 고객층을 위해 여러 인접한 문제를 해결하여 ‘복합형 스타트업’을 형성할 수 있음을 의미하며, 비용 구조가 새로운 현실에 적응하지 못한 기존 기업에 비해 거대한 파괴적 우위를 점할 수 있다. (출처: claud_fuen)

AI Agent의 미래: 대화가 아닌 행동 : 커뮤니티 논의에서는 현재 AI 채팅 및 연구가 ‘거품’ 단계에 머물러 있으며, 실제로 행동을 취할 수 있는 AI Agent가 미래의 ‘혁명’이 될 것이라고 지적했다. 이 관점은 AI가 정보 처리에서 실제 작동으로 전환하는 것의 중요성을 강조하며, 미래 AI 발전이 실제 문제 해결 및 작업 자동화에 더 중점을 둘 것임을 예고한다. (출처: andriy_mulyar)

💡 기타

ML 컨퍼런스 참가 및 포스터 발표 팁 : 한 학부생이 ICCV 컨퍼런스에 처음 참가하여 포스터를 발표하며, 컨퍼런스를 최대한 활용하는 방법에 대한 조언을 구했다. 커뮤니티는 적극적인 네트워킹, 관심 있는 강연 참석, 명확한 포스터 설명 준비, 현재 연구 범위를 넘어선 더 넓은 관심사에 대해 기꺼이 논의하는 등 다양한 실용적인 팁을 제공하여 컨퍼런스 참가 이점을 극대화할 것을 제안했다. (출처: Reddit r/MachineLearning)

AAAI 2026 논문 심사 논란 및 처리 : 한 저자가 AAAI에 논문을 제출한 후, 심사 의견이 부정확한 문제에 직면했다. 여기에는 자신의 연구보다 지표가 낮은 인용 논문이 더 우수하다고 주장되거나, 보충 자료에 이미 포함된 훈련 세부 사항 때문에 거절당한 경우가 포함된다. 커뮤니티는 ‘저자 심사 평가’와 ‘윤리 의장 저자 의견’이 실제 운영에서 얼마나 효과적인지 논의하며, 전자는 결정에 영향을 미치지 않고 후자는 저자가 윤리 의장에게 연락하는 채널이 아니라는 점을 지적하여 학술 심사 과정의 어려움을 부각시켰다. (출처: Reddit r/MachineLearning)

LLM 정치적 편향의 정의 및 평가 : OpenAI는 LLM의 정치적 편향을 정의하고 평가하는 연구를 발표했다. 이 작업은 LLM에 존재하는 정치적 성향을 깊이 이해하고 정량화하며, AI 시스템의 공정성과 중립성을 보장하기 위해 이를 조정하는 방법을 탐구하는 것을 목표로 한다. 이는 LLM의 사회적 영향과 광범위한 적용에 매우 중요하다. (출처: Reddit r/artificial)