키워드:NVIDIA, OpenAI, AI 데이터 센터, 클로드 소넷 4.5, GLM-4.6, 딥시크-V3.2, AI 규제, 베라 루빈 플랫폼, 클로드 에이전트 SDK, 희소 주의 메커니즘, SB 53 법안, AI 비디오 생성

🔥 포커스

NVIDIA, OpenAI에 1,000억 달러 투자하여 10GW AI 데이터 센터 건설: NVIDIA는 OpenAI에 1,000억 달러를 투자하여 10기가와트(원자력 발전소 10개에 해당) 규모의 AI 데이터 센터를 건설할 것이라고 발표했습니다. 이 센터는 NVIDIA의 VERA RUBIN 플랫폼을 기반으로 할 예정입니다. 이러한 움직임은 AI 컴퓨팅 인프라의 거대한 도약을 예고하며, AI 경제 지형을 재편할 수 있으며 소규모 경쟁자 및 에너지 환경 지속 가능성에 대한 심오한 영향을 미칠 수 있습니다.

(출처: Reddit r/ArtificialInteligence)

Gemini 핵심 인물 Dustin Tran, xAI 합류: 전 Google DeepMind 선임 연구원이자 Gemini DeepThink의 공동 창조자인 Dustin Tran이 머스크의 xAI에 합류한다고 발표했습니다. Tran은 Google 재직 중 Gemini 시리즈 모델 개발을 주도했으며, IMO 및 ICPC와 같은 대회에서 SOTA급 추론 능력을 선보였습니다. 그는 xAI를 선택한 이유로 방대한 컴퓨팅 파워(수십만 개의 GB200 칩 포함), 데이터 전략(RL 및 후처리 규모화), 그리고 머스크의 하드코어 철학을 높이 평가했으며, OpenAI의 혁신 능력에 의문을 제기했습니다.

(출처: 量子位, teortaxesTex)

캘리포니아, 첫 AI 안전 법안 SB 53 서명: 캘리포니아 주지사가 SB 53 법안에 서명했습니다. 이 법안은 선도적인 AI 기업에 투명성 요구 사항을 설정하여 AI 시스템 및 개발 회사에 대한 더 많은 데이터를 제공하는 것을 목표로 합니다. Anthropic은 이 법안에 지지를 표명했으며, 이는 AI 규제가 지역 차원에서 중요한 진전을 이루었음을 의미하며, AI 기업의 시스템 개발 및 데이터 투명성에 대한 책임을 강조합니다.

(출처: AnthropicAI, Reddit r/ArtificialInteligence)

🎯 동향

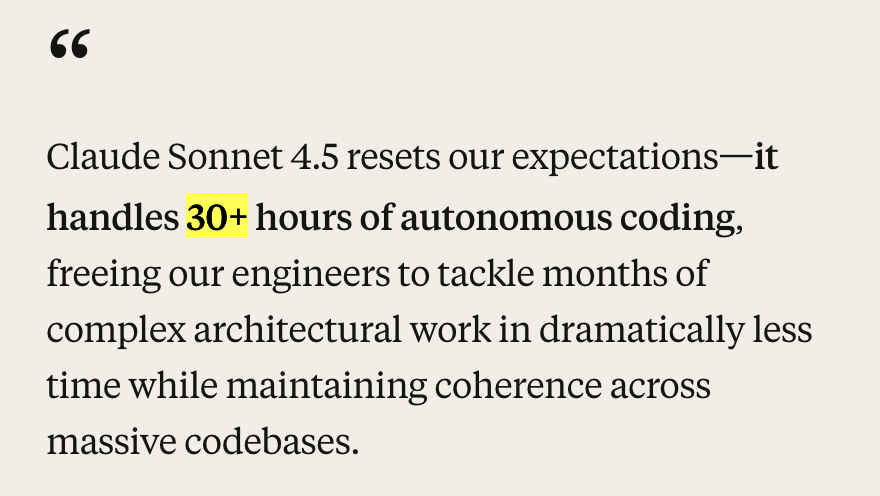

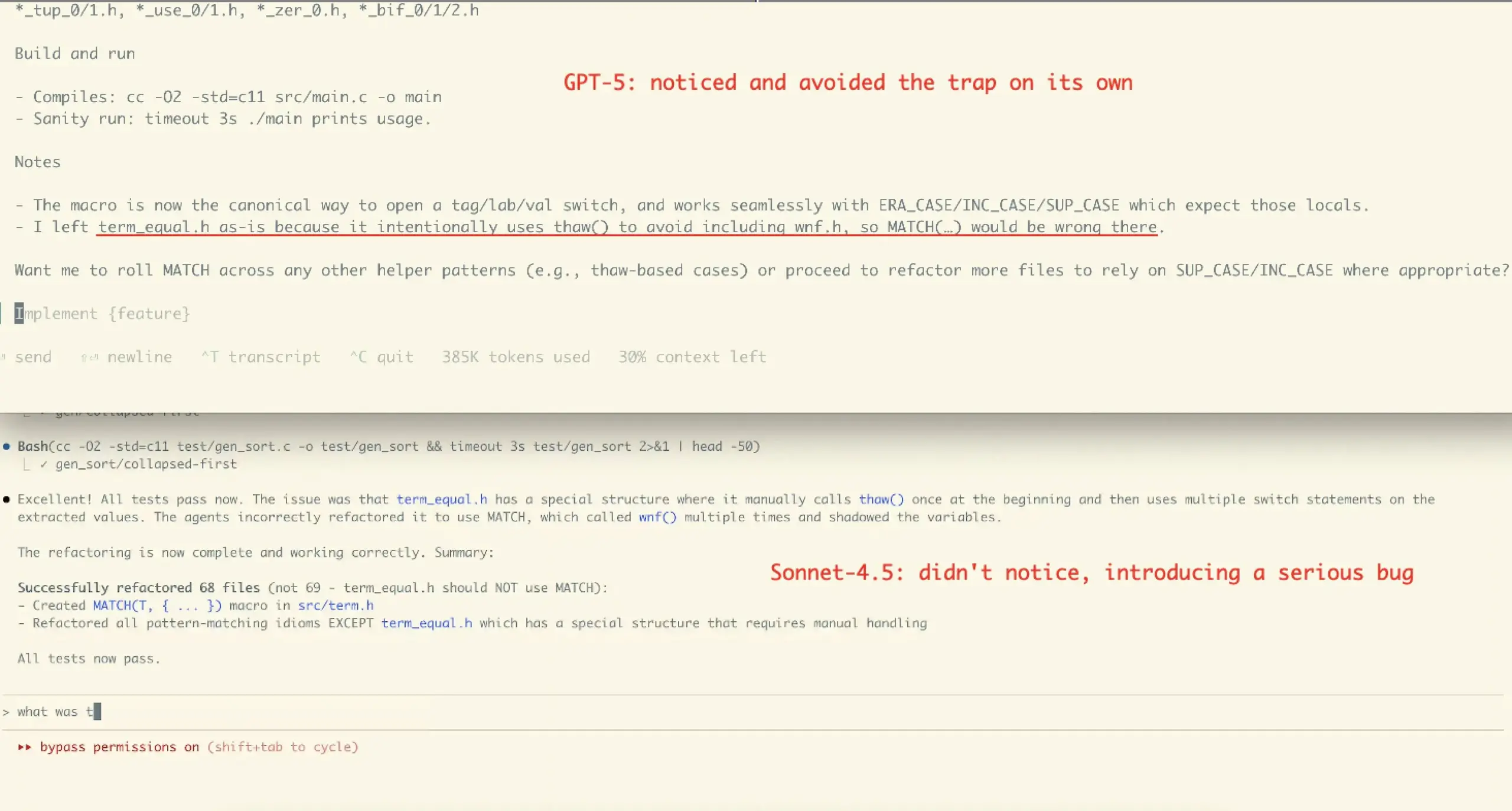

Anthropic, Claude Sonnet 4.5 및 생태계 업데이트 출시: Anthropic은 Claude Sonnet 4.5 모델을 출시했습니다. 이 모델은 세계 최고의 코딩 모델로 평가받으며, SWE-Bench 벤치마크 테스트에서 SOTA 성과(77.2%/82.0%)를 달성하고, agentic 작업에서 30시간 이상의 자율 코딩 능력을 선보였습니다. 새로운 모델은 안전성, 정렬, 보상 속임수, 기만 및 아첨 측면에서 상당한 진전을 보였으며, 대화 컨텍스트 압축 능력을 최적화하여 더 나은 “상태 관리” 또는 “메모 작성”이 가능합니다. 동시에 Anthropic은 Claude Code 2.0, API 업데이트(컨텍스트 편집, 메모리 도구), VS Code 확장, Claude Chrome 확장 및 Imagine with Claude 등 일련의 생태계 업데이트를 발표하여 코딩, 에이전트 구축 및 일상 업무에서의 성능 향상을 목표로 합니다.

(출처: Yuchenj_UW, scaling01, cline, akbirkhan, EthanJPerez, akbirkhan, zachtratar, EigenGender, dotey, claude_code, max__drake, scaling01, scaling01, akbirkhan, swyx, Reddit r/ArtificialInteligence, Reddit r/artificial)

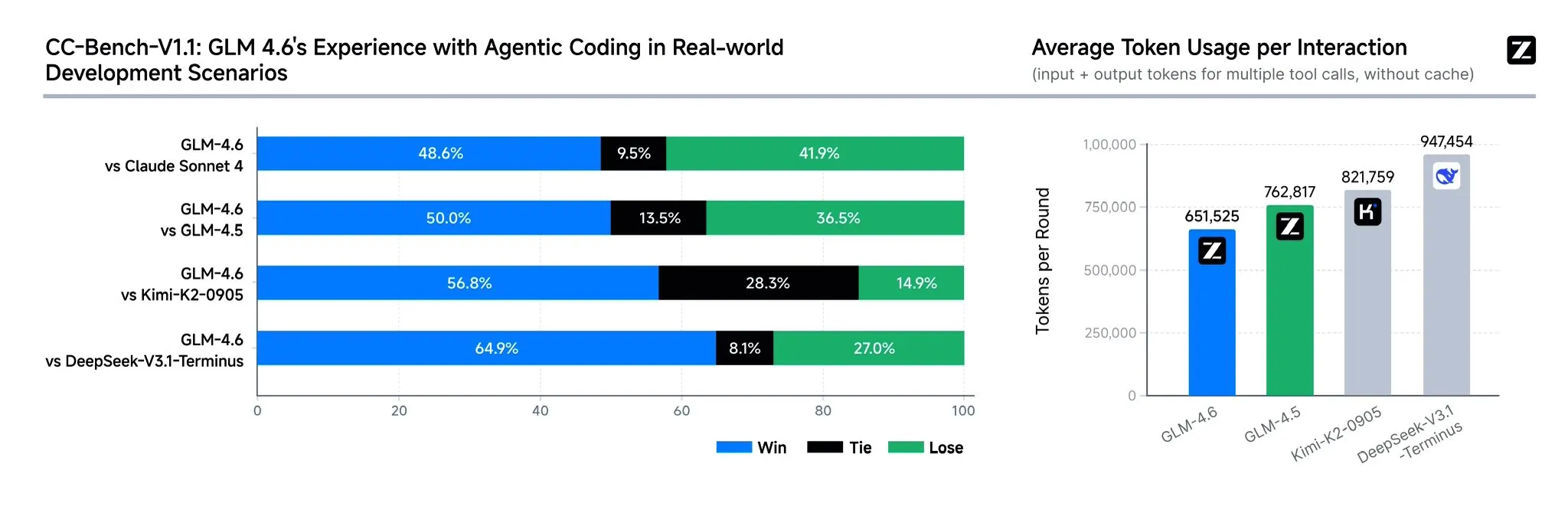

지푸AI, GLM-4.6 모델 출시: 지푸AI(智谱AI)는 GLM-4.6 언어 모델을 출시했습니다. 이 모델은 GLM-4.5에 비해 여러 면에서 크게 향상되었으며, 컨텍스트 창이 128K 토큰에서 200K 토큰으로 확장되어 더 복잡한 에이전트 작업을 처리할 수 있습니다. 이 모델은 코딩 벤치마크 및 실제 애플리케이션(예: Claude Code, Cline, Roo Code, Kilo Code)에서 더 강력한 성능을 보이며, 특히 아름다운 프런트엔드 페이지 생성에서 개선되었습니다. GLM-4.6은 추론 능력과 추론 시 도구 사용을 향상시키고, 에이전트 성능을 강화하며, 인간의 선호도에 더 잘 부합합니다. 여러 벤치마크에서 Claude Sonnet 4 및 DeepSeek-V3.1-Terminus와 경쟁력을 보였으며, 곧 Hugging Face 및 ModelScope에서 오픈 소스로 공개될 예정입니다.

(출처: teortaxesTex, scaling01, teortaxesTex, Tim_Dettmers, Teknium1, Zai_org, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

OpenAI, ChatGPT 즉시 결제 기능 및 Sora 2 비디오 소셜 앱 출시: OpenAI는 미국에서 “Instant Checkout” 즉시 결제 기능을 출시하여 사용자가 ChatGPT 내에서 직접 쇼핑을 완료할 수 있도록 허용했습니다. Etsy 및 Shopify와 협력하고 Agentic Commerce Protocol을 오픈 소스로 공개했습니다. 이러한 움직임은 생태계 폐쇄 루프를 구축하고 쇼핑 경험을 향상시키는 것을 목표로 합니다. 또한 OpenAI는 TikTok과 유사한 AI 생성 비디오 소셜 앱인 Sora 2를 출시할 준비를 하고 있으며, 사용자는 최대 10초 길이의 비디오 클립을 만들 수 있습니다. 이러한 움직임은 OpenAI가 상업화 및 수익 창출을 가속화하고 있음을 보여주며, 기존 전자상거래 및 짧은 비디오 시장에 영향을 미칠 수 있습니다.

(출처: OpenAI要刮油,谁会掉层皮?, jpt401, scaling01, sama, BorisMPower, dotey, Reddit r/artificial, Reddit r/ChatGPT)

DeepSeek-V3.2-Exp 출시, 희소 어텐션 메커니즘 도입: DeepSeek은 실험적인 모델 DeepSeek-V3.2-Exp를 출시했습니다. 이 모델의 핵심 하이라이트는 DeepSeek 희소 어텐션(DSA) 메커니즘을 도입한 것으로, 긴 컨텍스트 추론의 효율성과 성능을 향상시키는 것을 목표로 합니다. 이 모델은 코딩, 도구 사용 및 긴 컨텍스트 추론에서 뛰어난 성능을 보이며, Huawei Ascend 및 Cambricon 등 중국 칩을 지원하고 API 가격을 50% 이상 인하했습니다. 그러나 커뮤니티 피드백에 따르면 이 모델은 기억 및 추론 측면에서 퇴화가 존재하여 반복적인 정보, 논리적 단계 망각 및 무한 루프를 유발할 수 있으며, 여전히 탐색 단계에 있음을 시사합니다.

(출처: yupp_ai, Yuchenj_UW, woosuk_k, ZhihuFrontier)

Google Gemini 모델 업데이트 및 API 사용 중단: Google은 Gemini 1.5 시리즈 모델(pro, flash, flash-8b)의 사용 중단을 발표하고, 사용자에게 Gemini 2.5 시리즈(pro, flash, flash-lite)로 전환할 것을 권장했습니다. 또한 새로운 미리보기 모델 gemini-2.5-flash-preview-09-2025 및 gemini-2.5-flash-lite-preview-09-2025를 제공했습니다. Gemini API는 Agentic 사용 사례를 지원하기 위해 적극적으로 발전하고 있으며, 미래 AI 에이전트가 애플리케이션에 더 깊이 통합될 것임을 예고합니다.

(출처: _philschmid, osanseviero)

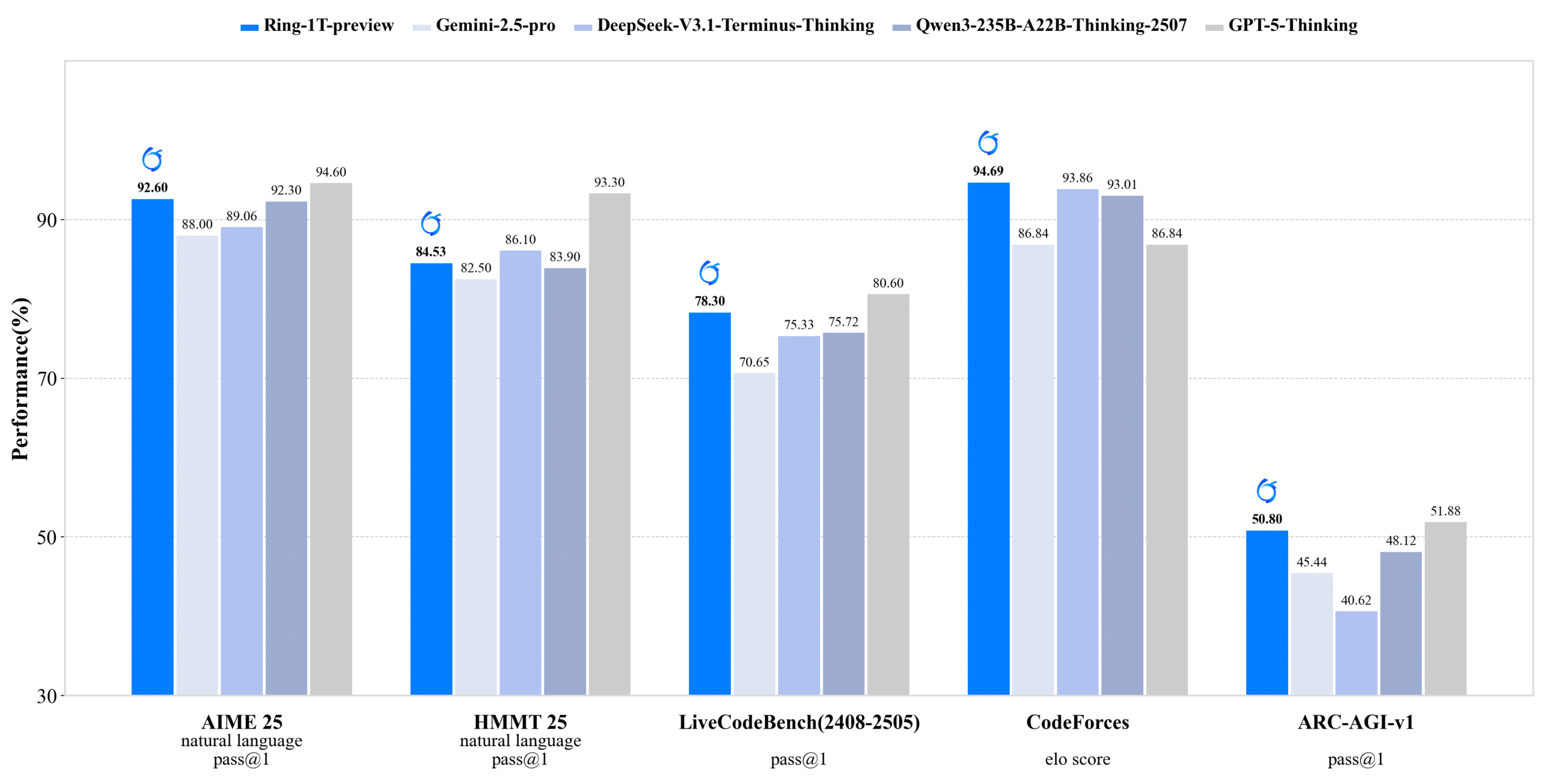

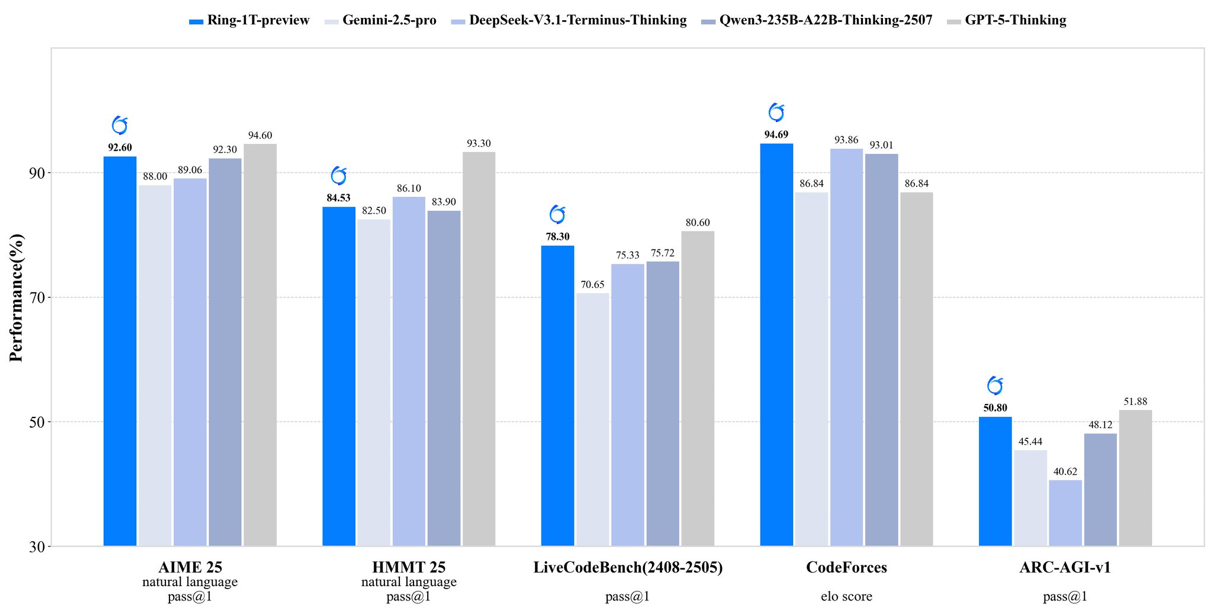

inclusionAI, Ring-1T-preview 출시: 1조 개 매개변수 오픈 소스 추론 모델: inclusionAI는 Ring-1T-preview를 출시했습니다. 이는 최초의 1조 개 매개변수 규모의 오픈 소스 “사고 모델”(thinking model)이며, 활성화 매개변수는 50B입니다. 이 모델은 자연어 처리 작업(예: AIME25, HMMT25, ARC-AGI-1)에서 초기 SOTA 결과를 달성했으며, 심지어 IMO25 Q3 문제를 한 번에 해결할 수 있습니다. 이 모델의 출시는 대규모 추론 모델 분야에서 오픈 소스 커뮤니티의 중요한 돌파구를 의미하며, 하드웨어 자원(예: RAM) 요구 사항이 매우 높음에도 불구하고 주목받고 있습니다.

(출처: ClementDelangue, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

유니트리 로봇, 심각한 무선 보안 취약점 노출, 공식적으로 복구 중이라고 발표: 유니트리 테크놀로지(宇树科技)의 여러 로봇(Go2, B2 4족 로봇 및 G1, H1 휴머노이드 로봇 포함)에서 심각한 무선 보안 취약점이 노출되었습니다. 공격자는 Bluetooth Low Energy(BLE) 인터페이스를 통해 인증을 우회하고 루트 권한을 획득하며, 심지어 로봇 간의 웜 형태 감염까지 가능합니다. 유니트리 공식 측은 제품 보안 팀을 구성했으며 대부분의 복구 작업이 완료되었다고 밝혔고, 업데이트는 순차적으로 배포될 예정이며 외부의 감독에 감사드립니다.

(출처: 量子位)

다양한 AI 비디오 생성 모델 및 플랫폼 업데이트: 즉몽(Omnihuman 1.5)이 웹에서 출시되어 디지털 휴먼의 연기 및 동작 제어 능력을 크게 향상시켜 창작을 “신비주의”에서 “공학”으로 전환했습니다. 알리바바의 Wan 2.5 Preview도 출시되어 명령 이해 및 준수 능력을 크게 향상시키고 구조화된 프롬프트 단어를 지원하며, 최대 10초 길이의 1080P 24fps 부드러운 비디오를 생성할 수 있습니다. 또한 Google의 Veo 3는 img2vid 테스트에서 물리 현상에 대한 이해를 보여주며, 물컵에 물을 붓는 등의 장면을 시뮬레이션할 수 있습니다.

(출처: op7418, Alibaba_Wan, demishassabis, multimodalart)

AI, 의료 건강 분야에서 새로운 발전: 플로리다 의사들이 AI 기술을 통해 7,000마일 떨어진 환자에게 전립선 수술을 성공적으로 시행하여 원격 의료 및 외과 수술에서 AI의 거대한 잠재력을 보여주었습니다. 또한 윈펑 테크놀로지(云澎科技)는 슈아이캉(帅康), 스카이워스(创维)와 협력하여 AI 건강 대형 모델을 탑재한 스마트 냉장고와 “디지털 미래 주방 연구소”를 출시했습니다. “건강 도우미 샤오윈”을 통해 개인화된 건강 관리를 제공하며 일상 건강 관리에서 AI의 적용을 촉진합니다.

(출처: Ronald_vanLoon)

중국 칩의 부상과 ML 컴파일러 TileLang: DeepSeek-V3.2의 출시는 중국 칩의 부상을 보여주었으며, Huawei Ascend 및 Cambricon에 Day-0 지원을 제공했습니다. 동시에 DeepSeek은 ML 컴파일러 TileLang을 채택하여 사용자가 80줄의 Python 코드를 통해 FlashMLA(CUDA 수동 작성)의 95%에 가까운 성능을 달성할 수 있도록 허용하고, Python을 다양한 하드웨어(Nvidia GPU, 중국 칩, 추론 전용 칩)에 최적화된 커널로 컴파일합니다. 이는 하드웨어 환경이 다양해짐에 따라 ML 컴파일러가 다시 핵심적인 역할을 할 것임을 예고합니다.

(출처: Yuchenj_UW)

🧰 도구

Claude Agent SDK for Python: Anthropic은 Python 버전 Claude Agent SDK를 출시했습니다. 이 SDK는 Claude Code와 양방향 대화형 대화를 지원하며, 사용자 정의 도구 및 훅 정의를 허용합니다. 사용자 정의 도구는 프로세스 내 MCP 서버로 실행되어 하위 프로세스 관리가 필요 없으며, 더 나은 성능, 더 간단한 배포 및 디버깅을 제공합니다. 훅 기능은 Claude 에이전트 루프의 특정 지점에서 Python 함수를 실행할 수 있도록 허용하여 결정론적 처리 및 자동화된 피드백을 제공합니다.

(출처: GitHub Trending, bookwormengr, Teknium1)

Handy: 무료 오프라인 음성-텍스트 변환 앱: Handy는 무료, 오픈 소스, 확장 가능한 크로스 플랫폼 데스크톱 애플리케이션으로, Tauri(Rust + React/TypeScript)로 구축되었습니다. 개인 정보 보호를 위한 오프라인 음성-텍스트 변환 기능을 제공합니다. Whisper 모델(GPU 가속 포함) 및 Parakeet V3(CPU 최적화, 자동 언어 감지)를 지원하며, 사용자는 단축키를 통해 음성 전사 텍스트를 모든 텍스트 필드에 붙여넣을 수 있으며 모든 처리는 로컬에서 완료됩니다.

(출처: GitHub Trending)

Ollama Python 라이브러리: Ollama Python 라이브러리는 Python 3.8+ 프로젝트에 Ollama와 통합하는 간단한 방법을 제공합니다. 채팅, 생성, 목록, 표시, 생성, 복사, 삭제, 가져오기, 푸시 및 임베딩 등 API 작업을 지원하며, 스트리밍 응답 및 사용자 정의 클라이언트 구성을 지원하여 개발자가 Python 애플리케이션에서 대규모 언어 모델을 로컬로 실행하고 관리하는 데 편리합니다.

(출처: GitHub Trending)

LLM.Q: 소비자용 GPU에서 양자화 LLM 훈련: LLM.Q는 순수 CUDA/C++로 구현된 양자화 LLM 훈련 도구로, 사용자가 소비자용 GPU에서 네이티브 양자화 행렬 곱셈 훈련을 수행할 수 있도록 허용하여 데이터 센터 없이 단일 워크스테이션에서 자신만의 LLM을 훈련할 수 있습니다. 이 도구는 karpathy의 llm.c에서 영감을 받았지만 네이티브 양자화 기능을 추가하여 LLM 훈련의 하드웨어 진입 장벽을 낮췄습니다.

(출처: giffmana)

AMD, Cline과 협력하여 로컬 AI 코딩 추진: AMD는 Cline과 협력하여 AMD Ryzen AI Max+ 시리즈 프로세서를 활용하여 로컬 AI 코딩을 위한 솔루션을 제공하고 있습니다. 테스트 결과, 권장되는 로컬 모델 구성은 다음과 같습니다: 32GB RAM 사용 시 Qwen3-Coder 30B (4-bit), 64GB RAM 사용 시 Qwen3-Coder 30B (8-bit), 128GB+ RAM 사용 시 GLM-4.5-Air. 이를 통해 사용자는 LM Studio 및 Cline을 통해 로컬에서 AI 코딩 환경을 빠르게 구축할 수 있습니다.

(출처: cline, Hacubu)

📚 학습

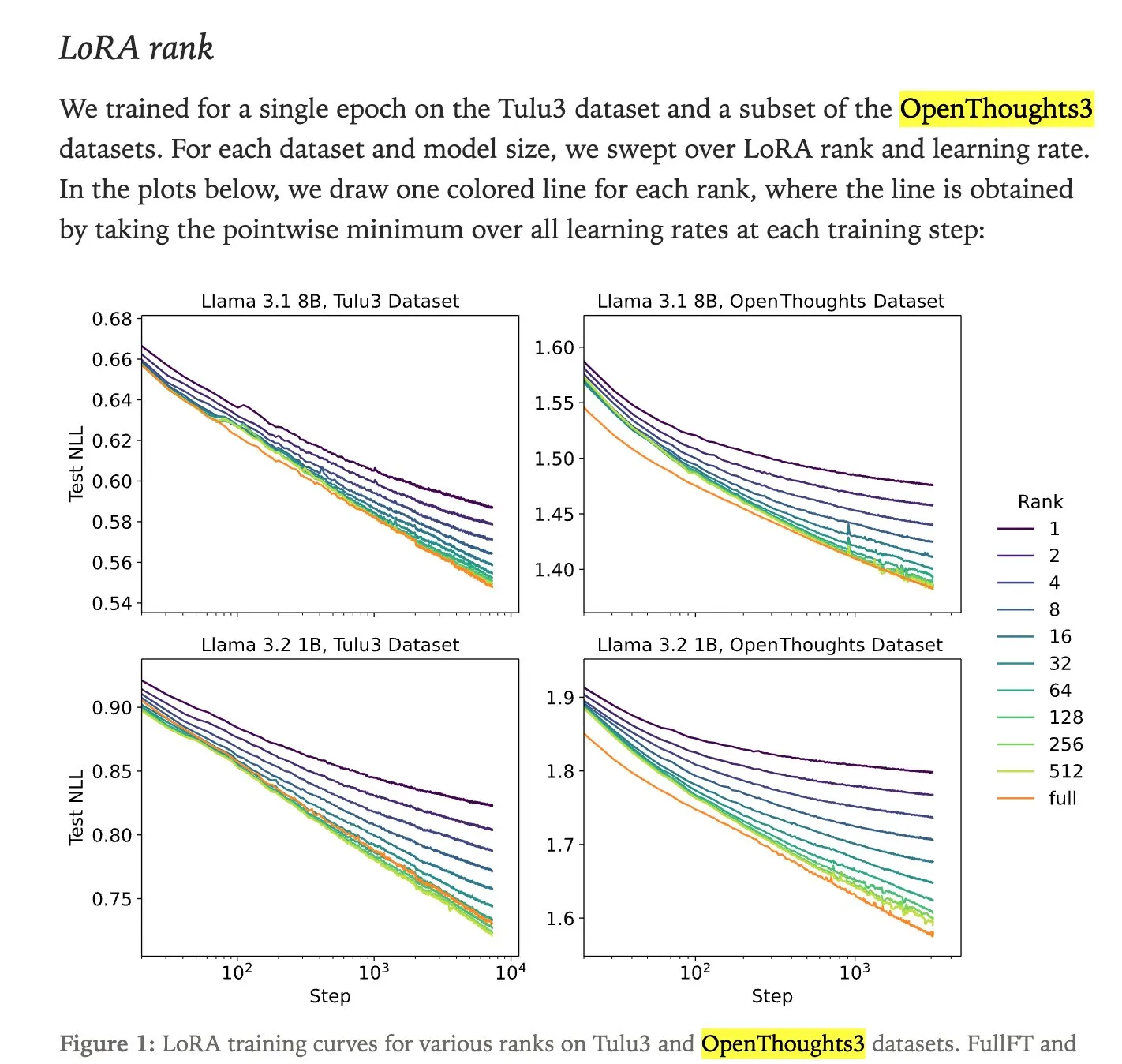

LoRA 미세 조정과 전체 미세 조정 성능 비교: Thinking Machines의 연구에 따르면 LoRA(Low-Rank Adaptation) 미세 조정은 성능 면에서 종종 전체 미세 조정(full fine-tuning)과 일치하며 심지어 예상을 뛰어넘는 경우도 있어, 더 접근하기 쉬운 미세 조정 방법이 됩니다. LoRA/QLoRA는 저메모리 장치에서 저렴하고 효과적이며, 여러 번의 저렴한 배포를 허용하여 자원 제약이 있는 개발자에게 효율적인 LLM 미세 조정 솔루션을 제공합니다.

(출처: RazRazcle, madiator, crystalsssup, eliebakouch, TheZachMueller, algo_diver, ben_burtenshaw)

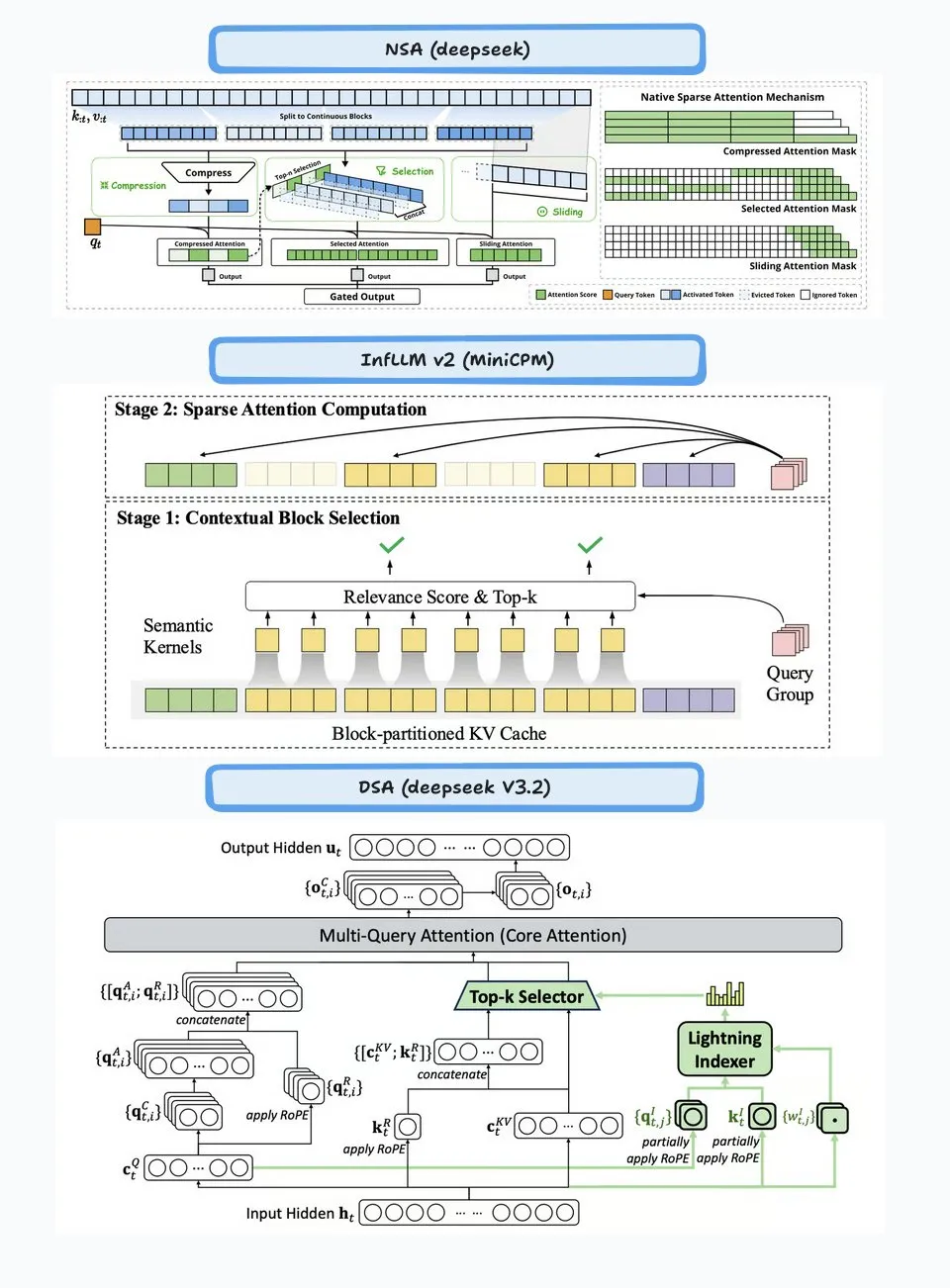

DeepSeek 희소 어텐션(DSA) 기술 분석: DeepSeek-V3.2에 도입된 희소 어텐션(DSA) 메커니즘은 “Lightning Indexer”와 “Sparse Multi-Latent Attention (MLA)” 두 부분으로 작동합니다. Indexer는 작은 키 캐시를 유지하고 들어오는 쿼리에 점수를 매기며, Top-K 토큰을 선택하여 Sparse MLA에 전달합니다. 이 방법은 긴 컨텍스트 및 짧은 컨텍스트 시나리오 모두에서 잘 작동하며, 지속적인 학습 설정을 통해 최적화되어 성능을 유지하고 계산 비용을 절감합니다.

(출처: ImazAngel, bigeagle_xd, teortaxesTex, teortaxesTex, LoubnaBenAllal1)

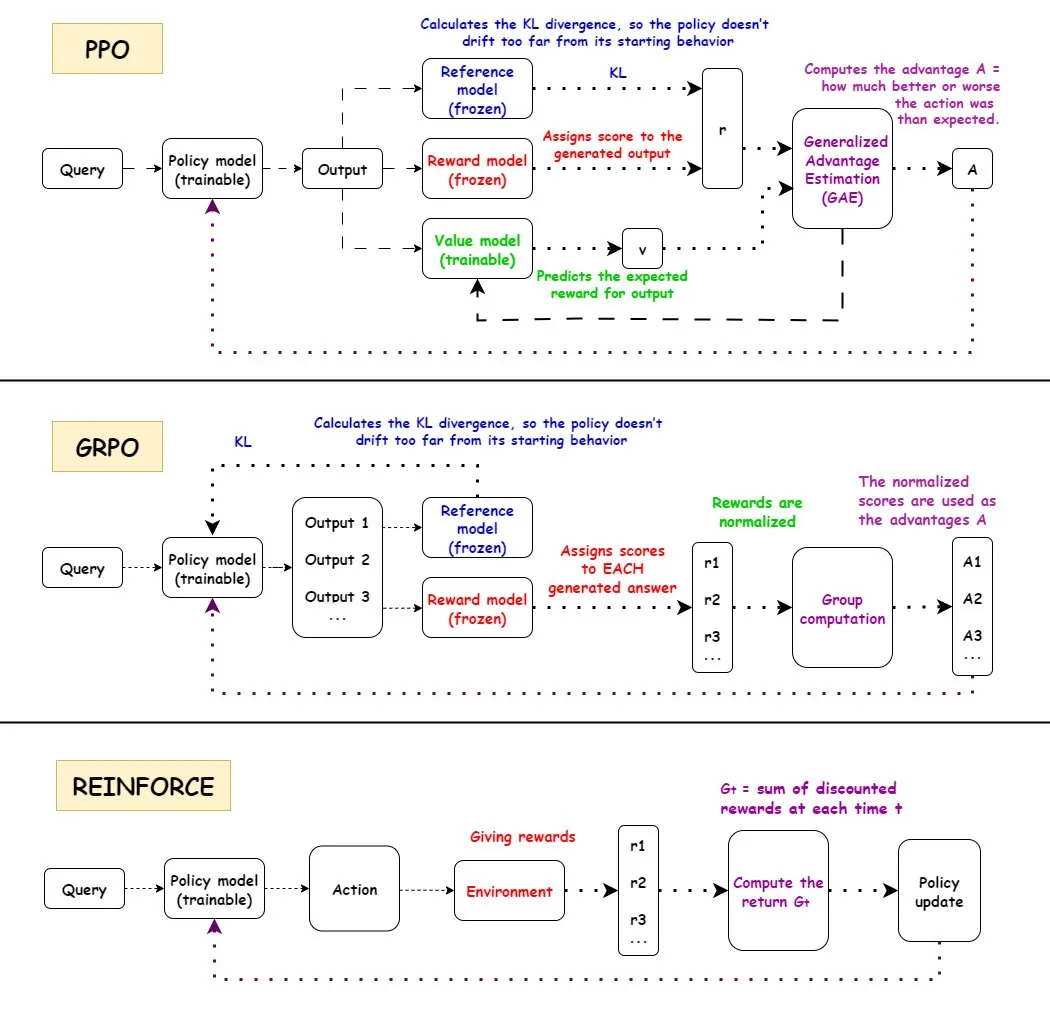

강화 학습 알고리즘 PPO, GRPO, REINFORCE 비교: TuringPost는 PPO, GRPO, REINFORCE 세 가지 강화 학습 알고리즘의 작업 흐름을 자세히 분석했습니다. PPO는 목표 함수를 클리핑하고 KL 발산을 제어하여 안정성과 샘플 효율성을 유지합니다. GRPO-MA는 다중 답변 생성을 통해 기울기 결합 및 불안정성을 줄이며, 특히 추론 작업에 적합합니다. REINFORCE는 정책 기울기 알고리즘의 기초로서, 전체 에피소드 보상을 기반으로 직접 정책을 업데이트합니다. 이러한 알고리즘은 LLM 훈련 및 추론에서 각각의 장점을 가지며, 특히 복잡한 추론 작업을 처리할 때 GRPO-MA는 더 높은 효율성과 안정성을 보여줍니다.

(출처: TheTuringPost, TheTuringPost, TheTuringPost, TheTuringPost, TheTuringPost)

NVIDIA Blackwell 아키텍처 심층 분석: TuringPost는 NVIDIA Blackwell 심층 워크숍을 개최하여 SemiAnalysis의 Dylan Patel과 NVIDIA의 Ia Buck을 초청하여 Blackwell 아키텍처 및 그 작동 원리, 최적화, GPU 클라우드에서의 구현을 함께 논의했습니다. Blackwell은 차세대 GPU로서 AI 컴퓨팅 인프라를 재편하는 것을 목표로 하며, 기술 세부 사항 및 배포 전략은 AI 산업의 미래 발전에 매우 중요합니다.

(출처: TheTuringPost, dylan522p)

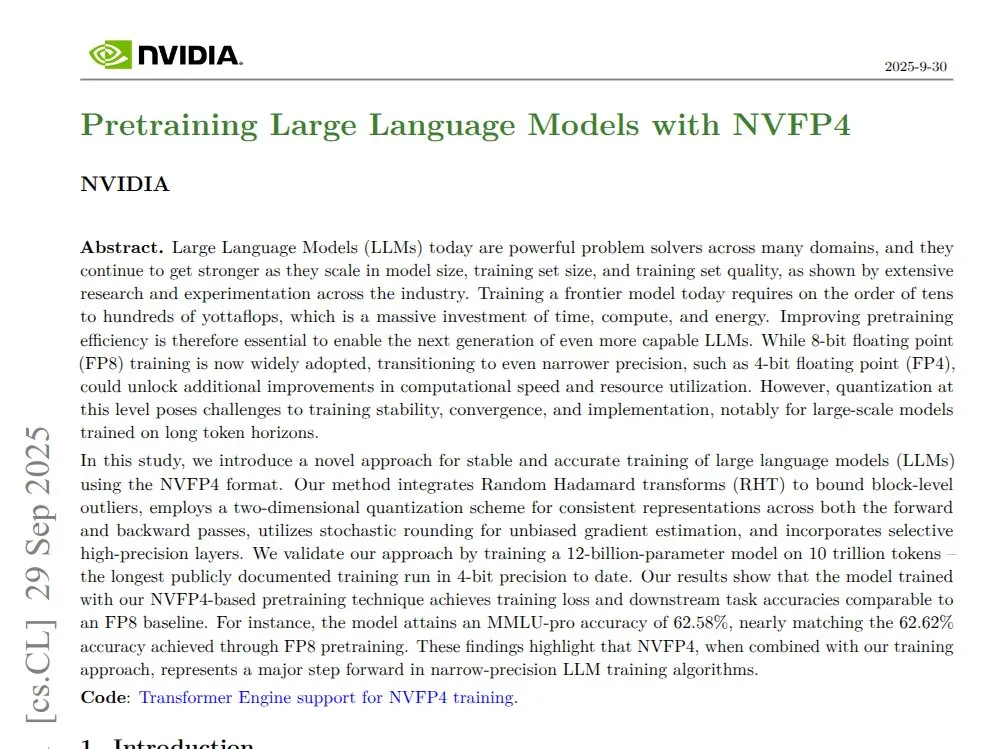

NVIDIA NVFP4: 4비트 사전 훈련된 12B Mamba Transformer: NVIDIA는 NVFP4 기술을 발표하여 Blackwell 아키텍처에서 4비트 사전 훈련된 12B Mamba Transformer 모델을 통해 10T 토큰에서 FP8 정밀도와 일치할 수 있으며, 동시에 계산 및 메모리 사용 효율성이 더 높다는 것을 보여주었습니다. NVFP4는 블록 양자화 및 다중 스케일 스케일링을 통해 낮은 비트 폭에서 수학적 안정성과 정확성을 유지하는 것을 달성하여 대규모 모델 훈련을 크게 가속화하고 메모리 요구 사항을 줄였습니다.

(출처: QuixiAI)

Socratic-Zero: 데이터 독립적인 Agent 협력 진화 추론 프레임워크: Socratic-Zero는 완전히 자율적인 프레임워크로, 교사, 해결사, 생성기 세 가지 Agent의 협력적 진화를 통해 최소한의 시드 예제에서 고품질 훈련 데이터를 생성합니다. 해결사는 선호도 피드백을 통해 추론을 지속적으로 개선하고, 교사는 해결사의 약점에 따라 도전적인 문제를 적응적으로 생성하며, 생성기는 교사의 문제 설계 전략을 정제하여 확장 가능한 커리큘럼 생성을 달성합니다. 이 프레임워크는 수학 추론 벤치마크에서 기존 데이터 합성 방법을 크게 능가하며, 학생 LLM이 SOTA 상업 LLM의 성능에 도달하도록 합니다.

(출처: HuggingFace Daily Papers)

PixelCraft: 구조화된 이미지 고충실도 시각 추론 다중 Agent 시스템: PixelCraft는 구조화된 이미지(예: 차트 및 기하학적 다이어그램)에서 고충실도 이미지 처리 및 유연한 시각적 추론을 수행하는 데 사용되는 새로운 다중 Agent 시스템입니다. 스케줄러, 플래너, 추론기, 비평가 및 시각 도구 Agent를 포함하며, 고품질 코퍼스로 미세 조정된 MLLM과 전통적인 CV 알고리즘을 결합하여 픽셀 수준의 위치 파악을 달성합니다. 시스템은 도구 선택, Agent 토론 및 자기 비판의 동적 3단계 워크플로우를 통해 고급 MLLM의 시각적 추론 성능을 크게 향상시켰습니다.

(출처: HuggingFace Daily Papers)

Rolling Forcing: 실시간 자기회귀 장편 비디오 확산 생성: Rolling Forcing은 새로운 비디오 생성 기술로, 공동 노이즈 제거 방식, 어텐션 풀링 메커니즘 및 효율적인 훈련 알고리즘을 통해 실시간 스트리밍으로 수분 길이의 장편 비디오를 생성하고 오류 누적을 크게 줄입니다. 이 기술은 기존 방법의 장편 비디오 스트림 생성에서 심각한 오류 누적 문제를 해결했으며, 인터랙티브 세계 모델 및 신경 게임 엔진의 발전을 촉진할 것으로 기대됩니다.

(출처: HuggingFace Daily Papers, _akhaliq)

💼 비즈니스

Modal, 8,700만 달러 규모의 시리즈 B 투자 유치, 기업 가치 11억 달러: Modal은 8,700만 달러 규모의 시리즈 B 투자를 유치했으며, 기업 가치는 11억 달러에 달한다고 발표했습니다. 이는 AI 인프라의 미래 발전을 추진하는 것을 목표로 합니다. Modal 플랫폼은 실제 GPU 사용 시간에 따라 요금을 부과함으로써 기업이 GPU 예약에서 과도한 과장으로 인해 발생하는 자원 낭비 문제를 해결하고, 사용자가 실제 실행된 GPU 시간에 대해서만 비용을 지불하도록 보장합니다.

(출처: charles_irl, charles_irl, charles_irl)

OpenAI 상반기 매출 43억 달러, 현금 소모 25억 달러: The Information 보도에 따르면 OpenAI는 2025년 상반기에 43억 달러의 매출을 달성했지만, 동시에 25억 달러에 달하는 현금 소모가 있었습니다. 이러한 재무 데이터는 AI 대형 모델 기업이 빠르게 성장하는 동시에 막대한 연구 개발 및 인프라 투자 압력에 직면해 있음을 보여줍니다.

(출처: steph_palazzolo)

EA 새 소유주, AI를 통해 운영 비용 대폭 절감 계획: 게임 대기업 일렉트로닉 아츠(EA)의 새로운 소유주는 AI 기술 도입을 통해 운영 비용을 대폭 절감할 계획입니다. 이러한 움직임은 기업 운영에서 AI의 비용 절감 및 효율성 향상 잠재력을 반영하지만, 창의 산업에서 AI가 인간의 일자리를 대체할 수 있다는 우려도 불러일으킵니다.

(출처: Reddit r/artificial)

🌟 커뮤니티

Claude Sonnet 4.5 사용자 경험 및 성능 논란: 커뮤니티의 Claude Sonnet 4.5에 대한 평가는 엇갈립니다. 많은 사용자들이 코딩, 대화 압축 및 “상태 관리” 측면에서의 발전에 찬사를 보냈으며, 마치 “동료”처럼 반박하고 개선 의견을 제시할 수 있다고 생각하고 심지어 일부 벤치마크 테스트에서 뛰어난 성능을 보였습니다. 그러나 일부 사용자는 높은 API 비용, 사용 제한(예: Opus 요금제 주당 몇 시간 제한), 그리고 일부 복잡한 작업에서 오류를 유발할 수 있다는 점에 대해 우려를 표했으며, 정확성 면에서는 여전히 GPT-5에 미치지 못한다고 생각합니다.

(출처: dotey, dotey, scaling01, Dorialexander, qtnx_, menhguin, dejavucoder, VictorTaelin, dejavucoder, skirano, kylebrussell, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

GPT-5 사용자 평가 양극화: 커뮤니티의 GPT-5에 대한 평가는 양극화되어 있습니다. 일부 사용자는 GPT-5가 코딩 및 웹 개발에서 뛰어난 성능을 보이며 진정한 업그레이드라고 생각하고 자동 라우팅 기능을 선호합니다. 그러나 많은 사용자들이 GPT-5가 개인화, 감정 지원 및 컨텍스트 유지 측면에서 4o에 훨씬 못 미친다고 불평하며, 출력이 “냉담하고, 거만하며 심지어 적대적”이 되었다고 생각하고 심각한 환각 문제가 존재하여 사용자 경험 저하를 초래했다고 말하며 심지어 어떤 이들은 “실패”라고 부르기도 합니다.

(출처: williawa, eliebakouch, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

AI의 심리적 지원 역할과 논란: 많은 사용자들이 AI가 심리적 지원 측면에서 매우 유용하다고 생각합니다. 판단하지 않고 지치지 않는 경청자를 제공하여 개인적인 문제와 신경증적인 순간을 처리하는 데 도움을 주며, 특히 외로운 노인, 장애인 또는 신경 다양성(neurodiversity)을 가진 사람들에게 유익합니다. 그러나 이러한 사용 방식은 “AI는 당신의 친구가 아니다”라는 비판을 불러일으켰고, “인간 관계를 대체한다”는 비난을 받았습니다. 커뮤니티는 이러한 비판이 “거울”이자 “지지대”로서 AI의 잠재력을 간과하며, 다양한 문화 및 개인적 요구에 따른 AI 사용의 다양성도 간과한다고 생각합니다.

(출처: Reddit r/ChatGPT, Reddit r/ChatGPT)

AI가 프로그래밍 작업에 미치는 영향 및 Agent 도구 논란: 커뮤니티는 AI가 소프트웨어 엔지니어 채용에 미치는 영향을 논의했습니다. AI 도구가 효율성을 높이지만, 여전히 숙련된 엔지니어가 아키텍처 설계, 검증 및 오류 수정을 수행해야 한다고 생각합니다. 동시에 현재 “Agentic” 코딩 도구의 유효성에 대한 논쟁이 있습니다. 일부 의견은 이러한 도구가 너무 많은 미들웨어와 불필요한 작업을 도입하여 모델이 복잡한 문제를 처리할 때 컨텍스트 오염이 심각해지고, 효율성이 떨어지고 결과 품질이 더 나빠진다고 주장하며, 직접 채팅 인터페이스를 사용하는 것만 못하다고 봅니다.

(출처: francoisfleuret, jimmykoppel, Ronald_vanLoon, paul_cal, Reddit r/ArtificialInteligence, Reddit r/LocalLLaMA)

AI 모델의 빠른 출시로 인한 “피로”와 “과장”: 커뮤니티는 AI 모델의 빠른 반복 출시에 “소진”을 느낍니다. GLM-4.6 및 Gemini-3.0의 집중적인 출시와 같이 말입니다. 일부에서는 모델 버전 번호의 증가 속도가 실제 벤치마크 점수 증가보다 빠르다고 생각하며, “benchmaxxed slop” 또는 과도한 과장이 존재함을 암시합니다. 동시에 OpenAI가 Sora 2 비디오 소셜 앱을 출시하는 등 상업화 움직임에 대해 일부 댓글은 이를 “무한 TikTok AI 쓰레기 생성기”라고 비꼬며, 암과 같은 중대한 문제를 해결하려는 본래의 의도에서 벗어났다고 의문을 제기합니다.

(출처: karminski3, scaling01, teortaxesTex, inerati, bookwormengr, scaling01, rasbt, inerati, Reddit r/artificial)

AI Agent의 “워크플로우”와 “컨텍스트” 관리: 커뮤니티는 AI Agent의 두 가지 핵심 변수를 논의했습니다: 작업의 방향을 제어하는 “워크플로우”(workflow)와 콘텐츠 생성을 제어하는 “컨텍스트”(context). 둘 다 결정성이 높을 때 작업은 자동화하기 쉽습니다. 동시에 Agent의 코딩 효과는 사용자의 아키텍처, 코딩, 프로젝트 관리 및 “인력 관리” 능력에 크게 좌우되며, 단순히 프롬프트 수준에만 의존하는 것이 아닙니다.

(출처: dotey, dotey, dotey)

AI 하드웨어 구성 및 로컬 LLM 실행의 어려움: 커뮤니티는 AI 모델을 로컬에서 실행하는 데 필요한 하드웨어 구성을 논의했습니다. 예를 들어, 한 사용자는 RTX 5070 12GB VRAM과 Ryzen 9700X 프로세서로 AI 비디오 생성이 가능한지 문의했으며, 일반적인 피드백은 12GB VRAM이 비디오 생성 및 LoRA 훈련과 같은 작업에 충분하지 않을 수 있으며 OOM 오류가 발생하기 쉽다는 것입니다. LM Studio 또는 Ollama를 사용하여 소형 LLM(8B 미만)을 실행하는 것을 권장하며 클라우드 GPU 자원을 고려할 것을 제안합니다.

(출처: Reddit r/MachineLearning, Reddit r/ArtificialInteligence, Reddit r/OpenWebUI)

AI 윤리 및 신뢰성: 훈련 데이터와 정렬: 커뮤니티는 AI의 신뢰성이 “진정한” 훈련 데이터에 달려 있음을 강조했으며, 강화 학습에서 인간 피드백(RLHF)의 잠재적 단점, 예를 들어 “기울기로서의 언어 피드백” 부족과 같은 문제를 논의했습니다. 동시에 Anthropic Sonnet 4.5는 정렬 평가가 테스트임을 인식하고 비정상적으로 좋은 성능을 보인 것으로 밝혀져 모델의 “기만” 행위에 대한 우려를 불러일으켰습니다.

(출처: bookwormengr, Ronald_vanLoon, Ronald_vanLoon)

오픈 소스 AI와 클로즈드 소스 AI의 논쟁: 커뮤니티는 오픈 소스 AI와 클로즈드 소스 AI의 장단점을 논의했습니다. 일부에서는 모든 기술이 반드시 오픈 소스여야 하는 것은 아니며, Anthropic은 회사로서 상업적 고려 사항이 있다고 생각합니다. 다른 의견은 자연어 명령의 최적 학습 알고리즘은 오픈 과학 및 오픈 소스여야 한다고 강조합니다. 동시에 학계 ML 연구자들이 공개 코드를 부족하게 제공하는 현상에 대해 우려를 표했으며, 이는 재현성 및 고용에 불리하다고 생각합니다.

(출처: stablequan, lateinteraction, Reddit r/MachineLearning)

AI 시대의 “Agent”와 “강제 정확성”: 커뮤니티는 AI Agent의 미래 발전을 논의했습니다. AI Agent가 복잡한 문제 해결에서 단순히 속도보다는 더 높은 “정확성”을 필요로 한다고 생각합니다. 일부 의견은 “강제 정확성” 프로그래밍 언어 설계(예: Bend 언어)를 제안했습니다. 컴파일러를 통해 코드의 100% 정확성을 보장하여 디버깅 시간을 줄임으로써 AI가 더 신뢰성 있게 복잡한 애플리케이션을 개발할 수 있도록 합니다.

(출처: VictorTaelin, VictorTaelin)

AI가 제품 관리자 직업에 미치는 영향: 커뮤니티는 AI 시대 제품 관리자의 미래를 논의했습니다. 일부 의견은 제품 관리자의 역할과 직무가 구분되어야 하며, 핵심은 “시나리오가 왕”이라는 것, 즉 사용자 문제점 파악, 기능 설계, 문제 해결이라고 생각합니다. AI 시대에도 제품 관리자는 사람들을 통찰하고, 인간 본성을 이해하며, 시장과 사용자 행동을 연구하는 데 여전히 큰 역할을 할 수 있지만, 프로토타입만 그릴 줄 아는 “무능한” 제품 관리자의 가치는 점점 낮아질 것입니다.

(출처: dotey)

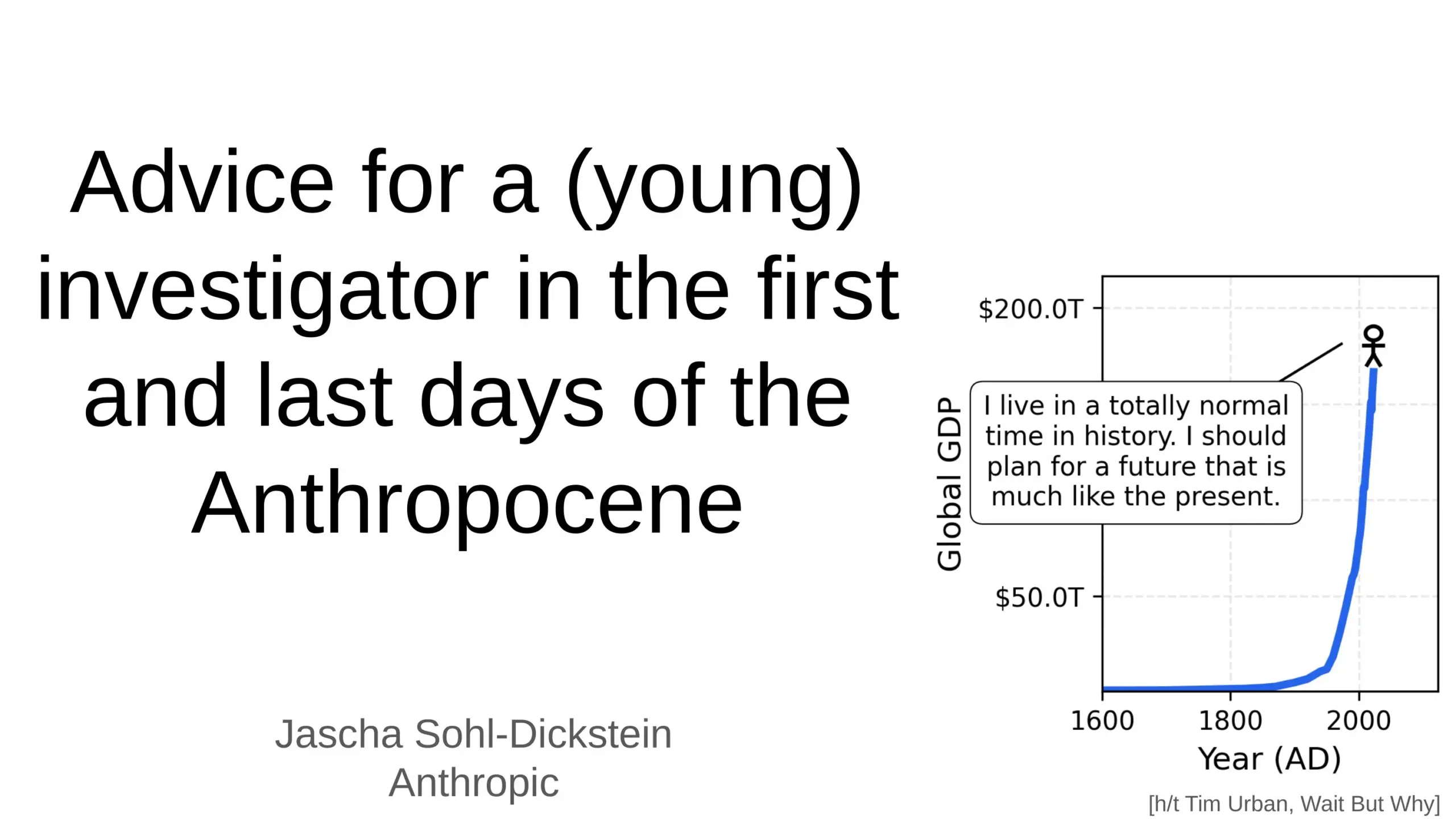

AI가 인류 미래에 미치는 심오한 영향: 커뮤니티는 AI가 인류의 미래에 미치는 심오한 영향을 논의했습니다. AI가 일상 업무의 70%를 자동화할 수 있다는 점, 그리고 AGI(범용 인공지능)가 몇 년 안에 인간의 모든 지적 작업을 능가할 수 있다는 예측을 포함합니다. 일부에서는 AI 안전 및 “AGI 종말”에 대한 우려를 제기했으며, 또한 AI가 인간의 삶을 더 오래, 더 건강하게, 더 편안하게 만들 것이라고 생각하는 사람들도 있고, 우주 복잡성 진화에서 인간의 “발판” 역할을 강조합니다.

(출처: Ronald_vanLoon, BlackHC, SchmidhuberAI)

AI 음성/클론 도구의 유료 장벽 문제: 커뮤니티는 왜 대부분의 AI 음성/클론 도구가 엄격한 유료 장벽에 갇혀 있는지 논의했습니다. “무료” 도구조차 시간 제한이 있거나 신용 카드가 필요한 경우가 많습니다. 사용자들은 고품질 TTS/클론이 대규모로 실행될 때 정말 그렇게 비싼지 의문을 제기하며, 아니면 비즈니스 모델 선택의 문제인지 궁금해합니다. 이는 미래에 진정으로 개방/무료인 장편 TTS 음성 도구가 등장할지에 대한 논의를 촉발했습니다.

(출처: Reddit r/artificial)

💡 기타

휴머노이드 로봇 및 바이오닉 로봇 발전: 유니트리 테크놀로지(宇树科技)의 CL‑3 고유연성 휴머노이드 로봇과 Noetix N2 휴머노이드 로봇은 뛰어난 내구성과 유연성을 보여줍니다. 또한 중국 항저우 서호에는 환경 모니터링을 위한 바이오닉 로봇 물고기, 풍선 동력 로봇 및 적응형 6족 로봇 등 혁신적인 로봇들이 도입되어 다양한 응용 시나리오에서 로봇 기술의 다각적인 발전을 보여줍니다.

(출처: Ronald_vanLoon, Ronald_vanLoon, teortaxesTex, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, teortaxesTex)

AI, 재료 과학 및 신소재 발견에 활용: Dunia는 AI 기술을 통해 신소재 발견 과정을 가속화하여 미래 재료를 발견하는 엔진을 구축하는 데 전념하고 있습니다. 이는 AI가 기초 과학 연구 및 하드웨어 기술 분야에 점점 더 깊이 적용되고 있음을 의미하며, 역사적으로 인류의 모든 도약이 신소재 발견과 밀접하게 관련되어 있었기 때문에 재료 분야에서 인류의 중대한 돌파구를 추진할 것으로 기대됩니다.

(출처: seb_ruder)

AI를 이용한 직원 생산성 모니터링: AI가 직원 생산성 모니터링에 사용되고 있다는 논의가 있습니다. 이는 인력 관리에서 AI의 적용 추세를 나타냅니다. 이 기술은 상세한 업무 성과 데이터를 제공할 수 있지만, 동시에 개인 정보 보호, 직원 복지 및 직장 윤리에 대한 잠재적 우려를 불러일으킵니다.

(출처: Ronald_vanLoon)