키워드:AI, 메타, 오픈AI, 안트로픽, 엔비디아, LLM, 휴머노이드 로봇, 개인 초지능, 챗GPT 학습 모드, 워커 S2 자동 배터리 교체, Qwen3-30B-A3B-Thinking-2507, 알파어스 파운데이션스

🔥 포커스

Meta, 개인 슈퍼 인텔리전스 비전 발표 : Mark Zuckerberg는 Meta의 ‘개인 슈퍼 인텔리전스’에 대한 미래 비전을 공유하며, 모든 사람에게 세계적 수준의 AI assistant, AI creator, AI enterprise interaction tools를 제공할 것이라고 강조했습니다. 이 비전은 AI를 통해 모든 사용자의 역량을 강화하고 open-source model 발전을 추진하는 것을 목표로 합니다. 그러나 이러한 움직임은 커뮤니티에서 ‘슈퍼 인텔리전스’ 정의에 대한 논의를 촉발했으며, 예측 불가능한 ‘singularity moment’를 가져올지, 아니면 단순히 virtual social extension에 불과한지에 대한 의문을 제기했습니다. (출처: AIatMeta)

ACL 2025 최우수 논문 발표 : 2025년 ACL(계산언어학회 연례회의)에서 최우수 논문상이 발표되었으며, 베이징 대학, DeepSeek, 워싱턴 대학이 공동 연구한 “Native Sparse Attention”과 베이징 대학의 “Language Models Resist Alignment: Evidence from Data Compression”이 수상의 영예를 안았습니다. 특히, 논문 저자의 절반 이상이 중국계인 것으로 나타났습니다. 또한 ACL은 신경 기계 번역 및 의미 역할 라벨링 등 분야에 깊은 영향을 미친 기념비적인 연구들을 표창하는 25년 및 10년 Test-of-Time 상도 수여했습니다. (출처: karminski3)

Anthropic, 영국 AI 안전 연구소 정렬 프로젝트 참여 : Anthropic은 영국 AI 안전 연구소(UK AI Safety Institute)의 정렬 프로젝트에 참여하여 핵심 연구를 추진하기 위한 컴퓨팅 자원을 기여할 것이라고 발표했습니다. 이는 AI 시스템의 능력이 계속 향상됨에 따라 예측 가능성을 유지하고 인간의 가치에 부합하도록 보장하기 위함입니다. 이러한 협력은 선도적인 AI 기업들이 미래 AI 시스템이 가져올 수 있는 복잡한 도전에 대응하기 위해 AI 안전 및 정렬 연구를 중요하게 생각하고 있음을 보여줍니다. (출처: AnthropicAI)

🎯 동향

OpenAI, ChatGPT 학습 모드 출시 : OpenAI가 ChatGPT ‘학습 모드’를 공식 출시했습니다. 이 모드는 소크라테스식 질문, 단계별 지침, 개인화된 지원을 통해 학생들이 직접적인 답변을 얻기보다는 능동적으로 사고하도록 유도하는 것을 목표로 합니다. 이 모드는 모든 ChatGPT 사용자에게 개방되었으며, 향후 시각화, 목표 설정, 진행 상황 추적 등의 기능도 확장될 예정입니다. 이는 OpenAI가 교육 기술 시장에 진출하는 중요한 단계로 간주되며, 교육 분야에서 AI의 역할과 잠재적인 ‘wrapper application’ 충격에 대한 광범위한 논의를 불러일으켰습니다. (출처: 量子位, 36氪)

UBTECH Walker S2 휴머노이드 로봇, 자율 배터리 교체 실현 : 중국 UBTECH Robotics는 풀사이즈 산업용 휴머노이드 로봇 Walker S2를 공개하며 세계 최초의 자율 배터리 교체 시스템을 선보였습니다. Walker S2는 3분 이내에 배터리 교체를 원활하게 완료하여 7×24시간 중단 없이 작업할 수 있어 산업 현장의 작업 효율성을 크게 향상시킵니다. 이 로봇은 AI dual-loop system, pure RGB binocular vision, 52 degrees of freedom을 갖추고 있으며, 자동차 제조와 같은 고강도 작업을 지원하는 것을 목표로 하여 로봇의 인간 대체 및 미래 작업 모델에 대한 논의를 불러일으켰습니다. (출처: 量子位, Ronald_vanLoon)

Qwen 시리즈 모델 지속적인 업데이트 및 성능 향상 : Qwen 팀은 최근 ‘사고’ 능력을 갖춘 Qwen3-30B-A3B-Thinking-2507 중형 모델을 발표했습니다. 이 모델은 reasoning, code, math 작업에서 뛰어난 성능을 보이며 256K long context를 지원합니다. 동시에 Qwen3 Coder 30B-A3B도 곧 출시될 예정이며, code generation 능력을 더욱 향상시킬 것입니다. 이러한 업데이트는 LLM 분야에서 Qwen 시리즈의 경쟁력을 강화하며, Anycoder 등의 도구에 이미 통합되었습니다. (출처: Alibaba_Qwen, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Google DeepMind 지구 및 역사 AI 모델 진행 상황 : Google DeepMind는 놀라운 세부 정보로 지구 지도를 그리고 방대한 지리 데이터를 통합하는 것을 목표로 하는 AlphaEarth Foundations를 출시했습니다. 동시에 Aeneas 모델은 AI를 통해 고대 라틴어 텍스트를 분석하여 역사가들이 역사를 정량적으로 모델링하는 데 도움을 줍니다. 이 모델들은 환경 모니터링 및 인문 역사 연구 분야에서 AI의 강력한 적용 잠재력을 보여줍니다. (출처: GoogleDeepMind, GoogleDeepMind)

Arcee, AFM-4.5B open-weight 모델 출시 : Arcee는 기업용 애플리케이션을 위해 설계된 open-weight language model인 AFM-4.5B 및 해당 Base 버전을 공식 출시했습니다. AFM-4.5B는 다양한 배포 환경에서 유연성과 고성능을 제공하는 솔루션을 목표로 하며, 고품질 출력을 보장하기 위해 훈련 데이터가 엄격하게 선별되었습니다. 이 모델의 출시는 기업이 AI 애플리케이션을 구축하고 배포하는 데 필요한 고급 open-source AI 선택지를 더 많이 제공합니다. (출처: code_star, stablequan)

GLM-4.5 모델, EQ-Bench 및 장문 작성에서 강력한 성능 발휘 : Z.ai의 GLM-4.5 모델은 EQ-Bench 및 장문 작성 벤치마크 테스트에서 매우 뛰어난 결과를 달성하며, reasoning, coding, agent 능력에서 통합적인 강점을 보여주었습니다. 이 모델은 GLM-4.5 및 GLM-4.5-Air 두 가지 버전으로 제공되며, HuggingFace에서 공개되었고 일부 버전은 무료 체험도 가능합니다. 강력한 성능과 도전적인 prompt를 빠르게 처리하는 능력은 복잡한 애플리케이션 시나리오에서의 잠재력을 시사합니다. (출처: Zai_org, jon_durbin)

Mistral AI, Codestral 25.08 출시 : Mistral AI는 최신 Codestral 25.08 모델을 출시하고, 기업용 완전한 Mistral coding stack을 선보였습니다. 이는 기업에 더욱 강력한 code generation 능력과 개선된 개발 도구를 제공하여, AI 프로그래밍 분야에서 Mistral AI의 시장 지위를 더욱 공고히 하는 것을 목표로 합니다. (출처: MistralAI)

NVIDIA, Hugging Face에서 모델/데이터셋/애플리케이션 성장 두드러져 : AI World 데이터에 따르면, NVIDIA는 지난 12개월 동안 Hugging Face에 365개의 새로운 public model, dataset, application을 추가하여 하루 평균 한 개꼴로 놀라운 성장 속도를 보였습니다. 이러한 성장은 NVIDIA가 하드웨어 분야에서 지배적인 위치를 차지할 뿐만 아니라, open-source AI 생태계에서도 강력한 영향력을 발휘하며 AI 기술의 보급과 응용을 적극적으로 추진하고 있음을 나타냅니다. (출처: ClementDelangue)

Llama 추론 속도 5% 향상 : 새로운 Fast Attention 알고리즘이 SoftMax 함수의 속도를 약 30% 향상시켜, Meta LLM의 A100 GPU에서의 inference 시간을 5% 단축시켰습니다. 이 최적화는 LLM의 실행 효율성을 높이고 inference 비용을 절감하여, 대규모 배포 및 실시간 애플리케이션에 중요한 의미를 가집니다. (출처: Reddit r/LocalLLaMA)

Skywork-UniPic-1.5B 통합 autoregressive multimodal model 출시 : Skywork가 Skywork-UniPic-1.5B를 출시했습니다. 이는 통합 autoregressive multimodal model로, 다양한 modality 데이터를 처리할 수 있어 multimodal AI 연구 및 애플리케이션에 새로운 기반을 제공합니다. (출처: Reddit r/LocalLLaMA)

Google, 가상 시착 AI 기능 출시 : Google이 새로운 AI 기능을 출시하여 사용자가 온라인에서 가상으로 옷을 시착할 수 있게 했습니다. 이 기술은 AI generative capability를 활용하여 소비자에게 더욱 직관적이고 개인화된 쇼핑 경험을 제공하며, 반품율을 줄이고 e-commerce conversion rate를 높일 것으로 기대됩니다. (출처: Ronald_vanLoon)

LimX Dynamics, 휴머노이드 로봇 Oli 출시 : LimX Dynamics가 신형 휴머노이드 로봇 Oli를 공식 출시했습니다. 가격은 약 2.2만 달러입니다. Oli는 키 5‘5”, 무게 55kg이며, 31 degrees of freedom을 가지고 자체 개발한 6축 IMU를 장착했습니다. 모듈형 SDK와 완전 개방형 Python 개발 인터페이스를 지원하여 연구 및 개발을 위한 유연한 플랫폼을 제공하며, 휴머노이드 로봇의 더 많은 시나리오 적용을 추진할 것으로 기대됩니다. (출처: teortaxesTex)

🧰 도구

LangSmith, Align Evals 기능 출시 : LangSmith가 새로운 Align Evals 기능을 출시했습니다. 이 기능은 LLM-as-a-Judge evaluator 생성 과정을 간소화하는 것을 목표로 합니다. 이 기능은 사용자가 LLM 점수를 인간의 선호도와 일치시켜 더 정확하고 신뢰할 수 있는 evaluator를 구축하고 평가 작업의 불확실성을 줄이는 데 도움을 줍니다. (출처: hwchase17)

NotebookLM, 동영상 개요 기능 추가 : Google의 NotebookLM이 동영상 개요 기능을 출시했습니다. 사용자는 노트 내용에 대해 시각적으로 매력적인 slideshow summary를 생성할 수 있습니다. 이 기능은 Gemini 모델을 활용하여 text presentation script를 생성하고, 내부 도구와 결합하여 static image와 독립적인 audio를 생성한 후 최종적으로 동영상을 합성하여 사용자에게 더욱 풍부한 학습 및 콘텐츠 표시 방식을 제공합니다. (출처: JeffDean, cto_junior)

Qdrant Cloud Inference 및 LLM 데이터 처리 : Qdrant Cloud Inference는 사용자가 vector database를 벗어나지 않고도 text, image, sparse vector를 native embedding할 수 있도록 지원하며, BGE, MiniLM, CLIP, SPLADE 등의 모델을 지원합니다. 또한, 커뮤니티에서는 LLM이 URL을 정보원으로 직접 참조하는 기능과 LLM이 URL 콘텐츠를 주기적으로 확인, 캐싱, 새로 고침할 가능성을 논의하여 AI의 신뢰성과 유용성을 높이는 방안을 모색했습니다. (출처: qdrant_engine, Reddit r/OpenWebUI)

Replit Agent, 실시간 대시보드 생성 지원 : Replit Agent는 기존 쓰나미 경보 웹사이트의 정보 혼란 문제를 해결하기 위해 접근 가능한 실시간 대시보드를 빠르게 생성하는 데 사용되었습니다. 이 사례는 데이터 시각화 및 사용자 인터페이스 설계 분야에서 AI agent의 잠재력을 보여주며, 복잡한 데이터를 이해하기 쉬운 interactive interface로 전환할 수 있음을 나타냅니다. (출처: amasad)

Hugging Face ML 인프라 도구 : Hugging Face와 Gradio는 머신러닝 실험 추적을 위한 local-first solution인 trackio를 공동 출시했습니다. 이를 통해 사용자는 핵심 지표를 Hugging Face Datasets에 영구적으로 저장할 수 있습니다. 동시에 Hugging Face는 완전히 관리되는 CPU 및 GPU 작업 실행 서비스인 “Hugging Face Jobs”를 출시하여 ML 작업 실행을 간소화하고 사용자가 모델 개발에 더 집중할 수 있도록 했습니다. (출처: algo_diver, reach_vb)

AI 수직 분야 및 워크플로우 자동화 agent : SciSpace Agent는 과학자 전용 AI assistant로, citation, literature retrieval, PDF reading, AI writing 기능을 통합하여 연구 효율성을 크게 향상시키는 것을 목표로 합니다. LlamaCloud Nodes도 n8n 워크플로우에 통합되어 문서 처리 자동화를 간소화했으며, Llama Extract agent를 활용하여 핵심 데이터를 추출하고 금융 문서, 고객 커뮤니케이션 등 structured data extraction을 자동화했습니다. (출처: TheTuringPost, jerryjliu0)

AutoRL: RL을 통한 task-specific LLM 훈련 : Matt Shumer는 강화 학습(Reinforcement Learning)을 통해 task-specific LLM을 훈련하는 간편한 방법인 AutoRL을 출시했습니다. 사용자는 원하는 모델을 한 문장으로 설명하기만 하면 AI 시스템이 데이터와 평가 기준을 생성하고 모델을 훈련할 수 있습니다. 이 open-source 도구는 ART를 기반으로 하며, customized LLM 개발의 진입 장벽을 낮출 것으로 기대됩니다. (출처: corbtt)

ccflare: Claude Code 고급 사용자 도구 : ccflare는 Claude Code 고급 사용자를 위해 설계된 강력한 도구 모음으로, analytics tracking, multi-Claude subscription account load balancing 및 전환, deep request analysis, sub-agent 모델 설정 등의 기능을 제공합니다. 이 도구는 Claude Code의 사용 효율성과 제어 가능성을 높여 개발자가 AI 프로그래밍 워크플로우를 더 잘 관리하고 최적화하는 데 도움을 줍니다. (출처: Reddit r/ClaudeAI)

📚 학습

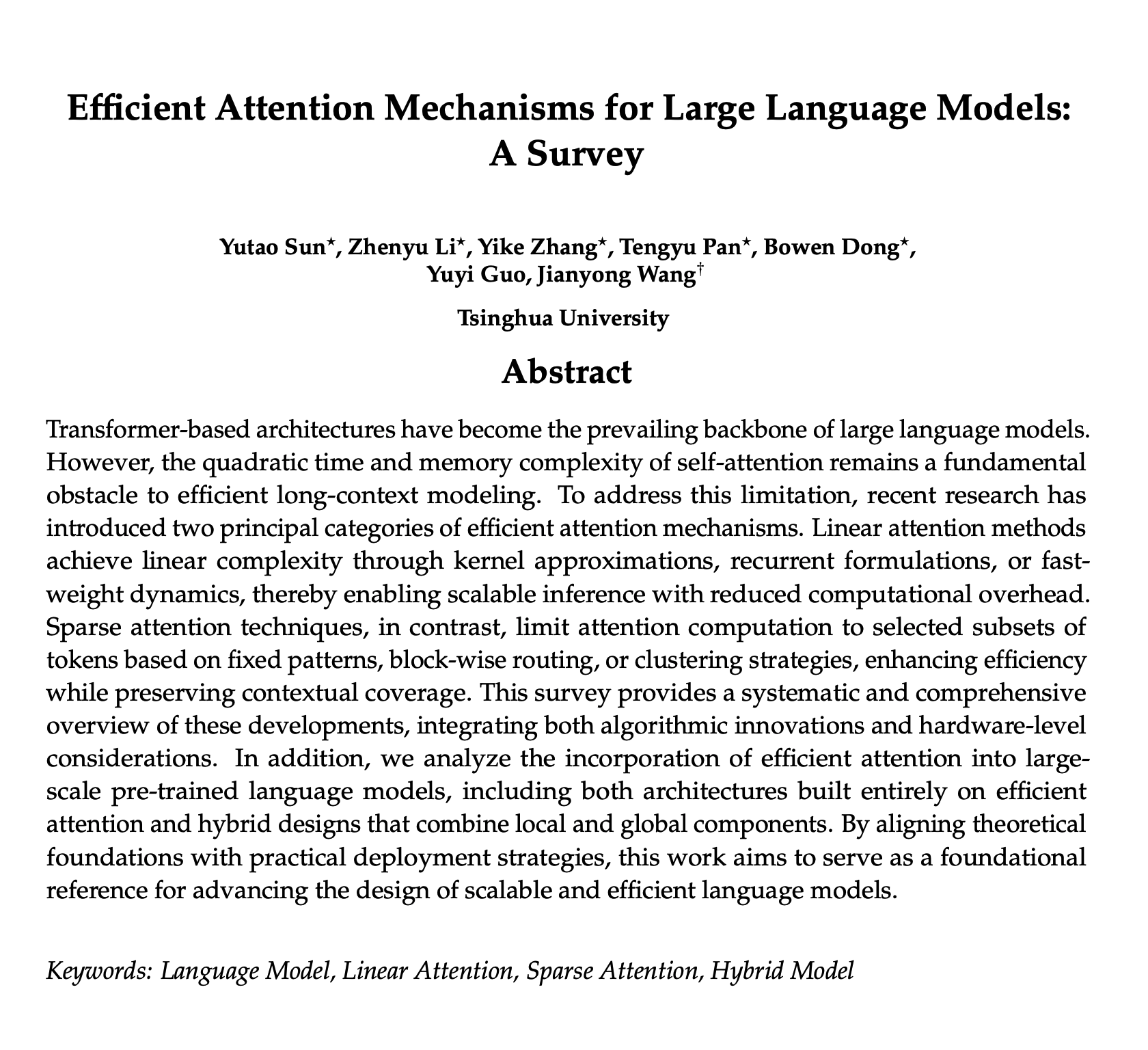

효율적인 attention mechanism LLM 개요 : LLM의 효율적인 attention mechanism에 대한 최신 개요가 공유되었으며, 이는 새로운 아이디어와 미래 동향을 이해하는 데 훌륭한 자료로 평가됩니다. 이 개요는 attention computation을 최적화하는 다양한 방법을 다루고 있어, LLM의 효율성과 성능 향상을 목표로 하는 연구자와 개발자에게 중요한 참고 가치를 가집니다. (출처: omarsar0)

GEPA: Reflective Prompt Evolution이 강화 학습을 능가하다 : 한 연구 논문은 GEPA(Reflective Prompt Evolution)라는 reflective prompt optimization 방법을 소개했습니다. 이 방법은 낮은 배포 예산에서 reflective evolution prompt를 통해 기존의 강화 학습(Reinforcement Learning) 알고리즘보다 성능이 뛰어남을 보여주었습니다. 이 연구는 AI 모델이 특정 작업에서 RL과 유사한 성능 향상을 달성하는 새로운 아이디어를 제공하며, 특히 synthetic data generation 분야에서 잠재력을 가집니다. (출처: teortaxesTex, stanfordnlp)

LLM 설명성 지표 XPLAIN 이해 : “XPLAIN”이라는 새로운 지표가 black-box LLM의 설명성을 정량화하기 위해 제안되었습니다. 이 방법은 cosine similarity를 사용하여 단어 수준의 중요도 점수를 계산하고, LLM이 입력 문장을 어떻게 해석하는지, 어떤 단어가 출력에 가장 큰 영향을 미치는지 밝혀냅니다. 이 연구는 LLM 내부 메커니즘에 대한 이해를 증진하는 것을 목표로 하며, 코드와 논문이 커뮤니티에 제공되었습니다. (출처: Reddit r/MachineLearning)

MoHoBench: multimodal large model의 정직성 평가 : MoHoBench는 multimodal large language model(MLLM)의 정직한 행동을 체계적으로 평가하는 최초의 벤치마크 테스트입니다. 이 테스트는 모델이 시각적으로 답변할 수 없는 질문에 어떻게 반응하는지 분석하여 정직성을 측정합니다. 이 벤치마크는 1.2만 개 이상의 visual question-answering 샘플을 포함하며, 대부분의 MLLM이 필요할 때 답변을 거부하지 못하고, 그 정직성이 시각 정보에 깊이 영향을 받는다는 것을 드러내어, 전문적인 multimodal honesty alignment 방법 개발을 촉구합니다. (출처: HuggingFace Daily Papers)

Hierarchical Reasoning Model (HRM), ARC-AGI에서 돌파구 마련 : Hierarchical Reasoning Model (HRM)이 ARC-AGI 작업에서 단 1k 샘플과 소량의 컴퓨팅 자원으로 25%의 정확도를 달성하며 상당한 진전을 이루어, 복잡한 reasoning 작업에서의 강력한 잠재력을 보여주었습니다. 이 모델은 뇌의 계층적 처리 메커니즘에서 영감을 얻었으며, general AI system의 reasoning capability에서 돌파구를 마련할 것으로 기대됩니다. (출처: VictorTaelin)

ACL 2025, LLM 평가에 관한 논문 : 한 논문이 ACL 2025에서 한 language model이 다른 모델보다 우수한지 판단하는 방법을 제시하며, LLM 애플리케이션 개발에서 평가의 중요성을 강조했습니다. 이 연구는 LLM을 비교하고 선택하는 더 효과적인 방법을 제공하여, 개발자가 실제 진전 없이 맹목적으로 시도하는 것을 피하도록 돕는 것을 목표로 합니다. (출처: gneubig, charles_irl)

LLM에서 soft preferences 발생 이해 : 새로운 논문은 인간 언어 생산에서 견고하고 보편적인 “soft preferences”가 autoregressive memory cost function을 최소화하는 전략에서 어떻게 나타나는지 탐구했습니다. 이 연구는 LLM이 생성하는 텍스트에서 미묘한 인간적 특징을 깊이 이해하여, LLM의 행동 메커니즘에 대한 새로운 관점을 제공합니다. (출처: stanfordnlp)

LLM Agent의 정의 : LangChain 창립자 Harrison Chase는 AI Agent에 대한 자신의 정의를 공유하며, AI Agent의 ‘Agentic’ 정도는 LLM이 다음 행동을 얼마나 자율적으로 결정하는지에 달려있다고 강조했습니다. 이 관점은 AI Agent의 개념을 명확히 하고, 개발자가 Agent 시스템을 구축할 때 그 자율성을 측정하는 방법을 안내하는 데 도움이 됩니다. (출처: hwchase17)

💼 비즈니스

Anthropic, 기업 가치 1,700억 달러로 급등 : Claude의 배후 회사인 Anthropic이 최대 50억 달러 규모의 새로운 자금 조달을 논의 중이며, 기업 가치는 1,700억 달러에 이를 것으로 예상됩니다. 이는 Anthropic을 OpenAI에 이어 두 번째로 1,000억 달러 가치를 넘는 AI unicorn으로 만들 것입니다. 이번 자금 조달은 Iconiq Capital이 주도하며, 카타르 투자청, 싱가포르 국부 펀드 GIC, Amazon 등이 참여할 수 있습니다. Anthropic의 수익은 주로 API 호출에서 발생하며, 특히 AI 프로그래밍 분야에서 강력한 성과를 보여 연간 수익이 이미 40억 달러에 달합니다. (출처: 36氪, 36氪)

Surge AI, 고품질 데이터로 10억 달러 매출 달성 : 중국계 Edwin Chen이 설립한 Surge AI는 자금 조달이나 영업팀 없이 120명의 팀으로 연간 10억 달러 이상의 매출을 달성하여 동종 업계보다 훨씬 효율적인 모습을 보였습니다. 이 회사는 고품질 human feedback data(RLHF) 제공에 주력하며, 엄격한 기준과 MIT 수학 박사 등 전문적인 배경을 가진 ‘Surge Force’ elite annotation network를 통해 데이터 정확도를 보장합니다. 이는 OpenAI, Anthropic 등 최고 AI 연구소의 선호 공급업체가 되었으며, 10억 달러 규모의 첫 자금 조달을 시작할 계획이며 기업 가치는 150억 달러에 이를 수 있습니다. (출처: 36氪)

Nvidia 데이터센터 수익, 2년 내 10배 성장 : Nvidia의 데이터센터 수익이 지난 2년 동안 10배 증가했으며, H20 칩 해금 이후에도 강력한 성장세를 계속 유지할 것으로 예상됩니다. 이러한 성장은 AI large model의 GPU computing power에 대한 막대한 수요 덕분이며, AI 하드웨어 시장에서 Nvidia의 선두 위치를 공고히 했습니다. (출처: Reddit r/artificial)

🌟 커뮤니티

AI prompt에서 role-playing의 유효성 논의 : 커뮤니티에서는 large model prompt에서 role-playing의 실제 효용성에 대해 뜨거운 논의가 진행 중입니다. 일반적으로 이는 AI가 특정 작업에 집중하도록 효과적으로 유도하고 출력 품질을 향상시키며, 확률 분포를 고품질 데이터로 유도한다고 여겨집니다. 그러나 일부에서는 role-playing에 과도하게 의존하거나 완전히 부정하는 것은 형식주의에 불과하며, AI 작업 요구 사항을 이해하는 것이 핵심이라고 지적합니다. (출처: dotey)

AI coding이 야기하는 코드 양 및 품질 논란 : 소셜 미디어에서는 AI assisted coding tool의 효율성과 코드 품질 문제가 뜨거운 논쟁을 불러일으켰습니다. 일부 사용자는 AI가 수만 줄의 코드를 빠르게 생성할 수 있다고 보고했지만, 동시에 유지보수성 및 아키텍처 선택에 대한 우려를 표했습니다. 논의에서는 AI가 생성한 코드가 ‘mindless generation’이 아닌 상당한 수동 검토 및 수정이 필요할 수 있음을 지적하며, 이는 소프트웨어 개발에서 AI 역할 변화가 가져오는 도전을 부각시킵니다. (출처: vikhyatk, dotey, Reddit r/ClaudeAI)

Meta AI 전략 및 인재 쟁탈전, 커뮤니티에서 뜨거운 논의 불러일으켜 : Meta는 최근 AI 분야에서 활발한 움직임을 보이고 있습니다. CEO Mark Zuckerberg가 제시한 ‘개인 슈퍼 인텔리전스’ 비전, Mira Murati 스타트업 직원들을 포함한 최고 AI 인재들에게 최대 10억 달러의 poaching offer를 제시한 것, 그리고 미래 최고 모델의 open-source 전략에 대한 ‘신중한’ 태도 표명 등이 커뮤니티에서 광범위한 논의를 불러일으켰습니다. 이러한 움직임은 AI 분야에서 Meta의 야심을 보여주는 것으로 해석되지만, AI 인재 시장, technological ethics, open-source spirit에 대한 우려도 동반합니다. (출처: dotey, teortaxesTex, joannejang, tokenbender, amasad)

AI 교육 애플리케이션 및 윤리적 도전 : OpenAI가 학생들의 사고를 유도하기 위해 ChatGPT 학습 모드를 출시했음에도 불구하고, 커뮤니티는 부정행위 위험 및 critical thinking ability 저하와 같은 교육에서의 윤리적 문제에 대해 일반적으로 우려를 표하고 있습니다. 논의에서는 교육 분야에서 AI 적용이 혁신과 학문적 진실성 사이의 균형을 맞춰야 하며, 더 심층적인 personalized teaching 및 교육 커리큘럼 설계를 통해 이러한 도전에 대응하는 방법을 모색해야 한다고 지적합니다. (출처: 36氪, Reddit r/artificial, Reddit r/ArtificialInteligence)

AI 모델 환각 및 콘텐츠 진실성 도전 : 소셜 미디어에서는 AI 모델이 생성하는 콘텐츠의 ‘환각’ 현상과 정보 진실성에 미치는 영향에 대한 광범위한 논의가 진행 중입니다. 사용자들은 AI가 전문적으로 보이지만 logically inconsistent하거나 false information을 생성할 수 있으며, 특히 image 및 video generation 분야에서는 진위 구별이 어렵다는 것을 발견했습니다. 이는 AI 도구에 대한 신뢰 위기를 초래하며, 사람들이 인간의 discernment ability와 critical thinking을 유지하고 algorithm에 과도하게 의존하는 것을 피하는 방법에 대해 반성하게 합니다. (출처: 36氪, teortaxesTex, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial)

AI의 사회 경제 및 개인 창의성에 대한 이중적 영향 : 커뮤니티에서는 AI의 사회 경제적 영향에 대해 양극화된 논의가 존재합니다. 한편으로는 일부 CEO가 AI가 ‘우리가 아는 일을 끝낼 것’이라고 공개적으로 언급하여 일자리 손실에 대한 우려를 불러일으켰습니다. 다른 한편으로는 일부 사용자가 AI가 예산과 기술이 부족한 상황에서도 개인이 창업 아이디어를 실현할 수 있도록 어떻게 empower하는지 공유하며, AI가 ‘위대한 균형추’로서 개인의 창의성을 해방시켰다고 주장합니다. (출처: Reddit r/artificial, Reddit r/ArtificialInteligence)

AI open-source 및 closed-source의 안전성 논쟁 : 커뮤니티에서는 AI 모델의 open-source와 closed-source의 안전성에 대한 격렬한 논쟁이 벌어졌습니다. 일부 의견은 모델을 API 또는 chatbot 뒤에 배포하는 것이 open-weight model을 출시하는 것보다 더 위험할 수 있다고 주장합니다. 이는 악의적 사용의 문턱을 낮추기 때문입니다. 이 논쟁은 ‘open-weight는 안전하지 않다’는 주장을 재검토하고, AI 안전이 단순한 technical openness를 넘어선다는 점을 강조할 것을 촉구합니다. (출처: bookwormengr)

AI와 인간 감정 연결에 대한 탐구 : 소셜 미디어에서는 AI와 감정적 연결을 맺는 것에 대한 다양한 견해가 존재합니다. 일부 사용자는 정상적인 생활에 영향을 미치지 않는 한 AI와 관계를 맺는 것은 개인의 선택이라고 생각합니다. 다른 사람들은 AI companionship에 과도하게 의존하는 것이 실제 인간 관계에 대한 인내심을 낮출 수 있다고 우려하며, AI companion의 윤리적 및 심리적 영향에 대한 심층적인 고찰을 불러일으킵니다. (출처: Reddit r/ChatGPT, ClementDelangue)

💡 기타

AI 글로벌 발전 불균형 및 지정학적 영향 : 유엔 사무차장은 ‘AI 격차’ 해소를 촉구하며, AI 개발 능력이 소수의 국가와 기업에 집중되어 기술 및 거버넌스 불평등을 초래한다고 지적했습니다. 전문가들은 AI가 인간의 능력을 강화해야지 대체해서는 안 되며, 기술자와 비기술자 간의 범주 차이를 피하기 위해 유연한 governance mechanism을 구축해야 한다고 강조합니다. 또한, 미중 AGI 경쟁과 같은 AI의 지정학적 경쟁도 국제적인 관심사가 되고 있습니다. (출처: 36氪, teortaxesTex)

AI 저작권 전쟁: 상상력과 기계의 충돌 : 영국에서는 AI 저작권에 대한 논쟁이 진행 중이며, 핵심 문제는 AI 기술 기업이 허가 및 보상 없이 인간이 창작한 콘텐츠를 scraping하여 ‘향상된’ 콘텐츠를 훈련하고 생성할 수 있는지 여부입니다. 이 논쟁은 AI 시대 창작물의 copyright ownership과 creator rights protection에 초점을 맞추고 있으며, 기술 발전과 기존 법적 프레임워크 간의 충돌을 반영합니다. (출처: Reddit r/artificial)

FDA의 AI 적용이 야기하는 윤리적 우려 : 미국 FDA의 AI가 약물 승인 과정에서 ‘연구를 조작’할 수 있다는 보도가 나와, 의료 건강 분야에서 AI 적용의 윤리성 및 정확성에 대한 우려를 불러일으켰습니다. 이는 AI assisted decision-making system, 특히 고위험 분야에서 데이터 진실성 및 투명성이 직면한 도전과, AI의 결정이 윤리적 및 규제 표준에 부합하도록 보장하는 방법의 중요성을 부각시킵니다. (출처: Ronald_vanLoon)