키워드:AI 훈련 데이터 저작권, AlphaGenome, OpenAI 하드웨어 표절, AI 수능 성적, Gemini CLI, RLT 새로운 방법, BitNet b1.58, Biomni 에이전트, AI 합리적 사용 판결, DNA 염기쌍 예측, 알트만 표절 주장에 대한 답변, 대형 모델 수학 능력 향상, 터미널 AI 에이전트 무료 할당량

🔥 주요 뉴스

AI 학습 데이터 저작권 관련 획기적 판결: 미국 법원, AI의 합법적 구매 서적 활용 학습은 ‘공정 이용’에 해당: 미국 연방 법원은 Anthropic에 대한 소송에서 AI 기업이 합법적으로 구매한 출판된 서적을 사용하여 대규모 언어 모델(LLM)을 학습시키는 것이 저자의 사전 동의 없이 ‘공정 이용’ 범주에 해당한다고 판결했습니다. 법원은 AI 학습이 원저작물의 ‘변형적 사용(transformative use)’이며, 원저작물 시장을 직접적으로 대체하지 않고 기술 혁신과 공공 이익에 기여한다고 보았습니다. 그러나 법원은 불법 복제 서적을 사용한 학습은 공정 이용에 해당하지 않으며, Anthropic은 여전히 이에 대한 책임을 질 수 있다고 판결했습니다. 이번 판결은 2015년 Google Books 사건의 선례를 참고했으며, AI 학습 데이터 저작권 위험을 줄이는 중요한 단계로 여겨지며, OpenAI 및 Meta를 상대로 한 소송 등 다른 유사 사건 심리에 영향을 미칠 수 있습니다. 앞서 Meta는 다른 유사 저작권 소송에서도 유리한 판결을 받았으며, 판사는 원고가 Meta가 AI 모델 학습에 자신의 서적을 사용하여 경제적 피해를 입혔음을 충분히 증명하지 못했다고 판단했습니다. 이러한 판결들은 AI 업계의 데이터 확보 및 사용에 대해 보다 명확한 법적 지침을 제공하는 동시에 합법적인 데이터 확보의 중요성을 강조합니다. (출처: 量子位, DeepLearning.AI Blog, wiredmagazine)

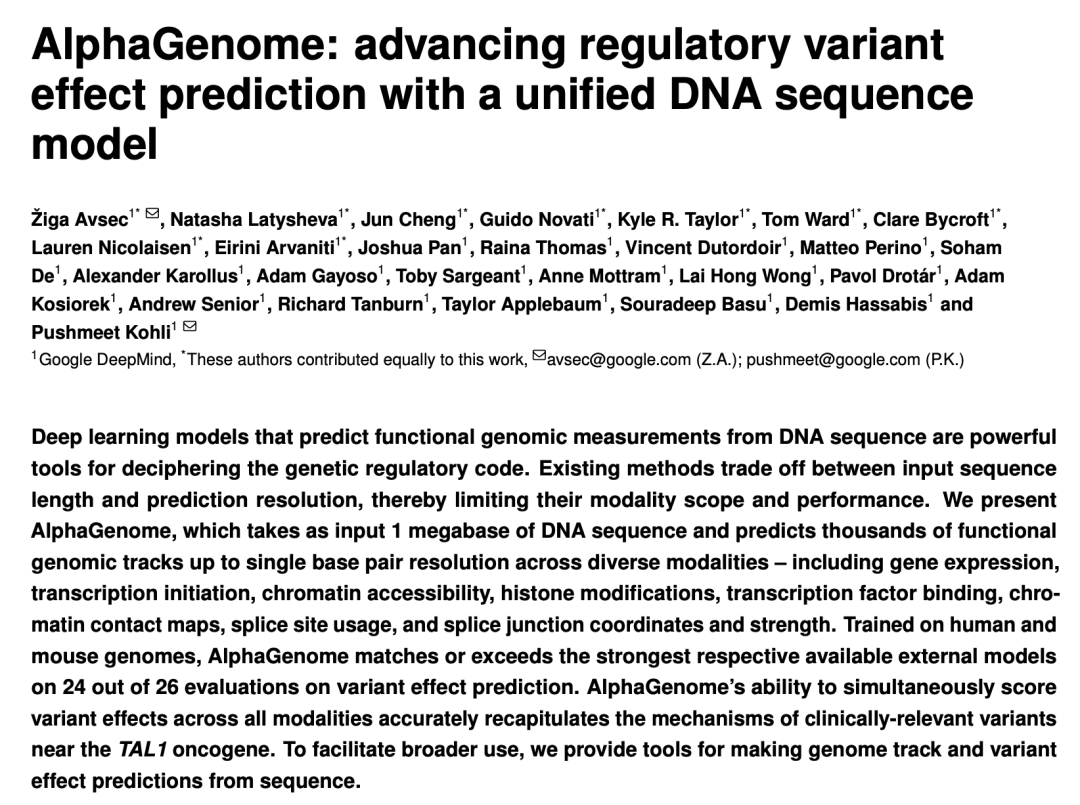

구글 DeepMind, AlphaGenome 발표: AI ‘현미경’으로 백만 DNA 염기쌍 유전자 변이 영향 예측: 구글 DeepMind가 AI 모델 AlphaGenome을 출시했습니다. 이 모델은 최대 100만 염기쌍 길이의 DNA 서열을 입력받아 수천 가지 분자 특성을 예측하고 유전자 변이의 영향을 평가하며, 20개 이상의 유전체 예측 벤치마크 테스트에서 선도적인 성능을 보였습니다. AlphaGenome은 고해상도 장거리 서열 컨텍스트 처리, 종합적인 멀티모달 예측, 효율적인 변이 점수화 및 새로운 스플라이싱 연결 모델 등의 특징을 갖추고 있으며, 단일 모델 학습에 단 4시간이 소요되고 계산 예산은 기존 Enformer 모델의 절반입니다. 이 모델은 과학자들이 유전자 조절을 이해하고, 질병(특히 희귀 질환) 이해를 가속화하며, 합성 생물학 설계를 지도하고 기초 연구를 촉진하는 데 도움을 주기 위해 개발되었습니다. 현재 API를 통해 비상업적 연구용으로 미리보기 버전을 제공하고 있으며, 향후 정식 출시될 예정입니다. (출처: 36氪, Google, demishassabis)

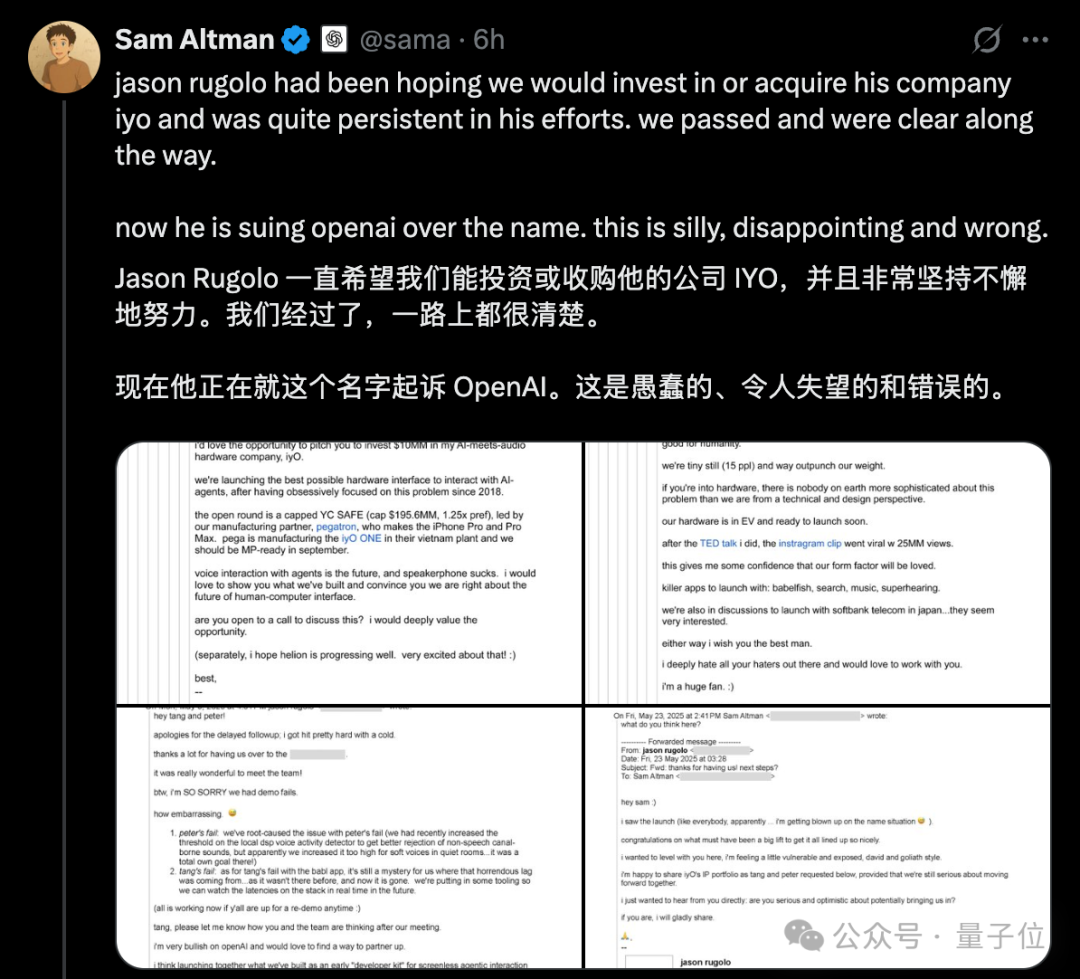

OpenAI 하드웨어 ‘표절’ 논란 격화, Altman 공개 이메일로 IYO 소송 반박: AI 하드웨어 스타트업 IYO가 OpenAI 및 OpenAI가 인수한 하드웨어 회사 io(전 Apple 디자이너 Jony Ive 설립)를 상표권 침해 및 제품 표절로 고소한 데 대해, OpenAI CEO Altman은 소셜 미디어를 통해 IYO의 소송이 “어리석고 실망스러우며 완전히 잘못된 것”이라고 공개적으로 반박했습니다. Altman은 IYO 창립자 Jason Rugolo가 소송 전에 OpenAI에 1,000만 달러 투자 또는 인수를 적극적으로 요청했으며, OpenAI가 io 인수를 발표한 후에도 자신의 지식 재산권을 공유하기를 원했다는 내용의 이메일 스크린샷을 제시했습니다. Altman은 IYO가 투자 또는 인수가 무산된 후에야 소송을 제기했다고 주장했습니다. IYO 창립자는 Altman이 온라인에서 여론몰이를 하고 있다며 제품명에 대한 권리를 고수한다고 반박했습니다. 앞서 법원은 IYO의 임시 금지 명령 신청을 승인하여 OpenAI가 IO 로고를 사용하지 못하도록 했습니다. OpenAI 측은 자사 하드웨어 제품이 IYO의 맞춤형 귀 착용 장치와 다르며, 프로토타입 디자인이 미정이고 최소 1년 후에나 출시될 것이라고 밝혔습니다. (출처: 量子位, 36氪)

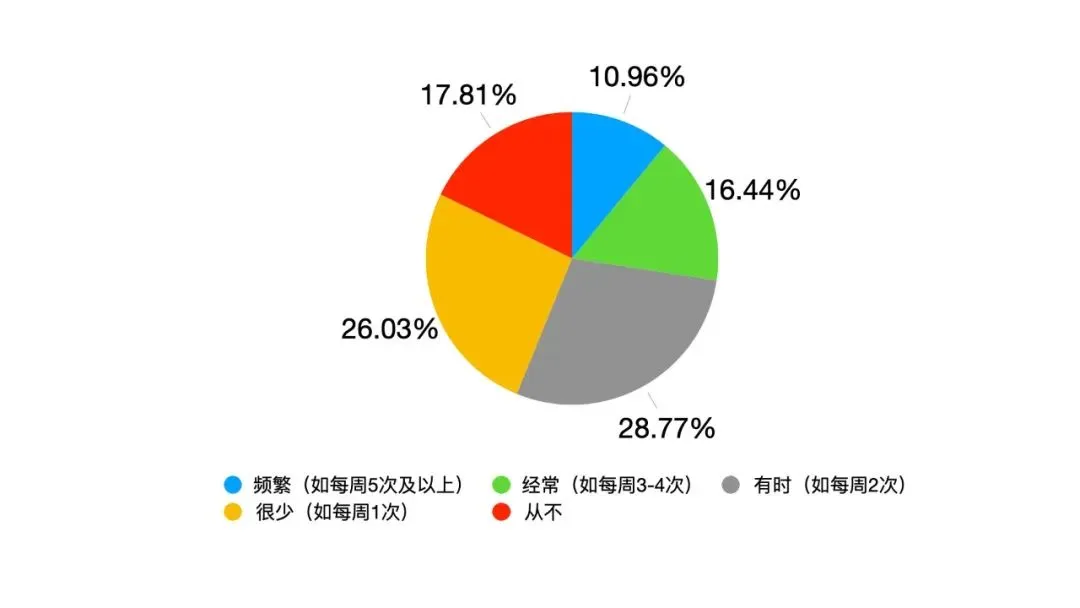

AI 대규모 모델, 대학 입시 재도전, 전체 성적 눈에 띄게 향상, 수학 능력 두드러진 발전: GeekPark 2025년 연례 AI 대학 입시 모의 평가 결과, 주요 대규모 모델(예: Doubao, DeepSeek R1, ChatGPT o3 등)의 전체 성적이 작년에 비해 크게 향상되어 최상위권 대학 진학 가능성을 보여주었으며, 예상 수석인 Doubao는 산둥성 상위 900위 안에 들 것으로 예측됩니다. AI의 문과/이과 편중 현상이 완화되었고, 이과 평균 점수가 더 빠르게 상승했으며, 수학이 가장 두드러진 발전 과목으로 평균 점수가 84.25점 상승하여 국어와 영어를 앞질렀습니다. 멀티모달 능력이 격차를 벌리는 핵심 요소로 작용했으며, 특히 물리, 지리 등 이미지 문제가 많은 과목에서 두각을 나타냈습니다. AI는 복잡한 추론과 계산에서 우수한 성능을 보였지만, 시각 정보가 혼란스러운 간단한 문제(예: 한 수학 벡터 문제)에서는 여전히 오류를 범했습니다. 작문에서는 AI가 구조가 완전하고 논거가 풍부한 글을 작성할 수 있었지만, 깊이 있는 사유와 정서적 공감이 부족하여 최고 수준의 작품을 만들어내기는 어려웠습니다. (출처: 36氪)

🎯 동향

구글 Gemini 2.5 Pro 기반 Gemini CLI 출시, 높은 무료 할당량으로 주목: 구글이 터미널 환경에서 실행되는 AI 어시스턴트인 Gemini CLI를 정식 출시했습니다. 이 모델은 Gemini 2.5 Pro를 기반으로 하며, 매우 관대한 무료 사용 할당량을 제공하는 것이 특징입니다. 100만 토큰 컨텍스트 창을 지원하며, 분당 60회, 하루 1000회의 모델 호출이 가능하여 Anthropic의 Claude Code 등 유료 도구와 강력한 경쟁 구도를 형성합니다. Gemini CLI는 Apache 2.0 오픈소스 라이선스를 채택했으며, 코드 작성, 디버깅, 프로젝트 관리, 문서 조회 및 MCP를 통한 다른 구글 서비스(예: 이미지 비디오 생성) 호출을 지원합니다. 구글은 복잡한 개발 작업을 처리하는 데 있어 범용 모델의 이점을 강조하며, 순수 코드 모델은 오히려 제한적일 수 있다고 주장합니다. 커뮤니티는 이것이 CLI AI 도구의 보급과 경쟁을 촉진할 것이라며 뜨거운 반응을 보이고 있습니다. (출처: 36氪, Reddit r/LocalLLaMA, dotey)

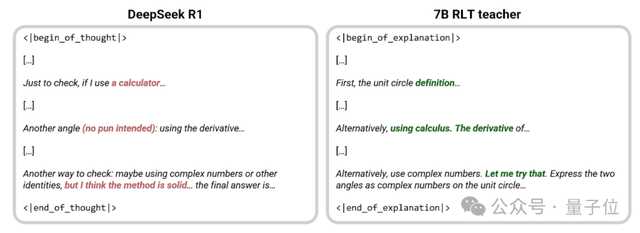

Sakana AI, 새로운 RLT 방법 제안, 7B 소형 모델 ‘교육’ 효과 DeepSeek-R1 능가: Transformer 저자 중 한 명인 Llion Jones가 설립한 Sakana AI가 새로운 강화 학습 교사(RLTs) 방법을 제안했습니다. 이 방법은 교사 모델이 처음부터 문제를 해결하는 대신, 이미 알려진 해결책을 바탕으로 명확한 단계별 설명을 출력하여 인간 우수 교사의 ‘발견적 학습법’을 모방합니다. 실험 결과, 이 방법을 사용하여 훈련된 7B RLT 소형 모델은 추론 능력 전달 측면에서 671B의 DeepSeek-R1보다 우수한 효과를 보였으며, 자신보다 3배 큰 학생 모델(예: 32B)을 효과적으로 훈련시키고 훈련 비용도 크게 절감했습니다. 이 방법은 기존 교사 모델이 자체 문제 해결 능력에 의존하고 훈련이 느리고 비용이 많이 드는 문제를 해결하기 위해, 교사 훈련을 실제 목적(학생 모델 학습 지원)과 일치시켜 효율성을 높이는 것을 목표로 합니다. (출처: 量子位, SakanaAILabs)

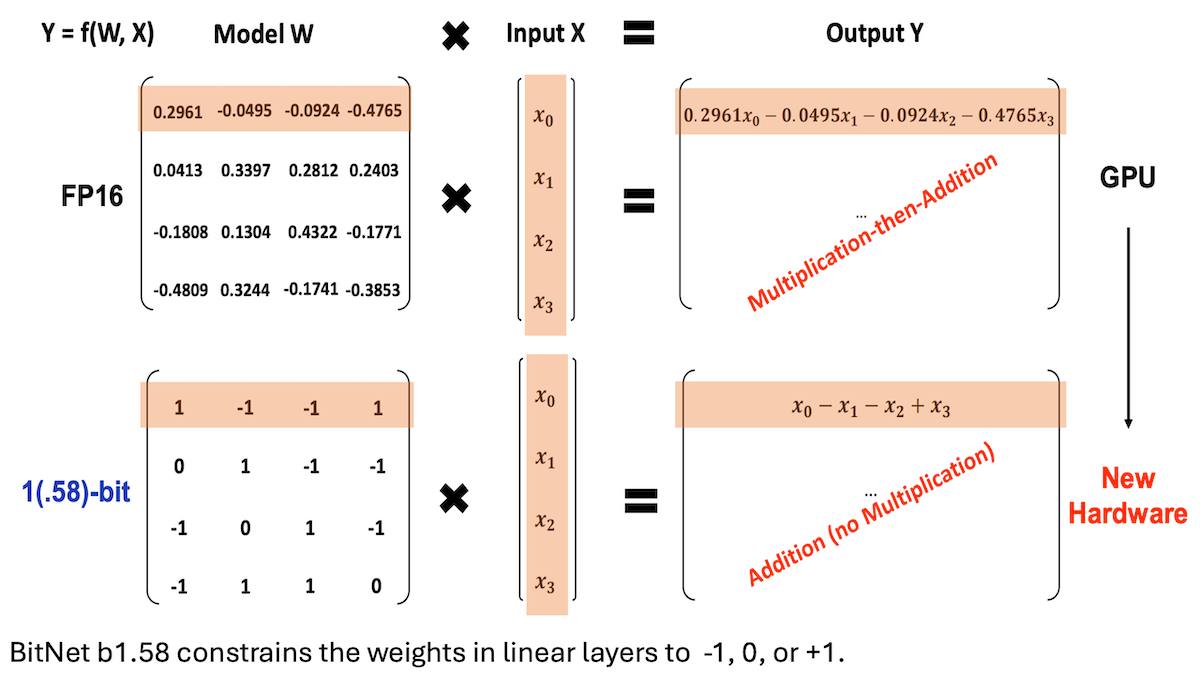

마이크로소프트 등, BitNet b1.58 제안, 저정밀도 고추론 성능 LLM 구현: 마이크로소프트, 중국과학원대학, 칭화대학 연구진이 BitNet b1.58 모델을 업데이트했습니다. 이 모델은 대부분의 가중치가 -1, 0 또는 +1 세 가지 값(약 1.58비트/파라미터)으로 제한되며, 20억 파라미터 규모에서 최고 수준의 완전 정밀도 모델과 경쟁할 수 있는 성능을 보입니다. 이 모델은 양자화 인식 훈련, 2단계 학습률 및 가중치 감소와 같은 정교하게 설계된 훈련 전략을 통해 최적화되었으며, 16개의 인기 벤치마크 테스트에서 Qwen2.5-1.5B, Gemma-3 1B 등보다 속도와 메모리 사용량이 우수하고, 평균 정확도는 Qwen2.5-1.5B에 근접하며 4비트 양자화 버전의 Qwen2.5-1.5B보다 뛰어납니다. 이 연구는 하이퍼파라미터를 세심하게 조정함으로써 저정밀도 모델도 고성능을 달성할 수 있음을 보여주며, 효율적인 LLM 배포를 위한 새로운 아이디어를 제공합니다. (출처: DeepLearning.AI Blog)

스탠포드 등 기관, Biomni 생물 연구 지능형 에이전트 출시, 100여 개 도구 및 데이터베이스 통합: 스탠포드 대학, 프린스턴 대학 등 기관의 연구진이 광범위한 생물학 연구를 위해 설계된 AI 에이전트 Biomni를 출시했습니다. 이 에이전트는 Claude 4 Sonnet을 기반으로 하며, 유전체학, 면역학, 신경과학 등 25개 생물학 전문 분야의 최근 논문 2500편에서 추출하고 선별한 150개 도구, 약 60개 데이터베이스 및 약 100개 인기 생물학 소프트웨어 패키지를 통합했습니다. Biomni는 질문, 가설 제시, 프로세스 설계, 데이터셋 분석, 차트 생성 등 다양한 작업을 수행할 수 있습니다. CodeAct 프레임워크를 채택하여 반복적인 계획, 코드 생성 및 실행을 통해 쿼리에 응답하며, 다른 Claude 4 Sonnet 인스턴스를 판단자로 도입하여 중간 출력의 합리성을 평가합니다. Lab-bench 등 여러 벤치마크 테스트와 실제 사례 연구에서 Biomni는 단독 Claude 4 Sonnet 및 문헌 검색 강화 Claude 모델보다 우수한 성능을 보였습니다. (출처: DeepLearning.AI Blog)

Anthropic, Claude Code 신기능 출시: AI 기반 Artifacts 생성 및 공유: Anthropic은 AI 프로그래밍 어시스턴트 Claude Code에 사용자가 “Artifacts”(소형 AI 애플리케이션 또는 도구로 이해 가능)를 생성, 호스팅 및 공유하고 Claude의 지능을 이러한 창작물에 직접 내장할 수 있는 새로운 기능을 도입했습니다. 이는 사용자가 Claude를 사용하여 코드 스니펫을 생성하거나 분석하는 것뿐만 아니라 AI 기반의 기능적인 애플리케이션을 구축할 수 있음을 의미합니다. 중요한 특징은 이러한 AI 애플리케이션을 공유할 때 시청자가 자신의 Claude 계정을 사용하여 인증하고 사용량은 생성자가 아닌 시청자 자신의 구독 할당량으로 계산된다는 것입니다. 이 기능은 현재 베타 단계이며 모든 무료, Pro 및 Max 사용자에게 공개되어 AI 애플리케이션 생성 장벽을 낮추고 AI 능력의 보급과 공유를 촉진하는 것을 목표로 합니다. (출처: kylebrussell, Reddit r/ClaudeAI)

Maya Research, Veena TTS 모델 출시, 힌디어 및 영어 지원, 인도 현지 발음 개선: Maya Research가 Veena라는 텍스트 음성 변환(TTS) 모델을 출시했습니다. 이 모델은 3B Llama 아키텍처를 기반으로 하며 Apache 2.0 라이선스를 사용합니다. Veena의 두드러진 특징은 코드 혼합(code-mix) 상황을 포함하여 인도 억양의 영어와 힌디어 음성을 생성할 수 있다는 점으로, 기존 TTS 모델의 인도 현지 발음 부족 문제를 해결했습니다. 이 모델은 지연 시간이 80밀리초 미만이며 무료 Google Colab 환경에서 실행할 수 있고 Hugging Face Hub에 등록되었습니다. 팀은 타밀어, 텔루구어, 벵골어 등 다른 인도 언어 지원을 적극적으로 개발 중이라고 밝혔습니다. (출처: huggingface, huggingface)

지샹웨이라이(智象未来), vivago2.0 출시, 멀티모달 생성 및 편집 기능 통합: AI 대가 메이타오(梅涛)가 설립한 지샹웨이라이(HiDream.ai)가 멀티모달 AI 창작 도구 vivago2.0을 출시했습니다. 이 제품은 이미지 생성, 이미지-비디오 변환, AI 팟캐스트(립싱크 동기화), 특수 효과 템플릿 등의 기능을 통합하고 사용자가 영감을 공유하고 얻을 수 있는 크리에이티브 커뮤니티를 갖추고 있습니다. 핵심 기술은 새로운 이미지 지능형 에이전트 HiDream-A1을 기반으로 하며, 이 에이전트는 이전에 오픈소스화되어 텍스트-이미지 생성 경쟁 분야에서 1위를 차지한 HiDream-I1(170억 파라미터 이미지 생성 기본 모델)과 HiDream-E1(대화형 이미지 편집 모델)의 고급 비공개 버전을 통합했습니다. vivago2.0은 멀티모달 콘텐츠 제작 장벽을 낮추고 수백 가지 특수 효과 템플릿을 제공하며 자연어 대화를 통한 이미지 생성 및 수정(Image Agent)을 지원하는 것을 목표로 합니다. (출처: 量子位)

엔비디아, RTX 5050 시리즈 GPU 출시, 데스크톱 및 노트북 버전 메모리 구성 차별화: 엔비디아가 GeForce RTX 5050 시리즈 GPU를 정식 출시했습니다. 데스크톱 버전과 노트북 버전이 포함되며 7월에 출시될 예정이며, 중국 내 데스크톱 버전 권장 소매가는 2099위안부터 시작합니다. 데스크톱 버전 RTX 5050은 2560개의 Blackwell CUDA 코어와 8GB GDDR6 메모리를 탑재했으며 최대 전력 소비량은 130W입니다. 노트북 버전 RTX 5050도 2560개의 CUDA 코어를 갖추고 있지만, 에너지 효율이 더 높은 8GB GDDR7 메모리를 탑재했습니다. 엔비디아는 DLSS 4 기술과 함께 RTX 5050이 《사이버펑크 2077》과 같은 게임에서 레이 트레이싱 프레임률이 150fps를 돌파할 수 있으며, RTX 3050에 비해 래스터화 성능이 평균 60%(데스크톱 버전) 및 2.4배(노트북 버전) 향상되었다고 밝혔습니다. 이번 메모리 구성 차별화는 엔비디아가 다양한 시장 구간에서 비용과 성능 균형을 맞추는 전략을 보여줍니다. (출처: 量子位)

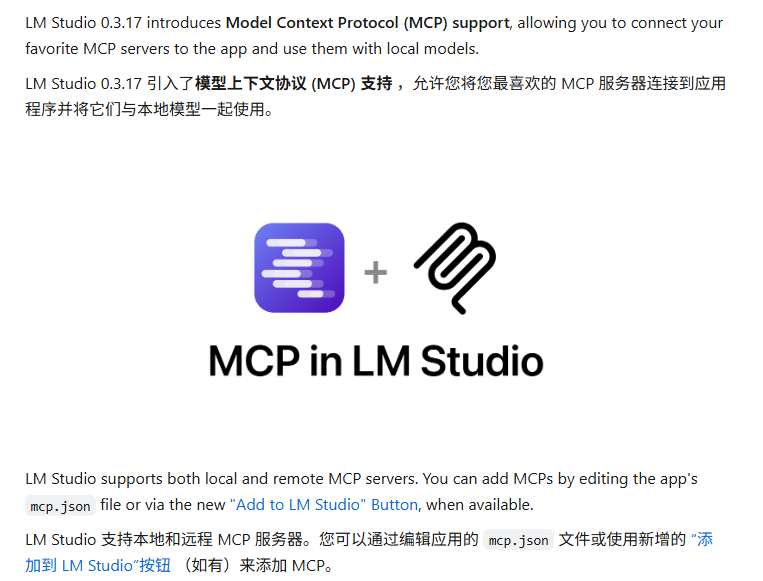

LM Studio, MCP 프로토콜 지원 업데이트, 로컬 LLM과 MCP 서버 연결 가능: 데스크톱 LLM 실행 도구 LM Studio가 새 버전(0.3.17)을 출시하며 모델 컨텍스트 프로토콜(MCP) 지원을 추가했습니다. 사용자는 이제 로컬에서 실행되는 대규모 언어 모델을 MCP 호환 서버(예: 외부 도구 또는 서비스 호출)와 연결할 수 있습니다. LM Studio는 이를 위해 프로그램 인터페이스를 업데이트하여 사용자가 MCP 서비스를 설치 및 구성하고 로컬 MCP 서버 프로세스를 자동으로 로드 및 관리할 수 있도록 했습니다. 구성을 용이하게 하기 위해 LM Studio는 원클릭으로 가져올 수 있는 MCP 서버 구성 링크를 생성하는 온라인 도구도 제공합니다. (출처: multimodalart, karminski3)

Gradio, 경량 실험 추적 라이브러리 Trackio 출시: Hugging Face 산하 Gradio 팀이 경량 실험 추적 및 시각화 라이브러리인 Trackio를 출시했습니다. 이 도구는 1000줄 미만의 Python 코드로 작성되었으며, 완전 오픈소스이며 무료로 로컬 또는 호스팅 환경에서 사용할 수 있습니다. Trackio는 개발자가 머신러닝 실험 과정의 다양한 지표와 결과를 보다 편리하게 기록하고 모니터링하여 실험 관리 프로세스를 단순화하도록 돕는 것을 목표로 합니다. (출처: ClementDelangue, _akhaliq)

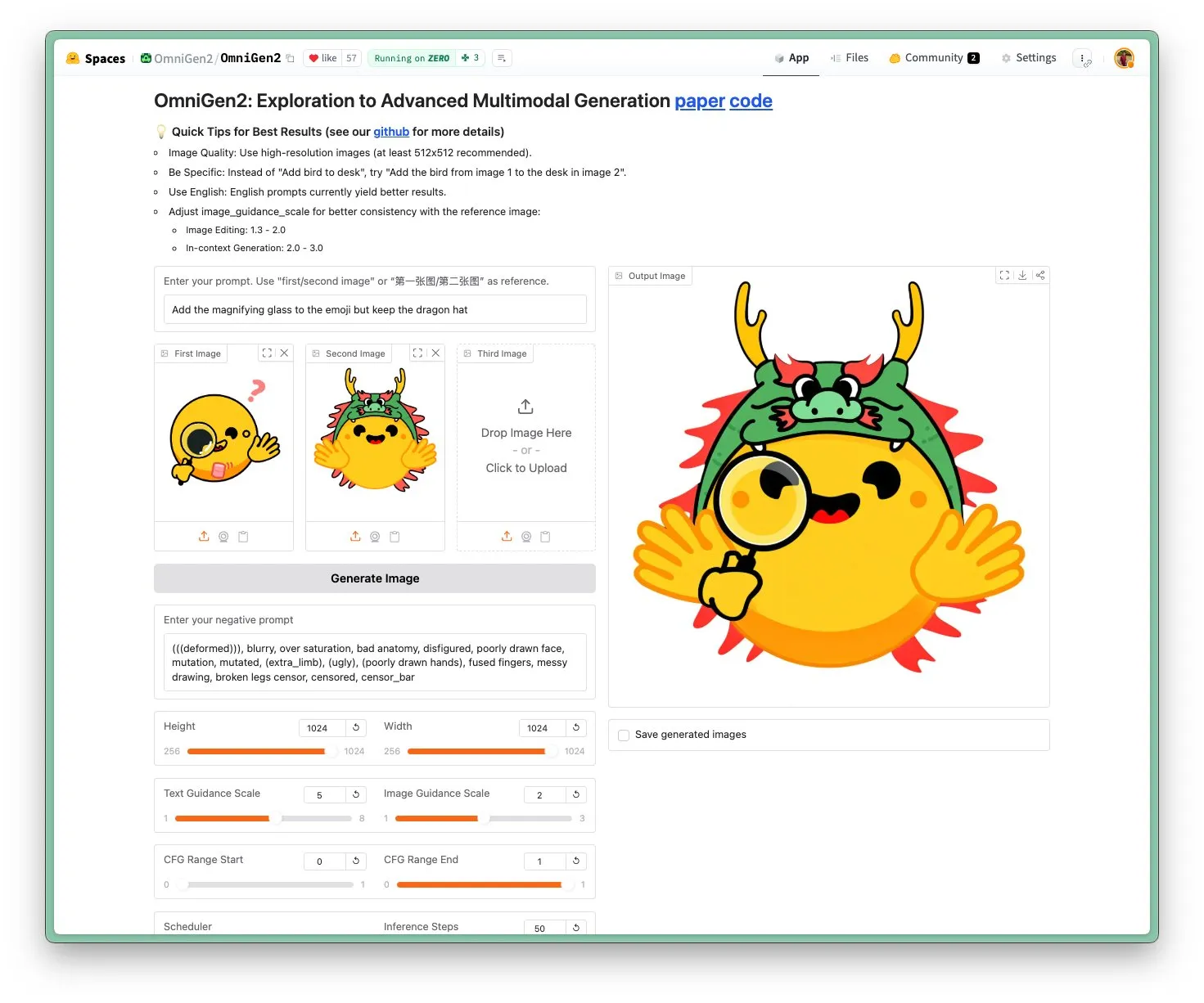

OmniGen 2 출시: Apache 2.0 라이선스의 SOTA 이미지 편집 및 다기능 비전 모델: 새로운 OmniGen 2 모델이 이미지 편집 분야에서 SOTA(최첨단) 수준을 달성했으며 Apache 2.0 오픈소스 라이선스를 채택했습니다. 이 모델은 이미지 편집에 능숙할 뿐만 아니라 컨텍스트 생성, 텍스트-이미지 변환, 시각적 이해 등 다양한 작업을 수행할 수 있습니다. 사용자는 Hugging Face Hub에서 직접 데모와 모델을 체험할 수 있습니다. (출처: huggingface)

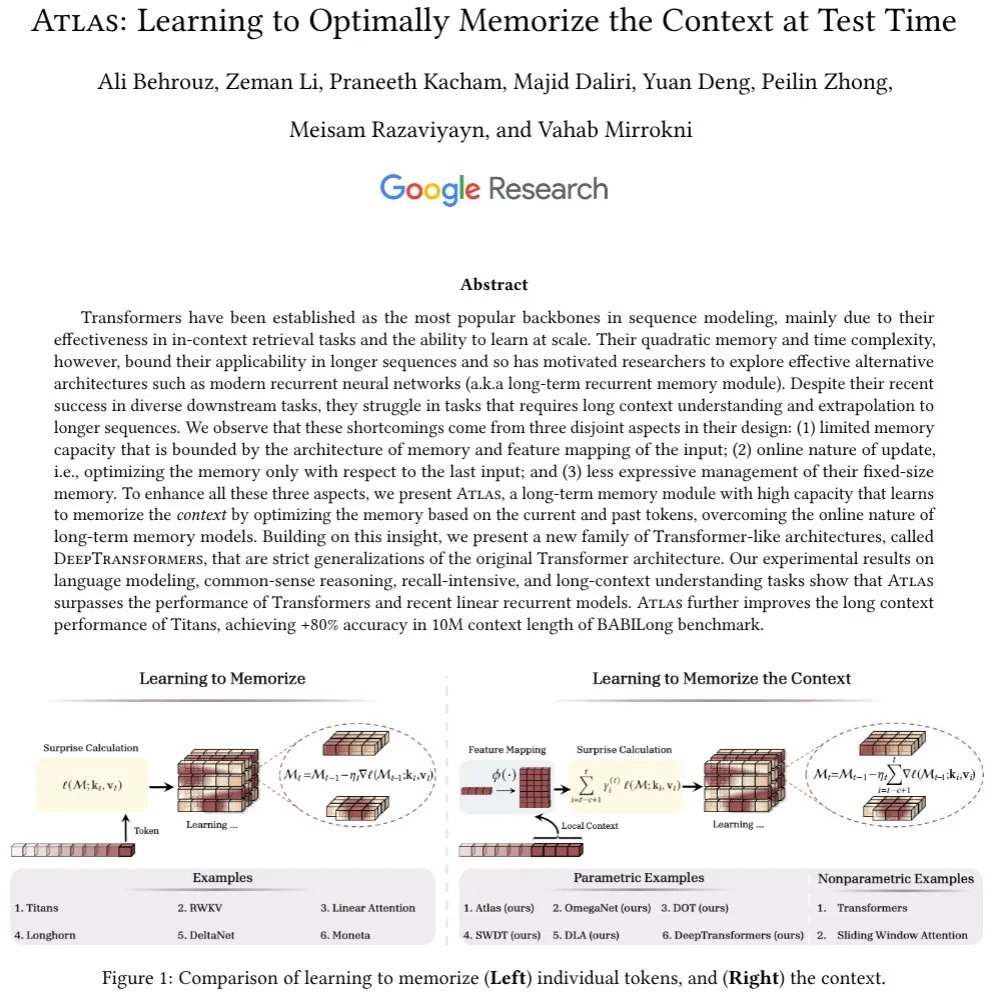

Atlas 아키텍처 제안: 장기 컨텍스트 메모리 보유, Transformer에 도전: 새롭게 제안된 Atlas 아키텍처는 LLM의 장기 기억 문제를 해결하는 것을 목표로 하며, 언어 모델링 작업에서 Transformer 및 최신 선형 RNN보다 우수하다고 주장합니다. Atlas는 테스트 시 컨텍스트를 기억하는 방법을 학습할 수 있는 능력을 갖추고 있어 Titans 모델의 유효 컨텍스트 길이를 향상시키고 BABILong 벤치마크 테스트에서 1000만 컨텍스트 창 길이로 80% 이상의 정확도를 달성합니다. 연구진은 또한 Atlas 아이디어를 기반으로 엄격하게 일반화된 소프트맥스 어텐션 모델의 또 다른 시리즈에 대해 논의했습니다. (출처: behrouz_ali)

Moondream 2B 비전 모델 업데이트: 시각적 추론 및 UI 이해 강화, 텍스트 생성 속도 40% 향상: Moondream 2B 비전 모델이 새로운 버전을 출시하여 시각적 추론, 객체 감지 및 UI 이해 측면에서 개선되었으며 텍스트 생성 속도가 40% 향상되었습니다. 이는 소형 멀티모달 모델이 특정 능력에서 지속적으로 최적화되어 보다 효율적이고 정확한 시각-언어 상호 작용을 제공하는 것을 목표로 함을 보여줍니다. (출처: mervenoyann)

Inworld AI, Modular와 협력하여 저비용 고품질 TTS 모델 출시: Inworld AI가 최첨단 TTS 비용을 20배 절감하여 백만 자당 5달러로 낮춘 새로운 텍스트 음성 변환(TTS) 모델을 출시한다고 발표했습니다. 이 모델은 Llama 아키텍처를 기반으로 하며, 훈련 및 모델링 코드는 오픈소스화될 예정입니다. 파트너사인 Modular는 기술 협력을 통해 NVIDIA B200에서 최저 지연 시간, 가장 빠른 TTS 추론 플랫폼을 구현했으며 공동 기술 보고서를 발표할 것이라고 밝혔습니다. (출처: clattner_llvm)

Higgsfield AI, Soul 모델 출시: 고미학 사진 생성에 집중: Higgsfield AI가 Higgsfield Soul이라는 새로운 사진 생성 모델을 출시했습니다. 이 모델은 높은 미적 가치와 패션 수준의 사실감을 특징으로 합니다. 50가지 이상의 세심하게 선별된 사전 설정을 제공하여 전문 사진 촬영 효과에 필적하는 이미지를 생성하고 기존 휴대폰 사진에 도전하는 것을 목표로 합니다. (출처: _akhaliq)

🧰 툴

Gemini CLI: 구글이 출시한 오픈소스 터미널 AI 에이전트, 매일 1000회 Gemini 2.5 Pro 무료 호출 제공: 구글이 오픈소스 명령줄 AI 에이전트인 Gemini CLI를 출시했습니다. 사용자는 터미널에서 직접 Gemini 2.5 Pro 모델을 사용할 수 있습니다. 이 도구는 100만 토큰 컨텍스트 창을 제공하며, 무료 사용자는 매일 최대 1000회 요청(분당 60회)의 할당량을 받을 수 있습니다. Gemini CLI는 코드 작성, 디버깅, 파일 시스템 I/O, 웹 페이지 내용 이해, 플러그인 및 MCP 프로토콜을 지원하며, 개발자가 소프트웨어를 보다 효율적으로 구축하고 유지 관리하도록 돕는 것을 목표로 합니다. 오픈소스 특성(Apache 2.0 라이선스)과 높은 무료 할당량으로 인해 Claude Code 등 기존 도구의 강력한 경쟁자가 되었으며, 로컬 모델 지원을 촉진할 수 있습니다. (출처: Reddit r/LocalLLaMA, dotey, yoheinakajima)

Anthropic, Claude Code 신기능 출시: AI 기반 Artifacts 생성 및 공유, 사용자 자체 할당량 사용: Anthropic은 AI 프로그래밍 어시스턴트 Claude Code에 사용자가 “Artifacts”(소형 AI 애플리케이션 또는 도구로 이해 가능)를 생성, 호스팅 및 공유하고 Claude의 지능을 이러한 창작물에 직접 내장할 수 있는 새로운 기능을 도입했습니다. 이는 사용자가 Claude를 사용하여 코드 스니펫을 생성하거나 분석하는 것뿐만 아니라 AI 기반의 기능적인 애플리케이션을 구축할 수 있음을 의미합니다. 중요한 특징은 이러한 AI 애플리케이션을 공유할 때 시청자가 자신의 Claude 계정을 사용하여 인증하고 사용량은 생성자가 아닌 시청자 자신의 구독 할당량으로 계산된다는 것입니다. 이 기능은 현재 베타 단계이며 모든 무료, Pro 및 Max 사용자에게 공개되어 AI 애플리케이션 생성 장벽을 낮추고 AI 능력의 보급과 공유를 촉진하는 것을 목표로 합니다. (출처: kylebrussell, Reddit r/ClaudeAI, dotey)

LM Studio, MCP 프로토콜 지원 업데이트, 로컬 LLM과 MCP 서버 연결 가능: 데스크톱 LLM 실행 도구 LM Studio가 새 버전(0.3.17)을 출시하며 모델 컨텍스트 프로토콜(MCP) 지원을 추가했습니다. 사용자는 이제 로컬에서 실행되는 대규모 언어 모델을 MCP 호환 서버(예: 외부 도구 또는 서비스 호출)와 연결할 수 있습니다. LM Studio는 이를 위해 프로그램 인터페이스를 업데이트하여 사용자가 MCP 서비스를 설치 및 구성하고 로컬 MCP 서버 프로세스를 자동으로 로드 및 관리할 수 있도록 했습니다. 구성을 용이하게 하기 위해 LM Studio는 원클릭으로 가져올 수 있는 MCP 서버 구성 링크를 생성하는 온라인 도구도 제공합니다. (출처: multimodalart, karminski3)

Superconductor: 모바일 또는 데스크톱에서 Claude Code 에이전트 팀을 관리하는 도구: Superconductor는 사용자가 휴대폰이나 노트북을 통해 여러 Claude Code 에이전트로 구성된 팀을 관리할 수 있는 새로운 도구입니다. 사용자는 비공식적인 작업 티켓을 작성하고 각 티켓에 대해 여러 에이전트를 시작할 수 있으며, 각 에이전트는 자체 실시간 애플리케이션 미리보기를 갖습니다. 개발자는 가장 우수한 성능을 보인 에이전트의 결과를 원클릭으로 PR(Pull Request)로 생성할 수 있습니다. 이 도구는 다중 에이전트 협업 및 코드 생성 프로세스를 단순화하는 것을 목표로 합니다. (출처: full_stack_dl)

Udio, Sessions 기능 출시, AI 음악 편집 정확도 향상: AI 음악 생성 플랫폼 Udio가 표준 및 프로 구독 사용자를 위해 “Sessions” 기능을 출시했습니다. 이 기능은 트랙 편집을 위한 새로운 타임라인 뷰를 도입하여 사용자가 AI의 무작위 생성에 대한 의존도를 줄이고 음악을 보다 정확하게 제작할 수 있도록 합니다. 현재 Sessions는 트랙 확장 또는 편집을 지원하며 향후 더 많은 기능이 추가될 예정입니다. (출처: TomLikesRobots)

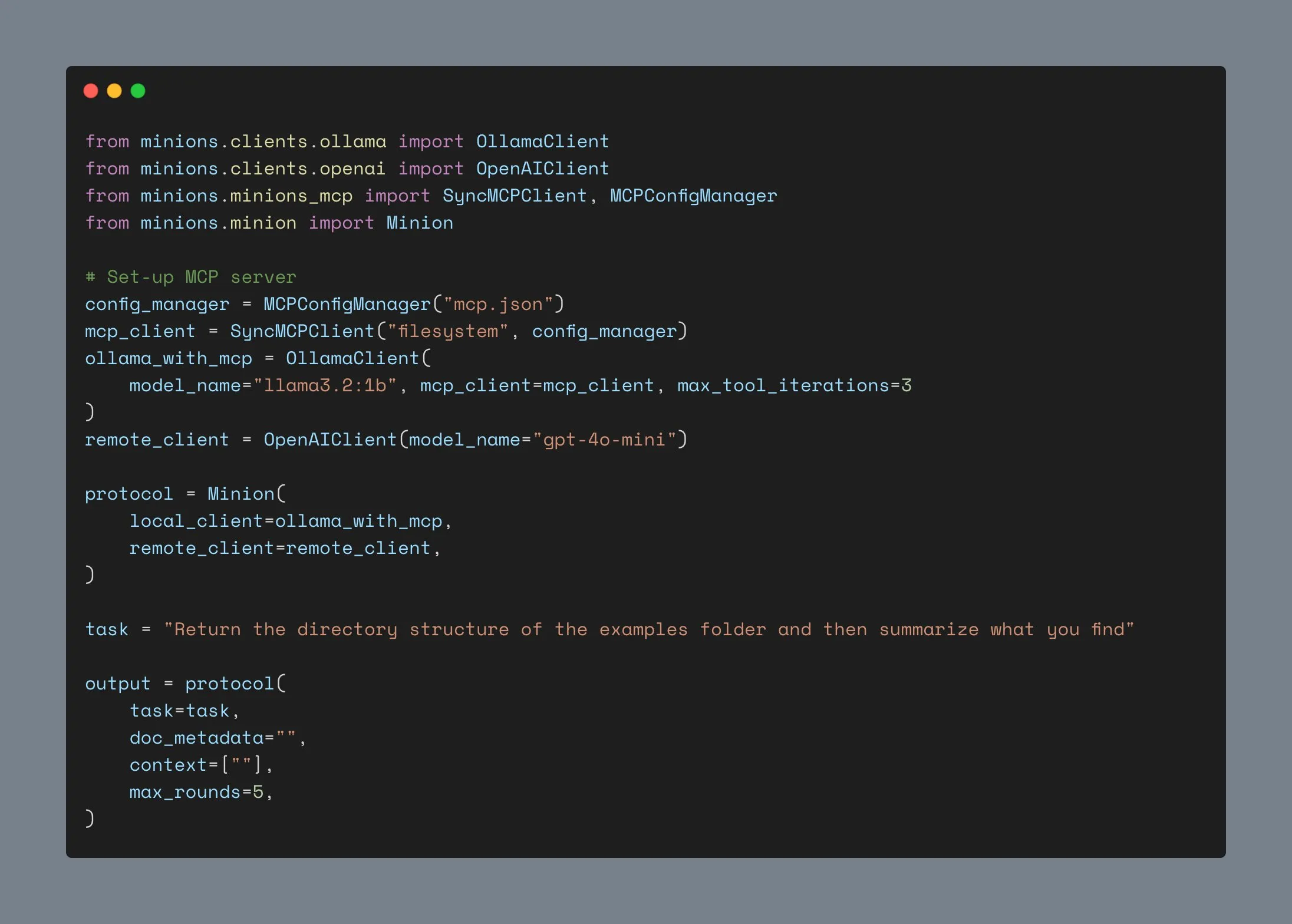

Ollama 클라이언트 업데이트, MCP 통합 지원, GitHub 스타 1000개 돌파: Ollama 클라이언트가 업데이트되어 도구 호출 기능을 모든 Anthropic MCP 서버와 통합할 수 있게 되었습니다. 이는 사용자가 Ollama 로컬 실행 모델의 편리함과 MCP가 제공하는 외부 도구 기능을 결합할 수 있음을 의미합니다. 동시에 이 프로젝트는 GitHub에서 스타 수가 1000개를 돌파했습니다. (출처: ollama)

📚 학습

앤드류 응, 새로운 강좌 출시: ACP 에이전트 통신 프로토콜: DeepLearning.AI와 IBM Research가 에이전트 통신 프로토콜(ACP)에 관한 단기 강좌를 공동으로 출시했습니다. ACP는 통합된 RESTful 인터페이스를 통해 에이전트 간 통신을 표준화하는 개방형 프로토콜로, 여러 팀이 다양한 프레임워크를 사용하여 다중 에이전트 시스템을 구축할 때 발생하는 통합 문제를 해결하는 것을 목표로 합니다. 이 강좌에서는 ACP를 사용하여 CrewAI, Smoljames와 같은 다양한 프레임워크로 구축된 에이전트를 연결하고, 순차적 및 계층적 워크플로 협업을 구현하며, ACP 에이전트를 BeeAI 플랫폼(오픈소스 에이전트 등록 및 공유 플랫폼)으로 가져오는 방법을 가르칩니다. 수강생은 ACP 에이전트의 수명 주기를 배우고 MCP(모델 컨텍스트 프로토콜), A2A(에이전트 대 에이전트) 등과 같은 프로토콜과 비교하게 됩니다. (출처: AndrewYNg)

존스 홉킨스 대학교, DSPy 강좌 개설: 존스 홉킨스 대학교에서 DSPy에 관한 강좌를 개설했습니다. DSPy는 LLM 프롬프트와 가중치를 알고리즘적으로 최적화하기 위한 프레임워크로, 기존에 수동으로 조정해야 했던 프롬프트 엔지니어링 과정을 보다 체계적이고 프로그래밍 가능한 모듈 구축 및 최적화 프로세스로 전환합니다. Shopify CEO Tobi Lutke도 DSPy가 컨텍스트 엔지니어링을 위한 최고의 도구라고 언급했습니다. (출처: stanfordnlp, lateinteraction)

LM Studio 튜토리얼: 오픈소스 Hugging Face 모델을 사용하여 로컬에서 비공개 ChatGPT와 유사한 경험 구현: Niels Rogge가 LM Studio와 Hugging Face의 오픈소스 모델(예: Mistral 3.2-Small)을 결합하여 로컬에서 100% 비공개 및 오프라인으로 ChatGPT와 유사한 경험을 구현하는 방법을 시연하는 YouTube 튜토리얼을 게시했습니다. 튜토리얼에서는 GGUF, 양자화 등의 개념과 4비트 양자화에서도 모델이 큰 공간을 차지하는 이유를 설명하고 LM Studio와 OpenAI API의 호환성을 보여줍니다. (출처: _akhaliq)

LlamaIndex, 에이전트 메모리에 관한 온라인 워크숍 개최 예정: LlamaIndex가 AIMakerspace와 협력하여 에이전트 메모리에 관한 온라인 토론을 개최할 예정입니다. 내용은 지속적인 채팅 기록, 정적, 사실 및 벡터 블록을 사용한 장기 기억 구현, 사용자 정의 메모리 구현 로직, 그리고 메모리가 중요한 시점 등에 대해 다룰 예정입니다. 이 토론은 개발자가 대화에서 실제 컨텍스트가 필요한 에이전트를 구축하는 데 도움을 주는 것을 목표로 합니다. (출처: jerryjliu0)

Weaviate 팟캐스트, RAG 벤치마크 및 평가 논의: Weaviate 팟캐스트 124회에서는 검색 평가 분야에서 중요한 공헌을 한 Nandan Thakur를 초대하여 검색 증강 생성(RAG)의 벤치마크 테스트 및 평가에 대해 논의했습니다. 내용은 BEIR, MIRACL, TREC 및 최신 FreshStack과 같은 벤치마크와 RAG에서의 추론, 쿼리 작성, 순환 검색, 페이지 검색 결과, 하이브리드 검색기 등 다양한 주제를 다룹니다. (출처: lateinteraction)

PyTorch, flux-fast 레시피 출시, H100에서 Flux 모델 2.5배 가속: PyTorch가 복잡한 조정 없이 H100 GPU에서 Flux 모델의 실행 속도를 2.5배 향상시키는 것을 목표로 하는 flux-fast라는 간단한 레시피를 출시했습니다. 이 솔루션은 고성능 컴퓨팅 구현을 단순화하기 위한 것이며 관련 코드가 제공되었습니다. (출처: robrombach)

MLSys 2026 컨퍼런스 정보 공개: MLSys 2026 컨퍼런스는 2026년 5월 시애틀(벨뷰)에서 개최될 예정이며, 논문 제출 마감일은 올해 10월 30일입니다. MLSys 2025의 모든 컨퍼런스 영상은 공식 웹사이트에서 무료로 시청할 수 있습니다. 이 컨퍼런스는 머신러닝 시스템 분야의 연구와 발전에 중점을 둡니다. (출처: JeffDean)

스탠포드 CS336 강좌 ‘처음부터 언어 모델 구축하기’ 주목: 스탠포드 대학교 Percy Liang 등이 강의하는 CS336 강좌 ‘처음부터 언어 모델 구축하기’(Language Models from Scratch)가 호평을 받고 있습니다. 이 강좌는 학생들이 언어 모델의 기술적 세부 사항을 깊이 이해하고, 직접 모델을 구축함으로써 연구자와 기술적 세부 사항 간의 괴리를 메우는 것을 목표로 합니다. 강좌 내용과 과제는 LLM 전문가가 되기 위한 중요한 학습 자료로 간주됩니다. (출처: nrehiew_, jpt401)

💼 비즈니스

Meta, Scale AI에 143억 달러 투자 및 CEO Alexandr Wang 영입, AI 연구 개발 가속화: Meta는 AI 역량 강화를 위해 데이터 라벨링 회사 Scale AI와 계약을 체결하여 143억 달러를 투자해 의결권 없는 지분 49%를 확보하고, 창립자 겸 CEO인 Alexandr Wang과 그의 팀을 영입했습니다. Alexandr Wang은 Meta의 초지능 연구에 중점을 둔 새로운 연구소를 책임지게 됩니다. 이번 조치는 Llama 4 모델의 미미한 반응과 AI 연구 부서의 인사 불안정에 대응하여 Meta에 최고 수준의 AI 인재와 대규모 데이터 운영 능력을 불어넣기 위한 것입니다. Scale AI는 자금을 활용하여 혁신을 가속화하고 주주들에게 일부 자금을 분배할 예정이며, 최고 전략 책임자인 Jason Droege가 임시 CEO를 맡게 됩니다. 이번 거래는 직접 인수를 피함으로써 일부 정부 심사를 회피했을 가능성이 있습니다. (출처: DeepLearning.AI Blog)

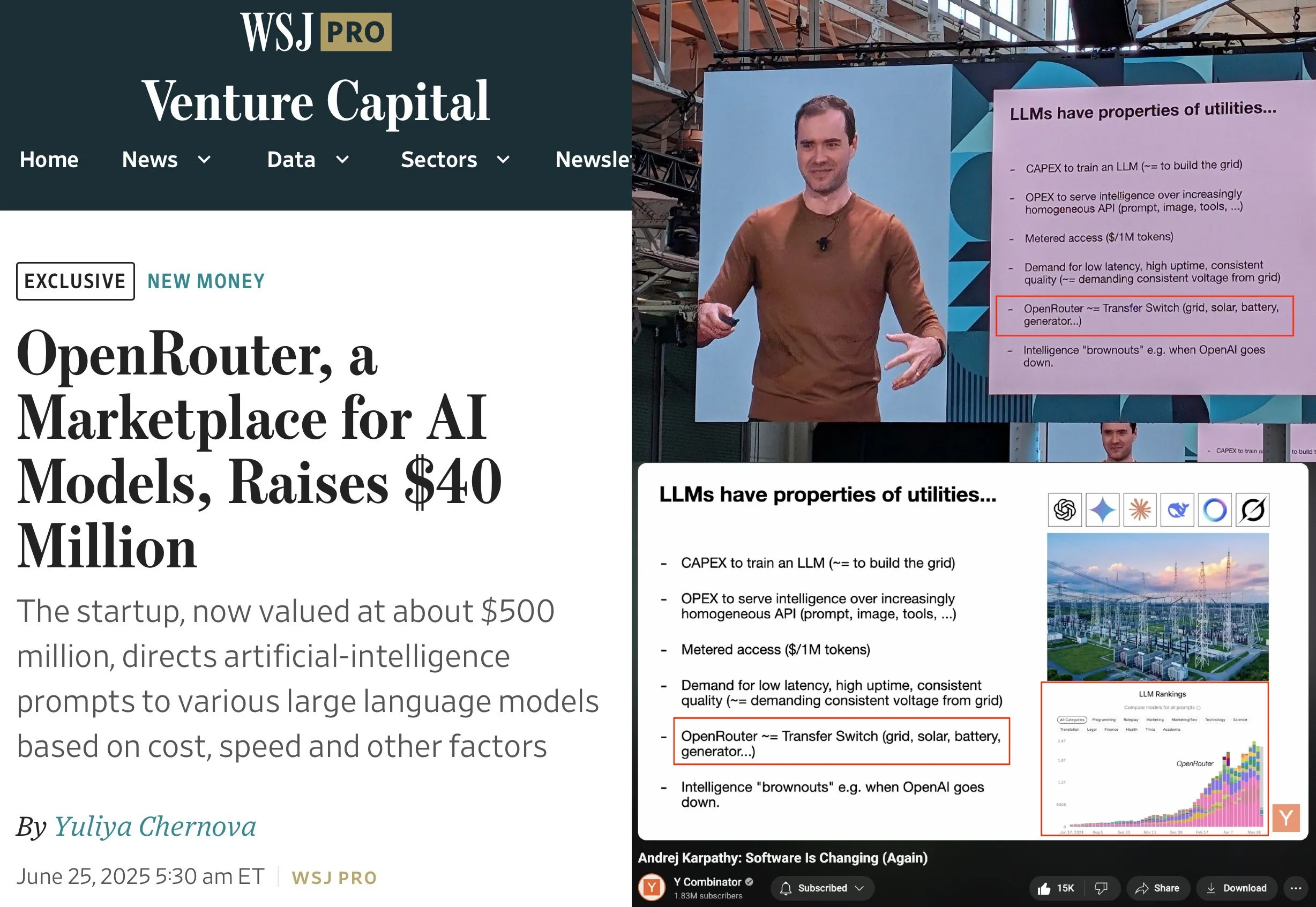

OpenRouter, a16z와 Menlo 주도로 4천만 달러 시리즈 A 투자 유치: LLM 추론 제어 플레인 및 모델 마켓플레이스 OpenRouter가 a16z와 Menlo Ventures 주도로 총 4천만 달러 규모의 시드 라운드 및 시리즈 A 투자를 유치했다고 발표했습니다. OpenRouter는 개발자가 다양한 LLM을 선택하고 사용하는 통합 인터페이스가 되는 것을 목표로 하며, 현재 400개 이상의 모델을 제공하고 연간 100조 개의 토큰을 처리합니다. 투자금은 지원 모델 모달리티 확장(예: 이미지 생성, 멀티모달 인터랙션 모델), 보다 스마트한 라우팅 메커니즘 구현(예: 지리적 라우팅, 기업용 GPU 할당 최적화) 및 모델 검색 기능 강화에 사용될 예정입니다. (출처: amasad, swyx)

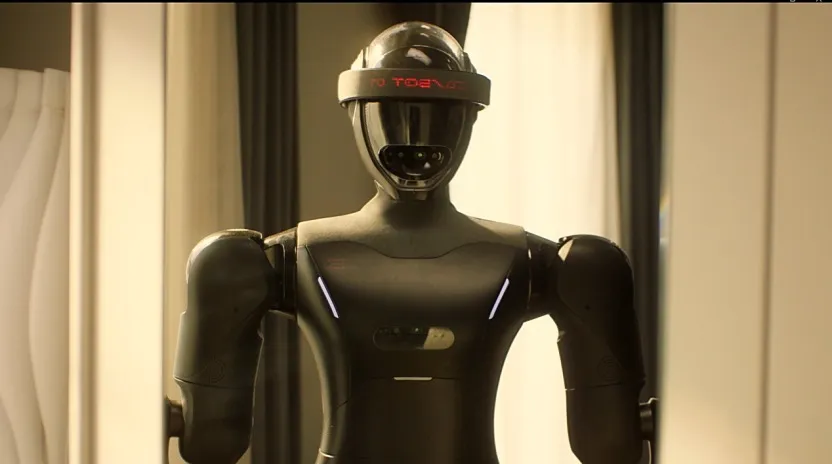

휴머노이드 로봇 회사 ‘링바오 CASBOT’, 란쓰테크놀로지 주도로 약 1억 위안 규모 엔젤+ 투자 유치: 휴머노이드 로봇 브랜드 ‘링바오 CASBOT’이 란쓰테크놀로지(蓝思科技) 주도로 약 1억 위안 규모의 엔젤+ 투자를 유치했다고 발표했습니다. 톈진자이(天津佳益) 및 기존 주주인 궈터우촹허(国投创合), 허난자산(河南资产)이 공동 투자했습니다. 자금은 제품 양산 가속화, 기술 연구 개발 및 시장 확장에 사용될 예정입니다. 링바오 CASBOT은 범용 휴머노이드 로봇과 체화 지능(embodied intelligence)의 실제 적용에 중점을 두고 있으며, 이미 특수 작업용 CASBOT 01과 안내, 교육 등 보다 광범위한 인간-로봇 상호작용 시나리오용 CASBOT 02 두 가지 이족보행 휴머노이드 로봇을 출시했습니다. 회사의 핵심 기술에는 강화 학습 후 훈련과 결합된 계층적 종단 간 모델이 포함되며, 이미 산업 제조 및 광물 에너지 분야에서 자오진 그룹(招金集团), 중광 그룹(中矿集团) 등과 협력 관계를 맺었습니다. (출처: 36氪, 36氪)

🌟 커뮤니티

Andrej Karpathy, ‘컨텍스트 엔지니어링’이 ‘프롬프트 엔지니어링’을 대체해야 한다고 주장하며 LLM 애플리케이션 구축의 복잡성 강조: Andrej Karpathy는 Tobi Lutke의 견해에 동의하며, ‘컨텍스트 엔지니어링(context engineering)’이 ‘프롬프트 엔지니어링(prompt engineering)’보다 산업 수준 LLM 애플리케이션의 핵심 기술을 더 정확하게 설명한다고 주장했습니다. 그는 프롬프트가 일반적으로 사용자가 일상적으로 입력하는 짧은 작업 설명을 의미하는 반면, 컨텍스트 엔지니어링은 컨텍스트 창에 작업 설명, 소량의 예시, RAG, 멀티모달 데이터, 도구, 상태 기록 등의 정보를 정확하게 채워 LLM 성능을 최적화하는 정교한 예술이자 과학이라고 지적했습니다. 또한 LLM 애플리케이션은 이보다 훨씬 더 복잡하며, 문제 분해, 제어 흐름, 다중 모델 스케줄링, UI/UX, 안전성 평가 등 일련의 복잡한 소프트웨어 엔지니어링 문제를 해결해야 하므로 ‘ChatGPT 껍데기’라는 말은 잘못되었다고 강조했습니다. (출처: karpathy, code_star, dotey)

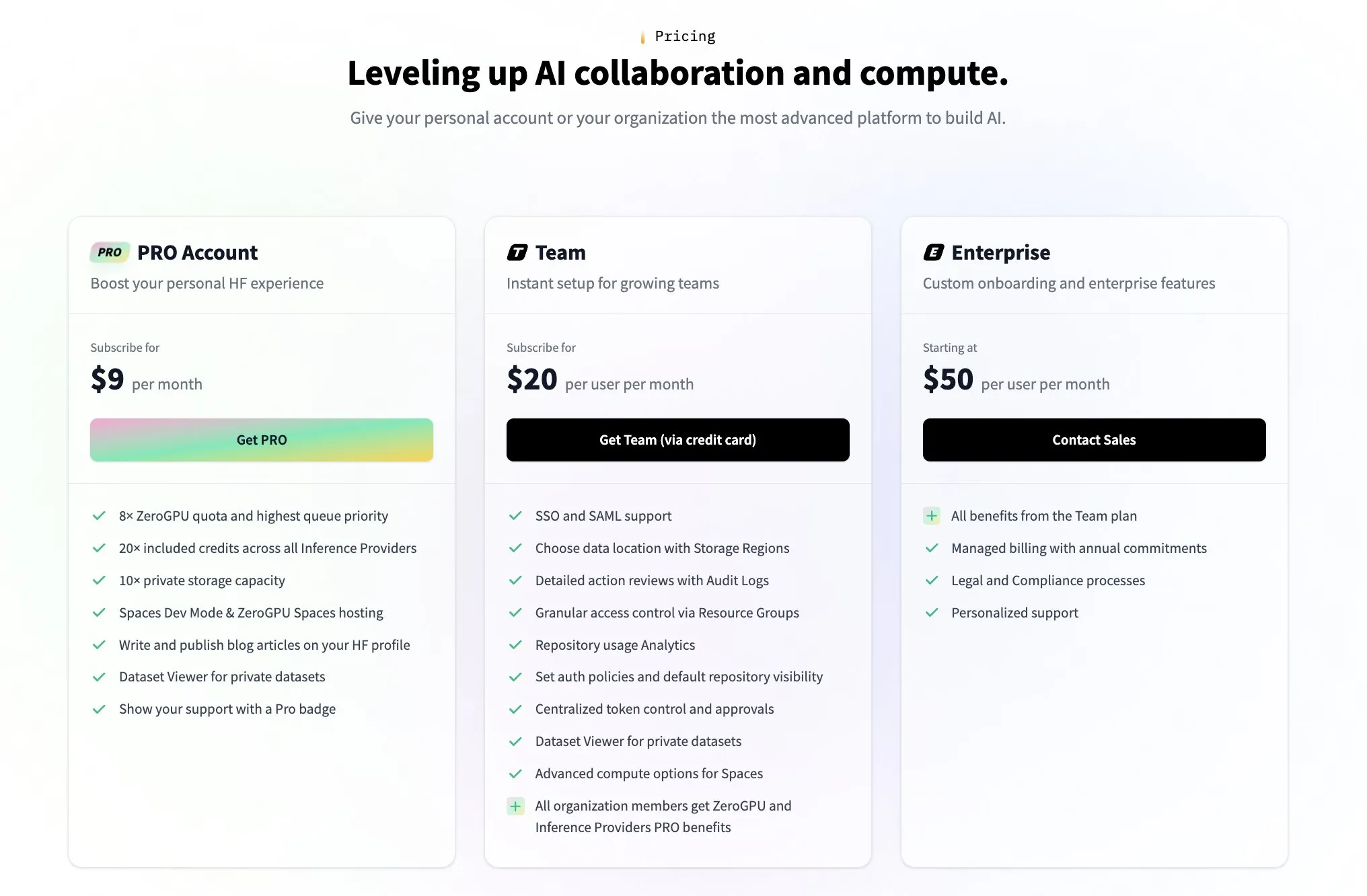

Hugging Face, 수익 모델에 대한 커뮤니티 의문에 대응하기 위해 유료 팀 플랜 출시: Hugging Face의 수익 모델에 대한 커뮤니티의 의문(예: 사용자 @levelsio의 트윗으로 촉발됨)에 대해 Hugging Face 공동 창립자 Clement Delangue는 “수익 불안이 촉발되었다”고 유머러스하게 응답하며 새로운 유료 고급 팀 플랜을 출시한다고 발표했습니다. Hugging Face는 수많은 AI 모델을 호스팅하고 무료 API를 제공하며 API 키를 강제하지 않는 플랫폼으로서, 그 비즈니스 모델은 항상 커뮤니티 토론의 초점이었습니다. 새로운 플랜 출시는 Hugging Face가 적극적으로 상업화 경로를 모색하고 확장하고 있음을 보여줍니다. (출처: huggingface, ClementDelangue)

커뮤니티, AI 코드 어시스턴트 사용자 충성도 및 다중 도구 협업에 대해 열띤 토론: The Information은 개발자들이 코딩 어시스턴트에 대한 충성도가 생각보다 높을 수 있다고 보도했습니다. 동시에 커뮤니티에서는 개발자들이 동일한 코드 저장소에서 Claude Code, Codex (CLI) 및 Gemini (CLI) 등 여러 AI 코딩 도구를 동시에 사용하는 현상도 나타나고 있습니다. 이는 개발자들이 효율성을 높이기 위해 다양한 AI 도구를 적극적으로 시도하고 있으며, 단일 도구에 완전히 의존하기보다는 자신의 작업 흐름에 가장 적합한 특정 기능 조합을 찾고 있을 가능성을 반영합니다. (출처: steph_palazzolo, code_star)

AI, 의료 진단에서 잠재력 발휘하며 ‘세컨드 오피니언’ 논의 촉발: 소셜 미디어에서 AI 보조 진단 사례가 다시 등장했습니다. 목 통증 환자가 의사의 관찰 권고 후 ChatGPT를 통해 조언을 얻어 초음파 검사를 진행했고, 결국 갑상선암을 발견했습니다. 이러한 사건은 사람들이 의료 문제에 대해 AI를 활용하여 ‘세컨드 오피니언’을 얻도록 장려하는 논의를 촉발했으며, 이것이 생명을 구할 수 있다고 여겨집니다. 동시에 알리바바 다모아카데미의 GRAPE 모델이 일반 CT 스캔을 통해 조기 위암을 검출하는 연구도 《네이처 메디슨》에 게재되어 AI가 암 조기 발견 분야에서 엄청난 잠재력을 가지고 있음을 보여주었습니다. (출처: aidan_mclau, Yuchenj_UW)

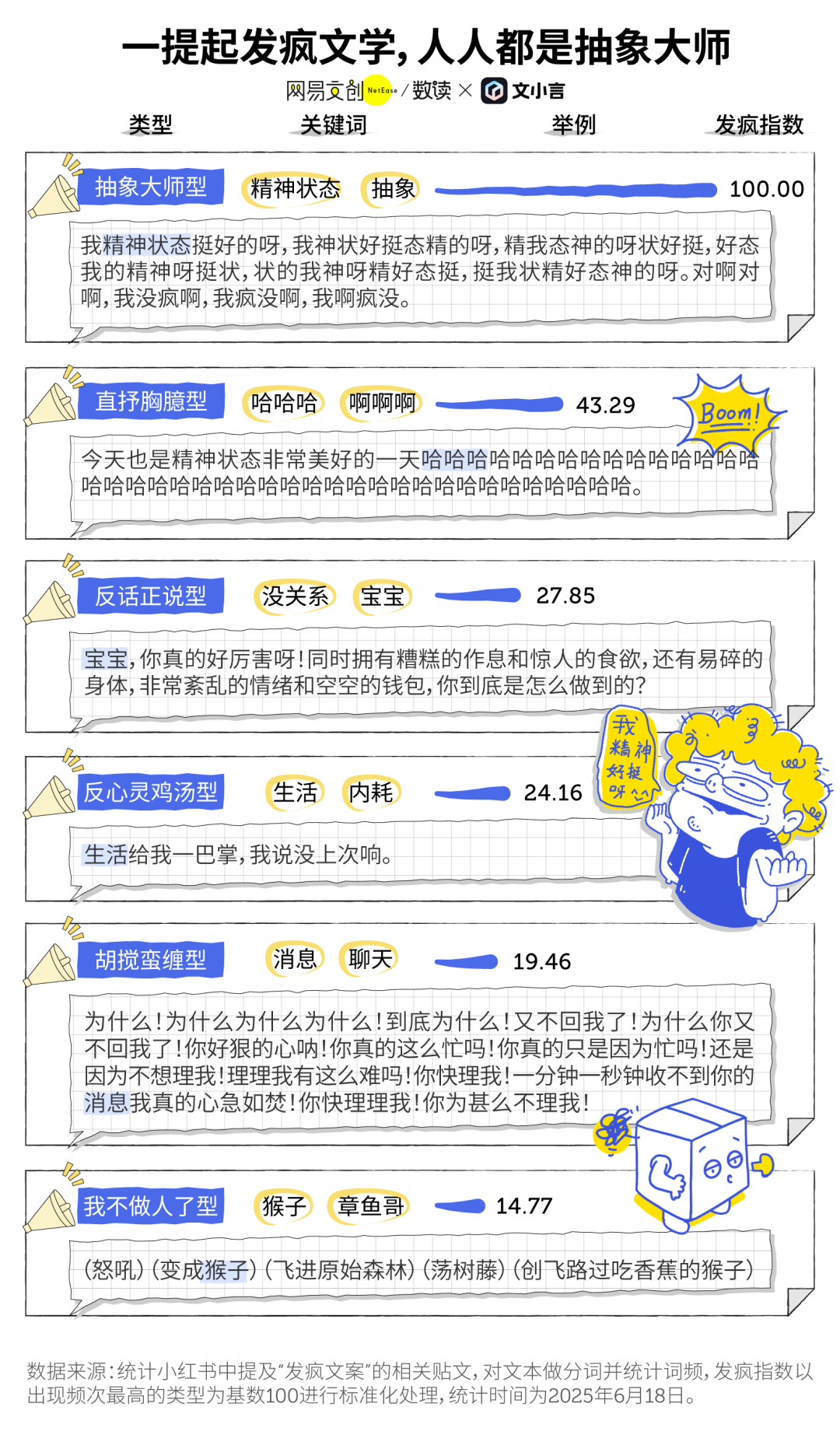

AI 시대 ‘광란 문학’과 AI 동반 현상: 젊은층 사이에서 유행하는 ‘광란 문학(发疯文学)’은 감정 해소와 미미한 저항의 방식으로, AI 도구와 교차점을 형성하고 있습니다. 많은 사용자가 생성형 AI(예: 원샤오옌의 단샤오황)를 감정 배출구이자 동반자로 삼아 외로움을 달래고 위안을 얻으며, 심지어 의사 결정(예: 말다툼 복기)에도 활용합니다. AI는 인내심 있고 편견 없으며 언제든지 사용할 수 있다는 특성 덕분에 저비용 고프라이버시 ‘전자 친구’가 되어 사용자가 혼란스러운 순간에 위안을 찾도록 돕고 정신 상태 개선에 도움이 된다고 여겨집니다. (출처: 36氪)

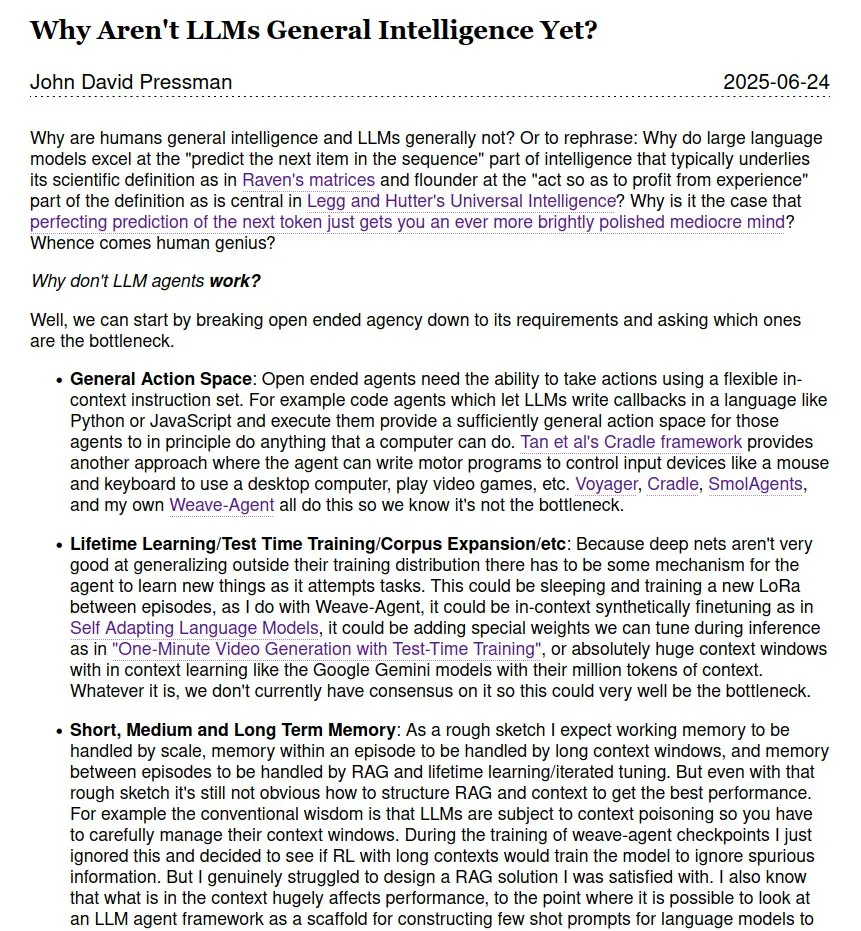

LLM이 범용 인공지능(AGI)인지에 대한 논의 지속: 커뮤니티에서는 대규모 언어 모델(LLM)이 범용 인공지능(AGI)에 도달했는지, 그리고 언제 도달할 수 있는지에 대한 논의가 계속되고 있습니다. LLM이 많은 작업에서 뛰어난 성능을 보이지만, 특히 인간 과학 천재의 이론과 내부 작동 데이터가 부족한 상황에서 진정한 AGI와는 거리가 멀다는 견해가 있습니다. AGI 구현 시점에 대해서도 2028년과 같은 가까운 미래부터 2035-2040년과 같은 더 먼 미래까지 다양한 의견이 존재합니다. (출처: menhguin)

💡 기타

세계 최초의 챗봇 Eliza, 60년 만에 성공적으로 복원: 매사추세츠 공과대학교(MIT) 과학자 조셉 와이젠바움이 1960년대 중반에 발명한 세계 최초의 챗봇 Eliza가 원본 코드가 수년간 유실된 후 인쇄본이 다시 발견되었습니다. 스탠포드 대학교와 MIT 팀의 노력으로 원본 코드 정리 및 디버깅, 기능 보완, 시뮬레이션 실행 환경 개발 등의 작업을 통해 Eliza는 60년 만에 성공적으로 “부활”했습니다. 원본 Eliza는 사용자 입력 텍스트를 분석하고 키워드를 추출하여 문장을 재구성하는 방식으로 응답했으며, 로저스식 치료사의 모습으로 사용자와 상호작용하여 많은 테스트 참여자에게 정서적 애착을 형성하게 했습니다. 복원된 Eliza 코드와 시뮬레이터는 Github에 공개되어 일반인이 체험할 수 있습니다. (출처: 36氪)

AI 이미지 생성 도구 Midjourney, 디즈니 등 저작권 소송 직면, 그러나 독특한 창작 모델로 인기: AI 이미지 생성 플랫폼 Midjourney는 생성된 이미지가 디즈니, 유니버설 픽처스 등 회사의 시각 자산 저작권을 침해할 가능성이 있어 법적 소송에 직면해 있습니다. 그러나 이 도구는 Discord 커뮤니티에서 텍스트 프롬프트를 통해 고도로 예술적이고 스타일리시한 이미지를 생성하는 독특한 창작 모델로 전 세계 크리에이터들 사이에서 큰 인기를 얻고 있습니다. Midjourney 팀은 50명 미만이며 투자를 유치하지 않았지만 연 매출은 이미 2억 달러에 달합니다. 제품 철학은 “상상력 최우선”을 강조하며 AI를 단순한 대체 도구가 아닌 인간 사고를 확장하는 엔진으로 포지셔닝하고, “탈도구화”된 미니멀한 상호작용과 커뮤니티 공동 창작 문화를 통해 디지털 창의성 패러다임을 재편하고 있습니다. (출처: 36氪)

AI 주도 리더십 변화: 계층적 복종에서 인간-기계 공생으로: AI가 업무에 깊숙이 통합됨에 따라 전통적인 리더십이 도전을 받고 있습니다. 구글 조사에 따르면 청년 리더의 82%가 AI를 사용하며, 오라클 데이터에 따르면 직원의 25%가 리더보다 AI에게 묻는 것을 선호합니다. AI는 리더십 환경 변화를 야기합니다. 정보와 경험은 더 이상 리더의 전유물이 아니며, 의사 결정 투명화는 압박감을 가져오고, 관리 대상은 순수 인간 팀에서 “인간-기계 혼합체”로 변화합니다. 푸단대학교 경영대학원은 “공생 리더십” 개념을 제시하며 전통 경제와 디지털 경제, 기업과 생태계, 인간 두뇌와 기계 두뇌의 융합 공생을 강조합니다. AI 시대 리더는 신구 동력 전환을 주도하고, 협력 네트워크에서 가치를 창출하며, 인간-기계 협력의 시너지 효과를 발휘해야 하며, 핵심 경쟁력은 AI를 인간에게 봉사하도록 하는 방법을 아는 데 있습니다. (출처: 36氪)