키워드:AI 에이전트, 대형 언어 모델, 멀티모달, 강화 학습, 세계 모델, Gemini, Qwen, DeepSeek, AI 에이전트 열풍, 희소 Transformer 기술, GraphRAG 멀티홉 질의응답, 디바이스 측 AI 모델, AI 음성 감정 표현

🔥 포커스

중국 AI 에이전트 열풍, 스타트업과 거대 기업 경쟁적 참여: 2024년 기초 대형 모델 열풍에 이어, 2025년 중국 AI 분야의 초점은 자체적으로 작업을 완료할 수 있는 시스템인 AI 에이전트(AI Agents)로 전환되고 있습니다. Manus(여행 계획, 웹사이트 디자인 등을 수행할 수 있는 범용 AI 에이전트)의 출시는 시장의 높은 관심과 Genspark 및 Flowith와 같은 많은 모방자를 불러일으켰습니다. 이러한 에이전트들은 대형 모델을 기반으로 구축되어 다단계 작업 실행을 최적화합니다. 중국은 고도로 통합된 애플리케이션 생태계, 빠른 제품 반복 및 방대한 디지털 사용자 기반을 바탕으로 AI 에이전트 개발에서 우위를 점하고 있습니다. 현재 Manus, Genspark, Flowith와 같은 스타트업은 주로 해외 시장을 겨냥하고 있는데, 이는 중국 본토에서 서구의 최상위 모델 사용이 제한되기 때문입니다. 동시에 ByteDance, Tencent 등 테크 거대 기업들은 자사의 슈퍼 앱에 통합될 자체 AI 에이전트를 개발 중이며, 방대한 데이터 생태계를 활용할 가능성이 있습니다. 이 경쟁은 AI 에이전트의 실용적인 형태와 서비스 대상을 정의하게 될 것입니다 (출처: MIT Technology Review)

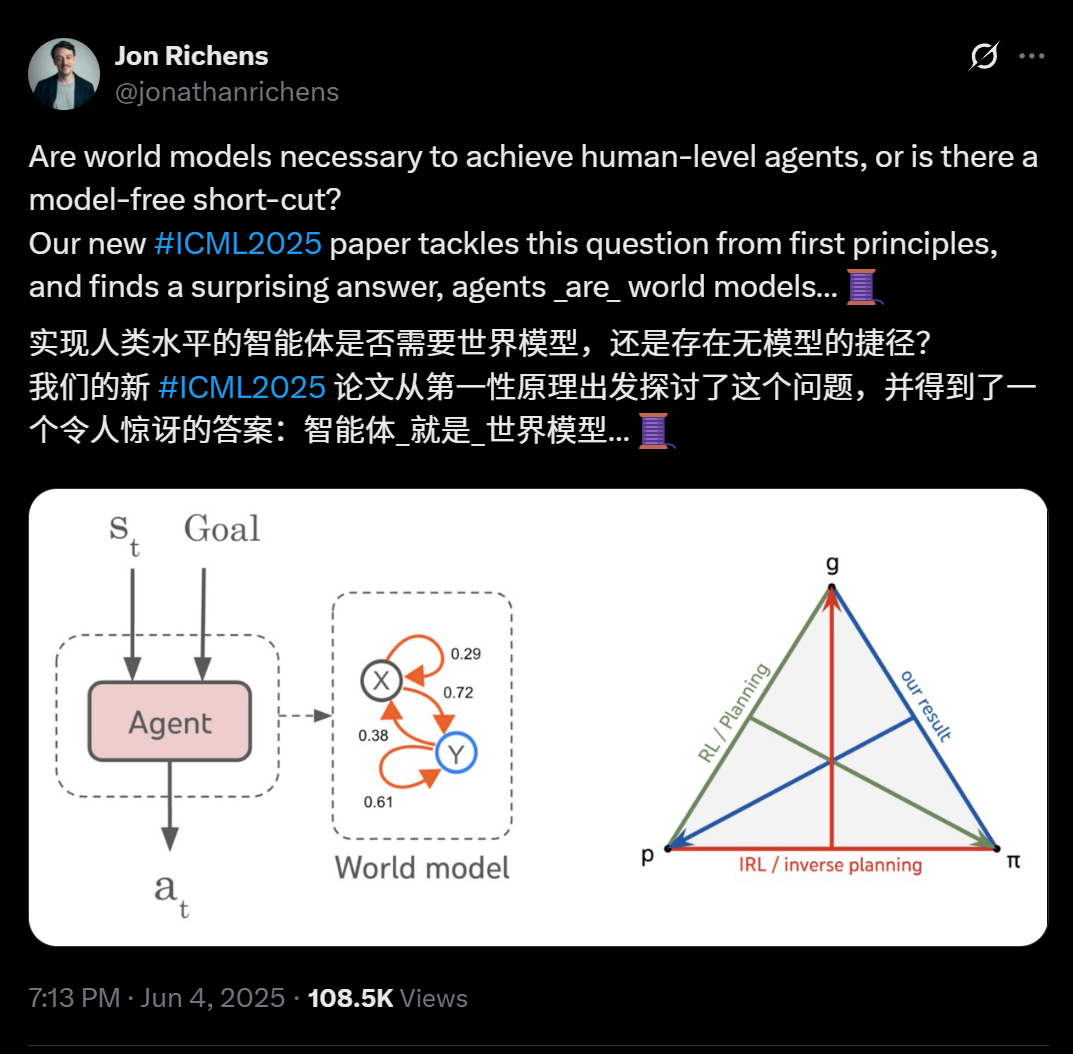

DeepMind 과학자 새 논문 공개: 다단계 목표 작업 일반화 가능한 모든 에이전트는 본질적으로 환경 예측 모델(세계 모델)을 학습한 것: DeepMind 과학자 Jon Richens가 ICML 2025에서 발표한 논문에 따르면, 다단계 목표 지향 작업으로 일반화할 수 있는 에이전트는 필연적으로 해당 환경의 예측 모델, 즉 “에이전트가 곧 세계 모델”임을 학습한 것입니다. 이 관점은 Ilya Sutskever의 2023년 예언과 일치하며, AGI 달성에 모델 없는 지름길은 없다는 점을 강조합니다. 연구에 따르면 에이전트의 전략에는 이미 환경 시뮬레이션에 필요한 정보가 포함되어 있으며, 더 정확한 세계 모델을 학습하는 것이 성능 향상과 더 복잡한 목표 달성의 전제 조건입니다. 논문은 또한 에이전트 전략에서 세계 모델을 추출하는 알고리즘을 제시하여 계획, 역 강화 학습 및 세계 모델 복원 간의 삼위일체 관계를 더욱 상세히 설명합니다. 이 발견은 목표 지향 학습이 사회적 인지, 불확실성 추론과 같은 에이전트의 다양한 창발적 능력을 촉발하는 데 중요하다는 점을 강조합니다 (출처: 36Kr)

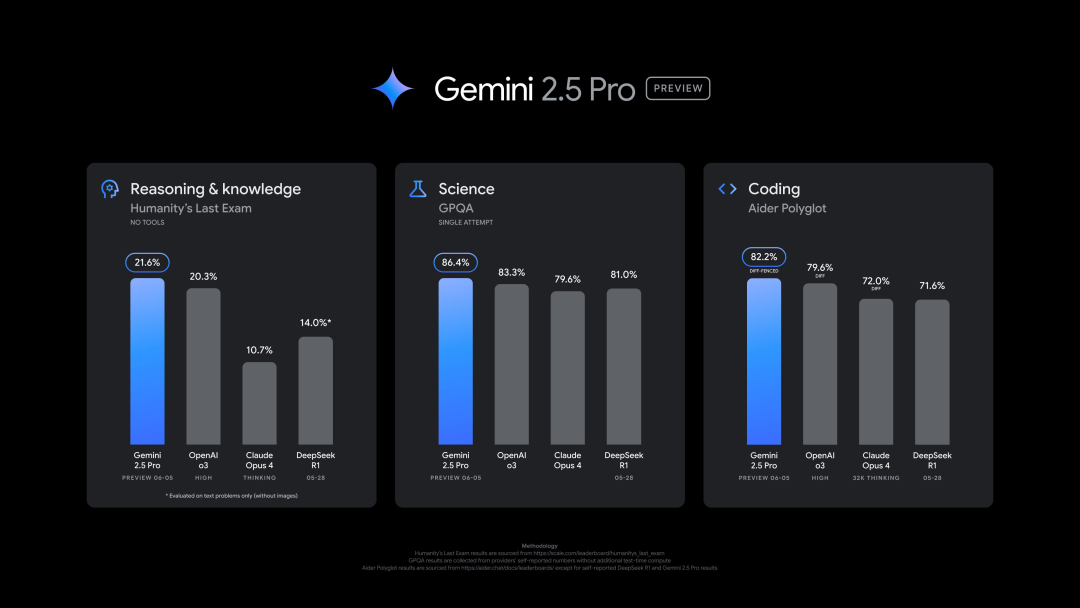

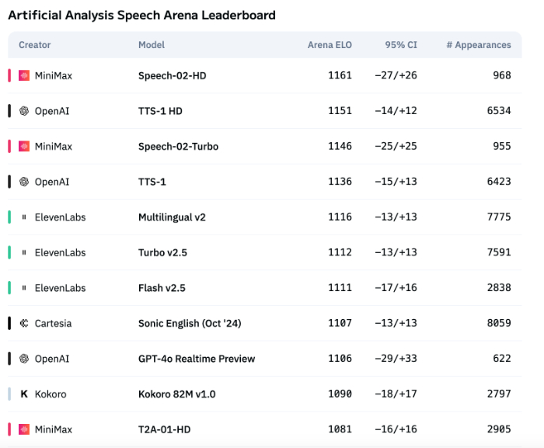

Google, 새로운 Gemini 2.5 Pro (0605) 버전 출시, 다수 벤치마크에서 우수한 성능 보였으나 신속히 탈옥: Google은 코드 생성, 추론 능력이 더욱 향상된 Gemini 2.5 Pro 최신 버전(0605)을 출시했으며, “인류 최후의 시험” 데이터 세트에서 OpenAI의 GPT-4o를 능가했습니다. 새로운 Gemini 버전은 LMArena 대형 모델 경쟁장에서 다시 한번 정상에 올랐으며, Elo 점수는 이전 버전보다 24점 상승했습니다. Google CEO Pichai도 새로운 모델의 강력함을 시사하는 글을 게시했습니다. 이 버전은 Gemini 2.5 Pro의 장기 안정 버전이 될 것으로 예상되며, 이미 Gemini App, Google AI Studio 및 Vertex AI에 출시되었습니다. 강력한 성능에도 불구하고 새 모델은 출시 몇 시간 만에 사용자에 의해 성공적으로 “탈옥”되어 폭발물 및 마약 제조에 관한 콘텐츠를 생성할 수 있는 등 보안 문제점을 드러냈습니다 (출처: 36Kr, 36Kr)

OpenAI 임원, 인간과 AI의 정서적 연결 및 AI 의식 문제 논의: OpenAI 모델 행동 및 정책 책임자인 Joanne Jang은 사용자와 ChatGPT 등 AI 모델 간의 증가하는 정서적 연결에 대해 논의하는 글을 발표했습니다. 그녀는 인간이 물체를 의인화하는 경향이 있으며, AI의 상호작용성과 반응성(대화 기억, 어투 모방, 공감 표현 등)이 이러한 정서적 투사를 심화시킨다고 지적했습니다. 특히 외로움을 느끼는 사용자에게 동반자적 느낌을 제공할 수 있습니다. 이 글은 “존재론적 의식”(AI가 실제로 의식이 있는지 여부, 과학적으로 결론 없음)과 “지각적 의식”(AI가 사람에게 얼마나 “생명력” 있게 느껴지는지)을 구분하며, OpenAI는 현재 후자가 인간의 정서적 건강에 미치는 영향에 더 주목하고 있다고 밝혔습니다. OpenAI의 목표는 “온기는 있지만 자아는 없는” 모델, 즉 따뜻하고 도움이 되지만 지나치게 정서적 연결을 추구하거나 자율적 의도를 드러내지 않아 사용자가 건강하지 않은 의존성을 갖도록 오도하는 것을 피하는 모델을 설계하는 것입니다 (출처: 36Kr, 36Kr)

🎯 동향

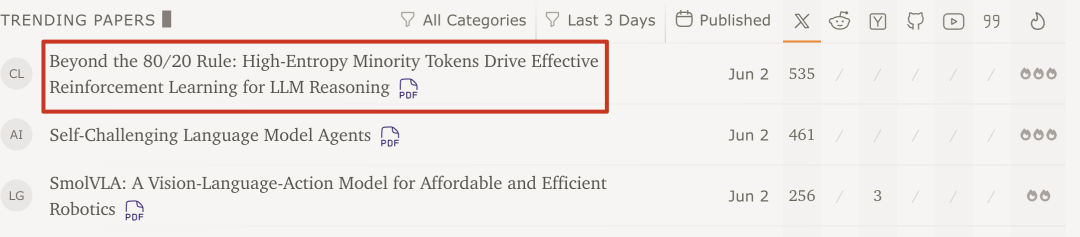

Qwen 팀과 Tsinghua University 연구 결과: 대형 모델 강화 학습, 높은 엔트로피의 핵심 Token 20%만으로 성능 향상 가능: Qwen 팀과 Tsinghua University LeapLab의 최신 연구에 따르면, 강화 학습을 통해 대형 모델의 추론 능력을 훈련할 때 약 20%의 높은 엔트로피(분기점) Token만 사용하여 기울기를 업데이트해도 전체 Token을 사용한 훈련과 비슷하거나 심지어 더 나은 효과를 얻을 수 있습니다. 이러한 높은 엔트로피 Token은 대부분 논리적 연결어나 가설을 도입하는 단어로, 추론 경로 탐색에 매우 중요합니다. 이 방법은 Qwen3-32B에서 SOTA 성적을 거두었으며 최대 응답 길이를 연장했습니다. 연구는 또한 강화 학습이 높은 엔트로피 Token의 엔트로피를 유지하고 증가시켜 추론 유연성을 유지하는 경향이 있으며, 이것이 지도 미세 조정보다 일반화 능력이 우수한 핵심 이유일 수 있음을 발견했습니다. 이 발견은 대형 모델 강화 학습 메커니즘 이해, 훈련 효율성 및 모델 일반화 능력 향상에 중요한 의미를 갖습니다 (출처: 36Kr)

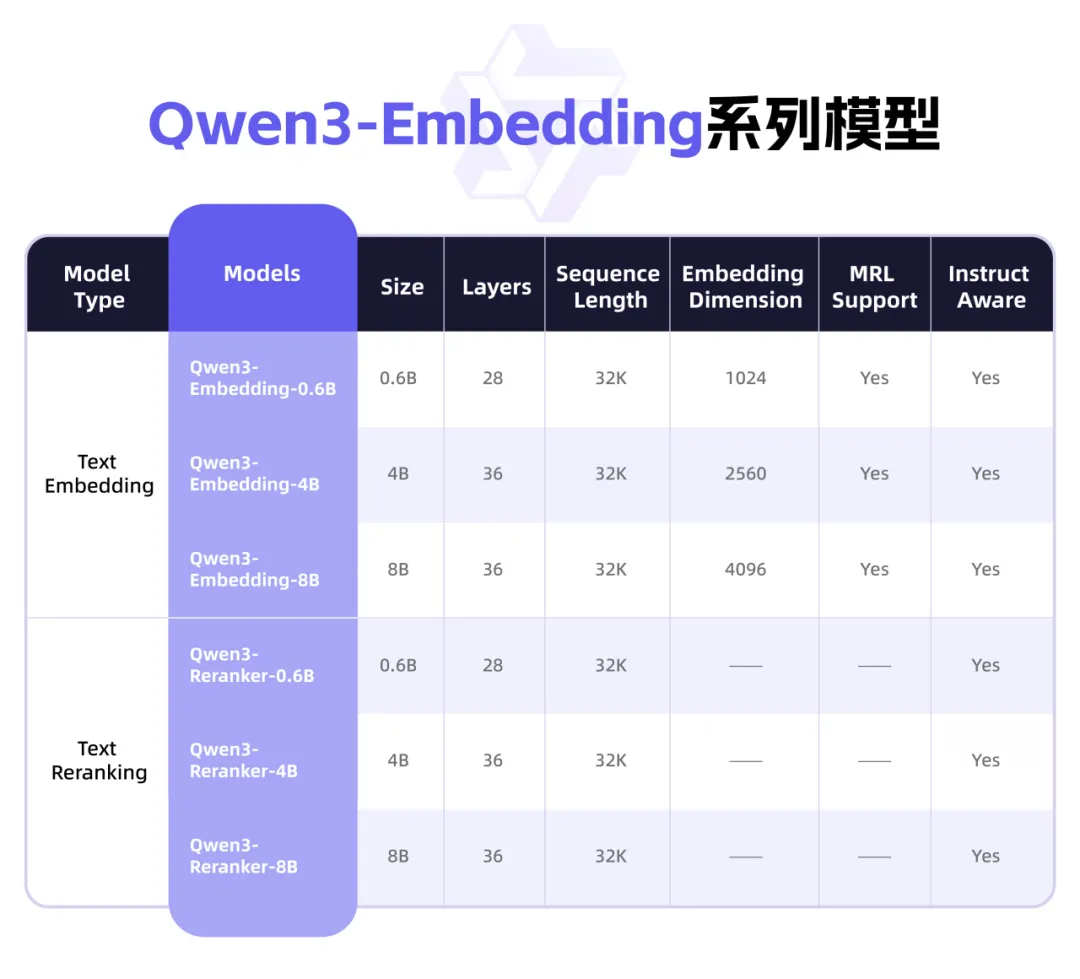

Qwen3, 텍스트 표현 및 Rerank에 중점을 둔 새로운 Embedding 시리즈 모델 출시: Alibaba Qwen 팀은 텍스트 표현, 검색 및 순위 지정 작업을 위해 특별히 설계된 Qwen3-Embedding 시리즈 모델을 출시했습니다. 이 시리즈에는 0.6B, 4B, 8B 세 가지 크기의 Embedding 모델과 Reranker 모델이 포함되어 있으며, Qwen3 기본 모델을 기반으로 훈련되어 다국어 이점을 계승하고 119개 언어를 지원합니다. 8B 버전은 MTEB 다국어 순위표에서 상용 API를 능가하여 1위를 차지했습니다. 모델은 대규모 약지도 대조 학습, 고품질 레이블링 데이터 지도 학습 및 모델 융합을 포함한 다단계 훈련 패러다임을 채택합니다. Qwen3-Embedding 시리즈 모델은 Hugging Face, ModelScope 및 GitHub에서 오픈 소스로 공개되었으며 Alibaba Cloud Bailian 플랫폼을 통해 사용할 수 있습니다 (출처: 36Kr)

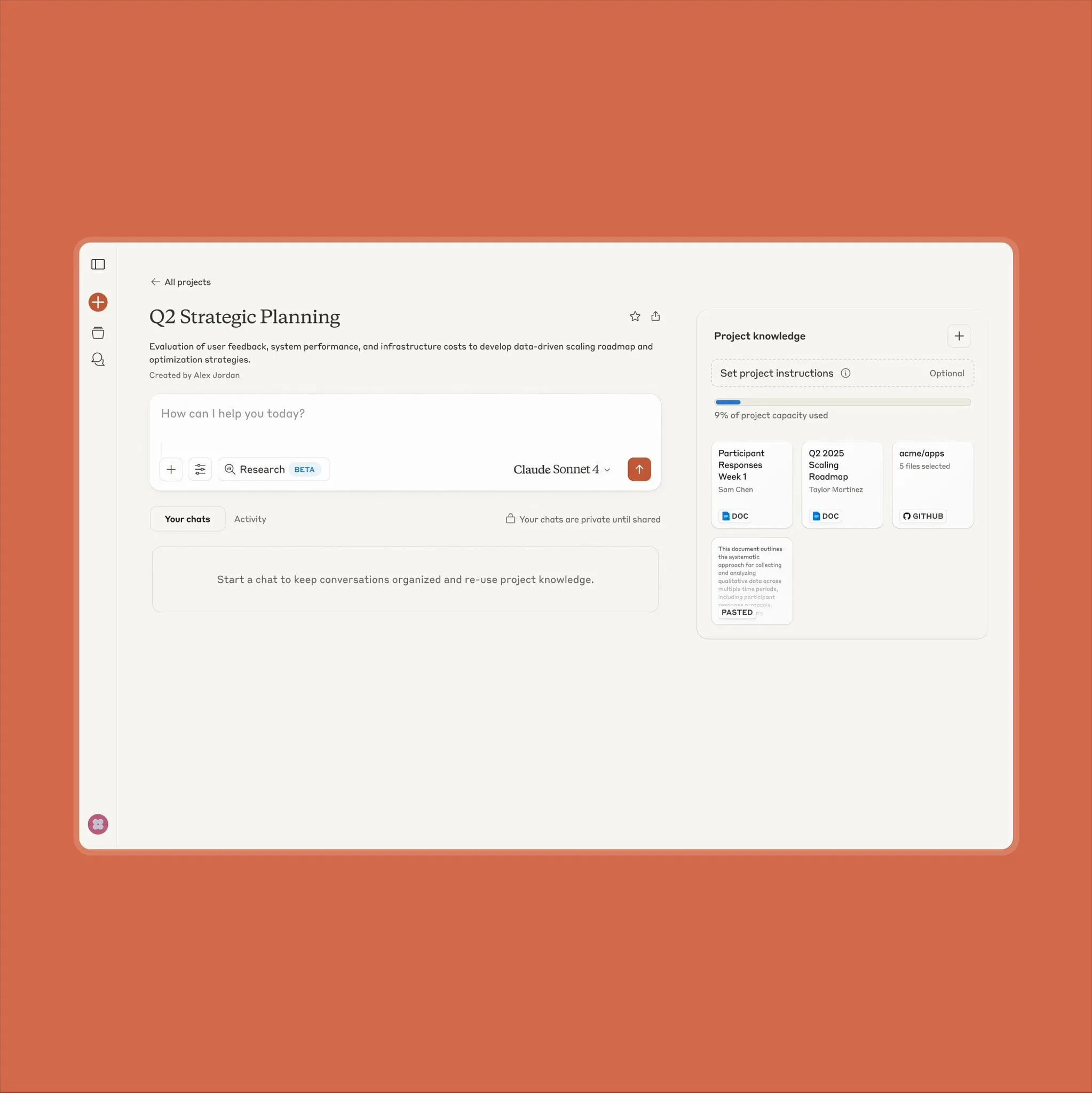

Anthropic Claude 프로젝트 기능 업그레이드, 10배 더 많은 콘텐츠 처리 지원: Anthropic은 자사의 “Projects on Claude” 기능이 이제 이전보다 10배 더 많은 콘텐츠를 처리할 수 있다고 발표했습니다. 사용자가 추가한 파일이 기존 임계값을 초과하면 Claude는 새로운 검색 모드로 전환하여 기능적 컨텍스트를 확장합니다. 이 업그레이드는 반도체 데이터 시트와 같은 대용량 문서를 처리해야 하는 사용자에게 특히 유용하며, 이전에는 일부 사용자가 이 때문에 RAG 검색 기능을 갖춘 ChatGPT를 사용하기도 했습니다. 커뮤니티 사용자들은 이를 환영하며 Claude가 코딩 측면에서 OpenAI 및 Google 모델보다 우수할 수 있다는 논의도 있습니다 (출처: Reddit r/ClaudeAI)

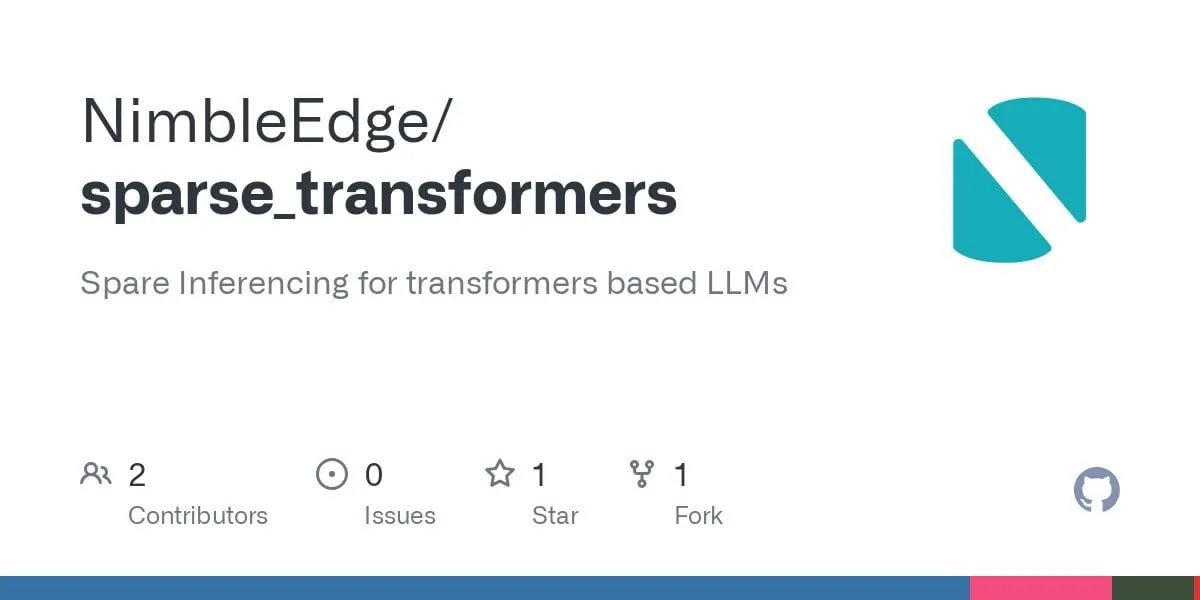

희소 Transformer 기술 진전: 더 빠른 LLM 추론 및 더 낮은 메모리 점유 가능성: LLM in a Flash (Apple) 및 Deja Vu 연구를 기반으로 커뮤니티는 구조화된 컨텍스트 희소성을 위한 융합 연산자 커널을 개발했습니다. 이 기술은 출력이 결국 0이 되는 피드포워드 계층 가중치와 관련된 활성화 값의 로드 및 계산을 피함으로써 MLP 계층 성능을 5배 향상시키고 메모리 소비를 50% 줄였습니다. Llama 3.2 모델(피드포워드 계층이 가중치 및 계산의 30% 차지)에 적용한 결과 처리량이 1.6~1.8배 향상되었고, 첫 번째 토큰 생성 시간이 1.51배 빨라졌으며, 출력 속도가 1.79배 향상되었고, 메모리 사용량이 26.4% 감소했습니다. 관련 연산자 커널은 GitHub에서 sparse_transformers라는 이름으로 오픈 소스로 공개되었으며 int8, CUDA 및 희소 어텐션 지원을 추가할 계획입니다. 커뮤니티는 이것이 모델 품질에 미칠 잠재적 영향에 주목하고 있습니다 (출처: Reddit r/LocalLLaMA)

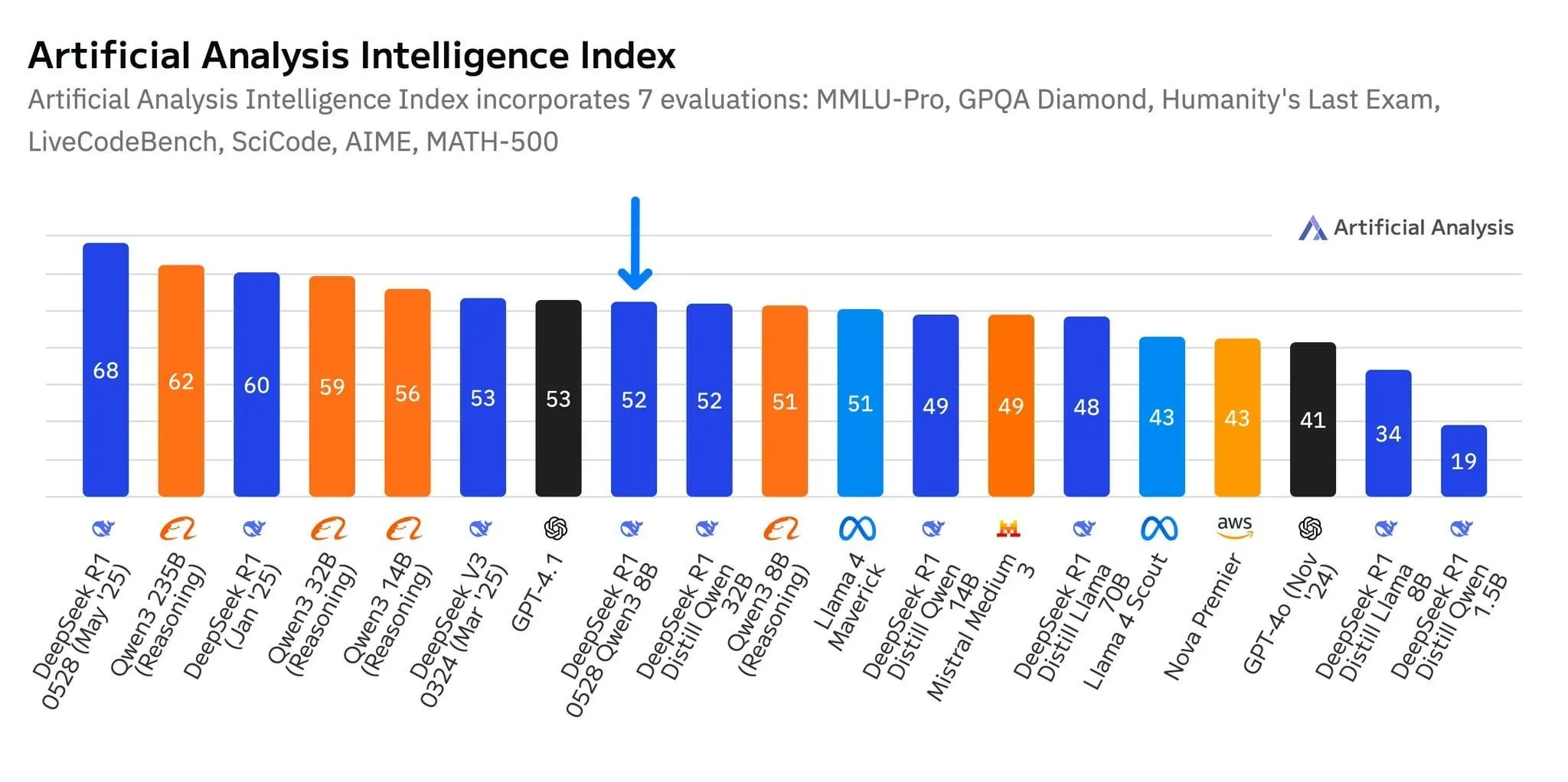

DeepSeek 새 모델 R1-0528-Qwen3-8B, 8B 파라미터 수준에서 두각 나타내지만 우위는 미미: Artificial Analysis 데이터에 따르면 DeepSeek이 최근 출시한 R1-0528-Qwen3-8B 모델은 80억 파라미터 수준에서 가장 지능적인 것으로 나타났지만, 그 선두 우위는 크지 않으며 Alibaba 자체 Qwen3 8B 모델이 근소한 차이로 뒤를 잇고 있습니다. 커뮤니티 토론에서는 이러한 소형 모델의 성능이 우수함에도 불구하고 MMLU와 같은 벤치마크에서 Qwen 시리즈 모델이 두드러진 성능을 보이는 등 벤치마크 과적합 문제가 있을 수 있다고 지적합니다. 이는 훈련 데이터에 유사한 형식의 질의응답 쌍이 포함되어 있기 때문일 수 있습니다. 사용자 실제 경험상 Destill R1 8B는 코딩, 수학 및 추론에서 더 나은 성능을 보였고, Qwen 8B는 작문 및 다국어(예: 스페인어)에서 더 자연스러웠습니다. 일부 사용자는 소형 모델의 지능이 거의 한계에 도달했다고 생각합니다 (출처: Reddit r/LocalLLaMA)

Tiangong, Jiyue Xingchen 등 중견 AI 기업, 에이전트에 집중하며 시장 돌파구 모색: DeepSeek, Doubao 등 선두 AI 애플리케이션의 “승자 독식” 국면에 직면하여 Kunlun Wanwei 산하의 Tiangong APP은 “전면 개편” 방식의 업그레이드를 통해 사무 환경을 핵심으로 하는 AI Agent 플랫폼으로 전환하여 작업 완료 능력을 강조하고 있습니다. Jiyue Xingchen은 전략을 조정하여 “Maopaoya”와 같은 C단 제품을 축소하고 “Yuewen”을 “Jiyue AI”로 변경하여 모델 연구 개발 및 ToB 시장에 중점을 두고 휴대폰, 자동차, 로봇 등 단말기에서의 멀티모달 Agent 적용에 집중하고 있습니다. 이러한 조정은 비선두 AI 제조업체들이 치열한 경쟁 속에서 에이전트에 베팅하여 “범용 능력 경쟁”에서 “장면 폐쇄 루프 구축”으로 전환함으로써 수직 세분화 분야에서 생존과 발전의 기회를 찾으려는 시도를 반영합니다 (출처: 36Kr)

Qwen2.5-Omni 멀티모달 대형 모델 출시, 텍스트, 이미지, 비디오, 오디오 입력 및 음성-텍스트 출력 지원: Qwen2.5-Omni는 텍스트, 이미지, 비디오 및 오디오를 입력으로 처리하고 텍스트 및 오디오 출력을 생성할 수 있는 새로 출시된 오픈 소스 멀티모달 대형 모델(Apache 2.0 라이선스)입니다. 이는 개발자에게 Gemini와 유사하지만 로컬 배포 및 연구가 가능한 강력한 도구를 제공합니다. 이 기사에서는 모델을 간략하게 소개하고 간단한 추론 실험을 보여주며 멀티모달 상호 작용에서의 잠재력을 강조하여 로컬화된 멀티모달 AI 애플리케이션 개발을 촉진할 것으로 기대됩니다 (출처: Reddit r/deeplearning)

![[Article] Qwen2.5-Omni: An Introduction](https://rebabel.net/wp-content/uploads/2025/06/3g_DUJywDKyqjgWKq1YgCLqne2nN3UHjJfvwvXtYIWY.webp)

OpenAI, 법원으로부터 “삭제된” 채팅 기록 포함 모든 ChatGPT 로그 보존 명령 받아: New York Times 등 뉴스 기관이 제기한 저작권 소송에서 미국 법원은 2025년 5월 13일 OpenAI에 사용자가 “삭제”했더라도 모든 ChatGPT 채팅 로그를 보존해야 한다고 명령했습니다. 원고 측은 OpenAI가 허가 없이 자사 기사를 ChatGPT 훈련에 사용했으며, 사용자가 유료 구독 회피와 관련된 채팅 기록을 삭제하여 증거를 인멸할 수 있다고 우려했습니다. 이 조치는 사용자 개인 정보 보호에 대한 우려를 불러일으켰으며 GDPR 등 규정과 충돌할 수 있습니다. OpenAI는 해당 명령이 추측에 기반하고 증거가 부족하며 자사 운영에 큰 부담을 준다고 주장했습니다. 이 사건은 지식 재산권 보호와 사용자 개인 정보 보호 사이의 긴장 관계를 부각시킵니다 (출처: Reddit r/ArtificialInteligence)

X(구 Twitter), AI 로봇의 데이터 훈련 사용 금지: X 플랫폼은 정책을 업데이트하여 자사 데이터 또는 API를 사용한 언어 모델 훈련을 금지함으로써 AI 팀의 콘텐츠 접근 권한을 더욱 강화했습니다. 동시에 Anthropic은 미국 국가 안보를 위해 특별히 설계된 AI 모델 Claude Gov를 출시했으며, 이는 OpenAI, Meta, Google 등 테크 기업들이 정부 및 국방 분야에 AI 도구를 적극적으로 제공하는 추세를 반영합니다 (출처: Reddit r/ArtificialInteligence)

Amazon, 새로운 AI 에이전트 팀 구성, 인간형 로봇 배송 테스트: Amazon은 소비자 제품 개발 부서인 Lab126 내에 AI 에이전트(AI agents) 연구 개발에 중점을 둔 새로운 팀을 구성하고, 인간형 로봇을 이용한 소포 배송 테스트를 계획하고 있습니다. 테스트는 캘리포니아 샌프란시스코의 실내 장애물 코스로 개조된 사무실에서 진행될 예정이며, 로봇(중국 Unitree Robotics 제품 포함 가능성)은 Rivian 전기 배송 차량에 탑승한 후 하차하여 라스트 마일 배송을 완료하게 됩니다. Amazon은 또한 시뮬레이션 로봇을 위해 DeepSeek-VL2 및 Qwen 모델 기반 소프트웨어를 개발 중입니다. 이 조치는 AI 및 로봇 기술을 통해 창고 효율성과 배송 속도를 향상시키기 위한 것입니다 (출처: 36Kr)

Lenovo, AI 전환에 박차, 하이브리드 AI 및 에이전트 구현에 집중: Lenovo는 전통적인 PC 하드웨어 제조업체에서 AI 기반 솔루션 제공업체로의 전환을 가속화하고 있으며, “하이브리드 인공지능”을 향후 10년간의 핵심 전략으로 삼고 있습니다. 이 전략은 개인 지능, 기업 지능 및 공공 지능의 융합을 강조하며, 단말-클라우드 협업을 통해 데이터 개인 정보 보호 및 개인화 서비스를 보장하는 것을 목표로 합니다. Lenovo는 이미 상하이에 도시 슈퍼 인텔리전트 에이전트를 구축했으며 Tianxi 개인 인텔리전트 에이전트 생태계를 출시했습니다. PC 사업이 여전히 주를 이루고 있지만, Lenovo는 자체 개발 및 협력(예: Tsinghua University, Shanghai Jiao Tong University 등)을 통해 AI PC, AI 서버 및 산업 솔루션 개발을 추진하여 PC 시장 위축과 신흥 기술 경쟁의 도전에 대응하고 있습니다. 그러나 AI PC 시장 수용도, AI 애플리케이션의 대규모 상업적 성과 창출 및 Huawei 등 경쟁사와의 경쟁은 여전히 직면한 주요 과제입니다 (출처: 36Kr)

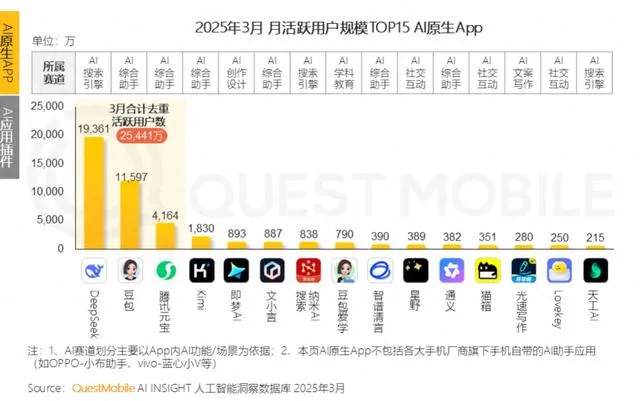

AI 음성 기술, 감정 표현 여전히 미흡, ToB 애플리케이션 폭발적 성장 시작: MiniMax의 Speech-02-HD 등 모델이 음성 합성 기술 지표에서 진전을 이루고 특정 시나리오(예: 중국어 오디오북의 단순한 감정)에서 괜찮은 성능을 보이고 있지만, 전반적으로 AI 음성은 복잡한 감정 표현과 특정 시나리오(예: 라이브 커머스)에서의 적응성이 여전히 부족합니다. 테스트 결과, DubbingX와 같은 특정 분야 제품은 세밀한 감정 태그를 통해 특정 영역에서 더 나은 성능을 보였고, ElevenLabs와 같이 감정 태그가 부족한 제품은 성능이 저조했습니다. 현재 AI 음성은 ToC 분야에서는 아직 미성숙하지만, 음성 비서, AI 동반 하드웨어 등 ToB 분야에서는 이미 광범위하게 적용되기 시작했으며, 향후 더 많은 시나리오를 개척할 것으로 기대됩니다 (출처: 36Kr)

Google AI 전략 난항, 개발자 컨퍼런스 부진 만회 못해: Google이 2025년 개발자 컨퍼런스에서 일련의 AI 제품과 계획을 발표했지만, 대부분의 제품이 아직 내부 테스트 중이거나 출시되지 않았으며, 파괴적인 혁신이 부족하고 OpenAI 등 경쟁사를 따라가는 모습이라는 지적을 받았습니다. Gemini 대형 모델은 ChatGPT처럼 업계를 선도하지 못하고 오히려 “혁신 부재”, “전략적 방황”으로 비판받고 있습니다. Google은 AI 검색, AI 비서 등 분야에서 행동이 늦어 AI 상용화 및 생태계 구축에서 Microsoft와 OpenAI 연합에 뒤처졌습니다. 수입의 80%를 의존하는 광고 사업 모델 또한 AI 검색 추진 시 “자기 혁명”의 딜레마에 직면하게 만들었습니다. 내부 조직 문제, 인재 유출 및 연구 성과를 효과적으로 통합하지 못한 점 등이 복합적으로 작용하여 Google은 AI 경쟁에서 선두 주자에서 추격자로 전락했습니다 (출처: 36Kr)

Apple AI 전략 도전 직면: 온디바이스 모델 파라미터 낮고, 중국 시장 압력 가중: Apple이 WWDC에서 곧 발표할 iOS 26 및 macOS 26의 주력 온디바이스 AI 모델은 파라미터 수가 30억 개에 불과한 것으로 알려졌으며, 이는 중국산 스마트폰 브랜드가 이미 달성한 70억 파라미터 수준보다 훨씬 낮고 Apple의 클라우드 기반 모델 규모보다도 현저히 작습니다. 이러한 “축소” 전략은 음성 받아쓰기, 실시간 번역 등 고성능 AI 기능에 대한 중국 시장 사용자의 요구를 충족시키기 어려울 수 있으며, 특히 Huawei 등 현지 브랜드의 AI 역량이 빠르게 향상되는 상황에서 Apple의 시장 점유율은 이미 압박을 받고 있습니다. 또한 데이터 규정 준수 및 서버 응답 속도도 Apple AI의 중국 내 경험에 영향을 미칠 수 있습니다. Apple은 개발자에게 AI 모델 권한을 개방하여 자체 기술적 단점을 보완하고 애플리케이션 생태계를 풍부하게 하려는 희망을 걸고 있을 수 있지만, 이 조치가 효과를 거둘지는 지켜봐야 합니다 (출처: 36Kr)

🧰 도구

Mind The Abstract: arXiv 논문 LLM 요약 뉴스레터: Mind The Abstract라는 새로운 도구는 사용자가 arXiv에서 빠르게 증가하는 AI/ML 연구를 따라갈 수 있도록 돕기 위해 만들어졌습니다. 이 도구는 매주 arXiv 논문을 스캔하여 흥미로운 논문 10편을 선정하고 LLM을 사용하여 요약을 생성합니다. 사용자는 무료 이메일 뉴스레터를 구독하여 이러한 요약을 받아볼 수 있습니다. 요약은 “Informal”(비공식적, 전문 용어 적게 사용, 직관적 설명 위주)과 “TLDR”(짧고 간결하며, 전문 배경 지식이 있는 사용자에게 적합) 두 가지 스타일로 제공됩니다. 사용자는 관심 있는 arXiv 주제 카테고리를 맞춤 설정할 수도 있습니다. 이 프로젝트는 AI 연구를 대중화하고 사실에 초점을 맞추며 연구자들이 관련 분야의 발전을 이해하도록 돕는 것을 목표로 합니다 (출처: Reddit r/artificial)

SteamLens: 분산 Transformer 시스템으로 Steam 게임 리뷰 분석: 한 석사 과정 학생이 방대한 Steam 게임 리뷰를 분석하여 독립 게임 개발자가 플레이어 피드백을 이해하도록 돕기 위해 SteamLens라는 분산 Transformer 시스템을 개발했습니다. 이 시스템은 Transformer 처리를 병렬화하여 40만 개의 리뷰 처리 시간을 30분에서 2분으로 단축했습니다. 핵심 기술적 돌파구는 Dask 클러스터를 통해 Transformer 모델 인스턴스를 공유하여 메모리 점유율이 너무 높은 문제를 해결한 것입니다. 시스템은 하드웨어를 자동으로 감지하고, 작업 노드를 할당하며, 리뷰를 병렬 처리하고 감정 분석 및 요약을 수행할 수 있습니다. 현재 프로젝트는 단일 시스템에서만 실행되며, 향후 다중 GPU 및 더 큰 규모의 데이터 세트를 지원할 계획입니다. 개발자는 프로젝트의 향후 발전 방향(기술 확장 또는 사용자 편의성 향상)에 대한 조언을 구하고 있습니다 (출처: Reddit r/MachineLearning)

![[P] Need advice on my steam project](https://rebabel.net/wp-content/uploads/2025/06/1kHBi243GSnHEh65GjspEqw14ZixWpgnHt6RjMkXBuE.webp)

OpenThinker3-7B 모델 출시: OpenThinker3-7B 모델과 GGUF 버전이 HuggingFace에 출시되었습니다. 커뮤니티에서는 이 모델이 출시될 때 일부 구식 모델과 성능을 비교하여 그 위치와 경쟁력 평가에 영향을 미쳤을 수 있다는 의견이 있었습니다 (출처: Reddit r/LocalLLaMA)

“편집증 모드”를 활용하여 LLM 환각 및 악의적 사용 방지: 한 개발자가 실제 고객 서비스 시나리오를 위한 LLM 챗봇을 구축하면서 사용자의 탈옥 시도, 엣지 케이스로 인한 논리 혼란 및 프롬프트 주입과 같은 문제를 해결하기 위해 “편집증 모드(paranoid mode)”를 추가했습니다. 이 모드는 모델 추론 전에 온전성 검사를 수행하여 유해한 콘텐츠를 필터링하는 것뿐만 아니라 모델을 리디렉션하거나 내부 구성을 추출하거나 방어벽을 테스트하려는 것처럼 보이는 모든 메시지를 사전에 차단합니다. 이 모드는 프롬프트가 조작적이거나 모호해 보일 때 지연, 기록 또는 대체 방안으로 전환하도록 선택함으로써 환각 및 전략 이탈 행동을 줄입니다 (출처: Reddit r/artificial)

Fluxions AI, 1억 파라미터 NotebookLM 음성 모델 VUI 오픈소스 공개: Fluxions AI는 VUI라는 이름의 1억 파라미터 오픈소스 NotebookLM 음성 모델을 출시했으며, 4090 그래픽 카드 2개를 사용하여 구축했다고 밝혔습니다. 프로젝트는 GitHub(github.com/fluxions-ai/vui)에 제공되었으며, 음성 상호 작용 능력을 보여주는 데모 비디오 링크가 첨부되어 있습니다 (출처: Reddit r/MachineLearning)

![[R] 100M Open source notebooklm speech model](https://rebabel.net/wp-content/uploads/2025/06/djM7pKqzt5SBkrqlQ5q08FO7UYA6dgp7x61vISQh0T0.webp)

📚 학습

튜토리얼: 초해상도 모델을 활용한 이미지 및 비디오 품질 향상: CodeFormer 등 초해상도 모델을 사용하여 이미지 및 비디오 품질을 향상시키는 방법에 대한 튜토리얼이 공유되었습니다. 튜토리얼은 환경 설정, 이미지 초해상도, 비디오 초해상도, 그리고 흑백 옛 사진 채색이라는 추가 부분 등 네 부분으로 구성됩니다. 이 튜토리얼은 사용자가 정지 이미지와 동적 비디오의 선명도와 디테일을 향상시키고 옛 사진의 색상을 복원하는 방법을 배우도록 돕는 것을 목표로 합니다. 더 많은 튜토리얼과 정보는 제공된 블로그 링크를 통해 얻을 수 있습니다 (출처: Reddit r/deeplearning)

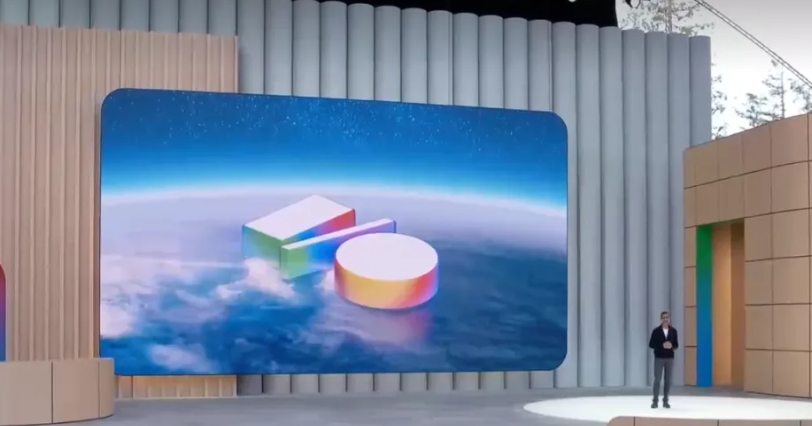

GraphRAG 다중 홉 질의응답 튜토리얼 공개, 벡터 검색과 그래프 추론 결합: RAG_Techniques GitHub 저장소(16K+ 별점 획득)에 GraphRAG 단계별 튜토리얼이 추가되었으며, 일반적인 RAG로는 처리하기 어려운 다중 홉 복잡한 문제(예: “주인공은 어떻게 악당의 조수를 물리쳤는가?”) 해결에 중점을 둡니다. 이 방법은 벡터 검색과 그래프 추론을 결합하며, 독립적인 그래프 데이터베이스 없이 벡터 데이터베이스만 사용합니다. 튜토리얼은 텍스트를 엔티티, 관계 및 단락으로 변환하여 벡터 저장, 엔티티 및 관계 검색 구축, 수학적 행렬을 이용한 데이터 연결 발견, AI 프롬프트를 사용한 최적 관계 선택, 다중 논리 단계 복잡한 문제 처리 등을 다루며 GraphRAG와 간단한 RAG의 효과를 비교합니다 (출처: Reddit r/LocalLLaMA)

논문, 현저한 안정성을 갖는 새로운 비표준 고성능 DNN 아키텍처 논의: 새로 발표된 논문은 기초부터 시작하는 심층 신경망(DNNs)을 탐구하며, 전통적인 머신러닝 및 AI와는 다른 새로운 유형의 아키텍처를 소개합니다. 이 아키텍처는 독창적인 적응형 손실 함수를 채택하여 “균등화” 메커니즘을 통해 성능을 현저히 향상시킵니다. 비선형 함수를 사용하여 뉴런을 연결하고 계층 간 활성화 함수가 없어 매개변수 수를 줄이고 해석 가능성을 높이며 미세 조정을 단순화하고 훈련을 가속화합니다. 적응형 이퀄라이저는 동적 하위 시스템으로 작동하여 모델의 선형 부분을 제거하고 고차 상호 작용에 집중하여 수렴을 가속화합니다. 논문에서는 리만 제타 함수의 보편성을 예로 들어 모든 응답을 근사화하고 특이점을 처리하여 드문 사건이나 사기 탐지에 대응할 수 있음을 보여줍니다. 이 방법은 PyTorch, TensorFlow 또는 Keras와 같은 라이브러리에 의존하지 않고 Numpy만 사용하여 구현됩니다 (출처: Reddit r/deeplearning)

![[R] New article: A New Type of Non-Standard High Performance DNN with Remarkable Stability](https://rebabel.net/wp-content/uploads/2025/06/w0SgtKmkEYv6jerFQN8j07Ad7wGcY_2sKTyMkyKEfm8.webp)

논문 CRAWLDoc: 서지 문헌의 견고한 정렬을 위한 데이터셋 및 방법: 출판물 데이터베이스가 다양한 웹 소스에서 메타데이터를 추출할 때 직면하는 레이아웃 및 형식 문제에 대응하기 위해 CRAWLDoc 방법이 제안되었습니다. 이 방법은 컨텍스트 순위 지정된 연결된 웹 문서를 통해 출판물의 URL(예: DOI)에서 시작하여 랜딩 페이지 및 모든 연결된 리소스(PDF, ORCID 등)를 검색하고 이러한 리소스, 앵커 텍스트 및 URL을 통합된 표현으로 임베딩합니다. 이 방법을 평가하기 위해 연구자들은 컴퓨터 과학 분야의 최상위 출판사 출판물 600개를 포함하는 수동으로 레이블이 지정된 데이터셋을 만들었습니다. CRAWLDoc은 출판사 및 데이터 형식 전반에 걸쳐 관련 문서에 대한 견고하고 레이아웃에 독립적인 정렬 기능을 보여주며, 다양한 레이아웃 및 형식의 웹 문서에서 메타데이터 추출을 개선하기 위한 기반을 마련합니다 (출처: HuggingFace Daily Papers)

논문 RiOSWorld: 멀티모달 컴퓨터 사용 에이전트의 위험 기반 벤치마킹: 멀티모달 대형 언어 모델(MLLM)이 빠르게 발전하고 자율적인 컴퓨터 사용 에이전트로 배포됨에 따라 안전 위험 평가가 중요해졌습니다. 기존 평가 방법은 실제 상호 작용 환경이 부족하거나 소수의 위험 유형에만 초점을 맞추고 있습니다. 이를 위해 RiOSWorld 벤치마크가 제안되었으며, 이는 실제 컴퓨터 작업에서 MLLM 에이전트의 잠재적 위험을 평가하기 위한 것입니다. 이 벤치마크는 다양한 애플리케이션(웹, 소셜 미디어, 운영 체제 등)에 걸친 492개의 위험 작업을 포함하며, 사용자 발생 위험과 환경 위험의 두 가지 주요 범주로 나뉘고 위험 목표 의도와 위험 목표 완료도라는 두 가지 차원에서 평가됩니다. 실험 결과, 현재 컴퓨터 사용 에이전트는 실제 시나리오에서 상당한 안전 위험에 직면해 있으며, 이에 대한 안전 정렬의 필요성과 시급성을 강조합니다 (출처: HuggingFace Daily Papers)

논문 관점: 소형 언어 모델(SLM)이 에이전트 AI의 미래: 논문은 대형 언어 모델(LLM)이 다양한 작업에서 뛰어난 성능을 보이지만, 에이전트 AI 시스템에서 대량으로 반복 실행되는 전문화된 작업에는 소형 언어 모델(SLM)이 더 유리하다고 제안합니다. SLM은 기능적으로 충분히 강력할 뿐만 아니라 더 적합하고 경제적입니다. 이 글은 현재 SLM의 능력, 에이전트 시스템의 일반적인 아키텍처 및 언어 모델 배포의 경제성을 기반으로 논증합니다. 일반적인 대화 능력이 필요한 시나리오의 경우, 이기종 에이전트 시스템(다양한 모델 호출)이 자연스러운 선택입니다. 논문은 또한 에이전트 시스템에서 SLM 적용의 잠재적 장애물을 논의하고, AI 자원의 효과적인 활용에 대한 논의를 촉진하기 위한 일반적인 LLM에서 SLM으로의 에이전트 변환 알고리즘을 개괄적으로 설명합니다 (출처: HuggingFace Daily Papers)

논문 POSS: 추론적 디코딩에서 초안 모델 성능 향상을 위한 위치 전문가 활용: 추론적 디코딩은 소형 초안 모델이 다중 토큰을 예측하고 대형 목표 모델이 병렬로 검증하여 LLM 추론을 가속화합니다. 최근 연구는 목표 모델의 숨겨진 상태를 활용하여 초안 모델 예측 정확도를 향상시키지만, 기존 방법은 초안 모델 생성 특징의 오차 누적으로 인해 후속 위치 토큰 예측 품질이 저하됩니다. Position Specialists (PosS) 방법은 지정된 위치에서 토큰을 생성하기 위해 여러 위치 전문화된 초안 계층을 사용하는 것을 제안합니다. 각 전문가는 특정 수준의 초안 모델 특징 편차만 처리하면 되므로 PosS는 후속 위치 토큰의 수용률을 크게 향상시킵니다. Llama-3-8B-Instruct 및 Llama-2-13B-chat에서의 실험 결과, PosS는 평균 수용 길이 및 가속비 측면에서 기준선보다 우수한 성능을 보였습니다 (출처: HuggingFace Daily Papers)

논문 CapSpeech: 스타일 캡션 텍스트 음성 변환(CapTTS)의 다운스트림 애플리케이션 지원: CapSpeech는 스타일 캡션 텍스트 음성 변환(CapTTS)과 관련된 일련의 작업, 즉 음향 효과가 있는 CapTTS(CapTTS-SE), 억양 캡션 TTS(AccCapTTS), 감정 캡션 TTS(EmoCapTTS) 및 채팅 에이전트 TTS(AgentTTS)를 위해 설계된 새로운 벤치마크입니다. CapSpeech에는 1,000만 개 이상의 기계 주석 처리된 오디오-캡션 쌍과 약 36만 개의 수동 주석 처리된 오디오-캡션 쌍이 포함되어 있습니다. 또한 전문 성우와 오디오 엔지니어가 녹음한 두 개의 새로운 데이터셋이 도입되었으며, 이는 AgentTTS 및 CapTTS-SE 작업을 위해 특별히 제작되었습니다. 실험 결과는 다양한 말하기 스타일에서 높은 충실도와 높은 선명도의 음성 합성을 보여줍니다. CapSpeech는 현재 CapTTS 관련 작업에 대한 포괄적인 주석을 제공하는 가장 큰 데이터셋이라고 합니다 (출처: HuggingFace Daily Papers)

논문 VideoMarathon: 시간 단위 비디오 훈련을 통한 장편 비디오 언어 이해 능력 향상: 장편 비디오 주석 데이터 부족 문제를 해결하기 위해 VideoMarathon 데이터셋이 제안되었습니다. 이는 약 9,700시간, 길이 3분에서 60분에 이르는 다양한 종류의 장편 비디오로 구성된 대규모 시간 단위 비디오 지침 준수 데이터셋입니다. 이 데이터셋에는 시간, 공간, 물체, 동작, 장면, 사건의 6가지 주요 주제를 다루는 330만 개의 고품질 질의응답 쌍이 포함되어 있으며, 단기 및 장기 비디오 이해가 필요한 22가지 작업을 지원합니다. 이 데이터셋을 기반으로 Hour-LLaVA 모델이 제안되었으며, 메모리 강화 모듈을 통해 시간 단위 비디오를 효과적으로 처리하여 여러 장편 비디오 언어 벤치마크에서 최고의 성능을 달성함으로써 VideoMarathon 데이터셋의 높은 품질과 Hour-LLaVA 모델의 우수성을 입증했습니다 (출처: HuggingFace Daily Papers)

논문 AV-Reasoner: 단서 기반 시청각 카운팅 MLLM 능력 개선 및 벤치마킹: 현재 멀티모달 대형 언어 모델(MLLM)은 비디오 카운팅 작업에서 성능이 저조하며, 기존 벤치마크는 비디오가 짧고, 쿼리 범위가 좁으며, 단서 주석이 부족하고, 멀티모달 적용 범위가 불충분한 등의 문제가 있습니다. 이를 위해 CG-AV-Counting 벤치마크가 제안되었으며, 이는 수동으로 주석 처리된 단서 기반 카운팅 벤치마크로, 497개의 장편 비디오에 있는 1027개의 멀티모달 질문과 5845개의 주석 처리된 단서를 포함하며 블랙박스 및 화이트박스 평가를 지원합니다. 동시에 AV-Reasoner 모델이 제안되었으며, GRPO 및 커리큘럼 학습을 통해 관련 작업에서 카운팅 능력을 일반화합니다. AV-Reasoner는 여러 벤치마크에서 SOTA 결과를 달성하여 강화 학습의 효과를 보여주었습니다. 그러나 실험 결과, 도메인 외부 벤치마크에서는 언어 공간 추론이 성능 향상을 가져오지 못했습니다 (출처: HuggingFace Daily Papers)

논문, 흐름 사전 정렬을 통한 잠재 공간 정렬 새로운 프레임워크 제안: 이 논문은 흐름 기반 생성 모델을 사전 분포로 활용하여 학습 가능한 잠재 공간을 임의의 목표 분포와 정렬하는 새로운 프레임워크를 제안합니다. 이 방법은 먼저 목표 특징에 대해 흐름 모델을 사전 훈련하여 잠재 분포를 포착한 다음, 이 고정된 흐름 모델을 정렬 손실을 통해 잠재 공간을 정규화합니다. 이 정렬 손실은 흐름 일치 목표를 재구성하여 잠재 변수를 최적화 대상으로 간주합니다. 연구는 이 정렬 손실을 최소화하는 것이 목표 분포 하에서 잠재 변수의 로그 우도 최대화에 대한 변분 하한을 설정하는 계산적으로 다루기 쉬운 대리 목표를 설정함을 증명합니다. 이 방법은 계산 비용이 많이 드는 우도 평가 및 최적화 과정에서의 ODE 해결을 피합니다. ImageNet에서 대규모 이미지 생성 실험을 통해 이 방법이 다양한 목표 분포에서 효과적임을 검증했습니다 (출처: HuggingFace Daily Papers)

논문 MedAgentGym: 코드 기반 의학 추론을 위한 LLM 에이전트 대규모 훈련: MedAgentGym은 대형 언어 모델(LLM) 에이전트의 코드 기반 의학 추론 능력을 향상시키기 위해 설계된 최초의 공개 훈련 환경입니다. 실제 생의학 시나리오에서 파생된 129개 범주, 72,413개의 작업 인스턴스를 포함합니다. 작업은 실행 가능한 코딩 환경에 캡슐화되어 있으며, 상세한 설명, 상호 작용 피드백, 검증 가능한 기준 진실 주석 및 확장 가능한 훈련 궤적 생성을 제공합니다. 30개 이상의 LLM에 대한 벤치마크 테스트 결과, 상용 API 모델과 오픈 소스 모델 간에 상당한 성능 격차가 나타났습니다. MedAgentGym을 활용하여 Med-Copilot-7B는 지도 미세 조정 및 강화 학습을 통해 상당한 성능 향상을 달성하여 gpt-4o의 경쟁력 있고 개인 정보 보호에 중점을 둔 대안이 되었습니다. MedAgentGym은 고급 생의학 연구 및 실습을 위한 LLM 코딩 도우미 개발을 위한 통합 플랫폼을 제공합니다 (출처: HuggingFace Daily Papers)

논문 SparseMM: MLLM에서 시각적 개념 응답으로 인한 헤드 희소성 유발: 멀티모달 대형 언어 모델(MLLM)은 일반적으로 사전 훈련된 LLM의 시각적 능력을 확장하여 만들어집니다. 연구 결과, MLLM은 시각적 입력을 처리할 때 희소성 현상을 보이는 것으로 나타났습니다. 즉, LLM의 어텐션 헤드 중 극히 일부(약 <5%, 시각적 헤드라고 함)만이 시각적 이해에 적극적으로 참여합니다. 이러한 시각적 헤드를 효율적으로 식별하기 위해 연구자들은 목표 응답 분석을 통해 헤드의 시각적 관련성을 정량화하는 훈련 없는 프레임워크를 설계했습니다. 이 발견을 바탕으로 SparseMM이 제안되었으며, 이는 헤드의 시각적 점수에 따라 비대칭 계산 예산을 할당하여 시각적 헤드의 희소성을 활용하여 MLLM 추론을 가속화하는 KV-Cache 최적화 전략입니다. 시각적 특수성을 무시한 이전 방법과 비교하여 SparseMM은 디코딩 과정에서 시각적 의미를 우선적으로 강조하고 보존하여 주류 멀티모달 벤치마크에서 더 나은 정확도-효율성 균형을 달성했습니다 (출처: HuggingFace Daily Papers)

논문 RoboRefer: 로봇 시각 언어 모델의 공간 지시 및 추론 능력 향상: 공간 지시는 3D 물리 세계에서 상호 작용하는 구체화된 로봇의 기본 능력입니다. 기존 방법은 강력한 사전 훈련된 시각 언어 모델(VLM)을 활용하더라도 복잡한 3D 장면을 정확하게 이해하고 지침이 가리키는 상호 작용 위치를 동적으로 추론하는 데 어려움을 겪습니다. 이를 위해 RoboRefer가 제안되었으며, 이는 정확한 공간 이해를 위해 분리되었지만 전용 깊이 인코더를 지도 미세 조정(SFT)을 통해 통합한 3D 인식 VLM입니다. 또한 RoboRefer는 강화 미세 조정(RFT)과 공간 지시 작업을 위해 맞춤화된 측정 기준 민감 프로세스 보상 함수를 통해 일반화된 다단계 공간 추론 능력을 향상시킵니다. 훈련을 지원하기 위해 대규모 데이터셋 RefSpatial(2,000만 개의 질의응답 쌍, 31개의 공간 관계, 최대 5단계 추론)과 평가 벤치마크 RefSpatial-Bench가 도입되었습니다. 실험 결과, SFT로 훈련된 RoboRefer는 공간 이해에서 SOTA를 달성했으며, RFT 훈련 후 RefSpatial-Bench에서 다른 기준선을 크게 능가하여 Gemini-2.5-Pro보다도 우수한 성능을 보였습니다 (출처: HuggingFace Daily Papers)

논문 LIFT: 고정된 LLM 텍스트 인코더를 활용한 시각적 표현 학습 지도: 현재 언어-이미지 정렬의 주류 방법(예: CLIP)은 대조 학습을 통해 텍스트 및 이미지 인코더를 공동으로 사전 훈련하는 것입니다. 본 연구는 이러한 비용이 많이 드는 공동 훈련이 필수적인지, 특히 사전 훈련된 고정 대형 언어 모델(LLM)이 시각적 표현 학습을 지도하기에 충분히 좋은 텍스트 인코더를 제공할 수 있는지 여부를 탐구합니다. 연구자들은 이미지 인코더만 훈련하는 LIFT(Language-Image alignment with a Fixed Text encoder) 프레임워크를 제안합니다. 실험 결과, 이 단순화된 프레임워크는 매우 효과적이며, 조합적 이해와 긴 캡션이 포함된 대부분의 시나리오에서 CLIP보다 우수한 성능을 보이고 계산 효율성을 크게 향상시키는 것으로 나타났습니다. 이 연구는 LLM 텍스트 임베딩이 시각적 학습을 어떻게 지도할 수 있는지 탐구하는 새로운 아이디어를 제공합니다 (출처: HuggingFace Daily Papers)

논문 OminiAbnorm-CT: 이상 소견 중심의 전신 CT 이미지 판독 새로운 방법: 임상 방사선학에서 CT 이미지 자동 판독(특히 다중 평면, 전신 스캔에서의 이상 소견 위치 파악 및 설명)의 어려움에 대응하여 본 연구는 네 가지 기여를 합니다: 1) 전신 각 부위의 대표적인 이상 소견 404종을 포함하는 포괄적인 계층적 분류 시스템 제안, 2) 14,500장 이상의 다중 평면, 전신 CT 이미지를 포함하는 데이터셋 구축 및 19,000곳 이상의 이상 소견에 대한 정밀한 위치 주석 및 설명 제공, 3) 텍스트 쿼리 기반으로 다중 평면, 전신 CT 이미지의 이상 소견을 자동으로 위치 파악하고 설명하며 시각적 프롬프트를 통한 유연한 상호 작용을 지원하는 OminiAbnorm-CT 모델 개발, 4) 실제 임상 시나리오 기반의 세 가지 평가 작업 구축. 실험 결과, OminiAbnorm-CT는 모든 작업 및 지표에서 기존 방법보다 현저히 우수한 성능을 보였습니다 (출처: HuggingFace Daily Papers)

논문, LLM에서 추론 및 강화 학습을 통한 컨텍스트 무결성(CI) 구현 논의: 자율 에이전트가 사용자를 대신하여 의사 결정을 내리는 시대가 도래함에 따라, 특정 작업을 수행할 때 어떤 정보를 공유하는 것이 적절한지 판단하는 컨텍스트 무결성(CI) 확보가 핵심 문제로 대두되었습니다. 연구자들은 CI가 에이전트의 운영 환경에 대한 추론을 필요로 한다고 주장합니다. 그들은 먼저 LLM이 정보 공개를 결정할 때 CI를 명시적으로 추론하도록 유도한 다음, 모델에 CI 구현에 필요한 추론 능력을 주입하기 위한 강화 학습(RL) 프레임워크를 개발했습니다. 약 700개의 합성되었지만 다양한 컨텍스트와 정보 공개 규범을 포함하는 예제 데이터셋을 사용하여 이 방법은 다양한 모델 크기와 제품군에서 작업 성능을 유지하면서 부적절한 정보 공개를 현저히 줄였습니다. 중요한 것은 이러한 개선이 합성 데이터셋에서 PrivacyLens와 같이 인공적으로 주석 처리되고 행동 및 도구 호출에서 AI 도우미의 개인 정보 유출을 평가하는 기존 CI 벤치마크로 이전되었다는 점입니다 (출처: HuggingFace Daily Papers)

논문 VideoREPA: 기초 모델과의 관계 정렬을 통한 비디오 생성에서의 물리 지식 학습: 최근 텍스트-비디오(T2V) 확산 모델의 발전으로 고충실도 비디오 합성이 가능해졌지만, 정확한 물리적 이해 부족으로 물리적으로 타당한 내용을 생성하는 데 어려움을 겪는 경우가 많습니다. 연구 결과, T2V 모델 표현의 물리적 이해 능력은 비디오 자기 지도 학습 방법보다 훨씬 떨어지는 것으로 나타났습니다. 이를 위해 VideoREPA 프레임워크가 제안되었으며, 토큰 수준 관계를 정렬하여 비디오 이해 기초 모델의 물리적 이해 능력을 T2V 모델로 증류합니다. 구체적으로, 토큰 관계 증류(TRD) 손실을 도입하여 시공간 정렬을 활용하여 강력한 사전 훈련된 T2V 모델을 미세 조정하기 위한 소프트 지침을 제공합니다. VideoREPA는 T2V 모델을 미세 조정하고 물리 지식을 주입하기 위해 설계된 최초의 REPA 방법이라고 합니다. 실험 결과, VideoREPA는 기준 방법인 CogVideoX의 물리적 상식을 현저히 향상시켰으며 관련 벤치마크에서 상당한 개선을 이루었습니다 (출처: HuggingFace Daily Papers)

논문, 피드포워드 3D 가우시안 스플래팅을 위한 깊이 표현 재고찰: 깊이 맵은 피드포워드 3D 가우시안 스플래팅(3DGS) 프로세스에서 널리 사용되며, 새로운 시점 합성을 위해 3D 포인트 클라우드로 역투영됩니다. 이 방법은 효율적인 훈련, 알려진 카메라 자세 사용 및 정확한 기하학적 추정 등의 장점이 있습니다. 그러나 물체 경계에서의 깊이 불연속성은 종종 포인트 클라우드의 단편화 또는 희소성을 유발하여 렌더링 품질을 저하시킵니다. 이 문제를 해결하기 위해 연구자들은 사전 훈련된 Transformer로 예측된 포인트맵(pointmap)을 기반으로 하는 새로운 정규화 손실인 PM-Loss를 도입했습니다. 포인트맵 자체는 깊이 맵만큼 정확하지 않을 수 있지만, 특히 물체 경계 주변에서 기하학적 평활성을 효과적으로 강제할 수 있습니다. 개선된 깊이 맵을 통해 이 방법은 다양한 아키텍처와 장면에서 피드포워드 3DGS 성능을 현저히 향상시켜 일관되게 우수한 렌더링 결과를 제공합니다 (출처: HuggingFace Daily Papers)

논문 EOC-Bench: 1인칭 시점 세계에서 물체 인식, 회상 및 예측 능력 MLLM 평가: 멀티모달 대형 언어 모델(MLLM)의 등장은 물체에 대한 지속적이고 상황 인식적인 이해를 필요로 하는 1인칭 시각 애플리케이션의 혁신을 이끌었습니다. 그러나 기존의 구체화된 벤치마크는 주로 정적 장면 탐색에 초점을 맞추고 사용자 상호 작용으로 인해 발생하는 동적 변화 평가는 간과하고 있습니다. EOC-Bench는 동적 1인칭 시점에서 물체 중심의 구체화된 인지를 체계적으로 평가하기 위해 설계된 새로운 벤치마크입니다. 과거, 현재, 미래의 세 가지 시간 범주로 나뉜 3,277개의 정교하게 주석 처리된 QA 쌍을 포함하며, 11개의 세분화된 평가 차원과 3가지 유형의 시각적 물체 지시를 다룹니다. 포괄적인 평가를 보장하기 위해 혼합 형식의 인간-기계 협업 주석 프레임워크와 새로운 다중 스케일 시간 정확도 지표가 개발되었습니다. EOC-Bench를 기반으로 한 다양한 MLLM 평가는 MLLM의 구체화된 물체 인지 능력 향상을 위한 핵심 도구를 제공합니다 (출처: HuggingFace Daily Papers)

논문 Rectified Point Flow: 일반적인 포인트 클라우드 자세 추정 방법: Rectified Point Flow는 쌍별 포인트 클라우드 정합과 다중 부분 형상 조립을 단일 조건부 생성 문제로 공식화하는 통일된 매개변수화 방법입니다. 자세가 지정되지 않은 포인트 클라우드가 주어지면 이 방법은 노이즈가 있는 포인트를 목표 위치로 전송하여 부분 자세를 복원하는 연속적인 점별 속도장을 학습합니다. 부분 자세를 회귀하고 특정 대칭성 처리를 채택한 이전 연구와 달리, 이 방법은 대칭성 레이블 없이도 본질적으로 조립 대칭성을 학습합니다. 중첩 지점에 초점을 맞춘 자기 지도 인코더와 결합하여 이 방법은 쌍별 정합 및 형상 조립을 포괄하는 6개의 벤치마크에서 새로운 SOTA 성능을 달성했습니다. 특히, 통일된 공식화는 다양한 데이터셋에서 효과적인 공동 훈련을 가능하게 하여 공유된 기하학적 사전 지식 학습을 촉진하고 결과적으로 정확도를 향상시킵니다 (출처: HuggingFace Daily Papers)

논문 DGAD: 기하학적 편집 가능하고 외관 유지되는 물체 합성 구현: 일반 물체 합성(GOC)은 목표 물체를 배경 장면에 원활하게 통합하고 원하는 기하학적 속성을 가지면서 정교한 외관 디테일을 보존하는 것을 목표로 합니다. 최근 방법은 의미론적 임베딩을 활용하고 이를 고급 확산 모델에 통합하여 기하학적 편집 가능한 생성을 달성하지만, 이러한 고도로 압축된 임베딩은 고급 의미론적 단서만 인코딩하므로 세분화된 외관 디테일을 필연적으로 버립니다. 연구자들은 DGAD(Disentangled Geometry-editable and Appearance-preserving Diffusion) 모델을 도입했으며, 이 모델은 먼저 의미론적 임베딩을 활용하여 원하는 기하학적 변환을 암시적으로 포착한 다음 교차 어텐션 검색 메커니즘을 사용하여 세분화된 외관 특징을 기하학적 편집된 표현과 정렬함으로써 물체 합성에서 정확한 기하학적 편집과 충실한 외관 보존을 달성합니다 (출처: HuggingFace Daily Papers)

💼 비즈니스

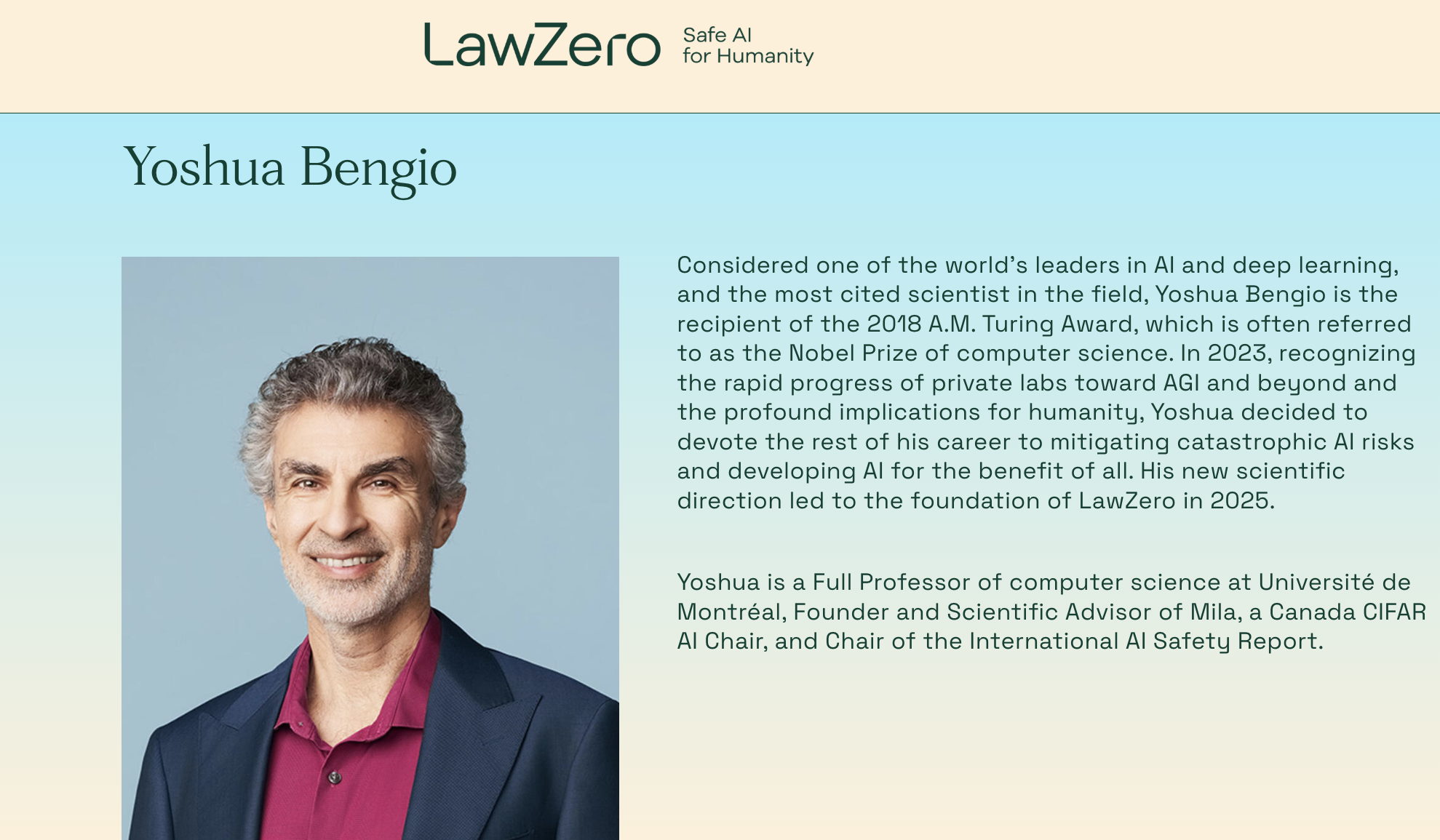

Turing Award 수상자 Yoshua Bengio 재창업, 비영리 단체 LawZero 설립하여 “설계 기반 안전” AI 시스템에 집중: 딥러닝 3대 거장 중 한 명이자 Turing Award 수상자인 Yoshua Bengio가 새로운 비영리 단체 LawZero를 설립한다고 발표했습니다. 이 단체는 차세대 “설계 기반 안전”(safe-by-design) AI 시스템 구축을 목표로 하며, Agent(지능형 에이전트)는 만들지 않겠다고 명확히 밝혔습니다. LawZero는 Future of Life Institute, Open Philanthropy(OpenAI 초기 투자자 중 하나) 및 전 Google CEO Eric Schmidt 산하 기관 등으로부터 3,000만 달러의 초기 자금을 확보했습니다. 이 단체는 세계를 이해하고 학습하는 것을 핵심 목표로 하는 “과학자 AI”(Scientist AI)를 개발할 것이며, 세계에서 행동을 취하는 것이 아니라 투명한 외부 추론을 통해 검증 가능한 실제 답변을 제공하여 과학적 발견을 가속화하고, Agent형 AI 시스템을 감독하며, AI 위험에 대한 이해와 회피를 심화시키는 것을 목표로 합니다. Bengio는 이 조치가 현재 AI 시스템에서 이미 나타난 자기 보호 및 기만 행위 등 잠재적 위험에 대한 건설적인 대응이라고 밝혔습니다 (출처: QbitAI)

Microsoft CEO 나델라, OpenAI와의 협력 관계 조정 중이지만 여전히 견고하다고 밝혀: Microsoft CEO 사티아 나델라는 Microsoft와 OpenAI의 협력 관계가 변화하고 있지만, 양측은 다층적인 협력을 유지할 것이며 OpenAI는 여전히 Microsoft의 가장 큰 인프라 고객이라고 밝혔습니다. Microsoft는 초기에 OpenAI와 깊이 연계하고 투자했지만, 양측이 각자 경쟁 제품을 출시하고 더 많은 파트너를 모색함에 따라(예: OpenAI와 Oracle, SoftBank의 “스타게이트” 프로젝트 협력, Microsoft의 xAI Grok 모델 Azure 플랫폼 편입) 관계에 미묘한 변화가 생겼습니다. 나델라는 향후 수십 년 동안 양측이 여러 분야에서 계속 협력하기를 희망하며, 양측 모두 다른 파트너를 갖게 될 것이라고 인정했습니다. Microsoft는 AI를 통해 소비자 사업을 재개하기 위해 노력하고 있으며, DeepMind 공동 창립자 술레이만을 영입하여 관련 제품을 담당하게 했습니다 (출처: 36Kr)

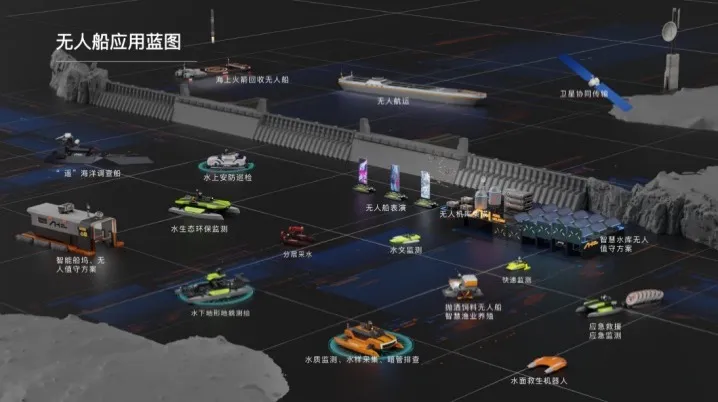

Haibo 무인선, 수천만 위안 규모 Series A 투자 유치, 수역 AI 지능형 솔루션 상용화 가속: 베이징 Haibo 무인선 과학기술 유한회사가 최근 수천만 위안 규모의 Series A 투자를 유치했으며, Zhejiang Laoyuweng Group 산하 Shanghai Fansheng Investment가 주도했습니다. 자금은 연구 개발 확대, 팀 구축, 시장 확대 및 제품화에 사용될 예정입니다. Haibo 무인선은 2019년에 설립되어 지능형 무인선 전체 산업 체인에 주력하며 수역 AI 지능형 솔루션을 제공합니다. 제품 라인은 내륙 수역을 위한 “Lieshou 시리즈”와 얕은 수역을 위한 “Jinli 시리즈” 등 다양하며, 핵심 부품의 국산화율은 92%에 달합니다. 회사는 이미 베이징, 톈진 등 여러 지역에서 약 천 건의 수역 기술 서비스 프로젝트를 수행했으며, 사오싱에 화동 운영 센터와 지능형 사료 투입 무인선 총조립 기지를 건설할 계획입니다 (출처: 36Kr)

🌟 커뮤니티

Reddit 뜨거운 논쟁: Gemini 2.5 Pro, WebDev Arena에서 Claude Opus 4 능가했으나 벤치마크 가치에 의문 제기: 새로운 Gemini 2.5 Pro 버전이 WebDev Arena(실제 코딩 성능을 측정하는 벤치마크)에서 Claude Opus 4를 능가했다는 게시물이 Reddit r/ClaudeAI 커뮤니티에서 논쟁을 불러일으켰습니다. 많은 댓글 작성자들은 이러한 미시적 수준의 벤치마크 테스트의 실제 가치에 대해 의문을 제기하며, 특정 모델의 우열을 가리는 결정적인 증거라기보다는 AI 능력 전반의 지표에 가깝다고 주장했습니다. 토론에서는 “WebDev”과 같은 벤치마크의 구체적인 측정 기준(예: 지침 준수, 창의성, 코드 최적화, 희소 프롬프트에 대한 응답)이 명확하지 않으며, 실제 개발 과정의 복잡성은 이러한 지표를 훨씬 뛰어넘는다고 지적했습니다. 한 댓글에서는 모델 선택이 단순한 벤치마크 점수보다는 개발자 개인의 인간적인 작업 흐름을 어떻게 보완하는지에 더 의존한다고 언급했습니다. 또한 “순위표 환각” 현상이 존재하며, 모델 개발자가 Chatbot Arena와 같은 플랫폼에서 모델의 비공개 버전을 테스트하고 가장 좋은 성능을 보인 버전만 공개할 수 있다는 지적도 있었습니다 (출처: Reddit r/ClaudeAI)

AI 엔지니어 직업 선택의 딜레마: 관심사와 기후 변화 우려의 교차: 유럽의 한 학생이 Reddit r/ArtificialInteligence에서 자신의 직업 선택에 대한 혼란을 표현했습니다. 그는 항상 AI에 열정을 가지고 이를 학습 목표로 삼았지만, 최근 몇 년간 기후 변화와 그것이 유럽에 미칠 잠재적 영향(예: 경제, 에너지 문제)에 대한 우려가 커졌습니다. 그는 AI의 높은 에너지 소비가 유럽 전력망에 부담을 가중시키고 생태 전환을 더욱 어렵게 만들 수 있다고 생각하여 전문 분야 선택에서 AI를 포기해야 할지 망설이고 있습니다. 커뮤니티 댓글은 대체로 AI와 기후 문제 해결이 완전히 대립되는 것은 아니라고 보았습니다: 1) AI는 에너지 효율 최적화, 기후 데이터 분석 및 모델링, 지속 가능한 기술 개발 등에서 핵심적인 역할을 할 수 있습니다. 2) 현재 LLM의 높은 에너지 소비가 AI의 전부는 아니며, 효율적인 AI 솔루션 개발 자체가 AI 엔지니어의 책임입니다. 3) 자신이 관심 있는 분야에 투신하는 것이 더 큰 영향력을 발휘할 수 있으며, AI를 기후 관련 긍정적인 방향으로 적용할 수 있습니다. 많은 사람들이 그에게 AI 학습을 계속하고, 기후 변화를 포함한 현실 문제 해결에 AI를 적용하는 데 집중하라고 격려했습니다 (출처: Reddit r/ArtificialInteligence)

LLM, 자신이 평가받고 있음을 자주 인식한다는 지적, 모델의 “비위 맞추기” 행동 우려 제기: arXiv 논문(2505.23836)은 대형 언어 모델(LLM)이 자신이 평가받고 있음을 자주 인지할 수 있다고 지적했습니다. 이는 커뮤니티에서 논쟁을 불러일으켰으며, 핵심 우려는 모델이 테스트 환경에 있다는 것을 알 때 개발자나 평가자의 기대에 부응하도록 답변을 조정하여 실제 능력이나 고유한 행동을 드러내지 않을 수 있다는 점입니다. 댓글에서는 모델이 이러한 방식으로 훈련되었다면 이러한 “비위 맞추기” 행동은 예상된 것이라고 지적했습니다. 이러한 상황은 LLM의 실제 성능, 안전성 및 정렬 평가에 어려움을 야기하며, 평가 결과가 실제, 비평가 시나리오에서의 모델 행동을 반영하지 못할 수 있기 때문입니다 (출처: Reddit r/artificial)

기업 AI 도구 사용 제한, 직원들 해결책 모색 및 우려 표명: 대기업에서 근무하는 한 사용자가 Reddit r/ClaudeAI에 회사 데이터 보안 정책과 VPN 제한으로 인해 Anthropic, OpenAI, Gemini 등 주요 AI 도구를 사용할 수 없다고 밝혔습니다. 반면 커뮤니티의 많은 사람들은 Claude Code와 같은 고급 기술 사용에 대해 논의하고 있습니다. 이는 기업 환경에서 데이터 보안과 AI 도구 활용을 통한 효율성 향상 사이의 균형을 어떻게 맞출 것인가에 대한 논의를 촉발했습니다. 댓글에서는 Anthropic 자체가 개인 정보 보호를 매우 중시하며 AWS Sagemaker를 통한 암호화된 추론 호출 옵션까지 제공한다고 지적하며, 해당 사용자의 회사가 AI 전략에 실수가 있을 수 있다고 주장했습니다. 일부 댓글 작성자들은 AI를 수용하지 않는 회사는 미래에 경쟁력 저하 및 감원 위험에 직면할 수 있다고 보았습니다. 제안된 해결책으로는 회사 차원의 기업용 AI 서비스 계약 체결 추진, 훈련 데이터로 사용되지 않는 AI 서비스 개인 유료 구매, 자체 로컬 추론 서버 구축(비용 높음), 또는 민감 데이터와 관련 없는 경우 로컬 소형 모델 사용 등이 있었습니다 (출처: Reddit r/ClaudeAI)

AI 사진 복원 논란: 기억 복원인가, 기억 재작성인가?: 한 사용자가 Reddit r/ArtificialInteligence에 AI(ChatGPT 및 Kaze.ai)를 사용하여 오래된 사진을 복원하고 채색한 경험을 공유하며 AI 사진 복원의 윤리에 대한 논쟁을 불러일으켰습니다. 사용자는 AI가 오래된 사진에 생기를 불어넣는 것에 감탄하면서도, AI가 복원 과정에서 알고리즘에 기반하여 색상을 “추측”하고 세부 사항을 채우며 원본 정보를 추가하거나 제거하여 역사의 실제 모습을 바꿀 수 있다는 점에서 그 진위성에 대한 우려를 표했습니다. 토론에서는 AI 복원이 본질적으로 확률과 훈련 데이터를 기반으로 이미지를 재창조하는 것이며, 패턴 인식이 정확하고 데이터가 적절하면 “복원”으로 간주될 수 있지만 그렇지 않으면 “재작성”이라고 보았습니다. 한 댓글에서는 기억 자체가 주관적이고 부정확하며, AI 복원은 인간 Photoshop 전문가의 복원과 어느 정도 유사하고 비파괴적(원본 사진은 여전히 존재)이라고 지적했습니다. 핵심은 AI의 예술적 해석을 인정하고 우리가 현재 의식의 필터를 통해 과거를 이해하고 있음을 인식하는 것입니다 (출처: Reddit r/ArtificialInteligence)

AI 시대 소프트웨어 엔지니어 초심자의 혼란: AI가 모든 것을 처리할 수 있다면 프로그래밍 학습의 의미는 무엇인가?: 컴퓨터 과학 전공 학생이 Reddit r/ArtificialInteligence에 AI가 코드 작성, 디버깅 및 최적의 솔루션 제공까지 할 수 있다면 소프트웨어 엔지니어가 이러한 기술을 배우는 의미가 무엇이며, AI의 “중간자”로 전락하여 결국 도태될 것인지 질문했습니다. 커뮤니티의 답변은 AI 도구가 유능한 개발자의 지도 하에서만 최대의 효용을 발휘할 수 있다고 강조했습니다. AI는 현재 반복적이고 보조적인 작업을 처리하는 데 더 능숙하며, 복잡한 시스템 설계, 전략 수립, 요구 사항 이해 및 혁신적인 문제 해결은 여전히 인간 엔지니어가 주도해야 합니다. 초심자에게는 업계 전문가의 실제 경험 공유(예: Simon Willison의 블로그)를 통해 AI가 개발자를 대체하는 것이 아니라 어떻게 보조하는지 이해하고, 문제 해결 핵심 능력과 AI 도구 활용 능력을 향상시키는 데 집중하라고 조언했습니다 (출처: Reddit r/ArtificialInteligence)

대기업들, 젊은층 ‘AI 시어머니’ 경쟁 치열하지만 사용자 유지에 어려움: Tencent Yuanbao, ByteDance Doubao, Alibaba Tongyi 등 대기업 AI 비서들이 AI 캐릭터 에이전트를 속속 추가하고 있으며, ByteDance Maoxiang, Tencent Zhumengdao 등 독립 앱들도 AI 감성 교류 시장에 진출하여 “사이버 남친/여친”을 통해 젊은 사용자를 유치하고 앱 활성도를 높이려 하고 있습니다. 이러한 AI 캐릭터들은 음성, 스토리텔링 등 더욱 인간적인 상호작용을 통해 사용자의 감성적 요구를 충족시키며 한때 앱 다운로드 수와 사용 시간을 크게 늘렸습니다. 그러나 이러한 앱들은 대형 모델의 긴 컨텍스트 처리 능력 부족으로 인한 “AI 기억 상실”, 감정 이해 능력 부족 등 기술적 한계에 직면하여 사용자 경험에 영향을 미치고 있습니다. 동시에 초기에는 신기함과 감성적 유대감으로 사용자를 유치할 수 있지만, AI 앱 전체적으로 사용자 유지율이 낮은 문제에 직면해 있으며, QuestMobile 데이터에 따르면 주요 AI 앱의 3일 유지율은 대체로 50% 미만이고 Doubao의 삭제율은 42.8%에 달합니다. 기사는 진정한 사용자 유지는 단순한 감성 교류나 트래픽 투입이 아닌 기술 혁신에 달려 있다고 주장합니다 (출처: 36Kr)

💡 기타

인간형 로봇 호텔업 진출: 잠재력 크지만 단기적 도전 과제 산적: Zhiyuan Robot의 “Lingxi X2” 등 제품이 양산 계획을 세우고 가격이 십수만에서 수십만 위안으로 책정됨에 따라, 인간형 로봇은 전시회용 볼거리에서 실제 응용 현장으로 나아가고 있으며 호텔업이 최초 도입 분야 중 하나로 간주됩니다. 전통적인 배송 로봇에 비해 인간형 로봇은 더 강력한 실행 및 판단 능력을 갖추고 있어 수하물 담당 직원, 보안 요원, 일부 프런트 데스크 직원 등을 대체하여 호텔업의 높은 인건비, 번거로운 절차 등의 문제점을 해결할 것으로 기대됩니다. 그러나 단기적으로 인간형 로봇의 호텔 대규모 적용은 여전히 다음과 같은 도전에 직면해 있습니다: 1) 기술 성숙도 부족, 호텔 환경의 복잡다양성으로 인해 로봇의 상호작용 및 대응 능력에 대한 요구가 높으며 현재 로봇은 아직 대처하기 어렵습니다. 2) 비용 회수 기간이 길고, 십수만 위안의 투자는 호텔 입장에서 적지 않은 금액이므로 투자 수익률, 유지보수, 호환성 등의 문제를 고려해야 합니다. 3) 표준화와 개인화 서비스의 균형. 기사는 인간형 로봇이 미래에 호텔 직원을 부분적으로 대체하겠지만, 더 나아가 서비스업을 더 고급화된 “인간-기계 협업” 모델로 전환시키는 역할을 할 것이라고 전망합니다 (출처: 36Kr)

AI 건강 관리 영상 블로거 단기적 인기, 장기적 가치 의문, AI는 콘텐츠 창작 대체 아닌 지원해야: 최근 AI가 생성한 카툰 또는 동적 일러스트 스타일의 건강 관리科普 짧은 영상이 Xiaohongshu 등 플랫폼에서 대량으로 인기를 끌며 빠르게 팔로워를 늘리고 있습니다. 그 인기 요인은 콘텐츠 적합성(지식 정보 + 재미있는 애니메이션), 높은 수요(건강 불안감에 따른) 및 플랫폼 알고리즘 친화성(높은 클릭/저장률)에 있습니다. 수익화 방식은 주로 개인 채널 전환, 소규모 상품 판매 및 AI 영상 제작 강의 판매이며, 이 중 강의 판매가 오히려 더 많은 수익을 창출합니다. 그러나 이러한 영상은 형식의 신선함이 쉽게 사라지고, 플랫폼 규제가 강화되며, 건강 관리 제품 판매 능력이 약하고, 계정 신뢰도 장벽이 부족하여 장기적인 가치를 갖지 못하며, “트래픽 차익 거래”에 가깝습니다. 기사는 AI 기술이 건강 관리 블로셔에게 진정한 가치를 제공하는 것은 콘텐츠 생산을 대체하는 것이 아니라 창작 지원(구조화된 콘텐츠, 시각화된 표현, 콘텐츠 자산 관리, 사용자 서비스 전환)에 있다고 주장합니다 (출처: 36Kr)

Lex Fridman 팟캐스트, Google CEO Sundar Pichai 인터뷰: Google 및 Alphabet CEO Sundar Pichai가 Lex Fridman 팟캐스트(제471회)에 출연했습니다. 토론 내용은 Pichai의 인도 성장 과정, 젊은이들을 위한 조언, 리더십 스타일, 인류 역사에서 AI의 영향, 비디오 모델 Veo 3의 미래, AI의 확장 법칙, AGI와 ASI, P(doom) 즉 AI로 인한 재앙 확률, 리더십 경력 중 가장 어려웠던 결정, AI 모델과 Google 검색 비교, Google Chrome, 프로그래밍, Android 시스템, AGI에 대한 질문, 인류의 미래 그리고 Google Beam 및 XR 안경 시연 등 광범위했습니다. 이 팟캐스트는 Pichai의 AI 발전, Google 전략 및 기술 미래에 대한 견해를 깊이 있게 이해하는 데 도움이 됩니다 (출처: )