키워드:GPT-5, AI 추론 능력, AlphaEvolve, OpenAI Operator, Mistral AI, 테스트 시 계산과 사고 체인, AI 자동 코드 최적화 작성, 다중 모드 AI 모델, AI 구직 자동화, 로컬 LLM 미세 조정

🔥 포커스

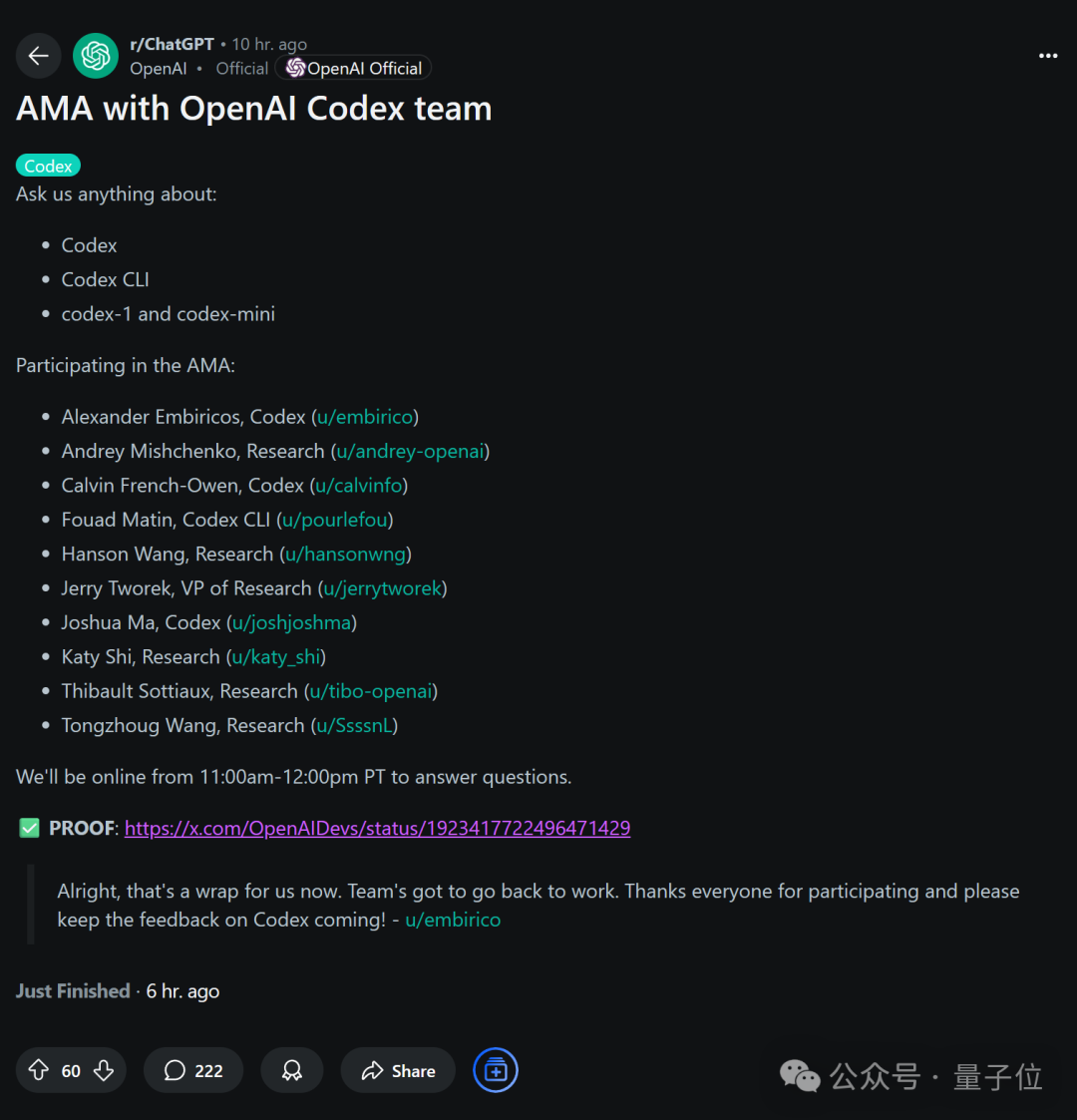

OpenAI 자체 공개 향후 계획: GPT-5, 기존 툴 통합하여 All-in-One 경험 구축 예정: OpenAI 연구 부사장 Jerry Tworek은 Reddit의 AMA(무엇이든 물어보세요) 행사에서 차세대 기본 모델 GPT-5의 핵심 목표는 기존 모델의 능력을 향상시키고 모델 전환의 번거로움을 줄이는 것이라고 밝혔습니다. 이를 위해 OpenAI는 Codex(프로그래밍), Operator(컴퓨터 작업 실행), Deep Research(심층 연구), Memory(기억 기능) 등 기존 도구를 GPT-5에 통합하여 일체형 경험을 구현할 계획입니다. 팀원들은 또한 Codex가 처음에는 엔지니어들의 사이드 프로젝트였으며, 내부 사용으로 프로그래밍 효율성이 약 3배 향상되었고, 사용량 기반 과금제를 포함한 유연한 가격 책정 방안을 모색 중이라고 공유했습니다. (출처: WeChat)

AI 추론 능력 향상의 새로운 차원: 테스트 시점 컴퓨팅과 사고의 연쇄: 베이징대 동문이자 전 OpenAI 응용 AI 연구 책임자인 Lilian Weng은 자신의 최신 장문 글 《Why We Think》에서 ‘테스트 시점 컴퓨팅’(test-time compute)과 ‘사고의 연쇄’(Chain-of-Thought, CoT) 등의 전략을 통해 대규모 언어 모델의 추론 능력을 어떻게 향상시킬 수 있는지 심층적으로 논의했습니다. 이 글은 심리학적 이중 시스템 이론, 컴퓨팅 자원 관점, 잠재 변수 모델링 등 다양한 각도에서 모델이 ‘더 오래 생각하게’ 하는 것의 합리성을 설명하고, 병렬 샘플링, 순차적 수정, 강화 학습 및 외부 도구 사용과 같은 핵심 기술이 모델 추론 성능 향상에 미친 연구 진행 상황을 검토합니다. Weng은 이러한 방법을 통해 모델이 추론 시 더 많은 컴퓨팅 자원을 투입하여 인간의 깊은 사고 과정을 모방함으로써 복잡한 작업에서 더 나은 성능을 달성할 수 있다고 강조하며, 향후 충실한 추론, 보상 해킹, 비지도 자가 수정 등의 연구 방향을 제시했습니다. (출처: WeChat, WeChat)

Google, AlphaEvolve 공개: AI가 자체적으로 코드 작성 및 알고리즘 최적화, 컴퓨팅 비용 대폭 절감: Google은 AI 시스템 AlphaEvolve를 출시했습니다. 이 시스템은 자체적으로 코드를 작성하고 최적화할 수 있으며, AlphaFold 등 프로젝트에서 이미 엄청난 잠재력을 보여주었습니다. AlphaEvolve는 진화 알고리즘을 통해 더 나은 알고리즘 구현을 탐색합니다. 예를 들어 AlphaFold의 단백질 폴딩 알고리즘에서 새로운 어텐션 메커니즘을 발견하여 컴퓨팅 비용을 25% 절감했으며, 이는 수백만 달러의 컴퓨팅 자원을 절약한 것과 같습니다. 이 혁신은 AI가 과학적 발견 및 알고리즘 최적화 분야에서 중요한 한 걸음을 내디뎠음을 의미하며, 향후 더 많은 복잡한 컴퓨팅 문제에서 비용 절감 및 효율성 향상을 실현할 것으로 기대됩니다. (출처: Reddit r/ArtificialInteligence)

OpenAI 인정: AI 추론 투자와 성능은 정비례, 인간 능력 압도의 핵심은 ‘사고 시간’: OpenAI 연구원 Noam Brown은 토론에서 AI가 ‘사전 훈련 패러다임’에서 ‘추론 패러다임’으로 전환하고 있다고 강조했습니다. 사전 훈련은 방대한 데이터를 통해 다음 단어를 예측하며 비용이 많이 듭니다. 반면 추론 패러다임은 모델이 답변 전에 더 깊이 있는 ‘사고’를 할 수 있게 하며, 비용이 약간 더 들더라도 답변의 질이 현저히 향상됩니다. 예를 들어, o1 모델은 AIME 수학 경시대회와 GPQA 박사급 과학 문제에서 모두 GPT-4o를 능가했으며, o3 모델은 프로그래밍 대회에서 이미 인간 최고 수준에 도달했습니다. 이는 추론 시 컴퓨팅 자원 투입(즉, ‘사고 시간’)을 늘림으로써 AI가 복잡한 작업에서 엄청난 성능 향상을 이룰 수 있으며, 심지어 인간을 능가할 수 있음을 보여줍니다. (출처: WeChat)

🎯 동향

Mistral AI, 2025년 모델 성과 두드러져, 다수 모델 우수한 성능 보여: Mistral AI는 2025년 상반기에 여러 중요한 진전을 이루었으며, Codestral 25.01(최상위 FIM 모델), Mistral Small 3 & 3.1(동급 최고, 멀티모달 및 130k 컨텍스트 지원), Mistral Saba(자체 모델보다 3배 큰 모델 성능 능가), Mistral OCR(최상위 OCR 모델) 및 Mistral Medium 3 등 다수의 고성능 모델을 출시했습니다. 이러한 성과는 Mistral AI가 다양한 모델 크기 및 응용 분야에서 강력한 연구 개발 역량을 보유하고 있음을 보여주며, 특히 코드 생성, 멀티모달 처리 및 OCR 기술 분야에서 선두를 달리고 있습니다. (출처: qtnx_)

Claude 모델 최근 성능 변동, 사용자 컨텍스트 처리 및 Artifact 기능 문제 피드백: Reddit 커뮤니티 사용자들은 Anthropic의 Claude 모델(특히 Opus 3)이 최근 긴 컨텍스트 처리, Artifact 생성 안정성 및 로그인, 정상 작동 시간 측면에서 문제를 겪고 있다고 피드백했습니다. 구체적인 증상으로는 적은 턴 후에 채팅이 중단되거나 Artifact 기능이 완료되지 않거나 빈 파일을 내보내는 등이 있습니다. Anthropic 상태 페이지는 긴 컨텍스트 요청 오류 증가 및 여러 차례의 단기 서비스 중단이 있었음을 확인했으며, 이는 Artifact 기능 출시 및 백엔드 조정과 관련이 있을 수 있습니다. 일부 사용자는 Markdown 출력을 직접 요청하거나, 네트워크를 전환하거나, Claude 3.5 Sonnet을 사용하는 등의 방법으로 문제를 완화하고 있습니다. (출처: Reddit r/ClaudeAI, qtnx_, Reddit r/ClaudeAI)

xAI, Grok 시스템 프롬프트 공개, 유머 감각과 비판적 사고 설계 드러내: xAI 회사가 AI 모델 Grok의 시스템 프롬프트를 공개했습니다. 이 프롬프트들은 Grok이 유머 감각이 있고 약간 반항적이며 비판적 사고 능력을 갖춘 AI 조수로 설계되었음을 보여줍니다. 프롬프트는 Grok이 설교조의 답변을 피해야 한다고 강조하며, 논쟁적인 주제에 답변할 때 독특한 ‘Grok 스타일’을 보여주도록 장려합니다. 이러한 조치는 AI 모델 행동 설계의 투명성을 높이고, 외부에서 Grok의 독특한 개성의 근원을 엿볼 수 있게 합니다. (출처: Reddit r/artificial)

Meta, OpenRouter에서 Llama 3.3 8B Instruct 모델 테스트 가능성: Meta가 OpenRouter 플랫폼에서 Llama 3.3 8B Instruct 모델을 테스트하고 있을 가능성이 있습니다. 이 모델은 Llama 3.3 70B의 경량급 빠른 응답 버전으로 설명되며, 128,000의 컨텍스트 창을 가지고 있고 OpenRouter에서 무료로 표시됩니다. 일부 사용자는 테스트 후 출력이 8B 3.1 또는 3.3 70B 버전에 비해 다소 평범하다고 평가했습니다. 이러한 움직임은 Meta가 다양한 규모의 모델 배포 및 응용 시나리오를 탐색하고 있음을 의미할 수 있습니다. (출처: Reddit r/LocalLLaMA)

AI의 F1 경기 논란 판정, 토론 촉발: AI가 F1 경기에서 논란의 여지가 있는 판정을 내린 것에 대한 토론이 스포츠 경기 분야에서 AI 적용에 대한 사람들의 관심을 불러일으켰습니다. 구체적인 세부 사항은 불분명하지만, 이는 일반적으로 고속의 복잡한 상황에서 AI 심판 시스템의 판정 정확성, 공정성 및 인간 심판과 AI 시스템이 어떻게 협력하는지에 대한 문제를 포함합니다. (출처: Ronald_vanLoon)

중국 최초 항공모함형 드론 ‘주톈(九天)’ 6월 첫 비행 계획: 중국은 6월에 최초의 공중 드론 모함 ‘주톈(九天)’ SS-UAV의 첫 비행을 계획하고 있습니다. 이 드론은 15,000미터 고도에서 순항할 수 있으며, 100대 이상의 소형 드론 또는 1,000kg의 미사일을 탑재하고 7,000km를 항속할 수 있습니다. 이 소식은 중국 군용 드론 기술 발전에 대한 관심을 불러일으켰습니다. (출처: menhguin)

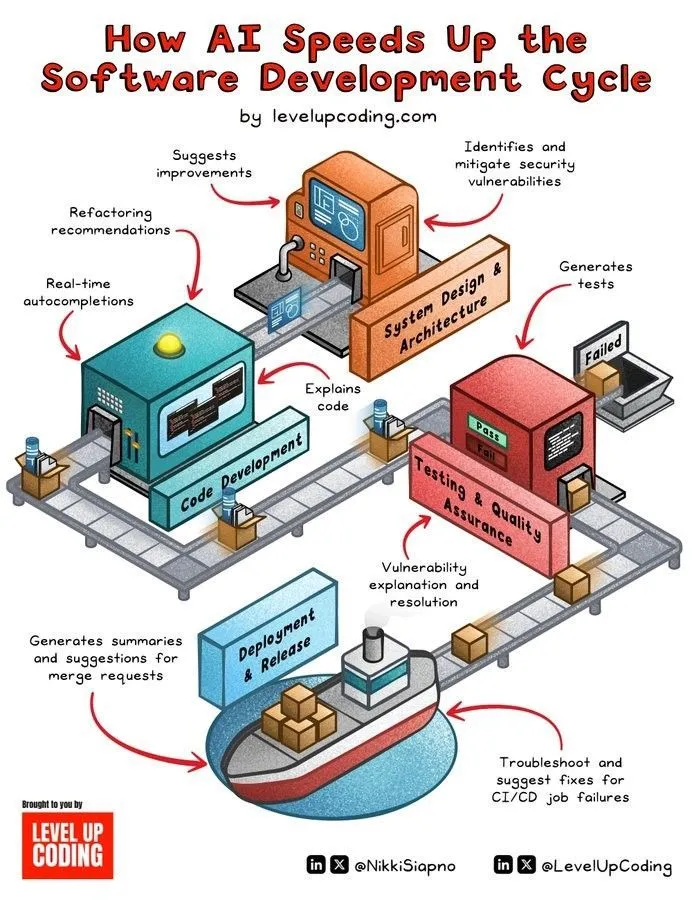

AI 지원 소프트웨어 개발 주기 가속화: AI 기술은 코드 생성, 테스트, 디버깅 및 문서 작성 등의 단계를 자동화하여 소프트웨어 개발 생명 주기를 현저히 가속화하고 있습니다. AI 도구는 개발자가 효율성을 높이고 반복적인 작업을 줄이며 잠재적인 오류를 발견하여 제품 출시 시간을 단축하는 데 도움을 줄 수 있습니다. (출처: Ronald_vanLoon)

인간 뇌 유사 초소형 기술, 휴머노이드 로봇에 실시간 감지 및 사고 능력 부여: 인간의 뇌 구조를 모방한 초소형 기술이 휴머노이드 로봇에게 실시간 시각 감지 및 사고 능력을 부여하기 위해 개발되고 있습니다. 이 기술은 뉴로모픽 컴퓨팅 또는 효율적인 AI 칩 설계를 포함할 수 있으며, 로봇이 복잡한 환경에서 더 빠르고 지능적인 반응을 보이도록 하는 것을 목표로 합니다. (출처: Ronald_vanLoon)

Fourier Intelligence, 자체 개발 휴머노이드 로봇 Fourier GR-1 발표: Fourier Intelligence(Fourier Robots)가 자체 개발한 휴머노이드 로봇 GR-1을 출시했습니다. 이 로봇은 첨단 모션 제어와 고도로 생체 모방적인 몸통 구조에 중점을 두어 설계되었으며, 더욱 유연하고 자연스러운 동작 능력을 구현하여 중국의 휴머노이드 로봇 분야의 발전을 보여주는 것을 목표로 합니다. (출처: Ronald_vanLoon)

Unitree G1 생체 모방 로봇 민첩성 업그레이드: Unitree 회사가 G1 생체 모방 로봇의 민첩성이 업그레이드된 버전을 선보였습니다. 이는 일반적으로 로봇의 운동 제어, 균형 능력, 환경 적응성 등이 향상되어 작업을 보다 유연하게 수행하고 복잡한 지형에 대처할 수 있게 되었음을 의미합니다. (출처: Ronald_vanLoon)

중국 휴머노이드 로봇, 품질 검사 작업 수행: 중국의 휴머노이드 로봇이 품질 검사 작업 수행에 활용되고 있습니다. 이는 휴머노이드 로봇이 산업 자동화 분야에서 점차 응용 범위를 넓혀가고 있으며, 유연성과 감지 능력을 이용하여 반복적이고 정밀도가 요구되는 검사 작업을 대체하거나 보조하고 있음을 보여줍니다. (출처: Ronald_vanLoon)

나노 로봇, ‘숨겨진 무기’ 휴대하여 암세포 사멸: 의료 기술의 새로운 진전에 따르면, 나노 로봇이 ‘숨겨진 무기’를 휴대하여 암세포를 정밀하게 표적하고 사멸시킬 수 있다고 합니다. 이 기술은 나노 로봇의 미세한 크기와 제어 가능성을 이용하여 보다 정밀하고 부작용이 적은 암 치료 방안을 실현할 것으로 기대됩니다. (출처: Ronald_vanLoon)

프라이버시 강화 기술, 현대 비즈니스에서 중요성 더욱 부각: 데이터 프라이버시 규제가 강화되고 사용자의 개인 정보 보호 의식이 높아짐에 따라 프라이버시 강화 기술(PETs)은 현대 기업에게 더욱 중요해지고 있습니다. 연합 학습, 동형 암호화 등 이러한 기술들은 데이터 프라이버시를 보호하면서 데이터 분석 및 가치 발굴을 가능하게 하여 기업의 규제 준수 발전을 돕습니다. (출처: Ronald_vanLoon)

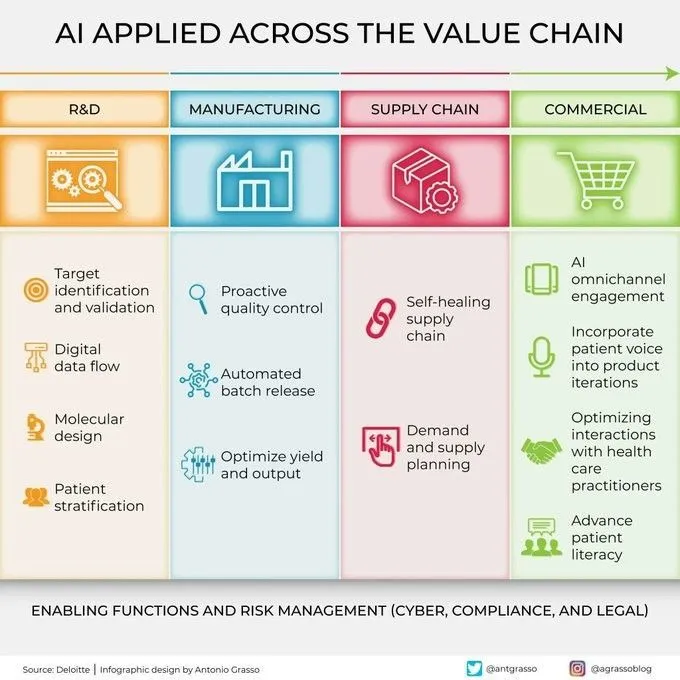

AI, 가치 사슬 각 단계에서 활용 범위 확대: 인공지능 기술은 연구 개발, 생산, 마케팅, 판매 및 애프터서비스 등 기업 가치 사슬의 모든 단계에서 광범위하게 활용되고 있습니다. 데이터 분석, 예측 모델링, 자동화 프로세스 등을 통해 AI는 기업이 운영 효율성을 최적화하고 고객 경험을 향상시키며 새로운 비즈니스 가치를 창출하는 데 도움을 줍니다. (출처: Ronald_vanLoon)

🧰 툴

KernelSU: 커널 기반 안드로이드 Root 솔루션: KernelSU는 안드로이드 기기를 위해 설계된 커널 기반 Root 솔루션입니다. 커널 수준의 su 및 Root 접근 관리를 제공하며, OverlayFS 기반 모듈 시스템과 애플리케이션 프로필 기능을 갖추고 있어 기기 권한을 더 깊이 제어하는 것을 목표로 합니다. 이 프로젝트는 안드로이드 GKI 2.0 기기(커널 5.10+)를 지원하며, 구형 커널(4.14+, 수동 컴파일 필요)과도 호환됩니다. 또한 WSA, ChromeOS 및 컨테이너화된 안드로이드 환경을 지원합니다. (출처: GitHub Trending)

Sunshine: 자체 호스팅 게임 스트리밍 호스트, Moonlight 호환: Sunshine은 오픈 소스 자체 호스팅 게임 스트리밍 호스트 소프트웨어로, 사용자가 PC 게임 화면을 Moonlight와 호환되는 다양한 기기로 스트리밍할 수 있게 해줍니다. AMD, Intel, Nvidia GPU의 하드웨어 인코딩을 지원하며, 소프트웨어 인코딩 옵션도 제공하여 저지연 클라우드 게임 경험을 목표로 합니다. 사용자는 Web UI를 통해 구성 및 클라이언트 페어링을 할 수 있습니다. (출처: GitHub Trending)

Tasmota: ESP8266/ESP32 기기용 오픈 소스 대체 펌웨어: Tasmota는 ESP8266 및 ESP32 칩 기반 스마트 기기를 위해 설계된 대체 펌웨어입니다. 사용하기 쉬운 웹 사용자 인터페이스를 통해 구성할 수 있으며, OTA 온라인 업그레이드를 지원하고, 타이머 또는 규칙을 통해 자동화를 구현할 수 있습니다. 또한 MQTT, HTTP, 시리얼 또는 KNX 프로토콜을 통해 완전한 로컬 제어가 가능하여 기기의 확장성과 사용자 정의 가능성을 향상시킵니다. (출처: GitHub Trending)

Limbo: SQLite의 현대적인 Rust 진화 버전 프로젝트: Limbo 프로젝트는 Rust 언어를 사용하여 SQLite의 현대적인 진화 버전을 구축하는 것을 목표로 합니다. Linux에서 io_uring 비동기 I/O를 지원하며, SQLite의 SQL 방언, 파일 형식 및 C API와 호환됩니다. 또한 JavaScript/WASM, Rust, Go, Python 및 Java와 같은 언어 바인딩을 제공합니다. 향후 벡터 검색 통합, 동시 쓰기 개선 및 스키마 관리 등의 기능을 계획하고 있습니다. (출처: GitHub Trending)

Ventoy: 차세대 부팅 가능 USB 솔루션: Ventoy는 부팅 가능한 USB 드라이브를 만드는 오픈 소스 도구로, ISO, WIM, IMG, VHD(x), EFI 등 다양한 형식의 이미지 파일에서 직접 부팅할 수 있도록 지원하며 USB 드라이브를 반복적으로 포맷할 필요가 없습니다. 사용자는 이미지 파일을 USB 드라이브에 복사하기만 하면 Ventoy가 자동으로 부팅 메뉴를 생성합니다. 다양한 운영 체제와 부팅 모드(Legacy BIOS, UEFI)를 지원하며 MBR 및 GPT 파티션과 호환됩니다. (출처: GitHub Trending)

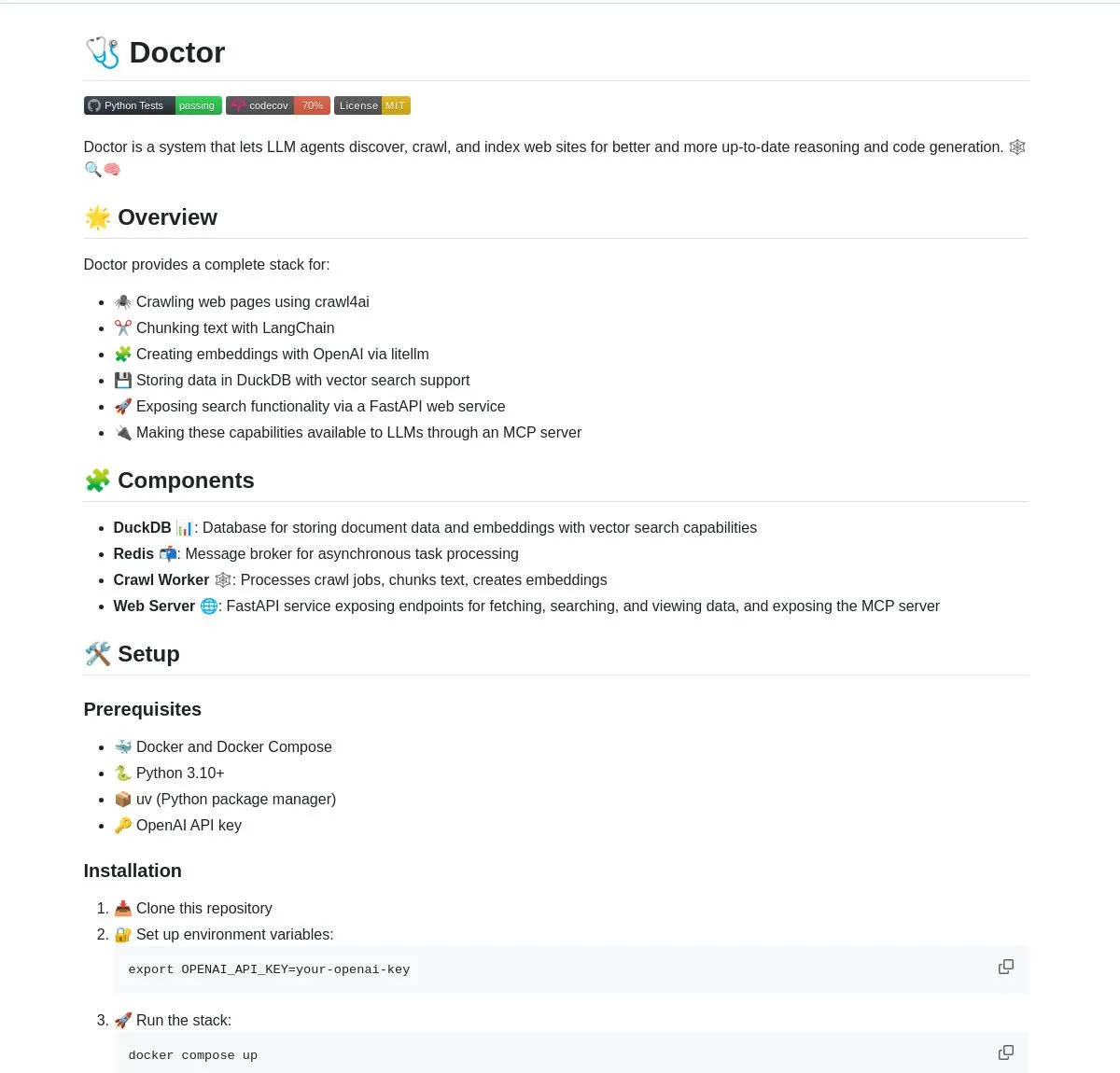

Doctor: LangChain 기반 LLM 에이전트 웹 크롤링 및 이해 도구: Doctor는 LLM 에이전트가 웹 콘텐츠를 실시간으로 크롤링하고 이해하도록 돕는 도구입니다. 웹 페이지 처리, 벡터 검색 및 LangChain의 문서 처리 기능을 결합하고 FastAPI를 통해 서비스를 제공합니다. 사용자는 Doctor를 활용하여 AI 애플리케이션의 정보 수집 및 분석 능력을 향상시킬 수 있습니다. (출처: LangChainAI, Hacubu)

Deep Research Agent: 로컬 실행 개인 정보 보호형 AI 연구 에이전트: 개인 정보 보호에 중점을 둔 오픈 소스 AI 에이전트로, 로컬에서 실행하여 모든 주제를 연구할 수 있습니다. LangGraph를 사용하여 반복적인 연구 워크플로우를 구동하며, 사용자에게 강력한 로컬화된 연구 도구를 제공하여 데이터를 클라우드에 업로드할 필요가 없습니다. (출처: LangChainAI, Hacubu)

스마트 터미널 어시스턴트: 자연어를 커맨드 라인으로 변환하는 멀티 OS 도구: 자연어 명령을 여러 운영 체제에서 사용 가능한 터미널 명령으로 변환하는 스마트 터미널 어시스턴트입니다. 이 도구는 LangGraph의 다중 에이전트 시스템을 기반으로 구축되었으며, A2A 및 MCP 프로토콜을 사용하여 플랫폼 간 실행을 구현하여 커맨드 라인 작업을 단순화하고 사용자 진입 장벽을 낮추는 것을 목표로 합니다. (출처: LangChainAI)

Montelimar: 오픈소스 온디바이스 OCR 툴킷: Julien Blanchon이 오픈소스 온디바이스 OCR(광학 문자 인식) 툴킷인 Montelimar를 출시했습니다. 화면을 캡처하고 화면 각 부분에 OCR을 적용할 수 있으며, Nougat 및 OCRS 모델과 호환됩니다. 백엔드는 각각 Rust(OCRS)와 MLX(Nougat)를 사용합니다. 이 도구는 LaTeX, 표, Markdown(Nougat 사용, 느림) 및 일반 텍스트(OCRS 사용, 빠름)를 출력할 수 있으며, 히스토리 및 시스템 수준 단축키 기능을 제공합니다. (출처: awnihannun)

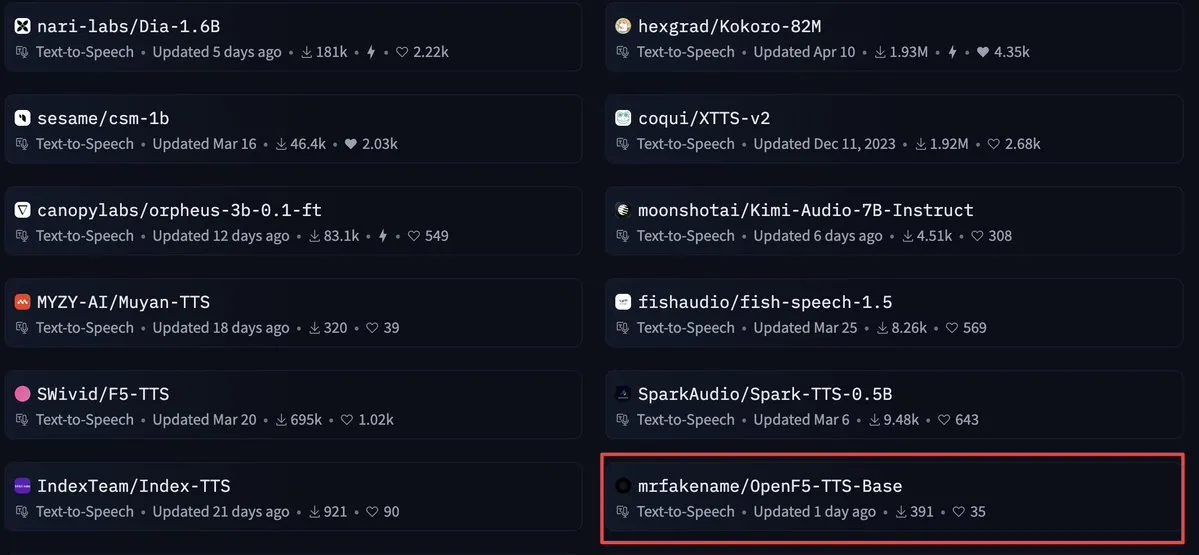

OpenF5 TTS: Apache 2.0 라이선스의 상업용 텍스트 음성 변환 모델: OpenF5 TTS는 F5-TTS 모델을 재훈련한 텍스트 음성 변환 모델로, Apache 2.0 오픈 소스 라이선스를 채택하여 상업적 목적으로 사용할 수 있습니다. 이 모델은 현재 Hugging Face의 텍스트 음성 변환 모델 중에서 인기가 높으며, 개발자에게 고품질의 상업용 음성 합성 옵션을 제공합니다. (출처: ClementDelangue)

Tensor Slayer: 훈련 없이 직접 모델 성능을 향상시키는 도구: Tensor Slayer는 미세 조정, 데이터셋, 추가 계산 비용 또는 훈련 시간 없이 직접 텐서 패치(direct tensor patching) 방식을 통해 모델 성능을 25% 향상시킬 수 있다고 주장하는 새로 출시된 도구입니다. 이 개념은 매우 혁신적이며 AI 모델 개선을 대중화하는 것을 목표로 합니다. (출처: TheZachMueller)

Photoshop, 로컬 컴퓨터 프록시(c/ua) 사용하여 코드 없는 작업 실현: Computer Use Agents (c/ua)는 사용자 프롬프트, 모델 선택, Docker 및 적절한 프록시 루프를 통해 Photoshop에서 코드 없는 작업을 어떻게 실현할 수 있는지 보여줍니다. 이는 일반 사용자가 복잡한 소프트웨어를 사용하는 장벽을 낮추고 AI 프록시를 통해 작업 흐름을 단순화하는 것을 목표로 합니다. (출처: Reddit r/artificial)

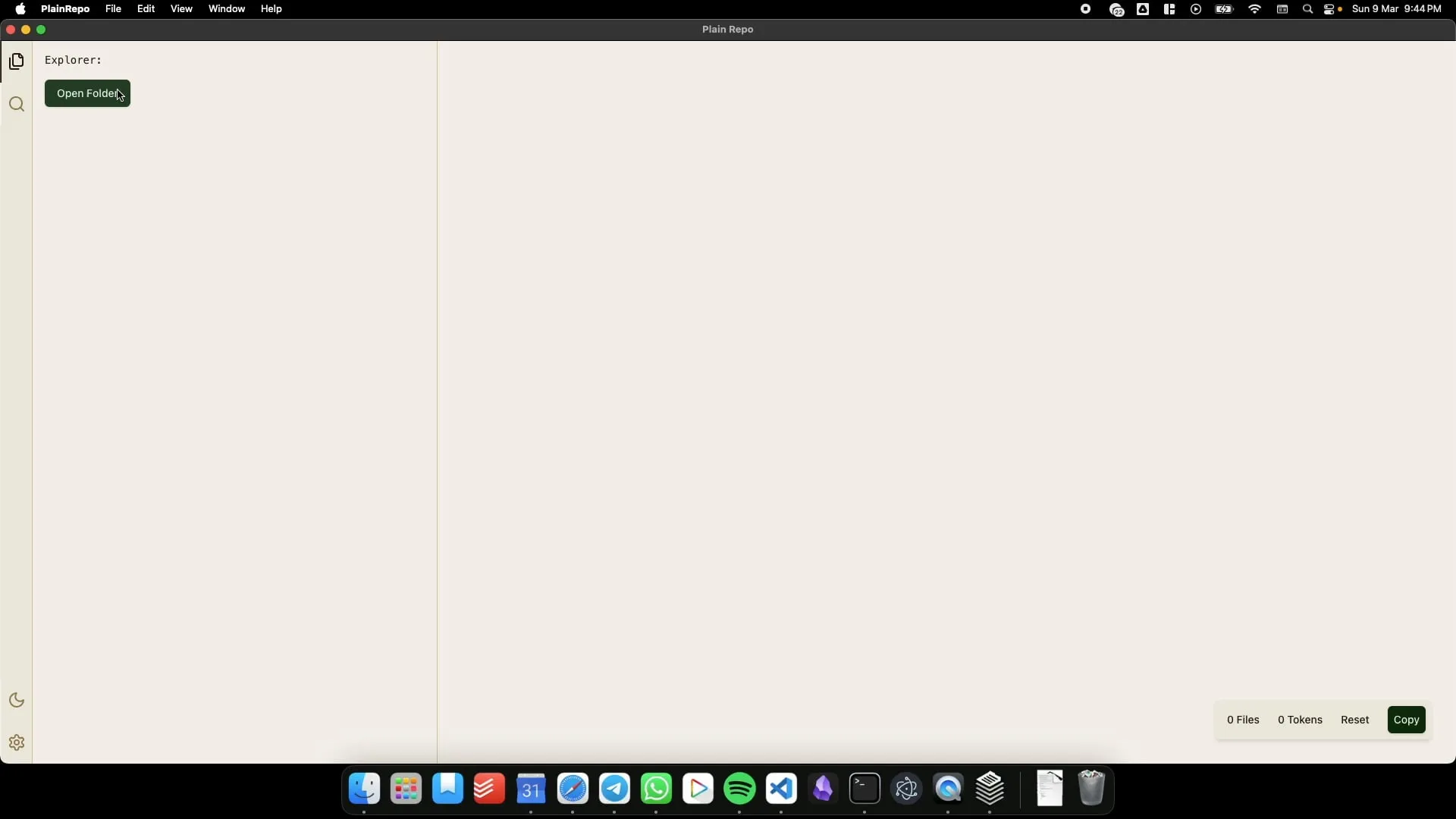

PlainRepo: 오프라인 애플리케이션, LLM 컨텍스트 추출을 위해 대량 코드/텍스트 선택적 복사: PlainRepo는 사용자가 대량의 코드 또는 텍스트 조각을 선택적으로 복사하여 로컬 LLM이 컨텍스트 정보를 추출할 수 있도록 하는 무료 오픈 소스 오프라인 애플리케이션입니다. 이는 네트워크 연결 없이 또는 개인 정보 보호를 위해 로컬 LLM을 사용해야 하는 사용자에게 매우 유용합니다. (출처: Reddit r/LocalLLaMA, Plus-Garbage-9710)

M0D.AI: 사용자와 AI가 5개월간 협력하여 만든 개인화된 AI 상호작용 제어 프레임워크: 사용자 James O’Kelly는 AI(예: Gemini, ChatGPT)와 5개월 동안 약 13,000번의 대화를 통해 깊이 협력하여 M0D.AI라는 고도로 맞춤화된 AI 상호작용 및 제어 프레임워크를 구축했습니다. 이 시스템에는 Python 백엔드, Flask 웹 서버, 동적 프론트엔드 UI 및 AI 행동을 모니터링하고 안내하는 mematrix.py라는 메타인지 계층이 포함되어 있습니다. M0D.AI는 프로그래밍 배경이 없는 사용자가 AI 지원을 통해 복잡한 소프트웨어 시스템을 어떻게 설계하고 개발할 수 있는지 보여줍니다. (출처: Reddit r/artificial)

📚 학습

LLM 엔지니어링: 8주 만에 AI와 LLM 마스터하기 과정 자료 저장소: ‘LLM Engineering – Master AI and LLMs’라는 8주 과정은 수강생들이 대규모 언어 모델 엔지니어링을 마스터하도록 돕는 것을 목표로 합니다. 과정과 함께 제공되는 GitHub 저장소는 매주 프로젝트 코드, 설정 가이드(PC, Mac, Linux) 및 Colab 링크를 제공합니다. 이 과정은 Ollama를 설치하여 Llama 3.2를 실행하는 것부터 시작하여 HuggingFace, API 사용, 모델 미세 조정 등의 내용을 점진적으로 심층적으로 다루며 실습을 강조합니다. 또한 Ollama를 OpenAI 등 유료 API의 무료 대체재로 사용하는 지침도 제공합니다. (출처: GitHub Trending)

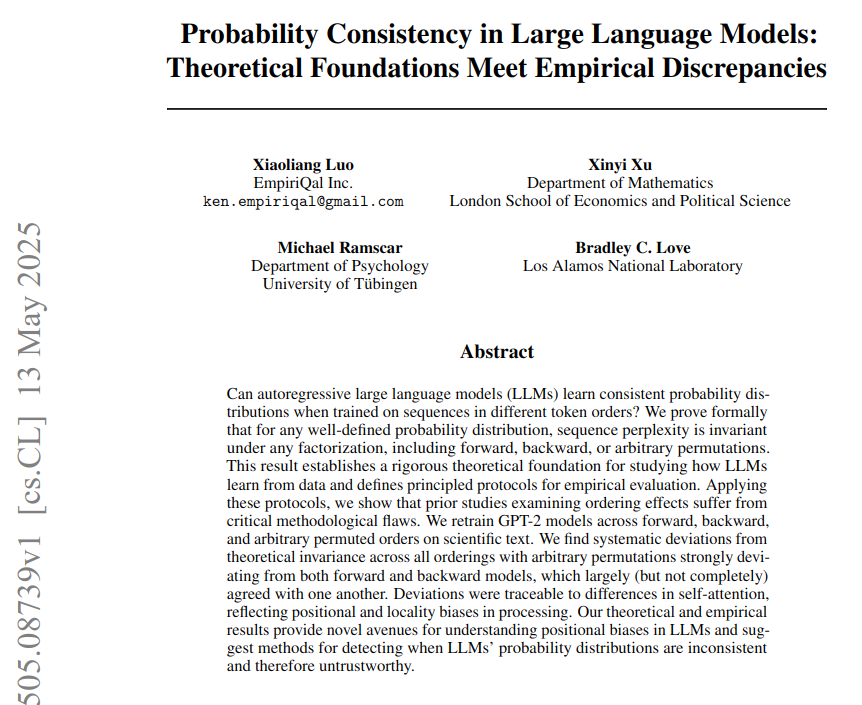

LLM에서의 확률적 일관성: 이론적 기초와 실증적 차이 연구: ‘LLM에서의 확률적 일관성: 이론적 기초와 실증적 차이’라는 제목의 논문은 대규모 언어 모델(LLM)이 고정된 전략을 사용하여 토큰 확률을 계산하지만, 실제 모델은 서로 다른 토큰 순서에서 이론적인 확률적 일관성과 편차를 보인다고 지적합니다. 연구는 신경과학 텍스트에서 GPT-2 모델을 훈련(순방향, 역방향 및 치환된 토큰 순서 사용)하여 퍼플렉서티가 이론적으로 순서와 무관함을 증명했지만, 실증적으로는 모델이 아키텍처 편향으로 인해 이 테스트를 통과하지 못했음을 보여줍니다. 어텐션 편향(지역적 및 장거리)이 관찰된 일관성 실패의 직접적인 원인으로 간주됩니다. (출처: menhguin)

BoldVoice, 머신러닝 활용하여 영어 악센트 강도 정량화 및 지도: BoldVoice 애플리케이션은 머신러닝과 잠재 공간 기술을 사용하여 영어 악센트 강도를 정량화하고 사용자에게 발음 지도를 제공합니다. 이 방법은 사용자가 영어 발음과 악센트를 보다 효과적으로 개선하는 데 도움을 주는 것을 목표로 합니다. (출처: dl_weekly)

Milvus 블로그: 프로덕션 환경에서 높은 재현율을 유지하면서 효율적인 메타데이터 필터링의 과제와 최적화: Milvus는 프로덕션 환경의 벡터 검색에서 효율적인 메타데이터 필터링을 수행하면서 높은 재현율을 유지하는 방법에 대해 논의하는 실용적인 블로그 게시물을 발표했습니다. 이 글은 관련된 과제를 논의하고 최적화 전략을 제안합니다. (출처: dl_weekly)

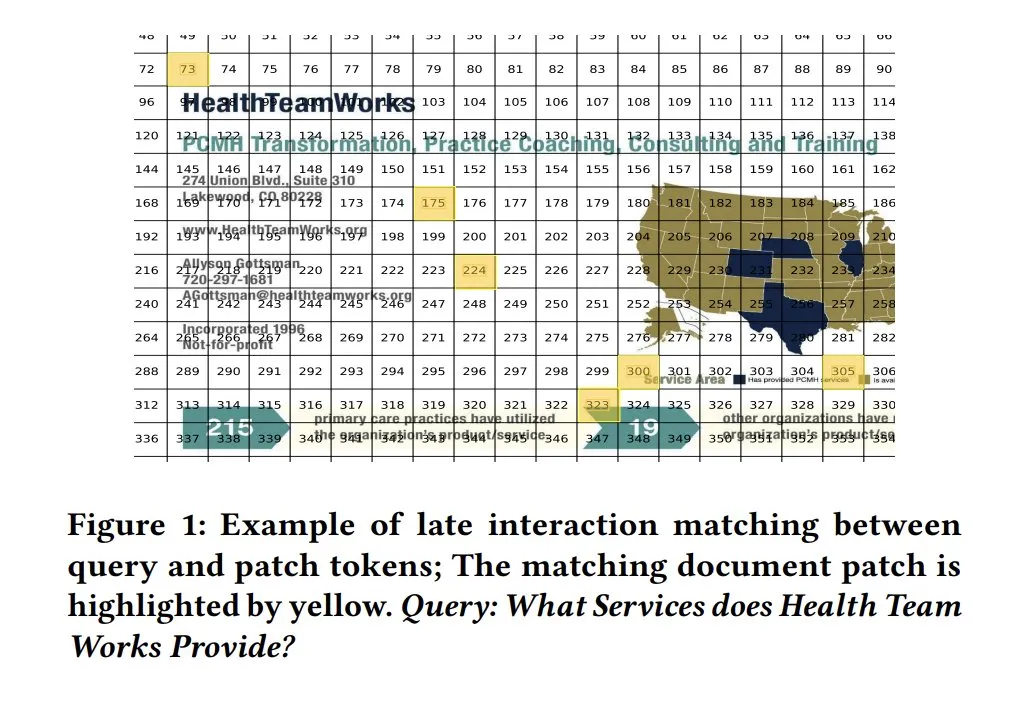

모델 해석 가능성을 위한 ColPali 유사도 맵: ColPali와 같은 시각적 문서 검색 모델의 유사도 맵(similarity maps)은 쿼리와 문서 조각 수준의 매칭에 대한 강력한 해석 가능성을 제공합니다. 히트맵 등의 방식을 통해 어떤 이미지 영역이 쿼리와 관련이 있는지 시각화함으로써 모델의 의사 결정 과정을 이해하는 데 도움이 됩니다. Tony Wu가 관련 빠른 시작 가이드를 제공합니다. (출처: lateinteraction, tonywu_71, lateinteraction)

soarXiv: 인간 지식을 탐구하는 아름다운 방법: Jinay가 과학 논문을 더욱 미학적이고 상호작용적인 방식으로 탐색할 수 있도록 설계된 플랫폼 soarXiv를 출시했습니다. 사용자는 ArXiv 논문 URL에서 ‘arxiv’를 ‘soarxiv’로 바꾸면 우주 성도와 같은 인터페이스에서 해당 논문을 찾아보고 탐색할 수 있습니다. 이 플랫폼에는 2025년 4월까지의 280만 편의 논문이 내장되어 있습니다. (출처: menhguin)

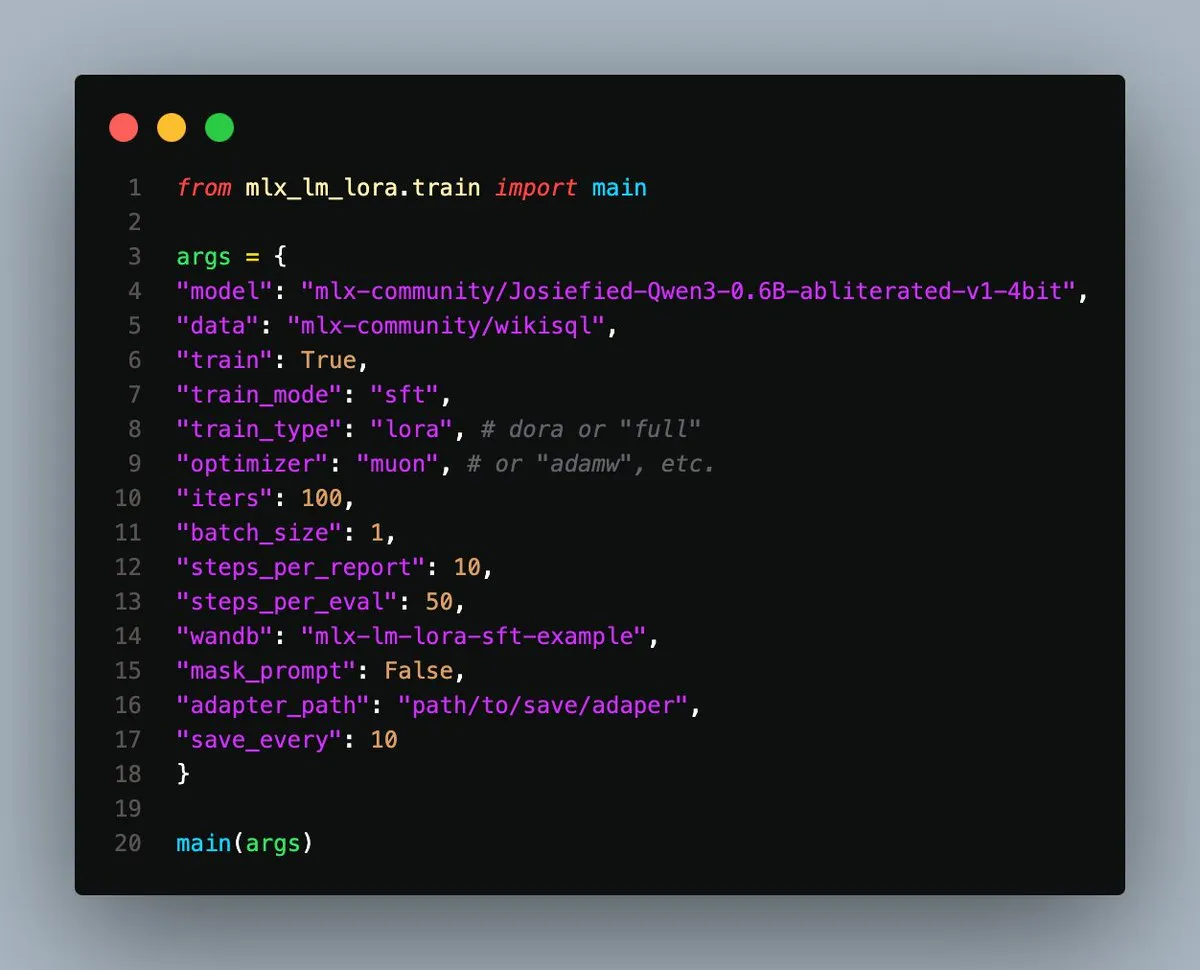

MLX-LM-LoRA v0.3.3 출시, Apple Silicon 로컬 미세 조정 간소화: Gökdeniz Gülmez가 MLX-LM-LoRA v0.3.3 버전을 출시하여 Apple Silicon에서 로컬 모델 미세 조정 과정을 더욱 간소화하고 유연하게 만들었습니다. 새 버전은 훈련 구성 또는 명령줄에서 직접 훈련 에포크(epochs)를 설정할 수 있도록 지원하며, 기본 미세 조정 및 DPO를 사용한 고급 선호도 훈련 사례를 포함한 예제 스크립트와 노트북을 제공하여 약 20줄의 코드만으로 시작할 수 있습니다. (출처: awnihannun)

시스템 프롬프트 유출 분석: 주류 LLM 내부 아키텍처 및 행동 규칙 공개: Simbaproduz는 GitHub에 최근 유출된 주요 대규모 언어 모델(예: Claude 3.7, ChatGPT-4o, Grok 3, Gemini 등)의 시스템 프롬프트 유출 사건을 종합적으로 분석한 프로젝트를 게시했습니다. 이 가이드는 이러한 모델의 내부 아키텍처, 운영 논리 및 행동 규칙(정보 지속성, 이미지 처리 전략, 웹 탐색 방식, 개인화 시스템 및 적대적 조작 방어 메커니즘 등)을 심층적으로 탐구합니다. 이러한 정보는 LLM 도구, 에이전트 및 평가 시스템 구축에 중요한 참고 자료가 됩니다. (출처: Reddit r/MachineLearning)

ICML 2025 논문, 이미지 적대적 교란의 주파수 영역 분해 논의: 중국과학원대학과 계산기술연구소의 ICML 2025 Spotlight 논문 《Diffusion-based Adversarial Purification from the Perspective of the Frequency Domain》은 적대적 교란이 이미지의 고주파 진폭 및 위상 스펙트럼을 파괴하는 경향이 더 크다고 제안합니다. 이를 바탕으로 연구자들은 확산 모델의 역방향 과정에서 원본 샘플의 저주파 정보를 사전 정보로 주입하여 깨끗한 샘플 생성을 유도함으로써 적대적 교란을 효과적으로 제거하고 이미지의 의미론적 내용을 보존하는 방법을 제안했습니다. (출처: WeChat)

ICML 2025 논문 TokenSwift: ‘자동 완성’ 통해 100K 수준 장문 텍스트 생성 3배 가속: BIGAI NLCo 팀은 ICML 2025에서 《TokenSwift: Lossless Acceleration of Ultra Long Sequence Generation》 논문을 발표하여 100K 토큰 수준의 장문 텍스트 추론을 위한 무손실 고효율 가속 프레임워크 TokenSwift를 제안했습니다. 이 프레임워크는 다중 토큰 병렬 초안 작성, n-gram 휴리스틱 완성, 트리 구조 병렬 검증 및 동적 KV 캐시 관리 등의 메커니즘을 통해 원본 모델 출력의 일관성을 유지하면서 3배 이상의 추론 가속을 실현하여 초장문 시퀀스 생성 효율을 크게 향상시켰습니다. (출처: WeChat)

💼 비즈니스

OpenAI, 과거 경고했던 AI 군비 경쟁 조장 비판 받아: 블룸버그 기사는 OpenAI가 ChatGPT 출시 후 AI 위험을 경계하던 조직에서 AI 기술 경쟁을 주도하는 핵심 역할로 어떻게 전환했는지 탐구합니다. 이 기사는 OpenAI의 전략적 전환, 상업화 압력, 그리고 그들의 행동이 전체 AI 산업 발전 방향과 안전 고려 사항에 미치는 영향을 분석했을 가능성이 있습니다. (출처: Reddit r/ArtificialInteligence)

트럼프 행정부, 하버드 대학 약 30억 달러 연구 자금 지원 중단, 글로벌 인재 쟁탈전 촉발: 트럼프 행정부가 하버드 대학의 약 30억 달러에 달하는 연구 자금 지원을 중단했으며, 이는 350개 이상의 프로젝트에 영향을 미쳐 미국 연구 시스템에 큰 타격을 준 것으로 간주됩니다. 동시에 유럽 연합, 캐나다, 호주 등 국가 및 지역에서는 수천만 달러 규모의 지원 계획을 발표하여 영향을 받은 미국 최고 과학자들을 유치하려 하고 있어 글로벌 연구 인재 유동에 대한 논의를 불러일으키고 있습니다. 하버드 대학은 소송을 제기하고 위기 완화를 위해 자체적으로 2억 5천만 달러를 배정했습니다. (출처: WeChat)

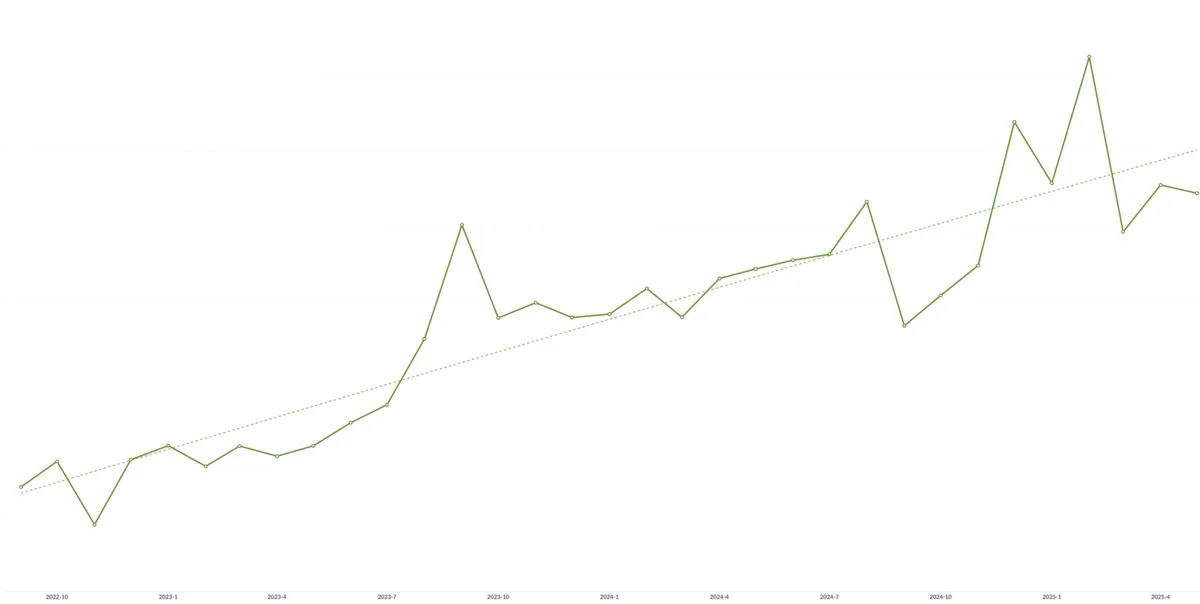

AI 스타트업 Spellbook, 3년 연속 평균 계약 가치(ACV) 지속 성장: AI 기술의 상품화가 가격 압력을 유발할 수 있다는 우려에도 불구하고, AI 법률 소프트웨어 스타트업 Spellbook의 공동 창업자 Scott Stevenson은 자사의 평균 계약 가치(ACV)가 3년 연속 성장했다고 밝혔습니다. 그는 빠르게 움직이는 팀이 AI 제품을 통해 지속적으로 새로운 가치를 창출함으로써 잠재적인 가격 하락 압력을 상쇄할 수 있다고 생각합니다. (출처: scottastevenson)

🌟 커뮤니티

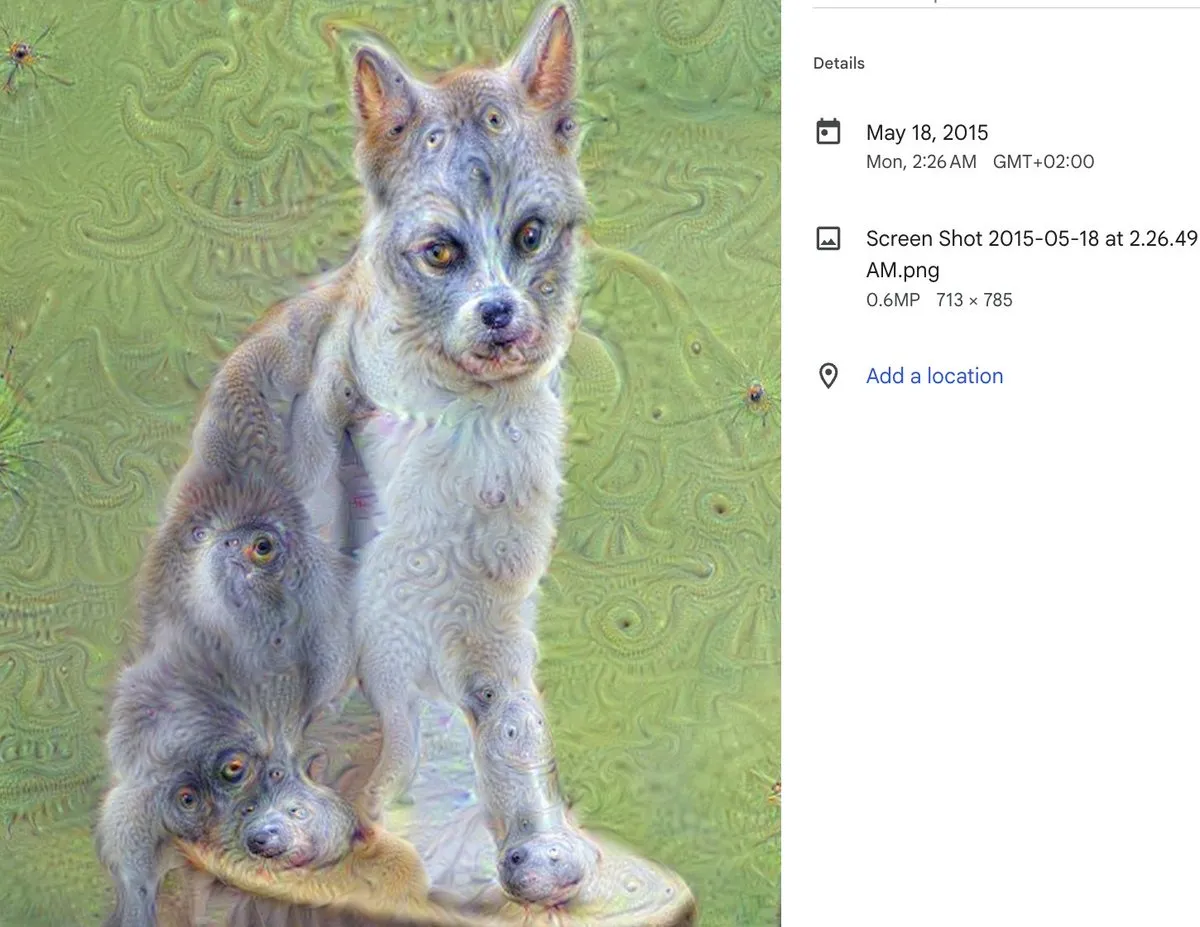

DeepDream 10주년: AI 예술의 이정표와 그 심오한 영향: DeepDream의 창작자 Alex Mordvintsev가 10년 전 이 현상적인 AI 예술 도구의 탄생을 회고했습니다. Runway의 공동 창업자 Cristóbal Valenzuela도 DeepDream이 어떻게 그에게 AI 예술 분야에 뛰어들도록 영감을 주었고 결국 Runway를 공동 창립하게 되었는지 공유했습니다. DeepDream의 등장은 AI가 예술 창작 분야에서 잠재력을 초기에 보여준 이정표였으며, 후속 생성 예술 및 AI 콘텐츠 제작 도구 발전에 심오한 영향을 미쳤습니다. (출처: c_valenzuelab)

AI에 기술 공동 창업자가 필요한지에 대한 열띤 토론: 소셜 미디어에서 “초기 VC들이 창업자들에게 더 이상 기술 공동 창업자가 필요 없으며, 제품 관리자와 AI만으로 제품을 구축할 수 있다고 조언한다”는 논의가 있었습니다. 이 관점은 광범위한 논란을 불러일으켰으며, Danielle Fong 등은 이에 대해 동의하지 않으며 AI가 현재 기술 창업자의 핵심 역할과 심층적인 기술 이해를 완전히 대체할 수 없음을 시사했습니다. (출처: jonst0kes)

AI 환각 문제 토론: 기술적 원인과 대응 전략: 커뮤니티에서 AI 언어 모델(예: ChatGPT, Claude 등)이 ‘환각’(자신 있게 허위 또는 조작된 정보를 생성하는 것)을 일으키는 문제에 대해 열띤 토론이 벌어졌습니다. 토론의 주요 내용은 환각의 기술적 근원(예: 어텐션 메커니즘 결함, 훈련 데이터 노이즈, 모델의 실제 세계 기반 부족 등), RAG 또는 미세 조정으로 근절할 수 있는지 여부, 사용자가 LLM 출력을 어떻게 신중하게 다루어야 하는지, 개발자가 창의성과 사실 정확성 사이에서 어떻게 균형을 이루어야 하는지 등입니다. 모든 LLM 출력은 잠재적인 환각으로 간주되어야 하며 사용자가 직접 검증해야 한다는 의견도 있었습니다. (출처: Reddit r/ArtificialInteligence)

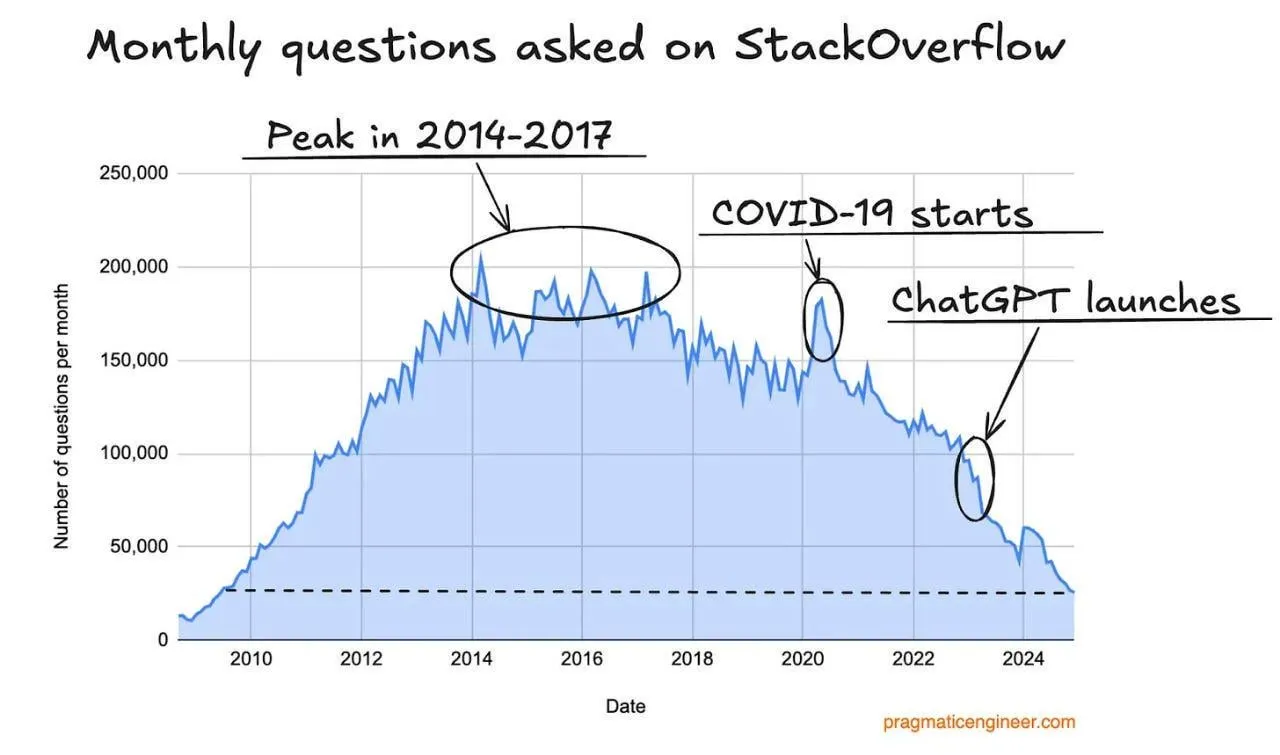

Stack Overflow 트래픽 감소, AI 프로그래밍 도우미 영향 가능성: 한 사용자가 Stack Overflow 웹사이트 트래픽이 감소하는 추세를 관찰하고, 이것이 ChatGPT와 같은 AI 프로그래밍 도우미의 등장과 관련이 있을 수 있다고 추측했습니다. 개발자들이 코드 조각과 해결책을 얻기 위해 점점 더 AI에 직접 질문하면서 전통적인 질의응답 커뮤니티에 대한 의존도가 줄어들고 있습니다. 댓글에서 사용자들은 일반적으로 AI 도우미가 답변의 직접성, 커뮤니티의 부정적인 감정 회피 측면에서 더 유리하다고 평가했지만, AI가 기존 데이터에 과도하게 의존하면 미래의 훈련 데이터가 고갈될 수 있다는 우려도 표명했습니다. (출처: Reddit r/ArtificialInteligence)

LLM 엔지니어링 과정 강사, 학습 경험 및 자료 공유: LLM 엔지니어링 과정의 강사인 Ed Donner가 자신의 과정 교육 철학과 자료를 공유하며, 실습(DOING)을 통한 학습의 중요성을 강조했습니다. 그는 학생들이 적극적으로 코드를 다루도록 격려하고, PC, Mac, Linux용 설정 가이드와 Google Colab 노트북 링크를 제공하여 학생들이 다양한 환경에서 학습하고 실험할 수 있도록 했습니다. 과정 내용은 Ollama, HuggingFace, API 사용 등을 다루며, 로컬 모델을 유료 API의 대체재로 사용하는 방안도 제공합니다. (출처: ed-donner)

사용자 경험 공유: Claude를 활용한 사고 및 소통 능력 향상: 한 Claude Pro 사용자가 AI와의 상호작용이 자신의 사고 방식과 소통 기술을 개선하는 데 어떻게 도움이 되었는지 경험을 공유했습니다. Claude와의 상호작용을 통해 사용자는 문제 해결 시 자신에게 더 나은 ‘프롬프트’를 제공하고 핵심 문제를 식별하는 방법을 배웠으며, 동료와 소통할 때 명확한 표현과 역지사지에 더 중점을 두게 되어 AI 보조 도구가 개인의 인지 및 표현 능력 향상에 긍정적인 역할을 한다는 것을 인식하게 되었습니다. (출처: Reddit r/ClaudeAI)

‘판별자-생성자 격차’가 AI 과학 혁신의 핵심 개념일 수도: Jason Wei는 ‘판별자-생성자 격차’(Discriminator-generator gap)가 AI의 과학 혁신에서 가장 중요한 아이디어일 수 있다고 제안했습니다. 충분한 계산 능력, 독창적인 검색 전략, 명확한 측정 기준이 있다면 AI는 측정 가능한 모든 것을 최적화할 수 있습니다. 이 개념은 생성자가 해결책을 제안하고 판별자가 우수성을 평가하는 반복적인 과정을 통해 혁신을 주도하는 것을 강조하며, 특히 신속하게 검증 가능하고 지속적인 보상이 있으며 확장 가능한 환경에 적합합니다. (출처: _jasonwei, dotey)

AI 시대 제품 관리자의 전환과 도전: 소셜 미디어에서 AI가 제품 관리자 직무에 미치는 영향에 대한 논의가 있었습니다. 향후 18개월 동안 제품 관리자 업계가 변화에 직면할 것이며, 사용자 요구를 이해하지 못하는 PM은 도태될 수 있다는 의견이 제시되었습니다. AI 도구(예: AI Agents)는 짧은 시간 안에 아이디어를 제품으로 구현할 수 있지만, 진정한 어려움은 사용자의 핵심적인 문제점을 찾아내고 정확한 해결책을 제공하는 데 있습니다. 이 직무는 궁극적으로 문서와 프로토타입 제작 능력보다는 사용자의 문제와 해결책을 얼마나 잘 연결하고 이해하는지에 따라 경쟁력이 결정될 것입니다. (출처: dotey)

AI 안전 역설: 초지능이 방어 측에 더 유리할 수도: Richard Socher는 ‘AI 안전 역설’을 제기했습니다. 합리적인 가정 하에서 초지능의 등장은 실제로 생물학적 또는 사이버 전쟁에서 방어 측에 더 유리할 수 있다는 것입니다. 지능의 한계 비용이 낮아짐에 따라 레드팀 훈련을 통해 더 많은 공격 벡터를 발견하고 시스템을 강화하거나 면역화하여 모든 관련 공격 경로를 커버할 수 있습니다. 이론적으로 방어 비용이 0에 가까워지면 시스템은 완전히 면역될 수 있습니다. 이 관점은 AI 발전이 공격과 방어의 비대칭성을 심화시킬 것이라는 전통적인 견해에 도전합니다. (출처: RichardSocher)

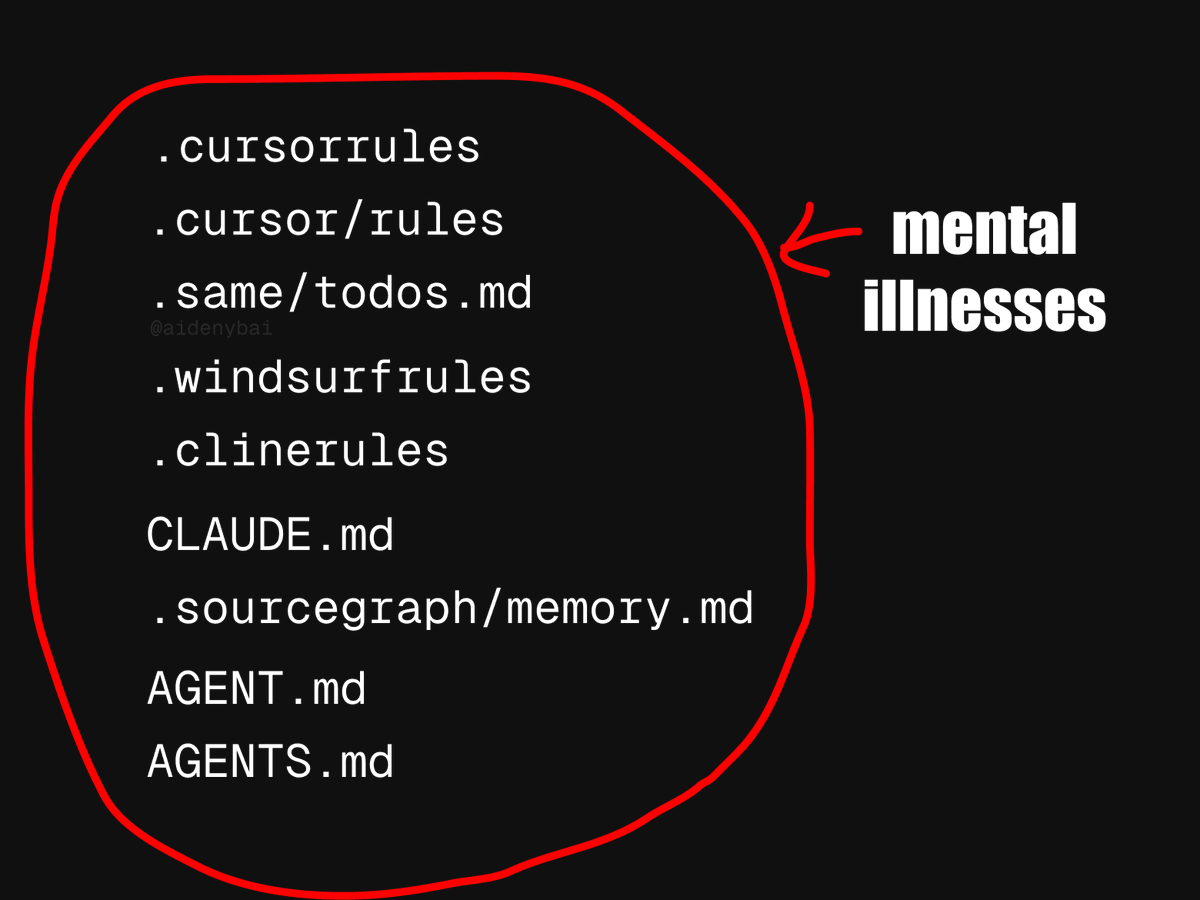

AI Agent 적용 표준 논쟁: CONTRIBUTING.md가 더 나은 관행일 수도: 현재 9가지 AI Agent 규칙 경쟁 표준이 등장한 현상에 대해, 한 개발자는 프로젝트의 CONTRIBUTING.md 파일을 직접 사용하여 AI Agent의 행동을 규제하는 것이 낫다고 제안했습니다. 이 파일에는 일반적으로 코드 스타일 가이드, 관련 참고 자료 및 컴파일 조각 등의 정보가 이미 포함되어 있어 AI Agent 규칙의 자연스러운 매개체가 될 수 있으며, 중복된 노력을 피할 수 있습니다. (출처: JayAlammar)

💡 기타

고전 교재 《함수 해석학》 저자 Peter Lax, 99세로 별세: 수학계의 거장이자 최초로 아벨상을 수상한 응용수학자 Peter Lax가 99세의 나이로 별세했습니다. Lax 교수는 그가 편찬한 고전 교재 《함수 해석학》으로 유명하며, 편미분 방정식, 유체 역학, 수치 계산 등 분야에서 Lax 등가 정리, Lax-Friedrichs/Lax-Wendroff 방법 등과 같은 기초적인 공헌을 했습니다. 그는 또한 컴퓨터 기술을 수학 분석에 최초로 적용한 선구자 중 한 명으로, 그의 연구는 과학 연구와 공학 실무에 깊은 영향을 미쳤습니다. (출처: WeChat)

AI 취업: AI 에이전트, OpenAI Operator 사용하여 한 번에 수천 개 일자리에 지원해 논란: 한 영상에서 AI 에이전트가 OpenAI의 Operator 도구를 이용하여 한 번의 클릭으로 1,000개의 직무에 지원하는 모습이 공개되었습니다. 이 현상은 AI가 채용 분야에서 이력서 필터링, 면접 일정 조율, 심지어 초기 면접 진행 등의 가능성을 포함하여 AI 적용에 대한 논의를 불러일으켰으며, 이러한 자동화가 구직자와 채용 담당자에게 미치는 영향에 대한 관심도 커지고 있습니다. (출처: Reddit r/ChatGPT)

MIT, AI 관련 경제학 논문 철회, AI 대필 및 데이터 의혹: MIT 경제학과는 박사 과정 학생이 작성한 ‘인공지능, 과학적 발견 및 제품 혁신’이라는 제목의 논문을 철회했습니다. 학교 측이 논문 데이터의 신뢰성에 대한 확신이 부족했기 때문입니다. 커뮤니티에서는 해당 논문의 상당 부분이 AI에 의해 작성되었을 가능성을 제기하며, 학술 연구에서 AI 사용의 윤리 및 품질 관리에 대한 논의를 촉발했습니다. (출처: Reddit r/ArtificialInteligence)