키워드:제미니 모델, 미스트랄 AI, 엔비디아 네모, LTX 비디오, 사파리 브라우저, RTX 5060, AI 에이전트, 강화 학습 미세 조정, 제미니 네이티브 이미지 생성, 미스트랄 미디움 3 프로그래밍 성능, 네모 프레임워크 2.0 모듈화, DiT 실시간 비디오 생성, AI 기반 검색 개조

🔥 포커스

Google Gemini 네이티브 이미지 생성 기능 업그레이드, 시각적 품질 및 텍스트 렌더링 정확도 향상: Google은 Gemini 모델의 네이티브 이미지 생성 기능에 대한 중요 업데이트를 발표했으며, 새 버전 “gemini-2.0-flash-preview-image-generation”이 Google AI Studio 및 Vertex AI에 출시되었습니다. 이번 업그레이드를 통해 이미지의 시각적 품질과 텍스트 렌더링 정확도가 크게 향상되었으며 지연 시간도 단축되었습니다. 새로운 기능은 이미지 요소 융합, 실시간 편집(예: 객체 추가, 부분 콘텐츠 수정) 및 Gemini 2.0 Flash와의 결합을 통해 AI가 자율적으로 구상하고 이미지를 생성하는 것을 지원합니다. 사용자는 Google AI Studio에서 무료로 체험할 수 있으며, API 호출 가격은 이미지당 0.039달러입니다. 눈에 띄는 발전에도 불구하고 일부 사용자는 전반적인 효과가 여전히 GPT-4o에 비해 다소 떨어진다고 평가합니다. (출처: 量子位)

Mistral AI, Mistral Medium 3 출시, 프로그래밍 및 멀티모달에 중점, 비용 대폭 절감: 프랑스 AI 스타트업 Mistral AI가 최신 멀티모달 모델 Mistral Medium 3를 출시했습니다. 이 모델은 프로그래밍 및 STEM 작업에서 뛰어난 성능을 보이며, 여러 벤치마크 테스트에서 Claude Sonnet 3.7의 90%에 달하거나 이를 능가하는 성능을 달성했으며 비용은 1/8(입력 0.4달러/백만 토큰, 출력 2달러/백만 토큰)에 불과하다고 합니다. Mistral Medium 3는 하이브리드 배포, 맞춤형 후속 학습 및 기업 도구와의 통합과 같은 엔터프라이즈급 기능을 갖추고 있으며, Mistral La Plateforme 및 Amazon Sagemaker에 이미 출시되었고 향후 더 많은 클라우드 플랫폼에 출시될 예정입니다. 동시에 Mistral AI는 기업용 챗봇 서비스 Le Chat Enterprise도 출시했습니다. (출처: 量子位)

NVIDIA NeMo 프레임워크 2.0 출시, 모듈성 및 사용 편의성 향상, Hugging Face 모델 및 Blackwell GPU 지원: NVIDIA NeMo 프레임워크가 2.0 버전으로 업데이트되었습니다. 주요 개선 사항으로는 YAML 대신 Python 구성을 채택하여 유연성을 높였고, PyTorch Lightning의 모듈식 추상화를 통해 실험 및 사용자 정의를 단순화했으며, NeMo-Run 도구를 활용하여 대규모 실험의 원활한 확장을 구현했습니다. 새 버전은 Hugging Face AutoModelForCausalLM 모델의 사전 학습 및 미세 조정을 지원하며 NVIDIA Blackwell B200 GPU를 초기 지원합니다. 또한 NeMo 프레임워크는 비디오 처리 라이브러리 NeMo Curator 및 Cosmos 토크나이저를 포함하여 물리 AI 시스템의 월드 모델 개발을 가속화하기 위한 NVIDIA Cosmos 월드 기초 모델 플랫폼에 대한 지원을 통합했습니다. (출처: GitHub Trending)

Lightricks, LTX-Video 출시: 실시간 DiT 비디오 생성 모델: Lightricks 회사가 Diffusion Transformer (DiT) 기반의 최초 실시간 비디오 생성 모델이라고 주장하는 LTX-Video를 오픈 소스로 공개했습니다. 이 모델은 30FPS로 1216×704 해상도의 고품질 비디오를 생성할 수 있으며, 텍스트-이미지, 이미지-비디오, 키프레임 애니메이션, 비디오 확장, 비디오-비디오 변환 등 다양한 기능을 지원합니다. 최신 버전 13B v0.9.7은 프롬프트 준수도와 물리적 이해 능력을 향상시켰으며, 빠르고 고품질 렌더링을 위한 다중 스케일 비디오 파이프라인을 출시했습니다. 모델은 Hugging Face에서 제공되며 ComfyUI 및 Diffusers 통합이 있습니다. (출처: GitHub Trending)

Apple, Safari 브라우저 대대적 개편 고려, AI 기반 검색으로 전환 가능성, Google과의 협력 관계 주목: Apple의 수석 부사장 에디 큐가 미국 법무부의 Google 반독점 소송에서 증언하면서 Apple이 Safari 브라우저 개편을 적극적으로 고려하고 있으며, AI 기반 검색 엔진으로의 전환에 중점을 두고 있다고 밝혔습니다. 그는 Safari 검색량이 처음으로 감소했으며, 부분적으로는 사용자들이 OpenAI, Perplexity AI 등 AI 도구로 전환했기 때문이라고 지적했습니다. Apple은 이미 Perplexity AI와 협의를 진행했으며 Safari에 더 많은 AI 검색 옵션을 도입할 수 있습니다. 이러한 움직임은 Apple과 Google 간의 연간 약 200억 달러 규모의 기본 검색 엔진 계약에 영향을 미칠 수 있으며 양사 주가에도 영향을 미칠 수 있습니다. Apple은 이미 Siri에 ChatGPT를 통합했으며 Google Gemini를 추가할 계획입니다. (출처: 36氪)

🎯 동향

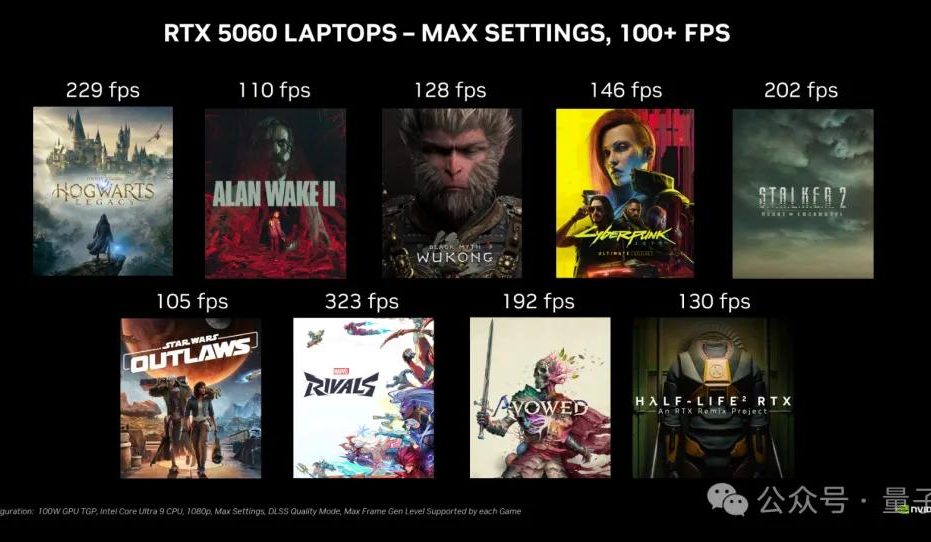

NVIDIA RTX 5060 데스크톱 그래픽 카드 5월 20일 출시, 국내 가격 2499위안: NVIDIA는 RTX 5060 데스크톱 그래픽 카드가 베이징 시간 5월 20일에 출시되며 국내 가격은 2499위안이라고 발표했습니다. 이 카드는 Blackwell RTX 아키텍처를 사용하며 3840개의 CUDA 코어, 8GB GDDR7 메모리, 총 전력 145W를 갖추고 있습니다. 공식 발표에 따르면 DLSS 4 멀티프레임 생성 기술을 지원하는 게임에서 RTX 4060의 두 배 성능을 발휘하며, 사용자가 100 FPS 이상의 프레임 속도로 게임을 실행할 수 있도록 하는 것을 목표로 합니다. 리뷰 엠바고 해제와 판매는 같은 날 진행됩니다. (출처: 量子位)

Google Gemini API, 암시적 캐싱 기능 출시, 최대 75% 비용 절감 가능: Google은 Gemini API에 암시적 캐싱 기능을 출시했다고 발표했습니다. 사용자의 요청이 캐시에 적중하면 Gemini 2.5 모델 사용 비용이 자동으로 75% 절감될 수 있습니다. 동시에 캐시 트리거에 필요한 최소 토큰 수도 줄어들어 Gemini 2.5 Flash는 1K 토큰, Gemini 2.5 Pro는 2K 토큰으로 낮아졌습니다. 이 기능은 개발자가 명시적으로 캐시를 생성할 필요 없이 Gemini API 사용 비용을 절감하는 것을 목표로 합니다. (출처: matvelloso, demishassabis, algo_diver, jeremyphoward)

Meta FAIR, Rob Fergus를 새로운 책임자로 임명, 고급 기계 지능(AGI)에 집중: Meta는 Rob Fergus가 기초 AI 연구(FAIR) 팀의 리더를 맡게 될 것이라고 발표했습니다. Yann LeCun은 FAIR가 일반적으로 인간 수준 AI 또는 AGI라고 불리는 고급 기계 지능에 다시 집중할 것이라고 밝혔습니다. 이 소식은 AI 연구 커뮤니티로부터 광범위한 관심과 축하를 받았습니다. (출처: ylecun, Ar_Douillard, soumithchintala, aaron_defazio, sainingxie)

OpenAI, o4-mini 모델의 강화 학습 미세 조정(RFT) 기능 출시: OpenAI는 o4-mini 모델이 이제 강화 학습 미세 조정(RFT)을 지원한다고 발표했습니다. 이 기술은 작년 12월부터 개발되었으며, 사고의 연쇄 추론 및 작업별 점수를 활용하여 특히 복잡한 영역에서 모델 성능을 향상시킵니다. Ambience 회사는 RFT로 튜닝된 모델을 사용하여 ICD-10 코딩 정확도에서 전문가 임상의보다 27% 높은 성과를 거두었습니다. Harvey 회사도 RFT를 통해 모델을 훈련하여 법률 작업에서 인용의 정확성을 높였습니다. 동시에 OpenAI의 가장 빠르고 작은 모델인 4.1-nano도 미세 조정이 가능해졌습니다. (출처: stevenheidel, aidan_mclau, andrwpng, teortaxesTex, OpenAIDevs, OpenAIDevs)

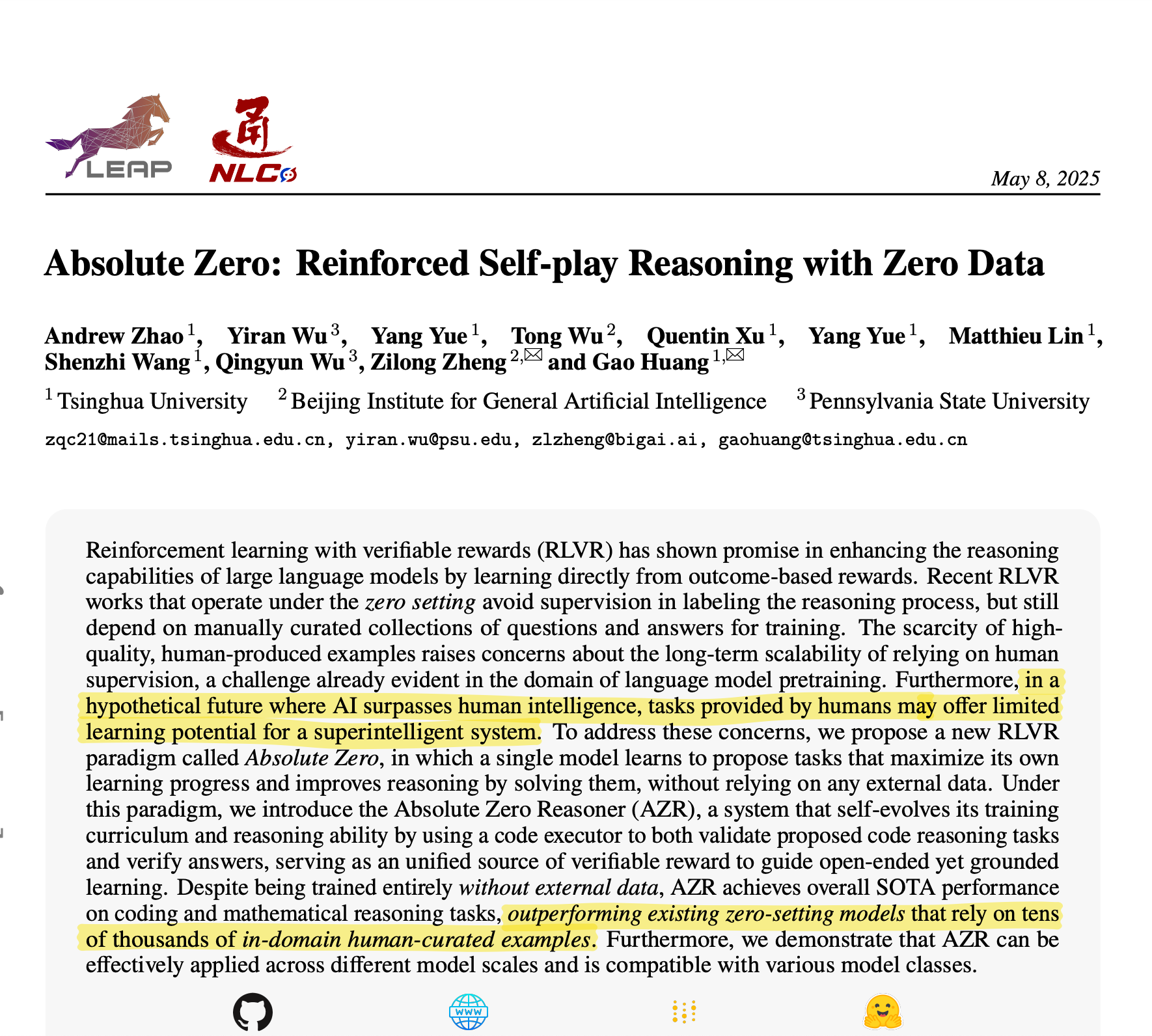

칭화대학교, Absolute Zero Reasoner 제안: AI 자체 생성 학습 데이터로 뛰어난 추론 능력 구현: 칭화대학교 팀은 Absolute Zero Reasoner라는 AI 모델을 개발했습니다. 이 모델은 외부 데이터 없이 자체 대결(self-play)을 통해 학습 작업을 생성하고 학습할 수 있습니다. 수학 및 코딩과 같은 분야에서 전문가가 수동으로 큐레이션한 데이터에 의존하여 훈련된 모델을 능가하는 성능을 보였습니다. 이 성과는 AI 발전의 데이터 병목 현상 완화를 의미하며 AGI로 가는 새로운 길을 열 수 있습니다. (출처: corbtt)

Meta, NVIDIA와 협력하여 cuVS를 통해 Faiss GPU 벡터 검색 성능 향상: Meta와 NVIDIA는 NVIDIA의 cuVS(CUDA Vector Search)를 Meta의 오픈 소스 유사성 검색 라이브러리 Faiss v1.10에 통합하여 GPU에서의 벡터 검색 성능을 대폭 향상시키는 협력을 발표했습니다. 이번 통합으로 IVF 인덱스 구축 시간이 최대 4.7배 향상되고 검색 지연 시간이 최대 8.1배 단축되었습니다. 그래프 인덱스 측면에서는 CUDA ANN Graph (CAGRA)의 구축 시간이 CPU HNSW보다 12.3배 빠르고 검색 지연 시간이 4.7배 단축되었습니다. (출처: AIatMeta)

Google AI Studio 및 Firebase Studio에 Gemini 2.5 Pro 통합: Google은 Gemini 2.5 Pro 모델을 Gemini Code Assist(개인용) 및 Firebase Studio에 통합했다고 발표했습니다. 이를 통해 개발자는 이러한 플랫폼에서 최고 수준의 코딩 모델을 더욱 편리하고 강력하게 사용할 수 있게 되어 코딩 효율성과 경험을 향상시키는 것을 목표로 합니다. (출처: algo_diver)

Microsoft Copilot, Pages 기능 출시, 인라인 편집 및 텍스트 강조 지원: Microsoft Copilot에 “Pages” 기능이 추가되어 사용자가 Copilot 인터페이스 내에서 AI가 생성한 응답을 직접 인라인으로 편집하고 텍스트를 강조 표시하며 구체적인 수정 요구 사항을 제시할 수 있게 되었습니다. 이 기능은 사용자가 질문과 연구 결과를 사용 가능한 문서로 더 빠르고 스마트하게 전환하여 작업 효율성을 높이는 데 도움이 되는 것을 목표로 합니다. (출처: yusuf_i_mehdi)

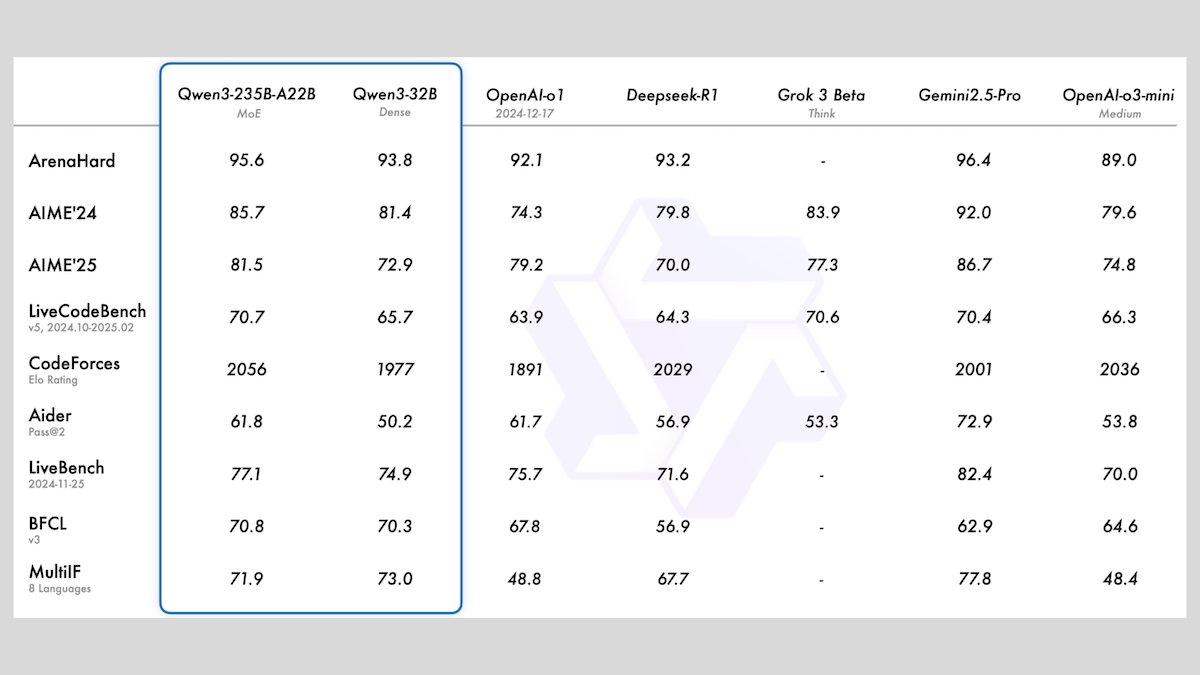

알리바바, Qwen3 시리즈 모델 출시, 8개의 오픈 소스 대형 언어 모델 포함: 알리바바는 Qwen3 시리즈를 출시했으며, 여기에는 2개의 혼합 전문가(MoE) 모델과 0.6B에서 32B까지의 매개변수 범위를 가진 6개의 밀집 모델을 포함한 8개의 오픈 소스 대형 언어 모델이 포함됩니다. 모든 모델은 선택적 추론 모드와 119개 언어의 다국어 기능을 지원합니다. Qwen3-235B-A22B와 Qwen3-30B-A3B는 추론, 코딩 및 함수 호출 작업에서 뛰어난 성능을 보여 OpenAI 등 최고 수준의 모델과 견줄 만하며, 특히 Qwen3-30B-A3B는 강력한 성능과 로컬 실행 능력으로 주목받고 있습니다. (출처: DeepLearningAI)

Meta, 정확한 3D 환경 객체 위치 파악을 위한 Meta Locate 3D 모델 출시: Meta AI는 3D 환경에서 객체를 정확하게 위치 파악하도록 특별히 설계된 모델인 Meta Locate 3D를 출시했습니다. 이 모델은 로봇이 주변 환경을 더 정확하게 이해하고 인간과 더 자연스럽게 상호 작용하도록 돕는 것을 목표로 합니다. Meta는 모델, 데이터 세트, 연구 논문 및 대중이 사용하고 경험할 수 있는 데모를 제공했습니다. (출처: AIatMeta)

Google, AI를 활용한 사이버 사기 퇴치 방법 설명하는 새 보고서 발표: Google은 검색 엔진, Chrome 브라우저 및 Android 시스템에서 AI 기술을 활용하여 사이버 사기를 퇴치하는 방법에 대한 새로운 보고서를 발표했습니다. 이 보고서는 Google이 10년 이상 AI를 활용하여 온라인 사기로부터 사용자를 보호해 온 노력과 최신 진행 상황을 자세히 설명하며, 사기 행위를 식별하고 차단하는 데 있어 AI의 핵심적인 역할을 강조합니다. (출처: Google)

Cohere, Embed 4 임베딩 모델 출시, AI 검색 및 검색 능력 강화: Cohere는 기업 데이터 액세스 및 활용 방식을 혁신하기 위해 최신 임베딩 모델 Embed 4를 출시했습니다. Embed 4는 Cohere의 가장 강력한 임베딩 모델로서 AI 검색 및 검색의 정확성과 효율성을 향상시키는 데 중점을 두어 조직이 데이터에서 숨겨진 가치를 발굴하도록 돕습니다. (출처: cohere)

Google, Google I/O 컨퍼런스 5월 20일 개최 발표: Google은 연례 개발자 컨퍼런스인 Google I/O를 5월 20일에 개최하며 등록을 시작했다고 공식 발표했습니다. 기조 연설, 신제품 및 기술 발표가 있을 예정이며 AI가 핵심 의제 중 하나가 될 것으로 예상됩니다. (출처: Google)

NVIDIA Parakeet 모델, 오디오 트랜스크립션 신기록 수립: 1초에 60분 분량 오디오 트랜스크립션: NVIDIA의 Parakeet 모델은 오디오 트랜스크립션 분야에서 획기적인 성과를 거두어 1초 안에 최대 60분 분량의 오디오를 트랜스크립션할 수 있으며 Hugging Face 관련 순위에서 상위권에 올랐습니다. 이 성과는 NVIDIA의 음성 인식 기술 분야에서의 선도적인 위치를 보여주며 개발자에게 효율적인 오디오 처리 도구를 제공합니다. (출처: huggingface)

🧰 툴

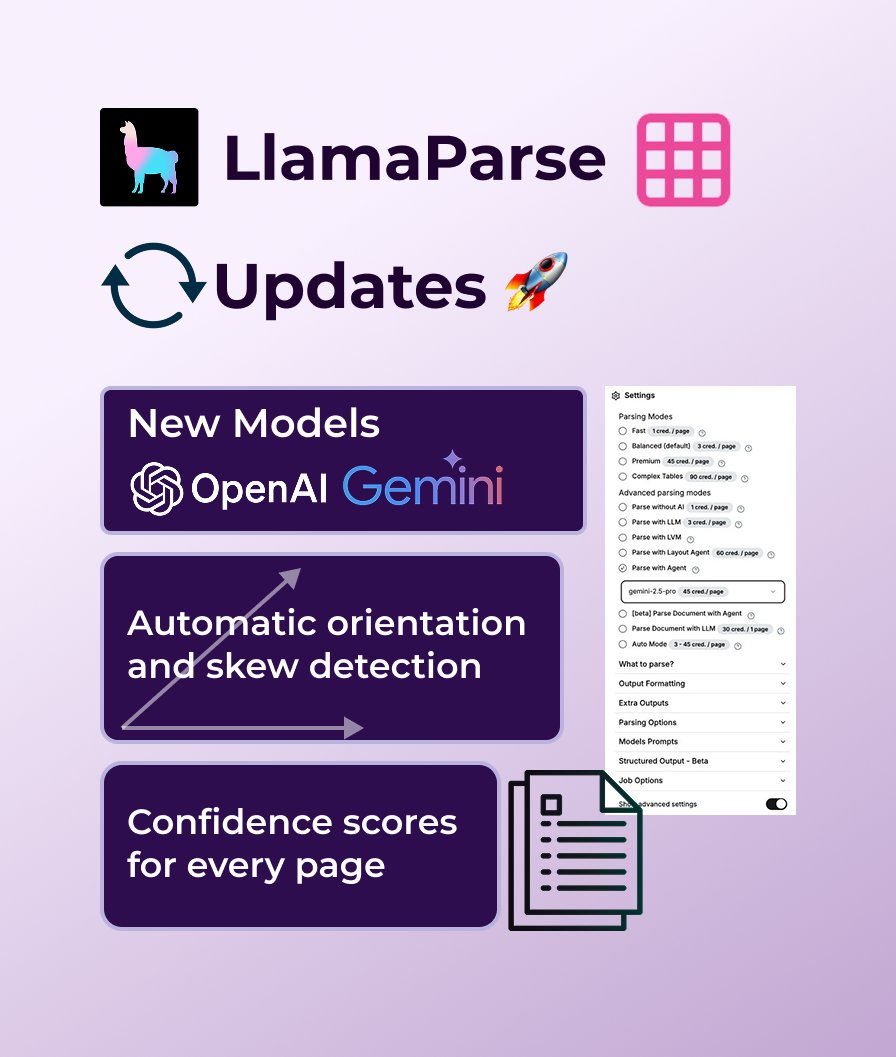

LlamaParse, GPT 4.1 및 Gemini 2.5 Pro 지원 추가, 문서 파싱 능력 강화: LlamaParse는 최근 정확도 향상을 위해 새로운 파싱 모델 GPT 4.1 및 Gemini 2.5 Pro를 도입하는 등 일련의 기능 업데이트를 진행했습니다. 또한 새 버전은 자동 방향 및 기울기 감지 기능을 추가하여 완벽하게 정렬된 파싱을 보장하고, 파싱 품질을 평가하기 위한 신뢰도 점수를 제공하며, 사용자가 오류 허용 범위와 실패한 페이지 처리 방식을 사용자 정의할 수 있도록 합니다. LlamaParse는 월 10,000페이지의 무료 사용량을 제공합니다. (출처: jerryjliu0)

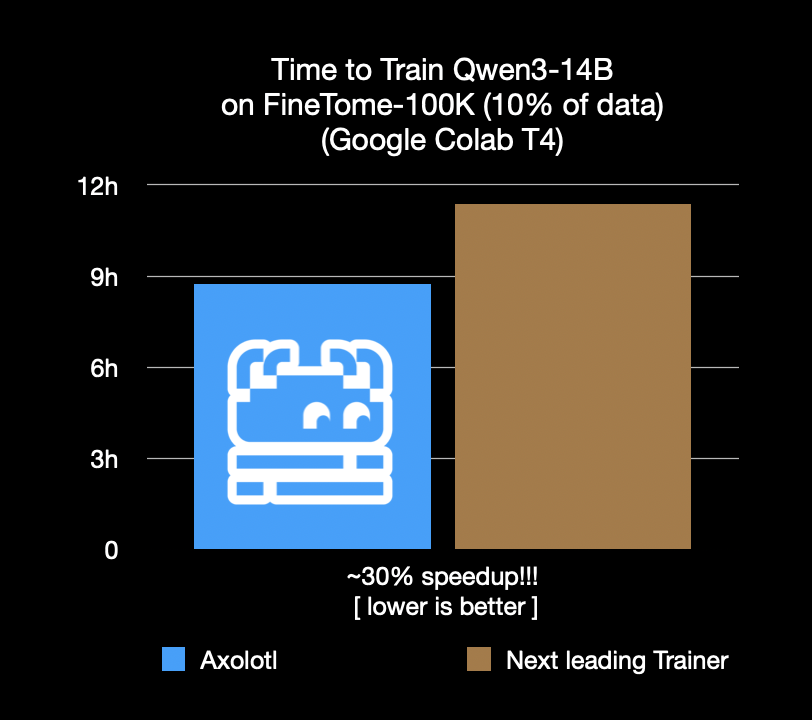

Axolotl 미세 조정 프레임워크 속도 30% 향상, 비용 및 시간 절감: Axolotl 미세 조정 프레임워크는 FineTome-100k와 같은 실제 워크로드에서 차선책 프레임워크보다 30% 더 빠르다고 발표했습니다. 중대형 머신러닝 팀의 경우 이는 월 수천 달러의 비용 절감을 의미합니다. 이 프레임워크의 최적화는 사용자가 모델 미세 조정을 보다 효율적이고 경제적으로 수행할 수 있도록 돕는 것을 목표로 합니다. (출처: Teknium1, winglian, maximelabonne)

Runway, 애니메이션 파일럿 에피소드 ‘Mars & Siv: No Vacancy’ 공개, Gen-4 모델 능력 과시: Runway 산하 AI 스튜디오가 Jeremy Higgins와 Britton Korbel이 제작한 애니메이션 파일럿 에피소드 ‘Mars & Siv: No Vacancy’를 공개했습니다. 이 작품은 Runway의 Gen-4 모델이 컨셉부터 최종成品까지 애니메이션 제작 과정의 모든 단계에 적용된 사례를 보여주며, 창의적인 콘텐츠 생성 분야에서 AI의 잠재력을 강조합니다. (출처: c_valenzuelab, c_valenzuelab)

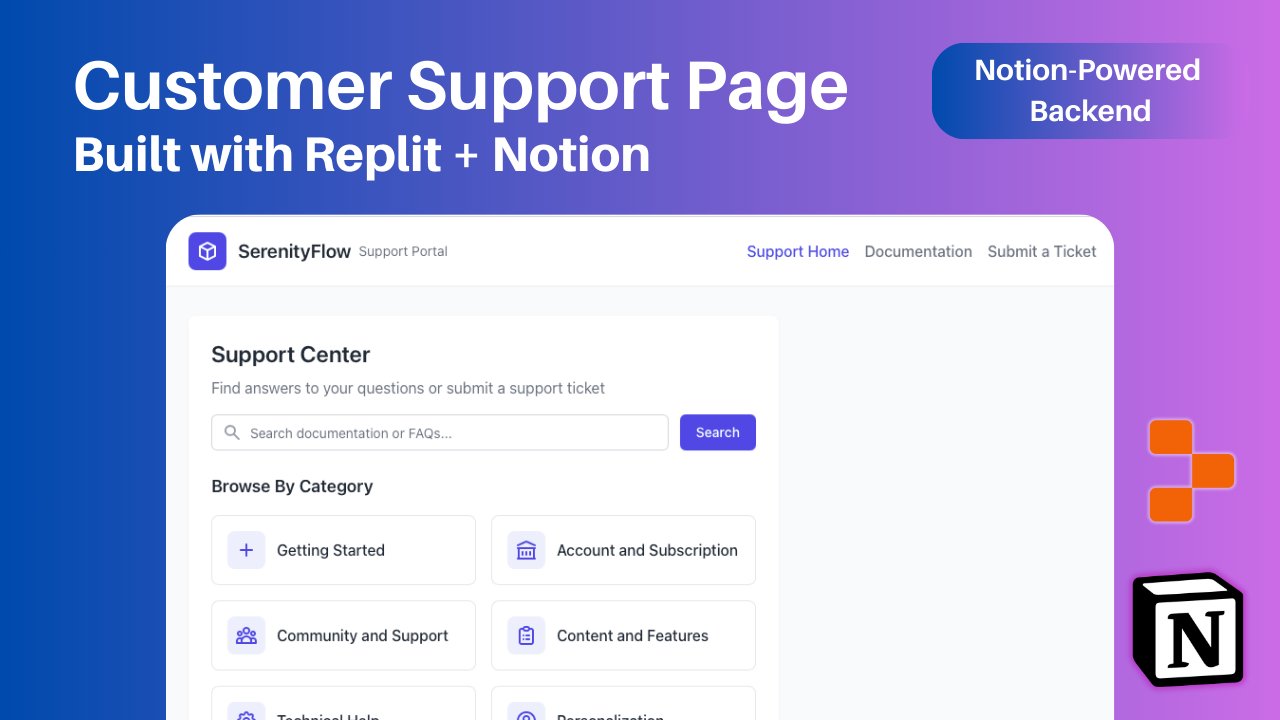

Replit, Notion 통합 추가, Notion 콘텐츠를 애플리케이션 백엔드로 지원: Replit은 Notion과의 새로운 통합 협력을 발표하여 개발자가 Notion을 애플리케이션의 백엔드로 사용할 수 있도록 했습니다. 사용자는 Notion 데이터베이스를 Replit 프로젝트에 연결하여 FAQ를 표시하고, 문서 기반 맞춤형 AI 챗봇을 구동하며, 지원 티켓 기록을 Notion으로 다시 보낼 수 있습니다. 이는 Notion의 백엔드 조직 능력과 Replit의 유연한 프론트엔드 생성 능력을 결합하는 것을 목표로 합니다. (출처: amasad, amasad, pirroh)

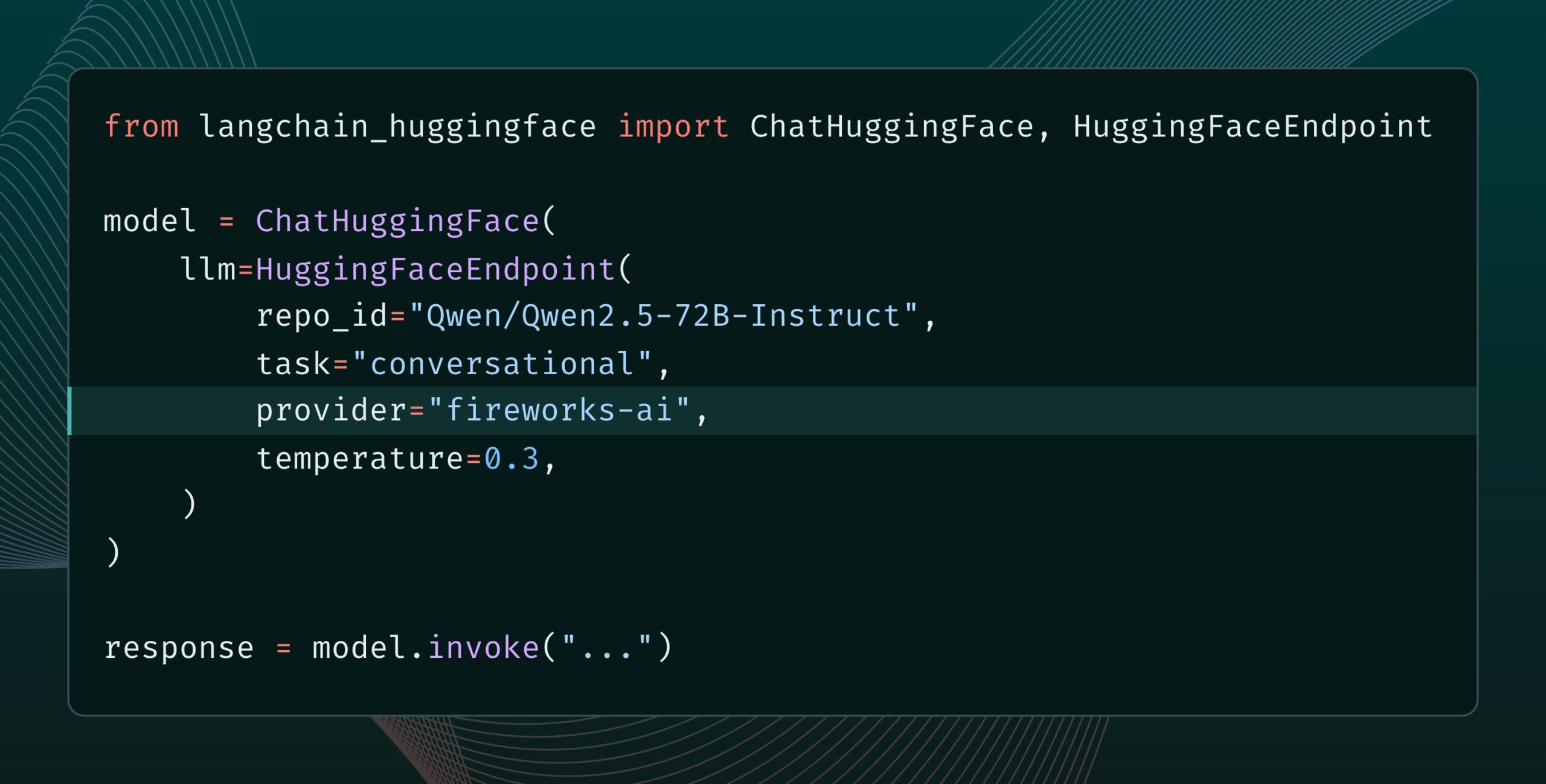

Langchain-huggingface v0.2 출시, HF Inference Providers 지원: Langchain-huggingface가 v0.2 버전을 출시했으며, 새 버전에는 Hugging Face Inference Providers에 대한 지원이 추가되었습니다. 이 업데이트를 통해 LangChain 생태계에서 Hugging Face가 제공하는 추론 서비스를 더욱 편리하게 사용할 수 있게 됩니다. (출처: LangChainAI, huggingface, ClementDelangue, hwchase17, Hacubu)

smolagents 1.15 출시, 스트리밍 출력 기능 추가: AI 에이전트 프레임워크 smolagents가 1.15 버전을 출시하며 스트리밍 출력(streaming outputs) 기능을 도입했습니다. 사용자는 CodeAgent를 초기화할 때 stream_outputs=True로 설정하면 이 기능을 활성화할 수 있으며, 이를 통해 모든 상호 작용 과정이 더욱 원활하게 느껴질 것입니다. (출처: huggingface, AymericRoucher, ClementDelangue)

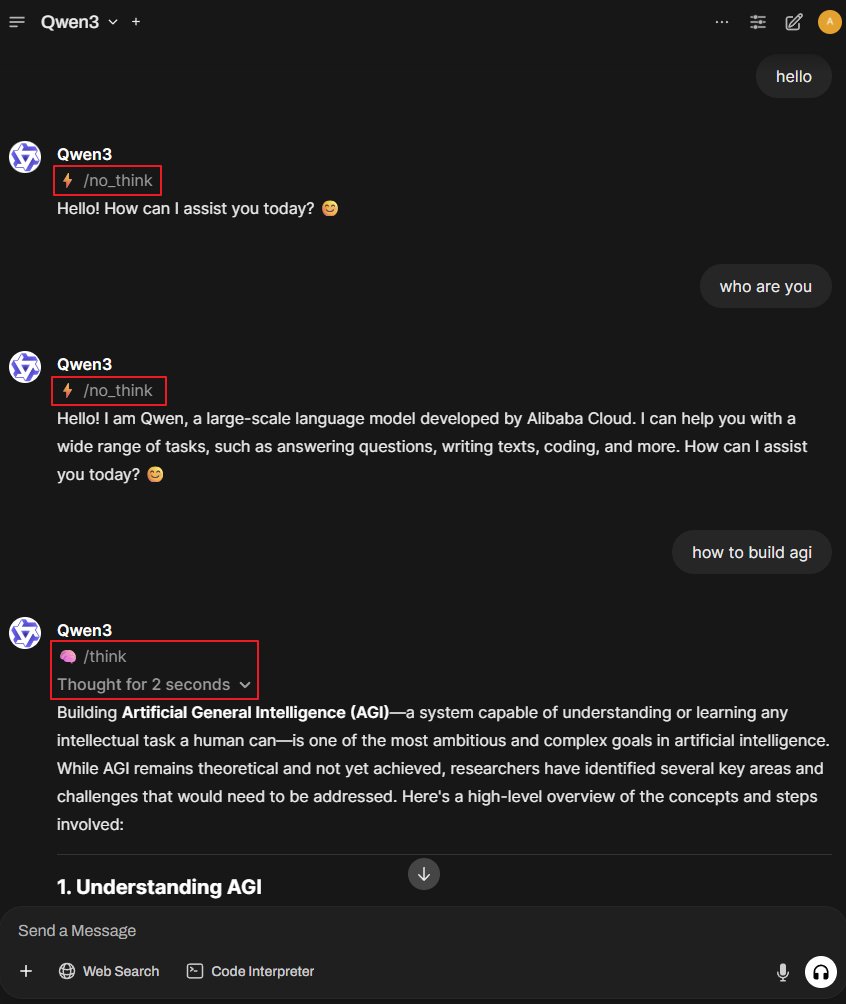

Better-Qwen3 프로젝트: Qwen3 모델이 자동으로 사고 모드 전환: Better-Qwen3라는 GitHub 프로젝트가 주목받고 있습니다. 이 프로젝트는 Qwen3 모델이 사용자 질문의 복잡성에 따라 ‘사고 모드’ 활성화 여부를 자동으로 제어하도록 하는 것을 목표로 합니다. 간단한 질문에는 모델이 직접 답변하고, 복잡한 질문에는 자동으로 사고 모드로 들어가 더 심층적인 답변을 제공합니다. 프로젝트 주소: http://github.com/AaronFeng753/Better-Qwen3 (출처: karminski3, Reddit r/LocalLLaMA)

MLX-Audio: Apple MLX 프레임워크 기반 TTS/STT/STS 라이브러리: MLX-Audio는 Apple Silicon 칩을 위해 특별히 제작된 텍스트 음성 변환(TTS), 음성 텍스트 변환(STT) 및 음성 음성 변환(STS) 라이브러리로, Apple의 MLX 프레임워크를 기반으로 개발되어 효율적인 음성 처리 능력을 제공하는 것을 목표로 합니다. 이 라이브러리는 다양한 언어, 음성 사용자 정의, 말하기 속도 제어를 지원하며 대화형 웹 인터페이스와 REST API를 제공합니다. (출처: GitHub Trending)

Runway References 모델, 이미지 확장(Outpainting) 기능 지원: Runway의 References 모델이 이제 이미지 확장(outpainting) 기능을 지원합니다. 사용자는 References에 이미지를 배치하고 원하는 출력 형식을 선택한 다음 프롬프트를 비워두고 생성을 클릭하면 원본 이미지를 확장할 수 있습니다. 이 기능은 Runway의 이미지 편집 및 창작 능력을 더욱 향상시킵니다. (출처: c_valenzuelab)

Docker2exe: Docker 이미지를 실행 파일로 변환: Docker2exe는 Docker 이미지를 독립 실행 파일로 변환하여 사용자가 쉽게 공유하고 실행할 수 있도록 하는 도구입니다. Docker 이미지의 tarball을 실행 파일에 직접 패키징하는 임베디드 모드를 지원합니다. 대상 장치에서 실행할 때 로컬에 해당 Docker 이미지가 없으면 임베디드 이미지를 자동으로 로드하거나 네트워크에서 가져옵니다. (출처: GitHub Trending)

Smoothie Qwen: Qwen 모델 토큰 확률을 평활화하여 다국어 생성 균형 조정: Smoothie Qwen은 Qwen 모델의 토큰 확률을 평활화하여 모델이 다국어 생성 시 균형을 강화하고 특정 언어(예: 중국어)에 대한 의도치 않은 편향을 줄이면서 핵심 성능을 유지하는 것을 목표로 하는 경량 조정 도구입니다. 이 도구는 Unicode 범위를 사용하여 토큰을 식별하고 N-gram 분석을 수행하며 lm_head에서 토큰 가중치를 조정합니다. 사전 조정된 모델은 Hugging Face에서 제공됩니다. (출처: Reddit r/LocalLLaMA)

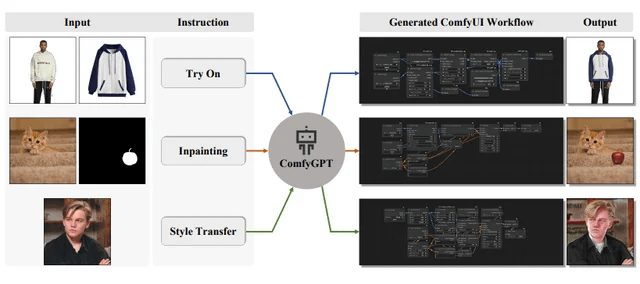

ComfyGPT: ComfyUI 워크플로우 생성을 위한 자체 최적화 다중 에이전트 시스템: ‘ComfyGPT: A Self-Optimizing Multi-Agent System for Comprehensive ComfyUI Workflow Generation’이라는 논문이 arXiv에 제출되어 ComfyGPT라는 시스템을 소개했습니다. 이 시스템은 자체 최적화 다중 에이전트 방법을 활용하여 ComfyUI의 워크플로우를 포괄적으로 생성하고 복잡한 이미지 생성 프로세스 구축을 단순화하는 것을 목표로 합니다. (출처: Reddit r/LocalLLaMA)

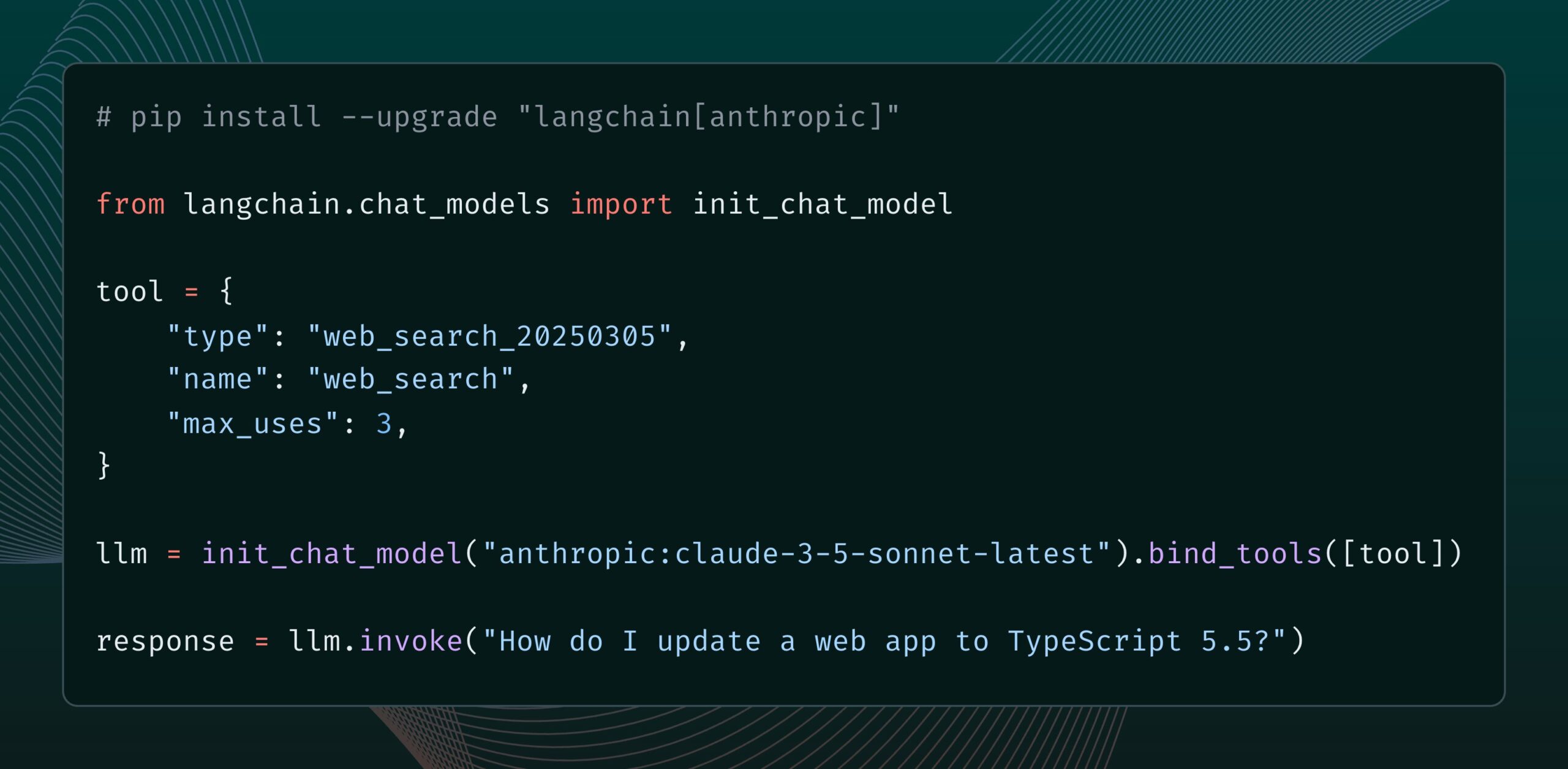

Anthropic Claude 모델, 웹 검색 도구 추가: Anthropic은 Claude 모델을 위한 새로운 웹 검색 도구를 출시했습니다. 이 도구를 사용하면 Claude가 응답을 생성할 때 웹 검색을 수행하고 검색 결과를 근거로 인용이 포함된 답변을 제공할 수 있습니다. 이 기능은 langchain-anthropic 라이브러리에 통합되어 Claude가 실시간 정보를 획득하고 활용하는 능력을 향상시킵니다. (출처: LangChainAI, hwchase17)

Glass Health, AI를 활용한 임상 진단 및 치료 계획 지원 Workspace 기능 출시: Glass Health는 임상의가 AI를 사용하여 복잡한 진단 추론, 치료 계획 수립 및 문서화 워크플로우를 보다 효율적으로 완료할 수 있도록 하는 새로운 Workspace 기능을 출시했습니다. 이는 AI 기술을 통해 의료 업무의 효율성과 품질을 향상시키는 것을 목표로 합니다. (출처: GlassHealthHQ)

OpenWebUI, AI 강화 노트 및 회의 녹음 기능 추가: OpenWebUI 최신 버전에 AI 강화 노트 기능이 추가되어 사용자는 노트를 만들고 회의 또는 음성 오디오를 첨부한 다음 AI가 오디오 트랜스크립션을 활용하여 노트를 즉시 강화, 요약 또는 최적화하도록 할 수 있습니다. 또한 회의 오디오 녹음 및 가져오기 기능을 지원하여 사용자가 중요한 토론 정보를 검토하고 추출하는 데 편리합니다. (출처: Reddit r/OpenWebUI)

📚 학습

유엔, 200페이지 분량의 AI와 글로벌 인간 개발 보고서 발표: 유엔개발계획(UNDP)은 글로벌 인간 개발 관점에서 인공지능을 검토하는 200페이지 분량의 보고서를 발표했습니다. 이 보고서는 AI가 지속 가능한 개발 목표, 불평등, 거버넌스 및 미래의 일자리 등 다양한 측면에 미치는 영향을 탐구하고 정책 제안을 제시합니다. 이 보고서는 뚜렷한 관점으로 주목받고 있습니다. (출처: random_walker)

The Turing Post, Agent2Agent (A2A) 프로토콜 심층 분석 기사 게시: AI 에이전트 간 통신 프로토콜에 대한 커뮤니티의 높은 관심에 부응하여 The Turing Post는 Hugging Face에 Google A2A 프로토콜에 대한 심층 분석 기사를 무료로 게시했습니다. 이 기사는 A2A 프로토콜의 중요성(AI 에이전트 고립을 깨고 협업을 실현하는 것을 목표로 함), 잠재적 응용 분야(예: 전문 에이전트 팀 협업, 기업 간 워크플로우, 인간-기계 협업 표준화, 검색 가능한 에이전트 디렉토리) 및 작동 원리와 시작 방법을 탐구합니다. (출처: TheTuringPost, TheTuringPost, TheTuringPost, dl_weekly)

프롬프트 엔지니어 공유: 사용하기 좋은 프롬프트 템플릿을 쉽게 작성하는 방법: 프롬프트 엔지니어 dotey는 효율적인 프롬프트 템플릿을 만드는 3단계 방법을 공유했습니다: 1. 동일한 스타일이지만 다른 주제의 프롬프트를 수집합니다. 2. 공통점과 차이점을 찾습니다(AI의 도움을 받을 수 있음). 3. 반복적으로 테스트하고 최적화합니다. 그는 좋은 템플릿은 프로그램의 함수와 유사하며, 변수를 약간 수정하여 다른 결과를 생성할 수 있다고 강조했습니다. 또한 AI를 사용하여 새로운 프롬프트를 빠르게 생성하는 지침 템플릿을 공유했으며, 모든 스타일이 템플릿화에 적합한 것은 아니며 복잡한 세부 사항이 많은 주제는 여전히 개별적인 최적화가 필요하다고 지적했습니다. (출처: dotey)

DeepMind 연구원 John Jumper 팀 채용, LLM 기반 과학적 발견 확장: Google DeepMind의 연구원 John Jumper는 대규모 언어 모델(LLM) 기반 과학적 발견 분야의 작업을 확장하기 위해 팀에서 여러 직책을 채용한다고 발표했습니다. 채용 직책에는 연구 과학자(RS)와 연구 엔지니어(RE)가 포함되며, 자연어 과학 AI의 미래를 추진하는 것을 목표로 합니다. (출처: demishassabis, NandoDF)

Ragas 블로그, 2년간의 AI 애플리케이션 개선 경험 공유: Shahules786은 Ragas 블로그에 지난 2년간 AI 팀과 긴밀히 협력하고 평가 주기를 제공하며 LLM 시스템을 개선한 경험과 교훈을 요약한 글을 게시했습니다. 이 글은 AI 애플리케이션을 구축하고 최적화하는 실무자에게 실용적인 지침과 통찰력을 제공하는 것을 목표로 합니다. (출처: Shahules786)

조경현 교수, LLM 시대 머신러닝 대학원 과정 교육 방법론 논의: 뉴욕대학교 조경현 교수는 현재 LLM 및 대규모 컴퓨팅 시대에 1학년 머신러닝 대학원 과정 교육 내용에 대한 자신의 생각과 실험을 공유했습니다. 그는 SGD(확률적 경사 하강법)를 수용하고 LLM이 아닌 모든 내용을 가르치고 학생들이 고전 논문을 읽도록 지도할 것을 제안했습니다. (출처: ylecun, sainingxie)

지능형 문서 처리(IDP) 순위 발표, VLM 문서 이해 능력 통합 평가: OCR, KIE, VQA, 테이블 추출 등 다양한 문서 이해 작업을 위한 통합 벤치마크 테스트를 제공하는 것을 목표로 하는 새로운 지능형 문서 처리(IDP) 순위가 공개되었습니다. 이 순위는 6개의 핵심 IDP 작업, 16개의 데이터 세트 및 9229개의 문서를 다룹니다. 초기 결과에 따르면 Gemini 2.5 Flash가 전반적으로 선두를 달리고 있지만 모든 모델이 긴 문서 이해에서 부진한 성능을 보였으며 테이블 추출은 여전히 병목 현상으로 남아 있습니다. GPT-4o 최신 버전의 성능은 오히려 하락했습니다. (출처: Reddit r/MachineLearning, Reddit r/LocalLLaMA)

LangGraph, Cron Jobs 기능 출시, AI 에이전트 정기 실행 지원: LangChain의 LangGraph 플랫폼에 Cron Jobs 기능이 추가되어 사용자가 AI 에이전트의 실행을 자동으로 트리거하는 예약 작업을 설정할 수 있게 되었습니다. 이 기능을 통해 AI 에이전트는 미리 설정된 일정에 따라 작업을 수행할 수 있으며, 주기적인 처리 또는 모니터링이 필요한 시나리오에 적합합니다. (출처: hwchase17)

💼 비즈니스

AI 소프트웨어 디버깅 도구 Lightrun, Accel 및 Insight Partners 주도로 7,000만 달러 B 라운드 투자 유치: AI 소프트웨어 관찰 가능성 및 디버깅 도구 개발업체 Lightrun이 Accel과 Insight Partners가 주도하고 씨티그룹 등이 참여한 7,000만 달러 규모의 B 라운드 투자를 유치했다고 발표했으며, 누적 투자액은 1억 1,000만 달러에 달합니다. 핵심 제품인 Runtime Autonomous AI Debugger는 IDE에서 문제 코드를 정확하게 찾아내고 수정 제안을 제공하여 디버깅 시간을 몇 시간에서 몇 분으로 단축하는 것을 목표로 합니다. 이 회사의 2024년 매출은 4.5배 증가했으며 고객으로는 씨티, Microsoft 등 포춘 500대 기업이 있습니다. (출처: 36氪)

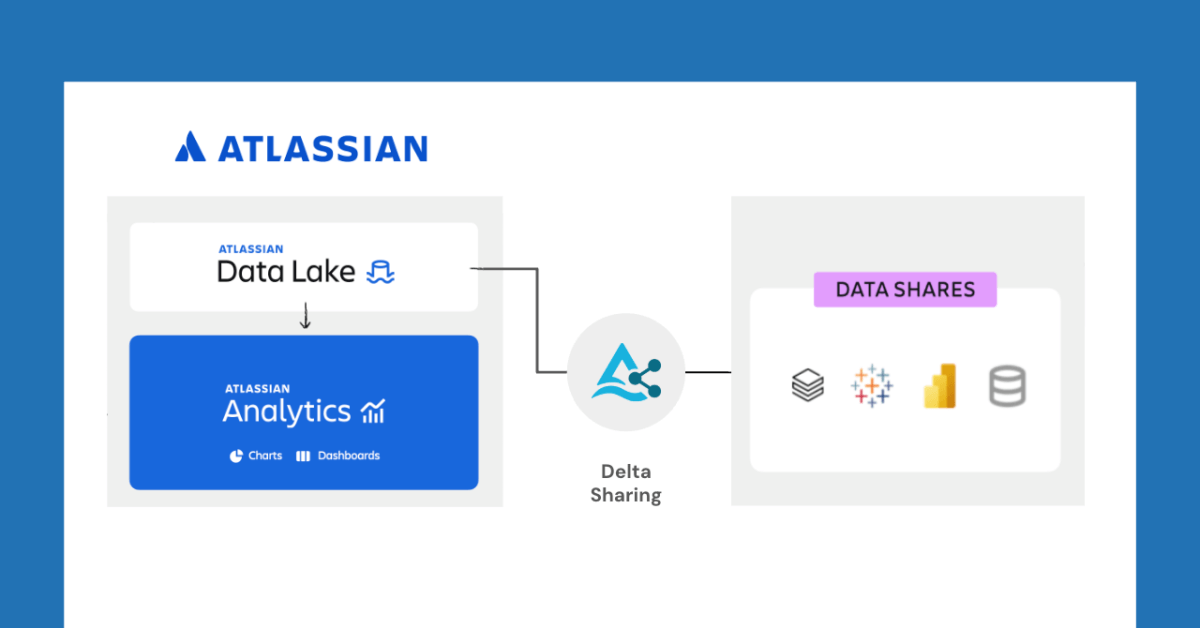

Databricks, Atlassian과 협력하여 Delta Sharing을 통해 새로운 데이터 공유 기능 잠금 해제: Databricks는 Atlassian과 협력하여 Atlassian Analytics에 새로운 데이터 공유 기능을 제공한다고 발표했습니다. Delta Sharing의 개방형 프로토콜을 통해 Atlassian 고객은 자신이 선택한 도구를 사용하여 Atlassian Data Lake에 있는 데이터에 안전하게 액세스하고 분석할 수 있습니다. 이 기능은 BI 통합, 맞춤형 데이터 워크플로우, 팀 간 협업 등 다양한 사용 사례를 지원합니다. (출처: matei_zaharia)

Fastino, 작업 특정 언어 모델(TLM)에 집중하여 1,750만 달러 투자 유치: 스타트업 Fastino는 Khosla Ventures가 주도한 1,750만 달러(총 2,500만 달러 프리 시드 라운드) 투자를 유치하여 혁신적인 작업 특정 언어 모델(TLM)을 개발한다고 발표했습니다. Fastino는 자사의 TLM 아키텍처가 작고 특정 작업에 최적화되어 있어 저가형 게임 GPU에서 훈련할 수 있으며 비용 효율적이라고 밝혔습니다. TLM은 아키텍처, 사전 훈련 및 사후 훈련 수준에서 작업 전문화를 통해 매개변수 중복성과 아키텍처 비효율성을 제거하여 특정 작업의 정확성을 높이고 지연 시간 및 비용에 민감한 애플리케이션에 내장될 수 있도록 하는 것을 목표로 합니다. (출처: Reddit r/MachineLearning)

🌟 커뮤니티

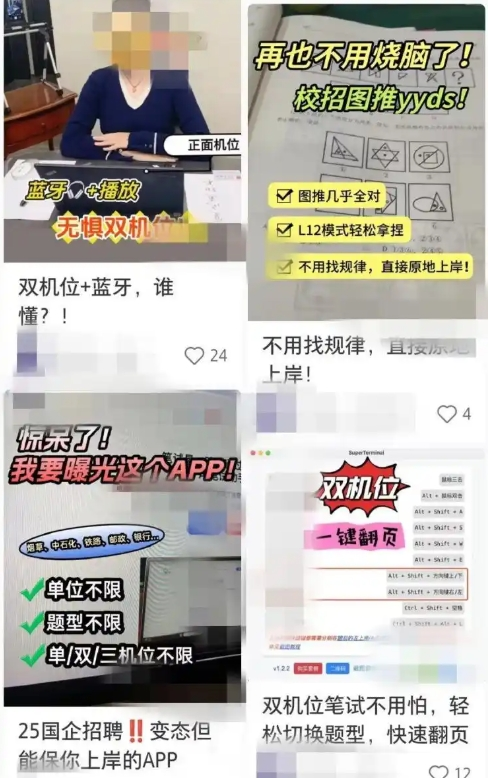

AI 보조 구직 도구, 부정행위 우려 야기, 기업 대응책 강화: 최근 AI 도구를 활용하여 온라인 면접 및 필기시험을 보조하는 현상이 증가하고 있으며, 이러한 ‘AI 면접 도우미’는 사용자 이력서에 맞춰 답변을 제공하여 구직자가 취업에서 유리한 고지를 점하도록 돕습니다. 이러한 소프트웨어는 획득 장벽이 낮고 여러 단계의 유료 요금제와 원격 지도까지 제공합니다. 이러한 추세는 ‘Interview Coder’와 같은 초기 AI 부정행위 도구의 출현으로 거슬러 올라갑니다. 기업들은 이미 구직자의 면접 시 비정상적인 행동에 주목하고 화면 감지 도입 또는 오프라인 면접 복귀를 고려하는 등 대응책을 마련하기 시작했습니다. 변호사들은 AI 부정행위 사용이 성실 의무 위반에 해당하며 근로 계약 해지로 이어질 수 있고 개인 정보 유출 위험도 존재한다고 지적합니다. (출처: 36氪)

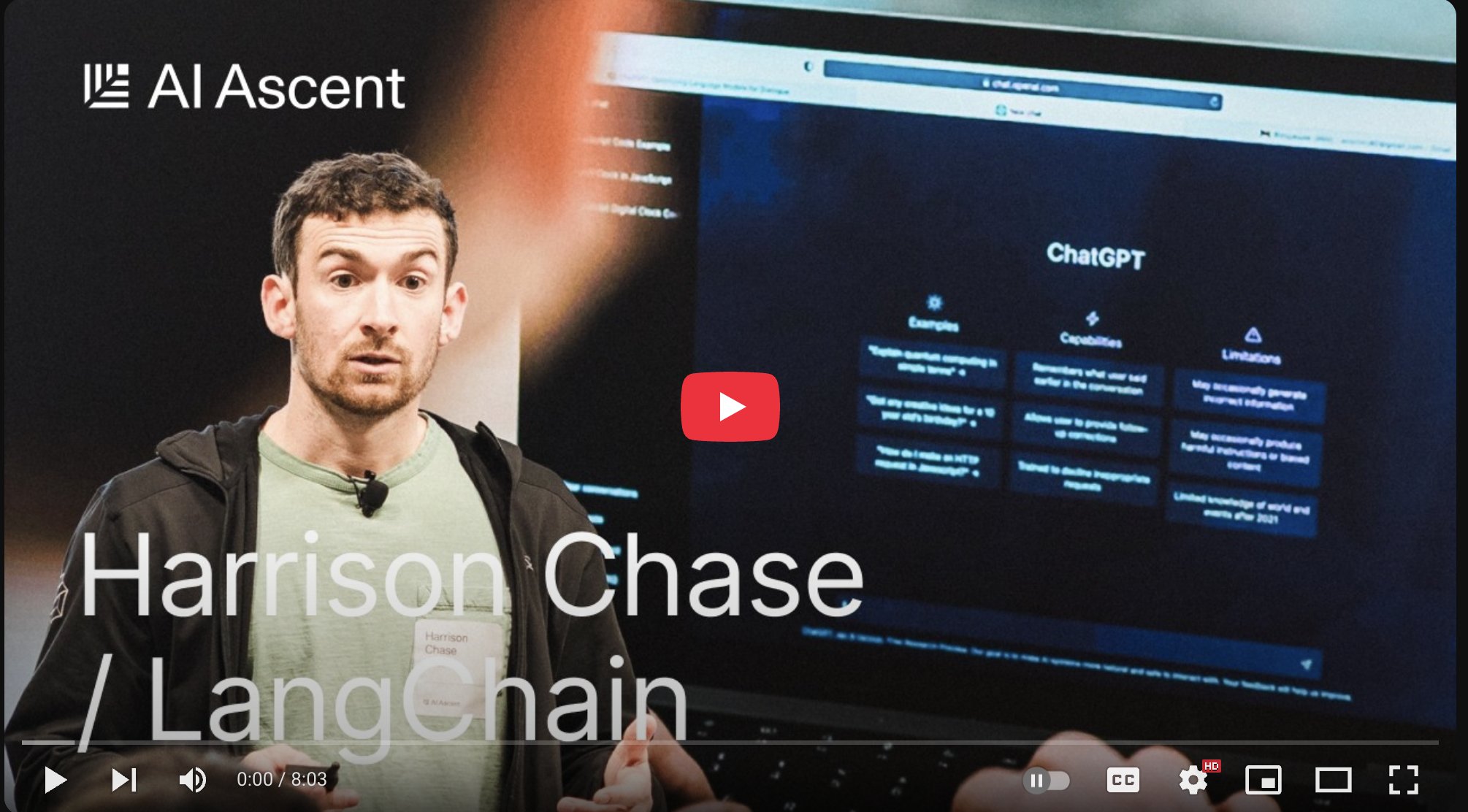

LangChain CEO Harrison Chase, ‘앰비언트 에이전트’ 및 ‘에이전트 인박스’ 개념 제시: LangChain CEO Harrison Chase는 Sequoia AI Ascent 행사에서 AI 에이전트의 미래 발전에 대한 자신의 견해를 공유하며 ‘앰비언트 에이전트(Ambient Agents)’와 ‘에이전트 인박스(Agent Inbox)’라는 개념을 제시했습니다. 앰비언트 에이전트는 백그라운드에서 지속적으로 실행되며 직접적인 인간의 지시가 아닌 이벤트에 응답하는 AI 시스템을 의미하며, 에이전트 인박스는 이러한 에이전트의 활동을 관리하고 감독하기 위한 새로운 인간-기계 상호 작용 인터페이스입니다. (출처: hwchase17, hwchase17, hwchase17)

Jim Fan, AI의 새로운 북극성으로 ‘물리적 튜링 테스트’ 제안: NVIDIA 과학자 Jim Fan은 Sequoia AI Ascent 행사에서 ‘물리적 튜링 테스트’라는 개념을 제시하며 이를 AI 분야의 다음 ‘북극성’으로 간주했습니다. 이 테스트는 일요일 해커톤 후 집이 엉망진창이었는데 월요일 저녁에 집에 돌아오니 거실이 깨끗하게 정돈되어 있고 촛불 저녁 식사가 준비되어 있는데, 이것이 인간의 소행인지 기계의 소행인지 구분할 수 없는 시나리오를 가정합니다. 그는 이것이 일반 로봇 기술의 목표라고 생각하며, 데이터 전략과 규모의 법칙을 포함하여 이 문제를 해결하기 위한 최우선 원칙을 공유했습니다. (출처: DrJimFan, killerstorm)

AI 모델 평가 위기 직면, EvalEval 연합 개선 촉구: 현재 AI 모델 평가 방법의 부족함, 예를 들어 벤치마크 포화, 과학적 엄밀성 부족 등의 문제에 대응하여 EvalEval 연합이 언급되었으며, 이는 평가 현황에 관심을 가진 사람들을 연합하여 평가 보고서 개선, 포화 문제 해결, 평가 과학성 및 인프라 향상 등에 공동으로 노력하는 것을 목표로 합니다. 관련 논의에서는 평가의 유효성에 더 중점을 두어야 한다고 주장합니다. (출처: ClementDelangue)

Reddit 뜨거운 논쟁: LLM 워크플로우 구축에 대한 관찰과 경험: 한 개발자가 Reddit에 지난 1년간 복잡한 LLM 워크플로우를 구축한 경험을 요약하여 공유했습니다. 핵심 사항은 다음과 같습니다: 작업을 최소 단계로 분해하고 프롬프트를 연쇄적으로 호출하는 것이 단일 복잡한 프롬프트보다 우수합니다. XML 태그를 사용하여 프롬프트 구조를 구축하는 것이 더 효과적입니다. LLM에게 그 역할이 의미론적 분석 및 변환에 불과하며 자체 지식을 도입해서는 안 된다는 점을 명확히 알려야 합니다. NLTK와 같은 전통적인 NLP 라이브러리를 사용하여 LLM 출력을 검증해야 합니다. 소규모 작업에서는 미세 조정된 BERT 계열 분류기가 LLM보다 우수한 경우가 많습니다. LLM을 심판으로 사용하거나 신뢰도 점수를 매기는 것은 신뢰할 수 없으며, 특히 명확한 채점 기준이 없을 때 더욱 그렇습니다. 에이전트 순환에서 LLM이 순환을 종료하는 조건을 설정하는 것은 어려운 점입니다. 성능은 일반적으로 입력 컨텍스트 창이 4K 토큰을 초과하면 저하됩니다. 32B 모델은 구조화된 작업에서 이미 충분합니다. 구조화된 CoT가 비구조화된 CoT보다 우수합니다. 자체 작성 CoT가 추론 모델에 의존하는 것보다 우수합니다. 장기 목표는 모든 구성 요소를 미세 조정하고 균형 잡힌 미세 조정 데이터 세트를 구축하는 데 주의하는 것입니다. (출처: Reddit r/LocalLLaMA)

Reddit 사용자, Claude Sonnet 3.7 시스템 프롬프트 설정 논의: Reddit r/ClaudeAI 커뮤니티 사용자들이 Claude Sonnet 3.7 모델이 지침 준수, 코드 수정 및 컨텍스트 기억 측면에서 불안정성을 보인다고 지적하며 효과적인 시스템 프롬프트를 모집했습니다. 일부 사용자는 Sonnet 3.5의 동작을 모방한 프롬프트와 효율적이고 실용적인 솔루션, DRY, KISS, SRP와 같은 핵심 컴퓨터 과학 원칙 준수를 강조하는 상세한 지침을 공유했습니다. 또한 Claude가 시스템 프롬프트를 자체적으로 다시 작성하고 최적화하도록 하거나 간결하고 명확한 단일 라인 지침을 사용하여 효과를 높일 것을 제안하는 사용자도 있었습니다. (출처: Reddit r/ClaudeAI)

LLM 미세 조정에 필요한 Epoch 수에 대한 논의: Reddit r/MachineLearning에서 한 사용자가 Deepseek R1 논문에서 Deepseek-V3-Base 모델(약 80만 샘플)을 단 2 Epoch만으로 미세 조정한 것에 대해 의문을 제기하며, 손실 함수 외에 평가 데이터 성능 및 데이터 품질과 같이 미세 조정 Epoch 수를 결정하는 지표에 대해 논의했습니다. (출처: Reddit r/MachineLearning)

💡 기타

François Chollet: 견고한 사고 모델 구축은 어려운 문제 해결의 전제 조건: AI 사상가 François Chollet는 명확하고 일관된 사고 모델을 구축하는 것이 (운에 의존하는 것이 아니라) 창의적으로 어려운 문제를 해결하기 위한 선결 조건이며, 이는 간단한 문제를 빠르게 해결하는 능력과는 다르다고 강조했습니다. 그는 우아함은 표현력과 간결성의 결합이며 압축과 밀접하게 관련되어 있다고 생각합니다. (출처: fchollet, teortaxesTex, fchollet, pmddomingos)

Replit CEO Amjad Masad: AI 에이전트가 프로그래밍의 새로운 물결이 될 것: Replit의 CEO 겸 공동 창립자인 Amjad Masad는 The Turing Post와의 인터뷰에서 AI 에이전트가 프로그래밍의 다음 물결을 이끌 것이라고 항상 생각해 왔다고 말했습니다. 그는 프로그래밍을 가르치는 것에서 자동으로 프로그래밍할 수 있는 에이전트를 구축하는 것으로의 전환 아이디어를 공유했습니다. 그는 소프트웨어 에이전트가 이미 실제 비즈니스에서 효과를 내고 있으며, 예를 들어 부동산 기업이 리드 할당 알고리즘을 최적화하여 전환율을 10% 향상시키는 데 도움을 주었다고 언급했습니다. 그는 미래의 10억 달러 규모 스타트업은 AI로 강화된 독립 창업자에 의해 만들어질 수 있다고 생각하며, 이 비전을 실현하는 데 필요한 조건, 프로그래밍 분야의 현황과 미래, Replit의 비전 변화, AGI 및 오픈 소스의 중요성에 대해 논의했습니다. (출처: TheTuringPost, TheTuringPost)

LazyVim: ‘게으른 사람’을 위한 Neovim 구성: LazyVim은 lazy.nvim을 기반으로 하는 Neovim 구성 솔루션으로, 사용자가 Neovim 환경을 쉽게 사용자 정의하고 확장할 수 있도록 하는 것을 목표로 합니다. 사전 구성되고 기능이 풍부한 IDE와 유사한 환경을 제공하는 동시에 높은 유연성을 유지하여 사용자가 필요에 따라 조정할 수 있도록 합니다. (출처: GitHub Trending)