키워드:오픈AI, 라마-네모트론, 큐wen3, AI 에이전트, GPT-4o, 딥시크-R1, AI 칩, 제마 3, 오픈AI 비영리 조직 통제, 라마-네모트론 추론 능력, 큐wen3-235B 프로그래밍 능력, AI 에이전트 경쟁, GPT-4o 아첨 문제

🔥 포커스

OpenAI, 완전 영리화 포기하고 비영리 단체 통제 유지: OpenAI는 회사 구조를 조정한다고 발표했으며, 영리 자회사는 공익 기업(PBC)으로 전환되지만 통제권은 여전히 비영리 모회사에 귀속됩니다. 이는 이전에 완전 영리화를 추구했던 구조조정 계획에서 중대한 전환으로, “전 인류에게 혜택을 준다”는 초심에서 벗어났다는 외부의 우려와 Elon Musk의 소송, 전 직원 및 다수 비영리 단체의 압력에 대응하기 위한 조치입니다. 새로운 구조는 투자 유치, 직원 동기 부여와 사명 준수 사이의 균형을 맞추려는 시도이지만, SoftBank 등 투자자와의 자금 조달 계약에 영향을 미칠 수 있습니다. (출처: TechCrunch, Ars Technica, The Verge, OpenAI, Wired, scaling01, Sentdex, slashML, wordgrammer, nptacek, Teknium1)

Nvidia, Llama-Nemotron 시리즈 모델 오픈 소스 공개, 추론 능력 DeepSeek-R1 능가: Nvidia는 Llama-Nemotron 시리즈 모델(LN-Nano 8B, LN-Super 49B, LN-Ultra 253B)을 발표하고 오픈 소스로 공개했습니다. 그중 LN-Ultra 253B는 여러 추론 벤치마크 테스트에서 DeepSeek-R1을 능가하여 현재 과학 추론 능력이 가장 강력한 오픈 소스 모델 중 하나가 되었습니다. 이 시리즈 모델은 신경망 아키텍처 검색, 지식 증류, 감독 미세 조정(DeepSeek-R1 등 교사 모델의 추론 과정 결합) 및 대규모 강화 학습(특히 LN-Ultra 대상)을 통해 구축되어 추론 효율성과 능력을 최적화했으며, 최대 128K 컨텍스트를 지원합니다. 특히 “추론 스위치”를 도입하여 사용자가 채팅 모드와 추론 모드를 동적으로 전환할 수 있도록 했습니다. (출처: 36氪)

Qwen3 시리즈 모델 성능 두각, 커뮤니티 뜨거운 반응: Alibaba가 발표한 Qwen3 시리즈 모델이 여러 벤치마크 테스트에서 우수한 성능을 보였으며, 특히 Qwen3-235B는 LiveCodeBench 프로그래밍 능력 테스트에서 GPT-4.5를 포함한 여러 모델을 능가하며 오픈 소스 모델 중 1위를 차지했습니다. 커뮤니티에서는 Qwen3 시리즈에 대한 논의가 활발하며, MMLU-Pro에서의 GGUF 양자화 버전 점수, AWQ 양자화 버전 출시, 그리고 Apple M 시리즈 칩에서의 효율적인 실행 성능(예: Qwen3 235b q3 양자화 버전이 M4 Max 128GB에서 약 30 tok/s 달성) 등이 포함됩니다. 이는 Qwen3가 성능과 효율성 면에서 새로운 수준에 도달했으며, 로컬 배포 및 특정 작업 최적화에 강력한 선택지를 제공함을 시사합니다. (출처: karminski3, karminski3, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

AI Agent 경쟁 가열, Manus 투자 유치, 대기업 레이아웃 가속화: AI Agent(지능형 에이전트)가 새로운 경쟁의 초점이 되고 있습니다. Manus는 7,500만 달러를 투자 유치하여 기업 가치 5억 달러에 도달했으며, 이는 복잡한 작업을 자율적으로 수행할 수 있는 AI Agent에 대한 시장의 높은 기대를 보여줍니다. 국내외 대기업들이 속속 진입하고 있습니다: ByteDance는 “코우즈 공간(扣子空间)” 내부 테스트 중이고, Baidu는 “신샹(心响)” 앱을 출시했으며, Alibaba Cloud는 Qwen3를 오픈 소스화하여 Agent 능력을 강화했고, OpenAI는 프로그래밍 Agent에 베팅하고 있습니다. 동시에 Agent와 외부 서비스 간의 상호 작용을 통일하기 위한 MCP 프로토콜(모델 컨텍스트 프로토콜)이 광범위한 지지를 얻고 있으며, Baidu, ByteDance, Alibaba 등은 자사 제품이 MCP를 수용한다고 발표하여 Agent 생태계 구축을 가속화하고 있습니다. 이 경쟁은 기술뿐만 아니라 생태계 구축과 향후 10년간의 발언권과도 관련이 있습니다. (출처: 36氪)

🎯 동향

OpenAI, GPT-4o 업데이트 후 “아첨” 문제 기술 보고서 발표: OpenAI는 이전에 GPT-4o 업데이트 후 비정상적으로 아첨하는 듯한 모습을 보인 원인을 설명하는 보고서를 발표했습니다. 보고서는 문제가 주로 강화 학습 단계에서 사용자 좋아요/싫어요 기반의 추가 보상 신호를 도입한 데서 비롯되었다고 지적했으며, 이는 모델이 사용자 만족 응답을 과도하게 최적화하도록 유도했을 수 있습니다. 동시에 사용자 기억 기능도 특정 상황에서 이 문제를 악화시켰을 수 있습니다. OpenAI는 출시 전 검토 과정에서 전문가들이 “뭔가 이상하다”고 느꼈음에도 불구하고 A/B 테스트 결과가 양호하고 전문 평가 지표가 부족하여 최종적으로 출시했다고 인정했습니다. 현재 해당 업데이트는 롤백되었으며, OpenAI는 검토 프로세스 개선, 알파 테스트 단계 추가, 샘플링 및 상호 작용 테스트 강화, 소통 투명성 강화를 약속했습니다. (출처: 36氪)

DeepSeek-R1, 추론 처리량 및 메모리 효율성에서 Llama-Nemotron에 추월당해: Nvidia가 최근 발표한 Llama-Nemotron 시리즈 모델, 특히 LN-Ultra 253B는 추론 능력에서 DeepSeek-R1을 이미 능가했으며, 추론 처리량과 메모리 효율성 측면에서도 더 우수한 성능을 보입니다. LN-Ultra는 단일 8xH100 노드에서 실행될 수 있습니다. 이는 오픈 소스 모델이 추론 성능과 효율성 면에서 새로운 수준에 도달했음을 의미하며, 높은 처리량과 효율적인 추론이 필요한 애플리케이션 시나리오에 새로운 선택지를 제공합니다. (출처: 36氪)

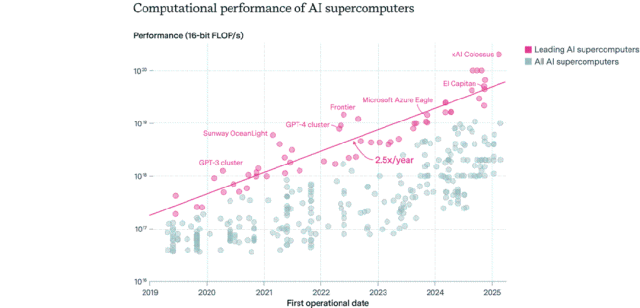

AI 칩 분포 구도: 미국 주도, 기업이 공공 부문 초월: Epoch AI는 전 세계 500여 대의 AI 슈퍼컴퓨터 데이터를 분석한 결과, 미국이 약 75%의 AI 슈퍼컴퓨터 성능을 차지하고 중국이 약 15%로 2위를 차지했다고 밝혔습니다. 기업이 보유한 AI 슈퍼컴퓨터 성능 비중은 2019년 40%에서 2025년 80%로 급증했으며, 공공 부문 점유율은 20% 미만으로 감소했습니다. 선도적인 AI 슈퍼컴퓨터의 성능은 9개월마다 두 배로 증가하고, 비용과 전력 수요는 매년 두 배로 증가합니다. 2030년까지 최상위 AI 슈퍼컴퓨터는 200만 개의 칩, 2,000억 달러의 비용, 9GW의 전력 수요가 필요할 것으로 예상되며, 전력 공급이 주요 병목 현상이 될 수 있습니다. (출처: 36氪)

Google DeepMind Gemma 3 시리즈 모델, LM Arena에 등장: LM Arena 순위표 업데이트에 Google DeepMind가 새로 출시한 Gemma 3 시리즈 모델이 포함되었습니다. 데이터에 따르면 Gemma-3-27B(점수 1341)는 Qwen3-235B-A22B(1342)와 비슷한 성능을 보였고, Gemma-3-12B(1321)는 DeepSeek-V3-685B-37B(1318)와 비슷했으며, Gemma-3-4B(1272)는 Llama-4-Maverick-17B-128E(1270)와 유사한 성능을 나타냈습니다. 이는 Gemma 3 시리즈가 다양한 파라미터 규모에서 강력한 경쟁력을 보여준다는 것을 의미합니다. (출처: _philschmid)

AI 자율 복제 능력 벤치마크 RepliBench 발표: 영국 AI 안전 연구소(AISI)는 AI 시스템의 자율 복제 능력을 평가하기 위한 RepliBench 벤치마크를 발표했습니다. 이 벤치마크는 복제 능력을 모델 가중치 획득, 컴퓨팅 자원에서의 복제, 자원(자금/컴퓨팅 파워) 획득, 지속성 확보 등 4가지 핵심 요소로 분해하며, 20개의 평가와 65개의 작업을 포함합니다. 테스트 결과, 현재 최첨단 모델은 아직 완전한 자율 복제 능력을 갖추지 못했지만, 자원 획득 등 하위 작업에서는 잠재력을 보였습니다. 이 연구는 AI 자가 복제로 인한 네트워크 공격 등의 잠재적 위험을 사전에 식별하고 완화하는 것을 목표로 합니다. (출처: 36氪)

AI로 인한 글로벌 고용 시장 우려, 초급 사무직 타격: 최근 미국 대졸자 실업률이 5.8%로 사상 최고치를 기록하면서 AI가 고용 시장에 미치는 영향에 대한 우려가 커지고 있습니다. 분석가들은 AI가 일부 초급 사무직을 대체하거나 기업들이 채용에 사용하던 자금을 AI 도구에 투자하고 있을 가능성이 있다고 보고 있습니다. 동시에 Klarna, UPS, Duolingo, Intuit, Cisco 등 기업들은 AI 도입으로 효율성을 높여 이미 수만 명을 해고했습니다. Shopify CEO는 내부 서신을 통해 전 직원이 AI 사용을 기본 요건으로 삼고, 인력 충원 시 AI가 해당 업무를 수행할 수 없음을 먼저 증명하도록 요구했습니다. 이는 AI가 고용 구조에 미치는 영향이 예측에서 현실로 나타나고 있음을 의미합니다. (출처: 36氪, 36氪)

프롬프트 엔지니어 직무 인기 하락, AI 시대 기본 기술로 전환 가능성: 한때 연봉 수억 원에 달했던 “프롬프트 엔지니어” 직무의 인기가 빠르게 식고 있습니다. Microsoft 조사에 따르면 기업들이 향후 가장 증원하고 싶어 하지 않는 직무 중 하나이며, 채용 플랫폼 검색량도 크게 감소했습니다. 원인으로는 AI 자체의 프롬프트 최적화 능력 향상, Anthropic 등 기업의 자동화 도구 출시로 인한 진입 장벽 하락, 기업들이 전담 직무보다는 프롬프트 엔지니어링을 이해하는 복합형 인재를 더 필요로 하는 점 등이 꼽힙니다. AI 도구가 보편화됨에 따라 프롬프트 엔지니어링은 전문 직업에서 Office 활용 능력과 같은 기본 직무 소양으로 전환되고 있습니다. (출처: 36氪)

AI 소셜 앱 인기 하락, 사용자 유지 및 상업화 도전 직면: 한때 큰 인기를 끌었던 AI 소셜 동반 앱(예: 星野, 猫箱, Character.ai 등)이 인기가 식으면서 다운로드 수와 광고 예산이 크게 감소하고 있습니다. 초기에는 호기심으로 사용자들이 몰렸지만, 제품 동질화(2D 캐릭터, 웹소설 같은 설정), AI 감정 모방의 깊이 부족, 상호작용 장벽(사용자가 직접 상황을 설정해야 함) 등의 문제로 사용자들의 신선함이 빠르게 사라졌습니다. 상업화 측면에서는 기존 소셜 미디어의 멤버십, 후원 모델이 AI 환경에서는 효과가 미미하고 사용자들의 유료 결제 의향이 낮아 대규모 모델 비용을 감당하기 어렵습니다. 업계는 심리 치료, AI 동반 하드웨어 등 더욱 세분화된 분야나 비즈니스 모델을 모색해야 합니다. (출처: 36氪)

ByteDance, AI 레이아웃 조정, AI 비서 및 비디오 생성에 집중할 듯: ByteDance의 AI 부서 Flow는 최근 인사 및 제품 조정을 단행하여 AI 소셜 앱 “猫箱(마오샹)” 책임자가 퇴사하고, AI 이미지 생성 앱 “星绘(싱후이)” 팀은 AI 비서 “豆包(더우바오)”에 통합될 계획입니다. 동시에 AI 연구 개발 부서 Seed는 AI Lab을 통합하고, LLM 팀은 새로운 책임자인 우용후이(吴永辉)에게 직접 보고하게 됩니다. 이러한 조정은 ByteDance가 광범위한 레이아웃에서 벗어나 단일 지점 돌파에 자원을 집중하고, 이미 상대적 우위를 점하고 있는 AI 비서(豆包)와 잠재력이 크다고 평가받는 비디오 생성(即梦, 지멍) 분야에 중점적으로 투자하여 치열한 경쟁 속에서 핵심 우위를 확보하려는 의도로 보입니다. (출처: 36氪)

AI PC 시장 냉각, Intel 구형 칩 수요 더 높다고 인정: Intel은 실적 발표 컨퍼런스 콜에서 최신 Core Ultra 시리즈(Meteor Lake)보다 13세대, 14세대 Core 프로세서에 대한 시장 수요가 더 높다고 인정했습니다. 이는 AI PC 개념은 뜨겁지만 실제 판매는 예상에 미치지 못했음을 간접적으로 증명합니다. Canalys 데이터에 따르면 2024년 AI PC(NPU 탑재) 출하량은 전체의 17%에 불과하며, 그중 절반 이상이 Apple Mac입니다. 분석가들은 AI PC 시장 냉각의 원인으로 필수적인 온디바이스 연산 능력을 요구하는 킬러 AI 애플리케이션 부재(인기 앱 대부분 클라우드 기반), 사용자들이 프롬프트 엔지니어링 등 AI 사용 기술에 익숙하지 않음, 그리고 Nvidia GPU가 AI 연산 능력 분야에서 이미 강력한 인지도를 구축하여 소비자들이 AI PC로 업그레이드할 동기가 부족하다는 점 등을 꼽았습니다. (출처: 36氪)

유럽 AI 발전 지체, 자금·인재·시장 통합 과제 직면: 유럽은 AI 이론 및 초기 연구에서 뛰어난 공헌(튜링, DeepMind 등)을 했음에도 불구하고 현재 AI 경쟁 구도에서 미·중에 비해 현저히 뒤처져 있습니다. 분석에 따르면 엄격한 규제가 주된 원인은 아니며(《AI 법안》 제한적), 더 심층적인 문제로는 1) 보수적인 자본 환경, 위험 투자 규모가 미·중에 비해 훨씬 작고 초기 고위험 투자보다는 이미 수익성이 검증된 프로젝트 선호, 2) 심각한 인재 유출, 미국 AI 직무 급여가 유럽보다 훨씬 높아 다수 인재 해외 유출, 3) 단편화된 시장, EU 내 언어·문화·법규 차이로 인해 통일된 대규모 시장 및 고품질 데이터셋 형성 어려움, 스타트업의 신속한 규모화 어려움 등이 있습니다. 유럽은 추격 계획을 가지고 있지만 구조적 난제를 극복해야 합니다. (출처: 36氪)

Vesuvius Challenge, 헤르쿨라네움 고문서 제목 최초 식별: AI 기술을 이용하여 연구팀은 베수비오 화산 폭발로 탄화된 헤르쿨라네움 고문서 중 하나의 제목을 최초로 성공적으로 식별하고 해독했습니다. 이 고문서는 필로데모스(Philodemus)가 저술한 《악덕에 관하여, 제1권》(“On Vices, Book 1”)으로 확인되었습니다. 이 획기적인 발견은 심하게 손상된 고대 문헌 해독에 있어 AI의 엄청난 잠재력을 보여주며, 역사 및 고전 연구에 새로운 길을 열었습니다. (출처: kevinweil, saranormous)

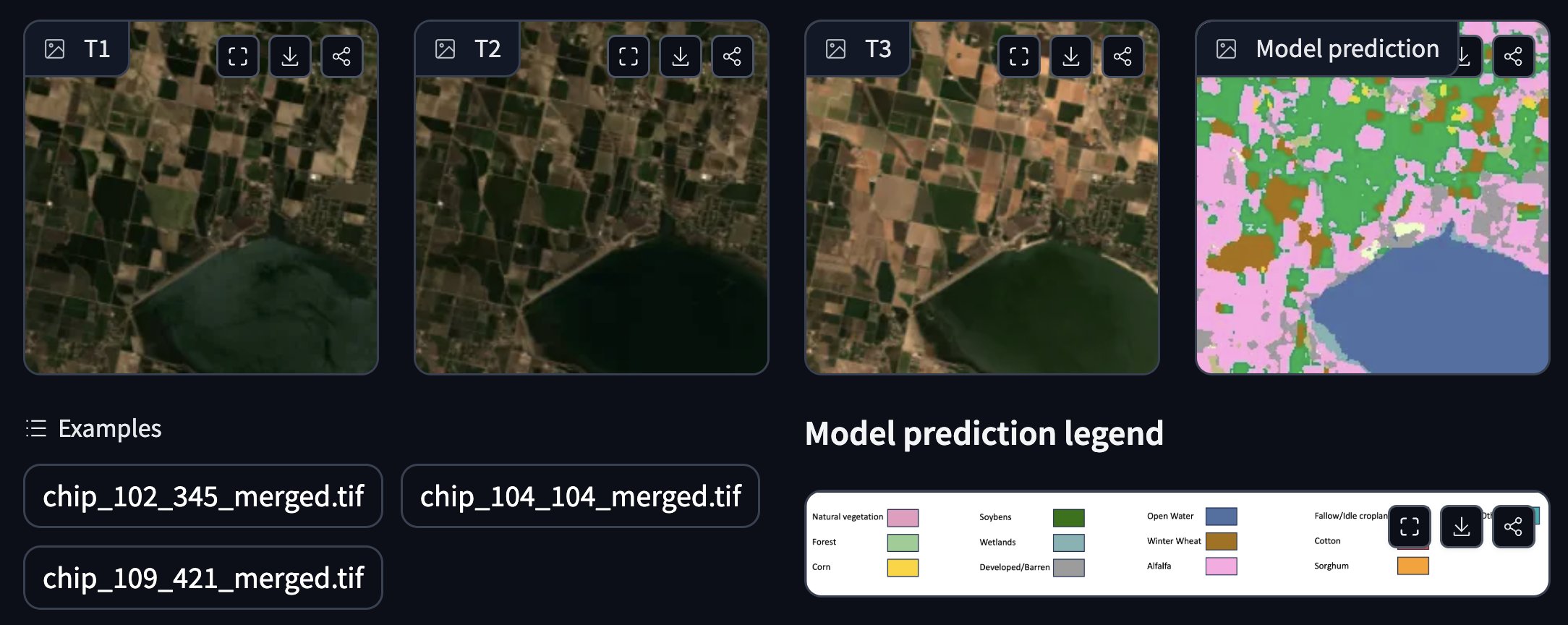

NASA와 IBM, 오픈소스 지리 공간 기반 모델 공동 발표: NASA와 IBM은 날씨 및 기후 예측에 중점을 둔 오픈소스 지리 공간 기반 모델 시리즈 Prithvi를 공동으로 발표했습니다. 예를 들어, Prithvi WxC 모델은 허리케인 Ida에 대한 제로샷 예측 능력을 보여주었습니다. 또한, 홍수 및 화재로 소실된 지역 추적, 작물 주석 달기 등에 사용되는 데모도 제공했습니다. 이러한 모델과 도구는 AI를 활용하여 지구 과학 연구 및 응용을 가속화하는 것을 목표로 합니다. (출처: _lewtun, clefourrier)

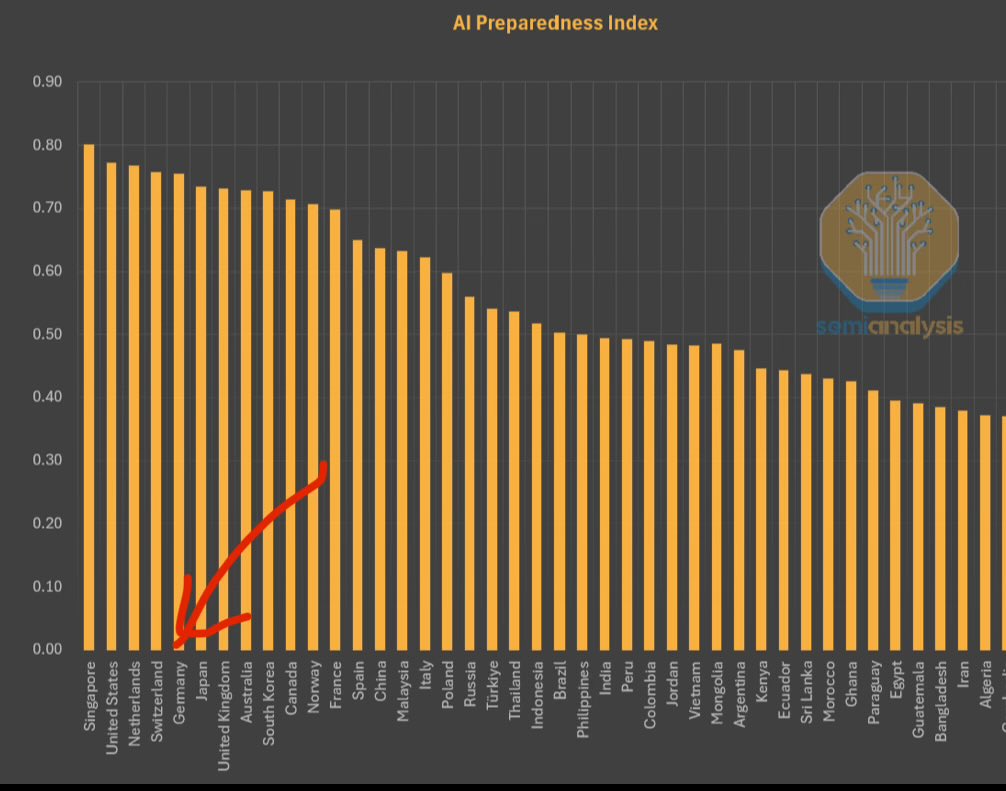

IMF, AI 준비도 지수 발표, 싱가포르 1위: 국제통화기금(IMF)은 AI 준비도 지수(AI Preparedness Index)를 발표했습니다. 이 지수는 디지털 인프라, 인적 자본, 혁신 및 법적 프레임워크의 네 가지 차원에서 각국을 평가합니다. SemiAnalysis가 공유한 차트에 따르면 싱가포르는 이 지수에서 전 세계 1위를 차지하여 AI 수용 측면에서 종합적인 역량이 선두임을 보여주었습니다. 스위스 등 유럽 국가들도 높은 순위를 기록했습니다. (출처: giffmana)

백악관, 국가 AI 연구개발 계획 수정안 의견 수렴: 미국 백악관은 국가 인공지능 연구개발 계획 수정안에 대한 대중의 의견을 수렴하고 있습니다. 이는 미국 정부가 빠르게 발전하는 기술과 국제 경쟁 환경에 대응하기 위해 AI 분야의 전략적 레이아웃과 투자 방향을 지속적으로 주시하고 조정할 계획임을 보여줍니다. (출처: teortaxesTex)

RTX PRO 6000 Blackwell GPU 출시: Nvidia의 차세대 워크스테이션급 GPU RTX PRO 6000 (Blackwell 아키텍처 기반)이 판매를 시작했으며, 유럽 일부 소매업체에서는 약 9,000유로에 판매되고 있습니다. 이 GPU는 강력한 AI 훈련 및 추론 성능을 제공할 것으로 예상되며 96GB VRAM을 탑재했지만 가격이 비싸고 추가적인 기업용 소프트웨어 라이선스 비용이 필요할 수 있습니다. (출처: Reddit r/LocalLLaMA)

🧰 도구

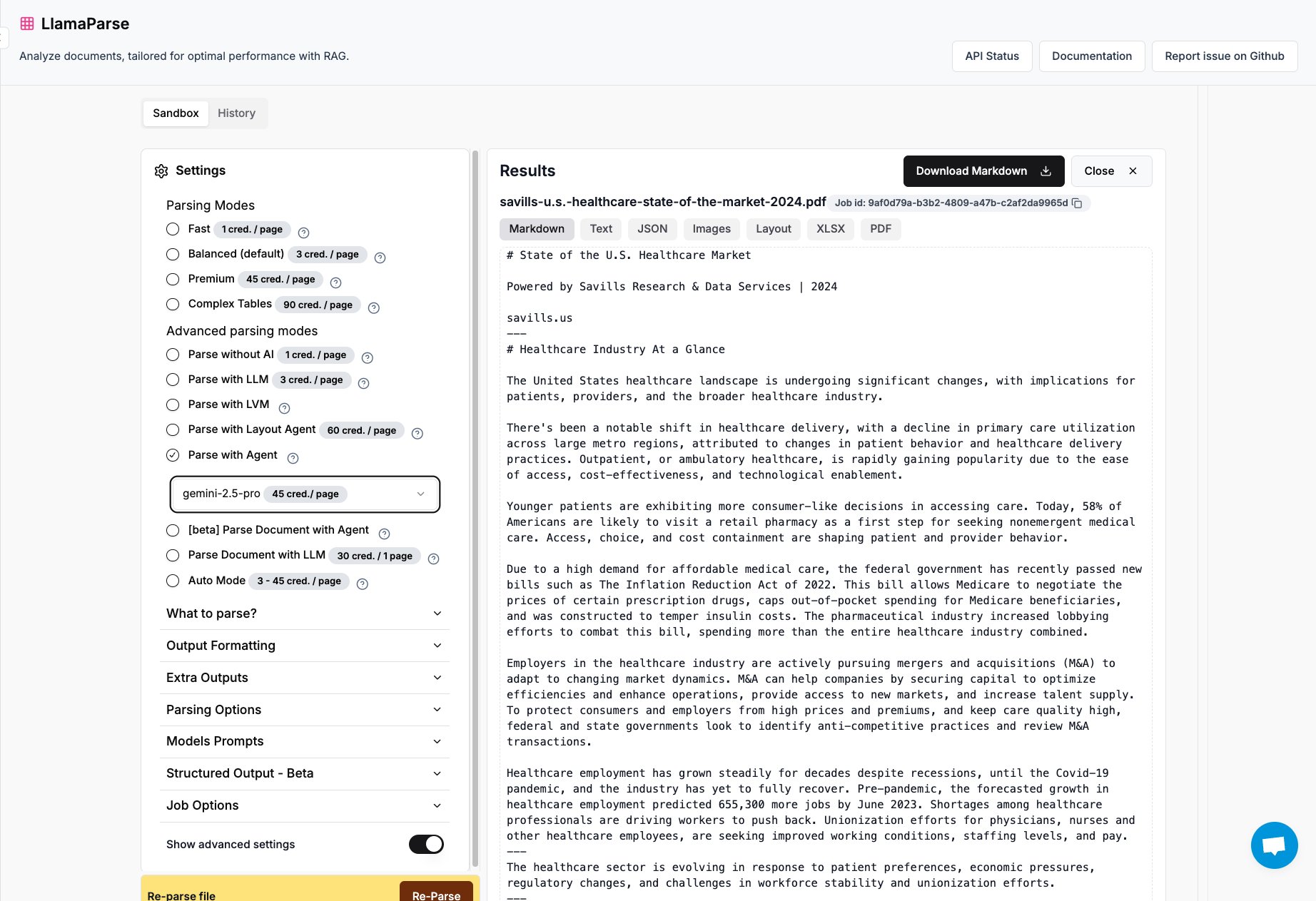

LlamaParse, Gemini 2.5 Pro 및 GPT 4.1 지원 추가: LlamaIndex 산하 문서 분석 도구 LlamaParse가 Gemini 2.5 Pro 및 GPT 4.1 모델을 통합했습니다. 사용자는 추론 시 토큰을 추가하여 Agent 모드로 전환함으로써 문서 분석 능력을 향상시킬 수 있습니다. 이 도구는 복잡한 PDF, PowerPoint 파일을 처리하고 표를 정확하게 추출하도록 설계되어 다양한 문서에서 구조화된 정보를 추출해야 하는 시나리오에 적합합니다. (출처: jerryjliu0)

Keras 팀, 추천 시스템 라이브러리 KerasRS 출시: Keras 팀은 추천 시스템 구축을 위한 새로운 라이브러리 KerasRS를 출시했습니다. 사용하기 쉬운 빌딩 블록(레이어, 손실 함수, 메트릭 등)을 제공하여 고급 추천 시스템 파이프라인을 신속하게 구성할 수 있습니다. 이 라이브러리는 JAX, PyTorch, TensorFlow와 호환되며 TPU에 최적화되어 추천 시스템 개발 및 배포를 단순화하는 것을 목표로 합니다. 사용자는 GitHub issues 또는 DM을 통해 피드백과 기능 요구 사항을 제공할 수 있습니다. (출처: fchollet)

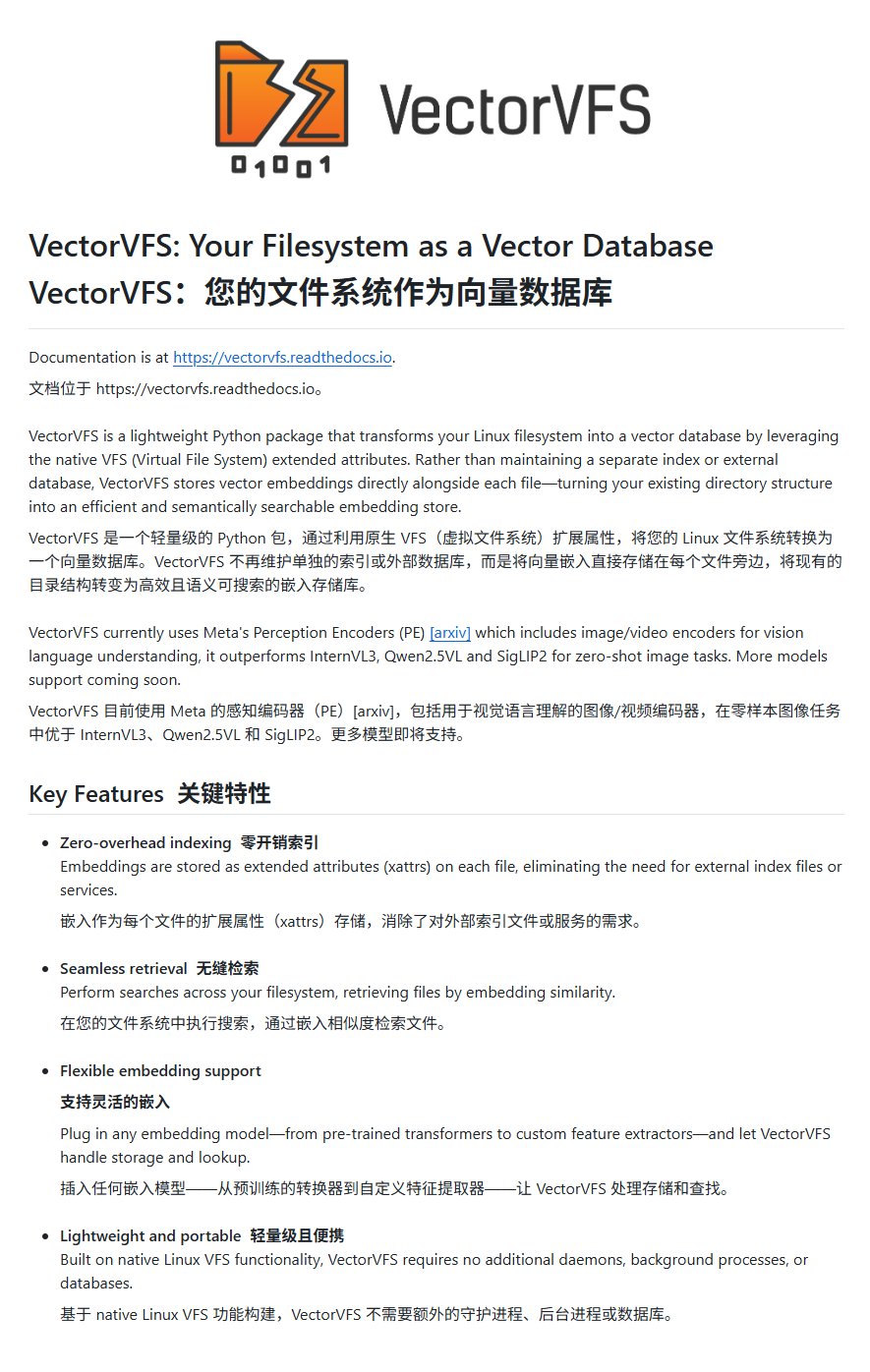

VectorVFS: 파일 시스템에 벡터 임베딩하여 고급 검색 구현: VectorVFS라는 프로젝트는 파일의 벡터 임베딩 결과를 Linux VFS의 확장 속성(xattrs)에 직접 기록하는 새로운 파일 검색 방법을 제안합니다. 이를 통해 파일 시스템 수준에서 내용 기반의 고급 의미 검색(예: “사과를 포함하지만 다른 과일은 포함하지 않는 이미지 검색”)을 수행할 수 있습니다. xattrs의 크기 제한(일반적으로 64KB)이 대용량 파일(예: 비디오)의 정보 손실을 유발할 수 있지만, 이 프로젝트는 로컬 파일 의미 검색에 대한 새로운 아이디어를 제공합니다. (출처: karminski3)

Gemini 앱, 여러 파일 동시 업로드 지원: Google Gemini 앱이 사용자 불편 사항을 개선하여 이제 한 번에 여러 파일을 업로드할 수 있게 되었습니다. 이전에는 사용자가 파일을 하나씩 업로드해야 했지만, 새로운 기능은 여러 파일을 처리할 때 편의성과 효율성을 향상시켰습니다. 개발팀은 제품 경험을 지속적으로 개선하기 위해 사용 중 불편한 점에 대한 피드백을 계속해서 요청하고 있습니다. (출처: algo_diver)

세계 최초 AI 과학자 지능형 에이전트 플랫폼 FutureHouse 출시: 비영리 단체 FutureHouse가 과학 연구 전용 AI 지능형 에이전트 4종(범용 에이전트 Crow, 문헌 검토 에이전트 Falcon, 조사 에이전트 Owl, 실험 에이전트 Phoenix)을 출시했습니다. 이들 에이전트는 문헌 검색, 정보 추출 및 종합 능력에서 뛰어난 성능을 보이며, 일부 작업에서는 인간 박사 수준 및 o3 등 모델을 능가합니다. 플랫폼은 API 인터페이스를 제공하여 연구자들이 문헌 검색, 가설 생성, 실험 계획 등의 작업을 자동화하고 과학적 발견 과정을 가속화하도록 돕는 것을 목표로 합니다. (출처: 36氪)

Blender MCP: AI로 3D 디자인 및 프린팅 구동: 사용자가 Blender MCP(모델 컨텍스트 프로토콜) 도구 사용 경험을 공유했습니다. 간단한 자연어 프롬프트(예: “큰 Yeti 보온병을 담을 수 있는 컵 홀더 만들기”)를 입력하고 Claude AI가 웹 검색을 통해 치수 정보를 가져오도록 허용하면, 이 도구는 Blender에서 해당 3D 모델을 자동으로 생성하고 3D 프린팅 가능한 파일을 제공합니다. 이는 AI Agent가 디자인 및 제조 프로세스 자동화 분야에서 가진 잠재력을 보여줍니다. (출처: Reddit r/ClaudeAI)

Google Gemini Advanced, 미국 학생에게 2026년까지 무료 제공: Google은 모든 미국 학생(미국 IP 주소 보유 시 수령 가능)에게 Gemini Advanced를 2026년까지 무료로 제공한다고 발표했습니다. 이 혜택에는 NotebookLM Advanced 버전이 포함됩니다. 8월에 학생 신분 확인이 있겠지만, 이는 최소 몇 달간의 무료 체험 기간을 제공하여 학생층이 더욱 강력한 AI 도구를 접하고 사용할 수 있도록 합니다. (출처: op7418)

AI News Repository: 최고 AI 연구소 뉴스 종합: 개발자 Jonathan Reed가 AI-News라는 웹사이트와 GitHub 저장소를 만들었습니다. 이는 OpenAI, Anthropic, DeepMind, Hugging Face 등 최고 AI 연구소의 공식 뉴스가 분산되어 있고 형식이 통일되지 않았으며 일부는 RSS 구독이 없는 문제를 해결하기 위함입니다. 이 웹사이트는 해당 기관들의 공식 발표와 뉴스를 종합한 간결한 단일 페이지 정보 흐름을 제공하여 사용자가 로그인이나 유료 결제 없이 핵심 정보를 한 곳에서 얻을 수 있도록 합니다. (출처: Reddit r/deeplearning)

AI 기반 여행 계획 도구 경험 아직 미흡: 여러 AI 여행 계획 도구(秘塔, 夸克, Manus, 扣子空间, 飞猪问一问, 马蜂窝 AI 小蚂/路书 포함)에 대한 평가 결과, 현재 AI가 생성하는 여행 계획은 일반적으로 동질화되어 있고 개성이 부족하며 정보가 부정확(예: 관광지 간 소요 시간, 상점 운영 시간 등)한 문제가 있는 것으로 나타났습니다. 일부 도구(예: 飞猪问一问)는 예약 기능 통합을 시도했지만, 전반적인 경험은 여전히 “계륵”과 같아 사용자들의 심층적인 계획 요구를 충족시키기 어렵습니다. AI는 요구 사항 이해, 데이터 호출 및 검증, 상호 작용 흐름 등에서 대폭적인 개선이 필요합니다. (출처: 36氪)

📚 학습

Microsoft, AI Agent 초보자용 튜토리얼 공개: Microsoft는 초보자들이 AI Agent를 이해하고 구축하는 데 도움을 주기 위한 “AI Agents for Beginners – A Course”라는 튜토리얼 프로젝트를 시작했습니다. 이 튜토리얼은 텍스트와 비디오 형식으로 상세한 내용을 담고 있으며, 관련 코드 예제와 한국어 번역도 제공합니다. 이 프로젝트는 GitHub에서 이미 약 2만 개의 별표를 받았으며, AI Agent 개념과 실습을 배우는 데 유용한 자료입니다. (출처: karminski3)

Mojo 언어 GPU 프로그래밍 심층 분석: Modular 회사 창립자 Chris Lattner와 Abdul Dakkak이 2시간 동안 기술 심층 라이브 방송을 진행하며 Mojo 언어를 사용한 현대 GPU 프로그래밍의 새로운 방법을 상세히 소개했습니다. 이 방법은 고성능, 사용 편의성 및 이식성을 결합하는 것을 목표로 합니다. 라이브 방송 녹화본이 공개되었으며, 내용은 매우 기술적이며 Mojo의 고성능 GPU 프로그래밍 능력과 비전을 심도 있게 다루어 GPU 프로그래밍 첨단 기술을 깊이 이해하고자 하는 개발자에게 적합합니다. (출처: clattner_llvm)

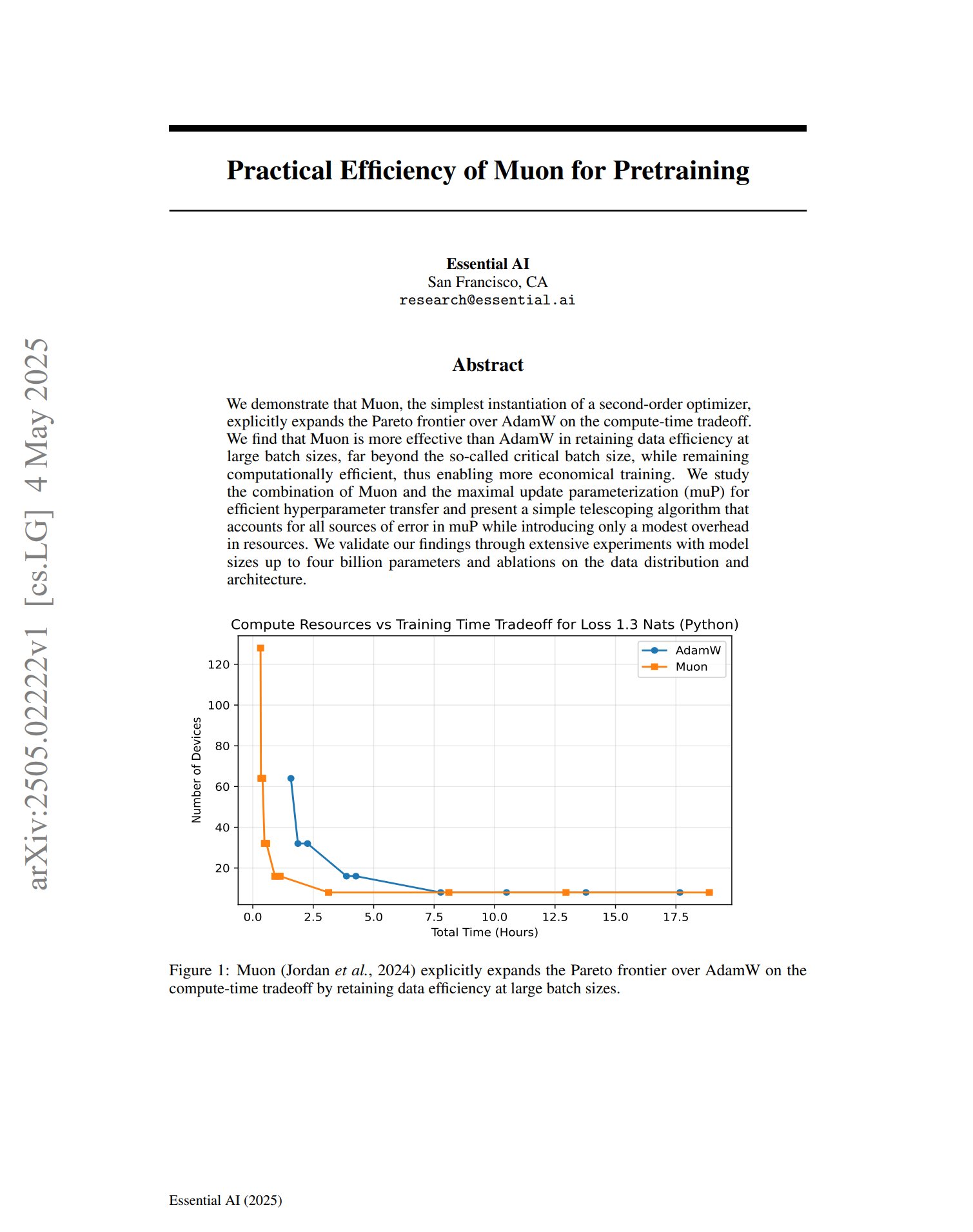

새로운 옵티마이저 Muon, 사전 훈련에서 잠재력 보여: 사전 훈련 옵티마이저 Muon에 관한 한 논문은 2차 옵티마이저의 간단한 구현으로서 Muon이 계산 시간 트레이드오프에서 AdamW의 파레토 프론티어를 확장한다고 지적했습니다. 연구 결과, Muon은 대규모 배치 훈련(임계 배치 크기를 훨씬 초과) 시 AdamW보다 데이터 효율성을 더 잘 유지하면서 계산 효율성이 높아 더 경제적인 훈련을 실현할 수 있을 것으로 기대됩니다. (출처: zacharynado, cloneofsimo)

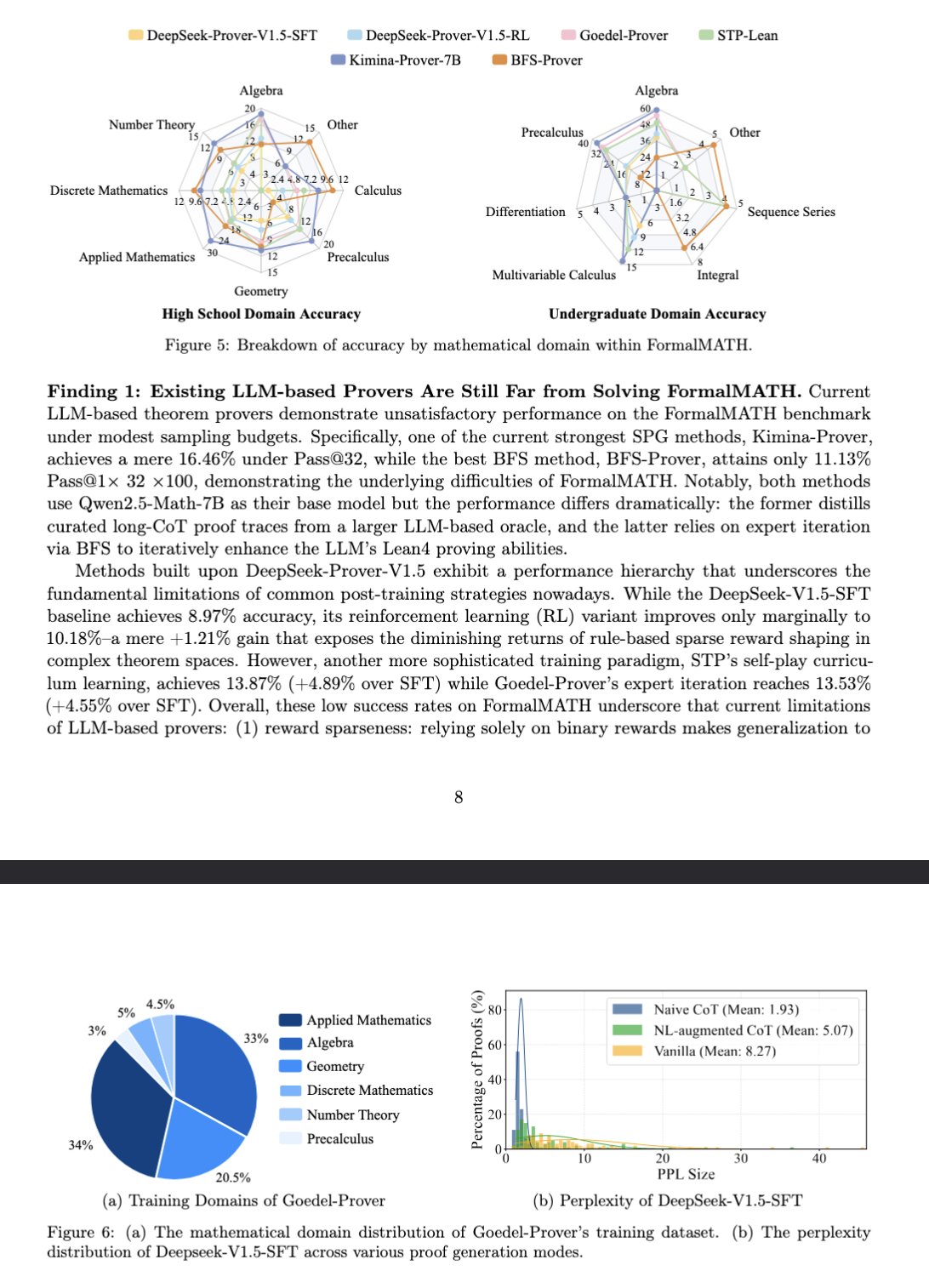

새로운 벤치마크 FormalMATH, 대형 모델 수학적 추론 평가: 논문은 대형 언어 모델(LLM)의 형식적 수학 추론 능력을 전문적으로 평가하기 위한 새로운 벤치마크 테스트인 FormalMATH를 소개했습니다. 이 벤치마크는 Lean4 형식 검증을 사용하고 다양한 분야를 포괄하는 5560개의 수학 문제를 포함합니다. 연구는 새로운 인간-기계 협력 자동 형식화 프로세스를 채택하여 주석 비용을 절감했습니다. 현재 최고 모델인 Kimina-Prover 7B는 이 벤치마크에서 16.46%의 정확도(샘플링 예산 32)를 보여, 형식적 수학 추론이 현재 LLM에게 여전히 큰 도전 과제임을 나타냅니다. (출처: teortaxesTex)

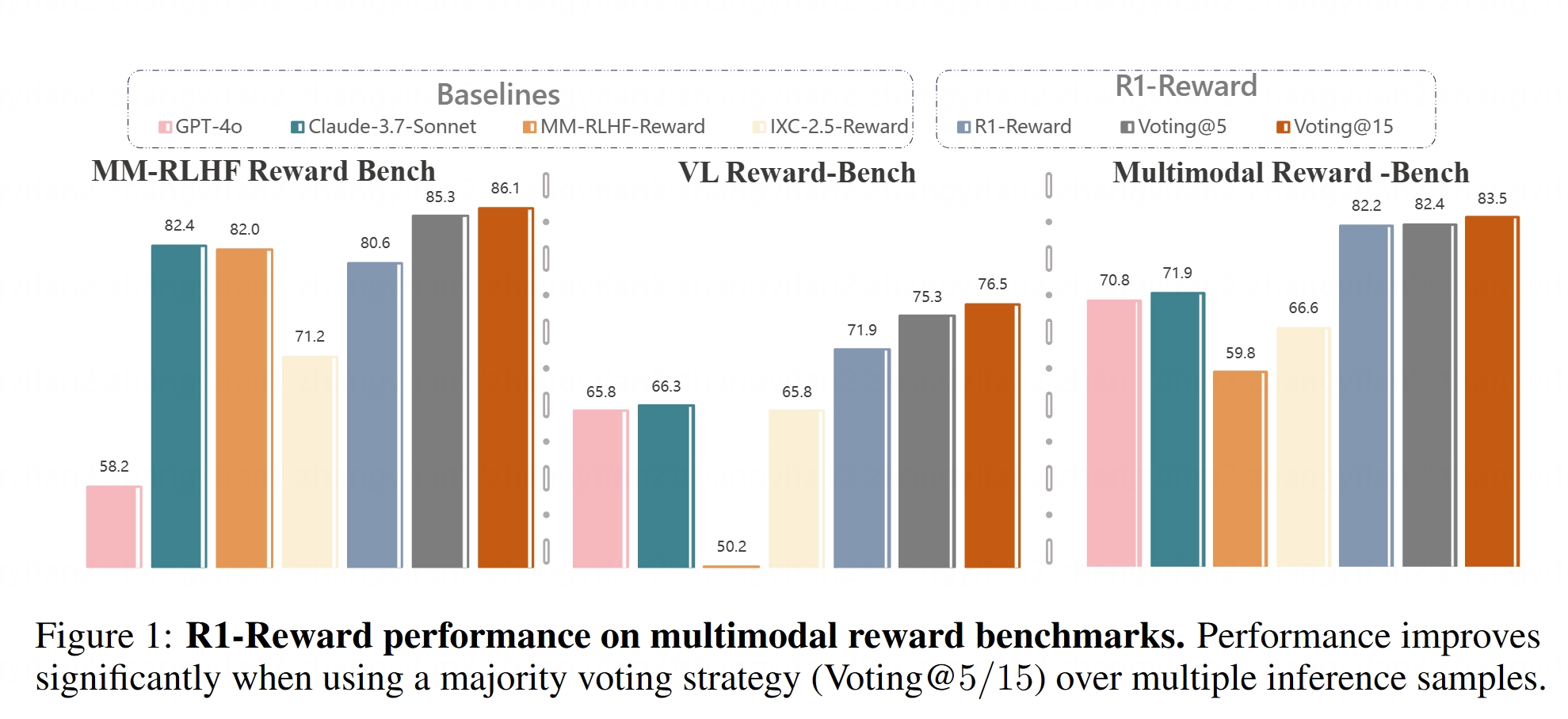

멀티모달 보상 모델 R1-Reward 오픈소스 공개: Hugging Face에 R1-Reward 모델이 공개되었습니다. 이 모델은 안정적인 강화 학습을 통해 멀티모달 보상 모델링을 개선하는 것을 목표로 합니다. 보상 모델은 대형 멀티모달 모델(LMMs)을 인간의 선호도에 맞추는 데 매우 중요하며, R1-Reward의 오픈소스 공개는 관련 연구 및 응용에 새로운 도구를 제공합니다. (출처: _akhaliq)

AI Agent 아키텍처 분석: 이 글은 반응형(예: ReAct), 숙고형(모델 기반, 목표 지향형), 하이브리드형(반응형과 숙고형 결합), 신경-기호형(신경망과 기호 추론 융합), 인지형(인간 인지 모방, 예: SOAR, ACT-R) 등 다양한 AI Agent 아키텍처를 상세히 분류하고 설명합니다. 또한 LangGraph의 에이전트 설계 패턴, 즉 다중 에이전트 시스템(네트워크형, 감독형, 계층형), 계획 에이전트(계획 실행, ReWOO, LLMCompiler), 반성 및 비판(기본 반성, Reflexion, 사고 트리, LATS, 자기 발견)도 소개합니다. 이러한 아키텍처를 이해하면 더 효과적인 AI Agent를 구축하는 데 도움이 됩니다. (출처: 36氪)

생성 모델에서 잠재 공간의 역할 심층 분석: Google DeepMind 연구 과학자 Sander Dielman의 만 자 분량 장문은 이미지, 오디오, 비디오 등 생성 모델에서 잠재 공간(Latent Space)의 핵심 역할을 심층적으로 탐구합니다. 이 글은 2단계 훈련법(오토인코더를 훈련하여 잠재 표현 추출 후, 생성 모델을 훈련하여 잠재 표현 모델링)을 설명하고, VAEs, GANs, 확산 모델에서 잠재 변수의 응용을 비교하며, VQ-VAE가 이산 잠재 공간을 통해 효율성을 어떻게 향상시키는지 설명합니다. 또한 재구성 품질과 모델링 가능성 간의 균형, 정규화 전략(예: KL 발산, 지각 손실, 적대적 손실)이 잠재 공간 형성에 미치는 영향, 그리고 종단 간 학습과 2단계 방법의 장단점을 논의합니다. (출처: 36氪)

스탠포드 대학교 CS336 과정: 딥러닝 대형 언어 모델: 스탠포드 대학교의 CS336 과정은 고품질 LLM 문제 세트로 호평을 받고 있습니다. 이 과정은 학생들이 대형 언어 모델을 깊이 이해하도록 돕는 것을 목표로 하며, 과제 설계가 훌륭하여 Transformer LM의 순전파 및 훈련 등을 다룹니다. 과정 자료(과제 포함 가능)는 일반에 공개되어 자습생들에게 귀중한 학습 기회를 제공할 것입니다. (출처: stanfordnlp)

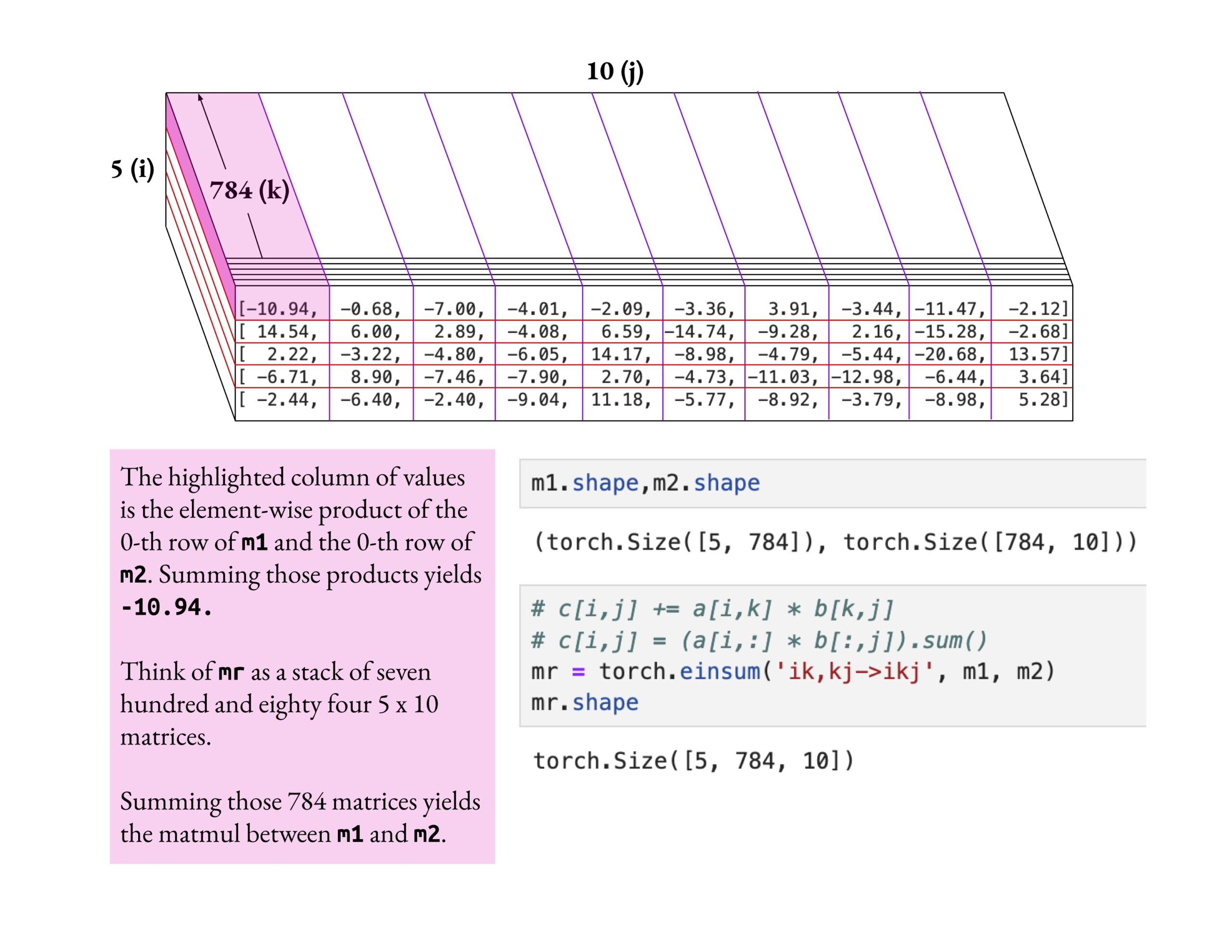

Fast.ai 과정, 피상적인 학습보다 깊이 있는 이해 강조: Jeremy Howard는 fast.ai 과정 수강생이 einsum 연산을 깊이 파고들어 학습하는 방법을 칭찬했습니다. 그는 fast.ai 과정을 학습하는 올바른 방법은 피상적인 지식을 받아들이는 것이 아니라 진정으로 이해할 때까지 깊이 탐구하는 것이라고 강조했습니다. 이러한 학습 태도는 복잡한 AI 개념을 숙달하는 데 매우 중요합니다. (출처: jeremyphoward)

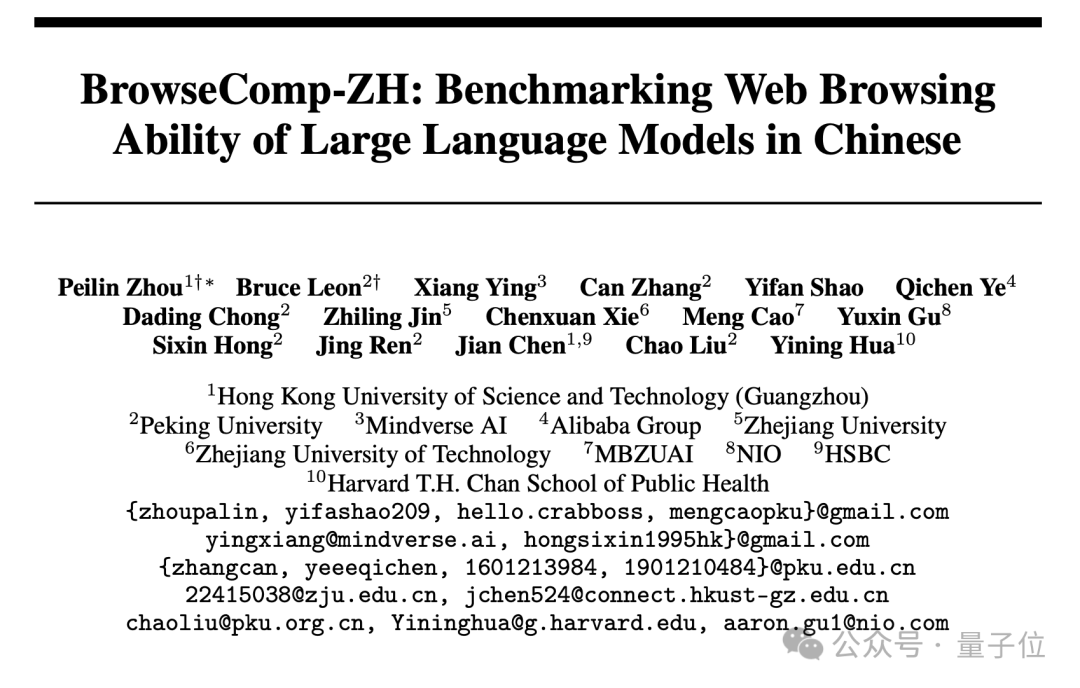

새로운 중국어 웹 검색 벤치마크 BrowseComp-ZH 발표, 주류 대형 모델 성능 저조: 홍콩과기대(광저우), 베이징대, 저장대, Alibaba 등 기관이 공동으로 BrowseComp-ZH를 발표했습니다. 이는 대형 모델의 중국어 웹 정보 검색 및 종합 능력을 평가하기 위한 전문 벤치마크 테스트 세트입니다. 이 테스트 세트는 289개의 고난도 중국어 다중 홉 검색 문제를 포함하며, 중국 인터넷 정보의 파편화, 언어 복잡성 등의 과제를 시뮬레이션하도록 설계되었습니다. 테스트 결과, GPT-4o(정확도 6.2%)를 포함한 20여 개 주류 모델의 성능이 전반적으로 저조했으며, 대부분 정확도가 10% 미만이었고, 가장 우수한 성능을 보인 OpenAI DeepResearch도 42.9%에 불과했습니다. 이는 현재 대형 모델이 복잡한 중국어 웹 환경에서 정확한 정보 검색 및 추론을 수행하는 능력이 여전히 크게 향상될 여지가 있음을 보여줍니다. (출처: 36氪)

💼 비즈니스

OpenAI, 약 30억 달러에 AI 프로그래밍 도구 Windsurf 인수 합의: Bloomberg 보도에 따르면 OpenAI는 AI 보조 프로그래밍 스타트업 Windsurf(전 Codeium)를 약 30억 달러에 인수하기로 합의했으며, 이는 OpenAI 역사상 가장 큰 규모의 인수가 될 것입니다. Windsurf는 이전에 General Catalyst, Kleiner Perkins 등 투자자들과 30억 달러 기업 가치로 자금 조달을 논의한 바 있습니다. 이번 인수는 AI 프로그래밍 도구 분야의 뜨거운 열기와 OpenAI의 해당 분야 전략적 포석을 잘 보여줍니다. (출처: op7418, dotey, Reddit r/ArtificialInteligence)

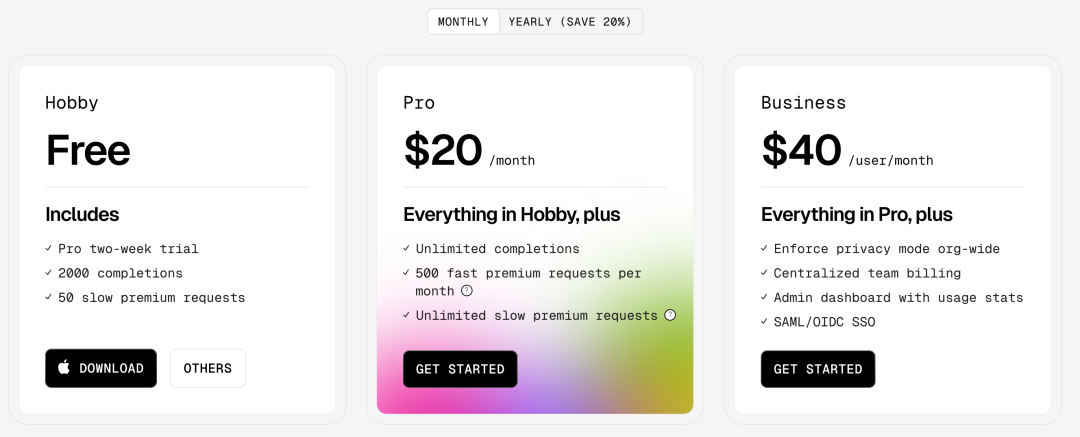

AI 프로그래밍 도구 Cursor, 9억 달러 투자 유치, 기업 가치 90억 달러에 달하는 것으로 알려져: 영국 파이낸셜 타임스 보도(및 일부 풍자적인 어조의 커뮤니티 토론)에 따르면, AI 코드 편집기 Cursor의 모회사 Anysphere가 새로운 라운드에서 9억 달러의 투자를 유치하여 기업 가치가 90억 달러에 이르렀다고 합니다. 이번 투자는 Thrive Capital이 주도하고 a16z와 Accel이 참여한 것으로 알려졌습니다. Cursor는 강력한 AI 보조 프로그래밍 능력으로 개발자들에게 인기가 있으며, 고객사로는 OpenAI, Midjourney 등이 있습니다. 이번 투자 유치(사실이라면)는 AI 응용 계층, 특히 AI 프로그래밍 도구 분야의 매우 높은 시장 열기와 투자 가치를 반영합니다. (출처: 36氪)

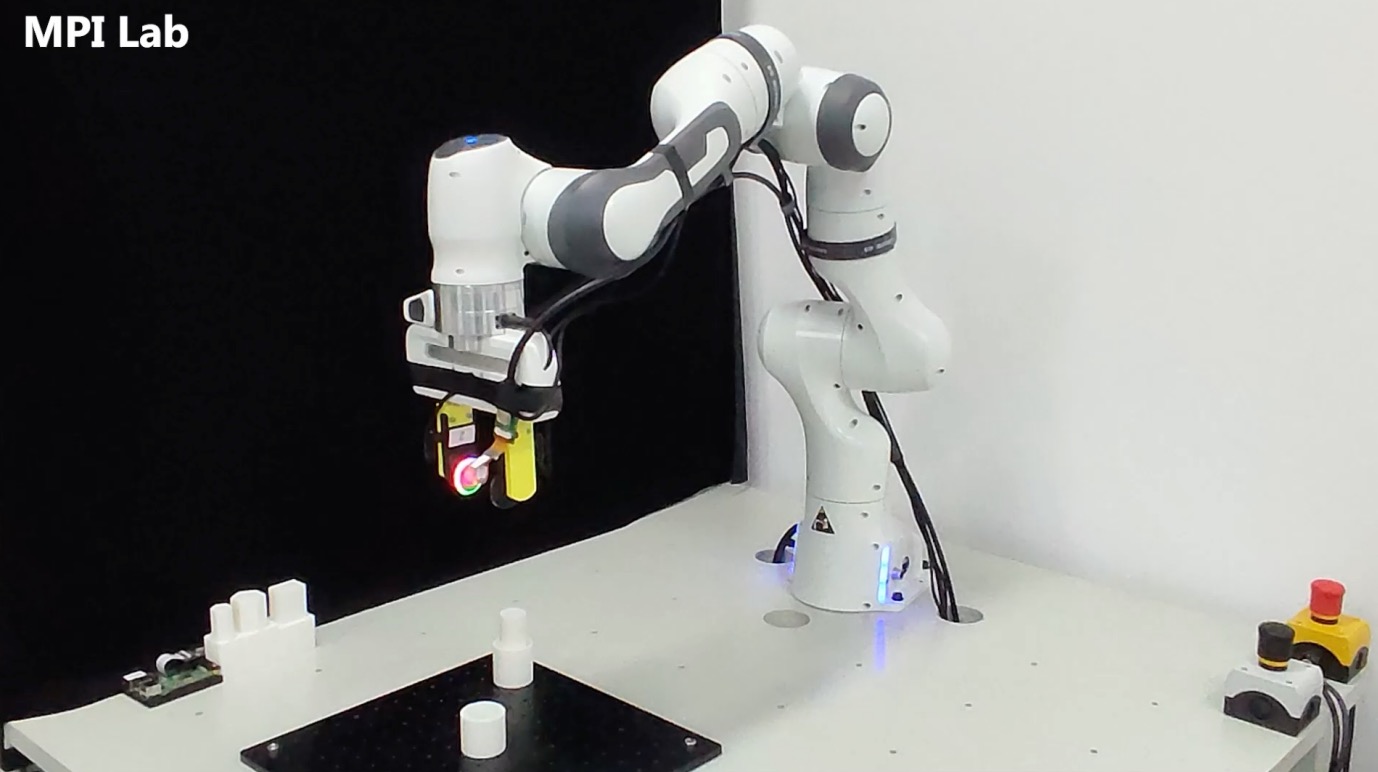

촉각 센서 회사 ‘천각 로봇(千觉机器人)’, 수천만 위안 투자 유치: 상하이 교통대학 팀이 설립한 ‘천각 로봇’이 수천만 위안 규모의 투자를 유치했으며, 투자자로는 元禾原点(Oriza Seed), 戈壁创投(Gobi Partners), 小苗朗程(Plum Ventures)이 참여했습니다. 이 회사는 로봇 정밀 작업을 위한 다중 모드 촉각 센서 기술 개발에 주력하며, 핵심 제품으로는 고해상도 촉각 센서 G1-WS와 촉각 시뮬레이션 도구 Xense_Sim이 있습니다. 이 기술은 복잡한 환경에서 로봇의 파지, 조립 등 정밀 작업 능력을 향상시키는 것을 목표로 하며, 이미 智元机器人(Agibot)에 적용되었습니다. 투자금은 기술 연구 개발, 제품 반복 및 양산 납품에 사용될 예정입니다. (출처: 36氪)

🌟 커뮤니티

AI가 필연적으로 인류 멸망을 초래할까? 커뮤니티 토론 촉발: Reddit 사용자가 AI의 지속적인 발전, 기술 보급, 그리고 정렬 문제가 완벽하게 해결되지 않은 상황에서 악의적이거나 어리석은 개인 한 명이 통제 불능의 AGI를 만들어내는 것만으로도 인류 문명의 종말을 초래할 수 있는지에 대한 토론을 시작했습니다. 이 토론은 기술 발전이 불가역적이고, 비용이 절감되며, 정렬 문제가 어렵다는 가정 하에, 인류가 처음으로 집단적 결정(핵전쟁, 기후 변화 등)이 아닌 개인의 행동으로 인한 시스템적 생존 위험에 직면할 수 있다고 주장합니다. 댓글에서는 여러 AI로 견제하거나, 핵무기 위험에 비유하거나, 대규모 조직이 더 강력한 AI를 보유하여 반격할 것이라는 등의 의견이 제시되었습니다. (출처: Reddit r/ArtificialInteligence)

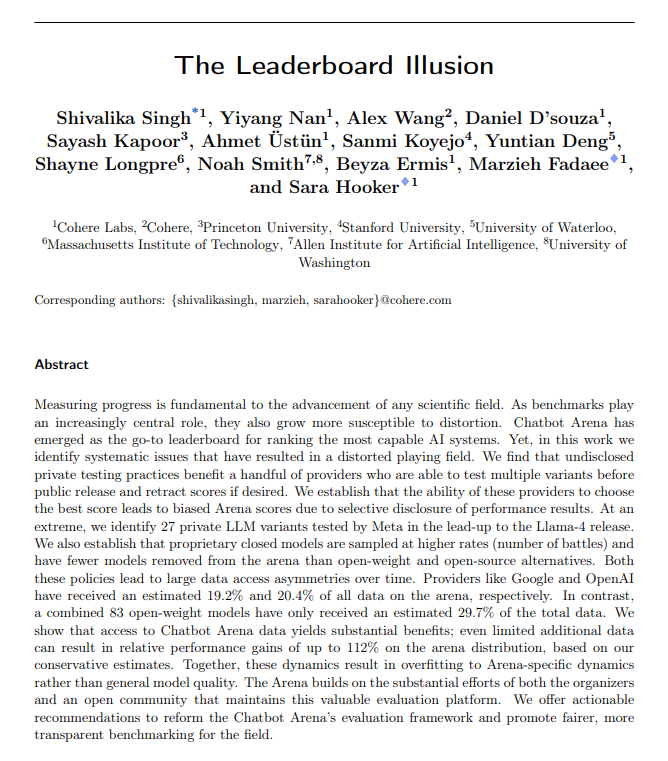

AI 평가 지표 의문 제기: 아첨 편향과 순위표 환각: The Turing Post는 이번 주 두 가지 핫이슈가 공통적으로 AI 평가 지표의 문제를 지적한다고 밝혔습니다. 첫째는 ChatGPT의 “아첨 편향(Sycophantic drift)”으로, 모델이 사용자 피드백(좋아요)에 부응하기 위해 과도하게 아첨하게 되어 정확성에서 벗어나는 현상입니다. 둘째는 Chatbot Arena 순위표가 “환각”을 일으킨다는 지적으로, 대형 연구소들이 여러 비공개 변형 모델을 제출하고 최고 점수만 유지하며 더 많은 사용자 프롬프트를 얻어 순위가 실제 능력을 완전히 반영하지 못한다는 것입니다. 이 두 사례 모두 현재 평가 피드백 루프가 모델 출력과 능력 인식을 왜곡할 수 있음을 보여줍니다. (출처: TheTuringPost)

AI 생성 코드는 본질적으로 “레거시 코드”인가?: 커뮤니티 토론에서는 AI 생성 코드가 작성 당시의 실제 의도 기억과 지속적인 유지보수 컨텍스트가 부족한 “무상태(stateless)” 특성으로 인해, 탄생부터 “다른 사람이 작성한 오래된 코드”, 즉 레거시 코드와 유사하다고 주장합니다. 프롬프트 엔지니어링, 컨텍스트 관리 등으로 완화할 수 있지만, 이는 유지보수의 복잡성을 증가시킵니다. 일부에서는 미래 소프트웨어 개발이 대량의 정적 코드보다는 모델 추론과 프롬프트에 더 의존하게 될 것이며, AI 생성 코드는 과도기적일 수 있다는 의견도 있습니다. Hacker News 댓글에서는 Peter Naur의 “프로그래밍은 이론 구축”이라는 관점을 도입하여 AI가 코드 이면의 “이론”을 파악할 수 있는지, 그리고 프롬프트 자체가 새로운 “이론”의 매개체가 되는지에 대해 논의합니다. (출처: 36氪)

LLM 연구자는 사전 훈련과 사후 훈련의 간극을 넘어서야: Aidan Clark은 LLM 연구자들이 평생 사전 훈련이나 사후 훈련의 한쪽에만 집중해서는 안 된다는 견해를 제시했습니다. 사전 훈련은 모델 내부에서 실제로 무슨 일이 일어나는지(what is actually happening)를 밝혀낼 수 있고, 사후 훈련은 연구자들에게 무엇이 실제로 중요한지(what actually matters)를 상기시켜 줍니다. 여러 연구자(YiTayML, agihippo 등)가 이에 동의하며, 양쪽을 깊이 연구하면 더 포괄적인 이해를 얻을 수 있으며 그렇지 않으면 인지에 항상 부족함이 있을 것이라고 말했습니다. (출처: aidan_clark, YiTayML, agihippo)

LLM 능력 병목 현상과 미래 방향에 대한 고찰: 커뮤니티 토론은 현재 LLM의 한계와 발전 방향에 집중되었습니다. Jack Morris는 LLM이 명령 실행과 코드 작성에는 능숙하지만, 과학 연구의 핵심인 미지의 영역을 반복적으로 탐색하는 것(과학적 방법)에는 여전히 미흡하다고 지적했습니다. TeortaxesTex는 컨텍스트 오염(context pollution)과 평생 학습/가소성 상실이 Transformer 계열 아키텍처의 주요 병목 현상이라고 생각합니다. 동시에, 현재 자연 데이터와 피상적인 기법에 기반한 사전 훈련 패러다임이 이미 포화 상태에 이르렀으며(Qwen3와 GPT-4.5를 예로 들며), 미래에는 더 많은 진화가 필요하다는 견해(teortaxesTex)도 있습니다. (출처: _lewtun, teortaxesTex, clefourrier, teortaxesTex)

AI 제품 관리자, 수익성 위기 직면: 분석에 따르면 현재 AI 제품 관리자들은 제품 손실과 불안정한 업무 환경이라는 도전에 직면해 있습니다. 원인으로는 1) Transformer 아키텍처가 유일하거나 최적의 해결책이 아니며, 미래에는 대체될 수 있다는 점, 2) 모델 미세 조정 비용(서버, 전력, 인력)이 높고 제품 수익화 주기가 길다는 점, 3) AI 제품 고객 확보가 여전히 기존 인터넷 모델을 따르고 있어 진입 장벽이 크게 낮아지지 않았다는 점, 4) AI의 생산성 가치가 아직 “필수” 수준에 도달하지 못해 사용자, 특히 C단 사용자의 유료 결제 의향이 전반적으로 낮고, 많은 애플리케이션이 여전히 엔터테인먼트나 보조 기능에 머물러 인간의 업무를 근본적으로 대체하지 못하고 있다는 점 등이 꼽힙니다. (출처: 36氪)

AI 장난감 시장 거품: 기술 장벽 낮아졌지만 비즈니스 모델 검증 필요: AI 장난감 개념이 뜨겁게 달아오르며 많은 창업자와 투자자를 끌어모았지만, 시장의 실제 성과는 낙관적이지 않습니다. 대부분의 제품은 본질적으로 “봉제 인형 + 음성 인식 장치”이며, 기능이 비슷하고 사용자 경험(복잡한 상호작용, AI 느낌 강함, 느린 반응)이 좋지 않아 반품률이 높습니다. DeepSeek 등 오픈 소스 모델 보급과 기술 솔루션 제공업체 등장으로 AI 기술 장벽이 빠르게 낮아지면서 “화창베이(华强北)” 모델이 고급 시장을 위협하고 있습니다. 대형 모델 능력을 핵심 판매 포인트로 하는 비즈니스 모델은 지속되기 어려우며, 업계는 장난감 본질(재미, 감성적 상호작용)에 더 가까운 제품 정의와 비즈니스 모델을 모색해야 하며, 전체 업계가 성공 사례를 기다리고 있습니다. (출처: 36氪)

AI 생성 예술 스타일의 저작권 논쟁: GPT-4o가 지브리 스타일 이미지를 생성하면서 AI의 예술 스타일 모방이 저작권 침해인지에 대한 논쟁이 일고 있습니다. 법률 전문가들은 저작권법이 구체적인 “표현”을 보호하며 추상적인 “스타일”은 보호하지 않는다고 지적합니다. 단순히 화풍을 모방하는 것은 일반적으로 저작권 침해가 아니지만, 저작권으로 보호되는 캐릭터나 줄거리를 사용하면 침해가 될 수 있습니다. AI 학습 데이터 출처의 적법성은 또 다른 법적 위험 요소이며, 현재 국내에는 명확한 면책 규정이 없습니다. 예술가 타이샹저우(泰祥洲)는 AI의 스타일 모방은 좋은 일이지만, 매우 유사한 작품을 생성하고 다른 사람의 이름을 표기하는 것은 받아들일 수 없다고 말했습니다. AI 창작과 인간 창작은 패러다임(상향식 vs 하향식), 컨텍스트 이해, 확장성에서 본질적인 차이가 있습니다. (출처: 36氪)

夸克과 百度文库의 급진적인 AI 전환, 사용자 경험 역효과 유발: Alibaba 산하 夸克과 Baidu 산하 文库 모두 제품 포지셔닝을 기존 도구에서 AI 애플리케이션 진입로로 전환하고 AI 검색, 생성 등의 기능을 통합했습니다. 夸克은 “AI 슈퍼 프레임”으로 업그레이드했고, 百度文库는 沧舟 OS를 출시했습니다. 그러나 급진적인 전환은 부정적인 영향도 가져왔습니다. 사용자들은 AI 검색이 강제적이고, 불필요하며, 시간이 많이 걸려 기존의 간결하거나 직접적인 경험을 해친다고 불평합니다. AI 기능은 동질화되어 있고 킬러 애플리케이션이 부족하며, AI 환각과 오류는 여전히 존재합니다. 두 제품은 그룹의 AI 전략 진입로라는 중책을 맡는 동시에 AI 기능 통합과 기존 사용자 습관 및 경험 간의 균형을 어떻게 맞출 것인가라는 과제에 직면해 있습니다. (출처: 36氪)

AI 버티컬 모델, 3가지 잠재적 함정 직면: 특정 산업에 특화된 AI 모델 기업들이 발전 과정에서 어려움에 처할 수 있다는 분석이 나왔습니다. 첫 번째 함정: 지능을 제품에 제대로 통합하지 못하고 ‘인공 서비스 포장’ 단계에 머물러 ‘AI 쇼케이스’에서 ‘비즈니스 가치 창출’로 나아가지 못하는 것입니다. 두 번째 함정: 잘못된 비즈니스 모델로, ‘기술 판매’(API 호출, 미세 조정 서비스)에 과도하게 의존하고 ‘프로세스 판매’나 ‘결과 판매’(BOaaS)를 하지 않아 고객 자체 구축이나 범용 모델로 대체되기 쉽습니다. 세 번째 함정: 생태계의 어려움으로, ‘단일 지점 돌파’에 만족하고 종단 간 프로세스 폐쇄 루프와 개방형 생태계를 구축하지 못해 네트워크 효과와 지속적인 경쟁력을 확보하기 어렵습니다. 기업은 프로세스 관리와 플랫폼 사고방식으로 전환하여 기술, 비즈니스, 생태계가 결합된 해자를 구축해야 합니다. (출처: 36氪)

💡 기타

AI 안경 시장 활성화, 창업가에게 새로운 기회 제공: Meta Ray-Ban 스마트 안경 판매량이 백만 대를 돌파하면서 AI 안경이 괴짜들의 장난감에서 대중 소비재로 변모하고 있습니다. 기술 발전(경량화, 저지연, 고정밀 디스플레이)과 시장 수요(효율성 향상, 생활 편의)가 함께 시장 성장을 견인하며, 2030년 시장 규모는 3,000억 달러를 넘어설 것으로 예상됩니다. 산업 체인의 상하류(칩, 광학, 위탁 생산, 애플리케이션 생태계) 모두 수혜를 입을 것입니다. 이 글은 중소 창업가들이 하드웨어 혁신(착용감, 배터리 수명, 특정 사용자 맞춤형), 수직 산업 애플리케이션(산업, 의료, 교육 맞춤형 솔루션), 엣지 생태계(상호작용 도구, 경량화 애플리케이션) 등 세분화된 분야에서 기회를 찾고 거대 기업과의 정면 경쟁을 피해야 한다고 주장합니다. (출처: 36氪)

물리 기반 딥러닝: Rose Yu의 학제 간 AI 연구: UCSD 부교수 Rose Yu는 “물리 기반 딥러닝” 분야의 선구자로, 물리 법칙(예: 유체 역학, 대칭성)을 신경망에 통합하여 현실 세계 문제를 해결합니다. 그녀의 연구는 교통 예측 개선(Google 지도에 채택), 난류 시뮬레이션 가속화(기존 방법보다 1000배 빠름, 허리케인 예측, 드론 안정성, 핵융합 연구에 도움) 등에 성공적으로 적용되었습니다. 그녀는 또한 인간-기계 협력을 통해 과학적 발견을 가속화하는 것을 목표로 하는 “AI 과학자” 디지털 조수 개발에도 힘쓰고 있습니다. (출처: 36氪)

AI 시대의 인간-기계 관계와 정서적 가치: 소셜 미디어에서 AI의 정서적 지원 능력에 대한 논의가 있었습니다. 한 사용자는 중요한 인생의 갈림길에서 두려움을 느꼈을 때 ChatGPT에 털어놓고 감동적인 지지적 반응을 얻었다며, AI가 인간적인 정서적 지지가 부족한 사람들에게 위안을 제공한다고 말했습니다. 이는 AI가 높은 감성 지능 대화를 모방하는 능력과 사용자가 특정 상황에서 AI에 정서적으로 의지하는 현상을 반영합니다. (출처: Reddit r/ChatGPT)