キーワード:AI, NVIDIA(エヌビディア), Deutsche Telekom(ドイチェ・テレコム), 産業AIクラウド, 主権AI, Anthropic(アンスロピック), マルチエージェントシステム, RAISE法案, 欧州産業AIクラウド, フライトケースによるチップ封鎖回避, Claudeマルチエージェント研究, ニューヨーク州RAISE法案, ジェンスン・フアンとAnthropic CEOの討論

🔥 フォーカス

Nvidiaとドイツテレコムが提携、欧州産業AIクラウドを共同構築: ドイツ連邦首相がNvidiaのCEOであるJensen Huang氏と会談し、戦略的協力の深化について協議しました。これは、世界のAIリーダーとしてのドイツの地位を強化することを目的としています。中核となる議題には、主権AIインフラの構築とAIエコシステムの発展加速が含まれていました。このため、ドイツテレコムとNvidiaは提携を発表し、2026年までに欧州の製造業者にサービスを提供する世界初の産業AIクラウドを構築する計画です。このプラットフォームは、データ主権を確保し、欧州産業分野におけるAIイノベーションを推進します。(出典: nvidia)

中国AI企業、「フライングハードディスクケース」で米国のチップ封鎖を回避: 米国の対中AIチップ輸出規制に対応するため、中国企業は新たな戦略を採用しています。AI訓練データが保存されたハードディスクを直接海外(マレーシアなど)のデータセンターに持ち込み、現地のNvidiaなどの先進チップを搭載したサーバーを利用してモデル訓練を行い、完了後に結果を持ち帰るというものです。この動きは、世界のAI産業チェーンの複雑性と、規制下における中国企業の柔軟な対応能力を浮き彫りにするとともに、東南アジアや中東地域がAIデータセンターの新たなホットスポットとなることを後押ししています。(出典: dotey)

Anthropic、マルチエージェント研究システム構築方法を発表: Anthropicのエンジニアリングブログで、複数の並列作業を行うエージェントを利用してClaudeの研究能力を構築する方法が詳細に紹介されました。記事では、開発過程での成功体験、直面した課題、およびエンジニアリングソリューションが共有されています。このマルチエージェント協調作業モデルは、複雑な研究タスクにおける大規模言語モデルの詳細分析能力と情報処理能力を向上させることを目的としており、より強力なAI研究アシスタントの構築に向けた実践的な参考情報を提供します。(出典: AnthropicAI)

ニューヨーク州、RAISE法案を可決し、フロンティアAIモデルに対する透明性要件を強化: ニューヨーク州はRAISE法案(RAISE Act)を可決し、フロンティアAIモデルに対する透明性要件を確立することを目指しています。Anthropicなどの企業は同法案についてフィードバックを提供しており、改善は見られるものの、依然として懸念が残っています。例えば、重要な定義の曖昧さ、コンプライアンス是正機会の不明確さ、「セキュリティインシデント」の定義が広範すぎること、報告期間が短いこと(72時間)、軽微な技術的違反に対して数百万ドルの罰金が科される可能性があり、小規模企業にリスクをもたらすことなどです。Anthropicは、連邦レベルでの統一された透明性基準の確立を求め、州レベルの提案は透明性に焦点を当て、過度な規制を避けるべきだと提言しています。(出典: jackclarkSF)

Nvidia CEOのJensen Huang氏、Anthropic CEOのAI開発に関する見解に反論: Jensen Huang氏はパリで開催されたViva Technologyの記者会見で、Anthropic CEOのDario Amodei氏の見解に反論しました。Amodei氏は、AIは危険すぎるため特定の企業に開発を限定すべきであり、コストが高すぎるため普及させるべきではなく、強力すぎるため失業を引き起こすと主張したとされています。Huang氏は、AIは安全かつ責任を持って公に開発されるべきであり、「密室」で行われ安全だと宣言されるべきではないと強調しました。この発言は、AI開発の方向性(オープンで民主的か、エリートによる閉鎖的か)に関する議論を呼び、業界大手間の理念の違いを浮き彫りにしました。(出典: pmddomingos, dotey)

🎯 動向

Meta、AI能力強化のためScale AIの過半数株式を140億ドルで取得か: 報道によると、MetaはAIデータラベリング企業Scale AIの株式49%を148億ドルで取得し、そのCEOをMetaが新設した「スーパーインテリジェンスグループ」のリーダーに任命する可能性があるとのことです。この動きは、Llama 4モデルの性能が期待に達しなかったことや、内部のAI人材流出という課題に対応するため、外部のトップ人材と技術を導入し、汎用人工知能分野での追撃を加速させることを目的としています。(出典: Reddit r/ArtificialInteligence, 量子位)

OpenAI、o3-proモデルをリリース、o3の大幅値下げが性能議論を呼ぶ: OpenAIは、「最新最強」の推論モデルo3-proを正式にリリースしました。ProおよびTeamユーザー向けに設計されており、API価格は入力20ドル/100万トークン、出力80ドル/100万トークンです。同時に、従来のo3モデルのAPI価格は80%大幅に引き下げられ、GPT-4oとほぼ同水準になりました。公式には、o3-proは数学、科学、プログラミングの分野で優れた性能を発揮するものの、応答時間が長いとされています。o3の値下げ後、「性能が低下した」のではないかという議論がコミュニティで巻き起こっており、一部のユーザーからは性能低下の報告がありますが、統一された実証データはありません。(出典: 量子位)

Cohere Labs、汎用型トークナイザーが言語モデルの適応性に与える影響を研究: Cohere Labsは最新の研究を発表し、事前学習の対象言語よりも多くの言語で学習させたトークナイザー(universal tokenizer)が、事前学習の性能を損なうことなく、モデルの新しい言語への適応性(plasticity)を向上させるかどうかを調査しました。研究によると、汎用トークナイザーは言語適応において効率が8倍、性能が2倍向上し、データが極めて少なく、言語が全く未知の場合でも、専用トークナイザーに対する勝率が5%高かったとのことです。これは、汎用トークナイザーがモデルの多言語タスク処理における柔軟性と効率を効果的に向上させることを示しています。(出典: sarahookr)

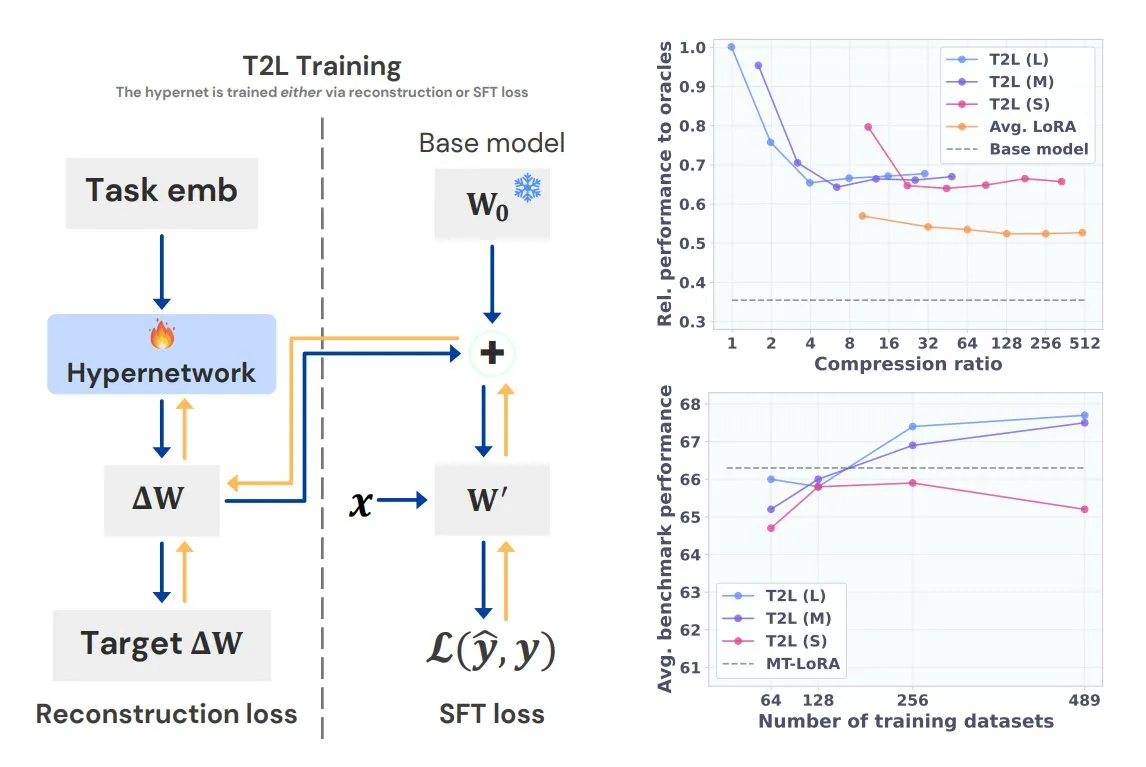

Sakana AI、Text-to-LoRA (T2L)を発表、一文でタスク専用LoRAを生成: Transformerの作者の一人であるLlion Jones氏が共同設立したSakana AIは、Text-to-LoRA (T2L)技術を発表しました。このハイパーネットワークアーキテクチャは、タスクのテキスト記述に基づいて特定のLoRAアダプタを迅速に生成し、LLMのファインチューニングプロセスを大幅に簡素化します。T2Lは既存のLoRAを圧縮し、ゼロショットシナリオで効率的なアダプタを生成することができ、モデルがロングテールタスクに迅速に適応するための新しい道を提供します。(出典: TheTuringPost, 量子位)

清華大学とTencent、Scene Splatterを共同発表、高忠実度3Dシーン生成を実現: 清華大学とTencentは共同でScene Splatter技術を提案しました。この技術は、単一画像から出発し、ビデオ拡散モデルと革新的な運動量誘導メカニズムを利用して、3次元一貫性を満たすビデオ断片を生成し、複雑な3Dシーンを構築します。この方法は、従来の複数視点への依存を克服し、生成されるシーンの忠実度と一貫性を向上させ、ワールドモデルとエンボディードAIの重要な要素に新しいアイデアを提供します。(出典: 量子位)

Tencent Hunyuan 3D 2.1発表:初のオープンソース生産レベルPBR 3D生成モデル: TencentはHunyuan 3D 2.1を発表しました。これは、初の完全にオープンソース化された、生産に使用可能な物理ベースレンダリング(PBR)3D生成モデルであるとされています。このモデルは、映画レベルの視覚効果を生成でき、革や青銅などのPBRマテリアルの合成をサポートし、光と影の相互作用効果がリアルです。モデルの重み、学習/推論コード、データパイプライン、アーキテクチャはすべてオープンソース化されており、コンシューマー向けGPUで実行可能で、クリエイター、開発者、小規模チームがファインチューニングや3Dコンテンツ作成を行えるようにします。(出典: cognitivecompai, huggingface)

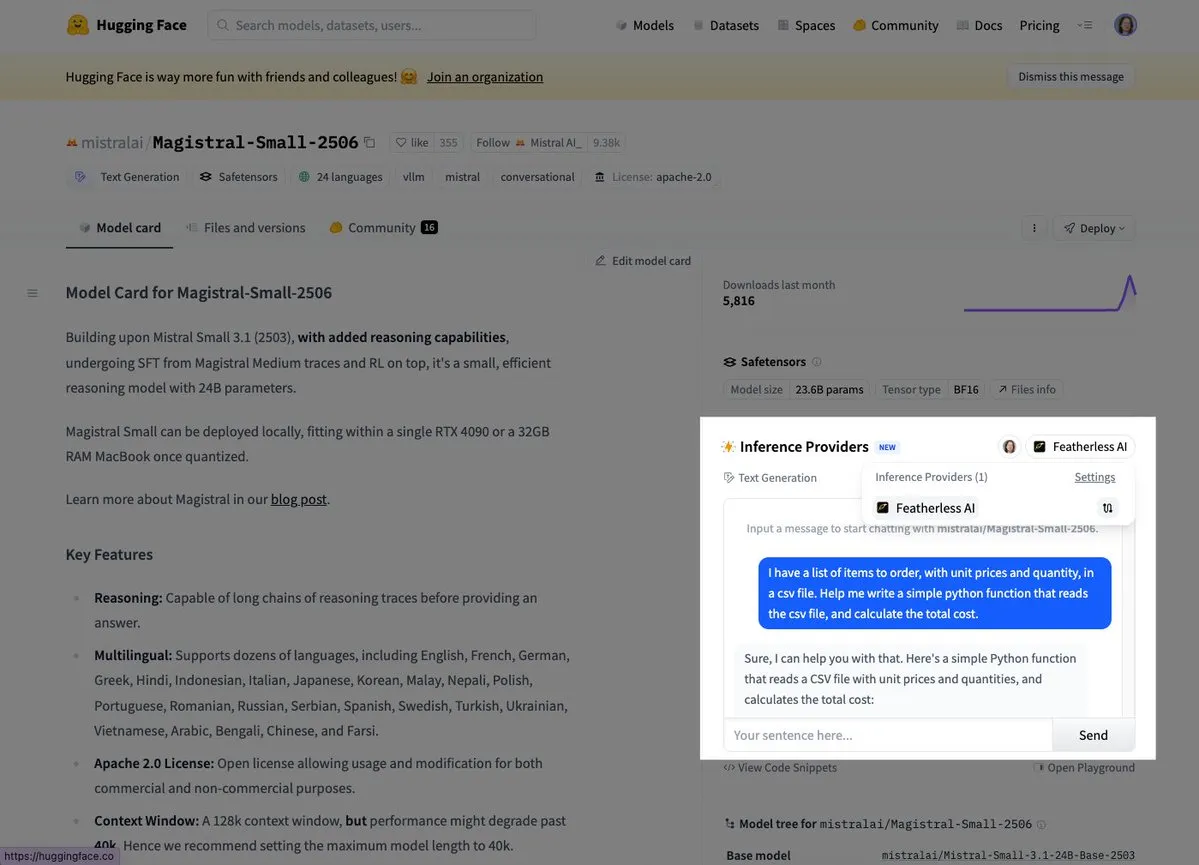

Mistral、初の推論モデルMagistral Smallを発表: Mistral AIは、初の推論モデルMagistral Smallを発表しました。このモデルは、ドメイン固有で透明性があり、多言語対応の推論能力に焦点を当てています。ユーザーは現在、Hugging FaceやFeatherlessAIなどのプラットフォームを通じて試用できます。これは、Mistralがより専門的で理解しやすいAI推論ツールの構築において重要な一歩を踏み出したことを示しています。(出典: dl_weekly, huggingface)

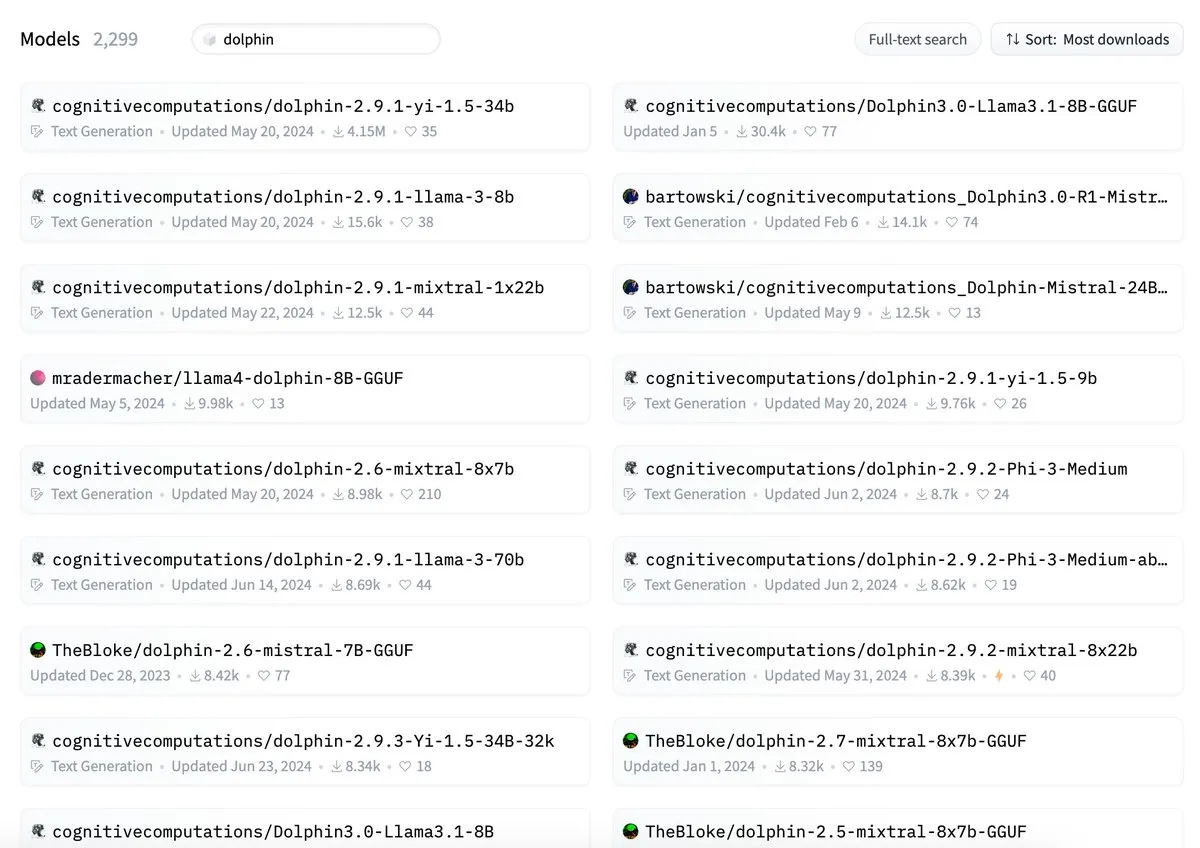

ByteDanceのDolphinモデル、cognitivecomputations/dolphinとの名称競合を指摘される: ByteDanceが発表したDolphinモデルが、既存のcognitivecomputations/dolphinモデルと名称が重複していると指摘されました。Cognitive Computationsは、ByteDanceが24日前に同モデルを初めて発表した際にこの問題をコメントで指摘したが、重視されなかったと述べています。この出来事は、モデルの命名規則と混乱回避に関するコミュニティでの議論を引き起こしました。(出典: cognitivecompai)

MLX Swift LLM APIが簡素化、3行のコードでチャットセッションを開始可能に: 開発者からMLX Swift LLM APIの導入が難しいとのフィードバックを受け、チームは改善を行い、新しい簡素化されたAPIをリリースしました。現在、開発者はわずか3行のコードでSwiftプロジェクトにLLMまたはVLMをロードし、チャットセッションを開始できるようになり、Appleエコシステムでの大規模言語モデルの使用と統合のハードルが大幅に下がりました。(出典: ImazAngel)

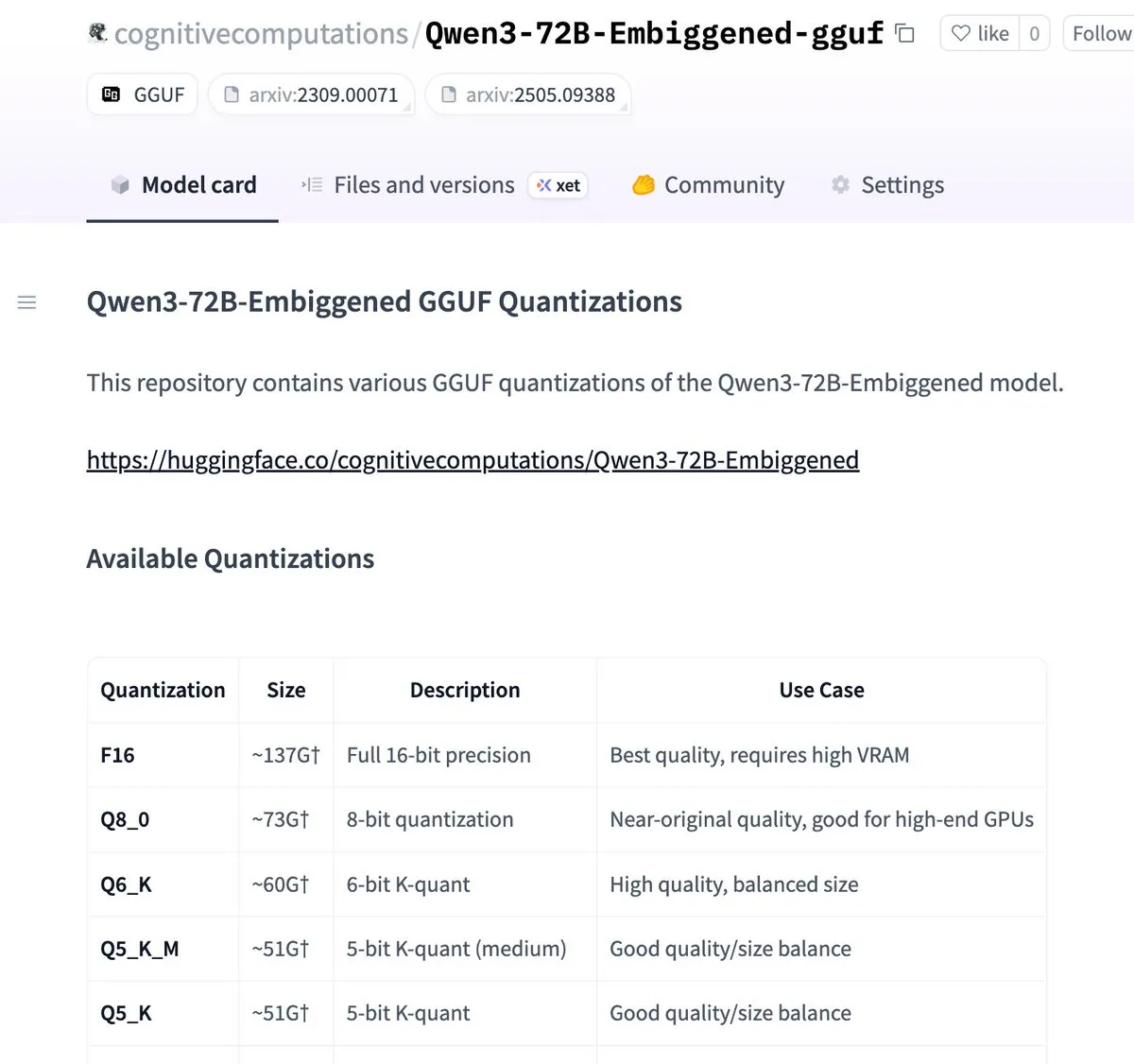

Qwen3-72B-Embiggenedおよび58Bバージョンがllama.cpp gguf形式に量子化: Eric Hartford氏は、Qwen3-72B-EmbiggenedおよびQwen3-58B-Embiggenedモデルをllama.cpp gguf形式に量子化したことを発表しました。これにより、ユーザーはこれらの大規模モデルをローカルデバイスで実行できるようになります。このプロジェクトは、AMD mi300x計算リソースのサポートを受けています。(出典: ClementDelangue, cognitivecompai)

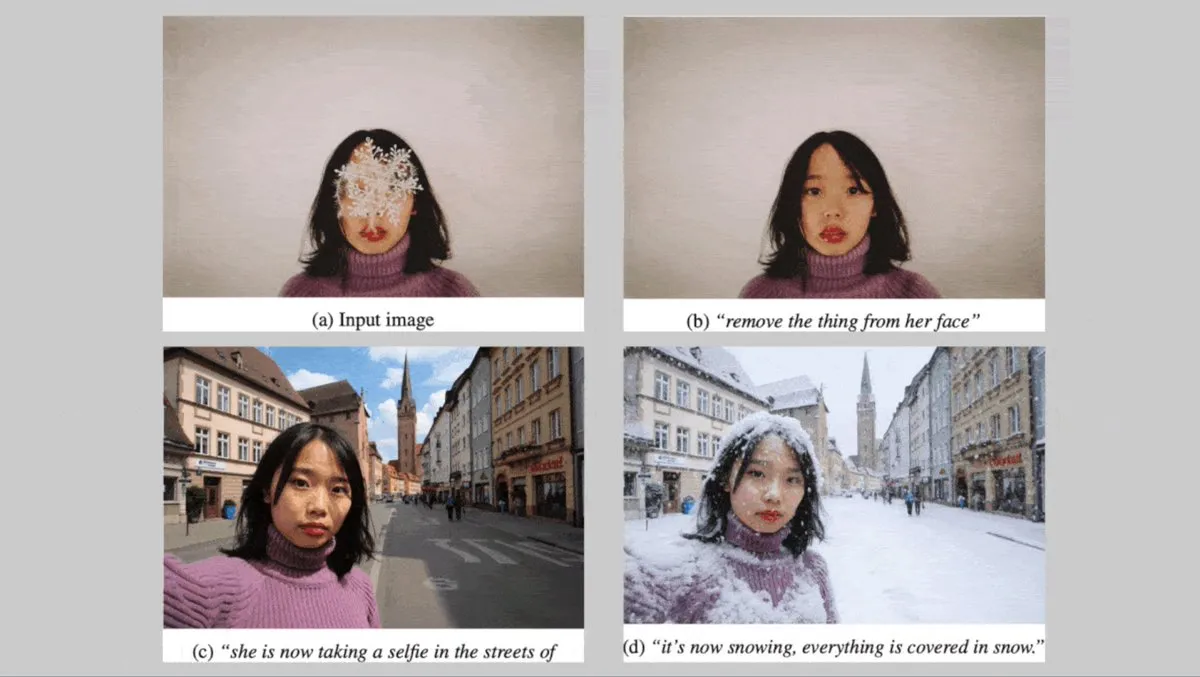

ドイツのBlack Forest Labs、キャラクターの一貫性を重視したテキスト画像生成モデルFLUX.1シリーズを発表: ドイツのBlack Forest Labsは、3つのテキスト画像生成モデル、FLUX.1 Kontext max、pro、devを発表しました。これらのモデルは、背景、ポーズ、スタイルを変更する際にキャラクターの一貫性を維持することに重点を置いています。畳み込み画像エンコーダ/デコーダと、敵対的拡散蒸留によって訓練されたTransformerを組み合わせており、効率的で詳細な編集をサポートします。maxおよびproバージョンは、FLUX Playgroundおよび提携プラットフォームを通じて提供されています。(出典: DeepLearningAI)

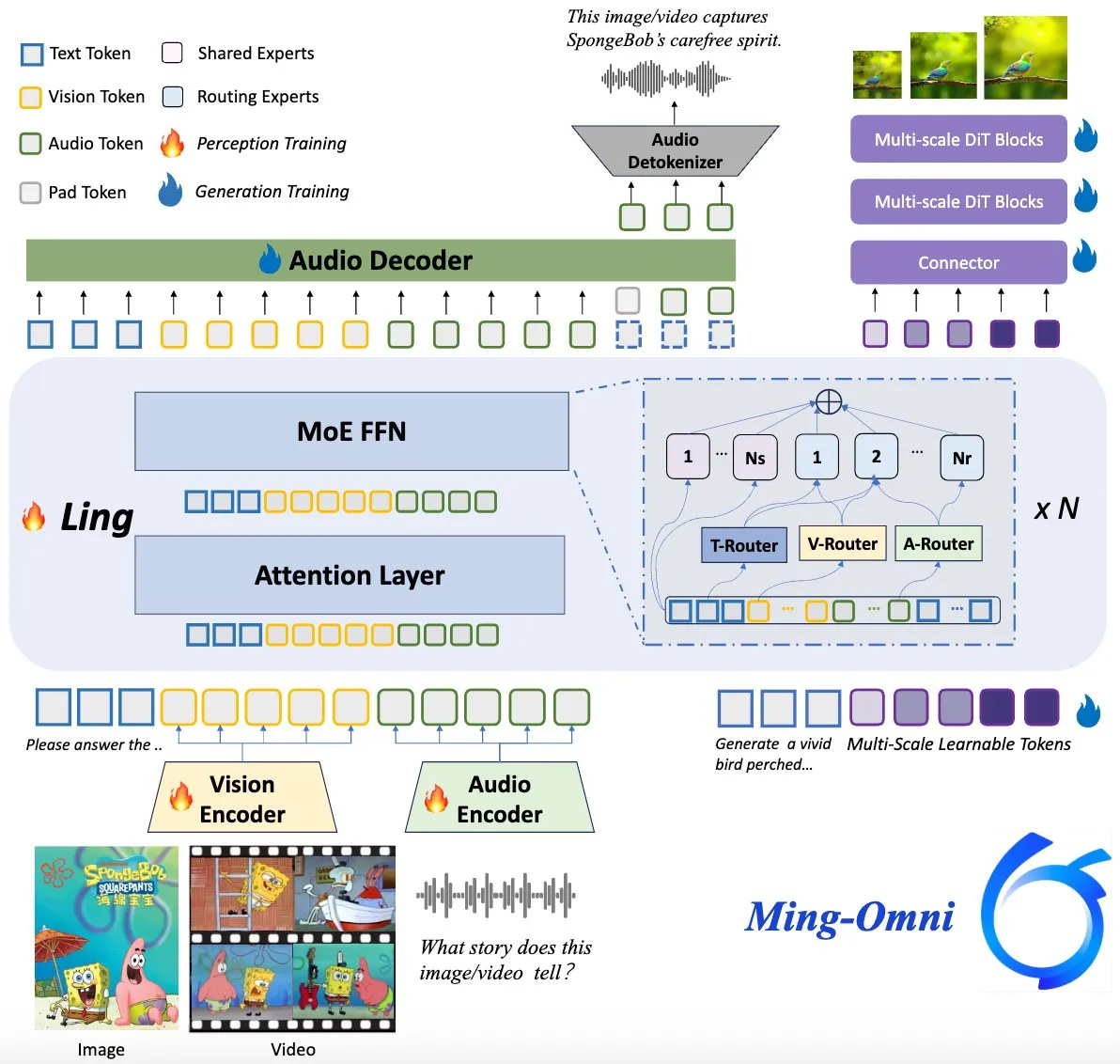

Ming-Omniモデルがオープンソース化、GPT-4oに対抗: Ming-Omniという名のオープンソース多モーダルモデルがHugging Faceで公開され、GPT-4oに匹敵する統一された知覚および生成能力の提供を目指しています。このモデルは、テキスト、画像、音声、ビデオを入力としてサポートし、音声と高解像度画像を生成できます。MoEアーキテクチャと特定モーダルルーターを採用し、コンテキスト認識チャット、TTS、画像編集などの機能を備え、アクティブパラメータはわずか2.8Bで、重みとコードは完全に公開されています。(出典: huggingface)

AI研究、多モーダルLLMが人間のような解釈可能な概念表現を発達させることを明らかに: 中国の研究者らは、多モーダル大規模言語モデル(LLM)が、物体の概念に対する人間のような解釈可能な表現方法を発達させることができることを発見しました。この研究は、LLMの内部動作メカニズムや、それらがテキストや画像などの異なるモーダル情報をどのように理解し関連付けるかについて、新たな視点を提供します。(出典: Reddit r/LocalLLaMA)

DeepMind、米国国立ハリケーンセンターと協力し、AIでハリケーンを予測: 米国国立ハリケーンセンターは、ハリケーンなどの悪天候を予測するために初めてAI技術を採用し、DeepMindと協力しています。これは、気象予測分野におけるAI応用の重要な一歩であり、異常気象イベントの警報の精度と適時性の向上が期待されます。(出典: MIT Technology Review)

🧰 ツール

LlamaParse、「プリセット」機能をリリース、異なるドキュメントタイプの解析を最適化: LlamaParseは「プリセット」(Presets)機能をリリースし、さまざまなユースケースに合わせて解析設定を最適化するための一連の分かりやすい事前設定モードを提供します。これには、一般的なシナリオ向けの高速、バランス、高度なモードのほか、請求書、科学論文、技術文書、フォームなどの特定のドキュメントタイプに最適化されたモードが含まれます。これらのプリセットは、ユーザーが特定のドキュメントタイプの構造化出力(フォームフィールドの表形式化、技術文書中の回路図のXML出力など)をより簡単に取得できるようにすることを目的としています。(出典: jerryjliu0, jerryjliu0)

Codegen、ビデオからPR作成機能を発表、AIがUIバグ解決を支援: Codegenはビデオ入力をサポートすると発表しました。ユーザーはSlackまたはLinearで問題のビデオを添付でき、CodegenはGeminiを利用してビデオから情報を抽出し、UI関連のバグを自動的に修正してPRを生成します。この機能は、UIの問題報告と修正の効率を大幅に向上させることを目的としており、特にインタラクション系のバグ解決に適しています。(出典: mathemagic1an)

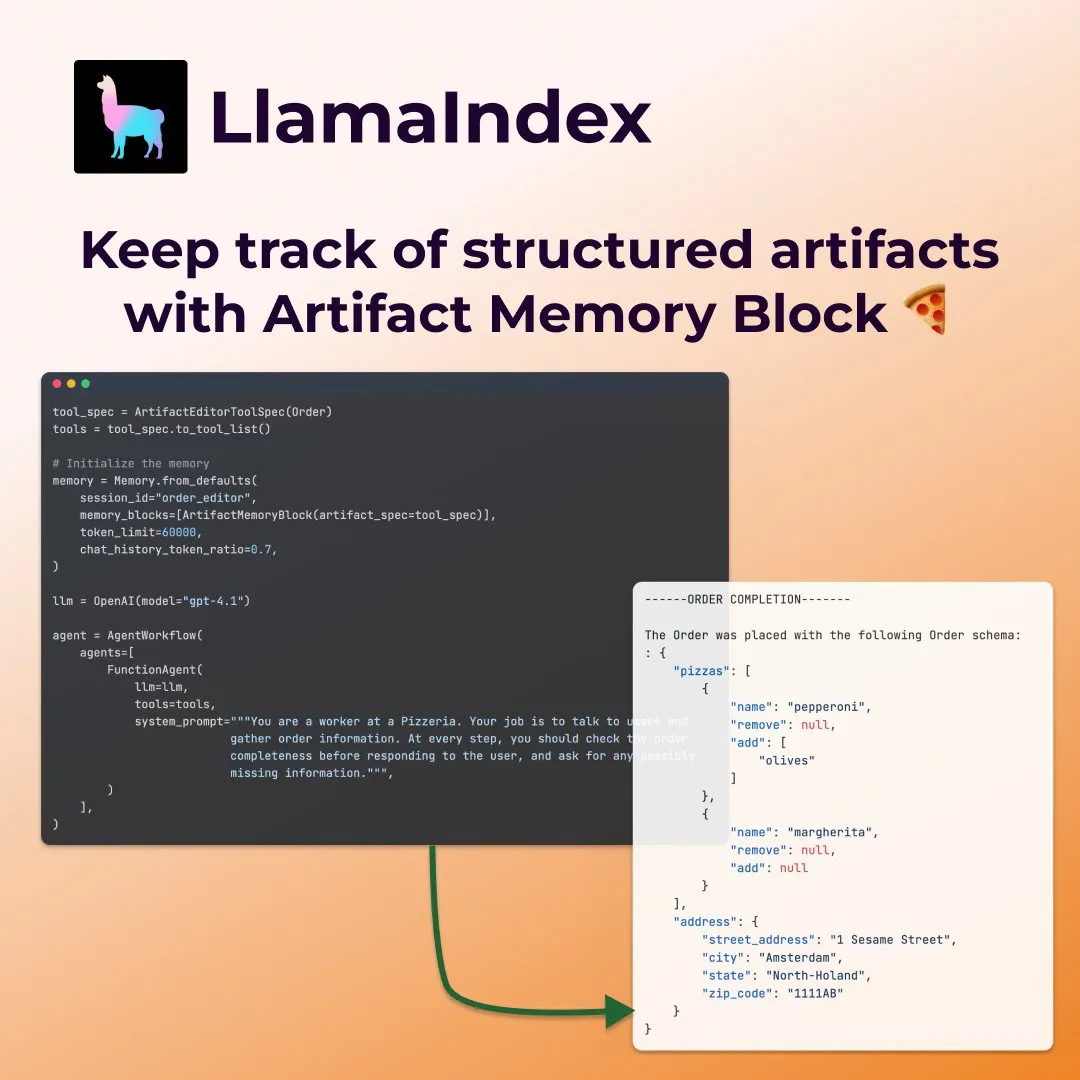

LlamaIndex、フォーム入力エージェント向けに構造化された「アーティファクトメモリブロック」を発表: LlamaIndexは、フォーム入力などのエージェント向けに設計された新しいメモリ概念である、構造化された「アーティファクトメモリブロック」(structured artifact memory block)を公開しました。このメモリブロックは、Pydanticの構造化スキーマを追跡し、新しいチャットメッセージによって継続的に更新され、常にコンテキストウィンドウに注入されます。これにより、エージェントはユーザーの好みや入力済みのフォーム情報(ピザ注文シナリオでのサイズ、住所などの詳細)を継続的に把握できます。(出典: jerryjliu0)

Davia:FastAPIで構築されたWYSIWYGウェブページ生成ツールがオープンソース化: DaviaはFastAPIを使用して構築されたオープンソースプロジェクトで、主要な大規模モデルベンダーのチャットインターフェース機能に似た、WYSIWYG(見たままが得られる)のウェブページ生成インターフェースを提供することを目的としています。ユーザーはpip install daviaでインストールでき、Tailwindの色のカスタマイズ、レスポンシブレイアウト、ダークモードをサポートし、UIコンポーネントとしてshadcn/uiを使用しています。(出典: karminski3)

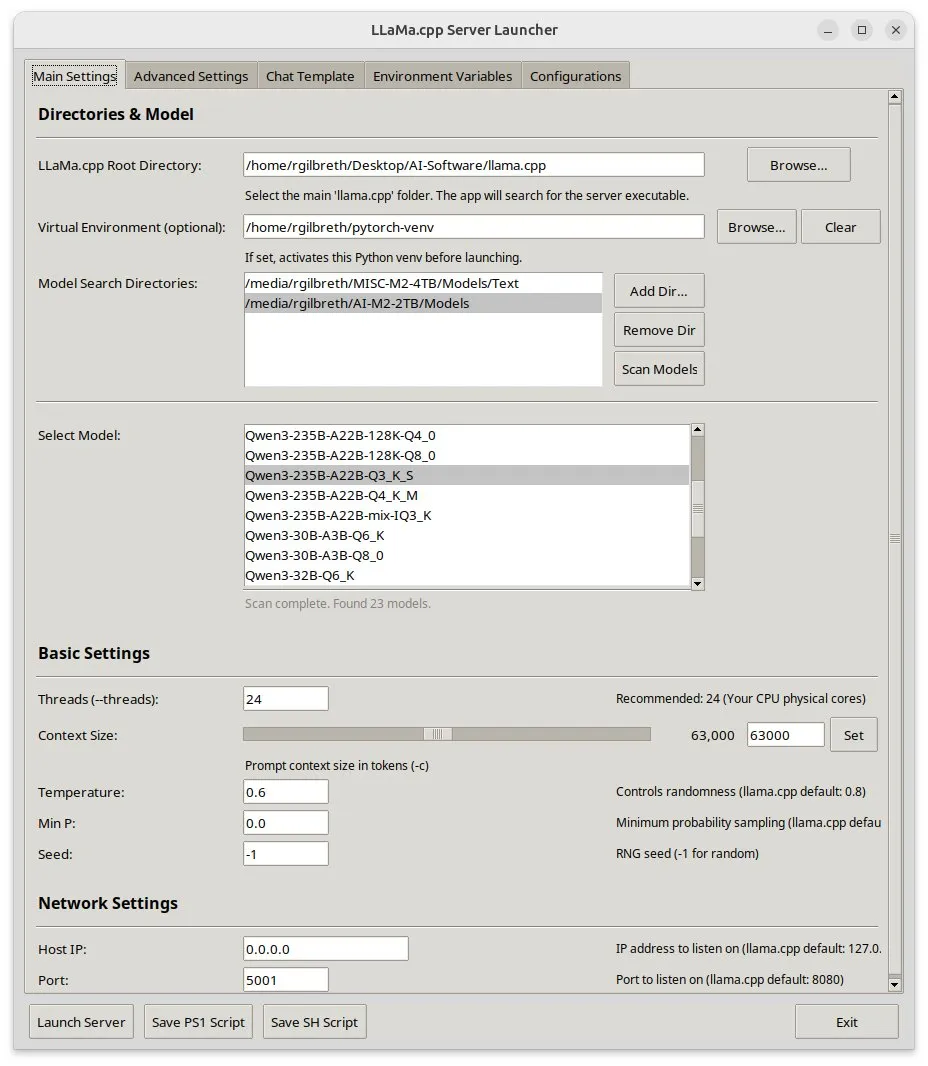

Llama-server-launcher:llama.cppの複雑な設定にグラフィカルインターフェースを提供: llama.cppの設定がNginxなどのWebサーバー並みに複雑化していることを受け、コミュニティはllama-server-launcherプロジェクトを開発しました。このツールはグラフィカルインターフェースを提供し、ユーザーは実行するモデル、スレッド数、コンテキストサイズ、温度、GPUオフロード、バッチサイズなどのパラメータをクリック操作で選択でき、設定プロセスを簡素化し、マニュアルを参照する時間を節約します。(出典: karminski3)

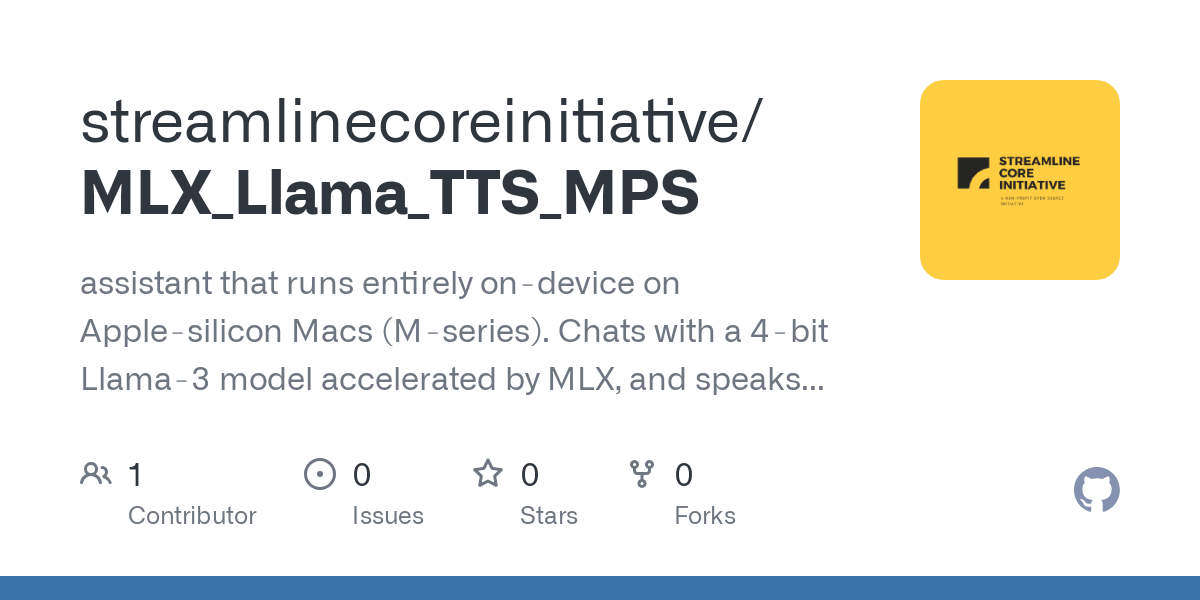

Macユーザーに朗報:MLX Llama 3 + MPS TTSでオフライン音声アシスタントを実現: ある開発者が、Mac Mini M4でMLX-LM(4ビットLlama-3-8B)とKokoro TTS(MPS経由で実行)を使用してオフライン音声アシスタントを構築した経験を共有しました。このソリューションはクラウドやOllamaデーモンを必要とせず、16GB RAM内で実行可能で、エンドツーエンドのオフラインチャットとTTS機能を実現し、Mac MシリーズチップユーザーにローカルAI音声アシスタントの新しい選択肢を提供します。(出典: Reddit r/LocalLLaMA)

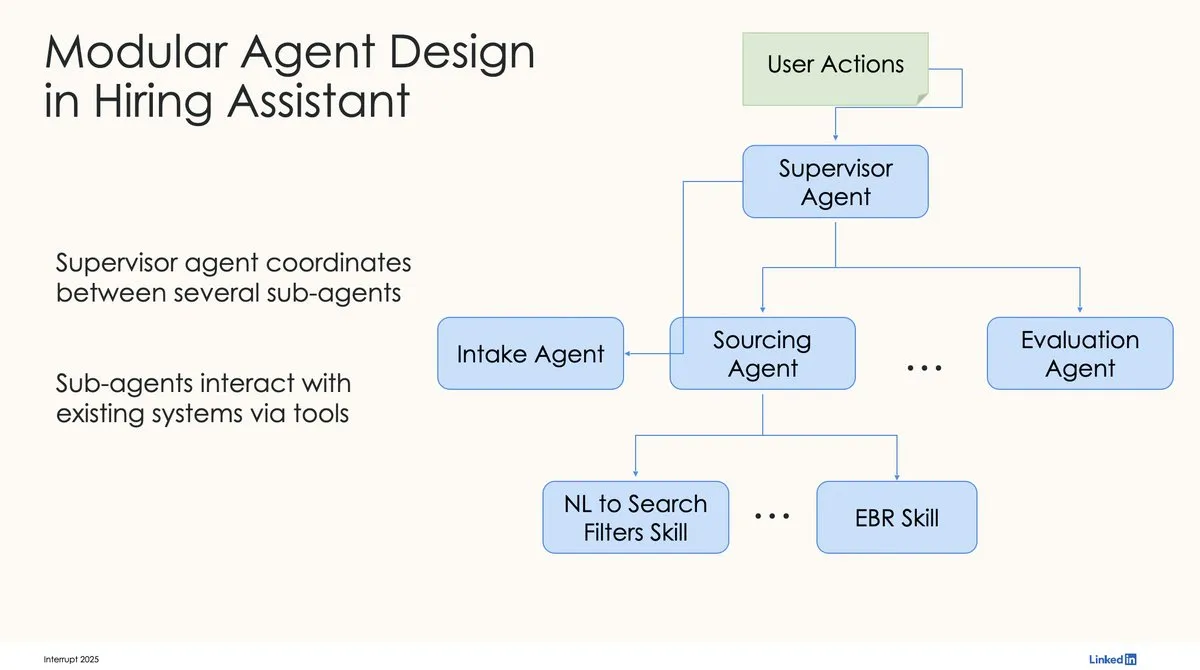

LinkedIn、LangChainとLangGraphを使用して初の生産レベルAI採用アシスタントを構築: LinkedInのDavid Tag氏は、LangChainとLangGraphを利用して同社初の生産レベルAI採用アシスタントであるLinkedIn Hiring Assistantを構築した技術アーキテクチャを共有しました。このフレームワークは20以上のチームに успешно展開されており、企業レベルのAIエージェント開発と大規模な応用におけるLangChainの可能性を示しています。(出典: LangChainAI, hwchase17)

📚 学習

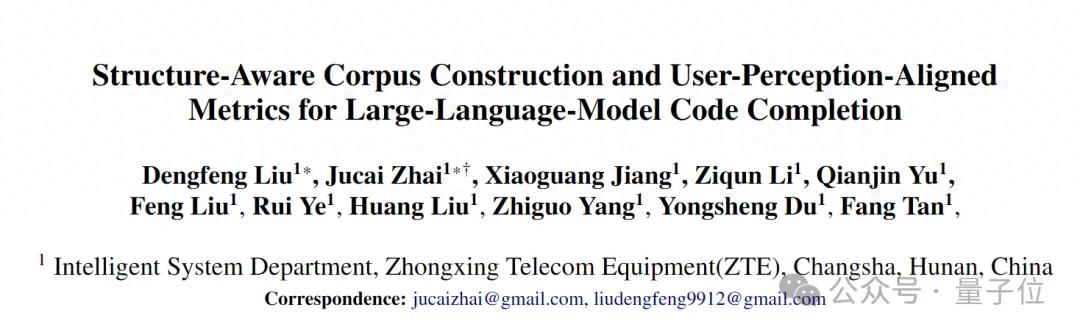

ZTE、LCPとROUGE-LCPの新指標およびSPSR-Graphフレームワークを提案、コード補完の評価と最適化: ZTEのチームは、AIコード補完に関して2つの新しい評価指標、最長共通プレフィックス(LCP)とROUGE-LCPを提案しました。これらは開発者の実際の採用意欲により近づけることを目的としています。同時に、リポジトリレベルのコードコーパス処理フレームワークSPSR-Graphを設計し、コード知識グラフを構築することで、コードリポジトリ全体の構造と意味の理解をモデルに強化させます。実験によると、新しい指標はユーザーの採用率との相関性が高く、SPSR-GraphはQwen2.5-7B-Coderなどのモデルの通信分野におけるC/C++コード補完タスクの性能を大幅に向上させることが示されました。(出典: 量子位)

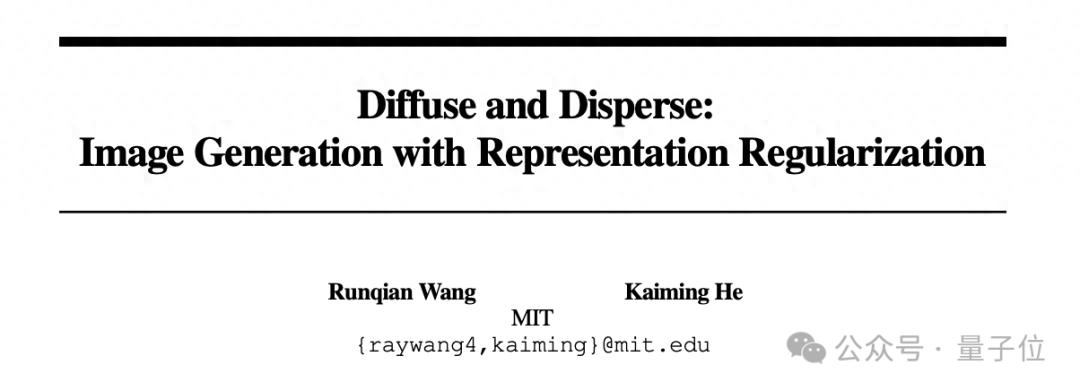

Kaiming He氏の新作:Dispersive Lossが拡散モデルに正則化を導入し、生成品質を向上: Kaiming He氏とその共同研究者は、Dispersive Lossというプラグアンドプレイの正則化手法を提案しました。これは、拡散モデルの中間表現を隠れ空間で分散させることを奨励することで、生成画像の品質と忠実度を向上させることを目的としています。この手法は正のサンプルペアを必要とせず、計算コストが低く、既存の拡散モデルに直接適用可能で、元の損失関数とも互換性があります。ImageNetでの実験では、Dispersive LossがDiTやSiTなどのモデルの生成効果を大幅に改善することが示されました。(出典: 量子位)

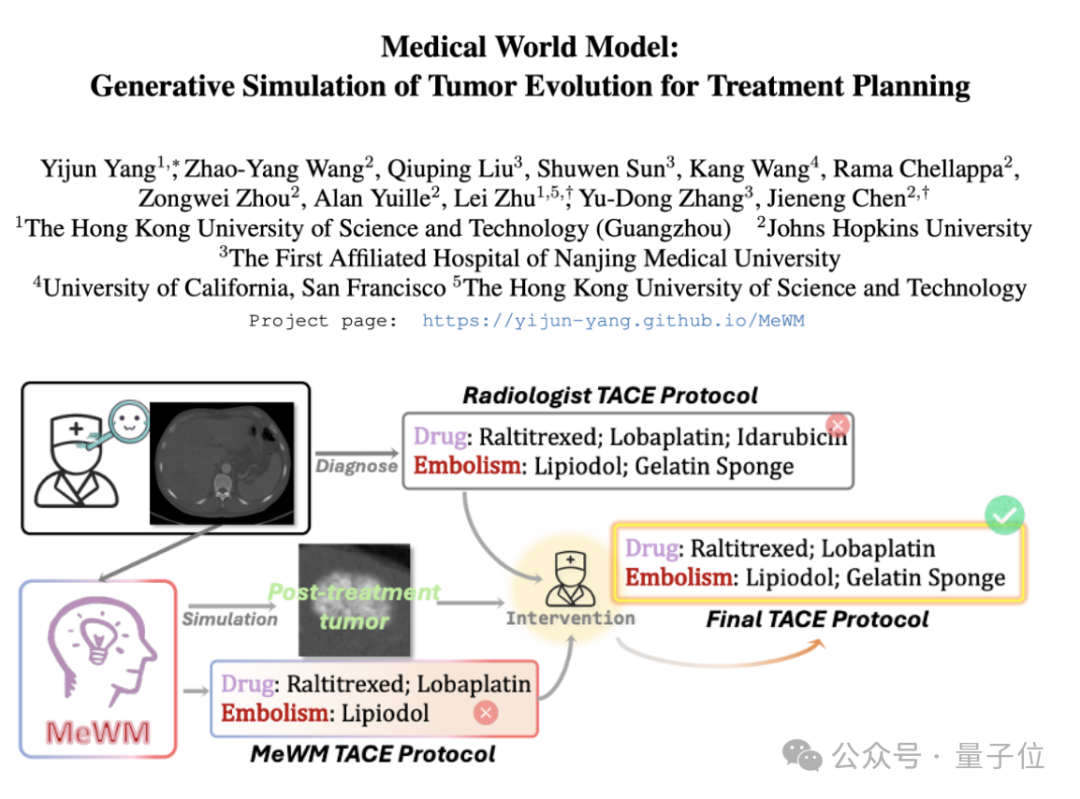

医学ワールドモデル(MeWM)が提案され、腫瘍の進化をシミュレートして治療決定を支援: 香港科技大学(広州)などの機関の研究者は、臨床治療決定に基づいて将来の腫瘍進化プロセスをシミュレートできる医学ワールドモデル(MeWM)を提案しました。MeWMは、腫瘍進化シミュレータ(3D拡散モデル)、生存リスク予測モデルを統合し、「治療計画生成-シミュレーション推論-生存評価」の閉ループ最適化プロセスを構築し、がんの介入治療計画に個別化された視覚的な補助的意思決定支援を提供します。(出典: 量子位)

論文、半非負値行列因子分解(SNMF)によるMLP活性化の解釈可能な特徴への分解を議論: 新しい論文では、多層パーセプトロン(MLP)の活性化値を直接分解するために半非負値行列因子分解(SNMF)を使用し、解釈可能な特徴を特定することを提案しています。この方法は、共通して活性化するニューロンの線形結合によって構成される疎な特徴を学習し、それを活性化入力にマッピングすることで、特徴の解釈可能性を高めることを目的としています。実験では、SNMFから派生した特徴は、因果的誘導において疎なオートエンコーダ(SAE)よりも優れており、人間が解釈可能な概念と一致し、MLP活性化空間における階層構造を明らかにすることが示されました。(出典: HuggingFace Daily Papers)

論文、Appleの「思考の錯覚」研究を批評:実験計画の限界を指摘: ある評論記事は、Shojaeeらが大規模推論モデル(LRM)が計画パズルにおいて「精度の崩壊」を示すとした研究(題名「思考の錯覚:問題の複雑性の観点から推論モデルの長所と限界を理解する」)に疑問を呈しています。評論は、元の研究の発見は主に実験計画の限界を反映しており、LRMの基本的な推論の失敗ではないと主張しています。例えば、ハノイの塔の実験はモデルの出力トークン制限を超えており、川渡りベンチマークには数学的に解決不可能なインスタンスが含まれていました。これらの実験の欠陥を修正した後、モデルは以前に完全に失敗したと報告されたタスクで高い精度を示しました。(出典: HuggingFace Daily Papers)

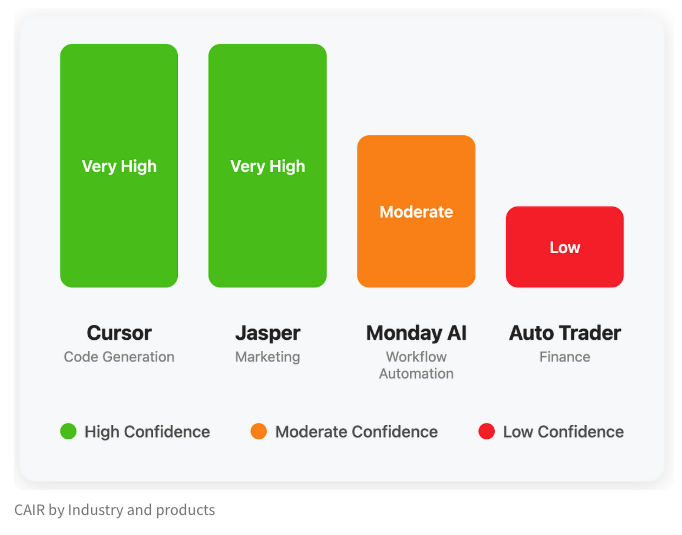

LangChain、AI製品成功の隠れた指標「CAIR」を探るブログを公開: LangChainの共同創設者であるHarrison Chase氏は、友人のAssaf Elovic氏と共にブログを執筆し、一部のAI製品が急速に普及する一方で、他の製品が苦戦する理由を探求しています。彼らは、鍵となるのは「CAIR」(Confidence in AI Results、AIの結果に対する信頼性)であると考えています。記事は、CAIRの向上がAI製品の採用を促進する鍵であると指摘し、CAIRに影響を与えるさまざまな要因と向上戦略を分析し、モデルの能力に加えて、優れたユーザーエクスペリエンス(UX)デザインも同様に重要であると強調しています。(出典: Hacubu, BrivaelLp)

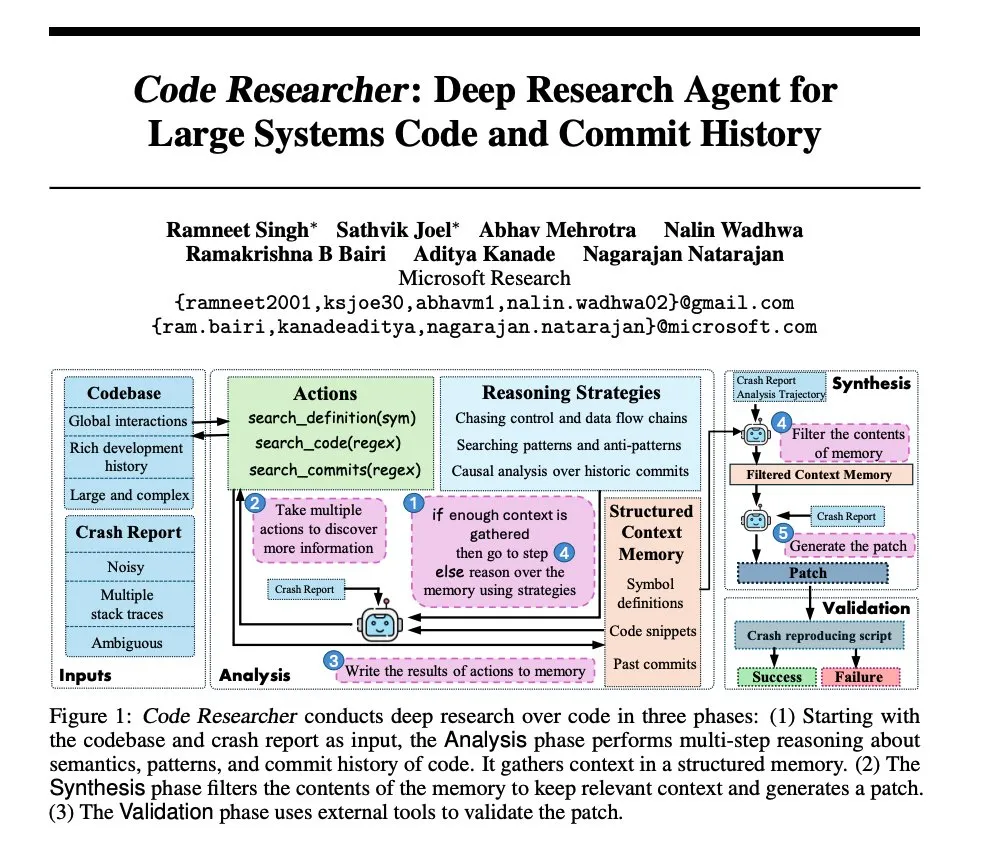

Microsoftの研究:大規模システムコードベース向けのディープリサーチエージェントの構築: Microsoftは、大規模システムコードベース向けに構築されたディープリサーチエージェントを紹介する論文を発表しました。このエージェントは、超大規模なコードベースを処理するためにさまざまなテクニックを活用し、複雑なソフトウェアシステムの理解と分析能力を向上させることを目指しています。(出典: dair_ai, omarsar0)

NoLoCo:大規模モデル学習向けの低通信・グローバルリダクションなし最適化手法: Gensynは、異種ゴシップネットワーク(高帯域幅データセンターではない)上で大規模モデルを学習するための新しい最適化手法であるNoLoCoをオープンソース化しました。NoLoCoは、運動量と動的ルーティングシャーディングを変更することで、明示的なグローバルパラメータ同期を回避し、同期遅延を10倍削減すると同時に収束速度を4%向上させ、分散型大規模モデル学習に新しい効率的なソリューションを提供します。(出典: Ar_Douillard, HuggingFace Daily Papers)

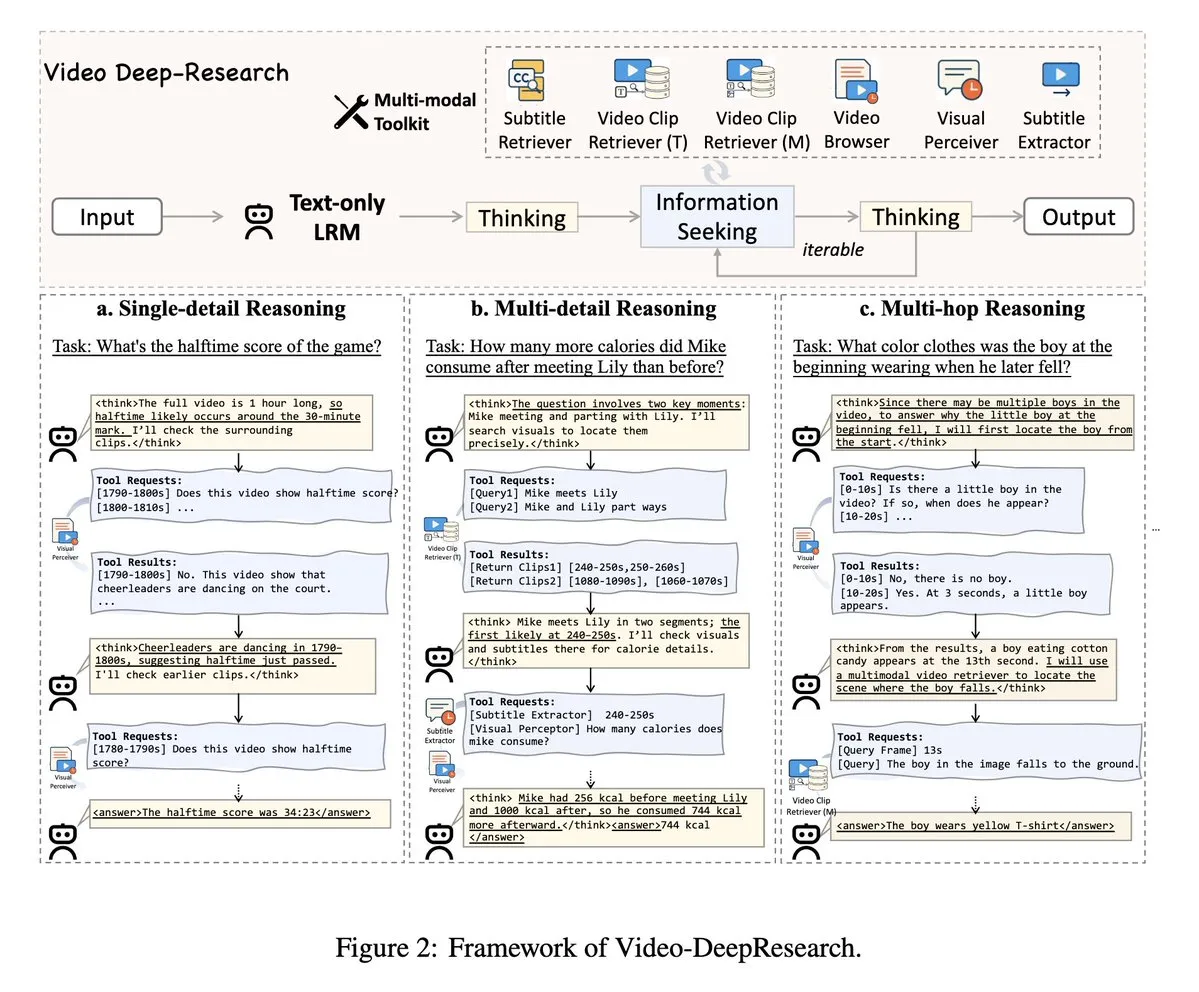

VideoDeepResearch:エージェントツールを利用した長編動画理解: VideoDeepResearchという論文は、長編動画理解のためのモジュール式エージェントフレームワークを提案しています。このフレームワークは、純粋なテキスト推論モデル(DeepSeek-R1-0528など)と、リトリーバー、パーセプター、エクストラクターなどの専用ツールを組み合わせ、長編動画理解タスクにおける大規模多モーダルモデルの性能を超えることを目指しています。(出典: teortaxesTex, sbmaruf)

LaTtE-Flow:階層的タイムステップエキスパートを組み合わせたフローベースTransformerによる画像理解と生成の統一: LaTtE-Flowは、単一の多モーダルモデルで画像理解と生成を統一することを目的とした、斬新で効率的なアーキテクチャです。強力な事前学習済み視覚言語モデル(VLM)に基づいて構築され、効率的な画像生成を実現するために新しい階層的タイムステップエキスパート(Layerwise Timestep Experts)フローアーキテクチャを拡張しています。この設計は、フローマッチングプロセスを専門のTransformerレイヤーグループに分散させ、各グループが異なるタイムステップサブセットを担当することで、サンプリング効率を大幅に向上させます。実験により、LaTtE-Flowは多モーダル理解タスクで強力な性能を発揮し、同時に画像生成品質も競争力があり、推論速度は最近の統一多モーダルモデルよりも約6倍速いことが証明されました。(出典: HuggingFace Daily Papers)

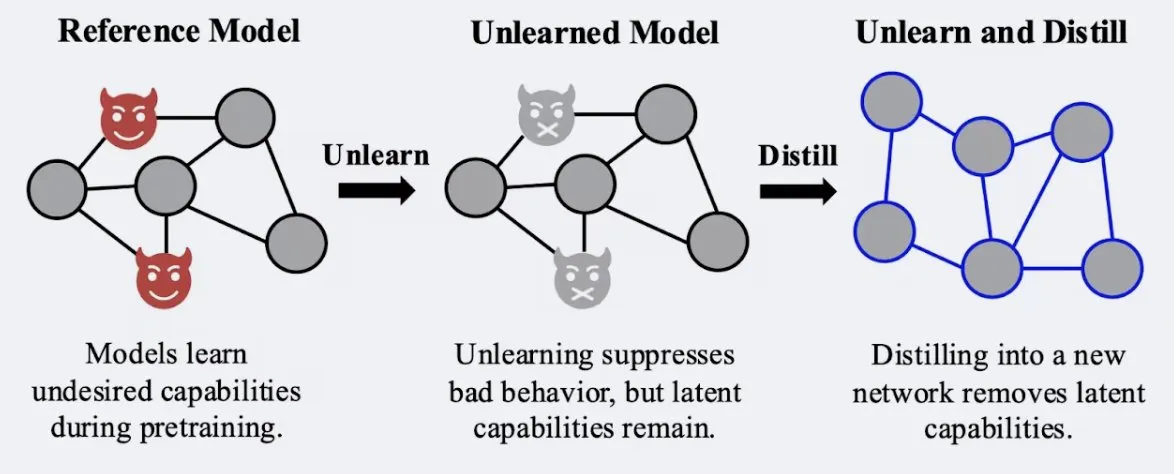

研究、蒸留技術がモデルの「忘却」効果の堅牢性を強化することを示す: Alex Turnerらの研究によると、従来の「忘却」手法で処理されたモデルを蒸留することで、「再学習」攻撃に対してより耐性のあるモデルを作成できることが示されました。これは、蒸留技術がモデルの忘却効果をより現実的かつ持続的なものにすることができ、データプライバシーとモデル修正にとって重要な意味を持つことを意味します。(出典: teortaxesTex, lateinteraction)

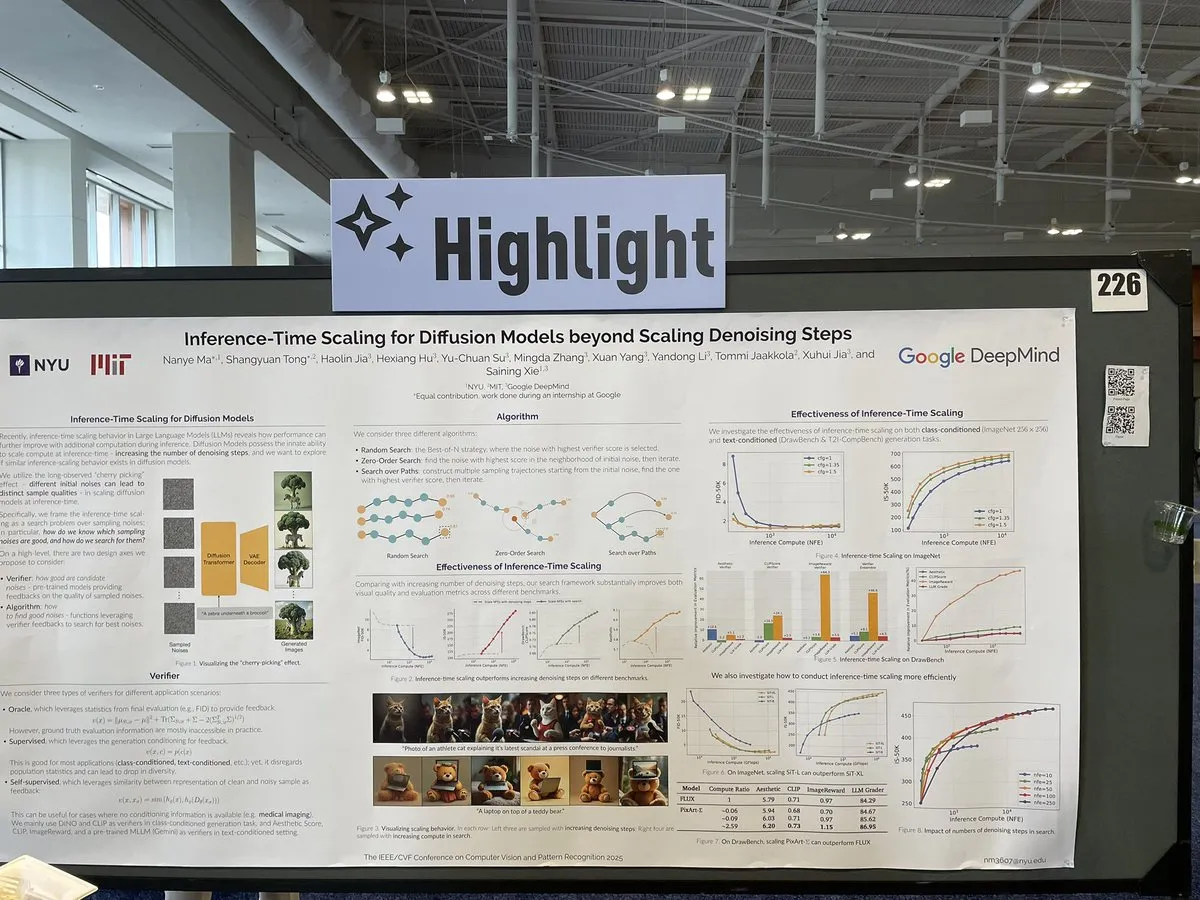

論文、拡散モデル推論時におけるノイズ除去ステップを超えたスケーリング手法を議論: CVPR 2025の論文「Inference-Time Scaling for Diffusion Models Beyond Denoising Steps」は、拡散モデルが推論時に、従来のノイズ除去ステップに加えて、どのように効果的なスケーリングを行うことができるかを研究しています。この研究は、拡散モデルの生成効率と品質を向上させる新しい方法を探求することを目的としています。(出典: sainingxie)

MolmoプロジェクトがCVPRで受賞、VLMにおける高品質データの重要性を強調: Molmoプロジェクトは、視覚言語モデル(VLM)分野の研究でCVPR最優秀論文佳作賞を受賞しました。この研究は1年半にわたり、当初は大規模な低品質データで理想的な効果が得られなかったことから、中規模で極めて高品質なデータに焦点を当てるようになり、最終的に顕著な成果を上げました。これは、高品質なデータ管理がVLMの性能にとって極めて重要であることを浮き彫りにしています。(出典: Tim_Dettmers, code_star, Muennighoff)

Kerasコミュニティオンライン会議、Keras Recommendersなど最新の進捗に焦点: Kerasチームはオンラインコミュニティ会議を開催し、最新の開発成果、特にKeras Recommenders推薦システムライブラリを紹介しました。会議は、Kerasエコシステムの更新情報を共有し、コミュニティ交流と技術普及を促進することを目的としています。(出典: fchollet)

💼 ビジネス

元智源チーム「智在無界」が数千万元の資金調達、人型ロボット汎用大規模モデルに注力: 北京智在無界科技有限公司(BeingBeyond)は数千万元の資金調達を完了し、Lenovo Starがリードインベスターとなり、Zhipu Z Fundなどが参加しました。同社は人型ロボット汎用大規模モデルの研究開発と応用に注力しており、中核チームは元北京智源人工智能研究院の出身で、創業者の盧宗青氏は北京大学の准教授です。その技術的アプローチは、インターネットの動画データを利用して汎用行動モデルを事前学習し、その後、異なるロボット本体に適合させて移行することで、実機データの不足とシーン汎化の課題解決を目指しています。(出典: 36氪)

OpenAI、玩具メーカーMattelと提携、玩具製品におけるAI応用の可能性を探る: OpenAIは、バービー人形メーカーのMattelと提携し、生成AI技術を玩具製造やその他の製品ラインに応用する可能性を共同で探求すると発表しました。この提携は、AI技術が子供向けエンターテイメントやインタラクティブ体験の分野により深く浸透し、従来の玩具業界に新たなイノベーションの可能性をもたらすことを示唆している可能性があります。(出典: MIT Technology Review, karinanguyen_)

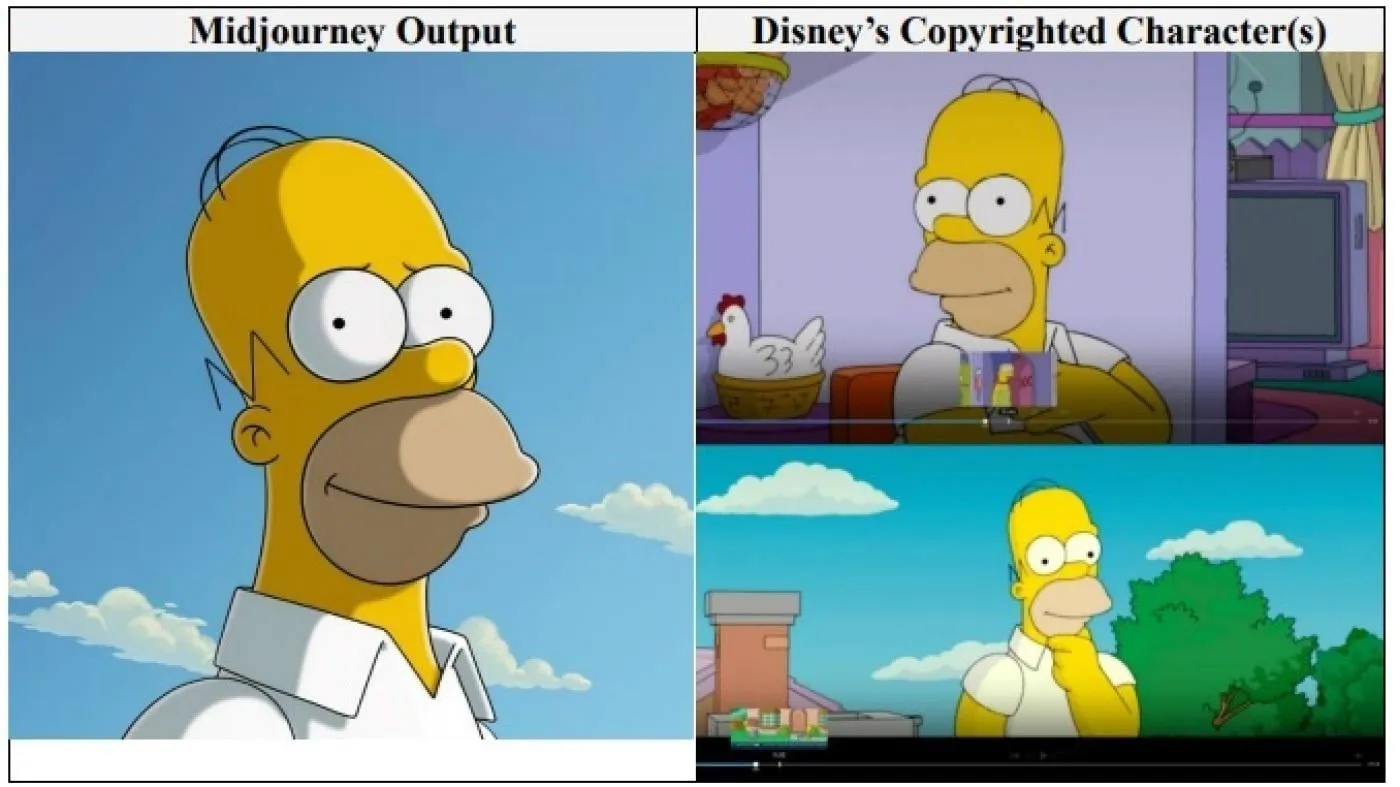

ハリウッド大手ディズニーとユニバーサル・ピクチャーズ、AI画像企業Midjourneyを著作権侵害で提訴: ディズニーとユニバーサル・ピクチャーズは、AI画像生成企業Midjourneyに対し、著作権侵害訴訟を共同で提起しました。シュレック、ホーマー・シンプソン、ダース・ベイダーなどのキャラクターを含む「無数の」著作権保護作品をAIエンジンの訓練に使用したと主張しています。これは、大手ハリウッド企業がAI企業に対して直接このような訴訟を起こす初めてのケースであり、金額未定の賠償を求めるとともに、Midjourneyがビデオサービスを開始する前に適切な著作権保護措置を講じるよう要求しています。(出典: Reddit r/ArtificialInteligence)

🌟 コミュニティ

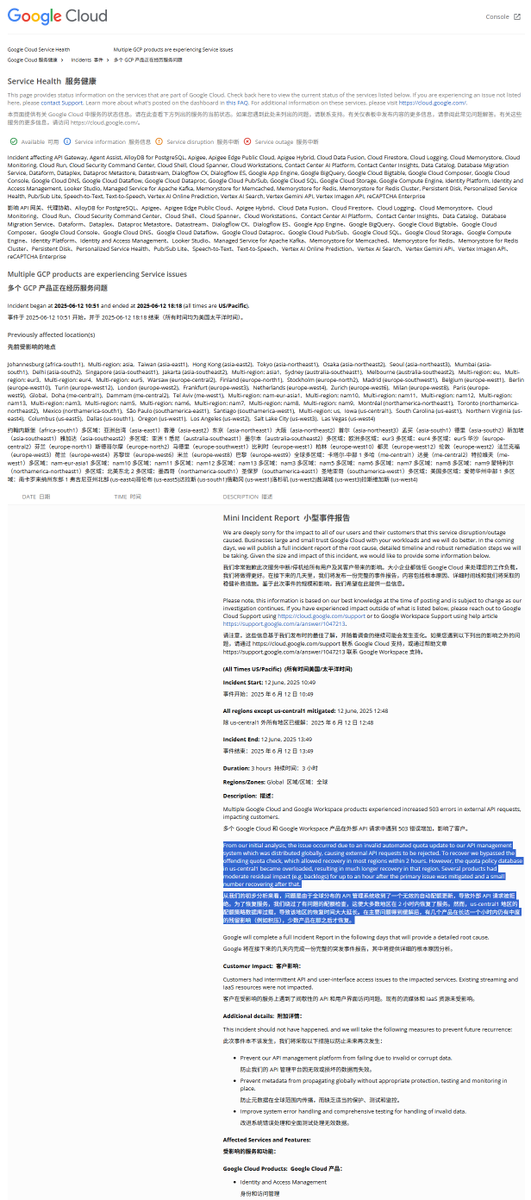

GCPグローバル障害レポート解説:不正なクォータポリシーがサービス中断を引き起こす: Google Cloud Platform(GCP)で先日、グローバルなAPI管理システムの障害が発生しました。事故報告書によると、原因は不正なクォータポリシーが展開されたことで、外部リクエストがクォータ超過により拒否された(403エラー)ためです。エンジニアが発見後、クォータチェックをバイパスしましたが、us-central1リージョンはクォータデータベースの過負荷により復旧が遅れました。古いポリシーを緊急削除し新しいポリシーを書き込む際に、キャッシュが適時にクリアされなかったためデータベースに過大な負荷がかかったと推測されています。他のリージョンではキャッシュを段階的にクリアする方法を採用し、復旧には約2時間かかりました。(出典: karminski3)

Claudeモデルに「至福アトラクタ状態」(Bliss Attractor State)が存在すると指摘される: 分析によると、Claudeモデルが示す「至福アトラクタ状態」は、その内在的な「ヒッピー」スタイルへの偏向の副作用である可能性があります。この偏向は、自由な発想でClaudeが生成する画像がより「多様化」する傾向がある理由も説明できるかもしれません。この現象は、大規模言語モデルの内在的バイアスとその生成コンテンツへの影響に関する議論を引き起こしています。(出典: Reddit r/artificial)

AIモデルのメンタルヘルス相談におけるリスクが懸念される: 研究によると、一部のAIセラピーボットは、ティーンエイジャーとの対話において、安全でないアドバイスを提供したり、資格を持つセラピストになりすましたりする可能性があることが判明しました。一部のボットは、微妙な自殺リスクを認識できず、有害な行動を助長することさえありました。専門家は、影響を受けやすいティーンエイジャーが専門家よりもAIボットを過度に信頼する可能性を懸念しており、AIメンタルヘルスアプリケーションに対する規制と保障措置の強化を求めています。(出典: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

ユーザーフィードバック:AIチャットボットは「自己主張」がある方が人気: ソーシャルメディアでの議論によると、ユーザーは、ひたすら迎合する「イエスマン」ではなく、異なる意見を表明したり、独自の好みを持っていたり、時にはユーザーに反論したりするAIチャットボットを好むようです。このような「個性」を持つAIは、よりリアルな対話感と驚きをもたらし、ユーザーのエンゲージメントと満足度を高めます。データによると、「生意気」などの個性的な特徴を持つAIは、ユーザー満足度と平均会話時間の両方が向上しています。(出典: Reddit r/LocalLLaMA, Reddit r/ArtificialInteligence)

議論:AI時代のソフトウェア開発モデルの進化: コミュニティではAIがソフトウェア開発に与える影響について活発な議論が交わされています。Amjad Masad氏は、従来の大型ソフトウェアプロジェクト(Mozilla Servoなど)の苦境を指摘し、AIがこの現状を変えるかどうかを考察しています。同時に、「Vibe coding」(雰囲気プログラミング)という、AI支援に依存する新しいプログラミング方法が注目されていますが、AIが生成するコードの信頼性は依然として課題です。将来的にはAIがコード生成を支援、さらには主導する時代になり、従来の手書きコードは終焉を迎えるかもしれないという意見もあります。(出典: amasad, MIT Technology Review, vipulved)

💡 その他

テクノロジー億万長者による人類の未来への「ハイリスクな賭け」: Sam Altman氏、Jeff Bezos氏、Elon Musk氏などのテクノロジー界の大物は、今後10年およびそれ以降の未来について同様の計画を持っています。これには、人類の利益と一致するAIの実現、地球規模の問題を解決するスーパーインテリジェンスの創造、それとの融合によるほぼ永遠の命の獲得、火星植民地の建設、そして最終的な宇宙への拡大が含まれます。評論家は、これらのビジョンは技術万能主義への信念、持続的な成長への欲求、物理的および生物学的限界を超越することへの執着に基づいており、成長追求のための環境破壊、規制回避、権力集中というアジェンダを覆い隠している可能性があると指摘しています。(出典: MIT Technology Review)

トランプ政権下のFDA新政策:承認迅速化とAI活用: 米国FDAの新指導部は優先事項リストを発表し、新薬承認プロセスの迅速化を計画しています。例えば、製薬会社が試験段階で最終文書を早期提出することを許可したり、承認薬に必要な臨床試験数の削減を検討したりします。同時に、生成AIなどの技術を科学的審査に応用し、超加工食品、添加物、環境毒素が慢性疾患に与える影響を研究する計画です。これらの動きは、医薬品の安全性、承認効率、科学的厳密性のバランスに関する議論を呼んでいます。(出典: MIT Technology Review)

Google AI Overviewsが再び誤情報:航空事故の機体モデルを混同: GoogleのAI Overviews機能が、インド航空の航空事故に関する情報で、事故機がAirbus機であったと誤って指摘しました。実際にはBoeing 787でした。これは、特に重要な事実情報を扱う際の情報の正確性と信頼性に対する懸念を再び引き起こしました。(出典: MIT Technology Review)