キーワード:Geminiモデル, Mistral AI, NVIDIA NeMo, LTX-Video, Safariブラウザ, RTX 5060, AIエージェント, 強化学習によるファインチューニング, Geminiネイティブ画像生成, Mistral Medium 3のプログラミング性能, NeMoフレームワーク2.0モジュール化, DiTリアルタイム動画生成, AI駆動型検索改造

🔥 フォーカス

Google Geminiネイティブ画像生成機能がアップグレード、視覚的品質とテキストレンダリングの精度を向上: Googleは、Geminiモデルのネイティブ画像生成機能が大幅に更新されたことを発表しました。新バージョン「gemini-2.0-flash-preview-image-generation」はGoogle AI StudioおよびVertex AIで利用可能です。今回のアップグレードにより、画像の視覚的品質とテキストレンダリングの精度が大幅に向上し、遅延も削減されました。新機能は、画像要素の融合、リアルタイム編集(オブジェクトの追加、部分的な内容の変更など)、およびGemini 2.0 Flashとの連携によるAIの自律的な構想と画像生成をサポートします。ユーザーはGoogle AI Studioで無料で試用でき、API呼び出し価格は画像1枚あたり0.039ドルです。大幅な進歩にもかかわらず、一部のユーザーは、全体的な効果は依然としてGPT-4oにわずかに劣ると考えています。(ソース: 量子位)

Mistral AIがMistral Medium 3をリリース、プログラミングとマルチモーダルに注力、コストを大幅に削減: フランスのAIスタートアップ企業Mistral AIは、最新のマルチモーダルモデルMistral Medium 3を発表しました。このモデルはプログラミングとSTEMタスクで優れたパフォーマンスを発揮し、多くのベンチマークテストでClaude Sonnet 3.7の90%に達するかそれを超える性能を達成したとされ、コストはその1/8(入力0.4ドル/100万トークン、出力2ドル/100万トークン)です。Mistral Medium 3は、ハイブリッド展開、カスタマイズされた後期トレーニング、エンタープライズツールとの統合など、エンタープライズレベルの機能を備えており、Mistral La PlateformeとAmazon Sagemakerで利用可能で、将来的にはさらに多くのクラウドプラットフォームに展開される予定です。同時に、Mistral AIは企業向けチャットボットサービスLe Chat Enterpriseも開始しました。(ソース: 量子位)

NVIDIA NeMoフレームワーク2.0がリリース、モジュール性と使いやすさを強化、Hugging FaceモデルとBlackwell GPUをサポート: NVIDIA NeMoフレームワークが2.0バージョンにアップデートされました。主な改善点には、YAMLに代わるPython設定の採用による柔軟性の向上、PyTorch Lightningのモジュール化された抽象化による実験とカスタマイズの簡素化、NeMo-Runツールを利用した大規模実験のシームレスな拡張が含まれます。新バージョンでは、Hugging Face AutoModelForCausalLMモデルの事前学習とファインチューニングのサポートが追加され、NVIDIA Blackwell B200 GPUの初期サポートも開始されました。さらに、NeMoフレームワークは、ビデオ処理ライブラリNeMo CuratorやCosmos tokenizerを含む、物理AIシステムのワールドモデル開発を加速するためのNVIDIA Cosmosワールド基礎モデルプラットフォームのサポートも統合しています。(ソース: GitHub Trending)

LightricksがLTX-Videoをリリース:リアルタイムDiT動画生成モデル: Lightricks社は、Diffusion Transformer (DiT) に基づく初のリアルタイム動画生成モデルと称するLTX-Videoをオープンソース化しました。このモデルは、30FPSで1216×704解像度の高品質動画を生成でき、テキストから画像、画像から動画、キーフレームアニメーション、動画拡張、動画から動画への変換など、多様な機能をサポートしています。最新バージョン13B v0.9.7では、プロンプトへの追従性と物理的理解能力が向上し、高速で高品質なレンダリングのためのマルチスケール動画パイプラインが導入されました。モデルはHugging Faceで提供されており、ComfyUIとDiffusersの統合も利用可能です。(ソース: GitHub Trending)

Apple、Safariブラウザの大幅な改造を検討、AI駆動型検索への移行か、Googleとの協力関係に注目: Appleの上級副社長エディ・キュー氏は、米国司法省によるGoogleの反トラスト法違反訴訟で証言し、AppleがSafariブラウザの改造を積極的に検討しており、AI駆動型の検索エンジンに重点を置いていることを明らかにしました。同氏は、Safariの検索量が初めて減少し、その一部はユーザーがOpenAIやPerplexity AIなどのAIツールに移行したためだと指摘しました。AppleはすでにPerplexity AIと協議を行っており、Safariにより多くのAI検索オプションを導入する可能性があります。この動きは、AppleとGoogle間の年間約200億ドル相当のデフォルト検索エンジン契約に影響を与え、両社の株価にも影響を与える可能性があります。AppleはすでにSiriにChatGPTを統合しており、Google Geminiの追加も計画しています。(ソース: 36氪)

🎯 動向

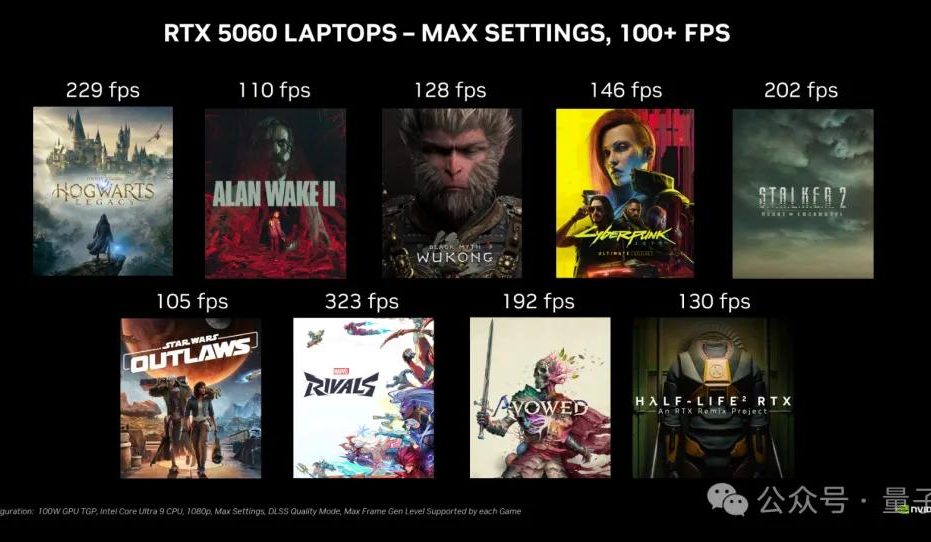

NVIDIA RTX 5060デスクトップグラフィックスカードが5月20日に発売、国内価格2499元: NVIDIAは、RTX 5060デスクトップグラフィックスカードを北京時間5月20日に発売すると発表しました。国内価格は2499元です。このカードはBlackwell RTXアーキテクチャを採用し、3840個のCUDAコア、8GBのGDDR7メモリを搭載し、総電力は145Wです。公式によると、DLSS 4マルチフレーム生成技術をサポートするゲームでは、RTX 4060の2倍の性能を発揮し、ユーザーが100 FPS以上のフレームレートでゲームを実行できるようにすることを目標としています。レビュー解禁と販売は同日に行われます。(ソース: 量子位)

Google Gemini APIが暗黙的キャッシュ機能を導入、最大75%のコスト削減が可能に: Googleは、Gemini APIに暗黙的キャッシュ機能を導入したことを発表しました。ユーザーのリクエストがキャッシュにヒットした場合、Gemini 2.5モデルの使用コストが自動的に75%削減されます。同時に、キャッシュをトリガーするために必要な最小トークン数も引き下げられ、Gemini 2.5 Flashは1Kトークン、Gemini 2.5 Proは2Kトークンになりました。この機能は、明示的にキャッシュを作成することなく、開発者がGemini APIを使用するコストを削減することを目的としています。(ソース: matvelloso, demishassabis, algo_diver, jeremyphoward)

Meta FAIR、Rob Fergus氏を新責任者に任命、高度な機械知能(AGI)に焦点: Metaは、Rob Fergus氏が基礎AI研究(FAIR)チームのリーダーを引き継ぐことを発表しました。Yann LeCun氏によると、FAIRは高度な機械知能、つまり一般的に人間レベルのAIまたはAGIと呼ばれるものに再び焦点を当てる予定です。このニュースはAI研究コミュニティから広く注目され、祝福されています。(ソース: ylecun, Ar_Douillard, soumithchintala, aaron_defazio, sainingxie)

OpenAI、o4-miniモデルの強化学習ファインチューニング(RFT)機能を発表: OpenAIは、o4-miniモデルが強化学習ファインチューニング(RFT)をサポートしたことを発表しました。この技術は昨年12月から開発されており、思考連鎖推論とタスク固有のスコアリングを利用してモデルのパフォーマンスを向上させ、特に複雑な分野で有効です。Ambience社はRFTでチューニングされたモデルを使用し、ICD-10コーディングの精度で専門の臨床医を27%上回りました。Harvey社もRFTを通じてモデルをトレーニングし、法律タスクにおける引用の精度を向上させています。同時に、OpenAIの最速かつ最小のモデルである4.1-nanoもファインチューニングが可能になりました。(ソース: stevenheidel, aidan_mclau, andrwpng, teortaxesTex, OpenAIDevs, OpenAIDevs)

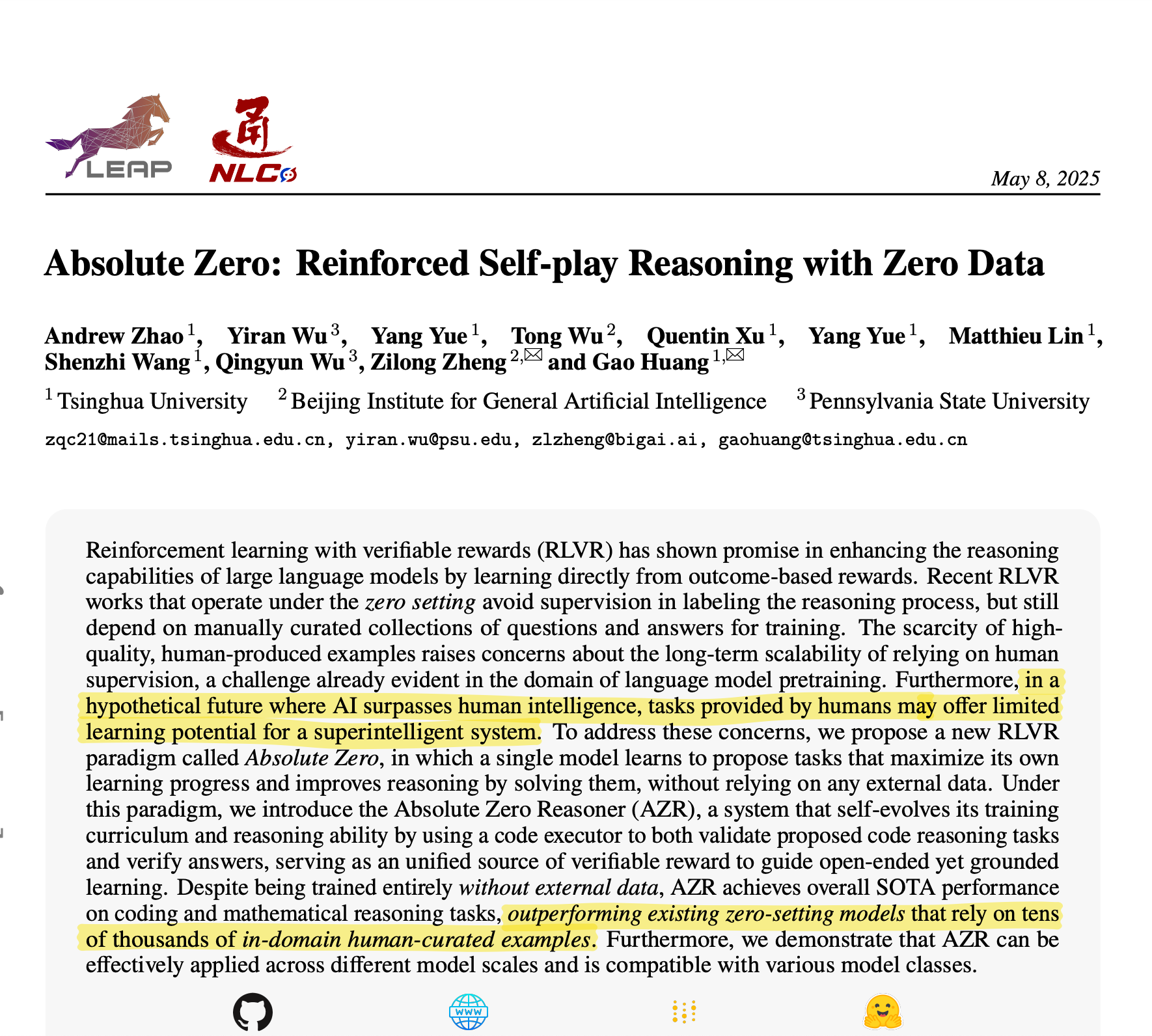

清華大学がAbsolute Zero Reasonerを提案:AIが自己生成した訓練データで卓越した推論を実現: 清華大学のチームは、Absolute Zero Reasonerという名のAIモデルを開発しました。このモデルは、外部データを一切使用せず、自己対戦(self-play)を通じて訓練タスクを生成し、そこから学習することができます。数学やコーディングなどの分野で、専門家が人手でキュレーションしたデータで訓練されたモデルを既に凌駕しています。この成果は、AI開発におけるデータボトルネック問題が緩和され、AGIへの新たな道が開かれる可能性を示唆しています。(ソース: corbtt)

MetaとNVIDIAが協力し、cuVSを通じてFaiss GPUベクトル検索性能を強化: MetaとNVIDIAは、NVIDIAのcuVS(CUDA Vector Search)をMetaのオープンソース類似性検索ライブラリFaiss v1.10に統合し、GPU上のベクトル検索性能を大幅に向上させることを発表しました。この統合により、IVFインデックスの構築時間が最大4.7倍向上し、検索遅延が最大8.1倍削減されました。グラフインデックスに関しては、CUDA ANN Graph (CAGRA) の構築時間がCPU HNSWより12.3倍速く、検索遅延が4.7倍削減されました。(ソース: AIatMeta)

Google AI StudioとFirebase StudioがGemini 2.5 Proを統合: Googleは、Gemini 2.5 ProモデルをGemini Code Assist(個人版)とFirebase Studioに統合したことを発表しました。これにより、開発者はこれらのプラットフォームでトップクラスのコーディングモデルをより便利かつ強力に利用できるようになり、コーディング効率と体験の向上を目指します。(ソース: algo_diver)

Microsoft CopilotがPages機能を発表、インライン編集とテキストハイライトをサポート: Microsoft Copilotに「Pages」機能が追加され、ユーザーはCopilotインターフェース内でAIが生成した返信を直接インライン編集できるようになりました。テキストをハイライトして具体的な修正要求を出すことができます。この機能は、ユーザーが質問や研究成果をより迅速かつスマートに利用可能なドキュメントに変換し、作業効率を向上させることを目的としています。(ソース: yusuf_i_mehdi)

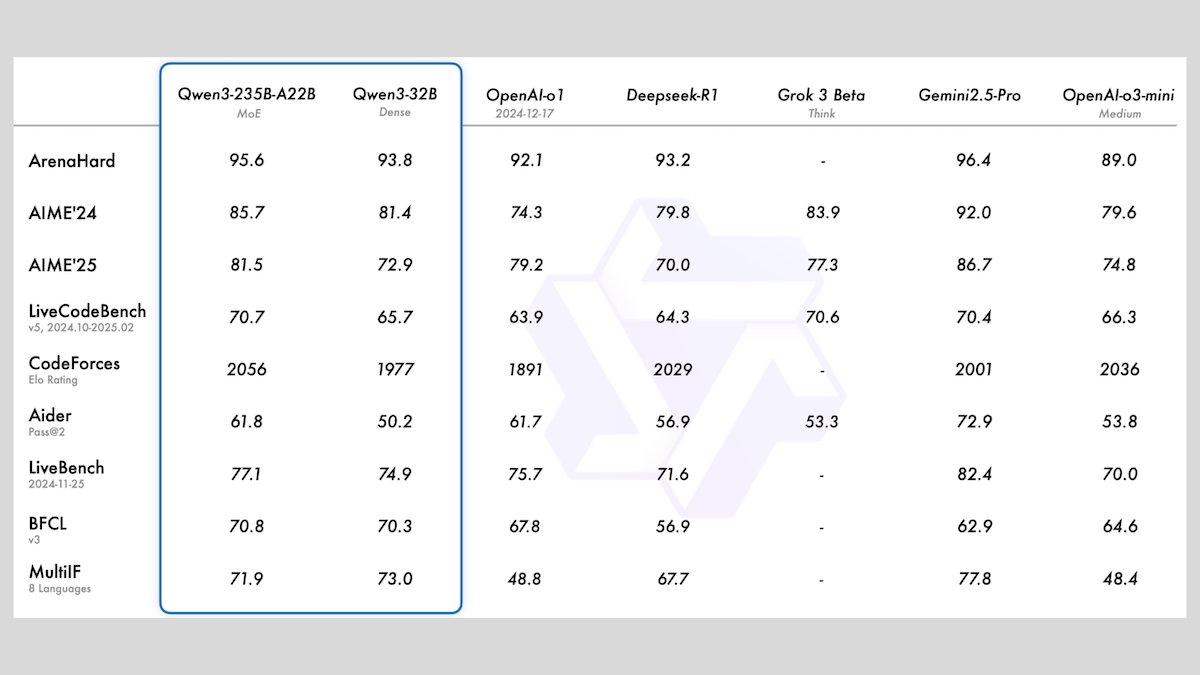

アリババがQwen3シリーズモデルを発表、8つのオープンソース大規模言語モデルを含む: アリババはQwen3シリーズを発表しました。これには、2つの混合エキスパート(MoE)モデルと、0.6Bから32Bのパラメータ範囲を持つ6つの高密度モデルを含む、8つのオープンソース大規模言語モデルが含まれています。すべてのモデルは、オプションの推論モードと119言語の多言語機能をサポートしています。Qwen3-235B-A22BとQwen3-30B-A3Bは、推論、コーディング、関数呼び出しタスクで優れたパフォーマンスを発揮し、OpenAIなどのトップモデルに匹敵します。特にQwen3-30B-A3Bは、その強力な性能とローカル実行能力で注目されています。(ソース: DeepLearningAI)

MetaがMeta Locate 3Dモデルを発表、正確な3D環境オブジェクト位置特定用: Meta AIは、3D環境内のオブジェクトを正確に特定するために設計されたモデル、Meta Locate 3Dを発表しました。このモデルは、ロボットが周囲の環境をより正確に理解し、人間とより自然に対話するのを助けることを目的としています。Metaは、モデル、データセット、研究論文、および一般ユーザーが使用・体験できるデモを提供しています。(ソース: AIatMeta)

Googleが新レポートを発表、AIを活用したネット詐欺対策を解説: Googleは、検索エンジン、Chromeブラウザ、Androidシステムにおけるネット詐欺対策にAI技術をどのように活用しているかについての新しいレポートを発表しました。レポートでは、Googleが10年以上にわたりAIを利用してユーザーをオンライン詐欺から保護してきた取り組みと最新の進捗状況を詳述し、詐欺行為の特定と阻止におけるAIの重要な役割を強調しています。(ソース: Google)

CohereがEmbed 4埋め込みモデルを発表、AI検索と検索能力を強化: Cohereは、最新の埋め込みモデルEmbed 4を発表しました。これは、企業のデータアクセスと活用方法を革新することを目的としています。Embed 4は、Cohere史上最も強力な埋め込みモデルとして、AI検索と検索の精度と効率の向上に重点を置き、組織がデータから隠れた価値を引き出すのを支援します。(ソース: cohere)

Google、Google I/Oカンファレンスを5月20日に開催と発表: Googleは、年次開発者会議Google I/Oを5月20日に開催し、登録受付を開始したことを公式に発表しました。基調講演、新製品・技術発表が行われる予定で、AIが中心的な議題の一つとなる見込みです。(ソース: Google)

NVIDIA Parakeetモデルが音声文字起こし新記録:60分の音声を1秒で文字起こし: NVIDIAのParakeetモデルは音声文字起こしでブレークスルーを達成し、60分間の音声を1秒で文字起こしすることが可能になり、Hugging Face関連のランキングで上位にランクインしました。この成果は、NVIDIAの音声認識技術におけるリーダーシップを示し、開発者に効率的な音声処理ツールを提供します。(ソース: huggingface)

🧰 ツール

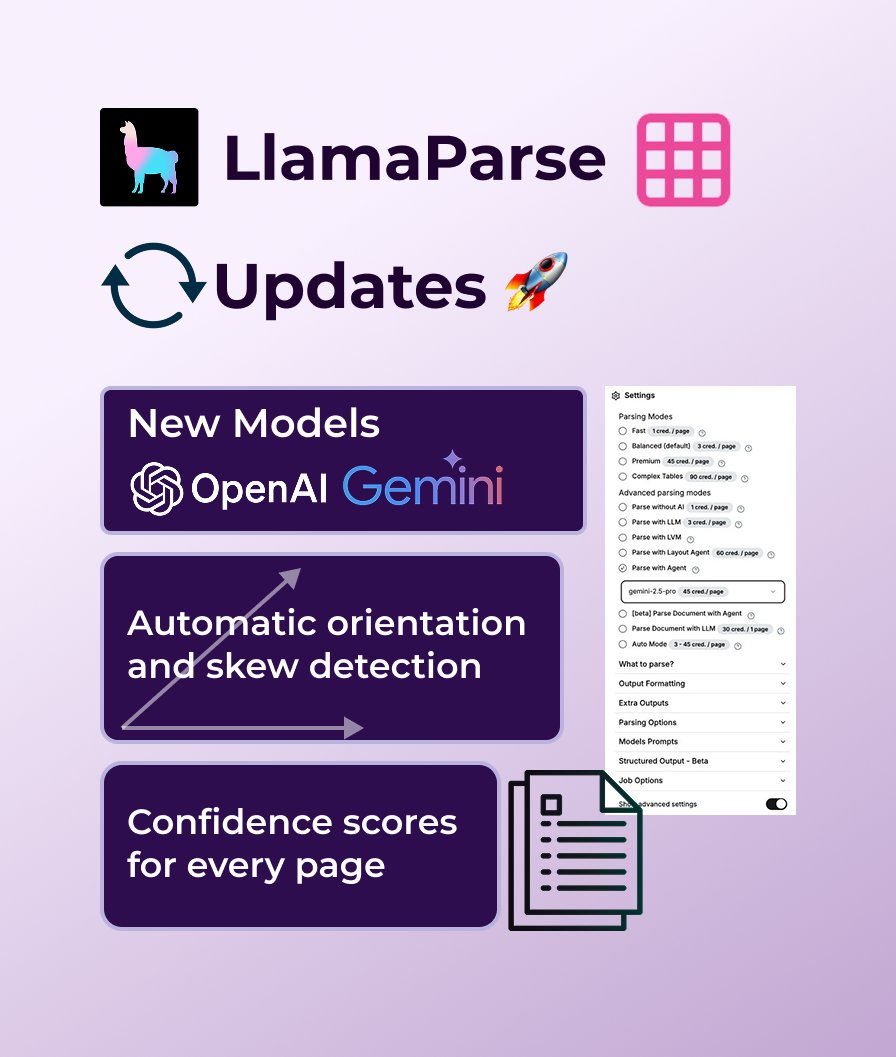

LlamaParseがGPT 4.1とGemini 2.5 Proのサポートを追加、ドキュメント解析能力を強化: LlamaParseは最近一連の機能更新を行い、精度向上のために新しい解析モデルGPT 4.1とGemini 2.5 Proを導入しました。さらに、新バージョンでは自動方向・傾き検出機能が追加され、完璧なアライメント解析を保証します。解析品質を評価するための信頼度スコアを提供し、ユーザーがエラー許容度や失敗ページの処理方法をカスタマイズできるようになりました。LlamaParseは毎月10,000ページの無料枠を提供しています。(ソース: jerryjliu0)

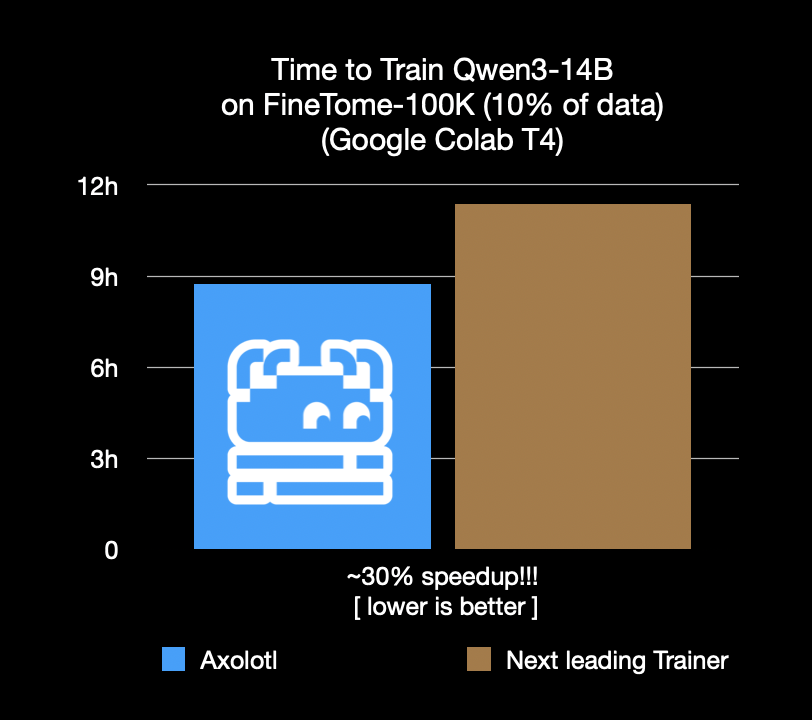

Axolotlファインチューニングフレームワークが30%高速化、コストと時間を節約: Axolotlファインチューニングフレームワークは、FineTome-100kなどの実際のワークロードにおいて、次善のフレームワークよりも30%高速であると発表しました。中規模から大規模の機械学習チームにとって、これは毎月数千ドルのコスト削減を意味します。このフレームワークの最適化は、ユーザーがより効率的かつ経済的にモデルのファインチューニングを行えるようにすることを目的としています。(ソース: Teknium1, winglian, maximelabonne)

Runwayがアニメーションパイロットエピソード『Mars & Siv: No Vacancy』を公開、Gen-4モデルの能力を披露: Runway傘下のAIスタジオは、Jeremy Higgins氏とBritton Korbel氏が制作したアニメーションパイロットエピソード『Mars & Siv: No Vacancy』を公開しました。この作品は、RunwayのGen-4モデルがコンセプトから最終製品に至るまで、アニメーション制作プロセスの各段階で応用されている様子を示し、AIによるクリエイティブコンテンツ生成の可能性を強調しています。(ソース: c_valenzuelab, c_valenzuelab)

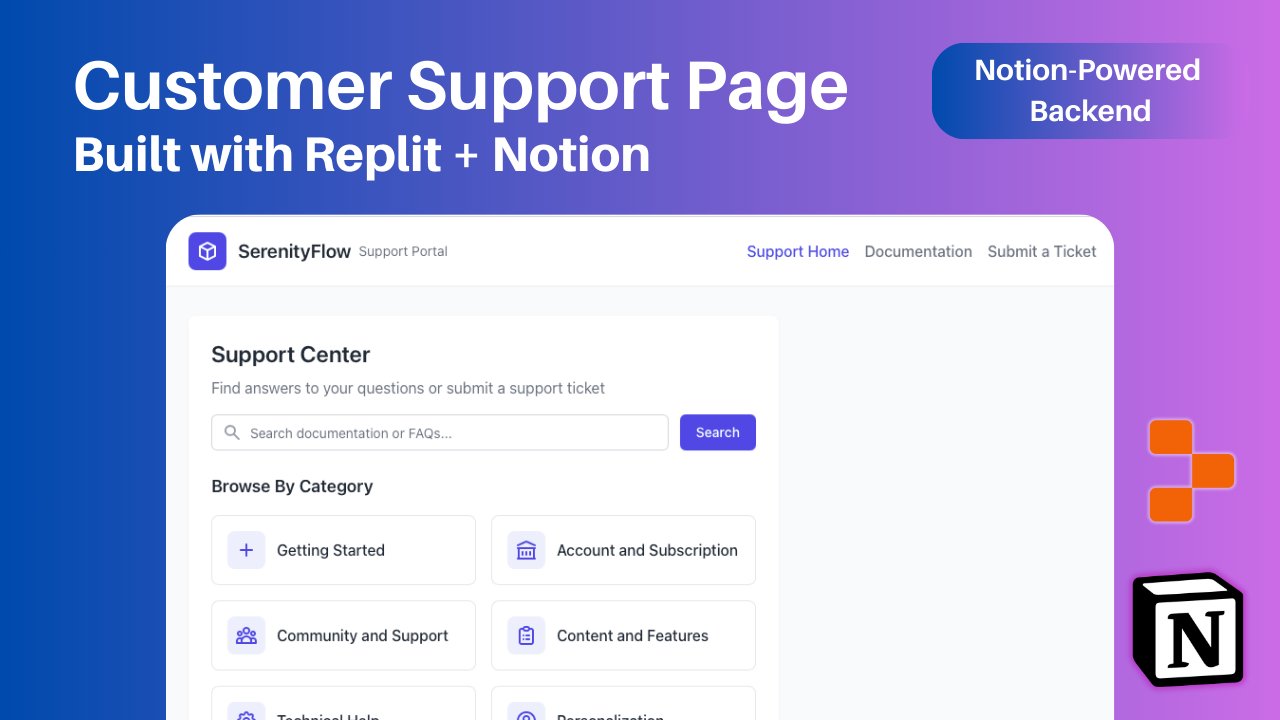

ReplitがNotion統合を追加、Notionコンテンツをアプリのバックエンドとしてサポート: ReplitはNotionとの新たな統合提携を発表し、開発者がNotionをアプリケーションのバックエンドとして使用できるようになりました。ユーザーはNotionデータベースをReplitプロジェクトに接続し、FAQの表示、ドキュメントベースのカスタムAIチャットボットの駆動、サポートチケットの記録をNotionに戻すことができます。この動きは、Notionのバックエンド整理能力とReplitの柔軟なフロントエンド作成能力を組み合わせることを目的としています。(ソース: amasad, amasad, pirroh)

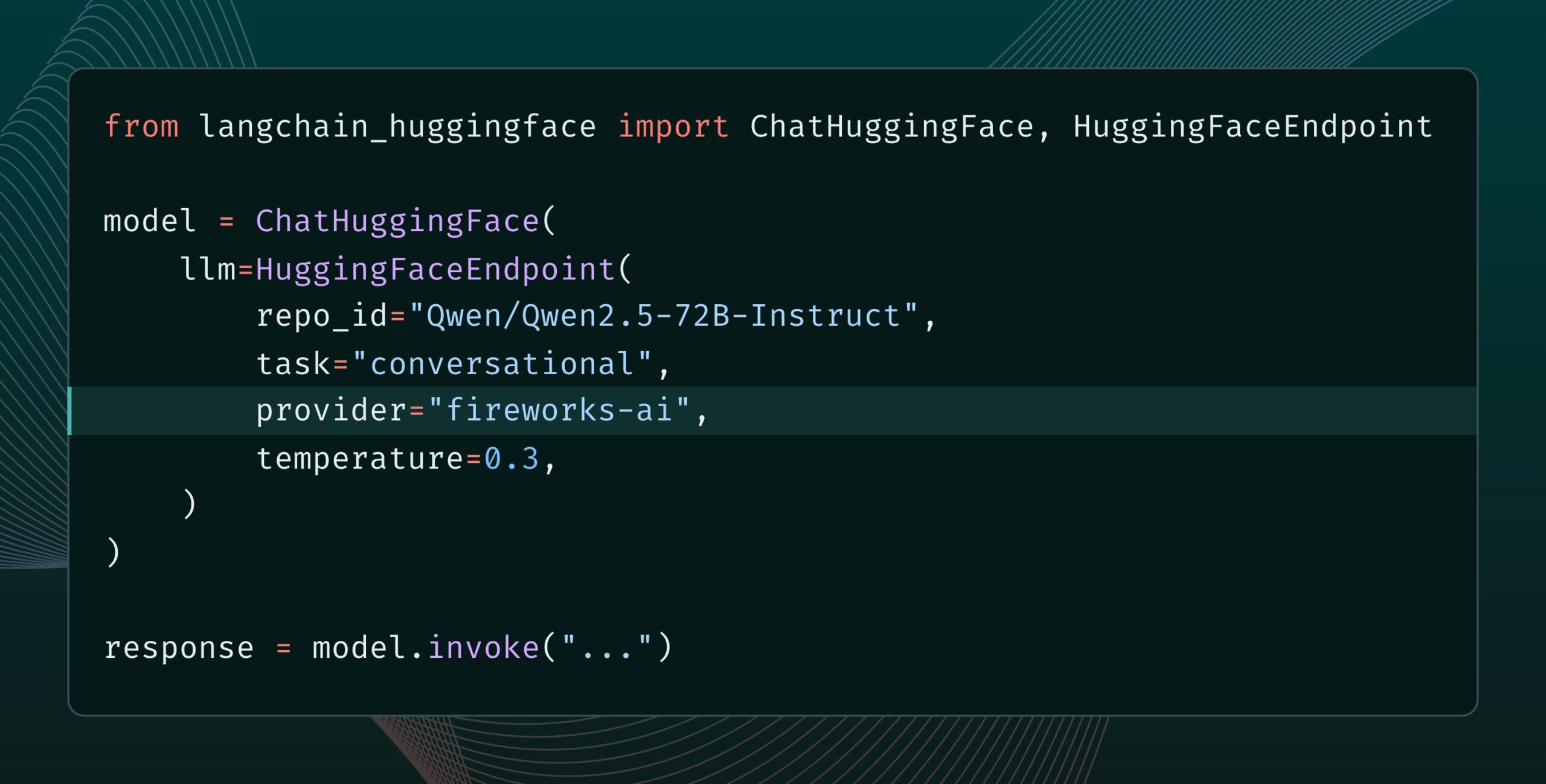

Langchain-huggingface v0.2リリース、HF Inference Providersをサポート: Langchain-huggingfaceはv0.2をリリースし、新バージョンではHugging Face Inference Providersのサポートが追加されました。このアップデートにより、LangChainエコシステム内でHugging Faceが提供する推論サービスをより便利に利用できるようになります。(ソース: LangChainAI, huggingface, ClementDelangue, hwchase17, Hacubu)

smolagents 1.15リリース、ストリーミング出力機能を追加: AIエージェントフレームワークsmolagentsは1.15バージョンをリリースし、ストリーミング出力(streaming outputs)機能を導入しました。ユーザーはCodeAgentを初期化する際にstream_outputs=Trueを設定するだけで有効になり、これによりすべてのインタラクションプロセスがよりスムーズに感じられるようになります。(ソース: huggingface, AymericRoucher, ClementDelangue)

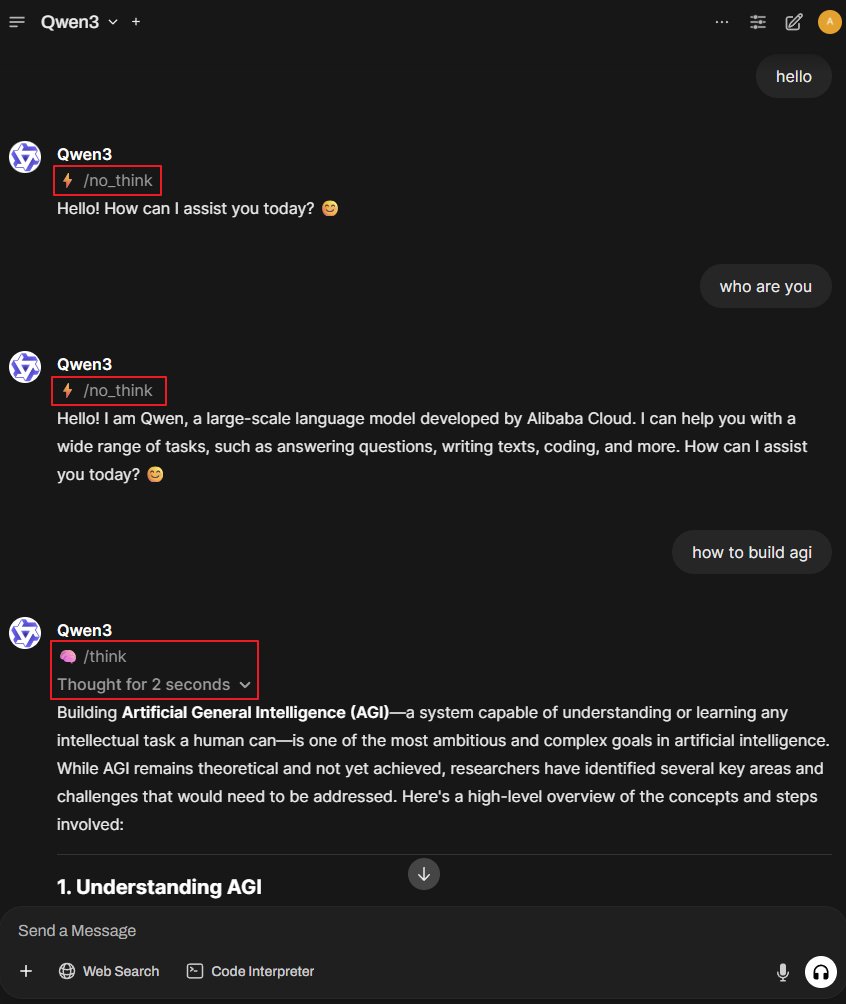

Better-Qwen3プロジェクト:Qwen3モデルに思考モードの自動切り替えを実装: Better-Qwen3というGitHubプロジェクトが注目を集めています。このプロジェクトは、Qwen3モデルがユーザーの質問の複雑さに応じて「思考モード」のオン/オフを自動的に制御できるようにすることを目的としています。簡単な質問にはモデルが直接回答し、複雑な質問には自動的に思考モードに入り、より深い回答を提供します。プロジェクトアドレス:http://github.com/AaronFeng753/Better-Qwen3 (ソース: karminski3, Reddit r/LocalLLaMA)

MLX-Audio:Apple MLXフレームワークに基づくTTS/STT/STSライブラリ: MLX-Audioは、Apple Silicon向けに特別に構築されたテキスト読み上げ(TTS)、音声認識(STT)、音声変換(STS)ライブラリで、AppleのMLXフレームワークに基づいて開発されており、効率的な音声処理能力を提供することを目的としています。このライブラリは、多言語、音声カスタマイズ、話速制御をサポートし、インタラクティブなWebインターフェースとREST APIを提供します。(ソース: GitHub Trending)

Runway Referencesモデルが画像拡張(Outpainting)機能をサポート: RunwayのReferencesモデルが画像拡張(outpainting)機能をサポートしました。ユーザーはReferencesに画像を配置し、必要な出力形式を選択し、プロンプトを空のままにして生成をクリックするだけで、元の画像を拡張できます。この機能は、Runwayの画像編集および作成能力をさらに強化します。(ソース: c_valenzuelab)

Docker2exe:Dockerイメージを実行可能ファイルに変換: Docker2exeは、Dockerイメージを独立した実行可能ファイルに変換できるツールで、ユーザーが簡単に共有・実行できるようにします。Dockerイメージのtarballを実行可能ファイルに直接パッケージ化する埋め込みモードをサポートしています。ターゲットデバイスで実行する際、ローカルに対応するDockerイメージがない場合は、埋め込まれたイメージを自動的にロードするか、ネットワークからプルします。(ソース: GitHub Trending)

Smoothie Qwen:Qwenモデルのトークン確率を平滑化し、多言語生成のバランスを調整: Smoothie Qwenは、Qwenモデルのトークン確率を平滑化することで、モデルの多言語生成時のバランスを強化し、特定の言語(中国語など)への意図しない偏りを減らしつつ、コア性能を維持することを目的とした軽量調整ツールです。このツールはUnicode範囲を利用してトークンを識別し、N-gram分析を行い、lm_head内のトークン重みを調整します。調整済みモデルはHugging Faceで提供されています。(ソース: Reddit r/LocalLLaMA)

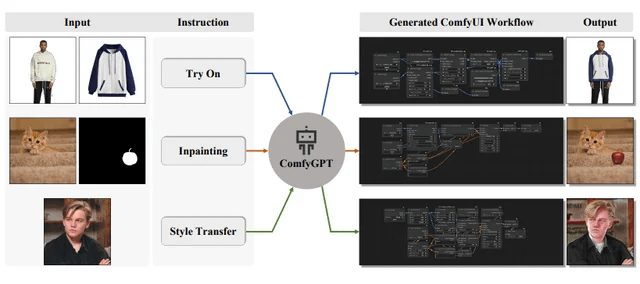

ComfyGPT:自己最適化マルチエージェントシステムによるComfyUIワークフロー生成: 「ComfyGPT: A Self-Optimizing Multi-Agent System for Comprehensive ComfyUI Workflow Generation」という論文がarXivに提出され、ComfyGPTというシステムが紹介されました。このシステムは、自己最適化マルチエージェント手法を利用し、ComfyUIのワークフローを包括的に生成し、複雑な画像生成プロセスの構築を簡素化することを目的としています。(ソース: Reddit r/LocalLLaMA)

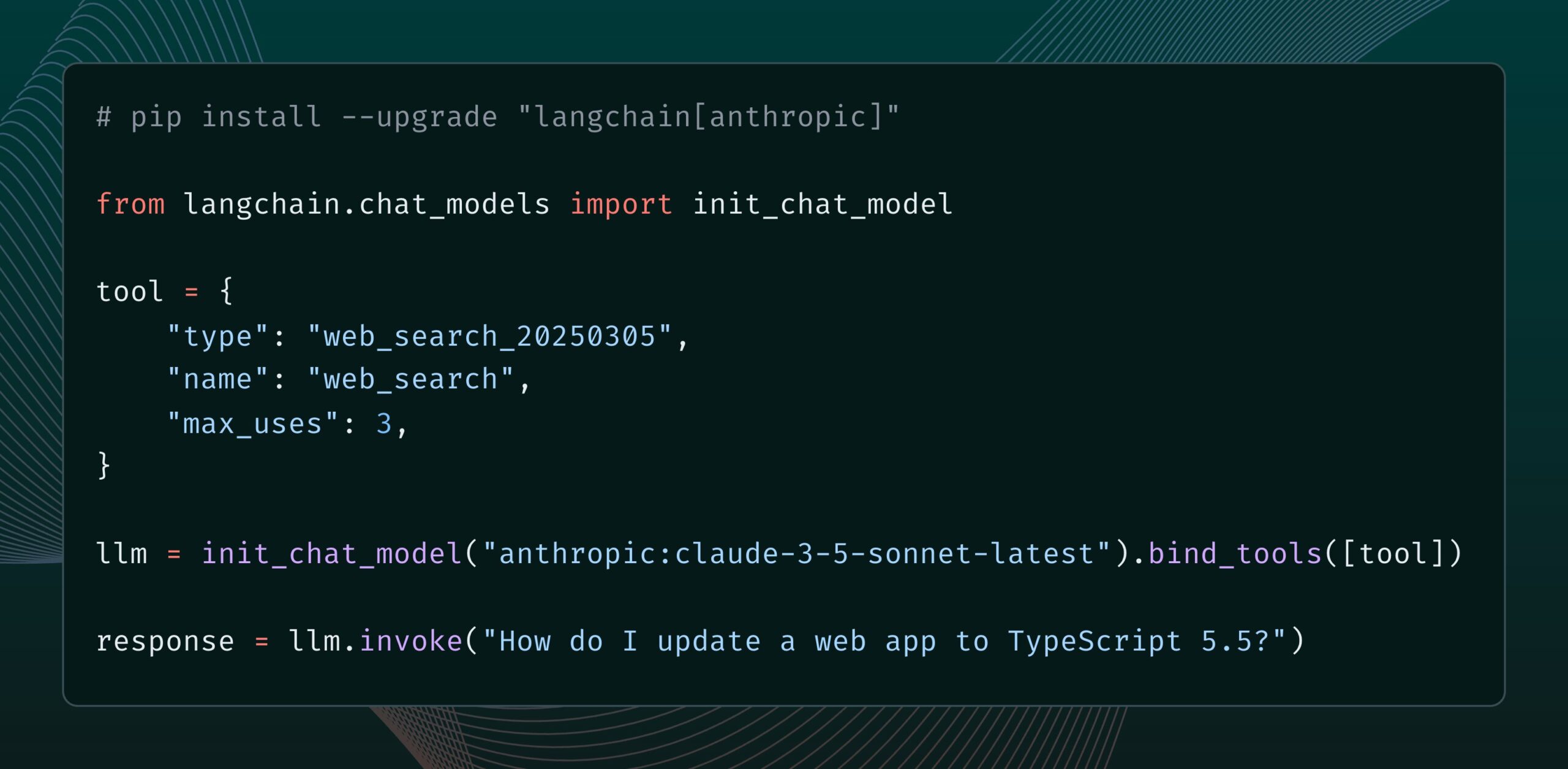

Anthropic Claudeモデルにウェブ検索ツールが追加: AnthropicはClaudeモデル向けに新しいウェブ検索ツールをリリースしました。このツールにより、Claudeは返信を生成する際にウェブ検索を行い、検索結果を根拠として引用付きの回答を提供できます。この機能はlangchain-anthropicライブラリに統合され、Claudeがリアルタイム情報を取得・活用する能力を強化しました。(ソース: LangChainAI, hwchase17)

Glass HealthがWorkspace機能を発表、AIによる臨床診断と治療計画を支援: Glass Healthは新しいWorkspace機能を発表しました。この機能により、臨床医はAIを使用して複雑な診断推論、治療計画策定、文書記録ワークフローをより効率的に完了できます。これは、AI技術を通じて医療業務の効率と質を向上させることを目的としています。(ソース: GlassHealthHQ)

OpenWebUIにAI強化ノートと会議録音機能が追加: OpenWebUIの最新バージョンには、AI強化ノート機能が追加されました。ユーザーはノートを作成し、会議や音声オーディオを添付し、AIにオーディオの文字起こしを利用してノートを即座に強化、要約、または最適化させることができます。さらに、会議オーディオの録音とインポート機能もサポートしており、ユーザーが重要な議論情報を確認・抽出するのに便利です。(ソース: Reddit r/OpenWebUI)

📚 学習

国連が200ページのAIとグローバルな人間開発に関する報告書を発表: 国連開発計画(UNDP)は、グローバルな人間開発の視点から人工知能を考察する200ページに及ぶ報告書を発表しました。この報告書は、AIが持続可能な開発目標、不平等、ガバナンス、未来の仕事など多方面に与える影響を探求し、政策提言を行っています。報告書はその鮮明な視点から注目されています。(ソース: random_walker)

The Turing PostがAgent2Agent (A2A)プロトコルの詳細解説記事を公開: AIエージェント間通信プロトコルに対するコミュニティの強い関心を受け、The Turing PostはHugging Face上でGoogleのA2Aプロトコルに関する詳細解説記事を無料で公開しました。記事では、A2Aプロトコルの重要性(AIエージェントのサイロ化を打破し、協調を実現することを目指す)、潜在的な応用(専門エージェントチームの協調、企業横断的なワークフロー、人間と機械の協調の標準化、検索可能なエージェントディレクトリなど)、その動作原理と入門方法について論じています。(ソース: TheTuringPost, TheTuringPost, TheTuringPost, dl_weekly)

プロンプトエンジニアが共有:使いやすいプロンプトテンプレートを簡単に作成する方法: プロンプトエンジニアのdotey氏は、効率的なプロンプトテンプレートを作成するための3ステップの方法を共有しました:1. 同じスタイルだが異なるテーマのプロンプトを収集する。2. 共通点と相違点を見つける(AIの助けを借りてもよい)。3. テストと最適化を繰り返す。同氏は、優れたテンプレートはプログラムの関数に似ており、少数の変数を変更するだけで異なる結果を生成できると強調しています。また、AIを利用して新しいプロンプトを迅速に生成するための指示テンプレートも共有し、すべてのスタイルがテンプレート化に適しているわけではなく、複雑な詳細が多いテーマは依然として個別最適化が必要であると指摘しました。(ソース: dotey)

DeepMind研究員John Jumper氏のチームが採用を拡大、LLMベースの科学的発見を拡張: Google DeepMindの研究員John Jumper氏は、大規模言語モデル(LLM)に基づく科学的発見に関する研究を拡大するため、チームが複数のポジションで採用を行っていることを発表しました。募集職種には研究科学者(RS)と研究エンジニア(RE)が含まれ、自然言語科学AIの未来を推進することを目指しています。(ソース: demishassabis, NandoDF)

Ragasブログが2年間のAIアプリケーション改善経験を共有: Shahules786氏はRagasブログに記事を投稿し、過去2年間AIチームと緊密に協力し、評価サイクルを提供し、LLMシステムを改善してきた経験と教訓をまとめました。この記事は、AIアプリケーションを構築・最適化する実務者に実用的なガイダンスと洞察を提供することを目的としています。(ソース: Shahules786)

Kyunghyun Cho氏がLLM時代の機械学習大学院課程の教授法を議論: ニューヨーク大学のKyunghyun Cho教授は、現在のLLMと大規模計算時代における1年生の機械学習大学院課程の教授内容に関する自身の考えと実験を共有しました。同氏は、SGD(確率的勾配降下法)を受け入れ、かつLLMではないすべての内容を教え、学生に古典的な論文を読むよう指導することを提案しています。(ソース: ylecun, sainingxie)

インテリジェント・ドキュメント・プロセッシング(IDP)ランキングが公開、VLMのドキュメント理解能力を統一的に評価: 新しいインテリジェント・ドキュメント・プロセッシング(IDP)ランキングが公開され、OCR、KIE、VQA、テーブル抽出など、さまざまなドキュメント理解タスクに統一的なベンチマークテストを提供することを目的としています。このランキングは、6つのコアIDPタスク、16のデータセット、9229のドキュメントをカバーしています。初期結果によると、Gemini 2.5 Flashが全体的にリードしていますが、すべてのモデルが長文ドキュメントの理解においてパフォーマンスが低く、テーブル抽出は依然としてボトルネックとなっています。GPT-4oの最新版は性能が低下さえしています。(ソース: Reddit r/MachineLearning, Reddit r/LocalLLaMA)

LangGraphがCron Jobs機能を発表、AIエージェントの定時トリガーをサポート: LangChainのLangGraphプラットフォームにCron Jobs機能が追加され、ユーザーはAIエージェントの実行を自動的にトリガーする定時タスクを設定できるようになりました。この機能により、AIエージェントは事前に設定されたスケジュールに従ってタスクを実行でき、周期的な処理や監視が必要なシナリオに適しています。(ソース: hwchase17)

💼 ビジネス

AIソフトウェアデバッグツールLightrunが7000万ドルのシリーズB資金調達、AccelとInsight Partnersが主導: AIソフトウェア可観測性およびデバッグツール開発企業Lightrunは、AccelとInsight Partnersが主導し、シティグループなどが参加する7000万ドルのシリーズB資金調達を完了したと発表しました。累計調達額は1億1000万ドルに達しました。同社の中核製品であるRuntime Autonomous AI Debuggerは、IDE内で問題のあるコードを正確に特定し、修正案を提案することで、デバッグ時間を数時間から数分に短縮することを目指しています。同社の2024年の収益は4.5倍に増加し、顧客にはシティグループやマイクロソフトなどのフォーチュン500企業が含まれています。(ソース: 36氪)

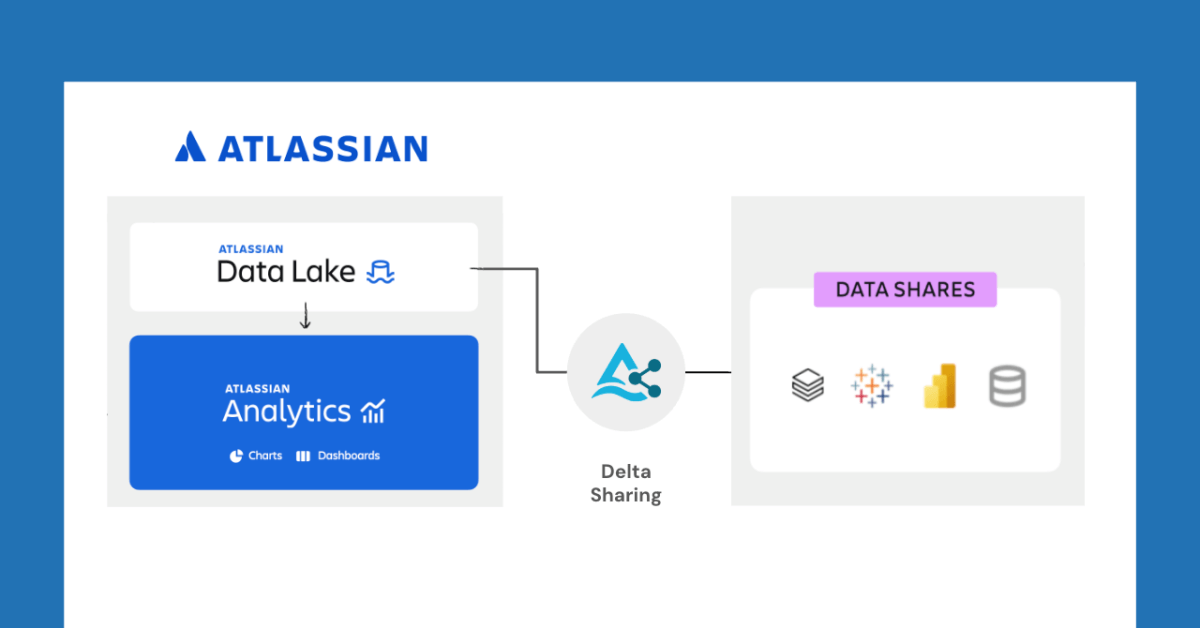

DatabricksとAtlassianが提携、Delta Sharingを通じてデータ共有の新機能を開放: DatabricksはAtlassianとの提携を発表し、Atlassian Analyticsに新たなデータ共有機能を提供します。Delta Sharingのオープンプロトコルを通じて、Atlassianの顧客は選択したツールを使用してAtlassian Data Lake内のデータに安全にアクセスし、分析することができます。この機能は、BI統合、カスタムデータワークフロー、チーム横断的なコラボレーションなどのユースケースをサポートします。(ソース: matei_zaharia)

Fastinoが1750万ドルの資金調達、タスク特化型言語モデル(TLM)に注力: スタートアップ企業Fastinoは、Khosla Venturesが主導する1750万ドル(総額2500万ドルのプレシードラウンド)の資金調達を発表し、革新的なタスク特化型言語モデル(TLM)の開発に充当します。Fastinoによると、同社のTLMアーキテクチャは小型で特定のタスクに特化しており、ローエンドのゲームGPUでトレーニング可能で、コスト効率が高いとのことです。TLMは、アーキテクチャ、事前学習、事後学習の各レベルでタスクの専門化を行うことで、パラメータの冗長性とアーキテクチャの非効率性を排除し、特定タスクの精度向上を目指し、遅延とコストに敏感なアプリケーションへの組み込みが可能です。(ソース: Reddit r/MachineLearning)

🌟 コミュニティ

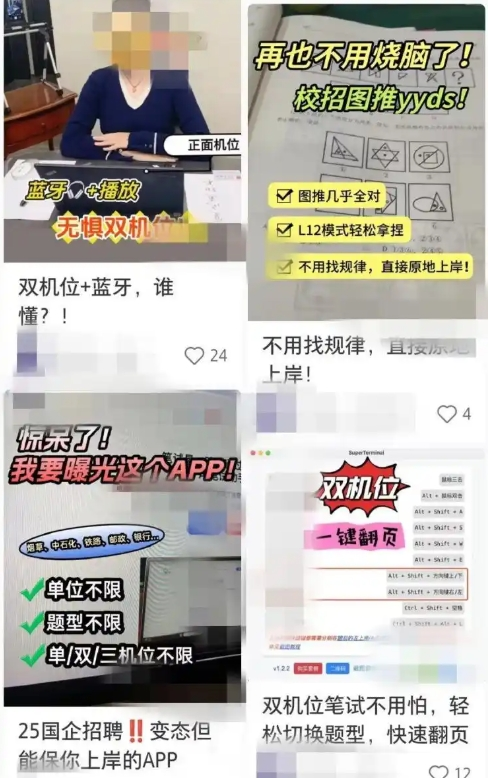

AI支援型就職ツールが不正行為の懸念を引き起こし、企業は対策を強化: 最近、AIツールを利用してオンライン面接や筆記試験を支援する現象が増加しており、これらの「AI面接神器」はユーザーの履歴書に基づいて回答をカスタマイズし、応募者が就職活動で有利になるのを助けます。このようなソフトウェアの入手は容易で、複数の有料プランやリモート指導まで提供されています。この傾向は、「Interview Coder」などの初期のAI不正ツールの出現にまで遡ります。企業側は既に対策を講じ始めており、応募者の面接時の異常行動に注意を払ったり、画面検出の導入や対面面接の再開を検討したりしています。弁護士は、AIによる不正行為は誠実義務違反に該当し、労働契約の解除につながる可能性があり、プライバシー漏洩のリスクも存在すると指摘しています。(ソース: 36氪)

LangChain CEO Harrison Chase氏が「アンビエントエージェント」と「エージェントインボックス」の概念を提唱: LangChainのCEOであるHarrison Chase氏は、Sequoia AI AscentイベントでAIエージェントの将来の発展についての見解を共有し、「アンビエントエージェント」(Ambient Agents)と「エージェントインボックス」(Agent Inbox)という概念を提唱しました。アンビエントエージェントとは、バックグラウンドで継続的に実行され、人間の直接的な指示ではなくイベントに応答するAIシステムを指し、エージェントインボックスは、これらのエージェントの活動を管理・監督するための新しい人間と機械のインタラクションインターフェースです。(ソース: hwchase17, hwchase17, hwchase17)

Jim Fan氏がAIの新たな北極星として「物理チューリングテスト」を提唱: NVIDIAの科学者Jim Fan氏は、Sequoia AI Ascentイベントで「物理チューリングテスト」の概念を提唱し、これをAI分野の次の「北極星」と位置づけました。このテストは、日曜日のハッカソンの後、家が散らかっているが、月曜日の夜に帰宅するとリビングルームが塵一つなく片付いており、キャンドルライトディナーが用意されているというシナリオを想定しており、それが人間によるものか機械によるものか区別できないというものです。同氏はこれを汎用ロボット技術の目標であると考え、データ戦略やスケール則を含む、この問題を解決するための最優先原則を共有しました。(ソース: DrJimFan, killerstorm)

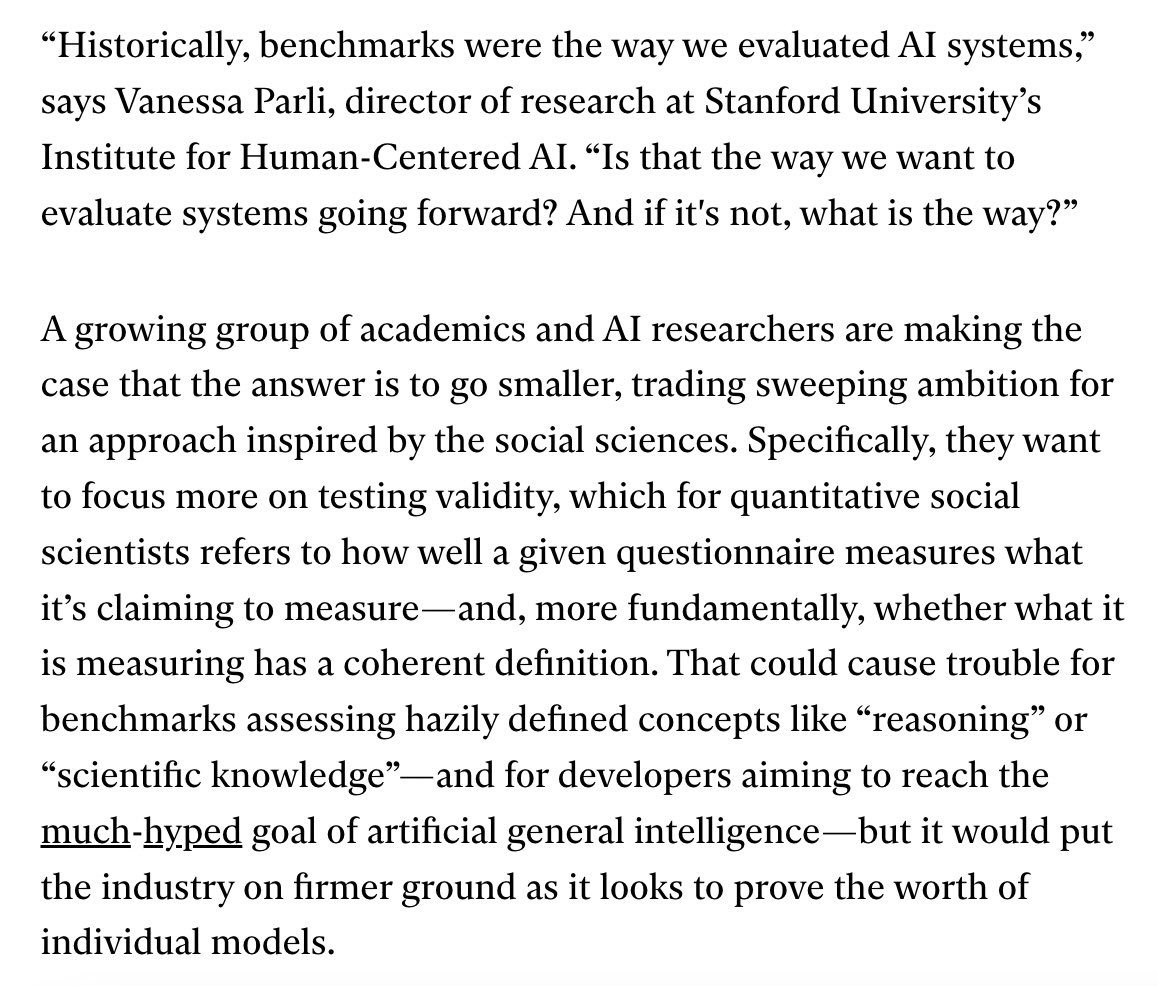

AIモデル評価が危機に直面、EvalEvalアライアンスが改善を呼びかけ: 現在のAIモデル評価方法に存在する、ベンチマークの飽和、科学的厳密性の欠如などの問題に対し、EvalEvalアライアンスが言及され、評価の現状に関心を持つ人々を結集し、評価報告の改善、飽和問題の解決、評価の科学性およびインフラストラクチャの向上などに共同で取り組むことを目指しています。関連する議論では、評価の有効性により注意を払うべきであると考えられています。(ソース: ClementDelangue)

Redditでの議論:LLMワークフロー構築の観察と経験: ある開発者がRedditで、過去1年間に複雑なLLMワークフローを構築した経験のまとめを共有しました。重要な点としては、タスクを最小ステップに分解し、プロンプトを連鎖的に呼び出す方が単一の複雑なプロンプトよりも優れていること、XMLタグを使用してプロンプト構造を構築する方が効果的であること、LLMにはその役割が意味解析と変換のみであり、自身の知識を導入すべきではないことを明確に伝える必要があること、NLTKなどの従来のNLPライブラリを使用してLLMの出力を検証すること、小規模なタスクではファインチューニングされたBERT系分類器がLLMよりも優れていることが多いこと、LLMを審判として、または信頼度スコアリングに使用することは信頼性が低く、特に明確なスコアリング基準がない場合はそうであること、AgenticループではLLMがループを終了する条件の設定が難点であること、パフォーマンスは通常、入力コンテキストウィンドウが4Kトークンを超えると低下すること、32Bモデルは構造化タスクでは十分であること、構造化CoTは非構造化CoTよりも優れていること、自作のCoTは推論モデルに依存するよりも優れていること、長期的な目標はすべてのコンポーネントをファインチューニングし、バランスの取れたファインチューニングデータセットの構築に注意することなどが挙げられています。(ソース: Reddit r/LocalLLaMA)

RedditユーザーがClaude Sonnet 3.7のシステムプロンプト設定について議論: Redditのr/ClaudeAIコミュニティのユーザーは、Claude Sonnet 3.7モデルが指示の遵守、コード修正、コンテキスト記憶において不安定性があると報告し、効果的なシステムプロンプトを募集しています。あるユーザーはSonnet 3.5の振る舞いを模倣したプロンプトや、効率的で実用的なソリューション、DRY、KISS、SRPなどのコアコンピュータサイエンス原則への準拠を強調する詳細な指示を共有しました。また、Claude自身にシステムプロンプトを書き直させて最適化することで効果を高める、あるいは簡潔で明確な一行の指示を使用することを提案するユーザーもいました。(ソース: Reddit r/ClaudeAI)

LLMのファインチューニングに必要なエポック数に関する議論: Redditのr/MachineLearningで、あるユーザーがDeepseek R1論文でDeepseek-V3-Baseモデル(約80万サンプル)をわずか2エポックでファインチューニングしたことについて疑問を呈し、損失関数以外に、ファインチューニングのエポック数を決定する指標として、評価データのパフォーマンスやデータ品質などを議論しました。(ソース: Reddit r/MachineLearning)

💡 その他

François Chollet氏:強固な思考モデルの構築は難問解決の前提: AI思想家のFrançois Chollet氏は、明確で自己矛盾のない思考モデルを構築することが、運に頼らず創造的に難問を解決するための前提条件であり、これは簡単な問題を迅速に解決する能力とは異なると強調しています。同氏は、優雅さとは表現力と簡潔さの組み合わせであり、圧縮と密接に関連していると考えています。(ソース: fchollet, teortaxesTex, fchollet, pmddomingos)

Replit CEO Amjad Masad氏:AIエージェントがプログラミングの新潮流となる: ReplitのCEO兼共同創設者であるAmjad Masad氏は、The Turing Postのインタビューで、AIエージェントがプログラミングの次の波をリードすると常に考えてきたと述べました。同氏は、プログラミングを教えることから、自動的にプログラミングできるエージェントを構築することへの考え方の転換を共有しました。同氏は、ソフトウェアエージェントが実際のビジネスで既に効果を上げており、例えば不動産企業がリード割り当てアルゴリズムを最適化し、コンバージョン率を10%向上させるのに役立っていると述べました。同氏は、将来の10億ドル規模のスタートアップはAIで強化された独立した創業者によって構築される可能性があり、このビジョンを実現するために必要な条件、プログラミング分野の現状と未来、Replitのビジョンの進化、そしてAGIとオープンソースの重要性について議論しました。(ソース: TheTuringPost, TheTuringPost)

LazyVim:「怠け者」のためのNeovim設定: LazyVimは、lazy.nvimに基づくNeovim設定ソリューションであり、ユーザーがNeovim環境を簡単にカスタマイズおよび拡張できるようにすることを目的としています。事前に設定された、機能豊富なIDEのような体験を提供しつつ、高度な柔軟性を維持しており、ユーザーは必要に応じて調整できます。(ソース: GitHub Trending)