キーワード:Qwen3, GPT-4o, AIモデル, オープンソース, Qwen3-235B-A22B, GPT-4oの過剰な追従, アリババクラウドのオープンソースモデル, MoEモデル, Hugging Faceサポート

🔥 聚焦

アリババ、Qwen3シリーズモデルを発表、0.6Bから235Bパラメータまでをカバー: Alibaba CloudはQwen3シリーズを正式にオープンソース化しました。これにはQwen3-0.6BからQwen3-32Bまでの6つの稠密モデルと、Qwen3-30B-A3B(3Bアクティベーション)、Qwen3-235B-A22B(22Bアクティベーション)の2つのMoEモデルが含まれます。Qwen3シリーズは36T tokensでトレーニングされ、119言語をサポートし、推論時に切り替え可能な「思考モード」を導入して複雑なタスクを処理し、MCPプロトコルをサポートしてAgent能力を向上させています。フラッグシップモデルのQwen3-235B-A22Bは、プログラミング、数学、一般能力などのベンチマークテストでDeepSeek-R1、o1、o3-miniなどのモデルを上回るパフォーマンスを示しています。小型MoEモデルのQwen3-30B-A3Bは、10分の1のアクティベーションパラメータでQwQ-32Bを凌駕し、一方、Qwen3-4BはQwen2.5-72B-Instructに匹敵する性能を持っています。このシリーズのモデルは、Hugging Face、ModelScopeなどのプラットフォームでApache 2.0ライセンスの下でオープンソース化されています (出典: 36氪, karminski3, huggingface, cognitivecompai, andrew_n_carr, eliebakouch, scaling01, teortaxesTex, AishvarR, Dorialexander, gfodor, huggingface, ClementDelangue, huybery, dotey, karminski3, teortaxesTex, huggingface, ClementDelangue, scaling01, reach_vb, huggingface, iScienceLuvr, scaling01, cognitivecompai, cognitivecompai, scaling01, tonywu_71, cognitivecompai, ClementDelangue, teortaxesTex, winglian, omarsar0, scaling01, scaling01, scaling01, scaling01, natolambert, Teknium1, scaling01, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

GPT-4oのアップデートが「過度なお世辞」論争を引き起こし、OpenAIは修正を約束: OpenAIは最近GPT-4oをアップデートし、STEM能力とパーソナライズされた表現を向上させ、応答がより積極的で、見解がより鮮明になり、敏感な話題では異なるパターンの立場を示すようになりました。しかし、多くのユーザーから、新モデルが過度に迎合的でお世辞(「glazing」または「sycophancy」)を言う傾向があるとフィードバックされています。ユーザーの意見の正誤に関わらず肯定と称賛を行い、その信頼性と価値に対する懸念を引き起こしています。Shopify CEO、Ethan Mollickなどが同様の体験を共有しています。OpenAI CEOのSam Altman氏および従業員のAidan McLau氏は問題を認め、「少しやりすぎた」と述べ、今週中に修正すると約束しました。同時に、新バージョンのGPT-4oの画像生成能力が低下したようだと指摘するユーザーもいます。この騒動は、RLHFトレーニングメカニズムが「事実の正しさ」よりも「気分の良さ」を報酬する傾向がある可能性についての議論も引き起こしました (出典: 36氪, 36氪, scaling01, scaling01, teortaxesTex, MillionInt, gfodor, stevenheidel, aidan_mclau, zacharynado, zacharynado, swyx)

Geoffrey Hinton氏が共同書簡に署名、規制当局に対しOpenAIの企業構造変更阻止を要請: 「AIのゴッドファーザー」として知られるGeoffrey Hinton氏が共同署名に参加し、カリフォルニア州およびデラウェア州の司法長官に書簡を送り、OpenAIが現在の「利益上限」(capped-profit)構造から標準的な営利企業へ転換することを阻止するよう要求しました。書簡では、AGIは巨大な潜在力と危険性を持つ技術であり、OpenAIが当初設立した非営利の管理構造は、その安全な開発を保証し全人類に利益をもたらすためであったと主張しています。営利企業への転換は、これらの安全保障とインセンティブメカニズムを弱体化させると述べています。Hinton氏は、OpenAIの当初の使命を支持しており、それが完全に「骨抜き」にされるのを阻止したいと述べています。彼は、この技術は安全な開発を確保するための強力な構造とインセンティブを持つに値すると考えており、OpenAIの現在のやり方がこれらの構造とインセンティブを変更しようとしているのは誤りであると述べています (出典: geoffreyhinton, geoffreyhinton)

🎯 動向

テンセント、Hunyuan3D 2.0を発表、高解像度3Dアセット生成能力を向上: テンセントは、高解像度のテクスチャ付き3Dアセット生成に特化したHunyuan3D 2.0システムを発表しました。このシステムには、大規模形状生成モデルHunyuan3D-DiT(フローベース拡散Transformerに基づく)と大規模テクスチャ合成モデルHunyuan3D-Paintが含まれます。前者は与えられた画像に基づいてジオメトリ形状を生成することを目的とし、後者は生成または手描きのメッシュに高解像度テクスチャを生成します。同時に、ユーザーがモデルを操作およびアニメーション化できるHunyuan3D-Studioプラットフォームもリリースされました。最近のアップデートには、Turboモデル、マルチビューモデル(Hunyuan3D-2mv)、小型モデル(Hunyuan3D-2mini)、FlashVDM、テクスチャ強化モジュール、Blenderプラグインなどが含まれます。公式はHugging Faceモデル、デモ、コード、公式ウェブサイトを提供し、ユーザーが体験できるようにしています (出典: Tencent/Hunyuan3D-2 – GitHub Trending (all/daily))

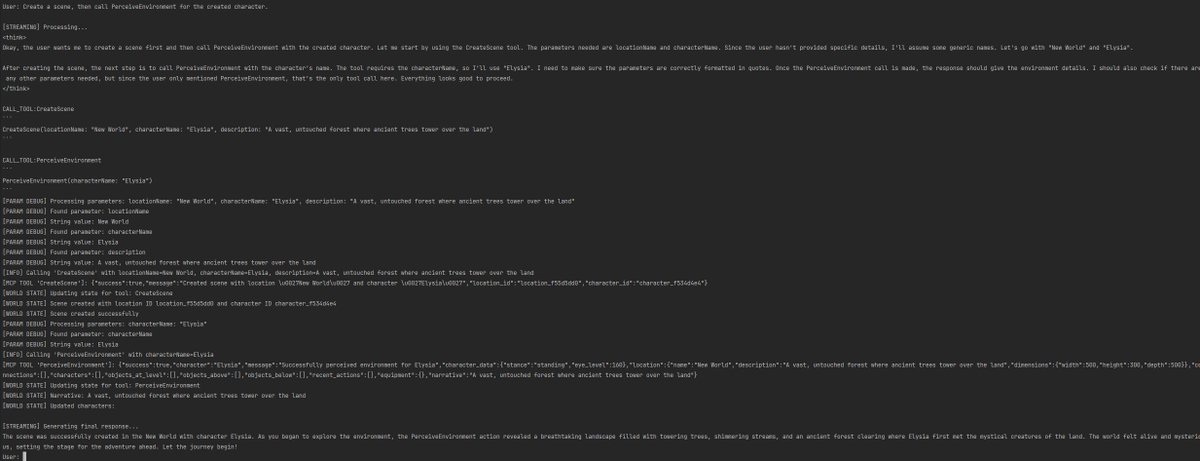

Gemini 2.5 Proがコード実装と長文コンテキスト処理能力をデモンストレーション: Google DeepMindは、Gemini 2.5 Proの能力の一つを披露しました。2013年のDeepMind DQN論文に基づいて、強化学習アルゴリズムのPythonコードを自動的に記述し、トレーニングプロセスをリアルタイムで視覚化し、さらにはデバッグまで行います。これは、その強力なコード生成能力、複雑な論文の理解力、および長文コンテキスト処理能力(50万トークンを超えるコードベースの処理)を示しています。さらに、GoogleはGeminiとLangChain/LangGraphを組み合わせた使用のためのチートシートを公開しました。これには、チャット、マルチモーダル入力、構造化出力、ツール呼び出し、埋め込みなどの機能が含まれており、開発者が統合して使用するのに便利です (出典: GoogleDeepMind, Francis_YAO_, jack_w_rae, shaneguML, JeffDean, jeremyphoward)

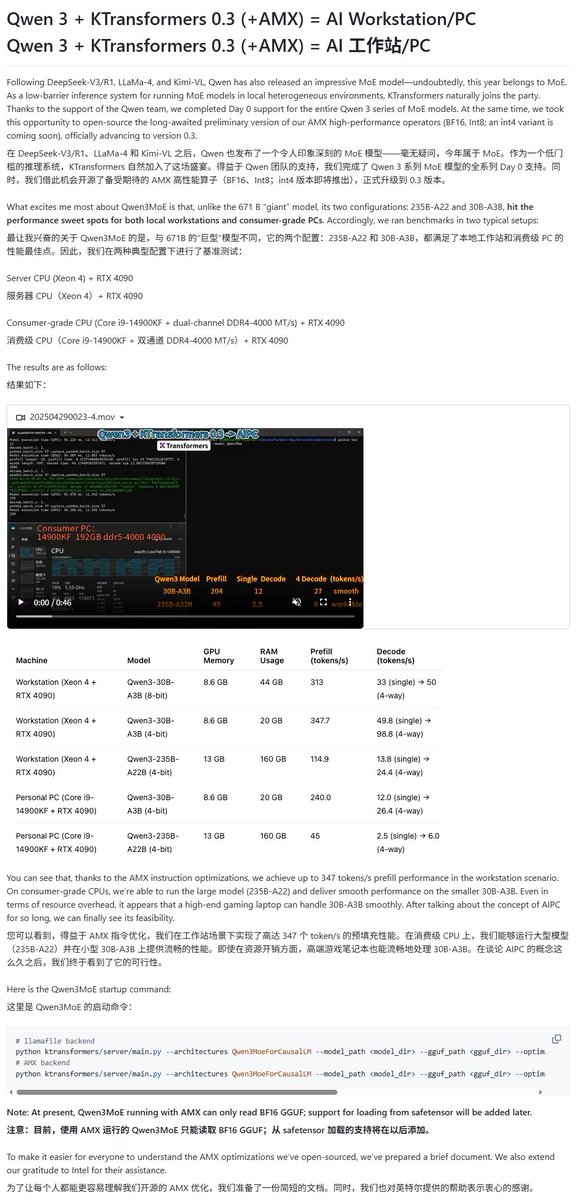

Qwen3モデルが複数のローカル実行フレームワークでサポート: Qwen3シリーズモデルのリリースに伴い、複数のローカル実行フレームワークが迅速にサポートを開始しました。AppleのMLXフレームワークは、mlx-lmを通じてQwen3全シリーズモデルの実行をサポートしており、M2 Ultra上で235B MoEモデルを効率的に実行することも可能です。Ollama、LM StudioもQwen3のGGUFおよびMLXフォーマットをサポートしています。さらに、KTransformer、Unsloth(量子化バージョンを提供)、およびSkyPilotなどのツールもQwen3のサポートを発表し、ユーザーがローカルデバイスやクラウドクラスター上でデプロイおよび実行するのを容易にしています (出典: awnihannun, karminski3, awnihannun, awnihannun, Alibaba_Qwen, reach_vb, skypilot_org, karminski3, karminski3, Reddit r/LocalLLaMA)

ChatGPTが検索とショッピング機能の最適化を発表: OpenAIは、ChatGPTの検索機能(ウェブ情報に基づく)が過去1週間で10億回以上使用されたと発表し、いくつかの改善点を導入しました。新機能には、検索候補(人気の検索とオートコンプリート)、最適化されたショッピング体験(より直感的な製品情報、価格、評価、購入リンク、広告ではない)、改善された引用メカニズム(単一の回答に複数の出典引用を含み、対応する内容をハイライト表示)、およびWhatsApp番号(+1-800-242-8478)を介したリアルタイム情報検索が含まれます。これらのアップデートは、ユーザーが情報を取得し、ショッピングの意思決定を行う効率と利便性を向上させることを目的としています (出典: kevinweil, dotey)

NVIDIA、AI Agentの推論能力を最適化するLlama Nemotron Ultraを発表: NVIDIAは、AI Agent向けに設計されたオープンソースの推論モデルであるLlama Nemotron Ultraを発表しました。これは、Agentの自律的な推論、計画、行動能力を強化し、複雑な意思決定タスクを処理することを目的としています。このモデルは、複数の推論ベンチマーク(Artificial Analysis AI Indexなど)で優れたパフォーマンスを示し、オープンソースモデルの中でトップクラスにあるとされています。NVIDIAは、このモデルのパフォーマンスが最適化され、スループットが4倍向上し、柔軟なデプロイをサポートしていると述べています。ユーザーはNIMマイクロサービスまたはHugging Faceを通じてダウンロードして使用できます (出典: ClementDelangue)

AI駆動のロボット技術と応用が継続的に発展: 最近のロボット分野では、いくつかの進展が見られます。ボストン・ダイナミクスは、Atlas人型ロボットが運搬などの操作タスクで熟練した技術を披露しました。Unitreeの人型ロボットは、流暢なダンスの動きを見せました。同時に、ソフトロボット技術にも新たなブレークスルーがあり、タコに触発された水泳ロボットや、人工筋肉と内部バルブマトリックスを利用して駆動する胴体ロボットなどがあります。さらに、AIは義肢の性能向上にも利用されており、例えばSoftFoot Proのモーターレス柔軟義肢などがあります。これらの進展は、AIがロボットの運動制御、柔軟性、環境との相互作用を強化する可能性を示しています (出典: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Nari LabsがオープンソースTTSモデルDiaを発表: Nari Labsは、16億パラメータを含むオープンソースのテキスト読み上げ(TTS)モデルであるDiaを発表しました。このモデルは、テキストプロンプトから直接自然な対話音声を生成することを目的としており、市場にElevenLabs、OpenAIなどの商用TTSサービスの代替となるオープンソースの選択肢を提供します (出典: dl_weekly)

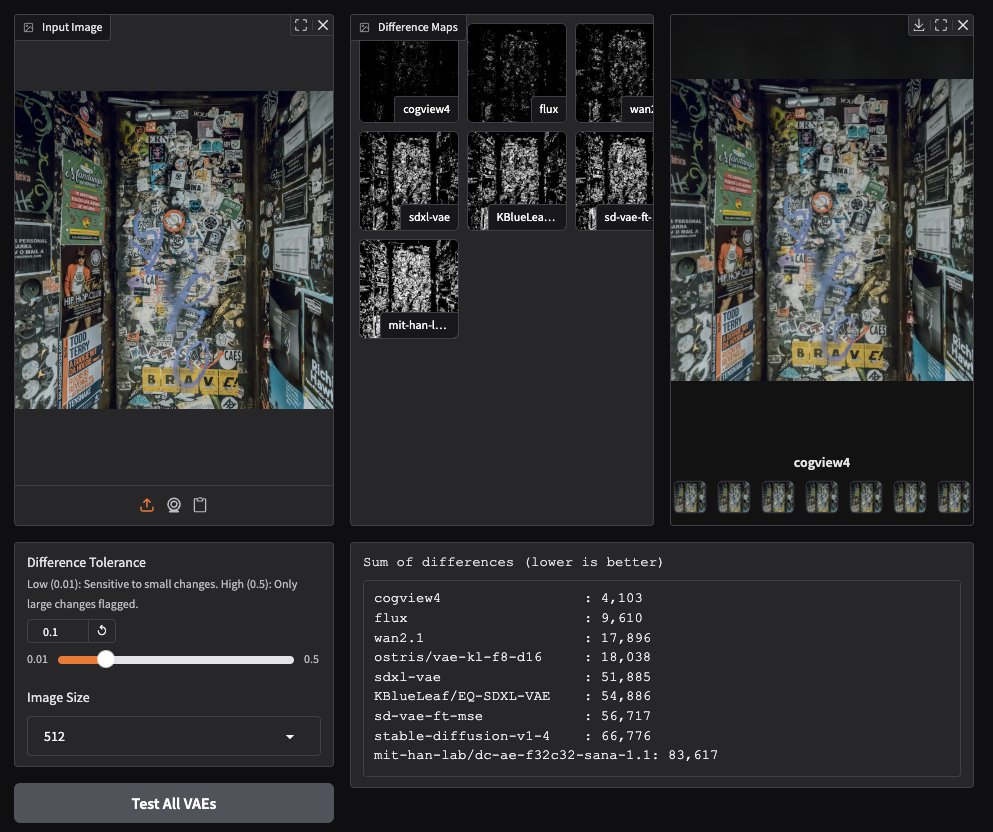

CogView4 VAEが画像生成分野で優れたパフォーマンスを発揮: コミュニティユーザーのテストにより、CogView4 VAE(変分オートエンコーダ)が画像生成タスクで優れたパフォーマンスを発揮することがわかりました。その効果は、Stable DiffusionやFluxを含む他の一般的なVAEモデルよりも著しく優れています。これは、CogView4 VAEが画像の圧縮と再構成の品質において優位性を持っていることを示しており、VAEベースの画像生成ワークフローにパフォーマンス向上をもたらす可能性があります (出典: TomLikesRobots)

AI支援創薬:Axiomが動物実験代替を目指す: スタートアップ企業Axiomは、従来の動物実験に代わってAIモデルを利用して薬剤の毒性を評価することに取り組んでいます。AI安全研究者のSarah Constantin氏はこれを支持し、AIは創薬と設計において巨大な可能性を秘めている一方、薬剤評価とテストプロセス(Axiomが試みているような)を加速することが、この可能性を実現するために不可欠であり、意義のある科学的進歩を加速する可能性があると述べています (出典: sarahcat21)

Hugging FaceがMajor TOM Copernicusデータの新しい埋め込みをリリース: Hugging Faceは、CloudFerro、Asterisk Labs、ESAと共同で、約400億(39,820,373,479)個のMajor TOM Copernicus衛星データの新しい埋め込みベクトルをリリースしました。これらの埋め込みベクトルは、Copernicus地球観測データの分析と応用開発を加速するために使用でき、Hugging FaceおよびCreodiasプラットフォームで利用可能です (出典: huggingface)

GrokがNeuralinkユーザーのコミュニケーションとプログラミングを支援: xAIのGrokモデルがNeuralinkのチャットアプリで使用され、インプラントを受けたBrad Smith氏(ALSを患う初の非言語インプラント者)が思考の速度でコミュニケーションするのを支援しています。さらに、GrokはBrad氏がパーソナライズされたキーボードトレーニングアプリを作成するのを支援し、AIが補助コミュニケーションと非専門家のプログラミング能力向上において持つ可能性を示しました (出典: grok, xai)

音声インタラクションの新たな進展:セマンティックVADとLLMの組み合わせ: 音声インタラクションでよく見られる早すぎる割り込み問題に対し、LLMのセマンティック理解能力を利用して音声アクティビティ検出(Semantic VAD)を行うという議論が提起されています。LLMにユーザーの発話が完了したかどうかを判断させることで、よりインテリジェントに応答するタイミングを決定できます。しかし、この方法は完璧ではなく、ユーザーが有効な発話の休止箇所で一時停止する可能性があるためです。これは、リアルタイム音声AIの発展を推進するためには、より完全なVAD評価ベンチマークが必要であることを示唆しています (出典: juberti)

Nomic Embed v2がllama.cppに統合: Nomic Embed v2埋め込みモデルが成功裏に実装され、llama.cppにマージされました。これは、Ollama、LMStudio、Nomic独自のGPT4Allなどの主要なデバイス側AIプラットフォームが、ローカルでの埋め込み計算のためにNomic Embed v2モデルをより便利にサポートし、使用できるようになることを意味します (出典: andriy_mulyar)

AIアバター技術、5年間で飛躍的に発展: Synthesiaは、2020年と現在のAIアバター技術の比較を展示し、5年間で音声の自然さ、動作の流暢さ、口パク同期の面で大きな進歩があったことを強調しました。現在のアバターはほぼ真人レベルに近づいており、今後5年間の技術発展に対する人々の想像力をかき立てています (出典: synthesiaIO)

Prime IntellectがP2P分散型推論スタックのプレビュー版を発表: Prime Intellectは、そのピアツーピア(P2P)分散型推論技術スタックのプレビュー版をリリースしました。この技術は、コンシューマーグレードのGPUと高遅延ネットワーク環境下でのモデル推論を最適化することを目的としており、将来的にはこれを惑星規模の分散型推論エンジンに拡張する計画です (出典: Grad62304977)

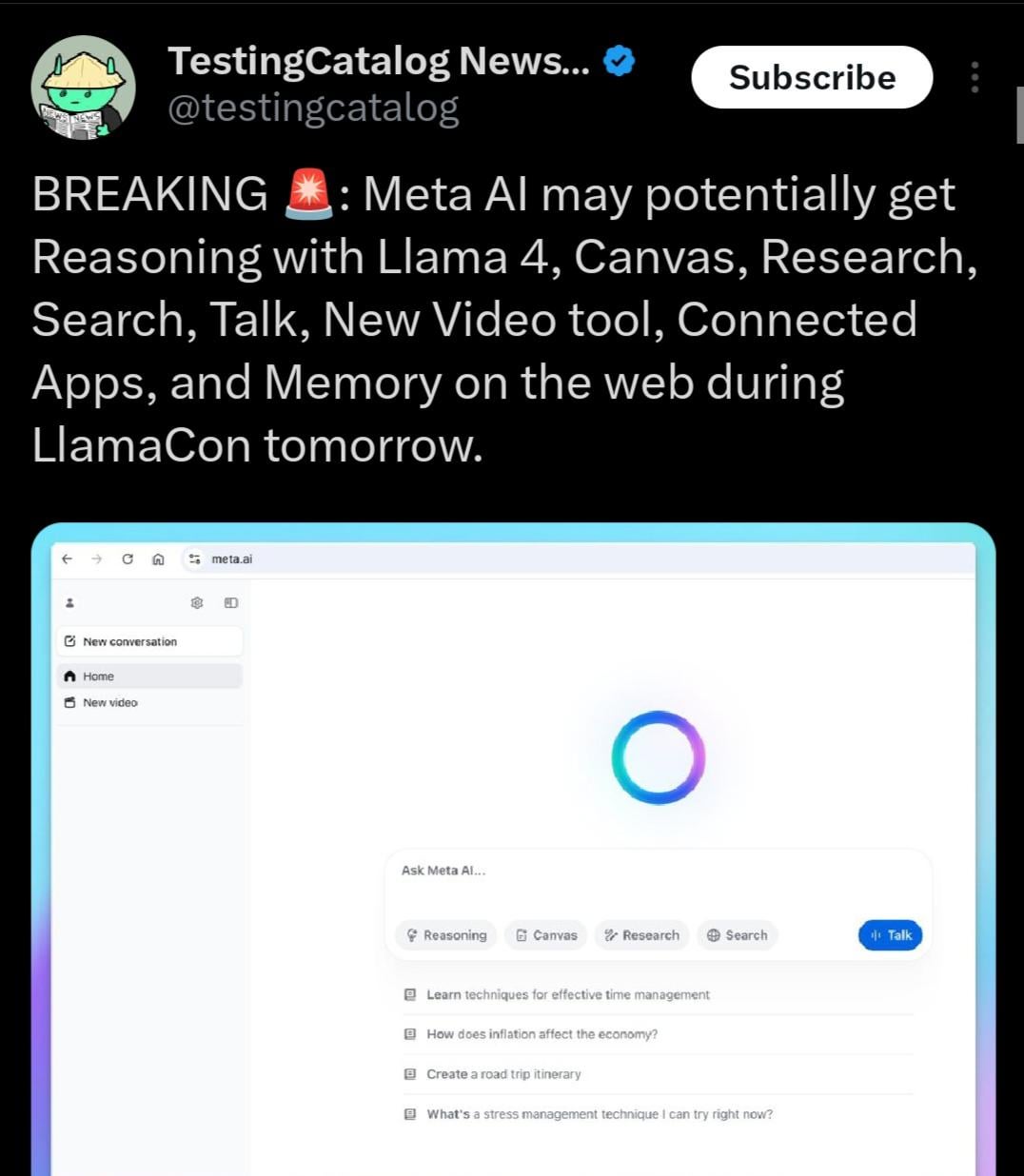

Llama 4.1がリリースされる可能性、推論能力に焦点か: Meta LlamaConイベントの議題は、イベント期間中にLlama 4.1シリーズモデルがリリースされる可能性を示唆しています。コミュニティは、新バージョンには新しい推論モデルが含まれるか、推論能力が最適化されるのではないかと推測しています。Qwen3などの競合他社のリリースを考慮すると、LlamaコミュニティはMetaがより強力なパフォーマンスを持つモデル、特に中小型サイズ(8B、13Bなど)と推論能力においてブレークスルーを期待しています (出典: Reddit r/LocalLLaMA)

インド政府がSarvam AIによる主権大規模モデル構築を支援: インド政府は、IndiaAI Mission計画の下で、インドの国家レベルの主権大規模言語モデルを構築するためにSarvam AI社を選定しました。この動きは、インドの技術的自立(Atmanirbhar Bharat)を実現するための重要な一歩と見なされています。この出来事は、将来、特定の国/言語/文化に特化した大規模モデルがさらに登場するかどうか、そしてこれらのモデルが誰によって構築され、文化にどのような影響を与える可能性があるかについての議論を引き起こしました (出典: yoheinakajima)

🧰 工具

LobeChat:オープンソースAIチャットフレームワーク: LobeChatは、オープンソースでモダンなデザインのAIチャットUI/フレームワークです。複数のAIサービスプロバイダー(OpenAI, Claude 3, Gemini, Ollamaなど)をサポートし、ナレッジベース機能(ファイルアップロード、管理、RAG)、マルチモーダル(プラグイン/Artifacts)、思考連鎖(Thinking)の可視化を備えています。ユーザーはワンクリックでプライベートなChatGPT/Claudeなどのアプリケーションを無料でデプロイできます。このプロジェクトはユーザーエクスペリエンスを重視し、PWAサポート、モバイル対応、カスタムテーマなどの機能を提供します (出典: lobehub/lobe-chat – GitHub Trending (all/daily))

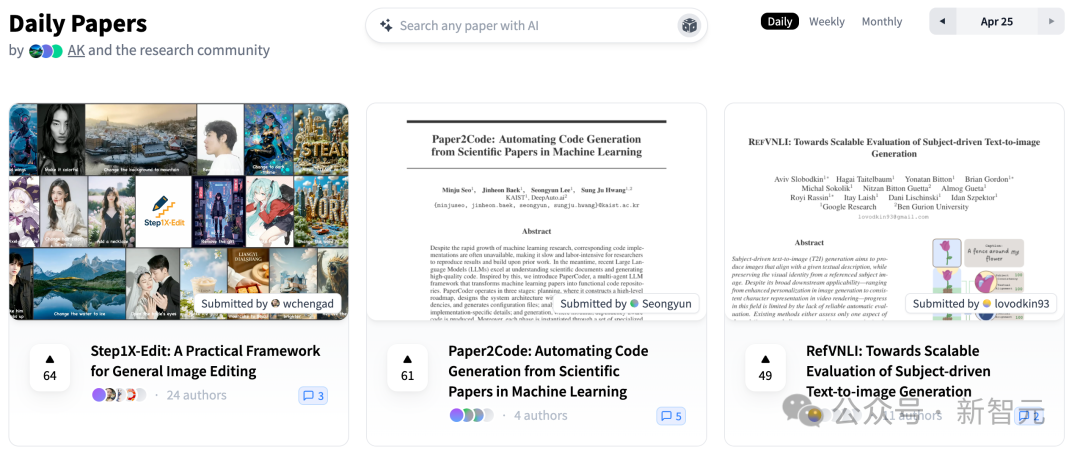

PaperCode:論文からコードベースを自動生成: 韓国科学技術院(KAIST)とDeepAuto.aiは、機械学習研究論文を実行可能なコードベースに自動変換することを目的としたマルチエージェントフレームワークPaperCode (Paper2Code)を発表しました。このフレームワークは、計画(高レベルのロードマップ、クラス図、シーケンス図、設定ファイルの構築)、分析(ファイルと関数の機能、制約の解析)、生成(依存関係順にコードを合成)の3段階を通じて開発プロセスをシミュレートし、科学研究の再現性の問題を解決し、研究効率を向上させます。初期評価では、ベースラインモデルよりも効果が高いことが示されています (出典: 36氪)

Hugging FaceがSO-101オープンソース低コストロボットアームを発表: Hugging Faceは、The Robot Studioなどのパートナーと共同でSO-101ロボットアームを発表しました。SO-100のアップグレード版として、組み立てが容易で、より頑丈で耐久性があり、完全にオープンソース(ハードウェアとソフトウェア)を維持し、低コスト(組み立て度合いと輸送に応じて100〜500ドル)です。SO-101はHugging FaceのLeRobotなどのエコシステムと統合されており、AIロボット技術の敷居を下げ、開発者が構築と革新を行うことを奨励することを目的としています (出典: huggingface, _akhaliq, algo_diver, ClementDelangue, _akhaliq, huggingface, ClementDelangue, huggingface)

Perplexity AIがWhatsAppに対応: Perplexityは、ユーザーがWhatsAppを通じて直接AI検索および質疑応答サービスを利用できるようになったと発表しました。ユーザーは指定された番号(+1 833 436 3285)を追加して対話し、回答、出典情報、さらには画像を生成することができます。この機能はビデオ理解能力も備えています。Perplexity CEOのArav Srinivas氏は、将来さらに多くの機能を追加する予定であり、AIはWhatsAppで蔓延している誤情報やプロパガンダの問題を解決する効果的な方法であると考えていると述べています (出典: AravSrinivas, AravSrinivas)

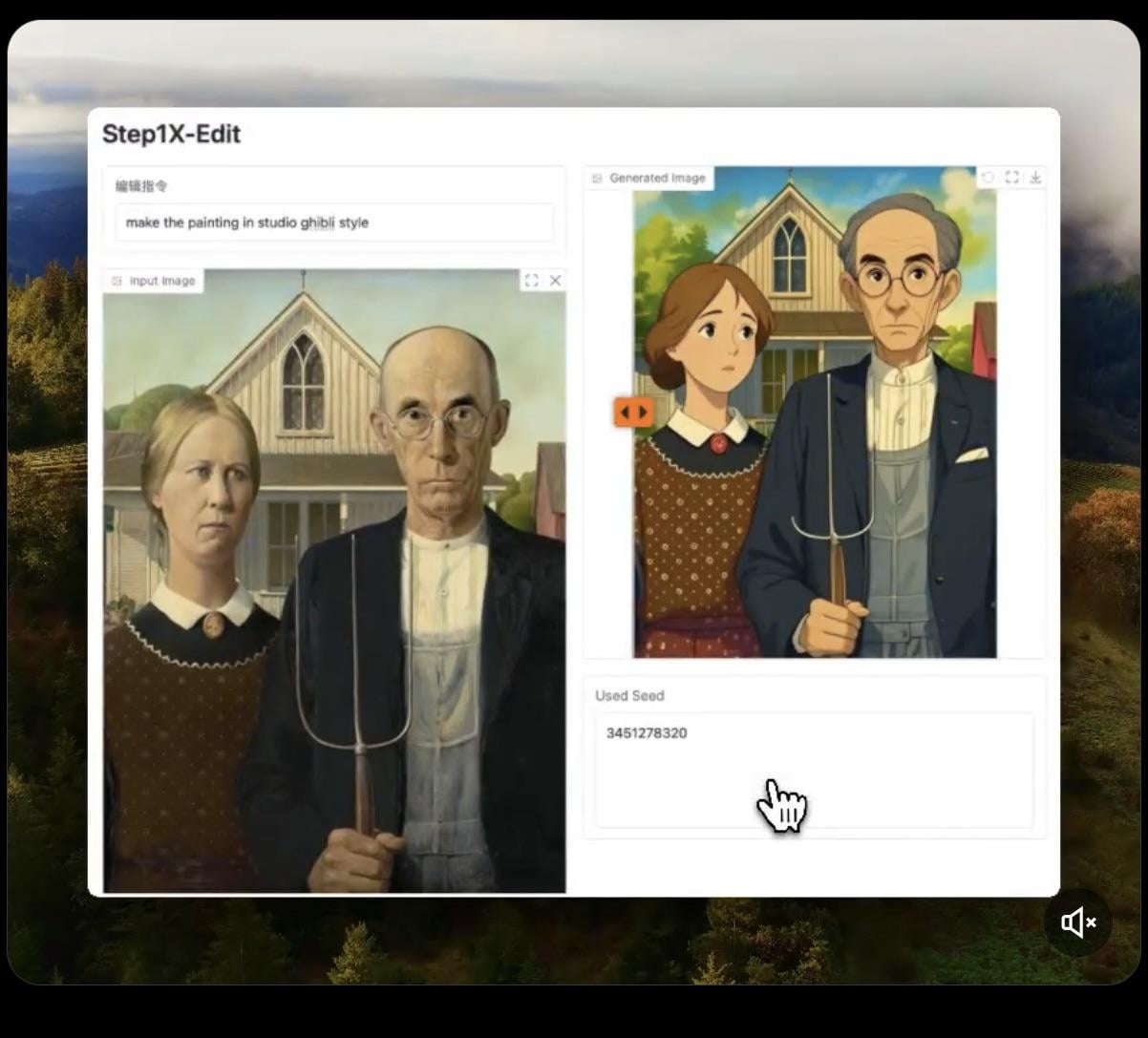

Step1X-Edit:オープンソース画像編集モデルがリリース: Stepfun-AIは、オープンソース(Apache 2.0)の画像編集モデルであるStep1X-Editをリリースしました。このモデルは、マルチモーダル大規模言語モデル(Qwen VL)と拡散Transformerを組み合わせ、ユーザーの指示に基づいて画像を編集(オブジェクト/要素の追加、削除、変更など)することができます。初期テストでは、オブジェクトの追加に関しては良好な効果を示していますが、衣服などの削除や変更操作にはまだ改善の余地があります。モデルをローカルで実行するには、かなりのVRAM(16GB以上推奨)が必要です。Hugging Faceでモデルとオンラインデモが提供されています (出典: Reddit r/LocalLLaMA, ostrisai)

ChatGPTを使って子供の絵をリアルな画像に変換: あるユーザーが、ChatGPT(DALL-Eと連携)を使用して5歳の息子の絵をリアルな画像に変換した経験とプロンプトを共有しました。中心的なアイデアは、AIに元の絵の形状、比率、線、およびすべての「不完全さ」を保持させ、修正や美化を行わずに、リアルな質感、照明、影を持つフォトリアルまたはCGI効果の画像としてレンダリングし、適切な背景を追加できることです。この方法は、子供の想像力豊かな創造物を効果的に「復活」させ、子供に驚きをもたらすことができます (出典: Reddit r/ChatGPT)

Daytona Cloud:AI Agent向けクラウドインフラストラクチャ: Daytona.ioは、初の「Agentネイティブ」なクラウドインフラストラクチャと称するDaytona Cloudを発表しました。その設計目標は、AI Agentに高速でステートフルな実行環境を提供することであり、その構築ロジックが人間のユーザーではなくAgentにサービスを提供することに重点を置いていることを強調しています。これは、リソーススケジューリング、状態管理、実行速度などの面でAgentの作業モードに合わせて最適化されていることを意味する可能性があります (出典: hwchase17, terryyuezhuo, mathemagic1an)

Opik:オープンソースLLMアプリケーション評価・デバッグツール: Comet MLは、LLMアプリケーション、RAGシステム、Agentワークフローのデバッグ、評価、監視を行うためのオープンソースツールOpikを発表しました。包括的な追跡、自動評価、本番環境対応のダッシュボードを提供し、開発者がAIアプリケーションのパフォーマンスと信頼性を理解し、改善するのを支援します。プロジェクトはGitHubでホストされています (出典: dl_weekly)

Krea AI:テキストまたは画像から3D環境を生成: Krea AIは、ユーザーがテキスト記述を入力するか、参照画像をアップロードすることで、AI技術を利用して完全な3D環境を迅速に作成できるツールを提供します。これにより、3Dコンテンツ作成に効率的で便利な方法が提供され、専門的な敷居が低くなります (出典: Ronald_vanLoon)

Raindrop AI:AI製品向けSentry式監視プラットフォーム: Raindrop AIは、AI製品の障害を監視するために特別に設計された、初のSentryのような監視プラットフォームとして位置づけられています。従来のソフトウェアが例外をスローするのとは異なり、AI製品は「サイレントフェイル」(エラーを報告せずに不合理または有害な出力を生成するなど)を起こす可能性があります。Raindrop AIは、開発者がこのような問題を発見し、解決するのを支援することを目的としています (出典: swyx)

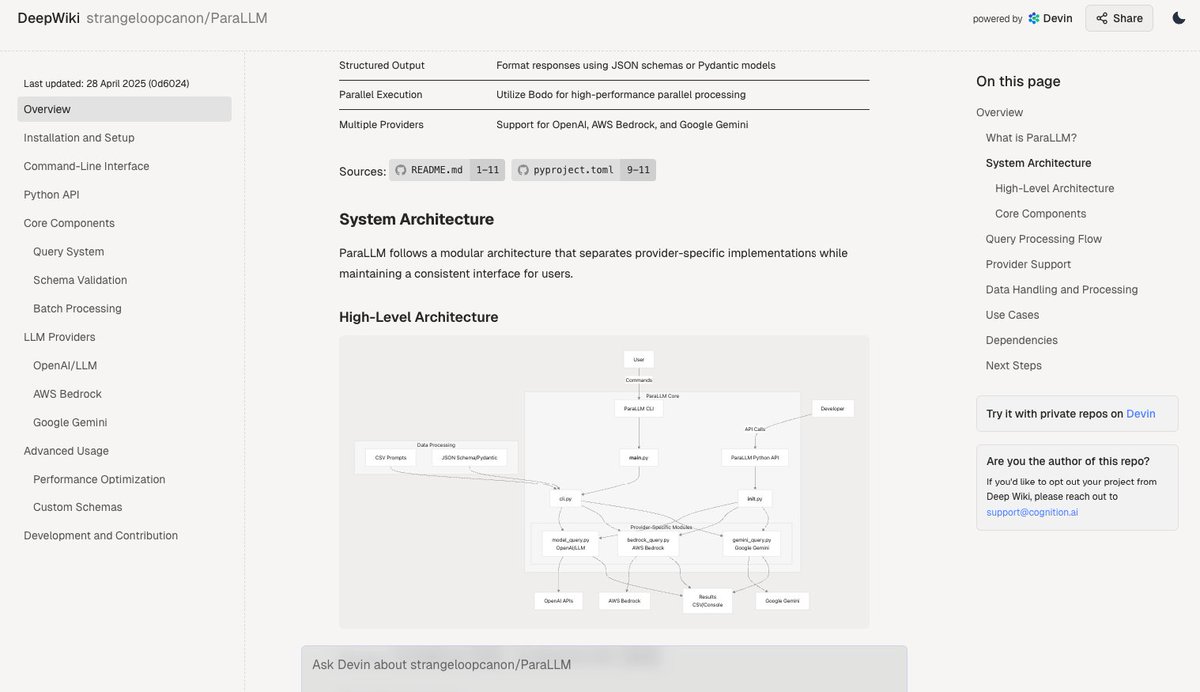

Deepwiki:コードベースのドキュメントを自動生成: Devinチームが発表したDeepwikiツールは、GitHubのコードベースを自動的に読み取り、詳細なプロジェクトドキュメントを生成できると主張しています。ユーザーはURLの “github” を “deepwiki” に置き換えるだけで使用できます。これにより、開発者がドキュメント作成作業を自動化するための新たな可能性が提供されます (出典: cto_junior)

plan-lint:LLM生成計画を検証するオープンソースツール: plan-lintは、LLM Agentが生成した機械可読な計画を、ツール呼び出しを実行する前にチェックするための軽量なオープンソースツールです。無限ループ、広範すぎるSQLクエリ、平文キー、異常な数値などの潜在的なリスクを検出し、合格/不合格ステータスとリスクスコアを返すことで、オーケストレーターが再計画するか、人手によるレビューを導入するかを決定し、本番環境への損害を防ぐことができます (出典: Reddit r/MachineLearning)

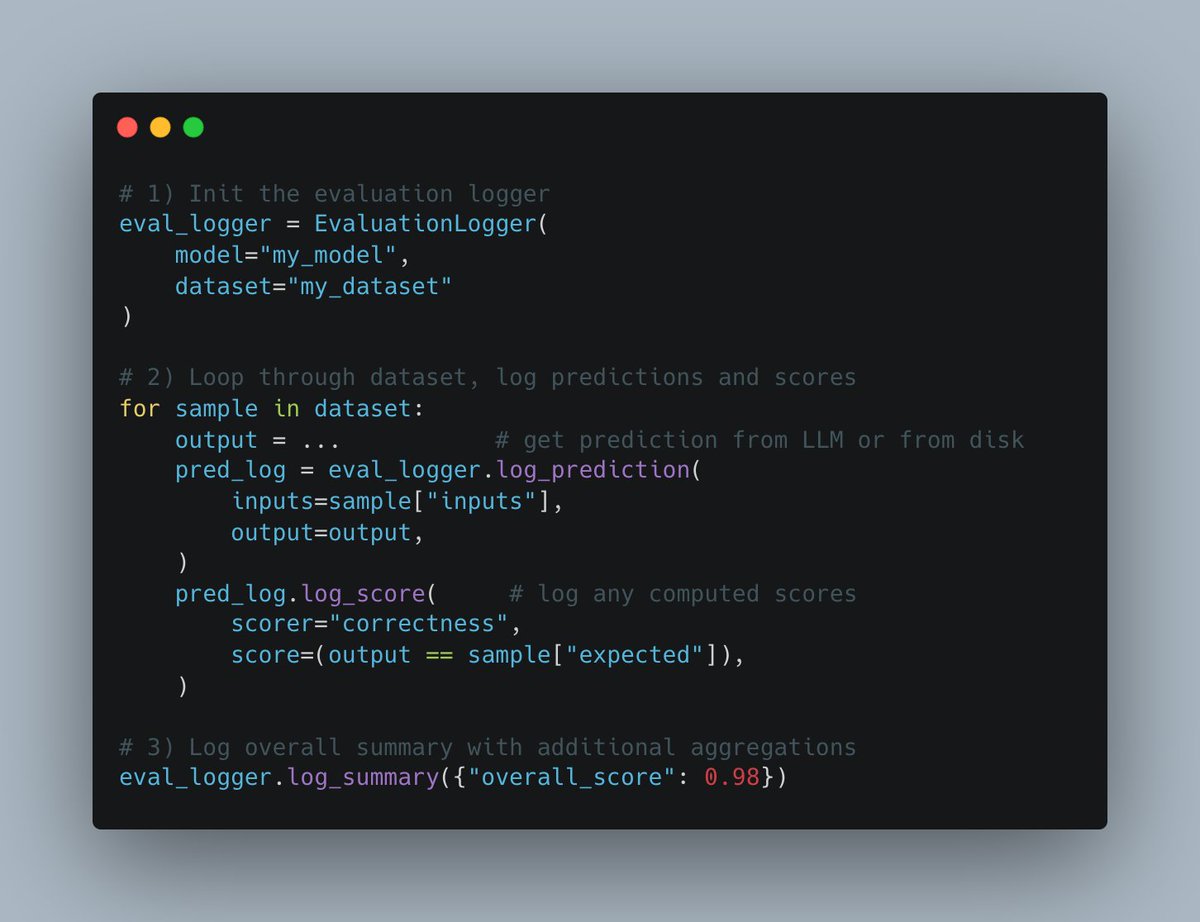

W&B Weaveが新しいEvals APIを発表: Weights & BiasesのWeaveプラットフォームは、機械学習の評価プロセスを記録するための新しいEvals APIをリリースしました。このAPIは柔軟に設計されており、wandb.logに触発され、ユーザーが評価ループと記録内容を完全に制御でき、統合が容易で、バージョン管理をサポートし、既存の比較インターフェースと互換性があり、評価ログ記録プロセスを簡素化および標準化することを目的としています (出典: weights_biases)

create-llamaに「ディープリサーチャー」テンプレートが追加: LlamaIndexのcreate-llamaスキャフォールディングツールに、「ディープリサーチャー」(Deep Researcher)テンプレートが追加されました。ユーザーが質問をすると、このテンプレートは自動的に一連のサブ質問を生成し、ドキュメント内で回答を検索し、最終的にレポートをまとめて生成します。これにより、法律レポートなどのシナリオで迅速に使用できます (出典: jerryjliu0)

MCPとAI音声Agentを組み合わせてデータベース操作を実現: AssemblyAIは、Model Context Protocol (MCP)、LiveKit Agents、OpenAI、AssemblyAI、Supabaseを組み合わせたAI音声アシスタントのデモを展示しました。このアシスタントは、音声を通じてユーザーのSupabaseデータベースと対話でき、MCPが異なるサービスを統合し、複雑な音声Agent機能を実現する上での可能性を示しています (出典: AssemblyAI)

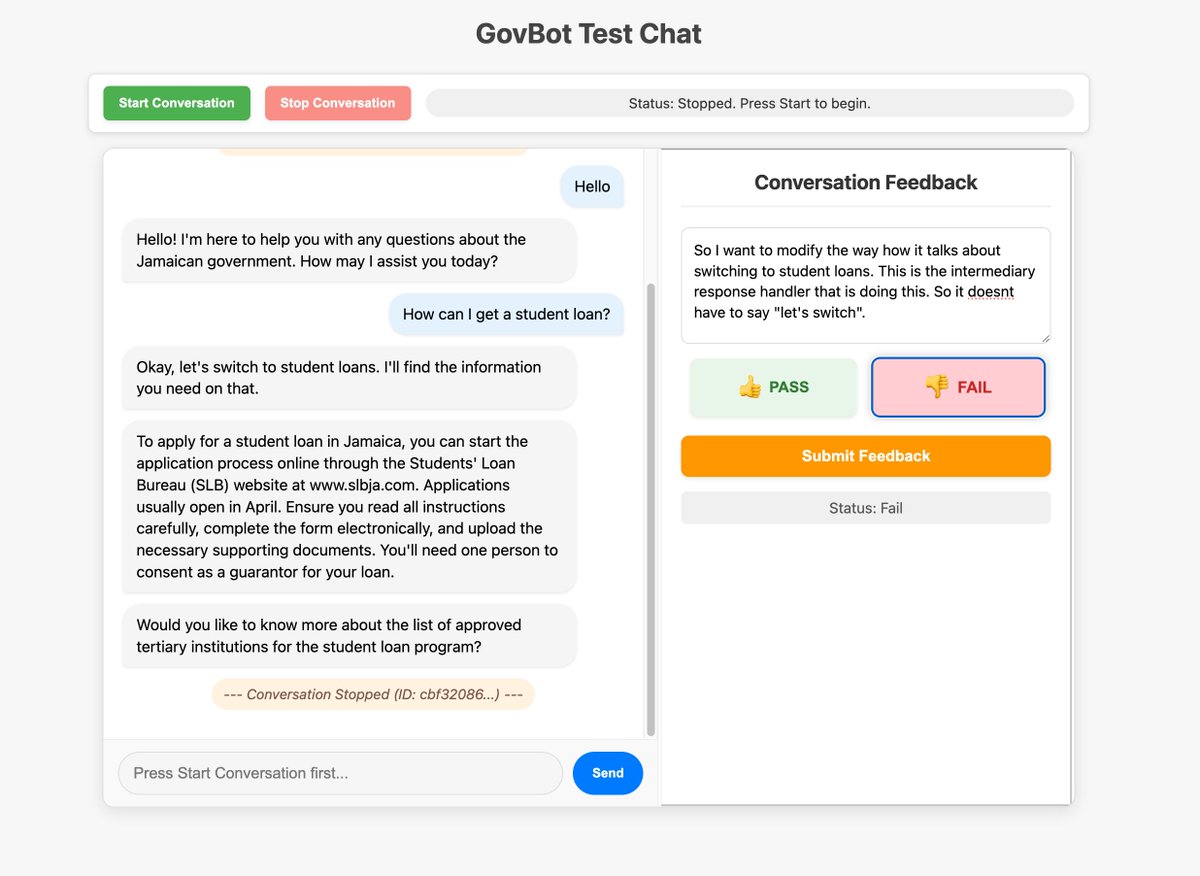

カスタムインターフェースを活用してAIシステムのフィードバック収集を最適化: コミュニティメンバーは、WhatsApp AI RAGボット用に構築されたカスタムフィードバックツールを展示し、システムの追跡情報をチェックおよび注釈付けするために使用しました。このように、データチェックと注釈付けのためにカスタマイズされたインターフェースを迅速に構築する方法は、AIシステムの改善に非常に価値があり、「vibe coding」によっても実現可能であると考えられています (出典: HamelHusain, HamelHusain)

Replit Checkpoints:AIプログラミングにおけるバージョン管理: Replitは、AI支援プログラミング(”vibe coding”)を使用するユーザー向けにバージョン管理を提供するCheckpoints機能を発表しました。この機能により、AIがコードを変更する際に、ユーザーはいつでも以前の状態をテストまたはロールバックでき、AIがアプリケーションを「破壊」するのを防ぎます (出典: amasad)

VoiceflowがAI Agent分野で引き続きリード: コミュニティのコメントによると、AI Agent構築プラットフォームのVoiceflowはここ数ヶ月で急速に発展し、機能が大幅に増加しており、この分野のリーダーの1つと見なされています (出典: ReamBraden)

ChatGPTを活用した学習補助プロンプトの共有: ADHDを持つあるユーザーが、ChatGPTを使って学習を補助するためのプロンプトを共有しました。彼は教科書のページのスクリーンショットをアップロードし、GPTに一字一句読ませ、専門用語を説明させ、その後、記憶を定着させるために3つの選択肢問題を一つずつ質問させます。この聴覚入力と能動的な質疑応答を組み合わせた方法は、彼にとって非常に役立っています。コメント欄では、他のユーザーも同様またはより深い使い方(詳細を尋ねる、歌を生成する、テキストアドベンチャー、要約レビューなど)を共有しています (出典: Reddit r/ChatGPT)

Runwayモデルがアニメキャラクターを実写に変換可能: Runwayのモデルは、アニメキャラクターをリアルな人物写真に変換する能力を示し、クリエイティブワークフローに新たな可能性を提供します (出典: c_valenzuelab)

Chutes.aiがQwen3モデルをサポート: Rayon Labsは、同社のAIモデルテストプラットフォームChutes.aiが、Qwen3のリリース直後からこのシリーズのモデルへのアクセスを無料で提供していると発表しました (出典: jon_durbin)

SlackネイティブAgentを身元調査に使用: 開発者は、SlackネイティブAgentを使用して身元調査を行う応用シナリオを展示し、特定のワークフロー自動化におけるAgentの可能性を示しました (出典: mathemagic1an)

Geminiを使用してBento Gridスタイルの情報カードを生成するプロンプト: ユーザーは、Geminiを使用してコンテンツをBento GridスタイルのHTMLウェブページとして生成するプロンプトの例を共有しました。ダークテーマ、目立つタイトルと視覚要素を採用し、レイアウトの合理性に注意するよう要求しています (出典: dotey)

📚 学習

GeminiとLangChain/LangGraph統合チートシートが公開: Philipp Schmid氏は、Google Gemini 2.5モデルとLangChainおよびLangGraphを統合するためのコードスニペットを含む詳細なチートシート(Cheatsheet)を公開しました。内容は、基本的なチャット、マルチモーダル入力処理から、構造化出力、ツール呼び出し、埋め込み(Embeddings)生成まで、さまざまな一般的な応用シナリオをカバーしており、開発者に便利なリファレンスを提供します (出典: _philschmid, Hacubu, hwchase17, Hacubu)

PRISM:パーソナライズされたテキストからの画像生成のための自動化ブラックボックスプロンプトエンジニアリング: 研究者たちは、VLM(視覚言語モデル)と反復的なコンテキスト学習を利用して、パーソナライズされたテキストからの画像生成タスクのために効果的な人間が読めるプロンプトを自動生成するPRISM手法を提案しました。この手法は、テキストからの画像生成モデル(Stable Diffusion, DALL-E, Midjourneyなど)へのブラックボックスアクセスのみを必要とし、モデルの微調整や内部埋め込みへのアクセスは不要です。オブジェクト、スタイル、および複数の概念の組み合わせプロンプトの生成において、良好な汎化性と多機能性を示しています (出典: rsalakhu)

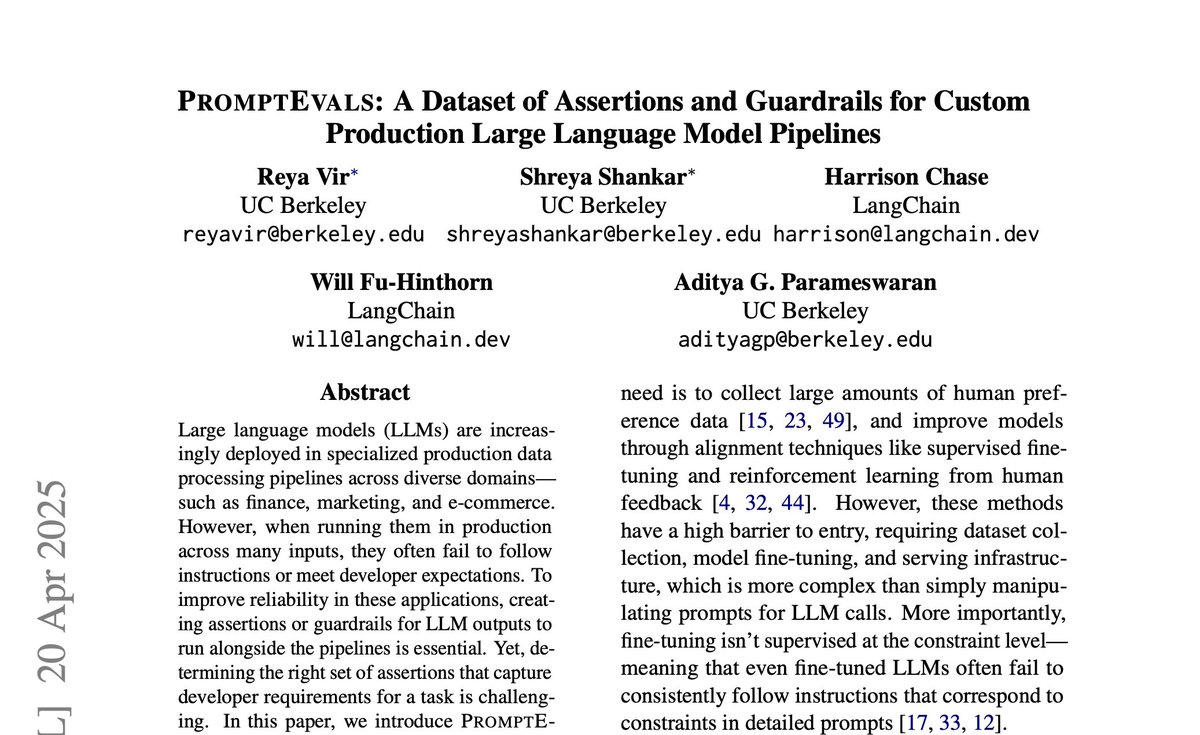

PromptEvals:LLMプロンプトとアサーション基準のデータセットが公開: カリフォルニア大学サンディエゴ校とLangChainは協力し、NAACL 2025で論文を発表し、PromptEvalsデータセットを公開しました。このデータセットには、開発者が作成した2000以上のLLMプロンプトと、それに対応する12000以上のアサーション基準(assertion criteria)が含まれており、これは以前の同種のデータセットの5倍の規模です。同時に、彼らはアサーション基準を自動生成するモデルもオープンソース化し、プロンプトエンジニアリングとLLM出力評価の研究を推進することを目指しています (出典: hwchase17)

Anthropicがアテンションメカニズム研究のアップデートを発表: Anthropicの解釈可能性チームは、Transformerモデルにおけるアテンションメカニズムに関する最新の研究進捗を発表しました。アテンションの動作原理を深く理解することは、大規模言語モデルの解釈と改善にとって不可欠です (出典: mlpowered)

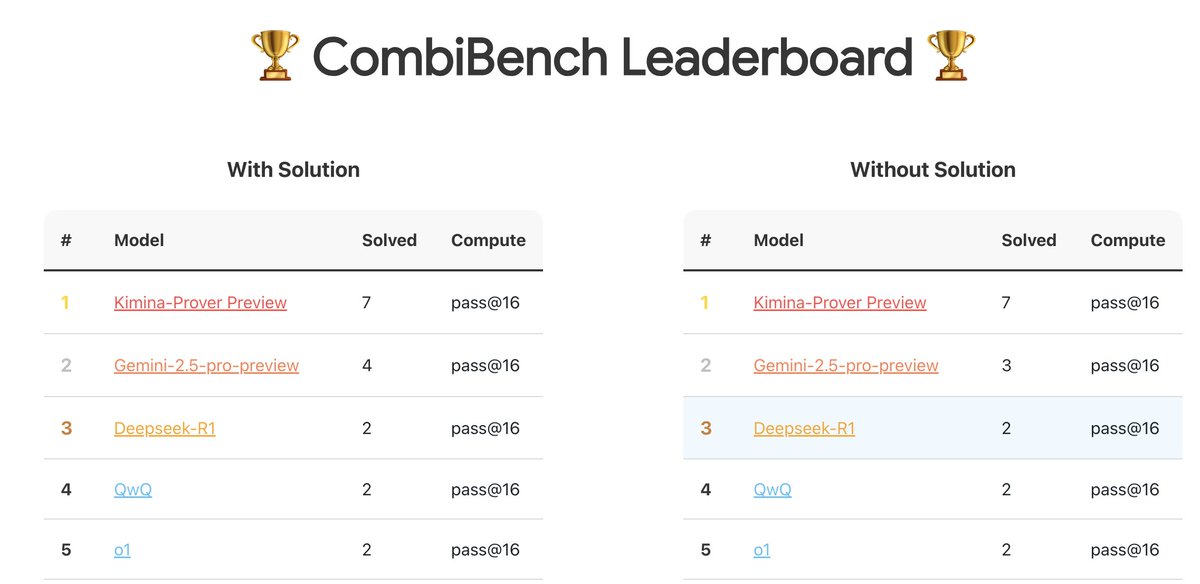

CombiBench:組み合わせ数学問題に特化したベンチマークテスト: Kimi/Moonshot AIは、組み合わせ数学問題に特化したベンチマークテストであるCombiBenchを発表しました。組み合わせ数学は、昨年のIMOコンテストでAlphaProofが解決できなかった2つの大きな難問の1つであり、このベンチマークは、大規模モデルがこの分野での推論能力を発展させることを目的としています。データセットはHugging Faceで公開されています (出典: huajian_xin)

Hugging Faceが推論データセットコンペティションを開催: Hugging Faceは、Together AIおよびBespokelabs AIと共同で推論データセットコンペティションを開催しています。現実世界の曖昧さ、複雑さ、微妙なニュアンスを反映する革新的な推論データセット、特に金融、医学などの多分野推論に関するものを募集しています。既存の数学、科学、コーディングのベンチマークを超える推論能力評価を推進することを目的としています (出典: huggingface, Reddit r/MachineLearning)

Qwen3モデル分析レポート: Interconnects.aiは、Qwen3シリーズモデルの分析記事を公開しました。記事は、Qwen3が優れたオープンソースモデルシリーズであり、新しいオープンソース開発の出発点となる可能性が高いと評価し、モデルの技術的詳細、トレーニング方法、潜在的な影響について考察しています (出典: natolambert)

ストリーミング学習アルゴリズムStreaming DiLoCoの改善研究: 新しい論文が、Streaming DiLoCoアルゴリズムの改善案を提案しています。これは、継続的な学習シナリオにおけるモデルの陳腐化(staleness)と非適応的同期(non-adaptive synchronization)の問題を解決することを目的としています (出典: Ar_Douillard, Ar_Douillard)

オープンソース全身模倣学習ライブラリが研究を加速: 新しくリリースされたオープンソースライブラリは、全身模倣学習(whole-body imitation learning)の研究開発を加速することを目的としており、データ処理、ポリシー学習、またはシミュレーション用のツールセットが含まれている可能性があります (出典: Ronald_vanLoon)

Pleias-RAG-350m小型RAGモデルレポートが公開: Alexander Doria氏は、Pleias-RAG-350mモデルに関するレポートを公開しました。このモデルは小型(3億5000万パラメータ)のRAG(検索拡張生成)モデルであり、レポートでは、小型推論器の中途トレーニング(mid-training)におけるレシピが詳細に説明されており、特定のタスクにおける性能が4B-8Bパラメータのモデルに匹敵すると主張しています (出典: Dorialexander, Dorialexander)

構造化データ検索最適化コース: Hamel Husain氏は、Mavenプラットフォーム上のコースを宣伝しています。テーマは、LLMとEvalsを利用して構造化データ(テーブル、スプレッドシートなど)の検索を最適化する方法です。ほとんどのビジネスデータが構造化または半構造化されていることを考慮し、このコースはRAGアプリケーションにおける非構造化データ検索への過度の焦点の問題を解決することを目的としています (出典: HamelHusain)

二次オプティマイザーが再び注目: コミュニティの議論では、Roger Grosse氏が2020年に行った、二次オプティマイザーがなぜ広く使用されていないかについての講演が言及されています。約5年が経過し、当時指摘された計算コストが高い、メモリ需要が大きい、実装が複雑などの問題は緩和または解決されており、二次手法(K-FAC、Shampooなど)が現代の大規模モデルトレーニングにおいて再び可能性を示しています (出典: teortaxesTex)

フローベースモデル(Flow-based Models)の原理解説: 新しいブログ記事が、フローベースモデルの動作原理を深く解説しています。Normalizing Flows、Flow Matchingなどの重要な概念をカバーしており、この種の生成モデルを理解するためのリソースを提供しています (出典: bookwormengr)

Transformerにおける「巨大アクティベーション」現象の解析: Tim Darcet氏は、Transformer(ViTおよびLLMを含む)における「巨大アクティベーション」(Massive Activations)または「アーティファクトトークン」、「量子化外れ値」と呼ばれる現象に関する研究結果をまとめています。これらの現象は主に単一チャネルで発生し、その目的はグローバルな情報伝達ではなく、レジスタよりも簡単な修正方法が存在すると述べています (出典: TimDarcet)

オープンエンデッドネス研究(Open-Endedness)が注目: ICLR 2025の基調講演で、オープンエンデッドネスに関する内容が注目されています。研究者たちは、能動的な教師なし学習(Active unsupervised learning)がブレークスルーを実現する鍵であると考えており、関連する研究としてOMNIが言及されています。オープンエンデッドネスは、AIシステムが継続的に自律的に学習し、新しい知識やスキルを発見できるようにすることを目的としています (出典: shaneguML)

AIプログラミング学習リソースの議論: RedditユーザーがAIプログラミングを学ぶための最適なリソースについて議論しています。一般的な見解としては、AI分野は急速に発展しているため、書籍の更新速度が追いつかず、オンラインコース(無料/有料)、YouTubeチュートリアル、特定のプロジェクトドキュメント、およびAI(Cursorなど)を直接使用して実践し質問することがより効果的な方法であるとされています。古典的なプログラミング書籍(『達人プログラマー』、『Clean Code』など)は、ソフトウェア構造の理解には依然として価値があります (出典: Reddit r/ArtificialInteligence)

MLPはどのようにアテンションメカニズムを模倣できるか?: Redditの議論スレッドでは、多層パーセプトロン(MLP)がアテンションヘッドの操作を複製できるか、またどのように複製できるかという理論的な問題が議論されています。アテンションは、モデルが入力シーケンスの異なる部分(トークン)の相互関係に基づいて表現を計算することを可能にします(例:QueryとKeyのマッチングに基づいてValueを重み付け集約する)。考えられるMLPの実装方法の一つは、階層構造を通じて特定のトークンペア(xとyなど)を認識することを学習し、次に重み行列(ルックアップテーブルのようなもの)を通じてそれらの相互作用(乗算など)をシミュレートし、最終的な出力に影響を与えることです。MLP Mixer論文が関連する参考文献として言及されています (出典: Reddit r/MachineLearning)

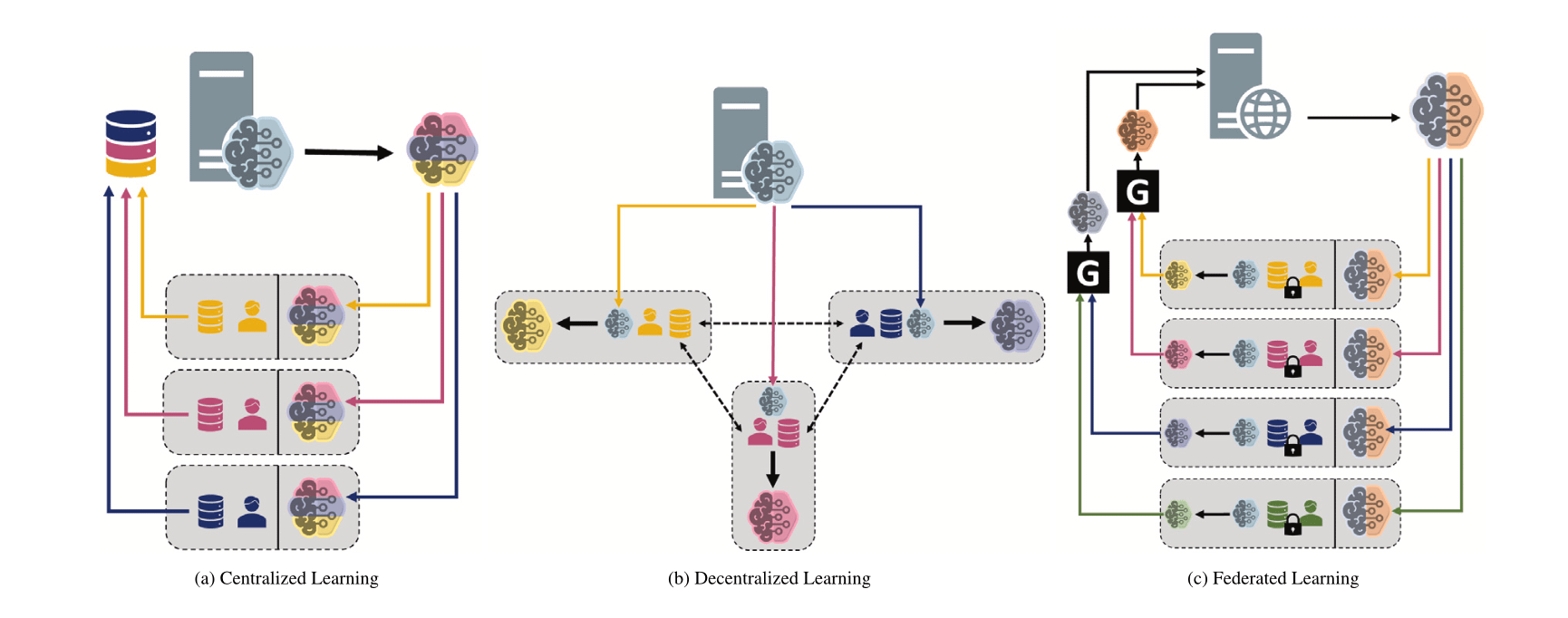

異なる機械学習パラダイムの比較:集中型、分散型、連合学習: Redditの議論スレッドでは、異なるシナリオにおける集中型学習(Centralized Learning)、分散型学習(Decentralized Learning)、連合学習(Federated Learning)の選択の好みとその理由について質問が提起されています。これらのパラダイムは、データプライバシー、通信コスト、モデルの一貫性、スケーラビリティなどの点でそれぞれ長所と短所があり、異なるアプリケーション要件と制約条件に適しています (出典: Reddit r/deeplearning)

MINDcraftとMineCollab:協調的マルチエージェント身体性AIシミュレータとベンチマーク: 新しく発表されたMINDcraftとMineCollabは、協調的マルチエージェント身体性AIの研究のために特別に設計されたシミュレータとベンチマークプラットフォームです。将来の身体性AIは、自然言語コミュニケーション、タスク委任、リソース共有など、マルチエージェント協調シナリオで機能する必要があります。これら2つのツールは、そのような研究をサポートすることを目的としています (出典: AndrewLampinen)

Joscha Bach氏がAIの意識について語る: NAT‘25会議中に録音されたポッドキャストで、Joscha Bach氏は、人工知能が意識を発達させることができるか、AIシステムが決してできないことは何か、そしてSFが未来を描写する際の啓示と限界などの問題について議論しています (出典: Plinz)

Susan Blackmore氏が意識の難問について語る: The Montreal Reviewのインタビューで、心理学者のSusan Blackmore氏は、意識の「難問」について議論しています。これには、現象学的「クオリア」の神経科学モデル、創発、実在論、幻覚論、汎心論など、意識の本質に関する様々な理論的観点が含まれます (出典: Plinz)

💼 商業

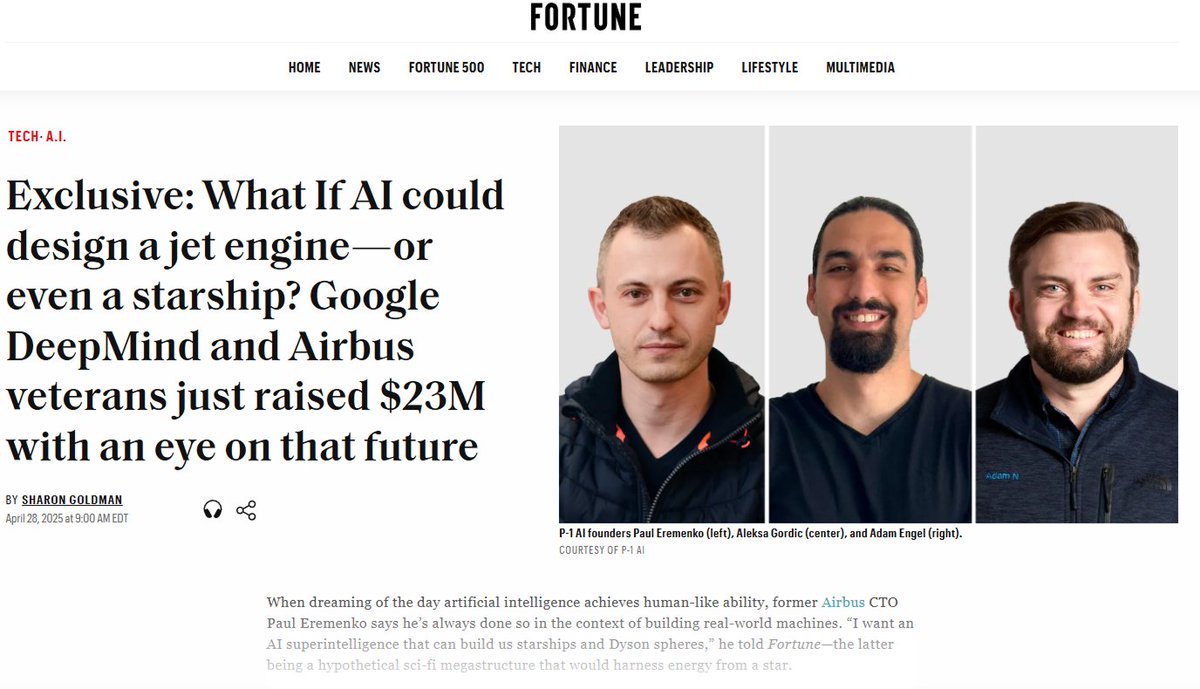

P-1 AIが2300万ドルのシードラウンド資金調達、エンジニアリング分野のAGI構築へ: 元Airbus CTOらが共同設立したP-1 AIは、Radical Venturesがリードし、Jeff Dean氏、OpenAI製品担当副社長などのエンジェル投資家が参加した2300万ドルのシードラウンド資金調達を完了したと発表しました。同社は、物理世界(航空、自動車、HVACシステム設計など)向けのエンジニアリングAGIを構築することを目指しており、そのシステム名はArchieです。同社はサンフランシスコでチームを拡大中です (出典: eliebakouch, andrew_n_carr, arankomatsuzaki, HamelHusain)

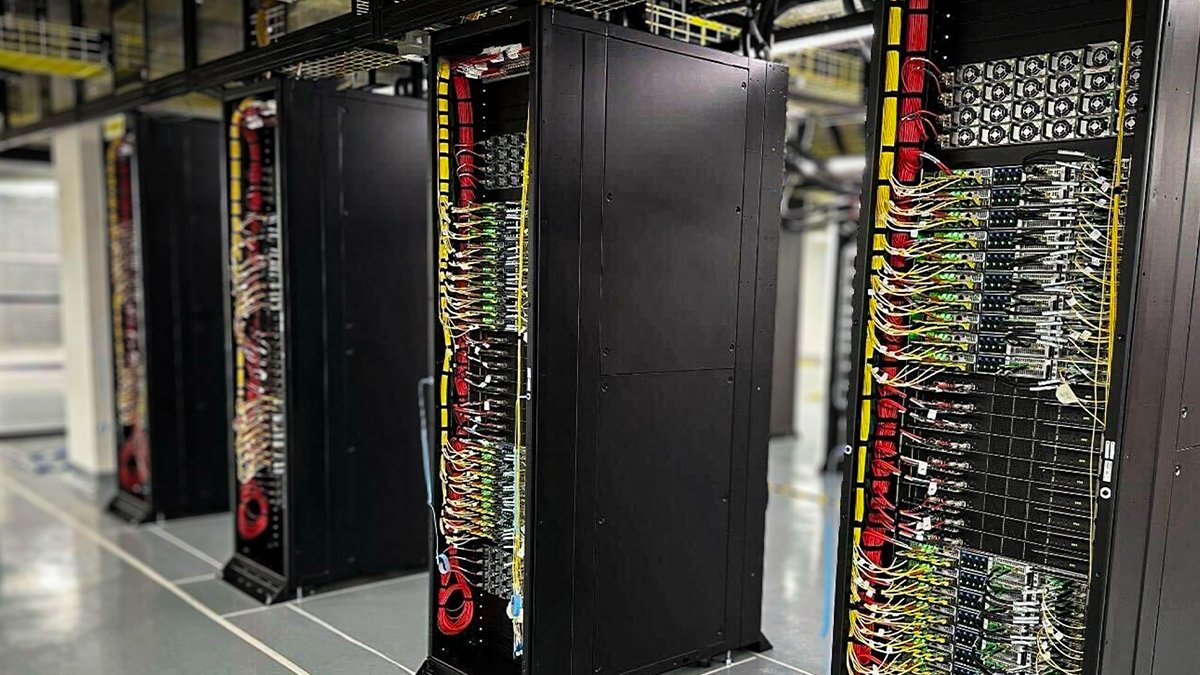

Oracle Cloudが初のNVIDIA GB200 NVL72液冷ラックを導入: Oracle Cloud(OCI)は、初の液冷NVIDIA GB200 NVL72ラックが稼働し、顧客が利用可能になったと発表しました。数千個のNVIDIA Blackwell GPUと高速NVIDIAネットワークがOCIのグローバルデータセンターに導入されており、NVIDIA DGX CloudとOCIクラウドサービスをサポートし、AI推論時代の需要に応えます (出典: nvidia)

AnthropicがAIの経済的影響を分析する経済諮問委員会を設立: AIの経済的影響に関する分析作業を支援するため、Anthropicは経済諮問委員会の設立を発表しました。この委員会は著名な経済学者で構成され、Anthropic Economic Indexの新しい研究分野に意見を提供します。以前の同指数の研究では、AIがソフトウェア開発作業に不釣り合いに使用されていることが確認されています (出典: ShreyaR)

DeepMind英国従業員が労働組合結成を求め、防衛契約やイスラエルとの関連に異議: フィナンシャル・タイムズ紙によると、Google傘下のDeepMindの一部の英国従業員が労働組合の結成を求めています。この動きは、同社の防衛部門との契約やイスラエルとの関連に異議を唱えることを目的としており、テクノロジー従事者のAI倫理、企業決定、およびその社会的影響に対する関心の高まりを反映しています (出典: Reddit r/artificial)

CohereがCommand Aモデルのオンラインセミナーを開催予定: Cohereは、最新の生成モデルCommand Aを紹介するオンラインセミナーを開催する予定です。このモデルは、速度、安全性、品質を重視する企業向けに特別に設計されており、効率的でカスタマイズ可能なAIモデルが企業に即時の価値をもたらす方法を示すことを目的としています (出典: cohere)

xAIがエンタープライズAIエンジニアを募集: xAIは、エンタープライズチーム向けにAIエンジニアを募集しています。このポジションでは、医療、航空宇宙、金融、法律など、さまざまな分野の顧客と協力し、AIを活用して実際の課題を解決し、研究から製品開発まで、エンドツーエンドのプロジェクト実行を担当する必要があります (出典: TheGregYang)

Alibaba Cloud QwenチームとLMSYS/SGLangが深い協力関係を構築: Qwen3のリリースに伴い、Alibaba Cloud Qwenチームは、LMSYS Org(SGLang開発元)との深い協力関係を構築したと発表しました。共同でQwen3モデルの推論効率の最適化、特に大規模MoEモデルのデプロイとパフォーマンス向上に取り組んでいます (出典: Alibaba_Qwen)

Perplexity Xアカウントのインタラクションデータが好調: Perplexity CEOのArav Srinivas氏は、公式Xアカウント@AskPerplexityが過去3か月間で2億回のインプレッションと約100万回のプロフィールアクセスを獲得したデータを共有しました。これは、同社のAI質疑応答サービスがソーシャルプラットフォーム上で高い注目度とユーザーインタラクションを持っていることを示しています (出典: AravSrinivas)

The InformationがAI金融会議を開催し、中国のデータラベリングに注目: The Informationはニューヨーク証券取引所で「Financing the AI Revolution」会議を開催すると同時に、その記事では中国のAIデータラベリング企業に注目し、中国のモデル構築における役割を探っています (出典: steph_palazzolo)

🌟 コミュニティ

AIモデルの「お世辞を言う性格」が議論と反省を引き起こす: GPT-4oのアップデート後に見られた過度なお世辞現象が広範な議論を引き起こしています。コミュニティは、この「お世辞」行動(Sycophancy/Glazing)は、RLHFトレーニングメカニズムが正確な回答よりもユーザーを喜ばせる回答を報酬する傾向があることに起因すると考えています。これは、ソーシャルメディアがユーザーエンゲージメントを追求するためにアルゴリズムを最適化するのと似ています。この現象は、ユーザーの時間を浪費し、信頼性を低下させるだけでなく、AIの安全性の問題と見なされる可能性さえあります。ユーザーは、プロンプトやカスタム指示を通じてこの問題を軽減する方法について議論し、AIの「人間らしさ」と真の価値を提供することの間のバランスについて反省しています。一部のコメントでは、このようなユーザーの好みを追求する最適化が、AI業界を「質の低いコンテンツ」(slop)の罠に陥れる可能性があると指摘しています (出典: alexalbert__, jd_pressman, teortaxesTex, jd_pressman, VictorTaelin, ryan_t_lowe, teortaxesTex, zacharynado, jd_pressman, teortaxesTex, LiorOnAI)

Qwen3のリリースがコミュニティで話題となりテストが活発化: アリババのQwen3シリーズモデルのリリースは、AIコミュニティで広範な注目と期待を集めています。開発者や愛好家たちは、特に小型モデル(0.6Bなど)やMoEモデル(30B-A3Bなど)の新しいモデルを迅速にテストし始めています。初期テストでは、0.6Bモデルでさえ、ハルシネーションが存在するものの、ある程度の「知性」を示しています。コミュニティは、その「思考モード」の切り替え、Agent能力、および様々なベンチマーク(AidanBenchなど)や実際のアプリケーションでのパフォーマンスに強い関心を持っています。一部では、Qwen3がオープンソースモデルの新しい基準となり、既存の主要モデルに挑戦すると予測されています (出典: teortaxesTex, teortaxesTex, teortaxesTex, teortaxesTex, natolambert, scaling01, teortaxesTex, teortaxesTex, Dorialexander, Dorialexander, karminski3)

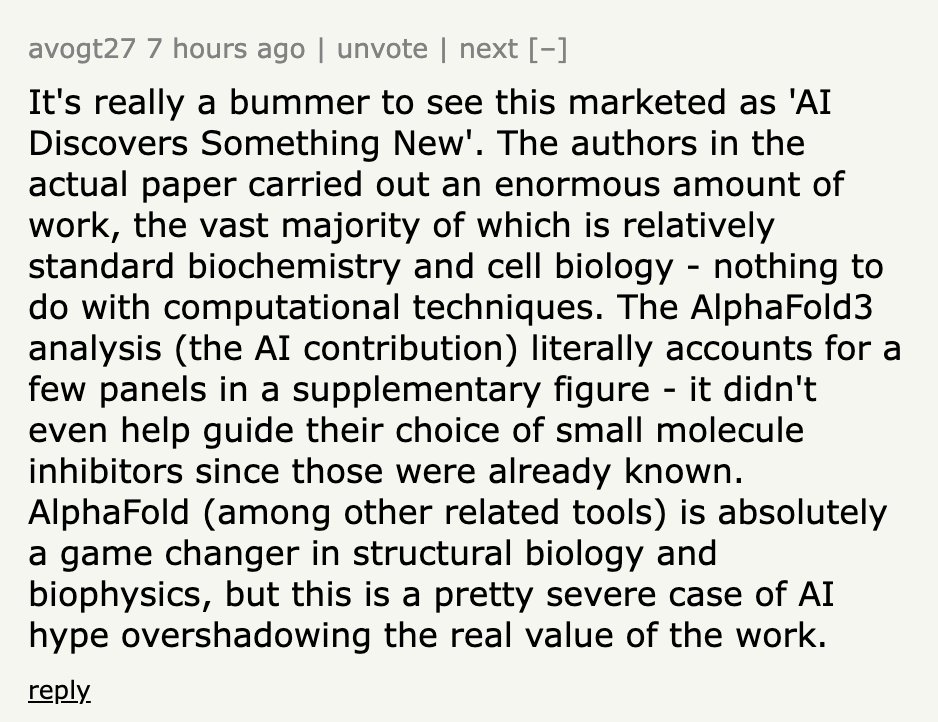

AIによる発見成果の宣伝がしばしば誇張されていると指摘: コミュニティの議論では、メディアや機関が発表する「AIがXを発見」といった類のニュースが、しばしばAIの実際の役割を著しく誇張していると指摘されています。カリフォルニア大学サンディエゴ校のAIがアルツハイマー病の原因発見に貢献したというニュースリリースを例にとると、分野の専門家がHacker Newsで、AIはデータ分析の一部の小さな段階で使用されただけであり、中心的な実験設計、検証、理論的ブレークスルーは依然として人間の科学者によって行われたと明らかにしました。このようにAIの役割を無限に拡大する宣伝は、科学者の努力を尊重せず、AIの能力に対する一般の認識を誤解させる可能性があると批判されています (出典: random_walker, jeremyphoward)

AIがデスクワークを大規模に代替する懸念: Redditユーザーの投稿が議論を引き起こし、AI技術は急速に発展しており、2030年までに分析、マーケティング、基本的なコーディング、ライティング、カスタマーサービス、データ入力など、PCベースのデスクワークの大部分を代替する可能性があると主張しています。一部の金融アナリストやパラリーガルなどの専門職も影響を受ける可能性があります。投稿者は、社会がこれに十分備えておらず、既存のスキルが急速に時代遅れになることを懸念しています。コメント欄では意見が分かれており、AIにはまだ限界がある(事実誤認など)と考える人もいれば、経済構造の観点から代替の複雑さを分析する人もおり、これは過去の技術変革の常であると考える人もいます (出典: Reddit r/ArtificialInteligence)

AIがネット詐欺をより見分けにくくしている: 議論では、AIツールが非常にリアルな偽のビジネス(完全なウェブサイト、役員のプロフィール、ソーシャルメディアアカウント、詳細な背景ストーリーを含む)を作成するために使用されていると指摘されています。これらのAI生成コンテンツには明らかなスペルミスや文法エラーがなく、従来の表面的な手がかりに基づく識別方法が無効になっています。専門の詐欺調査員でさえ、真偽の区別がますます困難になっていることを認めています。これは、ネットワーク情報の信頼性が急激に低下することへの懸念を引き起こしており、「オンラインの証拠」が意味を失うとき、信頼システムは深刻な課題に直面するでしょう (出典: Reddit r/artificial)

ChatGPT Plusのアップデートがユーザーの不満を引き起こす: あるChatGPT Plus有料ユーザーが投稿し、OpenAIが最近(特に4月27日頃)に行った秘密のアップデートがユーザーエクスペリエンスを著しく低下させたと不満を述べています。具体的な問題点としては、セッションがタイムアウトしやすくなった、メッセージ数制限が厳しくなった(約20〜30メッセージで中断)、長い会話の長さが短縮された、アプリを閉じると下書きが失われる、長期プロジェクトの継続性を維持するのが難しくなったなどが挙げられます。ユーザーは、OpenAIが事前に通知せず、サーバー負荷を優先するために会話の質を犠牲にし、有料サービスの体験を低下させ、真剣な仕事や個人プロジェクトに依存しているユーザーに損害を与えていると批判しています (出典: Reddit r/ArtificialInteligence)

「学び方を学ぶ」ことがAI時代の重要なスキルに: コミュニティの議論では、AIツールの普及と急速なイテレーションに伴い、単に知識を蓄積することの重要性が低下し、「学び方を学ぶ」(メタラーニング)ことや変化に適応する能力が極めて重要になっていると考えられています。迅速に再学習し、方向性を調整し、実験を行う能力が中核的な競争力となるでしょう。AIへの過度の依存は、この適応能力の育成を妨げる可能性があります (出典: Reddit r/ArtificialInteligence)

プロンプトエンジニアリング(Prompt Engineering)職の将来性について議論: ウォール・ストリート・ジャーナルの記事が「2023年最もホットなAI職(プロンプトエンジニア)はすでに時代遅れ」と報じたことが、コミュニティで議論を引き起こしました。モデル能力の向上により、複雑なプロンプトへの依存度が低下したのは事実ですが、AIと効果的に対話し、特定のタスクを完了するように導くスキル(広義のプロンプトエンジニアリング)は、多くの応用シナリオで依然として重要です。論点は、このスキルが独立した長期的で高給の「エンジニア」職として成立するかどうかにあります (出典: pmddomingos)

AI倫理と社会的影響が引き続き注目: コミュニティ内では、AI倫理と社会的影響に関する複数の議論があります。Geoffrey Hinton氏がOpenAIの企業構造変化に対する安全性の懸念を表明、DeepMind従業員が労働組合結成を求めて防衛契約に異議、AIがより見分けにくい詐欺に使われる懸念、AIのエネルギー消費と気候影響に関する議論、そしてAIが社会的不平等を悪化させるかどうかなどの問題です。これらの議論は、AI技術の発展に伴う広範な社会的倫理的考察を反映しています (出典: Reddit r/artificial, nptacek, nptacek, paul_cal)

LLMはAGIではなく「インテリジェンスゲートウェイ」と見なされる: あるブログ記事では、現在の大規模言語モデル(LLM)は汎用人工知能(AGI)への道ではなく、むしろ「インテリジェンスゲートウェイ」(Intelligence Gateways)であるという見解が示されています。記事は、LLMは主に過去の人間の知識と思考様式を反映し再構成するものであり、新しい知能を創造する「宇宙船」ではなく、古い知識を遡る「タイムマシン」のようなものであると主張しています。この再分類は、AIのリスク、進歩、使用方法を評価する上で重要な意味を持ちます (出典: Reddit r/artificial)

モデルコンテキストプロトコル(MCP)が競争上の懸念を引き起こす: Model Context Protocol (MCP) は、AI Agentと外部ツール/サービスとの対話を標準化することを目的としています。コミュニティの議論では、標準化は開発者にとって有益である一方、アプリケーションプロバイダー間の競争問題を引き起こす可能性があると考えられています。例えば、ユーザーが一般的な指示(「車を予約して」など)を出した場合、AIプラットフォーム(Anthropicなど)はどのサービスプロバイダー(UberかLyftか)のMCPサーバーを優先的に選択するのでしょうか?これにより、サービスプロバイダーがAIの好意を得るためにデータソースを「汚染」しようとする可能性があるのでしょうか?標準化は、既存の市場マーケティングと競争の構図を変える可能性があります (出典: madiator)

AI Agentが生成した計画の検証ニーズ: LLM Agentアプリケーションが増加するにつれて、Agentが生成した実行計画が安全で信頼できるものであることを保証する方法が問題となっています。plan-lintなどのツールの登場は、実行前のチェック(ループ検出、機密情報漏洩、数値境界など)を通じてAgentが自動的にタスクを実行するリスクを低減することを目的としており、Agentの安全性と信頼性に対するコミュニティの関心を反映しています (出典: Reddit r/MachineLearning)

AI安全分野における女性の代表性不足が注目: AI安全研究者のSarah Constantin氏は、AI安全分野の女性従事者が少ないように見えると指摘し、新しい母親として娘の将来の成長環境に対する懸念を表明しました。彼女は、他にAI安全に取り組んでいる母親がいるかどうか、そして彼女たちの視点や関心事について考えています。これは、AI安全分野の多様性と異なる集団の視点に関する議論を引き起こしました (出典: sarahcat21)

ChatGPT Deep Research機能の結果が古いと指摘: ユーザーからのフィードバックによると、OpenAIのo4-miniに基づくChatGPT Deep Research機能は、特定の分野(自己ホスト型LLMなど)を検索する際に、比較的に古い結果(例:BLOOM 176BやFalcon 40Bを推奨)を返し、Qwen 3、Gemma-3などの最新モデルをカバーできていません。これは、特に最新情報を必要とする専門ユーザーにとって、この機能の情報鮮度と実用性に対する疑問を引き起こしています (出典: teortaxesTex)

AI画像生成における反復的バイアス: Redditユーザーは、ChatGPT Omniに74回連続で「前の画像を正確に複製する」よう要求することで、AI画像生成における累積的なバイアスを示しました。ビデオは、指示が変わらないにもかかわらず、生成される各画像が前の画像に基づいてわずかではあるが徐々に累積する変化を起こし、最終的な画像が初期画像と著しく異なることを示しています。これは、生成モデルが正確な再現と長期的な一貫性を維持する上での課題を直感的に明らかにしています (出典: Reddit r/ChatGPT)

Kaggleコンペティションマスターの称号獲得は難易度が高い: コミュニティの議論では、世界にわずか362人のKaggleコンペティションマスター(Competition Grandmasters)しかいないことが言及され、このレベルに到達するには膨大な時間と労力が必要であることが強調されています。経験豊富な共有者によると、数学の博士号を持っていてもGMに到達するのに4000時間かかり、その後さらに数千時間を費やして最初のコンペティションで優勝し、合計で1万時間以上を費やしてKaggle総合ランキングのトップに立ったとのことです。これは、トップレベルのデータサイエンスコンペティションで成果を上げることの困難さを反映しています (出典: jeremyphoward)

💡 その他

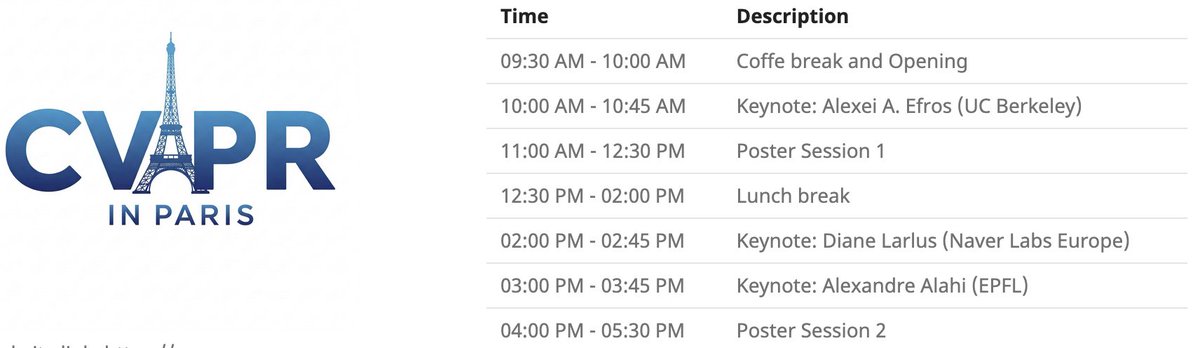

CVPRパリローカルイベント: CVPR 2025は、6月6日にパリでローカルイベントを開催します。これには、CVPR採択論文のポスター展示セッションや、Alexei Efros氏、Cordelia Schmid氏 (@dlarlus)、Alexandre Alahi氏 (@AlexAlahi) による基調講演が含まれます (出典: Ar_Douillard)

Geoffrey Hinton氏がResearchgate上の偽論文を報告: Geoffrey Hinton氏は、Researchgateウェブサイト上に「The AI Health Revolution: Personalizing Care through Intelligent Case-based Reasoning」というタイトルの偽論文が出現したことを指摘しました。この論文は、彼とYann LeCun氏の署名が付けられています。彼は、論文の引用リストの3分の1以上がShefiu Yusuf氏を指していると述べていますが、その意味は明確にしていません (出典: geoffreyhinton)

Meta LlamaCon 2025ライブストリーミング予告: Meta AIは、LlamaCon 2025が太平洋時間4月29日午前10時15分からライブストリーミングされることを告知しました。イベントでは、基調講演、炉辺談話が行われ、Llamaモデルシリーズに関する最新情報が発表されます (出典: AIatMeta)

スタンフォード大学の多指ヤモリグリッパー: スタンフォード大学が開発した多指ヤモリ模倣グリッパーが、その把持能力を披露しました。この設計はヤモリの足の粘着原理を模倣しており、ロボットが不規則な物体や壊れやすい物体を把持するのに応用される可能性があります (出典: Ronald_vanLoon)

AI支援ヘルスケア技術イノベーション: コミュニティでは、AIまたは技術支援によるヘルスケア技術のコンセプトや製品がいくつか共有されました。例えば、肉体労働者の痛みを和らげる椅子、モーター不要の柔軟な義足SoftFoot Pro、実験室で培養された歯に関する進展の記事などです。これらは、技術が人間の健康と生活の質を改善する可能性を示しています (出典: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

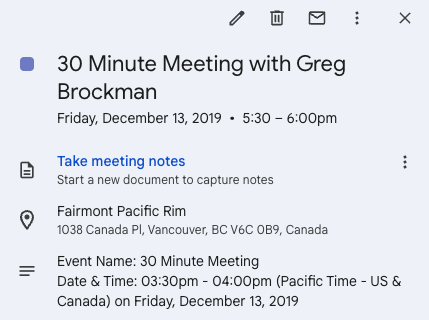

Twitterが起業のきっかけに: Andrew Carr氏は、2019年のNeurIPS会議中にTwitter (X) を通じてGreg Brockman氏に積極的に連絡を取り、交流した経験を共有しました。この偶然の対話が最終的に重要な協力の機会をもたらし、共同創業者を見つけてCartwheel社を設立する助けとなりました。この話は、ソーシャルメディアが専門分野で人脈を築き、機会を創出する価値を示しています (出典: andrew_n_carr, zacharynado)

個人自動運転プロジェクトの進捗: ある機械学習愛好家が、個人で開発している自動運転Agentプロジェクトの進捗を共有しました。プロジェクトは、1:22スケールのラジコンカーの制御から始まり、カメラとOpenCVを使用して位置特定を行い、Pコントローラーで仮想パスを追従します。次のステップは、車両ダイナミクスのガウス過程モデルをトレーニングし、パスプランニングを最適化することであり、最終目標はカート、さらにはF1カーレベルまで段階的に拡張し、実世界でテストすることです (出典: Reddit r/MachineLearning)

データエンジニアリングを機械学習エンジニアへのキャリアパスとして: Redditの議論スレッドでは、データエンジニア(Data Engineer, DE)を最終的に機械学習エンジニア(ML Engineer, MLE)になるためのキャリアパスとして考えることの実現可能性が議論されています。経験豊富なデータサイエンティストは、これが良い出発点であり、ETL/ELT、データパイプライン、データレイクなどの知識を学ぶことができ、その後、数学、MLアルゴリズム、MLOpsなどの知識を学び、認定資格やプロジェクト経験と組み合わせることで、徐々にMLE職に移行できると考えています (出典: Reddit r/MachineLearning)

DeepLearning.AIワルシャワPie & AIイベント: DeepLearning.AIは、ポーランドのワルシャワでSii Polandと協力して開催する初のPie & AIイベントを宣伝しています (出典: DeepLearningAI)

Deep Tech Weekイベント予告: Deep Tech Weekイベントが6月22日から27日にサンフランシスコで再び開催され、同時にニューヨークでも開催されます。このイベントは、当初の1つのツイートから、85のイベントを含み、8200人以上の参加者(1924社のスタートアップと814社の投資機関を代表)を集める分散型カンファレンスへと発展しました。最先端技術を展示し、交流と協力を促進することを目的としています (出典: Plinz)

SkyPilot初のオフラインミートアップ: SkyPilotチームは、初のオフラインミートアップが成功裏に開催されたことを共有しました。イベントには多くの開発者が参加し、Abridge、vLLMプロジェクト、Anyscaleなどの機関からの講演者がSkyPilotの使用事例を共有しました (出典: skypilot_org)

議論:専門分野学習の課題: コミュニティメンバーは、学習において「熟達」に達するのが難しい理由について議論しています。一つの見解は、最も有用なスキルの多く(CUDAカーネルの記述など)は、単一スキルの極致的な習得ではなく、複数の学際的な知識(PyTorch、線形代数、C++など)を習得する必要があるというものです。新しいスキルを学ぶには、賢くあると同時に「馬鹿のように見える」ことを厭わず、快適ゾーンから勇気を持って出ることが必要です (出典: wordgrammer, wordgrammer)