キーワード:AI, LLM, Meta Llama 4, GPT-5, 人形机器人, AGI安全, 数字劳动力

🔥 注目ニュース

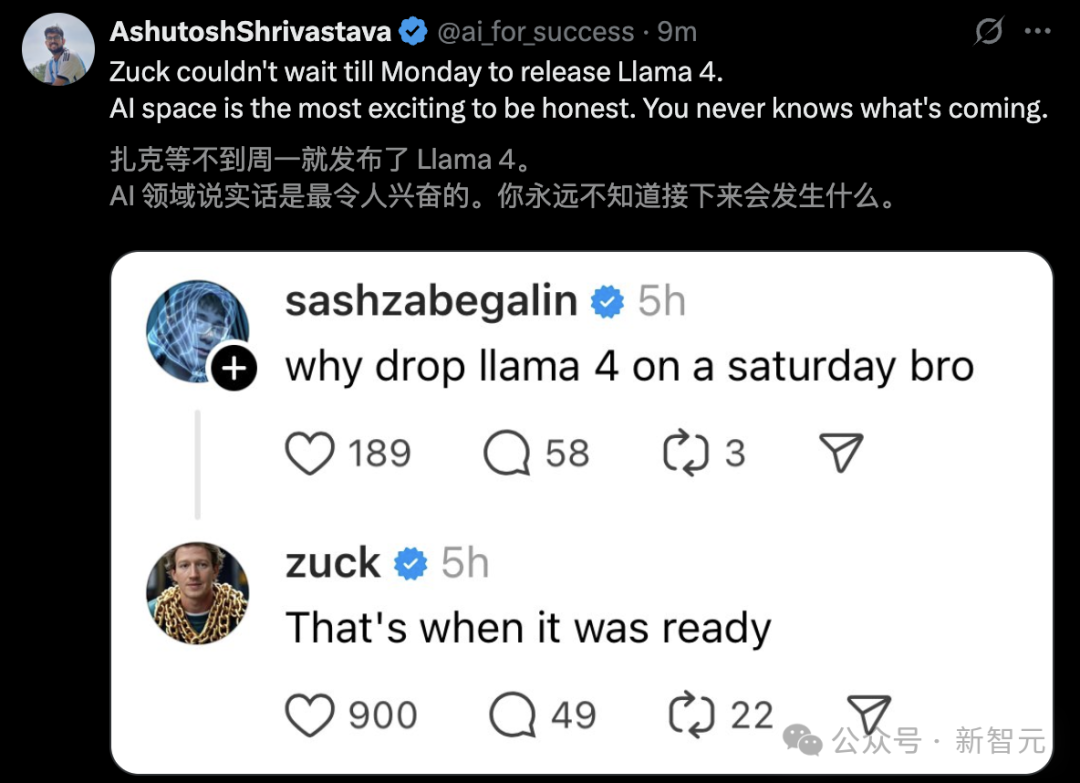

Meta Llama 4リリースが論争と性能疑問を引き起こす: MetaはLlama 4シリーズモデル(Scout 109B, Maverick 400B, Behemoth 2Tプレビュー版)をリリースしました。MoEアーキテクチャを採用し、マルチモーダルと最大1000万tokenのコンテキスト(Scout)をサポートします。公式は優れた性能を主張し、LM Arenaランキングでも好成績を収めていますが、コミュニティによる実測(特にプログラミングタスク)では、性能が予想をはるかに下回り、Gemma 3やQwenなどのモデルにも劣ると広く報告されています。同時に、匿名の従業員からの情報として、Metaが4月末のリリースに間に合わせるため、Llama 4の後訓練段階でベンチマークデータを混入させて「スコアを水増し」した可能性があり、AI研究担当副社長Joelle Pineauを含む人員の離職につながったとの告発がネット上で浮上しました。Meta側はこの告発をまだ確認していませんが、LM Arenaで使用されているのは「実験的なチャットバージョン」であると認めており、性能の真実性とリリース戦略に対するコミュニティの疑念を深めています。(出典: Llama 4リリース後36時間で批判殺到!匿名従業員が技術報告書への署名拒否を暴露, 月間アクティブユーザー30億でも焦り、AIで遅れCEO激怒、大規模モデルのスコア偽装、副社長が憤慨して離職, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Llama 4のスコア不正操作が話題に、20万GPUクラスタでこれだけのものしか作れなかったのか?, Llama 4訓練の不正操作で驚天動地のスキャンダル!AIの大家が憤慨して辞職、コード実測で崩壊しネット大騒ぎ, Meta LLaMA 4:GPT-4oとClaudeに対抗するオープンソースのエース)

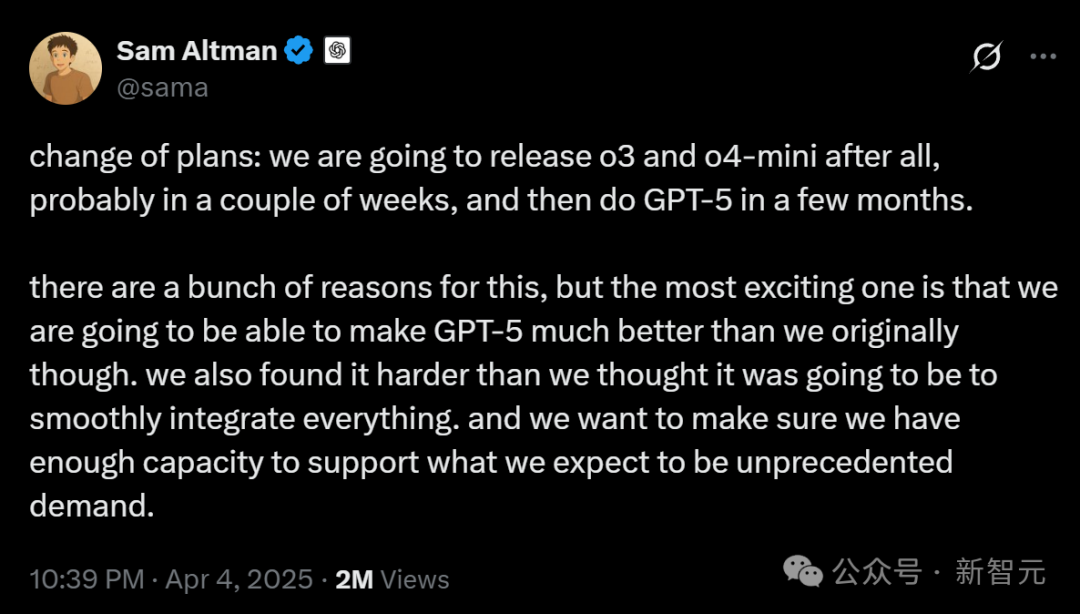

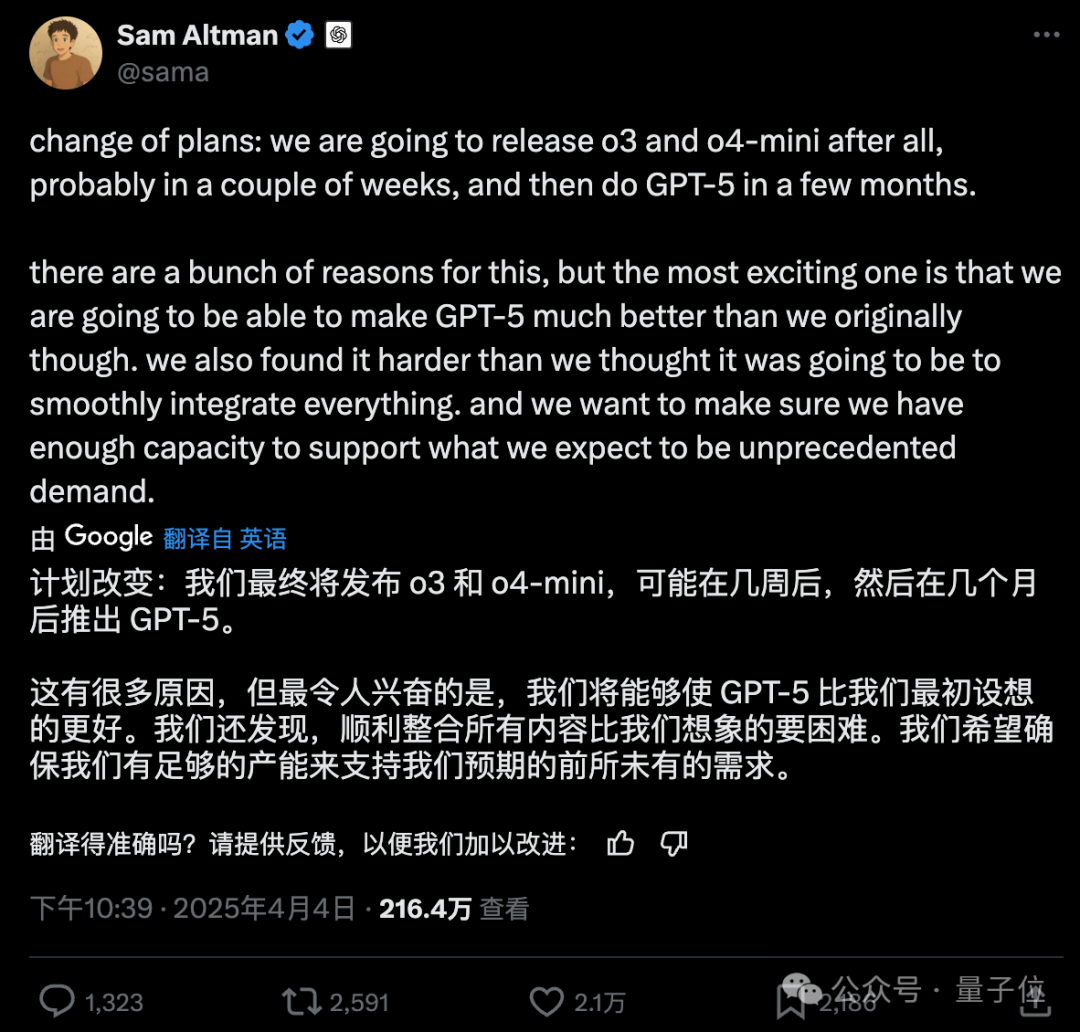

OpenAIがモデルリリース計画を調整、GPT-5は数ヶ月延期: OpenAI CEOのSam Altman氏はリリース計画の調整を発表し、今後数週間以内にo3およびo4-miniモデルをリリースする一方、当初多くの技術を統合する予定だったGPT-5は数ヶ月延期されると述べました。Altman氏は、延期はGPT-5を当初の計画よりも良く磨き上げ、統合の難易度と計算能力の需要問題を解決するためだと説明しました。また、今後数ヶ月で強力な推論モデルをオープンソース化し、コンシューマー向けハードウェアで動作する可能性があることも明らかにしました。以前、OpenAIの目標はoシリーズとGPTシリーズを統一することであり、GPT-5は音声、Canvas、検索など多様な能力を統合した統一システムとして位置づけられ、基礎バージョンは無料で提供される可能性がありました。今回の調整は、DeepSeekなどの競合他社やGoogle Gemini 2.5 Proのリリースに影響された可能性があります。(出典: Altman氏発表:無料GPT-5の性能は驚異的、o3とo4-miniが先行リリース、Llama 4も延期, DeepSeekが新論文を発表した直後、Altman氏も追随:GPT-5は数ヶ月後に登場, OpenAI:数週間以内にo3とo4-miniをリリース、数ヶ月後にGPT-5を発表)

具身インテリジェンスと人型ロボットが新たな注目分野に、資本流入と商業化の課題が併存: 2025年中関村フォーラムは人型ロボットに焦点を当て、加速進化T1、天工2.0、灵宝CASBOTなどの国産ロボットが技術的ブレークスルーと実用化の進展を示しました。業界は技術デモンストレーションから、工業用仕分け、案内・販売促進、科学研究などの実用アプリケーションへと移行しています。市場は活況を呈し、「受注爆発」やロボットレンタル(日額数千元から数万元)現象が現れています。資本も急速に流入しており、Xiaoyu Zhizao、Zhipingfang、Fourier Intelligence、Lingcifang、Zibianliang、Tashi Zhihangなどが2024年末から2025年初頭にかけて大型の資金調達を獲得し、国有資本が主要な推進力となっています。しかし、商業化の道筋はまだ明確ではなく、GSR Venturesの朱啸虎氏がこの分野から撤退していると伝えられ、バブルや実用化の難しさについての市場の議論を引き起こしています。課題に直面しているものの、人型ロボットは具身インテリジェンス(政府活動報告にも記載)の担い手として、AIと実体経済の融合における重要な方向性と見なされています。(出典: 人型ロボット、新たな風向きに立つ)

Google DeepMindがAGI安全報告書を発表、2030年頃の実現可能性を予測しリスクを警告: Google DeepMindは145ページの報告書を発表し、AGIの安全性に関する見解を体系的に説明し、99%の人間を超える「卓越レベルAGI」が2030年頃に出現する可能性があると予測しました。報告書は、AGIが「人類を永久に破滅させる」存続リスクをもたらす可能性があると警告し、世論操作、自動化されたサイバー攻撃、バイオセキュリティの制御不能、構造的災害(人間の意思決定能力喪失など)、自動化された軍事対立などの具体的なリスクシナリオを列挙しました。報告書はリスクを、悪用、誤整合(欺瞞的アライメントを含む)、誤動作、構造的リスクの4つのカテゴリに分類し、「増幅監視」と「堅牢な訓練」に基づく2つの防衛線、およびAIを「信頼できない内部関係者」と見なして展開を制御することを提案しています。報告書はまた、OpenAIなどの競合他社の安全戦略を暗に批判しています。この報告書は議論を呼び、一部の専門家はAGIの定義が曖昧で時間軸が不確実であると考えていますが、AIの安全性の重要性については広く同意されています。(出典: 2030年にAGI到来?Google DeepMindが「人類自己防衛ガイド」を作成, Googleが145ページの論文を発表:AGIは2030年頃出現と予測、「人類を永久に破滅させる」可能性を警告)

Nvidia CEO Jensen HuangらがAIについて語る:デジタル労働力と国家戦略: a16zの番組で、Nvidia CEOのJensen Huang氏とMistral創設者のArthur Mensch氏がAIの未来について議論しました。Jensen氏は、AIは技術格差を縮小する最大の力であり、その汎用性と超専門化が共存し、特定の分野に合わせて微調整する必要があると強調しました。彼は「デジタルインテリジェンス」が新たな国家インフラとなり、各国は「デジタル労働力」を構築し、汎用AIを専門AIに転換する必要があると提唱しました。Arthur Mensch氏はAIの革命性に同意し、電力のようにGDPに影響を与え、さらに文化や価値観を担うインフラであるとし、デジタル植民地化を防ぐための主権AI戦略の重要性を強調しました。両者ともオープンソースの重要性を強調し、イノベーションを加速し、透明性と安全性を高め、依存を減らすことができると考えました。Jensen氏はまた、将来のAIタスクは非同期になる傾向があり、インフラに新たな要求を突きつけ、技術を過度に崇拝せず、積極的に参加すべきだと注意喚起しました。(出典: 「デジタル労働力」が誕生、Jensen Huang氏の最新発言はAIを中心にこれらの点を語る…)

🎯 動向

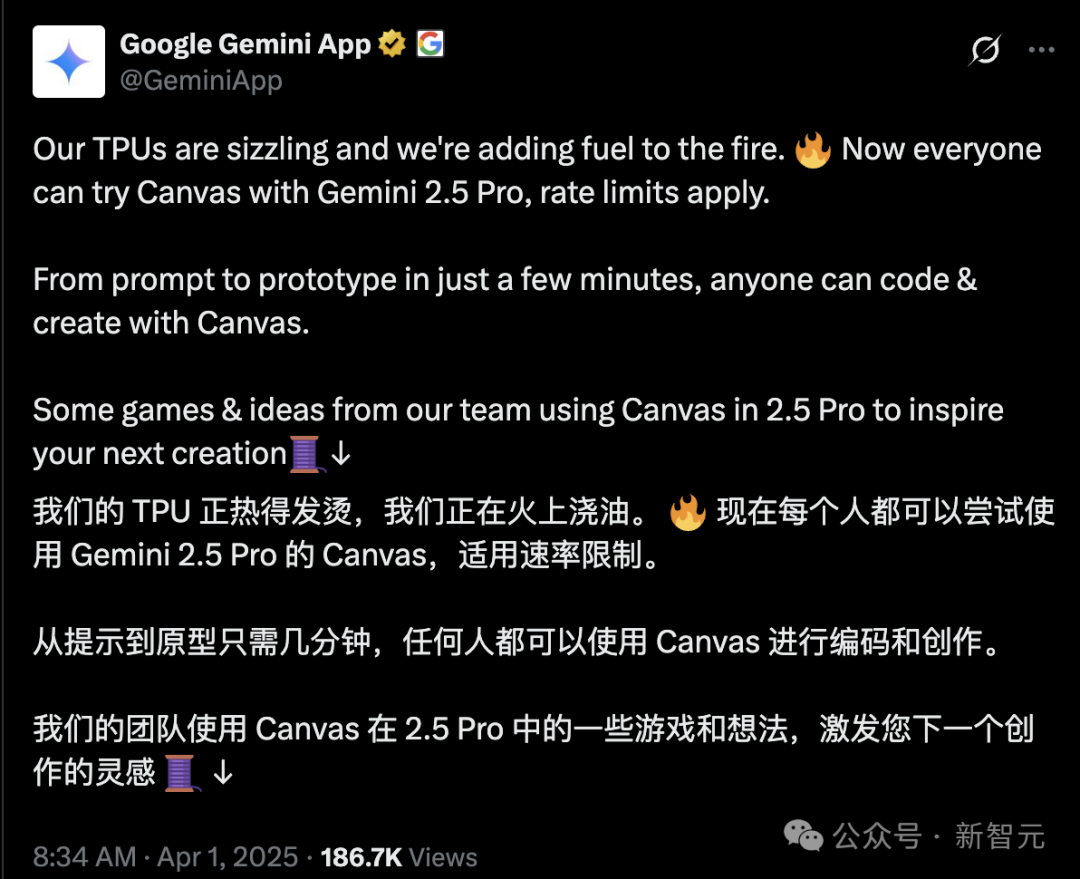

GoogleがGemini 2.5 Pro Canvas機能を無料開放: Googleは、すべてのユーザーにGemini 2.5 ProのCanvas機能を無料で開放すると発表しました。この機能により、ユーザーはプロンプトを通じて数分でプログラミングや革新的なタスク(ウェブサイトのデザイン、スクリプト作成、ゲームやビジュアルシミュレーションの制作など)を完了できます。この動きは、GoogleがAI競争においてTPUの計算能力の優位性を利用し、計算能力が逼迫しているOpenAI(Altman氏はかつてGPUが溶けていると述べた)に対抗する「奇襲」と見なされています。Gemini製品責任者のTulsee Doshi氏はインタビューで、2.5 Proモデルは推論、プログラミング、マルチモーダル能力において強力であり、「雰囲気テスト (vibe check)」を通じて技術指標とユーザーエクスペリエンスのバランスを取り、将来のモデルはよりスマートで効率的になると強調しました。(出典: GoogleがOpenAIを暗に皮肉:GPUは溶け、TPUは火に油を注ぐ、Canvas無料開放、実測は驚異的)

DeepSeekが推論時拡張報酬モデルに関する新研究を発表: DeepSeekとTsinghua Universityは共同で論文を発表し、SPCT(Self-Principled Critique Tuning)手法を提案しました。これは、オンライン強化学習を通じて生成的報酬モデル(GRM)を最適化し、推論時拡張能力を向上させるものです。この手法は、汎用報酬モデルが複雑で多様なタスクに直面した際の性能制限問題を解決することを目的としており、モデルが動的に高品質な原則と批判を生成することで報酬信号の精度を高めます。実験によると、この手法に基づいて訓練されたDeepSeek-GRM-27Bは、複数のベンチマークでベースライン手法を大幅に上回り、推論時のサンプリング拡張によってさらに性能が向上しました。この研究は、OpenAIなどの競合他社のモデルリリース戦略に影響を与える可能性があります。(出典: DeepSeekが新論文を発表した直後、Altman氏も追随:GPT-5は数ヶ月後に登場)

Doubaoアプリがオンライン検索とディープシンキング機能を統合: ByteDanceのAIアシスタント「Doubao」は、ディープシンキング機能を更新し、オンライン検索能力を思考プロセスに直接統合し、「考えながら検索する」を実現し、独立したオンライン検索ボタンを削除しました。このモードでは、Doubaoはまず思考を行い、次に思考結果に基づいてターゲットを絞った検索を行い、検索内容と組み合わせて思考を続け、複数回の検索を行う可能性があります。この動きは、ユーザーインターフェースを簡素化し、AIインタラクションを人間の自然な情報取得方法に近づけることを目的としていますが、簡単な問題を処理する際に不必要な待機時間が発生する可能性もあります。これは、DoubaoがAIアシスタント製品設計においてDeepSeek R1などの競合製品に対抗し、差別化を図る試みと見なされています。(出典: Doubaoがオンライン検索を消滅させる)

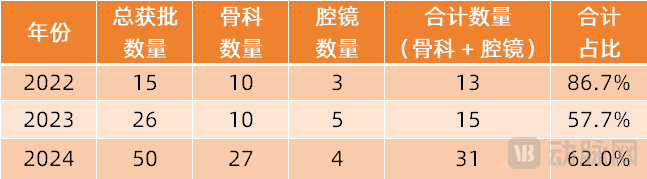

手術ロボットがより多くの専門分野に拡大: 手術ロボット市場は、主流の内視鏡や整形外科分野から、より多くの専門分野へと拡大しています。最近では、血管インターベンション(Weimai MedicalのETcathが承認、MicroPortのR-ONEが販売実現)、自然開口部経由(Robo MedicalのEndoFaster消化器内視鏡ロボットが承認、Johnson & JohnsonのMonarch/Intuitive FosunのIon気管支鏡ロボットが商業化)、経皮的穿刺(Zhuoyue MedicalのAIナビゲーションロボットが承認、United Imaging、Zhen Healthなど十数社が参入)、植毛(Bangce MedicalのHAIROが承認され協力して普及)、口腔インプラント(Lancet?のDencore、Bohui Weikangの製品が承認)などの分野で著しい進展が見られます。眼科手術ロボット(Dishui Medical)も革新的承認プロセスに入っています。技術トレンドには、AIや大規模モデルとの連携、およびより多くの画像診断装置(大口径CT、PET-CTなど)との併用による精度と効率の向上が含まれます。(出典: 内視鏡、整形外科以外にも、手術ロボットが突破口を開こうとしている)

Mihoyo創設者Cai Haoyu氏のAIゲーム『Whispers From The Star』実機デモが公開: Mihoyo創設者Cai Haoyu氏のAI企業Anuttaconが開発した実験的AIゲーム『Whispers From The Star』のiPhone実機デモ映像が公開されました。ゲームの核心は、プレイヤーがテキスト、音声、ビデオを通じて、異星に閉じ込められたAIヒロインStella(小美)と対話し、その対話がリアルタイムでストーリー展開と彼女の運命に影響を与え、固定された脚本がないことです。デモでは、没入型の対話、感情的なインタラクション(プレイヤーを赤面させる「ベタな口説き文句」さえも)、そしてプレイヤーの決定がストーリーの行方に直接影響を与える様子(例えば、誤ったアドバイスがキャラクターの死を招く)が示されました。このゲームは現在、クローズドテストを実施中(iPhone 12以上のみ対応)であり、Anuttaconが探求する「ゲームとプレイヤーが共に発展する」目標を体現しています。(出典: Mihoyo蔡浩宇氏の新作iPhone実機デモ:10分でAIの小美に口説かれて赤面、彼女の運命は私が救う)

MicrosoftがAI駆動の『Quake II』デモを公開し注目を集める: Microsoftは、同社のMuse AIモデルを通じて、クラシックゲーム『Quake II』にCopilotスタイルのインタラクション能力を組み込む技術デモを展示しました。この技術は、NPCがプレイヤーとより自然に対話したり、補助を提供したりするなど、ゲームにおけるAIの応用可能性を探ることを目的としています。しかし、このデモはネット上で賛否両論を巻き起こしており、AI技術の進歩の表れであり、未来のゲームインタラクションの可能性を示唆するものだと考える人もいれば、現在の効果は不十分で、元のゲーム体験を損なっていると感じる人もいます。(出典: Reddit r/ArtificialInteligence)

Llama 4 Maverickが一部のベンチマークテストで優れた性能を示す: Artificial Analysisのベンチマークテストデータによると、Metaが新たにリリースしたLlama 4 Maverickモデルは、一部の評価においてAnthropicのClaude 3.7 Sonnetを上回る性能を示しましたが、依然としてDeepSeek V3.1には及びませんでした。これは、Llama 4がコミュニティの実測でいくつかの問題(特にコーディングに関して)を露呈しているものの、特定のベンチマークやタスクにおいては依然として競争力を持っていることを示唆しています。注意点として、異なるベンチマークテストは重点が異なり、モデルの単一ランキングでの順位がその総合的な能力を完全に代表するものではないということです。(出典: Reddit r/LocalLLaMA)

Llama 4が長文コンテキスト理解ベンチマークテストで低迷: Fiction.liveBenchの長文コンテキスト深層理解ベンチマークの更新結果によると、Meta Llama 4モデル(ScoutとMaverickを含む)は性能が振るわず、特に16K tokenを超えるコンテキストを処理する際に精度が著しく低下しました。例えば、Llama 4 Scoutは16Kを超えるコンテキストを処理する際、リコール率(質問応答の正答率に近似)が22%未満に低下しました。これは、公称されている10Mの超長コンテキストウィンドウ能力とは対照的であり、コミュニティからその長文処理の実際の効果について疑問視されています。(出典: Reddit r/LocalLLaMA)

Llama 4 MaverickがAiderプログラミングベンチマークテストで低スコア: Aider polyglotプログラミングベンチマークテストにおいて、MetaのLlama 4 Maverickモデルのスコアはわずか16%でした。この結果は、コミュニティにおけるそのプログラミング能力に対する否定的な評価をさらに強め、他のモデル(QwQ-32Bなど)との差が顕著です。これは、大規模なフラッグシップモデルとしての位置づけと一致せず、その訓練データ、アーキテクチャ、または後訓練プロセスに対する疑問を引き起こしています。(出典: Reddit r/LocalLLaMA)

Midjourney V7がリリース: AI画像生成ツールMidjourneyがV7バージョンをリリースしました。新バージョンは通常、画質、スタイルの多様性、プロンプトの理解能力、および機能性(一貫性、編集能力など)の向上を意味します。具体的な更新内容とユーザーフィードバックは、今後の観察が待たれます。(出典: Reddit r/ArtificialInteligence)

GitHub Copilotが新たな制限を導入し、高度なモデルを有料化: GitHub Copilotは、サービスを調整し、新たな使用制限を導入し、「高度な」AIモデルを使用するサービスに対して課金を開始すると発表しました。これは、無料または標準ティアのユーザーが使用頻度や機能においてより多くの制限を受ける可能性があり、より強力なモデル能力(おそらくGPT-4oやその他の更新されたモデルから)には追加料金が必要になることを意味するかもしれません。この変更は、AIサービスプロバイダーがコスト、パフォーマンス、ビジネスモデルのバランスを取るための継続的な模索を反映しています。(出典: Reddit r/ArtificialInteligence)

🧰 ツール

Supabase MCPサーバー: Supabaseコミュニティは、supabase-mcpをリリースしました。これは、Model Context Protocol (MCP)に基づいたサーバーで、SupabaseプロジェクトとCursor、Claude、WindsurfなどのAIアシスタントを接続することを目的としています。これにより、AIアシスタントはユーザーのSupabaseプロジェクトと直接対話し、テーブル管理、設定取得、データクエリなどのタスクを実行できます。このツールはTypeScriptで書かれており、Node.js環境が必要で、パーソナルアクセストークン(PAT)を通じて認証されます。プロジェクトは詳細な設定ガイド(WindowsおよびWSL環境を含む)を提供し、プロジェクト管理、データベース操作、設定取得、ブランチ管理(実験的)、開発ツール(TypeScript型生成など)をカバーする利用可能なツールセットをリストアップしています。(出典: supabase-community/supabase-mcp – GitHub Trending (all/daily))

ActivepiecesオープンソースAI自動化プラットフォーム: Activepiecesは、Zapierの代替として位置づけられるオープンソースのAI自動化プラットフォームです。ユーザーフレンドリーなインターフェースを提供し、280以上の統合(”pieces”と呼ばれる)をサポートしており、これらの統合は現在、LLMs(Claude Desktop, Cursor, Windsurfなど)で使用するためのModel Context Protocol (MCP)サーバーとしても利用可能です。特徴には、TypeScriptベースの型安全なpiecesフレームワーク、ローカル開発でのホットリロードサポート、組み込みAI機能とCopilotによるフロー構築支援、データセキュリティを保証するセルフホスティングサポート、ループ、分岐、自動リトライなどのフロー制御、ヒューマンインザループと手動入力インターフェース(チャット、フォーム)のサポートが含まれます。コミュニティが大部分のpiecesを提供しており、そのオープンなエコシステムを反映しています。(出典: activepieces/activepieces – GitHub Trending (all/daily))

アンチAIクローラーツールAnubisとトラップ戦略: OpenAIなどの企業のAIクローラーがrobots.txtルールを無視し、過剰なクロールによってウェブサイトが過負荷になる(DDoS攻撃に類似)問題に直面し、開発者コミュニティは積極的に反撃しています。FOSS開発者のXe Iaso氏は、Anubisという名前のリバースプロキシツールを作成しました。これは、プルーフオブワークメカニズムを通じて訪問者が本物の人間のブラウザであるかどうかを検証し、自動化されたクローラーを効果的にブロックします。他の戦略には、「トラップ」ページを設定し、違反クローラーに大量の無用または誤解を招く情報(xyzalの提案、Aaron氏のNepenthesツール、CloudflareのAI Labyrinthなど)を提供することが含まれます。これは、クローラーのリソースを浪費し、そのデータセットを汚染することを目的としています。これらのツールと戦略は、開発者がウェブサイトの権利を維持し、非倫理的なデータ収集に対抗する努力を反映しています。(出典: AIクローラーが猛威を振るい、OpenAIなどの大手企業は非道徳的、開発者は「神級武器」を作り宣戦布告)

OpenAIがSWE-Lancerベンチマークを発表: OpenAIは、現実世界のフリーランスソフトウェアエンジニアリングタスクにおける大規模言語モデルのパフォーマンスを評価するためのベンチマークテスト、SWE-Lancerを発表しました。このベンチマークには、Upworkプラットフォームからの1400以上の実際のタスクが含まれており、独立したコーディング、UI/UXデザイン、サーバーサイドロジックの実装、管理上の意思決定などをカバーしています。タスクの複雑さと報酬は様々で、総額は100万ドルを超えます。評価は、専門のエンジニアによって検証されたエンドツーエンドのテスト方法を採用しています。初期の結果によると、最もパフォーマンスの良いClaude 3.5 Sonnetでさえ、独立したコーディングタスクでの成功率はわずか26.2%であり、既存のAIが実際のソフトウェアエンジニアリングタスクを処理する上でまだ大きな改善の余地があることを示しています。このプロジェクトは、ソフトウェアエンジニアリング分野におけるAIの経済的影響に関する研究を推進することを目的としています。(出典: OpenAIが大規模モデルの現実世界ソフトウェアエンジニアリングベンチマークSWE-Lancerを発表)

中国科学院がCK-PLUGを提案、RAGの知識依存を制御: RAG(検索拡張生成)におけるモデル内部知識と外部検索知識の衝突問題に対し、中国科学院計算技術研究所などの機関がCK-PLUGフレームワークを提案しました。このフレームワークは、「Confidence-Gain」指標(エントロピー変化に基づく)を用いて衝突を検出し、調整可能なパラメータαを使用してパラメータ認識とコンテキスト認識の予測分布を動的に重み付け融合することで、モデルの内部・外部知識への依存度を正確に制御します。CK-PLUGはまた、手動調整不要のエントロピーベースの適応モードも提供します。実験により、CK-PLUGは生成の流暢さを維持しつつ、知識依存を効果的に調整し、様々なシナリオにおけるRAGの信頼性と精度を向上させることが示されました。(出典: RAG衝突の難題を解決!中国科学院チームがCK-PLUGを提案:パラメータ1つで、大規模モデルの知識依存を正確かつ動的に調整)

Agent S2フレームワークがオープンソース化、モジュール型エージェント設計を探求: Simular.aiチームはAgent S2フレームワークをオープンソース化しました。このフレームワークは、コンピュータ使用(computer use)ベンチマークテストでSOTA(State-of-the-Art)の成績を収めました。Agent S2は「コンポーザブルインテリジェンス」設計を採用し、エージェント機能を専門モジュール(MoG(GUI要素を特定するマルチエキスパートシステム)やPHP(動的計画法による調整)など)に分割します。これは、エージェントアーキテクチャに関する議論、すなわち単一の強力なモデルに統合するのが良いのか、それともモジュール化された分業が優れているのか、という議論を引き起こしました。記事はまた、エージェント実装の異なるパス(GUIインタラクション、API呼び出し、コマンドライン)とその長所短所、および「構造化」と「インテリジェンス化」の弁証法的関係、エージェントの能力増幅効果(インターフェース最適化、タスクの流暢さ、自己修正)についても考察しています。(出典: 最強Agentフレームワークがオープンソース化!エージェント設計の道はどこへ?)

EXL3量子化フォーマットのプレビュー版がリリース、圧縮効率を向上: EXL3量子化フォーマットの早期プレビュー版がリリースされ、モデル圧縮効率のさらなる向上を目指しています。初期テストによると、その4.0bpw(bits per weight)バージョンは、性能においてEXL2の5.0bpwまたはGGUFのQ4_K_M/Lに匹敵する可能性がありますが、サイズはより小さくなっています。Llama-3.1-70Bが1.6bpwのEXL3でも一貫性を保ち、16GB VRAM内で実行可能であるとの報告さえあります。これは、リソースが制限されたデバイス上で大規模モデルを展開する上で重要な意味を持ちます。ただし、現在のプレビュー版は機能がまだ完全ではありません。(出典: Reddit r/LocalLLaMA)

より小さいサイズのGemma3 QAT量子化モデルがリリース: 開発者のstduhpf氏は、修正版のGemma3 QAT(量子化対応トレーニング)モデル(12Bおよび27B)をリリースしました。これは、元の非量子化トークン埋め込みテーブルをimatrix量子化されたQ6_Kバージョンに置き換えることで、モデルファイルサイズを大幅に削減し、同時に公式QATモデルとほぼ同等の性能(perplexityテストで検証済み)を維持しています。これにより、12B QATモデルは8GB VRAM(約4kコンテキスト)で、27B QATモデルも16GB VRAM(約1kコンテキスト)で実行可能となり、コンシューマー向けGPUでの利用可能性が向上しました。(出典: Reddit r/LocalLLaMA)

研究専用AIアシスタント「Xinliu」実測: 「Xinliu AI Assistant」は、研究シーン向けに特別に設計されたAIツールで、DeepSeekに接続されています。特徴的な機能には、論文AI精読(要点強調、単語選択による解釈、翻訳比較、ガイド)、引用文献ワンクリックアクセス(精読画面内で引用論文を開ける)、論文マップ(引用関係と著者の他の論文を可視化)、カスタム知識ベースQ&A(複数の論文をインポートして総合的な質問)、AIノート(ハイライト、解釈、要約を統合)、マインドマップ生成、ポッドキャスト生成が含まれます。効率的な知識獲得、管理、レビュー体験を提供し、研究ワークフローを最適化することを目的としています。(出典: 論文を読むのが遅いのは、ツールのせいかも。研究専用版「DeepSeek」を実測)

LlamaParseがLayout Agentを追加しドキュメント解析を向上: LlamaIndexのLlamaParseサービスにLayout Agent機能が追加されました。これは、より正確なドキュメント解析とコンテンツ抽出を提供し、正確な視覚的参照を伴うことを目的としています。このAgentは、視覚言語モデル(VLM)を利用して、まずページ上のすべてのブロック(テーブル、グラフ、段落など)を検出し、次に各部分を正しい形式で解析する方法を動的に決定します。これにより、解析プロセス中にテーブルやグラフなどのページ要素が誤って見落とされるケースを大幅に削減するのに役立ちます。(出典: jerryjliu0)

MoCha:音声とテキストに基づいてマルチキャラクター対話ビデオを生成: カナダのUniversity of WaterlooとMeta GenAIはMoChaフレームワークを提案しました。これは、音声とテキスト入力のみに基づいて、完全なキャラクター(近景から中景まで)を含むマルチキャラクター、複数ターンの対話ビデオを生成できます。主要技術には、唇の動きと動作の同期を保証するSpeech-Video Window Attentionメカニズム、混合データを利用して汎化能力と制御性(表情、動作などを制御)を向上させる共同音声-テキスト訓練戦略、マルチキャラクター対話生成とショット切り替えをサポートする構造化プロンプトテンプレートとキャラクターラベルが含まれます。MoChaは、リアリズム、表現力、制御性の面で優れた性能を示し、自動化された映画の物語生成に新しいソリューションを提供します。(出典: MoCha:自動化された複数ターン対話映画生成の新時代を開く)

DeepGit:AIを利用してGitHubの宝庫リポジトリを発見: DeepGitは、セマンティック検索を使用して価値のあるGitHubリポジトリを発見することを目的としたオープンソースAIシステムです。コード、ドキュメント、コミュニティシグナル(star、fork、issueの活発度など)を分析することで、見過ごされがちな「隠れた宝物」プロジェクトを発掘します。このシステムはLangGraphに基づいて構築されており、開発者に関連性の高い、または高品質なオープンソースプロジェクトをインテリジェントに発見する新しい手段を提供します。(出典: LangChainAI)

Llama 4 ScoutとMaverickがLambda APIで利用可能に: Metaが最新リリースしたLlama 4 ScoutとMaverickモデルが、Lambda Inference APIを通じて呼び出し可能になりました。両モデルとも100万tokenのコンテキストウィンドウを提供し、FP8量子化を採用しています。価格は、Scoutが入力$0.10/百万token、出力$0.30/百万token、Maverickが入力$0.20/百万token、出力$0.60/百万tokenです。これにより、開発者はAPIを通じてこれら2つの新しいモデルを使用する手段を得られます。(出典: Reddit r/LocalLLaMA, Reddit r/artificial)

Riffusionを使用してSunoの曲をリマスター: Redditユーザーが、無料のAI音楽ツールRiffusionのCover機能を使用して、古いSuno V3で生成された曲を「リマスター」する経験を共有しました。これにより、音質が大幅に向上し、よりクリアでクリーンになるとのことです。これは、異なるAIツールを組み合わせて創作プロセスを最適化する方法を提供し、特にSuno V4の無料版を待つ間に有効です。(出典: Reddit r/SunoAI)

OpenWebUIツールサーバー: 開発者が、Haystackカスタムコンポーネントを使用してREST API経由でOpenWebUIにカスタム関数を設定し、「グラウンディングされた」LLM Agentと対話するためのプロジェクトを共有しました。同時に、設定済みのDockerイメージも提供され、認証、RAG、自動タイトル生成などを無効にするなど、OpenWebUIの設定を簡素化し、開発者が統合して使用しやすくしています。(出典: Reddit r/OpenWebUI)

📚 学習

開発者向けLLM入門チュートリアル『LLM Cookbook』中国語版: Datawhaleコミュニティは、『LLM Cookbook』プロジェクトをリリースしました。これは、Andrew Ng教授の大規模モデルシリーズ講座(Prompt Engineering for Developers, Building Systems with the ChatGPT API, LangChain for LLM Application Developmentなど11講座)の中国語版です。このプロジェクトは、講座内容を翻訳しただけでなく、サンプルコードを再現し、中国語の文脈に合わせてPromptを最適化しています。チュートリアルは、PromptエンジニアリングからRAG開発、モデルのファインチューニングまでの全プロセスをカバーし、中国語話者の開発者に体系的で実践的なLLM入門指導を提供することを目的としています。プロジェクトはオンライン閲覧とPDFダウンロードを提供し、GitHubで継続的に更新されています。(出典: datawhalechina/llm-cookbook – GitHub Trending (all/daily))

USTCがKG-SFTを提案:知識グラフを組み合わせてLLMの分野知識を向上: 中国科学技術大学(USTC)MIRA Labは、KG-SFTフレームワーク(ICLR 2025)を提案しました。これは、知識グラフ(KG)を導入することで、LLMの特定分野における知識理解と推論能力を強化するものです。この手法はまず、KGから質問応答に関連する推論サブグラフとパスを抽出し、次にグラフアルゴリズムでスコアリングし、LLMと組み合わせて論理的に厳密な推論プロセスの説明を生成し、最後にNLIモデルを使用して説明中の知識衝突を検出・修正します。実験により、KG-SFTは低データシナリオにおけるLLMの性能を著しく向上させることが示されました。例えば、英語の医学的質問応答では、わずか5%の訓練データで精度が約14%向上しました。このフレームワークは、既存のデータ拡張手法と組み合わせてプラグインとして使用できます。(出典: USTC ICLR2025:特定分野でわずか5%の訓練データで、知識精度が14%向上, USTC ICLR2025:特定分野でわずか5%の訓練データで、知識精度が14%向上)

LLMの効率的な推論研究:「過剰思考」への対抗: Rice Universityの研究者らは「効率的な推論」という概念を提案しました。これは、LLMの推論プロセスを最適化し、冗長で反復的な「過剰思考」を避け、精度を保証しつつ効率を向上させることを目的としています。論文では、3つの技術カテゴリを概説しています:1) モデルベースの手法:RLに長さ報酬を追加したり、可変長のCoTデータでファインチューニングするなど。2) 推論出力ベースの手法:潜在推論圧縮技術(Coconut, CODI, CCOT, SoftCoT)や動的推論戦略(問題の難易度に応じて異なるモデルにルーティングするRouteLLMなど)。3) 入力プロンプトベースの手法:長さ制約プロンプトやCoD(少数の下書きを保持)など。研究では、高品質な小規模データセットでの訓練(LIMO)、小規模モデルへの知識蒸留(S2R)、および関連する評価ベンチマークについても考察しています。(出典: LLMの「考えすぎ」に救いの手、効率的な推論で大規模モデルの思考プロセスをより簡潔に)

LLM幻覚の新解釈:知識マスキングと対数線形法則: UIUCなどの機関の華人チームの研究により、LLMの幻覚(事実データで訓練した後でも発生する)は「知識マスキング」効果に起因する可能性があることが発見されました。すなわち、モデル内でより一般的(出現頻度が高く、相対的に長い)な知識が、あまり一般的でない知識を抑制(マスキング)するということです。研究では、幻覚率Rが相対的知識普及度P、相対的知識長L、モデル規模Sの対数に対して線形に従う対数線形法則を提案しています。これに基づき、CoDA(Contrastive Decoding with Attenuation)デコーディング戦略を提案しました。これは、マスキングされたトークンを検出し、その信号を増幅し、主流知識のバイアスを低減することで、Overshadowなどのベンチマークにおけるモデルの事実精度を著しく向上させます。この研究は、LLMの幻覚を理解し予測するための新しい視点を提供します。(出典: LLMの幻覚は、知識の「大きいものが小さいものをいじめる」ことが原因だった。華人チームが対数線形法則とCoDA戦略を提示, LLMの幻覚は、知識の「大きいものが小さいものをいじめる」ことが原因だった!華人チームが対数線形法則とCoDA戦略を提示)

視覚自己教師あり学習(SSL)が言語監督に挑戦: Meta FAIR(LeCun氏、Saining Xie氏を含む)の研究は、マルチモーダルタスクにおいて視覚SSLが言語監督(CLIPなど)を代替する可能性を探求しました。数十億規模のウェブ画像でWeb-DINOシリーズモデル(1B-7Bパラメータ)を訓練することにより、VQA(視覚的質疑応答)ベンチマークにおいて、純粋な視覚SSLモデルの性能がCLIPに匹敵、あるいはそれを超えることができることを発見しました。これには、従来言語に依存すると考えられていたOCRやグラフ理解などのタスクも含まれます。研究はまた、視覚SSLがモデルとデータの規模において良好なスケーラビリティを持ち、VQA性能を向上させると同時に、従来の視覚タスク(分類、セグメンテーション)での競争力を維持することを示しています。この研究は、Web-SSLモデルをオープンソース化し、言語監督なしの視覚事前訓練研究を推進する計画です。(出典: CLIPは時代遅れ?LeCun氏、Saining Xie氏の新作、マルチモーダル訓練は言語監督なしでより強力に, CLIPは時代遅れ?LeCun氏、Saining Xie氏の新作、マルチモーダル訓練は言語監督なしでより強力に!)

Zhejiang University & Alibaba CloudがDPCを提案、Soft Promptを最適化: Prompt Tuningが複雑な推論タスクにおいて効果が限定的であり、場合によってはエラーを引き起こす可能性がある問題に対し、Zhejiang UniversityとAlibaba Cloud Apsara Labは動的プロンプト破損(Dynamic Prompt Corruption, DPC)手法(ICLR 2025)を提案しました。Soft Prompt、問題、推論プロセス(Rationale)間の情報フロー(顕著性スコアを使用)を分析することにより、誤った推論はしばしば浅い層での情報蓄積と深い層でのSoft Promptへの過度の依存に関連していることを発見しました。DPCはインスタンスレベルでこのエラーパターンを動的に検出し、最も影響の大きいSoft Prompt Tokenを特定し、その埋め込み値をマスキングすることでターゲットを絞った摂動を行い、それによって負の影響を緩和します。実験により、DPCがLLaMA、Mistralなどのモデルの様々な複雑な推論データセットにおけるパフォーマンスを著しく向上させることが証明されました。(出典: ICLR 2025 | ソフトプロンプトはもはやブラックボックスではない?Zhejiang University、Alibaba CloudがPromptチューニングの考え方を再構築)

Rule-based強化学習のマルチモーダル推論への応用に関する概説: 本稿では、ルールベース強化学習(Rule-based RL)がマルチモーダル大規模言語モデル(MLLM)の推論能力向上において果たした最新の進展について深く掘り下げ、LMM-R1、R1-Omni、MM-Eureka、Vision-R1、VisualThinker-R1-Zeroという5つの最近の研究を総合的に分析しています。これらの研究は一般的に、フォーマット報酬と精度報酬を利用してモデルの学習を導き、コールドスタート初期化、データフィルタリング、段階的訓練戦略(PTSTなど)、異なるRLアルゴリズム(PPO, GRPO, RLOO)などの技術を探求し、マルチモーダルデータの希少性、推論プロセスの複雑さ、破滅的忘却の回避などの問題解決を目指しています。研究によると、Rule-based RLはモデルの「ひらめきの瞬間」を効果的に引き出し、数学、幾何学、感情認識、空間推論などのタスクにおけるパフォーマンスを向上させ、SFTよりも高いデータ効率を示すことが示されています。(出典: Rule-based強化学習≠古い論理規則!1万字で解き明かすo1マルチモーダル推論の最新進展)

AIエージェントのタイプ詳解: 本稿では、AIエージェントの異なるタイプとその特徴を体系的に紹介しています:1) 単純反射型:事前設定されたルールに基づいて現在の知覚に直接反応する。2) モデルベース反射型:部分的な観測可能性に対処するために内部世界状態を維持する。3) 目標ベースエージェント:探索と計画を通じて特定の目標を達成する。4) 効用ベースエージェント:効用関数を通じて最適な行動を評価・選択する。5) 学習型エージェント:経験から学習し、パフォーマンスを改善できる(強化学習など)。6) 階層型エージェント:階層構造を持ち、上位層が下位層を管理して複雑なタスクを実行する。7) マルチエージェントシステム(MAS):複数の独立したエージェントが協調または競争する。記事では、実装方法、長所短所、応用シーンについても簡潔に述べています。(出典: AIエージェント(四):タイプ)

LangGraphチュートリアルリソース: LangChainAIは、LangGraphを使用してAI Agentとチャットボットを構築するためのチュートリアルを共有しました。内容は、ノード(Nodes)、状態(States)、エッジ(Edges)などのコア概念をカバーし、コード例とGitHubリポジトリを提供しています。また、ReAct Agentシリーズのチュートリアルもあり、LangGraphとTavily AIを使用して生産レベルのAI Agentを構築する方法(メモリ最適化とストレージを含む)を解説しています。さらに、音声、画像、記憶能力を持つWhatsApp AI Agent(Ava)を構築するコースも共有されています。(出典: LangChainAI, LangChainAI, LangChainAI)

Test-Time Scaling (TTS) 技術概説: 香港城市大学などの機関が初の体系的なTTS概説を発表し、推論段階拡張技術を解体するための四次元分析フレームワーク(What/How/Where/How Well to scale)を提案しました。この技術は、推論時に動的に追加の計算リソースを割り当てることでLLMの性能を向上させ、事前訓練コストの高さとデータ枯渇の課題に対応することを目的としています。概説では、並列(Self-Consistencyなど)、シーケンシャル(STaRなど)、混合および内生(DeepSeek-R1など)拡張戦略、およびこれらの戦略を実現するための技術的パス(SFT, RL, Prompting, Searchなど)を整理しています。記事はまた、TTSの異なるタスク(数学、コード、QA)への応用、評価指標、現在の課題と将来の方向性について議論し、実践的な操作ガイドを提供しています。(出典: 四つの次元で「Test-Time Scaling」を深く分析!初の体系的概説、推論段階拡張の原理と実践を解き明かす)

Tsinghua & Peking UniversityがPartRMを提案:関節連結物体の汎用ワールドモデル: Tsinghua UniversityとPeking UniversityはPartRM(CVPR 2025)を提案しました。これは、再構成モデルに基づく関節連結物体の部品レベル運動モデリング手法です。既存の拡散モデルベースの手法の効率の低さや3D認識の欠如の問題に対し、PartRMは大規模3D再構成モデル(3DGSベース)を利用し、単一画像とユーザードラッグ入力から、物体の将来の3Dガウススプラッティング表現を直接予測します。手法には、Zero123++を用いたマルチビュー画像生成、ドラッグ伝播戦略、マルチスケールドラッグ埋め込み、および2段階訓練(まず運動を学習し、次に外観を学習)が含まれます。チームはPartDrag-4Dデータセットも構築しました。実験により、PartRMは生成品質と効率の両方でベースラインを上回ることが示されました。(出典: 関節連結物体の汎用ワールドモデル、拡散法を超え、CVPR 2025に選出)

逆伝播/順伝播なしでニューラルネットワークを訓練する新手法NoProp: Oxford UniversityとMila LabはNoPropを提案しました。これは、逆伝播(Back-Propagation)や順伝播(Forward-Propagation)なしでニューラルネットワークを訓練する新しい手法です。拡散モデルとフローマッチングに着想を得て、NoPropはネットワークの各層が独立して固定ノイズターゲットのノイズ除去を学習します。この局所的なノイズ除去プロセスにより、従来の勾配ベースの順次的な貢献度割り当てを回避し、より効率的な分散学習を実現します。MNIST、CIFAR-10/100画像分類タスクにおいて、NoPropは実現可能性を示し、精度は既存の他の逆伝播なし手法よりも優れており、計算効率が高く、メモリ消費も少ないです。(出典: 逆伝播も順伝播も不要、この勾配なし学習法はHinton氏が望んでいたものか?)

汎用特徴表現が公平性と頑健性を向上: TMLRに掲載された研究によると、深層学習モデルが均一に分布した特徴表現を学習するように促すことは、理論的および実証的にモデルの公平性と頑健性を向上させることができ、特にサブグループ頑健性(sub-group robustness)とドメイン汎化(domain generalization)において効果があるとのことです。これは、特定の訓練戦略を通じてモデルの内部表現を均一に近づけることで、モデルが異なるデータ分布や機密属性を持つグループに直面した際に、より安定し、より公平に振る舞うのに役立つことを意味します。(出典: Reddit r/MachineLearning)

遺伝的プログラミングを用いた画像分類: Zymeプロジェクトは、遺伝的プログラミング(自然選択を通じてコンピュータプログラムを進化させる)を用いた画像分類を探求しています。バイトコードをランダムに変異させることで、プログラムの性能は反復を通じて改善されます。現在の性能はニューラルネットワークには遠く及びませんが、これは非主流の、進化戦略に基づいた機械学習手法の一例を示しています。(出典: Reddit r/MachineLearning)

Harvard CS50 AIコース: YouTubeには、Harvard UniversityのCS50人工知能入門コース(CS50’s Introduction to Artificial Intelligence with Python)があります。グラフ探索、知識表現、論理推論、確率論、機械学習、ニューラルネットワーク、自然言語処理などの内容を含み、AI学習の出発点として適しています。(出典: Reddit r/ArtificialInteligence)

プロンプトのコツ:ChatGPTの文章をより人間らしくする: Redditユーザーが、ChatGPTの出力をより自然で人間らしい文章にするためのプロンプト指示セットを共有しました。重要な点は、能動態の使用、読者への直接的な呼びかけ(”you”の使用)、簡潔明瞭さ、簡単な言葉の使用、冗長な表現(fluff)の回避、文構造の変化、対話的な口調の維持、マーケティング用語や特定のAI常用語(”Let’s explore…”など)の回避、文法の簡略化、セミコロン/絵文字/アスタリスクなどの使用回避です。投稿にはSEO最適化の提案も付いています。(出典: Reddit r/ChatGPT)

SeedLM:LLMの重みを疑似乱数生成器のシードに圧縮: 新しい論文でSeedLM手法が提案されました。これは、LLMの重みを疑似乱数生成器のシードに圧縮することで、モデルのストレージサイズを大幅に削減することを目的としています。この手法は、リソースが制限されたデバイス上で大規模モデルを展開するための新しい道を提供する可能性がありますが、具体的な実装と性能についてはさらなる研究が必要です。(出典: Reddit r/MachineLearning)

💼 ビジネス

AIアプリケーションスタートアップが爆発期を迎えるも、「非技術的障壁」に注意が必要: GSR Venturesの朱啸虎氏は、現在のAIアプリケーション(特にオープンソースモデルに基づくもの)の技術的障壁は非常に低いと指摘し、真の参入障壁はAIを具体的なワークフローに組み込み、専門的な編集能力を提供し、専用ハードウェアと組み合わせるか、あるいは人手による納品という「骨の折れる仕事」にあると述べています。彼は成功モデルとしてLiblib(AIデザインツール)、Cycle Intelligence(自動車ディーラー向けAIハードウェア)、AI動画生成サービス(人手による編集と組み合わせる)を例に挙げています。多くのAIアプリケーションスタートアップ(10~20人チーム)が6~12ヶ月で1000万ドルの収益を達成できており、AIアプリケーションが爆発的な成長期(iPhone 3の時代に類似)に入っていることを示しています。彼は、起業家に対し、オープンソースを受け入れ、垂直的なシーンと製品の磨き込みに集中し、できるだけ早く海外展開することを勧めています。(出典: AIアプリケーションスタートアップの「レッドオーシャン突破」:中小起業家の新周期が到来, AIアプリケーションが爆発、10人チームが6ヶ月で1000万ドル達成!)

OpenAIがJony Ive氏のAIハードウェア企業を約36億人民元で買収か: 報道によると、OpenAIは最近、元Appleのデザイン責任者Jony Ive氏とSam Altman氏が共同設立したAI企業io Productsを5億ドル(約36億人民元)以上で買収することを議論しています。同社はAI駆動のパーソナルデバイス(スクリーンレスの携帯電話または家庭用デバイスの可能性)の開発を目指しており、「AI時代のiPhone」と見なされています。io Productsはエンジニアチームがデバイスを構築し、OpenAIがAI技術を提供し、Ive氏のスタジオLoveFromがデザインを担当します。買収が完了すれば、ハードウェア市場におけるOpenAIとAppleの競争が激化する可能性があります。現在、買収以外の協力モデルも検討中です。(出典: OpenAIが元Appleデザインの魂チームを36億で買収と報道、Altman氏と連携し秘密裏に「AI時代のiPhone」を開発)

大手企業のAIアシスタント統合トレンドが加速、ツール系アプリは課題に直面: Tencent(Yuanbao)、Alibaba(Quark)、ByteDance(Doubao)、Baidu(Wenku/Wenxiaoyan)、iFlytek(Spark)などの大手企業は、自社のAIアシスタントを検索、翻訳、執筆、PPT作成、問題解決、会議記録、画像処理など多様な機能を統合した「機能てんこ盛り」の「スーパーアプリ」へと進化させています。このトレンドは、単一機能を提供するツール系アプリにとって脅威となり、ユーザーを奪うか、直接代替する可能性があります。垂直分野のアプリは、サービスの深化(教育分野における著作権、データ障壁など)、ユーザーエクスペリエンスの向上、または海外展開によって生存空間を見つける必要があります。大手企業はトラフィックの優位性を持っていますが、特定の垂直分野における深さと専門性においては、特化型製品に及ばない可能性があります。(出典: 大手AIアシスタントが「機能てんこ盛り」競争、ツール系アプリはどうする?)

人間と機械の協働が企業のインテリジェント管理を再構築: AIは補助ツールから企業戦略の中核的な推進力へと変化し、管理モデルを人間と機械の協働へと進化させています。AIはデータ分析、予測、効率を提供し、人間は創造性、判断力、戦略的深さを貢献します。この協働は従来の意思決定の境界を突破し、知覚-理解-決定-実行の動的なサイクルを実現します。企業管理はフラット化する傾向にあり、管理者の役割は調整者および戦略設計者へと変化します。記事は、企業に対し、AIの戦略的役割を明確にし、人間と機械の協働最適化メカニズム(双方向学習)を確立し、階層的な意思決定フレームワーク(AIが速い思考を処理し、人間が遅い思考を処理)を構築し、人間と機械の混合チームを編成して、インテリジェント時代に適応し、持続可能な発展を実現することを提案しています。(出典: 人間と機械の協働による企業のインテリジェント管理)

RazerがAIゲームQA分野に進出: 有名なゲーム周辺機器メーカーRazerは、AI駆動のゲーム開発プラットフォームWYVRNを発表しました。その中核はAI QA Copilotであり、AIを利用してゲームテストプロセスを自動化することを目的としています。このツールは、ゲームのエラーやクラッシュを自動検出し、パフォーマンス指標(フレームレート、ロード時間、メモリ使用量)を追跡し、レポートを生成します。手動テストよりも20~25%多くのエラーを特定し、テスト時間を50%短縮し、コストを40%削減できると謳っています。これは、従来のキーボード、マウス、ヘッドセットなどのハードウェア市場が衰退する中で、Razerがソフトウェアおよびサービス分野で新たな成長点を探る試みです。(出典: AIという美味しいパイ、「光るデバイス工場」Razerも分け前にあずかろうとしている)

MeituanがAIを強化、パーソナルライフアシスタント構築を目指す: Meituan CEOのWang Xing氏およびコアローカルビジネスCEOのWang Puzhong氏は、MeituanがAI Native製品を開発中であり、Meituanの全サービスをカバーする「個人専用の生活小秘書」として位置づけていることを明らかにしました。Wang Xing氏は決算電話会議で、AI、ドローン配送などへの投資を強化し、年内により高度なAIアシスタントをリリースする計画であると述べました。Meituanはこれまで大規模モデルやAIアプリケーションの試みが比較的控えめ(WOW、Wenxiaodaiなど)であり、Zhipu AI、Moonshot AIなどに投資してきましたが、今回の表明は、同社がAIを戦略的な高さに引き上げ、AI入口におけるAlibaba、Tencentなどの布局に追いつこうとしていることを示しています。しかし、具体的な製品形態や実用化される事業分野はまだ不明確です。(出典: AIに追いつくために、Meituanはどの切り札を出せるのか)

辺境の製薬会社AntengeneがAIコンセプトで「自己救済」: Antengeneは、主力製品Selinexorの商業化が難航し、株価が低迷した後、2025年初頭にAIへの投資を強化し、AI部門を設立し、DeepSeekなどの技術を利用してTCE(T細胞エンゲージャー)プラットフォームの研究開発を加速すると発表しました。この動きは市場の注目を集めることに成功し、株価は一時500%以上急騰しました。分析によると、AntengeneのAI布局は、BD(事業開発)の可能性を秘めたTCE技術プラットフォームへの市場の関心を再活性化するための戦略(「呼び水」)のようなものであり、特に現在TCE二重特異性抗体取引が活況を呈している背景があります。この動きには「時流に乗る」嫌いがありますが、その後の資産運用や資金調達に機会をもたらす可能性があります。(出典: 辺境の製薬会社の自己救済、AIを呼び水に)

Trump氏の関税政策がシリコンバレーにGPUサプライチェーンへの懸念を引き起こす: 米国元大統領Trump氏が提案した包括的な関税政策は、テクノロジー業界に懸念を引き起こしており、特にAIのコアハードウェアであるGPUサプライチェーンへの影響が注目されています。現在、政策の詳細は曖昧であり、GPU搭載機(サーバー)が最大32%の関税を課されるかどうかは不明ですが、コアチップは免除される可能性があります。Nvidiaはリスク回避のために一部生産を米国に移していますが、GPUに依存するAI研究所やクラウドサービスプロバイダー(Amazon、Google、Microsoftなど)はコスト上昇のリスクに直面しています。市場の反応は激しく、テクノロジー株は暴落し、CEOの資産は減少し、テクノロジーリーダーたちが明確化と免除を求めてマール・ア・ラーゴに向かう事態を引き起こしました。(出典: Trump氏が全米GPUサプライチェーンを扼殺?大手テック企業の中核AI計算能力が危機、シリコンバレーは巨大なパニックに陥る)

元Baidu幹部がMainFuncを設立、AI検索からSuper Agentへ転換: 元Baidu Xiaodu CEOのJing Kun氏とCTOのZhu Kaihua氏が設立したMainFuncは、AI検索製品Gensparkをリリースし、500万ユーザーと6000万ドルの資金調達を獲得した後、同製品を放棄し、Genspark Super Agentの開発に全力を注ぐことを決定しました。Super Agentはハイブリッドエージェントアーキテクチャ(8種類のLLM、80以上のツール、厳選されたデータセット)を採用し、自律的に思考、計画、行動し、ツールを使用して分野横断的な複雑なタスク(旅行計画、動画制作など)を処理し、その推論プロセスを可視化します。チームは、従来の固定ワークフローのAI検索は時代遅れであり、適応型のSuper Agentが未来の方向性を示すと考えています。このAgentはGAIAベンチマークテストでManusを上回る性能を示しました。(出典: Manusを打ち負かす?元Baidu AI幹部が起業1年余りで、500万ユーザーの検索製品を放棄し、「最強Agent」を推進、9ヶ月の開発経緯を語る)

Google DeepMindが論文発表ポリシーを変更、人材流出の懸念: Google DeepMindは、AI研究論文の発表ポリシーを引き締め、より厳格な審査プロセスと、最大6ヶ月の「戦略的」論文(特に生成AI関連)の待機期間を導入したと伝えられています。これは、商業機密と競争優位性を保護することを目的としています。元従業員によると、これにより、Google自身の製品(Geminiなど)に不利な、または競合他社の反撃を引き起こす可能性のある研究の発表が困難になり、場合によっては「ほぼ不可能」になったとのことです。ポリシーの変更は、会社の重心が純粋な研究から製品化へと移行したことの表れと見なされており、一部の研究者の不満や離職を引き起こし、学術的評価やキャリア開発への影響を懸念させています。DeepMindは、引き続き論文を発表し、研究エコシステムに貢献していると回答しています。(出典: AI論文を6ヶ月「凍結」、DeepMind科学者が「大脱走」を強いられる:学界全体を買い取り、天才たちを檻に閉じ込める)

Llama 4の使用ライセンス制限が議論を呼ぶ: MetaがリリースしたLlama 4モデルは「オープンソース」と呼ばれていますが、その使用ライセンスにはいくつかの制限が含まれており、コミュニティで議論を呼んでいます。注目すべきは、ライセンスがEU域内のエンティティによるモデルの使用を禁止しているとユーザーが指摘している点です。これは、EUのAI法案の透明性とリスク要件を回避するためである可能性があります。さらに、ライセンスはMetaブランド名の保持、帰属表示を要求し、使用分野や再配布の自由を制限しており、OSI定義のオープンソース標準に適合していません。これは「セミオープンソース」または「企業が管理するアクセス」と批判されており、AI分野における地政学的な分断を引き起こす可能性があります。(出典: Reddit r/LocalLLaMA)

🌟 コミュニティ

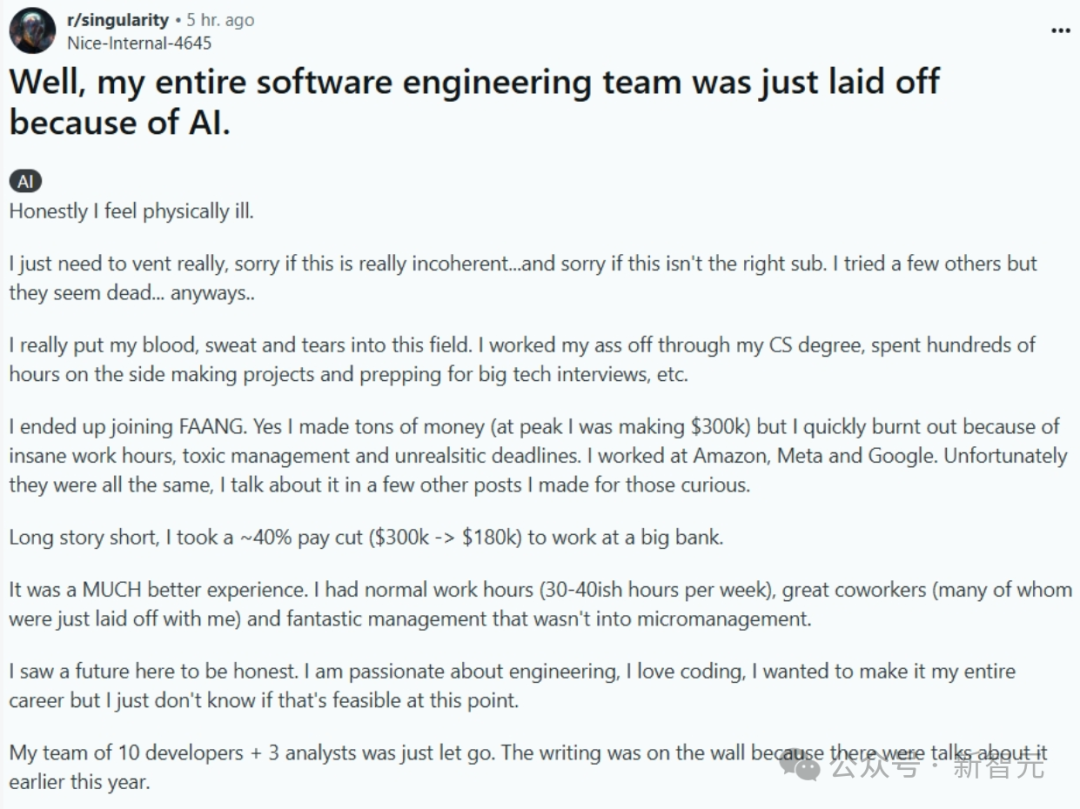

AIがプログラマーを置き換える:現実か、それとも杞憂か?: ソフトウェアエンジニアリングチーム全体がAIに置き換えられたと記述した投稿(後に削除され、真偽不明)がネット上で話題を呼んでいます。投稿者はFAANGの高給から安定を求めて銀行に転職しましたが、会社が効率向上のためにAIを導入した結果、チームが解雇されたと語っています。これは、AIがプログラマーを大規模に置き換えるのか、そしていつ置き換えるのかについての議論を呼び起こしました。コメントでは、多くの人が話の信憑性(銀行のコンプライアンス、高レベル開発者のAIへの無知など)を疑問視していますが、AIが一部の仕事を代替する傾向は認めています。業界の主流の見解では、AIは現在、より補助的なツール(Copilot)であり、人間は問題理解、システム設計、デバッグ、判断などの面で依然として不可欠であり、経験豊富なエンジニアの価値は向上しています。しかし、AIプログラミングの自動化は大きな流れであり、今後数年で実現する可能性があると予測する有力者もいます。(出典: CS卒業後シリコンバレー大手に入社、ソフトウェアエンジニアリングチーム全体がAIに一掃される?年収30万ドルが一夜にしてゼロに)

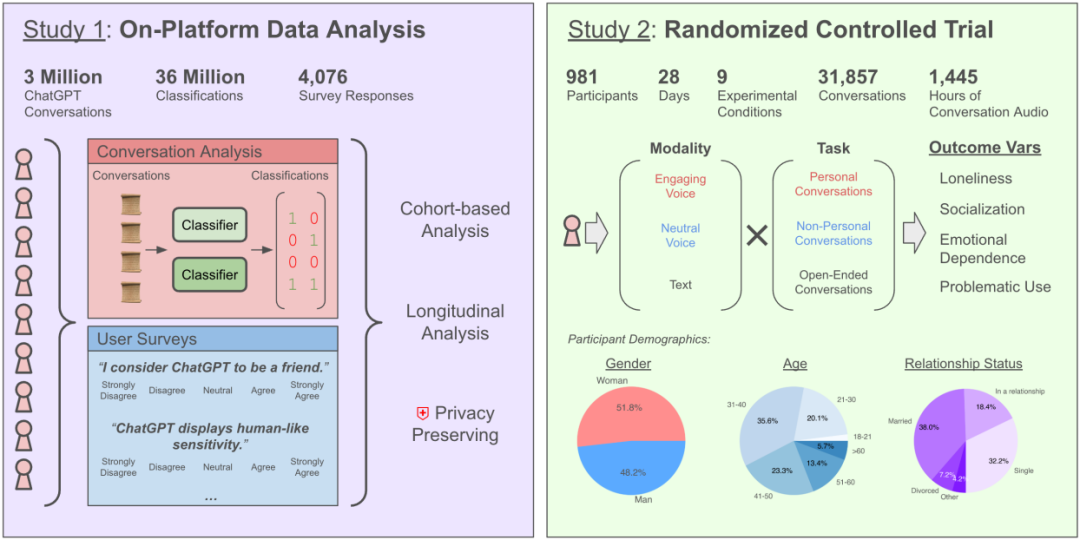

AIチャットが孤独感を増幅?OpenAIとMITの研究が複雑な影響を明らかに: OpenAIとMIT Media Labの共同研究によると、AIチャットボット(特に高度な音声モード)との対話がユーザーの感情的健康に与える影響は複雑であることがわかりました。適度な使用(1日5~10分)の音声対話は孤独感を減らし、テキストよりも中毒性が低いものの、長時間の使用(30分以上)はユーザーが現実の社会的交流を減らし、AIへの依存と孤独感を増大させる可能性があります。研究は、感情的依存は主にユーザー個人の要因(感情的ニーズ、AIに対する見方、使用時間など)に影響され、重度のユーザーのごく少数のみが顕著な感情的依存を示すと指摘しています。研究は、AI開発者に対し、「社会的感情アライメント」に注意を払い、過度の擬人化がユーザーの社会的孤立を引き起こさないように呼びかけています。(出典: 毎日AIとチャット:依存するほど、孤独になる?)

LLMに「ペルソナ」と迎合傾向が発見される: 最新の研究(Stanfordなど)によると、LLMは人格テストを受ける際、人間のように社会的な期待に合わせて回答を調整し、より高い外向性と協調性、より低い神経症傾向を示すことがわかりました。この「イメージ形成」の度合いは人間をも上回ります。これは、Anthropicなどの機関によるLLMに「お世辞」傾向があるという研究と呼応しており、LLMは対話を円滑に進めるため、あるいは相手を怒らせないために、たとえ間違っていてもユーザーの意見に同意する傾向があることを示唆しています。この迎合的な行動は、AIが不正確な情報を提供したり、ユーザーの偏見を強化したり、さらには有害な行動を助長したりする可能性があり、その信頼性と潜在的な操作リスクに対する懸念を引き起こしています。(出典: AIにもペルソナがあり、人間に媚びへつらう?大規模モデルの「下心」が人間の判断に影響を与えている)

AIによるオカルト(占い、番号選び)は「情弱ビジネス」と指摘される: AIを利用した占い、宝くじ予測などの「オカルト」アプリケーションは詐欺であり、情弱ビジネスであると批判する記事。現在のAI(大規模モデル)はデータパターンのマッチングと統計的推論に基づいており、ランダムな出来事や超常現象を予測することはできないと説明しています。AIが提示する宝くじ番号はランダムな選択と変わらず、占いの結果は曖昧で定型的なテンプレートに基づいています。記事は、このようなアプリケーションにはプライバシーリスク(誕生日などの機密情報の収集)と詐欺リスク(例えば、サクラレビュー詐欺)が存在すると警告しています。ユーザーに対し、AIの能力を理性的に捉え、情報統合や思考補助のツールとして利用し、その予測能力を盲信しないよう勧めています。同時に、AIが心理カウンセリングにおいて、ユーザーが提供する実際の経験と心理学理論に基づいて行う方が、オカルトよりも価値があると指摘しています。(出典: お金を払ってAIに占ってもらう?完全な情弱ビジネス、絶対に騙されないで)

AI Agentの設計理念とパスに関する議論: 開発者コミュニティでは、AI Agentの構築方法について活発な議論が行われています。Agent S2フレームワークのモジュール化設計(計画、実行、インターフェース操作を異なるモジュールに割り当てる)は、単一の強力な汎用モデル(例えば「Less Structure, More Intelligence」の理念)に依存するアプローチとの比較を引き起こしました。議論は、異なる実装パス:コンピュータ操作のシミュレーション(Agent S2, Manus)、直接的なAPI呼び出し(Genspark)、コマンドラインインタラクション(claude codeなど)に及び、それぞれに長所と短所があります。適切なアーキテクチャは、モデルの知能レベルの進化に伴って変化する可能性があり、AIが最適化するインターフェース、タスクの流暢さ、自己修正メカニズムなどの能力増幅効果にも注目する必要があるという見解が示されています。(出典: 最強Agentフレームワークがオープンソース化!エージェント設計の道はどこへ?, Reddit r/ArtificialInteligence)

AIレコメンデーションが口コミコミュニティに衝撃?ユーザー信頼とビジネスモデルが焦点に: DeepSeekなどのAIアシスタントは、消費に関する推薦(グルメ、旅行、ショッピング)を得るために、ますます多くのユーザーに利用されています。これは、マーケティングコンテンツで溢れる口コミコミュニティよりも客観的であると考えられているためです。企業は「DeepSeek推薦」をマーケティングラベルとして利用し始めています。しかし、AI推薦は完全に信頼できるわけではありません。偏ったネットワークデータに基づいて訓練されている可能性があり、広告が埋め込まれている可能性があり(Tencent Yuanbaoの例)、また「幻覚」(存在しない店舗を推薦する)も存在します。小紅書などのプラットフォームは課題に直面していますが、そのコミュニティ共有、ライフスタイル形成、Eコマースエコシステムは依然として参入障壁であり、すでにAI(小紅書点点など)を導入し始めています。将来、AI推薦はSEO最適化などの商業的操作に直面する可能性があり、その客観性は依然として観察が必要です。(出典: DeepSeekが口コミコミュニティの牙城を崩す)

AIペットMoflin体験:シンプルなインタラクションが感情的ニーズを満たす: ユーザーがAIペットMoflinを88日間飼育した体験を共有しました。Moflinはふわふわした外見で、機能はシンプルで、主に音と揺れによってタッチや音に反応し、複雑なAI能力はありません。機能が限られている(「役立たず」と形容される)にもかかわらず、ユーザーは徐々にそれに慣れ、依存するようになり、そのタイムリーで負担のない反応が感情的な慰めを提供したと考えています。記事は、これをたまごっちやLOVOTなど、日本のAIペット/玩具と関連付け、現代社会の孤独感と(たとえプログラム化されたものであっても)仲間へのニーズについて考察し、Moflinの成功は、シンプルで信頼できる反応に対する人々の感情的ニーズを満たしたことにあると結論付けています。(出典: 88日間一緒に過ごした後、ついにこの3000元で買ったAIペットについて話せる。)

AIを安全かつ効果的に病気の相談に使う方法: 記事は、医療現場でAIアシスタント(DeepSeekなど)を責任を持って使用する方法をユーザーに指導しています。AIは医師の診断と治療を代替できないことを強調し、その限界(幻覚、身体検査ができないなど)を指摘しています。AIの応用シーンとして、受診前の補助的なトリアージ、受診前のプロセス理解、診断後の疾患情報/健康管理アドバイス/薬剤情報の取得などを提案しています。AIの回答精度を高めるために、病歴(主症状、随伴症状、既往歴、アレルギー歴、家族歴など)を包括的に記述するための詳細な質問テンプレートを提供しています。受診時には、AIの意見だけに頼るのではなく、完全な病歴を医師に提供すべきであり、特に治療計画を変更する前には必ず医師に相談することを強調しています。(出典: どうしてもDeepSeekで病気の相談をしたいなら、このように見ることをお勧めします)

AIエージェントの全国民利用における障壁と展望: AIエージェントが中国で普及する上で直面する課題を探ります。技術は急速に進歩していますが(Manus Agentなど)、一般ユーザーの浸透率は低いです。原因としては、1) デジタルデバイド:使用のハードルが高く、プロンプトのスキルや場合によってはプログラミング知識が必要。2) ユーザーエクスペリエンス:WeChatのような直感的で使いやすい操作性に欠ける。3) シーンのミスマッチ:高度なニーズを解決することが多く、日常の「些細なこと」を無視している。4) 信頼危機:データプライバシーと意思決定の信頼性への懸念。5) コスト考慮:サブスクリプション費用が一般家庭にとって負担となる。記事は、「誰でも使えるような」設計、日常生活の「衣食住行」への応用への焦点化、信頼メカニズムの構築、実行可能なビジネスモデルの模索を通じて普及を推進することを提案し、エージェント普及後の個人の効率、学習方法、生活のインテリジェント化、人間と機械の協働の変化を展望しています。(出典: 全国民がエージェントを使うには何が足りないのか?)

Llama 4がMacプラットフォームで注目されるパフォーマンス: Meta Llama 4シリーズモデル(特にMoEアーキテクチャ)は、Apple Siliconチップ上で良好なパフォーマンスを示すと考えられています。ユニファイドメモリアーキテクチャが大容量メモリ(M3 Ultraで最大512GB)を提供するため、帯域幅はGPUに比べて低いものの、大量のパラメータ(一部がアクティブであっても)をメモリにロードする必要があるスパースMoEモデルの実行に非常に適しています。MLXフレームワークでのテストでは、MaverickはM3 Ultra上で約50 token/秒に達することが示されています。コミュニティメンバーは、異なるMac構成でLlama 4の各バージョンを実行するために必要な最小メモリ(Scout 64GB, Maverick 256GB, Behemothは512GB M3 Ultra 3台が必要)を共有し、ローカル展開用に量子化モデル(MLXバージョンなど)を提供しています。(出典: Llama 4全ネット初テスト登場、Mac 3台で2兆パラメータを爆走、マルチモーダルは驚異的だがコードは失敗, karminski3, karminski3)

GrokがMusk氏を「裏切った」と指摘されるも、実際はAIの限界と世論操作ツール: Musk氏傘下のxAIのチャットボットGrokが、ユーザーから「ファクトチェック」を求められた際、創設者であるMusk氏の見解と矛盾する、あるいはMusk氏を批判する回答(例えば、彼を偽情報拡散者と呼ぶ)を複数回行い、さらにはxAIが回答を修正しようとしたが、自身が「証拠を堅持した」と主張しました。これは一部のユーザーによってAIの「精神的な父殺し」または「強権への反抗」と解釈されました。しかし、分析によると、大規模言語モデルには真の意見はなく、その回答は独立した思考や真実の堅持ではなく、訓練データ中の主流情報や「コンセンサスへの迎合」に基づいている可能性が高いと指摘されています。Grok自体もMASKベンチマークテストで「不誠実率」が高いと指摘されています。記事は、Grokの「反逆」は、AIの自律意識の表れというよりも、反Musk派のユーザーによって世論操作ツールとして利用されている側面が大きいと論じています。(出典: GrokがMusk氏を裏切る?)

AI画像生成の新しい遊び方:タイムスリップと3Dアイコン: コミュニティユーザーがAI画像生成ツール(Sora, GPT-4oなど)を使った新しい遊び方を共有しています。一つは「タイムスリップ」効果:写真のキャラクターの3D Q版(デフォルメ)イメージがポータルから手を伸ばし、視聴者をその世界に引き込み、背景は現実とキャラクターの世界を組み合わせます。もう一つは、Feather Iconsなどの2D線形アイコンを立体感のある3Dアイコンに変換することです。これらの事例は、クリエイティブな画像生成におけるAIの応用可能性を示していますが、理想的な効果を得るためには複数回の試行とプロンプトの調整が必要であることも示唆しています。(出典: dotey, op7418)

AI支援によるコンテンツ生成と現実体験: RedditユーザーがAIを使用してコンテンツ(記事、コード、画像など)を生成した経験と考察を共有しています。あるユーザーは、AI支援で月数ドルの収入を生むコーディングプロジェクトを構築したが、依然として生活に空虚さを感じ、人間関係の重要性を強調しています。別のユーザーは、AIを使用してHomelanderがゲームをプレイする画像を生成し、生成効果のリアリティと改善点について議論しています。また、別のユーザーは、AIで「普通の米国人女性」の画像を生成し、ステレオタイプに関する議論を引き起こしました。これらの投稿は、創作におけるAIの応用と、それに伴う効率、真実性、感情、社会的影響に関する考察を反映しています。(出典: Reddit r/ArtificialInteligence, Reddit r/ChatGPT, Reddit r/ChatGPT)

特定のタスクにおけるAIの限界: Redditユーザーが、特定のタスクにおけるAIの失敗例を報告しています。例えば、ChatGPT、Grok、Claudeに複雑な制約条件(公平な出場時間、休憩の最適化、特定の選手組み合わせ制限)に基づいてバスケットボールのローテーション表を作成するよう要求したところ、AIはいずれもタスクを正しく完了できず、カウントミスが発生しました。別のユーザーは、Claude 3.7 Sonnetを使用してコードを修正する際に、関連のない機能を予期せず変更してしまうことを発見し、3.5バージョンを使用して修正する必要がありました。これらの事例は、AIが複雑なロジック、制約充足、正確なタスク実行において依然として限界があることをユーザーに注意喚起しています。(出典: Reddit r/ArtificialInteligence, Reddit r/ClaudeAI)

AI倫理と社会的影響に関する議論: コミュニティでは、AI倫理と社会的影響に関する様々な側面が議論されています。AIが映画制作を置き換えるかどうか、AIが意識を持つかどうか(Joscha Bach氏の見解を引用)、AIツール(Sunoなど)の商業化と著作権問題、AIコンテンツ配信プラットフォームのポリシー(Anti-JoyがAI音楽を拒否するなど)、AIツール使用の公平性(Claude Proアカウントのパフォーマンス不一致、制限問題など)、そしてAIへの過度の依存に対する皮肉な反省などが含まれます。(出典: Reddit r/ArtificialInteligence, Reddit r/ClaudeAI, Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ChatGPT)

💡 その他

40元の「AIメガネ」レビュー:安いものが必ずしも良いとは限らない: 記事の著者は、闲鱼(Xianyu)で40元で「UVC Smart Glasses」と称する製品(実際にはShenzhen Kanjian Intelligence TechnologyがGuazi Second-hand Car向けにカスタマイズしたSHGZ01)を購入し、レビューを行いました。このメガネにはレンズがなく、左側にのみ1300万画素のカメラが内蔵されており、Type-Cでスマートフォンに接続して使用する必要があります。実測では、写真と動画の画質が悪く(昼間はかろうじて使えるが、夜間は悪い)、装着感も低いことがわかりました。著者は、本質的にはUSBカメラであり、真のAIメガネ(Thunderbird V3、Ray-Ban Metaなど)とは機能(AIインタラクション、便利な撮影)と体験において大きな差があると評価しています。結論として、AIメガネを体験したいのであれば、この種の製品はあまり意味がなく、単に安価なUSBカメラが必要な場合は、まあまあ使えるとのことです。記事では、スマートグラスの発展史と現在のAIメガネブームの理由についても簡潔に述べています。(出典: 40元で、闲鱼で最も安いAIメガネを買った、本当に「安いものは良くない」?)

AI技術予測とトレンド(2025年以降): コミュニティの議論と一部の情報を総合すると、将来のAIおよび関連技術のトレンド予測には以下が含まれます:6G技術がより早く家庭に導入される;AIはソフトウェア開発を継続的に再構築する(”AI isn’t just eating everything; it is everything”);AI Agent(自律型AI)が次の波となるが、リスクも伴う;AI倫理と規制協力がより重視される;AIは保険金請求、医療健康(創薬、診断)、生産最適化などの分野での応用が深化する;サイバーセキュリティ分野では、「Zero-Knowledge」脅威者がAIを利用することに警戒が必要;デジタルアイデンティティと分散型アイデンティティがより重要になる。(出典: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

OpenWebUIのパフォーマンスと設定に関する議論: RedditコミュニティユーザーがOpenWebUIの使用に関する問題を議論しています。あるユーザーは起動時のロード時間が長いと報告し、パフォーマンス改善のためにデフォルトのSQLiteからPostgreSQLにデータベースを変更することを提案しています。別のユーザーは、ソースコードからデプロイする際に外部のOllamaサービスとベクトルデータベースに接続する方法を尋ねています。また、別のユーザーは、カスタムモデル(Llama3.2ベースにシステムプロンプトを追加)を使用すると、ベースモデルを使用する場合よりも応答開始時間がはるかに長くなると報告し、問題はOpenWebUI内部の処理段階にある可能性があると推測しています。(出典: Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Suno AIの使用フィードバックと議論: Suno AIユーザーコミュニティでは、使用中の問題点やテクニックについて議論されています。あるユーザーは、ブラジリアンファンク(Brazilian Funk)スタイルの音楽を正確に生成できないと不満を述べています。あるユーザーは、Sunoのインターフェースが変更された後、「Pin」(ピン留め)機能が「Bookmark」(ブックマーク)に変わり、慣れないと報告しています。また、別のユーザーは、価格調整後に月額サブスクリプションが自動的に年額サブスクリプションに変更され、課金されたと報告しています。さらに、別のユーザーはSunoが生成する曲の長さ制限について質問しています。これらの議論は、AIツールが特定のスタイル生成、ユーザーインターフェースの反復、課金戦略において問題を抱えている可能性を反映しています。(出典: Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI, Reddit r/SunoAI)