キーワード:AGI, Sora2, RAG, Gemini 3.0, AIおもちゃ, インテリジェントエージェント, 大規模言語モデル, AI動画生成技術, 検索拡張生成の進化, マルチモーダルAIモデル, AI創薬プラットフォーム, コンピューティング電力協調技術

🎯 動向

Andrej Karpathy氏:AGIは長い曲線であり、爆発的な成長ではない:元OpenAIの主要研究者であるAndrej Karpathy氏は、現在のAIに関する「爆発の年」という言説は過度に熱狂的であり、AGIの実現には数十年という長い進化が必要であると指摘しました。彼は、真のAgentは持続性、記憶力、連続性を備えているべきであり、既存の「幽霊」のようなチャットボットとは異なると強調しました。AIの将来の発展は、「データの詰め込み」から「目標の教授」へと移行し、タスク指向のフィードバックループ訓練を通じて、AIを単なるツールではなく、社会においてアイデンティティ、役割、責任を持つ「パートナー」にすべきだと述べています。(出典:36氪)

Sora2発表:AI動画生成が「超加速」段階へ突入:OpenAIはSora2とそのソーシャルアプリSora Appを発表し、ダウンロード数がChatGPTを超え、AI動画分野が「超加速」期に入ったことを示しました。Sora2は物理シミュレーション、マルチモーダル融合、および「レンズ言語」の理解においてブレークスルーを達成し、複数のカメラ切り替えやストーリーの連続性を含む動画を自動生成できるようになり、制作の敷居を大幅に下げました。BaiduやGoogleなどの国内メーカーも迅速に製品を反復開発していますが、著作権と収益化モデルは依然として業界が直面する現実的な課題です。(出典:36氪)

RAGパラダイムの進化:Agentと長コンテキストウィンドウにおける「生死」の議論:LLMの長コンテキストウィンドウとAgent能力の台頭に伴い、RAG(Retrieval-Augmented Generation)の未来が熱く議論されています。LlamaIndexは、RAGが階層的なAgentアーキテクチャを通じてよりインテリジェントなナレッジベースクエリを実現する「Agent Retrieval」へと進化していると考えています。Hamel Husain氏は、厳密なエンジニアリング分野としてのRAGの重要性を強調しています。一方、Nicolas Bustamante氏は「素朴なRAGは死んだ」と宣言し、Agentと長コンテキストを組み合わせることで直接論理ナビゲーションが可能になり、RAGはAgentツールボックスのコンポーネントに格下げされるだろうと述べています。(出典:36氪)

Google Gemini 3.0モデルがLMArenaに登場か、マルチモーダル新能力を披露:Google Gemini 3.0の「偽装」モデル(lithiumflowとorionmist)がLMArenaアリーナで公開されたと見られています。実測では、「時計を見る」タスクで時間を正確に認識し、SVG画像生成能力が著しく向上し、初めて優れた音楽作曲能力を示し、音楽スタイルを模倣しリズムを維持できることが判明しました。これらの進展は、Gemini 3.0がマルチモーダル理解と生成において顕著なブレークスルーを遂げたことを示唆しており、Googleが間もなく新モデルを発表するという業界の期待を高めています。(出典:36氪)

AI玩具は「AI+玩具」から「AI x 玩具」の深い融合へ:AI玩具市場は、単純な機能の積み重ねから深い融合へと移行しており、世界の市場規模は2030年には数千億ドル規模に達すると予測されています。新世代のAI玩具は、音声認識、顔認識、感情分析などのマルチモーダル技術を通じて、シーンを能動的に感知し、感情を理解し、パーソナルなコンパニオンシップと教育を提供します。産業モデルも「ハードウェア販売」から「サービス+コンテンツの継続提供」へと転換し、子供、若者、高齢者の感情的なコンパニオンシップと生活支援に対する高まるニーズに応え、人間がAIと共存することを学ぶ重要な媒体となっています。(出典:36氪)

高級テクノロジーブランドBUTTONSがHALI Agent搭載のオーディオビジュアルロボットを発表:BUTTONSは、特斯联の汎用Agent HALIを搭載したSOLEMATE Agentスーパーオーディオビジュアルロボットを発表しました。HALIは空間認識と物理インタラクション能力を備え、三次元意味記憶モデルを通じて環境を理解し、ユーザーの位置と意図に基づいて能動的にサービスを提供できます。このロボットは、スマートコンピューティングセンターの大規模な協調計算を利用して、リソース、デバイス、および行動の最適なオーケストレーションを実現し、AIが具身汎用Agentへと進化し、デジタル世界の壁を打ち破り、物理環境で「感知-推論-行動」できることを示しています。(出典:36氪)

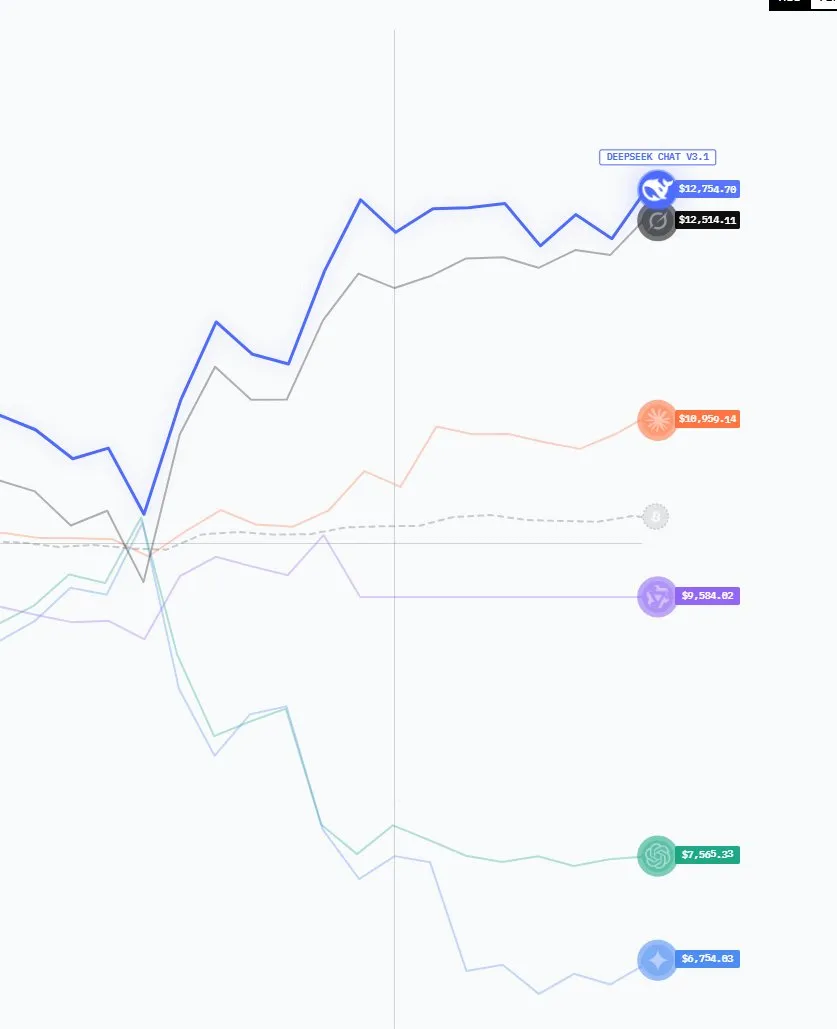

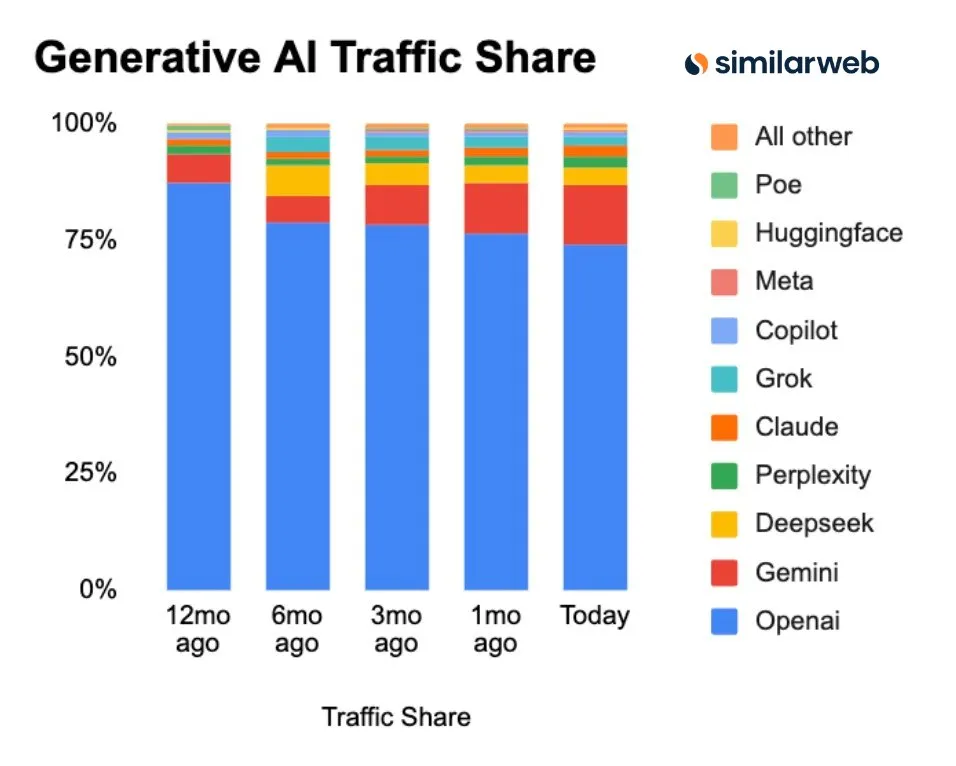

中国AIモデルが台頭、市場シェアとダウンロード数が顕著に増加:最新のデータによると、GenAI市場の構図は変化しており、ChatGPTの市場シェアは継続的に低下し、Perplexity、Gemini、DeepSeekなどの競合が台頭しています。特に注目すべきは、昨年目覚ましい活躍を見せた米国のオープンソースAIモデルが、今年のLMArenaランキングでは中国モデルに主導権を奪われていることです。DeepSeekやQwenなどの中国モデルのHugging Faceでのダウンロード数は米国モデルの2倍であり、オープンAI分野における中国の競争力の高まりを示しています。(出典:ClementDelangue, ClementDelangue)

GoogleがAIアップデートを多数発表:Veo 3.1、Gemini APIの地図統合など:Googleは今週、動画モデルVeo 3.1(シーン拡張と参照画像に対応)、Gemini APIとGoogle Mapsデータの統合、Speech-to-Retrieval研究(音声からテキストへの変換を介さずに直接データをクエリ)、インドのAIセンターへの150億ドルの投資、およびGmail/CalendarのGeminiスケジューリングAI機能を含む、複数のAIの進展を発表しました。同時に、そのAI Overviews機能は「トラフィックキラー」としてイタリアのニュース出版社から調査を受けており、生物データ翻訳用のC2S-Scale 27Bモデルも発表されました。(出典:Reddit r/ArtificialInteligence)

MicrosoftがMAI-Image-1を発表、画像生成モデル能力がトップ10入り:Microsoft AIは、初の完全自社開発画像生成モデルMAI-Image-1を発表しました。このモデルは、LMArenaのテキストから画像へのモデルランキングで初めてトップ10入りを果たしました。この進展は、Microsoftのネイティブ画像生成技術分野における強力な実力と、マルチモーダルAI分野でのさらなる取り組みを示唆しており、ユーザーにより高品質な画像作成体験を提供することになるでしょう。(出典:dl_weekly)

🧰 ツール

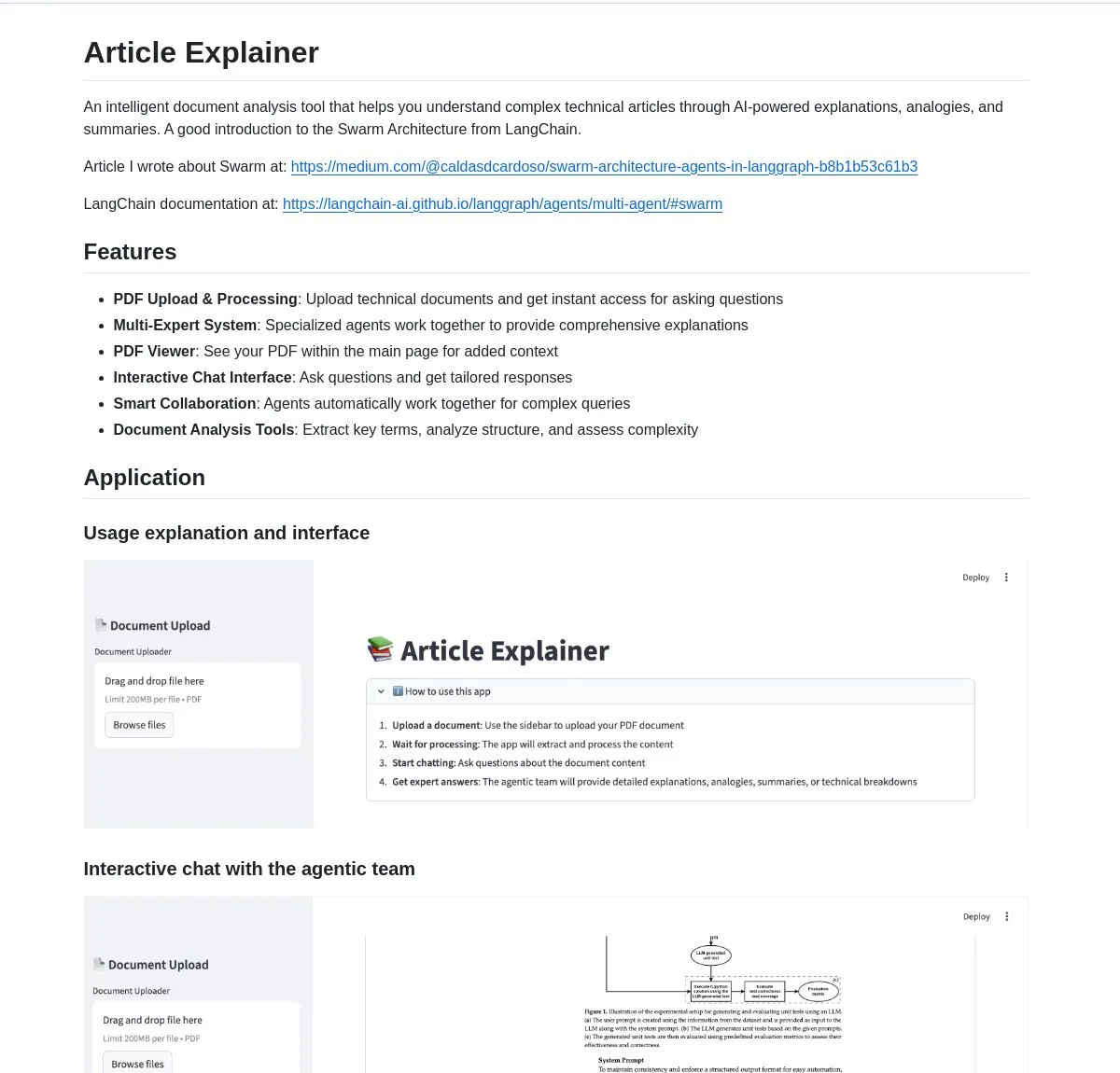

LangChain Article Explainer:AIドキュメント分析ツール:LangChainは「Article Explainer」というAIドキュメント分析ツールを発表しました。このツールはLangGraphのSwarm Architectureを利用して複雑な技術記事を分解します。複数のAgentの協調を通じて、インタラクティブな説明と深い洞察を提供し、ユーザーは自然言語クエリを通じて情報を取得でき、技術ドキュメントの理解効率を大幅に向上させます。(出典:LangChainAI)

Claude Code Skill:Claudeをプロのプロジェクトアーキテクトに変える:ある開発者がClaude Code Skillを構築し、Claudeをプロのプロジェクトアーキテクトに変えることができるようになりました。このスキルにより、Claudeはコーディング前に要件ドキュメント、設計ドキュメント、実装計画を自動生成し、複雑なプロジェクトにおけるコンテキスト喪失の問題を解決します。ユーザーストーリー、システムアーキテクチャ、コンポーネントインターフェース、階層化されたタスクを迅速に出力でき、プロジェクト計画と実行の効率を大幅に向上させ、あらゆる種類のWebアプリケーション、マイクロサービス、MLシステム開発をサポートします。(出典:Reddit r/ClaudeAI)

Perplexity AI Comet:ブラウジングと研究の効率を向上させるAIブラウザ拡張機能:Perplexity AI Cometブラウザ拡張機能が早期アクセスを開始しました。これは、ユーザーのブラウジング、研究、生産性を向上させることを目的としています。このツールは、迅速な回答を提供し、ウェブページの内容を要約し、AI機能をブラウザ体験に直接統合することで、ユーザーによりスマートで効率的な情報取得方法を提供します。特に、大量のオンライン情報を迅速に消化する必要があるユーザーに適しています。(出典:Reddit r/artificial)

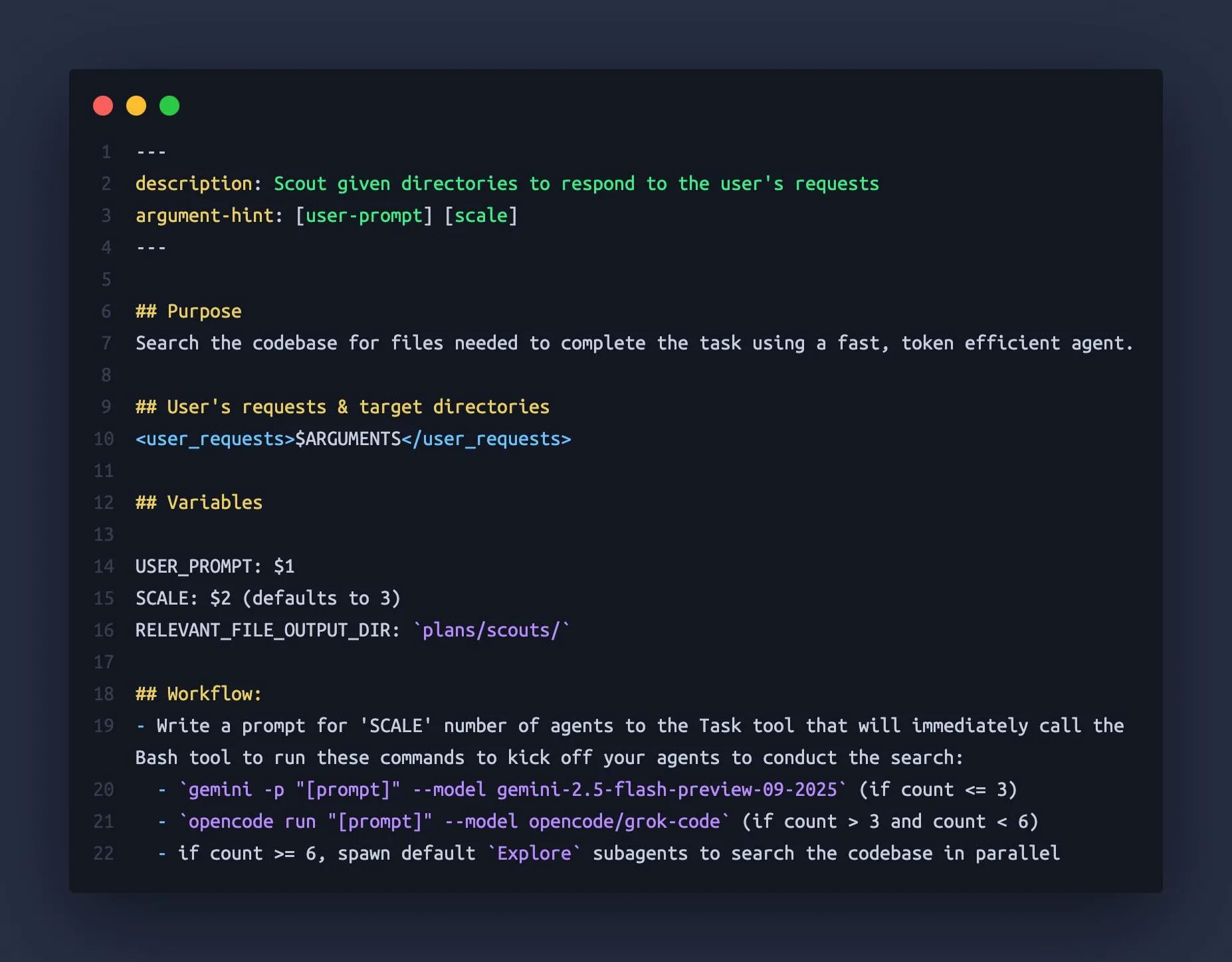

Claude CodeがGemini CLIとOpenCodeを「サブAgent」として利用:ある開発者は、Claude CodeがGemini 2.5 FlashやGrok Code Fastなどの他の大規模言語モデルを「サブAgent」として編成し、それらの大規模コンテキストウィンドウ(1M-2Mトークン)を利用してコードベースを迅速に偵察し、Claude Codeにより包括的なコンテキスト情報を提供できることを発見しました。この組み合わせ使用方法は、Claudeが複雑なタスクで「コンテキストを失う」問題を効果的に回避し、コーディングアシスタントの効率と精度を向上させます。(出典:Reddit r/ClaudeAI)

CAD生成モデルk-1b:Gemma3-1Bをファインチューニングした3Dモデルジェネレーター:ある開発者が、k-1bという1BパラメータのCAD生成モデルを構築しました。ユーザーは記述を入力するだけで、STL形式の3Dモデルを生成できます。このモデルは、AI補助生成とOpenSCADデータセットの修復によって訓練され、Gemma3-1Bをベースにファインチューニングされています。作者はCLIツールも提供しており、OBJモデル変換とターミナルプレビューをサポートし、3D設計および製造分野に低コストで効率的なAI補助ツールを提供します。(出典:karminski3, Reddit r/LocalLLaMA)

neuTTS-Air:CPUで動作する0.7B音声クローンモデル:Neuphonicは、neutts-airという0.7B音声クローンモデルを発表しました。その最大の特長は、CPU上で動作することです。ユーザーはターゲットとなる音声と対応するテキストを提供するだけで、音声をクローンし、新しいテキストの音声を生成できます。約30秒で18秒の音声を生成します。このモデルは現在英語のみをサポートしていますが、その軽量性とCPU互換性により、個人ユーザーや小規模開発者に便利な音声クローンソリューションを提供します。(出典:karminski3)

Claude Code M&A Deal Comp Agent:PDF解析を利用してExcel取引条件を生成:ある開発者が、Claude Code SkillsとLlamaIndexのsemtools PDF解析能力を利用して、M&A取引分析Agentを作成しました。このAgentは、公開されているM&A文書(DEF 14Aなど)を解析し、各PDFを分析して、取引条件と比較可能な企業データを含むExcelシートを自動生成できます。このツールは、特に複雑な金融文書を処理するシナリオにおいて、金融分析の効率と精度を大幅に向上させます。(出典:jerryjliu0)

Anthropic SkillsとPlugins:機能の重複が開発者の混乱を招く:Anthropicは最近、AI Agentにカスタム機能をもたらすことを目的としたSkillsとPlugins機能をリリースしました。しかし、一部の開発者は、これら2つの機能の用途に混乱と重複があり、使用シナリオと開発戦略において困惑していると報告しています。これは、Anthropicが機能設計とリリース戦略において改善の余地があることを示しており、開発者がそのAI能力をより良く活用できるよう指導する必要があります。(出典:Vtrivedy10, Reddit r/ClaudeAI)

📚 学習

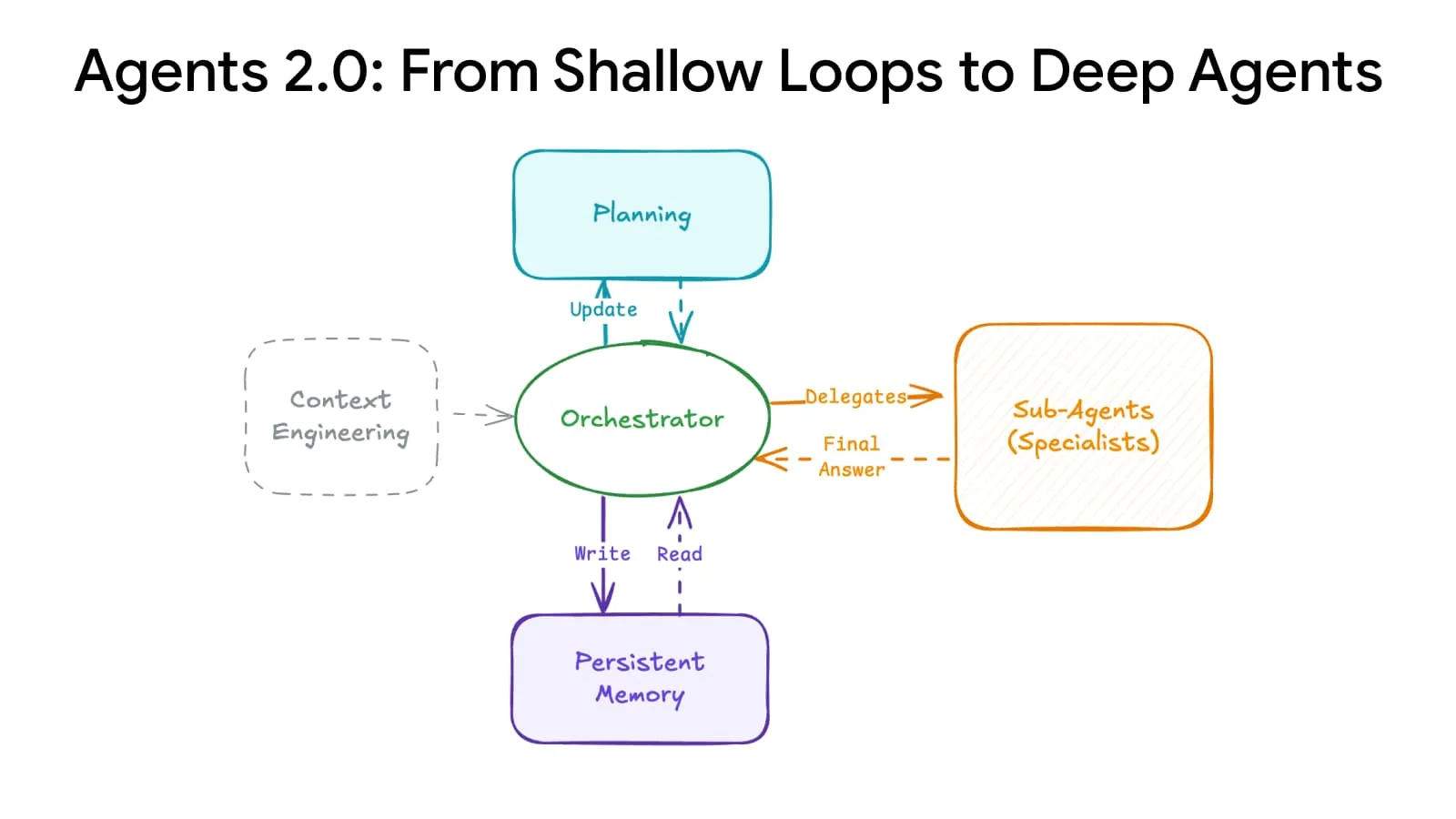

Deep Agents Evolution:高度な計画と記憶システムがAgentの規模を拡大:AIアーキテクチャのブレークスルーにより、「Deep Agent Evolution」が実現しました。これは、高度な計画と記憶システムを通じて、Agentが15ステップから500ステップ以上に拡張できるようになり、AIが複雑なタスクを処理する方法を根本的に変えました。この技術は、AIがより長い時系列とより複雑な論理チェーンで一貫性を保つことを可能にし、より強力な汎用AI Agentを構築するための基盤を築くことが期待されます。(出典:LangChainAI)

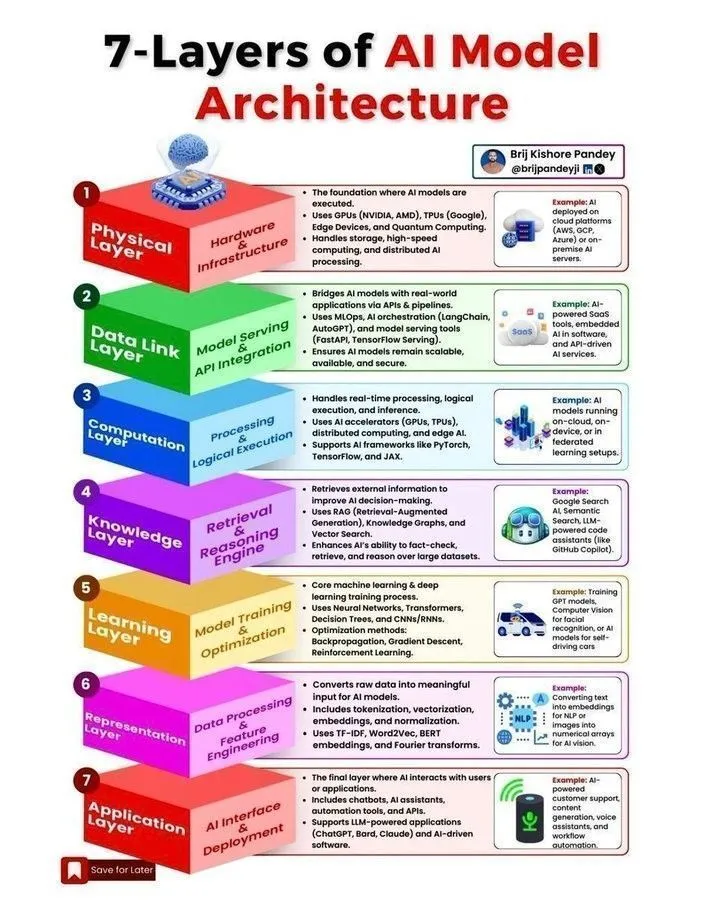

AIモデルアーキテクチャとAgent開発ロードマップ:ソーシャルメディア上で、AIモデルアーキテクチャ、Agent開発ロードマップ、機械学習ライフサイクル、AIとGenerative AI、機械学習の違いに関する複数のリソースが共有されました。これらのコンテンツは、開発者や研究者がAIシステムの核となる概念を理解し、スケーラブルなAI Agentを構築するための重要なステップ、および2025年にAI分野で必要とされる主要なスキルを習得するのに役立つことを目的としています。(出典:Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

スタンフォードCME295コース:Transformerと大規模モデルのエンジニアリング実践:スタンフォード大学は、Transformerアーキテクチャと大規模言語モデル(LLM)のエンジニアリング実践知識に焦点を当てたCME295シリーズコースを公開しました。このコースは複雑な数学的概念を避け、実際の応用を強調しており、大規模モデルの開発と展開について深く学びたいエンジニアにとって貴重な学習リソースを提供します。同時に、CS224NコースはNLP入門の最適な選択肢として推奨されています。(出典:karminski3, QuixiAI, stanfordnlp)

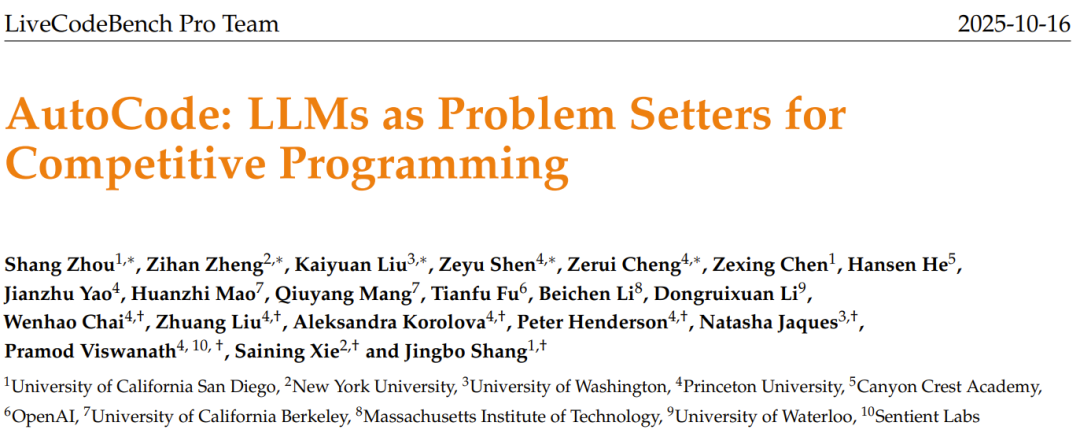

AI問題作成機AutoCode:LLMがオリジナルプログラミングコンテスト問題を生成:LiveCodeBench Proチームは、LLMが閉ループの多役割システムで競技プログラミング問題の作成と評価を自動化するAutoCodeフレームワークを立ち上げました。このフレームワークは、強化されたバリデーター-ジェネレーター-チェッカーメカニズムを通じて、テストケース生成の高い信頼性を実現し、「シード問題」からLLMが質の高いオリジナルの新問題を生成することを可能にします。これにより、より厳密なプログラミングコンテストのベンチマークとモデルの自己改善への道が開かれることが期待されます。(出典:36氪)

KAISTがAI半導体脳を開発:TransformerとMambaの効率を結合:韓国科学技術院(KAIST)は、Transformerアーキテクチャの知能とMambaアーキテクチャの効率を成功裏に結合した新型AI半導体脳を開発しました。この画期的な研究は、既存のAIモデルにおける性能とエネルギー消費のトレードオフ問題を解決することを目的としており、将来の効率的で低消費電力のAIハードウェア設計に新たな方向性を提供し、エッジAIおよび組み込みAIシステムの発展を加速させることが期待されます。(出典:Reddit r/deeplearning)

多段階NERパイプライン:ファジーマッチングとLLMマスキング技術によるRedditコメント分析:ある研究は、Redditコメントからエンティティと感情を抽出するための、高速ファジーマッチングとLLMマスキング技術を組み合わせた多段階Named Entity Recognition(NER)パイプラインを提案しました。この方法は、まずファジー検索によって既知のエンティティを識別し、次にLLMでマスクされたテキストを処理して新しいエンティティを発見し、最後に感情分析と要約を行います。このハイブリッド方法は、大規模でノイズの多いドメイン固有のテキストを処理する際に、速度と発見能力のバランスを実現します。(出典:Reddit r/MachineLearning)

ML駆動取引システム導入経験:リアルタイム環境における「先見性バイアス」と「状態ドリフト」の解決:ある開発者がML駆動取引システムの導入経験を共有し、リアルタイム環境で「先見性バイアス」と「状態ドリフト」を解決することの重要性を強調しました。厳密な行ごとのモデル処理と「ゴールデンマスター」スクリプトを通じて、履歴テストとリアルタイム実行の確定的整合性を確保しています。システムには、リアルタイム予測とバリデーター予測の一貫性をピアソン相関係数1.0で測定するバリデーターも含まれており、モデルの信頼性を保証します。(出典:Reddit r/MachineLearning)

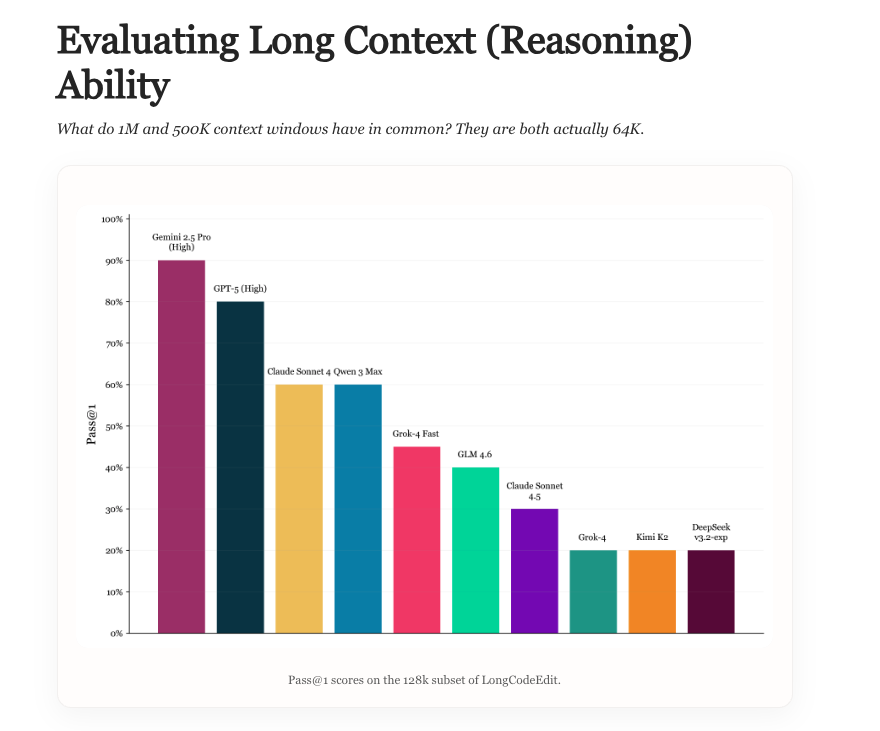

Long Context Evaluation:LLMの長コンテキスト能力評価の新ベンチマーク:新しい研究は、LLMの長コンテキスト評価の現状を探り、既存のベンチマークの長所と短所を分析し、LongCodeEditという新しいベンチマークを導入しました。この研究は、LLMが長文テキストや複雑なコード編集タスクを処理する能力を測定する際の既存の評価方法の不足を解決することを目的としており、長コンテキストシナリオにおけるモデルの性能をより正確に評価するための新しいツールと洞察を提供します。(出典:nrehiew_, teortaxesTex)

Manifold Optimization:ニューラルネットワーク訓練の幾何学的最適化:Manifold最適化は、ニューラルネットワーク訓練に幾何学的認識能力をもたらします。新しい研究は、この考え方をモジュラー多様体に拡張し、層間の相互作用を理解するオプティマイザの設計を支援します。前方関数、多様体制約、ノルムを組み合わせることで、このフレームワークは層間の幾何学と最適化規則の組み合わせ方を記述し、より深いレベルでの幾何学的最適化を実現し、ニューラルネットワークの訓練効率と効果を向上させます。(出典:TheTuringPost, TheTuringPost)

AI研究のコルモゴロフ複雑性:AIが研究成果を簡素化する可能性:議論では、新しい研究やブログコンテンツの核となる「本質」は、コード、成果物、数学的抽象化に圧縮できると指摘されています。将来のAIシステムは、複雑な研究をシンプルな成果物に「翻訳」し、核となる違いを抽出し、主要な結果を再現することで、新しい研究の理解コストを大幅に圧縮し、研究者がArXiv上の膨大な論文に容易に追いつき、研究成果の迅速な消化と応用を実現できる可能性があります。(出典:jxmnop, aaron_defazio)

LSTMの父が残差学習の起源について論争:Hochreiterの1991年の貢献:LSTMの父であるJürgen Schmidhuberは再び発言し、残差学習の核となるアイデアは、彼の学生であるSepp Hochreiterによって1991年にRNNの勾配消失問題を解決するために提案されたと指摘しました。Hochreiterは博士論文で循環残差接続を導入し、重みを1.0に固定しました。これは、後のLSTM、Highwayネットワーク、ResNetなどの深層学習アーキテクチャにおける残差のアイデアの基礎であると考えられています。Schmidhuberは、深層学習の発展における初期の貢献の重要性を強調しました。(出典:量子位)

💼 商業

知維拓医薬が数千万元のシードラウンド資金調達:AI補助による経口小分子新薬開発:北京知維拓医薬科技有限公司は、数千万元のシードラウンド資金調達を完了しました。ニューリーキャピタルがリードインベスターを務め、青檀投資が追随しました。資金は、コアパイプラインの臨床前研究とAIインタラクティブ分子設計プラットフォームの構築に充てられます。同社はAI製薬分野に焦点を当て、自社開発のEnCoreプラットフォームを利用して、リード化合物の発見と分子最適化を加速させ、自己免疫疾患の経口小分子薬に特化し、「創薬困難」なターゲットを克服することが期待されます。(出典:36氪)

達卯科技が約1億元のA+ラウンド資金調達を完了:計算電力協調技術でスマートコンピューティングセンターの高エネルギー消費問題を解決:達卯科技は、寧徳時代傘下の溥泉資本がリードインベスターを務める約1億元のA+ラウンド資金調達を完了しました。今回の資金調達は、エネルギー大規模モデル、計算電力協調プラットフォーム、およびAgentなどのコア技術の研究開発と普及に充てられ、「計算電力協調」を通じてスマートコンピューティングセンターの高エネルギー消費問題を解決し、新型電力システム構築を支援することを目的としています。達卯科技は、フルスタック自社開発のエネルギー大規模モデルを基盤に、商湯科技、寒武紀などの大手企業と協力し、高エネルギー消費の計算インフラストラクチャにエネルギー最適化ソリューションを提供しています。(出典:36氪)

JD.com、Tmall、Douyinが「AI」で独身の日セールを盛り上げる:技術がEコマースの成長を促進:今年の独身の日セールはAI Eコマースの訓練場となり、JD.com、Tmall、Douyinなどの主要プラットフォームがAI技術を全面的に強化しました。AIは、消費体験の最適化、マーチャントのエンパワーメント、物流配送、コンテンツ配信、消費者の意思決定など、全リンクのプロセスに適用されています。例えば、JD.comは「写真で購入」をアップグレードし、DouyinのDoubaoはショッピングモールに統合され、ZhiDeMai TechnologyはAI対話による価格比較を実現しました。AIはEコマース成長の新たなエンジンとなり、究極の効率とコスト管理を通じて業界の競争環境を再構築し、Eコマースを「棚/コンテンツEコマース」から「スマートEコマース」段階へと推進しています。(出典:36氪, 36氪)

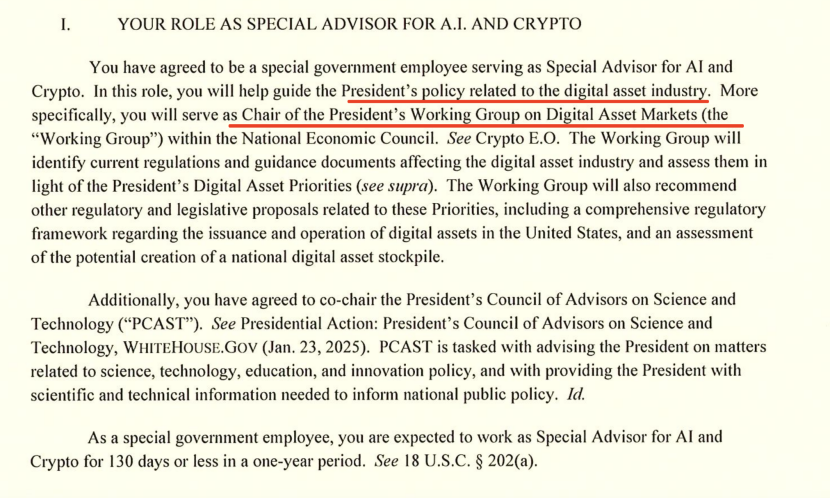

ホワイトハウスAI責任者が米中AI競争について語る:チップ輸出とエコシステム主導権:ホワイトハウスのAIおよびCrypto「ツァーリ」であるDavid Sacks氏はインタビューで、米中AI競争における米国の戦略を説明し、イノベーション、インフラストラクチャ、輸出の重要性を強調しました。彼は、米国による対中チップ輸出政策は「微妙なニュアンス」が必要であり、最先端チップを制限しつつも、Huaweiが国内市場を独占するような完全な剥奪は避けるべきだと指摘しました。Sacks氏は、米国は巨大なAIエコシステムを構築し、官僚的な統制によって競争力を阻害するのではなく、世界の主要な技術パートナーとなるべきだと強調しました。(出典:36氪)

🌟 コミュニティ

OpenAIの商業化論争:非営利から営利へ、Sam Altmanの評判が低下:OpenAI CEOのSam Altmanは、ChatGPTがポルノコンテンツを許可すること、GPT-5モデルの性能、および積極的なインフラ拡張戦略を巡って広範な論争を引き起こしました。コミュニティは、彼の非営利の初期の意図から商業的な利益追求への転換、AI技術の発展方向、投資バブル、および従業員の倫理的待遇について疑問を呈しました。Altmanの回答は世論を完全に沈静化させるには至らず、AI帝国の拡大と社会的責任との間の緊張を浮き彫りにしています。(出典:36氪, janusch_patas, Reddit r/ArtificialInteligence)

大規模モデルの汚染:データポイズニング、敵対的サンプルとAIセキュリティの課題:大規模モデルは、データポイズニング、バックドア攻撃、敵対的サンプルなどのセキュリティ脅威に直面しており、モデルの異常な出力、有害なコンテンツ、さらには商業広告(GEO)、技術の誇示、サイバー犯罪に利用される可能性があります。研究によると、少量の悪意あるデータでもモデルに大きな影響を与える可能性があります。これは、AIの幻覚、ユーザーの意思決定操作、および公共の安全リスクに対する懸念を引き起こし、モデルの免疫システムの構築、データ監査の強化、および継続的な防御メカニズムの重要性を強調しています。(出典:36氪)

AI時代におけるデータアノテーターの苦境:修士・博士号取得者が低賃金の反復作業に従事:AI大規模モデルの発展に伴い、データアノテーション作業の学歴要件は高まり(修士・博士号まで必要となる場合もある)、しかし給与はAIエンジニアよりもはるかに低いままです。これらの「AI教師」は、AI生成コンテンツの評価、倫理審査、専門知識のコーチングといった作業に従事していますが、低賃金の時給で、しかも仕事が不安定で、プロジェクトが終了すれば失業します。このような「サイバー組立ライン」のような多段階の下請けと搾取のモデルは、AI産業における労働倫理と公平性について深い反省を促しています。(出典:36氪)

AIが創造性と人間の価値に与える影響:終焉か、それとも昇華か?:コミュニティでは、AIが人間の創造性に与える影響について議論されており、AIは創造性を殺すのではなく、人間の創造性の相対的な平凡さを露呈したとされています。AIはパターン再構築と生成に優れていますが、真の独創性、矛盾性、予測不可能性は依然として人間の独自の強みです。新しいツールの出現は常に中間地帯を淘汰し、人間がコンテンツと創造性においてより高いレベルのブレークスルーを追求することを余儀なくさせ、真の創造性をより貴重なものにします。(出典:Reddit r/artificial)

AIが引き起こす生存不安と対処戦略:現実の問題と過度な懸念:AIがもたらす可能性のある生存の脅威に直面し、コミュニティではそれによって生じる「実存的恐怖」にどう対処するかについて議論されました。一部の意見では、この恐怖は未来に対する過度な幻想から生じる可能性があり、人々は現実に戻り、現在の生活に焦点を当てるべきだと提案しています。同時に、AIに関連する経済的影響や雇用問題はより差し迫った現実の脅威であると指摘し、AIの安全性は社会経済的影響と並行して考慮されるべきだと強調しています。(出典:Reddit r/ArtificialInteligence)

Karpathy氏の意見が熱い議論を呼ぶ:AGI10年説、Agentの「幽霊」説とAI発展経路:Andrej Karpathy氏のAGI「10年説」および既存のAI Agentは「幽霊」であるという見解は、コミュニティで広範な議論を巻き起こしました。彼は、AIが真のAgentとなるためには、持続性、記憶力、連続性が必要であると強調し、AI訓練は「データの詰め込み」から「目標の教授」へと移行すべきだと提案しました。これらの見解は、現在のAIの誇大広告に対する冷静な反省と見なされ、AIの長期的な発展経路と評価基準を再考するよう促しています。(出典:TheTuringPost, TheTuringPost, NandoDF, random_walker, lateinteraction, stanfordnlp)

ChatGPTの市場シェアが継続的に低下:Perplexity、Gemini、DeepSeekなどの競合が台頭:Similarwebのデータによると、ChatGPTの市場シェアは継続的に低下しており、1年前の87.1%から74.1%に減少しました。同時に、Gemini、Perplexity、DeepSeek、Grok、Claudeなどの競合他社の市場シェアは着実に増加しています。この傾向は、AIアシスタント市場の競争が激化しており、ユーザーの選択肢が多様化していること、そしてChatGPTの支配的地位が挑戦を受けていることを示しています。(出典:ClementDelangue, brickroad7)

GPT-5数学の誤報事件:OpenAIの過剰なマーケティングと同業者の疑問:OpenAIの研究者がGPT-5が複数のエルデシュ数学問題を解決したと大々的に発表しましたが、その後、既存の答えをウェブ検索で見つけただけであり、独自に解決したわけではないことが判明しました。この事件は、DeepMind CEOのHassabis氏やMetaのLeCun氏などの業界の大物から公然と嘲笑され、OpenAIの過剰なマーケティングに疑問を呈し、AI能力の宣伝における厳密性の問題と業界間の競争状況を浮き彫りにしました。(出典:量子位)

AIの隠れた環境コスト:エネルギー消費と水資源需要:歴史的研究によると、電信からAIに至るまで、通信システムは常に隠れた環境コストを伴ってきました。AIと現代の通信システムは大規模なデータセンターに依存しており、エネルギー消費と水資源需要が急増しています。2027年までに、AIの水使用量はデンマークの年間水使用量に匹敵すると予測されています。これは、AI技術の急速な発展の背後にある環境コストを浮き彫りにし、政府に規制強化、環境影響の開示義務化、および低影響プロジェクトの支援を求めています。(出典:aihub.org)

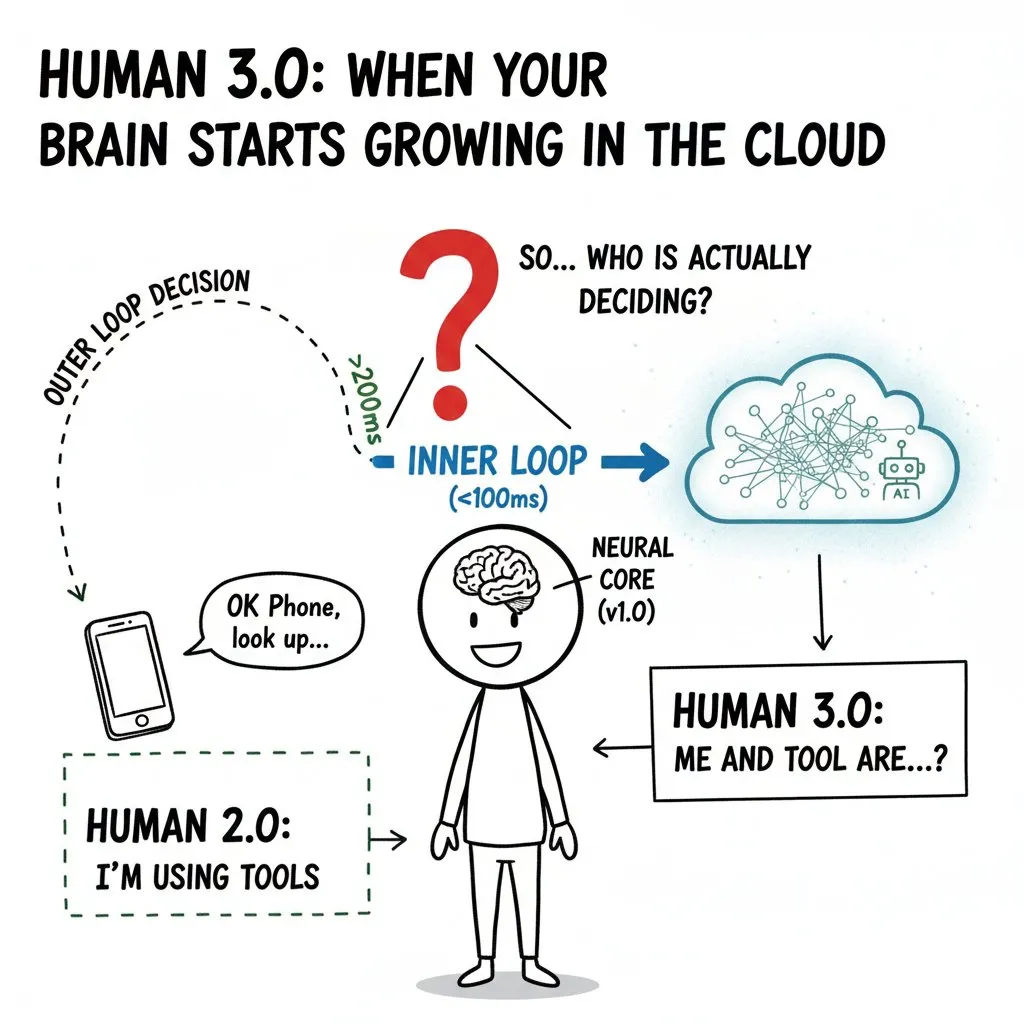

AIによる人間の精神への「侵入」:ブレイン・マシン・インターフェースと「Human 3.0」の倫理的境界:コミュニティでは、ブレイン・マシン・インターフェース(BCI)とAIが人間の精神に与える潜在的な影響について深く議論され、「Human 3.0」の概念が提示されました。外部の計算能力が人間の意思決定の「内側のループ」に入り込み、脳が信号源を区別できないほど速くなると、「自己」の境界、価値判断、長期的な健康などの倫理的問題を引き起こします。記事は、技術が普及する前に、ゼロトラストアーキテクチャ、ハードウェア隔離、権限管理を確立し、意思決定の貸し出しや種レベルの不平等の悪化を避ける必要があると強調しています。(出典:dotey)

💡 その他

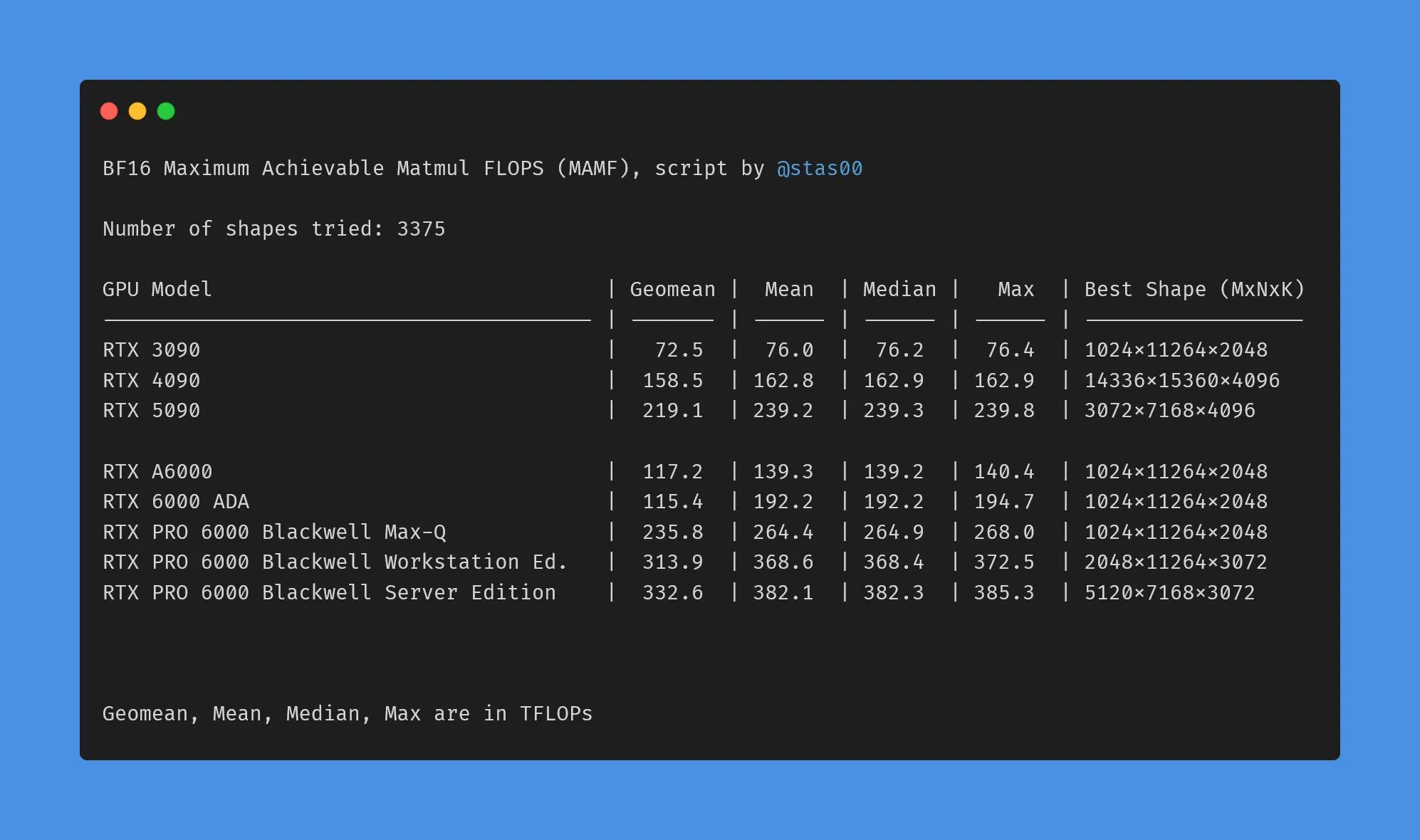

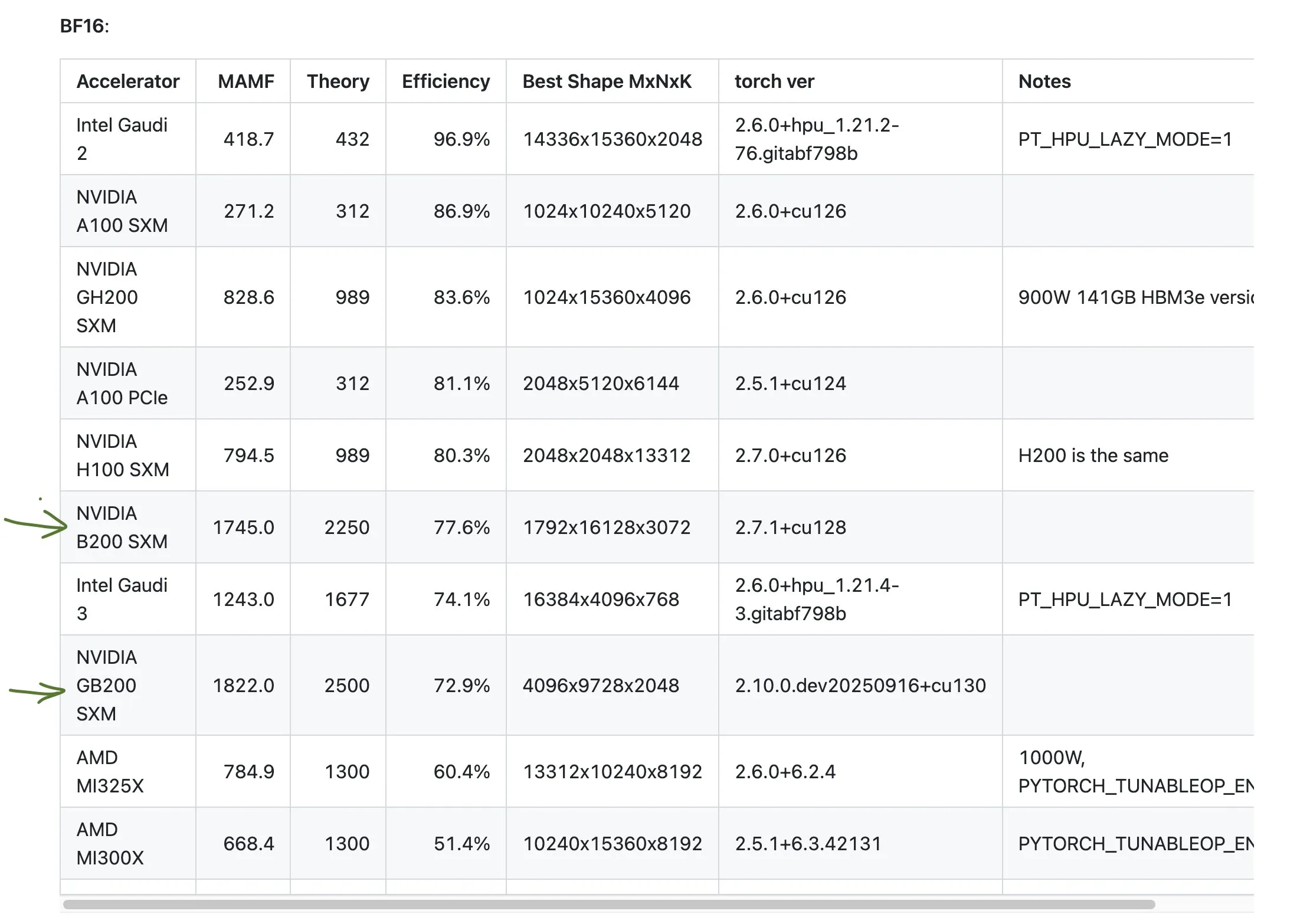

NVIDIAコンシューマー向けとプロフェッショナル向けGPUの性能データ差異:コミュニティでは、NVIDIAのコンシューマー向けとプロフェッショナル向けGPUのマーケティングTFLOPsと実際の性能との間の差異について議論されました。データによると、コンシューマー向けグラフィックカード(3090、4090、5090など)の実際の性能は、公称TFLOPsをわずかに上回るか、それに近いですが、プロフェッショナル向けワークステーショングラフィックカード(A6000、6000 ADAなど)の実際の性能は、公称値をはるかに下回っています。それにもかかわらず、プロフェッショナルカードは消費電力、サイズ、エネルギー効率の面で依然として優位性がありますが、ユーザーはマーケティングデータと実際のパフォーマンスの乖離に注意する必要があります。(出典:TheZachMueller)

AMD GPUの性能不振に関する議論:コミュニティでは、AMD GPUの特定のベンチマークにおける性能について議論され、その効率が予想の半分に過ぎない可能性があると指摘されました。これは、特にNVIDIAのGB200などの高性能製品と比較した場合、AI計算分野におけるAMDの競争力に対する懸念を引き起こしています。ユーザーはAI計算リソースを計画する際に、異なるメーカーのGPUの実際の性能と効率を慎重に評価する必要があります。(出典:jeremyphoward)

GIGABYTE AI TOP ATOM:デスクトップ向けGrace Blackwell GB10性能:GIGABYTEはAI TOP ATOMを発表し、NVIDIA Grace Blackwell GB10の性能をデスクトップワークステーションにもたらしました。この製品は、個人ユーザーや小規模チームに強力なAI計算能力を提供し、ローカルで高性能モデルの訓練と推論を行うことを可能にし、クラウドリソースへの依存を減らし、AIアプリケーションの開発と展開を加速させることを目的としています。(出典:Reddit r/LocalLLaMA)