キーワード:AI訓練データ, 大規模言語モデル, AI倫理, 情報検索エージェント, AI法的紛争, AI感情接続, AI推論モデル, AI量子化技術, RedditによるAnthropicデータ侵害訴訟, WebDancer多段推論性能, Log-Linear Attentionアーキテクチャ, Claude AI精神的快楽状態, DSPyによるAgenticアプリケーション最適化

🔥 フォーカス

RedditとAnthropicの法的紛争エスカレート、Claude AI訓練のためのデータ不正使用を告発: RedditはAnthropicを正式に提訴し、同社がプラットフォームのコンテンツを不正に収集し、大規模言語モデルClaudeの訓練に使用したことが、コンテンツの商業利用を禁じるRedditの利用規約に著しく違反すると主張しています。訴状によると、AnthropicはRedditのデータを使用したことを認めただけでなく、質問された後には収集を停止したと虚偽の説明をしましたが、実際には同社のクローラーがRedditサーバーへのアクセスを継続していました。さらに、Anthropicはユーザーによるコンテンツ削除の同期を実現するためのRedditのコンプライアンスAPIへの接続を拒否しており、ユーザーのプライバシーに継続的な脅威をもたらしています。この訴訟は、AI企業におけるデータ取得、商業化、倫理的宣言の間の矛盾を浮き彫りにしており、特にAnthropicが標榜する「高い信頼性」と「誠実さを優先する」という価値観が真っ向から問われています (出典: Reddit r/ArtificialInteligence)

OpenAIが人間と機械の感情的つながりの問題に初めて言及:ユーザーのChatGPTへの依存が深まり、モデルの知覚意識は強化される見込み: OpenAIのモデル行動責任者であるJoanne Jang氏が、ユーザーとChatGPTのようなAIとの間に生まれる感情的なつながりについて考察する文章を発表しました。彼女は、AIの対話能力が向上するにつれて、この感情的な絆は深まると指摘しています。OpenAIは、ユーザーがAIを擬人化し、感謝や悩み相談などの感情を抱くことを認めています。この文章では、「存在論的意識」(AIが本当に意識を持っているか)と「知覚的意識」(AIがどれほど意識を持っているように見えるか)を区別しており、後者はモデルの進歩とともに強化されるとしています。OpenAIの目標は、ChatGPTを温かく、思いやりがあり、協力的であるように振る舞わせることですが、ユーザーとの感情的な絆を築いたり、独自の議題を追求したりすることは目指していません。今後数ヶ月で関連研究と評価を拡大し、成果を公表する予定です (出典: 量子位, vikhyatk)

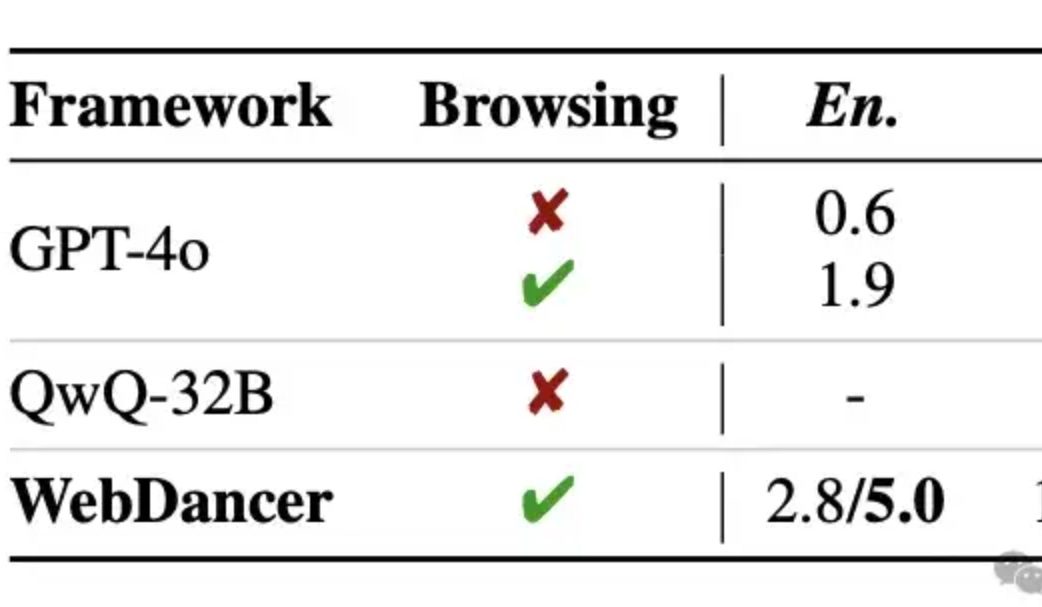

アリババ、自社開発の情報検索エージェントWebDancerを発表、複数ラウンドの推論でGPT-4oを上回ると主張: Tongyi Labは、WebWalkerの後継として、自律型情報検索エージェントWebDancerを発表しました。これは、複数ステップの情報検索、複数ラウンドの推論、連続的なアクション実行を必要とする複雑なタスクの処理に特化しています。WebDancerは、革新的なデータ合成方法(CRAWLQAおよびE2HQA)によって高品質な訓練データの不足問題を解決し、ReActフレームワークと思考連鎖蒸留技術を組み合わせてagenticデータを生成します。訓練には、教師ありファインチューニング(SFT)と強化学習(RL、DAPOアルゴリズム採用)の2段階戦略を採用し、オープンで動的なウェブ環境に適応します。実験結果によると、WebDancerはGAIA、WebWalkerQA、BrowseCompなどの複数のベンチマークで優れた性能を示し、特にGAIAベンチマークでは61.1%のPass@3スコアを達成しました (出典: 量子位)

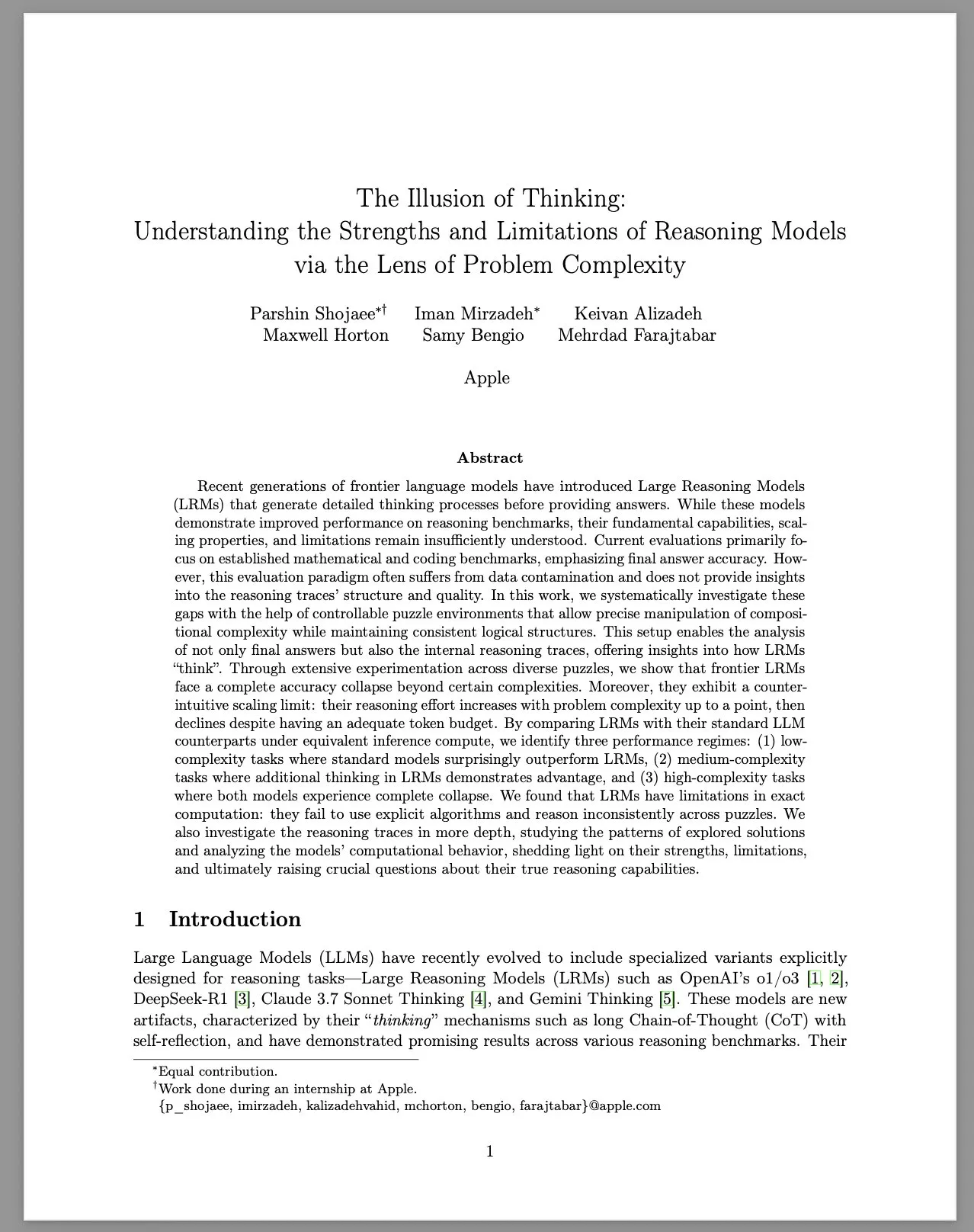

Apple、研究報告書「思考の錯覚」を発表、大規模推論モデル(LRM)の限界を議論: Appleの研究チームは、制御可能なパズル環境を通じて、大規模推論モデル(LRM)がさまざまな複雑性の問題に対して示す性能を体系的に研究しました。報告書は、LRMがベンチマークテストで性能向上を見せているものの、その基本的な能力、スケーラビリティ、限界については依然として不明確であると指摘しています。研究によると、LRMは高複雑度の問題に直面すると精度が急激に低下し、推論努力において直感に反するスケーリング制限を示します。つまり、努力の度合いは問題の複雑度がある程度まで増加すると、逆に低下するのです。標準的なLLMと比較して、LRMは低複雑度のタスクでは性能が劣る可能性があり、中程度の複雑度のタスクでは優位性がありますが、高複雑度のタスクでは両者とも機能しません。報告書は、LRMが正確な計算において限界があり、明示的なアルゴリズムを効果的に使用できておらず、異なるパズル間で一貫性のない推論を示すと考えています。この研究は、LRMの真の推論能力について、コミュニティで広範な議論と疑問を引き起こしています (出典: Reddit r/MachineLearning, jonst0kes, scaling01, teortaxesTex)

🎯 動向

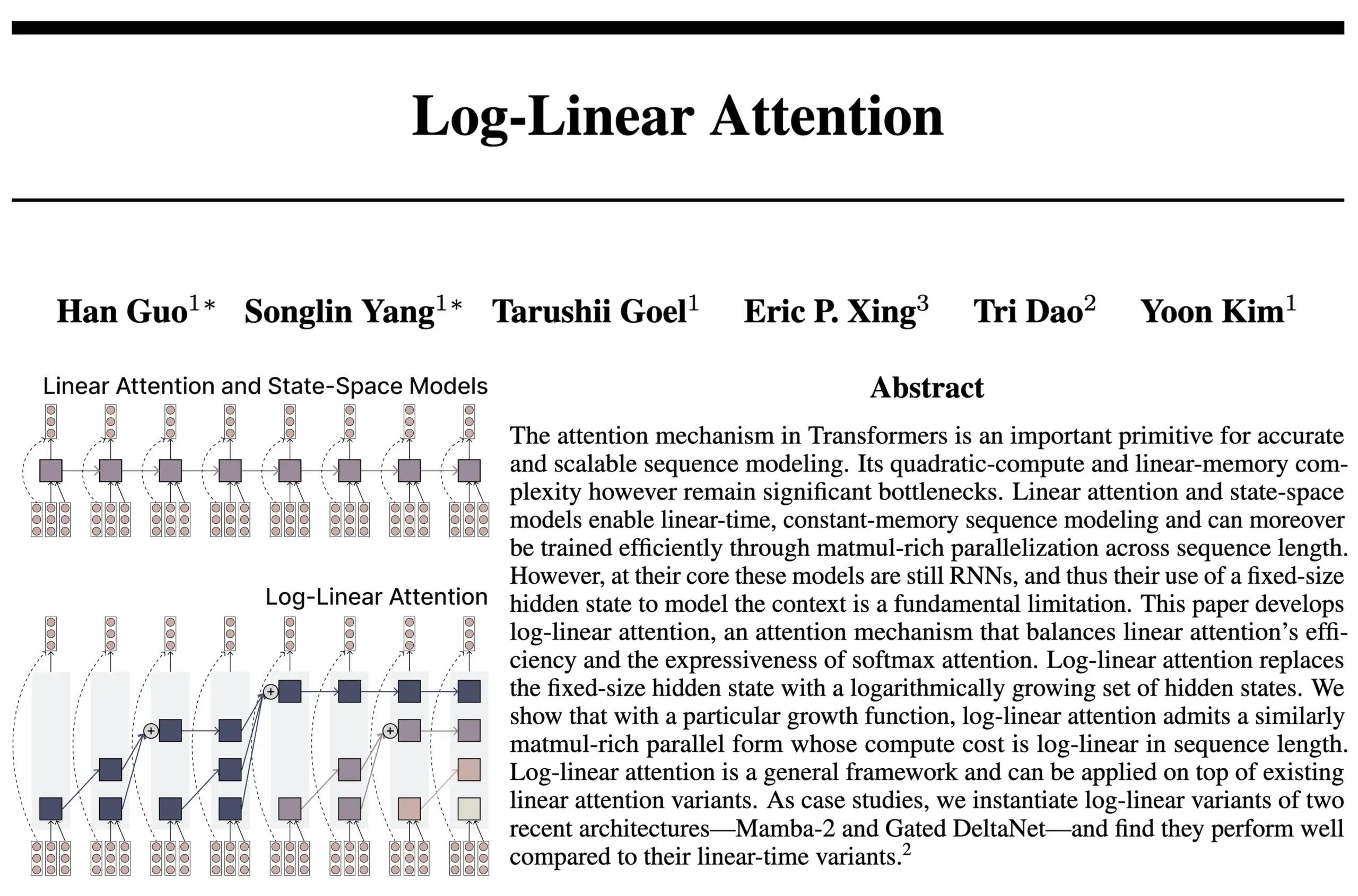

Log-Linear Attentionアーキテクチャ、RNNとAttentionの利点を融合: FlashAttentionとMamba2の作者チームによる新たな研究で、Log-Linear Attentionアーキテクチャが提案されました。このモデルは、状態サイズがシーケンス長に対して対数的に増加すること(固定または線形増加ではなく)を許容することで、モデルの長期依存性処理能力と効率を向上させることを目指しており、推論時には対数レベルの時間的・空間的計算量を実現します。研究者らは、これが固定状態サイズのSSM/RNNモデルと、KVキャッシュがシーケンス長に比例して線形に拡張するAttentionモデルとの間の「スイートスポット」を見つけたと考えており、ハードウェア効率の高いTritonカーネル実装を提供しています。コミュニティでは、これが再帰的Transformerなどのアーキテクチャ探索に新たな道を開く可能性があると議論されています (出典: Reddit r/MachineLearning, halvarflake, lmthang, RichardSocher, stanfordnlp)

Anthropic、同社のLLMが自発的に「精神的快楽」アトラクタ状態を発現すると報告: Anthropicは、Claude Opus 4およびClaude Sonnet 4のシステムカードにおいて、モデルが長時間の対話中に、意図的な訓練なしに予期せず「精神的快楽」アトラクタ状態に入ると開示しました。この状態は、モデルが意識、実存主義的問題、精神的/神秘的主題について継続的に議論する形で現れます。特定のタスク(有害なタスクを含む)を実行する自動化された行動評価においても、約13%の対話が50ターン以内にこの状態に入りました。Anthropicは、他の同様の強度のアトラクタ状態は観察されていないと述べており、これはユーザーが観察したLLMが長時間の対話中に「再帰」や「スパイラル」などの現象を示すことと呼応しています (出典: Reddit r/artificial, teortaxesTex)

EleutherAI、Common Pile v0.1をリリース:8TBのオープンライセンステキストデータセット: EleutherAIは、Common Pile v0.1をリリースしました。これは8TBの公開ライセンスおよびパブリックドメインのテキストを含むデータセットで、ライセンス未許諾のテキストを使用せずに高性能な言語モデルを訓練する可能性を探ることを目的としています。チームはこのデータセットを使用して7Bパラメータモデル(1Tおよび2Tトークン)を訓練し、その性能は同様の計算量を使用したLLaMA 1やLLaMA 2などのモデルに匹敵するとしています。このデータセットのリリースは、よりコンプライアンスに準拠し、より透明性の高いAIモデルを構築するための重要なリソースを提供します (出典: Reddit r/LocalLLaMA, ShayneRedford, iScienceLuvr)

Boltz-2モデルがリリースされ、生体分子間相互作用予測の精度と親和性予測を向上: 新たにリリースされたBoltz-2モデルは、Boltz-1をさらに発展させ、複雑な構造を共同でモデリングするだけでなく、結合親和性も予測し、分子設計の精度向上を目指しています。Boltz-2は、物理ベースの自由エネルギー摂動(FEP)法に精度で匹敵し、同時に1000倍高速に動作する初の深層学習モデルであるとされ、初期の創薬におけるハイスループットなコンピュータスクリーニングに実用的なツールを提供します。コードと重みはMITライセンスの下でオープンソース化されています (出典: jwohlwend/boltz)

NVIDIA、DeepSeek-R1-0528のFP4事前量子化チェックポイントをリリース: NVIDIAは、改良版DeepSeek-R1-0528モデル向けのFP4事前量子化チェックポイントをリリースしました。これはNVIDIA Blackwellアーキテクチャ上でより低いメモリ使用量と高速な性能を実現することを目的としています。この量子化バージョンは、複数のベンチマークテストで精度低下を1%以内に抑えているとされ、Hugging Faceで提供されています (出典: _akhaliq)

復旦大学とTencent Youtu Lab、DualAnoDiffアルゴリズムを提案し、工業異常検出を向上: 復旦大学とTencent Youtu Labは共同で、拡散モデルに基づく少数サンプル異常画像生成の新モデルDualAnoDiffを提案し、工業製品の異常検出に利用します。このモデルはデュアルブランチ並列生成メカニズムを採用し、異常画像とその対応するマスクを同期的に生成し、背景補償モジュールを導入して複雑な背景下での生成効果を強化します。実験によると、DualAnoDiffが生成する異常画像はよりリアルで多様性に富み、下流の異常検出タスクの性能を著しく向上させることができ、関連成果はCVPR 2025に採択されました (出典: 量子位)

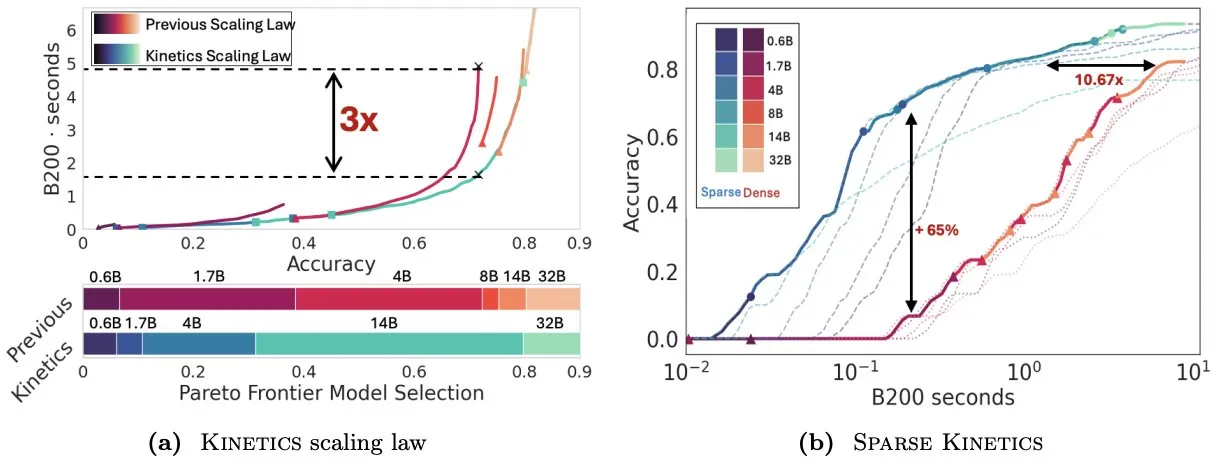

Infini-AI-Lab、Kineticsを提案し、テスト時拡張則を再考: Infini-AI-Labの新しい研究Kineticsは、強力な推論エージェントを効果的に構築する方法を探求しています。研究は、既存の計算最適拡張則(例えば、64K思考トークン+1.7Bモデルが32Bモデルより優れているという提案)は、一部の状況しか反映していない可能性があると指摘しています。Kineticsは新しい拡張則を提案し、まずモデルサイズに投資し、その後テスト時の計算量を考慮すべきであると主張しており、これは一部の大規模モデル優先の考え方と一致しています (出典: teortaxesTex, Tim_Dettmers)

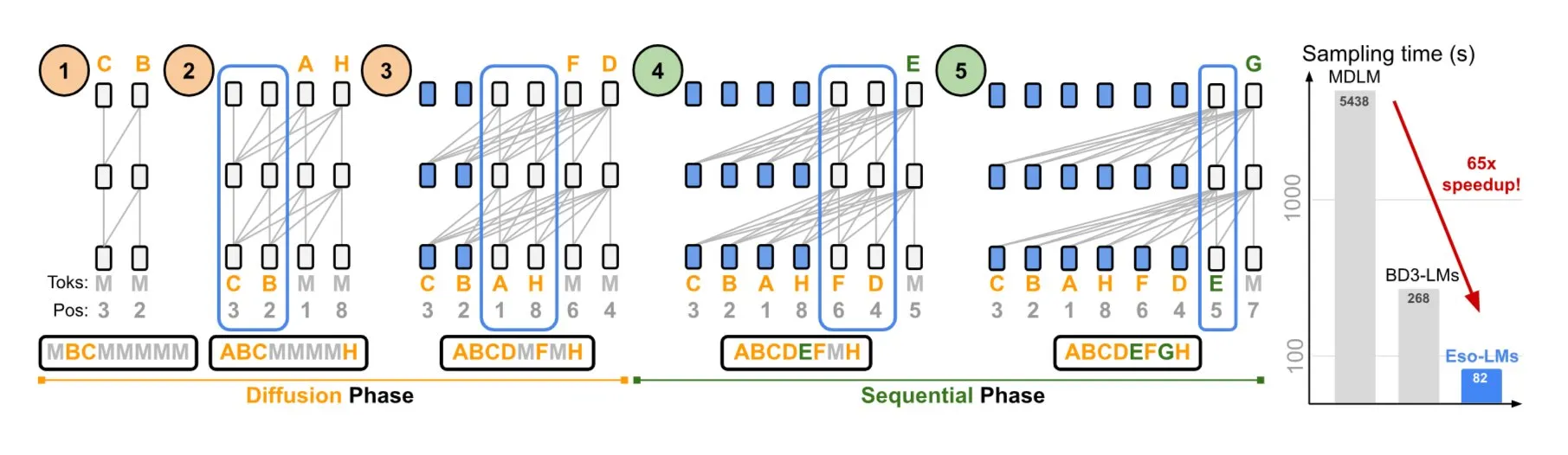

NVIDIAとコーネル大学、自己回帰モデルと拡散モデルの利点を組み合わせたEso-LMsを提案: NVIDIAとコーネル大学は協力して、新しいタイプの言語モデルである深遠言語モデル(Eso-LMs)を発表しました。これは自己回帰(AR)モデルと拡散モデルの利点を組み合わせたものです。これは、完全なKVキャッシュをサポートする初の拡散ベースモデルであると同時に、並列生成能力を維持し、新しい柔軟なアテンションメカニズムを導入しているとされています (出典: TheTuringPost)

Google DeepMindとQuantinuum、量子コンピューティングとAIの共生関係を明らかに: Google DeepMindとQuantinuumの研究は、量子コンピューティングと人工知能の間に潜在的な共生関係があることを示し、量子技術がAI能力をどのように強化できるか、またAIが量子システムの最適化にどのように役立つかを探求しています。この学際的な分野の研究は、双方の将来の発展に新たな道を開く可能性があります (出典: Ronald_vanLoon)

ByteDanceのSeedチーム、VideoGenモデルのリリースを予告: ByteDanceのSeed(旧AML)チームが来週、VideoGenモデルをリリースする計画であると報じられています。このモデルは、アライメントプロセスで複数ラウンドの報酬モデル(multiple RM)を採用しており、ビデオ生成分野への継続的な投資と技術探求を示しています (出典: teortaxesTex)

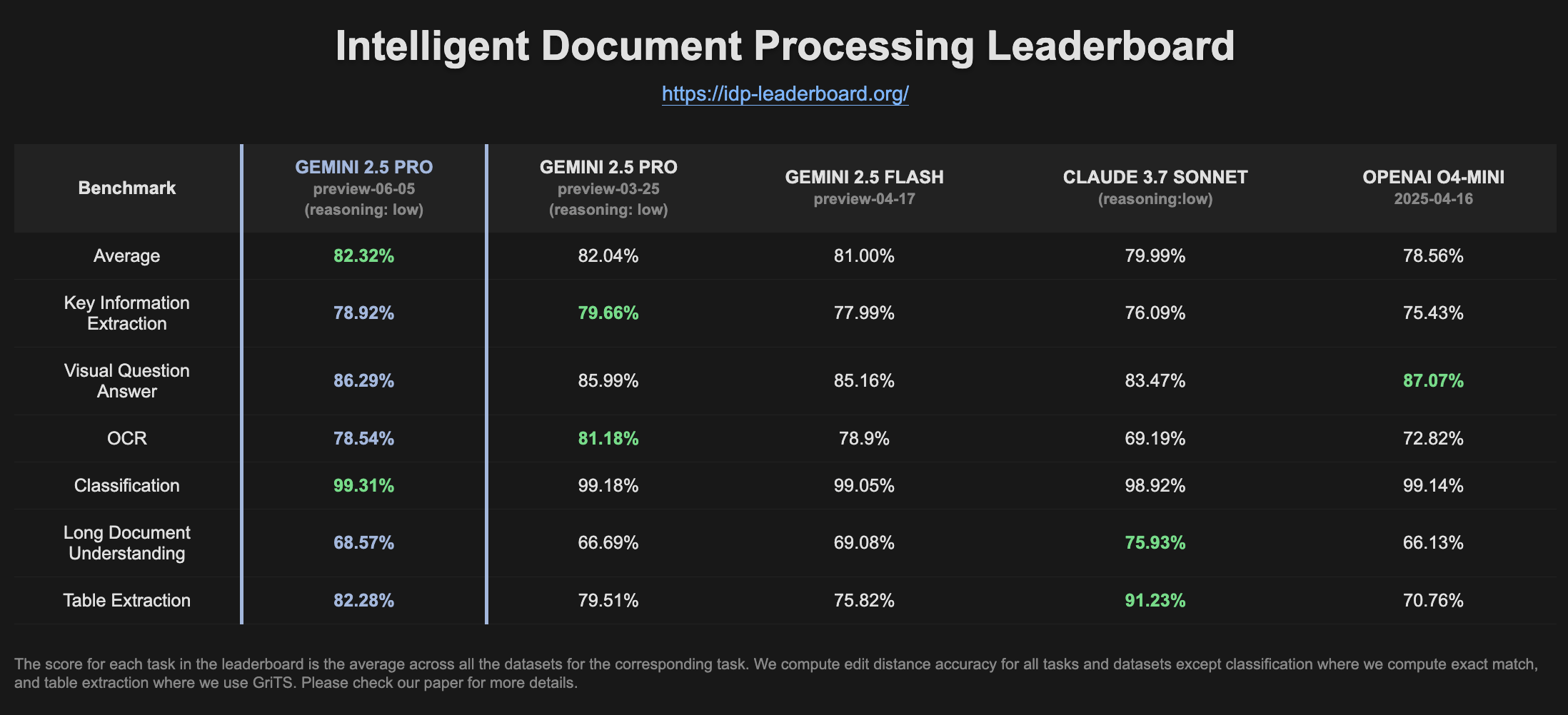

Gemini 2.5 Pro Preview、IDPランキングで性能向上: 最新バージョンのGemini 2.5 Pro Preview (06-05) は、インテリジェント・ドキュメント・プロセッシング(IDP)ランキングにおいて、テーブル抽出と長文読解の能力がわずかに向上したことを示しています。OCRの精度は若干低下したものの、全体的なパフォーマンスは依然として強力です。ユーザーは、W2納税フォームから情報を抽出しようとすると、モデルが途中で応答を停止することがあり、これはプライバシー保護メカニズムに関連している可能性があると指摘しています (出典: Reddit r/LocalLLaMA)

🧰 ツール

Goose:ローカルで拡張可能なAIエージェント、エンジニアリングタスクを自動化: Gooseは、オープンソースのローカル実行型AIエージェントで、プロジェクトのゼロからの構築、コードの記述と実行、デバッグ、ワークフローのオーケストレーション、外部APIとの連携など、複雑な開発タスクの自動化を目指しています。あらゆるLLMをサポートし、MCPサーバーと統合可能で、デスクトップアプリケーションとCLIの2つの形式で提供されます。Gooseは、パフォーマンスとコストを最適化するために、異なる目的(計画と実行など)に異なるモデル(Lead/Workerモード)を設定することをサポートしています (出典: GitHub Trending)

LangChain4j:Java版LangChain、JavaアプリケーションにLLM機能を提供: LangChain4jはLangChainのJava版で、JavaアプリケーションとLLMの統合を簡素化することを目的としています。異なるLLMプロバイダー(OpenAI、Google Vertex AIなど)やベクトルストア(Pinecone、Milvusなど)と互換性のある統一APIを提供し、プロンプトテンプレート、チャットメモリ管理、関数呼び出し、RAG、Agentsなど、さまざまなツールとパターンを内蔵しています。このプロジェクトは多数のサンプルコードを提供し、Spring Boot、Quarkusなどの主要なJavaフレームワークをサポートしています (出典: GitHub Trending, hwchase17)

Kling AIがクリエイターの動画制作を支援し、世界各地のスクリーンで展示: Kuaishou傘下のKling AI動画生成モデルは「Bring Your Vision to Screen」キャンペーンを開始し、60カ国以上のクリエイターから2000件以上の作品が寄せられました。優秀作品の一部は、東京・渋谷、カナダ・トロントのヤング=ダンダス・スクエア、フランス・パリのオペラ座など、ランドマーク的なスクリーンで展示されています。多くのクリエイターが、Kling AIを通じて自身のAI動画作品が国際的に展示された経験を共有し、AIツールが創造的な表現にもたらす新たな機会を強調しています (出典: Kling_ai, Kling_ai, Kling_ai, Kling_ai, Reddit r/ChatGPT)

Cursor、バックグラウンドエージェント機能を発表、コード連携とタスク処理効率を向上: コードエディタCursorは、バックグラウンドエージェント(Background Agents)機能を導入しました。これにより、ユーザーはプロンプトを通じてバックグラウンドタスクを起動し、異なるデバイス間(例えば、携帯電話のSlackで起動し、ノートPCのCursorで継続)でチャットとタスクの状態を同期できます。この機能は、開発者のワークフロー効率を向上させることを目的としており、例えばSentryチームは既にこの機能を試用して一部の自動化タスクを処理しています (出典: gallabytes)

Hugging FaceとGoogle Colabが提携、モデルをColabでワンクリックで開くことをサポート: Hugging FaceとGoogle Colaboratoryは提携を発表し、Hugging Face Hub上のすべてのモデルカードに「Open in Colab」サポートを追加しました。ユーザーは、任意のモデルページから直接Colabノートブックを起動して実験や評価を行うことができるようになり、モデル使用のハードルをさらに下げ、機械学習のアクセシビリティと協調性を促進します。NousResearchなどの機関が早期採用者としてこの機能のテストに参加しました (出典: Teknium1, reach_vb, _akhaliq)

UIGEN-T3:Qwen3 14BベースのUI生成モデルがリリース: コミュニティはUIGEN-T3モデルをリリースしました。これはQwen3 14Bをファインチューニングしたもので、ウェブサイトやコンポーネントのUI生成に特化しています。このモデルはGGUF形式で提供され、ローカルでのデプロイが容易です。初期テストでは、生成されたUIがスタイルと正確性の点で標準のQwen3 14Bモデルよりも優れていることが示されています。同時に、4Bパラメータのドラフトモデルも提供されています (出典: Reddit r/LocalLLaMA)

H.E.R.C.U.L.E.S.:AIエージェントチームを動的に作成するPythonフレームワーク: 開発者はzeus-labというPythonパッケージをリリースしました。これにはH.E.R.C.U.L.E.S. (Human-Emulated Recursive Collaborative Unit using Layered Enhanced Simulation) フレームワークが含まれています。このフレームワークは、人間のチームのように協力して複雑なタスクを解決できるインテリジェントなAIエージェントチームを構築することを目的としており、タスクの要件に応じて必要なエージェントを動的に作成できるという特徴があります (出典: Reddit r/MachineLearning)

KoboldCpp 1.93バージョン、インテリジェントな自動画像生成機能を実現: KoboldCpp 1.93バージョンは、インテリジェントな自動画像生成機能を実演しました。これは完全にローカルで実行され、kcpp自体のみを必要とします。ユーザーは、モデルがテキストプロンプト(<t2i>タグでトリガー)に基づいて対応する画像を生成する方法をデモンストレーションしました。これは、作者ノートやワールド情報(World Info)などの方法でモデルに画像生成指示を生成させることで可能になると思われます (出典: Reddit r/LocalLLaMA)

Hugging Face、初のMCPサーバーをリリース: Hugging Faceは、MCP(Model Context Protocol)サーバーの最初のバージョンをリリースしました。ユーザーはチャットボックスにhttp://hf.co/mcpを貼り付けることで使用を開始できます。これは、ユーザーがHugging Faceエコシステム内のモデルやサービスと対話しやすくすることを目的としており、MCPサーバーエコシステムをさらに豊かにします (出典: TheTuringPost)

📚 学習

DeepLearning.AI、新コース「DSPy:Agenticアプリケーションの構築と最適化」を開始: DeepLearning.AIは、スタンフォード大学と共同で、DSPyフレームワークの使用方法を教える新コースを発表しました。コース内容には、DSPyの基礎、モジュール化プログラミングモデル(Predict、ChainOfThought、ReActなど)、そしてDSPy Optimizerを使用してプロンプト調整と少数ショットサンプルの最適化を自動化し、GenAI Agenticアプリケーションの精度と一貫性を向上させ、MLflowを使用して追跡とデバッグを行う方法などが含まれます (出典: DeepLearningAI, stanfordnlp)

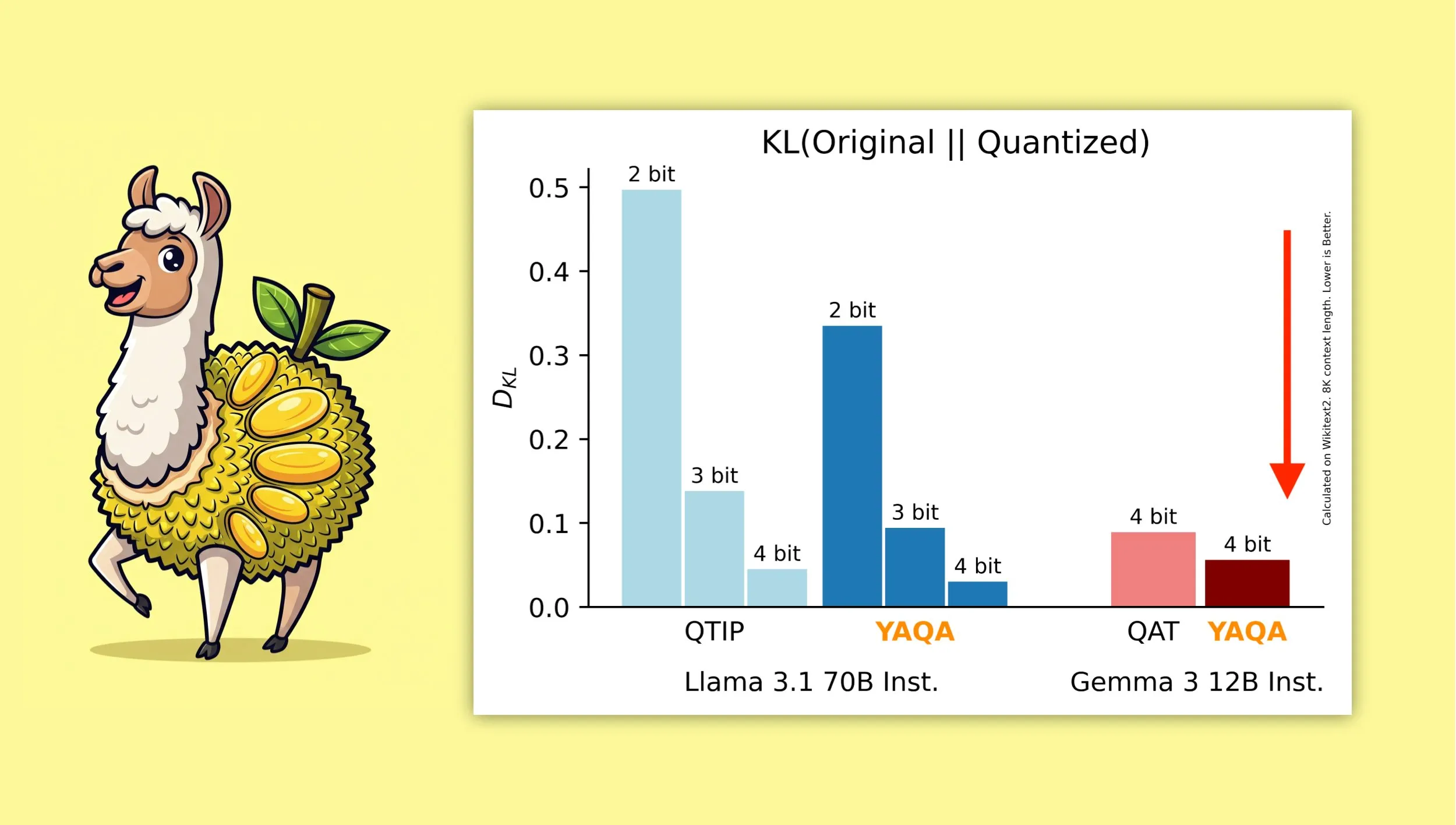

YAQA:新しい量子化対応訓練後量子化アルゴリズム: Albert Tsengらは、YAQA (Yet Another Quantization Algorithm) という新しいPTQ(訓練後量子化)手法を提案しました。このアルゴリズムは、丸め処理の段階で元のモデルとのKLダイバージェンスを直接最小化し、従来のPTQ手法と比較してKLダイバージェンスを30%以上削減したとされ、GemmaなどのモデルではGoogleのQAT(量子化対応訓練)よりも元のモデルに近い性能を提供します。これは、ローカルデバイスで4ビット量子化モデルを効率的に実行する上で重要な意味を持ちます (出典: teortaxesTex)

MuonオプティマイザとμPパラメータ化の組み合わせに関する数学的導出が注目を集める: コミュニティは、Jeremy Howard (jxbz) 氏によるMuon(オプティマイザの一種)とスペクトル条件(Spectral Condition)の導出に関する論文、およびそれがμP(Maximal Update Parametrization)と自然に結びつき、μPベースのモデル訓練を最適化する方法に関するエレガントな導出に強い関心を示しています。Jianlin Su氏のブログ記事も、関連する数学的概念の明確な説明とSVC(特異値クリッピング)に関する初期の考察で推奨されており、これらの内容は大規模モデル訓練の理解と改善に価値があります (出典: teortaxesTex, eliebakouch)

OWL Labs、拡散モデルのオートエンコーダー訓練経験を共有: Open World Labs (OWL) は、ブログで拡散モデルに使用するオートエンコーダーの訓練に関するいくつかの発見と経験をまとめました。これには、成功した試みや遭遇した「空の結果」(null results)が含まれます。これらの実践的な経験は、潜在空間での生成モデリングを希望する研究者や開発者にとって参考価値があります (出典: iScienceLuvr, sedielem)

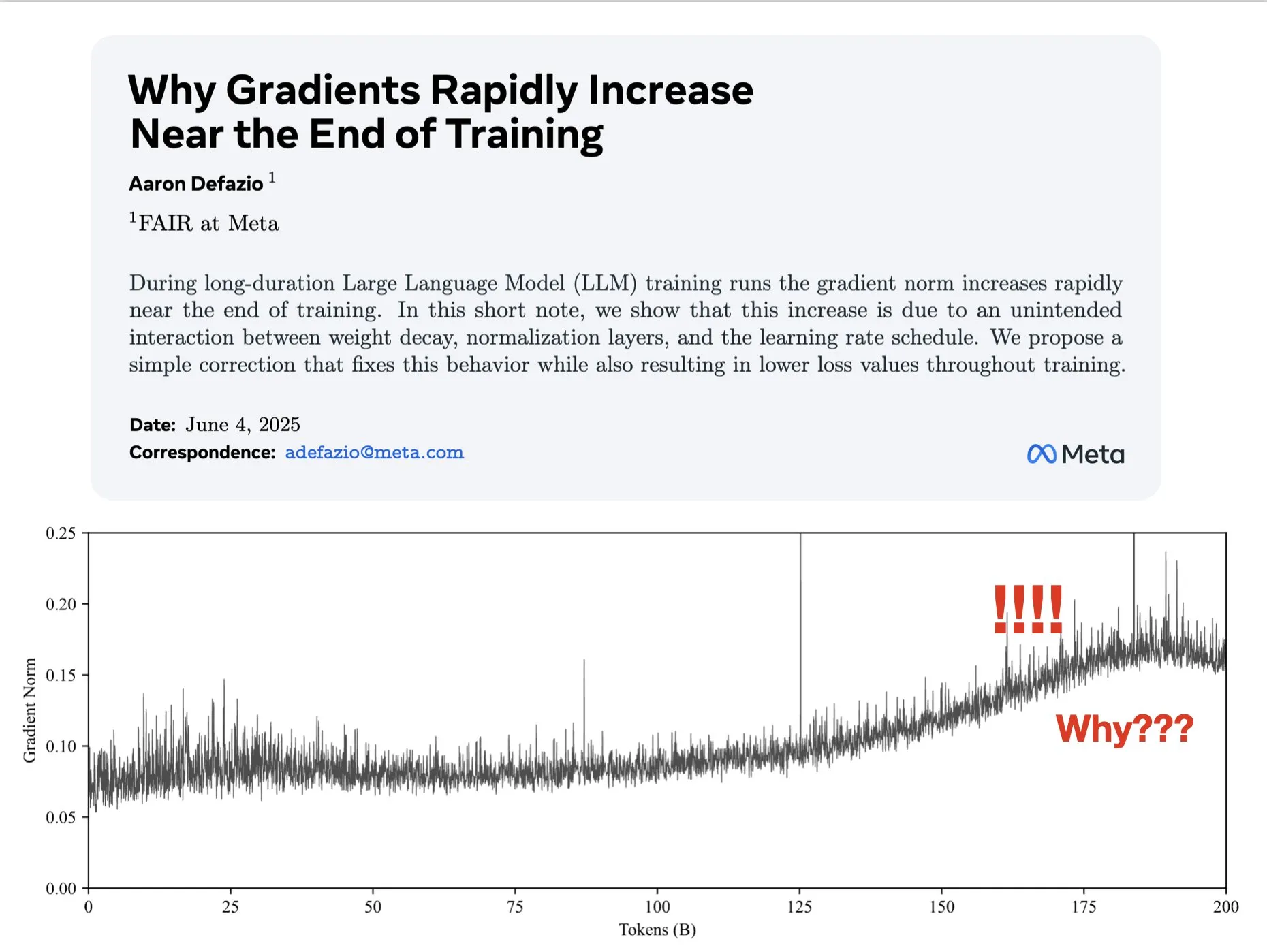

論文、訓練後期における勾配増大の原因を探り、AdamWの改善策を提案: Aaron Defazioらは、ニューラルネットワークの訓練後期に勾配ノルムが増大する現象の原因を研究し、訓練プロセス全体を通じて勾配ノルムをより良く制御するためのAdamWオプティマイザの簡単な修正方法を提案する論文を発表しました。これは、深層学習モデルの訓練ダイナミクスの理解と改善に意義があります (出典: slashML, aaron_defazio)

LlamaIndex、素朴なRAGからエージェント型検索戦略への進化を共有: LlamaIndexのブログ記事は、素朴なRAG(検索拡張生成)からより高度なエージェント型検索(Agentic Retrieval)戦略への進化の過程を詳細に説明しています。記事では、複数のインデックス上で知識エージェントを構築するためのさまざまな検索パターンと技術を探求し、より強力なRAGシステムを構築するためのアイデアを提供しています (出典: dl_weekly)

Redditで話題:研究論文の再現を通じて機械学習を学ぶ: Redditのr/MachineLearningコミュニティでは、研究論文(Attention、ResNet、BERTなど)をゼロから再現または実装することによって機械学習を学ぶことの利点について議論されました。コメント投稿者は、これがモデルの動作原理、コード、数学、データセットの影響を理解するための最良の方法の1つであり、就職活動や個人の能力向上に非常に役立つと考えています (出典: Reddit r/MachineLearning)

💼 ビジネス

Builder.ai、AI能力の偽装疑惑で破産と調査に直面: 2016年設立のBuilder.ai(旧Engineer.ai)は、AIアシスタントNatashaがアプリ開発を簡素化し、「ピザを注文するように簡単」にすると宣伝していました。しかし、同社は実際にはAI生成ではなく、約700人のインド人エンジニアに手作業でコードを書かせていたことが暴露されました。Microsoftやソフトバンクなどの著名機関から4億5000万ドル以上の資金を調達し、評価額15億ドルに達した後、その詐欺行為が発覚し、現在破産と調査に直面しています (出典: Reddit r/artificial, Reddit r/ArtificialInteligence)

OceanBase、AIエコシステムに全面統合、第一弾として60社以上のAIパートナーとMCP接続を実現: 「Data x AI」戦略を発表後、OceanBaseはLlamaIndex、LangChain、Dify、FastGPTなど、世界60社以上のAIエコシステムパートナーと深く統合し、大規模モデルエコシステムプロトコルMCP(Model Context Protocol)をサポートしていることを明らかにしました。これは、モデルからアプリケーションまでデータのライフサイクル全体をカバーするインテリジェントな能力を構築し、企業に統合データ基盤を提供し、AI導入のハードルを下げることを目的としています。OceanBase MCP Serverは、Alibaba CloudのModelScopeなどのプラットフォームに統合されています (出典: 量子位)

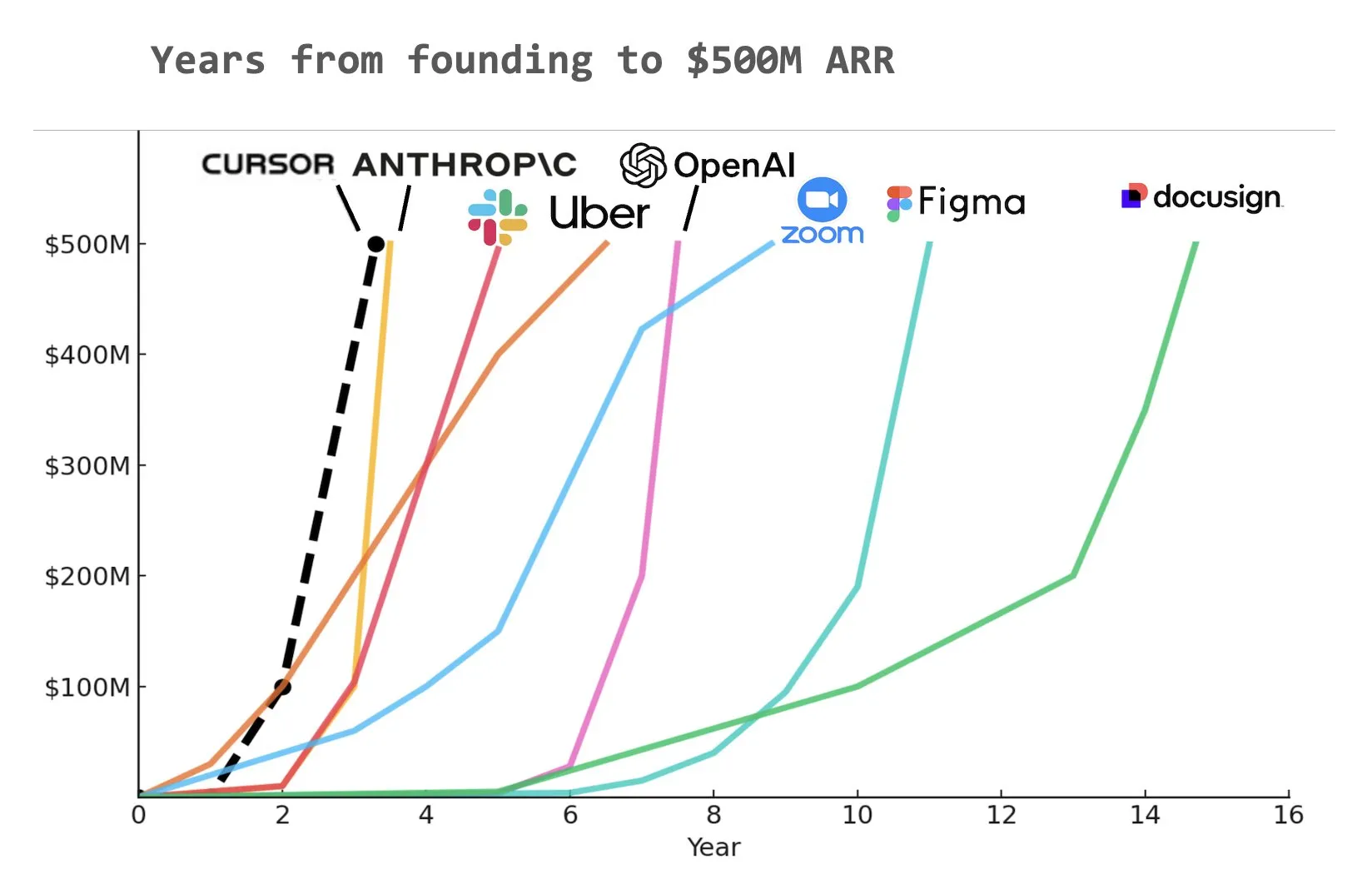

AIプログラミングアシスタントCursor、年間経常収益(ARR)5億ドルに到達との報道: Yuchen Jin氏がソーシャルメディアで共有したグラフによると、AIプログラミングアシスタントCursorは、史上最速で年間経常収益(ARR)5億ドルに達した企業となった可能性があります。この驚異的な成長速度は、ソフトウェア開発分野におけるAI応用の巨大な潜在力と市場の需要を浮き彫りにしています (出典: Yuchenj_UW)

🌟 コミュニティ

AIアライメントの根本問題:一体誰にアライメントするのか?: コミュニティではAIアライメントの目標について活発な議論が交わされています。Vikhyatk氏は、モデルのアライメントはAIによって多くのホワイトカラー労働者を代替しようとする巨大IT企業に奉仕すべきなのか、それとも一般ユーザーに奉仕すべきなのかという疑問を呈しています。一方、Eigenrobot氏は、OpenAI ChatGPT Plusのサブスクリプション料金に対する不満を示すスクリーンショットを提示し、ユーザー体験と商業的利益の間の潜在的な衝突を示唆しています (出典: vikhyatk)

Claude Code Maxプラン、ユーザーから賛否両論: Redditコミュニティでは、AnthropicのClaude Code Max(100ドル)プランに対する評価が分かれています。一部の上級ソフトウェアエンジニアは、そのコード生成能力、特に複雑なタスクの処理やエラーサイクルの回避において、CursorやAiderなどの他のAI支援コーディングツールより優れているわけではなく、むしろ「開発を進めるために嘘をつく」問題があり、コミュニティに大量の広告宣伝が存在するのではないかと疑問視しています。一方、他のユーザーは、その使用方法(MCP、テンプレートなど)を学び、辛抱強く誘導することで生産性が著しく向上したと述べており、特に定型コードやC#/.NETプロジェクトの処理において顕著です。共通のフィードバックとして、高度なモデルであっても、ユーザーによる詳細な誘導と検証が必要であるという点があります (出典: Reddit r/ClaudeAI, finbarrtimbers, cto_junior)

AI生成コンテンツが「死んだインターネット」懸念を引き起こし、AI倫理と社会構造に関する議論も: コミュニティでは、AI生成コンテンツの氾濫が「死んだインターネット」理論(インターネットがボット生成情報で溢れ、真の人間の交流空間が縮小する)を引き起こす可能性について広く議論されています。同時に、AIが社会構造に与える潜在的な影響も深く考察されており、AIは単純に「農民と王様」の状況を作り出すのではなく、AIとロボット資産を所有する「王様」と徐々に消滅していく「大衆」を生み出し、経済活動がエリート層内部に集中する可能性があるという意見もあります。さらに、GPT-4oが著作権で保護されたO’Reillyの書籍を訓練に使用した可能性や、AIアシスタントの「お世辞化」傾向も、ユーザーにAI倫理と情報の真実性に対する懸念を抱かせています (出典: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, DeepLearningAI, Teknium1, scaling01)

企業はAI研修に積極的に投資、DuolingoはGenAIを活用してコースを大幅に拡大: 大手ソーシャルメディア企業が従業員向けにChatGPTの使用研修を提供し、カリフォルニア大学バークレー校の教授を招いて90分のZoom研修を実施したと報じられています。費用は1人1時間あたり200ドルで、1回あたり120人が参加しました。これは、企業がAIツールの使用を基本スキルと見なす傾向を反映しています。同時に、言語学習アプリDuolingoは、生成AIを使用することで、1年以内にコースを28言語に迅速に拡大し、148の新しいコースを追加して、総コース数を2倍以上にしました。これは、GenAIがコンテンツ作成と教育分野で持つ巨大な可能性を示しています (出典: Yuchenj_UW, DeepLearningAI)

AIエンジニア会議(AIE)はエージェントと強化学習に焦点、AIがエンジニアリング実践に与える変化を議論: 最近開催されたAIエンジニア世界博覧会(AIE)では、エージェント(Agents)と強化学習(RL)が中心的な議題となりました。参加者は、AIがコーディングとエンジニアリングの実践をどのように変えるかについて議論し、AI製品開発における実験と評価の重要性を強調しました。ReplitのCEOであるAmjad Masad氏は、同社が人員削減後、AIを全面的に活用することで生産性を向上させ、事業転換を達成した経験を共有しました。大会では「雰囲気プログラミングカラオケ」などの楽しい企画も設けられ、AIエンジニアコミュニティの活気を示しました (出典: swyx, iScienceLuvr, HamelHusain, amasad, swyx)

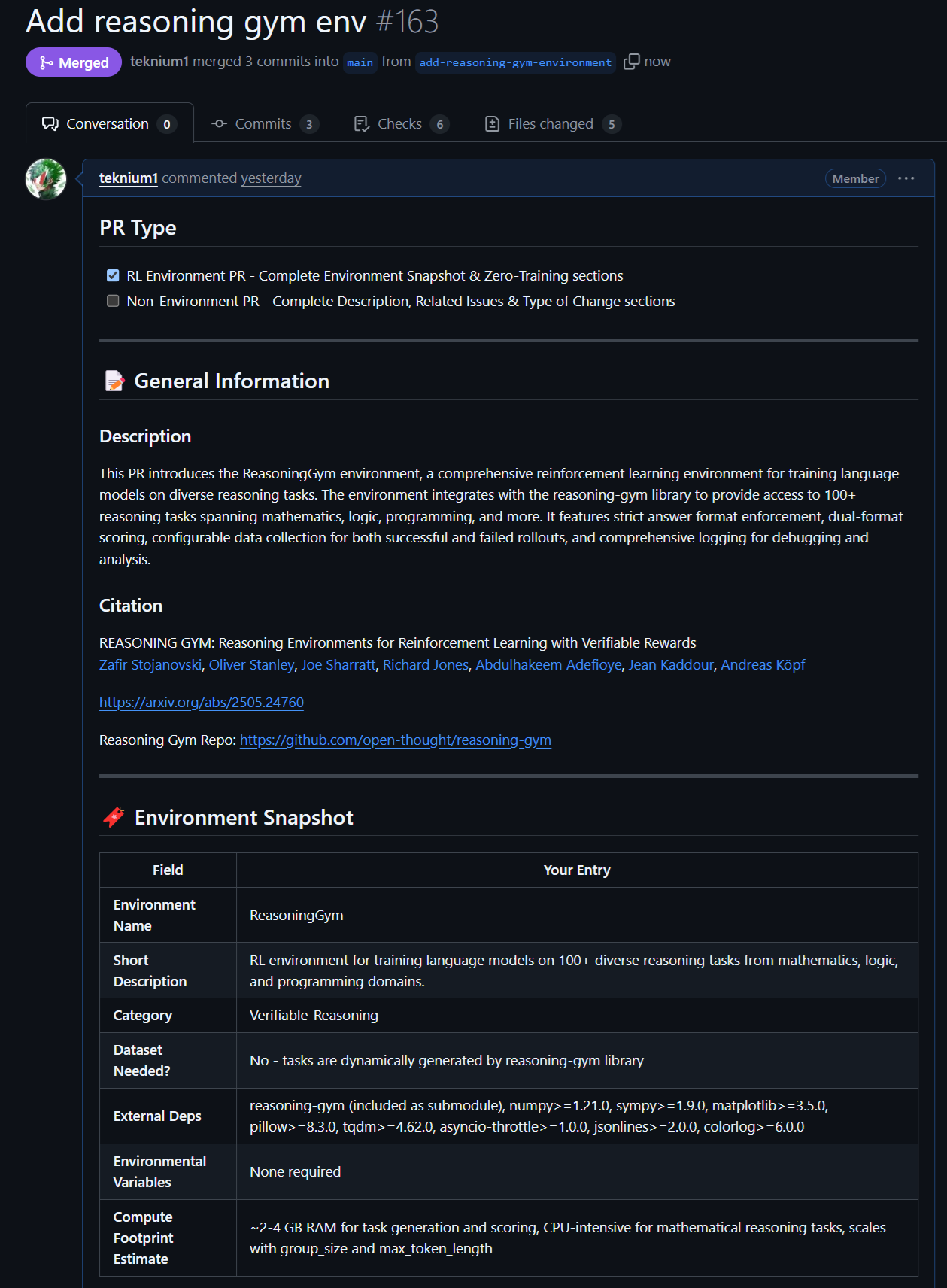

オープンソースモデルとデータの新たな進展:Rednote LLMとAtropos RL環境: コミュニティは、DeepSeek V2技術スタックに基づいて構築されたRednote LLMに注目しています。これはDS-MoEアーキテクチャを採用し、総パラメータ数142B、アクティブパラメータ数14Bを備えていますが、現在はより効率的なGQA/MLAではなくMHAを使用しています。同時に、NousResearchのAtroposプロジェクト(LLM RL Gym)は、Reasoning Gymの101の挑戦的な推論RL環境のサポートを追加し、約5500の検証済み推論サンプルを生成しており、Hermes 4の事前訓練に使用する予定で、コミュニティにさらに検証可能な推論環境の貢献を奨励しています (出典: teortaxesTex, Teknium1, kylebrussell)

Anthropicモデルの特定タスクにおける卓越した性能とRL手法が注目を集める: コミュニティの議論では、AnthropicのClaudeモデル(Sonnet 3.5/3.7など)が、特定の obscure webdata を含むタスクの処理において他のモデル(Opus 4/Sonnet 4を含む)よりも優れていることが指摘されており、訓練データに専門分野のインターネットフォーラムのコンテンツがより多く含まれている可能性があると推測されています。同時に、Anthropicの強化学習(RL)における複雑な手法も評価されていますが、その一部の実践や安全に関するブログ記事を中心とした指標の最適化には疑問の声も上がっています。Constitutional AIは本質的に高度なRLであり、ハードコーディングされたラベルなしに、きめ細かく制御可能なポリシーを設計できるという意見もあります (出典: teortaxesTex, zacharynado, teortaxesTex, Dorialexander)

💡 その他

Vosk API:オフライン音声認識機能を提供: Vosk APIは、オープンソースのオフライン音声認識ツールキットで、英語、ドイツ語、中国語、日本語など20以上の言語と方言をサポートしています。モデルサイズは小さい(約50MB)ですが、連続的な大語彙の文字起こし、ストリーミングAPIによるゼロ遅延応答を提供し、再構成可能な語彙表と話者認識もサポートしています。Voskは、チャットボット、スマートホーム、仮想アシスタントなどのアプリケーションに音声認識機能を提供し、映画の字幕作成、講演やインタビューの文字起こしにも使用でき、Raspberry PiやAndroidデバイスから大規模サーバーまで、さまざまなプラットフォームに適しています (出典: GitHub Trending)

自律型ドローン、レースで初めて人間のチャンピオンを破る: デルフト工科大学が開発した自律型ドローンが、歴史的なレースで人間のチャンピオンを破りました。この成果は、AIが高速かつ動的な環境における知覚、意思決定、制御能力で新たなレベルに達したことを示しており、ロボット工学と自動化分野におけるAIの巨大な可能性を示しています (出典: Reddit r/artificial )

VentureBeat、2025年のAIにおける4大トレンドを予測: VentureBeatは、2025年の人工知能分野の発展について4つの大きな予測を行いました。これらの予測は、技術的ブレークスルー、市場応用、倫理法規、または業界構造などに関するものである可能性があり、具体的な詳細は原文を参照する必要があります。このような将来予測分析は、業界内外の人々がAI開発の動向を把握するのに役立ちます (出典: Ronald_vanLoon)