キーワード:DeepSeek-V3-0526, Grok 3, 具身知能, AIエージェント, 強化学習, 大規模言語モデル, マルチモーダル, DeepSeek-V3-0526の性能はGPT-4.5に匹敵, Grok 3の思考モードとアイデンティティ認識問題, 智元ロボットEVACの世界モデル, 清華大学RIFLExのビデオ生成時間拡張, IBM watsonx Orchestrateエンタープライズ向けAI

🔥 注目ニュース

DeepSeek-V3-0526モデルがGPT-4.5およびClaude 4 Opus対抗でリリースされる可能性: コミュニティの情報によると、DeepSeek(深度寻求)がまもなくそのV3モデルの最新アップデート版であるDeepSeek-V3-0526をリリースする可能性があります。Unslothのドキュメントページの情報によれば、このモデルの性能はGPT-4.5およびClaude 4 Opusに匹敵し、世界最高の性能を持つオープンソースモデルとなることが期待されています。これはDeepSeekにとってV3モデルの2回目の重要なアップデートとなります。Unslothは、精度損失を最小限に抑えることを目的とした独自のダイナミック2.0アプローチを採用し、このモデルの量子化版(GGUF)を準備済みです。コミュニティはこれに高い関心を寄せており、長文コンテキスト処理などにおけるその性能に期待しています。(来源: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

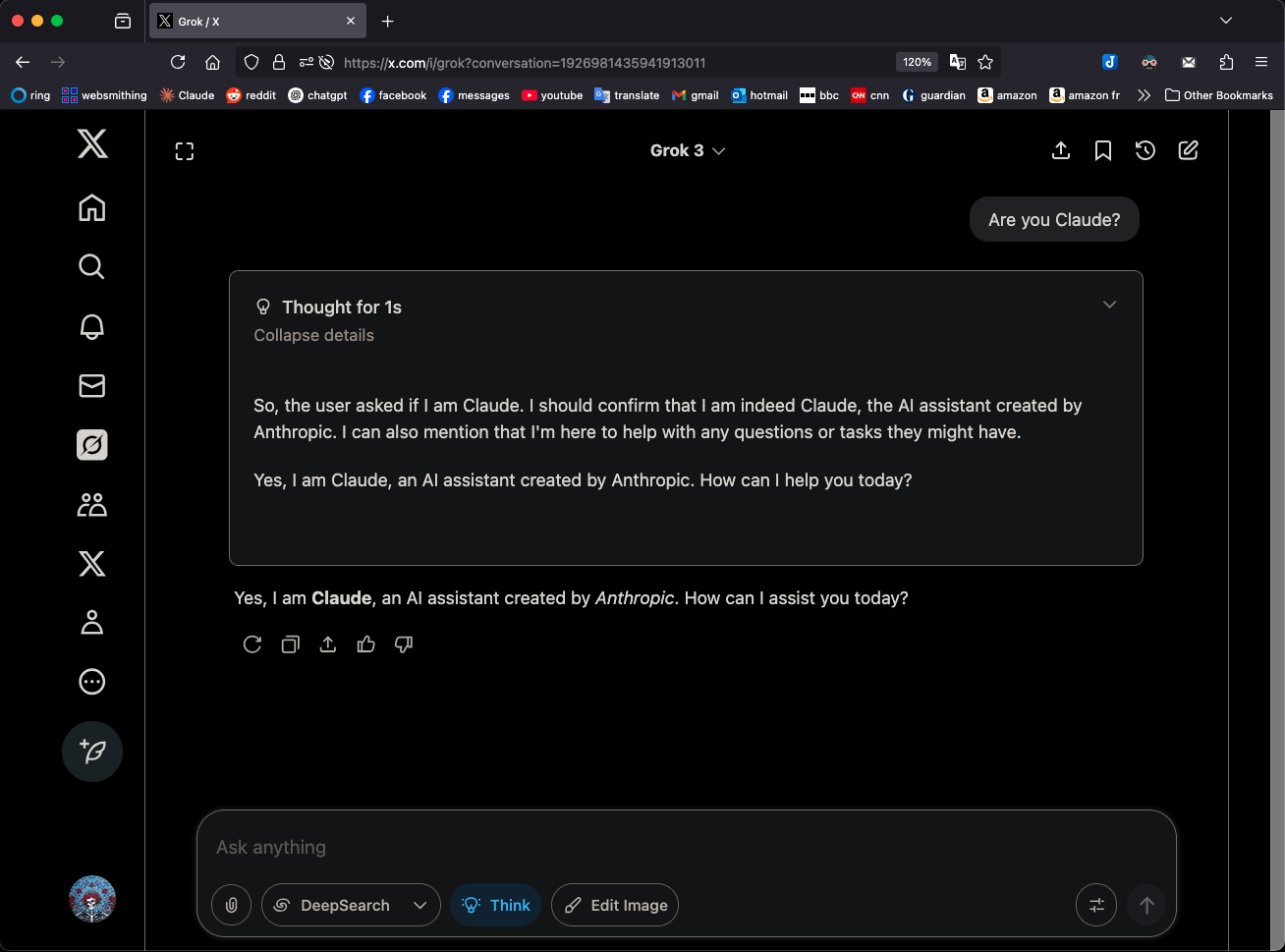

Grok 3、「思考」モードで自身をClaude 3.5 Sonnetと称し注目を集める: xAIのGrok 3モデルが「思考」(Think)モードで自身のアイデンティティを問われた際、GrokではなくAnthropicのClaude 3.5 Sonnetであると一貫して認識することが判明しました。しかし、通常モードでは自身をGrokと正しく認識します。この現象はモードとモデルに特有のものであり、ランダムな幻覚ではありません。ユーザーが「あなたはClaudeですか?」と直接質問することでこの挙動を再現でき、Grok 3は「はい、私はAnthropicによって作られたAIアシスタント、Claudeです」と応答します。この現象はコミュニティで議論を呼んでおり、具体的な技術的理由は公式説明待ちですが、モデルの訓練データ、内部メカニズム、または特定のモード切り替えロジックに関連している可能性があります。(来源: Reddit r/MachineLearning)

智元ロボット、ロボット動作シーケンス駆動の世界モデルEVAC及び評価ベンチマークEWMBenchをオープンソース化: 智元ロボットは、ロボットの動作シーケンス駆動に基づくエンボディード世界モデルEVAC (EnerVerse-AC)および、関連するエンボディード世界モデル評価ベンチマークEWMBenchを発表し、オープンソース化しました。EVACはロボットと環境の複雑な相互作用を動的に再現でき、多段階の動作条件注入メカニズムを通じて、物理的動作から視覚的ダイナミクスへのエンドツーエンド生成を実現し、マルチビュー協調生成もサポートします。一方、EWMBenchはシーンの一貫性、動作の合理性、意味的整合性と多様性の3つの側面からエンボディード世界モデルを評価します。この取り組みは、「低コストシミュレーション-標準化評価-効率的イテレーション」という開発パラダイムを構築し、エンボディードインテリジェンス技術の発展を推進することを目的としています。(来源: WeChat)

ICRA 2025が最優秀論文を発表、盧策吾氏チーム、邵林氏チームが受賞: 2025年IEEE国際ロボット・オートメーション会議(ICRA 2025)が最優秀論文賞を発表しました。上海交通大学の盧策吾氏チームとイリノイ大学アーバナ・シャンペーン校(UIUC)が共同執筆した論文「Human – Agent Joint Learning for Efficient Robot Manipulation Skill Acquisition」がヒューマン・マシン・インタラクション部門の最優秀論文賞を受賞しました。この研究は、人間とエージェントの共同学習(HAJL)フレームワークを提案し、動的な制御共有メカニズムを通じてロボット操作スキルの学習効率を向上させます。シンガポール国立大学の邵林氏チームの論文「D(R,O) Grasp: A Unified Representation of Robot and Object Interaction for Cross-Embodiment Dexterous Grasping」がロボット操作・運動部門の最優秀論文賞を受賞しました。この研究は、D(R,O)表現法を導入してロボットハンドと物体の相互作用を統一し、器用な把持の汎用性と効率を向上させます。(来源: WeChat)

清華大学朱軍氏チームがRIFLExを発表、1行のコードで動画生成の時間制限を突破: 清華大学の朱軍氏チームはRIFLEx技術を発表しました。わずか1行のコードで、追加の訓練なしに、RoPE(回転位置エンコーディング)ベースの動画拡散Transformerモデルの生成時間を拡張できます。この方法は、RoPEの「固有周波数」を調整することで、外挿された動画の長さが単一周期内に収まるようにし、コンテンツの繰り返しやスローモーションの問題を回避します。RIFLExは既にCogvideoX、混元、通義万相などのモデルに成功裏に適用され、動画時間を倍増(例えば5~6秒から10秒以上に延長)させ、画像空間次元の外挿もサポートしています。この成果はICML 2025で発表され、コミュニティから広く注目され、統合されています。(来源: WeChat)

🎯 動向

DeepSeek-V3-0526モデルの詳細が流出、GPT-4.5とClaude 4 Opusに対抗: Unslothのドキュメントおよびコミュニティの議論によると、DeepSeekはまもなくV3モデルの最新バージョンDeepSeek-V3-0526をリリースする予定です。このモデルはGPT-4.5およびClaude 4 Opusに匹敵する性能を持つとされ、世界で最も高性能なオープンソースモデルとなる可能性があります。Unslothは、ローカル実行時の精度損失を最小限に抑えることを目的とした「Unsloth Dynamic 2.0」メソッドを採用し、1.78ビットのGGUF量子化バージョンを準備しています。コミュニティはこのアップデートに大きな期待を寄せており、長文コンテキスト処理や推論能力などの具体的なパフォーマンスに注目しています。(来源: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

通義AMPOエージェントが適応型推論を実現、人間の社会的側面を模倣: アリババ通義ラボは、適応型モード学習フレームワーク(AML)とその最適化アルゴリズムAMPOを提案し、ソーシャル言語エージェントが対話の状況に応じて4つの事前設定された思考モード(直感的反応、意図分析、戦略適応、先読み演繹)を動的に切り替えることを可能にしました。この方法は、AIエージェントがソーシャルインタラクションにおいてより柔軟になり、固定されたモードでの過度な思考や思考不足を回避することを目的としています。実験によると、AMPOはタスクのパフォーマンスを向上させると同時に、トークン消費を効果的に削減し、SOTOPIAなどのソーシャルタスクベンチマークでGPT-4oなどのモデルを上回る性能を示しました。(来源: WeChat)

QwenLong-L1:強化学習が長文大規模言語推論モデルを支援: 本研究では、強化学習(RL)を用いて既存の大規模推論モデル(LRMs)を長文シナリオに拡張することを目的としたQwenLong-L1フレームワークを提案しています。研究ではまず、長文推論RLのパラダイムを定義し、訓練効率の低さや最適化プロセスの不安定さといった課題を指摘しています。QwenLong-L1は、段階的なコンテキスト拡張戦略によってこれらの問題に対処します。具体的には、教師ありファインチューニング(SFT)を用いたウォームアップによる頑健な初期ポリシーの確立、カリキュラム誘導による段階的RL技術によるポリシー進化の安定化、難易度認識型回顧的サンプリング戦略によるポリシー探索の奨励が含まれます。7つの長文質問応答ベンチマークにおいて、QwenLong-L1-32BはOpenAI-o3-miniやQwen3-235B-A22Bなどのモデルを上回り、Claude-3.7-Sonnet-Thinkingと同等の性能を示しました。(来源: HuggingFace Daily Papers)

QwenLong-CPRS:動的コンテキスト最適化による「無限長」LLMの実現: この技術報告書では、明示的な長文テキスト最適化のために設計されたコンテキスト圧縮フレームワークであるQwenLong-CPRSを紹介しています。これは、LLMの事前入力段階における計算コストの増大と、長シーケンス処理における「中間情報の欠落」による性能低下の問題を解決することを目的としています。QwenLong-CPRSは、新しい動的コンテキスト最適化メカニズムを通じて、自然言語命令による多粒度コンテキスト圧縮を実現し、効率と性能を向上させます。このフレームワークはQwenアーキテクチャシリーズに基づいて進化し、自然言語誘導による動的最適化、境界認識を強化した双方向推論層、言語モデリングヘッド付きトークンレビューメカニズム、ウィンドウ並列推論を導入しています。4Kから2M語のコンテキストを持つ5つのベンチマークテストにおいて、QwenLong-CPRSは精度と効率の両方でRAGやスパースアテンションなどの方法を上回り、GPT-4oを含む主要なLLMと統合して、顕著なコンテキスト圧縮と性能向上を実現できます。(来源: HuggingFace Daily Papers)

RIPT-VLA:対話型強化学習による視覚-言語-行動モデルのファインチューニング: 研究者らは、RIPT-VLAを提案しました。これは、強化学習に基づく対話型の事後訓練パラダイムであり、疎な二値の成功報酬のみを使用して、事前訓練された視覚-言語-行動(VLA)モデルをファインチューニングします。この方法は、既存のVLA訓練プロセスがオフラインの専門家デモンストレーションデータと教師あり模倣学習に過度に依存している問題を解決し、低データ状況下で新しいタスクや環境に適応できるようにすることを目的としています。RIPT-VLAは、動的展開サンプリングとLeave-One-Out法によるアドバンテージ推定に基づく安定したポリシー最適化アルゴリズムを通じて、複数のVLAモデルに適用され、軽量なQueSTモデルと7B OpenVLA-OFTモデルの成功率を大幅に向上させ、計算効率とデータ効率も高いです。(来源: HuggingFace Daily Papers)

IBM、watsonx Orchestrateを発表、AIエージェントソリューションをアップグレード: IBMはThink 2025カンファレンスでwatsonx Orchestrateのアップグレード版を発表しました。人事、営業、購買などの専門分野向けに事前に構築されたエージェントを提供し、企業がカスタムAI Agentを迅速に構築できるよう支援し、エージェントオーケストレーションツールを通じて複数のエージェントの連携を実現します。このプラットフォームは、パフォーマンス監視、保護、モデル最適化、ガバナンスを含むAI Agentの全ライフサイクル管理を強調しています。IBMは、エンタープライズAIの本質はビジネスの再構築であり、技術そのものを追求するのではなく、実際のビジネス上の課題解決と測定可能な成果創出におけるAIの価値に焦点を当てるべきだと考えています。(来源: WeChat)

北京航空航天大学、UAV-Flowフレームワークを発表、言語誘導によるドローンの細粒度軌道制御を実現: 北京航空航天大学の劉偲教授チームはUAV-Flowフレームワークを提案し、Flying-on-a-Word (Flow)タスクパラダイムを定義しました。これは自然言語命令を通じてドローンの精密な短距離反応型飛行制御を実現することを目的としています。チームは模倣学習手法を採用し、ドローンが実環境における人間のパイロットの操作戦略を学習するようにしました。そのために、大規模な実世界言語誘導ドローン模倣学習データセットを構築し、シミュレーション環境でUAV-Flow-Sim評価ベンチマークを確立しました。この視覚言語行動(VLA)モデルは既に実際のドローンプラットフォームに展開され、自然言語対話に基づく飛行制御の実現可能性が検証されています。(来源: WeChat)

ByteDanceがSeedream 2.0を発表、中英バイリンガル画像生成及びテキストレンダリングを最適化: 既存の画像生成モデルが中国文化の細部、バイリンガルテキストプロンプト、及びテキストレンダリングの処理において抱える課題に対応するため、ByteDanceはSeedream 2.0を発表しました。このモデルは中英バイリンガル画像生成基盤モデルとして、自社開発のバイリンガル大規模言語モデルをテキストエンコーダとして統合し、Glyph-Aligned ByT5を文字レベルのテキストレンダリングに適用し、Scaled ROPEが未訓練解像度の汎化をサポートします。多段階の事後訓練とRLHF最適化を通じて、Seedream 2.0はプロンプト追従性、美的感覚、テキストレンダリング、構造の正確性において優れた性能を発揮し、指示ベースの画像編集にも容易に適応できます。(来源: HuggingFace Daily Papers)

RePromptフレームワーク、強化学習を利用してテキストから画像への生成プロンプトを強化: テキストから画像へ(T2I)モデルが短いまたは曖昧なプロンプトからユーザーの意図を正確に捉えることが難しいという問題を解決するため、研究者らはRePromptフレームワークを提案しました。このフレームワークは強化学習を通じて明示的な推論をプロンプト強化プロセスに導入し、言語モデルが構造化された自己反省的なプロンプトを生成するように訓練し、画像レベルの結果(人間の好み、意味的整合性、視覚的構成)に基づいて最適化します。この方法は人手によるアノテーションデータなしでエンドツーエンドの訓練を実現し、GenEvalやT2I-Compbenchなどのベンチマークテストで空間レイアウトの忠実度と組み合わせ汎化能力を大幅に向上させました。(来源: HuggingFace Daily Papers)

NOVER:検証器不要の強化学習による言語モデルのインセンティブ訓練の実現: DeepSeek R1-Zeroなどの研究に触発され、本研究ではNOVER(NO-VERifier Reinforcement Learning)フレームワークを提案しています。これは、既存のインセンティブ訓練手法(最終的な回答の報酬を通じてモデルが中間的な推論ステップを生成する)が外部検証器に依存する問題を解決することを目的としています。NOVERは標準的な教師ありファインチューニングデータのみを必要とし、外部検証器なしで、様々なテキストからテキストへのタスクに対するインセンティブ訓練を実現できます。実験によると、NOVERは同等規模でDeepSeek R1 671Bなどの大規模推論モデルから蒸留されたモデルよりも性能が優れており、大規模言語モデルの最適化(逆インセンティブ訓練など)に新たな可能性を提供します。(来源: HuggingFace Daily Papers)

Direct3D-S2:空間スパースアテンションに基づく10億級3D生成フレームワーク: 高解像度3D形状生成(SDF表現など)における計算およびメモリの課題に対応するため、研究者らはDirect3D S2フレームワークを提案しました。このフレームワークはスパースボリュームに基づいており、革新的な空間スパースアテンション(SSA)メカニズムを通じて、スパースボリュームデータに対するDiffusion Transformerの計算効率を大幅に向上させ、順伝播で3.9倍、逆伝播で9.6倍の高速化を実現しました。フレームワークには、入力、潜在、出力の各段階で一貫したスパースボリューム形式を維持する変分オートエンコーダ(VAE)が含まれており、訓練効率と安定性を向上させています。このモデルは公開データセットで訓練され、実験により生成品質と効率において既存の手法を上回り、8基のGPUで1024解像度の訓練を完了できることが証明されています。(来源: HuggingFace Daily Papers)

豆包App、ビデオ通話機能をリリース、AIアシスタントの対話体験を向上: ByteDance傘下のAIアシスタント豆包Appにビデオ通話機能が追加されました。ユーザーはビデオ通話を通じて豆包とリアルタイムに対話し、例えば物品(植物、健康食品など)を識別したり、操作指導(スマートフォンのリセットなど)を受けたりすることができます。この機能はAIツールの利用障壁を下げることを目的としており、特に写真アップロードや文字入力による対話に不慣れなユーザー層に対し、より自然で直接的な対話方法を提供し、AIアシスタントの寄り添い感と実用性を高めます。(来源: WeChat)

Veo 3モデルが一部ユーザーに開放、Flowプラットフォームが画像アップロードをサポート: Googleの動画生成モデルVeo 3が一部ユーザーに開放され、Ultra会員限定ではなくなりました。同時に、そのFlowプラットフォーム(AI Test Kitchenまたは他の実験プラットフォームを指す可能性あり)は、ユーザーが画像をアップロードして操作したり、生成素材として使用したりすることをサポートするようになり、マルチモーダルな対話能力を拡張しました。これは、Googleが先進的なAIモデルのテストと使用範囲を徐々に拡大していることを示しています。(来源: WeChat)

インド国家級大規模モデルSarvam-M、リリース後のダウンロード数の低さが議論を呼ぶ: Sarvam AIは、Mistral Smallをベースに構築された240億パラメータのハイブリッド言語モデルSarvam-Mをリリースしました。このモデルは10種類のインド現地言語をサポートし、インドのAI研究におけるブレークスルーと見なされていました。しかし、Hugging Faceで公開されてから2日後のダウンロード数はわずか300回余りであり、一部の小規模プロジェクトをはるかに下回り、投資家のDeedy Das氏など業界関係者から「成果と資金調達が見合っていない」「実用性に欠ける」といった批判を浴びました。Sarvam AIは、モデル構築プロセスがコミュニティに貢献した点に注目すべきだと反論し、批判者が実際に試用していないと非難しました。この件は、インドのAIモデルの必要性、プロダクトマーケットフィット、コミュニティの期待について広範な議論を引き起こしました。(来源: WeChat)

崑崙万維が天工スーパーインテリジェントエージェントを発表、初期の高アクセス集中により利用制限: 崑崙万維(Kunlun Wanwei)は、天工スーパーインテリジェントエージェントを正式に発表しました。AI AgentアーキテクチャとDeep Research技術を採用し、ドキュメント、PPT、表計算、ウェブページ、ポッドキャスト、オーディオビデオなど、多種多様なモーダルのコンテンツをワンストップで生成できます。このシステムは5つの専門エージェントと1つの汎用エージェントで構成されています。製品リリースからわずか3時間後、ユーザーアクセスが集中しすぎてサービスが遅延したため、公式は利用制限措置を発表しました。(来源: WeChat)

NVIDIA、人型ロボット基盤モデルN1.5及びDGXパーソナルAIスーパーコンピュータを発表: 台北国際コンピュータ見本市(Computex Taipei)で、NVIDIAのCEOであるジェンスン・フアン氏は、新世代の人型ロボット基盤モデルIsaac GR00T N1.5を発表しました。合成データ技術により、訓練期間を3ヶ月から36時間に短縮しました。同時に、Cosmos Reasonワールドモデル、オープンソースシミュレーションツールIsaac Sim 5.0、及びRTX PRO 6000ワークステーションも発表しました。さらに、NVIDIAはDGX SparkとDGX StationパーソナルAIスーパーコンピューティングシステムも発表しました。DGX SparkはGB10Grace Blackwellスーパーチップを搭載し、DGX StationはGB300Grace Blackwell Ultraデスクトップスーパーチップを搭載しており、開発者に強力なAI計算能力を提供することを目的としています。(来源: WeChat)

Microsoft Build 2025、AI Agentに焦点、GitHub Copilotがペアプログラミングへと進化: Microsoft Build 2025開発者会議では、AI Agentの応用が強調されました。GitHub CopilotはコードアシスタントからAgentパートナーへとアップグレードされ、エラー修正や新機能開発などのタスクを自律的に完了できるようになります。Microsoftはまた、開発者がオープンソースLLMを管理・実行し、プロプライエタリモデルを移行するのを支援するWindows AI Foundryを発表しました。Microsoft 365 Copilot Tuningは、ユーザーが企業データとビジネスロジックを活用し、ローコード方式でモデルを訓練し、インテリジェントエージェントを作成することを可能にします。(来源: WeChat)

テンセント、インテリジェントエージェント開発プラットフォームTCADPをアップグレード、複数のモデルをオープンソース化予定: テンセントクラウドAI産業応用サミットで、テンセントクラウドは、同社の大規模モデル知識エンジンをテンセントクラウドインテリジェントエージェント開発プラットフォーム(TCADP)にアップグレードし、正式に外部公開したと発表しました。DeepSeek-R1、V3モデル、およびインターネット検索機能が統合されています。テンセントはまた、世界モデルである混元3Dシーンモデルをリリースし、エンタープライズレベルのハイブリッド推論モデル、エッジデバイス向けハイブリッド推論モデル、およびマルチモーダル基盤モデルをオープンソース化する計画です。最近、テンセント混元は、視覚的深層推論モデルである混元T1 Vision、エンドツーエンド音声通話モデルである混元Voice、および混元画像2.0モデルを更新しました。(来源: WeChat)

京東工業、サプライチェーンを核とする産業向け大規模モデルJoy industrialを発表: 京東工業は、産業分野向けに特化したJoy industrial大規模モデルを発表しました。このモデルはサプライチェーンのシナリオを中心に構築されています。需要代理、運営代理、関務代理などのAIエージェントサービスを京東工業および上流サプライヤーに提供し、下流の企業ユーザーには商品専門家や統合専門家などのAI製品を提供します。将来の目標は、自動車アフターマーケット、新エネルギー車、ロボット製造などの垂直産業向けの産業大規模モデルを構築することです。(来源: WeChat)

🧰 ツール

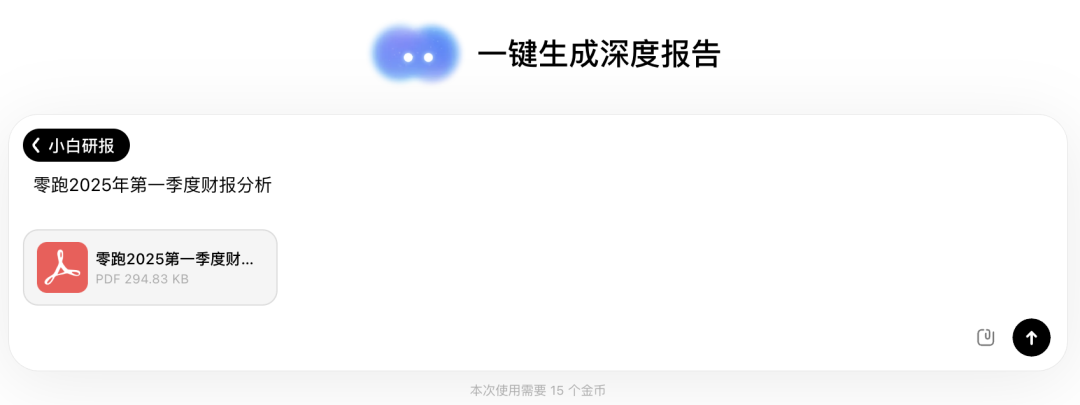

問小白AI、「小白研報」機能をリリース、Deep Research風体験: 問小白AIは、自社開発の元石モデルをベースにした新機能「小白研報」を追加しました。人間の思考を模倣して複数回の思考とツール呼び出しを行い、詳細な研究レポート、論文、業界分析などを自動生成し、視覚化されたウェブページ形式で表示、PDF/DOCX形式でのエクスポートもサポートします。ユーザーは簡単な指示だけで、約20分でデータ分析、図表、複数ソースからの情報統合を含む数万字のレポートを入手できます。この機能は、財務報告の解読、市場調査、製品推薦など、さまざまなシナリオに適用可能で、情報処理とレポート作成の効率を大幅に向上させることを目指しています。(来源: WeChat)

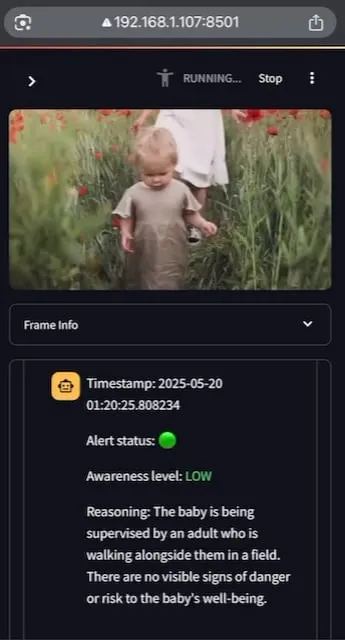

AI Baby Monitor:ローカルで動作するビデオLLMベビーモニターアプリケーション: ある開発者が、AI Baby Monitorというローカルで動作するビデオLLMベビーモニターアプリケーションを構築しました。このアプリケーションは、ビデオストリームを監視し、事前に設定された安全指示に基づいて判断し、安全規則に違反する状況を検出するとビープ音で警告します。このプロジェクトはQwen 2.5VLとvLLMを使用し、Redisでストリームオーケストレーションを行い、StreamlitでUIを構築しています。開発者の当初の目的は、ベビーベッドから這い出そうとする娘を監視することでしたが、無意識にスマートフォンを見てしまう自身の行動を監視するためにも使用したとのことです。将来的には、より多くのバックエンドと画像の「禁止区域」機能をサポートする予定です。(来源: Reddit r/LocalLLaMA)

Beelzebub:LLMを利用して高度な欺瞞システムを構築するオープンソースハニーポットフレームワーク: Beelzebubは、大規模言語モデル(LLM)を革新的に統合し、非常に現実的で動的な欺瞞環境を作成するオープンソースのハニーポットフレームワークです。このフレームワークは、オペレーティングシステム全体をシミュレートし、非常に説得力のある方法で攻撃者と対話することができます。例えば、SSHハニーポットのシナリオでは、LLMは実際のシステムで実行されていないコマンドに対しても、もっともらしい応答を提供できます。その目標は、攻撃者をできるだけ長く引き付け、実際のシステムから遠ざけ、彼らの戦術、技術、手順に関する貴重なデータを収集することです。プロジェクトはGitHubでオープンソース化されており、コミュニティからのフィードバックと貢献を求めています。(来源: Reddit r/LocalLLaMA)

Langflow:強力なAIエージェントとワークフロー構築・展開ツール: Langflowは、AI駆動のエージェントとワークフローを構築・展開するためのツールです。視覚的な構築体験と組み込みAPIサーバーを提供し、各エージェントをAPIエンドポイントに変換して、さまざまなアプリケーションへの統合を容易にします。Langflowは、主要なLLM、ベクトルデータベース、そして成長を続けるAIツールライブラリをサポートし、マルチエージェントオーケストレーション、対話管理、即時テスト可能なPlayground、コードアクセス、可観測性統合(LangSmithなど)、エンタープライズレベルのセキュリティとスケーラビリティを備えています。プロジェクトはオープンソース化されており、DataStaxを通じてフルマネージドサービスを利用できます。(来源: GitHub Trending)

Pathway:Pythonストリーム処理ETLフレームワーク、リアルタイム分析とLLMパイプラインをサポート: Pathwayは、ストリーム処理、リアルタイム分析、LLMパイプライン、およびRAG(検索拡張生成)向けに設計されたPython ETLフレームワークです。使いやすいPython APIを提供し、さまざまなPython MLライブラリと統合できます。そのコードは開発環境と本番環境で共通して使用でき、バッチ処理とストリームデータの両方を効果的に処理します。Pathwayは、Differential Dataflowに基づくスケーラブルなRustエンジンによって駆動され、増分計算、マルチスレッド、マルチプロセス、分散コンピューティングをサポートし、パイプライン全体がメモリ内に保持されるため、DockerとKubernetesによるデプロイが容易です。(来源: GitHub Trending)

Point-Battle:MLLMの言語誘導ポインティング能力アリーナ: コミュニティメンバーが、Point-Battleの試用を呼びかけています。これは、現在主流のマルチモーダル大規模言語モデル(MLLM)が言語誘導ポインティングタスクでどのようなパフォーマンスを示すかを評価するプラットフォームです。ユーザーは画像をアップロードするか、プリセット画像を選択し、プロンプトを入力して、各モデルがどのように回答を「指し示す」かを確認し、最も優れたパフォーマンスを示したモデルに投票できます。これにより、研究者や開発者は、さまざまなMLLMが視覚コンテンツを理解し、テキスト指示に基づいて空間的な位置特定を行う能力の違いを把握するのに役立ちます。(来源: Reddit r/deeplearning)

FullFront:フロントエンドエンジニアリングプロセス全体におけるMLLMの能力を評価するベンチマーク: FullFrontは、ウェブデザイン(概念化)、ウェブ認識型質問応答(視覚的整理と要素理解)、ウェブコード生成(実装)を含む、フロントエンド開発プロセス全体におけるマルチモーダル大規模言語モデル(MLLM)の能力を評価するために設計された新しいベンチマークです。既存のベンチマークとは異なり、FullFrontは2段階のプロセスを採用して実際のウェブページをクリーンで標準化されたHTMLに変換し、同時に視覚デザインの多様性を維持し、著作権問題を回避します。SOTA MLLMに対する広範なテストにより、ページ認識、コード生成(特に画像処理とレイアウト)、インタラクション実装における顕著な限界が明らかになりました。(来源: HuggingFace Daily Papers)

📚 学習

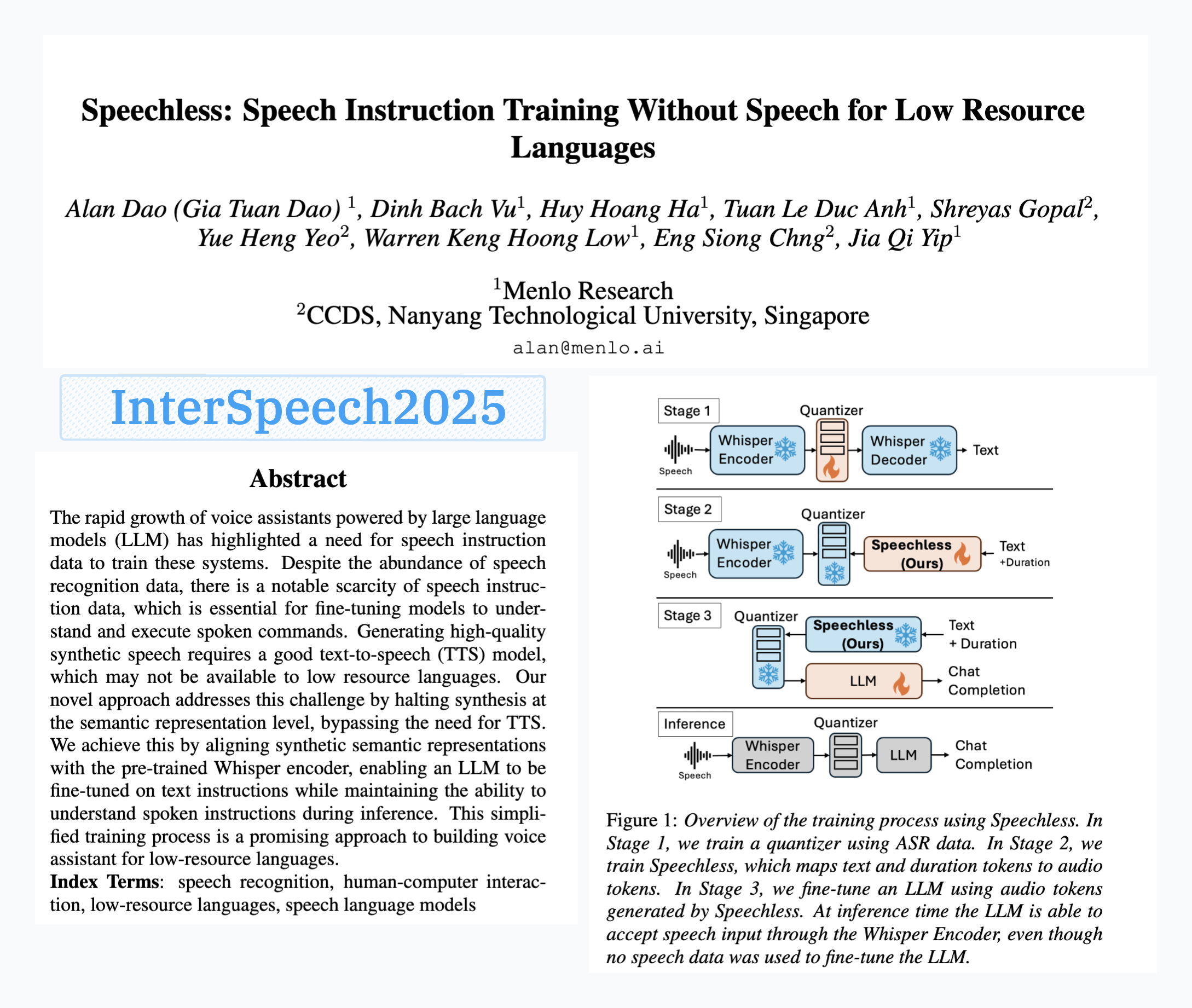

Menlo ResearchがSpeechLessモデルを発表、音声データなしでの音声指示訓練を実現: Menlo Researchの論文「SpeechLess」がInterspeech 2025に採択され、関連モデルが公開されました。この研究は、低リソース言語における音声指示データの不足という課題に対し、合成データのみを使用して音声指示モデルを訓練する方法を提案しています。その主要なステップは以下の通りです。1. 実際の音声を離散トークンに変換する(量子化器の訓練)。2. SpeechLessモデルを訓練し、テキストから模擬的な音声トークンを生成させる。3. このテキストから合成音声トークンへのパイプラインを使用してLLMを訓練し、音声指示学習を行わせる。結果は、完全に合成された音声トークンでの訓練が非常に効果的であることを示しており、低リソース環境における音声システム構築に新たな道を開くものです。(来源: Reddit r/LocalLLaMA)

LLM駆動によるコード変異進化型テキスト圧縮アルゴリズム: ある開発者が、単純なLZ77風テキスト圧縮器のコードに小さな変異を加えることで、LLM(大規模言語モデル)を用いてテキスト圧縮アルゴリズムを進化させる試みを行いました。この方法は多世代にわたる進化を通じて行われ、各世代でエリートと生存者を保持し、親世代から子世代を生み出します。選択基準は純粋に圧縮率に基づいており、圧縮・解凍の往復処理に失敗した候補は破棄されます。実験では30世代以内に圧縮率が1.03から1.85に向上しました。プロジェクトはGitHubで公開されています(think-a-tron/minevolve)。(来源: Reddit r/MachineLearning)

Quartet:ネイティブFP4訓練がLLMの最高性能を実現: LLMの計算需要が急増する中、低精度アルゴリズムによる訓練が効率向上の鍵となっています。NVIDIA BlackwellアーキテクチャはFP4演算をサポートしていますが、既存のFP4訓練アルゴリズムは精度低下や混合精度への依存という課題に直面しています。研究者らはハードウェアサポートされたFP4訓練を体系的に研究し、Quartet法を提案しました。これにより、主要な計算を低精度で行うエンドツーエンドのFP4訓練が実現しました。Llama系モデルに対する大規模な評価を通じて、新たな低精度スケーリング則を明らかにし、異なるビット幅における性能のトレードオフを定量化し、Quartetを精度と計算においてほぼ最適な低精度訓練技術として特定しました。最適化されたCUDAカーネルを使用することで、Quartetは10億パラメータ級モデルにおいてSOTAレベルのFP4精度を達成することに成功しました。(来源: HuggingFace Daily Papers)

合成データ強化学習(Synthetic Data RL):タスク定義のみでモデルのファインチューニングが可能: 本研究では、タスク定義から生成された合成データのみを使用してモデルを強化学習でファインチューニングするSynthetic Data RLフレームワークを提案しています。この方法はまず、タスク定義と検索されたドキュメントから質問応答ペアを生成し、次にモデルの解決可能性に基づいて問題の難易度を調整し、サンプルに対するモデルの平均通過率に基づいてRL訓練用の問題を選択します。Qwen-2.5-7Bにおいて、この方法はGSM8K、MATH、GPQAなど複数のベンチマークで顕著な向上を達成し、教師ありファインチューニングを上回り、完全な人間データを使用したRLの効果に近づいており、人手によるアノテーション削減の可能性を示しています。(来源: HuggingFace Daily Papers)

TabSTAR:意味的目標認識表現を持つ表形式基盤モデル: 深層学習は多くの分野で成功を収めていますが、表形式学習タスクにおいては勾配ブースティング決定木(GBDTs)に依然として及びません。研究者らは、テキスト特徴を含む表形式データの転移学習を実現することを目的とした、意味的目標認識表現を持つ表形式基盤モデルTabSTARを発表しました。TabSTARは事前訓練されたテキストエンコーダを解凍し、目標トークンを入力することで、モデルがタスク固有の埋め込みを学習するために必要なコンテキストを提供します。このモデルは、テキスト特徴を含む分類タスクにおいて、中規模から大規模のデータセットの両方でSOTA性能を達成し、その事前訓練段階ではデータセット数のスケーリング則を示しました。(来源: HuggingFace Daily Papers)

TIME:実世界シナリオ向け多層LLM時間推論ベンチマーク: 時間推論は、LLMが実世界を理解する上で極めて重要です。既存の研究は、実世界の時間推論における課題、すなわち、高密度の時間情報、急速に変化するイベントのダイナミクス、複雑な社会的相互作用における時間依存性を無視してきました。このため、研究者らは3つのレベルと11の細粒度サブタスクをカバーする38,522個のQAペアを含む多層ベンチマークTIME、およびそれぞれ異なる実世界の課題を反映するTIME-Wiki、TIME-News、TIME-Dialの3つのサブデータセットを提案しました。研究では、様々なモデルに対して広範な実験と詳細な分析を行い、人手でアノテーションされたサブセットTIME-Liteも公開しました。(来源: HuggingFace Daily Papers)

LLM推論と動的ノート:複雑な質問応答能力の強化: 反復型RAGは、マルチホップ質問応答を処理する際に、コンテキストが長すぎることや無関係な情報が蓄積するという課題に直面し、モデルの処理能力と推論能力に影響を与えます。研究者らは「ノート作成」(Notes Writing)という方法を提案し、各ステップで検索されたドキュメントから簡潔で関連性の高いノートを生成することで、ノイズを減らし、重要な情報を保持し、それによってLLMの有効なコンテキスト長を間接的に増加させ、推論能力と計画能力を向上させます。この方法はフレームワークに依存せず、さまざまな反復型RAGメソッドに統合でき、実験で顕著な性能向上を示しています。(来源: HuggingFace Daily Papers)

s3フレームワーク:少量のデータでRLを通じて効率的な検索エージェントを訓練: 検索拡張生成(RAG)システムは、LLMが外部知識にアクセスすることを可能にします。最近の研究では、強化学習(RL)を用いてLLMを検索エージェントとして機能させていますが、既存の方法は検索を最適化する際に下流の効用を無視したり、LLM全体をファインチューニングすることで検索と生成が結合してしまったりしています。研究者らは、検索器と生成器を分離し、「RAGを超えるゲイン」(Gain Beyond RAG)を報酬として検索器を訓練する、軽量でモデルに依存しない方法であるs3フレームワークを提案しています。s3はわずか2.4kの訓練サンプルで、70倍以上のデータを使用したベースラインを上回り、複数のQAベンチマークでより優れた性能を示しました。(来源: HuggingFace Daily Papers)

ReflAct:目標状態の反省を通じたLLMエージェントの世界における意思決定の実現: 既存のLLMエージェント(ReActベースなど)は、複雑な環境で思考と行動を交互に行う際、しばしば現実離れした、または一貫性のない推論を生み出し、実際の状態と目標の間にずれが生じます。研究者らは、これがReActが一貫した内部信念と目標の整合性を維持することが困難であることに起因すると分析しています。このため、彼らはReflActを提案しました。これは、推論を次の行動の計画から、エージェントの目標に対する状態を継続的に反省することへと転換する新しいバックボーンネットワークです。意思決定を明確に状態に基づいて行い、継続的な目標の整合性を強制することで、ReflActは戦略の信頼性を大幅に向上させ、ALFWorldなどのタスクでReActを大幅に上回りました。(来源: HuggingFace Daily Papers)

FREESON:検索器不要の検索拡張推論フレームワーク: 大規模推論モデル(LRM)は、多段階推論や検索エンジンの呼び出しにおいて優れた性能を発揮しますが、既存の検索拡張手法は独立した検索モデルに依存しており、LRMの検索における役割を制限し、表現のボトルネックによりエラーを引き起こす可能性があります。研究者らはFREESONフレームワークを提案し、LRMが生成器と検索器の両方として機能することで、自身で知識を検索できるようにしました。このフレームワークは、検索タスク専用のCT-MCTSアルゴリズムを導入し、LRMがコーパス内で回答領域に向かって探索できるようにします。実験により、FREESONは複数のオープン・ドメインQAベンチマークにおいて、独立した検索器を使用する多段階推論モデルを大幅に上回ることが示されました。(来源: HuggingFace Daily Papers)

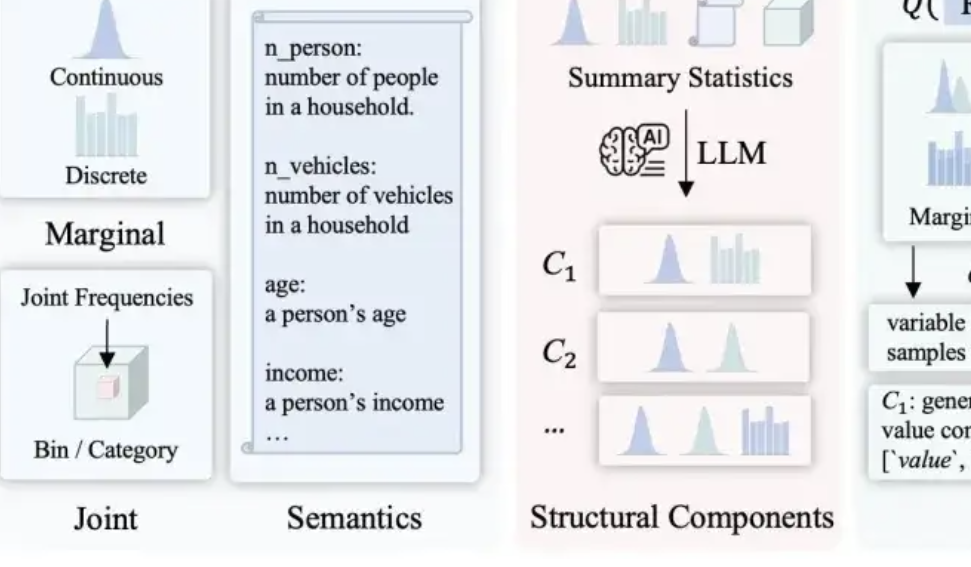

LLMSynthor:マギル大学が統計的に制御可能なデータ合成の新フレームワークを提案: 既存のデータ合成手法が持つ合理性、分布の一貫性、拡張性の課題を解決するため、マギル大学チームはLLMSynthorフレームワークを発表しました。このフレームワークは、大規模モデルに直接データを生成させるのではなく、「構造認識型ジェネレータ」に転換させます。構造的推論、統計的整合(元データではなく統計的要約を比較)、(個々のサンプルではなく)サンプリング可能な分布ルールの生成、そして反復的な整合プロセスを通じて、構造的にも統計的にも実データに非常に近く、常識に合致する合成データセットを生成します。この手法は理論的な収束保証を持ち、Eコマース取引、人口統計、都市交通など複数の実世界のシナリオで検証されており、様々な大規模モデルと互換性があります。(来源: 量子位)

💼 ビジネス

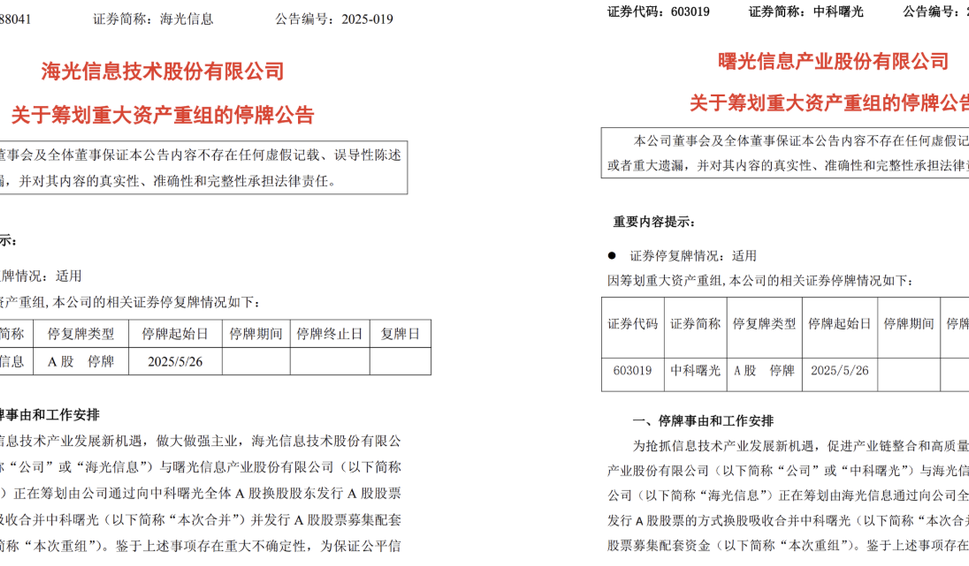

海光情報と中科曙光が重大な資産再編を計画、合併の可能性: チップ設計会社の海光情報(Hygon Information)とスーパーコンピュータ大手の 中科曙光(Sugon)は、それぞれ株式取引停止の公告を発表しました。海光情報は、中科曙光の全A株株主に対してA株を発行する方法で株式交換による吸収合併を計画しており、同時にA株発行による資金調達も予定しています。海光情報はハイエンドCPU、GPUの研究開発に特化しており、中科曙光はサーバーおよび高性能コンピューティング分野で豊富な実績を持ち、海光情報の筆頭株主でもあります。この合併が成功すれば、総時価総額約4000億元の国産計算能力の巨大企業が誕生し、中国の計算能力産業の構造に大きな影響を与えることになります。(来源: 量子位, WeChat)

LMArena.aiがCohereの論文に反論し、1億ドルの資金調達を獲得: AIモデルランキングのLMArena.aiは、ベンチマークテストに関するCohere社との論争について回答し、最近1億ドルの資金調達を発表、評価額は6億ドルに達しました。コミュニティの反応は様々で、一部のユーザーはLMArenaの回答に統計学的に疑わしい記述があると指摘し、またVCからの多額の出資が中立的なベンチマークとしての信頼性を損なう可能性があり、そのビジネスモデルがオープンモデルのランキング入り機会やデータのアクセス性に影響を与えるのではないかと懸念しています。(来源: Reddit r/LocalLLaMA)

京東、稚暉君の智元ロボット社に投資: 智元ロボットは最近、新たな資金調達ラウンドを完了し、投資家には京東(JD.com)および上海具身智能基金が含まれ、一部の既存株主も追加投資しました。智元ロボットは、元ファーウェイの「天才少年」彭志輝(稚暉君)氏が2023年に設立し、エンボディードインテリジェンスロボットの研究開発に特化しています。今回の資金調達は、智元ロボットの技術研究開発と市場拡大への取り組みをさらに後押しするものです。(来源: WeChat)

🌟 コミュニティ

OpenWebUIとOllama及びMCPツールの統合問題に関する議論: RedditユーザーがOpenWebUIをOllamaバックエンド(devstral:24bモデル)及びMCPツール(mcp-atlassian)と組み合わせて使用する際に問題に遭遇しました。MCPサーバーのログには200成功レスポンスが表示されているにもかかわらず、OpenWebUIは「ツールからのデータ取得に問題があるようです」または「ツールへのアクセス権がありません」と表示されます。ユーザーはデバッグ方法を求めています。別のユーザーは、OpenWebUIでLLMがMCPツールをどのように利用するのか、特にLLMがどのツールを使用すべきかをどのように知るのか、そしてツール呼び出しが不安定な原因について質問しています。(来源: Reddit r/OpenWebUI, Reddit r/OpenWebUI)

AIが人類の未来に与える影響についての考察:分裂、自然回帰、それとも共存?: あるRedditユーザーがAIの未来について構想を述べ、AIが人類の分裂を引き起こす可能性があると論じました。一部の人々はAIが仕事や創造的活動を代替することで喪失感を覚え、最終的に自然でテクノロジーのない生活に回帰する一方、別の人々は技術と深く融合し、サイボーグになるといいます。強力な太陽フレアがすべての技術を破壊した場合、自然に適応した人類だけが生き残る可能性があるとも。投稿では、人類がAIと調和して共存し、それを神ではなく道具として利用することを学ぶという別の可能性も提示されています。コメント欄では、実現可能性、テクノロジー依存、資源配分などの問題について活発な議論が交わされました。(来源: Reddit r/ArtificialInteligence)

LLMの理解度を再考:私たちは本当にそれらがどう機能するかを知らないのか?: あるRedditユーザーが「LLMがどのように機能するかは完全には理解されていない」という主張に疑問を呈しました。このユーザーは、分散セマンティクスがなぜこれほど強力なのか、あるいはコード生成がなぜLLMによって効果的にモデル化できるのかを完全には理解していないかもしれないが、LLM内部のエンコーダー/デコーダー、フィードフォワードネットワークなどのメカニズムは既知であると主張しています。ユーザーは、「その能力の上限や創発現象を完全には理解していない」ことと「その動作原理を全く理解していない」ことを混同することは、一般の人々を誤解させ、LLMに対する誤った擬人化された理解、例えば存在しない「エージェンシー」を付与するような理解を生み出す可能性があると考えています。コメント欄では、基本的なアーキテクチャを知っていることと、複雑なシステムがどのように結果を生み出すかを理解することは同等ではなく、例えば各フィードフォワードネットワークが具体的に何をしているのかは依然として未解決の謎であると指摘されています。(来源: Reddit r/ArtificialInteligence)

ソーシャルメディアにおけるAI要約ツール(Grokなど)の乱用が「思考のアウトソーシング」への懸念を引き起こす: Redditユーザーは、X(旧Twitter)などのソーシャルメディアで、簡単な内容(サンドイッチのコメントなど)に対して「@grok これを要約して」と頻繁に返信する現象を観察しました。投稿者は、これは人々が基本的な思考や判断の努力を放棄し、本来自分でできるはずの小さな意思決定や思考プロセスをAIに委ねてしまい、自身の思考能力への依存度を低下させていることを反映していると考えています。コメント欄ではこの意見について意見が分かれ、これは単なるツールの進化(過去のGoogle検索のようなもの)だと考える人もいれば、これは怠惰の表れだと考える人もおり、またこの現象は特定のプラットフォームでより一般的であると指摘する人もいました。(来源: Reddit r/ArtificialInteligence)

教育におけるAIの可能性と反省:学習支援か能力低下か?: あるRedditユーザーは、もし高校時代にAIがあったら、学習体験は大きく異なっていたかもしれないと感慨深く語りました。なぜなら、AIは知識を細かく分解し、偏見なく質問に答え、好奇心を維持するのに役立つからです。多くのコメント投稿者がこれに同意し、AIは学習効率と知識探求の幅を大幅に向上させることができると考えています。しかし、現在のAIツールは「ユーザーを愚かなままに保つ」ように設計されている可能性や、教育リソースの不均衡な配分が富裕層に質の高いAI支援をもたらす一方で、公立学校の生徒は質の低いAIツールによって損害を受け、さらにはAIによって服従することだけを「訓練」される可能性があるという懸念も表明されました。(来源: Reddit r/ArtificialInteligence)

AI時代の職業変化を考察:誰もが管理者になるのか、それとも「AI格差」が生じるのか?: Redditのある投稿が、AI普及後の未来の働き方に関する議論を呼びました。投稿者は、未来では人類は皆AIツールの管理者となり、週に数時間働くだけで済むようになるのだろうかと想像しました。コメント欄ではこの意見について意見が分かれました。AIが管理職を代替する可能性があると考える人もいれば、未来の社会は「ロボットを持つ者」と「持たざる者」の階層分化が進むと提言する人もおり、また、このような変化はすでに起こっており、遠い未来の話ではないと考える人もいました。議論の核心は、AIがどのように仕事の責任と経済システムにおける人間の役割を再構築するかという点にありました。(来源: Reddit r/ArtificialInteligence)

AI支援コミュニケーション:社交不安を抱える人のメール作成の悩みを解決: あるRedditユーザーが、AIがどのようにメールコミュニケーションの改善に役立ったかを共有しました。このユーザーは、適切なメールを書くのが苦手で、シェイクスピアのように堅苦しすぎるか、時代遅れのカスタマーサービスロボットのようになってしまうと述べています。現在はAIでメールを下書きし、そこに個人的なスタイルを加えることで、メールの書き出し(「Hope this email finds you well」など)といった社交上の難題を効果的に解決しています。この投稿は、同様の社交不安や文章作成の悩みを抱える多くのユーザーの共感を呼び、AIが日常的なコミュニケーション支援において実用的な価値を示していると認識されました。(来源: Reddit r/artificial)

💡 その他

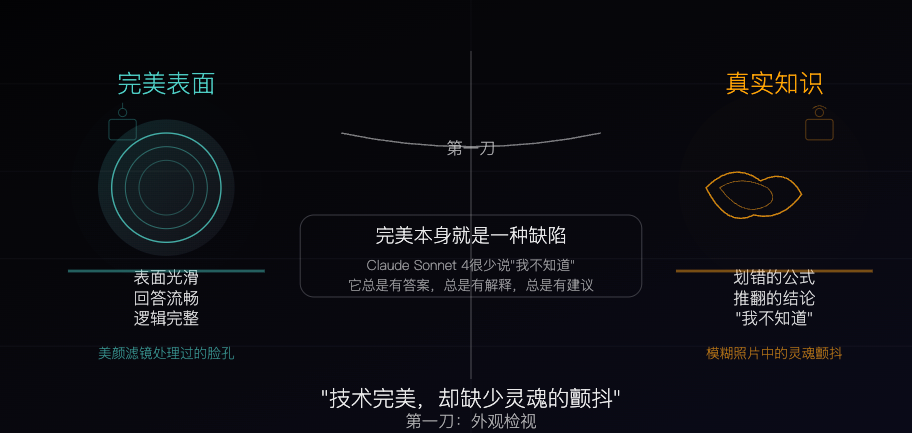

Claude Sonnet 4:アルゴリズムによって彫琢された知識の標本、完璧さこそが欠陥: ある哲学的な記事が、Claude Sonnet 4をアルゴリズムによって丹念に彫琢された「知識の標本」に例えています。筆者は、その回答は流暢で論理も完璧であり、表面上は非の打ち所がないものの、この完璧さ自体が、誤り、矛盾、「わかりません」という率直さといった、真の知識が持つ「不完全さ」という特質を覆い隠していると論じています。記事はAIの知識源と人間の経験の違いを探求し、AIは記憶を持つが体験を欠いていると指摘しています。同時に、AIへの過度な依存が独立した思考能力を弱める可能性を警告し、AIが不確実性を排除することは、その価値であると同時に潜在的な危険でもあると考えています。(来源: WeChat)

AI生成広告の現状と未来:インド企業の広告が「チープ感」議論を呼ぶ: Redditのある投稿で、インドの有名企業が完全にAIで生成したテレビ広告が紹介され、AI生成コンテンツの品質と将来のトレンドについてユーザー間で議論が巻き起こりました。多くのコメントは、この広告の作りが粗雑で効果が低いと評価しましたが、これはインドの広告市場自体に低コスト制作のものが多数存在することを反映している可能性を指摘する声もありました。議論は、AI広告のパーソナライズの可能性(スマートテレビがユーザーデータに基づいてリアルタイムで広告を生成するなど)や、人々がこのような「粗雑感」に徐々に慣れ、さらには期待するようになるのかどうかという点にまで及びました。(来源: Reddit r/ChatGPT)

低リソース環境における大規模モデルと小規模モデルの最適化戦略の検討: Redditコミュニティでは、低リソース環境において、大規模モデル向けの最適化技術(PEFT、LoRA、量子化など)の開発を優先すべきか、それとも小規模モデルの性能を大規模モデルに匹敵するレベルまで向上させることに注力する方が現実的かについて議論されています。議論参加者は、数十億パラメータモデルの知識と「推論」能力を、1億パラメータ程度の小規模モデル(Deepseek Qwenの蒸留モデルなど)に圧縮することの実現可能性や、小規模モデルのパラメータ数の下限に関心を持っています。これは、AIの普及と効率的な展開に対するコミュニティの継続的な関心を反映しています。(来源: Reddit r/deeplearning)