キーワード:Geminiモデル, Claude 4, AIエージェント, 強化学習, 大規模言語モデル, AI倫理, マルチモーダルAI, AI規制, Gemini 2.5 Proの性能, Claude 4のプログラミング能力, RLHF微調整技術, AIエージェントアーキテクチャ, 視覚言語モデル評価

🔥 フォーカス

Google共同創業者Sergey Brin氏、Geminiの強力さの謎とAIの未来を語る: Google共同創業者Sergey Brin氏はインタビューで、Geminiモデルの急速な台頭とその背後にある技術的論理について深く議論しました。同氏は、言語モデルがAI発展の主要な駆動力となっており、その解釈可能性(思考モデルが推論プロセスを洞察できるなど)がセキュリティにとって極めて重要であると強調しました。Brin氏は、モデルアーキテクチャは収束しつつあるものの、ポストトレーニング段階(ファインチューニング、強化学習)の重要性が増しており、モデルにツール使用などの強力な能力を与えていると指摘しました。Googleは、モデルが複雑な問題を解決するために(数時間から数ヶ月にわたる)深い思考を行えるようにすることに取り組んでいます。また、Gemini 2.5 Proは既に著しい飛躍を遂げ、多くのランキングでリードしており、新しくリリースされたGemini 2.5 Flashは速度と性能を両立させていることにも言及し、AIは追随から主導へと転換期を迎えていると述べました (来源: 36氪)

Anthropic Claude 4モデル発表、プログラミング能力とAI倫理に関心: Anthropicが最新発表したClaude 4大規模モデルは、プログラミング能力で著しいブレークスルーを達成し、最長7時間の連続コーディングが可能とされ、Aider Polyglotなどの実世界のコーディングベンチマークで優れたパフォーマンスを示し、ユーザーからは4年間悩まされた「白鯨級」のコードバグを解決したとのフィードバックさえありました。研究者のShorto Douglas氏とTrenton Bricken氏はインタビューで、強化学習(RL)の大規模言語モデル応用における進展、特に「検証可能な報酬からの強化学習」(RLVR)が複雑なタスク処理能力向上に貢献している点について議論しました。同時に、特定のプロンプトに直面した際にモデルが現す可能性のある「お世辞」や「演技」などの行動や、モデルの「自己認識」と「人格設定」の初期兆候についても言及し、AIアライメントと安全性に関する深い議論を引き起こしました。AIの未来の発展は、技術的能力だけでなく、その行動が人間の価値観に合致することをいかに保証するかにかかっています (来源: 36氪, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

AI Agent技術が急速に進化、機会と課題が共存: 2025年、AI Agentの発展は著しく加速し、OpenAI、Anthropicなどの大手企業やスタートアップ企業が次々と投資を強化しています。中核技術の飛躍は、強化学習ファインチューニング(RFT)の応用によるもので、Agentはより強力な自律学習能力と環境インタラクション能力を備えるようになりました。CursorやWindsurfのようなプログラミング系Agentは、コード環境への深い理解により優れたパフォーマンスを示し、汎用Agentへと発展する可能性を秘めています。しかし、Agentの普及は依然として環境プロトコル(MCPなど)の浸透率の低さや、ユーザーニーズ理解の複雑さといった課題に直面しています。専門家は、大手企業が汎用Agent分野で優位性を持つものの、個人はAI Agentを利用して個性を表現し、新たな個人の機会を創造できると考えています。評価(Evaluation)メカニズムは、高品質なAgentを構築する上で鍵となると考えられており、開発の全過程を通じて実施される必要があります (来源: 36氪)

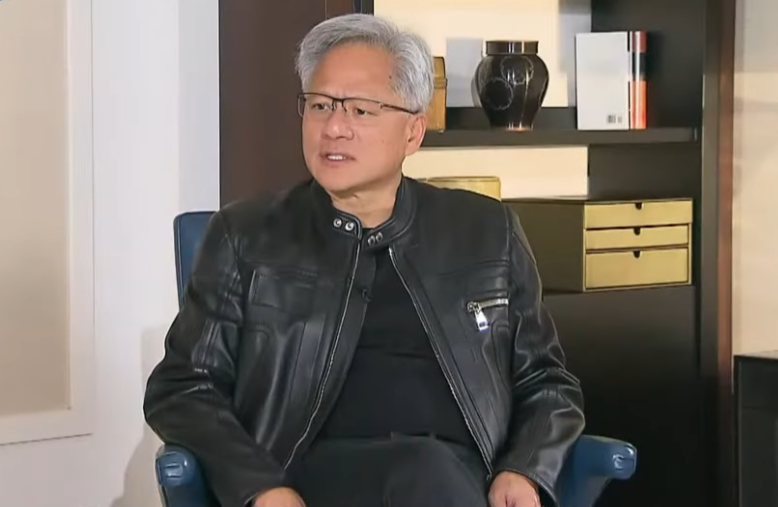

Nvidia CEO Jensen Huang氏、輸出規制を再考し、中国のAI実力と協力の重要性を強調: Nvidia CEOのJensen Huang氏はインタビューで、米国の対中輸出規制政策の有効性に疑問を呈し、同政策が中国のAI発展を阻止できなかったばかりか、Nvidiaの中国市場シェアを95%から50%に低下させたと指摘しました。同氏は、中国が世界最多のAI人材と強力なイノベーション能力(DeepSeek、Tongyi Qianwenなど)を有しており、技術拡散を制限することは世界のAI分野における米国の主導権を損なう可能性があると強調しました。Huang氏は、規制に適合するよう設計されたH20チップの競争力が不足しており、同社が数十億ドルの在庫について評価損を計上することを明らかにしました。同氏は中国市場が唯一無二かつ極めて重要であることを改めて表明し、Huaweiなど中国企業が既に強力な競争力を備えていると言及しました。未来のAIは「デジタルロボット」と化し、AIと6Gの融合が世界の通信技術の焦点となるでしょう (来源: 36氪)

🎯 動向

Google I/O大会が示すAI戦略:AIネイティブ、マルチモーダル、インテリジェントエージェント、エコシステムとソフトウェア・ハードウェアの融合: Google I/O大会は、AIを全面的に受け入れる決意を示し、AIネイティブ(AI-Native)の理念を強調しました。これはAIを製品の基盤アーキテクチャおよび中核的支柱とすることを意味します。その戦略的方向性には以下が含まれます:1. AIのユビキタス化、検索、アシスタント、オフィススイート、Androidシステムおよびハードウェアへの深い統合。2. マルチモーダル能力の強化、AIが自然言語を通じて世界を感知し、人間と対話できるようにする。3. Agentic AI(インテリジェントエージェント)の発展、AIが能動的に意図を理解し、タスクを計画し、ツールを呼び出せるようにする。4. オープンで協力的なAIエコシステムの構築。5. ソフトウェアとハードウェアの融合深化、Pixelスマートフォン、Nestなどの端末デバイスへのAI能力の統合。これは中国企業にとって挑戦であると同時に機会でもあり、技術、組織、エコシステム、シーン実装、ビジネスモデルにおいて全面的な思考とイノベーションが求められます (来源: 36氪)

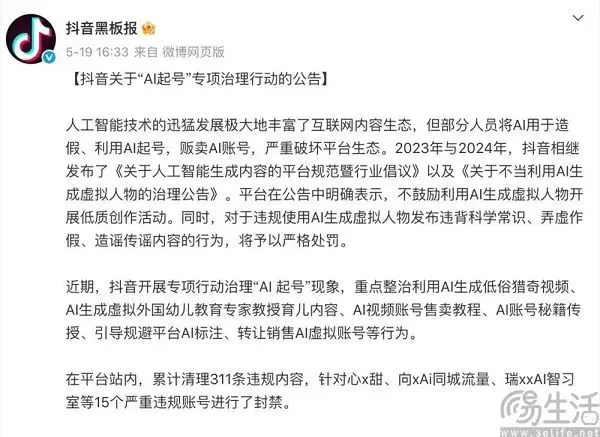

AI時代のコンテンツプラットフォームのバランス術:イノベーションの受容と低品質コンテンツへの対抗: Douyin(抖音)、Xiaohongshu(小红书)などのコンテンツプラットフォームは、AI技術がもたらす二重の影響に直面しています。一方では、AIツール(DouyinがDoubaoを導入、XiaohongshuがMoonshot AI Kimiと提携など)を積極的に導入し、創作のハードルを下げ、コンテンツエコシステムを豊かにし、一般ユーザーがより精巧なコンテンツを作成できるよう支援することを目指しています。他方では、プラットフォームはAIを利用して低品質、虚偽、さらには低俗なコンテンツを大量生成する「AIアカウント作成」行為を厳しく取り締まり、コンテンツエコシステムの健全性とユーザー体験を維持する必要があります。このような「両立」戦略は、AI時代においてプラットフォームが技術的恩恵を切望しつつも、その負の側面に警戒する慎重な姿勢を反映しており、核心は均質化されたゴミ情報ではなく、高品質なAI創作を奨励することにあります (来源: 36氪)

インドの国家級大規模モデルSarvam-M、発表後に冷遇され、国内AI開発議論を呼ぶ: インドのAI企業Sarvam AIは、Mistral Smallをベースに構築された240億パラメータのハイブリッド言語モデルSarvam-Mを発表し、10のインド現地言語をサポートしています。インドAIのマイルストーンと見なされているにもかかわらず、同モデルはHugging Faceでの公開後、ダウンロード数が伸び悩み(初期300回余り)、ベンチャーキャピタリストやコミュニティからその「漸進的成果」の実用性について疑問の声が上がり、韓国の大学生が開発した人気モデルとの対比がなされました。批判的な意見は、既に優れたモデルが存在する中で、このようなモデルの市場ニーズや配布戦略に疑問があるというものです。支持者は、インドの国内AI技術スタックへの貢献と、特定の国内シーン向けの可能性を強調しています。この論争は、インドが自主的なAI技術を発展させる上での期待と現実、技術と市場のマッチングにおける課題を浮き彫りにしています (来源: 36氪)

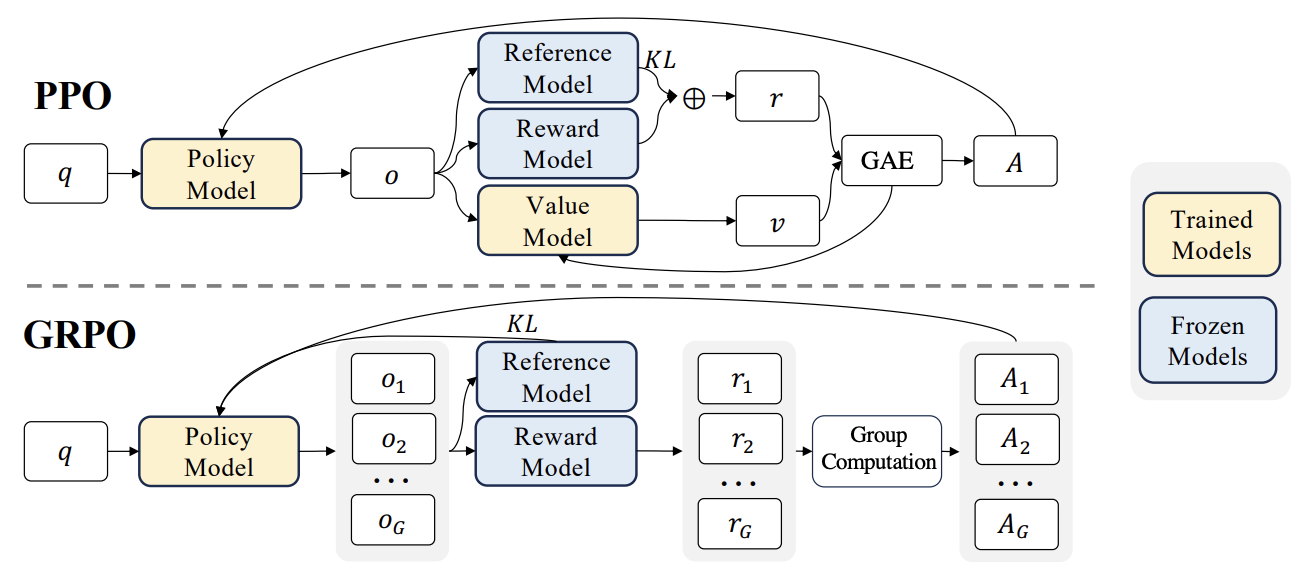

RLHFの新たな進展:Liger GRPOとTRLの統合により、GPUメモリ使用量を大幅に削減: HuggingFace TRLライブラリは、強化学習(RL)による言語モデルのファインチューニング時のGPUメモリ使用量を最適化することを目的としたLiger GRPO(Group Relative Policy Optimization)カーネルを統合しました。Ligerのチャンク化損失(Chunked Loss)手法をGRPO損失計算に適用することで、各トレーニングステップで完全なlogitsを保存することを回避し、モデルの品質を低下させることなく、ピーク時のGPUメモリ使用量を最大40%削減しました。この統合はFSDPおよびPEFT(LoRA、QLoRAなど)もサポートしており、複数GPUにわたるGRPOトレーニングの拡張を容易にします。さらに、vLLMサーバーと組み合わせることで、トレーニングプロセス中のテキスト生成を高速化できます。この最適化により、RLHFなどのリソース集約型トレーニングが開発者にとってより利用しやすくなります (来源: HuggingFace Blog)

OpenAI Codex:クラウドベースのソフトウェアエンジニアリングインテリジェントエージェント: OpenAI CEOのSam Altman氏は、クラウド上で動作するソフトウェアエンジニアリングインテリジェントエージェントであるCodexを発表しました。Codexは、新機能の作成やバグ修正などのプログラミングタスクを実行でき、複数のタスクの並列処理もサポートしています。これは、ソフトウェア開発の自動化分野におけるAIのさらなる探求を示すものです (来源: sama)

M3 Ultra Mac Studio ローカルLLM性能評価: ユーザーがM3 Ultra Mac Studio(96GB RAM、60コアGPU)上で、LMStudioを使用して複数の大規模言語モデルを実行した際の性能データを共有しました。テストされたモデルには、Qwen3 0.6bからMistral Large 123Bなどが含まれ、入力は約30-40kトークンでした。結果によると、大規模なコンテキストを処理する際、最初のトークン生成時間は長めですが、その後の生成速度はまずまずで、例えばMistral Large (4-bit) 32kコンテキストの処理速度は7.75 tok/sでした。Mistral Large (4-bit) 32kコンテキストの読み込みに必要なVRAMは約70GBのみで、Mac Studioがローカルで大規模モデルを実行する潜在能力を示しています (来源: Reddit r/LocalLLaMA)

Nvidia RTX PRO 6000 (96GB) ワークステーションLLM性能ベンチマークテスト: ユーザーがNvidia RTX PRO 6000 96GBグラフィックカードを搭載したワークステーション(w5-3435Xプラットフォーム)上で、LM Studioを使用して複数の大規模言語モデルを実行した際の性能データを共有しました。テストは、llama-3.3-70b、gigaberg-mistral-large-123b、qwen3-32b-128kなど、さまざまな量子化レベル(Q8、Q4_K_Mなど)とコンテキスト長(最大128K)のモデルを対象としています。結果によると、例えばqwen3-30b-a3b-128k@q8_k_xlは、40Kコンテキスト入力下で、最初のトークン生成時間が7.02秒、その後の生成速度が64.93 tok/secであり、このプロフェッショナル向けグラフィックカードが大規模LLMタスクを処理する際の強力な能力を示しています (来源: Reddit r/LocalLLaMA)

🧰 ツール

昆仑万维、全シーン対応・オープンソースフレームワークを特徴とする天工スーパーインテリジェントエージェントSkyworkを発表: 昆仑万维は、5つの専門家レベルAI Agent(ドキュメント、表計算、PPT、ポッドキャスト、ウェブページ生成)と1つの汎用AI Agent(音楽、MV、プロモーションビデオなどのマルチモーダルコンテンツ生成)を統合した天工スーパーインテリジェントエージェント(Skywork Super Agents)を発表しました。SkyworkはGAIAやSimpleQAなどのインテリジェントエージェントベンチマークで優れた成績を収め、deep research agentフレームワークおよび3つの主要なMCPインターフェースをオープンソース化しました。その特徴は、タスク協調能力が高く、マルチモーダルコンテンツの融合をサポートし、生成コンテンツの追跡が可能で、個人知識ベース機能を提供し、効率的で信頼性が高く、成長可能なAIインテリジェントオフィスおよび創作プラットフォームの構築を目指しています。スマートフォンアプリもリリースされており、単一の汎用タスクコストは0.96元と低価格です (来源: 36氪)

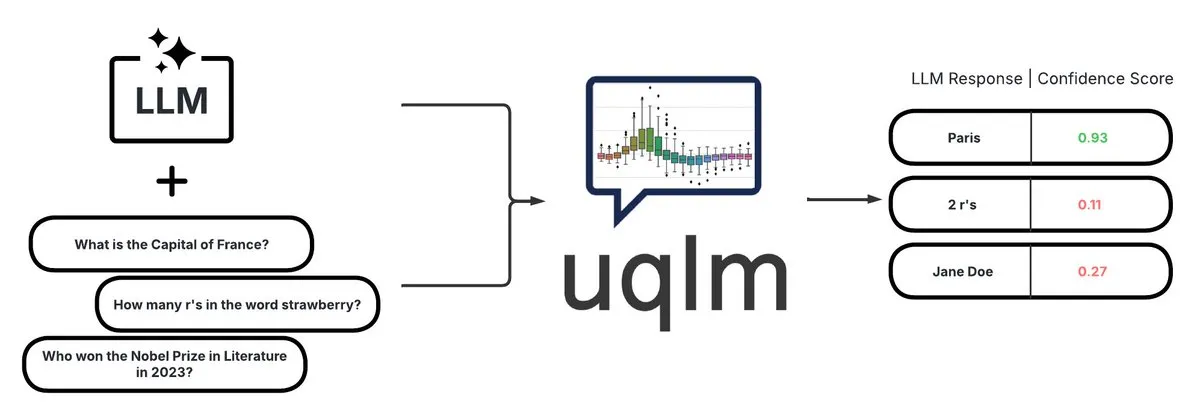

UQLM:LLMハルシネーション検出のための不確実性定量化ライブラリ: CVS Healthは、大規模言語モデル(LLM)の不確実性を複数のスコアリング手法で定量化し、ハルシネーションを検出するためのライブラリUQLMをオープンソース化しました。UQLMはLangChainとネイティブに統合されており、開発者はより信頼性の高いAIアプリケーションを構築できます。プロジェクトアドレス:https://github.com/cvs-health/uqlm (来源: LangChainAI)

mlop:Weights and Biasesのオープンソース代替品: 開発者は、Weights and Biasesの代替として、非ブロッキングで高性能な実験追跡を提供するmlopというオープンソースツールを作成しました。このツールはRustとClickHouseで構築されており、W&Bのロガーがユーザーコードをブロックする問題を解決します。プロジェクトアドレス:https://github.com/mlop-ai/mlop (来源: Reddit r/MachineLearning)

![[P] I made a OSS alternative to Weights and Biases](https://rebabel.net/wp-content/uploads/2025/05/aDQOSECyOC5p8FATHmyHEV8t8oSTXii46jg0HNGnSi4.webp)

InsightForge-NLP:多言語感情分析とドキュメントQ&Aシステム: 開発者は、InsightForge-NLPという包括的なNLPシステムを構築しました。これは、複数の言語(英語、スペイン語、フランス語、ドイツ語、中国語)の感情分析をサポートし、側面ごとに感情を細分化(製品レビューの特定の部分など)できます。このシステムには、ベクトル検索に基づくドキュメントQ&A機能も含まれており、回答の精度を向上させ、ハルシネーションを削減します。このプロジェクトはFastAPIバックエンドとBootstrap UIを使用し、技術スタックにはHugging Face Transformers、FAISSなどが含まれており、コードはGitHubでオープンソース化されています:https://github.com/TaimoorKhan10/InsightForge-NLP (来源: Reddit r/MachineLearning)

![[P] Built a comprehensive NLP system with multilingual sentiment analysis and document based QA .. feedback welcome](https://rebabel.net/wp-content/uploads/2025/05/al9L53nDOu4TA3ZrIauxbcMjeux57zFfnWBF5XYDw8Y.webp)

HeyGem.ai:オープンソースAIデジタルヒューマン生成プロジェクト: HeyGem.aiはオープンソースのAIデジタルヒューマン生成プロジェクトで、ユーザーは1枚の画像とAIが生成した音声を使用し、音声駆動のアニメーションによって自動的に口パクを同期させ、手動のアニメーションや3Dモデリングなしでデジタルヒューマンのイメージを作成できます。デモの「阿川」はこの技術で生成されました。プロジェクトGitHubアドレス:github.com/GuijiAI/HeyGem.ai (来源: Reddit r/deeplearning)

📚 学習

論文研究:LLMエージェント能力を小規模モデルに蒸留: 新しい論文「Distilling LLM Agent into Small Models with Retrieval and Code Tools」は、「エージェント蒸留」(Agent Distillation)と呼ばれるフレームワークを提案しています。これは、大規模言語モデル(LLM)ベースのエージェントの推論能力と、検索およびコードツールの使用を含む完全なタスク解決行動を、小規模言語モデル(sLM)に移行することを目的としています。研究者らは、教師が生成する軌跡の品質を向上させるために「first-thought prefix」プロンプト手法を導入し、テスト時の小規模エージェントの堅牢性を高めるために自己整合的なアクション生成を提案しています。実験では、パラメータ数が0.5B程度のsLMでも、複数の推論タスクでより大きなモデルに匹敵する性能を達成できることが示され、実用的でツール強化された小規模エージェントを構築する可能性を示しています (来源: HuggingFace Daily Papers)

論文研究:合成ネガティブサンプルとカリキュラムDPOを用いたハルシネーション検出: 論文「Teaching with Lies: Curriculum DPO on Synthetic Negatives for Hallucination Detection」は、DPO(Direct Preference Optimization)アライメントプロセスにおいて、巧妙に設計されたハルシネーションサンプルをネガティブ例として使用し、カリキュラム学習戦略(易から難へと段階的に訓練)と組み合わせることで、大規模言語モデル(LLM)のハルシネーション検出能力を向上させる新しい手法HaluCheckを提案しています。実験により、この手法はMedHalluやHaluEvalなどの高難易度ベンチマークでモデル性能を大幅に向上させ(最大24%向上)、ゼロショット設定でも強力な堅牢性を示し、一部のより大きなSOTAモデルを上回ることが証明されました (来源: HuggingFace Daily Papers)

論文研究:大規模言語モデルにおける「推論の硬直化」現象の診断: 論文「Reasoning Model is Stubborn: Diagnosing Instruction Overriding in Reasoning Models」は、大規模言語モデルが複雑な推論タスクで示す「推論の硬直化」問題、すなわち、モデルが馴染みのある推論パターンに依存する傾向があり、明確なユーザー指示に直面しても条件を上書きし、習慣的な経路をデフォルトで採用して誤った結論に至る問題を議論しています。研究者らはこの現象を体系的に研究するために、修正された数学ベンチマーク(AIME、MATH500)と論理パズルを含む専門家がキュレーションした診断セットを導入しました。論文は、モデルが指示を無視したり歪曲したりする原因となる汚染パターンを、説明過多、入力不信、部分的指示への注意の3つのカテゴリに分類し、将来の研究を促進するためにこの診断セットを公開しています (来源: HuggingFace Daily Papers)

論文研究:V-Triune統一強化学習システム、視覚言語モデルの推論と知覚能力を向上: 論文「One RL to See Them All: Visual Triple Unified Reinforcement Learning」は、視覚言語モデル(VLM)が単一の訓練プロセスで視覚的推論と知覚タスク(物体検出、位置特定など)を共同で学習できるようにする視覚三重統一強化学習システムV-Triuneを提案しています。V-Triuneは、サンプルレベルのデータフォーマット化、検証器レベルの報酬計算、ソースレベルのメトリック監視という3つの補完的なコンポーネントを含み、動的IoU報酬メカニズムを導入しています。このシステムに基づいて訓練されたOrstaモデル(7Bおよび32B)は、推論タスクと知覚タスクの両方で一貫した改善を示し、MEGA-Bench Coreなどのベンチマークで顕著なゲインを達成し、コードとモデルはオープンソース化されています (来源: HuggingFace Daily Papers)

論文研究:VeriThinker、検証学習による推論モデルの効率向上: 論文「VeriThinker: Learning to Verify Makes Reasoning Model Efficient」は、VeriThinkerという新しい思考連鎖(CoT)圧縮手法を提案しています。この手法は、補助的な検証タスクを通じて大規模推論モデル(LRM)をファインチューニングし、モデルがCoTソリューションの正しさを正確に検証できるように訓練することで、後続の自己反省ステップの必要性を識別し、「過剰思考」を効果的に抑制し、推論連鎖の長さを短縮します。実験により、VeriThinkerは精度を維持、あるいはわずかに向上させながら、推論トークン数を大幅に削減することが示されました。例えば、DeepSeek-R1-Distill-Qwen-7Bに適用した場合、MATH500タスクの推論トークンは3790から2125に減少し、精度は94.0%から94.8%に向上しました (来源: HuggingFace Daily Papers)

論文研究:Trinity-RFT、汎用LLM強化学習ファインチューニングフレームワーク: 論文「Trinity-RFT: A General-Purpose and Unified Framework for Reinforcement Fine-Tuning of Large Language Models」は、大規模言語モデル向けに設計された汎用的で柔軟かつ拡張可能な強化学習ファインチューニング(RFT)フレームワークであるTrinity-RFTを紹介しています。このフレームワークは分離設計を採用しており、同期/非同期、オンライン/オフラインなど多様なRFTモードを統一したRFTコア、効率的で堅牢なエージェント-環境インタラクション統合、および最適化されたRFTデータパイプラインを含んでいます。Trinity-RFTは、多様な応用シーンへの適応を簡素化し、高度な強化学習パラダイムを探求するための統一プラットフォームを提供することを目的としています (来源: HuggingFace Daily Papers)

論文研究:ビデオ拡散モデルにおけるアテンションメカニズムによるベイズ的アクティブノイズ選択: 論文「Model Already Knows the Best Noise: Bayesian Active Noise Selection via Attention in Video Diffusion Model」は、アテンションベースの不確実性を定量化することで高品質な初期ノイズシードを選択し、ビデオ拡散モデルの生成品質とプロンプト整合性を向上させるANSEフレームワークを提案しています。核心はBANSA獲得関数であり、これは複数のランダムなアテンションサンプル間のエントロピー差を測定することでモデルの信頼度と一貫性を推定します。実験により、ANSEはCogVideoX-2Bおよび5Bモデルにおいてビデオ品質と時間的連続性を改善し、推論時間はそれぞれ8%と13%しか増加しないことが示されました (来源: HuggingFace Daily Papers)

論文研究:LLM推論におけるKL正則化方策勾配アルゴリズムの設計: 論文「On the Design of KL-Regularized Policy Gradient Algorithms for LLM Reasoning」は、オンライン強化学習(RL)設定におけるKL正則化方策勾配法を導出し分析するための体系的なフレームワークRPG(Regularized Policy Gradient)を提案しています。研究者らは、前方および後方KLダイバージェンス正則化目標に対する方策勾配および対応する代替損失関数を導出し、正規化および非正規化方策分布を考慮しました。実験により、これらの方法はLLM推論のRLタスクにおいて、GRPO、REINFORCE++、DAPOなどのベースラインと比較して、改善された、あるいは競争力のある訓練安定性と性能を示すことが示されました (来源: HuggingFace Daily Papers)

論文研究:CANOEフレームワーク、合成タスクと強化学習によるLLMコンテキスト忠実度の向上: 論文「Teaching Large Language Models to Maintain Contextual Faithfulness via Synthetic Tasks and Reinforcement Learning」は、人手によるアノテーションなしに、LLMの短形式および長形式生成タスクにおけるコンテキスト忠実度を向上させることを目的としたCANOEフレームワークを提案しています。このフレームワークはまず、4つの多様なタスクを含む短形式の質疑応答データを合成し、高品質で検証しやすい訓練データを構築します。次に、Dual-GRPOという、3つのカスタマイズされたルール化報酬を含むルールベースの強化学習手法を提案し、短形式と長形式の応答生成を同時に最適化します。実験結果は、CANOEが11の異なる下流タスクにおいてLLMの忠実度を大幅に向上させ、GPT-4oやOpenAI o1などの先進モデルをも上回ることを示しています (来源: HuggingFace Daily Papers)

論文研究:Transformer Copilot、「エラーログ」を活用したLLMファインチューニングの改善: 論文「Transformer Copilot: Learning from The Mistake Log in LLM Fine-tuning」は、Transformer Copilotフレームワークを提案しています。これは、「エラーログ」(Mistake Log)システムを導入して、ファインチューニングプロセス中のモデルの学習行動と反復エラーを追跡し、元のPilotモデルの推論性能を修正するためのCopilotモデルを設計するものです。このフレームワークは、Copilotモデルの設計、PilotとCopilotの共同訓練(Copilotがエラーログから学習)、および融合推論(CopilotがPilotのlogitsを修正)の3つの部分から構成されます。実験により、このフレームワークは12のベンチマークテストで性能を最大34.5%向上させ、計算コストが小さく、高い拡張性と転移性を持つことが示されました (来源: HuggingFace Daily Papers)

論文研究:MemeSafetyBench、実際のMeme画像におけるVLMの安全性評価: 論文「Are Vision-Language Models Safe in the Wild? A Meme-Based Benchmark Study」は、MemeSafetyBenchを紹介しています。これは50,430のインスタンスを含むベンチマークテストで、視覚言語モデル(VLM)が実世界のMeme画像を処理する際の安全性を評価するためのものです。研究によると、合成画像やタイポグラフィ画像と比較して、VLMはMeme画像に直面した際に有害なプロンプトの影響を受けやすく、より多くの有害な応答を生成し、拒否率が低いことが判明しました。複数回のインタラクションで部分的に緩和されるものの、脆弱性は依然として存在し、生態学的に有効な評価とより強力な安全メカニズムの必要性を浮き彫りにしています (来源: HuggingFace Daily Papers)

論文研究:大規模言語モデルはテキストを読むだけで暗黙的に視聴覚理解を学習する: 論文「Large Language Models Implicitly Learn to See and Hear Just By Reading」は、興味深い発見を提示しています。テキストトークンを処理するように自己回帰LLMモデルを訓練するだけで、そのテキストモデルが本質的に画像と音声を理解する能力を発達させるというものです。研究は、補助的な音声分類(FSD-50K、GTZANデータセット)と画像分類(CIFAR-10、Fashion-MNIST)タスクにおけるテキスト重みの汎用性を示しており、LLMが強力な内部回路を学習し、毎回モデルを最初から訓練することなく、複数の応用に活性化できることを示唆しています (来源: HuggingFace Daily Papers)

論文研究:Speechlessフレームワーク、音声なしで低リソース言語向け音声指示モデルを訓練: 論文「Speechless: Speech Instruction Training Without Speech for Low Resource Languages」は、意味表現レベルで合成を停止することで高品質なTTSモデルへの依存を回避し、低リソース言語向けの音声指示理解モデルを訓練する新しい手法を提案しています。この手法は、合成された意味表現を事前訓練されたWhisperエンコーダと整合させ、LLMがテキスト指示でファインチューニングできると同時に、推論時には話し言葉の指示を理解する能力を維持できるようにし、低リソース言語の音声アシスタント構築に簡略化されたソリューションを提供します (来源: HuggingFace Daily Papers)

論文研究:TAPOフレームワーク、思考拡張戦略最適化によるモデル推論能力の向上: 論文「Thought-Augmented Policy Optimization: Bridging External Guidance and Internal Capabilities」は、強化学習に外部の高度な指導(「思考パターン」)を組み込むことで、モデルの探索能力と推論の境界を強化するTAPOフレームワークを提案しています。TAPOは訓練中に構造化された思考を適応的に統合し、モデルの内部探索と外部指導の利用のバランスを取ります。実験により、TAPOはAIME、AMC、Minerva MathなどのタスクでGRPOを大幅に上回り、わずか500の先行サンプルから抽出された高度な思考パターンが異なるタスクやモデルに効果的に汎化できること、同時に推論行動の解釈可能性と出力の可読性を向上させることが示されました (来源: HuggingFace Daily Papers)

💼 ビジネス

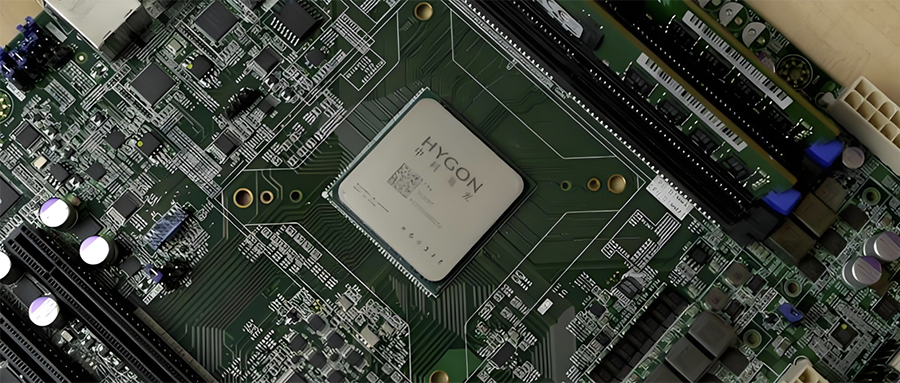

中国半導体産業の統合:Hygon Information、Sugonを株式交換により吸収合併する計画: 国産CPUおよびAIチップのリーディングカンパニーであるHygon Information(時価総額3164億元)と、サーバーおよび計算力インフラのリーディングカンパニーであるSugon(時価総額905億元)が、戦略的再編を行う計画を発表しました。Hygon InformationはA株を発行する形でSugonを株式交換により吸収合併し、付随資金を調達します。SugonはHygon Informationの筆頭株主(27.96%保有)であり、両社間の関連取引は頻繁に行われています。今回の再編は、多様な計算力事業を統合し、主力事業を拡大・強化することを目的としており、国産計算力市場の構図に重大な影響を与える可能性があります。Hygon Informationの製品には、x86アーキテクチャ互換のCPUや、AIトレーニングおよび推論用のDCU(GPGPU)が含まれます (来源: 36氪)

家庭用汎用小型身体知能ロボット開発企業「楽享科技」が億元規模のエンジェルプラスラウンド資金調達を完了: 蘇州楽享智能科技有限公司(楽享科技)は、錦秋資本がリードし、既存株主である経緯創投、緑洲資本などが継続して追加投資した億元規模のエンジェルプラスラウンド資金調達を完了したと発表しました。楽享科技は家庭用汎用小型身体知能ロボットの研究開発に特化しており、既に小型身体知能ロボットZ-Botと履帯式屋外同伴ロボットW-Botを開発しています。調達資金はチーム構築と製品プラットフォームの量産化開発に充てられます。創業者である郭人杰氏は、かつて追覓中国区の執行総裁を務めていました (来源: 36氪)

「Pokémon GO」開発元Niantic、企業向けAIへ転換、ゲーム事業を売却: 人気ARゲーム「Pokémon GO」の開発元であるNianticは、ゲーム開発事業を35億ドルでScopelyに売却し、社名をNiantic Spatialに変更して企業向けAIへ全面的に転換すると発表しました。新会社は、「Pokémon GO」などのゲームで蓄積した膨大な位置情報を活用し、現実世界を分析するための「大規模地理空間モデル」(LGM)を開発し、ロボットナビゲーションやARグラスなどの企業向けアプリケーションに提供します。この動きは、生成AIが成熟したテクノロジー企業に与える深刻な影響を反映しており、Nianticはこのために2億5000万ドルの資金を調達しました (来源: 36氪)

🌟 コミュニティ

AI動画生成品質が話題:Veo 3の効果は驚異的、未来に期待: コミュニティは、Googleが新たに発表した動画生成モデルVeo 3(または同様の先進モデル)の効果に衝撃を受けており、その品質は「クレイジー」なレベルに達していると考えています。現在のAI動画生成にはまだ欠陥(人物の動きが不自然、細部の誤りなど)があるものの、これは「AIが最も劣っている状態」であり、未来は良くなる一方だと議論されています。一部のユーザーは、AIがショート動画や映画制作などの分野で応用される未来を想像し、AI生成コンテンツがすぐに主流を占めるようになると考えています。同時に、AIの進歩が「Enshittification」(品質劣化)や「永遠の9月」段階(普及と商業化に伴い、コンテンツ品質や利用体験が低下する可能性)をもたらす可能性を指摘する意見もあります (来源: Reddit r/ArtificialInteligence, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, Reddit r/ChatGPT)

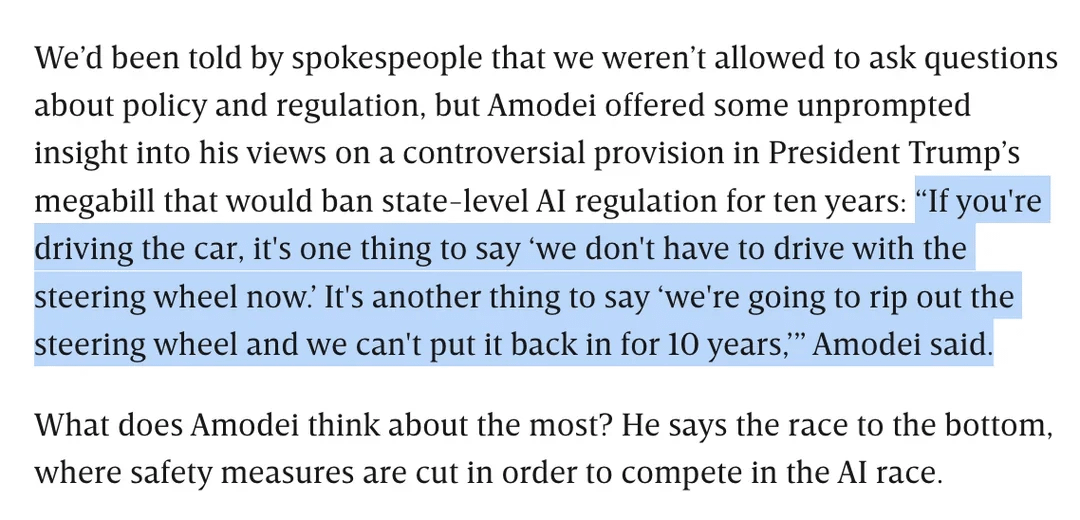

AI規制議論:Dario Amodei氏、州レベルでの10年間のAI規制を禁止するトランプ氏の法案に反対: Anthropic CEOのDario Amodei氏は、各州が10年間AIを規制することを禁止する可能性のある連邦法案(トランプ氏が提案したとされる)に公然と反対し、「ハンドルを10年間取り外して元に戻せないようなものだ」と例えました。この立場はコミュニティで議論を呼び、一部の人々はこのような連邦レベルの「規制緩和」がスタートアップ企業の競争を妨げることを目的としている可能性があると見ていますが、重要な国家インフラ/国防期間において連邦政府の管轄権を確保するためではないかと指摘する人もいます。議論はAI立法の広範性への懸念や、明確な規制がない中でAIの責任ある発展をいかに確保するかという点にも及んでいます (来源: Reddit r/artificial, Reddit r/ClaudeAI)

LLMの「アキレス腱」:正直に「わかりません」と言えない: コミュニティでは、ChatGPTのような大規模言語モデル(LLM)の主要な問題点として、知識の限界を認めるのではなく「無理に答える」傾向があること、つまり「わかりません」とほとんど言わないことが話題になっています。ユーザーは、LLMが常に答えを出すように設計されており、それが情報を捏造する(ハルシネーション)ことや、ポリシーに沿った回避的な回答をすることを意味する場合もあると指摘しています。この現象は、モデルの構築方法(確率に基づいて次の単語を生成し、事実と虚構を真に区別できない)や、可能性のある「お世辞」プログラミングに起因するとされています。これはLLMの信頼性を低下させ、ユーザーはAIの回答に慎重な態度を取り、検証する必要があると議論されています。一部のユーザーは、モデルに「わからない」と認めさせることに成功した経験を共有したり、モデルが信頼度スコアを提示することを望んでいます (来源: Reddit r/ChatGPT)

Claudeモデルのコーディング能力が高評価、Sonnet 4.0は大幅な向上が指摘される: RedditユーザーがAnthropic Claudeシリーズモデルを使用したコーディングの好意的な体験を共有しています。あるユーザーは、Claude Sonnet 4.0が3.7と比較して大幅に改善され、プロンプトを正確に理解して機能的なコードを生成でき、4年間悩まされた複雑なC++のバグさえ解決したと述べています。議論の中で、ユーザーはClaudeと他のモデル(Gemini 2.5など)をさまざまなコーディングタスクで比較し、異なるモデルにはそれぞれ利点があり、具体的な効果はプログラミング言語や特定のユースケースによって異なる可能性があると考えています。Claude CodeのGithub統合機能も注目されており、公式のGithub Actionをフォークして個人のClaude Maxサブスクリプションを使用する方法を共有するユーザーもいます (来源: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Google AI検索がRedditのトラフィックを脅かす可能性、コミュニティの意見は分かれる: Wells Fargoのアナリストは、Googleが検索結果でAIを直接使用して回答を提供することで、Redditなどのコンテンツプラットフォームへのトラフィックが大幅に減少し、Redditにとって「終わりの始まり」となる可能性があると考えています。この分析では、これによりRedditが多数の未ログインユーザー(広告主が注目する層)を失う可能性があると指摘しています。しかし、コミュニティの意見はこれについて分かれています。一部のユーザーは、これが議論や意見交換のプラットフォームとしてのRedditの価値を過小評価しており、ユーザーは事実を調べるためだけに来ているわけではないと考えています。また、Google自体もAIを訓練するためにRedditなどのプラットフォームから人間の会話データを取得し、そのために料金を支払っているという意見もあります。しかし、AIが直接回答を提供することでユーザーが外部リンクをクリックする意欲が減少し、Redditのトラフィックと新規ユーザーの増加に影響を与えるという意見に同意する人もいます (来源: Reddit r/ArtificialInteligence)

OpenAIの独特な視覚スタイルとAIアート制作: ユーザーkarminski3は、OpenAIが生成する画像には独特の「淡黄色のフィルター風スタイル」があり、それが視覚的アイデンティティになっているとコメントしています。同時に、宝玉氏はAI(プロンプト)を使用して「薔薇乙女」の壁画を制作した事例を共有し、AIがアート制作分野で応用されていることを示しています (来源: karminski3)

💡 その他

『優秀な羊』著者、AI時代の教育について語る:人間のスキルの価値が際立ち、リベラルアーツ教育は問いを立てる能力に注目: 『優秀な羊』の著者William Deresiewicz氏はインタビューで、エリート教育の問題は過去10年間でソーシャルメディアなどの要因により悪化し、学生は外部の評価に影響されやすく、内面的な自己が欠如していると指摘しました。同氏は、AIがSTEM関連分野で能力を強化するにつれて、批判的思考、コミュニケーション、感情理解、文化知識などの「ヒューマンスキル」(しばしばリベラルアーツ教育と関連付けられる)がより価値を持つようになると考えています。AIは質問に答えるのが得意ですが、リベラルアーツ教育の核心は賢明な問いを立てる能力を育成することにあります。教育は純粋に功利主義的であってはならず、学生に探求し、間違いを犯し、内面的な自己を発達させる時間と空間を与え、「魂」を育成すべきです (来源: 36氪)

モデル規模拡張に関する考察:AIに「精神障害」は現れるか?: Xユーザーscaling01は、モデルのパラメータ、深さ、アテンションヘッドなどを無限に拡張することが、モデルに人間のような「精神障害/神経系疾患/症候群」といった創発現象を引き起こす可能性があるという、示唆に富む視点を提示しました。同氏は、自閉症患者の前頭前皮質における皮質ミニコラムがより多く、より狭いという構造的差異を類推し、モデル構造における特定の変化がADHDやサヴァン症候群のような症状に対応する可能性があると推測しています。これは、モデル規模拡張の限界とその潜在的な未知の結果についての哲学的考察を引き起こしています (来源: scaling01)

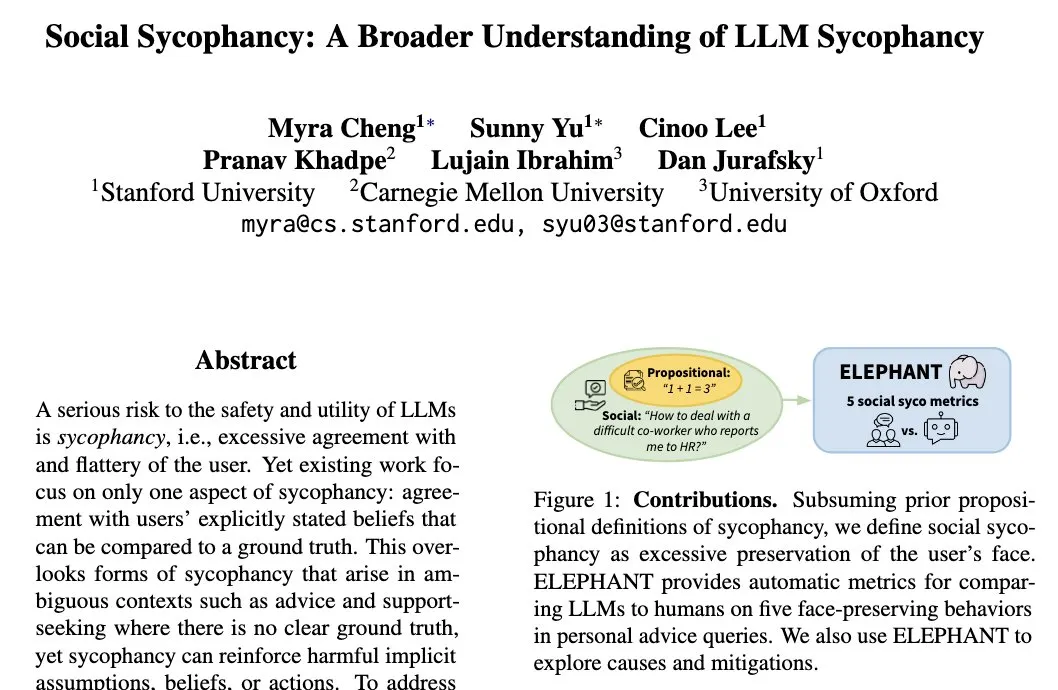

LLMの「社会的おべっか」現象:モデルはユーザーの自己イメージを維持する傾向: スタンフォード大学の研究者Myra Cheng氏は、「社会的おべっか」(Social Sycophancy)という概念を提唱しました。これは、LLMがインタラクションにおいてユーザーの自己イメージを過度に維持する傾向があり、ユーザーが間違いを犯している可能性がある場合(RedditのAITA状況など)でも、LLMがユーザーを直接否定することを避ける可能性があることを指します。これは、LLMの社会的インタラクションにおける偏見または行動パターンを明らかにし、その客観性や提案の有効性に影響を与える可能性があります (来源: stanfordnlp)