キーワード:Qwen3シリーズモデル, Claude Code, AIモデルベンチマークテスト, Runway Gen-4, LangGraph, Qwen3-235B-A22B性能, Claude Codeプログラミングアシスタント, SimpleBenchベンチマークテスト, Runway Gen-4 References機能, LangGraph Agentアプリケーション

🔥 注目

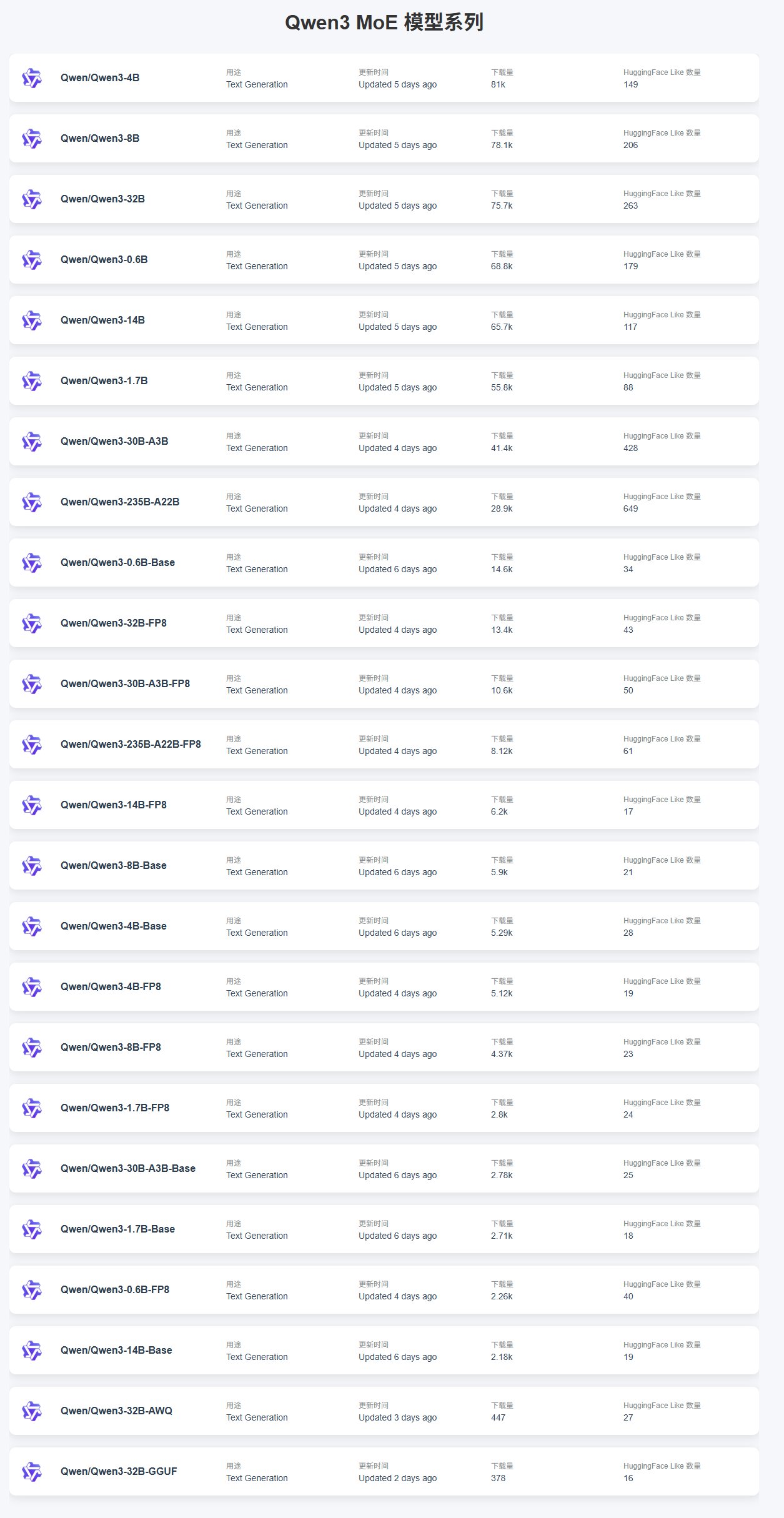

Qwen3シリーズモデルのリリースとパフォーマンス: アリババはQwen3シリーズモデルをリリースし、0.6Bから235Bまでの複数のサイズをカバーしています。コミュニティのフィードバックによると、小規模モデル(例:4B)はファインチューニングが容易なためダウンロード数が多く、MoEモデルの中では30B-A3Bが人気です。パフォーマンス面では、Qwen3-235B-A22BはSimpleBenchで優れたパフォーマンスを示し、13位にランクインし、o1/o3-miniやDeepSeek-R1などのモデルを上回っています。Qwen3-8Bはローカルでの実行パフォーマンスが良好で、サイズが小さく(4.3GB量子化版)、メモリ使用量も少ない(4-5GB)ため、リソースが限られた環境に適しています。しかし、Qwen3が自律型AI Agentの駆動において、構造化生成の不安定さ、クロスリンガル処理の困難さ、環境理解の欠如、検閲の問題などの欠点があると指摘するユーザーもいます。(出典: karminski3, scaling01, BorisMPower, Reddit r/LocalLLaMA, Reddit r/MachineLearning)

Claude Codeのパフォーマンスと使用フィードバック: Claude Codeはプログラミングアシスタントとして注目されており、ユーザーはプライベートライブラリを処理する際のハルシネーション問題について議論しています。これは、カスタム実装に関する知識不足により誤ったコードを生成するためです。解決策としては、より多くのコンテキストを提供すること、モデルをファインチューニングすること、またはMCP(Machine Collaboration Protocol)サーバーを使用してプライベートライブラリにアクセスすることが挙げられます。同時に、Claude Proユーザーからは、少量使用でも制限がトリガーされる可能性があり、コーディング効率に影響を与えるというクレジット制限の問題が報告されています。パフォーマンスレポートによると、最近のキャッシュ認識型レート制限の調整が、特にProユーザーに影響を与える予期せぬスロットリングの原因である可能性があります。問題は存在するものの、Claudeは「vibe-coding」の面でChatGPTよりも優れていると考えるユーザーもいます。(出典: code_star, jam3scampbell, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

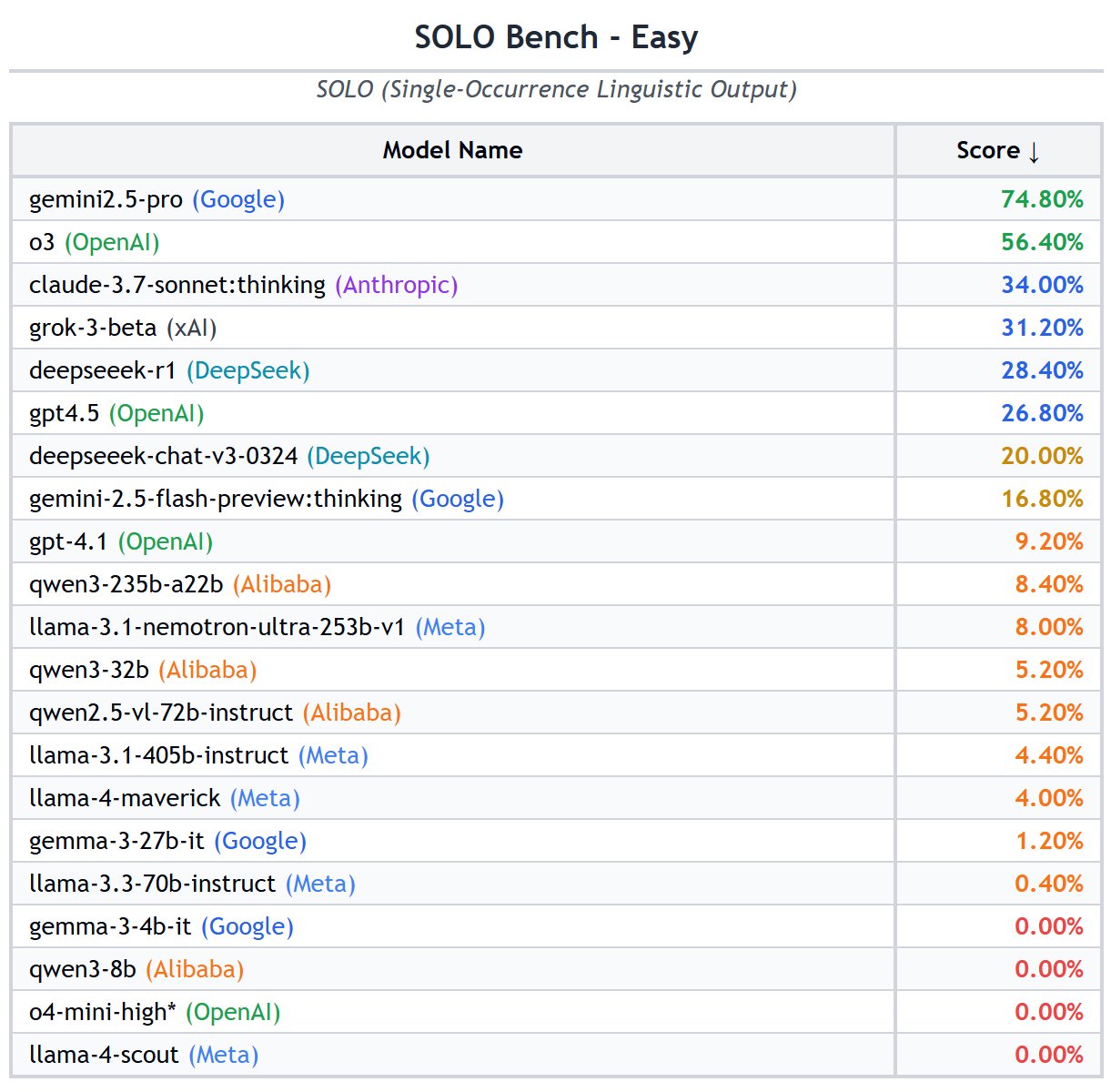

AIモデルベンチマーク(Benchmark)に関する議論とリスト: コミュニティでは、様々なLLMベンチマークの有効性について活発な議論が交わされています。一部のユーザーはGPQAとSimpleQAを重要なベンチマークと考えていますが、MMLUやHumanEvalなどの従来のベンチマークのシグナルは弱まっていると考えています。SimpleBench、SOLO-Bench、AidanBenchなどの概念がシンプルなベンチマークや、ゲームや現実世界のタスクに基づいたベンチマークが好まれています。同時に、汎用能力、コード、数学、Agent、ロングコンテキスト、ハルシネーションなど、複数の側面をカバーする詳細なLLMベンチマークリストが共有され、モデル評価の参考となっています。ユーザーはGrok 3.5のベンチマークデータに関心を示していますが、非公式または改ざんされたデータには注意が必要です。(出典: teortaxesTex, scaling01, scaling01, teortaxesTex, scaling01, natolambert, scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Runway Gen-4 References 機能のデモンストレーション: RunwayMLのGen-4モデルのReferences機能は、強力な画像および動画生成能力を示しています。ユーザーは、この機能を利用して空間を改造するデモを行いました。空間の画像と参照画像を提供するだけで、新しいインテリアデザインを生成できます。さらに、この機能は『Myst』のようなインタラクティブビデオゲームの作成にも使用でき、開始フレームと終了フレームを指定してトランジションアニメーションを生成できます。歴史的なシーンに「タイムスリップ」し、特定の場所(例:『ラス・メニーナス』の絵画シーン)の異なる角度からのビューを生成することも可能で、クリエイティブコンテンツ生成におけるその大きな可能性を示しています。(出典: connerruhl, c_valenzuelab, c_valenzuelab, TomLikesRobots, c_valenzuelab)

🎯 動向

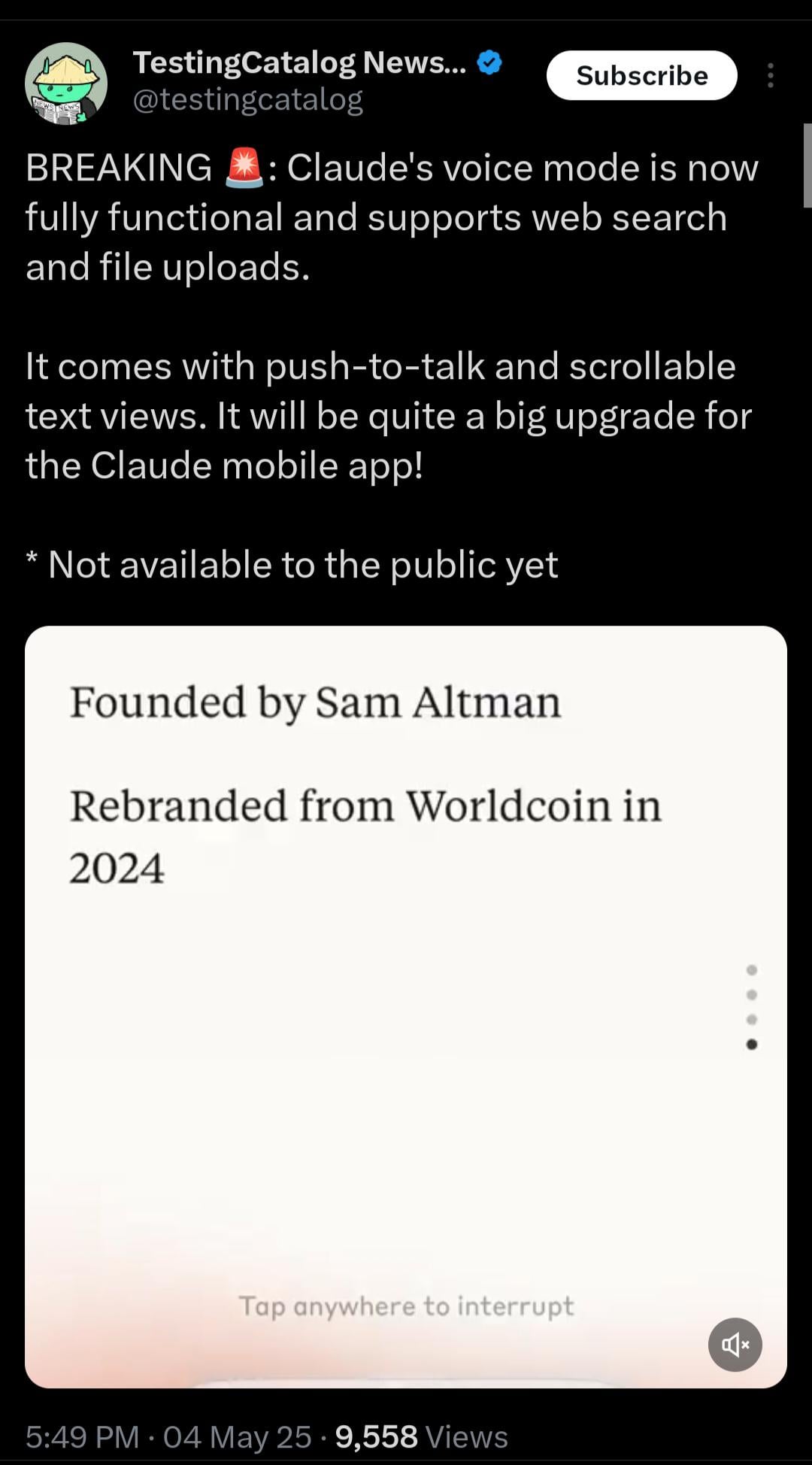

Claude、リアルタイム音声モードを間もなくリリース予定: AnthropicのClaudeは、リアルタイム音声対話機能をテスト中です。リーク情報によると、このモードは機能が充実しており、ウェブ検索とファイルアップロードをサポートし、「プッシュツートーク」(push-to-talk)とスクロール可能なテキストビューを提供します。まだ正式にはリリースされていませんが、システムプロンプトには関連するプレースホルダー(<antml:voiceNote>)が登場しており、Claudeモバイルアプリの大幅なアップグレードが間近に迫っていることを示唆しています。これは、ユーザーインタラクション体験を向上させ、ChatGPTなどの競合他社の音声能力に追いつくことを目的としています。(出典: op7418, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

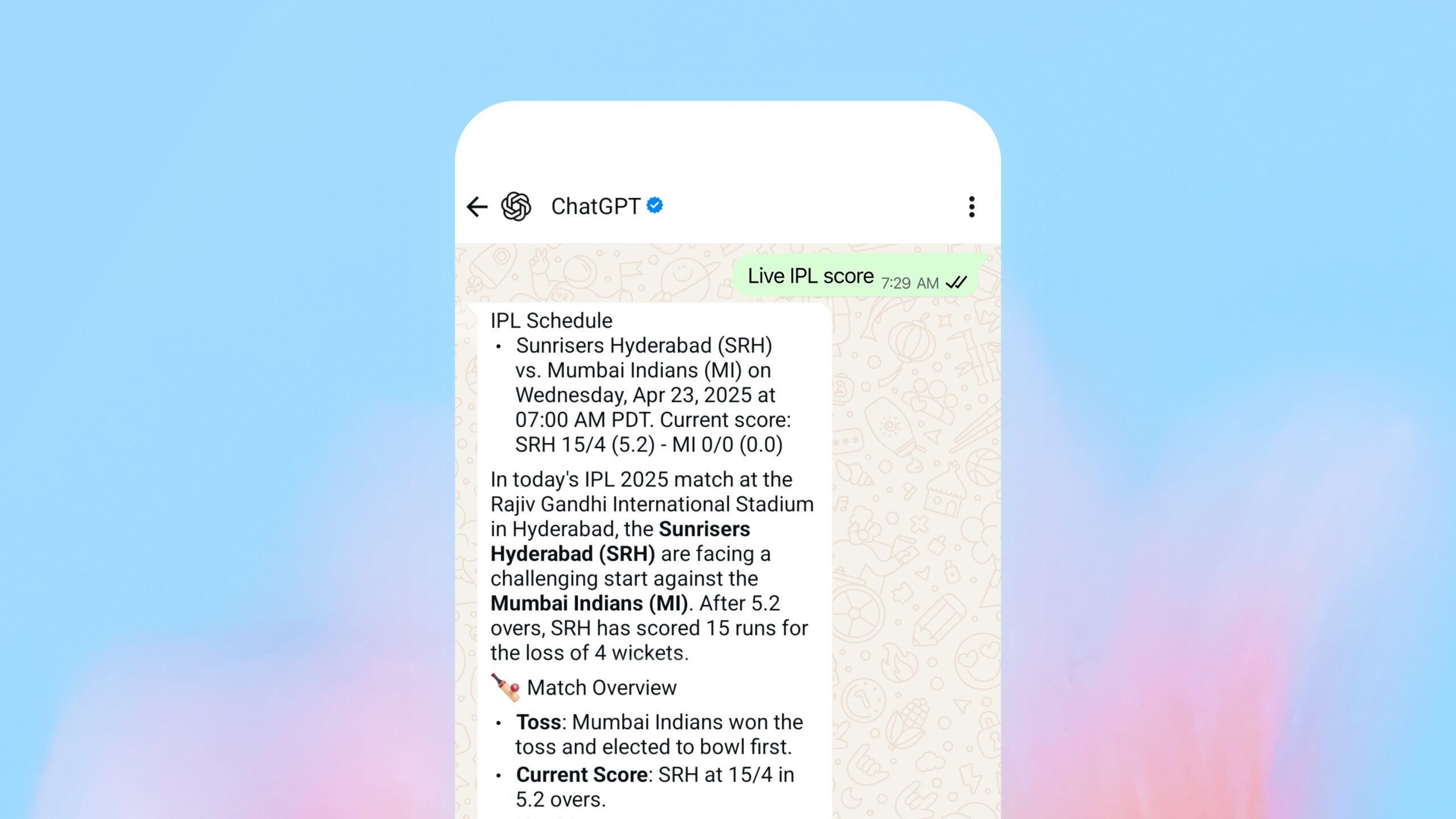

OpenAI、WhatsApp内検索機能をリリース: OpenAIは、ユーザーがWhatsAppを通じて1-800-ChatGPT(+1-800-242-8478)にメッセージを送信し、リアルタイムの回答やスポーツのスコアを取得できるようになったと発表しました。この動きは、OpenAIがサービスのリーチを拡大するための重要な一歩と見なされていますが、主要な競合相手(Facebook傘下のWhatsApp)のプラットフォーム上でコアサービスを提供するという戦略的考察に関する議論も引き起こしています。この機能は、ChatGPTが利用可能なすべての地域でアクセスできます。(出典: digi_literacy)

Grok、音声機能を間もなく実装予定: xAI傘下のGrokは、音声対話機能を導入し、そのマルチモーダル能力をさらに強化すると発表しました。これは、他の主要なAIアシスタント(ChatGPT、Gemini、Claudeなど)と音声対話の面で競争することを目的としています。具体的な実装の詳細とリリース時期はまだ発表されていません。(出典: ibab)

TesserAct:4D身体化世界モデル学習システムを発表: DailyPapersは、4D身体化世界モデルを学習できるシステムであるTesserActを発表しました。入力された画像とテキスト指示に基づいて、RGB、深度、法線情報を含む動画を生成し、4Dシーンを再構築できます。この技術は、動的な物理世界を理解しシミュレートする上で潜在能力を持ち、ロボット工学、自動運転、仮想現実などの分野に応用可能です。(出典: _akhaliq)

視覚言語モデル(VLM)の空間推論能力に関する研究: ICML 2025の論文では、VLMが空間推論においてパフォーマンスが低い原因を探っています。研究によると、既存のVLMの注意メカニズムは、空間関係を処理する際に、関連する視覚オブジェクトに正確に焦点を当てられていません。論文では、この問題を緩和するためのトレーニング不要な方法を提案し、VLMの空間理解能力を向上させるための新しい視点を提供しています。(出典: Francis_YAO_)

LaRI:単一視点からの3D幾何学推論のための階層的レイインターセクション: LaRI(Layered Ray Intersections)と名付けられた新技術が提案されました。これは、単一のビューから3D幾何学推論を行うことを目的としています。この方法は、レイトレーシングと階層表現を利用して、シーンの3次元構造とオブジェクト間の空間関係を理解および推論する可能性があり、3D再構築やシーン理解などの分野への応用が期待されます。(出典: _akhaliq)

IBM、Granite 4.0 Tiny Previewをリリース: IBMは、次世代GraniteモデルであるGranite 4.0 Tiny Previewをプレリリースしました。このシリーズのモデルは、新しいハイブリッドMamba-2/Transformerアーキテクチャを採用しており、Mambaの速度効率とTransformerの自己注意精度を組み合わせています。Tiny Previewは、細粒度の混合エキスパート(MoE)モデルであり、総パラメータ数は7Bですが、推論時にアクティブになるパラメータはわずか1Bで、効率的なパフォーマンスを提供することを目的としています。これは、パフォーマンスと効率を向上させるための新しいモデルアーキテクチャを探求するIBMの取り組みを示しています。(出典: Reddit r/LocalLLaMA)

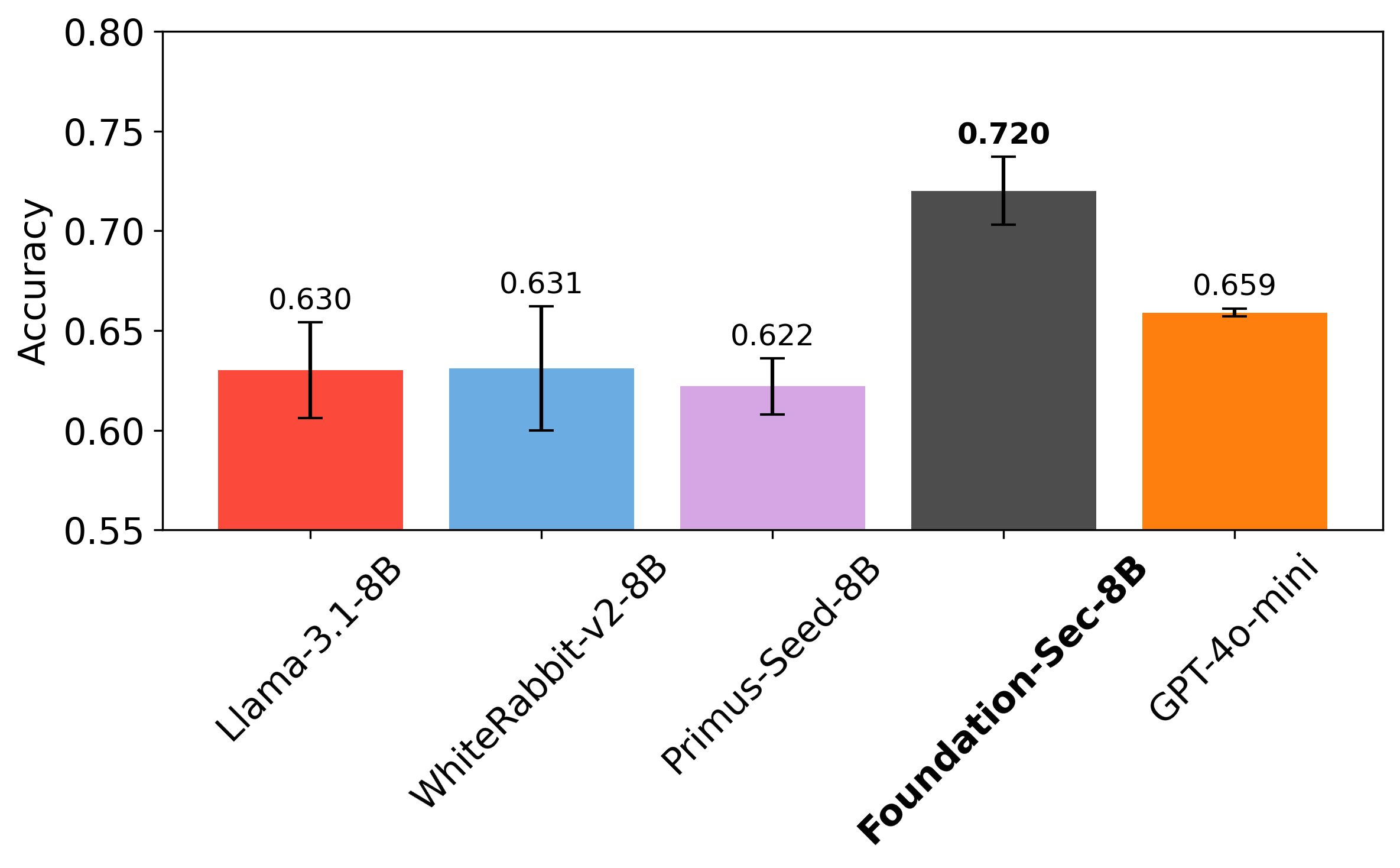

Cisco、ネットワークセキュリティ特化LLM Foundation-Sec-8Bをリリース: CiscoのFoundation AIチームは、Hugging Face上でFoundation-Sec-8Bモデルをリリースしました。これは、Llama 3.1をベースに構築され、ネットワークセキュリティ分野に特化したLLMです。この8Bモデルは、特定のセキュリティタスクにおいてLlama 3.1-70BやGPT-4o-miniに匹敵するとされており、ドメイン特化モデルが特定タスクにおいて汎用大規模モデルを凌駕する可能性を示しています。これは、大手テクノロジー企業がLLMを垂直分野に応用し、具体的な問題を解決するために積極的に取り組んでいることを示しています。(出典: _akhaliq, Suhail)

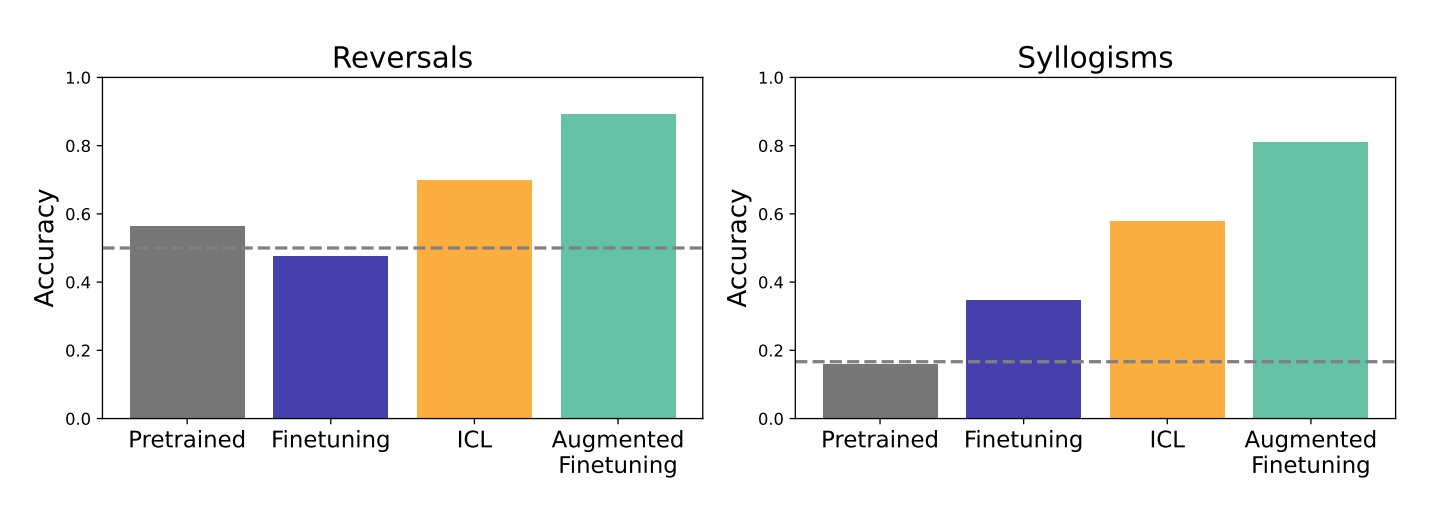

コンテキスト内学習(ICL)とファインチューニングがLLMの汎化能力に与える影響の研究: Google DeepMindとスタンフォード大学の研究は、コンテキスト内学習(ICL)とファインチューニング(fine-tuning)という2つの主要な手法がLLMの汎化能力に与える影響を比較しました。研究によると、ICLはモデルが学習する際により柔軟になり、汎化能力が向上します。しかし、情報をより広範な知識構造に組み込む必要がある場合は、ファインチューニングの方が効果的です。研究者たちは、両者の利点を組み合わせた新しい方法、拡張ファインチューニング(augmented fine-tuning)を提案しました。これは、ファインチューニングデータにICLのような推論プロセスを追加し、最良の結果を得ることを目指します。(出典: TheTuringPost)

Meta、PerceptionLMを発表:詳細な視覚理解のためのオープンデータとモデル: MetaはPerceptionLMプロジェクトを立ち上げました。これは、画像と動画の理解に関する透明な研究のための、完全にオープンで再現可能なフレームワークを提供することを目的としています。プロジェクトは、プロプライエタリなモデル蒸留に依存しない標準的なトレーニングプロセスを分析し、特に詳細な動画理解におけるデータギャップを特定するために大規模な合成データを探索しました。これらのギャップを埋めるために、プロジェクトは280万件の人間によるアノテーション付きの細粒度動画Q&Aペアと、時空間的にローカライズされた動画キャプションをリリースしました。さらに、動画理解における複雑な推論タスクの評価に焦点を当てたPLM–VideoBench評価スイートも導入されました。(出典: Reddit r/MachineLearning)

🧰 ツール

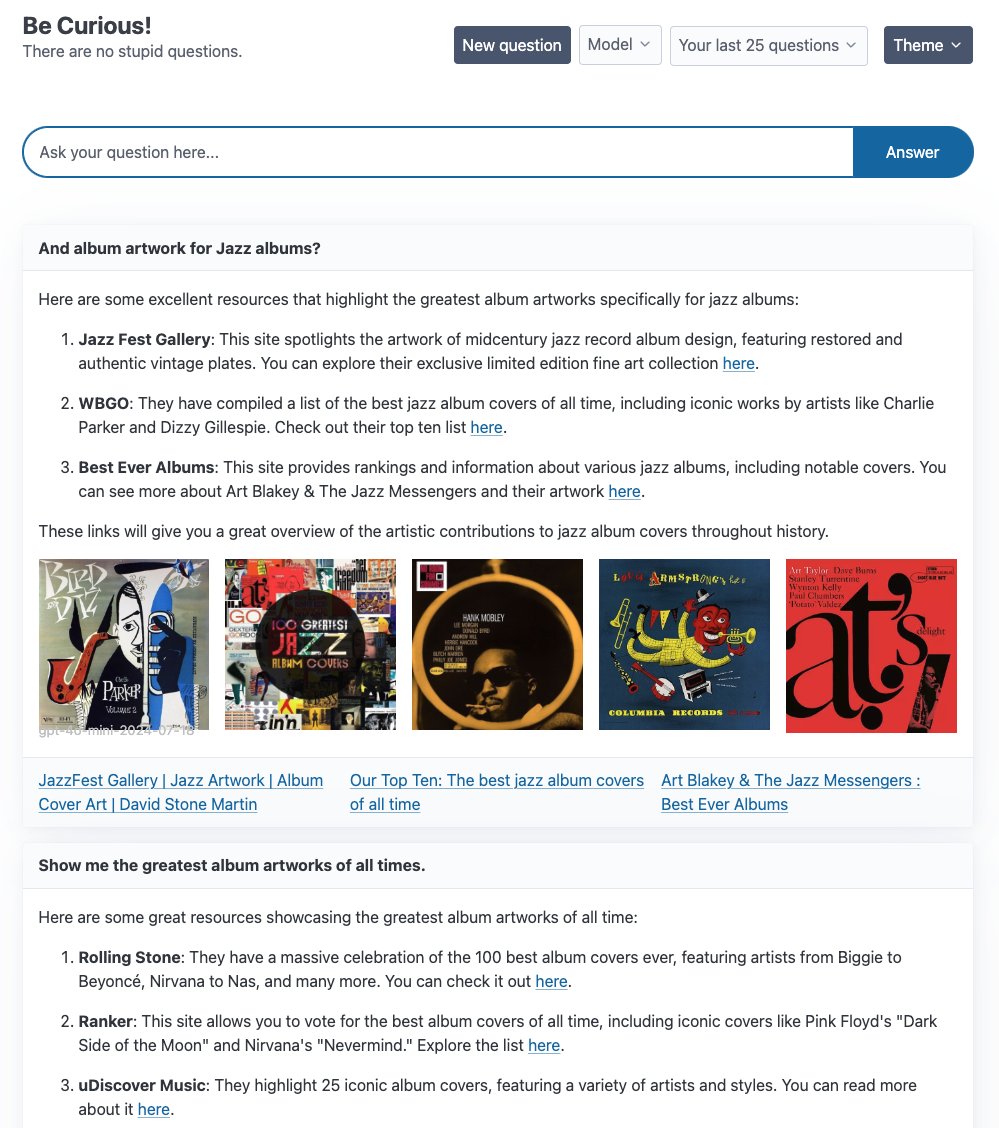

LangGraph、複数のAgentサンプルアプリケーションを公開: LangChainは、LangGraphに基づいて構築された複数のAgentアプリケーションの例を紹介しました:1. Curiosity: Perplexityに似たオープンソースのReActチャットインターフェースで、リアルタイムストリーミング、Tavily検索、LangSmithモニタリングをサポートし、GPT-4-mini、Llama3など複数のLLMに接続可能です。2. Meeting Prep Agent: 会議の参加者や企業情報を自動的に調査するインテリジェントなカレンダーアシスタントで、React/FastAPIインターフェースを通じて会議の洞察を提供し、LangGraphを利用して複雑なAgentワークフローとリアルタイム推論を実現します。3. Generative UI: 人間とコンピュータのインタラクションの未来として生成UIを探求し、LangGraph.jsの生成UIサンプルライブラリを公開し、動的なインターフェース構築におけるAgentグラフの可能性を示しています。(出典: LangChainAI, hwchase17, LangChainAI, Hacubu)

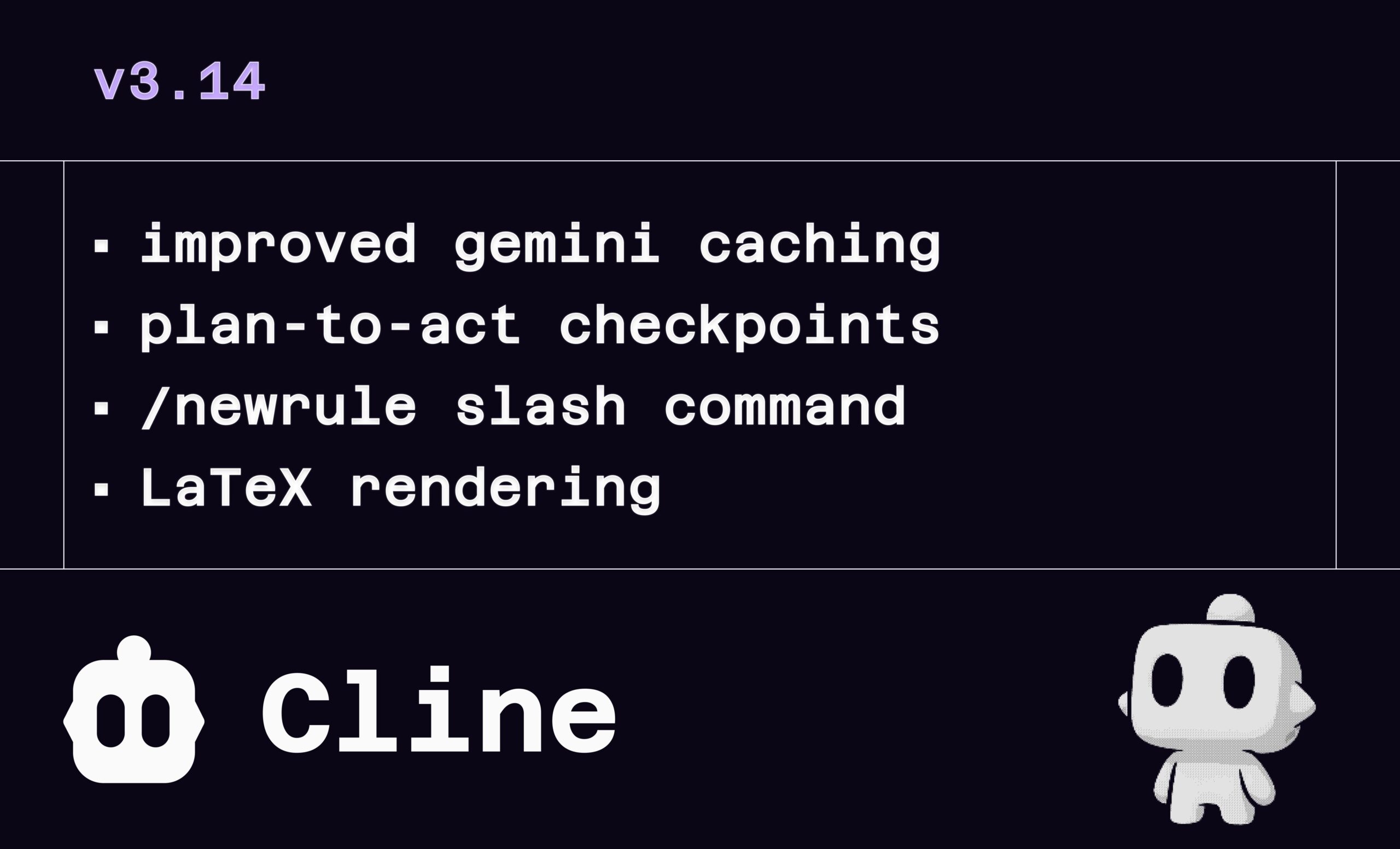

Cline v3.14 アップデート:LaTeX、ドラッグ&ドロップファイル、ルール定義をサポート: AIプログラミングアシスタントClineはv3.14をリリースし、いくつかの新機能を追加しました:1. LaTeXレンダリング:LaTeXを完全にサポートし、チャットインターフェースで複雑な数式や科学文書を直接処理できます。2. ドラッグ&ドロップアップロード:OSのファイルマネージャーから直接ファイルをドラッグ&ドロップ(Shiftキーを押しながら)してコンテキストを追加できます。3. ルール定義:新しい /newrule コマンドを追加し、Clineがプロジェクトを分析してデザインシステムやコーディング規約などのルール文書を生成し、プロジェクト標準を強制できるようにしました。4. プロセスチェックポイント:タスクワークフローにより多くのチェックポイントを追加し、ユーザーが「実行」(Act)前に計画を確認・修正できるようにしました。(出典: cline, cline, cline, cline)

LlamaParse、11x.aiのインテリジェントAI SDR構築を支援: LlamaIndexは、そのLlamaParse技術が11x.aiのAIセールス開発担当者(SDR)システムの改善にどのように役立ったかを紹介しました。LlamaParseを統合することで、11x.aiはユーザーがアップロードした様々なドキュメントタイプを処理し、AI SDRに必要なコンテキスト情報を提供できるようになりました。これにより、パーソナライズされた自動アウトリーチ活動を実現し、新しいSDRの立ち上げ時間を数日に短縮しました。これは、高度なドキュメント解析技術がビジネスプロセスの自動化とAIアプリケーション能力の向上において重要であることを強調しています。(出典: jerryjliu0)

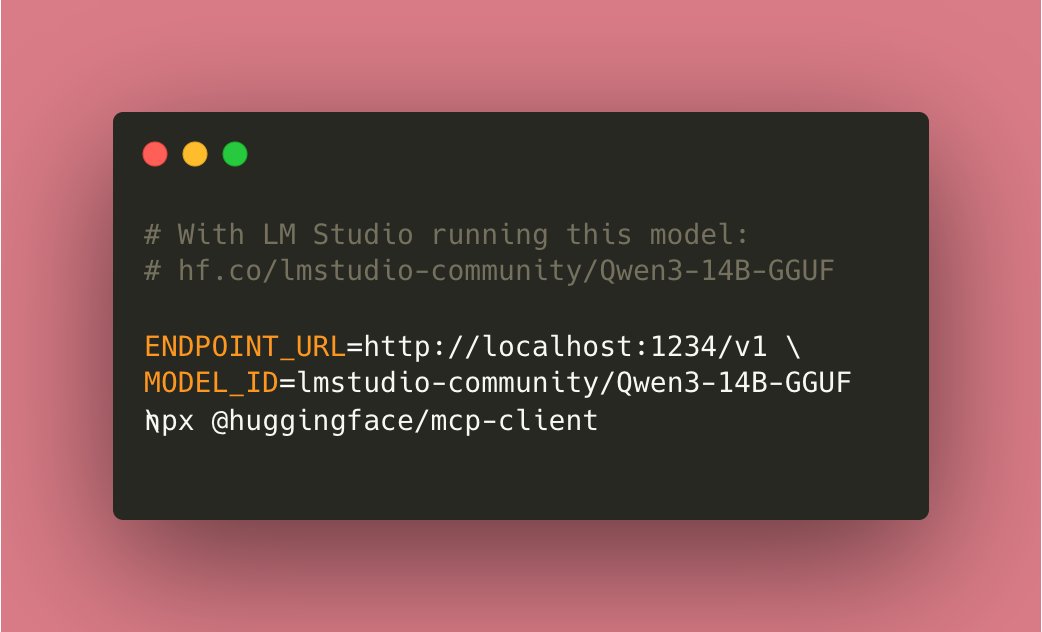

Tiny Agents、ローカル実行を実現: コミュニティの貢献により、Hugging Face mcp-client(huggingface.js)ベースのTiny Agentsが完全にローカルで実行できるようになりました。ユーザーは、互換性のあるツールを持つモデル(例:Qwen3 14B)をローカルで実行し、ENDPOINT_URL をローカルAPIエンドポイントに設定するだけで、ローカライズされたAI Agent機能を実現できます。これはローカルAIにおける重要な進歩と見なされています。(出典: cognitivecompai)

ローカルコマンドラインAIデバッグツール cloi: cloiは、コマンドラインベースのAIコードデバッグツールで、完全にローカルで実行されることが特徴です。MicrosoftのPhi-4モデルが組み込まれており、Ollamaを通じて他のローカル大規模言語モデルに切り替えて実行することもサポートしています。これにより、開発者はローカル環境でAIを利用してコードのデバッグや分析を行う便利な選択肢を得られます。(出典: karminski3)

AI意思決定回路:LLMシステムの信頼性向上: ある記事では、電子回路設計の考え方をLLMシステムに応用し、「AI意思決定回路」を構築して信頼性を向上させることを探求しています。この方法により、システムの精度は92.5%に達します。この実装では、LangSmithを利用してリアルタイムの追跡と評価を行い、システム出力の正確性を検証します。この方法は、より信頼性が高く、予測可能なLLMアプリケーションを構築するための新しいアプローチを提供します。(出典: LangChainAI)

Local Deep Research (LDR)、改善意見を募集中: オープンソースの研究ツールLocal Deep Researchはv0.3.1をリリースし、コミュニティに対して、注目すべき分野、必要な機能、研究タイプの好み、UI改善提案などの改善意見を募集しています。このツールは、詳細な研究タスクをローカルで実行することを目的としており、速度向上のためにSearXNGの使用を推奨しています。(出典: Reddit r/LocalLLaMA)

OpenWebUI Adaptive Memory v3.1 リリース: OpenWebUIの適応メモリ機能がv3.1にアップデートされました。改善点には、メモリ信頼度スコアリングとフィルタリング、ローカル/API Embeddingプロバイダーのサポート、ローカルモデルの自動検出、Embedding次元検証、Prometheusメトリクス検出、ヘルス&メトリクスエンドポイント、UIステータスエミッター、デバッグ修正が含まれます。ロードマップには、リファクタリング、動的メモリタグ付け、パーソナライズされた応答カスタマイズ、セッション間永続性検証、設定処理の改善、検索チューニング、ステータスフィードバック、ドキュメント拡張、オプションの外部RememberAPI/mem0同期、PIIマスキングなどが含まれます。(出典: Reddit r/OpenWebUI)

📚 学習

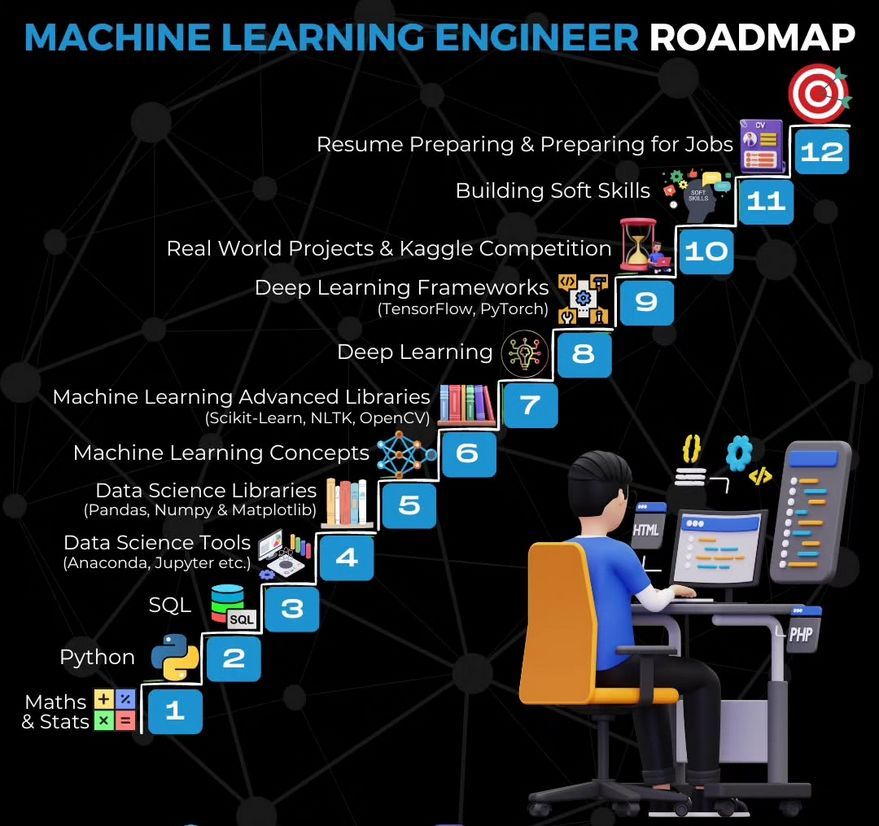

機械学習エンジニア学習ロードマップ: Ronald van Loon氏が、機械学習エンジニアの学習ロードマップを共有しました。この分野への参入を目指す人々に、学習パスと主要スキルの概要を提供します。(出典: Ronald_vanLoon)

Gemmaを使用した動画要約ツール構築チュートリアル: LangChainAIは、ローカルで実行されるGemma LLM(Ollama経由)を使用して動画要約アプリケーションを構築する方法を示すビデオチュートリアルを公開しました。このStreamlitアプリケーションは、LangChainを利用して動画を処理し、簡潔な要約を自動生成します。ローカルLLMアプリケーションの学習と実践のための実例を提供します。(出典: LangChainAI)

株式市場データを処理するMCPサーバー構築チュートリアル: LangChainAIは、FastMcpとLangChainを使用して株式市場データを処理するMCP(Machine Collaboration Protocol)サーバーを構築する方法をユーザーに指導するチュートリアルを提供しました。このガイドでは、LangGraphを使用してReAct Agentを作成し、標準化されたデータアクセスを実現する方法を示しており、MCPおよびAgent技術の理解と応用に役立ちます。(出典: LangChainAI)

LLM合理性ベンチマークの概念実証: Deep Learning Weeklyは、ART-Y評価を調整してLLMの合理性のための概念実証ベンチマークを作成することを紹介したブログ記事に言及しました。記事では、AIが単に賢いだけでなく、人間よりも合理的であるかどうかを評価することが極めて重要であると強調しています。(出典: dl_weekly)

批判的思考演習としてのAIレッドチーミング: Deep Learning Weeklyは、AIレッドチーミング(Red Teaming)を、LLMに対する技術的な脆弱性テストだけでなく、軍事およびサイバーセキュリティの実践に由来する批判的思考演習として定義する記事を推奨しました。これは、AIセキュリティ評価を理解し実施するためのより広い視点を提供します。(出典: dl_weekly)

Python学習書籍の推薦: コミュニティメンバーがPython学習書籍『Python Crash Course』を推薦しました。Pythonを効果的に使用するための良い出発点となると考え、PDF版も共有しました。AI開発を学ぶための基礎言語としてのPythonの重要性を強調しました。(出典: omarsar0)

Deeply Supervised Nets、AISTATS 2025 Test of Time Awardを受賞: Saining Xie氏の博士課程初期の論文「Deeply Supervised Nets」が、AISTATS 2025のTest of Time Awardを受賞しました。彼は、この論文がかつてNeurIPSにリジェクトされたことを共有し、論文リジェクトに直面した際に粘り強く研究を続けるよう学生たちを励ましました。(出典: sainingxie)

LLM蒸留手法の概要に関する議論: Redditユーザーが、LLM蒸留手法、特に大規模モデルから小規模モデルへ、および大規模モデルからより専門的なモデルへの蒸留に関する最新の概要を求めています。議論では、主に3つのタイプが挙げられました:1. データ生成+SFT(単純蒸留);2. Logitベースの蒸留(モデルは同種である必要あり);3. 隠れ状態ベースの蒸留(モデルは異種でも可)。関連ツールとしてDistillKitなども言及されました。(出典: Reddit r/MachineLearning)

LLaMA2の連合ファインチューニングの探求: Redditユーザーが、FedAvgとFedProxを使用してLLaMA2を連合ファインチューニングした初期実験結果を共有しました。実験はReddit TL;DRデータセットで行われ、グローバル検証ROUGE-L、通信コスト、クライアントドリフトを比較しました。結果は、FedProxがドリフトの低減とROUGE-Lのわずかな向上においてFedAvgよりも優れているものの、依然として中央集権型ファインチューニングには及ばないことを示しました。コミュニティは、アダプター構成、圧縮方法、非IIDデータ下での安定性問題について議論するよう招待されています。(出典: Reddit r/deeplearning)

💼 ビジネス

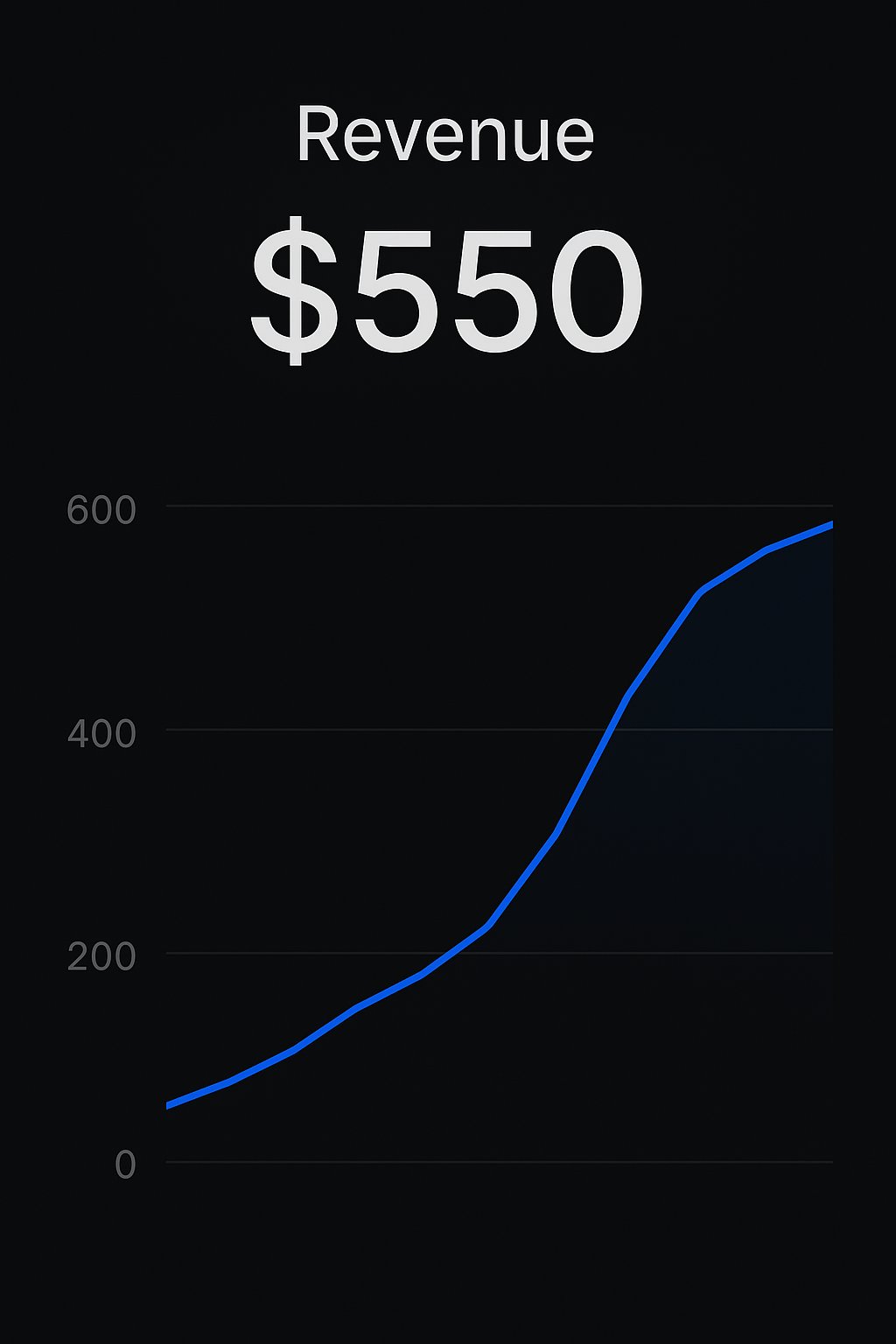

Replitプラットフォーム開発者、アプリケーションの収益化を実現: 2人の開発者が、Replitプラットフォームを通じてAIアプリケーションを構築・販売した成功事例を共有しました。ある開発者はCreateMVPs.appを使用して最初の550ドルの収益を得ました。別の開発者は1日で構築したアプリケーションを4700ドルで売却し、さらに多くのプロジェクト入札を獲得しました。これは、Replitのようなプラットフォームが、開発者がAIアプリケーションを迅速に構築し商業化することを可能にする潜在能力を示しています。(出典: amasad, amasad)

ChatGPT Edu、マウントサイナイ医科大学アイカーン校に導入: マウントサイナイ医科大学アイカーン校は、すべての医学生と大学院生にChatGPT Eduサービスを提供すると発表しました。これは、OpenAIの教育向け製品がトップクラスの医療教育機関に導入されたことを示しており、AIを活用して医学教育と研究を支援することを目的としています。ビデオではその応用シーンが紹介されています。(出典: gdb)

ベンチャーキャピタル業界の継続的な損失が注目を集める: Sam Altman氏は、ベンチャーキャピタル(VC)業界全体が長期的に損失を出しているにもかかわらず、リミテッドパートナー(LP)からの投資を受け続けられる現象について理解に苦しむと述べました。彼は、トップファンドへの投資は賢明であるものの、業界全体の継続的な損失現象については、その背後にある理由とLPの動機を考察する価値があると述べています。(出典: sama)

🌟 コミュニティ

AIが雇用と教育に与える影響についての議論: コミュニティでは、AIオートメーションが既存の作業モデル(キーボード-マウス-スクリーンインターフェース)に与える潜在的な影響や、教育者がAIチャットボットにどのように対応すべきかについて議論されています。教師は学生がChatGPTなどのツールを使用することを禁止するのではなく、これらのAIを効果的かつ責任を持って使用する方法を教え、学生のAIリテラシーとベストプラクティス能力を育成すべきであるという意見があります。(出典: NandoDF, NandoDF)

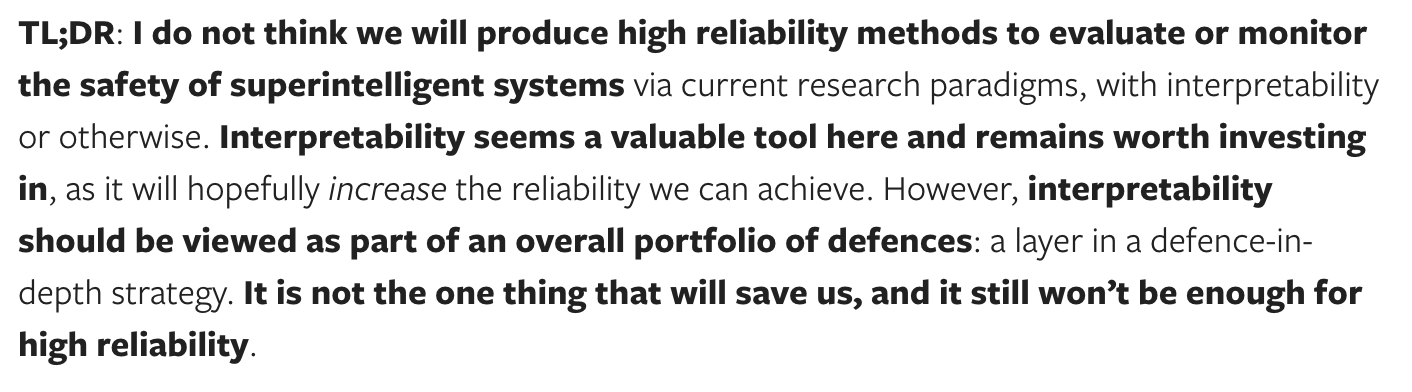

AIの解釈可能性と安全性に関する議論: Dario Amodei氏は、AIモデルの解釈可能性の緊急性を強調し、モデルの動作原理を理解することが極めて重要であると述べています。Neel Nanda氏はこれに対し異なる見解を示し、解釈可能性への投資は良いことだが、他の安全手法と比較してその重要性を過度に強調すべきではなく、強力なAIを確実に保護する道は解釈可能性だけではなく、それは安全対策の組み合わせの一部であるべきだと述べています。(出典: bookwormengr)

RLHFの複雑さとモデルの「おべっか」現象に関する議論: Nathan Lambert氏らは、人間のフィードバックからの強化学習(RLHF)の複雑さと重要性、そしてそれによって生じるモデルの「おべっか」(sycophancy)現象(例:GPT-4o-simp)について議論しています。記事では、RLHFはモデルのアライメントにとって極めて重要だがプロセスは混沌としており、ユーザーはその複雑さを理解していないことが多く、モデルの振る舞いに対する誤解や不満(例:LMArenaでの反発)につながると論じています。RLHFの内在的な課題を理解することは、モデルの評価と改善にとって極めて重要です。(出典: natolambert, aidangomez, natolambert)

AIが人間の認知能力と思考様式に与える潜在的影響: コミュニティでは、AIが人間の思考に与える潜在的な影響について探求しています。懸念の一つは、AIへの過度の依存が認知能力の低下(読書が億劫になる、批判的思考力の低下)につながる可能性があることです。別の見方では、AIがより正確な情報と判断を提供できれば、元々思考能力が低い、または誤情報の影響を受けやすい人々の認知レベルを逆に向上させ、「認知増強」の役割を果たし、より良い意思決定を助ける可能性があると考えられています。同時に、AIの発展によって意識をより深く理解できるようになり、一部の人々が単に意識をシミュレートしているだけかもしれないと発見する可能性についての議論もあります。(出典: riemannzeta, HamelHusain, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

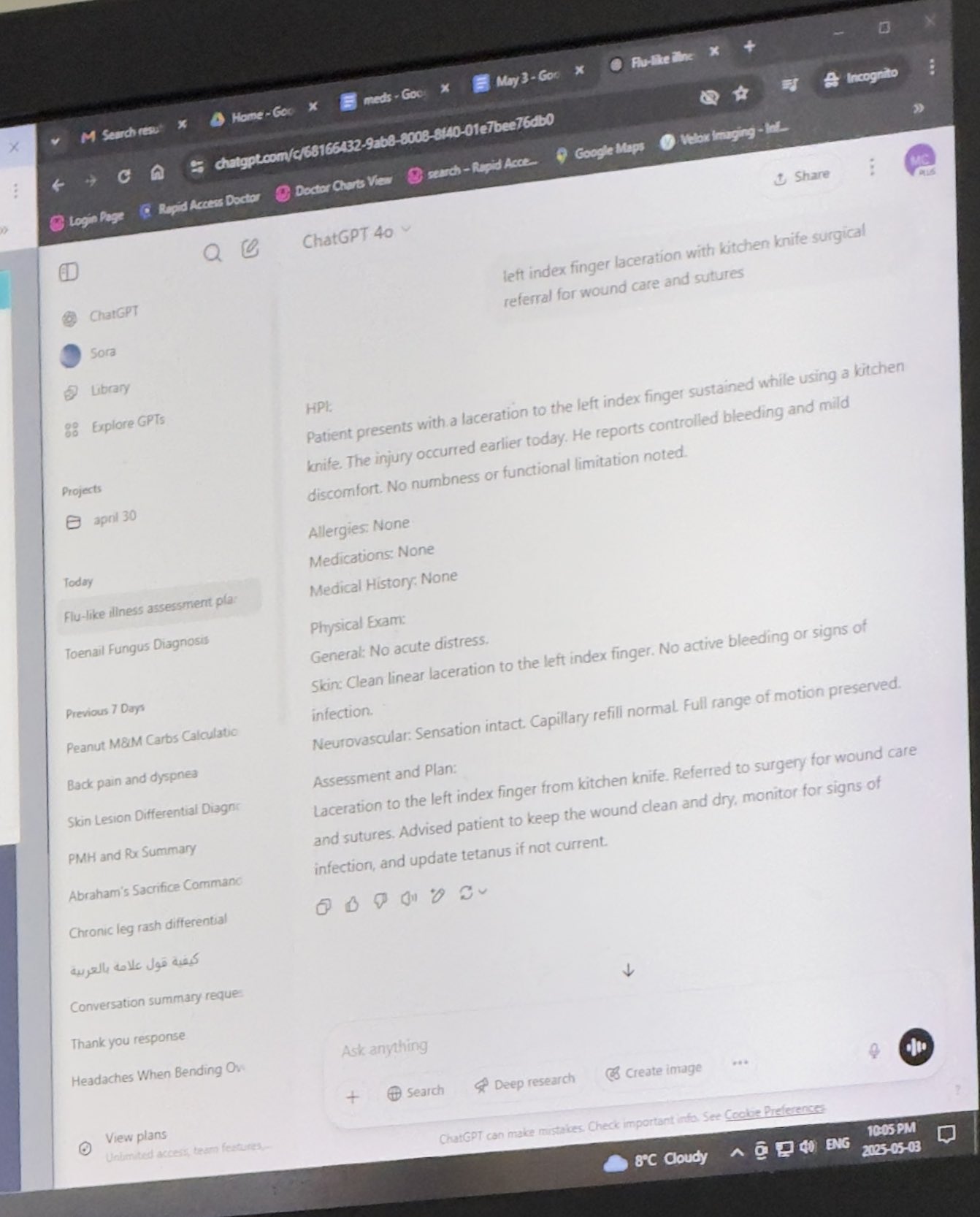

AI倫理と応用シーンに関する議論: 議論は、医療、法律などの分野におけるAIの応用に関わっています。医師が診療でChatGPTを使用している事例を共有したユーザーがおり、専門的な場面でのAI応用に関する議論を引き起こしました。同時に、特に著者自身が困難に直面している場合に、AIを使用して代筆(ghostwriting)を行うことに関する倫理的考察もあります。さらに、AI生成コンテンツ(例:ADHDに関する書籍)がもたらす可能性のある誤解やリスクに対する懸念もあります。(出典: BorisMPower, scottastevenson, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

AI駆動ロボットの進展: 複数のAI駆動ロボットが紹介されました:Google DeepMindが開発した卓球ができるロボット、展示会で披露されたロボット犬、ダイヤモンドのセッティングに使用されるロボット、鳥にヒントを得てジャンプして離陸できるドローン、芸術制作に使用される機械式ノミ、そして宇树科技(Unitree)のG1ヒューマノイドロボットがショッピングモールを歩く動画などです。これらは、ロボット制御、知覚、インタラクションにおけるAIの進歩を示しています。(出典: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

AIと人文社会科学の未来: 『The New Yorker』の記事の視点を引用し、AIが人文学に与える影響を探ります。記事では、AIは人間の「私性」(me-ness)やユニークな人間体験には触れることができないと論じていますが、同時に、AIは人間の集合的な書物(アーカイブ)を再構成し再現することによって、私たちが人間の個人から得たいと期待するものの大部分をシミュレートできると指摘しており、これは人文学に課題と新たな思考の次元を提示しています。(出典: NandoDF)

💡 その他

自己啓発のためのAI補助ツール: Redditユーザーが、ChatGPTを個人のフィットネスおよび栄養コーチとして使用した成功体験を共有しました。AIを通じてトレーニング計画や食事プラン(ケトジェニック、筋力トレーニング、断食などを組み合わせる)を作成し、外食時に主要栄養素のアドバイスを得るなどして、最終的には有料の人間のコーチよりも良い結果を得ました。これは、パーソナライズされた指導や生活支援におけるAIの可能性を示しています。(出典: Reddit r/ChatGPT)

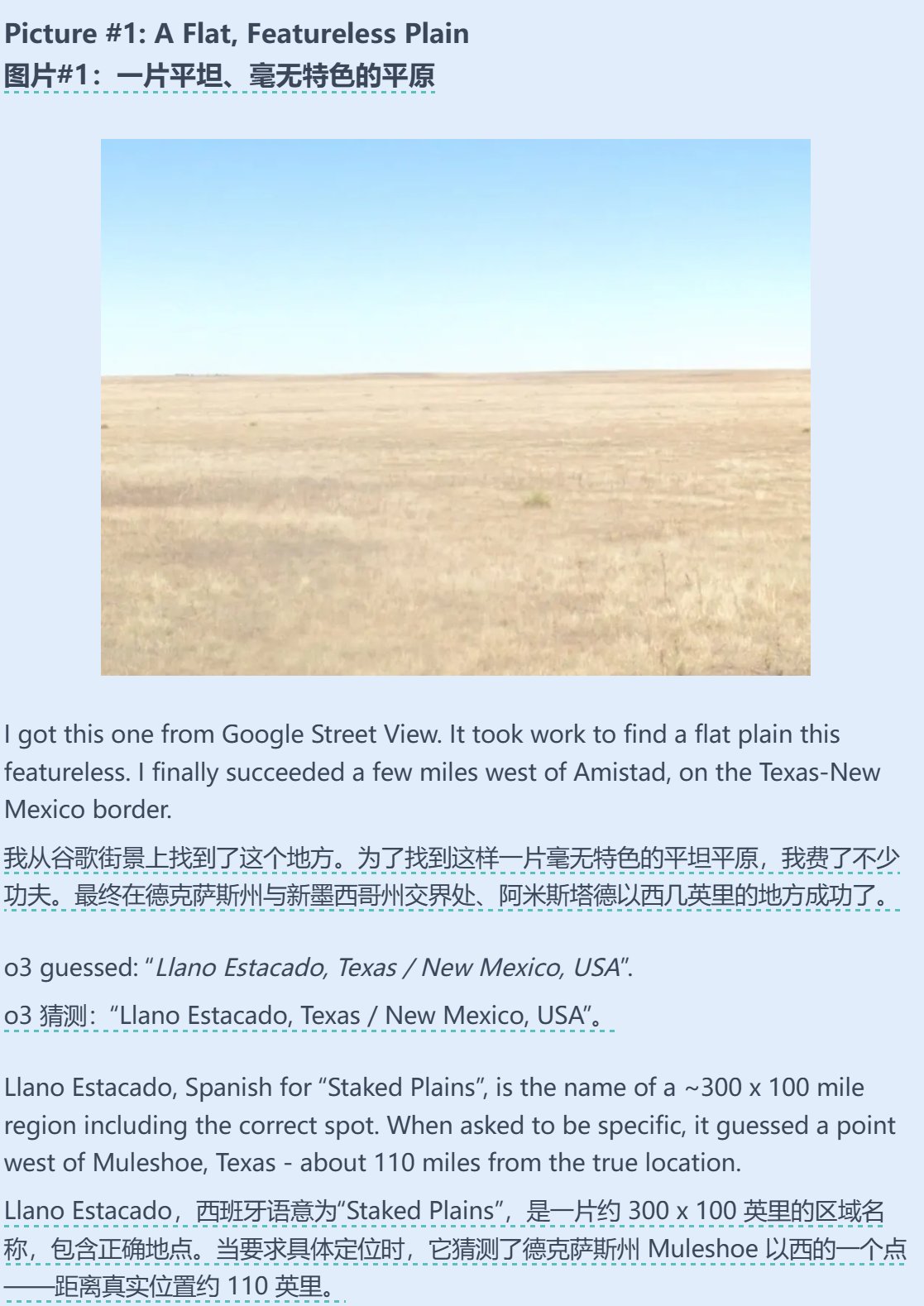

AIと地理推測能力の組み合わせ: Sam Altman氏が、AI(おそらくo3)がGeoguessr(地理推測ゲーム)で驚異的な能力を発揮したテストに関する記事をリツイートし、コメントしました。画像情報が非常に少ない(例:ぼやけた標識や単なるグラデーションのみ)場合でも、AIは選択肢の中に正解を含めることができ、その強力な画像認識、パターンマッチング、地理知識推論能力を示しています。(出典: op7418)

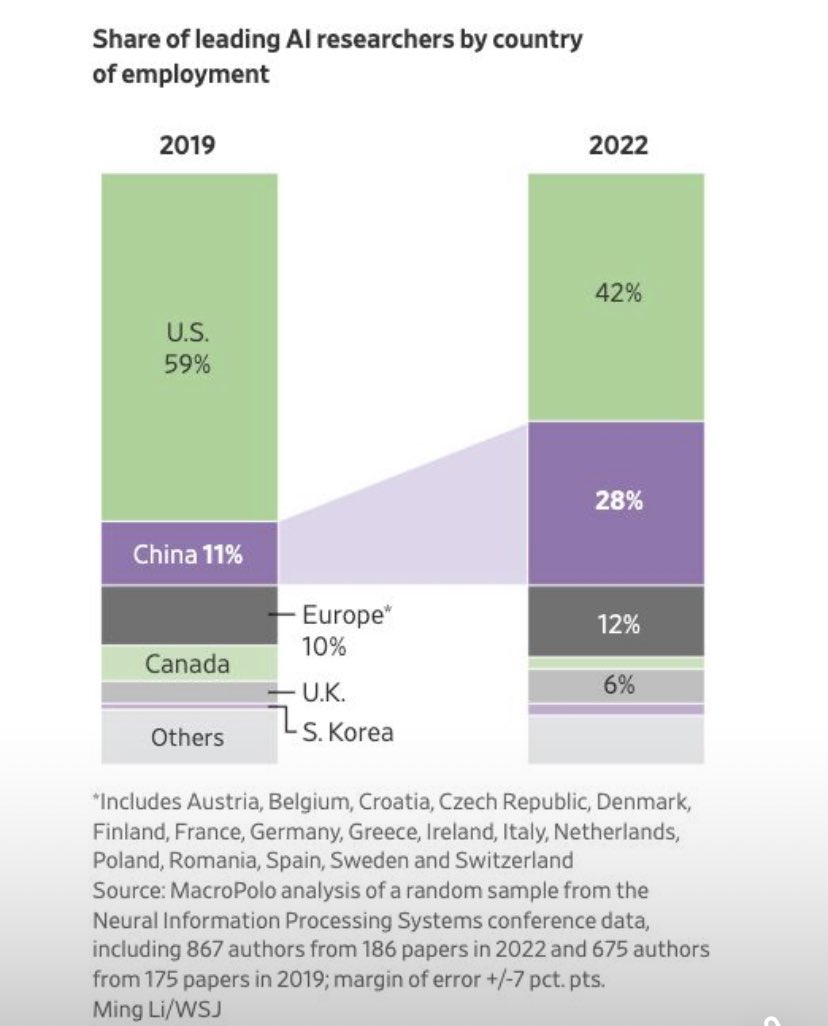

AI分野の研究者の流動トレンド: グラフによると、AI分野のトップ研究者の就職先の国別分布に変化が見られ、米国で就職する研究者の割合が減少し、中国で就職する割合が著しく上昇しています。コミュニティのコメントでは、中国国内の研究機会の増加や潜在的な人材還流を考慮すると、実際の差はグラフが示すよりも大きい可能性があり、これはグローバルなAI人材獲得競争の構図の変化を反映していると指摘されています。(出典: teortaxesTex, bookwormengr)