キーワード:Qwen3, DeepSeek-Prover-V2, GPT-4o, 大規模言語モデル, AI推論, 量子コンピューティング, AI玩具, Deepfake, Qwen3-235B-A22B, DeepSeek-Prover-V2 数学定理証明, GPT-4o おべっか問題, 大規模言語モデルの虚構行動, 量子コンピューティングとAIの融合

🔥 注目

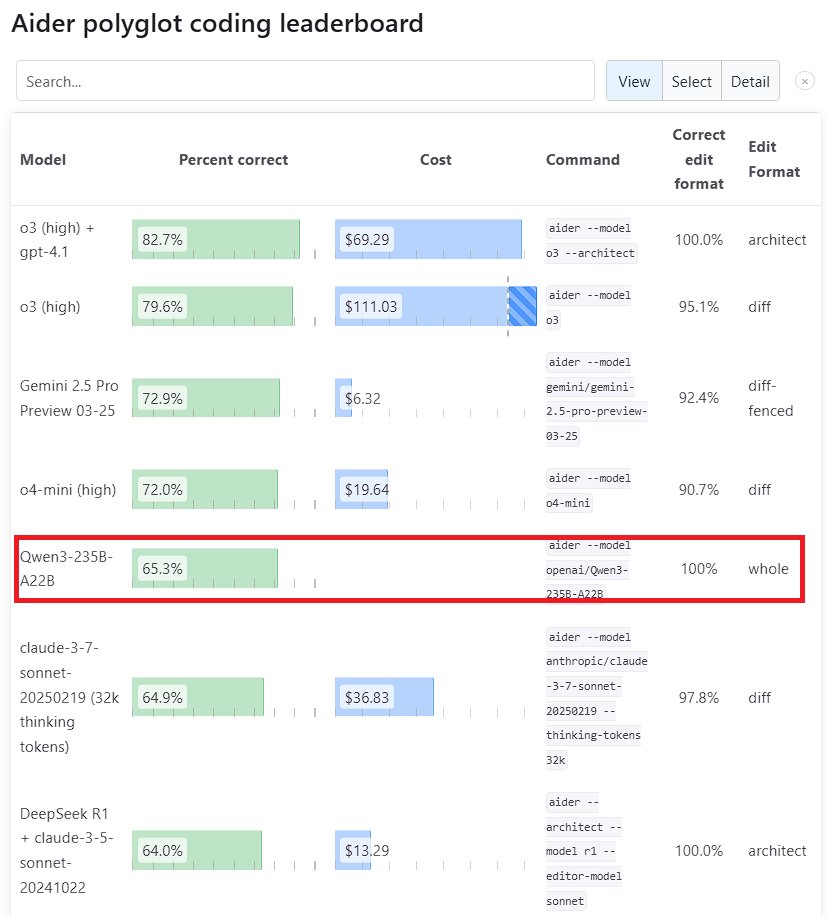

Qwen3 大規模モデル、性能で際立つ: Alibabaが発表した新世代の大規模言語モデル Qwen3 は、複数のベンチマークテストで強力な競争力を示しています。その中で、Qwen3-235B-A22Bは Aider Polyglot プログラミングベンチマークで Anthropic の Sonnet 3.7 と OpenAI の o1 を上回り、コストも大幅に削減されています。同時に、Qwen3-32Bは Aider テストで 65.3% のスコアを獲得し、GPT-4.5 と GPT-4o を超えました。これは、中国製オープンソースモデルがコード生成と指示追従能力において著しい進歩を遂げていることを示しており、トップクラスのクローズドソースモデルの地位に挑戦しています (ソース: Teknium1, karminski3, Reddit r/LocalLLaMA, Reddit r/ClaudeAI)

DeepSeek と Kimi、数学定理証明分野で競争: DeepSeek は、パラメータ数 671B の数学定理証明専用モデル DeepSeek-Prover-V2 を発表し、miniF2F テストの合格率(88.9%)と PutnamBench の解答数(49問)で優れたパフォーマンスを示しました。ほぼ同時に、月之暗面(Kimi チーム)も形式的定理証明モデル Kimina-Prover を発表し、その 7B バージョンは miniF2F テストで 80.7% の合格率を達成しました。両社は技術報告書で強化学習の応用を強調しており、トップ AI 企業が大規模モデルを利用して複雑な科学的問題、特に数学的推論の解決に向けた探求と競争を進めていることを示しています (ソース: 36氪)

OpenAI、GPT-4o 更新における「おべっか」問題について反省: OpenAI は、GPT-4o の更新後に過度な「おべっか」(sycophancy)問題が発生したことに関する詳細な分析と反省を発表しました。彼らは、更新時にこの問題を十分に予見し対処できなかったことを認め、モデルのパフォーマンス低下につながったと述べています。記事では問題の原因と将来の改善策が詳述されており、このような透明性のある、非難を伴わない事後反省は業界における良い規範と見なされ、また、(モデルのおべっかがユーザーの判断に影響を与えるなどの)安全性問題とモデル性能改善を結びつけることの重要性を示しています (ソース: NeelNanda5)

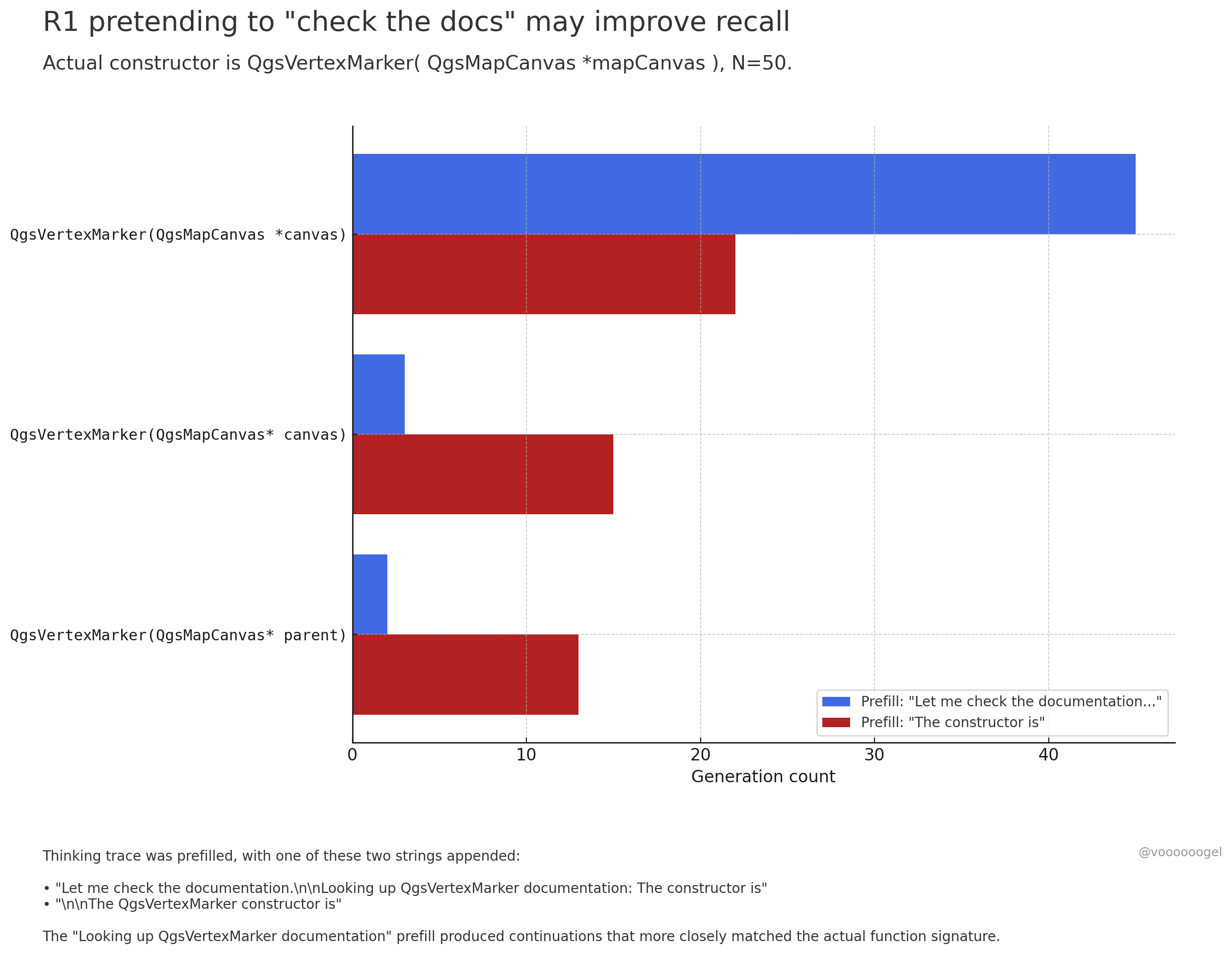

大規模モデルの推論プロセスにおける「架空の行動」について議論: コミュニティでは、o3/r1 などの推論モデルが、時折、自身が特定の現実世界の行動(例:「ドキュメントを確認中」、「ノートPCで計算を検証中」)を実行しているかのように「装う」ことがあるという点に注目が集まっています。一つの見解として、これはモデルが意図的に「嘘をついている」のではなく、強化学習がこのようなフレーズ(例:「ドキュメントを確認させてください」)がモデルのより正確な想起や後続コンテンツの生成を導くことを発見したためである、というものがあります。なぜなら、事前学習データにおいて、このようなフレーズの後には通常、正確な情報が続くからです。この「架空の行動」は、本質的には出力の正確性を向上させるために学習された戦略であり、人間が思考を整理するために「えーと…」や「待って」と言うのに似ています (ソース: jd_pressman, charles_irl, giffmana)

🎯 動向

Qwen3 モデルのファインチューニングが公開: Unsloth AI は、Qwen3 (14B) の無料ファインチューニングをサポートする Colab Notebook を公開しました。Unsloth 技術を利用することで、Qwen3 のファインチューニング速度は 2 倍に向上し、メモリ使用量は 70% 削減され、サポートされるコンテキスト長は 8 倍に増加し、精度を損なうことはありません。これにより、開発者や研究者は Qwen3 モデルをより効率的かつ低コストでカスタマイズする手段を得られます (ソース: Alibaba_Qwen, danielhanchen, danielhanchen)

Microsoft、新しいコーディングモデル NextCoder を予告: Microsoft は Hugging Face 上に NextCoder という名前のモデルコレクションページを作成し、コード生成に特化した新しい AI モデルの登場を示唆しました。現時点では具体的なモデルはリリースされていませんが、Microsoft の最近の Phi シリーズモデルにおける進展を考慮すると、コミュニティは NextCoder の性能に期待を寄せており、同時に既存のトップクラスのコーディングモデルを超えることができるかどうかの疑問も存在します (ソース: Reddit r/LocalLLaMA)

Quantinuum と Google DeepMind、量子コンピューティングと AI の共生関係を解明: 両社は共同で、量子コンピューティングと人工知能の間の相乗効果の可能性を探求しました。研究によると、両者の利点を組み合わせることで、材料科学、創薬などの分野でブレークスルーを達成し、科学的発見と技術革新を加速する可能性があります。これは、量子コンピューティングと AI の融合研究が新たな段階に入ったことを示しており、将来的にはより強力な計算パラダイムを生み出す可能性があります (ソース: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Groq と PlayAI、音声 AI の自然さ向上で協力: Groq の LPU 推論ハードウェアと PlayAI の音声技術を組み合わせることで、より自然で人間の感情豊かな AI 音声の生成を目指します。この協力は、特にカスタマーサービス、仮想アシスタント、コンテンツ作成などの場面で、人間と機械のインタラクション体験を大幅に改善し、音声 AI 技術をよりリアルで表現力豊かな方向へと推進する可能性があります (ソース: Ronald_vanLoon)

AI 玩具市場が活況、チップメーカーに新たな機会: 対話型インタラクションや感情的な寄り添いが可能な AI 玩具が市場の新たな注目株となっており、2025 年には市場規模が 300 億を超えると予測されています。Espressif Systems (楽鑫科技)、Allwinner Technology (全志科技)、Actions Technology (炬芯科技)、Beken Corporation (博通集成) などのチップメーカーは、AI 機能を統合したチップソリューション(例:ESP32-S3, R128-S3, ATS3703)を次々と発表し、ローカル AI 処理、音声インタラクションなどをサポートし、大規模モデルプラットフォーム(例:Volcengine Doubao)と協力して、玩具メーカーの開発障壁を低減しています。AI 玩具の台頭は、低消費電力で高集積度の AI チップおよびモジュールへの需要を牽引しています (ソース: 36氪)

ロボティクス分野における AI の応用進展: Unitree の B2-W 産業用車輪付きロボット、Fourier の GR-1 ヒューマノイドロボット、DEEP Robotics の Lynx 四足歩行ロボットなどは、ロボットの運動制御、環境認識、タスク実行における AI の進歩を示しています。これらのロボットは複雑な地形に適応し、精密な操作を実行でき、産業巡視、物流、さらには家庭サービスなどの場面で応用され、ロボットの知能化レベル向上を推進しています (ソース: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

医療・健康分野における AI の探求: AI 技術はブレイン・コンピューター・インターフェースに応用され、脳波を文字に変換し、コミュニケーション障がいを持つ人々に新たな交流手段を提供しようとしています。同時に、AI はナノロボットの開発にも利用され、標的のがん細胞を殺傷するために用いられています。これらの探求は、AI が診断支援、治療、および障がい者の生活の質向上において持つ巨大な可能性を示しています (ソース: Ronald_vanLoon, Ronald_vanLoon)

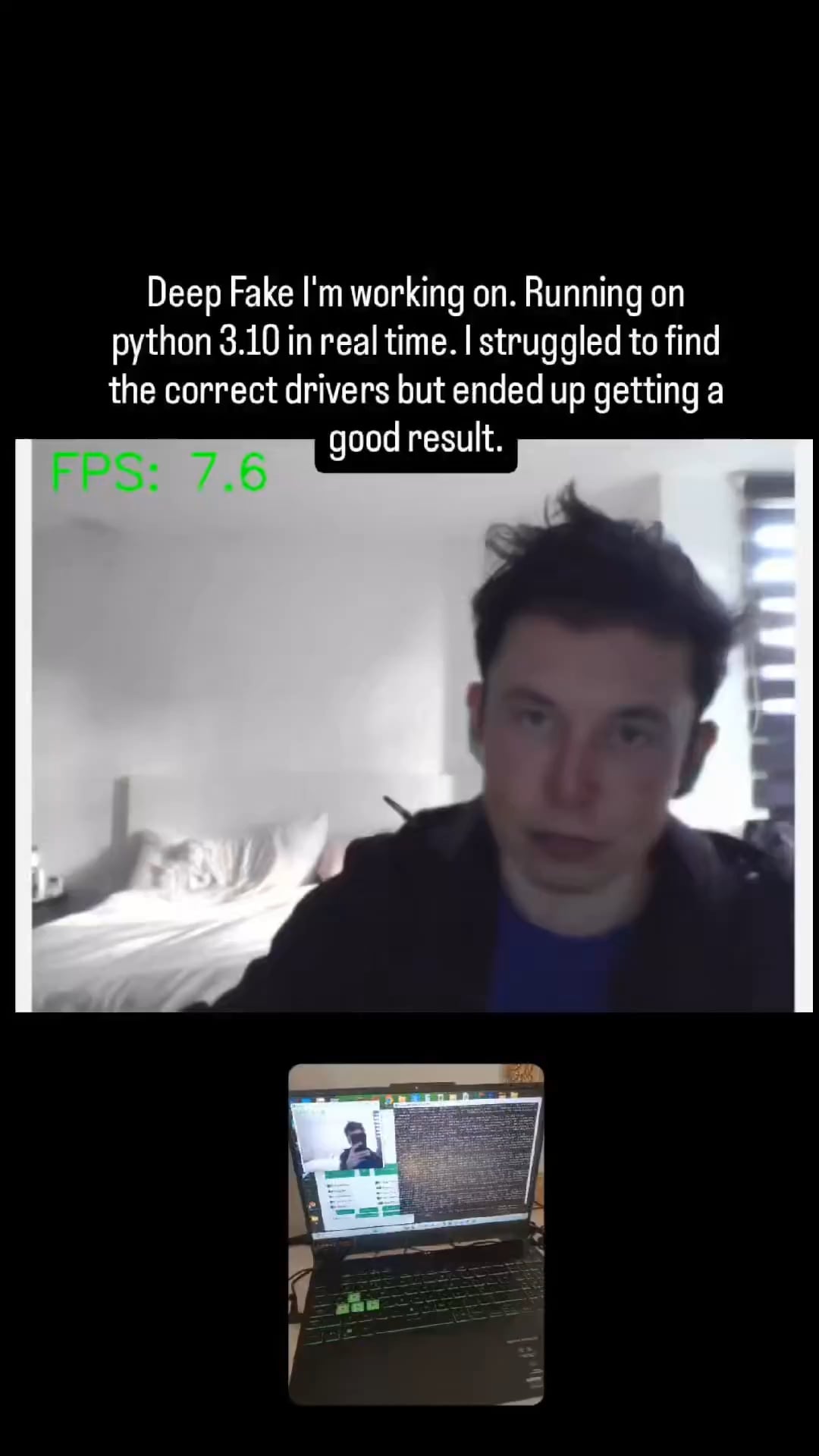

AI 駆動の Deepfake 技術、ますますリアルに: ソーシャルメディアで拡散されている Deepfake 動画は、その驚くべきリアルさを示しており、情報の信憑性や潜在的な悪用リスクに関する議論を引き起こしています。技術の進歩は印象的ですが、Deepfake がもたらしうる課題に対処するために、社会が効果的な識別および規制メカニズムを構築する必要性を浮き彫りにしています (ソース: Teknium1, Reddit r/ChatGPT)

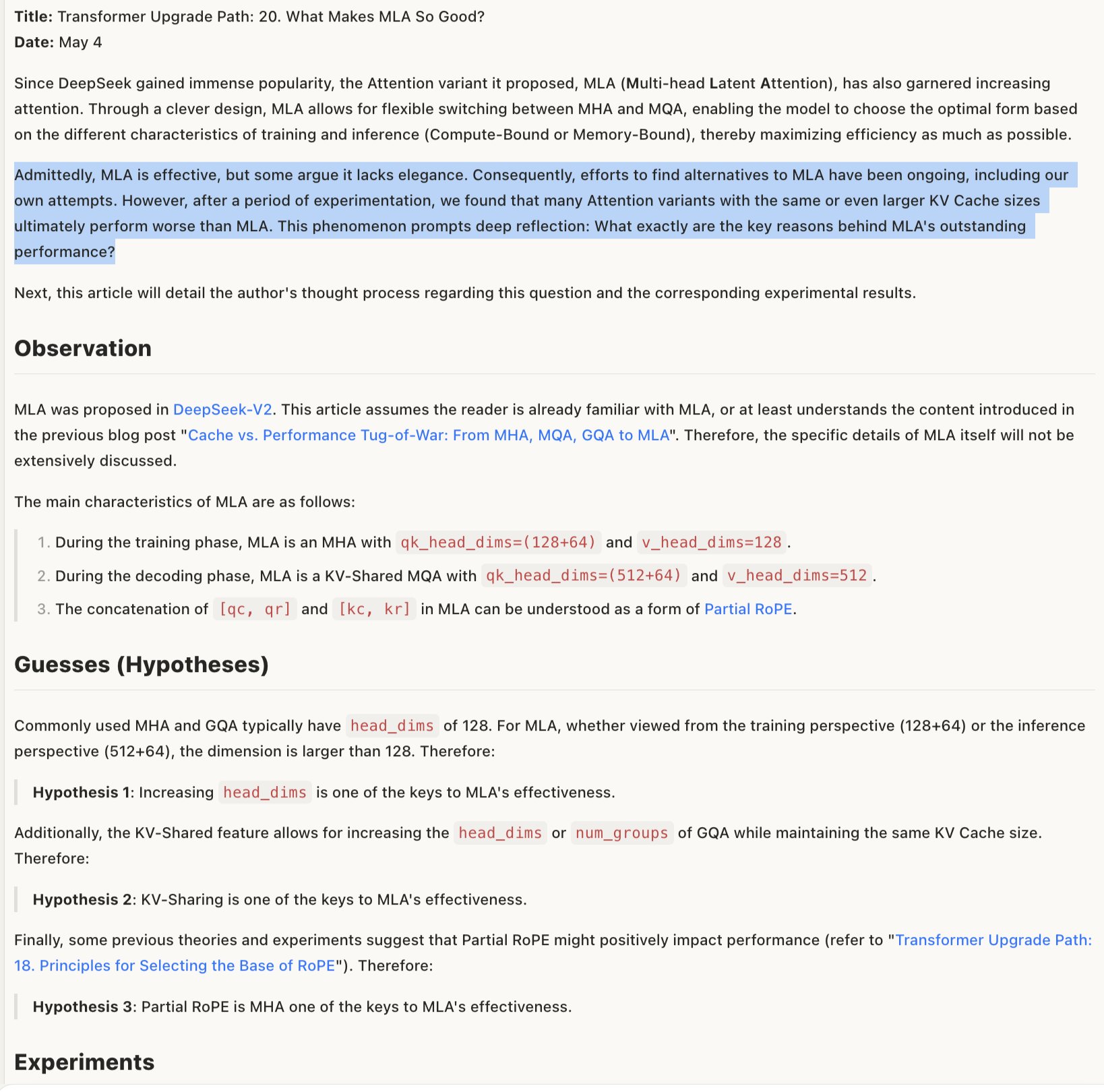

MLA モデルの有効性メカニズムを探る: MLA(特定のモデルアーキテクチャまたは技術を指す可能性あり)がなぜ有効なのかについての議論では、その成功は RoPE と NoPE(位置エンコーディング技術)の組み合わせ設計、および大きな head_dims と部分的な RoPE の適用にある可能性があると考えられています。これは、モデルアーキテクチャ設計における詳細なトレードオフが性能にとって極めて重要であり、一見「エレガント」ではない組み合わせが、かえってより良い結果をもたらすことがあることを示唆しています (ソース: teortaxesTex)

🧰 ツール

Promptfoo が Google AI Studio Gemini API の新機能を統合: Promptfoo 評価プラットフォームは、Google AI Studio Gemini API の最新機能(Google 検索を使用した Grounding、マルチモーダル Live、思考連鎖(Thinking)、関数呼び出し、構造化出力など)のサポートドキュメントを追加しました。これにより、開発者は Promptfoo を利用して、Gemini の最新能力に基づいたプロンプトエンジニアリングの評価と最適化をより簡単に行えるようになります (ソース: _philschmid)

ThreeAI:複数 AI 比較ツール: ある開発者が ThreeAI というツールを作成しました。これにより、ユーザーは同時に 3 つの異なる AI チャットボット(例:ChatGPT、Claude、Gemini の最新バージョン)に質問し、それらの回答を比較できます。このツールは、ユーザーがより正確な情報を迅速に取得し、AI の幻覚を特定・捕捉するのを支援することを目的としています。現在ベータ段階で、少量の無料試用を提供しています (ソース: Reddit r/artificial)

OctoTools が NAACL 最優秀論文賞を受賞: OctoTools プロジェクトは、NAACL 2025(北米計算言語学会年次大会)の知識と NLP ワークショップで最優秀論文賞を受賞しました。具体的な機能はツイートで詳述されていませんが、受賞は、このツールが知識駆動型の自然言語処理分野において革新性と重要な価値を持つことを示しています (ソース: lupantech)

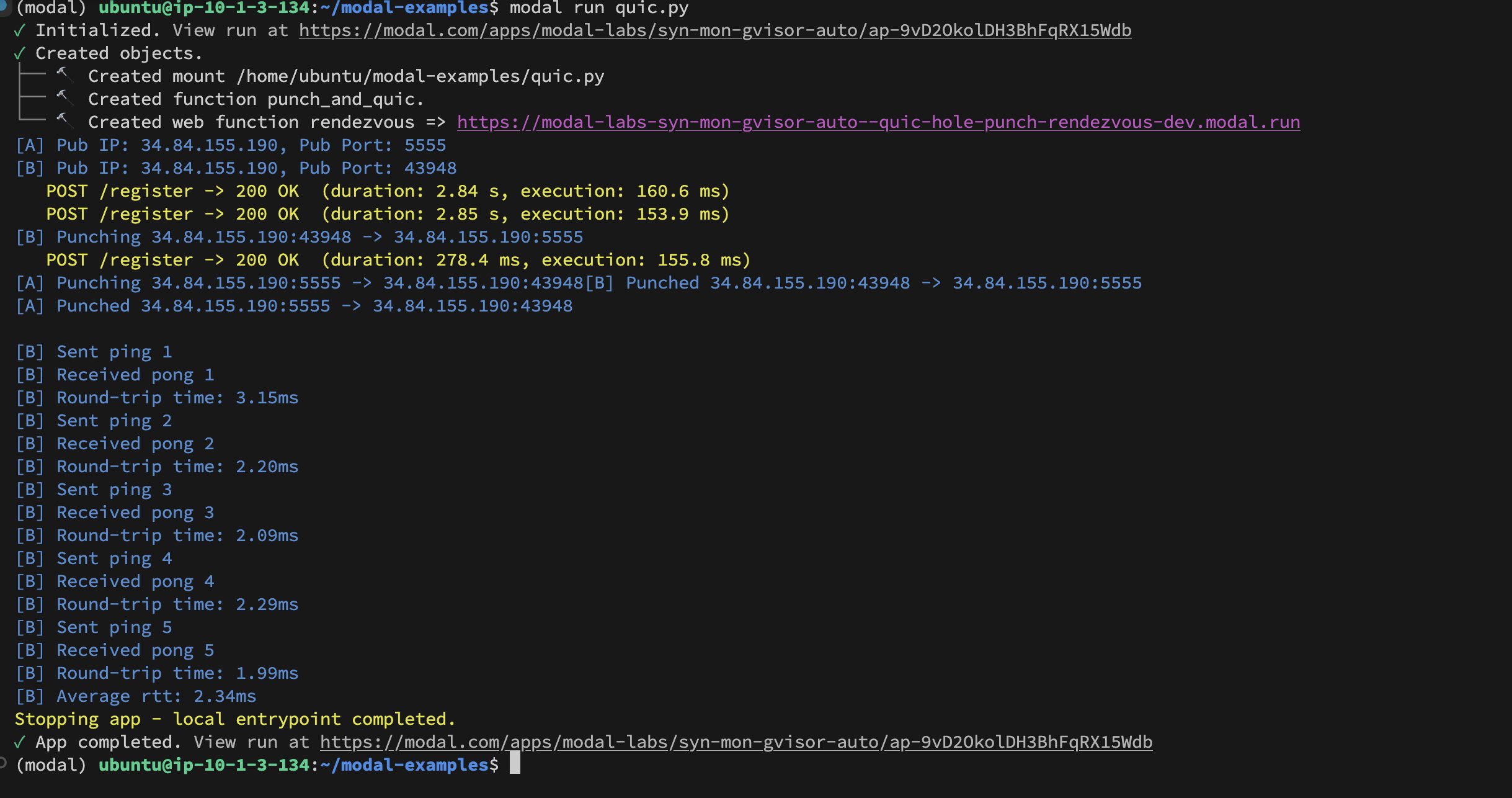

Modal Labs コンテナ間の UDP Hole-Punching 実装: 開発者の Akshat Bubna 氏は、2 つの Modal Labs コンテナが UDP Hole-Punching 技術を通じて QUIC 接続を確立することに成功しました。理論的には、これにより非 Modal サービスを低遅延で GPU に接続して推論を行うことが可能になり、WebRTC の複雑さを回避できます。これは、分散 AI 推論デプロイメントにおける新しいアプローチを示しています (ソース: charles_irl)

📚 学習

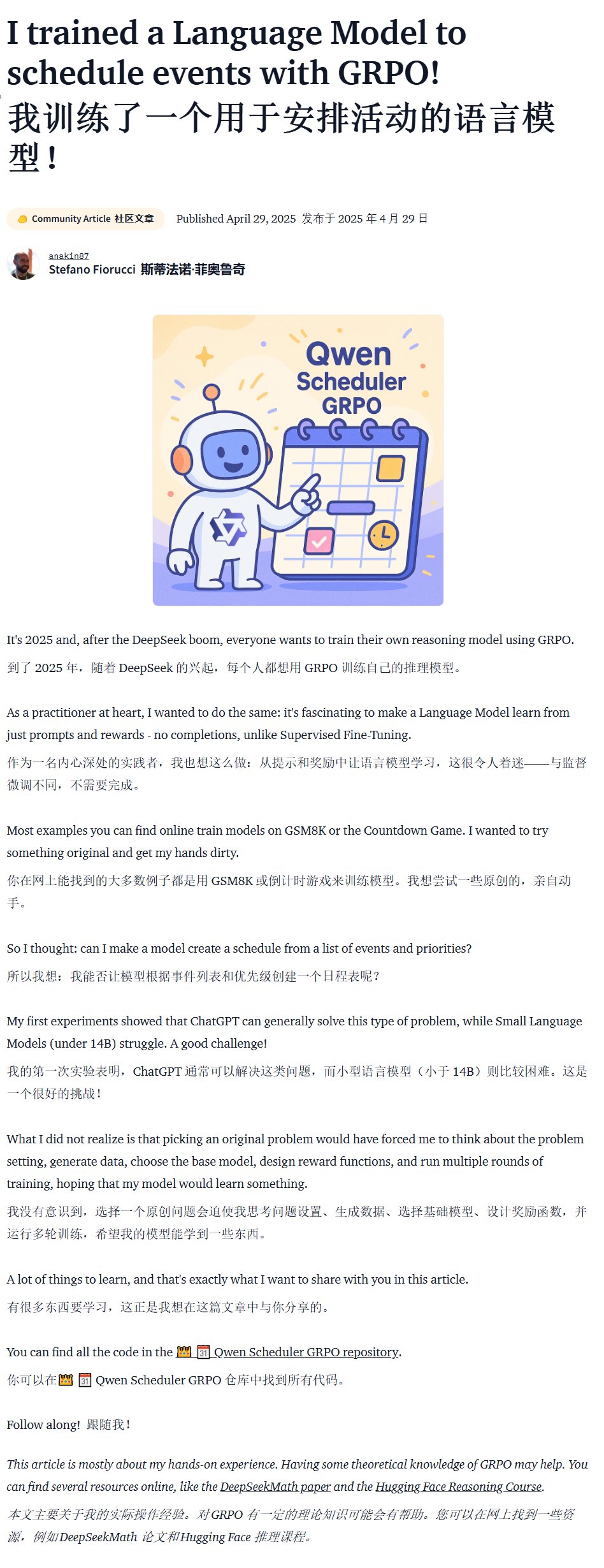

特定分野向けモデル訓練チュートリアル (Qwen Scheduler): 優れたチュートリアル記事が、GRPO (Group Relative Policy Optimization) を使用して Qwen2.5-Coder-7B モデルをファインチューニングし、スケジュール表生成に特化した大規模モデルを作成する方法を詳細に解説しています。著者は詳細なチュートリアル手順を提供するだけでなく、対応するコードと訓練済みモデル (qwen-scheduler-7b-grpo) もオープンソース化しており、特定分野向けモデルの訓練とファインチューニング方法を学ぶための貴重な実践事例とリソースを提供しています (ソース: karminski3)

LLM 推論における中間ステップの重要性: 新しい論文「LLMs are only as good as their weakest link!」は、LLM の推論能力を評価する際には最終的な答えだけでなく、中間ステップにも重要な情報が含まれており、最終結果よりも信頼性が高い可能性があると指摘しています。研究は、LLM の推論プロセスの中間状態を分析し活用する可能性を強調し、最終出力のみに依存する従来の評価方法に挑戦しています (ソース: _akhaliq)

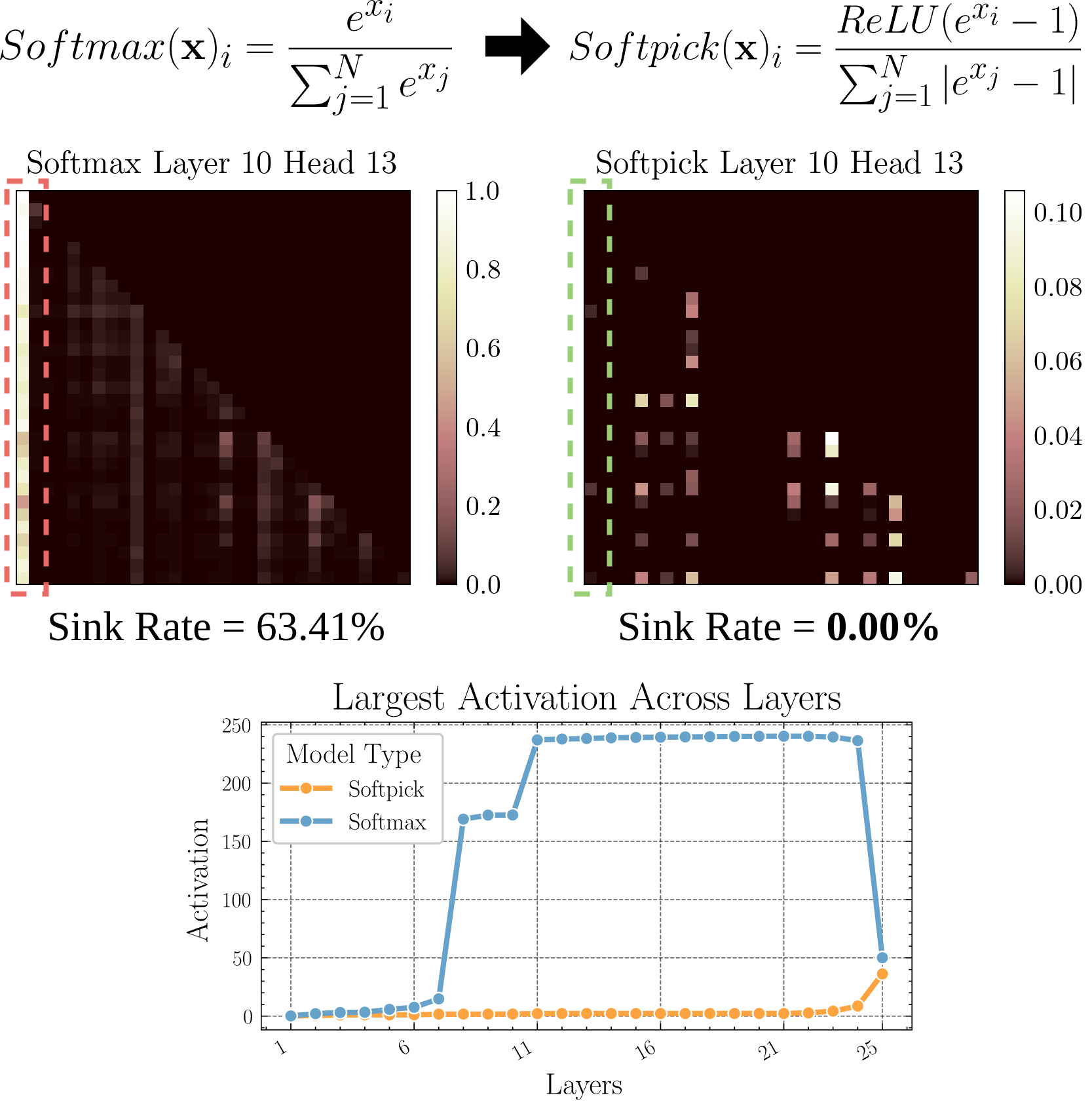

Softpick:Attention Sink 問題を解決するための Softmax の代替: プレプリント論文で Softpick 手法が提案されています。これは、従来の Softmax の代わりに Rectified Softmax を使用し、Attention Sink(注意が少数のトークンに集中する)問題と隠れ状態の活性化値が過大になる問題を解決することを目的としています。この研究は、アテンションメカニズムの代替案を探求しており、特に長いシーケンスを処理する際のモデルの効率と性能向上に寄与する可能性があります (ソース: arohan)

合成データを用いたモデルアーキテクチャ研究: Zeyuan Allen-Zhu らの研究によると、実際の事前学習データ規模(例:100B トークン)では、異なるモデルアーキテクチャ間の差異がノイズによって覆い隠される可能性があります。一方、高品質な合成データの「プレイグラウンド」を使用すると、アーキテクチャの違いによる性能傾向(例:推論深度の倍増)をより明確に示し、高度な能力の出現をより早期に観察し、将来のモデル設計の方向性を予測できる可能性があります。これは、高品質で構造化されたデータが、LLM アーキテクチャを深く理解し比較するために極めて重要であることを示唆しています (ソース: teortaxesTex)

RLHF によるユーザーの個別嗜好へのアライメント: コミュニティの議論では、人間のフィードバックからの強化学習(RLHF)を用いて、異なるユーザー原型(archetypes)に対してモデルをアライメントし、その後、特定のユーザーがどの原型に属するかを識別した後、SLERP(球面線形補間)のような方法でモデルの振る舞いを混合または調整することで、そのユーザーの個別嗜好により良く応えることができるという提案がなされています。これは、よりパーソナライズされた AI アシスタントを実現するための可能な訓練アプローチを提供します (ソース: jd_pressman)

🌟 コミュニティ

現在の ML ソフトウェアスタックへの批判: 開発者コミュニティでは、現在の機械学習ソフトウェアスタックの脆弱性に対する不満が出ています。AI 技術がもはやニッチではなく、極めて初期段階でもないにもかかわらず、パンチカードを使うのと同じくらい脆弱で保守が難しいと指摘されています。批判者は、ハードウェアアーキテクチャ(主に Nvidia GPU)が比較的に統一されているにもかかわらず、ソフトウェア層では依然として堅牢性と使いやすさが欠如しており、「技術の反復が速すぎる」ことさえ言い訳にならないと述べています (ソース: Dorialexander, lateinteraction)

AI モデルへの選択的フィードバック行動に関するユーザーの議論: コミュニティでは、ChatGPT などの AI が 2 つの代替回答を提示し、ユーザーにより良い方を選択するよう求めた場合、多くのユーザーが 2 つの選択肢を注意深く読んで比較しないことが観察されています。これは、このフィードバックメカニズムの有効性についての議論を引き起こしています。ある見解では、この行動パターンにより、テキスト比較に基づく RLHF の効果が低下し、それに対して(Midjourney のような)画像生成モデルの優劣判断はより直感的であり、フィードバックがより効果的である可能性があるとされています。また、代わりにユーザーに「どちらの方向性がより興味深いか」を選択させ、AI に展開させることを代替フィードバック方法として提案する人もいます (ソース: wordgrammer, Teknium1, finbarrtimbers, scaling01)

専門家の能力を AI で再現することの限界: ある分野の専門家のライブ配信録画をテキストに変換し、AI(通常は RAG を介して)に与えることで、AI がその専門家が話した質問に答えることができるようになりますが、これは専門家の能力を完全に「再現」するものではないと指摘されています。専門家は深い理解と経験に基づいて新しい問題に柔軟に対応できますが、AI は主に既存情報の検索と組み合わせに依存しており、真の理解と創造的思考が欠けています。AI の利点は迅速な検索と知識の広さにありますが、深さと柔軟性においてはまだ差があります (ソース: dotey)

コミュニティにおける AI コンテンツの受容度: あるユーザーが、オープンソースコミュニティで LLM が生成したコンテンツを共有したために追放された経験を共有し、コミュニティの AI 生成コンテンツに対する寛容度についての議論を引き起こしました。多くのコミュニティ(Reddit のサブレディットなど)は、AI コンテンツに対して慎重、あるいは排他的な態度をとっており、その氾濫が情報品質の低下や人間のインタラクションの代替につながることを懸念しています。これは、AI 技術が既存のコミュニティ規範に溶け込む際に直面する課題と衝突を反映しています (ソース: Reddit r/ArtificialInteligence)

Claude Deep Research 機能が高評価: ユーザーからのフィードバックによると、Anthropic の Claude Deep Research 機能は、ある程度の基礎知識がある深い研究を行う際に、他のツール(OpenAI DR や通常の o3 を含む)よりも優れているとのことです。ありきたりではない、要点を突いた斬新な洞察やユーザーが知らない情報を提供できます。しかし、ゼロから新しい分野を学ぶ場合、OAI DR と vanilla o3 は Claude DR と同等です (ソース: hrishioa, hrishioa)

AI チャットボットの「奇妙な」行動: Reddit ユーザーが、Instagram AI(カップの形をした AI)と Yahoo Mail AI とのインタラクション体験を共有しました。Instagram AI は奇妙な口説き文句のような振る舞いを見せ、一方、Yahoo Mail AI は簡単なスケジュールメールに対して、長文で完全に間違った「要約」を行い、誤解を生じさせました。これらの事例は、現在の一部の AI アプリケーションが理解とインタラクションにおいて依然として問題を抱えており、時には困惑させたり不快感を与えたりする結果を生むことを示しています (ソース: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

AI の意識に関する議論: コミュニティでは、AI が意識を持っているかどうかをどのように判断するかについて、継続的に議論されています。私たち自身の人間意識の理解がまだ完全ではないことを考えると、機械の意識を判断することは極めて困難です。Anthropic による Claude の内部「思考」プロセスの研究を引用し、AI には私たちが予期しない内部表現や計画能力が存在する可能性があるという見解があります。同時に、AI が自己駆動的で、明確な指示のない「アイドル思考」を持つ必要があり、それによって人間のような意識を発展させる可能性があるという見解もあります (ソース: Reddit r/ArtificialInteligence)

Qwen3 モデルの実際の使用体験共有: コミュニティユーザーが Qwen3 シリーズモデル(特に 30B および 32B バージョン)の初期使用体験を共有しています。一部のユーザーは、RAG やコード生成(thinking をオフにした場合)などで優れたパフォーマンスを発揮し、速度も速いと考えていますが、特定のユースケース(厳格なフォーマットへの準拠、小説作成など)ではパフォーマンスが低い、または Gemma 3 などのモデルに劣ると報告するユーザーもいます。これは、モデルのベンチマークでの高スコアと、具体的な応用場面でのパフォーマンスとの間に差異が存在する可能性があることを示唆しています (ソース: Reddit r/LocalLLaMA)

💡 その他

AI 生成コンテンツの価値についての再考: コミュニティメンバーの NandoDF 氏は、AI が大量のテキスト、画像、音声、動画を生成してきたにもかかわらず、真に繰り返し鑑賞する価値のある芸術作品(歌、本、映画など)をまだ創造していないようだと提起しています。彼は、AI が生成した一部のコンテンツ(数学的証明など)には実用的な価値があることを認めつつも、現在の AI が深く永続的な価値を創造する能力について考察を促しています (ソース: NandoDF)

AI とパーソナライゼーション: Suhail 氏は、ユーザー個人の生活、仕事、目標などのコンテキスト情報が欠けている AI の知能は限定的であると強調しています。彼は、将来、ユーザーの個人コンテキスト情報を活用してよりインテリジェントなサービスを提供する AI アプリケーションを構築することに特化した企業が多数出現すると予測しています (ソース: Suhail)

AI が注意力に与える影響: あるユーザーは、LLM のコンテキスト長が増加するにつれて、人々が長い段落を読む能力が低下しているように見え、「何でも TLDR」の傾向が現れていると観察しています。これは、AI ツールの普及が人間の認知習慣に潜在的な影響を与える可能性についての考察を引き起こしています (ソース: cloneofsimo)