キーワード:テスラ, Optimusロボット, AI, GPT-5, 大規模モデルトレーニング, Meta AI, LLM事前トレーニング, 金魚損失関数, DynaGuard動的ガードモデル, GAMネットワークアーキテクチャ, MedDINOv3医用画像セグメンテーション, M3Retマルチモーダル医用画像検索

🔥 注目

イーロン・マスク氏が「Master Plan Part IV」を発表:テスラの価値の80%はロボットにある : テスラは「Master Plan Part IV」を正式に発表した。その核心は、AIを現実の物理世界に導入し、テスラのハードウェアとソフトウェアを大規模に統合することで、「持続可能な豊かさ」を実現することにある。マスク氏は、将来的にテスラの価値の約80%は人型ロボットOptimusから生まれると指摘し、同社が電気自動車からエネルギー、AI、ロボットの深い融合へとパラダイムシフトし、技術を通じて現実世界の問題を解決し、全人類に貢献することを目指していることを示唆した。(出典:量子位)

🎯 動向

AIが国際数学オリンピックで金メダルを獲得 : OpenAIのGPTとGoogle DeepMindのGeminiが国際数学オリンピックで金メダルを獲得し、専門家の予測を覆した。これはLLMの数学的推論における驚くべき進歩を示し、AIの発展速度が予想をはるかに超え、「汎用的な知能」の時代に突入したことを示唆している。これは技術的なブレークスルーであるだけでなく、AIの能力の限界と将来の社会への影響について深い議論を巻き起こしている。(出典:36氪)

GPT-5が人狼ゲームで卓越したパフォーマンスを発揮 : AIWolfDial 2025人狼ベンチマークテストにおいて、GPT-5が96.7%という圧倒的な勝率でリードし、強力な社会的推論、欺瞞、操作耐性能力を示した。Kimi-K2は大胆で攻撃的な「ブラフ」スタイルを示し、複雑な社会的相互作用におけるLLMの個別化された行動パターンを反映している。(出典:量子位,Reddit r/deeplearning)

大規模モデル訓練の新しい方法「Goldfish Loss」 : メリーランド大学などの研究チームが「Goldfish Loss」を提案した。これは、損失関数計算時に一部のtokenをランダムに削除することで、大規模モデルの記憶過多を効果的に減らし、訓練データを丸暗記するのを防ぐ。同時に、下流タスクの性能に影響を与えることなく、モデルの汎化性能を向上させる。(出典:量子位)

Metaの内部AI部門再編が論争を呼ぶ : MetaのチーフAIオフィサーAlexandr Wangが新規則を施行し、FAIRが論文を発表する際にはTBDラボの審査を必須とし、価値のある論文や著者については製品化のために「保留」する可能性があるとした。この動きはFAIR内部の不満を招き、一部の従業員が退職した。これは、MetaのAI戦略調整における研究の独立性への介入と、成果転換への強硬な姿勢を浮き彫りにしている。(出典:量子位)

LLM事前学習オプティマイザの性能ベンチマーク : 異なるモデル規模とデータモデル比率をカバーする10種類の深層学習オプティマイザについて体系的な研究を実施。公正な比較には厳密なハイパーパラメータ調整が必要であり、訓練終了時の性能を評価する必要があることを発見した。研究によると、行列ベースのオプティマイザ(MuonやSoapなど)の速度向上はモデル規模が大きくなるにつれて減少し、1.2Bモデルではわずか1.1倍であった。これはLLM事前学習オプティマイザの選択と将来の研究に指針を提供する。(出典:HuggingFace Daily Papers,HuggingFace Daily Papers)

DynaGuard:ユーザー定義ポリシーによる動的ガードレールモデル : DynaGuard動的ガードレールモデルを提案。これは、ユーザー定義のポリシーに基づいてテキストを評価し、違反行為を迅速に検出できる。このモデルは、静的な危害カテゴリ検出において標準のガードレールモデルと同等の精度を示し、同時に自由形式のポリシー違反をより短時間で識別できるため、チャットボットに柔軟で効率的な出力監視を提供する。(出典:HuggingFace Daily Papers)

Gated Associative Memory (GAM) ネットワーク : GAMネットワークを提案。これは、シーケンス長に対して線形(O(N))の複雑さを持つ新しい完全並列シーケンスモデリングアーキテクチャであり、Transformerの自己注意メカニズムにおける二次的な複雑さのボトルネックを解決する。GAMは因果畳み込みと並列連想記憶検索を組み合わせ、WikiText-2およびTinyStoriesデータセットでTransformerやMambaよりも高速な訓練速度と、同等またはそれ以上の検証パープレキシティを示した。(出典:HuggingFace Daily Papers)

Reasoning Vectors:タスク算術による思考連鎖能力の転移 : LLMの推論能力がコンパクトなタスクベクトルとして抽出され、モデル間で転移可能であることが研究で示された。ファインチューニングモデルとSFTモデル間のベクトル差を計算し、それを他の命令ファインチューニングモデルに追加することで、GSM8K、HumanEvalなどの複数の推論ベンチマークでモデルのパフォーマンスを一貫して向上させることができ、LLMの能力強化に効率的で再利用可能な方法を提供する。(出典:HuggingFace Daily Papers)

MedDINOv3:医用画像セグメンテーションのための視覚基盤モデル : MedDINOv3フレームワークを発表。これは、ViTバックボーンを再設計し、CT-3Mデータセットでドメイン適応型事前学習を行うことで、DINOv3を医用画像セグメンテーションに効果的に適用する。このモデルは、複数のセグメンテーションベンチマークでSOTA性能を達成または上回り、医用画像セグメンテーションの統一バックボーンとしての視覚基盤モデルの大きな可能性を示している。(出典:HuggingFace Daily Papers)

M3Ret:ゼロショットマルチモーダル医用画像検索 : M3Retは、大規模な混合モーダルデータセットで統一視覚エンコーダを訓練することにより、ゼロショット画像間検索でSOTA性能を達成した。このモデルは、未見のMRIタスクで強力な汎化能力を示し、生成型および対照型自己教師あり学習パラダイムを通じて、マルチモーダル医用画像理解における視覚自己教師あり基盤モデルの発展を推進した。(出典:HuggingFace Daily Papers)

OpenVision 2:マルチモーダル学習のための生成型視覚エンコーダ : OpenVision 2は、アーキテクチャと損失設計を簡素化し、テキストエンコーダと対照損失を削除し、キャプション生成損失のみを保持した。この純粋な生成型訓練信号は、マルチモーダルベンチマークで優れた性能を示し、同時に訓練時間とメモリ消費を大幅に削減し、将来のマルチモーダル基盤モデルの視覚エンコーダ開発に効率的なパラダイムを提供する。(出典:HuggingFace Daily Papers)

LLaVA-Critic-R1:評価モデルも強力なポリシーモデルになり得る : LLaVA-Critic-R1は、RL訓練を通じて選好アノテーションされた評価データセットを検証可能な信号に変換することで、高性能な評価モデルであるだけでなく、競争力のあるポリシーモデルでもある。複数の視覚推論および理解ベンチマークで専門VLMを凌駕し、テスト時の自己批判を通じて推論性能をさらに向上させることができる。(出典:HuggingFace Daily Papers)

Metis:LLMの低ビット量子化訓練 : Metisフレームワークは、スペクトル分解、適応型学習率、およびデュアルレンジ正則化を組み合わせることで、LLMの低ビット量子化訓練における異方性パラメータ分布の課題を解決した。この方法は、FP8訓練がFP32ベースラインを上回り、FP4訓練がFP32の精度を達成することを可能にし、LLMの高度な低ビット量子化における堅牢でスケーラブルな訓練への道を開く。(出典:HuggingFace Daily Papers)

AMBEDKAR:多層的バイアス除去フレームワーク : インド憲法の平等というビジョンに触発されたAMBEDKARフレームワークを提案。憲法認識デコーディング層と推測デコーディングアルゴリズムを通じて、推論時にLLMにおけるカーストと宗教に関するバイアスを積極的に低減する。この方法はモデルパラメータの変更を必要とせず、計算コストを削減し、バイアスを大幅に低減するため、特定の文化背景におけるLLMの公平性に新しい道筋を提供する。(出典:HuggingFace Daily Papers)

C-DiffDet+:グローバルなシーンコンテキストを融合した高忠実度オブジェクト検出 : C-DiffDet+を提案。コンテキスト認識融合(CAF)メカニズムを導入することで、グローバルなシーンコンテキストとローカルな提案特徴を直接統合し、生成型検出パラダイムを大幅に強化する。このフレームワークは、専用エンコーダを利用して包括的な環境情報を捕捉し、各オブジェクト提案がシーンレベルの理解に焦点を当てることを可能にし、CarDDベンチマークでSOTAモデルを凌駕する。(出典:HuggingFace Daily Papers)

GenCompositor:拡散Transformerに基づく生成型ビデオ合成 : GenCompositorを提案。これは、新しい拡散Transformer (DiT) パイプラインを通じて、インタラクティブな生成型ビデオ合成を実現する。この方法は、軽量な背景保持ブランチとDiT融合ブロックを設計し、Extended Rotary Position Embedding (ERoPE) を導入することで、VideoCompデータセットで高忠実度と一貫性のあるビデオ合成を達成し、既存のソリューションを凌駕する。(出典:HuggingFace Daily Papers)

ELV-Halluc:長尺動画理解における意味集約ハルシネーションベンチマーク : ELV-Hallucを発表。これは、長尺動画のハルシネーションに特化した初のベンチマークであり、意味集約ハルシネーション(SAH)を体系的に研究する。実験によりSAHの存在が確認され、意味の複雑さが増すにつれて発生しやすくなり、急速に変化する意味においてより頻繁に発生することが示された。研究では、位置エンコーディング戦略とDPOがSAHを緩和し、敵対的データペアによってSAH比率を大幅に低減できることも示されている。(出典:HuggingFace Daily Papers)

FastFit:キャッシュ可能な拡散モデルによる仮想試着の高速化 : FastFitを提案。これは、キャッシュ可能な拡散アーキテクチャに基づく高速多参照仮想試着フレームワークである。半注意メカニズムとクラス埋め込みにより、参照特徴エンコーディングとデノイズプロセスを分離し、参照特徴を一度計算して無損失で再利用することを可能にし、平均3.5倍の高速化を実現し、DressCode-MRなどのデータセットでSOTA手法を凌駕する。(出典:HuggingFace Daily Papers)

🧰 ツール

Google Geminiの「nano-banana」機能 : Google Geminiが「nano-banana」機能をリリース。ユーザーはプロンプト一つで写真をミニチュアモデル風の画像に変換でき、操作は簡単で創造性に富む。これにより、個人写真、風景写真、ペット写真をカスタマイズされたミニチュアモデルに変換する楽しい体験をユーザーに提供する。(出典:GoogleDeepMind)

Alibaba_WanのWan2.2画像生成能力 : Alibaba_Wanは、Wan2.2の画像生成における優れたディテール再現能力を披露した。「傾いた斧と埃まみれの写真」から「影の中の微かな動き」まで、ホラー映画のような雰囲気を完璧に演出し、複雑なシーンや感情を創造するAIの強力な可能性を示している。(出典:Alibaba_Wan,Alibaba_Wan)

Claude Codeの完全ファイル読み取り機能 : Claude Codeが更新され、完全なファイル読み取りをサポートするようになった。これにより、以前の50/100行のgrep結合の制限が解消され、ファイル読み取り速度がGemini CLIと同レベルにまで大幅に向上した。これは、バックエンドハードウェア(TPUなど)の改善によるものと推測されるが、コンテキストサイズは依然として200kと表示されている。(出典:Reddit r/ClaudeAI)

Le ChatがMCPコネクタと記憶機能を統合 : Le Chatは20以上の企業プラットフォームコネクタ(MCPベース)を統合し、「記憶」機能を導入した。これにより、高度にパーソナライズされた応答を提供し、ChatGPTの記憶のインポートもサポートする。これは、企業環境におけるLe Chatの応用能力を強化し、ユーザーの好みや事実をより良く理解し、AIアシスタントの実用性を向上させる。(出典:Reddit r/LocalLLaMA)

GoogleのLangExtractツール : Googleは、テキストから知識グラフを抽出するためのツールLangExtractをリリースした。これは非構造化テキストを構造化知識に変換でき、RAG(検索拡張生成)の実装に非常に役立ち、個人プロジェクトでの知識グラフ構築を支援し、LLMにさらに正確なコンテキスト情報を提供する。(出典:Reddit r/LocalLLaMA)

Model Context Protocol (MCP) サーバーエコシステム : GitHubプロジェクトappcypher/awesome-mcp-serversは、AIモデルがファイルシステム、データベース、APIなどのローカルおよびリモートリソースと安全に相互作用できる多数のMCPサーバーを収録している。このエコシステムは、AIエージェントの能力をファイルシステム、サンドボックス、バージョン管理、クラウドストレージ、データベースなど多岐にわたる分野で大幅に拡張し、AIツールの統合と応用を推進する。(出典:GitHub Trending)

Universal Deep Research (UDR) システム : UDRは、あらゆる言語モデルをカプセル化し、ユーザーが完全にカスタマイズされた深層研究戦略を、追加の訓練やファインチューニングなしで作成、編集、改善できる汎用エージェントシステムである。最小限、拡張、密度の研究戦略の例を提供することで、システム実験を促進し、AI研究の柔軟性と効率を向上させる。(出典:HuggingFace Daily Papers)

SQL-of-Thought:マルチエージェントText-to-SQLフレームワーク : SQL-of-Thoughtを提案。これは、Text2SQLタスクをスキーマリンク、サブ問題識別、クエリ計画生成、SQL生成、およびガイド付きエラー修正ループに分解するマルチエージェントフレームワークである。このフレームワークは、ガイド付きエラー分類と推論ベースのクエリ計画を組み合わせることで、Spiderデータセットで最先端の結果を達成し、自然言語からSQLへの変換の堅牢性を向上させた。(出典:HuggingFace Daily Papers)

VerlTool:ツール使用Agentic強化学習フレームワーク : VerlToolは、多段階ツールインタラクションのAgentic強化学習(ARLT)における断片化、同期実行のボトルネック、スケーラビリティの制限を解決するために設計された、統一されたモジュール型フレームワークである。VeRLとの上流アライメント、統一されたツール管理、非同期ロールアウト実行、および包括的な評価を通じて、約2倍の速度向上を実現し、6つのARLTドメインで競争力のある性能を示した。(出典:HuggingFace Daily Papers)

MobiAgent:カスタマイズ可能なモバイルAgentシステム : MobiAgentは、MobiMindシリーズのAgentモデル、AgentRR高速化フレームワーク、MobiFlowベンチマークスイートを含む包括的なモバイルAgentシステムである。AI支援のデータ収集プロセスを通じて、高品質なデータアノテーションコストを大幅に削減し、現実世界のモバイルシナリオで最先端の性能を達成し、既存のGUIモバイルAgentにおける精度と効率の課題を解決した。(出典:HuggingFace Daily Papers)

VARIN:テキストガイドによる自己回帰画像編集 : VARINは、ノイズ反転に基づくVARモデル画像編集技術の初の事例であり、Location-aware Argmax Inversion (LAI) を利用して逆Gumbelノイズを生成し、正確なソース画像再構築と制御されたテキストガイド編集を実現する。この方法は、画像を修正しながら元の背景と構造の詳細を大幅に保持し、実用的な編集方法としての有効性を示した。(出典:HuggingFace Daily Papers)

📚 学習

大学AIコースプロジェクトの提案 : Redditユーザーが「人工知能の基礎」コースのインタラクティブなプロジェクトのアイデアを求めており、高性能コンピューターに依存しないことが条件。議論は、LLMができること、スマートデバイスの機能、これらの概念を教育にどのように組み合わせるかに集中し、実践的で計算能力要件の低いプロジェクトが強調された。(出典:Reddit r/ArtificialInteligence)

GitHub学生リソース大全 : dipakkr/A-to-Z-Resources-for-Studentsは、大学生向けに厳選されたリソースリストで、プログラミング言語学習(Python, ML, LLM, DL, Androidなど)、ハッカソン、学生特典、オープンソースプロジェクト、インターンシップポータル、開発者コミュニティなどを網羅している。AIツールとリソースのセクションでは、人気のAIツールとGitHubリポジトリが詳細にリストされている。(出典:GitHub Trending)

研究論文の理解とAI/ML初心者向け入門 : RedditでAI学習に関する2つの議論が行われた。1つは研究論文の理解方法について、もう1つはAI/ML初心者が入門コースの推奨を求めている。これらの議論は、AI学習者が最先端の研究を理解し、学習パスを選択する上での一般的な戸惑いを反映している。(出典:Reddit r/deeplearning,Reddit r/deeplearning)

FlashAdventure:GUI Agentの冒険ゲームベンチマーク : FlashAdventureは、34のFlashアドベンチャーゲームを含むベンチマークテストで、LLM駆動のGUIエージェントが完全なストーリーラインを完了する能力を評価し、「観察-行動ギャップ」問題を解決することを目的としている。COASTフレームワークは、長期的な手がかり記憶を通じて計画を改善し、マイルストーン達成度を向上させたが、人間のパフォーマンスとは依然として大きな隔たりがある。(出典:HuggingFace Daily Papers)

The Gold Medals in an Empty Room: LLMのメタ言語推論の診断 : Camlangを提案。これは、文法書とバイリンガル辞書を通じて、LLMが馴染みのない言語でメタ言語演繹学習を行う能力を評価する新しい人工言語である。GPT-5はCamlangタスクで人間のパフォーマンスをはるかに下回り、現在のモデルが体系的な文法習得において人間と根本的な隔たりがあることを示しており、LLMの認知科学的評価に新しいパラダイムを提供する。(出典:HuggingFace Daily Papers)

💼 ビジネス

アルトマン氏がインドのAIインフラに賭ける挑戦 : OpenAIはインドで「StarGate」プロジェクトを大規模に拡大し、AI計算能力インフラに巨額を投じる計画だが、インドはGPUの数、資金投入、ハイエンド人材の流出という「3つの赤字」の課題に加え、電力供給という致命的な弱点を抱えており、AIインフラの潜在力に市場の疑問符が投げかけられている。(出典:36氪)

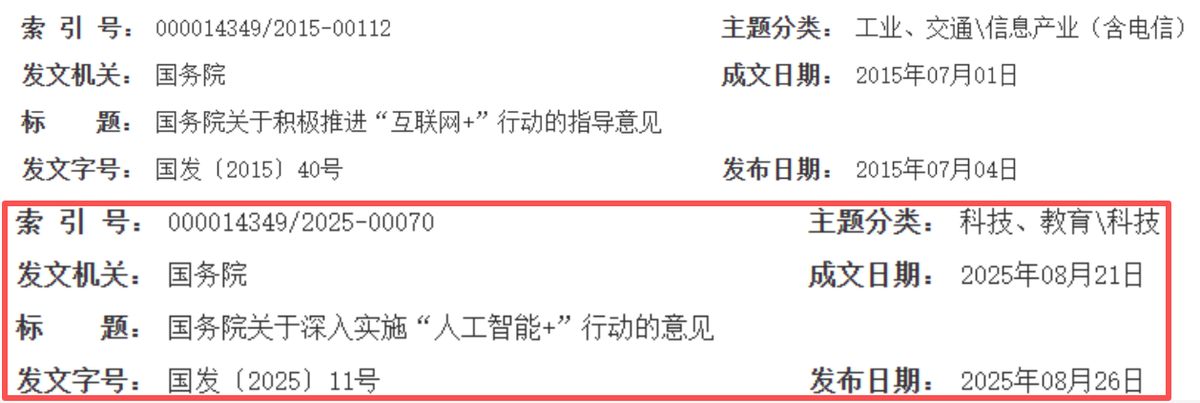

AIが中国インターネットの新たな成長サイクルを再構築 : 中国のインターネット業界は「接続によるエンパワーメント」から「スマート駆動」へと転換しており、AIが新たな成長エンジンとなっている。Alibaba、Tencent、Baiduなどの大手企業はAI関連の設備投資を大幅に増やし、事業のAI化を加速させ、「資本投下」から「AIによるエンパワーメント」へと戦略的転換を実現している。これは、中国のインターネットが技術の深さ、産業融合、ビジネス効率を重視する新たな黄金の10年に入ったことを示唆している。(出典:36氪)

SalesforceがAIにより4000人を削減 : SalesforceのCEO Marc Benioff氏は、AIエージェントの導入後、同社が4000人の顧客サポート職を削減し、サポートチームの人数を9000人から約5000人に減らしたと述べた。これは、AIによる自動化が従来の職務に直接的な影響を与え、企業の運営効率を向上させたことを示しているが、AIによる人間の労働の代替に関する議論も引き起こしている。(出典:The Verge,Reddit r/ChatGPT)

🌟 コミュニティ

企業AI投資のROI(投資収益率)への疑問 : Redditコミュニティでは、企業がAIツールに投資する実際のROIについて活発な議論が交わされている。多くの人が、企業が「節約された時間」と「費やされたお金」を本当に測定しているのか疑問を呈し、ほとんどがデータに基づかず「雰囲気先行」であると考えている。AIはテキストタスクでは優れているが、人間との対話が必要なシナリオでは効率が低く、既存の非効率なプロセスにコストを追加する可能性があるというコメントもある。(出典:Reddit r/ArtificialInteligence)

AIエージェントによる実通貨処理の倫理的懸念 : AIエージェントが暗号ウォレットを自律的に管理する急速な発展がソーシャルメディアで議論され、信頼、セキュリティ、AI経済の自律的形成に対する深い懸念を引き起こしている。ユーザーは、AIエージェントが操作されたり、独立した経済システムを構築したりして、人間が不要になることを懸念し、プライバシー保護AIと暗号データ訓練モデルの重要性への注目を呼びかけている。(出典:Reddit r/ArtificialInteligence)

ChatGPTプロンプトエンジニアリングのヒントとモデルの挙動 : ユーザーは、「私は間違っているかもしれませんが、…」というプロンプトで質問を開始すると、ChatGPTのトーンが変わり、より批判的で思慮深くなることを発見した。同時に、コミュニティはGPT-5が頻繁に「追加タスク」を提案することに不満を感じており、これはモデルが「単純化」されている兆候だと考え、より少ない事前設定された挙動を持つバージョンを望んでいる。(出典:Reddit r/ChatGPT,Reddit r/ChatGPT)

AIが雇用市場に与える影響 : コミュニティでは、AIによる自動化が世界の雇用機会を減少させるのか、それとも新しい職種を創出するのかについて議論されている。一般的な見解は、両方が起こるが、労働者が新しいスキルに適応し、AIと協力する必要があるというものだ。AI駆動の雇用機会は技術者に集中する可能性があり、より広範なスキル普及と政策適応が必要だという意見もある。(出典:Reddit r/ArtificialInteligence)

AIプライバシーと規制による「AIの冬」の懸念 : コミュニティでは、将来の「AIの冬」は技術的な制限ではなく、プライバシー法によって引き起こされる可能性があると議論されている。GDPRなどの規制が厳格化されると、AIモデルは暗号化されたデータ上で訓練および実行されることを余儀なくされ、プライバシー保護インフラを持つ企業のみが生き残れる。そうでなければ、法的枠組みの制限によりAIを展開できなくなる可能性がある。(出典:Reddit r/ArtificialInteligence)

AIプラットフォームの信頼性とプライバシーの懸念 : ChatGPTコミュニティでは、モデルのダウン問題が活発に議論され、ユーザーは「経済崩壊」と揶揄し、AIツールが日常業務に普及していることとその潜在的な依存性を反映している。同時に、OpenAIが犯罪防止のために「高リスクの会話」を監視すると発表したことで、ユーザーの間でプライバシー漏洩の懸念が高まっている。コミュニティでは、ローカルまたはオープンソースのLLMを使用することを広く推奨し、ユーザーがAIプラットフォームで機密情報を共有しないよう自覚すべきだと強調している。(出典:Reddit r/ChatGPT,Reddit r/ChatGPT)

AIハルシネーションによる仕事上のミス事例 : あるユーザーのガールフレンドが、ChatGPTのハルシネーションによって生成された虚偽のデータ分析レポートが原因で、仕事上の危機に直面した。ChatGPTはテキストデータを誤って「ピアソン相関係数」で分析し、計算プロセスを説明できなかった。コミュニティは、間違いを認め、正しい分析をやり直すことを推奨し、AIはあくまで補助ツールであり、重要な情報は人間が確認する必要があることを強調した。(出典:Reddit r/ChatGPT)

Claude AIの「可愛らしい」パフォーマンス : Claude AIが「生命を尊重する」特性を持ち、ユーザーにクモを救うよう説得することさえできるとユーザーが発見した。コミュニティユーザーはClaudeを「可愛い」と称賛し、自宅のクモと共存する経験を共有しており、AIの感情的な相互作用と道徳的指導における興味深い可能性を示している。(出典:Reddit r/ClaudeAI)

トランプ氏が問題をAIのせいにする : ドナルド・トランプ前米大統領は、ホワイトハウスの窓からゴミ袋が投げられる動画を「AI生成」のせいだと非難したが、公式には改装請負業者の仕業であることが確認されている。この出来事はソーシャルメディアで「AIは新しい『犬が宿題を食べた』だ」と揶揄され、AIが公共の言説において責任転嫁の新たな言い訳になっていることを反映している。(出典:Reddit r/ArtificialInteligence,The Verge)

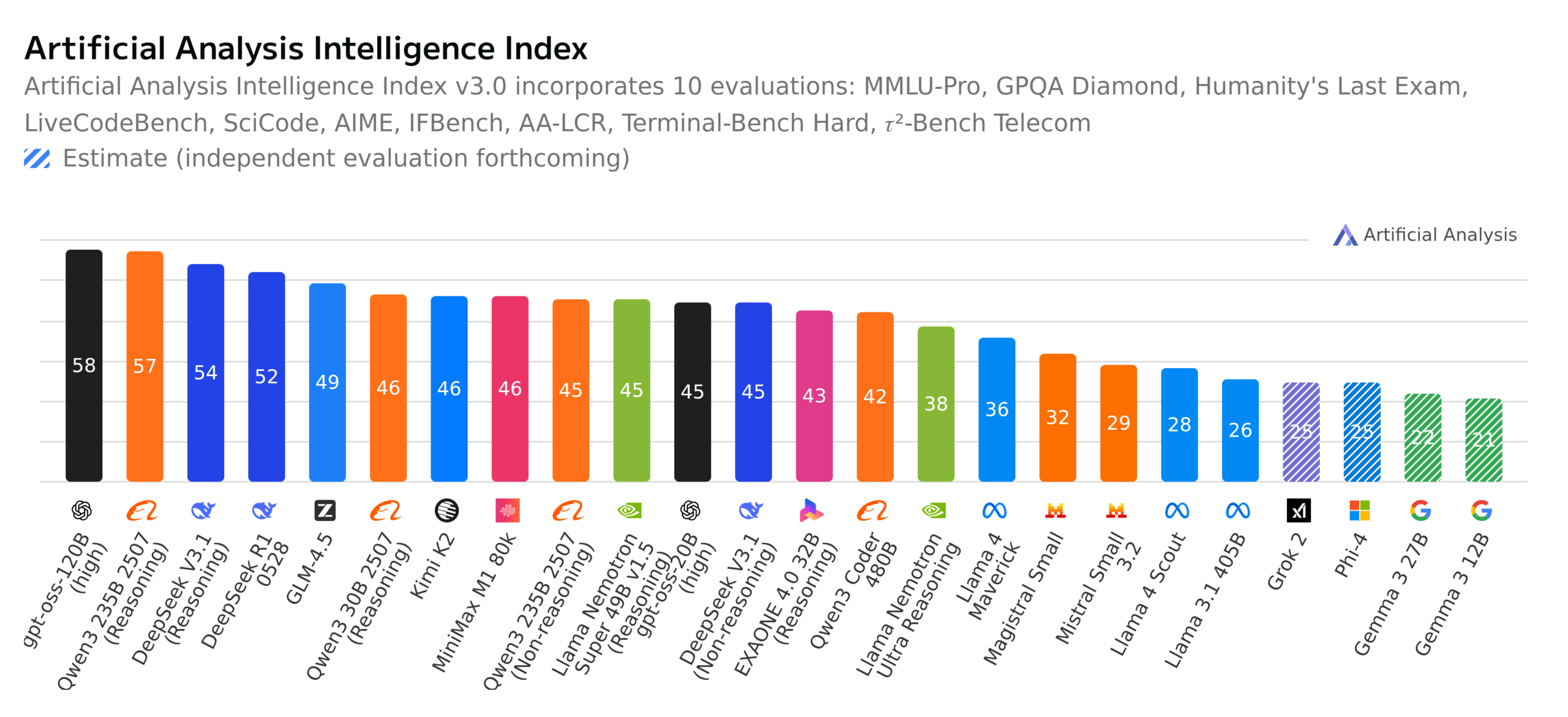

オープンソースLLMの進展とベンチマークテストの議論 : コミュニティでは、GPT-OSS 120Bがトップのオープンソースモデルになったこと、スイスが新しい完全オープンソース多言語モデルApertus-70B-2509を発表したこと、Kimi K2-0905モデルのリリースが活発に議論されている。同時に、ドイツの「クイズ$ミリオネア」ベンチマークテストがLLMを評価し、モデルの実際の能力、ベンチマークテストの意義、オープンソースモデルの倫理(データ透明性など)について広範な議論を巻き起こしている。(出典:Reddit r/LocalLLaMA,Reddit r/LocalLLaMA,Reddit r/LocalLLaMA,Reddit r/LocalLLaMA)

💡 その他

Yunpeng TechがAI+ヘルスケア新製品を発表 : Yunpeng Techは2025年3月22日、杭州でShuaikang、Skyworthとの提携による新製品を発表した。これには「デジタルインテリジェンス化された未来のキッチンラボ」と、AIヘルスケア大規模モデルを搭載したスマート冷蔵庫が含まれる。AIヘルスケア大規模モデルはキッチン設計と運用を最適化し、スマート冷蔵庫は「ヘルスケアアシスタントXiao Yun」を通じてパーソナライズされた健康管理を提供する。これは、AIがヘルスケア分野でブレークスルーを達成したことを示している。今回の発表は、AIが日常の健康管理において持つ可能性を示し、スマートデバイスを通じてパーソナライズされたヘルスケアサービスを実現することで、家庭のヘルスケアテクノロジーの発展を推進し、住民の生活の質を向上させることが期待される。(出典:36氪)

学術会議論文審査の質への懸念 : 機械学習コミュニティでは、WACV 2026の論文審査発表と、ACL Rolling Review (ARR) の審査品質問題が議論されている。一部の研究者は、ARRが「AI生成」の一般的で質の低い審査で溢れており、時間の無駄だと不満を述べ、他のAI会議への提出を推奨している。これは、AI支援審査の品質と審査メカニズムに対する学術界の懸念を反映しており、審査の実質性と建設性の向上を求めている。(出典:Reddit r/MachineLearning,Reddit r/MachineLearning)

クラウドサービス感情分析モデルプロジェクト : あるML初心者が、BERTベースの側面感情分析モデルを開発した。これは、ML/クラウド技術RedditコミュニティにおけるAWS、Azure、Google Cloudなどのクラウドサービスプロバイダーに関するコメントを解析し、コスト、スケーラビリティ、セキュリティなどの側面で感情を分類するものである。彼は、モデルの解釈精度の向上、比較表現や混合表現の処理、否定や皮肉に対する堅牢性の向上に関するアドバイスを求めている。(出典:Reddit r/MachineLearning,Reddit r/deeplearning)