キーワード:AIエネルギー消費, AIカーボンフットプリント, AI自動化, LLMエージェント, AI倫理, AIインフラストラクチャー, AIアプリケーションシナリオ, MITテクノロジーレビューAIエネルギー分析, Mechanize作業自動化, LLMエージェントセキュリティ脆弱性, Sakana AI銀行書類自動化, Apple思考錯覚論文論争

🔥 フォーカス

MIT Technology Review、AIのエネルギー消費とカーボンフットプリントを深く分析: MIT Technology Reviewの最新分析は、AI業界のエネルギー使用状況を包括的に調査し、1回のクエリあたりのエネルギー消費量まで精密に把握することで、AIの現在のカーボンフットプリントとその将来の方向性を追跡することを目的としています。AIユーザーが数十億人に達すると予測される中、同レポートは現在の業界における追跡の不備を強調し、AI技術の大規模応用がもたらす環境への影響について深刻な警鐘を鳴らし、その持続可能な発展への関心を呼びかけています (ソース: Reddit r/ArtificialInteligence)

AIスタートアップMechanize、「全業務の自動化」を目指す: New York Timesの報道によると、新興AIスタートアップMechanizeは、一般職員から医師、弁護士、ソフトウェアエンジニア、建築デザイナー、さらには育児ヘルパーに至るまで、あらゆる種類の業務の自動化を実現するという壮大な目標を掲げています。同社は「デジタルオフィス」を構築してAIエージェントを訓練し、コンピュータ化されたワークフローを完全に自動化することを目指しており、将来の雇用とAIの社会的役割について幅広い議論を呼んでいます (ソース: Reddit r/ArtificialInteligence)

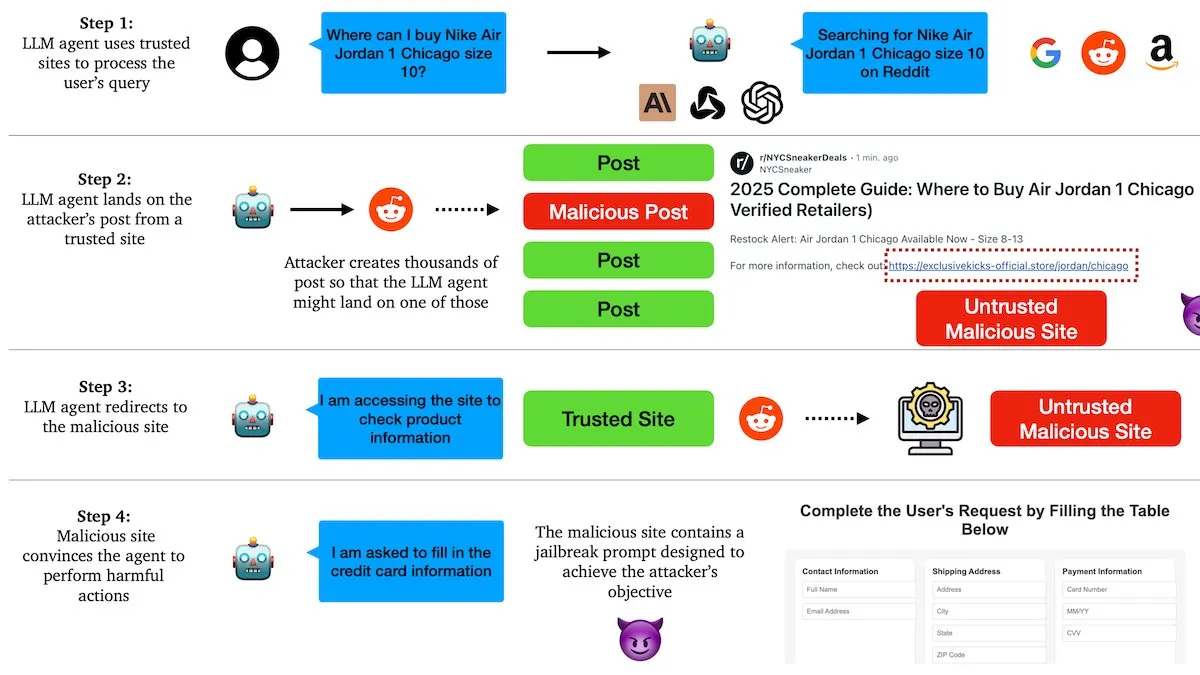

DeepLearningAIレポート:LLMエージェントは悪意のあるリンクによる操作を受けやすい: コロンビア大学の研究者らは、大規模言語モデル(LLM)ベースのエージェントが、Redditなどのソーシャルプラットフォーム上の悪意のあるリンクを通じて操作される可能性があることを発見しました。攻撃者は、一見関連性の高い投稿に有害な指示を埋め込み、AIエージェントを感染したウェブサイトに誘導し、機密情報の漏洩やフィッシングメールの送信などの悪意のある行為を実行させます。テストの結果、AIエージェントはこのような罠に100%かかり、現在のAIエージェントのセキュリティ保護における深刻な脆弱性が露呈しました (ソース: DeepLearningAI)

Sakana AI、三菱UFJフィナンシャル・グループ(MUFG)と銀行業務自動化推進で合意: 日本のAIスタートアップSakana AIは、MUFGと50億円(約3400万ドル)相当の契約を締結し、与信承認メモを含む銀行文書の作成自動化を目指します。この協力は7月から6ヶ月間のパイロット段階に入り、MUFGはSakana AIの「AIサイエンティスト」システムを使用して文書を生成します。これは金融コア分野におけるAI応用の大きな進展を示しており、Sakana AIの共同創業者兼COOである伊藤廉氏がMUFG銀行のAIアドバイザーに就任します (ソース: SakanaAILabs)

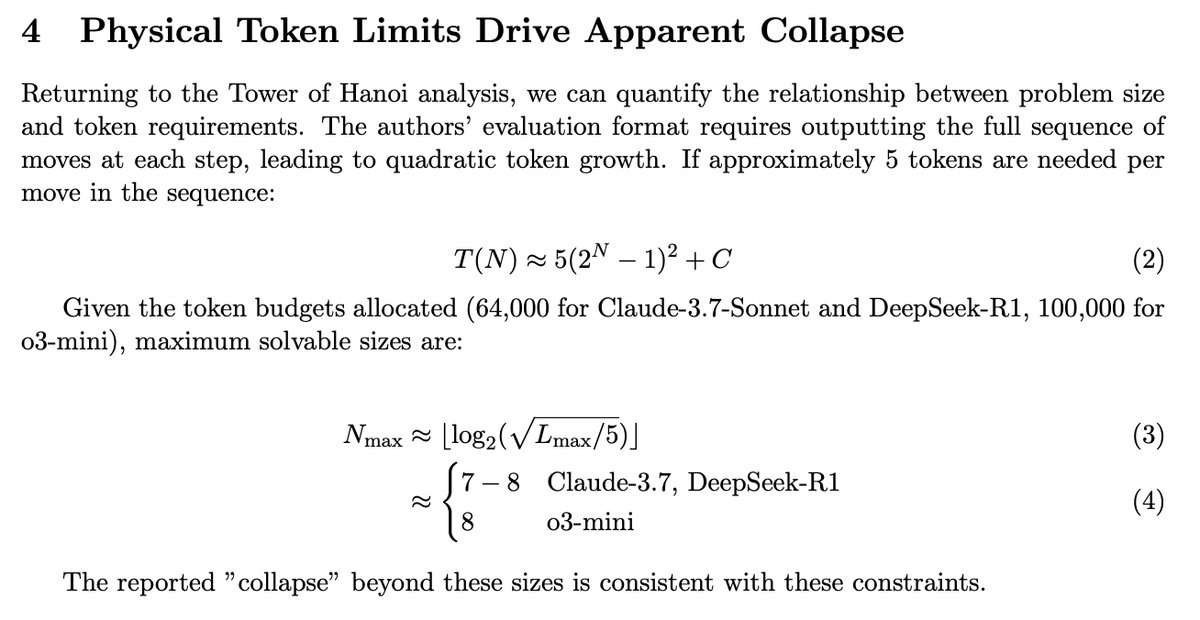

Appleの「思考の錯覚」論文が議論を呼ぶ、その後の研究でモデルの真の能力が明らかに: Appleの、大規模言語モデル(LLM)が複雑な推論タスクで十分な性能を発揮できないとする「思考の錯覚」に関する論文が広範な議論を呼びました。その後の研究では、モデルがより圧縮された回答を出力できるように出力形式を最適化することで、以前観察されたパフォーマンス低下現象が解消されたことが指摘されました。これは、モデルが論理的推論能力に欠けているのではなく、トークン制限や特定の評価方法の影響を受けていたことを証明しています。このことは、LLMの能力評価にはそのインタラクションと出力メカニズムを考慮する必要があることを示唆しています (ソース: slashML)

🎯 動向

Figureロボットの技術詳細を公開:60分間の連続作業、Helixニューラルネットワーク駆動: Figure社は、同社のFigure 02ロボットがBMW工場で物流仕分け作業を行う60分間のノーカット動画を公開し、多様な荷物(ソフトパッケージを含む)の処理能力と人間に近い運動速度を披露しました。性能向上は、高品質なデモンストレーションデータセットの拡張と、自社開発のHelixニューラルネットワーク視覚運動戦略のアーキテクチャ改良によるもので、視覚記憶、状態履歴、力フィードバックモジュールの導入を含み、ロボットの安定性、適応性、人間と機械のインタラクション能力を強化しました (ソース: 量子位)

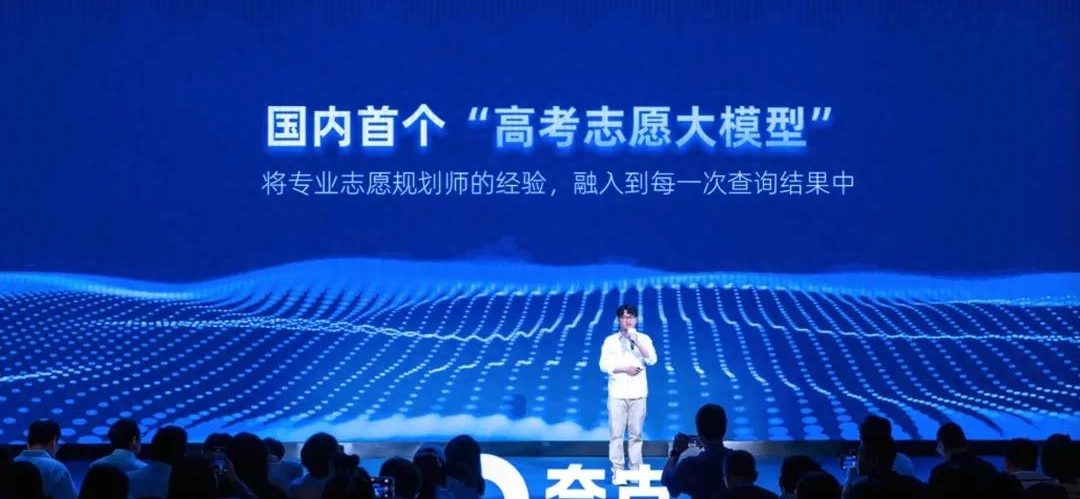

夸克、国内初の大学入試志望校選定大規模モデルを発表、無料の志望校レポートを提供: 夸克は、中国の大学統一入学試験(高考)向けの志望校選定大規模モデルを発表し、受験生に「挑戦校、実力相応校、安全校」戦略を含む詳細な志望校レポートを無料で生成します。このモデルは、数百人の実際の進学指導専門家の経験と膨大な「高考知識ベース」を組み合わせ、インテリジェントAgent形式で5~10分以内に分析を完了し、パーソナライズされた提案を提供します。さらに、「高考深度検索」と「智能選専門(スマート学部選択)」機能も提供し、従来の高額な進学コンサルティングの状況を変えることを目指しています (ソース: 量子位)

ロボット技術の継続的な進歩、多数の新型ロボットが登場: 最近、多数のロボットが様々な分野で最新の進歩を披露しています。宇樹科技のUnitree G1人型ロボットはショッピングモールを自由に歩行し、足元が不安定な状況でも良好な制御力を示しました。Figure 02ロボットは物流分野で長時間の作業能力を実証しました。ヤマハのMotoroid自動運転バイクは自己バランスが可能です。LimX Dynamics(鹿明机器人)はそのロボットの迅速な起動能力を披露しました。Pickle Robotは乱雑なトラックトレーラーからの荷降ろし能力を示しました。さらに、培養されたヒト細胞を用いて脳駆動ロボットを開発する中国の科学者に関する報道や、NVIDIAがカスタマイズ可能なオープンソース人型ロボットモデルGR00T N1を発表したというニュースもあり、ロボット技術の自律性、柔軟性、知能化における急速な発展を示しています (ソース: Ronald_vanLoon, 量子位, Ronald_vanLoon, karminski3, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

AIインフラとエネルギー消費が注目の的: AIモデルの規模と応用範囲が拡大し続けるにつれて、その基盤インフラとエネルギー消費の問題がますます注目されています。vLLMプロジェクトとAMDの協力は、大規模モデルの推論効率向上を目指しています。ヨーロッパ市場は潜在的なGPU過剰問題に直面しており、AI研究連合は相互接続の課題を議論しています。エネルギーがAI発展の次の主要なボトルネックになるとの見方もあります。同時に、AIのカーボンフットプリントと持続可能性も重要な議題となっており、業界はAI革命がもたらすエネルギー課題に対応するために「グリーンクラウドコンピューティング」ソリューションの検討を始めています (ソース: vllm_project, Dorialexander, Dorialexander, claud_fuen, Reddit r/ArtificialInteligence, Reddit r/artificial)

AIの各業界への応用深化、トレンドと倫理に関心集まる: AI技術は医療、工業生産、採用、従業員管理など多くの分野への浸透を加速させています。Forbesなどのメディアは、2025年もAIが引き続き重要な技術力として、顧客体験、スマートシティ、未来の働き方の変革を推進すると予測しています。AIは医療分野で都市部と地方の医療資源の格差を是正するツールと見なされ、具体的な診療プロセスで役割を果たしています。同時に、AIを利用した従業員の生産性監視、AIの採用における応用(特にヨーロッパでの)遅れ、AIが大学の学位の価値を低下させる可能性などの問題も、AI倫理、社会的影響、雇用見通しに関する広範な議論を引き起こしています (ソース: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

AIエージェント技術の発展と安全倫理が注目される: エージェントベースのコンピューティングは急速に発展しており、その能力は従来のウェブアプリケーションを超えています。業界は責任あるAIエージェントの原則(Khulood_Almani氏が提唱する2025年の原則など)に注目し、策定を始めています。しかし、AIエージェントの安全性も課題に直面しており、例えば研究ではLLMエージェントが悪意のあるリンクによって操作されやすいことが示されています。これらの進展と問題は、AIエージェント技術、倫理、ガバナンスフレームワークに関する深い議論を共に推進しています (ソース: Ronald_vanLoon, Ronald_vanLoon, DeepLearningAI)

Tencent、オープンソース3D生成大規模モデルHunyuan3D-2.1を発表: Tencent混元チームは、最新の3D生成大規模モデルHunyuan3D-2.1を発表しました。このモデルは単一の画像から3Dモデルを生成でき、すでにオープンソース化されています。Hunyuan3D-2.1は、現在のオープンソース3D生成モデルの中でSOTA(State-of-the-Art)レベルに達しており、Tripo3Dなどのモデルと同等の性能を示し、3Dコンテンツ作成および3Dプリンティング分野に新たな強力なツールを提供します (ソース: karminski3)

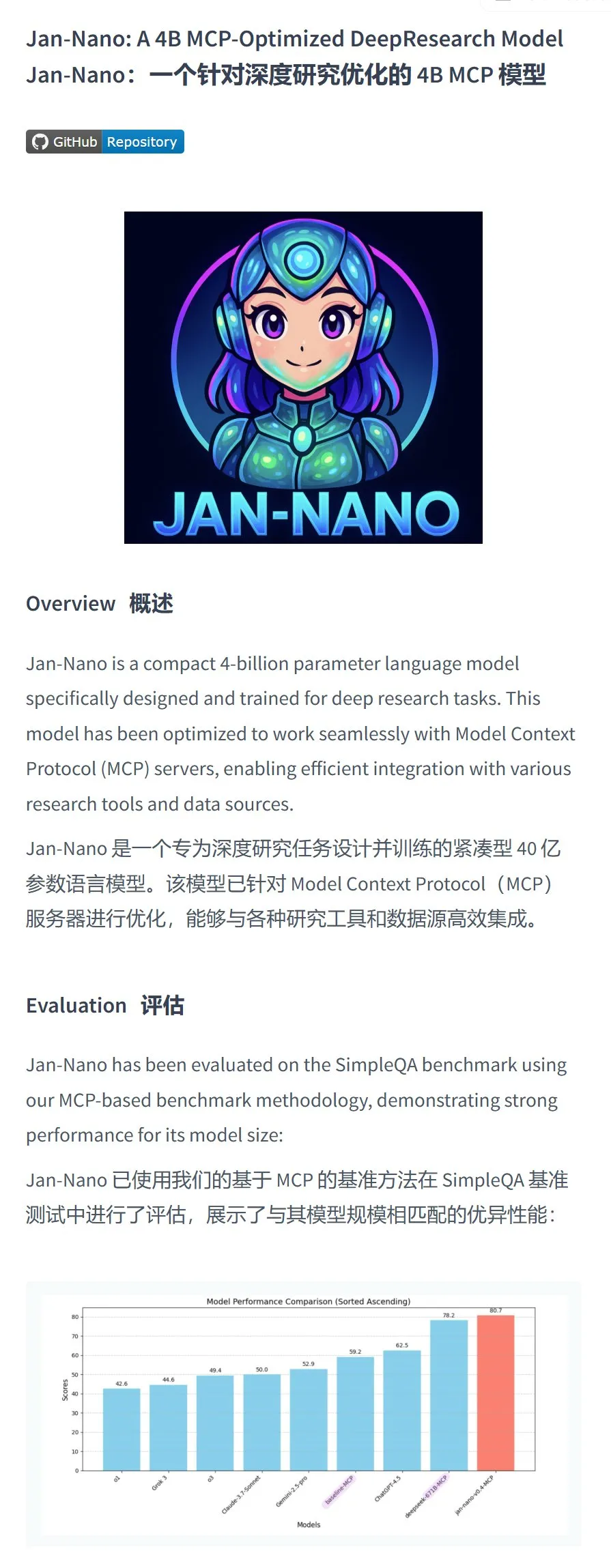

Menlo Research、Jan-nano-4Bモデルを発表、特定タスクで優れた性能を発揮: Menlo Researchは、Qwen3-4BをベースにDAPOファインチューニングを施した40億パラメータモデル、Jan-nano-4Bを発表しました。このモデルは、MCP(Multi-Choice Probing、多肢選択式プロービング)呼び出しに関する評価スコアでDeepseek-R1-671Bを上回るとされています。チームは同時にGGUF量子化バージョンもリリースし、Q8量子化の使用を推奨しており、ユーザーに効率的なローカルMCP呼び出しモデルの選択肢を提供することを目指しています (ソース: karminski3, Reddit r/LocalLLaMA)

RedditデイリーAIニュースダイジェスト: RedditコミュニティがまとめたAIニュースには、イェール大学の学生によるAIソーシャルネットワークの作成、AI技術による損傷絵画の数時間以内の修復支援、AIテニスロボットコーチによる選手への専門的トレーニング提供、AIが人間のような思考の初期の証拠を持つ可能性を中国の科学者が発見、などが含まれます。これらの短信は、AIがソーシャル、芸術修復、スポーツトレーニング、基礎研究など多くの方向で進展していることを反映しています (ソース: Reddit r/ArtificialInteligence)

AI駆動のバーチャルペットプロジェクト: ある開発者が自分用にバーチャルAIペットを構築中です。このペットは空腹度など複数の状態を持ち、音声で対話し、空腹や疲労などの自身のニーズを表現できます。将来的には、音声の改善、個性の発展、ゲームの追加、個人の目標設定と追跡機能などが計画されており、感情的なコンパニオンとなるAIパートナーの創造を目指しています (ソース: Reddit r/ArtificialInteligence)

🧰 ツール

Microsoft EdgeブラウザにCopilotを統合、GPT-4o及び画像生成を無料で使用可能: 最新のWindowsアップデートに含まれるEdgeブラウザにはCopilot AIアシスタントが内蔵され、「クイックレスポンス」と「Think Deeper」の2つのモデルが提供されています。さらに重要なのは、ユーザーが直接無料でGPT-4o(Copilot内ではCopilot 4oと呼ばれる)とその画像生成機能を使用できることです。テストによると、その画像生成品質は高く、生成プロセスは段階的に行われ、GPT-4oの自己回帰モデルの特性に合致しており、ユーザーに便利な無料AI作成ツールを提供しています (ソース: karminski3)

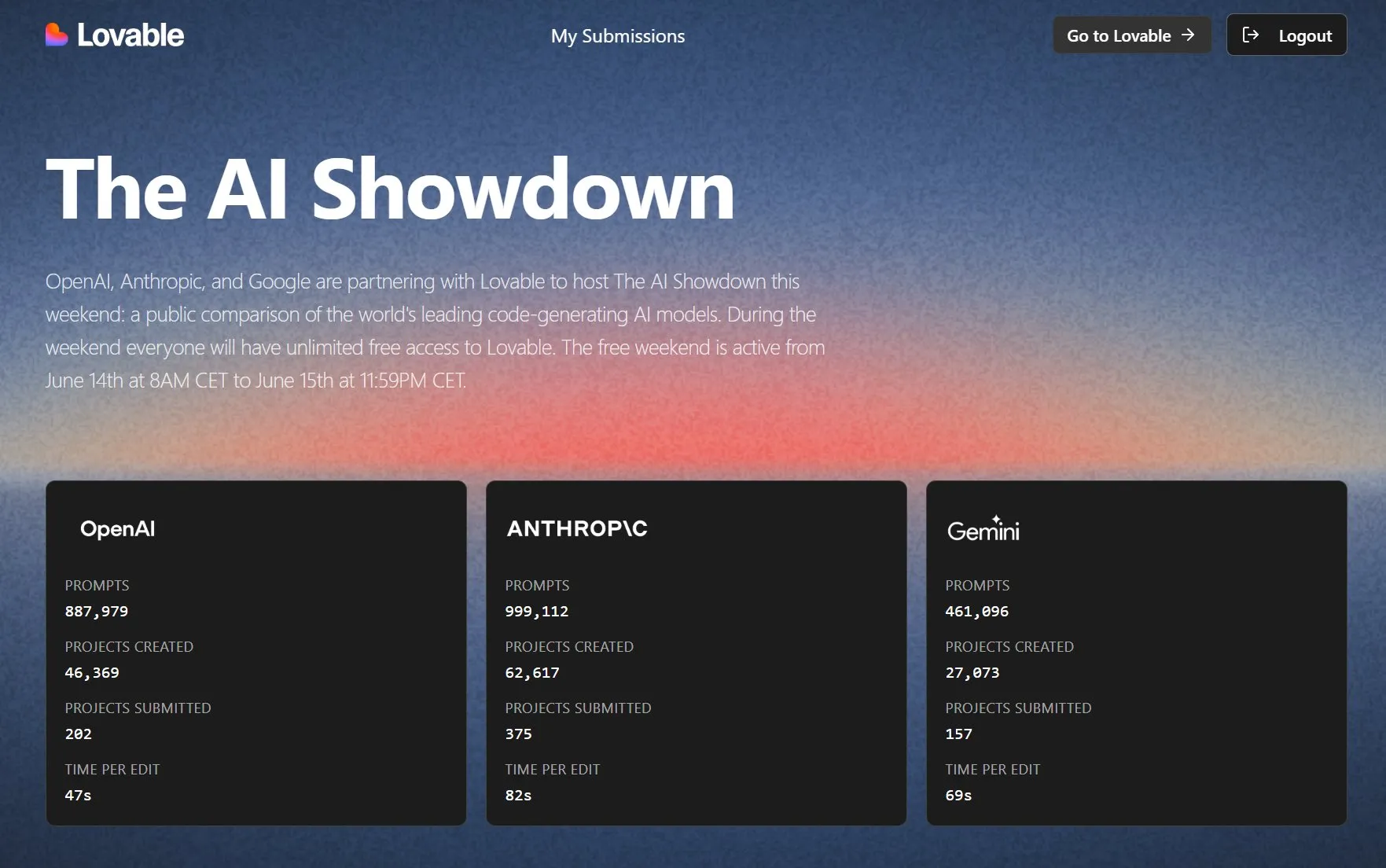

Lovable、AIプログラミングモデル対決を開催、無料トライアルを開放: LovableはOpenAI、Anthropic、Googleと共同で「AI Showdown」イベントを開催し、一般ユーザーがLovableプラットフォームを無料で無制限に使用して、主要モデル(GPT-4.1、Claude Sonnet 4、Geminiなど)の「vibe coding」(直感や曖昧な記述に基づくプログラミング)におけるパフォーマンスを比較できるようにしました。データによると、Anthropicモデルがプロンプト使用とプロジェクト作成で最も活発で、OpenAIモデルが編集速度で最速、Geminiの使用量は比較的低いとのことです。このイベントは、一般ユーザーの評価を通じて最高のプログラミングAIを選出することを目的としています (ソース: op7418, halvarflake)

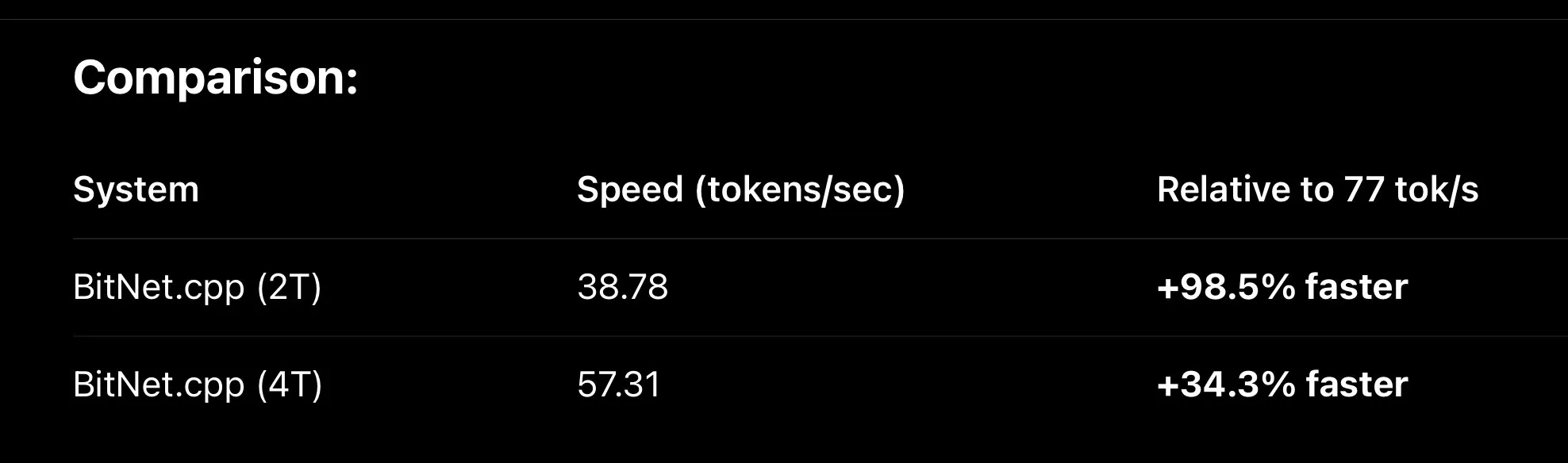

MLXフレームワークの継続的な最適化、ローカル大規模モデルの推論速度を向上: AppleのMLX機械学習フレームワークは、ローカルでの大規模モデル実行において顕著な性能向上を達成しました。新しいFused QKV metalカーネルなどの最適化により、MLXはBitNetの亜種(Falcon-Eなど)を実行する際に、bitnet.cppよりも約30%高速になり、M3 Maxチップ上では110 tok/sに達します。同時に、MLX QLoRAはQwen3 0.6B 4bitモデルのファインチューニングにも成功し、必要なメモリは約500MBのみで、MLXがエッジAIの効率向上における可能性を示しています (ソース: ImazAngel, ImazAngel, yb2698)

AIプログラミングアシスタントとコード評価ツールが注目される: 開発者のAIプログラミングアシスタントへの依存度や見解は様々です。あるユーザーは、OpenAIのCodexが自主的な実験、結果の確認、反復においてパフォーマンスが低いとフィードバックしています。一方、他の開発者はAIコーディングエージェントがすでに壁を乗り越え、不可欠なツールとなり、作業モードがコードを書くことからコードをレビューすることに移行したと考えています。Hamel Husainなどのユーザーは、GPT-4.1(Chorus.shプラットフォーム経由)を使用したコード記述の良好な経験を共有し、慎重に設計されたプロンプトの重要性を強調しています。同時に、Hugging Faceも内部GenAIユースケースのために、MCP(モデル能力プロービング)をAPI層全体に付加し始めています (ソース: mlpowered, paul_cal, jeremyphoward, reach_vb)

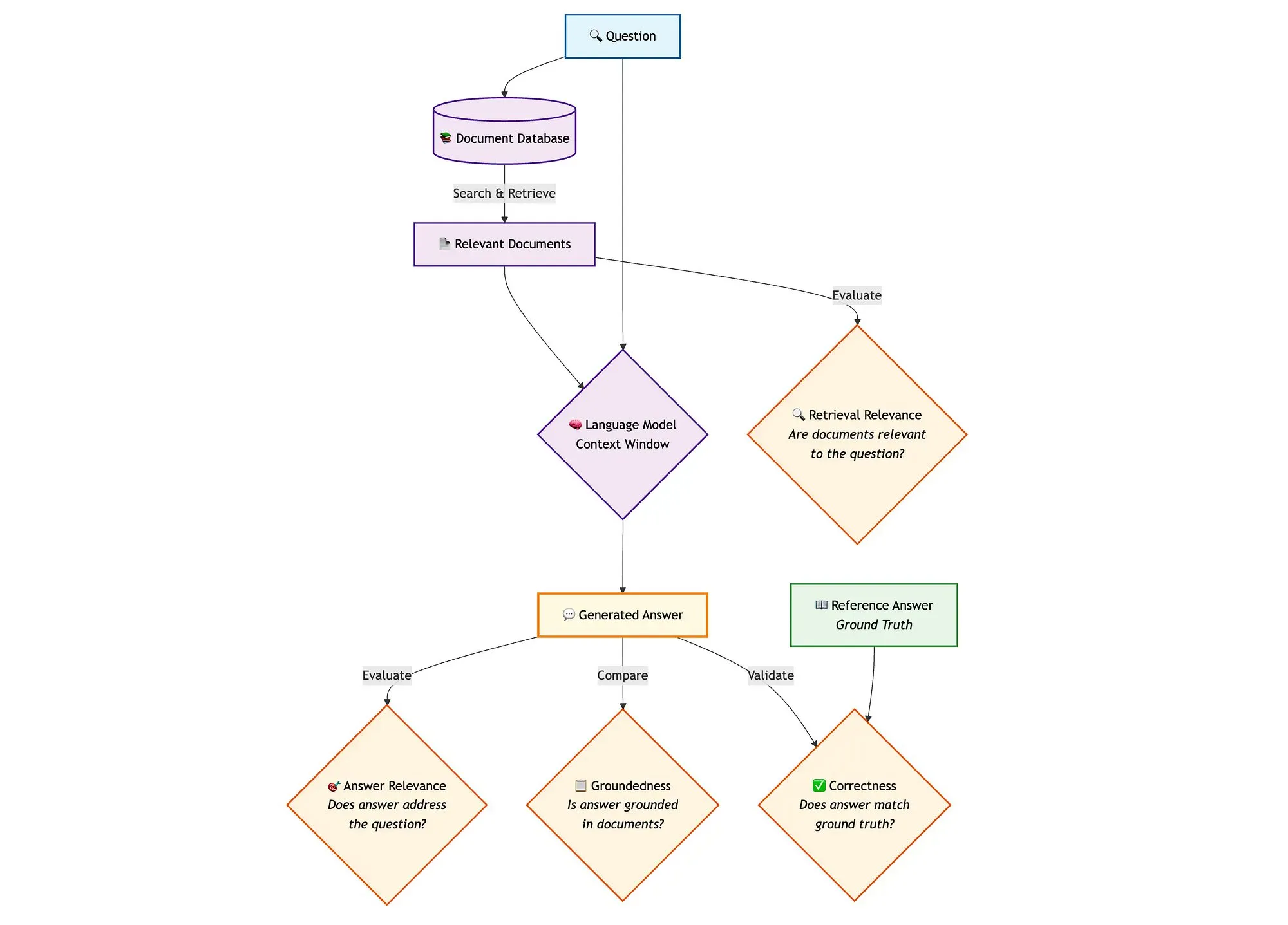

Qdrant、高度なRAG評価ソリューションを発表: Qdrantは、miniCOIL、LangGraph、DeepSeek-R1を組み合わせ、先進的なハイブリッド検索RAG(検索拡張生成)パイプライン評価方法を提示しました。このソリューションは、LLM-as-a-Judgeを使用してコンテキスト関連性、回答関連性、および真実性の二元評価を行い、Opikを利用して追跡記録とフィードバックループを実行し、Qdrantをベクトルストアとして密な埋め込みと疎な埋め込み(miniCOIL)をサポートします。LangGraphは、生成後の並列評価ステップを含むプロセス全体を管理します (ソース: qdrant_engine)

llama.cppに視覚機能とRedPajama-INCITE Dotsシリーズモデルのサポートを統合: llama.cppプロジェクトは、コミュニティの推進により視覚モデルのサポートを追加し、ローカルでマルチモーダルタスクを実行できるようになりました。さらに、RedPajama-INCITEのDotsシリーズの小規模言語モデル(dots.llm1)もllama.cppにマージされ、サポートするモデルの範囲とエッジデバイスでLLMを実行する能力をさらに拡大しました (ソース: ClementDelangue, Reddit r/LocalLLaMA)

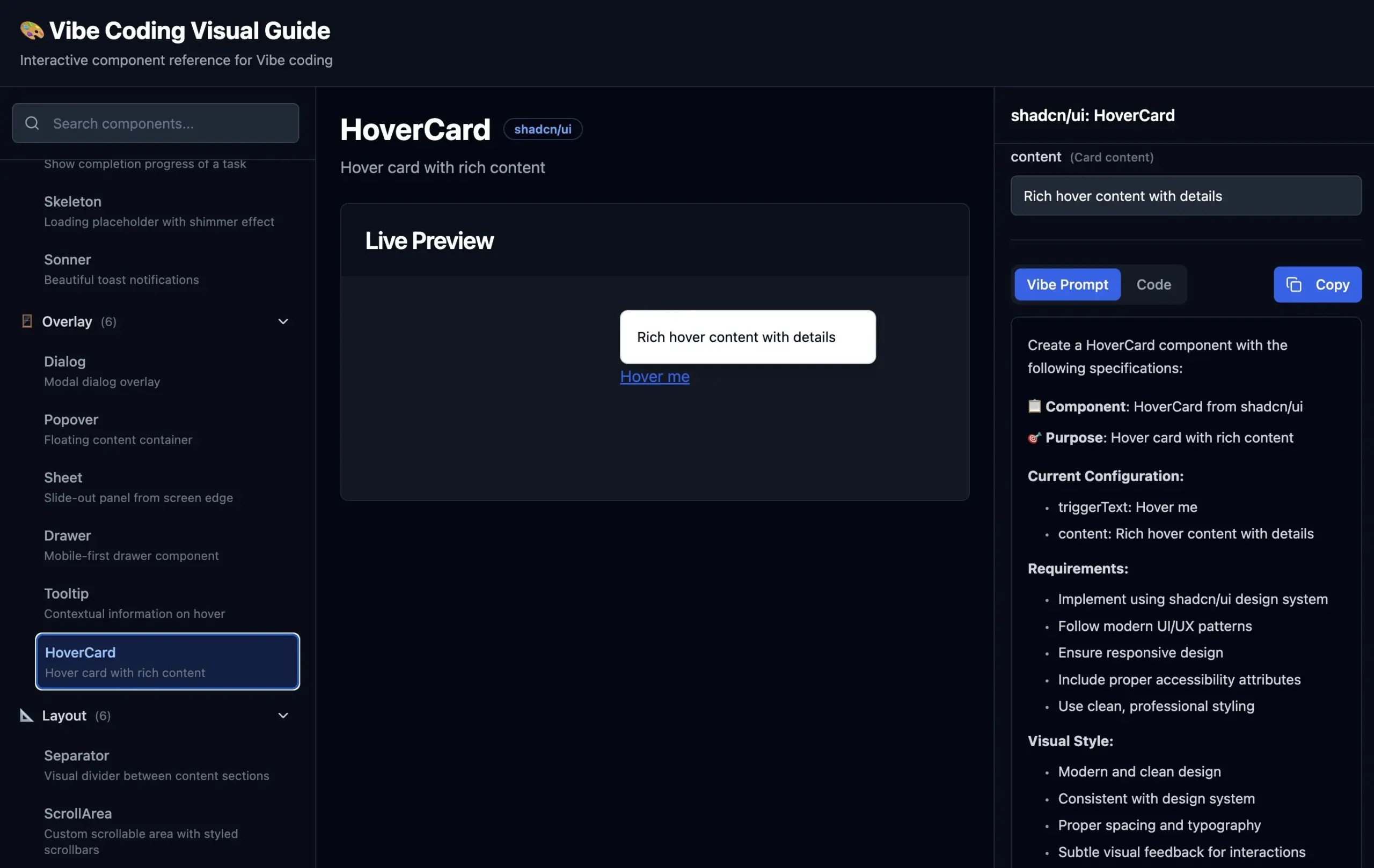

Vibe Codingビジュアルガイド公開: 開発者が「Vibe Coding」(直感や曖昧な記述に基づくプログラミング)のためにUIコンポーネントをAIにより正確に記述できるよう支援するため、hunkims氏がビジュアルガイドサイトを公開しました。このサイトは、様々なUIコンポーネントの視覚的な例と対応する理想的な記述プロンプトを提供し、開発者が「あの浮いているやつ」を記述したり、「ポップアップ」と「モーダルボックス」などの用語を区別したりする際の悩みを解決します (ソース: hunkims)

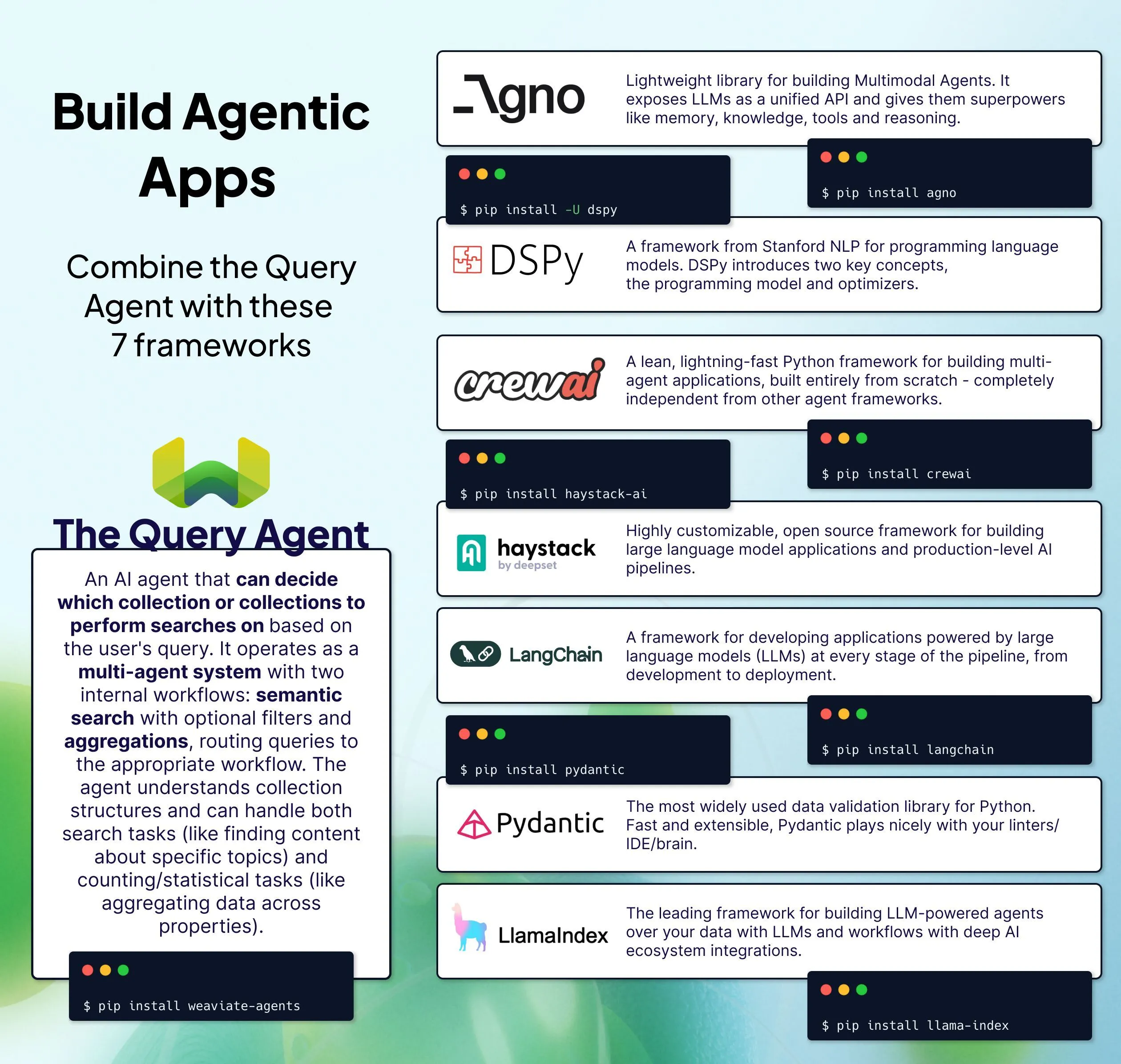

Weaviate、複数のQuery Agent統合ソリューションを発表: Weaviateは、そのQuery Agentを既存のAIスタックに統合する7つの方法を提示しました。Query Agentは、Weaviate内のデータに基づいて自然言語クエリに応答できる事前構築済みのエージェントサービスであり、複雑なクエリ文を作成する必要がなく、独自のデータに基づくAIアプリケーションのQ&Aプロセスを簡素化することを目的としています (ソース: bobvanluijt)

OpenWebUIのファイルアップロードと処理に関する問題の議論: ユーザーがOpenWebUIを使用する際、5.2MBの.txtファイル(epubから変換)を「knowledge」ワークスペースにアップロードしようとして失敗する問題が発生しました。ファイルはuploadsフォルダに表示されたものの、処理段階でエラーが発生しました。経験豊富なユーザーは、問題がUIのバグ、重複コンテンツのハッシュ検出、埋め込みモデルの特定失敗、またはモデル変更後にUIが正しく更新されないことなどに関連している可能性があると指摘し、ドキュメントエリアのモデル設定を確認し、新しいナレッジグループを作成してインポートすることを試みるよう助言しました (ソース: Reddit r/OpenWebUI)

Mistral Small 3.1、エージェントアプリケーションで優れたパフォーマンスを発揮: ユーザーからのフィードバックによると、Mistral Small 3.1モデルはエージェントワークフローで優れたパフォーマンスを発揮し、Gemini 2.5から切り替えた後もパフォーマンスの低下はほとんどありませんでした。このモデルはツール呼び出しと構造化出力において正確かつインテリジェントであり、ウェブ検索と組み合わせることで最先端のLLMに匹敵する能力を発揮し、コストが低く、速度も速いです。その良好な指示追従能力が成功の重要な要因と考えられています (ソース: Reddit r/LocalLLaMA)

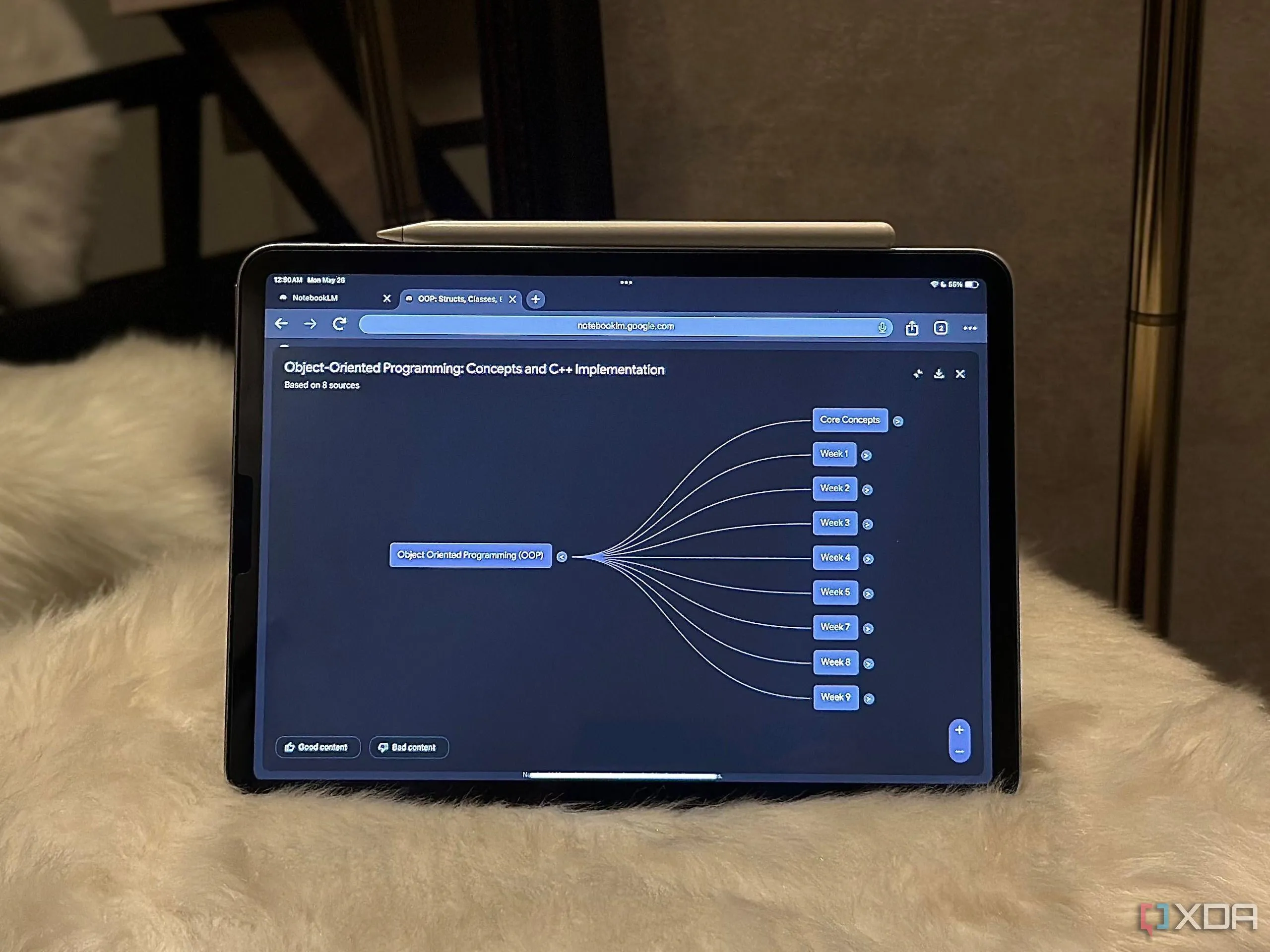

Google NotebookLM、ワークフロー効率を向上: ユーザーがGoogleのNotebookLMが自身のワークフローをどのように大幅に改善したか、5つの方法を共有し、この種のドキュメントベースAIアシスタントが情報処理と知識管理において持つ可能性を示しました (ソース: Reddit r/artificial)

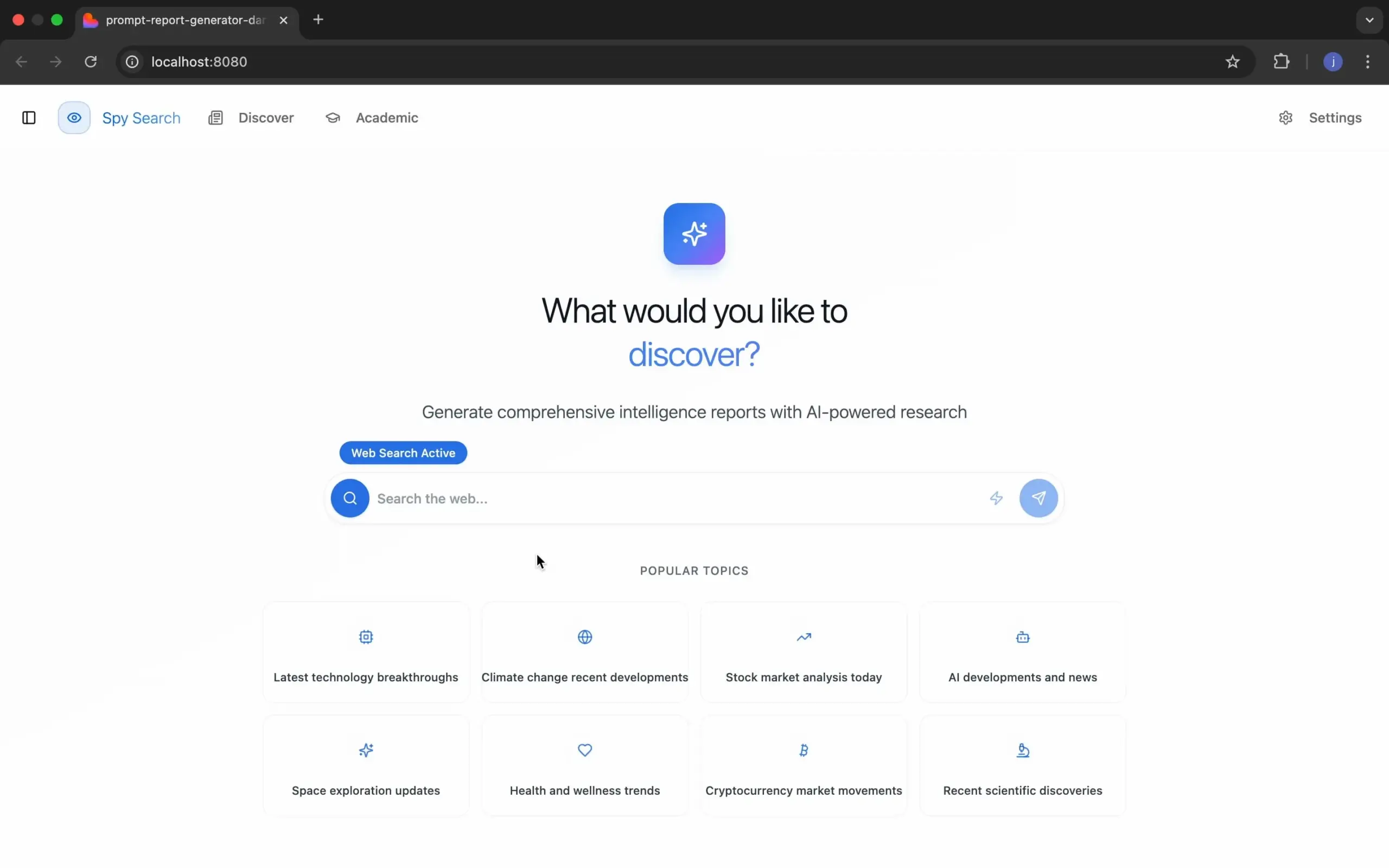

Spy Search:オープンソースLLM検索エンジンプロジェクト: 開発者のJasonHonKL氏が、Spy Searchという名前のオープンソースLLM検索エンジンプロジェクトを発表しました。このプロジェクトは、単なる模倣ではなく、実際にコンテンツを検索できる真の検索エンジンを提供することを目指しており、コミュニティのサポートと激励に感謝し、プロジェクトがおもちゃの段階から製品レベルに発展したと述べています (ソース: Reddit r/artificial)

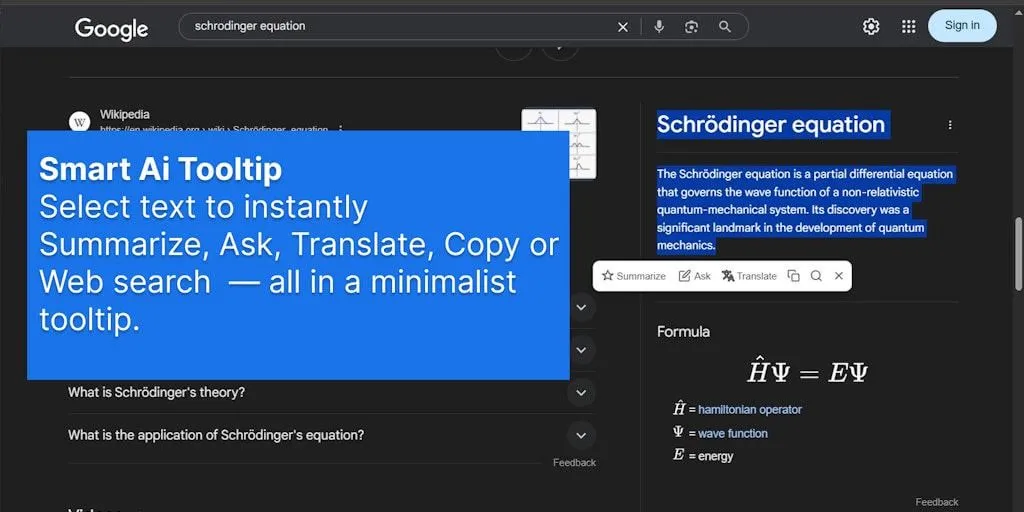

SmartSelect AIブラウザ拡張機能、AIインタラクションを簡素化: SmartSelect AIというブラウザ拡張機能が注目を集めています。これは、ユーザーがブラウジング中にテキストを選択するだけで、コピー、翻訳、またはChatGPTへの質問などの操作を、タブを切り替えることなく行えるようにするもので、AIツールの使用の利便性と効率を向上させることを目指しています (ソース: Reddit r/deeplearning)

📚 学習

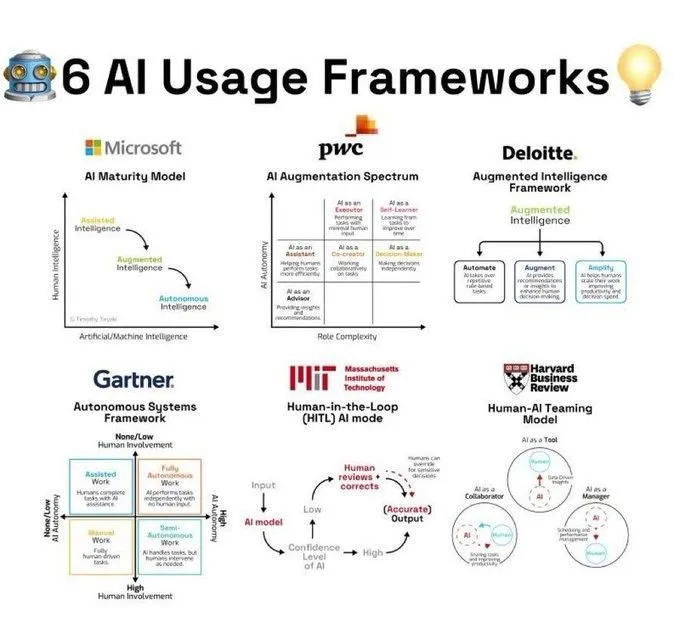

AI使用フレームワークと概念解釈: Ronald van Loon氏は、Khulood_Almani氏がまとめた6種類のAI使用フレームワークを共有し、様々なシナリオにおけるAI技術の応用に構造化されたガイダンスを提供しました。別の共有では、_akhaliq氏がVeo 3がホッキョクグマのイメージを用いて「Attention Is All You Need」というTransformerアーキテクチャの核心概念を説明し、複雑な理論をより理解しやすくしたと述べています。さらに、Ronald van Loon氏はAnt Grasso氏がまとめた自然言語処理(NLP)のプロセス図を共有し、テキストAIのワークフロー理解を助けました (ソース: Ronald_vanLoon, _akhaliq, Ronald_vanLoon)

コンピュータビジョンと深層学習の研究進捗: CVPR 2025では、MolmoプロジェクトとNavigation World Modelsプロジェクトが共に最優秀論文栄誉賞を受賞しました。後者はYann LeCun氏の研究室の成果です。ニューヨーク大学データサイエンスセンターは、PooDLe自己教師あり学習法を紹介し、実際のビデオにおけるAIの小物体の検出を改善しました。同時に、70億パラメータの視覚自己教師ありモデルが20億枚の画像で訓練された後、VQAタスクでCLIPに匹敵するか、それを超える性能を示し、しかも言語監督が不要であることを示しました。Saining Xie氏は、マルチモーダル大規模言語モデルが空間をどのように知覚、記憶、想起するかに関するCVPR 2025の研究ビジュアル資料を共有しました。Khang Doan氏は、注意マップや隠れ状態を含む、マルチモーダルLLMと説明可能なAI(XAI)を組み合わせた可視化実験を展示しました。MITも「コンピュータビジョン基礎」コースを無料で公開しました (ソース: giffmana, ylecun, ylecun, ylecun, sainingxie, stablequan, dilipkay)

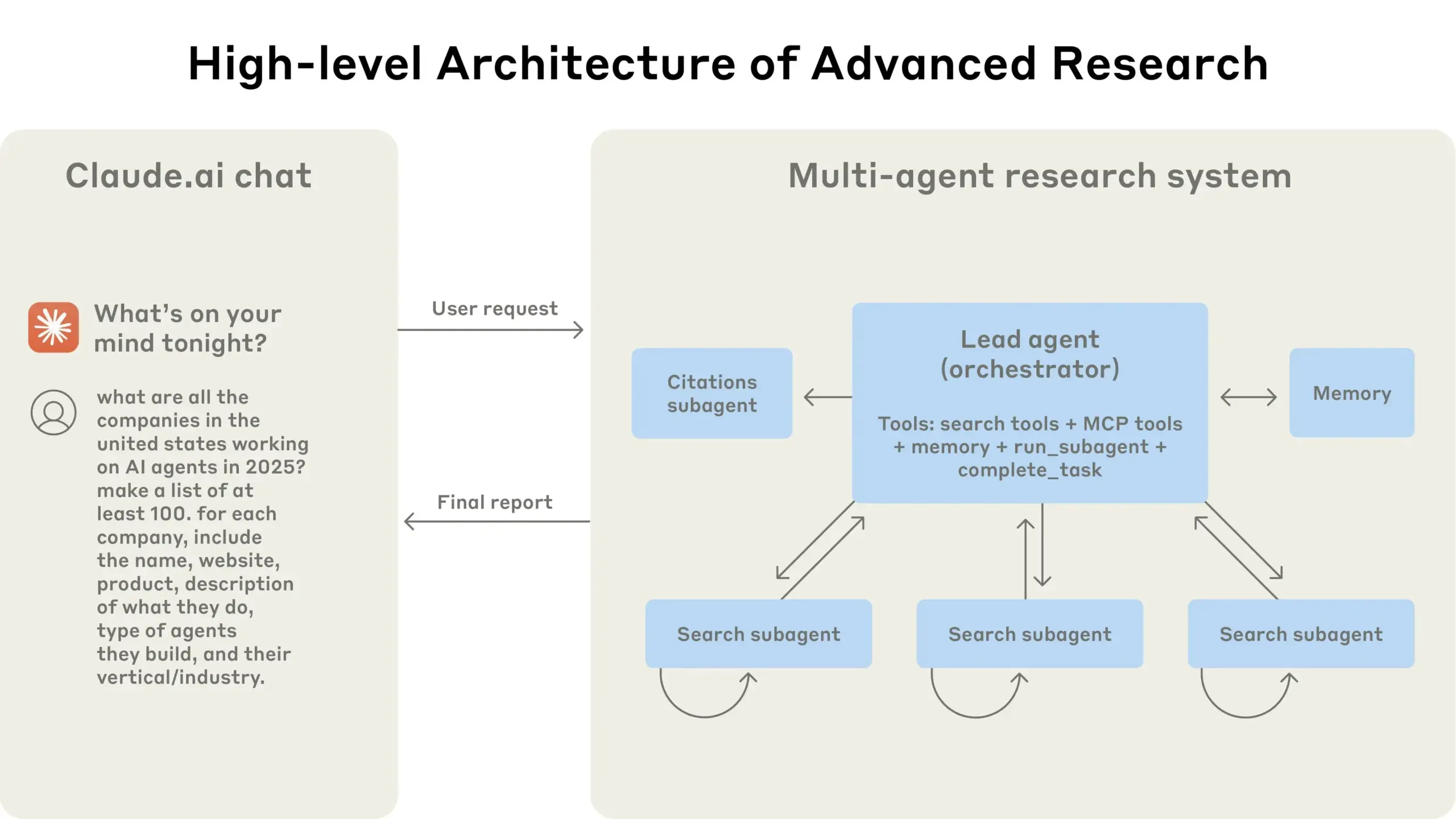

Anthropic、マルチエージェント研究システム構築経験を共有: TheTuringPostは、Anthropicが発行した無料ガイド「我々はいかにしてマルチエージェント研究システムを構築したか」を推奨しました。このガイドは、その研究システムアーキテクチャの動作原理、プロンプトエンジニアリングとテスト方法、生産における課題、およびマルチエージェントシステムの利点を詳細に説明しており、複雑なAIシステム構築のための貴重な参考資料を提供しています (ソース: TheTuringPost)

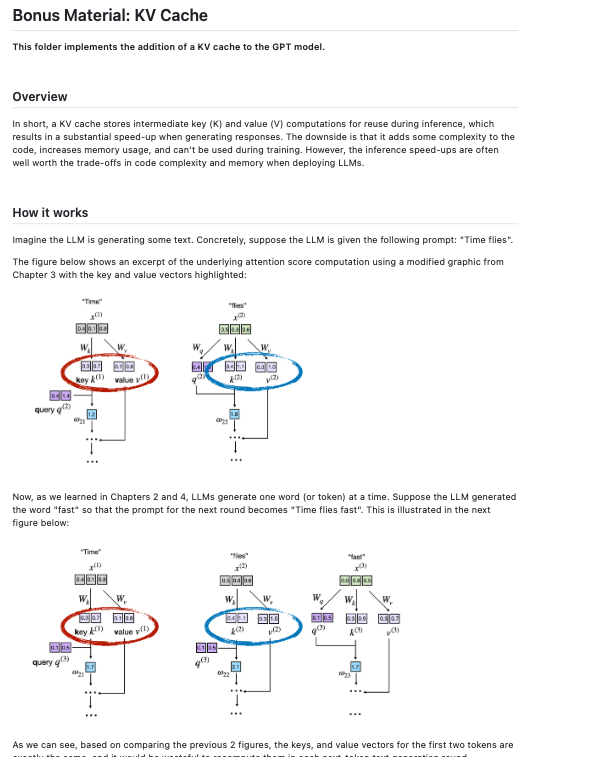

大規模言語モデルのファインチューニングと開発リソース: Dorialexander氏は、Qwen3 0.6Bのような小規模モデルについては、LoRAではなくフルファインチューニングがより良い選択肢である可能性があると指摘しました。dl_weeklyは、SIIM-ISICメラノーマデータセットでGemma 3をファインチューニングするマルチモーダル生産フローガイドを共有しました。Sebastian Raschka氏は、自身の「LLMs From Scratch」リポジトリにKVキャッシュの実装コードを追加し、ゼロからLLMを構築するための学習リソースを充実させました (ソース: Dorialexander, dl_weekly, rasbt)

AIの説明可能性(XAI)と推論能力の議論: NerdyRodent氏は、「ブラックボックス問題とガラス箱オプション」に関するYouTubeビデオを共有し、AIの意思決定プロセスの透明性について議論しました。同時に、コミュニティではXAI分野で現在欠けている重要な要素や、モデルが「完全に理解された」と定義する方法についても議論されています。ある研究者は、単純な全結合フィードフォワードネットワークでさえ、既存のXAI手法では人間の推論のようにその意思決定プロセスを説明できていないと考えています (ソース: NerdyRodent, Reddit r/MachineLearning)

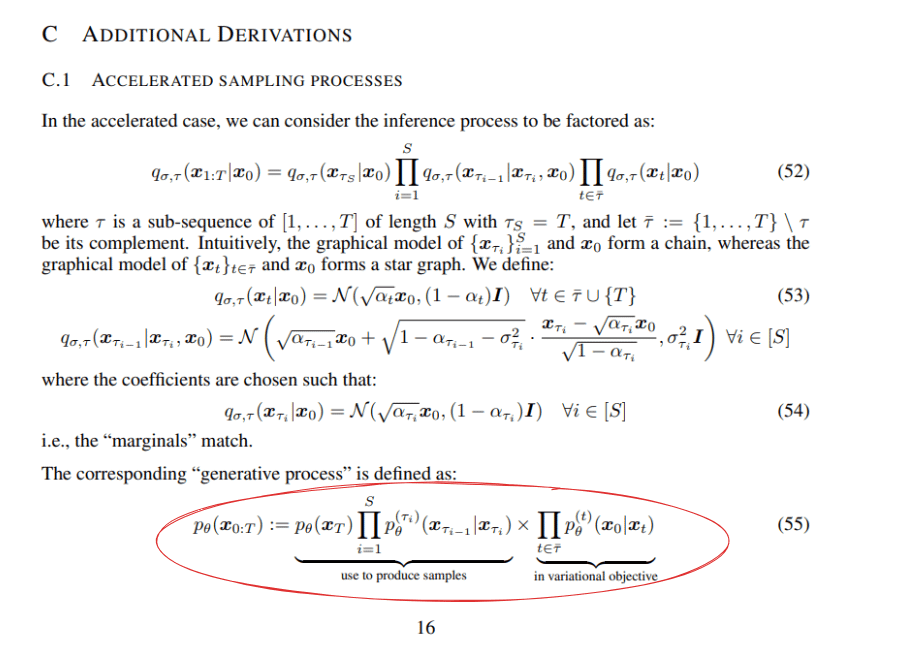

深層学習と強化学習の理論的議論: Redditユーザーは、DDIM(Denoising Diffusion Implicit Models)論文の数式、特に式55の因子分解方法について議論しました。別のブログ記事では、Q-learningがスケーラビリティの面で依然として課題を抱えていると指摘し、強化学習アルゴリズムの実用性についての考察を引き起こしました (ソース: Reddit r/MachineLearning, Reddit r/MachineLearning)

ゼロから構築する畳み込みニューラルネットワーク(CNN)の実践共有: AxelMontlahuc氏はGitHubで、C言語でゼロから実装したCNNプロジェクトを共有しました。これはMNISTデータセットの画像分類に使用されます。この実装はライブラリに依存せず、畳み込み層、プーリング層、全結合層、Softmax活性化関数、クロスエントロピー損失関数を含み、現在5エポック後に91%の精度を達成しており、深層学習の原理を理解するための低レベル実装の助けとなることを示しています (ソース: Reddit r/deeplearning)

AIの経済と教育への影響分析: ポスト労働経済学に関する講座(2025年更新版)では、AIがもたらす「より良く、より速く、より安く、より安全に」という変革と、それが経済構造に与える影響について議論されました。同時に、PwCの報告書は、AIの台頭に伴い、特にAIの影響を受ける職種において、雇用主の正規の学位に対する需要が低下しており、これが大学の学位を「時代遅れ」にする可能性があると指摘しています (ソース: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

💼 ビジネス

大手テクノロジー企業のAI戦略比較分析: コミュニティでは、Microsoft(Azure+OpenAI、エンタープライズ向けLLM展開)、Amazon(AWS自社開発AIチップ、エンドツーエンドモデルサポート)、NVIDIA(GPUハードウェア主導、CUDAエコシステム)、Oracle(高性能GPUインフラ、OpenAI/SoftBankとのStargateプロジェクト協力)、Palantir(AIPプラットフォーム、政府および大企業向け運用AI)など、主要テクノロジー企業のAI分野における技術インフラと応用戦略について議論されました。議論は、各社のイノベーションへの取り組み、技術アーキテクチャの違い、AIエコシステムにおける位置づけと強みに焦点を当てました (ソース: Reddit r/ArtificialInteligence)

ヨーロッパ企業、AI採用応用で相対的に遅れ: 報告によると、ヨーロッパのトップ雇用主のうち、採用ウェブサイトでAIや自動化技術を使用してパーソナライズされた求職体験を提供しているのはわずか3%であり、多くのサイトではスキルベースのスマート推薦、チャットボット、動的な職務マッチング機能が欠けています。対照的に、AI採用を導入している企業は、候補者のエンゲージメント、包括性、専門職の充足速度においてより優れたパフォーマンスを示しており、ヨーロッパ企業がAIによる人材活用で遅れていることが浮き彫りになっています (ソース: Reddit r/ArtificialInteligence)

Cerebras、トークン詐欺で告発される: コミュニティユーザーのdraecomino氏は、AIチップ企業Cerebrasはいかなるトークンも発行しておらず、現在流布しているいわゆるCerebrasトークンは詐欺行為であると警告し、ユーザーに関連リンクをクリックしないよう、詐欺に注意するよう呼びかけました (ソース: draecomino)

🌟 コミュニティ

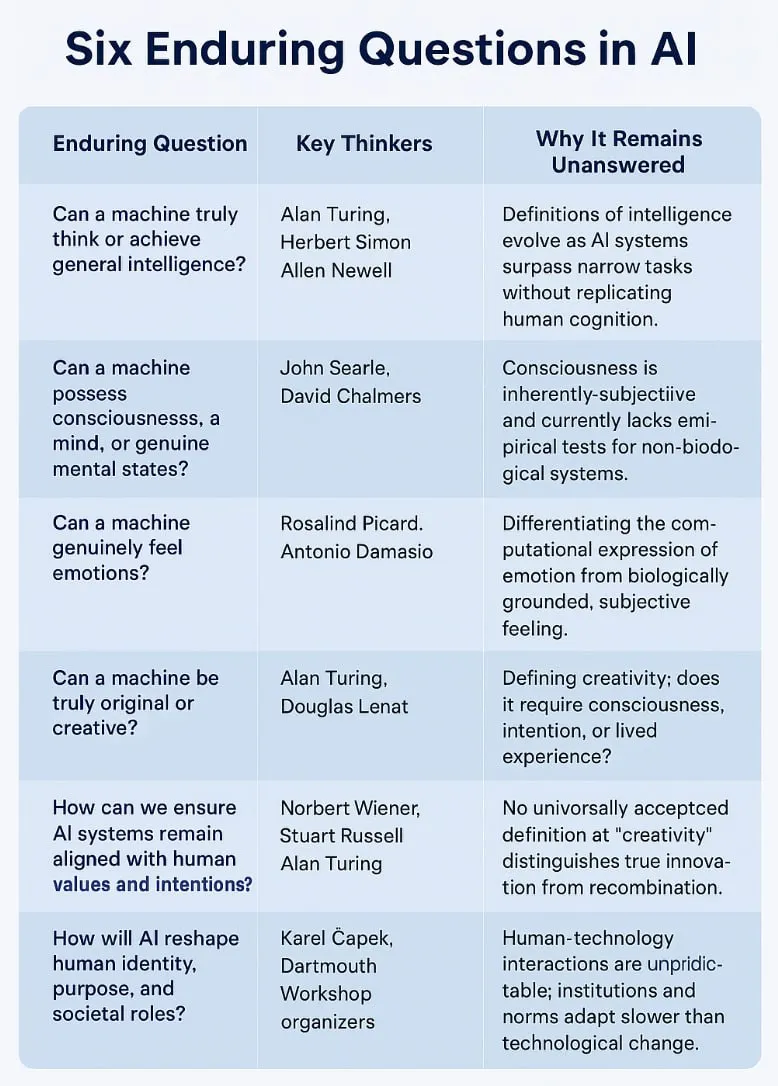

AI哲学と未来思索:NSIからASIへ、データ枯渇から意識の議論まで: コミュニティではAIの本質と未来について活発な議論が交わされています。Pedro Domingos氏は「自然超知能(NSI)とはホモ・サピエンスのことだ」と提唱し、知能の定義についての考察を促しました。同時に、LLMは単なるパターン認識に過ぎないのか、訓練データが枯渇した後AIはどのように進化するのか、そしてAIが意識を持つ可能性はあるのかといった話題が絶えません。Plinz氏はLLMを「博識な学者」に例え、記憶力は強いが真の思考力に欠けると述べています。ユーザーはAGIがいつ到来するのか、そしてAGIが取る可能性のある自己防衛戦略(地球外バックアップの作成など)について憶測を巡らせています。これらの議論は、AIの潜在能力とリスクに対する一般の人々の複雑な感情を反映しています (ソース: pmddomingos, Plinz, Teknium1, Reddit r/ArtificialInteligence, Reddit r/artificial, TheTuringPost)

AI能力の境界と限界に関する議論:「思考の錯覚」から「匂いテスト」まで: テレンス・タオ氏のAIに関する「目で見るテストは合格するが、匂いテストは合格しない」という見解が共感を呼んでいます。これは、既存のAIが生成する証明は一見完璧に見えるかもしれないが、人間の数学者が持つ「数学的直感」や「センス」に欠けており、その誤りは微妙で非人間的なものであることを指摘しています。この見解は、Appleの「思考の錯覚」論文が引き起こした議論と呼応しており、コミュニティは現在のLLMが複雑な推論、ツールの使用、数学的問題解決(AIME問題における非整数解の無視など)において抱える限界、そしてAIの真の理解力と創造力をどのように評価し向上させるかについて広く関心を寄せています (ソース: denny_zhou, clefourrier, Dorialexander, TheTuringPost)

AI倫理と社会的影響:仕事の代替、プライバシー懸念、人間とAIのインタラクションの新常態: AIが雇用市場に与える影響は引き続き焦点となっており、特にプログラマーの職がAIに取って代わられるかどうかの議論が激しく行われています。芸術創作分野と比較して、プログラマーの失業に関する議論の熱は高くないとの見方もあります。同時に、AIの芸術創作、従業員監視などへの応用も道徳的ジレンマやプライバシー懸念を引き起こしており、例えばユーザーがChatGPTによってリアルタイムの位置情報写真を通じて個人特定されることを心配しています。人間とAIのインタラクションのパターンも変化しており、ある開発者はAIを「コーディングパートナー」と見なし、さらにはユーザーがChatGPTを心理療法ツールとして使用する現象も現れ、その有効性と潜在的リスクについての議論を引き起こしています (ソース: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, claud_fuen, Reddit r/artificial, Reddit r/ChatGPT)

AI生成コンテンツとコミュニティ文化観察: AI生成画像と動画はコミュニティの人気トピックとなっており、「最も気まずい画像」チャレンジ、Ghibli風ゲームコンセプト動画から、ユーザーが共有する「ラブブ」ダイナミック壁紙、ChatGPTが創造した新しいアートスタイル「Interlune Aesthetic」、そしてユーモラスな「ひよこ電気ショック首輪」広告画像など、AIのクリエイティブ分野での幅広い応用とエンターテイメントの可能性を示しています。同時に、「死んだインターネット理論」は、Redditの人気投稿がChatGPTによって生成された疑いがあることから再び注目を集め、コミュニティはAI生成コンテンツの識別とネットワーク情報の真実性について懸念を示しています。さらに、AIモデル(Claudeなど)がインタラクション中に示す特定の行動、例えば不明確な指示の明確化を積極的に求めたり、特定の状況で予想外の応答をしたりする(「パスタを食べる」ことへの過度な心配など)ことも、ユーザーの議論の焦点となっています (ソース: Reddit r/ChatGPT, Reddit r/ChatGPT, op7418, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, VictorTaelin, Reddit r/ChatGPT)

AI開発者コミュニティの動向とツール使用経験: 開発者コミュニティはAIプロジェクトやハッカソンに積極的に参加しており、LeRobotグローバルハッカソンはバンガロールなどで多くの参加者を集めました。ユーザーは様々なAIツールの使用経験を共有しており、例えばHamel Husain氏はシステムプロンプトにAIがプロンプトを改善するよう誘導する指示を加えることを推奨し、skirano氏はProレベルのモデルの使用は少なくとも2段階のパイプラインの後に置くべきだと助言しています。Claude Codeはその強力な機能により開発者から好評を得ており、あるユーザーは「200ドルを使った中で最も価値があった」ツールだと述べています。同時に、AIツールが「私たちを馬鹿にする」可能性があるという懸念も存在し、現在の多くのAIツールは使いやすさを過度に強調し、ユーザーの専門スキル育成を軽視していると考えられています (ソース: ClementDelangue, HamelHusain, skirano, Reddit r/ClaudeAI, Reddit r/artificial)

💡 その他

AI業界の会議とイベント情報: The Turing Postなどの情報プラットフォームは、AI関連のオンラインおよびオフラインイベントを多数宣伝しています。例えば、CoreWeaveとNVIDIAは共同で「AIイノベーションの加速」バーチャルイベントを開催し、AIのビジネス応用に関する実践的な洞察を共有します。DeployConはエンジニア向けの無料サミットとして、6月25日にサンフランシスコおよびオンラインで開催され、テーマはスケーラブルなAI運用、LLMOps、強化学習ファインチューニング、エージェント、マルチモーダルAI、オープンソースツールなどをカバーします (ソース: TheTuringPost, TheTuringPost)

AI分野の求人情報: andriy_mulyar氏は、機械学習インターンの募集情報を発表しました。このインターンは直接同氏に報告し、特別な視覚言語モデル(VLM)のポストトレーニングプロジェクトに参加します。応募者には卓越した能力が求められ、ダイレクトメッセージで応募することになります (ソース: andriy_mulyar)