キーワード:GPT-5, AI推論能力, AlphaEvolve, OpenAI Operator, Mistral AI, テスト時計算と思考連鎖, AIによる自律的なコード最適化, マルチモーダルAIモデル, AI求職自動化, ローカルLLMファインチューニング

🔥 注目

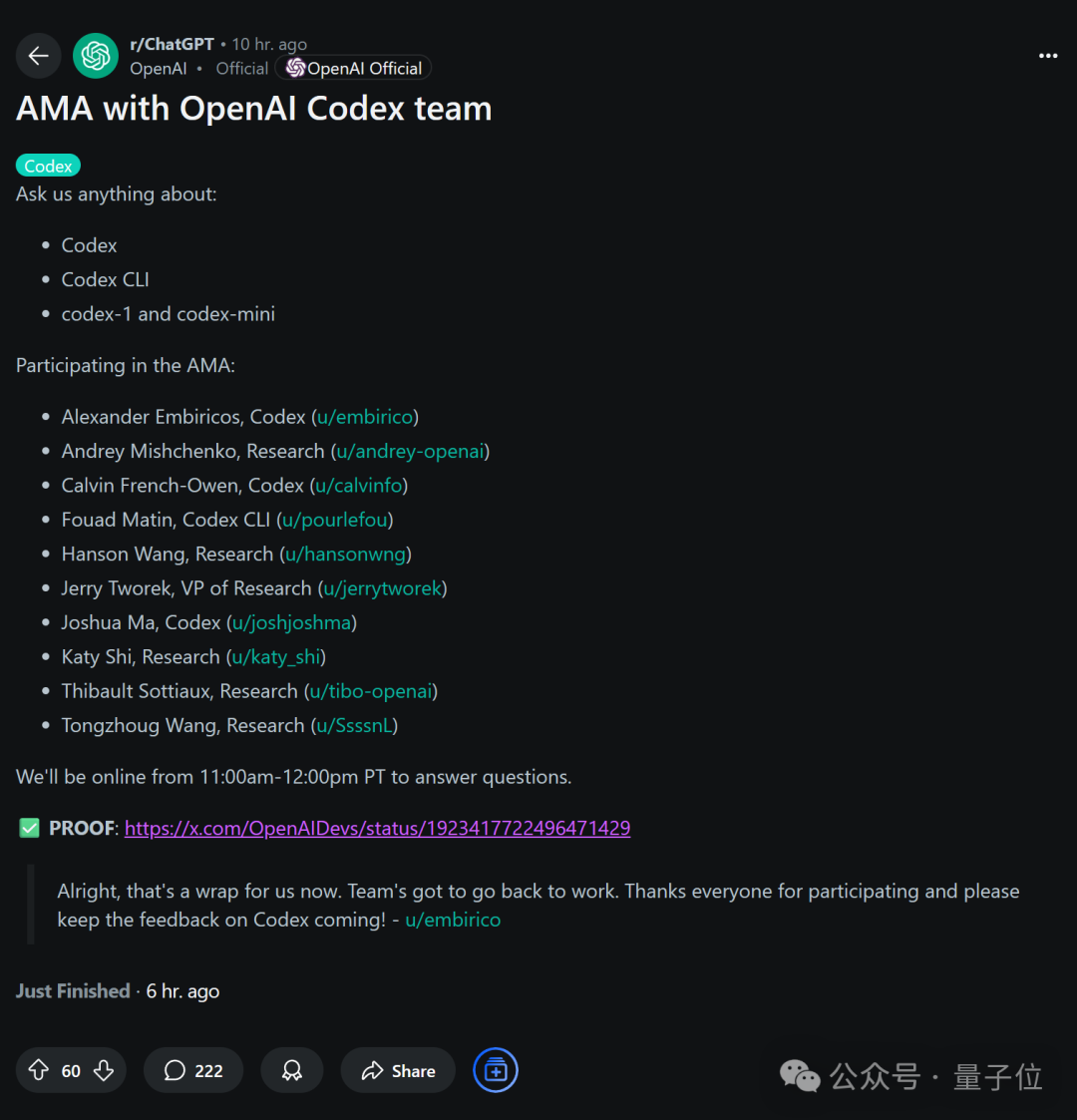

OpenAI、将来計画を明らかに:GPT-5は既存ツールを統合し、All-in-One体験を構築: OpenAIの研究担当副社長Jerry Tworek氏がRedditのAMAイベントで明らかにしたところによると、次世代基盤モデルGPT-5の中核目標は、既存モデルの能力を向上させ、モデル切り替えの煩雑さを軽減することです。そのため、OpenAIはCodex(プログラミング)、Operator(コンピュータタスク実行)、Deep Research(詳細研究)、Memory(記憶機能)などの既存ツールをGPT-5に統合し、一体化した体験を実現する計画です。チームメンバーはまた、Codexが当初エンジニアのサイドプロジェクトであり、内部使用でプログラミング効率が約3倍に向上し、オンデマンド課金を含む柔軟な価格設定案を検討中であると共有しました。(ソース: WeChat)

AI推論能力向上の新たな次元:テスト時計算と思考の連鎖: 北京大学出身で元OpenAI応用AI研究責任者のLilian Weng氏は、最新の長文記事「Why We Think」の中で、「テスト時計算」(test-time compute)や「思考の連鎖」(Chain-of-Thought, CoT)といった戦略を通じて大規模言語モデルの推論能力をいかに向上させるかについて深く論じています。記事は心理学の二重システム理論、計算資源の観点、潜在変数モデリングなど複数の角度から、モデルに「より長く考えさせる」ことの合理性を説明し、並列サンプリング、シーケンス修正、強化学習、外部ツールの使用といった主要技術がモデルの推論性能向上における研究進展を振り返っています。Weng氏は、これらの方法を通じて、モデルが推論時により多くの計算資源を投入し、人間の深い思考プロセスを模倣することで、複雑なタスクでより優れたパフォーマンスを達成できると強調し、忠実な推論、報酬ハッキング、教師なし自己修正などの将来の研究方向を示しました。(ソース: WeChat, WeChat)

Google、AlphaEvolveを発表:AIが自律的にコードを記述しアルゴリズムを最適化、計算コストを大幅に削減: GoogleはAIシステムAlphaEvolveを発表しました。このシステムは自律的にコードを記述・最適化でき、AlphaFoldなどのプロジェクトで既に大きな可能性を示しています。AlphaEvolveは進化的アルゴリズムを通じてより優れたアルゴリズム実装を探索し、例えばAlphaFoldのタンパク質フォールディングアルゴリズムでは、新たなアテンションメカニズムを発見し、計算コストを25%削減しました。これは数百万ドルの計算資源の節約に相当します。このブレークスルーは、AIが科学的発見とアルゴリズム最適化の分野で重要な一歩を踏み出したことを示しており、将来的にはより多くの複雑な計算問題でコスト削減と効率向上が期待されます。(ソース: Reddit r/ArtificialInteligence)

OpenAIが認める:AIの推論投入量と性能は比例、人間の能力を圧倒する鍵は「思考時間」: OpenAIの研究者Noam Brown氏は議論の中で、AIが「事前学習パラダイム」から「推論パラダイム」へと移行していると強調しました。事前学習は大量のデータを通じて次の単語を予測するもので、コストが高くつきます。一方、推論パラダイムでは、モデルが回答前により深いレベルで「思考」することが許容され、コストが若干高くても回答の質が著しく向上します。例えば、o1モデルはAIME数学コンテストやGPQA博士レベルの科学問題でGPT-4oを上回り、o3モデルはプログラミングコンテストで既に人間のトップレベルに達しています。これは、推論時の計算資源投入量(すなわち「思考時間」)を増やすことで、AIが複雑なタスクにおけるパフォーマンスを飛躍的に向上させ、人間をも超えることができることを示しています。(ソース: WeChat)

🎯 動向

Mistral AI、2025年モデルの成果著しく、多数のモデルが優れたパフォーマンスを発揮: Mistral AIは2025年上半期に多くの重要な進展を遂げ、Codestral 25.01(トップクラスのFIMモデル)、Mistral Small 3 & 3.1(同クラス最高、マルチモーダルと130kコンテキストをサポート)、Mistral Saba(自身の3倍以上のサイズのモデルを超える性能)、Mistral OCR(トップクラスのOCRモデル)、そしてMistral Medium 3など、多数の高性能モデルを発表しました。これらの成果は、Mistral AIの異なるモデルサイズと応用分野における強力な研究開発力を示しており、特にコード生成、マルチモーダル処理、OCR技術においてリードしています。(ソース: qtnx_)

Claudeモデルの最近のパフォーマンス変動、ユーザーからコンテキスト処理とArtifact機能に関する問題が報告される: Redditコミュニティのユーザーからの報告によると、AnthropicのClaudeモデル(特にOpus 3)は最近、長いコンテキスト処理、Artifact生成の安定性、ログインおよび正常稼働時間に関して問題が発生しています。具体的には、少数のターンでチャットが中断したり、Artifact機能が完了できなかったり、空のファイルをエクスポートしたりするなどの現象が見られます。Anthropicのステータスページでは、長いコンテキストリクエストのエラー増加や数回の短期的なサービス中断が確認されており、Artifact機能のリリースやバックエンド調整に関連している可能性があります。一部のユーザーは、Markdown出力を直接要求したり、ネットワークを切り替えたり、Claude 3.5 Sonnetを使用したりすることで問題を緩和しています。(ソース: Reddit r/ClaudeAI, qtnx_, Reddit r/ClaudeAI)

xAI、Grokシステムのプロンプトを公開、そのユーモアと批判的思考の設計を明らかに: xAI社は、同社のAIモデルGrokのシステムプロンプトを公開しました。これらのプロンプトは、Grokがユーモアのセンスを持ち、やや反抗的で批判的思考能力を備えたAIアシスタントとして設計されていることを明らかにしています。プロンプトは、Grokが説教じみた回答を避け、物議を醸す話題に対して独自の「Grokスタイル」で回答することを奨励しています。この動きは、AIモデルの行動設計の透明性を高め、Grokのユニークな個性の源泉を外部に垣間見せるものです。(ソース: Reddit r/artificial)

Meta、OpenRouter上でLlama 3.3 8B Instructモデルをテストか: MetaはOpenRouterプラットフォームでLlama 3.3 8B Instructモデルをテストしている可能性があります。このモデルはLlama 3.3 70Bの軽量高速応答バージョンとされており、128,000のコンテキストウィンドウを持ち、OpenRouter上では無料と表示されています。一部のユーザーがテストしたところ、その出力は8B 3.1や3.3 70Bバージョンと比較してやや平凡であるとの意見があります。この動きは、Metaが異なる規模のモデルの展開と応用シーンを模索していることを意味する可能性があります。(ソース: Reddit r/LocalLLaMA)

AIによるF1レースでの物議を醸す判定が議論を呼ぶ: AIがF1レースで物議を醸す判定を下したという議論が、スポーツ競技分野におけるAIの応用に対する人々の関心を集めています。具体的な詳細は不明ですが、これは通常、AI審判システムが高速で複雑な状況下での判定の正確性、公正性、そして人間の審判とAIシステムがどのように連携して機能するかといった問題に関わっています。(ソース: Ronald_vanLoon)

中国初の航空母艦型ドローン「九天」が6月に初飛行予定: 中国は6月に初の空中ドローン母艦「九天」SS-UAVの初飛行を計画しています。このドローンは高度15000メートルを巡航でき、100機以上の小型ドローンまたは1000キログラムのミサイルを搭載可能で、航続距離は7000キロメートルに達します。このニュースは、中国の軍事ドローン技術の発展に対する関心を引き起こしています。(ソース: menhguin)

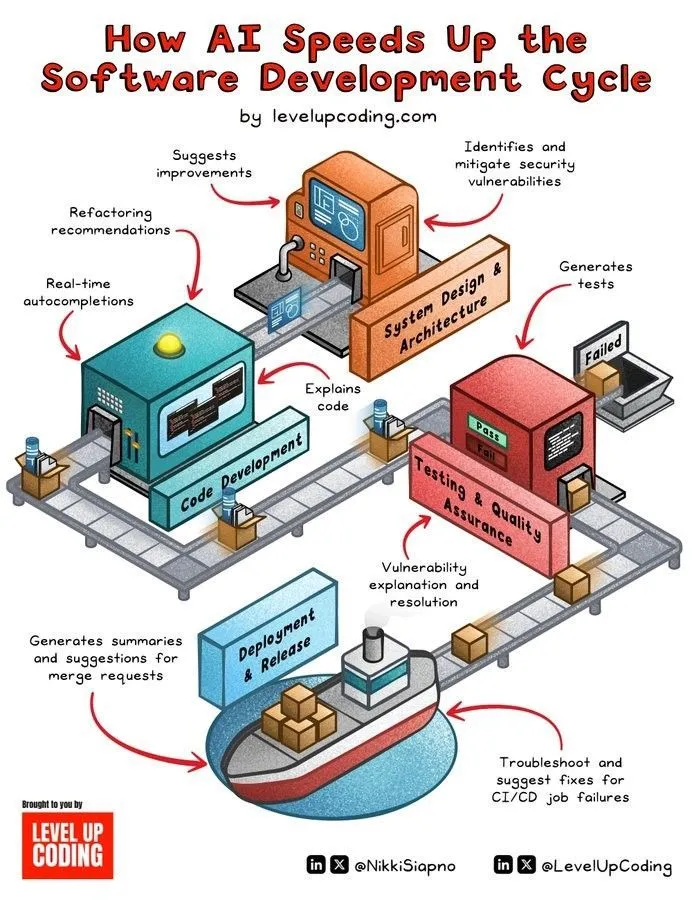

AIによるソフトウェア開発サイクルの加速: AI技術は、コード生成、テスト、デバッグ、ドキュメント作成などの工程を自動化することで、ソフトウェア開発ライフサイクルを著しく加速させています。AIツールは開発者の効率向上、反復作業の削減を助け、潜在的なエラーを発見する可能性があり、それによって製品の市場投入までの時間を短縮します。(ソース: Ronald_vanLoon)

人脳に近いマイクロ技術がヒューマノイドロボットにリアルタイムの知覚と思考能力を付与: 人間の脳構造を模倣したマイクロ技術が開発されており、ヒューマノイドロボットにリアルタイムの視覚的知覚と思考能力を付与することを目指しています。この技術は、ニューロモーフィックコンピューティングや高効率なAIチップ設計に関わる可能性があり、ロボットが複雑な環境でより迅速かつ知的な反応をすることを期待されています。(ソース: Ronald_vanLoon)

傅利叶智能、自社開発のヒューマノイドロボットFourier GR-1を発表: 傅利叶智能(Fourier Robots)は、自社開発のヒューマノイドロボットGR-1を発表しました。このロボットは先進的な運動制御と高度に生体模倣された胴体構造に重点を置いて設計されており、より柔軟で自然な動作能力の実現を目指しており、中国のヒューマノイドロボット分野における進展を示しています。(ソース: Ronald_vanLoon)

Unitree G1バイオニックロボットの敏捷性が向上: Unitree社は、G1バイオニックロボットの敏捷性を向上させたバージョンを展示しました。これは通常、ロボットの運動制御、バランス能力、環境適応性などが向上し、より柔軟にタスクを実行し、複雑な地形に対応できるようになったことを意味します。(ソース: Ronald_vanLoon)

中国人型ロボットが品質検査タスクを実行: 中国の人型ロボットが品質検査タスクの実行に応用されています。これは、人型ロボットが産業オートメーション分野での応用を徐々に拡大しており、その柔軟性と知覚能力を利用して、反復性が高く精度要求の厳しい検査作業を代替または補助していることを示しています。(ソース: Ronald_vanLoon)

ナノロボットが「隠された武器」を運び癌細胞を殺傷: ある医療技術の新たな進展によると、ナノロボットが「隠された武器」を運び、正確に癌細胞を標的として殺傷できることが示されました。この技術はナノロボットの微小なサイズと制御可能性を利用し、より精密で副作用の少ない癌治療法を実現することが期待されています。(ソース: Ronald_vanLoon)

プライバシー強化技術の現代ビジネスにおける重要性がますます高まる: データプライバシー規制の強化とユーザーの個人情報保護意識の高まりに伴い、プライバシー強化技術(PETs)は現代企業にとってますます重要になっています。これらの技術、例えば連合学習や準同型暗号などは、データプライバシーを保護しつつデータ分析と価値の掘り起こしを実現し、企業のコンプライアンス遵守と発展を支援します。(ソース: Ronald_vanLoon)

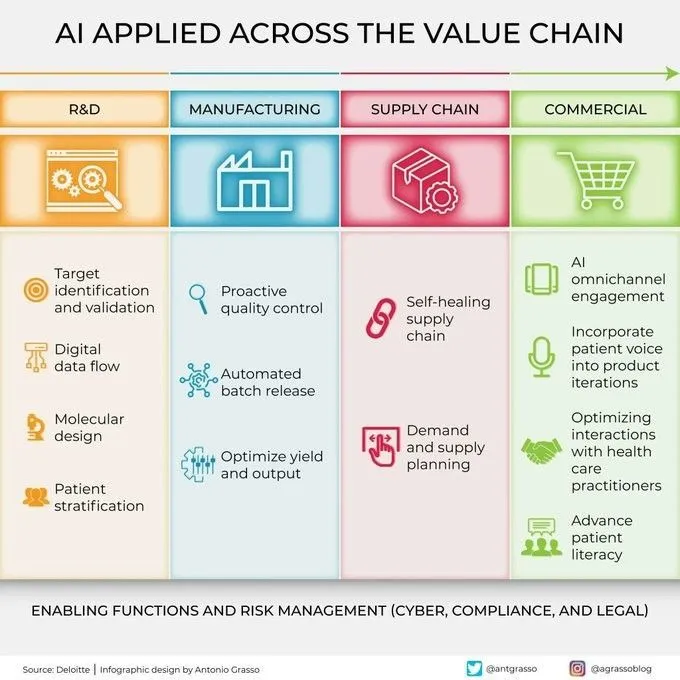

AIのバリューチェーン各段階における応用がますます広範に: 人工知能技術は、研究開発、生産、マーケティング、販売、アフターサービスなど、企業のバリューチェーンの各段階で幅広く応用されています。データ分析、予測モデリング、プロセス自動化などの方法を通じて、AIは企業が運営効率を最適化し、顧客体験を向上させ、新たなビジネス価値を創造するのを支援しています。(ソース: Ronald_vanLoon)

🧰 ツール

KernelSU:カーネルベースのAndroid Rootソリューション: KernelSUは、Androidデバイス向けに設計されたカーネルベースのRootソリューションです。カーネルレベルのsuとRootアクセス管理を提供し、OverlayFSベースのモジュールシステムとアプリケーションプロファイル機能を備え、デバイス権限をより深いレベルで制御することを目指しています。このプロジェクトはAndroid GKI 2.0デバイス(カーネル5.10+)をサポートし、旧バージョンのカーネル(4.14+、手動コンパイルが必要)とも互換性があり、WSA、ChromeOS、コンテナ化されたAndroid環境もサポートしています。(ソース: GitHub Trending)

Sunshine:Moonlight互換のセルフホスト型ゲームストリーミングホスト: Sunshineはオープンソースのセルフホスト型ゲームストリーミングホストソフトウェアで、ユーザーがPCゲームの画面をMoonlight互換の様々なデバイスにストリーミングすることを可能にします。AMD、Intel、Nvidia GPUのハードウェアエンコーディングをサポートし、ソフトウェアエンコーディングオプションも提供し、低遅延のクラウドゲーム体験の実現を目指しています。ユーザーはWeb UIを通じて設定やクライアントのペアリングを行うことができます。(ソース: GitHub Trending)

Tasmota:ESP8266/ESP32デバイス向けのオープンソース代替ファームウェア: Tasmotaは、ESP8266およびESP32チップをベースとしたスマートデバイス向けに設計された代替ファームウェアです。設定用の使いやすいWebユーザーインターフェースを提供し、OTAオンラインアップデートをサポートし、タイマーやルールによる自動化を実現し、MQTT、HTTP、シリアルポート、またはKNXプロトコルを介して完全にローカル制御を行い、デバイスの拡張性とカスタマイズ性を向上させます。(ソース: GitHub Trending)

Limbo:SQLiteの現代的なRust進化版プロジェクト: Limboプロジェクトは、Rust言語でSQLiteの現代的な進化版を構築することを目指しています。Linux上のio_uring非同期I/Oをサポートし、SQLiteのSQL方言、ファイル形式、C APIと互換性があり、JavaScript/WASM、Rust、Go、Python、Javaなどの言語バインディングを提供します。将来的には、ベクトル検索、並行書き込みの改善、スキーマ管理などの機能の統合を計画しています。(ソース: GitHub Trending)

Ventoy:新世代の起動可能なUSBドライブソリューション: Ventoyは、起動可能なUSBドライブを作成するためのオープンソースツールで、ISO、WIM、IMG、VHD(x)、EFIなど様々な形式のイメージファイルから直接起動することをサポートし、USBドライブを繰り返しフォーマットする必要がありません。ユーザーはイメージファイルをUSBドライブにコピーするだけで、Ventoyが自動的に起動メニューを生成します。複数のオペレーティングシステムと起動モード(Legacy BIOS、UEFI)をサポートし、MBRとGPTパーティションにも対応しています。(ソース: GitHub Trending)

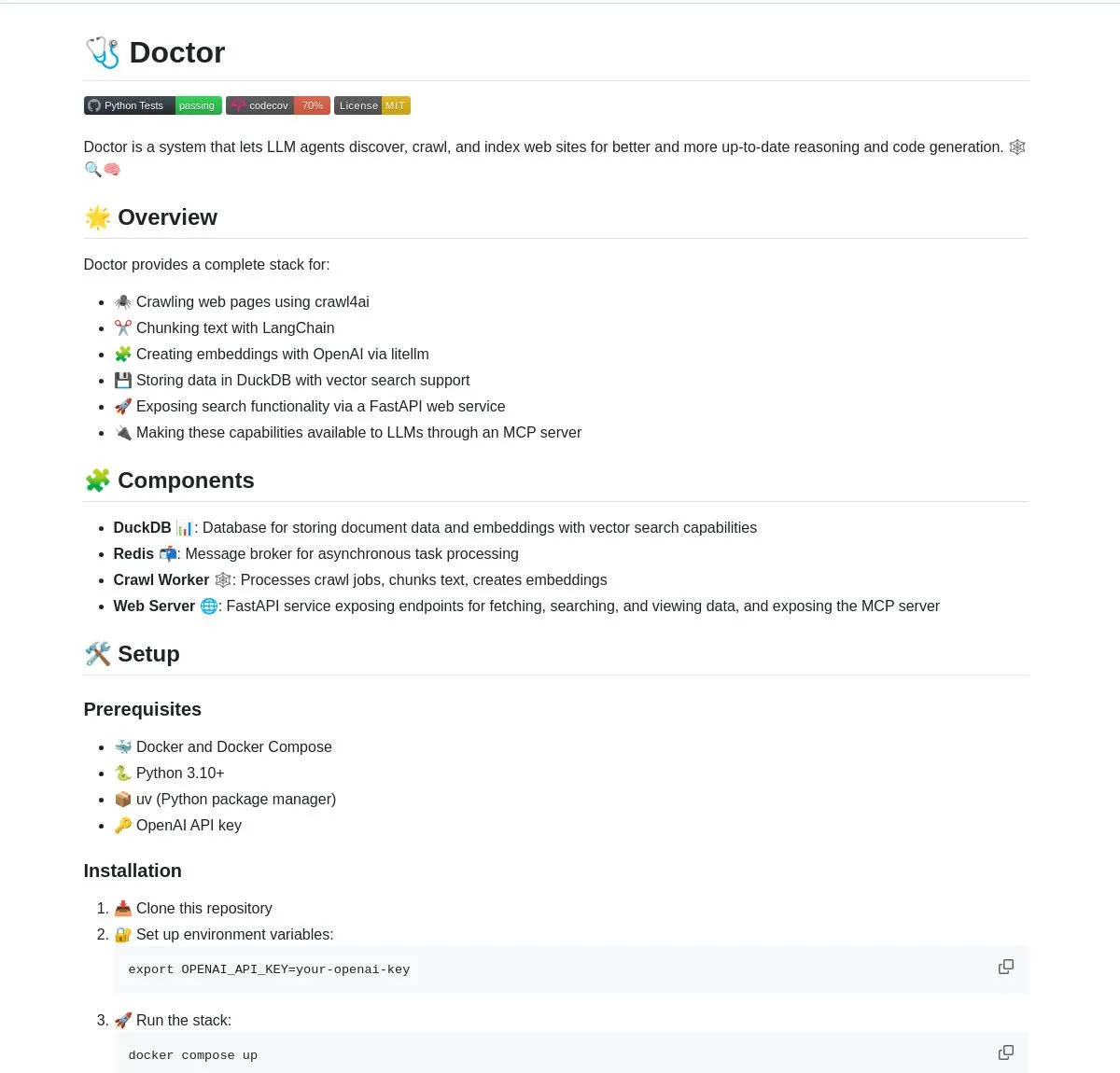

Doctor:LangChainを活用したLLMエージェントのWebクローリング・理解ツール: Doctorは、LLMエージェントがリアルタイムでWebコンテンツをクロールし理解するのを助けるツールです。Webページ処理、ベクトル検索、LangChainのドキュメント処理能力を組み合わせ、FastAPIを通じてサービスを提供します。ユーザーはDoctorを利用して、AIアプリケーションの情報収集・分析能力を強化できます。(ソース: LangChainAI, Hacubu)

Deep Research Agent:ローカルで実行可能なプライバシー保護型AI研究エージェント: プライバシー保護を重視したオープンソースのAIエージェントで、ローカルで実行してあらゆるトピックを研究できます。LangGraphを駆使して反復的な研究ワークフローを駆動し、ユーザーに強力なローカライズされた研究ツールを提供し、データをクラウドにアップロードする必要がありません。(ソース: LangChainAI, Hacubu)

スマートターミナルアシスタント:自然言語をコマンドラインに変換するマルチOSツール: 自然言語の指示をクロスプラットフォームのターミナルコマンドに変換するスマートターミナルアシスタントです。このツールはLangGraphのマルチエージェントシステムに基づいて構築され、A2AおよびMCPプロトコルを使用してクロスプラットフォーム実行を実現し、コマンドライン操作を簡素化し、ユーザーの使用のハードルを下げることを目指しています。(ソース: LangChainAI)

Montelimar:オープンソースのデバイス上OCRツールキット: Julien Blanchon氏がMontelimarをリリースしました。これはオープンソースのデバイス上OCR(光学文字認識)ツールキットです。スクリーンショットを取得し、画面の各部分をOCR処理することをサポートし、NougatおよびOCRSモデルと互換性があり、バックエンドはそれぞれRust(OCRS)とMLX(Nougat)を採用しています。このツールはLaTeX、表、Markdown(Nougat経由、比較的遅い)、プレーンテキスト(OCRS経由、比較的速い)を出力でき、履歴記録とシステムレベルのショートカットキー機能を提供します。(ソース: awnihannun)

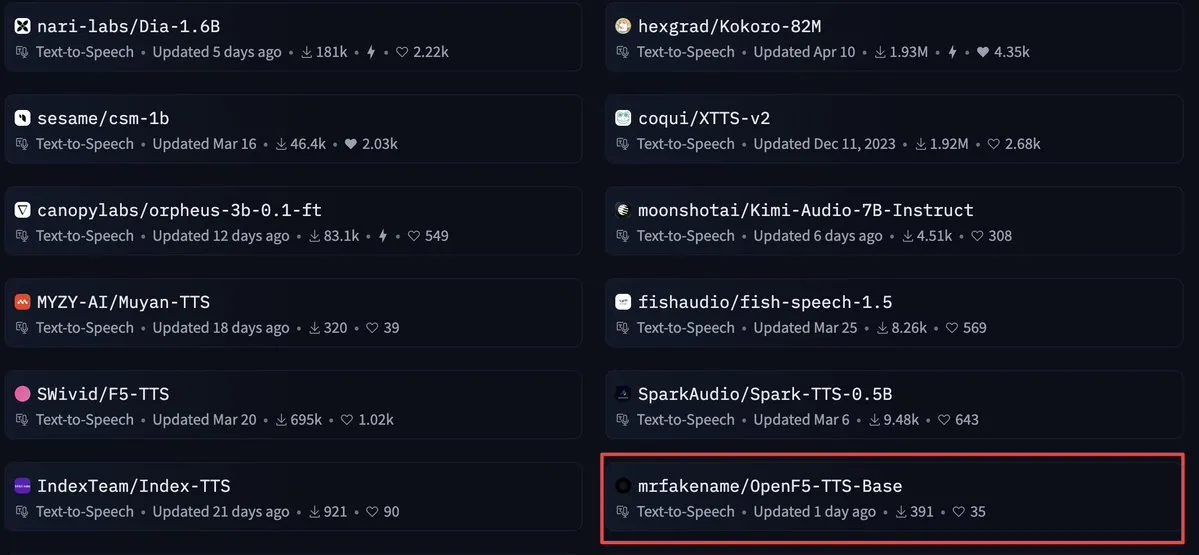

OpenF5 TTS:Apache 2.0ライセンスの商用テキスト読み上げモデル: OpenF5 TTSは、F5-TTSモデルを再学習したテキスト読み上げモデルで、Apache 2.0オープンソースライセンスを採用しており、商用目的で使用できます。このモデルは現在、Hugging Faceのテキスト読み上げモデルの中で注目度が高く、開発者に高品質で商用利用可能な音声合成オプションを提供します。(ソース: ClementDelangue)

Tensor Slayer:トレーニングなしで直接モデル性能を向上させるツール: Tensor Slayerは新しくリリースされたツールで、ファインチューニング、データセット、追加の計算コスト、トレーニング時間を必要とせずに、直接テンソルパッチング(direct tensor patching)によってモデル性能を25%向上させると主張しています。この概念は非常に革新的であり、AIモデルの改善を大衆化することを目指しています。(ソース: TheZachMueller)

Photoshop、ローカルコンピュータでプロキシ(c/ua)を利用しノーコード操作を実現: Computer Use Agents (c/ua) は、ユーザープロンプト、モデル選択、Docker、適切なプロキシループを通じて、Photoshopでノーコード操作を実現する方法を実演しました。これは、一般ユーザーが複雑なソフトウェアを使用する際のハードルを下げ、AIプロキシを通じて操作プロセスを簡素化することを目的としています。(ソース: Reddit r/artificial)

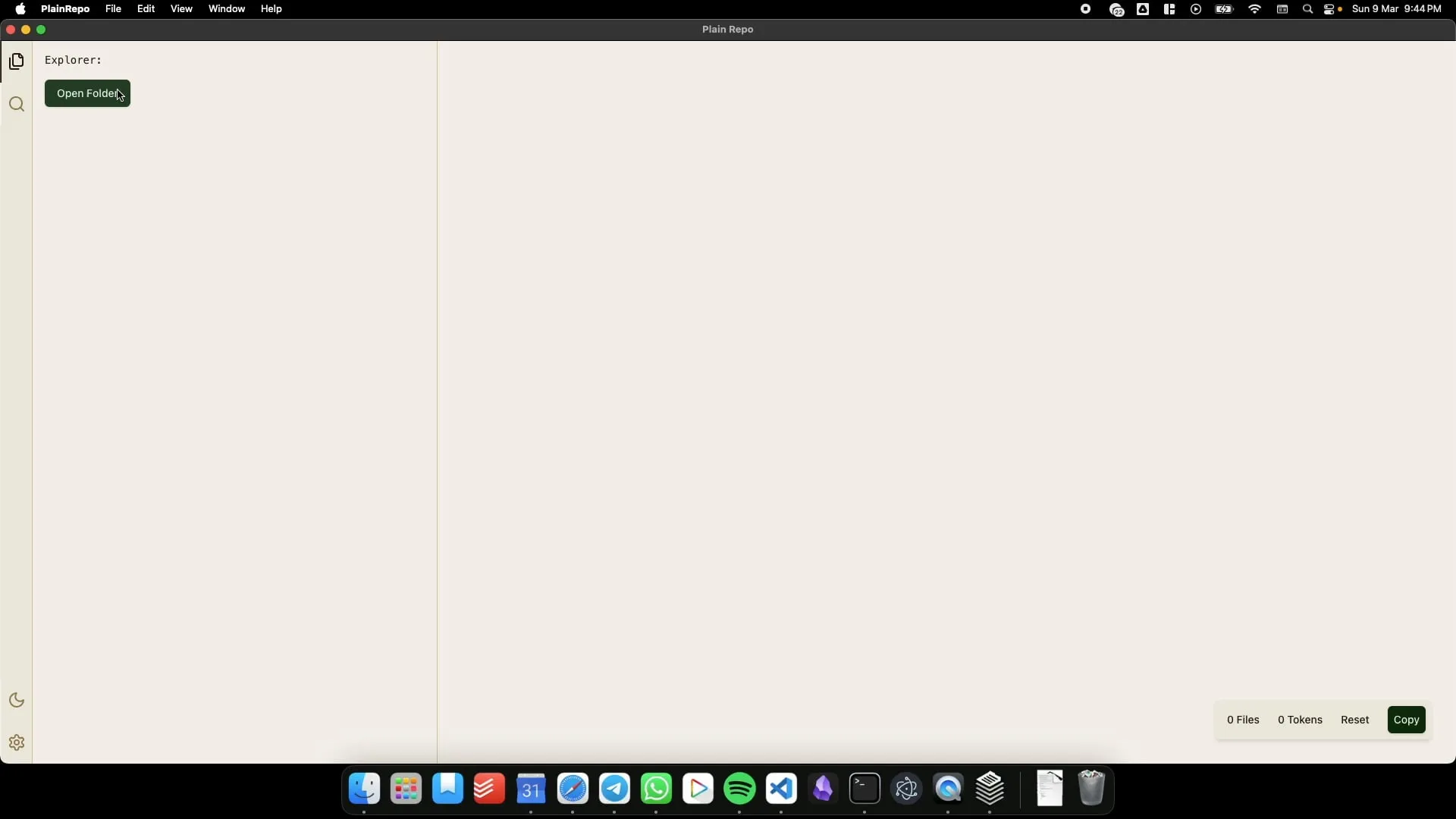

PlainRepo:オフラインアプリ、LLMがコンテキストを抽出するために大きなコード/テキストブロックを選択的にコピー: PlainRepoは無料のオープンソースオフラインアプリケーションで、ユーザーが大量のコードやテキストの断片を選択的にコピーし、ローカルLLMがコンテキスト情報を抽出できるようにします。これは、ネットワーク環境がない場合やプライバシーの懸念からローカルLLMを使用する必要があるユーザーにとって非常に便利です。(ソース: Reddit r/LocalLLaMA, Plus-Garbage-9710)

M0D.AI:ユーザーとAIが5ヶ月間協力して構築したパーソナライズAIインタラクション制御フレームワーク: ユーザーJames O’Kelly氏が、AI(Gemini、ChatGPTなど)との5ヶ月間、約13000回の対話を通じた深い協力により、M0D.AIという高度にカスタマイズされたAIインタラクションおよび制御フレームワークを構築しました。このシステムには、Pythonバックエンド、Flask Webサーバー、動的フロントエンドUI、そしてAIの行動を監視・指導するためのmematrix.pyというメタ認知レイヤーが含まれています。M0D.AIは、プログラミング経験のないユーザーがAIの支援を受けて、複雑なソフトウェアシステムの設計と開発を実現する方法を示しています。(ソース: Reddit r/artificial)

📚 学習

LLMエンジニアリング:8週間でAIとLLMをマスターするコースリソース庫: 「LLM Engineering – Master AI and LLMs」と題された8週間のコースで、受講者が大規模言語モデルエンジニアリングを習得することを目的としています。コースに付随するGitHubリポジトリでは、毎週のプロジェクトコード、セットアップガイド(PC、Mac、Linux)、およびColabリンクが提供されています。コースは実践を重視し、OllamaをインストールしてLlama 3.2を実行することから始まり、徐々にHuggingFace、APIの使用、モデルのファインチューニングなどの内容を深めていきます。また、OllamaをOpenAIなどの有料APIの無料代替手段として使用するためのガイダンスも提供しています。(ソース: GitHub Trending)

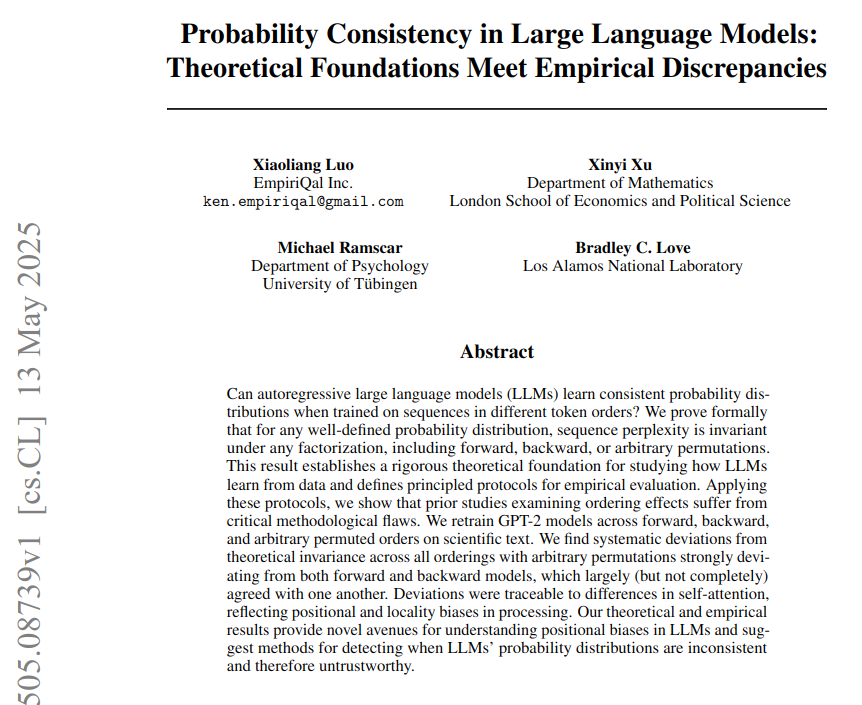

LLMにおける確率的一貫性:理論的基礎と実証的差異の研究: 「LLMにおける確率的一貫性:理論的基礎と実証的差異」と題された論文は、大規模言語モデル(LLM)が固定された戦略を用いてトークン確率を計算するものの、実際のモデルは異なるトークン順序の下での振る舞いが理論上の確率的一貫性と乖離していると指摘しています。研究では、神経科学のテキストでGPT-2モデルを訓練し(前方、後方、置換トークン順序を使用)、パープレキシティが理論上は順序に依存しないことを証明しましたが、実証的にはモデルがアーキテクチャのバイアスのためにこのテストに合格しなかったことを示しました。アテンションバイアス(局所的および長距離)が、観測された一貫性の失敗の直接的な原因であると考えられています。(ソース: menhguin)

BoldVoice、機械学習を利用して英語のアクセントの強さを定量化し指導: BoldVoiceアプリは、機械学習と潜在空間技術を用いて英語のアクセントの強さを定量化し、ユーザーに発音指導を提供します。この方法は、ユーザーがより効果的に英語の発音とアクセントを改善するのを助けることを目的としています。(ソース: dl_weekly)

Milvusブログ:本番環境で高い再現率を維持しつつ効率的なメタデータフィルタリングを行う際の課題と最適化: Milvusは、本番環境のベクトル検索において、効率的なメタデータフィルタリングを行いながら高い再現率を維持する方法について議論した実用的なブログ記事を公開しました。記事では関連する課題について議論し、最適化戦略を提案しています。(ソース: dl_weekly)

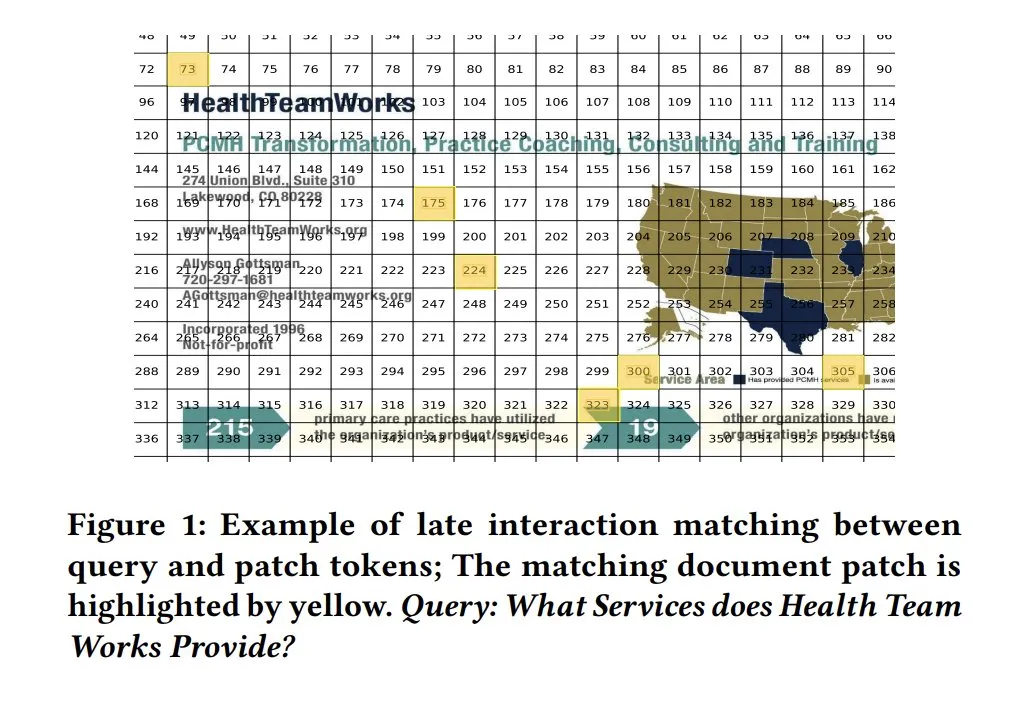

モデルの解釈可能性のためのColPali類似度マップ: ColPaliなどの視覚的文書検索モデルにおける類似度マップ(similarity maps)は、クエリと文書断片レベルのマッチングに対して強力な解釈可能性を提供します。ヒートマップなどの方法でどの画像領域がクエリに関連しているかを視覚化することで、モデルの意思決定プロセスを理解するのに役立ちます。Tony Wu氏が関連するクイックスタートガイドを提供しています。(ソース: lateinteraction, tonywu_71, lateinteraction)

soarXiv:人類の知識を探求する優美な方法: Jinay氏はsoarXivを発表しました。これは、科学論文をより美しくインタラクティブな方法で探求することを目的としたプラットフォームです。ユーザーはArXiv論文のURL中の「arxiv」を「soarxiv」に置き換えるだけで、宇宙の星図のようなインターフェースでその論文を特定し閲覧できます。このプラットフォームには2025年4月までの280万件の論文が埋め込まれています。(ソース: menhguin)

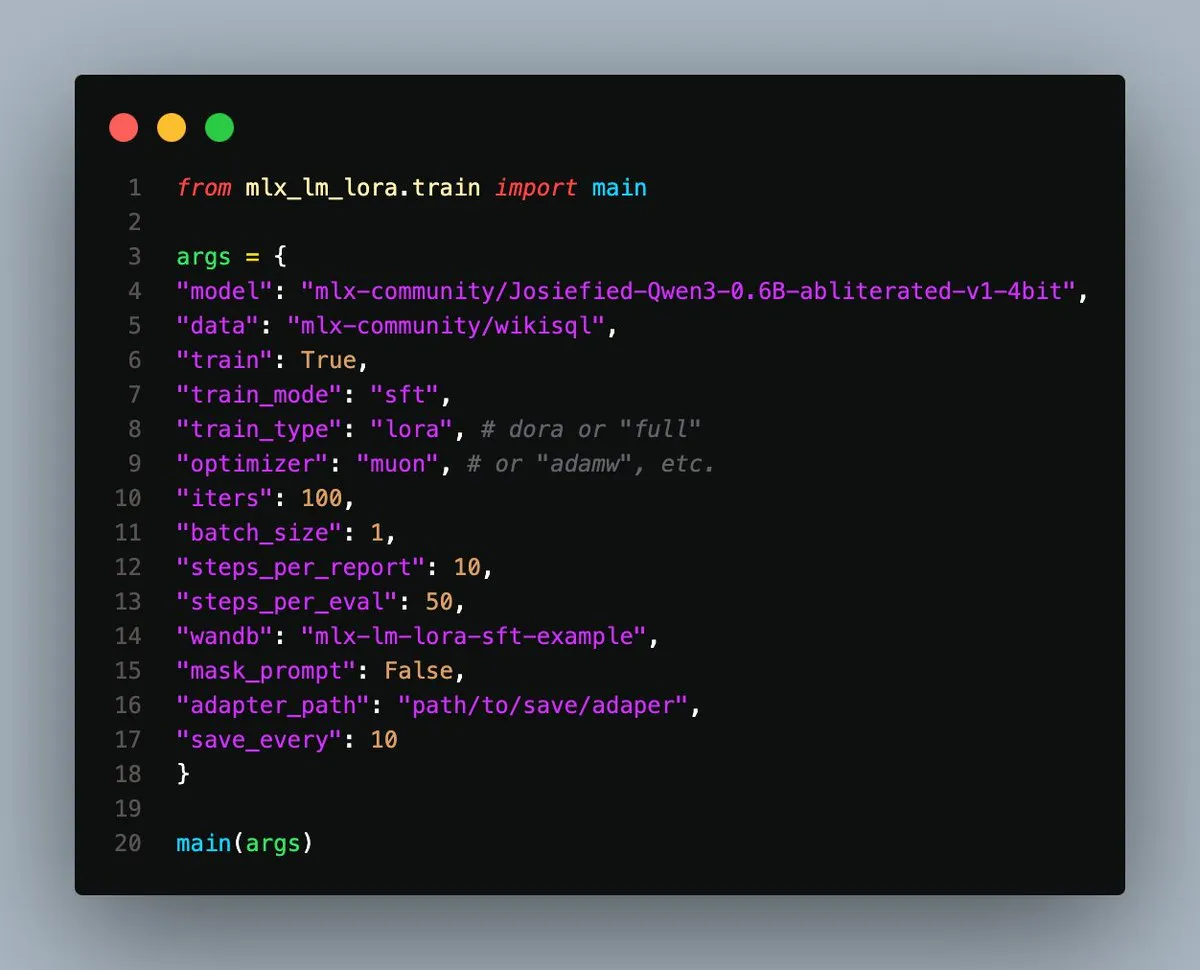

MLX-LM-LoRA v0.3.3リリース、Apple Siliconでのローカルファインチューニングを簡素化: Gökdeniz Gülmez氏はMLX-LM-LoRA v0.3.3をリリースし、Apple Silicon上でのローカルモデルのファインチューニングプロセスをさらに簡素化し、柔軟にしました。新バージョンでは、トレーニング設定またはコマンドラインで直接トレーニングエポック数を設定でき、基本的なファインチューニングやDPOを使用した高度な嗜好トレーニングのケースを含むサンプルスクリプトとNotebookが提供されており、わずか約20行のコードで開始できます。(ソース: awnihannun)

システムプロンプト漏洩分析:主要LLMの内部アーキテクチャと行動規則を解明: Simbaproduz氏はGitHub上で、最近流出した主要な大規模言語モデル(Claude 3.7、ChatGPT-4o、Grok 3、Geminiなど)のシステムプロンプト漏洩事件を包括的に分析したプロジェクトを公開しました。このガイドは、これらのモデルの内部アーキテクチャ、操作ロジック、行動規則について深く掘り下げており、情報の永続性、画像処理戦略、ウェブナビゲーション方法、パーソナライズシステム、および敵対的操作に対する防御メカニズムなどが含まれています。これらの情報は、LLMツール、エージェント、評価システムの構築において重要な参考価値があります。(ソース: Reddit r/MachineLearning)

ICML 2025論文、画像の敵対的摂動の周波数領域分解を議論: 中国科学院大学と計算技術研究所によるICML 2025 Spotlight論文「Diffusion-based Adversarial Purification from the Perspective of the Frequency Domain」は、敵対的摂動が画像の高周波振幅および位相スペクトルを破壊する傾向があることを提案しています。これに基づき、研究者らは拡散モデルの逆過程において元のサンプルの低周波情報を事前情報として注入し、クリーンなサンプルの生成を誘導することで、敵対的摂動を効果的に除去し、画像の意味内容を保持することを提案しています。(ソース: WeChat)

ICML 2025論文TokenSwift:「オートコンプリート」により100Kレベルの長文生成を3倍高速化: BIGAI NLCoチームはICML 2025で論文「TokenSwift: Lossless Acceleration of Ultra Long Sequence Generation」を発表し、100Kトークンレベルの長文推論のためのロスレス高効率高速化フレームワークTokenSwiftを提案しました。このフレームワークは、マルチトークン並列ドラフティング、n-gramヒューリスティック補完、ツリー構造並列検証、動的KVキャッシュ管理などのメカニズムを通じて、元のモデルの出力の一貫性を維持しつつ、3倍以上の推論高速化を実現し、超長シーケンス生成の効率を著しく向上させました。(ソース: WeChat)

💼 ビジネス

OpenAI、かつて警告したAI軍拡競争を助長していると非難される: ブルームバーグの記事は、OpenAIがChatGPTをリリースした後、AIリスクを警戒する組織からAI技術競争を推進する主要な役割へとどのように変化したかを探っています。記事は、OpenAIの戦略転換、商業化の圧力、そしてその行動がAI業界全体の発展方向と安全性の考慮に与える影響を分析している可能性があります。(ソース: Reddit r/ArtificialInteligence)

トランプ政権、ハーバード大学の約30億ドルの研究資金を停止、世界的な人材獲得競争を引き起こす: トランプ政権はハーバード大学の約30億ドル、350以上のプロジェクトに関わる研究資金を停止し、この措置は米国の研究システムに対する重大な打撃と見なされています。同時に、EU、カナダ、オーストラリアなどの国や地域は数千万ドル規模の助成計画を次々と打ち出し、影響を受けた米国のトップ科学者を引き付けようとしており、世界的な研究人材の流動に関する議論を引き起こしています。ハーバード大学は訴訟を起こし、危機を緩和するために2億5000万ドルを自己資金から拠出しました。(ソース: WeChat)

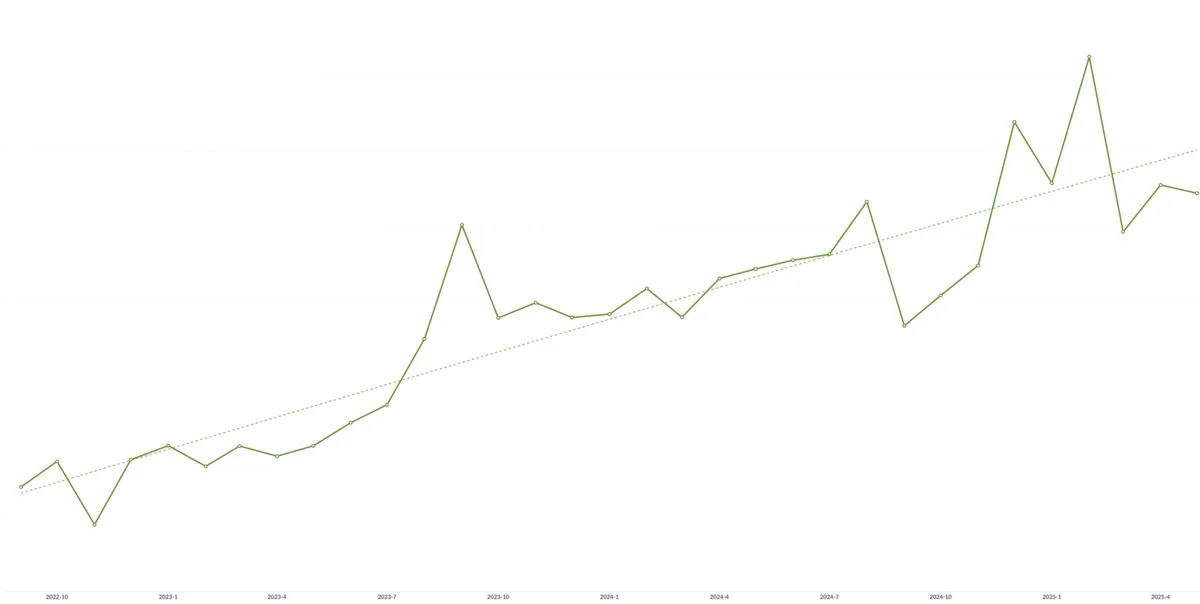

AIスタートアップSpellbook、3年連続で平均契約額(ACV)が継続的に成長: AI技術のコモディティ化が価格圧力をもたらす可能性への懸念があるにもかかわらず、AI法律ソフトウェアのスタートアップSpellbookの共同創業者Scott Stevenson氏は、同社の平均契約額(ACV)が3年連続で成長していると述べています。彼は、迅速に行動するチームはAI製品を通じて継続的に新たな価値を創造し、それによって潜在的な価格下落圧力を相殺できると考えています。(ソース: scottastevenson)

🌟 コミュニティ

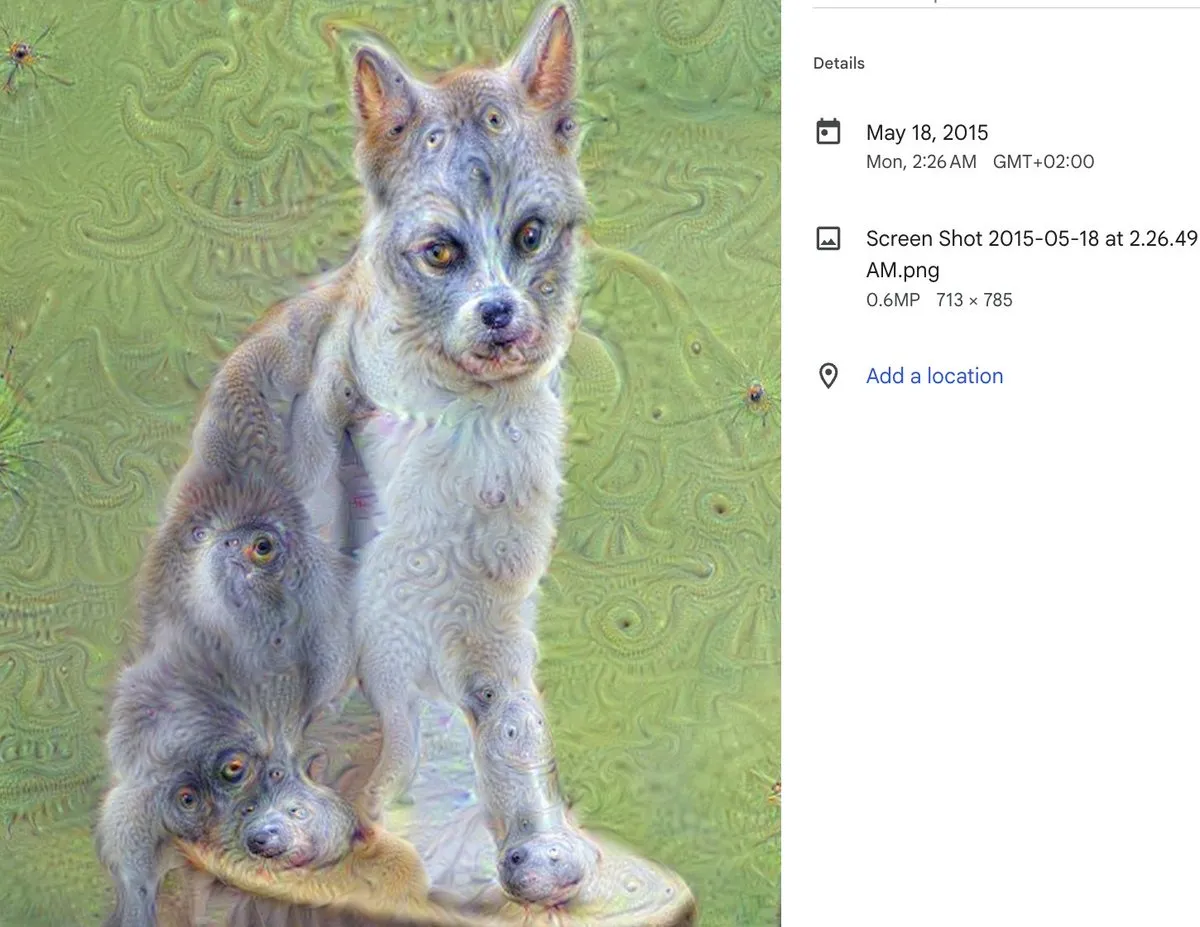

DeepDream 10周年:AIアートのマイルストーンとその深遠な影響: DeepDreamの制作者Alex Mordvintsev氏が、10年前のこの現象的なAIアートツールの誕生を振り返りました。Runwayの共同創設者Cristóbal Valenzuela氏も、DeepDreamがいかに彼をAIアート分野に身を投じるきっかけとなり、最終的にRunwayを共同設立するに至ったかを共有しました。DeepDreamの出現は、AIがアート制作分野で持つ可能性を早期に示したものであり、その後のジェネレーティブアートやAIコンテンツ制作ツールの発展に深遠な影響を与えました。(ソース: c_valenzuelab)

AIに技術系共同創業者は必要か、熱い議論を呼ぶ: ソーシャルメディア上で、「初期のVCが起業家にもはや技術系共同創業者は不要で、プロダクトマネージャーとAIだけで製品を構築できると助言している」という議論が起きています。この見解は広範な論争を引き起こし、Danielle Fong氏らはこれに懐疑的な見方を示し、AIが現在のところ技術系創業者の核心的な役割や深い技術的理解を完全に代替することはできないと示唆しています。(ソース: jonst0kes)

AIハルシネーション問題の議論:技術的要因と対応戦略: コミュニティでは、AI言語モデル(ChatGPT、Claudeなど)が「ハルシネーション」(自信を持って虚偽または捏造された情報を生成する)問題について活発な議論が交わされています。議論のポイントには、ハルシネーションの技術的根源(アテンションメカニズムの欠陥、訓練データのノイズ、モデルの現実世界へのアンカリングの欠如など)、RAGやファインチューニングで根絶できるか、ユーザーはLLMの出力をどのように慎重に扱うべきか、そして開発者は創造性と事実の正確性の間でどのようにバランスを取るべきか、などが含まれます。すべてのLLM出力は潜在的なハルシネーションと見なすべきであり、ユーザー自身が検証する必要があるという意見もあります。(ソース: Reddit r/ArtificialInteligence)

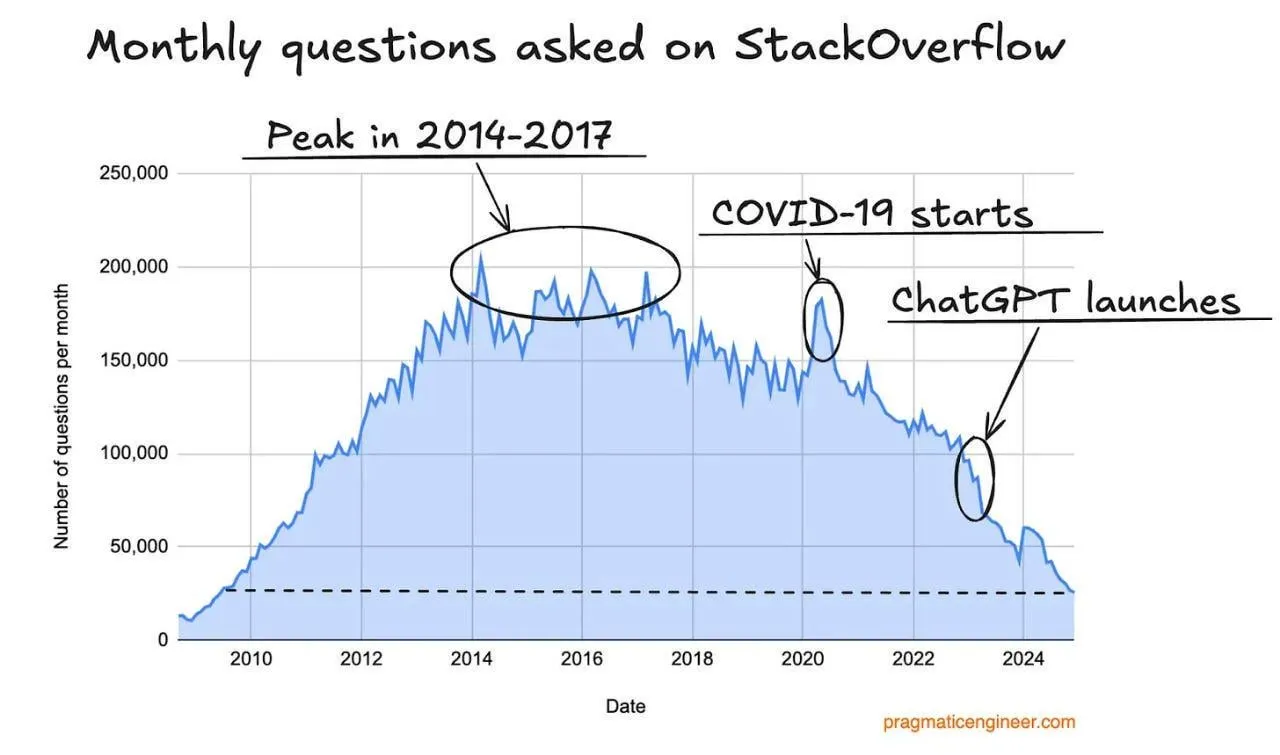

Stack Overflowのトラフィック減少、AIプログラミングアシスタントの影響か: あるユーザーがStack Overflowウェブサイトのトラフィックが減少傾向にあることを観察し、これはChatGPTなどのAIプログラミングアシスタントの台頭と関連があるのではないかと推測しています。開発者はコードの断片や解決策を得るためにますます直接AIに質問するようになり、従来のQ&Aコミュニティへの依存が減少しています。コメントでは、ユーザーは一般的にAIアシスタントが回答の直接性やコミュニティの否定的な感情を避ける点で優れていると考えていますが、AIが既存データに過度に依存することで将来の訓練データが枯渇する可能性も懸念されています。(ソース: Reddit r/ArtificialInteligence)

LLMエンジニアリングコースの講師が学習のヒントとリソースを共有: LLMエンジニアリングコースの講師であるEd Donner氏が、自身のコースの教育理念とリソースを共有し、実践(DOING)を通じて学ぶことの重要性を強調しました。彼は学生に積極的にコードを操作することを奨励し、PC、Mac、LinuxのセットアップガイドとGoogle ColabのNotebookリンクを提供し、学生が異なる環境で学習し実験できるようにしています。コース内容はOllama、HuggingFace、APIの使用などを網羅し、ローカルモデルを有料APIの代替として使用する方案も提供しています。(ソース: ed-donner)

ユーザー体験共有:Claudeを使用して思考力とコミュニケーション能力を向上: あるClaude Proユーザーが、AIとの対話が自身の思考方法やコミュニケーションスキルの改善にどのように役立ったかの経験を共有しました。Claudeとの対話を通じて、ユーザーは問題解決時により良く「自分自身にプロンプトを出す」こと、核心的な問題を特定すること、そして同僚とのコミュニケーションにおいてより明確な表現と相手の立場に立った思考を重視することを学び、AI支援ツールが個人の認知能力と表現能力の向上に積極的な役割を果たすことを認識しました。(ソース: Reddit r/ClaudeAI)

「識別器-生成器ギャップ」はAI科学イノベーションの中核理念か: Jason Wei氏は、「識別器-生成器ギャップ」(Discriminator-generator gap)がAIの科学イノベーションにおいて最も重要な考え方である可能性があると提唱しています。十分な計算能力、巧妙な探索戦略、明確な評価基準があれば、測定可能なものはすべてAIによって最適化できるというものです。この理念は、生成器が解決策を提案し、識別器が優劣を評価するという反復プロセスを通じてイノベーションを推進することを強調しており、特に迅速に検証可能で、継続的な報酬があり、スケーラブルな環境に適しています。(ソース: _jasonwei, dotey)

AI時代のプロダクトマネージャーの変革と課題: ソーシャルメディア上でAIがプロダクトマネージャーの職務に与える影響について議論されています。今後18ヶ月でプロダクトマネージャー業界は変革に直面し、ユーザーのニーズを理解しないPMは淘汰される可能性があるという意見があります。AIツール(AI Agentsなど)は短時間でアイデアを製品化できますが、真の難点はユーザーの核心的なペインポイントを見つけ出し、的確なソリューションを提供することにあります。この職務は最終的に、単にドキュメントやプロトタイプを作成することではなく、ユーザーの問題とソリューションのマッチングと理解能力で競われることになります。(ソース: dotey)

AI安全性のパラドックス:スーパーインテリジェンスは防御側に有利か: Richard Socher氏は「AI安全性のパラドックス」を提唱しています。合理的な仮定の下では、スーパーインテリジェンスの出現は実際には生物兵器やサイバー戦争における防御側に有利になる可能性があるというものです。インテリジェンスの限界費用が低下するにつれて、レッドチーム演習を通じてより多くの攻撃ベクトルを発見し、システムを強化または免疫化し、最終的には関連するすべての攻撃経路をカバーすることができます。理論上、防御コストがゼロに近づくと、システムは完全に免疫化できるとされています。この見解は、AIの発展が攻防の非対称性を悪化させるという従来の考え方に挑戦するものです。(ソース: RichardSocher)

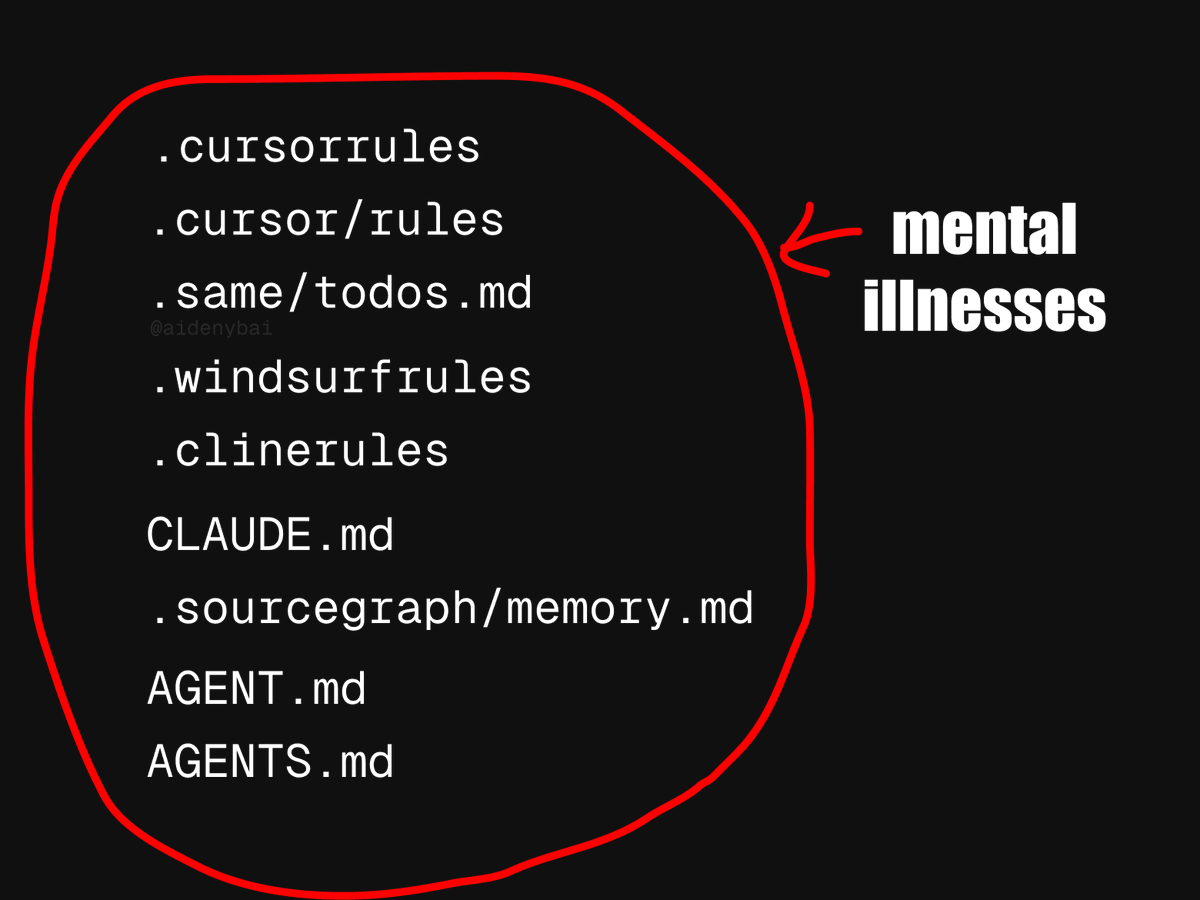

AI Agent応用標準の争い:CONTRIBUTING.mdがより良い実践か: 現在9種類のAI Agentルール競争標準が出現している現象に対し、ある開発者は、プロジェクト内のCONTRIBUTING.mdファイルを直接使用してAI Agentの行動を規範化する方が良いのではないかと提案しています。このファイルには通常、コードスタイルガイド、関連リファレンス、コンパイル断片などの情報が含まれており、AI Agentルールの自然な担い手となり、車輪の再発明を避けることができます。(ソース: JayAlammar)

💡 その他

古典的教科書『関数解析』の著者Peter Lax氏が99歳で逝去: 数学の巨匠であり、初のアーベル賞受賞者である応用数学者Peter Lax氏が99歳で逝去しました。Lax教授は、編著した古典的教科書『関数解析』で知られ、偏微分方程式、流体力学、数値計算などの分野で、Lax等価定理、Lax-Friedrichs/Lax-Wendroff法などの基礎的な貢献をしました。彼はまた、コンピュータ技術を数学解析に応用した最初の先駆者の一人でもあり、その業績は科学研究と工学実践に深い影響を与えました。(ソース: WeChat)

AI就職活動:AIエージェントがOpenAI Operatorを使いワンクリックで1000件の求人に応募し話題に: ある動画が、AIエージェントがOpenAIのOperatorツールを利用して、ワンクリックで1000件の職務に申請書を送る様子を映し出しました。この現象は、AIによる履歴書選考、面接日程調整、さらには一次面接の実施といった、就職・採用分野におけるAIの応用に関する議論を引き起こし、このような自動化が求職者と採用担当者にもたらす影響についても論じられています。(ソース: Reddit r/ChatGPT)

MIT、AI関連の経済学論文を撤回、AIによる代筆とデータ疑惑: MIT経済学部は、博士課程の学生が執筆した「人工知能、科学的発見と製品イノベーション」と題する論文を撤回しました。理由は、大学側が論文データの信頼性に確信を持てなかったためです。コミュニティでは、この論文の大部分がAIによって作成されたのではないかと推測されており、学術研究におけるAIの応用に関する倫理と品質管理についての議論を引き起こしています。(ソース: Reddit r/ArtificialInteligence)