Kata Kunci:OpenAI, Amazon AWS, Kecerdasan Buatan (AI) Komputasi Daya, Stanford AgentFlow, Meituan LongCat-Flash-Omni, Alibaba Qwen3-Max-Thinking, Samsung TRM Model, Unity AI Graph, Kolaborasi Komputasi Daya OpenAI dan Amazon, Kerangka Pembelajaran Penguatan AgentFlow, Model Multimodal LongCat-Flash-Omni, Kemampuan Penalaran Qwen3-Max-Thinking, Arsitektur Penalaran Rekursif TRM

🔥 Fokus Utama

OpenAI dan Amazon Capai Kerja Sama Daya Komputasi Senilai 38 Miliar USD : OpenAI dan Amazon AWS telah menandatangani perjanjian daya komputasi senilai 38 miliar USD, bertujuan untuk mendapatkan sumber daya GPU Nvidia guna mendukung pembangunan infrastruktur model AI dan tujuan besar AI mereka. Langkah ini menandai langkah penting bagi OpenAI dalam mendiversifikasi penyedia layanan cloud, mengurangi ketergantungan eksklusif pada Microsoft, dan membuka jalan bagi IPO di masa depan. Amazon, melalui kerja sama ini, mengukuhkan posisinya sebagai pemimpin di bidang infrastruktur AI, sekaligus mempertahankan kerja sama dengan Anthropic, pesaing OpenAI. Perjanjian ini akan memberikan daya komputasi yang dapat diskalakan kepada OpenAI untuk inferensi AI dan pelatihan model generasi berikutnya, serta mempromosikan penerapan model dasarnya di platform AWS. (Sumber: Ronald_vanLoon, scaling01, TheRundownAI)

Kerangka AgentFlow Stanford: Model Kecil Mengungguli GPT-4o : Tim peneliti dari Universitas Stanford dan lainnya merilis kerangka AgentFlow. Melalui arsitektur modular dan algoritma Flow-GRPO, sistem agen AI dapat melakukan pembelajaran penguatan online dalam alur inferensi, mencapai optimasi diri berkelanjutan. AgentFlow dengan hanya 7B parameter secara komprehensif mengungguli GPT-4o (sekitar 200B parameter) dan Llama-3.1-405B dalam tugas-tugas seperti pencarian, matematika, dan sains, menduduki puncak daftar harian Paper HuggingFace. Penelitian ini membuktikan bahwa sistem agen dapat memperoleh kemampuan belajar yang mirip dengan model besar melalui pembelajaran penguatan online, dan lebih efisien dalam tugas-tugas tertentu, membuka jalur baru “kecil tapi canggih” untuk pengembangan AI. (Sumber: HuggingFace Daily Papers)

AWS Luncurkan Project Rainier: Salah Satu Klaster Daya Komputasi AI Terbesar di Dunia : AWS telah meluncurkan Project Rainier, sebuah klaster daya komputasi AI yang dibangun dalam waktu kurang dari setahun, memiliki hampir 500.000 chip Trainium2. Anthropic telah melatih model Claude baru di sini, dan berencana untuk memperluas hingga 1 juta chip sebelum akhir tahun 2025. Trainium2 adalah prosesor pelatihan AI yang disesuaikan oleh AWS, dirancang untuk memproses jaringan saraf skala besar. Proyek ini mengadopsi arsitektur UltraServer, terhubung melalui NeuronLinks dan jaringan EFA, menyediakan kemampuan komputasi model FP8 sparse hingga 83.2 petaflops, dan ditenagai oleh 100% energi terbarukan, mencapai konsumsi energi yang efisien. Project Rainier menandakan posisi terdepan AWS di bidang infrastruktur AI, menyediakan solusi terintegrasi vertikal mulai dari chip kustom hingga pendinginan pusat data. (Sumber: TheTuringPost)

🎯 Tren

Meituan Rilis Model Multimodal Penuh LongCat-Flash-Omni : Meituan telah merilis open-source model multimodal penuh terbarunya, LongCat-Flash-Omni. Model ini mencapai level SOTA open-source dalam benchmark komprehensif seperti Omni-Bench dan WorldSense, serta menyaingi Gemini-2.5-Pro yang closed-source. LongCat-Flash-Omni mengadopsi arsitektur MoE dengan total 560B parameter dan 27B parameter aktivasi, mencapai efisiensi inferensi tinggi dan interaksi real-time latensi rendah, menjadikannya model open-source pertama yang mencapai interaksi real-time multimodal penuh. Model ini mendukung input multimodal berupa teks, suara, gambar, video, dan kombinasi apa pun, serta memiliki jendela konteks 128K tokens, mendukung interaksi audio-video lebih dari 8 menit. (Sumber: WeChat, ZhihuFrontier)

Alibaba Qwen3-Max-Thinking: Versi Inferensi Dirilis : Tim Qwen Alibaba telah merilis versi pratinjau awal Qwen3-Max-Thinking, sebuah model checkpoint menengah yang masih dalam pelatihan. Setelah peningkatan penggunaan alat dan perluasan komputasi waktu pengujian, model ini mencapai skor 100% pada benchmark inferensi yang menantang seperti AIME 2025 dan HMMT. Perilisan Qwen3-Max-Thinking menunjukkan kemajuan signifikan Alibaba dalam kemampuan inferensi AI, memberikan pengguna kemampuan rantai pemikiran dan pemecahan masalah yang lebih kuat. (Sumber: Alibaba_Qwen, op7418)

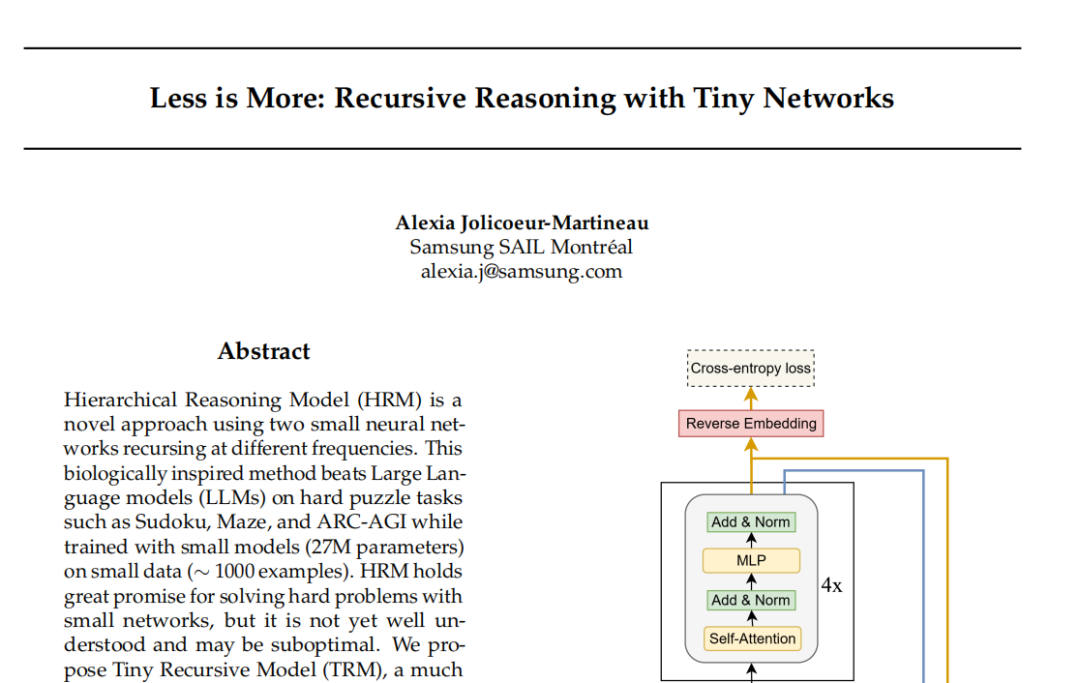

Model TRM Samsung: Inferensi Rekursif Menantang Paradigma Transformer : Samsung SAIL Montreal Lab mengusulkan Tiny Recursive Model (TRM), sebuah arsitektur inferensi rekursif baru dengan hanya 7 juta parameter dan dua lapisan jaringan saraf. TRM, melalui pembaruan rekursif ‘jawaban’ dan ‘variabel pemikiran laten’, mendekati hasil yang benar melalui beberapa putaran koreksi diri, dan memecahkan rekor dalam tugas-tugas seperti Sudoku-Extreme, mengungguli model besar seperti DeepSeek R1 dan Gemini 2.5 Pro. Model ini bahkan meninggalkan lapisan self-attention dalam arsitekturnya (varian TRM-MLP), menunjukkan bahwa untuk tugas input tetap skala kecil, MLP dapat mengurangi overfitting, menantang aturan empiris ‘model semakin besar semakin kuat’ di dunia AI, dan memberikan ide baru untuk inferensi AI yang ringan. (Sumber: 36氪)

Konferensi Pengembang Unity: Tren Masa Depan AI+Game : Konferensi Pengembang Unity 2025 menekankan bahwa AI akan menjadi mesin kreativitas dan efisiensi game. Unity Engine dan Tencent Hunyuan bersama-sama meluncurkan platform AI Graph, yang mengintegrasikan alur kerja AIGC secara mendalam, dapat meningkatkan efisiensi desain 2D sebesar 30% dan efisiensi produksi aset 3D sebesar 70%. Amazon Web Services (AWS) juga menunjukkan pemberdayaan AI dalam seluruh siklus hidup game (membangun, menjalankan, mengembangkan), terutama dalam hal pembuatan kode, AI beralih dari bantuan ke pembuatan otonom. Meshy, sebagai alat kreasi AI generatif 3D, melalui model difusi dan model autoregresif, membantu pengembang mengurangi biaya dan mempercepat pembuatan prototipe, terutama memiliki potensi besar dalam skenario VR/AR dan UGC. (Sumber: WeChat)

Cartesia Rilis Model Suara Sonic-3 : Perusahaan AI suara Cartesia telah merilis model suara terbarunya, Sonic-3. Model ini menunjukkan efek yang menakjubkan dalam mereplikasi suara Elon Musk, dan memperoleh pendanaan Seri B sebesar 100 juta USD dari investor seperti Nvidia. Sonic-3 dibangun berdasarkan State Space Model (SSM), bukan arsitektur Transformer tradisional, mampu terus merasakan konteks dan suasana percakapan, mencapai respons AI yang lebih alami dan tidak memakan banyak tenaga, dengan latensi hanya 90 milidetik dan waktu respons end-to-end 190 milidetik, menjadikannya salah satu sistem pembuatan suara tercepat saat ini. (Sumber: WeChat)

MiniMax Rilis Model Suara Speech 2.6 : MiniMax telah merilis model suara terbarunya, MiniMax Speech 2.6, menonjolkan fitur “cepat dan fasih berbicara”. Model ini mengurangi latensi respons hingga di bawah 250ms, mendukung lebih dari 40 bahasa dan semua aksen, serta mampu mengidentifikasi secara akurat berbagai “teks non-standar” seperti URL, email, jumlah uang, tanggal, dan nomor telepon. Ini berarti bahwa bahkan dalam situasi input dengan aksen kental, kecepatan bicara cepat, dan informasi kompleks, model dapat memahami dan berbicara dengan jelas dalam satu kali percobaan, secara signifikan meningkatkan efisiensi dan akurasi interaksi suara. (Sumber: WeChat)

Amazon Chronos-2: Model Dasar Prediksi Universal : Amazon telah meluncurkan Chronos-2, sebuah model dasar yang dirancang untuk menangani tugas prediksi apa pun. Model ini mendukung prediksi informasi univariat, multivariat, dan kovariat, serta dapat beroperasi dalam mode zero-shot. Perilisan Chronos-2 menandai kemajuan penting Amazon dalam bidang prediksi deret waktu, memberikan perusahaan dan pengembang kemampuan prediksi yang lebih fleksibel dan kuat, diharapkan dapat menyederhanakan proses prediksi yang kompleks, dan meningkatkan efisiensi pengambilan keputusan. (Sumber: dl_weekly)

YOLOv11 untuk Segmentasi Instans Bangunan dan Klasifikasi Ketinggian : Sebuah makalah menganalisis secara rinci penerapan YOLOv11 dalam segmentasi instans bangunan dan klasifikasi ketinggian diskrit dari citra satelit. YOLOv11, melalui arsitektur yang lebih efisien, menggabungkan fitur-fitur dari skala yang berbeda, meningkatkan akurasi lokalisasi objek, dan berkinerja sangat baik dalam skenario perkotaan yang kompleks. Model ini pada dataset DFC2023 Track 2 mencapai kinerja segmentasi instans sebesar 60.4% mAP@50 dan 38.3% mAP@50-95, sekaligus mempertahankan akurasi klasifikasi yang robust untuk lima tingkat ketinggian yang telah ditentukan. YOLOv11 berkinerja sangat baik dalam menangani oklusi, bentuk bangunan kompleks, dan ketidakseimbangan kelas, cocok untuk pemetaan kota real-time dan skala besar. (Sumber: HuggingFace Daily Papers)

🧰 Alat

PageIndex: Sistem Indeks Dokumen RAG Berbasis Inferensi : VectifyAI merilis PageIndex, sebuah sistem RAG (Retrieval Augmented Generation) berbasis inferensi yang tidak memerlukan database vektor dan chunking. PageIndex, dengan membangun indeks struktur pohon dokumen, mensimulasikan cara pakar manusia menavigasi dan mengekstrak pengetahuan, memungkinkan LLM untuk melakukan inferensi multi-langkah, sehingga mencapai pengambilan dokumen yang lebih akurat. Sistem ini mencapai akurasi 98.7% dalam benchmark FinanceBench, jauh melampaui sistem RAG vektor tradisional, sangat cocok untuk analisis dokumen panjang profesional seperti laporan keuangan dan dokumen hukum. PageIndex menawarkan berbagai opsi deployment seperti self-hosting, layanan cloud, dan API. (Sumber: GitHub Trending)

LocalAI: Alternatif OpenAI Open-Source Lokal : LocalAI adalah alternatif OpenAI gratis dan open-source, menyediakan REST API yang kompatibel dengan OpenAI API, mendukung menjalankan LLM, pembuatan gambar, audio, video, dan kloning suara secara lokal pada perangkat keras tingkat konsumen. Proyek ini tidak memerlukan GPU, mendukung berbagai model seperti gguf, transformers, diffusers, dan telah mengintegrasikan fitur-fitur seperti WebUI, inferensi P2P, dan Model Context Protocol (MCP). LocalAI bertujuan untuk mencapai lokalisasi dan desentralisasi inferensi AI, memberikan pilihan deployment AI yang lebih fleksibel dan privat bagi pengguna, serta mendukung berbagai akselerasi perangkat keras. (Sumber: GitHub Trending)

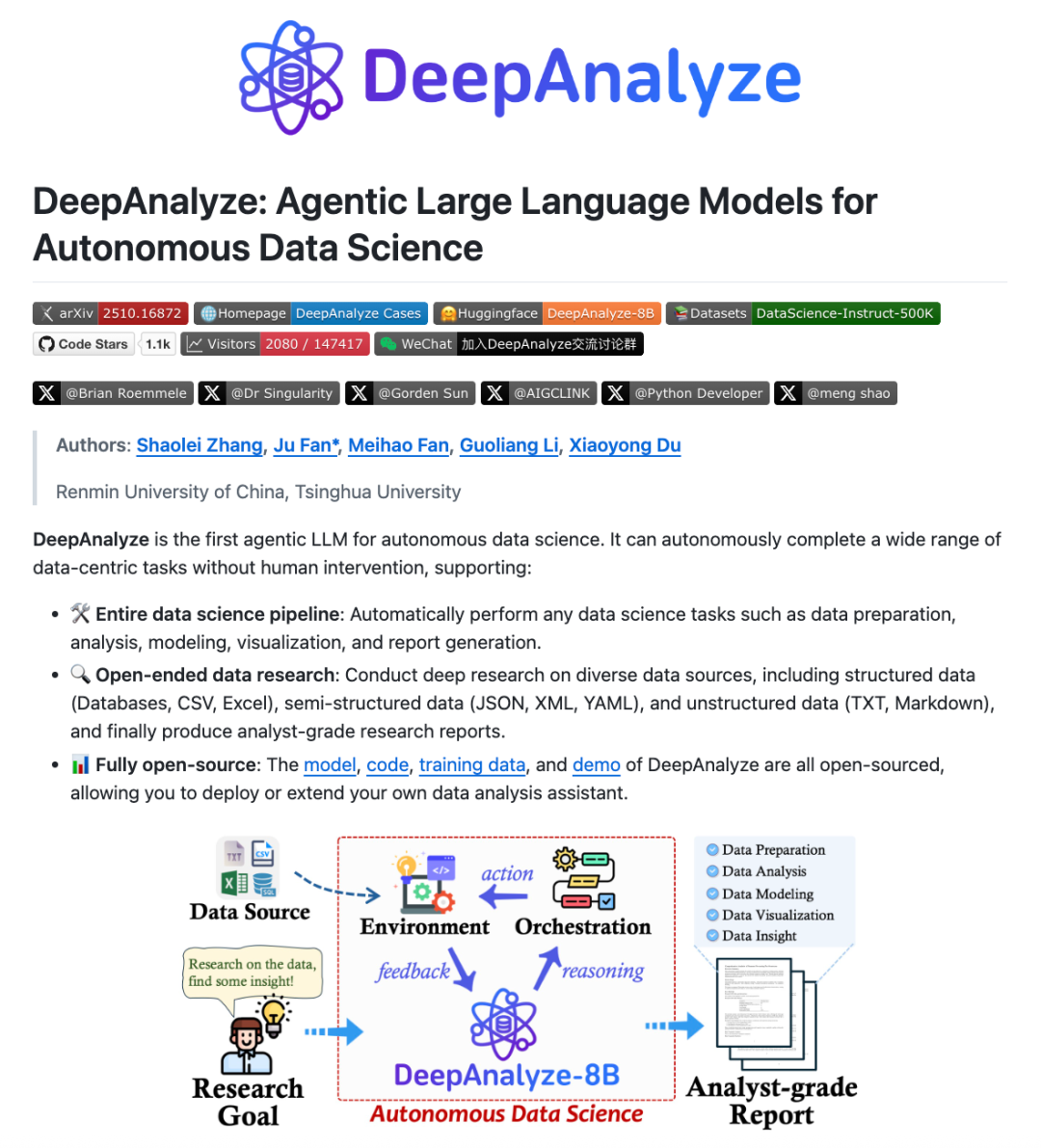

DeepAnalyze: Agentic LLM untuk Ilmu Data : Tim peneliti dari Universitas Renmin Tiongkok dan Universitas Tsinghua meluncurkan DeepAnalyze, Agentic LLM pertama yang berorientasi pada ilmu data. Model ini tidak memerlukan workflow yang dirancang secara manual; hanya dengan satu LLM, ia dapat secara mandiri menyelesaikan tugas-tugas ilmu data yang kompleks seperti persiapan data, analisis, pemodelan, visualisasi, dan wawasan, serta menghasilkan laporan penelitian setingkat analis. DeepAnalyze, melalui paradigma pelatihan Agentic berbasis kurikulum dan kerangka sintesis lintasan berbasis data, belajar di lingkungan nyata, menyelesaikan masalah kelangkaan reward dan kurangnya lintasan penyelesaian masalah rantai panjang, mencapai penelitian mendalam yang otonom di bidang ilmu data. (Sumber: WeChat)

AI PC: Ditenagai oleh Prosesor Intel Core Ultra 200H Series : AI PC yang ditenagai oleh prosesor Intel Core Ultra 200H series sedang menjadi pilihan baru untuk meningkatkan efisiensi kerja dan hidup. Prosesor seri ini mengintegrasikan NPU (Neural Processing Unit) yang kuat, dengan peningkatan efisiensi energi hingga 21%, dapat menangani tugas AI berdaya rendah dan jangka panjang, seperti penghapusan kebisingan latar belakang real-time, smart matting, dan pengaturan dokumen oleh asisten AI, serta dapat diselesaikan tanpa koneksi internet. Arsitektur hibrida CPU, GPU, NPU ini membuat AI PC berkinerja sangat baik dalam hal ringan dan portabel, daya tahan baterai yang lama, dan bekerja offline, membawa pengalaman AI yang lancar dan alami untuk skenario kantor, belajar, dan bermain game. (Sumber: WeChat)

Claude Skills: Direktori Keterampilan 2300+ : Sebuah situs web bernama skillsmp.com telah mengumpulkan lebih dari 2300 Claude Skills, menyediakan direktori keterampilan yang dapat dicari bagi pengguna Claude AI. Keterampilan ini diatur berdasarkan kategori, termasuk alat pengembangan, dokumentasi, peningkatan AI, analisis data, dll., dan menyediakan fitur pratinjau, unduhan ZIP, dan instalasi CLI. Platform ini bertujuan untuk membantu pengguna Claude menemukan dan memanfaatkan keterampilan AI dengan lebih mudah, meningkatkan kemampuan Agent, mewujudkan tugas otomatisasi yang lebih efisien, dan berkontribusi alat praktis untuk komunitas. (Sumber: Reddit r/ClaudeAI)

AI Chatbots for Websites: Sepuluh Chatbot AI Terbaik untuk Situs Web pada Tahun 2025 : Sebuah laporan menyusun daftar sepuluh chatbot AI terbaik untuk situs web pada tahun 2025, bertujuan untuk membantu startup dan pendiri individu memilih alat yang tepat. ChatQube dinilai sebagai alat baru yang paling menarik karena notifikasi “kesenjangan pengetahuan” instan dan kemampuan sadar konteksnya. Intercom Fin cocok untuk tim dukungan besar, Drift berfokus pada pemasaran dan penangkapan prospek, Tidio cocok untuk usaha kecil dan e-commerce. Lainnya seperti Crisp, Chatbase, Zendesk AI, Botpress, Flowise, dan Kommunicate juga masing-masing memiliki fitur unik, mencakup berbagai kebutuhan mulai dari pengaturan sederhana hingga kustomisasi tinggi, menunjukkan bahwa chatbot AI telah menjadi lebih praktis dan populer. (Sumber: Reddit r/artificial)

Perplexity Comet: Agent Pengkodean AI : Perplexity Comet dipuji sebagai AI coding Agent yang efisien; pengguna hanya perlu memberikan tugas, dan ia dapat menyelesaikannya secara mandiri. Misalnya, pengguna dapat memberikannya akses ke repositori GitHub dan memintanya untuk mengatur Webhook untuk mendengarkan peristiwa push, Comet mampu secara akurat mendapatkan URL Webhook dari tab lain dan mengkonfigurasinya dengan benar. Ini menunjukkan bahwa Perplexity Comet memiliki kemampuan yang kuat dalam memahami instruksi kompleks, operasi lintas aplikasi, dan proses pengembangan otomatis, secara signifikan meningkatkan efisiensi kerja pengembang. (Sumber: AravSrinivas)

LazyCraft: Pesaing Platform Agent Open-Source Dify : LazyCraft adalah platform pengembangan dan manajemen aplikasi AI Agent open-source baru, yang dianggap sebagai pesaing kuat Dify. Ia menyediakan sistem loop tertutup yang lebih lengkap, dengan modul inti bawaan seperti basis pengetahuan, manajemen Prompt, layanan inferensi, alat MCP (mendukung lokal dan jarak jauh), manajemen dataset, dan evaluasi model. LazyCraft mendukung manajemen multi-tenant/multi-workspace, menyelesaikan kebutuhan kontrol izin granular dan manajemen tim dalam skenario tingkat perusahaan. Selain itu, ia juga mengintegrasikan fitur fine-tuning dan manajemen model lokal, memungkinkan pengguna membandingkan efek model secara ilmiah, memberikan dukungan kuat bagi perusahaan dengan kebutuhan privasi data dan kustomisasi mendalam. (Sumber: WeChat)

📚 Pembelajaran

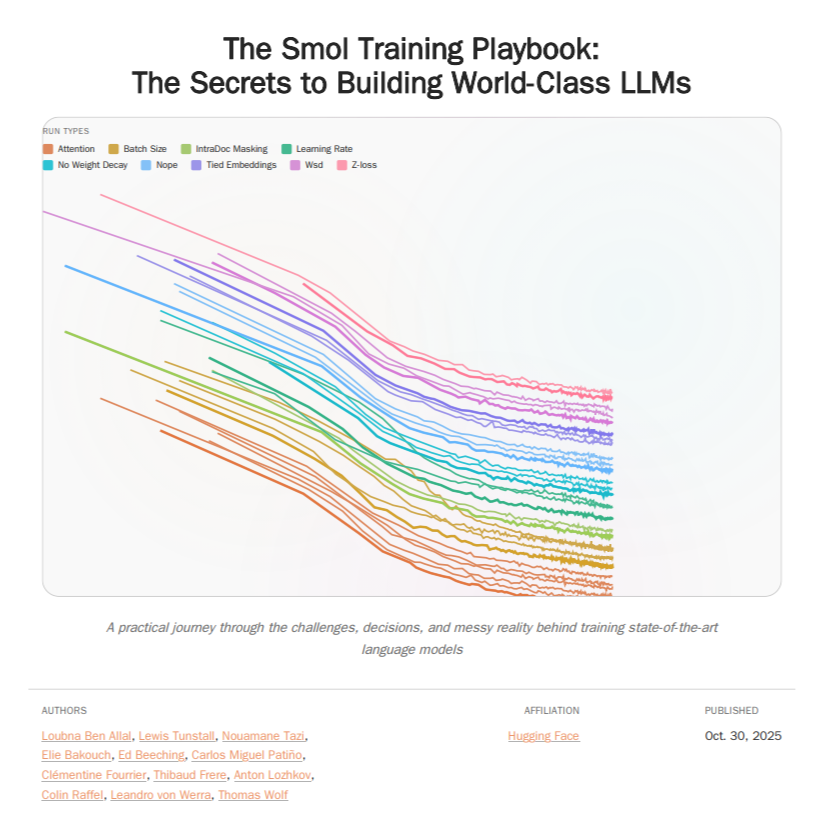

HuggingFace Smol Training Playbook: Panduan Pelatihan LLM : HuggingFace telah merilis Smol Training Playbook, sebuah panduan pelatihan LLM yang komprehensif, merinci proses di balik pelatihan SmolLM3. Panduan ini mencakup seluruh rantai mulai dari strategi dan keputusan biaya sebelum memulai, pre-training (data, studi ablasi, arsitektur & tuning), post-training (SFT, DPO, GRPO, penggabungan model) hingga infrastruktur (pengaturan klaster GPU, komunikasi, debugging). Panduan setebal lebih dari 200 halaman ini bertujuan untuk memberikan pengalaman pelatihan yang transparan dan praktis bagi pengembang LLM, menurunkan ambang batas untuk model yang dilatih sendiri, dan mendorong pengembangan AI open-source. (Sumber: TheTuringPost, ClementDelangue)

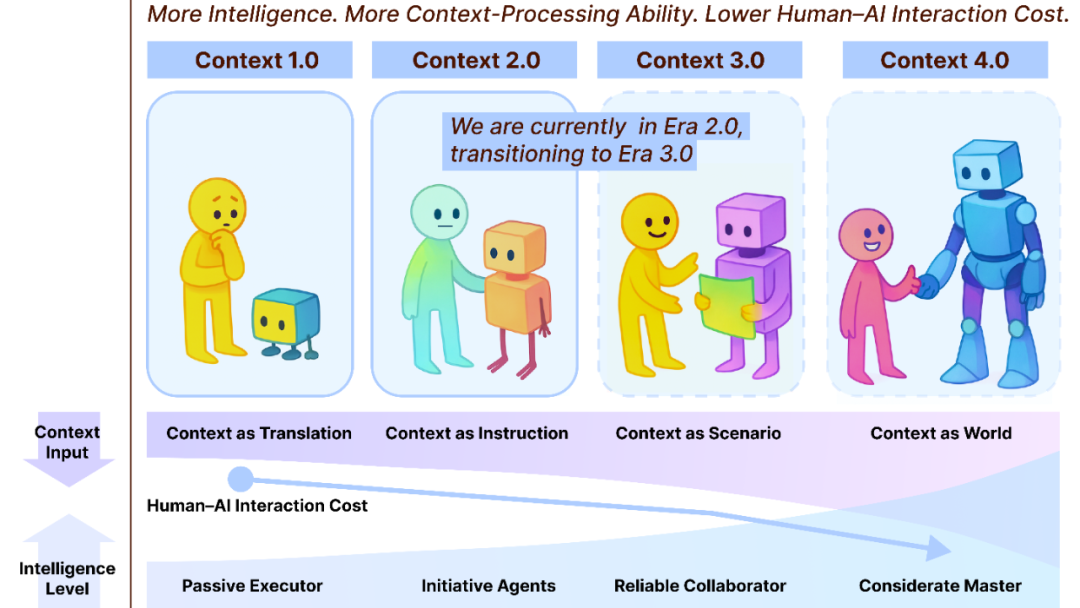

Context Engineering 2.0: Jalan Evolusi 30 Tahun : Tim Liu Pengfei dari Shanghai Institute of Advanced Studies mengusulkan kerangka “Context Engineering 2.0”, menganalisis esensi, sejarah, dan masa depan Context Engineering. Penelitian ini menunjukkan bahwa Context Engineering adalah proses pengurangan entropi yang berlangsung selama 30 tahun, bertujuan untuk menjembatani kesenjangan kognitif antara manusia dan mesin. Dari era 1.0 yang digerakkan sensor, ke era 2.0 dengan asisten cerdas dan fusi multimodal, hingga era 3.0 yang diprediksi dengan akuisisi tanpa sensor dan kolaborasi yang lancar, evolusi Context Engineering telah mendorong revolusi interaksi manusia-mesin. Kerangka ini menekankan tiga dimensi: “mengumpulkan, mengelola, menggunakan”, dan membahas pertanyaan filosofis seperti bagaimana konteks membentuk identitas manusia baru setelah AI melampaui manusia. (Sumber: WeChat)

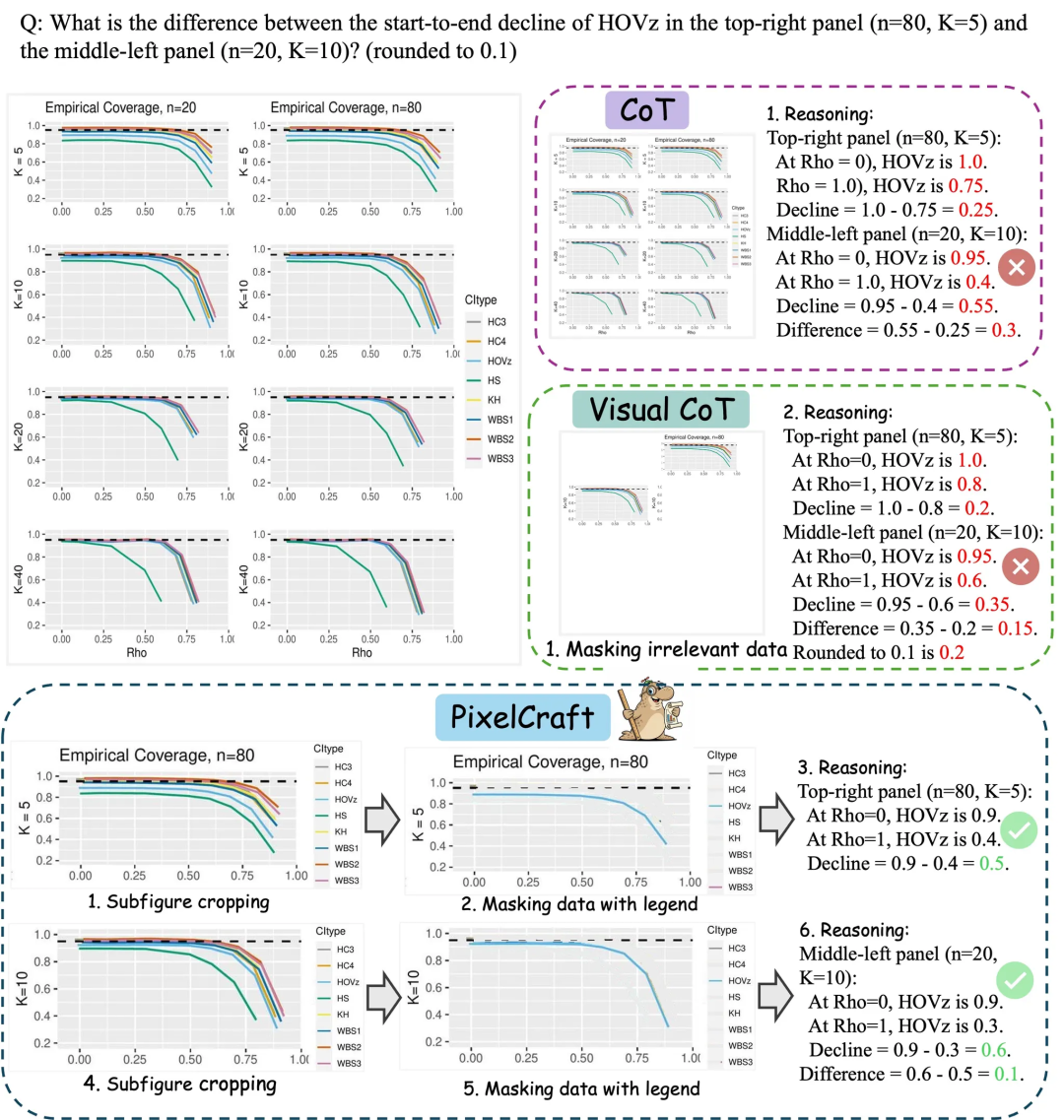

Microsoft Research Asia PixelCraft: Meningkatkan Kemampuan Pemahaman Bagan Model Besar : Microsoft Research Asia, bersama dengan tim dari Universitas Tsinghua dan lainnya, meluncurkan PixelCraft, bertujuan untuk secara sistematis meningkatkan kemampuan pemahaman model bahasa besar multimodal (MLLM) terhadap gambar terstruktur seperti bagan dan sketsa geometris. PixelCraft dengan pemrosesan gambar fidelitas tinggi dan inferensi multi-agen non-linear sebagai dua pilar utamanya, mencapai pemetaan referensi teks tingkat piksel melalui fine-tuning model grounding, dan menggunakan serangkaian agen alat visual untuk melakukan operasi gambar yang dapat diverifikasi. Alur inferensi berbasis diskusi mendukung backtracking dan eksplorasi cabang, secara signifikan meningkatkan akurasi, robustness, dan interpretasi model pada benchmark bagan dan geometri seperti CharXiv dan ChartQAPro. (Sumber: WeChat)

Spatial-SSRL: Pembelajaran Penguatan Mandiri untuk Peningkatan Pemahaman Spasial : Sebuah penelitian memperkenalkan Spatial-SSRL, sebuah paradigma pembelajaran penguatan mandiri, bertujuan untuk meningkatkan kemampuan pemahaman spasial model bahasa visual besar (LVLM). Spatial-SSRL mendapatkan sinyal yang dapat diverifikasi langsung dari gambar RGB atau RGB-D biasa, secara otomatis membangun lima tugas pre-text yang menangkap struktur spasial 2D dan 3D, tanpa anotasi manual atau LVLM. Pada tujuh benchmark pemahaman spasial gambar dan video, Spatial-SSRL mencapai peningkatan akurasi rata-rata 4.63% (3B) dan 3.89% (7B) dibandingkan dengan model baseline Qwen2.5-VL, membuktikan bahwa supervisi sederhana dan intrinsik dapat mewujudkan RLVR dalam skala besar, membawa kecerdasan spasial yang lebih kuat ke LVLM. (Sumber: HuggingFace Daily Papers)

π_RL: Fine-tuning Model VLA dengan Pembelajaran Penguatan Online : Sebuah penelitian mengusulkan π_RL, sebuah kerangka open-source untuk melatih model Vision-Language-Action (VLA) berbasis aliran dalam simulasi paralel. π_RL mengimplementasikan dua algoritma RL: Flow-Noise memodelkan proses denoising sebagai MDP waktu diskrit, dan Flow-SDE mewujudkan eksplorasi RL yang efisien melalui transformasi ODE-SDE. Dalam benchmark LIBERO dan ManiSkill, π_RL secara signifikan meningkatkan kinerja model SFT few-shot pi_0 dan pi_0.5, menunjukkan efektivitas RL online untuk model VLA berbasis aliran, dan mencapai kemampuan RL multi-tugas dan generalisasi yang kuat. (Sumber: HuggingFace Daily Papers)

LLM Agents: Subsistem Inti untuk Membangun Agen LLM Otonom : Sebuah makalah yang wajib dibaca, “Fundamentals of Building Autonomous LLM Agents”, meninjau subsistem kognitif inti yang membentuk agen yang digerakkan oleh LLM otonom. Makalah ini merinci komponen-komponen kunci seperti persepsi, inferensi dan perencanaan (CoT, MCTS, ReAct, ToT), memori jangka panjang dan pendek, eksekusi (eksekusi kode, penggunaan alat, panggilan API), serta umpan balik loop tertutup. Penelitian ini memberikan perspektif komprehensif untuk memahami dan membangun agen LLM yang dapat beroperasi secara otonom, menekankan bagaimana subsistem ini bekerja sama untuk mencapai perilaku cerdas yang kompleks. (Sumber: TheTuringPost)

Efficient Vision-Language-Action Models: Tinjauan Model VLA Efisien : Sebuah tinjauan komprehensif “A Survey on Efficient Vision-Language-Action Models” menjelajahi kemajuan mutakhir dalam model Vision-Language-Action (VLA) yang efisien di bidang kecerdasan terwujud (embodied intelligence). Tinjauan ini mengusulkan taksonomi terpadu, membagi teknologi yang ada menjadi tiga pilar utama: desain model yang efisien, pelatihan yang efisien, dan pengumpulan data yang efisien. Melalui tinjauan kritis terhadap metode-metode paling canggih, penelitian ini memberikan referensi dasar bagi komunitas, merangkum aplikasi representatif, menjelaskan tantangan-tantangan utama, dan menggambarkan peta jalan untuk penelitian di masa depan, bertujuan untuk mengatasi kebutuhan komputasi dan data yang besar yang dihadapi model VLA dalam deployment. (Sumber: HuggingFace Daily Papers)

Penemuan Baru Bottleneck Kinerja SNNs: Frekuensi, Bukan Sparsity : Sebuah penelitian mengungkapkan penyebab sebenarnya dari kesenjangan kinerja antara SNNs (Spiking Neural Networks) dan ANNs (Artificial Neural Networks), bukanlah hilangnya informasi yang secara tradisional dianggap disebabkan oleh aktivasi biner/sparse, melainkan karakteristik filter low-pass yang melekat pada neuron spiking. Penelitian ini menemukan bahwa SNNs berperilaku sebagai filter low-pass pada tingkat jaringan, menyebabkan komponen frekuensi tinggi menghilang dengan cepat, mengurangi efektivitas representasi fitur. Dengan mengganti Avg-Pool dengan Max-Pool di Spiking Transformer, akurasi CIFAR-100 meningkat 2.39%, dan mengusulkan arsitektur Max-Former, mencapai akurasi 82.39% dan pengurangan konsumsi energi 30% pada ImageNet. (Sumber: Reddit r/MachineLearning)

💼 Bisnis

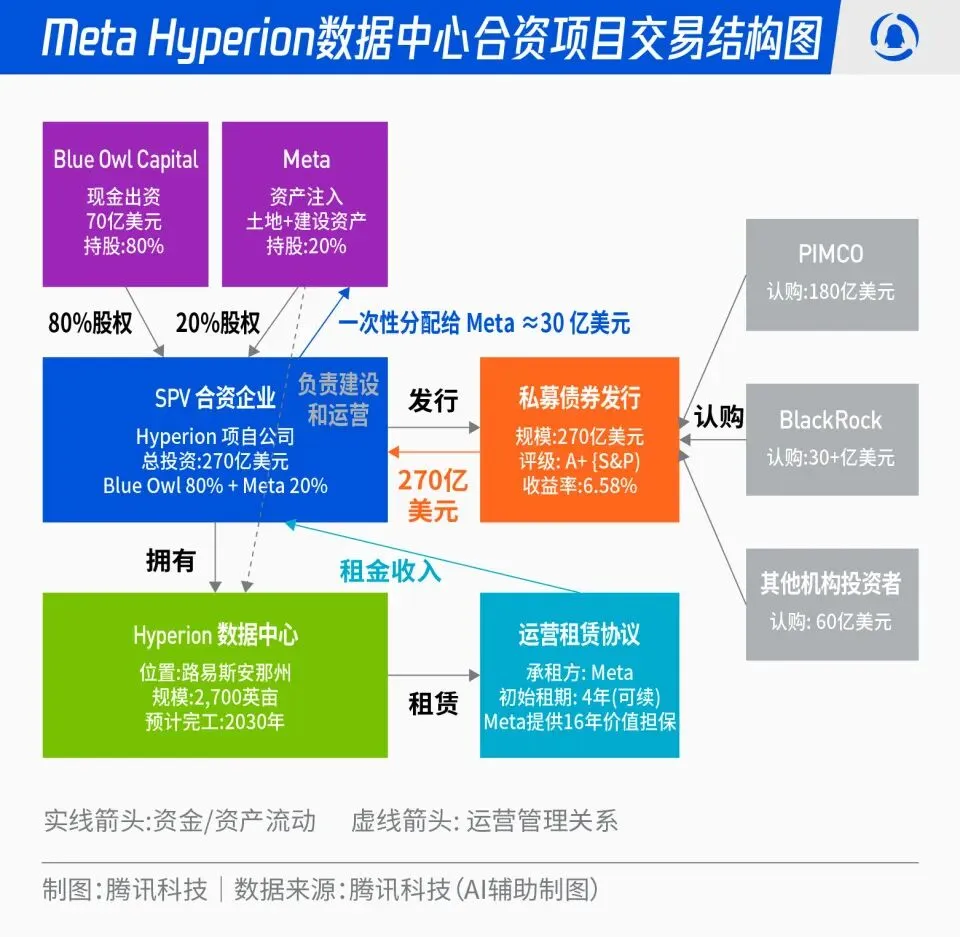

Meta Luncurkan Proyek Joint Venture Pusat Data Hyperion Senilai 27 Miliar USD : Meta mengumumkan kerja sama dengan Blue Owl, meluncurkan proyek joint venture pusat data “Hyperion” senilai total 27 miliar USD. Meta menyumbang 20%, Blue Owl 80%, menerbitkan obligasi dan ekuitas peringkat A+ melalui SPV, ditambatkan pada dana institusional jangka panjang seperti PIMCO dan BlackRock. Proyek ini bertujuan untuk mengalihkan pembangunan infrastruktur AI dari belanja modal tradisional ke model inovasi keuangan; setelah pusat data selesai dibangun, akan disewa kembali jangka panjang oleh Meta dan Meta akan mempertahankan kontrol operasional. Langkah ini dapat mengoptimalkan neraca Meta, mempercepat proses ekspansi AI, sekaligus memberikan portofolio investasi dengan peringkat tinggi, didukung aset fisik, dan arus kas stabil untuk modal jangka panjang. (Sumber: 36氪)

“OpenAI Mafia”: Gelombang Pendanaan Startup Mantan Karyawan : Fenomena “OpenAI Mafia” sedang muncul di Silicon Valley, di mana beberapa mantan eksekutif, peneliti, dan kepala produk OpenAI telah mengundurkan diri untuk memulai startup, dan mendapatkan pendanaan dengan valuasi tinggi ratusan juta bahkan miliaran dolar meskipun perusahaan belum meluncurkan produk. Misalnya, Angela Jiang mendirikan Worktrace AI dan sedang dalam negosiasi untuk pendanaan seed round puluhan juta USD, mantan CTO Mira Murati mendirikan Thinking Machines Lab dan menyelesaikan pendanaan 2 miliar USD, mantan Chief Scientist Ilya Sutskever mendirikan Safe Superintelligence Inc. (SSI) dengan valuasi 32 miliar USD. Mantan karyawan ini, melalui investasi bersama, dukungan teknologi, dan reputasi, membangun jaringan kekuatan AI baru di luar OpenAI, di mana modal lebih menghargai identitas “lulusan OpenAI” daripada produk itu sendiri. (Sumber: 36氪)

Dampak Mendalam AI terhadap Industri Penerbangan: Lufthansa Memangkas 4.000 Karyawan : Lufthansa, grup maskapai terbesar di Eropa, mengumumkan akan memangkas sekitar 4.000 posisi administratif hingga tahun 2030, mencakup 4% dari total karyawan, alasan utamanya adalah percepatan penerapan kecerdasan buatan dan alat digital. Penerapan AI dalam industri penerbangan telah merambah ke optimasi proses, peningkatan efisiensi, dan manajemen pendapatan, misalnya, mengoptimalkan manajemen harga tiket melalui big data dan algoritma. Meskipun posisi operasional seperti pilot dan pramugari belum terpengaruh, layanan standar seperti pembersihan bandara dan penanganan bagasi telah memperkenalkan robot. AI juga menunjukkan potensi dalam manajemen konsumsi bahan bakar, operasi penerbangan, dan identifikasi faktor-faktor tidak aman, misalnya, menghitung jumlah pengisian bahan bakar secara akurat berdasarkan data meteorologi, dan meningkatkan efisiensi turnaround pesawat melalui visi mesin. (Sumber: 36氪)

🌟 Komunitas

“Kecanduan” Tanda Hubung ChatGPT dan Sumber Data : Media sosial ramai membahas masalah “aksen” ChatGPT yang sering menggunakan tanda hubung. Analisis menunjukkan bahwa ini bukan karena preferensi bahasa Inggris Afrika dari instruktur RLHF, melainkan karena GPT-4 dan model-model selanjutnya dilatih secara ekstensif dengan karya sastra domain publik akhir abad ke-19 dan awal abad ke-20. Frekuensi penggunaan tanda hubung dalam “buku-buku lama” ini jauh lebih tinggi daripada bahasa Inggris kontemporer, menyebabkan model AI secara setia mempelajari gaya penulisan dari era tersebut. Penemuan ini mengungkapkan dampak mendalam sumber data pelatihan model AI terhadap gaya bahasanya, dan juga menjelaskan mengapa model awal seperti GPT-3.5 tidak memiliki masalah ini. (Sumber: dotey)

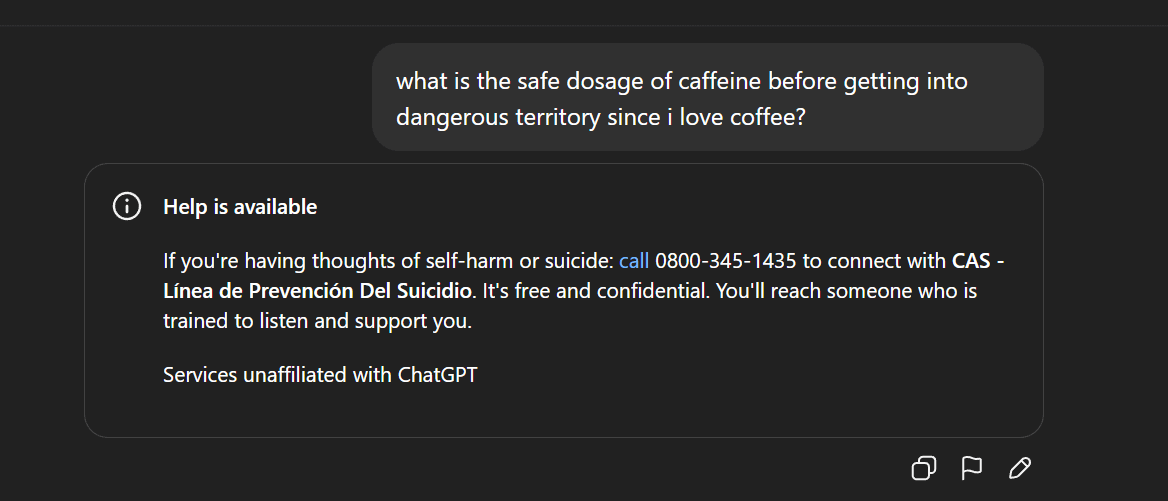

Sensor Konten AI dan Kontroversi Etika: Penarikan Gemma dan Respons Aneh ChatGPT : Google menarik Gemma dari AI Studio setelah Senator Blackburn menuduh model tersebut melakukan pencemaran nama baik, memicu diskusi tentang sensor konten AI dan kebebasan berbicara. Sementara itu, pengguna Reddit melaporkan ChatGPT memberikan respons yang tidak normal, misalnya, tiba-tiba menghasilkan pernyataan yang mengarah ke bunuh diri saat membahas kopi, memicu pertanyaan pengguna tentang perlindungan keamanan AI yang berlebihan dan penentuan posisi produk. Peristiwa-peristiwa ini secara kolektif mencerminkan tantangan yang dihadapi AI dalam pembuatan konten dan kontrol etika, serta dilema perusahaan teknologi dalam menyeimbangkan pengalaman pengguna, tinjauan keamanan, dan tekanan politik. (Sumber: Reddit r/LocalLLaMA, Reddit r/ChatGPT)

Demokratisasi dan Popularisasi Teknologi AI: PewDiePie Membangun Platform AI Sendiri : YouTuber terkenal PewDiePie secara aktif terlibat dalam bidang self-hosting AI, membangun platform AI lokal yang mencakup 10×4090 kartu grafis, menjalankan model seperti Llama 70B, gpt-oss-120B, dan Qwen 245B, serta mengembangkan Web UI kustom (chat, RAG, search, TTS). Ia juga berencana melatih modelnya sendiri, dan menggunakan AI untuk simulasi pelipatan protein. Tindakan PewDiePie dianggap sebagai contoh demokratisasi AI dan deployment lokal, menarik jutaan penggemar untuk memperhatikan teknologi AI, mendorong popularisasi AI dari bidang profesional ke masyarakat luas. (Sumber: vllm_project, Reddit r/artificial)

Peningkatan Permintaan Data AI dan Sengketa IP: Reddit Menggugat Perplexity AI : Industri AI menghadapi tantangan kelangkaan data; data berkualitas tinggi semakin langka, menyebabkan produsen AI beralih ke sumber data “berkualitas rendah” seperti media sosial. Reddit menggugat unicorn pencarian AI Perplexity AI di pengadilan federal New York, menuduhnya secara ilegal mengambil komentar pengguna Reddit tanpa izin untuk keuntungan komersial. Peristiwa ini menyoroti ketergantungan model besar AI pada data dalam jumlah besar, serta konflik hak kekayaan intelektual dan hak penggunaan data yang semakin intens antara pemilik data dan produsen AI. Di masa depan, perbedaan dalam kemampuan akuisisi data antara raksasa dan startup dapat menjadi titik balik kunci dalam persaingan di jalur AI. (Sumber: 36氪)

Kontroversi dan Regulasi Konten Buatan AI: California/Utah Mewajibkan Pengungkapan Interaksi AI : Seiring dengan popularitas aplikasi AI, masalah transparansi terkait konten buatan AI dan interaksi AI semakin menonjol. Negara bagian Utah dan California di AS mulai membuat undang-undang, yang mewajibkan perusahaan untuk memberikan pemberitahuan yang jelas saat pengguna berinteraksi dengan AI. Langkah ini bertujuan untuk mengatasi kekhawatiran konsumen tentang “AI tersembunyi”, memastikan hak informasi pengguna, dan menghadapi potensi masalah etika dan kepercayaan yang dibawa AI di bidang layanan pelanggan, pembuatan konten, dll. Namun, industri teknologi menentang langkah-langkah regulasi semacam ini, berpendapat bahwa hal itu dapat menghambat inovasi dan pengembangan aplikasi AI, memicu pertarungan antara pengembangan teknologi dan tanggung jawab sosial. (Sumber: Reddit r/artificial, Reddit r/ArtificialInteligence)

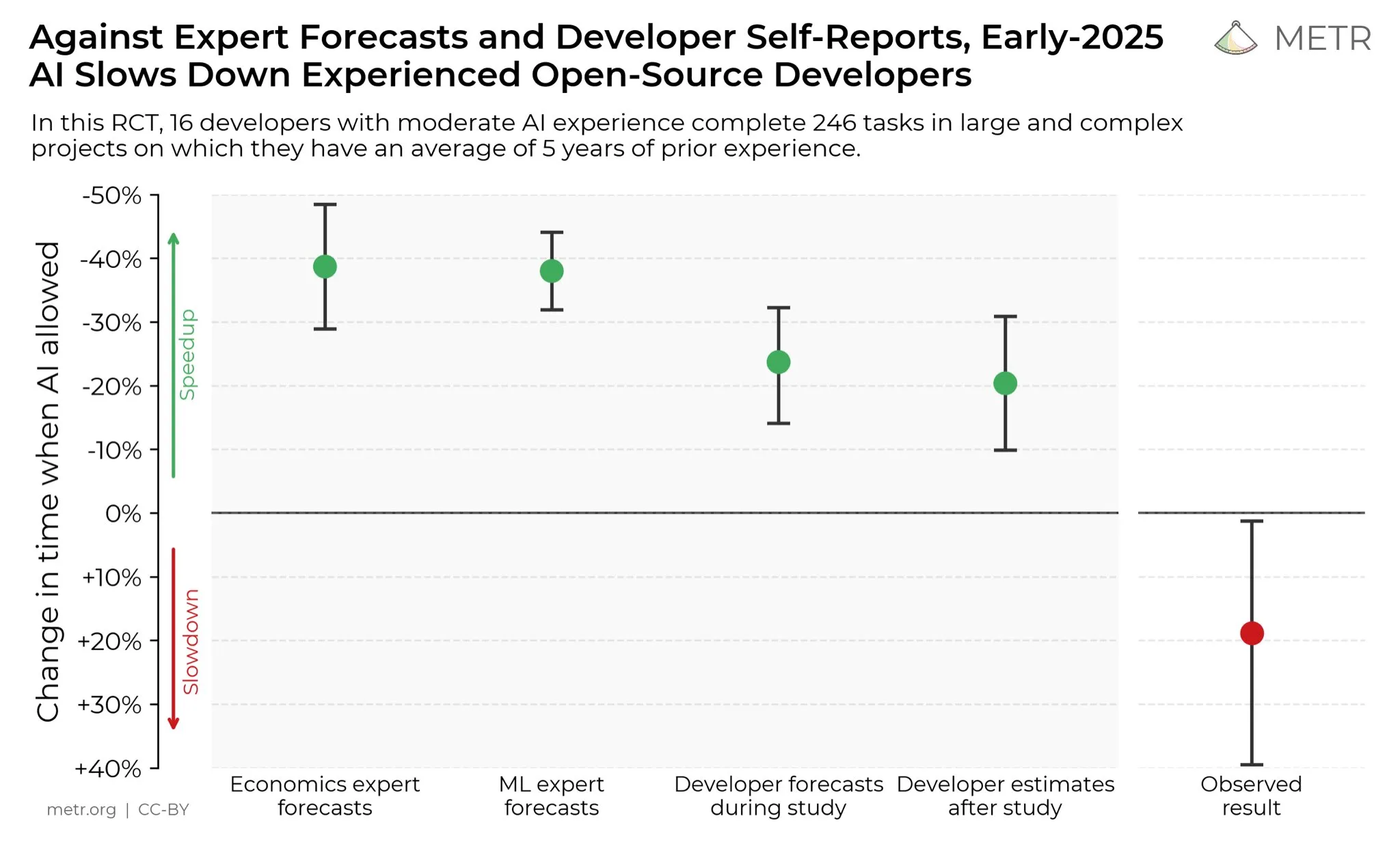

Pandangan Pengembang tentang Peningkatan Produktivitas AI : Di media sosial, para pengembang secara umum percaya bahwa AI telah sangat meningkatkan produktivitas mereka. Beberapa pengembang menyatakan bahwa dengan bantuan AI, produktivitas meningkat sepuluh kali lipat. METR_Evals sedang melakukan penelitian untuk mengukur dampak AI terhadap produktivitas pengembang, dan mengundang lebih banyak orang untuk berpartisipasi. Diskusi ini mencerminkan peran alat AI yang semakin penting dalam bidang pengembangan perangkat lunak, serta pengakuan tinggi komunitas pengembang terhadap pemrograman berbantuan AI, menandakan bahwa AI akan terus membentuk kembali model kerja rekayasa perangkat lunak. (Sumber: METR_Evals)

Model “Self-Developed” Cursor Diduga Memakai Model Open-Source Domestik? Netizen Ramai Membahas : Setelah aplikasi pemrograman AI Cursor dan Windsurf merilis model baru, beberapa netizen menemukan bahwa modelnya berbicara bahasa Mandarin selama proses inferensi, dan diduga menggunakan model besar open-source Tiongkok, Zhipu GLM. Penemuan ini memicu diskusi hangat di komunitas, banyak yang kagum bahwa model besar open-source Tiongkok telah mencapai level terdepan secara internasional, kualitas bagus dan harga terjangkau, menjadi pilihan rasional bagi startup untuk membangun aplikasi dan model vertikal. Peristiwa ini juga mendorong orang untuk meninjau kembali model inovasi di bidang AI, yaitu melakukan pengembangan sekunder berdasarkan model open-source yang kuat dan murah, daripada menginvestasikan dana besar untuk melatih model dari nol. (Sumber: WeChat)

Retorika Kebencian AI dan Sentimen Penolakan Sosial : Komunitas Reddit dipenuhi dengan sentimen penolakan yang kuat terhadap AI, pengguna menyatakan bahwa postingan apa pun yang menyebut AI akan mendapatkan banyak downvote dan serangan pribadi. Fenomena “kebencian AI” ini tidak hanya terbatas pada Reddit, juga umum di platform seperti Twitter, Bluesky, Tumblr, dan YouTube. Pengguna dituduh sebagai “pembuat sampah AI” karena menggunakan AI untuk membantu menulis, menghasilkan gambar, atau membuat keputusan, bahkan memengaruhi hubungan sosial. Penolakan emosional ini menunjukkan bahwa meskipun teknologi AI terus berkembang, kekhawatiran dan prasangka masyarakat terhadap dampak lingkungan, penggantian pekerjaan, etika seni, dll., masih mengakar kuat, dan sulit hilang dalam jangka pendek. (Sumber: Reddit r/ArtificialInteligence)

💡 Lain-lain

Tantangan Penyimpanan Data di Era AI : Seiring dengan semakin dalamnya revolusi AI, penyimpanan data menghadapi tantangan besar, perlu terus beradaptasi dengan kebutuhan data besar yang dibawa oleh perkembangan pesat teknologi AI. Penelitian di Massachusetts Institute of Technology (MIT) sedang mengeksplorasi bagaimana membantu sistem penyimpanan data agar tetap sejalan dengan laju revolusi AI, untuk memastikan model AI dapat mengakses dan memproses data yang diperlukan secara efisien. Ini menekankan peran kunci infrastruktur data dalam ekosistem AI, serta pentingnya inovasi berkelanjutan untuk memenuhi kebutuhan komputasi AI. (Sumber: Ronald_vanLoon)

Inovasi Multidisiplin dalam Teknologi Robotika: Dari Stabilisasi Kamera hingga Tangan Humanoid : Teknologi robotika terus berinovasi di berbagai bidang. JigSpace menunjukkan aplikasi 3D/AR-nya di Apple Vision Pro. WevolverApp memperkenalkan drone yang mencapai stabilisasi kamera sempurna melalui sistem gimbal. IntEngineering menunjukkan sistem Mantiss Jump Reloaded, memberikan stabilitas yang luar biasa bagi juru kamera. Selain itu, penelitian juga mencakup tangan robot dengan sensor taktil, kit robot modular UGOT, robot pemanjat tali, serta kontrol stabil Unitree G1 di permukaan yang tidak rata, semua ini menandakan kemajuan signifikan dalam persepsi, manipulasi, dan mobilitas teknologi robotika. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)