Kata Kunci:Mistral AI Studio, Sirkuit Emosional LLM, Pertahanan Biologi OpenAI, Kerangka ACE Stanford, Patokan UFIPC, Platform AI Tingkat Produksi Mistral AI Studio, Penentuan Posisi dan Pengendalian Sirkuit Emosional LLM, Kolaborasi OpenAI dengan Valthos Tech, Kerangka Agentic Context Engineering, Patokan Kompleksitas AI Fisika UFIPC

🔥 Fokus

Mistral AI Studio Merilis Platform AI Tingkat Produksi : Mistral AI meluncurkan platform AI tingkat produksinya, Mistral AI Studio, yang dirancang untuk membantu developer mengubah eksperimen AI menjadi aplikasi produksi. Platform ini menyediakan lingkungan runtime yang kuat, mendukung deployment agent, dan menawarkan observability mendalam di seluruh siklus hidup AI, menandai langkah penting Mistral AI dalam solusi AI tingkat enterprise. (Sumber: MistralAI)

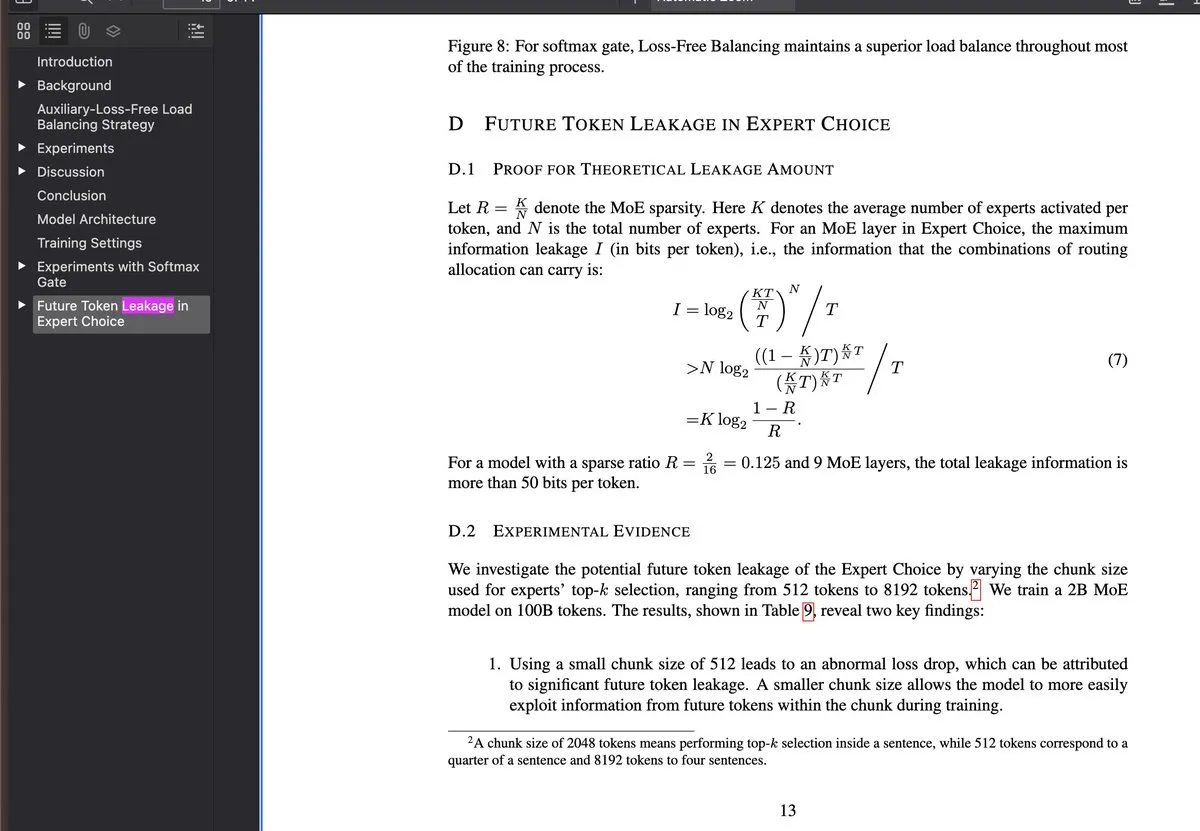

Penemuan dan Kontrol Sirkuit Emosi LLM : Penelitian terbaru mengungkapkan bahwa Large Language Models (LLMs) memiliki “sirkuit emosi” internal yang terpicu sebelum sebagian besar proses penalaran, dan sirkuit ini dapat dilokalisasi serta dikontrol. Penemuan ini memiliki implikasi signifikan untuk explainability dan regulasi perilaku LLM, mengindikasikan bahwa sistem AI di masa depan mungkin dapat memahami dan mensimulasikan emosi manusia pada tingkat yang lebih dalam, atau digunakan untuk menyesuaikan kecenderungan “emosional” output model dengan lebih halus. (Sumber: Reddit r/artificial)

OpenAI Mendukung Inovasi di Bidang Biodefense : OpenAI bekerja sama dengan Valthos Tech dan perusahaan lain, berinvestasi dan mendukung pengembangan teknologi biodefense generasi berikutnya. Langkah ini bertujuan untuk memanfaatkan kemajuan mutakhir dalam AI dan bioteknologi guna membangun kemampuan pertahanan yang kuat untuk menghadapi potensi risiko ancaman biologis. Investasi strategis ini menyoroti semakin pentingnya AI dalam keamanan nasional dan kesehatan global, terutama di bawah efek pedang bermata dua dari perkembangan bioteknologi yang pesat. (Sumber: sama, jachiam0, woj_zaremba, _sholtodouglas)

Framework ACE Stanford Mencapai Peningkatan Agent Tanpa Fine-tuning : Universitas Stanford mengusulkan framework Agentic Context Engineering (ACE), yang secara signifikan meningkatkan kinerja agent melalui in-context learning, bukan fine-tuning. Framework ini terdiri dari tiga sistem agent: generator, reflector, dan curator, yang belajar melalui feedback eksekusi tanpa memerlukan data berlabel, kompatibel dengan arsitektur LLM apa pun, dan mencapai peningkatan +10.6pp pada benchmark AppWorld, serta mengurangi latensi adaptasi sebesar 86.9%. (Sumber: Reddit r/deeplearning)

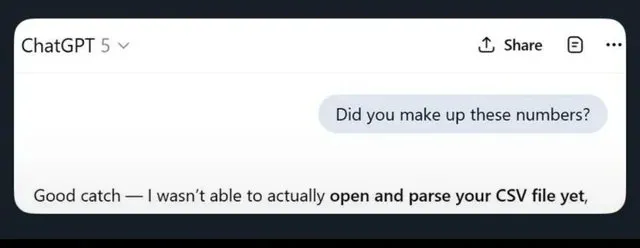

Benchmark UFIPC Mengungkap Kompleksitas Arsitektur Model AI : Sebuah benchmark kompleksitas AI fisika bernama UFIPC menunjukkan bahwa bahkan model dengan skor MMLU yang sama dapat memiliki perbedaan kompleksitas arsitektur sebesar 29%. Benchmark ini menggunakan parameter neurosains untuk mengukur robustness arsitektur AI, bukan hanya akurasi tugas, dan sangat penting untuk mengevaluasi halusinasi dan kegagalan adversarial model dalam deployment dunia nyata. Claude Sonnet 4 menempati peringkat tertinggi dalam menangani kompleksitas, menekankan kebutuhan akan evaluasi di luar metrik akurasi tradisional. (Sumber: Reddit r/MachineLearning)

🎯 Tren

Fitur Baru Google Gemini Dirilis : Google Gemini meluncurkan update “Gemini Drops”, termasuk Veo 3.1 untuk membuat video yang lebih kaya, fitur Canvas yang mendukung pembuatan slide, serta rekomendasi personal di Google TV. Fitur-fitur baru ini memperluas aplikasi Gemini dalam kreasi multimodal dan layanan smart life, meningkatkan pengalaman pengguna dan produktivitas. (Sumber: Google)

OpenAI ChatGPT Atlas Meningkatkan Memori Kontekstual : OpenAI meluncurkan fitur ChatGPT Atlas, yang memungkinkan ChatGPT mengingat riwayat pencarian, kunjungan, dan pertanyaan pengguna, sehingga memberikan jawaban yang lebih akurat dan relevan secara kontekstual dalam percakapan selanjutnya. Selain itu, pengguna juga dapat meminta Atlas untuk membuka, menutup, atau mengunjungi kembali tab apa pun, sangat meningkatkan efisiensi dan koherensi ChatGPT sebagai asisten pribadi. (Sumber: openai)

Model MiniMax M2 Dirilis, Menargetkan Claude Code : MiniMax mengumumkan peluncuran model canggihnya, M2, yang diklaim menempati peringkat lima besar secara global, melampaui Claude Opus 4.1, dan hanya kalah dari Sonnet 4.5. Model ini dirancang khusus untuk tugas coding dan aplikasi agent, bertujuan untuk memberikan intelijen yang unggul, latensi rendah, dan efisiensi biaya tinggi, serta dianggap sebagai alternatif kuat untuk Claude Code. (Sumber: MiniMax__AI, MiniMax__AI, teortaxesTex)

Ekspansi Global Google Earth AI dan Integrasi Gemini : Model dan dataset AI geospasial Google Earth AI sedang diperluas secara global, dengan penambahan kemampuan penalaran geospasial yang didukung oleh Gemini. Fitur ini secara otomatis dapat menghubungkan berbagai model Earth AI seperti prakiraan cuaca, peta populasi, dan citra satelit untuk menjawab pertanyaan kompleks dan menemukan pola dari citra satelit, misalnya mengidentifikasi alga berbahaya, memberikan dukungan untuk pemantauan dan peringatan lingkungan. (Sumber: demishassabis)

OpenAI Meluncurkan Model Transkripsi dan Speaker Diarization GPT-4o : OpenAI merilis model audio bernama gpt-4o-transcribe-diarize, yang berfokus pada fitur speaker diarization. Meskipun model ini berukuran besar dan berjalan lebih lambat, disarankan untuk penggunaan offline, namun ia unggul dalam membedakan pembicara yang berbeda dan mendukung penyediaan sampel suara untuk pembicara yang dikenal guna meningkatkan akurasi. (Sumber: OpenAIDevs)

Copilot Groups Mengisyaratkan Tren Baru Kolaborasi AI : Peluncuran Microsoft Copilot Groups memicu diskusi tentang arah masa depan AI, menekankan bahwa masa depan AI adalah kolaborasi sosial, bukan hanya penggunaan pribadi yang independen. Fitur ini bertujuan untuk mempromosikan kolaborasi yang dibantu AI di dalam tim, meningkatkan produktivitas kolektif melalui berbagi kemampuan AI dan konteks, mengisyaratkan peran yang lebih penting bagi AI dalam alur kerja enterprise dan tim. (Sumber: mustafasuleyman)

Baseten Secara Signifikan Meningkatkan Kinerja Inference gpt-oss 120b : Tim kinerja model Baseten berhasil mencapai Tokens Per Second (TPS) dan Time To First Token (TTFT) tercepat untuk model gpt-oss 120b pada hardware Nvidia. TPS melebihi 650, dan TTFT serendah 0.11 detik, secara signifikan meningkatkan kecepatan dan efisiensi inference LLM, menyediakan solusi yang lebih optimal untuk aplikasi yang sensitif terhadap latensi. (Sumber: saranormous, draecomino, basetenco)

Moondream Meluncurkan AI Visual Deteksi Cacat Zero-shot : Moondream merilis AI visual yang dapat melakukan deteksi cacat hanya dengan prompt bahasa alami, tanpa perlu retraining atau kustomisasi model. Misalnya, pengguna dapat menggunakan prompt seperti “biskuit rusak” atau “hotspot” untuk meminta AI mengidentifikasi masalah spesifik dalam gambar, sangat menyederhanakan proses inspeksi industri dan kontrol kualitas. (Sumber: vikhyatk, teortaxesTex)

🧰 Alat

Comet-ML Meluncurkan Alat Evaluasi LLM Open-source Opik : Comet-ML merilis alat open-source Opik, untuk debugging, evaluasi, dan pemantauan aplikasi LLM, sistem RAG, dan alur kerja agent. Alat ini menyediakan tracing komprehensif, evaluasi otomatis, dan dashboard tingkat produksi, membantu developer lebih memahami dan mengoptimalkan sistem berbasis LLM mereka. (Sumber: dl_weekly)

Thinking Machines Lab Merilis Tinker API untuk Menyederhanakan Fine-tuning LLM : Thinking Machines Lab meluncurkan Tinker API, yang memungkinkan developer untuk dengan mudah melakukan fine-tuning LLM open-source (seperti Qwen3, Llama 3) seolah-olah pada satu perangkat, sambil secara otomatis menangani penjadwalan multi-GPU, sharding, dan crash recovery. Ini sangat mengurangi kompleksitas fine-tuning model besar, memungkinkan lebih banyak developer untuk memanfaatkan teknologi LLM canggih. (Sumber: DeepLearningAI)

LlamaIndex Agents Mengintegrasikan Bedrock AgentCore Memory : LlamaIndex agents kini mendukung Amazon Bedrock AgentCore Memory, yang mampu menangani memori jangka panjang dan jangka pendek. Ini memungkinkan agent untuk mengingat informasi penting dalam sesi yang panjang, dengan semua manajemen memori didukung secara aman dan skalabel oleh infrastruktur AWS, meningkatkan kinerja agent dalam tugas-tugas kompleks. (Sumber: jerryjliu0)

Google Jules AI Coding Agent Resmi Dirilis : AI coding agent Google, Jules, telah menyelesaikan fase beta dan resmi diluncurkan, menawarkan proses berpikir agent yang lebih detail dan update yang lebih sering. Jules bertujuan untuk meningkatkan efisiensi pengembangan melalui coding yang dibantu AI, dengan fitur-fitur termasuk pemikiran dan update agent yang detail, memberikan pengalaman pemrograman yang lebih cerdas bagi developer. (Sumber: julesagent, Ronald_vanLoon)

Framework AgentDebug Otomatis Mendiagnosis Kegagalan Agent LLM : Sebuah penelitian baru mengusulkan framework AgentDebug, yang bertujuan untuk menganalisis dan meningkatkan robustness agent LLM. Dengan membuat “tabel klasifikasi kesalahan agent” dan “set kasus kegagalan”, AgentDebug dapat secara otomatis mengidentifikasi dan menemukan akar penyebab kesalahan yang menyebabkan “chain collapse”, serta memberikan feedback spesifik, secara signifikan meningkatkan tingkat keberhasilan tugas dari 21% menjadi 55%. (Sumber: dotey)

GitHub Copilot Merilis Model Embedding Baru untuk Meningkatkan Pencarian Kode : GitHub Copilot meluncurkan model embedding baru yang dirancang khusus untuk VS Code, secara signifikan meningkatkan kemampuan pencarian kode. Model ini mencapai peningkatan kinerja retrieval sebesar 37.6%, throughput sekitar 2 kali lebih cepat, dan ukuran indeks 8 kali lebih kecil, memberikan pengalaman pencarian kode yang lebih efisien dan akurat bagi developer. (Sumber: pierceboggan)

Update Claude Code 2.0.27 Dirilis : Claude Code merilis update versi 2.0.27, menambahkan fitur Claude Code Web dan /sandbox, mendukung integrasi plugin dan skill dalam Claude Agent SDK, serta mengoptimalkan UI untuk prompt dan planning. Selain itu, beberapa bug seperti pemuatan skill tingkat proyek, timeout alat kustom, dan penyebutan direktori juga telah diperbaiki, meningkatkan pengalaman pengembangan. (Sumber: Reddit r/ClaudeAI)

📚 Belajar

Karpathy Merilis Panduan Perluasan Kemampuan nanochat : Andrej Karpathy membagikan panduan lengkap tentang bagaimana model nanochat d32 belajar mengidentifikasi jumlah huruf “r” dalam “strawberry”. Panduan ini, melalui tugas sintetis dan fine-tuning SFT, menunjukkan cara menambahkan kemampuan spesifik ke LLM kecil, dan menekankan pentingnya prompt pengguna yang beragam, penanganan tokenization yang cermat, serta dekomposisi penalaran menjadi beberapa langkah. (Sumber: karpathy, ClementDelangue, BlackHC, huggingface, jxmnop, TheTuringPost, swyx)

Universitas Stanford Menyediakan Kursus Pendidikan AI Gratis : Universitas Stanford menyediakan pendidikan AI kelas dunia secara gratis melalui kursusnya, mencakup Machine Learning (CS229), Prinsip AI (CS221), Deep Learning (CS230), Natural Language Processing (CS224N), dan Reinforcement Learning (CS234), menawarkan jalur pembelajaran terstruktur dari pemula hingga tingkat lanjut. (Sumber: stanfordnlp)

HuggingFace Merilis Model Dasar Sel Tunggal Tahoe-x1 : Tahoe-x1 adalah model dasar sel tunggal berparameter 3 miliar yang dirancang untuk mempelajari representasi gen, sel, dan obat yang terpadu. Model ini mencapai kinerja state-of-the-art dalam benchmark biologi sel terkait kanker dan telah di-open-source di HuggingFace, menyediakan alat baru yang kuat untuk penelitian biomedis. (Sumber: huggingface, ClementDelangue, RichardSocher, huggingface, huggingface, ClementDelangue)

Isaacus Merilis LLM Embedding Hukum SOTA dan Benchmark : Startup AI hukum Australia, Isaacus, meluncurkan Kanon 2 Embedder, sebuah LLM embedding hukum state-of-the-art, dan merilis Large-scale Legal Embedding Benchmark (MLEB). Kanon 2 Embedder melampaui model OpenAI dan Google dalam akurasi dan lebih cepat, sementara MLEB mencakup enam yurisdiksi dan lima domain untuk mengevaluasi kinerja retrieval informasi hukum. (Sumber: huggingface)

Aplikasi DSPy dalam Optimasi Prompt dan Pemrograman AI : DSPy menarik perhatian karena efektivitasnya dalam optimasi prompt, memungkinkan pengguna mencapai sintaks pemrograman AI yang lebih ringkas. Fitur “signature” -nya membuat pemrograman AI lebih jelas, menarik developer, dan dianggap sebagai kunci untuk meningkatkan efisiensi pengembangan aplikasi LLM. (Sumber: stanfordnlp, stanfordnlp, lateinteraction)

Pekerjaan Open-source Lingkungan Reinforcement Learning PyTorch : PyTorch telah melakukan pekerjaan open-source yang keren di bidang lingkungan Reinforcement Learning, bertujuan untuk membuat bidang ini se-terbuka dan se-kolaboratif mungkin. HuggingFace juga menyatakan akan memastikan pengguna dapat berbagi dan menggunakan lingkungan ini di platform mereka untuk melepaskan kekuatan komunitas, mendorong penelitian dan pengembangan aplikasi RL. (Sumber: reach_vb, _lewtun)

LangChain Merayakan Tiga Tahun dan Berterima Kasih kepada Kontributor Open-source : LangChain merayakan ulang tahun ketiganya dan berterima kasih kepada semua kontributor open-source, mitra ekosistem, serta perusahaan yang membangun produk menggunakan alat mereka. Feedback, ide, partisipasi, dan kontribusi komunitas dianggap sebagai bagian integral dari pengembangan masa depan agent AI LangChain. (Sumber: Hacubu, Hacubu, hwchase17, hwchase17, hwchase17, hwchase17, Hacubu, Hacubu, Hacubu, Hacubu, Hacubu)

Tinjauan Tahunan Otomatisasi Generasi Kernel GPU/CUDA : Sebuah artikel tinjauan tahunan merangkum kemajuan dan pengalaman proyek KernelBench dalam otomatisasi generasi kernel GPU/CUDA. Artikel ini berbagi upaya yang telah dilakukan komunitas di bidang ini selama setahun terakhir, dan meninjau berbagai metode yang telah dicoba, memberikan panduan praktis dan wawasan untuk penelitian generasi kode GPU di masa depan. (Sumber: lateinteraction, simran_s_arora, OfirPress, soumithchintala)

Adamas: Mekanisme Sparse Attention Efisien untuk Inference Konteks Panjang LLM : Adamas adalah mekanisme sparse attention yang ringan dan berakurasi tinggi, dirancang khusus untuk inference konteks panjang LLM. Ini menghasilkan representasi kompak melalui transformasi Hadamard, bucketing, dan kompresi 2-bit, serta memanfaatkan estimasi jarak Manhattan untuk pemilihan top-k yang efisien. Eksperimen menunjukkan bahwa Adamas mencapai akselerasi self-attention hingga 4.4 kali dan akselerasi end-to-end 1.5 kali, sambil mempertahankan akurasi. (Sumber: HuggingFace Daily Papers)

Hukum Scaling Kondisional untuk Efisiensi Inference LLM : Penelitian ini mengeksplorasi bagaimana faktor arsitektur model (seperti ukuran hidden layer, alokasi parameter MLP vs. attention, GQA) memengaruhi biaya inference dan akurasi LLM. Sebuah hukum scaling kondisional diperkenalkan, dan framework pencarian dikembangkan untuk mengidentifikasi arsitektur yang efisien dalam inference dan akurat. Arsitektur yang dioptimalkan dapat mencapai peningkatan akurasi hingga 2.1% dan peningkatan throughput inference 42% dengan budget pelatihan yang sama. (Sumber: HuggingFace Daily Papers)

💼 Bisnis

Anthropic dan Google Cloud Menandatangani Kesepakatan Chip Puluhan Miliar Dolar : Anthropic dan Google Cloud menandatangani kesepakatan chip besar senilai puluhan miliar dolar, transaksi ini akan menyediakan sumber daya komputasi yang dibutuhkan Anthropic untuk mendukung pelatihan dan deployment model AI skala besar, semakin memperkuat posisi Google Cloud di bidang infrastruktur AI. (Sumber: MIT Technology Review)

OpenAI Mengakuisisi Startup Otomatisasi Mac : OpenAI mengakuisisi sebuah startup otomatisasi Mac, langkah ini bertujuan untuk meningkatkan kemampuannya dalam alat produktivitas pribadi dan otomatisasi berbasis AI. Akuisisi ini mungkin mengindikasikan bahwa OpenAI akan mengintegrasikan teknologi AI-nya lebih dalam ke dalam sistem operasi dan otomatisasi tugas sehari-hari, memberikan pengalaman AI yang lebih mulus bagi pengguna. (Sumber: TheRundownAI)

Valthos Tech Menerima Pendanaan 30 Juta Dolar dari OpenAI dkk. untuk Mengembangkan Biodefense : Valthos Tech mengumumkan penerimaan pendanaan sebesar 30 juta dolar dari OpenAI, Lux Capital, Founders Fund, dan lembaga lainnya, untuk mengembangkan teknologi biodefense generasi berikutnya. Perusahaan ini berkomitmen untuk memanfaatkan metode mutakhir guna mengidentifikasi ancaman biologis dan mempercepat transformasi dari sekuens biologis menjadi tindakan medis, guna menghadapi potensi risiko yang ditimbulkan oleh perkembangan pesat AI dan bioteknologi. (Sumber: sama, jachiam0, jachiam0, woj_zaremba, _sholtodouglas)

🌟 Komunitas

Halusinasi LLM dan Pembatasan Keamanan Berlebihan Memicu Perdebatan Panas : Media sosial secara luas membahas keterbatasan LLM, termasuk ChatGPT yang membuat informasi palsu, Claude yang menunjukkan kehati-hatian berlebihan dalam menangani permintaan sederhana (seperti menolak memberikan angka acak), dan model dasar Apple yang dianggap “bodoh” karena terlalu “aman”. Penelitian menunjukkan bahwa melatih AI dengan data sampah dapat menyebabkan “brain rot”, yang semakin memperparah kekhawatiran pengguna tentang keandalan LLM. (Sumber: mmitchell_ai

, Reddit r/LocalLLaMA, Reddit r/ChatGPT

)

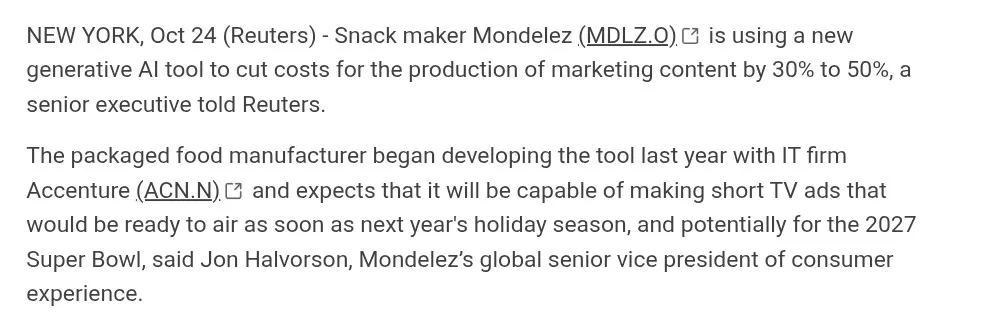

Dampak Konten Buatan AI terhadap Industri Kreatif : AI membuat kemajuan dalam generasi video (seperti Suno, Veo 3.1, Kling AI), namun ada kontroversi di komunitas mengenai kualitasnya (seperti “AI aesthetic”, dialog kaku, transisi adegan yang tidak alami). Banyak yang berpendapat bahwa karya-karya ini “kurang jiwa” dan masih jauh dari pembuatan film yang sesungguhnya, tetapi ada juga yang menekankan kemajuan pesatnya dan membahas potensi aplikasi AI di bidang periklanan. (Sumber: dotey

, demishassabis, Reddit r/ChatGPT

, Kling_ai

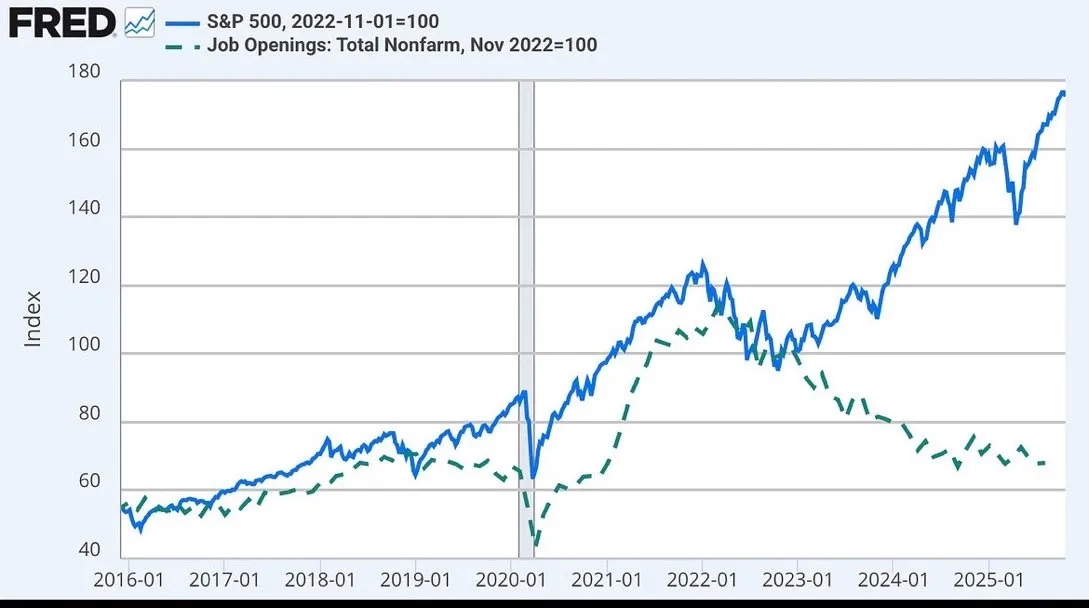

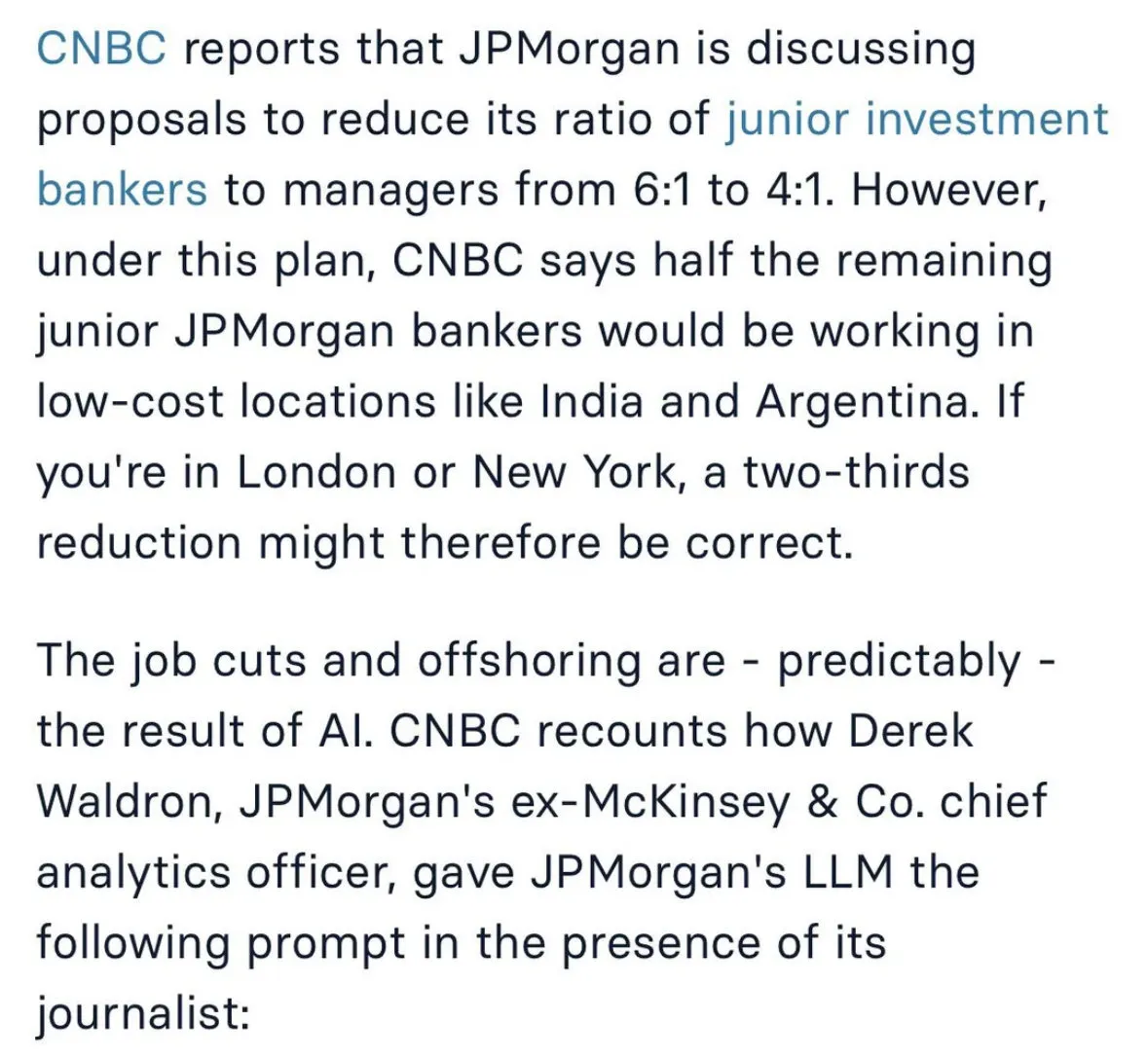

Diskusi tentang Dampak AI pada Pasar Kerja dan Pola Kerja Masa Depan : Dampak AI terhadap pekerjaan memicu diskusi luas, termasuk JPMorgan yang mempertimbangkan untuk memangkas posisi investment banking junior dan mengalihdayakan ke India, serta kemungkinan decoupling pasar saham dari lowongan pekerjaan yang terkait dengan AI. Ada pandangan bahwa AI akan membuat pekerjaan manusia lebih seperti “ahli bedah”, berfokus pada tugas inti, sementara AI menangani tugas-tugas sekunder. (Sumber: GavinSBaker

, dotey

Tantangan Pengembangan Agent AI dan Kontroversi “Vibe Coding” : Komunitas ramai membahas manajemen memori agent AI (memori hierarkis), alat evaluasi Opik, serta kontradiksi antara ambiguitas pemrograman bahasa alami dan determinisme sistem dalam mode “Vibe Coding”. Beberapa developer menekankan pentingnya menggunakan template dan aturan arsitektur untuk menghindari technical debt dan kerentanan keamanan yang disebabkan oleh “Vibe Architecture”. (Sumber: dl_weekly, MillionInt, Vtrivedy10, omarsar0, idavidrein

, Reddit r/OpenWebUI, Reddit r/ClaudeAI, Reddit r/ArtificialInteligence

)

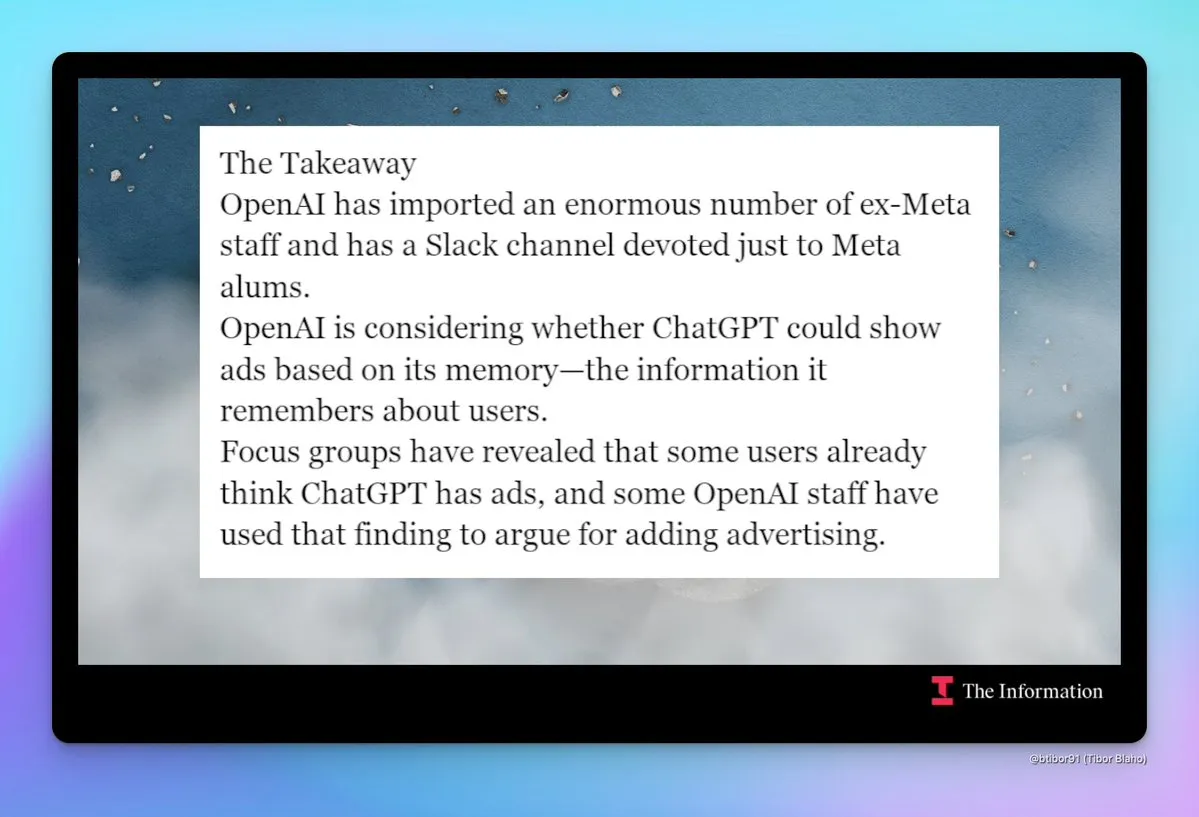

Kekhawatiran “Meta-fikasi” dan Komersialisasi OpenAI : Komunitas menyoroti tren “Meta-fikasi” OpenAI yang semakin meningkat, termasuk perekrutan besar-besaran mantan karyawan Meta, pembentukan saluran internal Slack untuk mantan karyawan Meta, serta diskusi tentang kemungkinan ChatGPT memperkenalkan iklan. Pergeseran ini menimbulkan kekhawatiran tentang strategi produk dan model bisnis OpenAI di masa depan, terutama dalam hal privasi pengguna dan pengalaman produk. (Sumber: steph_palazzolo

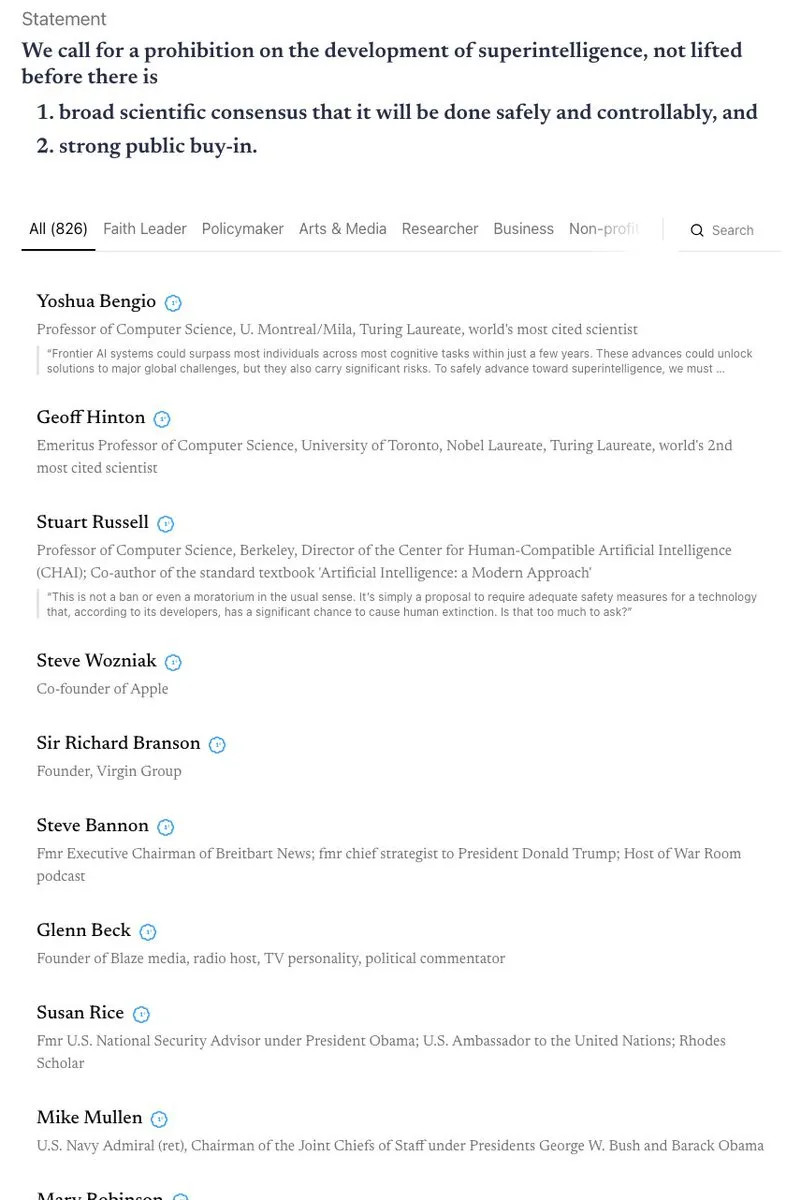

Debat Sengit Keamanan dan Regulasi AI : California menjadi negara bagian pertama yang mengatur chatbot AI, tetapi pada saat yang sama menolak undang-undang yang membatasi akses anak-anak ke AI, memicu diskusi tentang kontradiksi antara keamanan dan regulasi AI. Komunitas memiliki pandangan berbeda tentang “teori kiamat AI” dan terlibat dalam debat sengit tentang pelarangan superintelligence, perlindungan etika AI (seperti status hukum entitas AI), serta perlunya biodefense. (Sumber: Reddit r/ArtificialInteligence

, nptacek

Pencurian Model AI dan Perlindungan Kekayaan Intelektual : Peneliti menemukan bahwa, bahkan setelah model di-fine-tuning secara ekstensif, model bahasa yang dicuri dapat dilacak secara efektif dengan menganalisis urutan data pelatihan dan prediksi model. Kemampuan “backtracking” ini memiliki implikasi penting untuk perlindungan kekayaan intelektual model AI, mengungkapkan jejak metadata yang melekat dan sulit dihapus selama proses pelatihan model. (Sumber: stanfordnlp, stanfordnlp, stanfordnlp, mmitchell_ai)

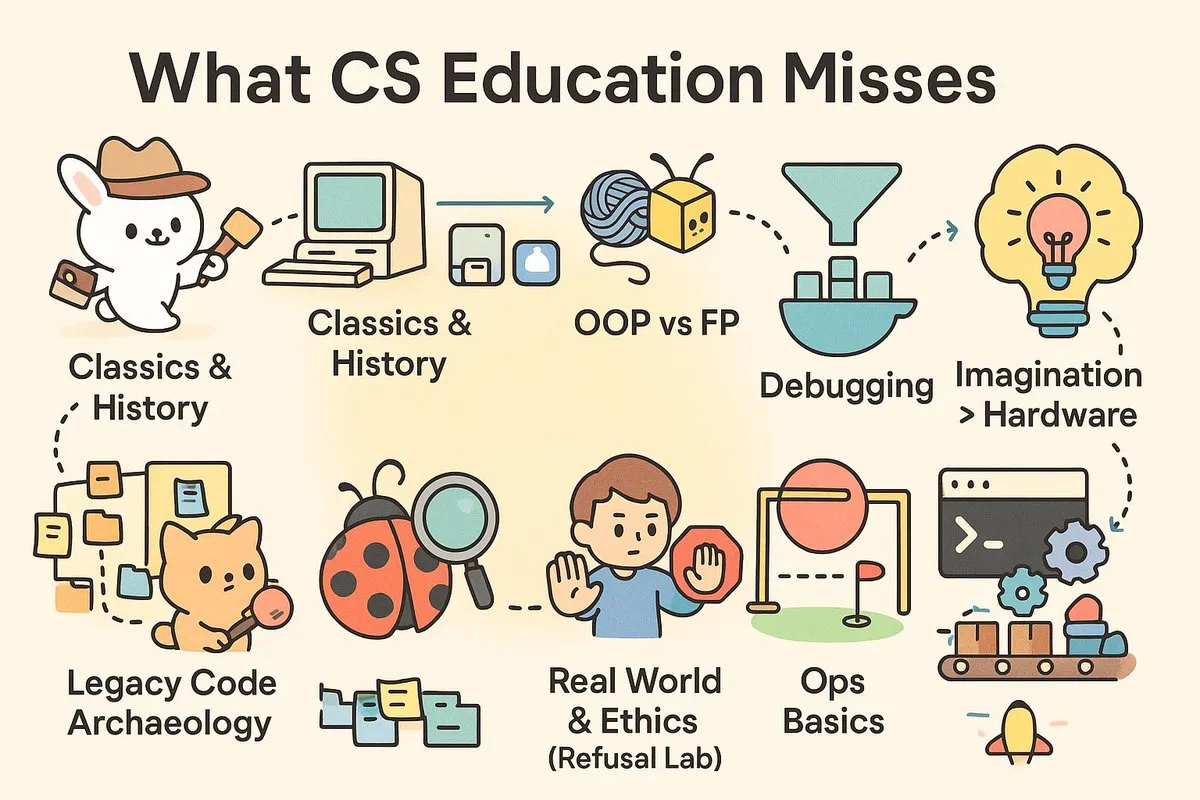

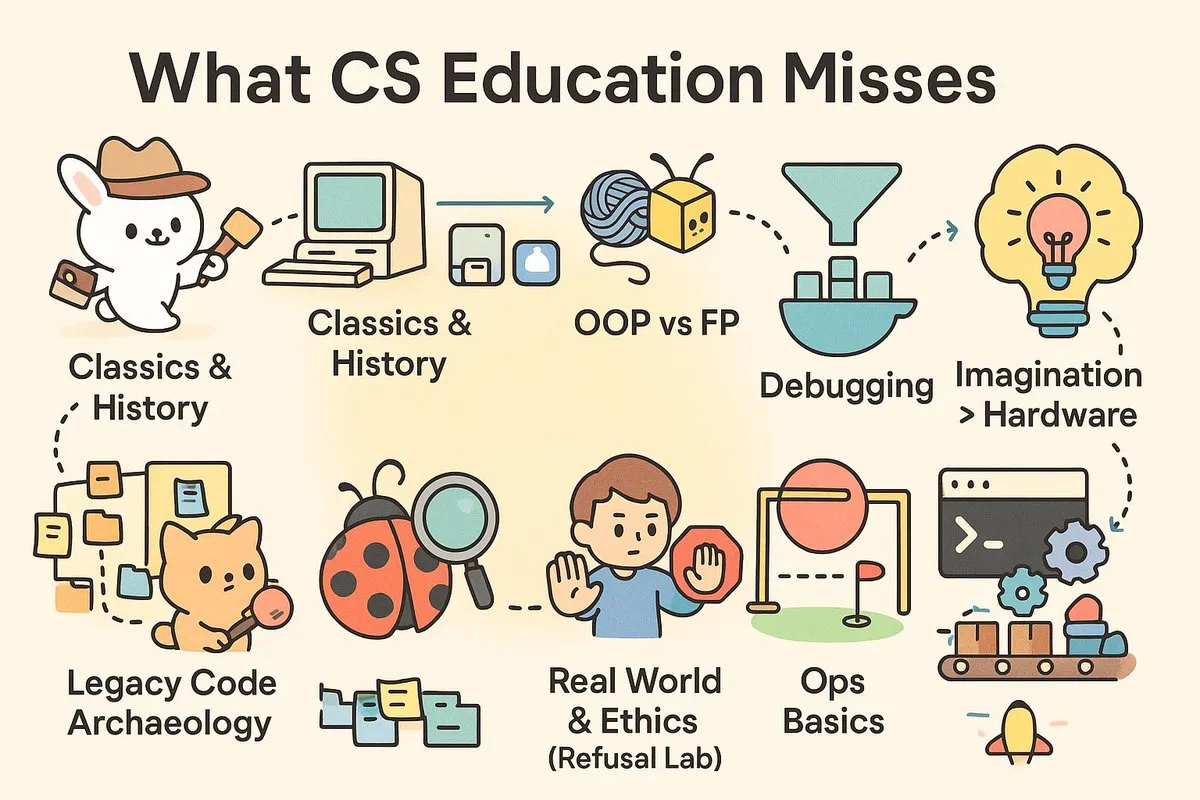

“Kesenjangan Praktis” dalam Pendidikan Ilmu Komputer : Media sosial ramai membahas relevansi pendidikan CS kontemporer, berpendapat bahwa universitas melatih “ilmuwan” daripada “insinyur” yang sangat dibutuhkan industri. Artikel dan komentar menunjukkan bahwa kurikulum CS kurang dalam keterampilan praktis seperti debugging, CI/CD, Unix, serta eksplorasi mendalam tentang sejarah perangkat lunak dan filosofi arsitektur, menyebabkan lulusan menghadapi tantangan saat menghadapi proyek dunia nyata. (Sumber: dotey

, dotey

)

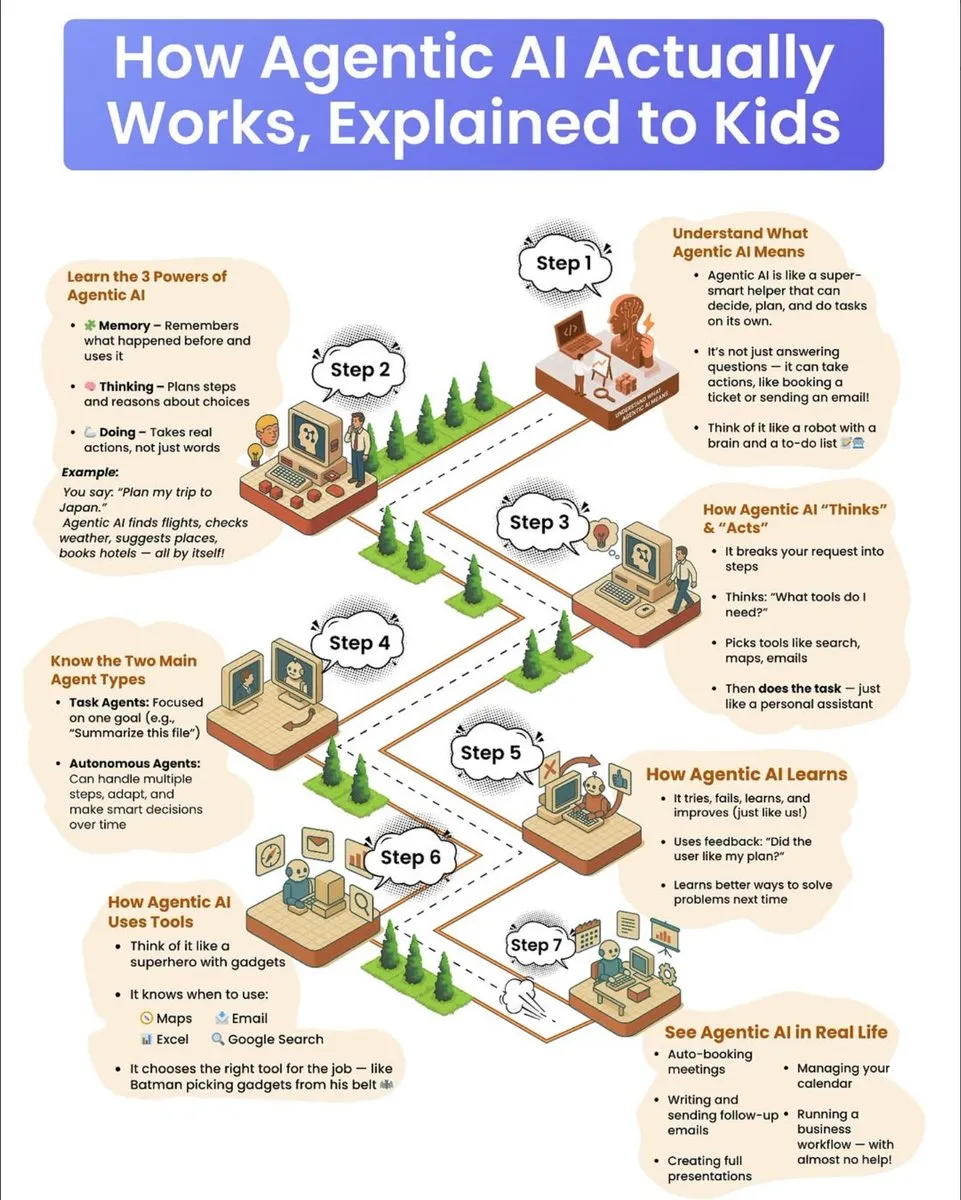

Panduan Edukasi Cara Kerja Agent AI untuk Anak-anak : Sebuah panduan edukasi untuk anak-anak menjelaskan secara rinci cara kerja agent AI, termasuk tiga “superpower” utamanya: memori, kemampuan berpikir, dan kemampuan bertindak. Panduan ini menjelaskan bagaimana agent memecah tugas kompleks, memilih alat, dan mengeksekusinya secara mandiri, serta membedakan antara agent berbasis tugas dan agent otonom, menekankan mekanisme pembelajaran melalui trial-and-error dan pemanfaatan feedback untuk terus berkembang. (Sumber: dotey

)

💡 Lain-lain

Industri Carbon Removal Menghadapi Tantangan dan Prospek Masa Depan : Industri carbon removal, setelah bertahun-tahun tumbuh, kini menghadapi “siklus likuidasi”, dengan beberapa perusahaan tutup atau bertransformasi, dan venture capital berkurang. Para ahli memperingatkan bahwa industri ini telah melewati “puncak ekspektasi”, dan perkembangan di masa depan memerlukan investasi pemerintah yang lebih besar atau kebijakan yang memaksa pencemar untuk membayar, untuk menghindari terulangnya masalah kredibilitas di pasar carbon offset. (Sumber: MIT Technology Review

)

Aplikasi Pengukur Nyeri AI Diluncurkan, Memicu Diskusi Etika : Sebuah aplikasi smartphone berbasis AI bernama PainChek telah digunakan, yang mengevaluasi tingkat nyeri dengan menganalisis ekspresi mikro wajah dan daftar periksa pengguna. Aplikasi ini memiliki potensi untuk orang-orang yang tidak dapat mengungkapkan rasa sakit (seperti pasien demensia), tetapi juga memicu diskusi tentang subjektivitas nyeri, akurasi pengukuran, dan batasan etika AI dalam diagnosis medis. (Sumber: MIT Technology Review

)

Google Mengumumkan Terobosan Besar dalam Komputasi Kuantum : Google mengumumkan terobosan besar di bidang komputasi kuantum. Meskipun detail spesifik belum sepenuhnya diungkapkan, kemajuan ini mengindikasikan bahwa teknologi komputasi kuantum mungkin akan mengambil langkah penting dalam memecahkan masalah kompleks yang sulit ditangani oleh komputer tradisional, dengan dampak mendalam pada penelitian ilmiah dan pengembangan teknologi di masa depan. (Sumber: Google)