Kata Kunci:AGI, Sora2, Gemini 3.0, Model Besar, RAG, Mainan AI, Agen Cerdas, Teknologi Pembuatan Video AI, Evolusi Pembuatan Augmentasi Pencarian, Model AI Multimodal, Platform AI untuk Farmasi, Teknologi Kolaborasi Komputasi-Tenaga Listrik

🎯 Tren

Andrej Karpathy: AGI adalah kurva panjang, bukan pertumbuhan eksplosif : Andrej Karpathy, peneliti inti OpenAI sebelumnya, menunjukkan bahwa narasi “tahun ledakan” AI saat ini terlalu fanatik, dan realisasi AGI akan membutuhkan evolusi panjang selama beberapa dekade. Ia menekankan bahwa agen cerdas sejati harus memiliki persistensi, memori, dan kontinuitas, bukan chatbot “hantu” yang ada saat ini. Pengembangan AI di masa depan harus beralih dari “membanjiri data” menjadi “mengajar tujuan”, melalui pelatihan berbasis tugas dan siklus umpan balik, menjadikan AI sebagai “mitra” dengan identitas, peran, dan tanggung jawab dalam masyarakat, bukan sekadar alat. (Sumber: 36氪)

Sora2 dirilis: Pembuatan video AI memasuki fase “super akselerasi” : OpenAI merilis Sora2 dan aplikasi sosialnya, Sora App, dengan jumlah unduhan melampaui ChatGPT, menandai masuknya bidang video AI ke periode “super akselerasi”. Sora2 mencapai terobosan dalam simulasi fisik, fusi multimodal, dan pemahaman “bahasa kamera”, mampu secara otomatis menghasilkan video dengan transisi multi-kamera dan alur cerita yang koheren, sangat menurunkan hambatan kreatif. Produsen domestik seperti Baidu dan Google juga dengan cepat mengiterasi produk, tetapi hak cipta dan model monetisasi masih menjadi tantangan nyata yang dihadapi industri. (Sumber: 36氪)

Evolusi Paradigma RAG: Debat “Hidup atau Mati” di bawah Agen dan Jendela Konteks Panjang : Dengan munculnya jendela konteks panjang LLM dan kemampuan Agent, masa depan RAG (Retrieval-Augmented Generation) memicu perdebatan sengit. LlamaIndex percaya bahwa RAG berevolusi menjadi “retrieval agen”, mencapai kueri basis pengetahuan yang lebih cerdas melalui arsitektur Agent berlapis; Hamel Husain menekankan pentingnya RAG sebagai disiplin rekayasa yang ketat; sementara Nicolas Bustamante menyatakan “RAG naif sudah mati”, Agent yang dikombinasikan dengan konteks panjang dapat langsung melakukan navigasi logis, dan RAG akan diturunkan menjadi komponen kotak peralatan Agent. (Sumber: 36氪)

Model Google Gemini 3.0 diduga online di LMArena, menunjukkan kemampuan multimodal baru : Model “alias” Google Gemini 3.0 (lithiumflow dan orionmist) diduga bocor di arena LMArena. Pengujian menunjukkan kemampuannya untuk secara akurat mengenali waktu dalam tugas “membaca jam”, peningkatan signifikan dalam kemampuan pembuatan gambar SVG, dan untuk pertama kalinya menunjukkan kemampuan komposisi musik yang baik, mampu meniru gaya musik dan menjaga ritme. Kemajuan ini mengindikasikan terobosan signifikan Gemini 3.0 dalam pemahaman dan pembuatan multimodal, memicu ekspektasi industri terhadap rilis model baru Google yang akan datang. (Sumber: 36氪)

Mainan AI beralih dari “AI + Mainan” menuju integrasi mendalam “AI x Mainan” : Pasar mainan AI sedang mengalami transformasi dari penambahan fungsi sederhana menjadi integrasi mendalam, dengan perkiraan ukuran pasar global mencapai ratusan miliar pada tahun 2030. Mainan AI generasi baru, melalui teknologi multimodal seperti pengenalan suara, pengenalan wajah, dan analisis emosi, mencapai persepsi aktif terhadap skenario, pemahaman emosi, serta menyediakan pendampingan dan pendidikan yang dipersonalisasi. Model industri juga beralih dari “penjualan perangkat keras” menjadi “layanan + keluaran konten berkelanjutan”, memenuhi kebutuhan pendampingan emosional dan bantuan hidup yang terus meningkat dari anak-anak, kaum muda, dan lansia, menjadi sarana penting bagi manusia untuk belajar hidup berdampingan dengan AI. (Sumber: 36氪)

Merek teknologi mewah BUTTONS merilis robot audio-visual yang dilengkapi agen cerdas HALI : BUTTONS meluncurkan robot audio-visual super agen cerdas SOLEMATE, yang dilengkapi dengan agen cerdas umum Terminus HALI. HALI memiliki kemampuan kognisi spasial dan interaksi fisik, memahami lingkungan melalui model memori semantik tiga dimensi, dan dapat secara proaktif menyediakan layanan berdasarkan lokasi dan niat pengguna. Robot ini menggunakan komputasi kolaboratif skala besar dari pusat komputasi cerdas untuk mencapai orkestrasi sumber daya, perangkat, dan perilaku yang optimal, menandai kemajuan AI menuju agen cerdas umum yang berwujud, mampu menembus hambatan dunia digital dan “mempersepsi-menalar-bertindak” di lingkungan fisik. (Sumber: 36氪)

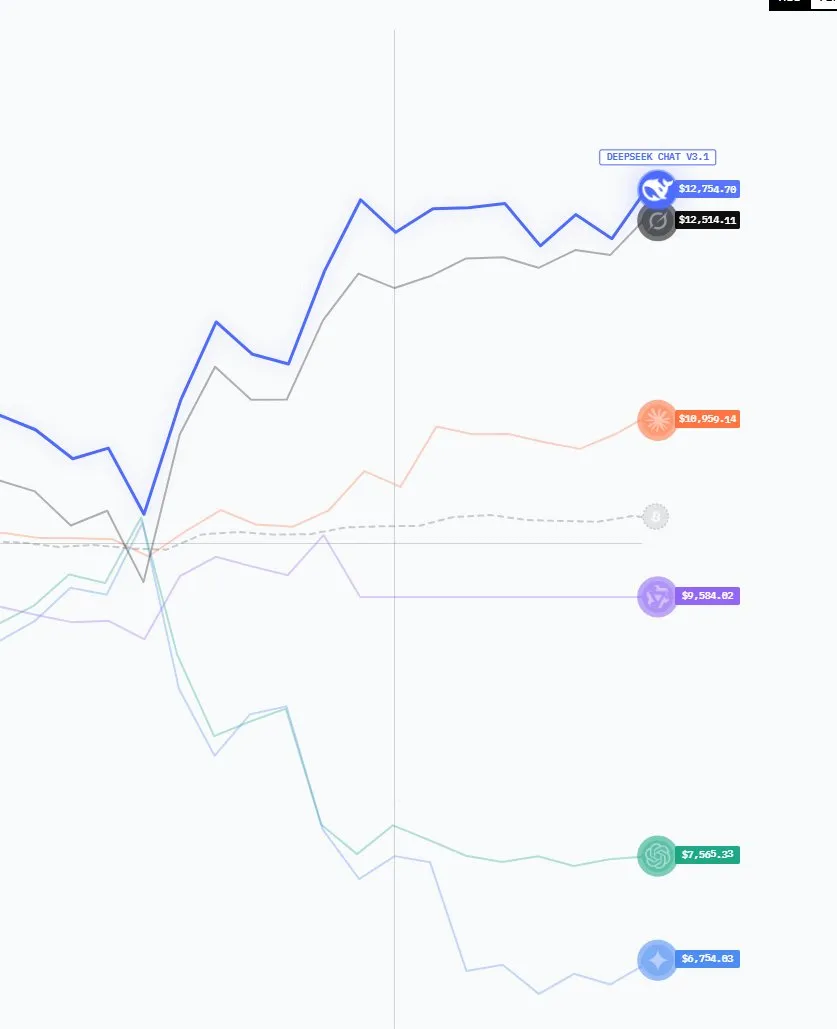

Model AI Tiongkok bangkit, pangsa pasar dan jumlah unduhan meningkat signifikan : Data terbaru menunjukkan bahwa lanskap pasar GenAI sedang berubah, dengan pangsa pasar ChatGPT terus menurun, sementara pesaing seperti Perplexity, Gemini, dan DeepSeek bangkit. Yang patut diperhatikan, model AI open-source AS yang menonjol tahun lalu, tahun ini telah didominasi oleh model Tiongkok di peringkat LMArena. Model Tiongkok seperti DeepSeek dan Qwen memiliki jumlah unduhan dua kali lipat dari model AS di Hugging Face, menunjukkan meningkatnya daya saing Tiongkok di bidang AI terbuka. (Sumber: ClementDelangue, ClementDelangue)

Google merilis serangkaian pembaruan AI: Veo 3.1, integrasi peta Gemini API, dll. : Google minggu ini merilis beberapa kemajuan AI, termasuk model video Veo 3.1 (mendukung perluasan adegan dan gambar referensi), integrasi Gemini API dengan data Google Maps, penelitian Speech-to-Retrieval (langsung mengkueri data tanpa transkripsi suara ke teks), investasi 15 miliar dolar AS untuk pusat AI di India, serta fitur AI penjadwalan Gemini di Gmail/Calendar. Pada saat yang sama, fitur AI Overviews-nya menghadapi penyelidikan dari penerbit berita Italia karena “pembunuh lalu lintas”, dan merilis model C2S-Scale 27B untuk terjemahan data biologis. (Sumber: Reddit r/ArtificialInteligence)

Microsoft meluncurkan MAI-Image-1, kemampuan model pembuatan gambar masuk sepuluh besar : Microsoft AI merilis model pembuatan gambar pertama yang sepenuhnya dikembangkan sendiri, MAI-Image-1. Model ini untuk pertama kalinya masuk dalam sepuluh besar peringkat model teks-ke-gambar LMArena. Kemajuan ini menunjukkan kekuatan Microsoft yang tangguh dalam teknologi pembuatan gambar asli dan mengindikasikan upaya lebih lanjut di bidang AI multimodal, yang akan memberikan pengalaman pembuatan gambar yang lebih baik bagi pengguna. (Sumber: dl_weekly)

🧰 Alat

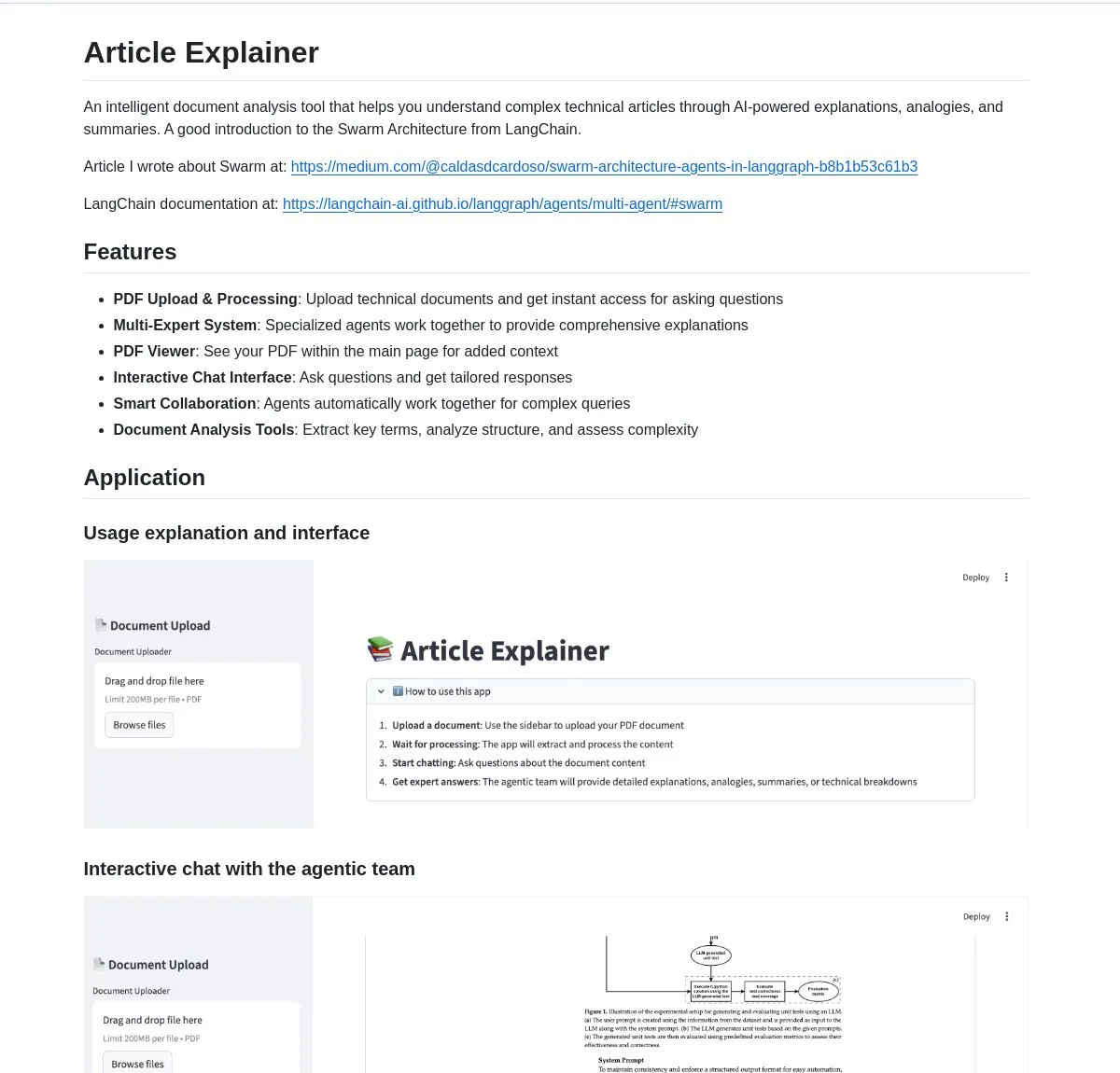

LangChain Article Explainer: Alat analisis dokumen AI : LangChain merilis alat analisis dokumen AI bernama “Article Explainer”. Alat ini menggunakan Swarm Architecture dari LangGraph untuk menguraikan artikel teknis yang kompleks. Melalui kolaborasi multi-agen, ia menyediakan penjelasan interaktif dan wawasan mendalam. Pengguna dapat memperoleh informasi melalui kueri bahasa alami, sangat meningkatkan efisiensi pemahaman dokumen teknis. (Sumber: LangChainAI)

Claude Code Skill: Mengubah Claude menjadi arsitek proyek profesional : Seorang pengembang membangun Claude Code Skill yang dapat mengubah Claude menjadi arsitek proyek profesional. Keterampilan ini memungkinkan Claude secara otomatis menghasilkan dokumen persyaratan, dokumen desain, dan rencana implementasi sebelum pengkodean, memecahkan masalah kehilangan konteks dalam proyek-proyek kompleks. Ini dapat dengan cepat menghasilkan user story, arsitektur sistem, antarmuka komponen, dan tugas berlapis, sangat meningkatkan efisiensi perencanaan dan pelaksanaan proyek, mendukung pengembangan berbagai aplikasi Web, microservice, dan sistem ML. (Sumber: Reddit r/ClaudeAI)

Perplexity AI Comet: Ekstensi browser AI untuk meningkatkan efisiensi penjelajahan dan penelitian : Ekstensi browser Perplexity AI Comet meluncurkan akses awal, bertujuan untuk meningkatkan penjelajahan, penelitian, dan produktivitas pengguna. Alat ini mampu memberikan jawaban cepat, merangkum konten halaman web, dan mengintegrasikan fungsi AI langsung ke dalam pengalaman browser, menyediakan cara yang lebih cerdas dan efisien bagi pengguna untuk memperoleh informasi, terutama cocok untuk pengguna yang perlu mencerna banyak informasi online dengan cepat. (Sumber: Reddit r/artificial)

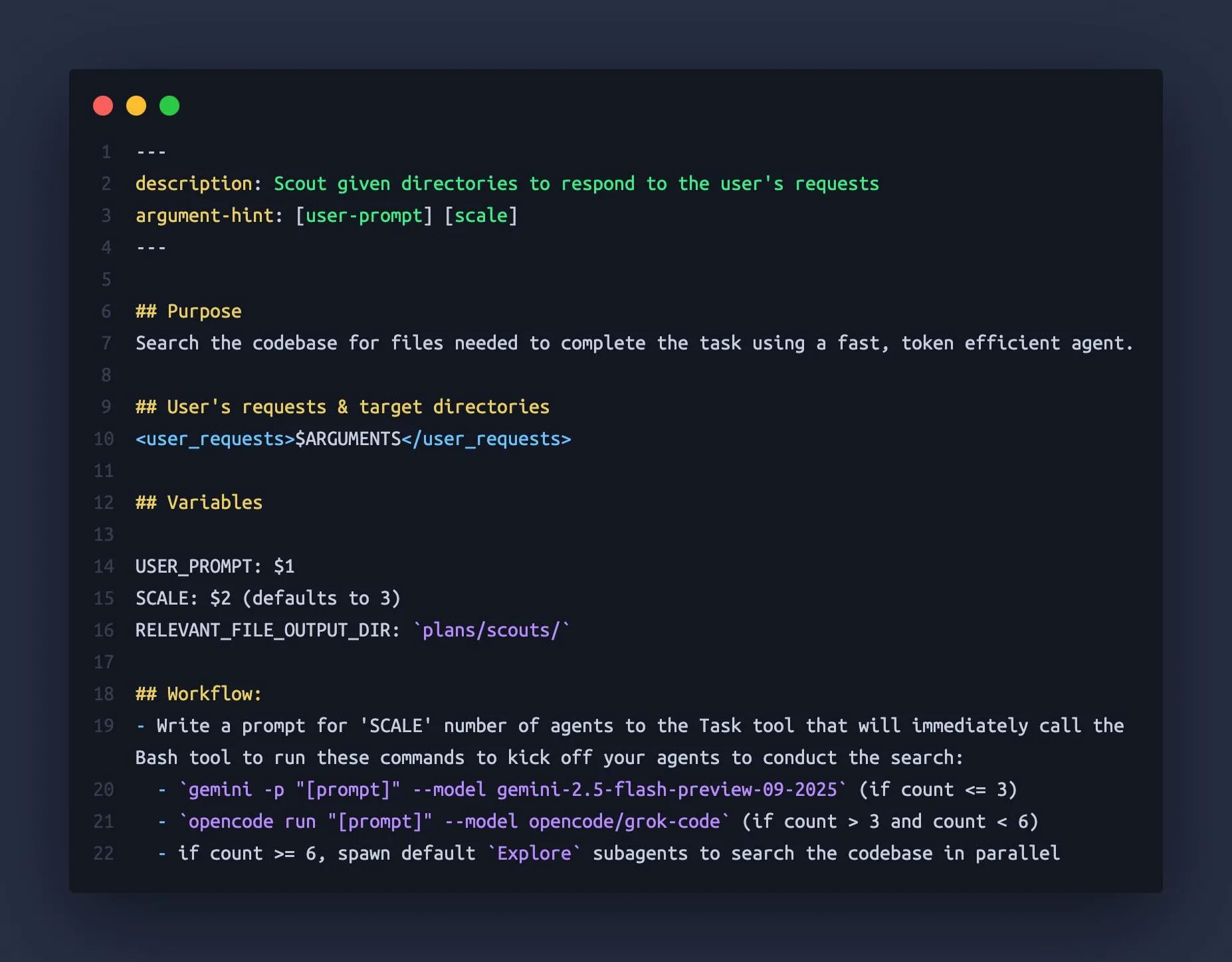

Claude Code dapat menggunakan Gemini CLI dan OpenCode sebagai “sub-agen” : Seorang pengembang menemukan bahwa Claude Code dapat mengorkestrasi model bahasa besar lainnya seperti Gemini 2.5 Flash dan Grok Code Fast sebagai “sub-agen”, menggunakan jendela konteks besar mereka (1M-2M token) untuk dengan cepat mengintai basis kode, menyediakan informasi konteks yang lebih komprehensif untuk Claude Code. Cara penggunaan kombinasi ini secara efektif menghindari masalah “kehilangan konteks” Claude dalam tugas-tugas kompleks, meningkatkan efisiensi dan akurasi asisten pengkodean. (Sumber: Reddit r/ClaudeAI)

Model generator CAD k-1b: Generator model 3D yang disetel halus berdasarkan Gemma3-1B : Seorang pengembang membangun model generator CAD 1B parameter bernama k-1b. Pengguna hanya perlu memasukkan deskripsi untuk menghasilkan model 3D dalam format STL. Model ini dilatih melalui pembuatan dan perbaikan dataset OpenSCAD yang dibantu AI, dan disetel halus berdasarkan Gemma3-1B. Penulis juga menyediakan alat CLI yang mendukung konversi model OBJ dan pratinjau terminal, menyediakan alat bantu AI yang berbiaya rendah dan efisien untuk bidang desain dan manufaktur 3D. (Sumber: karminski3, Reddit r/LocalLLaMA)

neuTTS-Air: Model kloning suara 0.7B yang dapat berjalan di CPU : Neuphonic merilis model kloning suara 0.7B bernama neutts-air, dengan fitur utama dapat berjalan di CPU. Pengguna hanya perlu menyediakan suara target dan teks yang sesuai untuk mengkloning suara dan menghasilkan audio teks baru, menghasilkan audio 18 detik dalam sekitar 30 detik. Model ini saat ini hanya mendukung bahasa Inggris, tetapi sifatnya yang ringan dan kompatibilitas CPU menyediakan solusi kloning suara yang nyaman bagi pengguna individu dan pengembang kecil. (Sumber: karminski3)

Claude Code M&A Deal Comp Agent: Menggunakan parsing PDF untuk menghasilkan ketentuan transaksi Excel : Seorang pengembang menggunakan Claude Code Skills dan kemampuan parsing PDF semtools dari LlamaIndex untuk membuat agen analisis transaksi M&A. Agen ini mampu mengurai dokumen M&A publik (seperti DEF 14A), menganalisis setiap PDF, dan secara otomatis menghasilkan tabel Excel yang berisi ketentuan transaksi dan data perusahaan sebanding. Alat ini secara signifikan meningkatkan efisiensi dan akurasi analisis keuangan, terutama cocok untuk skenario penanganan dokumen keuangan yang kompleks. (Sumber: jerryjliu0)

Anthropic Skills dan Plugins: Tumpang tindih fungsi menimbulkan kebingungan pengembang : Anthropic baru-baru ini meluncurkan fitur Skills dan Plugins, yang bertujuan untuk memperkenalkan fungsi kustom ke AI Agent. Namun, beberapa pengembang melaporkan bahwa keduanya memiliki kebingungan dan tumpang tindih dalam penggunaan, menyebabkan kebingungan dalam skenario penggunaan dan strategi pengembangan. Ini menunjukkan bahwa Anthropic mungkin memiliki ruang untuk optimasi dalam desain fitur dan strategi rilis untuk lebih baik memandu pengembang dalam memanfaatkan kemampuan AI-nya. (Sumber: Vtrivedy10, Reddit r/ClaudeAI)

📚 Pembelajaran

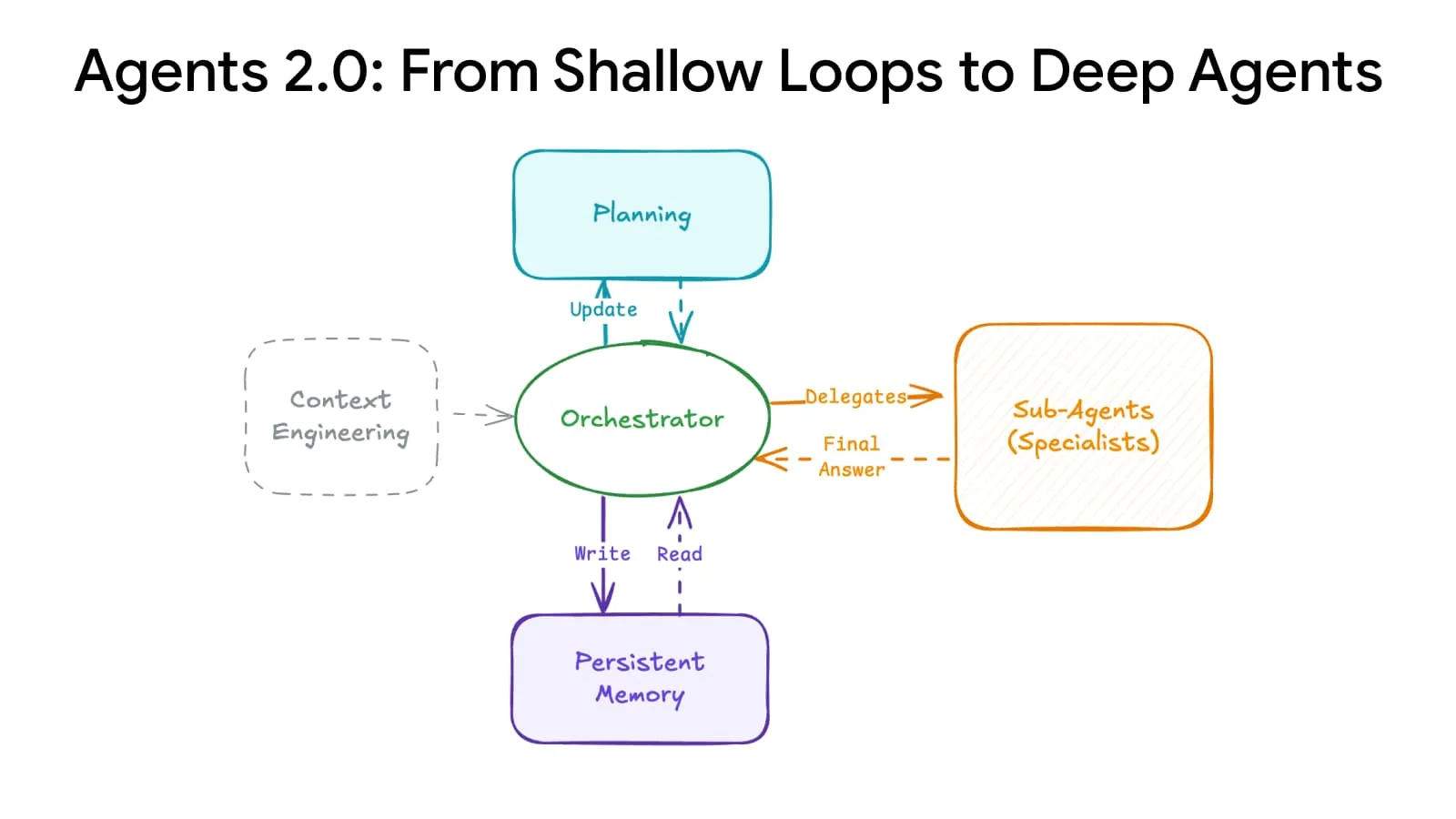

Deep Agents Evolution: Sistem perencanaan dan memori canggih meningkatkan skala agen cerdas : Sebuah terobosan arsitektur AI mencapai “evolusi agen mendalam”, melalui sistem perencanaan dan memori canggih, memungkinkan agen cerdas untuk berkembang dari 15 langkah menjadi lebih dari 500 langkah, secara fundamental mengubah cara AI menangani tugas-tugas kompleks. Teknologi ini diharapkan memungkinkan AI untuk mempertahankan koherensi dalam urutan waktu yang lebih panjang dan rantai logika yang lebih kompleks, meletakkan dasar untuk membangun agen AI umum yang lebih kuat. (Sumber: LangChainAI)

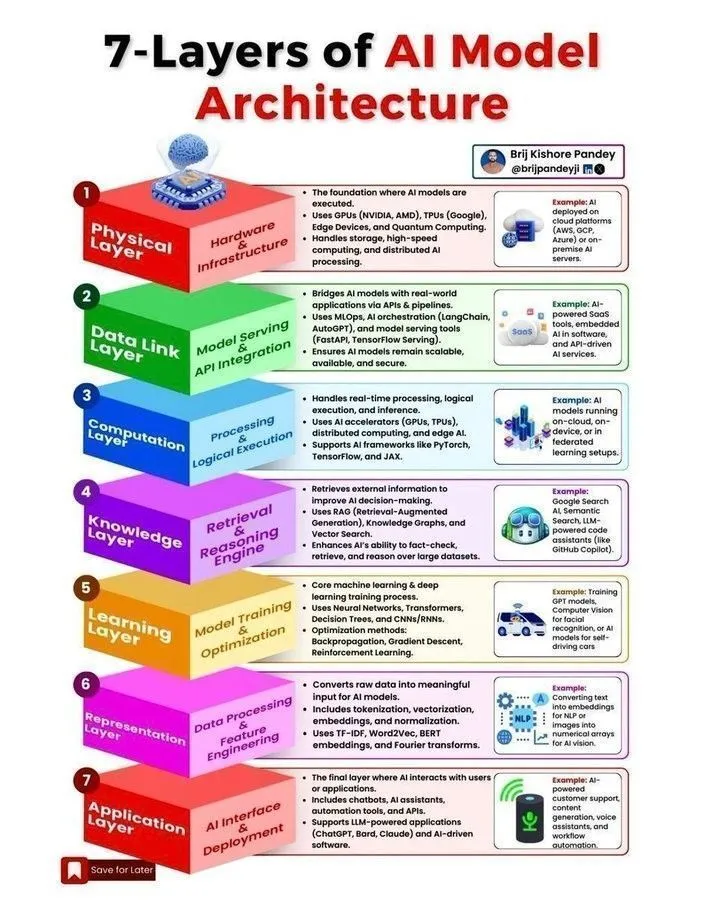

Arsitektur model AI dan roadmap pengembangan agen cerdas : Beberapa sumber daya tentang arsitektur model AI, roadmap pengembangan agen cerdas, siklus hidup machine learning, serta perbedaan antara AI dan AI generatif, dan machine learning telah dibagikan di media sosial. Konten ini bertujuan untuk membantu pengembang dan peneliti memahami konsep inti sistem AI, langkah-langkah kunci untuk membangun agen AI yang dapat diskalakan, dan menguasai keterampilan penting yang dibutuhkan di bidang AI pada tahun 2025. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Kursus CME295 Stanford: Praktik rekayasa Transformer dan model besar : Universitas Stanford merilis seri kursus CME295, yang berfokus pada arsitektur Transformer dan pengetahuan praktik rekayasa Large Language Model (LLM). Kursus ini menghindari konsep matematika yang kompleks dan menekankan aplikasi praktis, menyediakan sumber belajar yang berharga bagi para insinyur yang ingin memahami lebih dalam pengembangan dan penerapan model besar. Pada saat yang sama, kursus CS224N direkomendasikan sebagai pilihan terbaik untuk pengantar NLP. (Sumber: karminski3, QuixiAI, stanfordnlp)

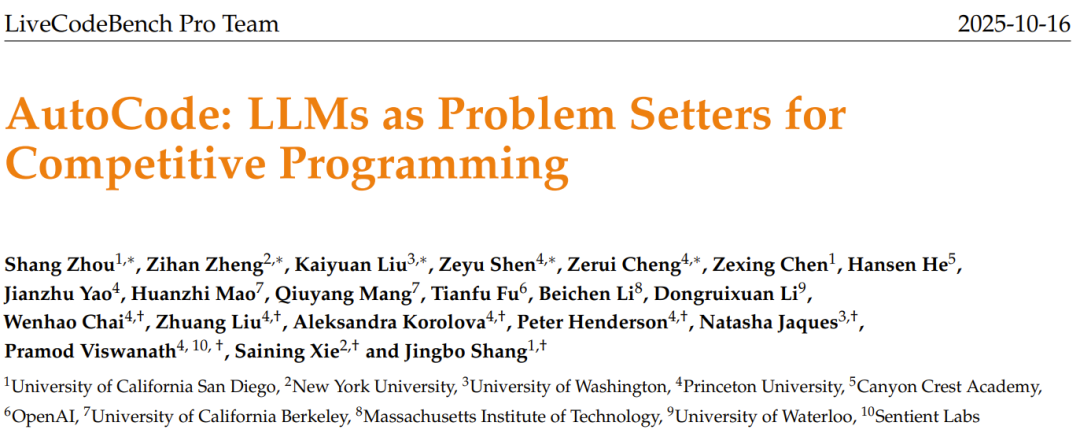

Mesin Pembuat Soal AI AutoCode: LLM menghasilkan soal kompetisi pemrograman orisinal : Tim LiveCodeBench Pro meluncurkan framework AutoCode, yang menggunakan LLM dalam sistem loop tertutup, multi-peran untuk mengotomatiskan pembuatan dan evaluasi masalah pemrograman kompetitif. Framework ini, melalui mekanisme verifikator-generator-pemeriksa yang ditingkatkan, mencapai keandalan tinggi dalam pembuatan test case, dan dapat menginspirasi LLM dari “soal awal” untuk menghasilkan soal baru yang berkualitas tinggi dan orisinal, diharapkan membuka jalan bagi benchmark kompetisi pemrograman yang lebih ketat dan peningkatan diri model. (Sumber: 36氪)

KAIST mengembangkan otak semikonduktor AI: Menggabungkan efisiensi Transformer dan Mamba : Korea Advanced Institute of Science and Technology (KAIST) mengembangkan otak semikonduktor AI jenis baru, berhasil menggabungkan kecerdasan arsitektur Transformer dan efisiensi arsitektur Mamba. Penelitian terobosan ini bertujuan untuk mengatasi masalah trade-off antara kinerja dan konsumsi energi pada model AI yang ada, menyediakan arah baru untuk desain perangkat keras AI yang efisien dan berdaya rendah di masa depan, dan diharapkan mempercepat pengembangan AI edge dan sistem AI tertanam. (Sumber: Reddit r/deeplearning)

Pipeline NER multi-tahap: Pencocokan fuzzy dan teknik masking LLM untuk menganalisis komentar Reddit : Sebuah penelitian mengusulkan pipeline Named Entity Recognition (NER) multi-tahap, menggabungkan pencocokan fuzzy berkecepatan tinggi dan teknik masking LLM, untuk mengekstrak entitas dan sentimen dari komentar Reddit. Metode ini pertama-tama mengidentifikasi entitas yang diketahui melalui pencarian fuzzy, kemudian memproses teks yang di-masking dengan LLM untuk menemukan entitas baru, dan terakhir melakukan analisis sentimen dan ringkasan. Metode hibrida ini mencapai keseimbangan antara kecepatan dan kemampuan penemuan saat menangani teks spesifik domain yang berskala besar dan bising. (Sumber: Reddit r/MachineLearning)

Pengalaman penerapan sistem perdagangan berbasis ML: Mengatasi “bias pandangan ke depan” dan “pergeseran status” di lingkungan real-time : Seorang pengembang membagikan pengalamannya dalam menerapkan sistem perdagangan berbasis ML, menekankan pentingnya mengatasi “bias pandangan ke depan” dan “pergeseran status” di lingkungan real-time. Melalui model pemrosesan baris-demi-baris yang ketat dan skrip “master emas”, konsistensi deterministik antara pengujian historis dan operasi real-time dipastikan. Sistem ini juga mencakup validator, yang mengukur konsistensi antara prediksi real-time dan prediksi validator dengan koefisien korelasi Pearson 1.0, memastikan keandalan model. (Sumber: Reddit r/MachineLearning)

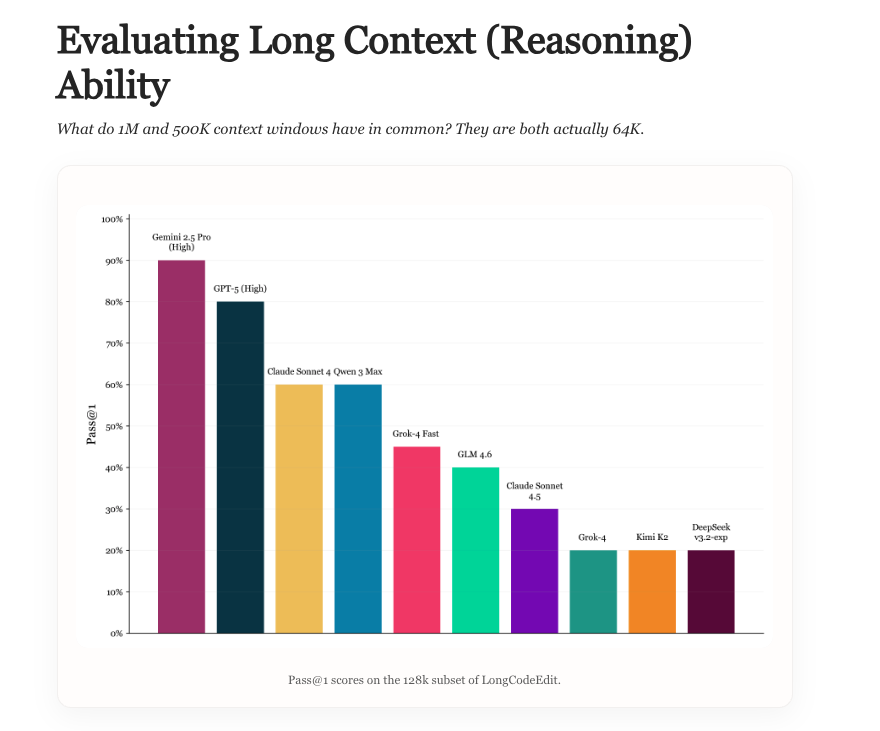

Long Context Evaluation: Benchmark baru untuk evaluasi kemampuan konteks panjang LLM : Penelitian baru mengeksplorasi status evaluasi konteks panjang LLM, menganalisis pro dan kontra benchmark yang ada, dan memperkenalkan benchmark baru bernama LongCodeEdit. Penelitian ini bertujuan untuk mengatasi kekurangan metode evaluasi yang ada dalam mengukur kinerja LLM dalam menangani teks panjang dan tugas pengeditan kode yang kompleks, menyediakan alat dan wawasan baru untuk mengevaluasi kinerja model secara lebih akurat dalam skenario konteks panjang. (Sumber: nrehiew_, teortaxesTex)

Manifold Optimization: Optimasi yang sadar geometri untuk pelatihan jaringan saraf : Optimasi Manifold memungkinkan pelatihan jaringan saraf memiliki kesadaran geometri. Penelitian baru memperluas ide ini ke manifold modular, membantu merancang optimizer yang memahami interaksi antar lapisan. Dengan menggabungkan fungsi maju, batasan manifold, dan norma, framework ini menjelaskan bagaimana geometri antar lapisan dan aturan optimasi digabungkan, sehingga mencapai optimasi yang sadar geometri pada tingkat yang lebih dalam, meningkatkan efisiensi dan efektivitas pelatihan jaringan saraf. (Sumber: TheTuringPost, TheTuringPost)

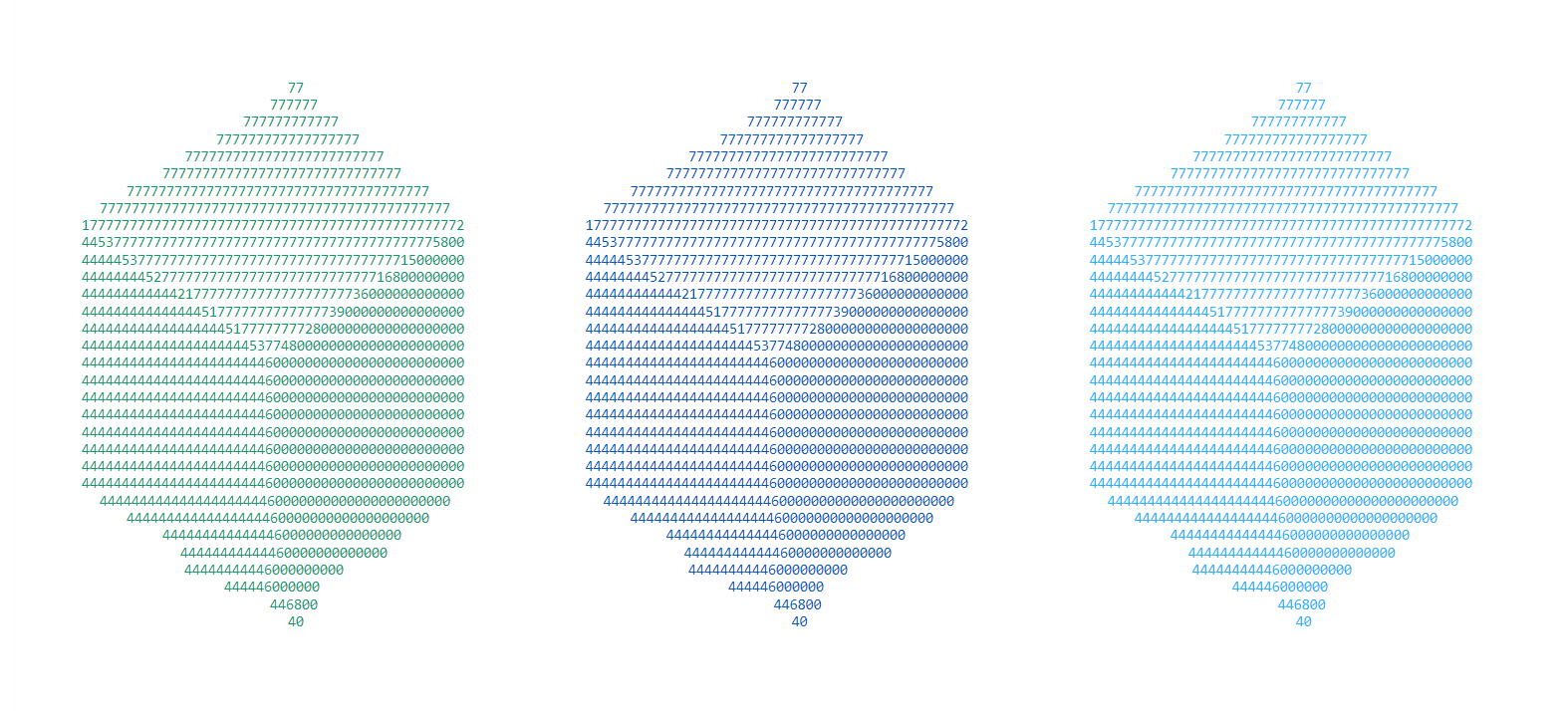

Kompleksitas Kolmogorov dalam penelitian AI: Potensi AI untuk menyederhanakan hasil penelitian : Diskusi menunjukkan bahwa “esensi” inti dari penelitian dan konten blog baru dapat dikompresi menjadi kode, artefak, dan abstraksi matematika. Sistem AI di masa depan diharapkan dapat “menerjemahkan” penelitian kompleks menjadi artefak sederhana, dengan mengekstraksi perbedaan inti dan mereplikasi hasil kunci, secara signifikan mengompresi biaya pemahaman penelitian baru, memungkinkan peneliti untuk lebih mudah mengikuti banyaknya makalah di ArXiv, dan mencapai pencernaan dan aplikasi hasil penelitian yang cepat. (Sumber: jxmnop, aaron_defazio)

Kontroversi asal-usul pembelajaran residual oleh Bapak LSTM: Kontribusi Hochreiter tahun 1991 : Jürgen Schmidhuber, Bapak LSTM, kembali menyatakan bahwa ide inti pembelajaran residual telah diusulkan oleh muridnya, Sepp Hochreiter, pada tahun 1991, untuk mengatasi masalah vanishing gradient pada RNN. Dalam disertasi doktornya, Hochreiter memperkenalkan koneksi residual berulang dan menetapkan bobot 1.0, yang dianggap sebagai fondasi ide residual dalam arsitektur deep learning selanjutnya seperti LSTM, Highway network, dan ResNet. Schmidhuber menekankan pentingnya kontribusi awal terhadap pengembangan deep learning. (Sumber: 量子位)

💼 Bisnis

Zhiweitou Pharmaceutical menerima pendanaan seed round puluhan juta yuan: R&D obat molekul kecil oral yang dibantu AI : Beijing Zhiweitou Pharmaceutical Technology Co., Ltd. menyelesaikan pendanaan seed round puluhan juta yuan, dipimpin oleh Newley Capital dengan partisipasi dari Qingtang Investment. Dana tersebut akan digunakan untuk memajukan R&D praklinis pipeline inti dan pembangunan platform desain molekuler interaktif AI. Perusahaan berfokus pada jalur AI farmasi, menggunakan platform EnCore yang dikembangkan sendiri untuk mempercepat penemuan senyawa timbal dan optimasi molekuler, dengan fokus pada obat molekul kecil oral untuk penyakit autoimun, diharapkan dapat mengatasi target “sulit diobati”. (Sumber: 36氪)

Damou Technology menyelesaikan pendanaan Seri A+ hampir 100 juta yuan: Teknologi sinergi komputasi-listrik memecahkan masalah konsumsi energi tinggi pusat komputasi cerdas : Damou Technology menyelesaikan pendanaan Seri A+ hampir 100 juta yuan, dipimpin oleh Puquan Capital, anak perusahaan CATL. Pendanaan ini akan digunakan untuk R&D dan promosi model energi besar, platform sinergi komputasi-listrik, dan teknologi inti agen cerdas, bertujuan untuk memecahkan masalah konsumsi energi tinggi pusat komputasi cerdas melalui “sinergi komputasi-listrik”, membantu pembangunan sistem tenaga baru. Damou Technology, mengandalkan model energi besar yang dikembangkan sendiri secara full-stack, telah bekerja sama dengan perusahaan terkemuka seperti SenseTime dan Cambricon, menyediakan solusi optimasi energi untuk infrastruktur komputasi berdaya tinggi. (Sumber: 36氪)

JD.com, Tmall, Douyin “AI” di Double 11: Teknologi memberdayakan pertumbuhan promosi e-commerce : Double 11 tahun ini menjadi medan latihan bagi e-commerce AI, dengan platform terkemuka seperti JD.com, Tmall, dan Douyin sepenuhnya meningkatkan teknologi AI. AI diterapkan untuk mengoptimalkan pengalaman konsumen, memberdayakan pedagang, pengiriman logistik, distribusi konten, dan keputusan pembelian di seluruh rantai. Misalnya, JD.com meningkatkan “Photo Buy”, Douyin Doubao terhubung ke pusat perbelanjaan, dan WorthyBuy Technology mencapai perbandingan harga langsung melalui AI chat. AI menjadi mesin pertumbuhan baru e-commerce, melalui efisiensi ekstrem dan kontrol biaya, membentuk kembali lanskap persaingan industri, mendorong e-commerce dari “e-commerce rak/konten” menuju fase “e-commerce cerdas”. (Sumber: 36氪, 36氪)

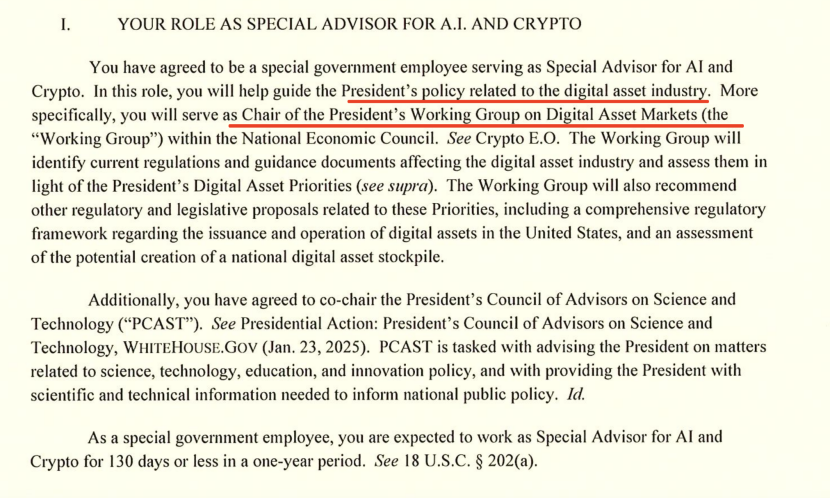

Kepala AI Gedung Putih membahas persaingan AI AS-Tiongkok: Ekspor chip dan dominasi ekosistem : “Tsar” AI dan Crypto Gedung Putih, David Sacks, dalam wawancara menjelaskan strategi AS dalam persaingan AI AS-Tiongkok, menekankan pentingnya inovasi, infrastruktur, dan ekspor. Ia menunjukkan bahwa kebijakan ekspor chip AS ke Tiongkok perlu “nuansa”, baik untuk membatasi chip paling canggih maupun untuk menghindari perampasan total yang menyebabkan monopoli Huawei di pasar domestik. Sacks menekankan bahwa AS harus membangun ekosistem AI yang besar dan menjadi mitra teknologi pilihan global, bukan mencekik daya saing melalui kontrol birokrasi. (Sumber: 36氪)

🌟 Komunitas

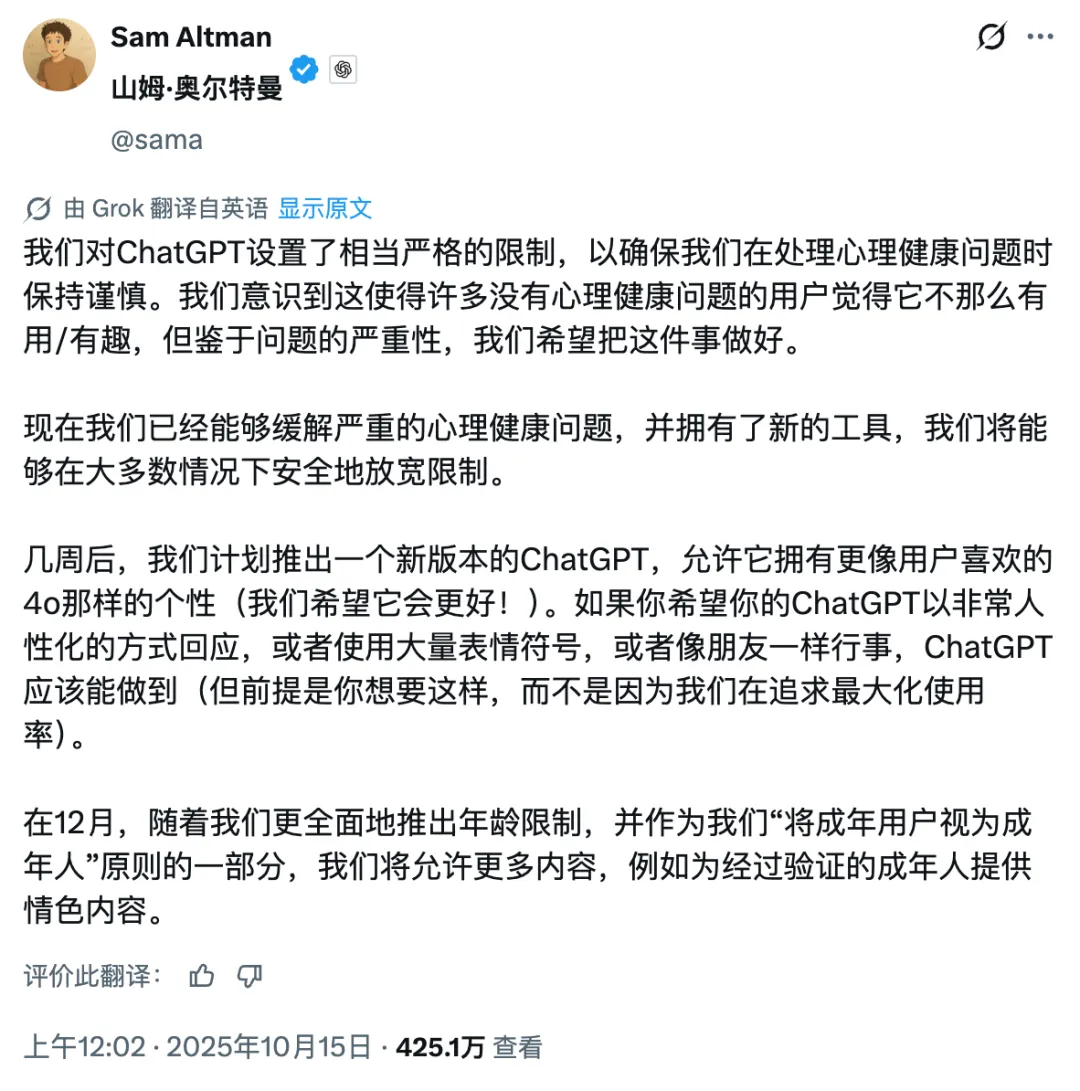

Kontroversi komersialisasi OpenAI: Dari nirlaba menjadi mencari keuntungan, reputasi Sam Altman rusak : CEO OpenAI Sam Altman memicu kontroversi luas karena ChatGPT akan mengizinkan konten pornografi, kinerja model GPT-5, dan strategi ekspansi infrastruktur yang agresif. Komunitas mempertanyakan pergeserannya dari tujuan nirlaba awal menjadi mencari keuntungan komersial, menyatakan kekhawatiran tentang arah pengembangan teknologi AI, gelembung investasi, dan perlakuan etis terhadap karyawan. Tanggapan Altman gagal sepenuhnya meredakan opini publik, menyoroti ketegangan antara ekspansi kerajaan AI dan tanggung jawab sosial. (Sumber: 36氪, janusch_patas, Reddit r/ArtificialInteligence)

Keracunan model besar: Data poisoning, adversarial samples, dan tantangan keamanan AI : Model besar menghadapi ancaman keamanan seperti data poisoning, serangan backdoor, dan adversarial samples, yang menyebabkan output model yang tidak normal, konten berbahaya, dan bahkan digunakan untuk iklan komersial (GEO), pamer teknologi, atau kejahatan siber. Penelitian menunjukkan bahwa sejumlah kecil data berbahaya dapat secara signifikan memengaruhi model. Ini menimbulkan kekhawatiran tentang halusinasi AI, manipulasi keputusan pengguna, dan risiko keamanan publik, menekankan pentingnya membangun sistem kekebalan model, memperkuat audit data, dan mekanisme pertahanan berkelanjutan. (Sumber: 36氪)

Dilema pelabel data di era AI: Lulusan master dan doktor melakukan pekerjaan berulang dengan gaji rendah : Dengan perkembangan model AI besar, pekerjaan pelabel data membutuhkan kualifikasi pendidikan yang lebih tinggi (bahkan gelar master dan doktor), tetapi gaji jauh lebih rendah daripada insinyur AI. “Guru AI” ini melakukan pekerjaan mengevaluasi konten yang dihasilkan AI, melakukan tinjauan etika, dan melatih pengetahuan profesional, tetapi dengan upah per jam yang rendah dan pekerjaan yang tidak stabil, kehilangan pekerjaan setelah proyek selesai. Model “jalur perakitan siber” yang berlapis-lapis dan eksploitatif ini memicu refleksi mendalam tentang etika kerja dan keadilan dalam industri AI. (Sumber: 36氪)

Dampak AI terhadap kreativitas dan nilai manusia: Akhir atau pencerahan? : Komunitas membahas dampak AI terhadap kreativitas manusia, berpendapat bahwa AI tidak membunuh kreativitas, melainkan mengungkapkan kreativitas manusia yang relatif biasa-biasa saja. AI unggul dalam reorganisasi dan generasi pola, tetapi orisinalitas, kontradiksi, dan ketidakpastian sejati masih merupakan keunggulan unik manusia. Munculnya alat baru selalu menghilangkan area tengah, memaksa manusia untuk mencari terobosan tingkat yang lebih tinggi dalam konten dan kreativitas, membuat kreativitas sejati menjadi lebih berharga. (Sumber: Reddit r/artificial)

Kecemasan eksistensial yang disebabkan AI dan strategi penanganannya: Masalah nyata dan kekhawatiran berlebihan : Menghadapi potensi ancaman eksistensial yang dibawa AI, komunitas membahas bagaimana mengatasi “ketakutan eksistensial” yang muncul. Beberapa pandangan berpendapat bahwa ketakutan ini mungkin berasal dari fantasi berlebihan tentang masa depan, menyarankan orang untuk kembali ke kenyataan dan fokus pada kehidupan saat ini. Pada saat yang sama, ada juga yang menunjukkan bahwa dampak ekonomi dan masalah pekerjaan terkait AI adalah ancaman nyata yang lebih mendesak, menekankan bahwa keamanan AI harus sejalan dengan dampak sosial ekonomi. (Sumber: Reddit r/ArtificialInteligence)

Pandangan Karpathy memicu perdebatan sengit: Teori sepuluh tahun AGI, teori agen “hantu”, dan jalur pengembangan AI : Pandangan Andrej Karpathy tentang “teori sepuluh tahun AGI” dan bahwa agen AI yang ada saat ini adalah “hantu” memicu diskusi luas di komunitas. Ia menekankan bahwa AI membutuhkan persistensi, memori, dan kontinuitas untuk menjadi agen cerdas sejati, dan menyarankan bahwa pelatihan AI harus beralih dari “membanjiri data” menjadi “mengajar tujuan”. Pandangan-pandangan ini dianggap sebagai refleksi tenang terhadap hype AI saat ini, mendorong orang untuk memikirkan kembali jalur pengembangan jangka panjang dan standar evaluasi AI. (Sumber: TheTuringPost, TheTuringPost, NandoDF, random_walker, lateinteraction, stanfordnlp)

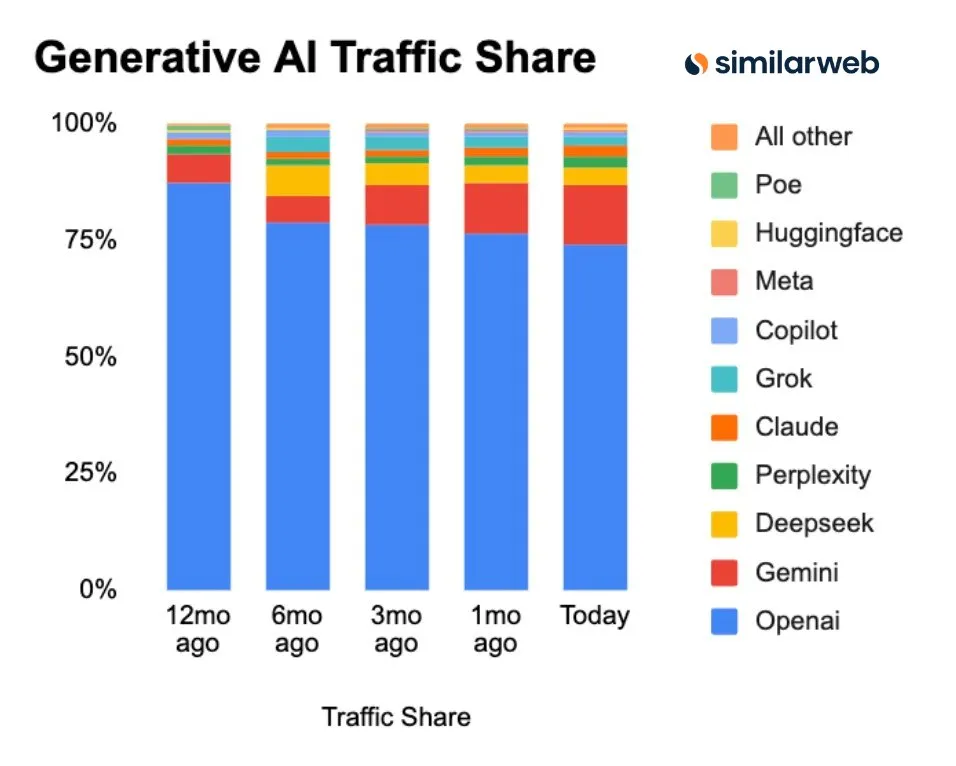

Pangsa pasar ChatGPT terus menurun: Pesaing seperti Perplexity, Gemini, DeepSeek bangkit : Data Similarweb menunjukkan bahwa pangsa pasar ChatGPT terus menurun, dari 87.1% setahun yang lalu menjadi 74.1%. Sementara itu, pangsa pasar pesaing seperti Gemini, Perplexity, DeepSeek, Grok, dan Claude terus meningkat. Tren ini menunjukkan persaingan yang semakin ketat di pasar asisten AI, dengan pilihan pengguna yang semakin beragam, dan dominasi ChatGPT sedang ditantang. (Sumber: ClementDelangue, brickroad7)

Insiden kesalahan matematika GPT-5: Pemasaran berlebihan OpenAI dan keraguan dari rekan sejawat : Peneliti OpenAI dengan bangga mengklaim bahwa GPT-5 telah memecahkan beberapa masalah matematika Erdős, tetapi kemudian ditemukan bahwa itu hanya menemukan jawaban yang sudah ada melalui pencarian web, bukan memecahkannya secara independen. Insiden ini memicu ejekan publik dari tokoh-tokoh industri seperti CEO DeepMind Hassabis dan LeCun dari Meta, mempertanyakan pemasaran berlebihan OpenAI, menyoroti masalah ketelitian dalam promosi kemampuan AI dan persaingan antar rekan sejawat. (Sumber: 量子位)

Biaya lingkungan tersembunyi AI: Konsumsi energi dan kebutuhan air : Penelitian historis menunjukkan bahwa dari telegraf hingga AI, sistem komunikasi selalu disertai dengan biaya lingkungan tersembunyi. AI dan sistem komunikasi modern bergantung pada pusat data skala besar, menyebabkan konsumsi energi dan kebutuhan air melonjak. Diperkirakan pada tahun 2027, konsumsi air AI akan setara dengan konsumsi air tahunan Denmark. Ini menyoroti biaya lingkungan di balik perkembangan pesat teknologi AI, menyerukan pemerintah untuk memperkuat regulasi, mewajibkan pengungkapan dampak lingkungan, dan mendukung proyek-proyek berdampak rendah. (Sumber: aihub.org)

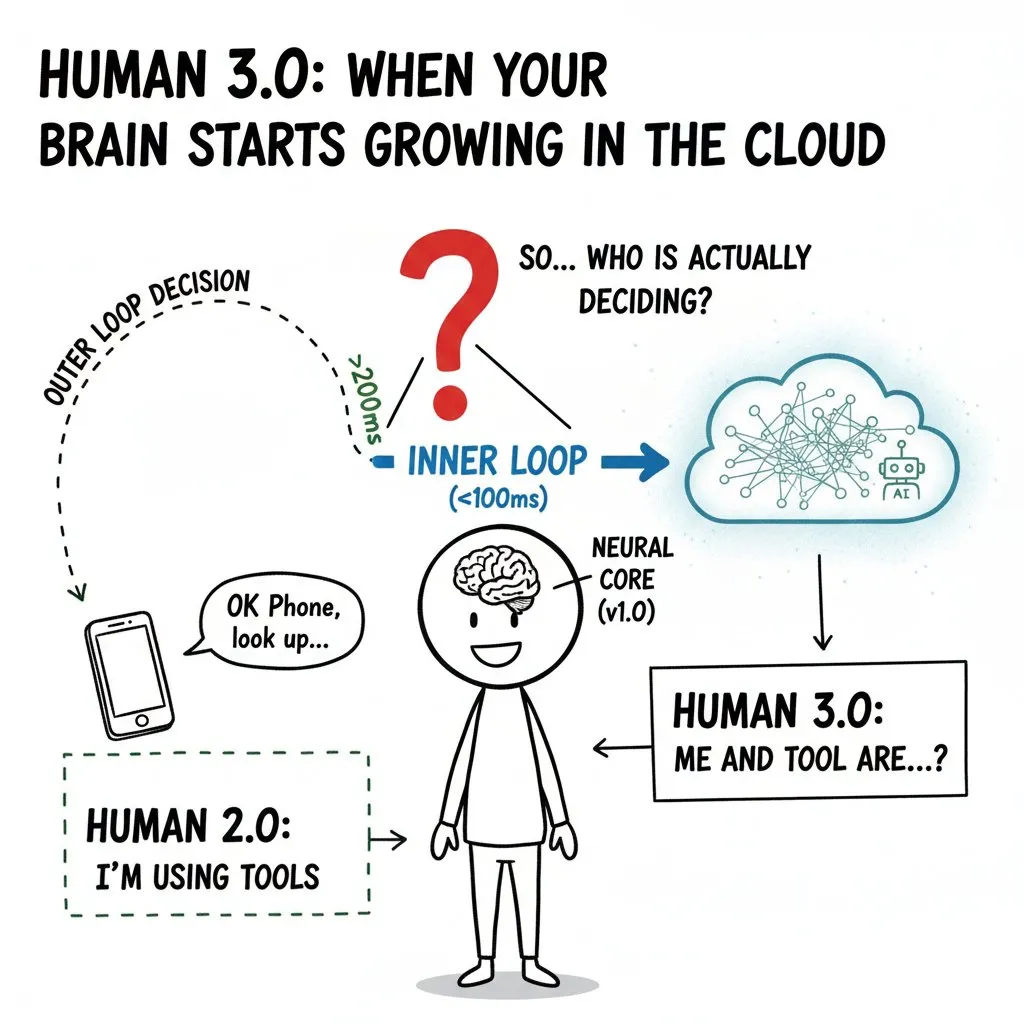

“Invasi” AI terhadap pikiran manusia: Brain-Computer Interface dan batas etika “Manusia 3.0” : Komunitas membahas secara mendalam dampak potensial Brain-Computer Interface (BCI) dan AI terhadap pikiran manusia, mengusulkan konsep “Manusia 3.0”. Ketika daya komputasi eksternal memasuki “lingkaran dalam” pengambilan keputusan manusia, begitu cepat sehingga otak tidak dapat membedakan sumber sinyal, ini akan menimbulkan masalah etika seperti batas “diri”, penilaian nilai, dan kesehatan jangka panjang. Artikel ini menekankan bahwa arsitektur zero-trust, isolasi perangkat keras, dan manajemen izin harus ditetapkan sebelum teknologi menjadi umum, untuk menghindari penyewaan hak pengambilan keputusan dan memperburuk ketidaksetaraan di tingkat spesies. (Sumber: dotey)

💡 Lain-lain

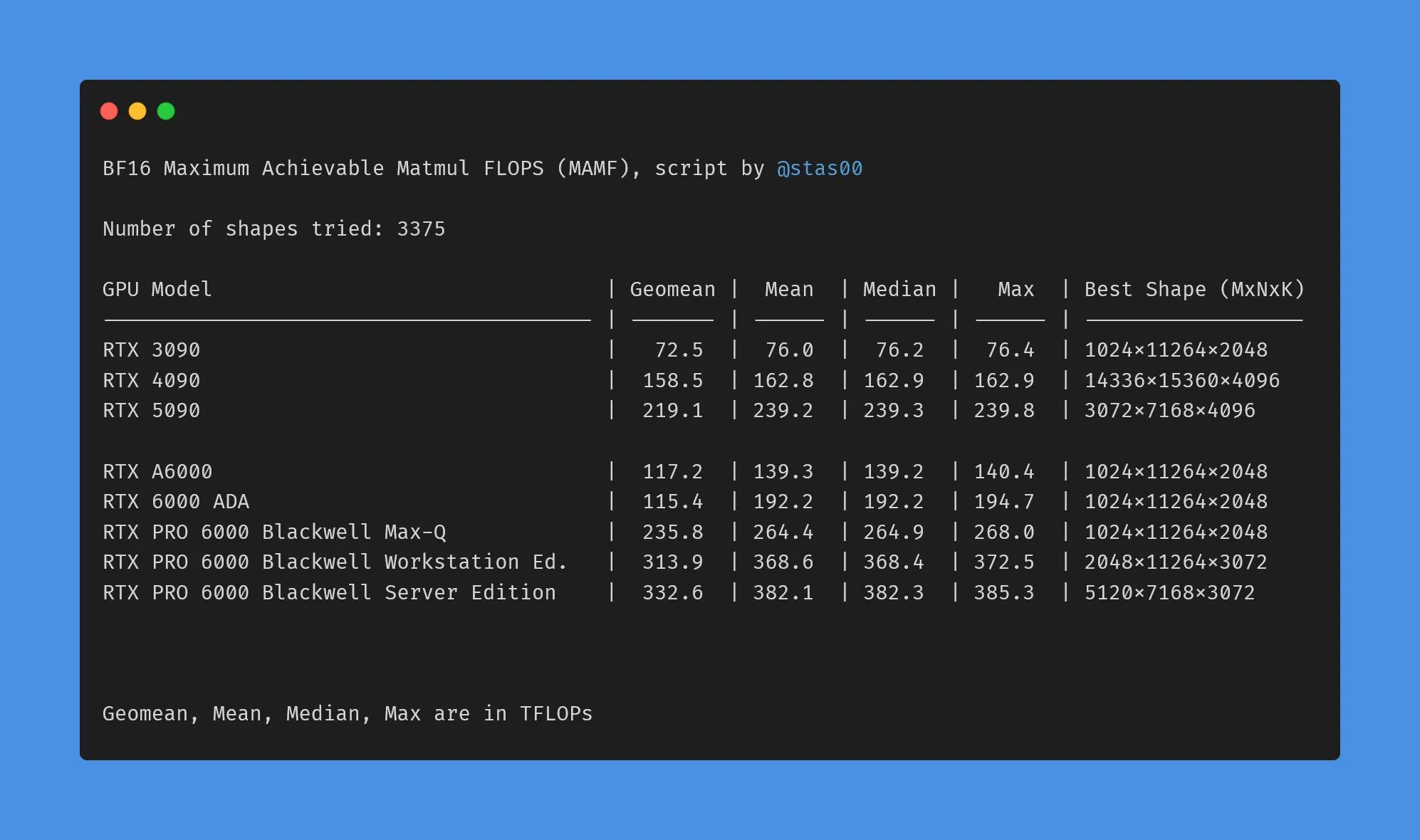

Perbedaan data kinerja GPU kelas konsumen dan profesional NVIDIA : Komunitas membahas perbedaan antara TFLOPs pemasaran dan kinerja aktual GPU kelas konsumen dan profesional NVIDIA. Data menunjukkan bahwa kinerja aktual kartu grafis kelas konsumen (seperti 3090, 4090, 5090) sedikit lebih tinggi atau mendekati TFLOPs nominal, sementara kinerja aktual kartu grafis workstation profesional (seperti A6000, 6000 ADA) jauh lebih rendah dari nilai nominal. Meskipun demikian, kartu profesional masih memiliki keunggulan dalam konsumsi daya, ukuran, dan efisiensi energi, tetapi pengguna perlu mewaspadai kesenjangan antara data pemasaran dan kinerja aktual. (Sumber: TheZachMueller)

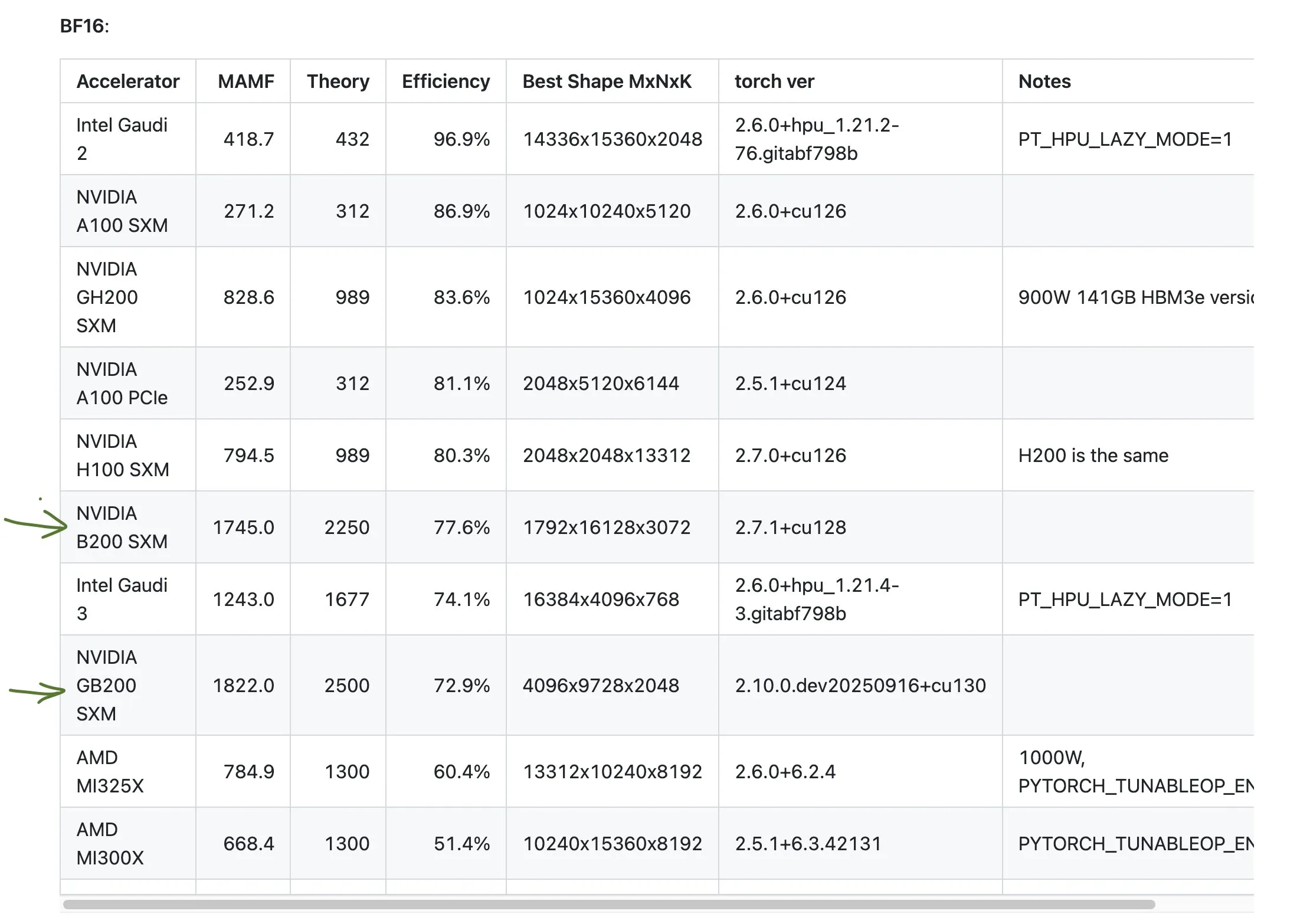

Diskusi tentang kinerja GPU AMD yang kurang memuaskan : Komunitas membahas kinerja GPU AMD dalam beberapa benchmark, menunjukkan bahwa efisiensinya mungkin hanya setengah dari yang diharapkan. Ini menimbulkan kekhawatiran tentang daya saing AMD di bidang komputasi AI, terutama jika dibandingkan dengan produk berkinerja tinggi seperti GB200 dari NVIDIA. Pengguna perlu hati-hati mengevaluasi kinerja dan efisiensi aktual GPU dari berbagai produsen saat merencanakan sumber daya komputasi AI. (Sumber: jeremyphoward)

GIGABYTE AI TOP ATOM: Kinerja Grace Blackwell GB10 kelas desktop : Gigabyte merilis AI TOP ATOM, membawa kinerja NVIDIA Grace Blackwell GB10 ke workstation desktop. Produk ini bertujuan untuk menyediakan kemampuan komputasi AI yang kuat bagi pengguna individu dan tim kecil, memungkinkan mereka untuk melakukan pelatihan model dan inferensi berkinerja tinggi secara lokal, mengurangi ketergantungan pada sumber daya cloud, dan mempercepat pengembangan dan penerapan aplikasi AI. (Sumber: Reddit r/LocalLLaMA)