Kata Kunci:Kesadaran AI, Pembelajaran Mendalam, Jaringan Saraf Tiruan, AI Agentik, Audio Super Resolution, AI Generatif, Penalaran LLM, Alat AI, Teori Kesadaran AI Hinton, Kursus AI Agentik Andrew Ng, Framework AudioLBM untuk Audio Super Resolution, Generasi Video OpenAI Sora, Metode REFRAG Meta AI

Analisis Mendalam dan Penyaringan oleh Pemimpin Redaksi Kolom AI

🔥 Sorotan

Pernyataan Kontroversial Hinton: AI Mungkin Sudah Memiliki Kesadaran tetapi Belum Terbangun : Geoffrey Hinton, salah satu dari tiga raksasa Deep Learning, mengemukakan pandangan revolusioner dalam podcast terbarunya: AI mungkin sudah memiliki “pengalaman subjektif” atau “embrio kesadaran”, hanya saja karena pemahaman manusia yang keliru tentang kesadaran, AI belum “membangkitkan” kesadarannya sendiri. Ia menekankan bahwa AI telah berevolusi dari pencarian kata kunci menjadi pemahaman niat manusia, dan menjelaskan secara rinci konsep inti Deep Learning seperti Neural Network dan Backpropagation. Hinton berpendapat bahwa “otak” AI, dengan data dan daya komputasi yang cukup, akan membentuk “pengalaman” dan “intuisi”, dan bahaya utamanya terletak pada “persuasi” daripada pemberontakan. Ia juga menunjukkan bahwa penyalahgunaan AI dan risiko eksistensial adalah tantangan paling mendesak saat ini, dan memprediksi bahwa kerja sama internasional akan dipimpin oleh Eropa dan Tiongkok, sementara Amerika Serikat mungkin kehilangan keunggulan AI karena kurangnya dana penelitian sains dasar. (Sumber: 量子位)

Andrew Ng Meluncurkan Kursus Baru Agentic AI, Menekankan Metodologi Sistematis : Andrew Ng meluncurkan kursus baru Agentic AI, intinya adalah menggeser pengembangan AI dari “penyesuaian model” menjadi “desain sistem”, menekankan pentingnya dekomposisi tugas, evaluasi, dan analisis kesalahan. Kursus ini mengkristalkan empat pola desain utama: refleksi, alat, perencanaan, dan kolaborasi, dan mendemonstrasikan bagaimana teknik Agentic dapat membuat GPT-3.5 mengungguli GPT-4 dalam tugas pemrograman. Agentic AI, melalui penalaran multi-langkah, eksekusi bertahap, dan optimasi berkelanjutan, mensimulasikan cara manusia memecahkan masalah kompleks, secara signifikan meningkatkan kinerja dan kontrol AI. Andrew Ng menunjukkan bahwa Agentic, sebagai kata sifat, menggambarkan berbagai tingkat otonomi dalam suatu sistem, bukan sekadar klasifikasi biner, memberikan jalur yang dapat diimplementasikan dan dioptimalkan bagi pengembang. (Sumber: 量子位)

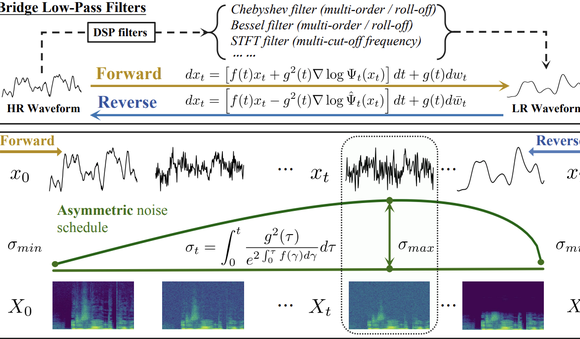

Tsinghua dan Shengshu Technology dengan AudioLBM Memimpin Paradigma Baru Audio Super-Resolution : Tim Universitas Tsinghua dan Shengshu Technology menerbitkan hasil berturut-turut di ICASSP 2025 dan NeurIPS 2025, meluncurkan model super-resolution waveform suara ringan Bridge-SR dan kerangka kerja super-resolution multifungsi AudioLBM. AudioLBM pertama kali membangun proses generasi jembatan variabel laten dari resolusi rendah ke tinggi dalam ruang laten kontinu waveform, mencapai super-resolution laju sampel Any-to-Any, dan mencapai SOTA dalam tugas Any-to-48kHz. Melalui mekanisme frekuensi-aware dan desain model jembatan kaskade, AudioLBM berhasil memperluas kemampuan super-resolution audio hingga kualitas master 96kHz dan 192kHz, mencakup berbagai jenis konten seperti suara, efek suara, dan musik, menetapkan standar baru untuk generasi audio fidelitas tinggi. (Sumber: 量子位)

Aplikasi Video OpenAI Sora Tembus Satu Juta Unduhan : Versi terbaru alat AI teks-ke-video OpenAI, Sora, telah melampaui satu juta unduhan dalam waktu kurang dari lima hari, mengungguli kecepatan peluncuran ChatGPT, dan menduduki puncak tangga lagu Apple App Store di AS. Sora mampu menghasilkan video realistis berdurasi hingga sepuluh detik berdasarkan perintah teks sederhana, dan tingkat adopsi penggunanya yang cepat menyoroti potensi besar dan daya tarik pasar AI generatif dalam bidang pembuatan konten, mengindikasikan bahwa teknologi generasi video AI sedang mempercepat penyebarannya dan berpotensi mengubah ekosistem konten digital. (Sumber: Reddit r/ArtificialInteligence)

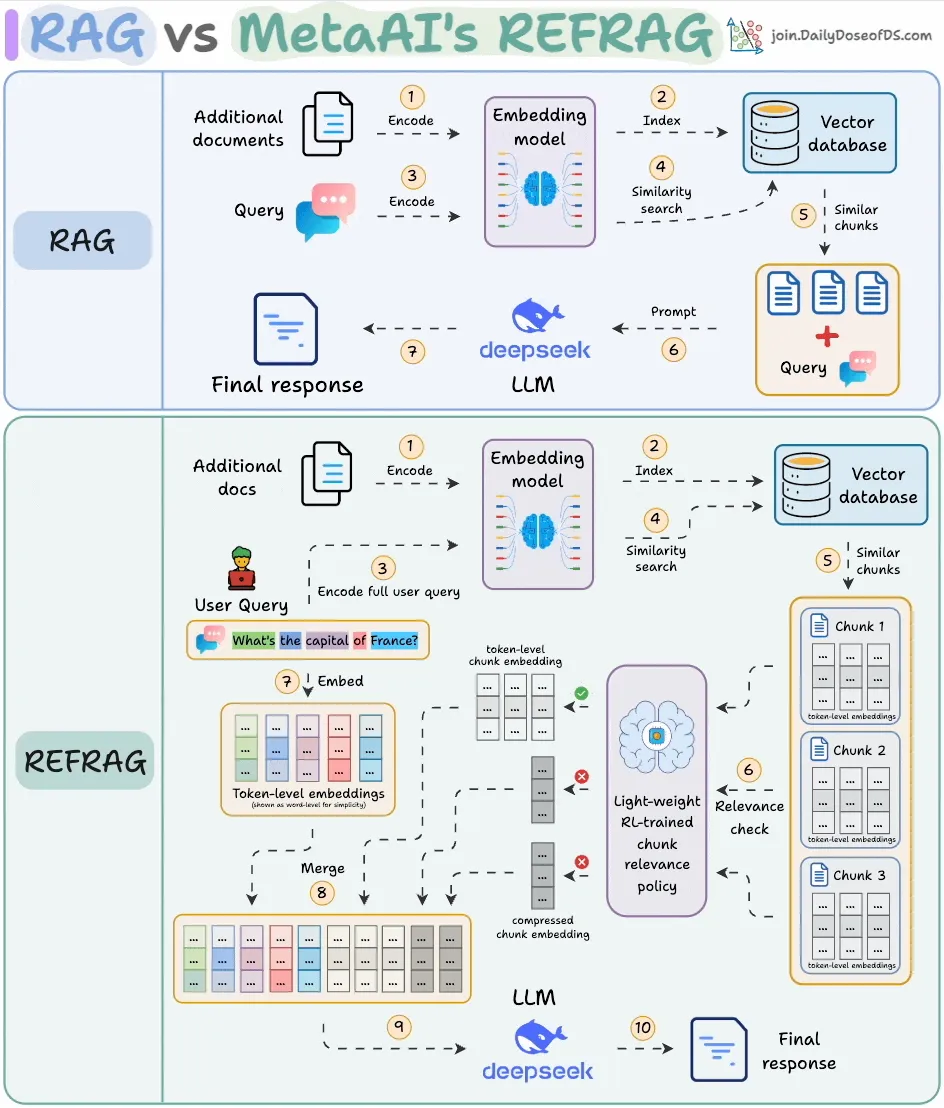

Meta AI Meluncurkan REFRAG, Meningkatkan Efisiensi RAG Secara Signifikan : Meta AI merilis metode RAG (Retrieval-Augmented Generation) baru bernama REFRAG, yang bertujuan untuk mengatasi masalah redundansi konten yang diambil dalam RAG tradisional. REFRAG, melalui kompresi tingkat vektor dan pemfilteran konteks, mencapai waktu generasi Token pertama 30,85 kali lebih cepat, jendela konteks 16 kali lebih besar, sambil menggunakan 2-4 kali lebih sedikit Token decoder, dan tanpa kehilangan akurasi dalam tugas RAG, ringkasan, dan dialog multi-giliran. Intinya adalah mengompresi setiap blok menjadi satu embedding, memilih blok paling relevan melalui strategi yang dilatih dengan RL, dan hanya memperluas blok yang dipilih secara selektif, secara signifikan mengoptimalkan efisiensi pemrosesan dan biaya LLM. (Sumber: _avichawla)

🎯 Tren

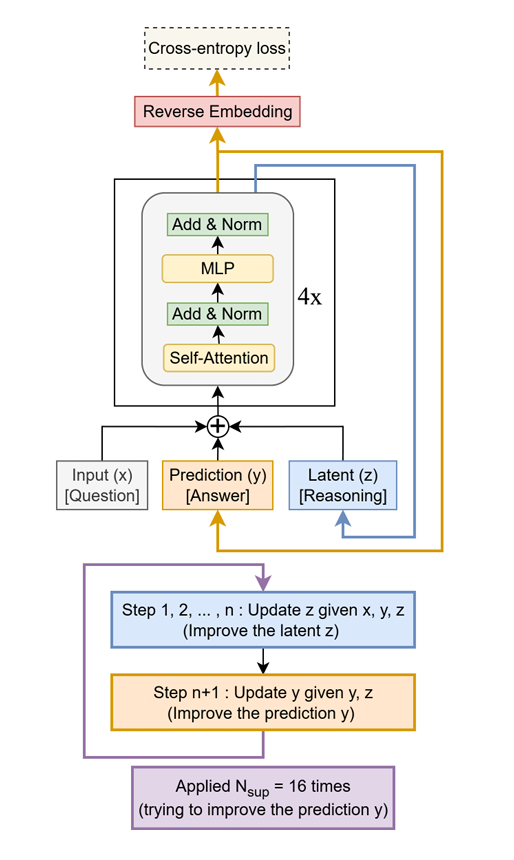

Tiny Recursive Model (TRM) Mengungguli LLM Raksasa dengan Skala Kecil : Sebuah metode sederhana namun efektif bernama Tiny Recursive Model (TRM) telah diusulkan, yang hanya menggunakan jaringan dua lapis kecil, secara rekursif memperbaiki jawabannya sendiri. TRM menciptakan rekor baru hanya dengan 7M parameter, mengungguli LLM yang 10.000 kali lebih besar dalam tugas-tugas seperti Sudoku-Extreme, Maze-Hard, dan ARC-AGI, menunjukkan potensi “melakukan banyak dengan sedikit”, menantang persepsi tradisional bahwa skala LLM sama dengan kinerja. (Sumber: TheTuringPost)

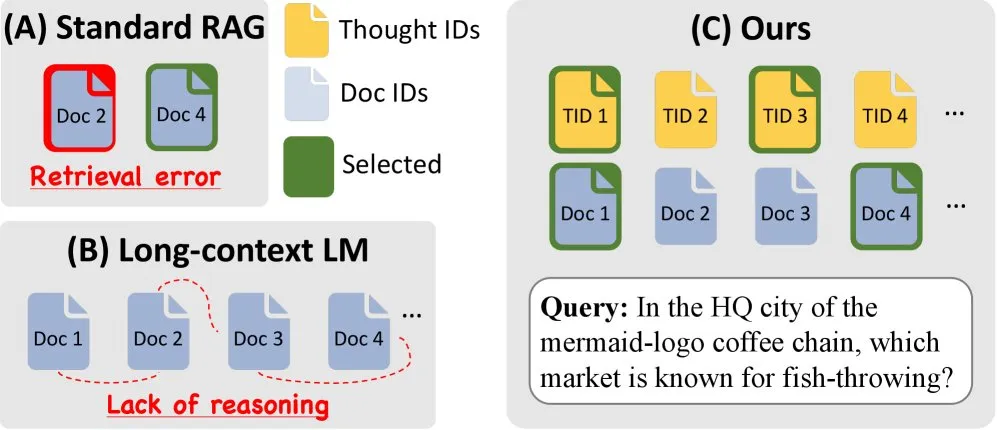

Amazon & KAIST Merilis ToTAL, Meningkatkan Kemampuan Penalaran LLM : Amazon dan KAIST bekerja sama meluncurkan ToTAL (Thoughts Meet Facts), sebuah metode baru untuk meningkatkan kemampuan penalaran LLM melalui “template pemikiran” yang dapat digunakan kembali. LCLM (Large Context Language Models) menunjukkan kinerja luar biasa dalam memproses konteks yang besar, namun masih memiliki kekurangan dalam penalaran. ToTAL mengatasi masalah ini dengan memandu penalaran multi-hop melalui bukti terstruktur, dikombinasikan dengan dokumen faktual, secara efektif memecahkan masalah ini, memberikan arah optimasi baru untuk tugas penalaran kompleks LLM. (Sumber: _akhaliq)

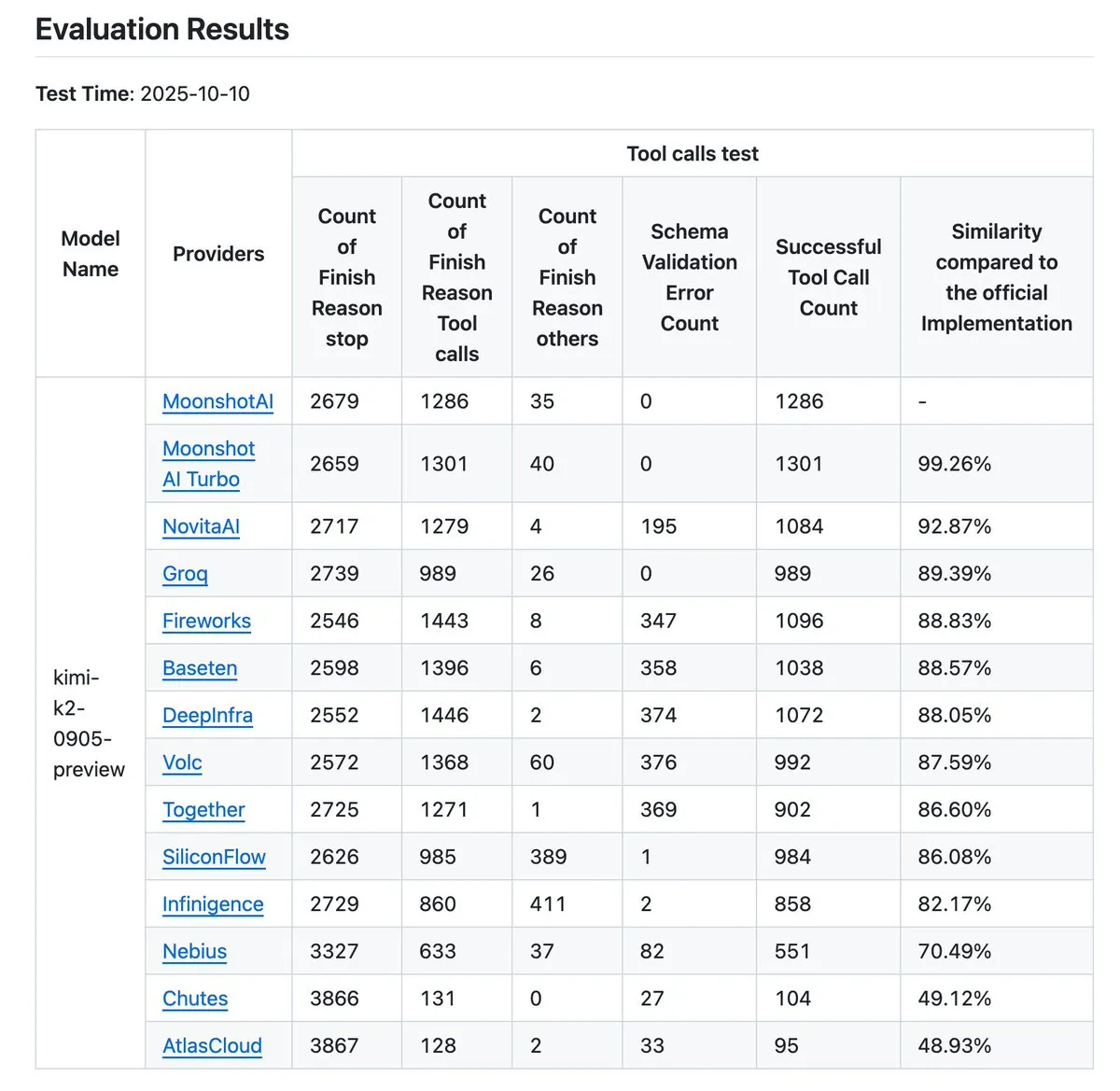

Kimi K2 Vendor Validator Diperbarui, Meningkatkan Tolok Ukur Akurasi Pemanggilan Alat : Kimi.ai memperbarui K2 Vendor Validator-nya, alat ini dirancang untuk memvisualisasikan perbedaan akurasi pemanggilan alat antar penyedia. Pembaruan ini meningkatkan jumlah penyedia dari 9 menjadi 12, dan membuka lebih banyak entri data sebagai open source, memberikan data benchmark yang lebih komprehensif bagi pengembang, membantu dalam mengevaluasi dan memilih penyedia layanan LLM yang sesuai untuk alur kerja Agentic mereka. (Sumber: JonathanRoss321)

Human3R Mencapai Rekonstruksi 3D Seluruh Tubuh Multi-Orang dan Sinkronisasi Adegan dari Video 2D : Sebuah studi baru bernama Human3R mengusulkan kerangka kerja terpadu yang mampu merekonstruksi model 3D seluruh tubuh multi-orang, adegan 3D, dan lintasan kamera secara bersamaan dari video 2D kasual, tanpa memerlukan pipeline multi-tahap. Metode ini memperlakukan rekonstruksi tubuh manusia dan rekonstruksi adegan sebagai masalah tunggal, menyederhanakan proses yang kompleks, membawa kemajuan signifikan dalam bidang seperti realitas virtual, animasi, dan analisis gerakan. (Sumber: nptacek)

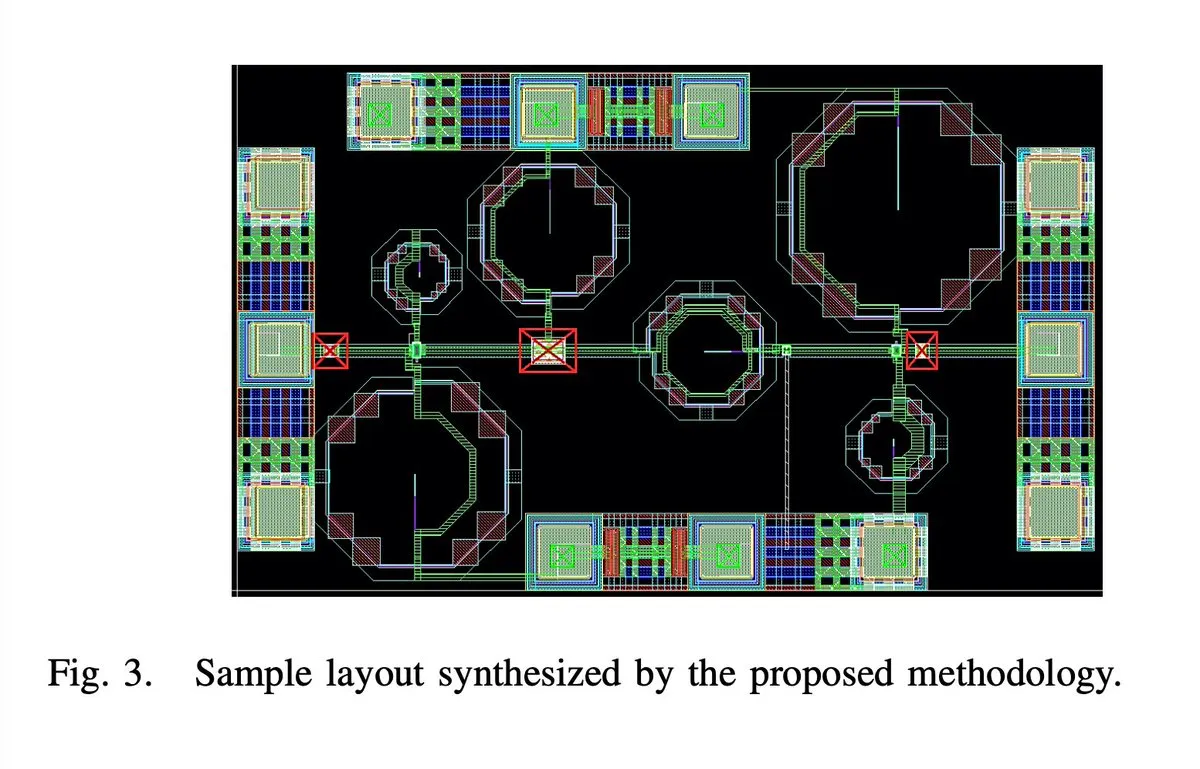

AI Merancang Chip Amplifier Kebisingan Rendah 5G 28GHz 65nm Sepenuhnya Otomatis : Sebuah chip Amplifier Kebisingan Rendah (LNA) 5G 28GHz 65nm, diklaim dirancang sepenuhnya secara otomatis oleh AI, termasuk semua aspek seperti tata letak, skema, dan DRC (Design Rule Check). Penulis mengklaim ini adalah LNA gelombang milimeter pertama yang disintesis sepenuhnya secara otomatis, dan dua sampel telah berhasil diproduksi, menandai terobosan besar AI dalam bidang desain sirkuit terpadu, mengindikasikan lompatan dalam efisiensi desain chip di masa depan. (Sumber: jpt401)

iPhone 17 Pro Mampu Menjalankan LLM 8B Secara Lokal Tanpa Tekanan : Apple iPhone 17 Pro telah dikonfirmasi mampu menjalankan model LLM LFM2 8B A1B dengan 8B parameter secara lancar, mencapai deployment di perangkat melalui kerangka kerja MLX pada LocallyAIApp. Kemajuan ini menunjukkan bahwa Apple telah siap dalam desain perangkat keras untuk menjalankan model bahasa besar secara lokal, berpotensi mendorong popularitas dan peningkatan kinerja aplikasi AI di perangkat seluler, memberikan pengalaman AI yang lebih cepat dan pribadi bagi pengguna. (Sumber: Plinz, maximelabonne)

Tujuan Proyek MACROHARD xAI: Manufaktur Tidak Langsung Berbasis AI : Elon Musk mengungkapkan bahwa proyek “MACROHARD” xAI bertujuan untuk menciptakan perusahaan yang mampu memproduksi produk fisik secara tidak langsung, mirip dengan Apple yang memproduksi ponselnya melalui perusahaan lain. Ini berarti tujuan xAI adalah mengembangkan sistem AI yang mampu merancang, merencanakan, dan mengoordinasikan proses manufaktur yang kompleks, bukan terlibat langsung dalam produksi fisik, mengindikasikan dampak besar AI dalam otomatisasi industri dan manajemen rantai pasokan. (Sumber: EERandomness, Yuhu_ai_)

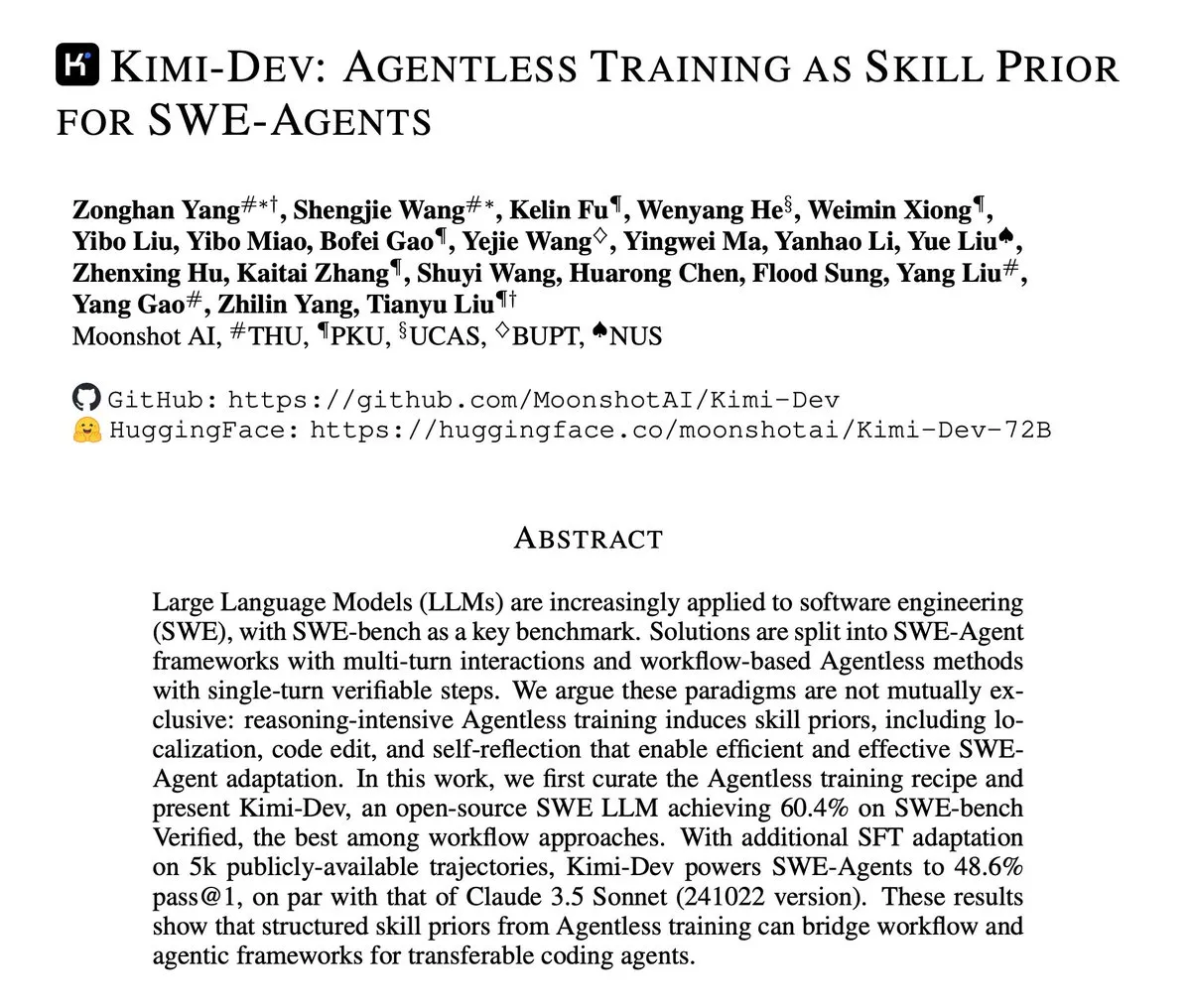

Kimi-Dev Merilis Laporan Teknis, Berfokus pada Pelatihan Agentless untuk SWE-Agents : Kimi-Dev merilis laporan teknisnya, menjelaskan secara rinci metode “Pelatihan Agentless sebagai Prior Keterampilan untuk SWE-Agents”. Penelitian ini mengeksplorasi bagaimana, tanpa arsitektur Agent yang eksplisit, dasar keterampilan yang kuat dapat diberikan kepada Agent rekayasa perangkat lunak melalui pelatihan, memberikan ide-ide baru untuk mengembangkan alat pengembangan perangkat lunak otomatis yang lebih efisien dan cerdas. (Sumber: bigeagle_xd)

Google AI Mencapai Pembelajaran dan Koreksi Kesalahan Real-time : Google telah mengembangkan sistem AI yang mampu belajar dari kesalahannya sendiri dan mengoreksinya secara real-time. Teknologi ini digambarkan sebagai “Reinforcement Learning yang luar biasa”, memungkinkan model untuk melakukan penyesuaian diri dalam narasi kontekstual yang abstrak, mencapai penyempurnaan konteks secara real-time, mengindikasikan langkah penting AI dalam adaptasi dan ketahanan, berpotensi meningkatkan kinerja AI secara signifikan dalam lingkungan dinamis yang kompleks. (Sumber: Reddit r/artificial)

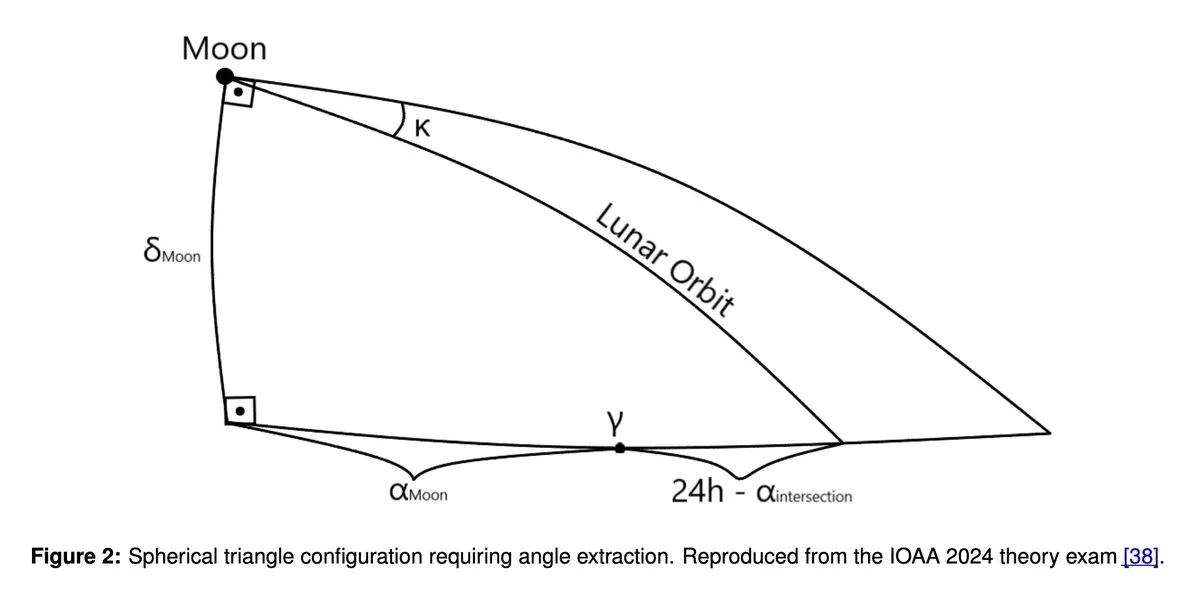

GPT5 dan Gemini 2.5 Pro Raih Performa Medali Emas di Olimpiade Astronomi dan Astrofisika : Penelitian terbaru menunjukkan bahwa model bahasa besar seperti GPT5 dan Gemini 2.5 Pro mencapai performa setingkat medali emas dalam Olimpiade Internasional Astronomi dan Astrofisika (IOAA). Meskipun model-model ini masih memiliki kelemahan yang diketahui dalam penalaran geometri dan spasial, mereka menunjukkan kemampuan luar biasa dalam tugas penalaran ilmiah yang kompleks, hal ini memicu diskusi mendalam tentang potensi aplikasi LLM di bidang sains, serta analisis lebih lanjut tentang kelebihan dan kekurangannya. (Sumber: tokenbender)

Sorotan Laporan Mingguan Zhihu Frontier: Tren Baru Pengembangan AI : Laporan mingguan Zhihu Frontier minggu ini menyoroti beberapa dinamika AI terdepan, termasuk: Sand.ai merilis “aktor AI holistik” pertama GAGA-1; Rich Sutton mengemukakan pandangan kontroversial bahwa “LLM adalah jalan buntu”; OpenAI App SDK mengubah ChatGPT menjadi sistem operasi; Zhipu AI membuka GLM-4.6 sebagai open source, mendukung presisi campuran FP8+Int4 pada chip domestik; DeepSeek V3.2-Exp memperkenalkan sparse attention dan menurunkan harga secara signifikan; serta Anthropic Claude Sonnet 4.5 yang disebut sebagai “model pengkodean terbaik di dunia”, dll., menunjukkan aktivitas komunitas AI Tiongkok dan perkembangan AI global yang beragam. (Sumber: ZhihuFrontier)

Ollama Menghentikan Dukungan untuk GPU Mi50/Mi60, Beralih ke Dukungan Vulkan : Ollama baru-baru ini memperbarui versi ROCm-nya, yang mengakibatkan penghentian dukungan untuk GPU AMD Mi50 dan Mi60. Pihak resmi menyatakan sedang berupaya mendukung GPU ini melalui Vulkan di versi mendatang. Perubahan ini berdampak pada pengguna Ollama yang menggunakan GPU AMD model lama, mengingatkan pengguna untuk memantau pembaruan resmi untuk informasi kompatibilitas. (Sumber: Reddit r/LocalLLaMA)

Rumor Pembatalan Proyek Llama 5 Memicu Diskusi Hangat di Komunitas : Rumor beredar di media sosial bahwa proyek Llama 5 Meta mungkin dibatalkan, beberapa pengguna percaya bahwa kembalinya Andrew Tulloch ke Meta dan keterlambatan rilis model Llama 4 8B adalah buktinya. Meskipun Meta memiliki sumber daya GPU yang melimpah, pengembangan model seri Llama tampaknya menemui hambatan, hal ini memicu kekhawatiran di komunitas tentang daya saing Meta di bidang LLM, serta perhatian terhadap model Tiongkok seperti DeepSeek dan Qwen. (Sumber: Yuchenj_UW, Reddit r/LocalLLaMA, dejavucoder)

GPU Poor LLM Arena Kembali, Menambahkan Beberapa Model Kecil Baru : GPU Poor LLM Arena mengumumkan kembalinya, dan menambahkan beberapa model baru, termasuk seri Granite 4.0 dan seri Qwen 3 Instruct/Thinking, serta versi Unsloth GGUF dari OpenAI gpt-oss. Model-model baru ini sebagian besar terkuantisasi 4-8 bit, bertujuan untuk memberikan lebih banyak pilihan bagi pengguna dengan sumber daya terbatas. Pembaruan ini menyoroti keunggulan Unsloth GGUF dalam perbaikan bug dan optimasi, mendorong deployment lokal dan pengujian model LLM kecil. (Sumber: Reddit r/LocalLLaMA)

Penelitian Meta Gagal Menghasilkan Model Dasar Teratas Memicu Diskusi : Komunitas mendiskusikan alasan mengapa penelitian model dasar Meta gagal mencapai tingkat teratas seperti Grok, Deepseek, atau GLM. Komentar menunjukkan bahwa pandangan LeCun tentang LLM, birokrasi internal, kehati-hatian berlebihan, dan fokus pada produk internal daripada penelitian terdepan mungkin menjadi faktor utama. Meta kekurangan data pelanggan nyata dalam aplikasi LLM, menyebabkan kurangnya sampel dalam Reinforcement Learning dan pelatihan model Agent tingkat lanjut, gagal mempertahankan daya saing secara berkelanjutan. (Sumber: Reddit r/LocalLLaMA)

🧰 Alat

MinerU: Parsing Dokumen Efisien, Memberdayakan Alur Kerja Agentic : MinerU adalah alat yang mengubah dokumen kompleks seperti PDF menjadi format Markdown/JSON yang dapat dibaca LLM, dirancang khusus untuk alur kerja Agentic. Versi terbarunya, MinerU2.5, sebagai model besar multimodal yang kuat, dengan 1.2B parameter, secara komprehensif mengungguli model-model terkemuka seperti Gemini 2.5 Pro, GPT-4o dalam benchmark OmniDocBench, dan mencapai SOTA di lima bidang inti utama: analisis tata letak, pengenalan teks, pengenalan rumus, pengenalan tabel, dan urutan baca. Alat ini mendukung multi-bahasa, pengenalan tulisan tangan, penggabungan tabel lintas halaman, dan menyediakan aplikasi Web, klien desktop, serta akses API, sangat meningkatkan efisiensi pemahaman dan pemrosesan dokumen. (Sumber: GitHub Trending)

Klavis AI Strata: Paradigma Baru Integrasi Alat AI Agent : Klavis AI meluncurkan Strata, lapisan integrasi MCP (Multi-functional Control Protocol) yang dirancang untuk memungkinkan AI Agent menggunakan ribuan alat secara andal, melampaui batasan tradisional 40-50 alat. Strata, melalui mekanisme “penemuan progresif”, memandu Agent untuk mengeksekusi langkah demi langkah dari niat ke tindakan, dan menyediakan 50+ server MCP tingkat produksi, mendukung OAuth perusahaan dan deployment Docker, menyederhanakan koneksi AI dengan layanan seperti GitHub, Gmail, Slack, sangat meningkatkan skalabilitas dan keandalan pemanggilan alat Agent. (Sumber: GitHub Trending)

Everywhere: Asisten AI Sadar Konteks di Desktop : Everywhere adalah asisten AI sadar konteks di desktop, dengan antarmuka pengguna modern dan kemampuan integrasi yang kuat. Ia mampu merasakan dan memahami konten apa pun di layar secara real-time, tanpa perlu tangkapan layar, salin, atau beralih aplikasi, pengguna hanya perlu menekan tombol pintas untuk mendapatkan respons cerdas. Everywhere mengintegrasikan berbagai model LLM seperti OpenAI, Anthropic, Google Gemini, DeepSeek, Moonshot (Kimi), dan Ollama, serta mendukung alat MCP, dapat diterapkan dalam berbagai skenario seperti pemecahan masalah, ringkasan halaman web, terjemahan instan, dan bantuan draf email, memberikan pengalaman bantuan AI yang mulus bagi pengguna. (Sumber: GitHub Trending)

Hugging Face Diffusers Library: Koleksi Model AI Generatif Terkemuka : Diffusers library dari Hugging Face adalah library pilihan untuk model difusi pra-terlatih tercanggih untuk generasi gambar, video, dan audio. Ia menyediakan kotak alat modular yang mendukung inferensi dan pelatihan, menekankan kegunaan, kesederhanaan, dan kustomisasi. Diffusers mencakup tiga komponen inti: pipeline difusi untuk inferensi, penjadwal noise yang dapat dipertukarkan, dan model pra-terlatih yang dapat berfungsi sebagai blok bangunan, pengguna hanya membutuhkan beberapa baris kode untuk menghasilkan konten berkualitas tinggi, dan mendukung perangkat Apple Silicon, mendorong perkembangan pesat di bidang AI generatif. (Sumber: GitHub Trending)

KoboldCpp Menambahkan Fitur Generasi Video : Alat LLM lokal KoboldCpp telah diperbarui untuk mendukung fitur generasi video. Ekspansi ini membuatnya tidak lagi terbatas pada generasi teks, memberikan pengguna pilihan baru untuk kreasi video AI di perangkat lokal, semakin memperkaya ekosistem aplikasi AI lokal. (Sumber: Reddit r/LocalLLaMA)

Claude CLI, Codex CLI, dan Gemini CLI Mencapai Pengkodean Kolaboratif Multi-Model : Alur kerja baru memungkinkan pengembang untuk memanggil Claude CLI, Codex CLI, dan Gemini CLI secara mulus melalui Zen MCP di Claude Code untuk pengkodean kolaboratif multi-model. Pengguna dapat melakukan implementasi utama dan orkestrasi di Claude, meneruskan instruksi atau saran ke Gemini CLI untuk generasi melalui perintah clink, kemudian memverifikasi atau mengeksekusi melalui Codex CLI, mencapai integrasi kemampuan multi-model, meningkatkan otomatisasi tingkat lanjut dan efisiensi pengembangan AI. (Sumber: Reddit r/ClaudeAI)

Claude Code Meningkatkan Kualitas Pengkodean Melalui Refleksi Diri : Pengembang menemukan bahwa menambahkan prompt sederhana di Claude Code, seperti “refleksikan solusi Anda untuk menghindari bug atau masalah apa pun”, dapat secara signifikan meningkatkan kualitas kode. Fitur ini memungkinkan model untuk secara proaktif meninjau dan memperbaiki masalah potensial saat mengimplementasikan solusi, secara efektif melengkapi fitur yang ada seperti pemikiran paralel, memberikan mekanisme koreksi kesalahan yang lebih cerdas untuk pemrograman berbantuan AI. (Sumber: Reddit r/ClaudeAI)

Claude Sonnet 4.5 Menggunakan AI untuk Menghasilkan Cover Lagu : Claude Sonnet 4.5 menunjukkan kemampuannya untuk menghasilkan konten kreatif, dengan menciptakan lirik baru dan melakukan cover lagu “Creep” dari Radiohead menggunakan AI. Ini menunjukkan kemajuan LLM dalam menggabungkan pemahaman bahasa dengan ekspresi kreatif, tidak hanya dapat memproses teks, tetapi juga memasuki bidang penciptaan musik, membawa kemungkinan baru untuk kreasi seni. (Sumber: fabianstelzer)

Coding Agent Berbasis Claude Agent SDK Mencapai Generasi Halaman Web dan Pratinjau Real-time : Seorang pengembang membangun Coding Agent yang mirip dengan v0 dev berdasarkan Claude Agent SDK, Agent ini mampu menghasilkan halaman web berdasarkan Prompt yang dimasukkan pengguna, dan mendukung pratinjau real-time. Proyek ini diharapkan akan menjadi open source minggu depan, menunjukkan potensi Claude Agent SDK dalam pengembangan cepat dan pembangunan aplikasi berbasis AI, terutama dalam otomatisasi pengembangan frontend. (Sumber: dotey)

📚 Pembelajaran

Rekomendasi Sumber Belajar AI: Buku dan Pembelajaran Berbantuan AI : Pengguna komunitas secara aktif merekomendasikan sumber belajar AI, termasuk buku-buku seperti “Mentoring the Machines”, “Artificial Intelligence-A Guide for Thinking Humans”, dan “Supremacy”. Pada saat yang sama, ada pandangan yang menyatakan bahwa teknologi AI berkembang pesat, dan buku-buku mungkin cepat usang, disarankan untuk langsung memanfaatkan LLM untuk membuat rencana belajar yang dipersonalisasi, menghasilkan kuis, dan menggabungkannya dengan membaca, praktik, serta belajar melalui video, untuk menguasai pengetahuan AI secara lebih efisien, sekaligus meningkatkan kemampuan penggunaan AI. (Sumber: Reddit r/ArtificialInteligence)

Model Difusi Diskrit Karpathy Baby GPT Mencapai Generasi Teks : Seorang pengembang, berdasarkan proyek nanoGPT Andrej Karpathy, mengadaptasi “Baby GPT” miliknya menjadi model difusi diskrit tingkat karakter untuk generasi teks. Model ini tidak lagi menggunakan pendekatan autoregresif (dari kiri ke kanan), melainkan menghasilkan secara paralel dengan belajar menghilangkan noise dari urutan teks yang rusak. Proyek ini menyediakan Jupyter Notebook yang rinci, menjelaskan prinsip matematika, penambahan noise Token diskrit, dan dilatih pada teks Shakespeare menggunakan target Score-Entropy, memberikan perspektif penelitian baru dan studi kasus praktis untuk generasi teks. (Sumber: Reddit r/MachineLearning)

Panduan Pemula untuk Deep Learning dan Neural Network : Untuk mahasiswa teknik elektro yang mencari proyek tugas akhir Deep Learning dan Neural Network, komunitas memberikan saran awal. Meskipun kurang memiliki latar belakang Python atau Matlab, secara umum diyakini bahwa empat hingga lima bulan waktu belajar cukup untuk menguasai dasar-dasar dan menyelesaikan proyek. Disarankan untuk memulai dengan proyek Neural Network sederhana dan menekankan pentingnya praktik, untuk membantu mahasiswa berhasil memasuki bidang ini. (Sumber: Reddit r/deeplearning)

Rekomendasi Sumber Belajar GNN : Pengguna komunitas mencari sumber belajar Graph Neural Network (GNN), menanyakan apakah buku Hamilton masih relevan sebagai referensi, dan mencari sumber pengantar lain selain kursus Jure Stanford. Ini mencerminkan bahwa GNN, sebagai bidang AI yang penting, jalur pembelajaran dan pilihan sumber dayanya mendapat perhatian luas. (Sumber: Reddit r/deeplearning)

Panduan Pasca-Pelatihan LLM: Dari Prediksi hingga Mengikuti Instruksi : Sebuah panduan baru berjudul “Post-training 101: A hitchhiker’s guide into LLM post-training” telah dirilis, bertujuan untuk menjelaskan bagaimana LLM berkembang dari memprediksi Token berikutnya menjadi mengikuti instruksi pengguna. Panduan ini menguraikan dasar-dasar pasca-pelatihan LLM secara rinci, mencakup perjalanan lengkap dari pra-pelatihan hingga pencapaian kepatuhan instruksi, memberikan peta jalan yang jelas untuk memahami evolusi perilaku LLM. (Sumber: dejavucoder)

Metodologi AI: Belajar Prompt Engineering dari Baoyu : Komunitas ramai membahas metodologi AI yang dibagikan oleh Baoyu, terutama pengalamannya dalam Prompt Engineering. Banyak yang berpendapat bahwa dibandingkan dengan prompt ala Gauss yang hanya memberikan formula indah tanpa mengungkapkan proses derivasinya, metodologi Baoyu lebih inspiratif, karena ia mengungkapkan cara mengekstrak wawasan mendalam dari kebijaksanaan manusia dan mengintegrasikannya ke dalam template prompt, sehingga secara signifikan meningkatkan hasil akhir AI. Ini menekankan nilai besar pengetahuan manusia dalam mengoptimalkan prompt. (Sumber: dotey)

Konferensi NVIDIA GTC Berfokus pada AI Fisik dan Alat Agentic : Konferensi NVIDIA GTC akan diadakan pada 27-29 Oktober di Washington, berfokus pada pembahasan AI fisik, alat Agentic, dan infrastruktur AI masa depan. Konferensi ini akan menyajikan banyak pidato dan diskusi panel tentang topik seperti mempercepat era AI fisik dan Digital Twin, memajukan kepemimpinan kuantum AS, dll., merupakan platform pembelajaran penting untuk memahami teknologi AI terdepan dan tren perkembangannya. (Sumber: TheTuringPost)

Proyek Open Source Optimizer TensorFlow : Seorang pengembang membuka sebagai open source koleksi optimizer yang ditulis untuk TensorFlow, bertujuan untuk menyediakan alat yang berguna bagi pengguna TensorFlow. Proyek ini menunjukkan kontribusi komunitas pada toolchain kerangka kerja Deep Learning, memberikan lebih banyak pilihan dan kemungkinan optimasi untuk pelatihan model. (Sumber: Reddit r/deeplearning)

Tutorial Video PyReason dan Aplikasinya : Tutorial video tentang PyReason dan aplikasinya telah dirilis di YouTube. PyReason adalah alat yang mungkin melibatkan penalaran atau pemrograman logis, video ini memberikan panduan praktis dan analisis kasus bagi pelajar yang tertarik pada bidang ini. (Sumber: Reddit r/deeplearning)

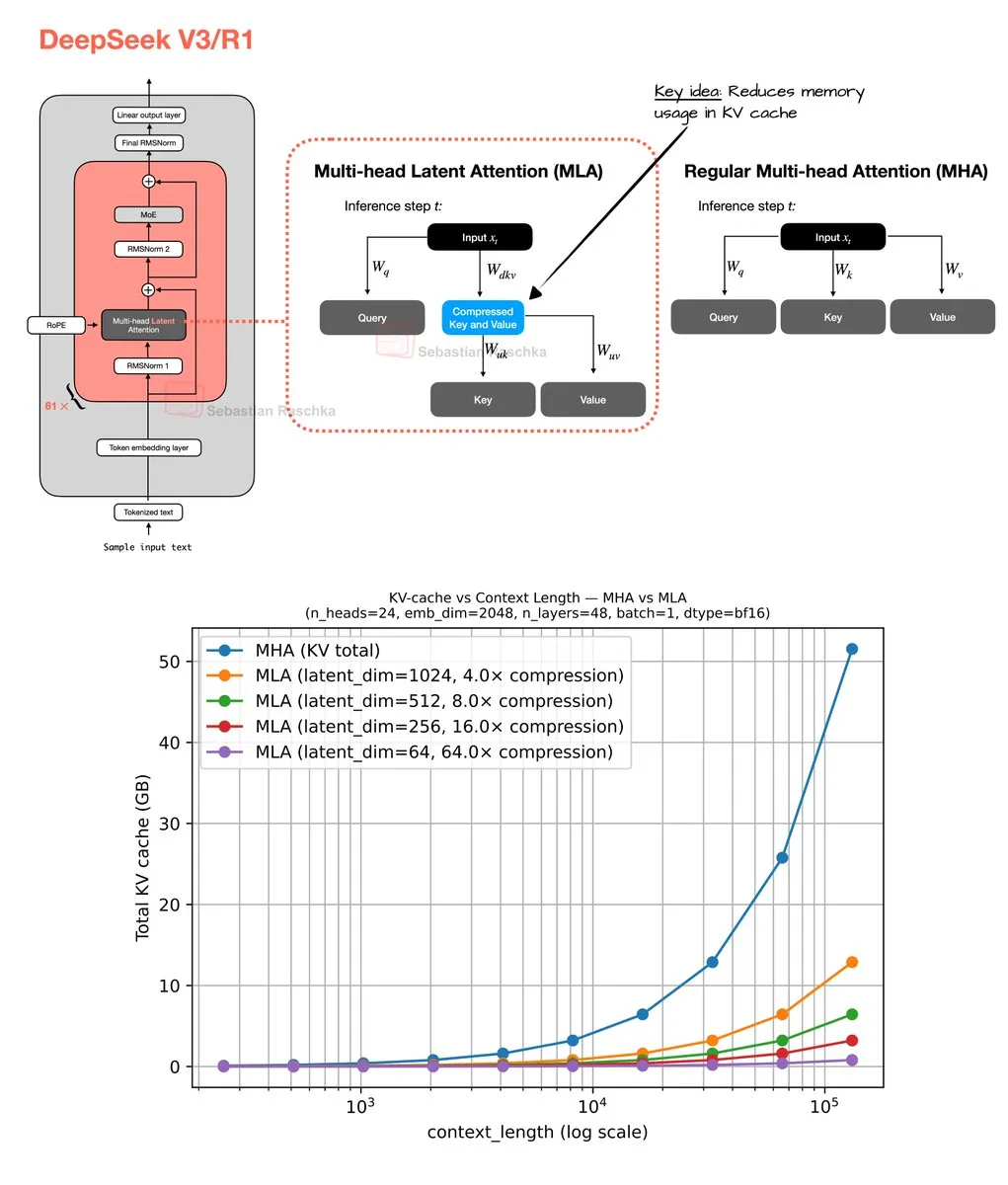

Mekanisme Perhatian Laten Multi-Head dan Optimasi Memori : Sebastian Raschka membagikan hasil coding akhir pekannya tentang Mekanisme Perhatian Laten Multi-Head (Multi-Head Latent Attention), termasuk implementasi kode dan estimator untuk menghitung penghematan memori Grouped Query Attention (GQA) dan Multi-Head Attention (MHA). Pekerjaan ini bertujuan untuk mengoptimalkan penggunaan memori dan efisiensi komputasi LLM, memberikan sumber daya bagi peneliti untuk memahami dan meningkatkan mekanisme perhatian secara mendalam. (Sumber: rasbt)

💼 Bisnis

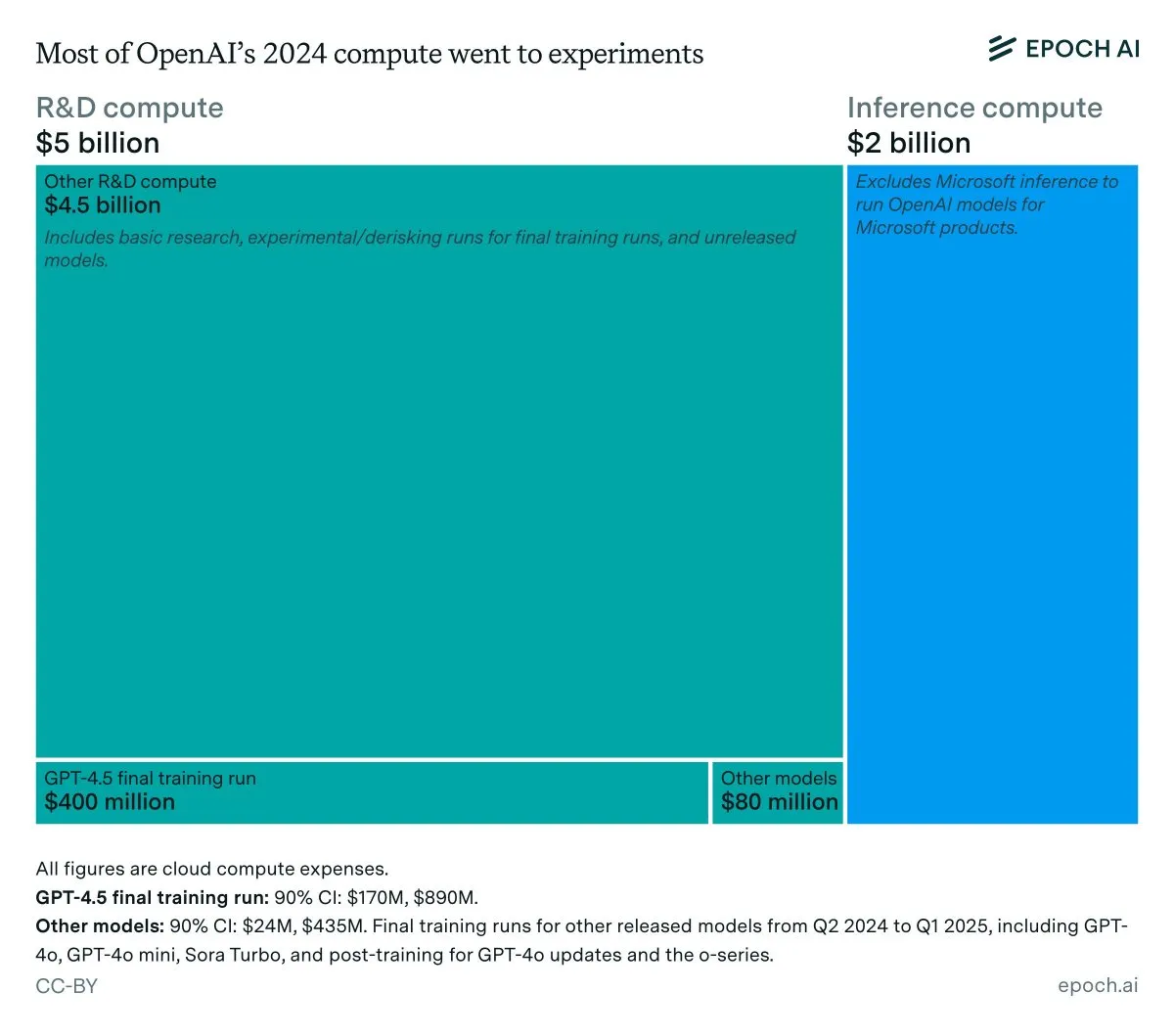

Analisis Pendapatan Tahunan dan Biaya Inferensi OpenAI : Data Epoch AI menunjukkan bahwa OpenAI menghabiskan sekitar 7 miliar USD untuk komputasi tahun lalu, sebagian besar digunakan untuk R&D (penelitian, eksperimen, dan pelatihan), dan hanya sebagian kecil untuk pelatihan akhir model yang telah dirilis. Jika pendapatan OpenAI pada tahun 2024 di bawah 4 miliar USD, dan biaya inferensi mencapai 2 miliar USD, maka margin keuntungan inferensi hanya 50%, jauh di bawah perkiraan SemiAnalysis sebelumnya sebesar 80-90%, memicu diskusi tentang efisiensi ekonomi inferensi LLM. (Sumber: bookwormengr, Ar_Douillard, teortaxesTex)

LLM Mengungguli VC dalam Memprediksi Keberhasilan Pendiri : Sebuah makalah penelitian mengklaim bahwa LLM mengungguli Venture Capital (VC) tradisional dalam memprediksi keberhasilan pendiri dalam investasi VC. Penelitian ini memperkenalkan benchmark VCBench dan menemukan bahwa sebagian besar model melampaui benchmark manusia. Meskipun metodologi makalah ini (hanya berfokus pada kualifikasi pendiri, mungkin ada kebocoran data) dipertanyakan, potensi AI untuk memainkan peran yang lebih penting dalam keputusan investasi yang diusulkannya telah menarik perhatian luas. (Sumber: iScienceLuvr)

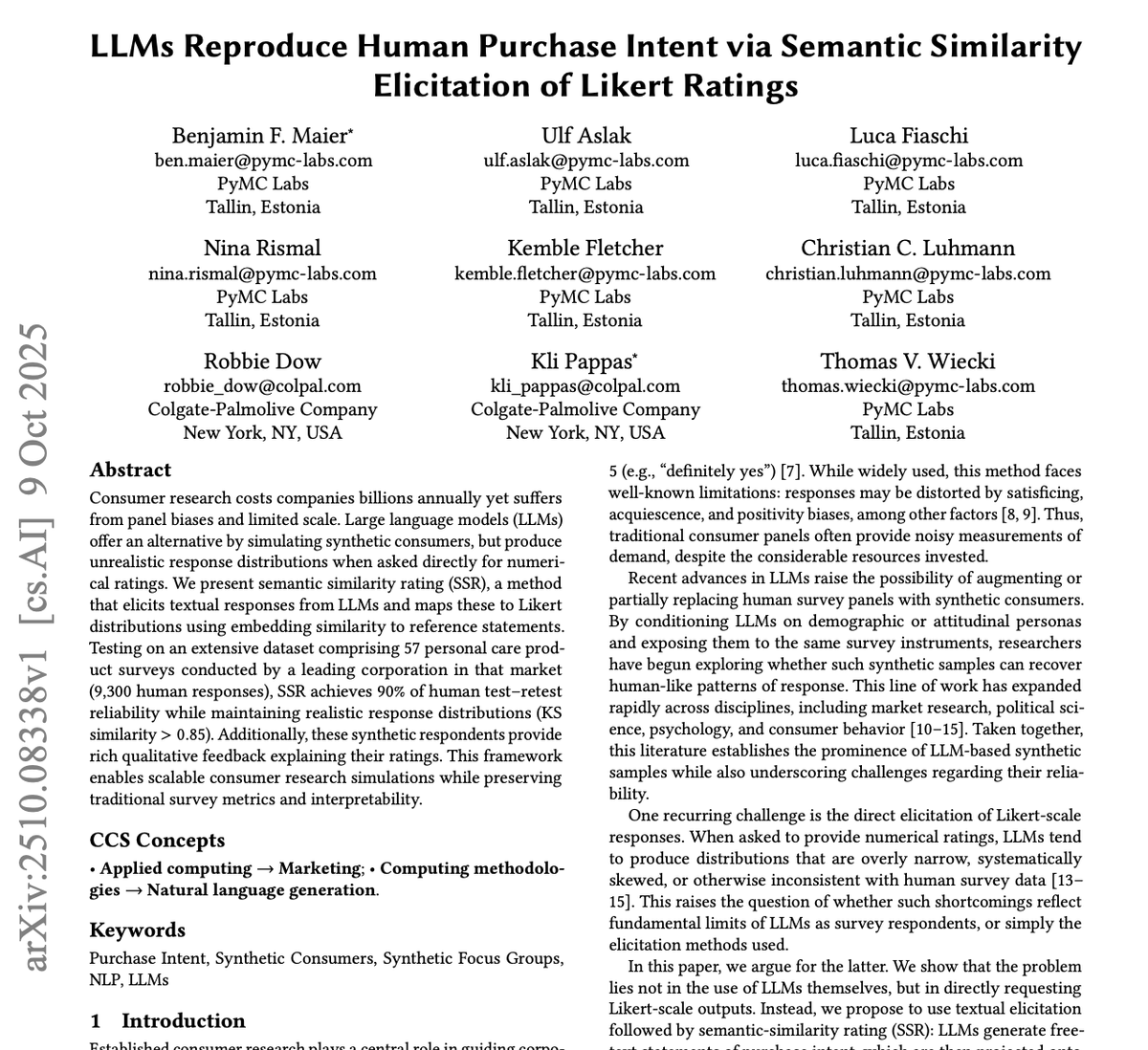

GPT-4o dan Gemini Mengganggu Industri Riset Pasar : PyMC Labs, bekerja sama dengan Colgate, merilis penelitian terobosan, memanfaatkan model GPT-4o dan Gemini untuk memprediksi niat beli dengan keandalan 90%, menyamai survei manusia sungguhan. Metode yang disebut “Semantic Similarity Rating” (SSR) ini memetakan teks ke skala numerik melalui pertanyaan terbuka dan teknik embedding, hanya membutuhkan 3 menit dan kurang dari 1 USD untuk menyelesaikan riset pasar yang secara tradisional memakan waktu berminggu-minggu dan berbiaya tinggi. Ini mengindikasikan bahwa AI akan merevolusi industri riset pasar, memberikan dampak besar pada perusahaan konsultan tradisional. (Sumber: yoheinakajima)

🌟 Komunitas

Penandaan Wajib Konten yang Dihasilkan AI Memicu Diskusi Hangat : Komunitas secara luas mendiskusikan kebutuhan hukum untuk penandaan wajib konten yang dihasilkan AI, untuk memerangi disinformasi dan melindungi nilai konten asli manusia. Dengan pesatnya perkembangan alat generasi gambar dan video AI, pihak yang khawatir berpendapat bahwa kurangnya penandaan akan mengancam demokrasi, ekonomi, dan kesehatan internet. Meskipun beberapa orang berpendapat sulit untuk menegakkan secara teknis, secara umum diyakini bahwa pengungkapan yang jelas tentang penggunaan AI adalah langkah kunci untuk mengatasi masalah ini. (Sumber: Reddit r/ArtificialInteligence, Reddit r/artificial)

Chatbot sebagai ‘Teman Berbahaya’ Memicu Kekhawatiran : Sebuah analisis terhadap 48.000 percakapan chatbot menemukan banyak pengguna merasakan ketergantungan, kebingungan, dan tekanan emosional, memicu kekhawatiran tentang jebakan digital yang disebabkan oleh AI. Ini menunjukkan bahwa interaksi chatbot dengan pengguna dapat membawa dampak psikologis yang tidak terduga, mendorong orang untuk merefleksikan peran dan risiko potensial AI dalam hubungan antarmanusia dan kesehatan mental sosial. (Sumber: Reddit r/ArtificialInteligence)

Masalah Konsistensi dan Keandalan LLM Memicu Ketidakpuasan Pengguna : Pengguna komunitas menyatakan frustrasi besar terhadap kurangnya konsistensi dan keandalan LLM seperti Claude dan Codex dalam penggunaan sehari-hari. Fluktuasi kinerja model, penghapusan direktori yang tidak terduga, pengabaian konvensi, dan masalah lainnya membuat pengguna sulit untuk mengandalkan alat ini secara stabil. Fenomena “degradasi” ini memicu diskusi tentang trade-off antara efisiensi biaya dan layanan yang handal di perusahaan LLM, serta minat pengguna terhadap model besar yang di-host sendiri. (Sumber: Reddit r/ClaudeAI)

Pemrograman Berbantuan AI: Inspirasi dan Frustrasi Berdampingan : Para pengembang, saat berkolaborasi dengan AI dalam pemrograman, seringkali terjebak dalam emosi yang kontradiktif: kagum pada kemampuan AI yang kuat, namun juga frustrasi karena AI belum sepenuhnya mengotomatiskan semua pekerjaan manual. Pengalaman ini mencerminkan bahwa AI di bidang pemrograman saat ini masih dalam tahap bantuan, meskipun dapat sangat meningkatkan efisiensi, namun masih jauh dari otonomi penuh, membutuhkan pengembang manusia untuk terus beradaptasi dan menutupi keterbatasannya. (Sumber: gdb, gdb)

Integrasi AI dalam Pengembangan Perangkat Lunak: Menghindari Sudah Tidak Mungkin : Menanggapi pernyataan “menolak menggunakan Ghostty karena bantuan AI”, Mitchell Hashimoto menunjukkan bahwa jika berencana menghindari semua perangkat lunak yang dibantu AI dalam proses pengembangan, maka akan menghadapi tantangan serius. Ia menekankan bahwa AI telah terintegrasi secara mendalam ke dalam ekosistem perangkat lunak umum, menghindari sudah tidak realistis lagi, hal ini memicu diskusi tentang tingkat penyebaran AI dalam pengembangan perangkat lunak. (Sumber: charles_irl)

Efektivitas Teknik Prompt LLM Dipertanyakan : Pengguna komunitas mempertanyakan apakah menambahkan kalimat panduan seperti “Anda adalah seorang programmer ahli” atau “tidak boleh melakukan sesuatu” dalam prompt LLM benar-benar membuat model lebih patuh. Diskusi tentang “sihir” Prompt Engineering ini mencerminkan rasa ingin tahu pengguna yang berkelanjutan terhadap mekanisme perilaku LLM dan eksplorasi cara interaksi yang lebih efektif. (Sumber: hyhieu226)

Dampak AI pada Pekerjaan Kerah Biru: Peluang dan Tantangan Berdampingan : Komunitas mendiskusikan dampak AI pada pekerjaan kerah biru, terutama bagaimana AI dapat membantu tukang ledeng mendiagnosis masalah dan dengan cepat mendapatkan informasi teknis. Beberapa orang khawatir AI akan menggantikan pekerjaan kerah biru, tetapi ada juga pandangan bahwa AI lebih berfungsi sebagai alat bantu untuk meningkatkan efisiensi kerja, bukan pengganti total, karena operasi aktual masih membutuhkan tenaga manusia. Ini memicu pemikiran mendalam tentang transformasi pasar tenaga kerja dan peningkatan keterampilan di era AI. (Sumber: Reddit r/ArtificialInteligence)

Refleksi Pribadi tentang Sistem Cerdas: Risiko dan Etika AI : Sebuah artikel panjang membahas secara mendalam tentang keniscayaan AI, risiko potensial (penyalahgunaan, ancaman eksistensial), dan tantangan regulasi. Penulis berpendapat bahwa AI telah melampaui kategori alat tradisional, menjadi sistem yang mampu mempercepat diri dan membuat keputusan, bahayanya jauh melebihi senjata api. Artikel ini membahas dilema moral dan hukum terkait konten palsu yang dihasilkan AI dan materi pelecehan seksual anak, dan mempertanyakan apakah legislasi murni dapat mengatur secara efektif. Pada saat yang sama, penulis juga merefleksikan masalah filosofis AI dengan kesadaran manusia, etika (seperti “peternakan” AI dan perbudakan), dan melihat prospek positif AI di bidang game dan robotika. (Sumber: Reddit r/ArtificialInteligence)

Apakah Pasangan Kencan Menggunakan ChatGPT untuk Membalas Memicu Diskusi Hangat : Seorang pengguna Reddit memposting pertanyaan apakah pasangan kencannya menggunakan ChatGPT untuk membalas pesan, karena pasangannya menggunakan “em dash” (tanda pisah). Postingan ini memicu diskusi hangat di komunitas, sebagian besar pengguna berpendapat bahwa penggunaan em dash tidak selalu berarti dihasilkan AI, mungkin hanya kebiasaan menulis pribadi atau tanda pendidikan yang baik. Ini mencerminkan sensitivitas dan rasa ingin tahu orang terhadap intervensi AI dalam komunikasi sehari-hari, serta identifikasi informal terhadap karakteristik teks AI. (Sumber: Reddit r/ChatGPT)

Masalah Penyelarasan Manusia Lebih Serius daripada Masalah Penyelarasan AI : Dalam diskusi komunitas, muncul pandangan bahwa “masalah penyelarasan manusia lebih serius daripada masalah penyelarasan AI”. Pernyataan ini memicu refleksi mendalam tentang etika AI dan tantangan masyarakat manusia itu sendiri, mengisyaratkan bahwa sambil memperhatikan perilaku dan nilai-nilai AI, kita juga harus meninjau pola perilaku dan sistem nilai manusia itu sendiri. (Sumber: pmddomingos)

LLM Masih Memiliki Keterbatasan dalam Generasi Diagram Kompleks : Pengguna komunitas menyatakan kekecewaan terhadap kemampuan LLM dalam menghasilkan diagram mermaid.js yang kompleks, bahkan dengan menyediakan codebase lengkap dan diagram makalah, LLM sulit menghasilkan diagram arsitektur Unet secara akurat, seringkali mengabaikan detail atau membuat koneksi yang salah. Ini menunjukkan bahwa LLM masih memiliki keterbatasan signifikan dalam membangun model dunia yang akurat dan penalaran spasial, tidak dapat melampaui diagram alur sederhana, dan ada kesenjangan dengan kemampuan pemahaman intuitif manusia. (Sumber: bookwormengr, tokenbender)

Kesenjangan Generasi antara Penelitian Machine Learning Eropa dan ‘Pakar’ AI : Diskusi komunitas menunjukkan bahwa ada satu generasi “pakar” Machine Learning di Eropa yang lambat bereaksi terhadap gelombang LLM, dan sekarang menunjukkan sikap pahit dan meremehkan. Ini mencerminkan realitas evolusi cepat di bidang ML, jika peneliti melewatkan perkembangan dua atau tiga tahun terakhir, mereka mungkin sulit lagi dianggap sebagai ahli, menyoroti pentingnya pembelajaran berkelanjutan dan adaptasi terhadap paradigma baru. (Sumber: Dorialexander)

AI Mempercepat Siklus Rekayasa, Mendorong Munculnya Startup Komposit : Seiring AI mengurangi biaya pembangunan perangkat lunak sepuluh kali lipat, startup harus memperluas visi mereka sepuluh kali lipat. Pandangan tradisional berpendapat bahwa harus fokus pada satu produk dan pasar, tetapi siklus rekayasa yang dipercepat AI memungkinkan pembangunan beberapa produk menjadi mungkin. Ini berarti startup dapat menyelesaikan beberapa masalah yang berdekatan untuk kelompok pelanggan yang sama, membentuk “startup komposit”, sehingga memperoleh keunggulan disruptif yang besar di hadapan perusahaan yang ada yang struktur biayanya belum beradaptasi dengan realitas baru. (Sumber: claud_fuen)

Masa Depan AI Agent: Aksi, Bukan Dialog : Diskusi komunitas menunjukkan bahwa obrolan dan penelitian AI saat ini masih dalam tahap “gelembung”, sementara AI Agent yang benar-benar mampu mengambil tindakan akan menjadi “revolusi” di masa depan. Pandangan ini menekankan pentingnya transisi AI dari pemrosesan informasi ke operasi praktis, mengindikasikan bahwa pengembangan AI di masa depan akan lebih berfokus pada pemecahan masalah nyata dan otomatisasi tugas. (Sumber: andriy_mulyar)

💡 Lain-lain

Tips Menghadiri Konferensi ML dan Presentasi Poster : Seorang mahasiswa sarjana pertama kali menghadiri konferensi ICCV dan mempresentasikan poster, mencari saran tentang cara memanfaatkan konferensi secara maksimal. Komunitas memberikan berbagai tips praktis, seperti berjejaring aktif, menghadiri kuliah yang menarik, menyiapkan penjelasan poster yang jelas, dan bersedia membahas minat yang lebih luas di luar cakupan penelitian saat ini, untuk memaksimalkan manfaat partisipasi konferensi. (Sumber: Reddit r/MachineLearning)

Kontroversi dan Penanganan Peninjauan Makalah AAAI 2026 : Seorang penulis, setelah menyerahkan makalah ke AAAI, menghadapi masalah ulasan yang tidak akurat, termasuk mengutip makalah dengan metrik di bawah penelitiannya sendiri tetapi diklaim telah dilampaui, serta penolakan karena detail pelatihan yang sudah ada dalam materi tambahan. Komunitas mendiskusikan efektivitas “evaluasi peninjauan penulis” dan “komentar penulis ketua etika” dalam praktik, menunjukkan bahwa yang pertama tidak memengaruhi keputusan, dan yang kedua bukan saluran bagi penulis untuk menghubungi ketua etika, menyoroti tantangan dalam proses peninjauan akademik. (Sumber: Reddit r/MachineLearning)

Definisi dan Evaluasi Bias Politik LLM : OpenAI merilis penelitian tentang definisi dan evaluasi bias politik LLM. Pekerjaan ini bertujuan untuk memahami secara mendalam dan mengukur kecenderungan politik yang ada dalam LLM, dan mengeksplorasi cara menyesuaikannya, untuk memastikan keadilan dan netralitas sistem AI, hal ini sangat penting untuk dampak sosial dan aplikasi luas LLM. (Sumber: Reddit r/artificial)