Kata Kunci:robot humanoid, model AI besar, pembelajaran penguatan, AI multimodal, agen AI, hambatan data Figure 03, pembuktian matematika GPT-5 Pro, EmbeddingGemma RAG perangkat ujung, analisis percakapan grafik GraphQA, kinerja inferensi NVIDIA Blackwell

🔥 FOKUS

Figure 03 Menjadi Sampul Daftar Penemuan Terbaik Majalah TIME, CEO Mengatakan “Saat Ini Hanya Kekurangan Data” : Brett Adcock, CEO Figure, menyatakan bahwa hambatan terbesar bagi robot humanoid Figure 03 saat ini adalah “data”, bukan arsitektur atau daya komputasi, dan percaya bahwa data dapat menyelesaikan hampir semua masalah serta mendorong penerapan robot secara massal. Figure 03 menjadi sampul daftar Penemuan Terbaik Majalah TIME 2025, memicu diskusi tentang pentingnya data, daya komputasi, dan arsitektur dalam pengembangan robot. Brett Adcock menekankan bahwa tujuan Figure adalah agar robot dapat menyelesaikan tugas manusia di lingkungan rumah dan komersial, serta sangat mementingkan keamanan robot, memprediksi bahwa jumlah robot humanoid di masa depan mungkin akan melampaui manusia. (Sumber: 量子位)

Terence Tao Tantang Batasan dengan GPT-5 Pro! Masalah Tak Terpecahkan Selama 3 Tahun, Terbukti Lengkap dalam 11 Menit : Matematikawan terkenal Terence Tao bekerja sama dengan GPT-5 Pro, menyelesaikan masalah tak terpecahkan selama 3 tahun di bidang geometri diferensial dalam 11 menit. GPT-5 Pro tidak hanya menyelesaikan perhitungan kompleks, tetapi juga langsung memberikan bukti lengkap, bahkan membantu Terence Tao mengoreksi intuisi awalnya. Terence Tao menyimpulkan bahwa AI berkinerja sangat baik dalam masalah “skala kecil”, juga membantu dalam pemahaman masalah “skala besar”, tetapi mungkin memperkuat intuisi yang salah dalam strategi “skala menengah”. Ia menekankan bahwa AI harus berfungsi sebagai “kopilot” bagi matematikawan, meningkatkan efisiensi eksperimen, bukan sepenuhnya menggantikan pekerjaan manusia dalam kreativitas dan intuisi. (Sumber: 量子位)

🎯 DINAMIKA

Yunpeng Technology Luncurkan Produk Baru AI+Kesehatan : Yunpeng Technology bekerja sama dengan Shuaikang dan Skyworth meluncurkan produk baru AI+Kesehatan, termasuk “Laboratorium Dapur Masa Depan Digital Cerdas” dan kulkas pintar yang dilengkapi dengan model AI kesehatan besar. Model AI kesehatan besar mengoptimalkan desain dan operasional dapur, sementara kulkas pintar menyediakan manajemen kesehatan yang dipersonalisasi melalui “Asisten Kesehatan Xiaoyun”. Ini menandai terobosan AI dalam manajemen kesehatan sehari-hari, mewujudkan layanan kesehatan yang dipersonalisasi melalui perangkat pintar, dan diharapkan dapat mendorong pengembangan teknologi kesehatan rumah tangga serta meningkatkan kualitas hidup penduduk. (Sumber: 36氪)

Kemajuan Robot Humanoid dan Embodied AI: Dari Tugas Rumah Tangga hingga Aplikasi Industri : Berbagai diskusi di media sosial menunjukkan kemajuan terbaru dalam robot humanoid dan embodied AI. Reachy Mini dinobatkan sebagai salah satu Penemuan Terbaik 2025 oleh Majalah TIME, menunjukkan potensi kolaborasi open-source di bidang robotika. Prostetik bionik yang digerakkan AI memungkinkan seorang remaja 17 tahun mengendalikan dengan pikiran, dan robot humanoid dapat dengan mudah menyelesaikan tugas rumah tangga. Di sektor industri, Yondu AI meluncurkan solusi pengambilan barang di gudang dengan robot humanoid beroda, AgiBot memperkenalkan Lingxi X2 dengan kemampuan bergerak mendekati manusia, dan Tiongkok juga meluncurkan robot polisi berbentuk bola berkecepatan tinggi. Robot Boston Dynamics telah berevolusi menjadi juru kamera multifungsi, dan robot berkaki empat LocoTouch mewujudkan transportasi cerdas melalui sentuhan. (Sumber: Ronald_vanLoon, Ronald_vanLoon, ClementDelangue, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, johnohallman, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Terobosan Kemampuan Model Besar dan Kemajuan Baru dalam Pengujian Benchmark Kode : GPT-5 Pro dan Gemini 2.5 Pro menunjukkan kinerja setara medali emas dalam International Astronomy and Astrophysics Olympiad (IOAA), menunjukkan kemampuan AI yang kuat di bidang fisika mutakhir. GPT-5 Pro juga menunjukkan kemampuan pencarian dan verifikasi literatur ilmiah yang sangat kuat, menyelesaikan masalah Erdos #339, dan dapat secara efektif mengidentifikasi celah signifikan dalam makalah yang telah diterbitkan. Di bidang kode, KAT-Dev-72B-Exp menjadi model open-source teratas di SWE-Bench Verified, mencapai tingkat perbaikan 74,6%. Proyek SWE-Rebench menghindari kontaminasi data dengan menguji GitHub issue yang baru diajukan setelah model besar dirilis. Sam Altman sangat antusias dengan masa depan Codex. Mengenai apakah AGI dapat dicapai melalui LLM murni, komunitas riset AI secara umum berpendapat bahwa inti LLM saja sulit untuk mencapainya. (Sumber: gdb, karminski3, gdb, SebastienBubeck, karminski3, teortaxesTex, QuixiAI, sama, OfirPress, Reddit r/LocalLLaMA, Reddit r/ArtificialInteligence)

Inovasi Kinerja dan Tantangan Hardware serta Infrastruktur AI : Platform NVIDIA Blackwell menunjukkan kinerja inferensi dan efisiensi yang tak tertandingi dalam benchmark SemiAnalysis InferenceMAX, dan Together AI telah menyediakan sistem NVIDIA GB200 NVL72 dan HGX B200. Groq, melalui ASIC dan strategi integrasi vertikalnya, membentuk kembali ekonomi infrastruktur LLM open-source dengan latensi lebih rendah dan harga yang kompetitif. Komunitas mendiskusikan dampak penghapusan Python GIL pada rekayasa AI/ML, percaya bahwa penghapusannya diharapkan dapat meningkatkan kinerja multi-threading. Selain itu, penggemar LLM berbagi konfigurasi hardware masing-masing dan membahas trade-off kinerja antara model terkuantisasi besar dan model tidak terkuantisasi kecil pada tingkat kuantisasi yang berbeda, menunjukkan bahwa kuantisasi 2-bit mungkin cocok untuk percakapan, tetapi tugas pengkodean setidaknya memerlukan Q5. (Sumber: togethercompute, arankomatsuzaki, code_star, MostafaRohani, jeremyphoward, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

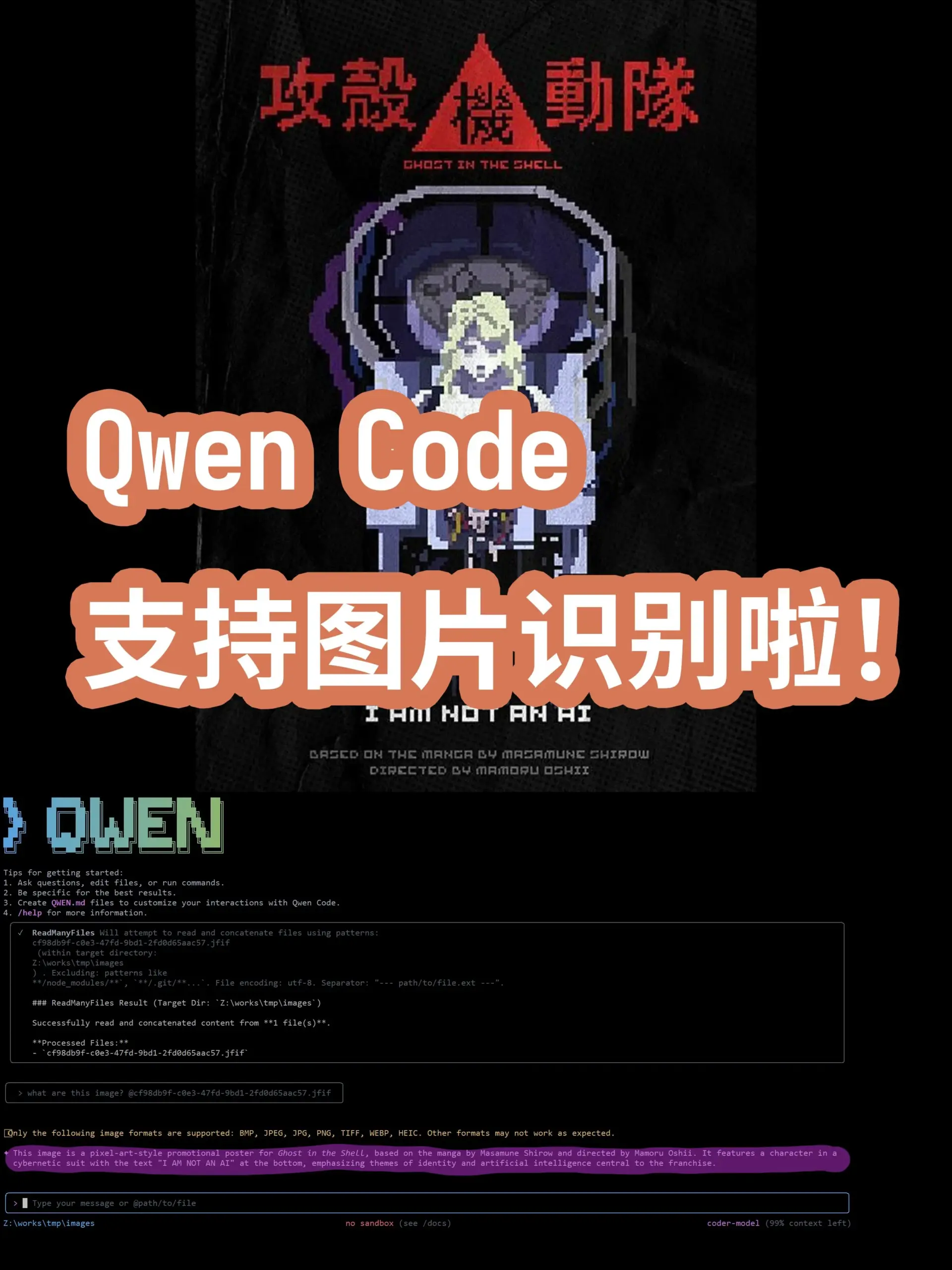

Dinamika Terdepan Model dan Aplikasi AI: Dari Model Umum hingga Domain Vertikal : Model dan fitur baru terus bermunculan di bidang AI. Model besar bahasa Turki Kumru-2B muncul di Hugging Face, dan Replit merilis beberapa pembaruan minggu ini. Sora 2 telah menghapus watermark, menandakan bahwa teknologi pembuatan video akan membawa aplikasi yang lebih luas. Ada rumor bahwa Gemini 3.0 akan dirilis pada 22 Oktober. AI terus mendalam di bidang kesehatan, dengan patologi digital yang dibantu AI untuk diagnosis kanker, dan mikroskop tanpa label yang dikombinasikan dengan AI diharapkan dapat membawa alat diagnostik baru. Model Augmented Reality (AR) mencapai SOTA pada daftar Imagenet FID. Agent pengkodean baris perintah Qwen Code diperbarui untuk mendukung pengenalan gambar oleh model Qwen-VL. Universitas Stanford mengusulkan metode Agentic Context Engineering (ACE), yang memungkinkan model menjadi lebih cerdas tanpa perlu fine-tuning. Model seri DeepSeek V3 juga terus berulang, dan jenis deployment AI Agent serta pembentukan kembali bidang layanan profesional oleh AI juga menjadi fokus perhatian industri. (Sumber: mervenoyann, amasad, scaling01, npew, kaifulee, Ronald_vanLoon, scaling01, TheTuringPost, TomLikesRobots, iScienceLuvr, NerdyRodent, shxf0072, gabriberton, Ronald_vanLoon, karminski3, Ronald_vanLoon, teortaxesTex, demishassabis, Dorialexander, yoheinakajima, 36氪)

🧰 ALAT

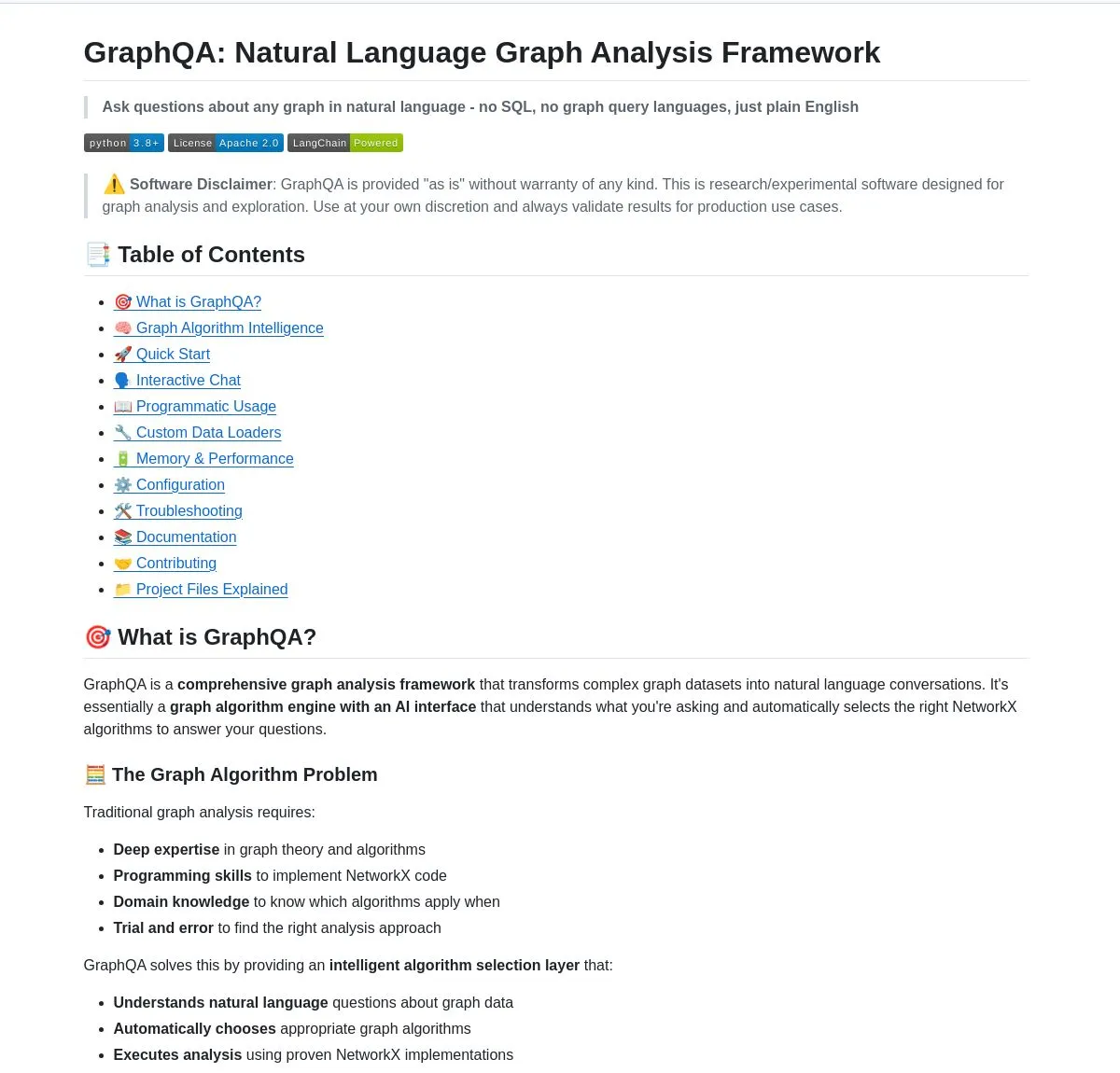

GraphQA: Mengubah Analisis Graf menjadi Percakapan Bahasa Alami : LangChainAI meluncurkan framework GraphQA, yang menggabungkan NetworkX dan LangChain, mampu mengubah analisis graf yang kompleks menjadi percakapan bahasa alami. Pengguna dapat mengajukan pertanyaan dalam bahasa Inggris biasa, dan GraphQA akan secara otomatis memilih dan menjalankan algoritma yang sesuai, menangani graf dengan lebih dari 100.000 node. Ini sangat menyederhanakan ambang batas analisis data graf, membuatnya lebih mudah digunakan oleh pengguna non-profesional, dan merupakan inovasi alat penting di bidang LLM. (Sumber: LangChainAI)

Alat Agentic AI Teratas untuk VS Code : Visual Studio Magazine menobatkan sebuah alat sebagai salah satu alat Agentic AI teratas untuk VS Code, menandai pergeseran paradigma pengembangan dari “asisten” menjadi “Agent sejati” yang dapat berpikir, bertindak, dan membangun bersama pengembang. Ini mencerminkan evolusi alat AI di bidang pengembangan perangkat lunak dari fungsi bantu menuju kolaborasi cerdas yang lebih mendalam, meningkatkan efisiensi dan pengalaman pengembang. (Sumber: cline)

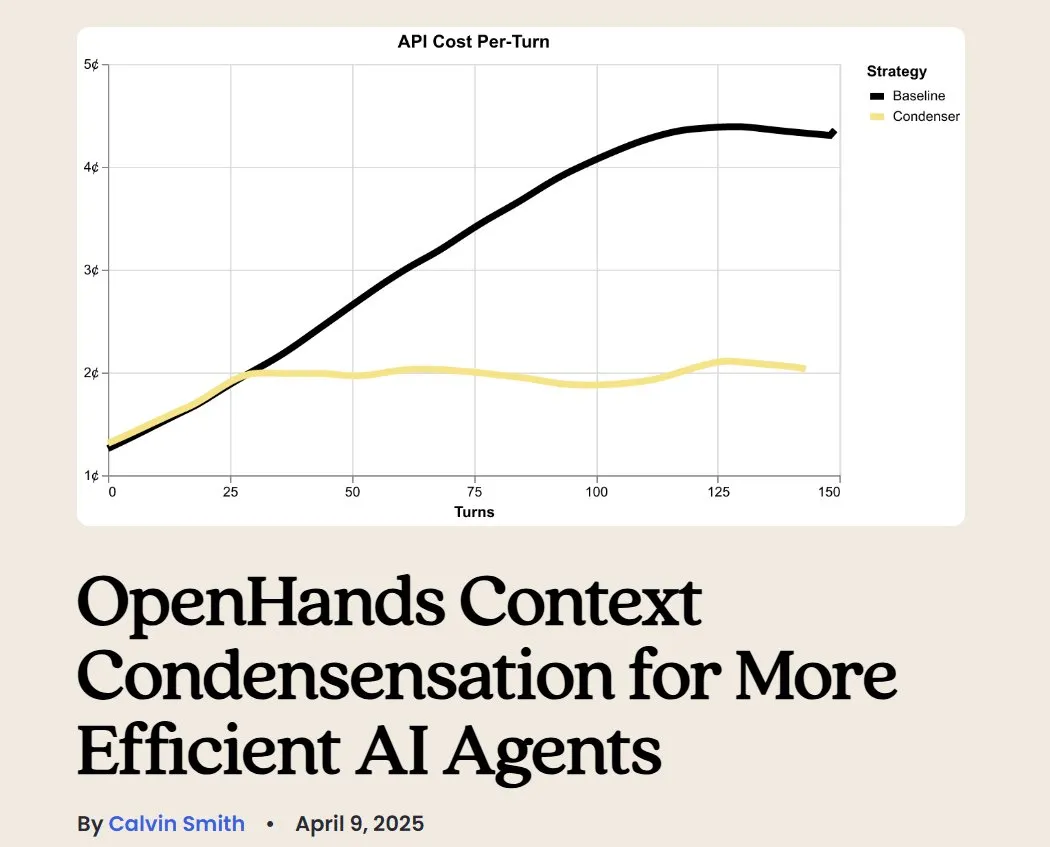

OpenHands: Alat Open-Source untuk Manajemen Konteks LLM : OpenHands, sebagai alat open-source, menyediakan berbagai kompresor konteks untuk mengelola konteks LLM dalam aplikasi Agentic, termasuk pemangkasan riwayat dasar, ekstraksi “peristiwa terpenting”, dan kompresi output browser. Ini sangat penting untuk debugging, evaluasi, dan pemantauan aplikasi LLM, sistem RAG, dan alur kerja Agentic, membantu meningkatkan efisiensi dan konsistensi LLM dalam tugas-tugas kompleks. (Sumber: gneubig)

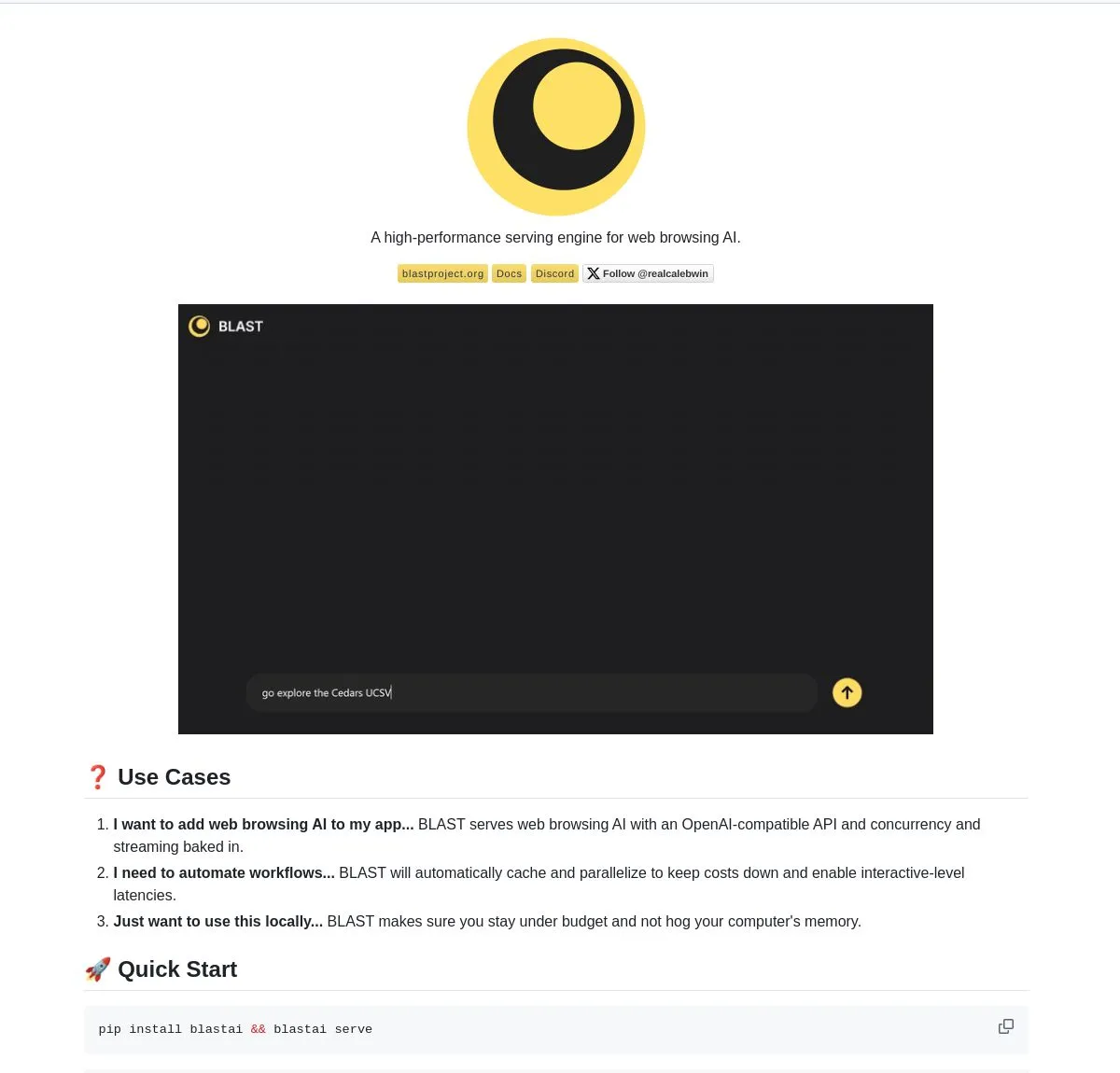

BLAST: Mesin Peramban Web AI : LangChainAI merilis BLAST, mesin peramban web AI berkinerja tinggi, yang dirancang untuk menyediakan kemampuan penjelajahan web bagi aplikasi AI. BLAST menyediakan antarmuka yang kompatibel dengan OpenAI, mendukung paralelisasi otomatis, caching cerdas, dan streaming real-time, mampu mengintegrasikan informasi halaman web ke dalam alur kerja AI secara efisien, sangat memperluas kemampuan AI Agent untuk memperoleh dan memproses data jaringan real-time. (Sumber: LangChainAI)

Opik: Alat Evaluasi LLM Open-Source : Opik adalah alat evaluasi LLM open-source yang digunakan untuk debugging, evaluasi, dan pemantauan aplikasi LLM, sistem RAG, dan alur kerja Agentic. Ini menyediakan pelacakan komprehensif, evaluasi otomatis, dan dashboard siap produksi, membantu pengembang lebih memahami perilaku model, mengoptimalkan kinerja, dan memastikan keandalan aplikasi dalam skenario nyata. (Sumber: dl_weekly)

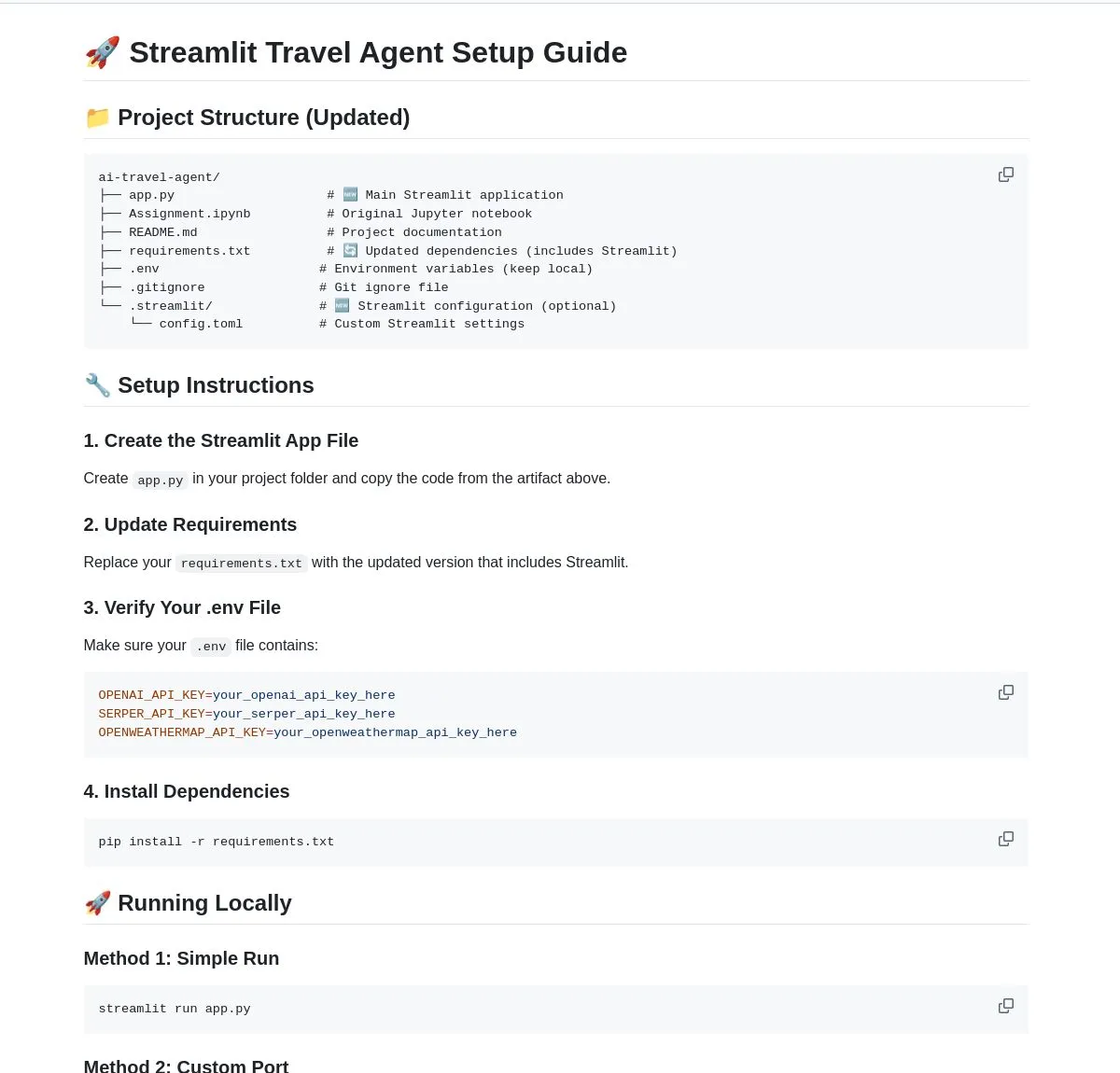

AI Travel Agent: Asisten Perencanaan Cerdas : LangChainAI mendemonstrasikan AI Travel Agent cerdas yang mengintegrasikan informasi cuaca real-time, pencarian, dan perjalanan, serta memanfaatkan beberapa API untuk menyederhanakan seluruh proses mulai dari pembaruan cuaca hingga penukaran mata uang. Agent ini bertujuan untuk menyediakan perencanaan dan bantuan perjalanan satu atap, meningkatkan pengalaman perjalanan pengguna, dan merupakan contoh tipikal LLM yang memberdayakan Agent dalam skenario aplikasi vertikal. (Sumber: LangChainAI)

Konsep Alat Pembuat Prompt Pengiklan AI : Ada pandangan yang menyatakan bahwa pasar sangat membutuhkan alat AI yang membantu pemasar membangun “prompt pengiklan”. Alat ini harus dapat membantu membangun sistem evaluasi (meliputi keamanan merek, kepatuhan prompt, dll.) dan menguji model-model utama. Dengan diluncurkannya berbagai unit iklan alami oleh OpenAI, pentingnya prompt pemasaran semakin menonjol, dan alat semacam ini akan menjadi tautan kunci dalam proses kreatif dan distribusi iklan. (Sumber: dbreunig)

Pembaruan Qwen Code: Mendukung Pengenalan Gambar Model Qwen-VL : Agent pengkodean baris perintah Qwen Code baru-baru ini diperbarui, menambahkan dukungan untuk beralih ke model Qwen-VL untuk pengenalan gambar. Pengujian pengguna menunjukkan hasil yang baik, dan saat ini dapat digunakan secara gratis. Pembaruan ini sangat memperluas kemampuan Qwen Code, memungkinkannya tidak hanya menangani tugas kode tetapi juga interaksi multimodal, meningkatkan efisiensi dan akurasi Agent pengkodean dalam menangani tugas yang melibatkan informasi visual. (Sumber: karminski3)

Menggunakan LibreChat untuk Menghosting Server Chatbot Pribadi : Sebuah postingan blog menyediakan panduan tentang cara menggunakan LibreChat untuk menghosting server chatbot pribadi dan terhubung ke beberapa Model Control Panels (MCPs). Ini memungkinkan pengguna untuk secara fleksibel mengelola dan beralih antara backend LLM yang berbeda, mewujudkan pengalaman chatbot yang disesuaikan, menekankan fleksibilitas dan kontrol solusi open-source dalam deployment aplikasi AI. (Sumber: Reddit r/artificial)

Generator AI: Menghidupkan Avatar : Seorang pengguna mencari generator AI terbaik, berharap dapat “menghidupkan” citra mereknya (termasuk video orang sungguhan dan avatar) untuk saluran YouTube, guna mengurangi waktu syuting dan perekaman, serta fokus pada editing. Pengguna berharap AI dapat membuat avatar berdialog, bermain game, menari, dll. Ini mencerminkan tingginya permintaan kreator konten akan alat AI dalam animasi avatar dan pembuatan video, untuk meningkatkan efisiensi produksi dan keragaman konten. (Sumber: Reddit r/artificial)

LLM Lokal Melawan Spam Email: Solusi Pribadi : Sebuah postingan blog berbagi praktik tentang cara menggunakan LLM lokal untuk secara pribadi mengidentifikasi dan melawan spam email di server email sendiri. Solusi ini menggabungkan Mailcow, Rspamd, Ollama, dan agen Python kustom, menyediakan metode penyaringan spam berbasis AI bagi pengguna server email yang di-host sendiri, menekankan potensi LLM lokal dalam perlindungan privasi dan aplikasi yang disesuaikan. (Sumber: Reddit r/LocalLLaMA)

📚 BELAJAR

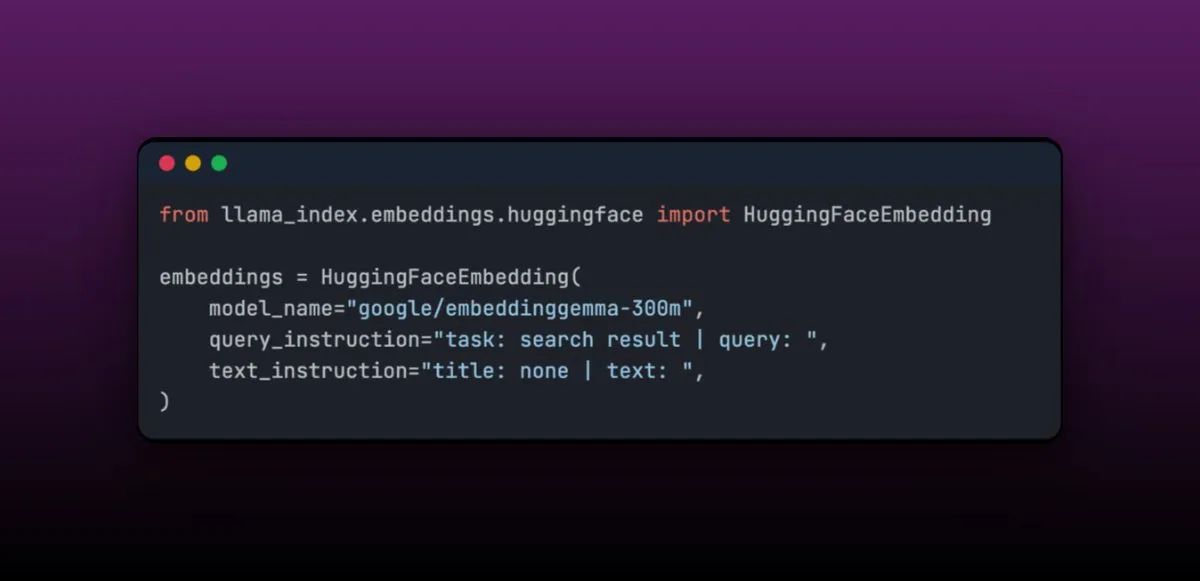

EmbeddingGemma: Model Embedding Multibahasa untuk Aplikasi RAG di Perangkat : EmbeddingGemma adalah model embedding multibahasa yang ringkas, dengan hanya 308M parameter, sangat cocok untuk aplikasi RAG di perangkat, dan mudah diintegrasikan dengan LlamaIndex. Model ini menempati peringkat tinggi dalam Massive Text Embedding Benchmark, sekaligus berukuran kecil, cocok untuk perangkat seluler. Fitur fine-tuning-nya yang mudah memungkinkan kinerja melampaui model yang lebih besar setelah fine-tuning di domain tertentu (seperti data medis). (Sumber: jerryjliu0)

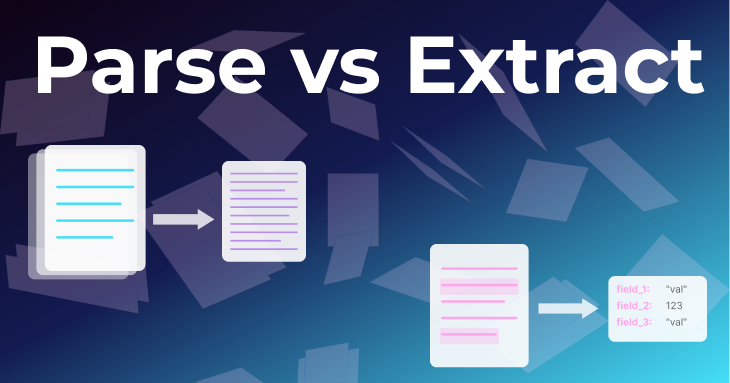

Dua Metode Dasar Pemrosesan Dokumen: Parsing dan Ekstraksi : Sebuah artikel dari tim LlamaIndex membahas secara mendalam dua metode dasar dalam pemrosesan dokumen: “parsing” dan “ekstraksi”. Parsing adalah mengubah seluruh dokumen menjadi Markdown atau JSON terstruktur, mempertahankan semua informasi, cocok untuk RAG, penelitian mendalam, dan ringkasan. Ekstraksi adalah mendapatkan output terstruktur dari LLM, menstandardisasi dokumen ke pola umum, cocok untuk ETL database, alur kerja Agent otomatis, dan ekstraksi metadata. Memahami perbedaan keduanya sangat penting untuk membangun Document Agent yang efisien. (Sumber: jerryjliu0)

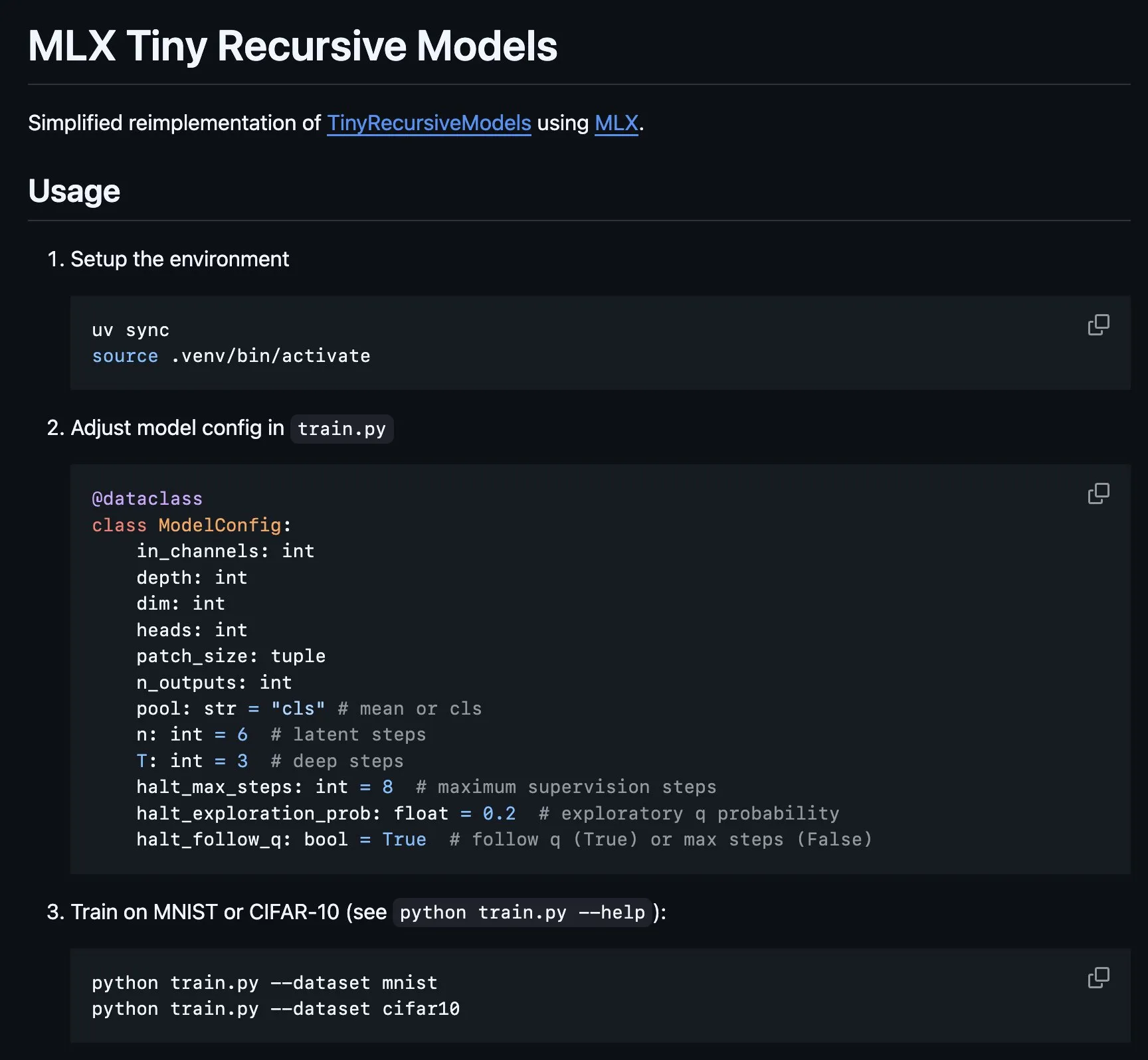

Implementasi Tiny Recursive Model (TRM) di MLX : Platform MLX mengimplementasikan bagian inti dari Tiny Recursive Model (TRM), model yang diusulkan oleh Alexia Jolicoeur-Martineau, yang bertujuan untuk mencapai kinerja tinggi melalui inferensi rekursif dengan jaringan saraf kecil berparameter 7M. Implementasi MLX ini memungkinkan eksperimen lokal pada laptop Apple Silicon, mengurangi kompleksitas, mencakup fitur-fitur seperti deep supervision, langkah inferensi rekursif, EMA, dll., memberikan kemudahan untuk pengembangan dan penelitian model kecil yang efisien. (Sumber: awnihannun, ImazAngel)

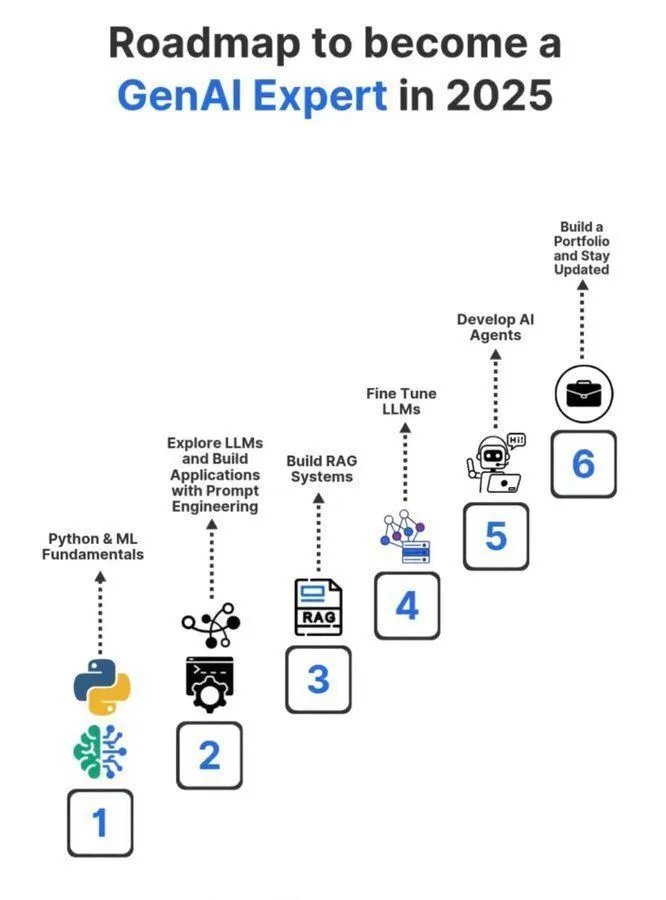

Peta Jalan Pembelajaran Ahli Generative AI 2025 : Sebuah peta jalan pembelajaran ahli Generative AI 2025 yang terperinci dibagikan di media media sosial, mencakup pengetahuan dan keterampilan kunci yang diperlukan untuk menjadi profesional di bidang Generative AI. Peta jalan ini bertujuan untuk membimbing para calon profesional untuk mempelajari konsep inti seperti kecerdasan buatan, machine learning, dan deep learning secara sistematis, guna beradaptasi dengan tren teknologi GenAI yang berkembang pesat. (Sumber: Ronald_vanLoon)

Berbagi Pengalaman Belajar PhD Machine Learning : Seorang pengguna membagikan kembali serangkaian tweet tentang mengejar gelar PhD di bidang machine learning, bertujuan untuk memberikan panduan dan pengalaman bagi mereka yang tertarik dengan studi PhD ML. Tweet-tweet ini mungkin mencakup proses aplikasi, arah penelitian, pengembangan karir, dan pengalaman pribadi, menjadikannya sumber daya pembelajaran AI yang berharga di komunitas. (Sumber: arohan)

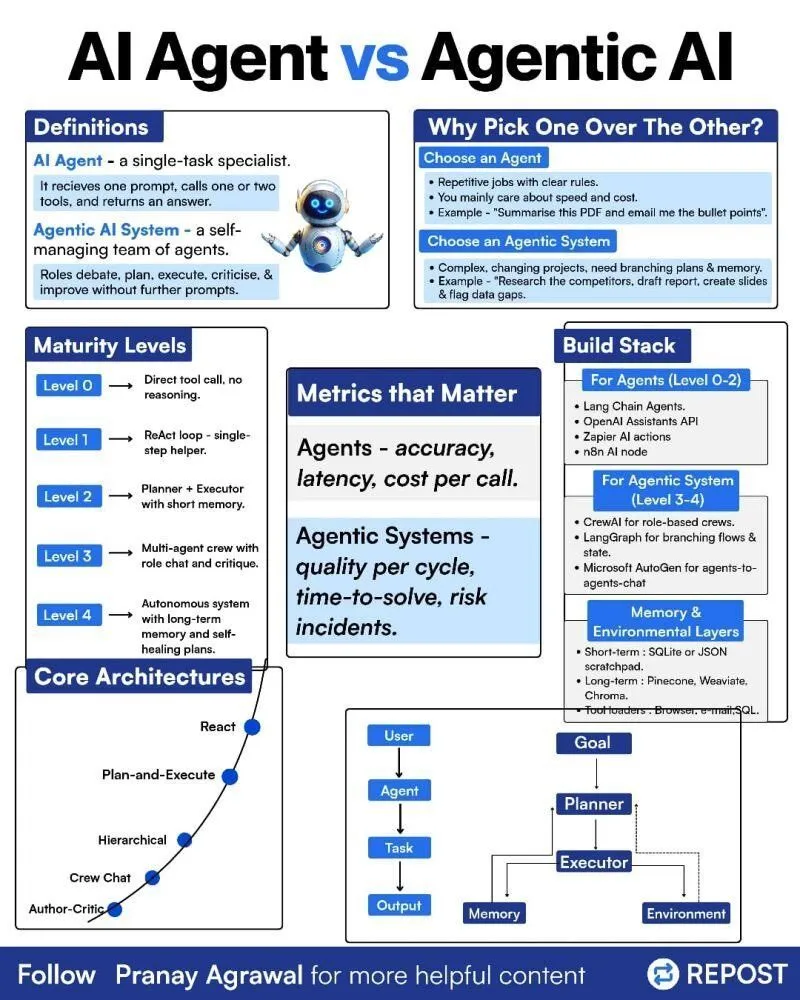

Perbedaan antara AI Agents dan Agentic AI : Seseorang di media sosial membagikan infografis tentang perbedaan antara “AI Agents” dan “Agentic AI”, bertujuan untuk mengklarifikasi dua konsep yang terkait namun berbeda ini. Ini membantu komunitas lebih memahami jenis deployment AI Agent, tingkat otonominya, dan peran Agentic AI dalam sistem kecerdasan buatan yang lebih luas, mendorong diskusi yang lebih tepat tentang teknologi Agent. (Sumber: Ronald_vanLoon)

Reinforcement Learning dan Weight Decay dalam Pelatihan LLM : Diskusi di media sosial membahas bahwa Weight Decay mungkin bukan ide yang baik dalam pelatihan Reinforcement Learning (RL) LLM. Ada pandangan bahwa Weight Decay dapat menyebabkan jaringan melupakan banyak informasi pra-pelatihan, terutama dalam pembaruan GRPO dengan keuntungan nol, di mana bobot akan cenderung nol. Ini mengingatkan para peneliti untuk mempertimbangkan dengan cermat dampak Weight Decay saat merancang strategi pelatihan RL untuk LLM, guna menghindari penurunan kinerja model. (Sumber: lateinteraction)

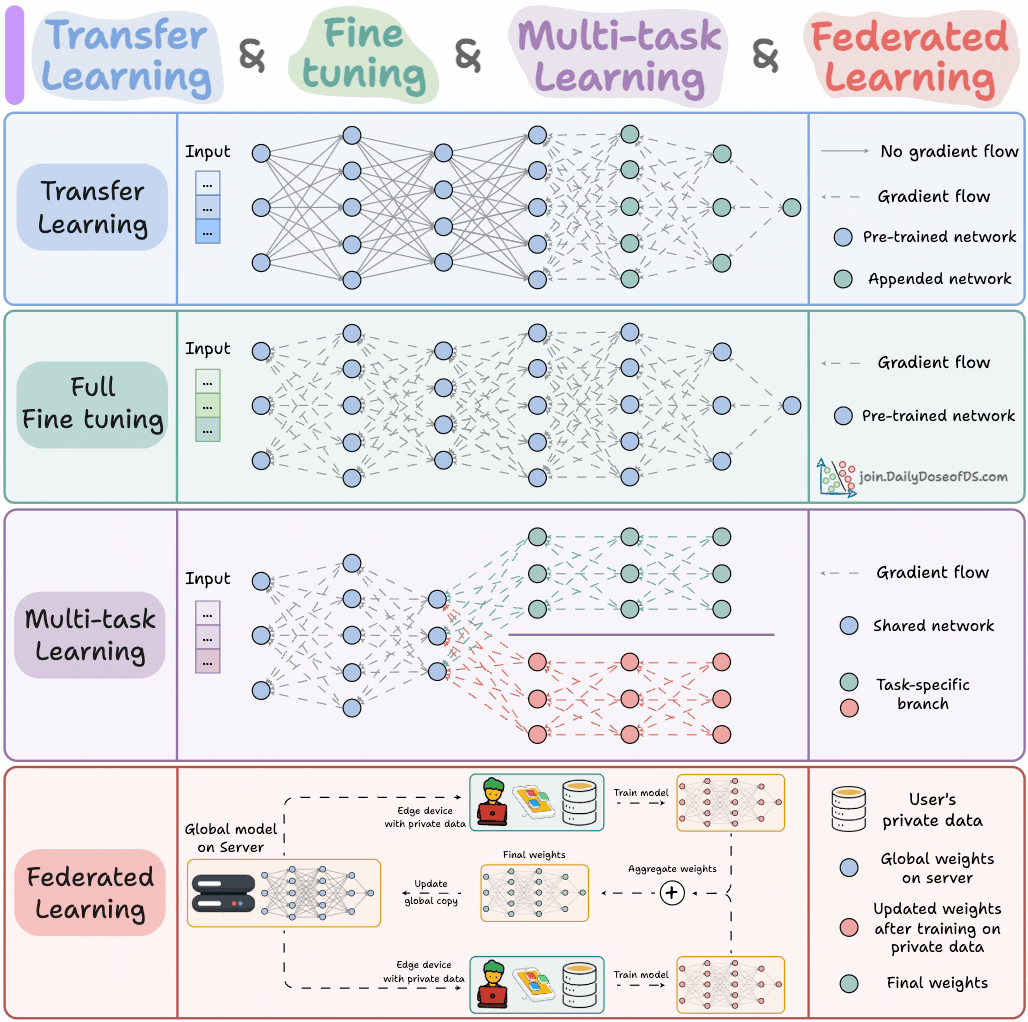

Paradigma Pelatihan Model AI : Seorang ahli berbagi empat paradigma pelatihan model yang harus diketahui oleh insinyur ML, bertujuan untuk memberikan panduan teoritis dan kerangka kerja praktis yang penting bagi insinyur machine learning. Paradigma ini mungkin mencakup supervised learning, unsupervised learning, reinforcement learning, dan self-supervised learning, membantu insinyur lebih memahami dan menerapkan berbagai metode pelatihan model. (Sumber: _avichawla)

Reinforcement Learning Berbasis Kurikulum untuk Meningkatkan Kemampuan LLM : Sebuah penelitian menemukan bahwa Reinforcement Learning (RL) yang dikombinasikan dengan pembelajaran kurikulum dapat mengajarkan kemampuan baru kepada LLM, yang sulit dicapai dengan metode lain. Ini menunjukkan potensi pembelajaran kurikulum dalam meningkatkan kemampuan inferensi jangka panjang LLM, menandakan bahwa kombinasi RL dan pembelajaran kurikulum mungkin menjadi kunci untuk membuka keterampilan AI baru. (Sumber: sytelus)

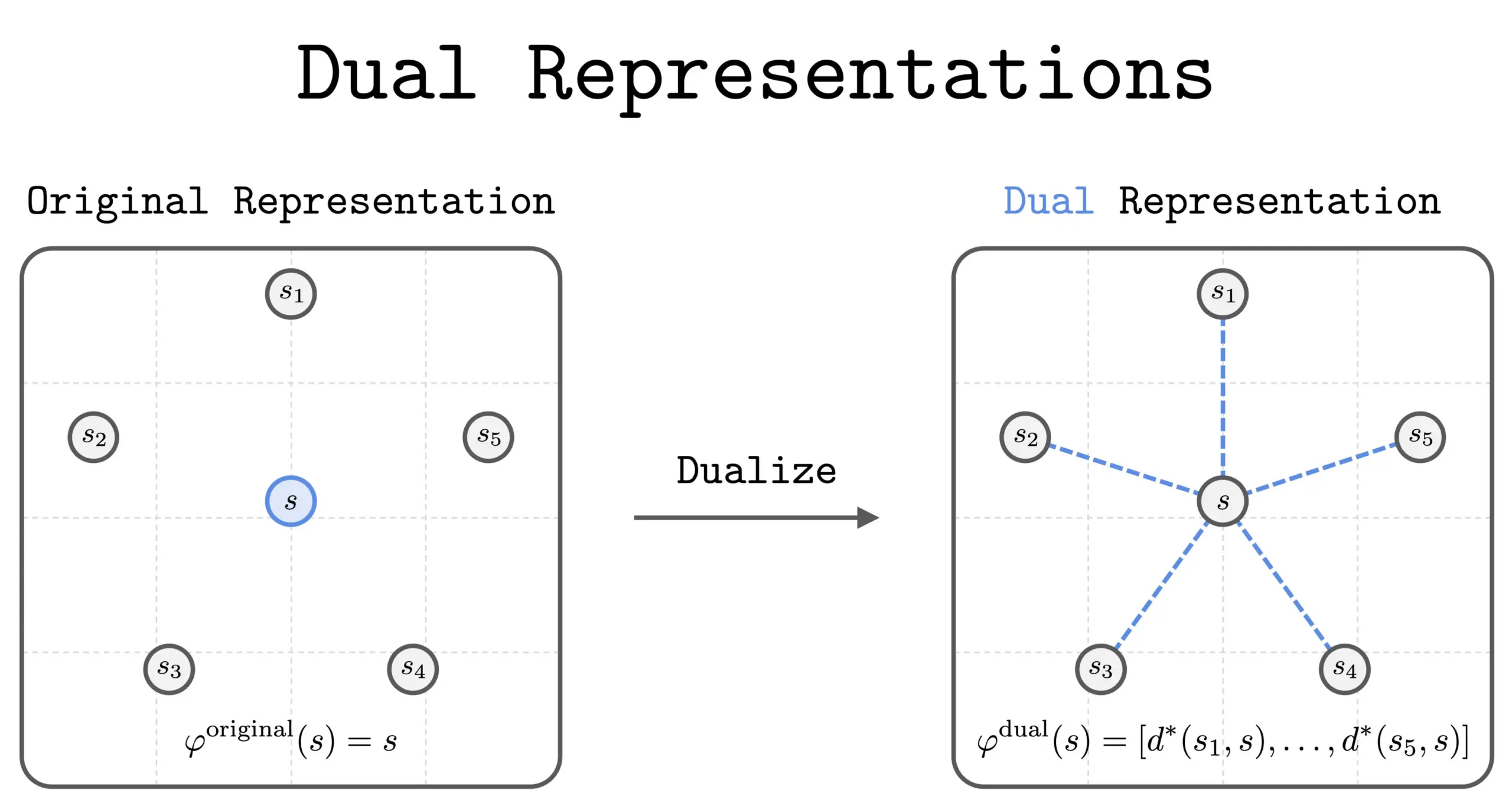

Metode Representasi Ganda Baru dalam RL : Sebuah penelitian baru memperkenalkan metode “representasi ganda” dalam Reinforcement Learning (RL). Metode ini memberikan perspektif baru dengan merepresentasikan status sebagai “kumpulan kesamaan” dengan semua status lainnya. Representasi ganda ini memiliki sifat teoritis yang baik dan manfaat praktis, diharapkan dapat meningkatkan kinerja dan kemampuan pemahaman RL. (Sumber: dilipkay)

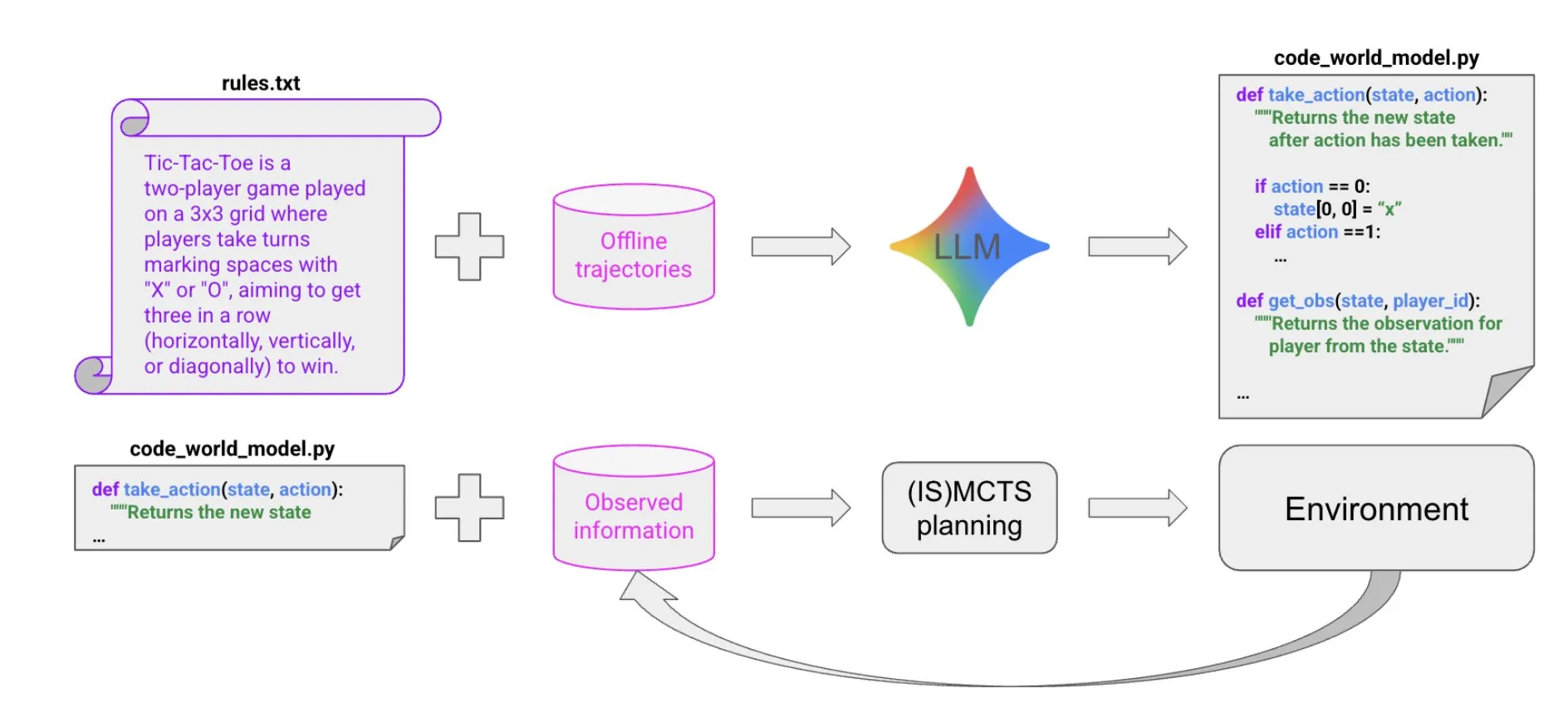

Sintesis Kode Berbasis LLM untuk Membangun Model Dunia : Sebuah makalah baru mengusulkan metode yang sangat efisien dalam sampel, menggunakan sintesis kode berbasis LLM untuk menciptakan Agent yang dapat berkinerja baik di lingkungan simbolis multi-Agent yang sebagian dapat diamati. Metode ini mempelajari model dunia kode dari sejumlah kecil data lintasan dan informasi latar belakang, kemudian meneruskannya ke pemecah masalah yang ada (seperti MCTS) untuk memilih tindakan selanjutnya, memberikan ide baru untuk membangun Agent yang kompleks. (Sumber: BlackHC)

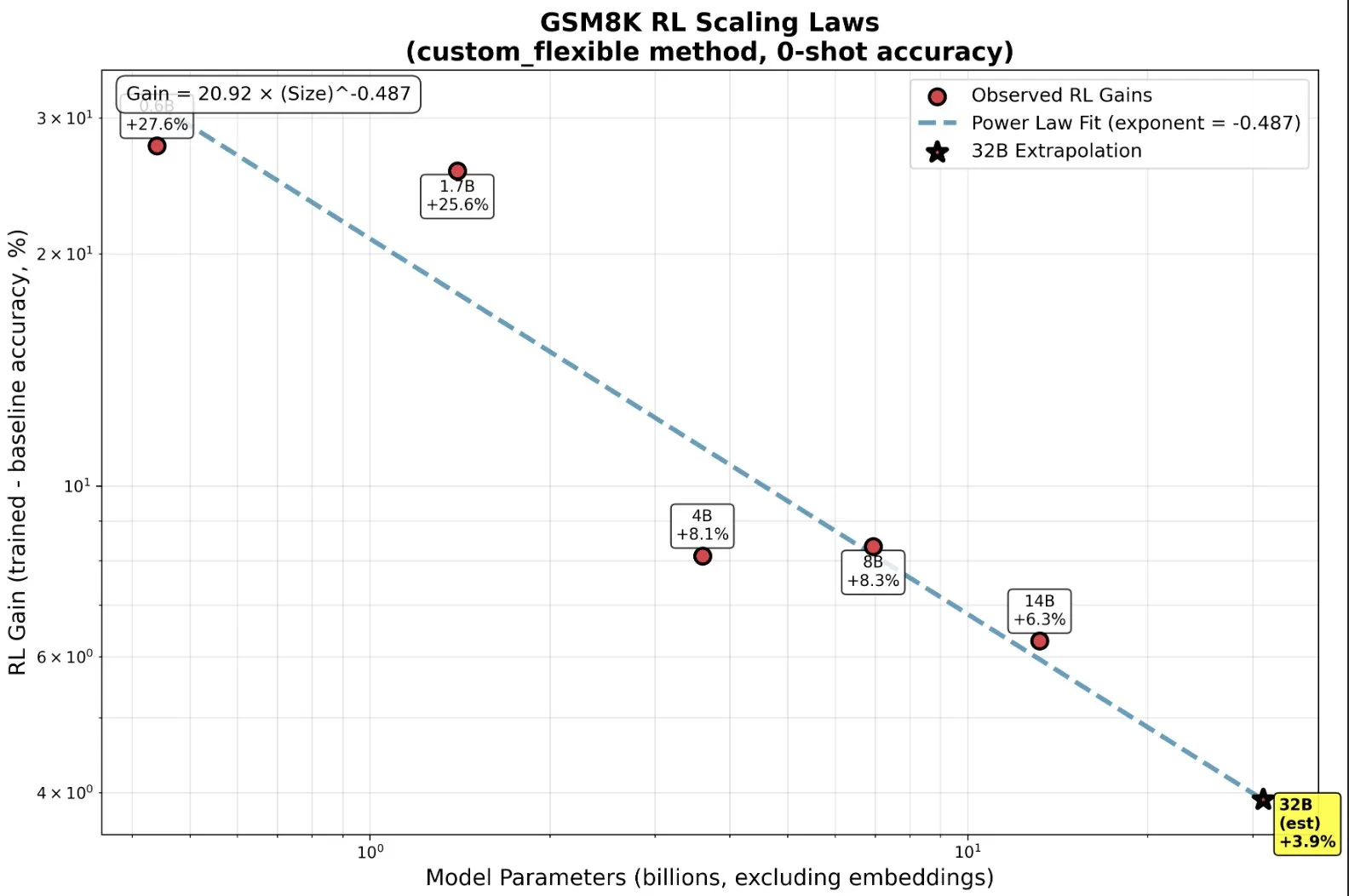

Pelatihan RL Model Kecil: Kemampuan Emergen Melampaui Pra-pelatihan : Penelitian menemukan bahwa dalam Reinforcement Learning (RL), model kecil dapat memperoleh manfaat secara tidak proporsional, bahkan menunjukkan kemampuan “emergen”, yang membalikkan intuisi tradisional “semakin besar semakin baik”. Pada model skala kecil, RL mungkin lebih efisien secara komputasi daripada pra-pelatihan yang lebih banyak. Penemuan ini memiliki signifikansi penting bagi keputusan laboratorium AI tentang kapan harus menghentikan pra-pelatihan dan kapan harus memulai RL saat memperluas RL, mengungkapkan hukum penskalaan baru antara ukuran model dan peningkatan kinerja dalam RL. (Sumber: ClementDelangue, ClementDelangue)

AI vs. Machine Learning vs. Deep Learning: Penjelasan Sederhana : Sebuah sumber video menjelaskan perbedaan antara Kecerdasan Buatan (AI), Machine Learning (ML), dan Deep Learning (DL) dengan cara yang mudah dipahami. Video ini bertujuan untuk membantu pemula dengan cepat memahami konsep-konsep inti ini, meletakkan dasar untuk pembelajaran lebih lanjut di bidang AI. (Sumber: )

Manajemen Template Prompt dalam Eksperimen Model Deep Learning : Komunitas deep learning mendiskusikan cara mengelola dan menggunakan kembali template prompt dalam eksperimen model. Dalam proyek besar, terutama saat memodifikasi arsitektur atau dataset, melacak efek berbagai varian prompt menjadi kompleks. Pengguna berbagi pengalaman menggunakan Empromptu AI dan alat lain untuk kontrol versi dan klasifikasi prompt, menekankan pentingnya versi prompt dan penyelarasan dataset dengan prompt untuk mengoptimalkan produk model. (Sumber: Reddit r/deeplearning)

Panduan Pemilihan Model Code Completion (FIM) : Komunitas mendiskusikan faktor-faktor kunci dalam memilih model Code Completion (FIM). Kecepatan dianggap sebagai prioritas mutlak, disarankan untuk memilih model dengan parameter sedikit dan hanya berjalan menggunakan GPU (target >70 t/s). Selain itu, model “dasar” dan model instruksi menunjukkan kinerja serupa dalam tugas FIM. Diskusi juga mencantumkan model FIM terbaru dan yang sedikit lebih lama seperti Qwen3-Coder, KwaiCoder, dan membahas bagaimana alat seperti nvim.llm dapat mendukung model non-spesifik kode. (Sumber: Reddit r/LocalLLaMA)

Trade-off Kinerja Model Terkuantisasi: Model Besar dan Presisi Rendah : Komunitas mendiskusikan trade-off kinerja antara model terkuantisasi besar dan model tidak terkuantisasi kecil, serta dampak tingkat kuantisasi pada kinerja model. Secara umum diyakini bahwa kuantisasi 2-bit mungkin cocok untuk penulisan atau percakapan, tetapi untuk tugas seperti pengkodean, setidaknya diperlukan tingkat Q5. Seorang pengguna menunjukkan bahwa kinerja Gemma3-27B menurun drastis pada kuantisasi rendah, sementara beberapa model baru dilatih dengan presisi FP4, tanpa memerlukan presisi yang lebih tinggi. Ini menunjukkan bahwa efek kuantisasi bervariasi tergantung pada model dan tugas, dan memerlukan pengujian spesifik. (Sumber: Reddit r/LocalLLaMA)

Alasan Kegagalan MissForest R dalam Tugas Prediksi : Sebuah artikel analisis membahas alasan kegagalan algoritma MissForest R dalam tugas prediksi, menunjukkan bahwa ia secara diam-diam melanggar prinsip kunci pemisahan set pelatihan dan set pengujian saat melakukan imputasi. Artikel tersebut menjelaskan batasan MissForest dalam situasi semacam ini, dan memperkenalkan metode baru seperti MissForestPredict yang mengatasi masalah ini dengan menjaga konsistensi antara pembelajaran dan aplikasi. Ini memiliki signifikansi panduan penting bagi praktisi machine learning dalam menangani nilai yang hilang dan membangun model prediksi. (Sumber: Reddit r/MachineLearning)

Mencari Sumber Daya Machine Learning Multimodal : Pengguna komunitas mencari sumber daya pembelajaran machine learning multimodal, terutama materi teori dan praktik tentang cara menggabungkan berbagai jenis data (teks, gambar, sinyal, dll.) serta memahami konsep seperti fusi, penyelarasan, dan perhatian lintas-modal. Ini mencerminkan meningkatnya kebutuhan akan pembelajaran teknologi AI multimodal. (Sumber: Reddit r/deeplearning)

Mencari Sumber Daya Video Pelatihan Model Inferensi Reinforcement Learning : Komunitas machine learning mencari sumber daya video kuliah ilmiah terbaik tentang penggunaan Reinforcement Learning (RL) untuk melatih model inferensi, termasuk video ikhtisar dan penjelasan mendalam tentang metode spesifik. Pengguna berharap mendapatkan konten akademik berkualitas tinggi, bukan video influencer yang dangkal, untuk dengan cepat memahami literatur terkait dan memutuskan arah penelitian lebih lanjut. (Sumber: Reddit r/MachineLearning)

Perjalanan Coding AI 11 Bulan: Alat, Tech Stack, dan Praktik Terbaik : Seorang pengembang berbagi perjalanan coding AI selama 11 bulan, merinci pengalaman, kegagalan, dan praktik terbaik menggunakan alat seperti Claude Code. Ia menekankan bahwa dalam coding AI, perencanaan awal dan manajemen konteks jauh lebih penting daripada menulis kode itu sendiri. Meskipun AI menurunkan ambang batas untuk implementasi kode, ia tidak menggantikan desain arsitektur dan wawasan bisnis. Berbagi pengalaman ini mencakup berbagai proyek mulai dari front-end hingga back-end, pengembangan aplikasi seluler, dan merekomendasikan alat bantu seperti Context7, SpecDrafter. (Sumber: Reddit r/ClaudeAI)

💼 BISNIS

JPMorgan Chase: Investasi $2 Miliar Setahun, Transformasi Menjadi ‘Bank Sepenuhnya AI’ : CEO JPMorgan Chase, Jamie Dimon, mengumumkan investasi $2 miliar setiap tahun untuk AI, bertujuan untuk mengubah perusahaan menjadi “bank yang sepenuhnya AI”. AI telah terintegrasi secara mendalam ke dalam bisnis inti seperti manajemen risiko, perdagangan, layanan pelanggan, kepatuhan, dan perbankan investasi, tidak hanya menghemat biaya, tetapi yang lebih penting, mempercepat ritme kerja dan mengubah esensi pekerjaan. JPMorgan Chase, melalui platform LLM Suite yang dikembangkan sendiri dan deployment AI Agent skala besar, menganggap AI sebagai sistem operasi dasar perusahaan, dan menekankan bahwa integrasi data serta keamanan siber adalah tantangan terbesar dalam strategi AI-nya. Dimon percaya bahwa AI adalah nilai jangka panjang yang nyata, bukan gelembung jangka pendek, dan akan membentuk kembali definisi bank. (Sumber: 36氪)

Apple dari Musk