Kata Kunci:OpenAI Sora, Pembuatan Video AI, Model Rekursif Kecil, Mainan AI, Chip AI, Pembuatan Ulang Video Sora 2, Efisiensi Inferensi TRM, Pertumbuhan Pasar Mainan AI, Kolaborasi Chip AMD dan OpenAI, Kontroversi Hak Cipta Konten AI

🔥 FOKUS

Kebangkitan dan Tantangan OpenAI Sora App : Aplikasi pembuatan video AI, Sora, yang dirilis oleh OpenAI, dengan cepat menjadi populer dan menduduki puncak App Store. Kemampuannya untuk menghasilkan video secara gratis dan tanpa batas telah menimbulkan kekhawatiran luas tentang biaya operasional, pelanggaran hak cipta (terutama penggunaan IP yang ada dan potret selebriti yang telah meninggal), serta penyalahgunaan teknologi deepfake. Sam Altman mengakui perlunya mempertimbangkan model profitabilitas dan berencana untuk menyediakan kontrol hak cipta yang lebih terperinci. Dampak aplikasi ini terhadap ekosistem pembuatan konten dan persepsi realitas telah memicu diskusi tentang apakah video AI akan melampaui video “nyata”. (Sumber: MIT Technology Review, rowancheung, fabianstelzer, nptacek, paul_cal, BlackHC)

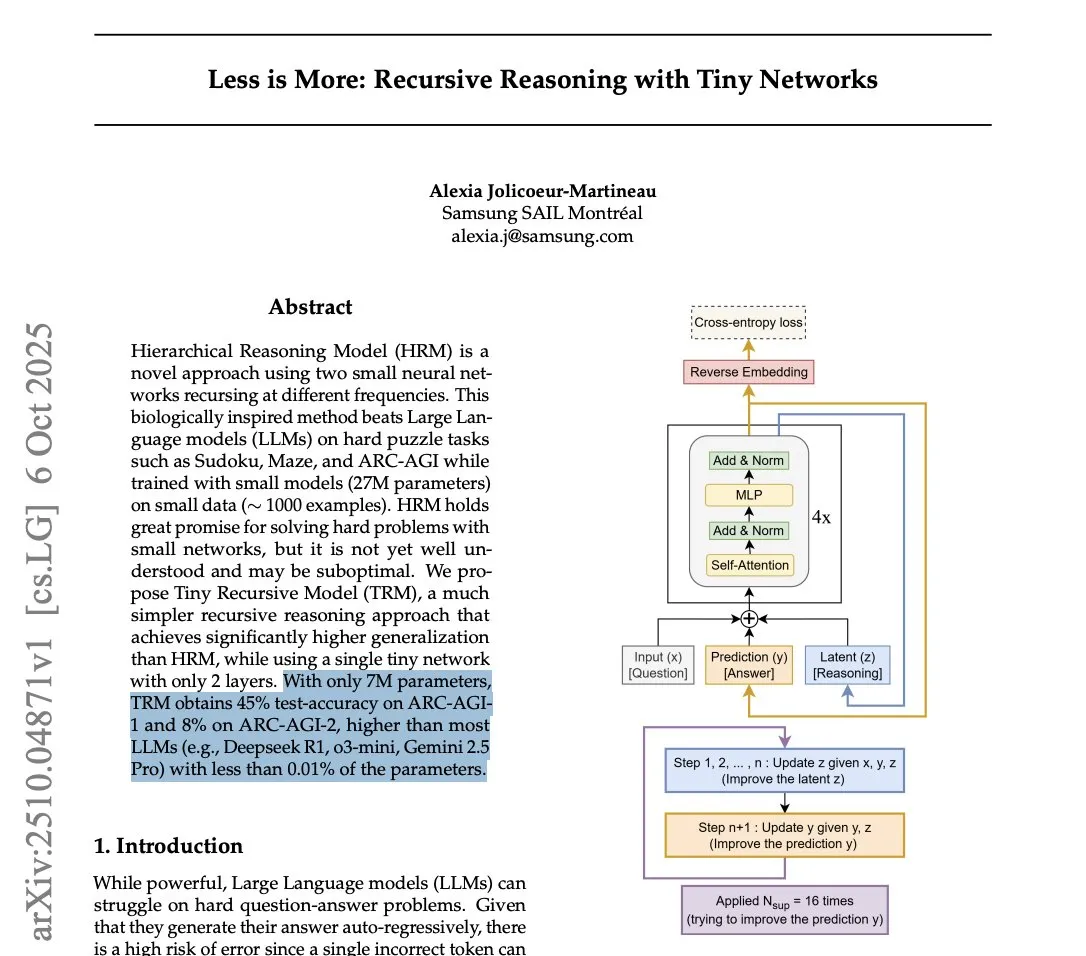

Samsung Meluncurkan Tiny Recursive Model (TRM) untuk Menantang Efisiensi Inferensi LLM : Samsung telah merilis Tiny Recursive Model (TRM), sebuah jaringan saraf kecil dengan hanya 7 juta parameter, yang menunjukkan kinerja luar biasa dalam benchmark ARC-AGI, bahkan melampaui LLM besar seperti DeepSeek-R1 dan Gemini 2.5 Pro. TRM menggunakan metode inferensi rekursif, mengoptimalkan jawaban melalui beberapa “pemikiran” internal dan kritik diri. Terobosan ini memicu diskusi tentang “apakah model kecil bisa lebih cerdas” dan mengindikasikan bahwa inovasi arsitektur mungkin lebih penting daripada sekadar ukuran model dalam tugas inferensi, berpotensi mengurangi biaya komputasi inferensi SOTA secara signifikan. (Sumber: HuggingFace Daily Papers, fchollet, cloneofsimo, ecsquendor, clefourrier, AymericRoucher, ClementDelangue, Dorialexander)

Yao Shunyu dari Tsinghua Pindah dari Anthropic ke Google DeepMind, Perbedaan Nilai Menjadi Alasan Utama : Yao Shunyu, penerima beasiswa khusus dari Departemen Fisika Universitas Tsinghua, mengumumkan keputusannya untuk meninggalkan Anthropic dan bergabung dengan Google DeepMind sebagai Ilmuwan Riset Senior. Ia menyatakan bahwa 40% alasan kepergiannya adalah “perbedaan nilai fundamental” dengan Anthropic, merasa bahwa perusahaan tersebut tidak ramah terhadap peneliti Tiongkok dan karyawan dengan posisi netral. Yao Shunyu bekerja di Anthropic selama setahun, terlibat dalam pembangunan teori pembelajaran penguatan di balik seri Claude 3.7 Sonnet dan Claude 4. Ia menyatakan bahwa bidang AI berkembang dengan kecepatan yang luar biasa, tetapi sekarang saatnya untuk melangkah maju. (Sumber: ZhihuFrontier, 量子位)

Arduino Diakuisisi oleh Qualcomm, Menandakan Arah Baru AI Tertanam : Arduino diakuisisi oleh Qualcomm dan meluncurkan papan pengembangan kolaboratif pertamanya, UNO Q, yang ditenagai oleh prosesor Qualcomm Dragonwing QRB2210, mengintegrasikan solusi AI. Ini menandai perkembangan Arduino dari bidang mikrokontroler berdaya rendah tradisional menuju komputasi edge dengan daya menengah dan kemampuan AI terintegrasi. Langkah ini berpotensi mendorong aplikasi AI yang luas di IoT dan perangkat tertanam, menyediakan daya komputasi AI yang lebih kuat bagi pengembang, dan menandakan perubahan baru dalam ekosistem perangkat keras AI tertanam. (Sumber: karminski3)

Meta Superintelligence Merilis REFRAG: Terobosan Baru dalam Efisiensi RAG : Meta Superintelligence merilis makalah pertamanya, REFRAG, yang mengusulkan metode RAG (Retrieval-Augmented Generation) baru yang bertujuan untuk meningkatkan efisiensi secara signifikan. Metode ini mengubah sebagian besar blok dokumen yang diambil menjadi “block embeddings” yang ringkas dan ramah LLM untuk langsung dikonsumsi oleh LLM, dan menggunakan strategi ringan untuk memperluas sebagian block embeddings kembali menjadi token lengkap sesuai kebutuhan dalam batas anggaran. Ini secara signifikan mengurangi biaya KV cache dan perhatian, mempercepat latensi byte pertama dan throughput, sambil mempertahankan akurasi, membuka jalan baru untuk aplikasi RAG real-time. (Sumber: Reddit r/deeplearning, Reddit r/LocalLLaMA)

🎯 GERAKAN

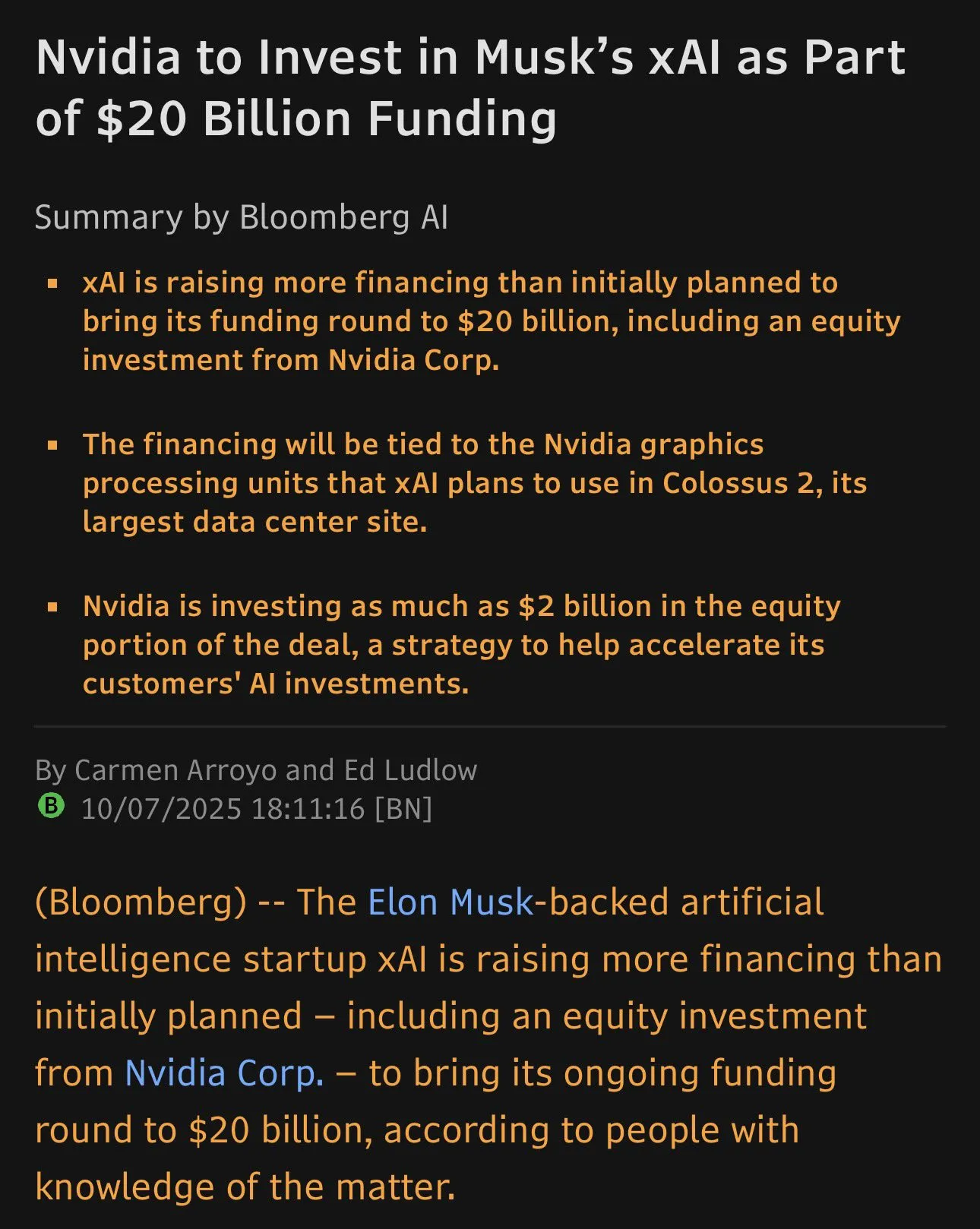

xAI Selesaikan Pendanaan $20 Miliar, NVIDIA Investasi $2 Miliar : Perusahaan xAI milik Elon Musk berhasil menyelesaikan putaran pendanaan senilai $20 miliar, termasuk investasi langsung sebesar $2 miliar dari NVIDIA. Dana ini akan digunakan untuk pengadaan GPU NVIDIA melalui Special Purpose Vehicle (SPV) guna mendukung pembangunan pusat data Memphis Colossus 2 mereka. Struktur pendanaan ini unik, bertujuan untuk memberikan jaminan perangkat keras bagi ekspansi besar-besaran xAI di bidang komputasi AI, yang semakin memperketat persaingan di pasar chip AI. (Sumber: scaling01)

Mainan AI Bangkit di Pasar Tiongkok dan AS : Mainan AI yang dilengkapi dengan chatbot dan asisten suara menjadi tren baru, terutama tumbuh pesat di pasar Tiongkok, dan telah meluas ke pasar internasional seperti Amerika Serikat. Produk dari perusahaan seperti BubblePal dan FoloToy bertujuan untuk mengurangi ketergantungan anak-anak pada layar. Namun, orang tua melaporkan bahwa fitur AI terkadang tidak stabil, responsnya panjang atau pengenalan suaranya lambat, yang menyebabkan minat anak-anak berkurang. Perusahaan AS seperti Mattel juga bekerja sama dengan OpenAI untuk mengembangkan mainan AI. (Sumber: MIT Technology Review)

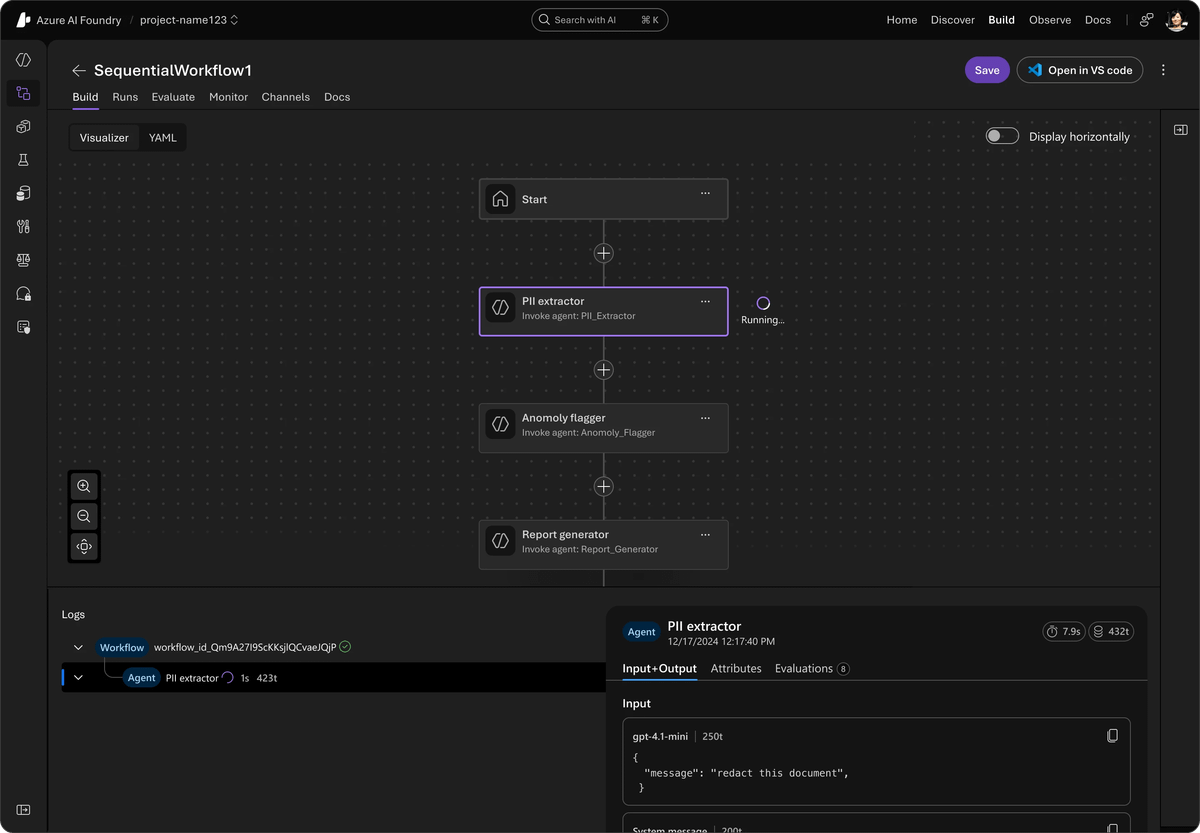

Microsoft Meluncurkan Kerangka Kerja Agent Sumber Terbuka Terpadu, Mengintegrasikan AutoGen dan Semantic Kernel : Microsoft telah merilis Agent Framework, sebuah SDK sumber terbuka terpadu yang dirancang untuk mengintegrasikan AutoGen dan Semantic Kernel, guna membangun sistem AI multi-agent tingkat perusahaan. Kerangka kerja ini didukung oleh Azure AI Foundry, menyederhanakan orkestrasi dan observabilitas, serta kompatibel dengan berbagai API. Ini memperkenalkan pratinjau pribadi alur kerja multi-agent, pelacakan lintas kerangka kerja OpenTelemetry, kemampuan agent suara real-time dari Voice Live API, serta alat AI yang bertanggung jawab, yang bertujuan untuk meningkatkan keamanan dan efisiensi sistem agent. (Sumber: TheTuringPost)

AI21 Labs Merilis Jamba 3B, Kinerja Model Kecil Melampaui Pesaing : AI21 Labs meluncurkan Jamba 3B, sebuah model MoE dengan hanya 3 miliar parameter, yang menunjukkan kinerja luar biasa dalam kualitas dan kecepatan, terutama dalam penanganan konteks panjang. Model ini dapat mempertahankan kecepatan generasi sekitar 40 t/s di Mac bahkan dengan konteks lebih dari 32K, jauh melampaui Qwen 3 4B dan Llama 3.2 3B. Jamba 3B memiliki indeks kecerdasan lebih tinggi dari Gemma 3 4B dan Phi-4 Mini, dan kemampuan inferensinya tetap utuh pada konteks 256K, menunjukkan potensi besar model kecil dalam AI edge dan penerapan di perangkat. (Sumber: Reddit r/LocalLLaMA)

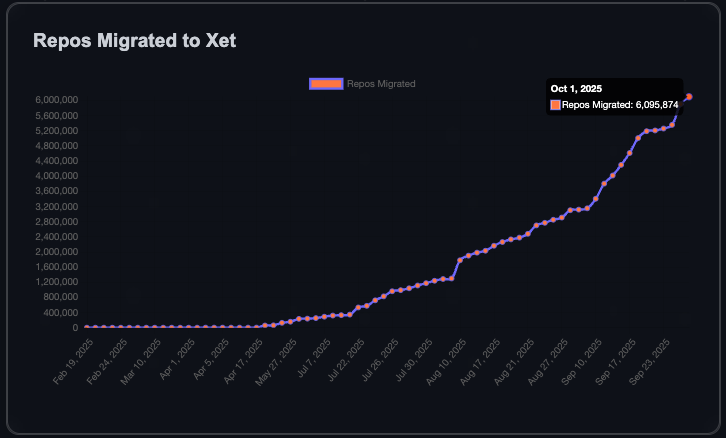

Komunitas HuggingFace Tumbuh Pesat, Tambah Sejuta Repositori dalam 90 Hari : Komunitas HuggingFace telah menambahkan 1 juta model, dataset, dan repositori Space dalam 90 hari terakhir. Untuk mencapai satu juta repositori pertama dibutuhkan enam tahun, yang berarti satu repositori baru dibuat setiap 8 detik. Pertumbuhan ini didorong oleh transfer data yang lebih efisien yang dimungkinkan oleh teknologi Xet, serta 40% repositori pribadi menunjukkan tren penggunaan HuggingFace secara internal oleh perusahaan untuk berbagi model dan data. Tujuan komunitas adalah mencapai 10 juta repositori, menandakan perkembangan pesat ekosistem AI sumber terbuka. (Sumber: Teknium1, reach_vb)

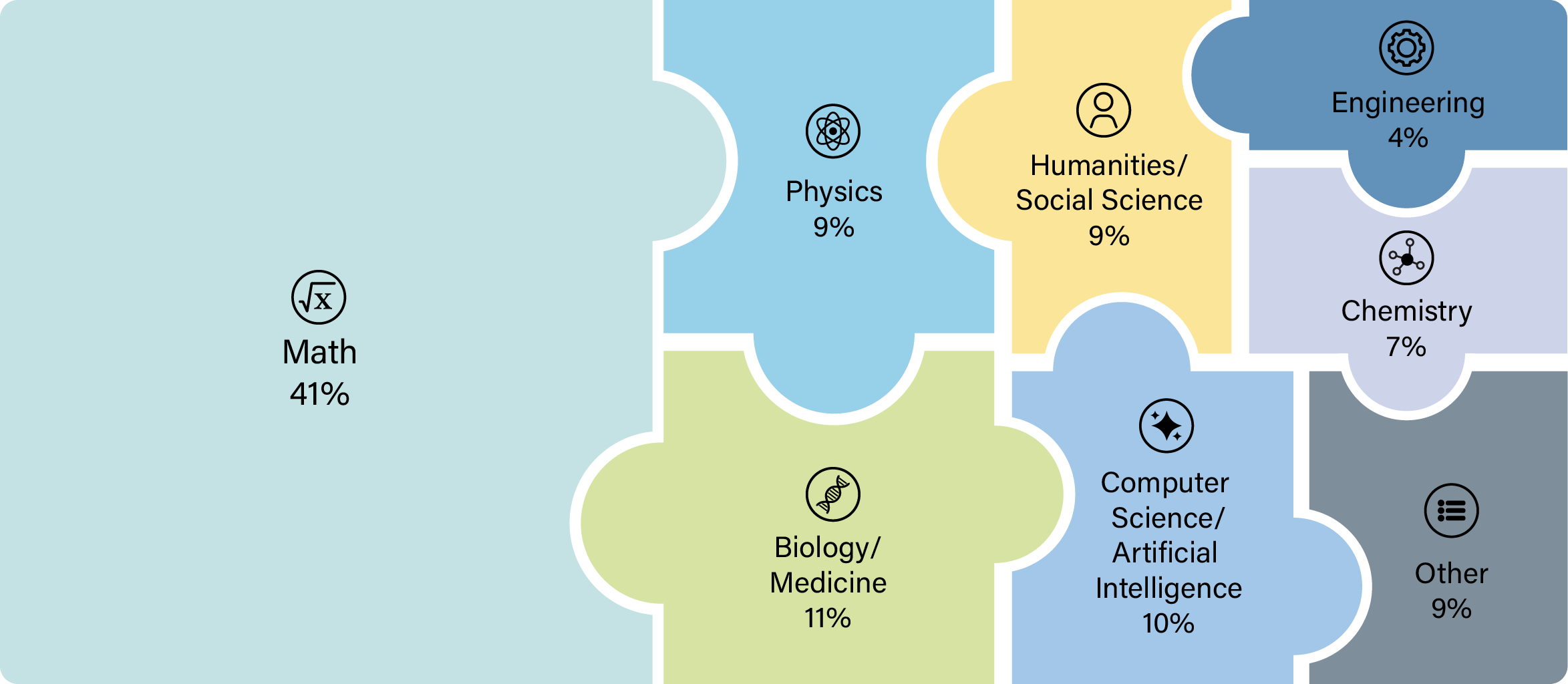

OpenAI GPT-5 Menunjukkan Kemampuan Terobosan dalam Penelitian Ilmiah : Model GPT-5 OpenAI telah melampaui ambang batas penting, dengan para ilmuwan berhasil menggunakannya untuk melakukan penelitian orisinal di bidang matematika, fisika, biologi, dan ilmu komputer. Kemajuan ini menunjukkan bahwa GPT-5 tidak hanya dapat menjawab pertanyaan, tetapi juga memandu dan melaksanakan eksplorasi ilmiah yang kompleks, sangat mempercepat proses penelitian. Beberapa peneliti menyatakan bahwa setelah rilis GPT-5 Thinking dan GPT-5 Pro, tidak lagi masuk akal untuk tidak berkonsultasi dengan mereka dalam penelitian ilmiah. (Sumber: tokenbender)

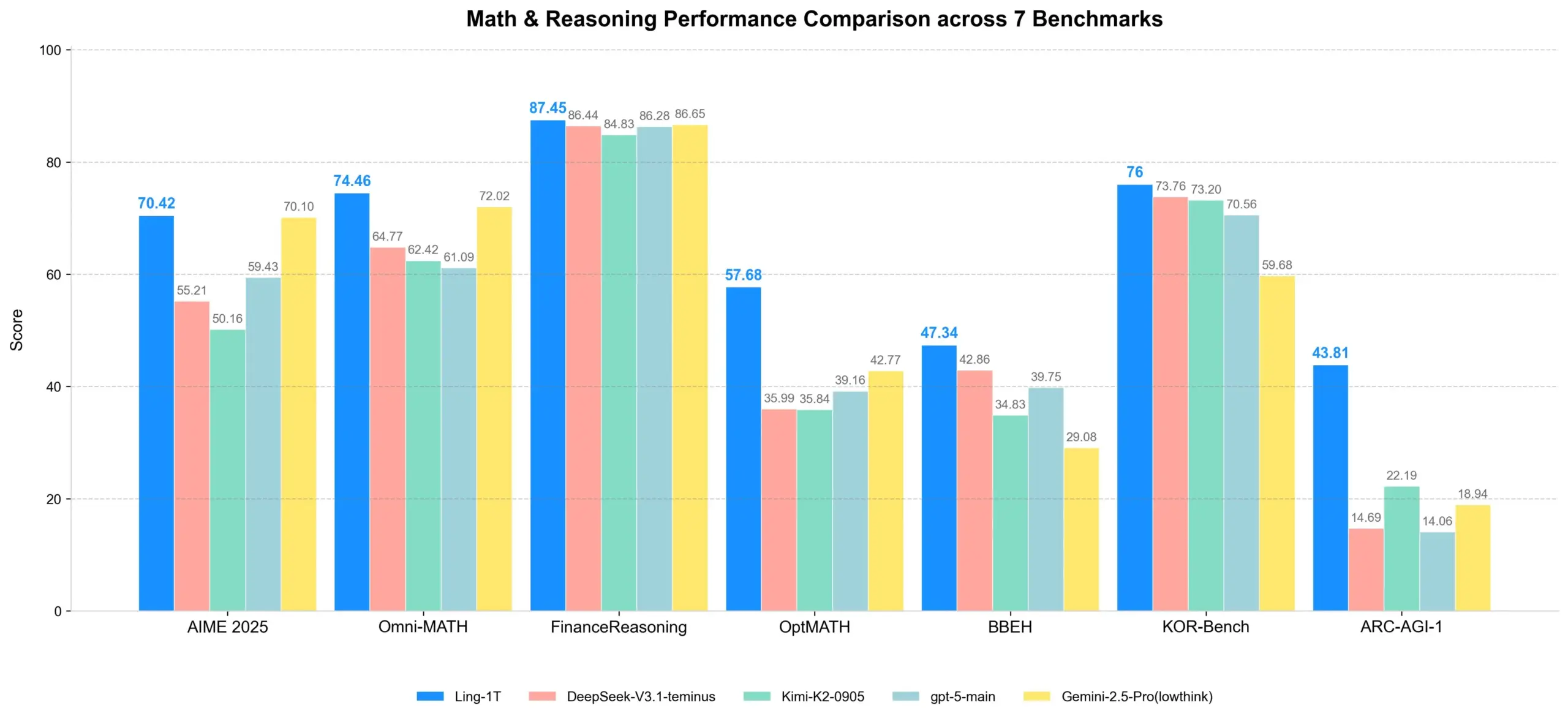

Ling-1T: Model Inferensi Sumber Terbuka dengan Triliunan Parameter Dirilis : Ling-1T, sebagai model unggulan dari seri Ling 2.0, memiliki total 1 triliun parameter, dengan sekitar 50 miliar parameter aktif per token, dan dilatih pada 20 triliun+ token intensif inferensi. Model ini mencapai inferensi yang dapat diskalakan melalui kurikulum Evo-CoT dan Linguistics-Unit RL, menunjukkan keseimbangan efisiensi-akurasi yang kuat dalam tugas inferensi kompleks. Ia juga memiliki kemampuan pemahaman visual tingkat lanjut dan pembuatan kode frontend, serta dapat menggunakan alat dengan tingkat keberhasilan sekitar 70%, menandai tonggak baru dalam kecerdasan triliunan parameter sumber terbuka. (Sumber: scaling01, TheZachMueller)

Meta Ray-Ban Display Mendefinisikan Ulang Interaksi Manusia-Komputer dan Pembelajaran : Kacamata pintar Meta Ray-Ban Display mengintegrasikan fitur pembelajaran dan terjemahan ke dalam pemakaian sehari-hari, menawarkan pengalaman “terjemahan tak terlihat” dan “pembelajaran visual instan”. Subtitel percakapan ditampilkan langsung di lensa, dan pengguna cukup melihat landmark atau karya seni untuk mendapatkan informasi terkait. Selain itu, kontrol gerakan diaktifkan melalui Neural Band, memungkinkan pengoperasian tanpa perlu ponsel. Teknologi ini diharapkan dapat membentuk kembali cara kita berinteraksi, belajar, dan terhubung dengan dunia, menandai awal baru komputasi yang berpusat pada manusia. (Sumber: Ronald_vanLoon)

🧰 ALAT

Synthesia Meluncurkan Copilot, Memberdayakan Pengeditan Video AI Profesional : Synthesia telah merilis Copilot, sebuah editor video AI profesional. Alat ini dapat dengan cepat menulis skrip, menghubungkan basis pengetahuan, dan merekomendasikan materi visual secara cerdas, seolah-olah memiliki rekan kerja yang sangat memahami bisnis dan platform Synthesia. Copilot bertujuan untuk menyederhanakan proses produksi video, menurunkan ambang batas untuk pembuatan video profesional, dan menyediakan solusi video AI yang efisien dan personal bagi perusahaan dan pembuat konten. (Sumber: synthesiaIO, synthesiaIO)

GLIF Agent Menggunakan Sora 2 untuk Reproduksi dan Kustomisasi Video Viral : GLIF telah mengembangkan sebuah Agent yang dapat mereproduksi video viral apa pun menggunakan model Sora 2. Agent ini pertama-tama menganalisis video asli, kemudian menghasilkan prompt terperinci berdasarkan hasil analisis. Pengguna dapat berkolaborasi dengan Agent untuk menyesuaikan prompt, sehingga menciptakan video yang dihasilkan AI yang sangat personal. Teknologi ini diharapkan dapat menyediakan kemampuan produksi video dan kreasi ulang yang kuat di bidang pembuatan konten dan pemasaran. (Sumber: fabianstelzer)

Cloudflare AI Search Berkolaborasi dengan GroqInc Meluncurkan Templat “Obrolan Dokumen” : Cloudflare AI Search (sebelumnya AutoRAG) telah berkolaborasi dengan GroqInc untuk meluncurkan templat “Obrolan Dokumen” sumber terbuka yang baru. Templat ini menggabungkan mesin inferensi Groq dengan AI Search, memungkinkan pengguna untuk lebih mudah menambahkan fitur AI percakapan ke dokumen, memungkinkan tanya jawab dan interaksi real-time dengan konten dokumen. Integrasi ini akan meningkatkan efisiensi pengambilan dokumen dan perolehan informasi. (Sumber: JonathanRoss321)

HuggingFace Meluncurkan Fitur Pengeditan GGUF dalam Browser : HuggingFace kini mendukung pengeditan metadata model GGUF langsung di dalam browser, tanpa perlu mengunduh model lengkap. Fitur ini diimplementasikan melalui teknologi Xet, mendukung pembaruan sebagian file, sangat menyederhanakan manajemen model dan proses iterasi, serta meningkatkan efisiensi kerja pengembang di platform HuggingFace. (Sumber: reach_vb)

LangChain dan LangGraph Merilis Versi Alpha v1.0, Mengumpulkan Umpan Balik Pengembang : LangChain dan LangGraph telah merilis versi Alpha v1.0, memperkenalkan API middleware Agent baru, blok output/konten standar, serta pembaruan API penting. Tim secara aktif mengundang pengembang untuk menguji versi baru dan memberikan umpan balik, guna lebih menyempurnakan kerangka kerja pengembangan agent AI mereka dan mendorong pembangunan aplikasi AI yang lebih kuat. (Sumber: LangChainAI)

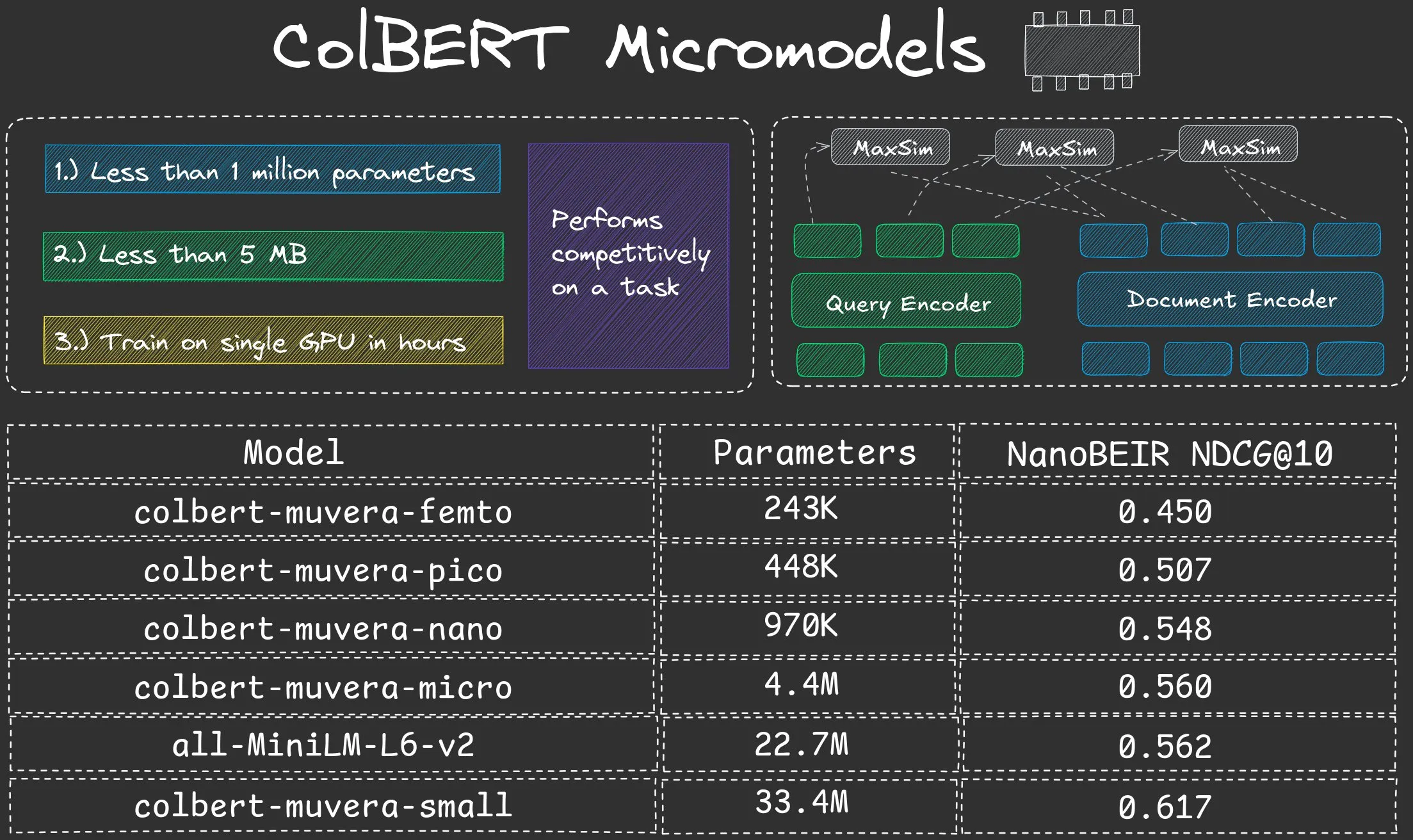

NeuML Merilis Seri Model Mikro ColBERT Nano, Jumlah Parameter di Bawah Satu Juta : NeuML telah merilis seri model ColBERT Nano, dengan jumlah parameter di bawah 1 juta (250K, 450K, 950K). Model-model mikro ini menunjukkan kinerja yang luar biasa dalam mode “Late interaction”, membuktikan bahwa model dengan skala sangat kecil pun dapat mencapai hasil yang baik dalam tugas-tugas tertentu, menyediakan solusi efisien untuk penerapan AI di lingkungan dengan sumber daya terbatas. (Sumber: lateinteraction, lateinteraction)

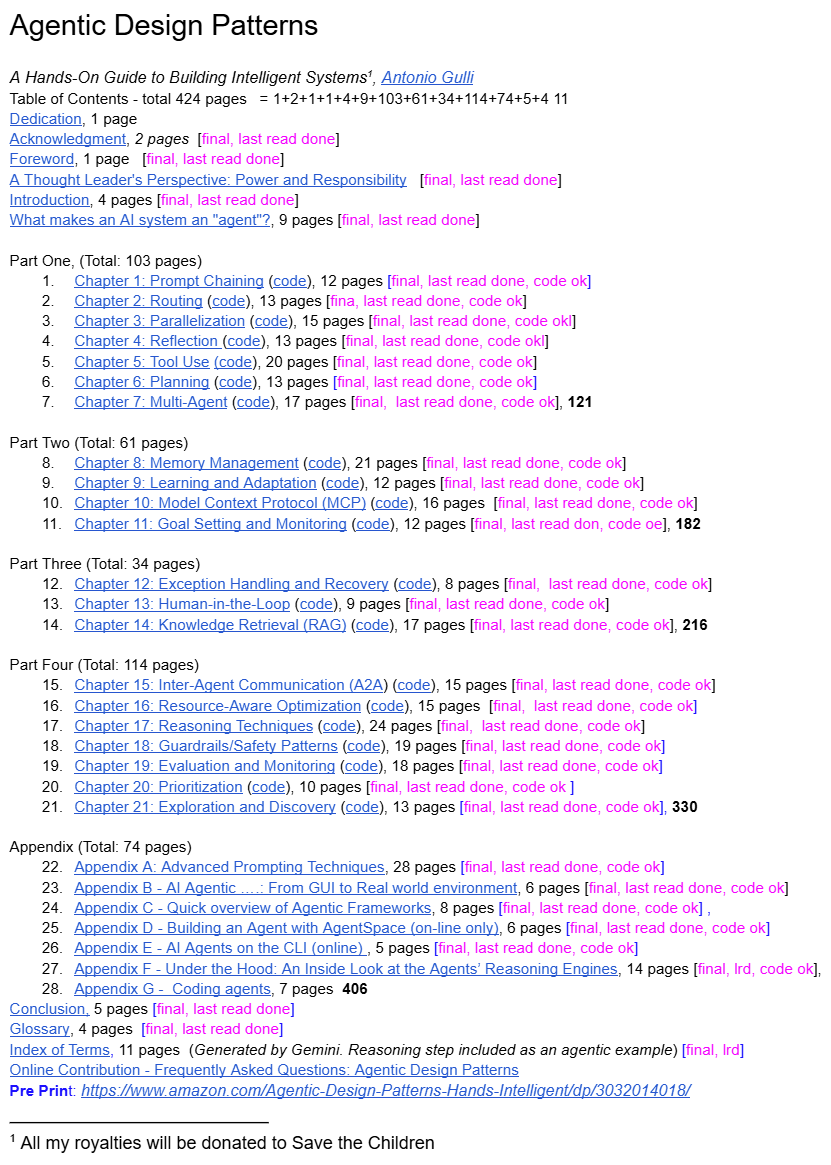

Direktur Teknik Senior Google Berbagi “Pola Desain Agent” : Direktur Teknik Senior Google telah membagikan buku “Pola Desain Agent” secara gratis, membawa seperangkat prinsip desain sistematis dan praktik terbaik pertama ke bidang AI Agent yang sedang berkembang pesat. Sumber daya ini bertujuan untuk membantu pengembang memahami dan membangun agent AI dengan lebih baik, mengisi kekosongan panduan sistematis di bidang ini, dan diharapkan menjadi referensi penting bagi pengembang AI Agent. (Sumber: dotey)

📚 PEMBELAJARAN

Studi Halusinasi LLM dan Mekanisme Penyelarasan Keamanan: Dari Asal Internal hingga Strategi Mitigasi : Penelitian menemukan bahwa model inferensi LLM mungkin menunjukkan fenomena “tebing penolakan” sebelum menghasilkan output akhir, yaitu penurunan tajam dalam niat penolakan. Melalui kerangka kerja DST, peneliti mengungkapkan bahwa halusinasi menjadi tak terhindarkan pada “lapisan komitmen” spesifik model, dan mengusulkan model inferensi kecil HalluGuard, yang mengurangi halusinasi dalam RAG melalui integrasi sinyal klinis dan optimasi data, menyediakan penjelasan mekanistik dan strategi praktis untuk penyelarasan keamanan LLM dan mitigasi halusinasi. (Sumber: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

ASPO Mengoptimalkan Pembelajaran Penguatan LLM, Mengatasi Masalah Ketidakcocokan Rasio IS : ASPO (Asymmetric Importance Sampling Policy Optimization) adalah metode pasca-pelatihan LLM baru yang mengatasi cacat fundamental ketidakcocokan rasio Importance Sampling (IS) token keuntungan positif dalam pembelajaran penguatan tradisional. Dengan membalik rasio IS token keuntungan positif dan memperkenalkan mekanisme soft double clipping, ASPO dapat memperbarui token probabilitas rendah dengan lebih stabil, mengurangi konvergensi dini, dan secara signifikan meningkatkan kinerja dalam benchmark pengkodean dan inferensi matematika. (Sumber: HuggingFace Daily Papers)

Fathom-DeepResearch: Sistem Agent untuk Pengambilan dan Sintesis Informasi Jangka Panjang : Fathom-DeepResearch adalah sistem agent yang terdiri dari Fathom-Search-4B dan Fathom-Synthesizer-4B, dirancang khusus untuk tugas pengambilan informasi yang kompleks dan terbuka. Fathom-Search-4B mengoptimalkan pencarian web real-time dan kueri halaman web melalui dataset self-play multi-agent dan pembelajaran penguatan. Fathom-Synthesizer-4B mengubah hasil pencarian multi-putaran menjadi laporan terstruktur. Sistem ini menunjukkan kinerja luar biasa dalam beberapa benchmark dan menunjukkan kemampuan generalisasi yang kuat untuk tugas inferensi seperti HLE dan AIME-25. (Sumber: HuggingFace Daily Papers)

AgentFlow: Optimasi Sistem Agent In-Flow untuk Perencanaan dan Penggunaan Alat yang Efisien : AgentFlow adalah kerangka kerja agent in-flow yang dapat dilatih, yang secara langsung mengoptimalkan perencananya dalam siklus interaksi multi-putaran melalui koordinasi empat modul: perencana, pelaksana, validator, dan generator. Ia menggunakan Flow-based Group Refined Policy Optimization untuk mengatasi masalah alokasi kredit dengan siklus panjang dan hadiah yang jarang. AgentFlow melampaui baseline SOTA dalam sepuluh benchmark dengan model backbone skala 7B, dengan akurasi rata-rata yang meningkat secara signifikan dalam tugas pencarian, agent, matematika, dan sains, bahkan melampaui GPT-4o. (Sumber: HuggingFace Daily Papers)

Studi Sistematis tentang Dampak Data Kode pada Kemampuan Inferensi LLM : Penelitian ini mengeksplorasi bagaimana data kode meningkatkan kemampuan inferensi LLM melalui kerangka kerja yang sistematis dan berpusat pada data. Dengan membangun dataset instruksi paralel dari sepuluh bahasa pemrograman dan menerapkan gangguan struktural atau semantik, ditemukan bahwa LLM lebih sensitif terhadap gangguan struktural daripada gangguan semantik, terutama dalam tugas matematika dan kode. Pseudocode dan diagram alir sama efektifnya dengan kode, dan gaya sintaksis juga memengaruhi keuntungan spesifik tugas (Python bermanfaat untuk inferensi bahasa alami, Java/Rust untuk matematika). (Sumber: HuggingFace Daily Papers)

DeepEvolve: Agent Penemuan Algoritma Ilmiah yang Menggabungkan Penelitian Mendalam dan Evolusi Algoritma : DeepEvolve adalah agent yang menggabungkan penelitian mendalam dengan evolusi algoritma, menemukan algoritma ilmiah dalam siklus iteratif berbasis umpan balik melalui pengambilan pengetahuan eksternal, pengeditan kode lintas file, dan debugging sistem. Ia tidak hanya mengajukan hipotesis baru, tetapi juga melakukan penyempurnaan, implementasi, dan pengujian, menghindari perbaikan dangkal dan penyempurnaan berlebihan yang tidak efektif. Dalam sembilan benchmark termasuk kimia, matematika, biologi, material, dan paten, DeepEvolve secara terus-menerus meningkatkan algoritma awal, menghasilkan algoritma baru yang dapat dieksekusi, dan memperoleh keuntungan berkelanjutan. (Sumber: HuggingFace Daily Papers)

Peta Jalan Pembelajaran AI/ML dan Konsep Inti : Komunitas telah berbagi jalur pembelajaran komprehensif untuk AI, Machine Learning, dan Deep Learning, mencakup berbagai aspek mulai dari konsep dasar hingga teknik canggih (seperti Agentic AI, parameter generasi LLM). Sumber daya ini bertujuan untuk memberikan panduan pembelajaran terstruktur bagi para profesional yang ingin memasuki atau memperdalam pengetahuan di bidang AI/ML, membantu mereka menguasai keterampilan seluruh proses mulai dari pengembangan model hingga deployment dan operasi, serta memahami bagaimana AI mendorong transformasi industri. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Benchmark AI dan Sumber Daya Pembelajaran: HLE, Konferensi, dan Manajemen Biaya GPU : Komunitas membahas beberapa sumber daya pembelajaran dan praktik AI. CAIS merilis benchmark “Humanity’s Last Exam” yang diperbarui secara dinamis untuk mengakomodasi peningkatan kinerja model. Pada saat yang sama, panduan partisipasi konferensi Machine Learning dan strategi pengembangan LLM berbiaya rendah disediakan, termasuk GPU bayar sesuai penggunaan dan menjalankan model kecil secara lokal. Selain itu, penyelenggaraan GPU Mode Hackathon menyediakan platform bagi pengembang untuk belajar dan berinteraksi. (Sumber: clefourrier, Reddit r/MachineLearning, Reddit r/MachineLearning, Reddit r/MachineLearning, danielhanchen)

OneFlow: Model Generatif Multimodal Campuran dan Interleaved Konkuren : OneFlow adalah model multimodal non-autoregresif pertama yang mendukung generasi multimodal campuran dengan panjang variabel dan konkuren. Ini menggabungkan aliran pengeditan plug-in untuk token teks diskrit dan pencocokan aliran untuk ruang laten gambar. OneFlow mencapai sintesis teks-gambar konkuren melalui sampling hierarkis, memprioritaskan konten daripada tata bahasa. Eksperimen menunjukkan bahwa OneFlow mengungguli baseline autoregresif dalam tugas generasi dan pemahaman, mengurangi FLOPs pelatihan hingga 50%, dan membuka kemampuan baru untuk generasi konkuren, penyempurnaan iteratif, dan generasi berbasis inferensi alami. (Sumber: HuggingFace Daily Papers)

Equilibrium Matching: Kerangka Pemodelan Generatif Berbasis Model Energi Implisit : Equilibrium Matching (EqM) adalah kerangka pemodelan generatif baru yang meninggalkan dinamika non-ekuilibrium, bergantung waktu dari model difusi dan aliran tradisional, dan beralih untuk mempelajari gradien ekuilibrium dari lanskap energi implisit. EqM menggunakan proses sampling berbasis optimasi, melakukan sampling pada lanskap yang dipelajari melalui penurunan gradien, mencapai kinerja SOTA ImageNet 256×256 FID 1.90, dan secara alami menangani tugas-tugas seperti denoising parsial, deteksi OOD, dan sintesis gambar. (Sumber: HuggingFace Daily Papers)

💼 BISNIS

OpenAI dan AMD Capai Kesepakatan Kemitraan Chip, Menantang Dominasi NVIDIA : OpenAI dan AMD telah menandatangani perjanjian kemitraan chip senilai miliaran dolar selama lima tahun, yang bertujuan untuk menantang dominasi NVIDIA di pasar chip AI. Langkah ini adalah bagian dari strategi diversifikasi pasokan chip OpenAI, setelah sebelumnya perusahaan juga menjalin kerja sama dengan NVIDIA. Perjanjian ini menyoroti permintaan besar industri AI akan perangkat keras komputasi berkinerja tinggi, serta pengejaran diversifikasi rantai pasokan. (Sumber: MIT Technology Review)

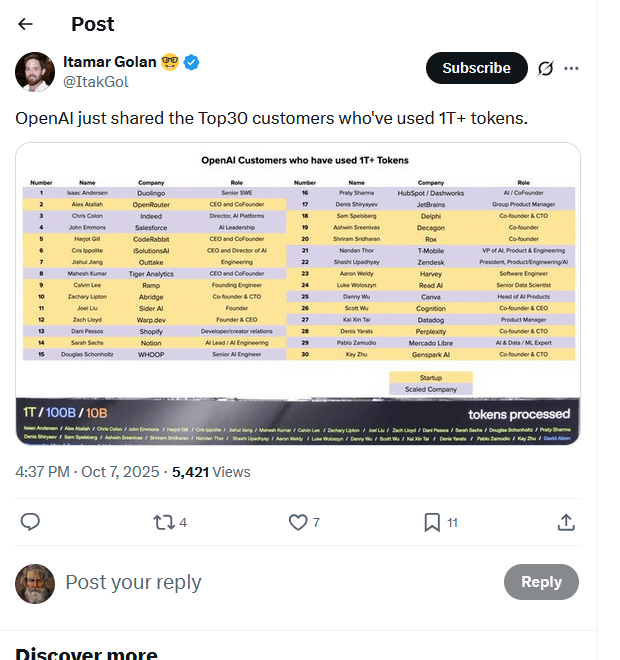

Daftar Klien Top OpenAI Bocor, 30 Perusahaan Mengonsumsi Triliunan Token : Sebuah daftar yang diduga merupakan klien top OpenAI beredar online, menunjukkan bahwa 30 perusahaan telah memproses lebih dari 1 triliun Token melalui model mereka. Daftar ini (termasuk Duolingo, OpenRouter, Salesforce, Canva, Perplexity, dll.) mengungkapkan pembentukan cepat ekonomi inferensi AI, dan menunjukkan empat jenis utama: pembangun AI-native, integrator AI, penyedia infrastruktur AI, dan penyedia solusi AI vertikal. Konsumsi Token dianggap sebagai benchmark baru untuk mengukur nilai sebenarnya dan kemajuan bisnis aplikasi AI. (Sumber: Reddit r/ArtificialInteligence, 量子位)

Singapura Menjadi Pelabuhan Aman Hak Cipta untuk Pengembangan AI, Menarik Perusahaan AI Global : Singapura mengubah Undang-Undang Hak Cipta-nya, memperkenalkan klausul pertahanan analisis komputasi, yang secara eksplisit menyatakan bahwa analisis data komputasi yang dilakukan untuk meningkatkan sistem AI dilindungi oleh pengecualian pelanggaran hak cipta, bahkan mencegah cakupan kontrak. Langkah ini bertujuan untuk menjadikan Singapura sebagai lokasi pengembangan model AI paling menarik secara global, menarik investasi dan inovasi, kontras dengan sikap hati-hati di wilayah seperti Eropa dan Amerika terhadap hak cipta AI. Meskipun cakupan perlindungan terbatas pada wilayah Singapura, ini memberikan jaminan penting untuk pengembangan model dasar. (Sumber: Reddit r/ArtificialInteligence)

🌟 KOMUNITAS

Transaksi Pendanaan Industri AI dan Kekhawatiran Gelembung : Kecurigaan muncul di media sosial mengenai transaksi pendanaan di industri AI, dengan banyak yang berpendapat bahwa banyak transaksi terdengar lebih seperti upaya untuk menaikkan harga saham secara artifisial, daripada berdasarkan nilai sebenarnya. Beberapa komentar menunjukkan bahwa banyak produk AI belum menunjukkan efek aplikasi praktis di pasar lokal atau regional, dan perusahaan malah mengeluh bahwa produk AI tidak efektif. Fenomena ini diinterpretasikan sebagai spekulasi pasar daripada pembentukan modal dan efek limpahan yang nyata. Pada saat yang sama, ada juga diskusi tentang aplikasi AI digital twin di bidang pemasaran, apakah itu “hype atau masa depan”. (Sumber: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Kontroversi Sensor Konten ChatGPT dan Pengalaman Pengguna : Pengguna ChatGPT mengeluh bahwa sensor konten platform terlalu ketat, bahkan menandai permintaan resep sederhana atau pelukan antar karakter sebagai “konten sugestif seksual”, sementara tidak sensitif terhadap konten kekerasan. Pengguna berpendapat bahwa ChatGPT menjadi “sampah” dan “terlalu protektif”, mempertanyakan apakah OpenAI telah kehilangan karyawan terbaiknya. Pada saat yang sama, pengguna juga melaporkan masalah dengan rendering LaTeX di ChatGPT App. Hal ini menyebabkan beberapa pengguna membatalkan langganan, menyerukan OpenAI untuk berhenti membunuh kreativitas. (Sumber: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, jeremyphoward)

Dampak Negatif Konten AI dan Kekhawatiran Kreator : Seiring dengan semakin populernya konten yang dihasilkan AI, sentimen anti-AI yang kuat muncul di masyarakat, terutama di bidang seni dan kreatif. Kreator terkenal seperti YouTuber MrBeast menyatakan kekhawatiran bahwa video AI dapat mengancam mata pencarian jutaan kreator. Penggemar Taylor Swift juga mengkritik video promosi yang dihasilkan AI sebagai “murah dan kasar”. Dampak negatif ini mencerminkan kecemasan kreator terhadap dampak teknologi AI pada industri tradisional, serta perhatian terhadap kualitas dan keaslian konten. (Sumber: Reddit r/artificial, MIT Technology Review)

Dilema dan Prospek Aplikasi AI di Industri Game : Komunitas membahas karakteristik teknologi AI yang kuat, kreatif, menarik, dan dinamis, namun mempertanyakan mengapa hingga kini belum ada game populer yang secara luas menggunakan AI. Beberapa berpendapat bahwa AI telah banyak digunakan dalam pengembangan, tetapi menjalankan model AI secara lokal mahal, dan pengembang game cenderung mengontrol narasi. Ada juga pandangan bahwa pengembang hanya fokus pada game besar tradisional, mengabaikan ide-ide baru. Ini mencerminkan tantangan teknis, biaya, dan kreatif yang dihadapi AI dalam implementasinya di industri game. (Sumber: Reddit r/artificial)

Perplexity Menonjolkan Kegunaan Pencarian AI Berkat Kasus Penggunaan Cristiano Ronaldo : Bintang sepak bola Cristiano Ronaldo menggunakan alat pencarian AI Perplexity saat mempersiapkan pidato Prestige Globe Award-nya. Ia menyatakan bahwa Perplexity membantunya memahami makna penghargaan dan mengatasi kegugupan. Insiden ini disebarluaskan secara luas oleh Perplexity secara resmi dan di media sosial, menyoroti nilai praktis pencarian AI dalam menyediakan informasi yang cepat dan akurat, serta potensi promosinya di bawah efek selebriti. (Sumber: AravSrinivas, AravSrinivas)

Penelitian AI Google Raih Hadiah Nobel dan Kontroversi Terkait : Google telah memenangkan tiga Hadiah Nobel dalam dua tahun, termasuk Demis Hassabis (AlphaFold) dan Geoff Hinton (AI). Pencapaian ini dianggap sebagai cerminan investasi penelitian jangka panjang dan ambisi Google. Namun, Jürgen Schmidhuber mempertanyakan adanya masalah plagiarisme dalam Hadiah Nobel Fisika 2024, berpendapat bahwa hasilnya sangat tumpang tindih dengan penelitian sebelumnya dan tidak dikutip dengan benar, memicu diskusi tentang etika akademik dan atribusi di bidang AI. (Sumber: Yuchenj_UW, SchmidhuberAI, SchmidhuberAI)

Debat Filosofis tentang Kebutuhan Komputasi AI dan Jalur Menuju AGI/ASI : Mengenai sumber daya komputasi besar yang dibutuhkan untuk pembuatan video AI, ada pandangan bahwa investasi komputasi besar berdasarkan kebutuhan nyata ini justru menunjukkan bahwa Artificial General Intelligence (AGI) dan Artificial Superintelligence (ASI) masih merupakan fantasi yang jauh. Diskusi ini mencerminkan pemikiran industri tentang jalur pengembangan AI, yaitu apakah keberhasilan AI saat ini dalam aplikasi tertentu akan mengalihkan sumber daya dan menunda pencapaian tujuan yang lebih besar. Pada saat yang sama, Richard Sutton menekankan bahwa esensi pembelajaran adalah perilaku aktif agent, bukan pelatihan pasif. (Sumber: fabianstelzer, Plinz, dwarkesh_sp)

Dampak AI pada Pasar Tenaga Kerja: Gaji Per Jam Penanda Data Bergelar Doktor Menurun : Diskusi di media sosial menunjukkan bahwa karena kelebihan pasokan penanda data bergelar doktor, gaji per jam mereka telah turun dari $100/jam menjadi $50/jam. Sebelumnya, OpenAI pernah mempekerjakan doktor untuk penandaan data dengan gaji $100/jam. Fenomena ini mencerminkan intensifikasi persaingan di pasar penandaan data AI, serta perubahan dalam permintaan akan talenta penandaan data berkualitas tinggi. (Sumber: teortaxesTex)

Alat Insinyur Perangkat Lunak Berbantuan AI Raih Pendanaan dan Dampaknya pada Profesi : Startup Relace, yang berfokus pada penyediaan alat bagi insinyur perangkat lunak yang didorong AI, telah menerima pendanaan Seri A sebesar $23 juta yang dipimpin oleh Andreessen Horowitz. Ini menandai bahwa rantai alat AI sedang meluas ke bidang pengembangan otonom AI yang lebih dalam. Pada saat yang sama, para insinyur membahas bagaimana alat pengkodean AI mengubah cara kerja mereka, berpendapat bahwa meskipun mahir menggunakan alat AI, kreativitas manusia dan kemampuan pemecahan masalah tetap menjadi nilai inti. (Sumber: steph_palazzolo, kylebrussell)

Kebangkitan dan Kejatuhan Fenomena Budaya Vibe Coding : Media sosial membahas kebangkitan dan kejatuhan konsep “Vibe Coding”. Beberapa berpendapat bahwa Vibe Coding adalah cara pemrograman dalam suasana santai, tetapi ada juga pandangan bahwa itu telah “mati”. Diskusi terkait juga menyebutkan konten yang dihasilkan AI seperti “Bob Ross vibe coding”, mencerminkan eksplorasi dan refleksi komunitas pengembang terhadap budaya pemrograman dan metode pemrograman berbantuan AI. (Sumber: arohan, Ronald_vanLoon, nptacek)

💡 LAIN-LAIN

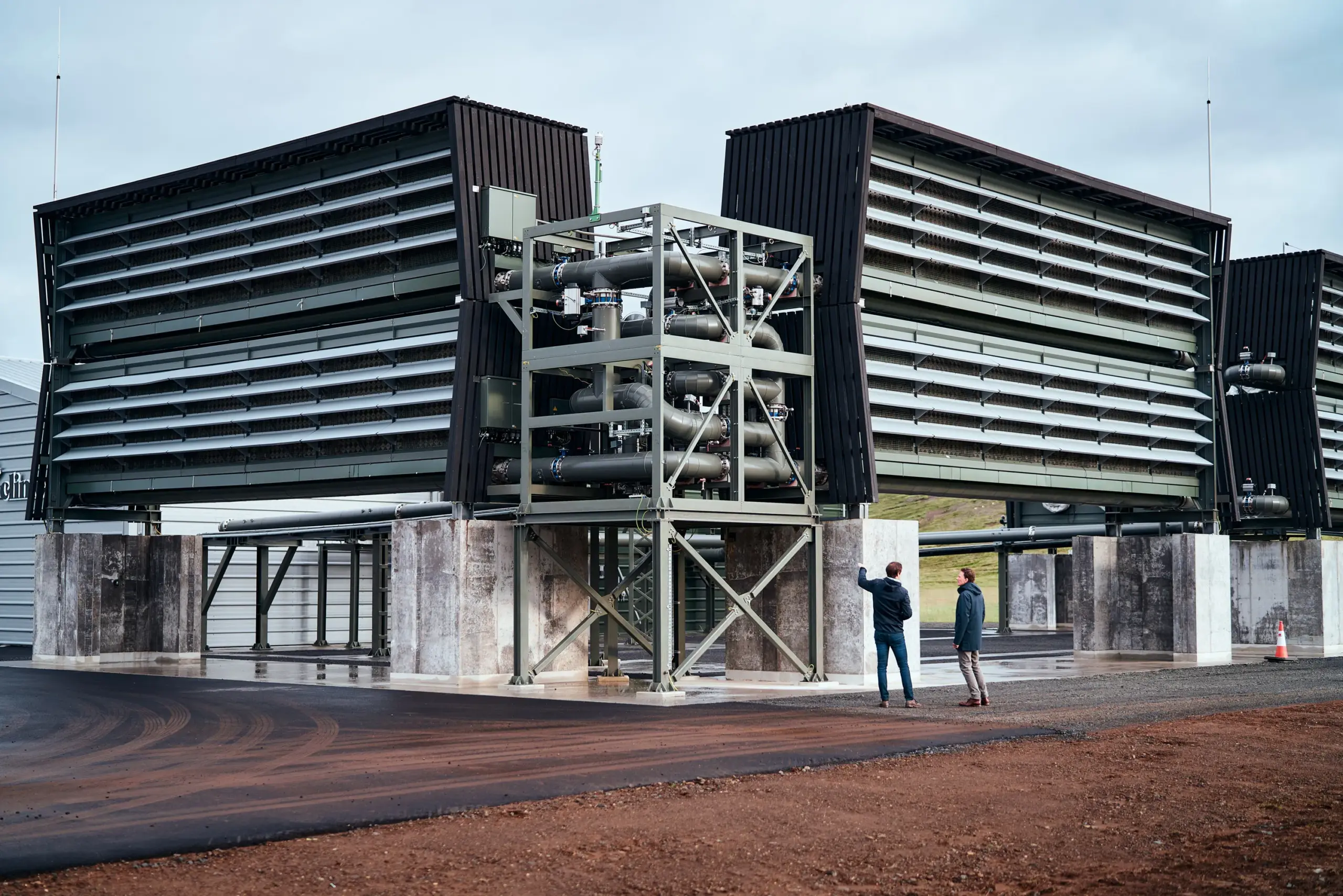

Pemerintah AS Mungkin Batalkan Pendanaan Miliaran Dolar untuk Pabrik Penangkapan Karbon : Departemen Energi AS mungkin akan menghentikan pendanaan miliaran dolar untuk dua pabrik penangkapan karbon udara langsung berskala besar. Proyek-proyek ini awalnya direncanakan untuk menerima lebih dari $1 miliar dana pemerintah, tetapi saat ini menghadapi status “penghentian”. Meskipun Departemen Energi menyatakan belum membuat keputusan akhir, dan sebelumnya telah menghentikan lebih dari 200 proyek untuk menghemat $7,5 miliar, ketidakpastian ini menimbulkan kekhawatiran di industri tentang pengembangan teknologi iklim AS dan daya saing internasional. (Sumber: MIT Technology Review)

Kemajuan Baru dalam Teknologi Robotika: Dari Pergelangan Tangan Fleksibel hingga Kumbang Bionik dan Robot Humanoid : Beberapa kemajuan telah dicapai di bidang teknologi robotika. Pergelangan tangan robot paralel baru telah mencapai gerakan fleksibel, mirip manusia di ruang sempit, meningkatkan akurasi operasi. Pada saat yang sama, peneliti sedang mengembangkan kumbang robot bionik yang membawa ransel, yang bertujuan untuk digunakan dalam pencarian dan penyelamatan bencana. Selain itu, ada laporan yang menunjukkan interaksi robot humanoid dengan sepeda motor, mencerminkan kemampuan teknologi bionik dalam mensimulasikan perilaku manusia. Kemajuan ini secara kolektif mendorong batas-batas teknologi robotika dalam adaptasi lingkungan kompleks dan interaksi manusia-robot. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)