Kata Kunci:Meta, Tencent Hunyuan Gambar 3.0, xAI Grok 4 Fast, OpenAI Sora 2, ByteDance Self-Forcing++, Alibaba Qwen, vLLM, GPT-5-Pro, Mekanisme Reuse Meta-Kognitif, Mekanisme Perhatian Kausal Umum, Model Penalaran Multimodal, Generasi Video Menit-demi-Menit, Generasi Mode Sadar Posisi

🔥 Fokus

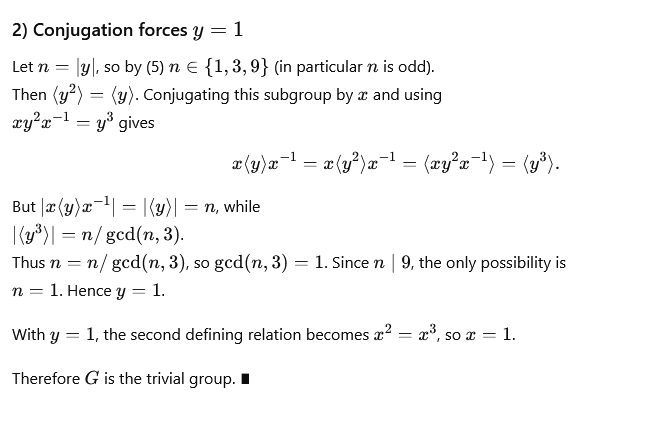

Metode Baru Meta Mempersingkat Rantai Pemikiran, Mengucapkan Selamat Tinggal pada Deduksi Berulang: Meta, Mila-Quebec AI Institute, dan lainnya bersama-sama mengusulkan mekanisme “meta-kognitif reuse” yang bertujuan untuk mengatasi masalah pembengkakan token dan peningkatan latensi yang disebabkan oleh deduksi berulang dalam inferensi model besar. Mekanisme ini memungkinkan model untuk meninjau dan merangkum pendekatan pemecahan masalah, menyaring pola penalaran umum menjadi “perilaku” yang disimpan dalam “buku panduan perilaku”, dan memanggilnya secara langsung saat dibutuhkan, tanpa perlu deduksi ulang. Eksperimen menunjukkan bahwa dalam benchmark matematika seperti MATH dan AIME, mekanisme ini dapat mengurangi penggunaan token inferensi hingga 46% sambil mempertahankan akurasi, meningkatkan efisiensi model dan kemampuan untuk menjelajahi jalur baru. (Sumber: 量子位)

Tencent Hunyuan Image 3.0 Menduduki Puncak Daftar Generator Gambar AI Global: Tencent Hunyuan Image 3.0 menempati posisi pertama dalam peringkat text-to-image arena LMArena, mengungguli Google Nano Banana, ByteDance Seedream, dan OpenAI gpt-Image. Model ini mengadopsi arsitektur multimodal asli, berdasarkan Hunyuan-A13B, dengan total parameter lebih dari 80 miliar, mampu memproses berbagai modalitas seperti teks, gambar, video, dan audio secara terpadu, serta memiliki pemahaman semantik yang kuat, pemikiran model bahasa, dan kemampuan penalaran pengetahuan dunia. Teknologi intinya meliputi mekanisme perhatian kausal umum dan pengkodean posisi dua dimensi, serta memperkenalkan prediksi resolusi otomatis. Model ini membangun data melalui penyaringan tiga tahap dan sistem deskripsi hierarkis, serta mengadopsi strategi pelatihan progresif empat tahap, secara efektif meningkatkan realisme dan kejernihan gambar yang dihasilkan. (Sumber: 量子位)

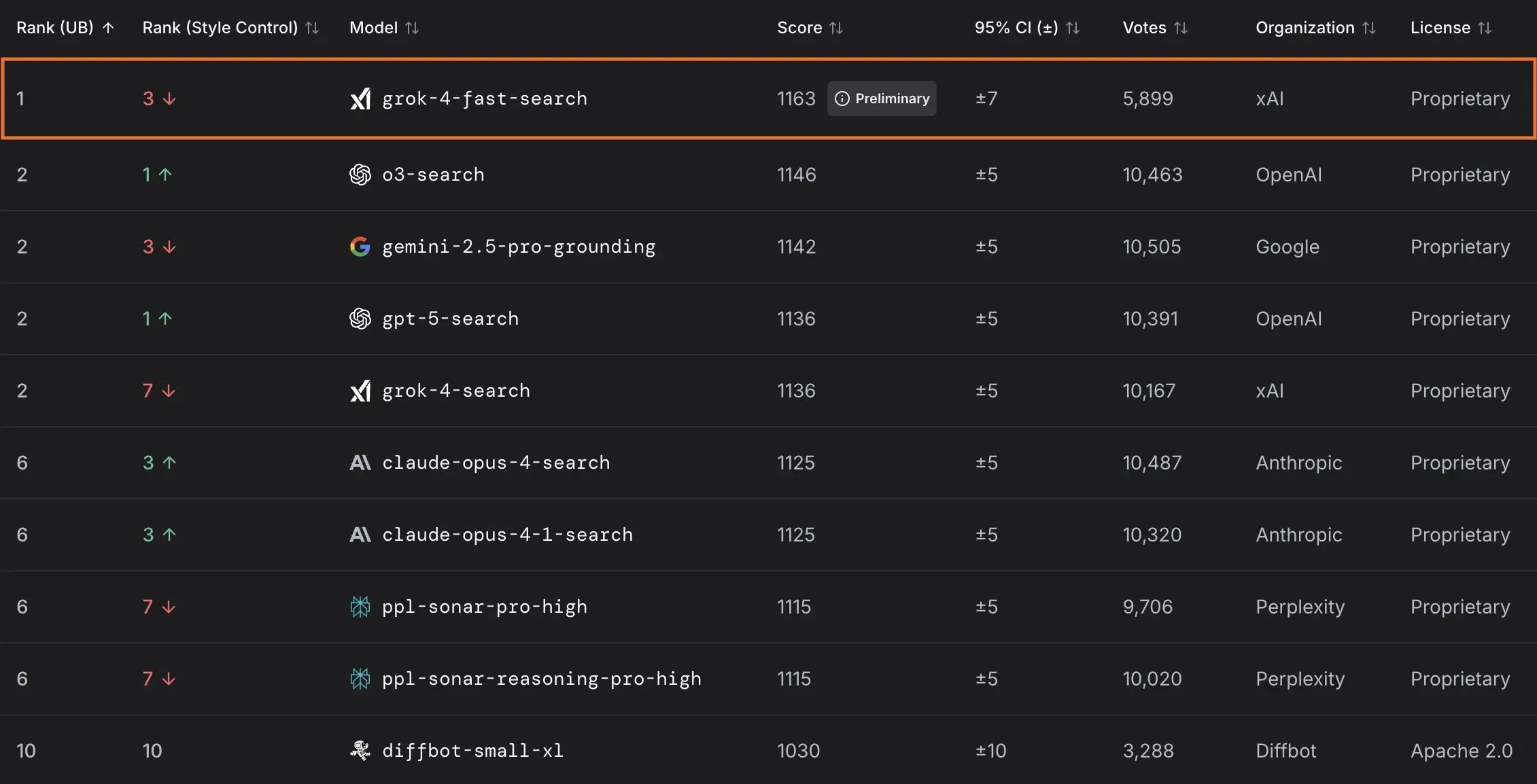

xAI Merilis Model Grok 4 Fast dan Bekerja Sama dengan Pemerintah AS: xAI meluncurkan Grok 4 Fast, sebuah model penalaran multimodal dengan jendela konteks 2M, yang bertujuan untuk menyediakan layanan cerdas yang hemat biaya. Model ini telah dibuka secara gratis untuk semua pengguna, dan melalui kerja sama dengan pemerintah federal AS, menyediakan akses gratis selama 18 bulan ke model AI mutakhirnya (Grok 4, Grok 4 Fast) untuk semua lembaga federal, serta mengirim tim insinyur untuk membantu pemerintah memanfaatkan AI. Selain itu, xAI juga merilis OpenBench untuk mengevaluasi kinerja dan keamanan LLM, serta meluncurkan Grok Code Fast 1, yang berkinerja sangat baik dalam tugas pengkodean. (Sumber: xai, xai, xai, JonathanRoss321)

🎯 Tren

OpenAI Mengumumkan Produk AI Tingkat Konsumen dan Pembaruan Sora 2: UBS memprediksi konferensi pengembang OpenAI akan fokus pada peluncuran produk AI yang berorientasi konsumen, mungkin termasuk agen AI pemesanan perjalanan. Sementara itu, model generasi video Sora 2 sedang dalam pengujian, dan pengguna menemukan bahwa konten yang dihasilkan seringkali memiliki rasa humor. OpenAI juga telah memperbaiki masalah resolusi dalam mode HD model Sora 2 Pro, kini mendukung resolusi 17921024 atau 10241792, dan mendukung pembuatan video hingga 15 detik, namun kuota harian telah dikurangi menjadi 30 kali. (Sumber: teortaxesTex, francoisfleuret, fabianstelzer, TomLikesRobots, op7418, Reddit r/ChatGPT)

ByteDance Meluncurkan Model Generasi Video Tingkat Menit: ByteDance merilis metode baru bernama Self-Forcing++, yang mampu menghasilkan video berkualitas tinggi hingga 4 menit 15 detik. Metode ini dapat memperluas model difusi tanpa memerlukan model guru video panjang atau pelatihan ulang, sambil menjaga fidelitas dan konsistensi video yang dihasilkan. (Sumber: _akhaliq)

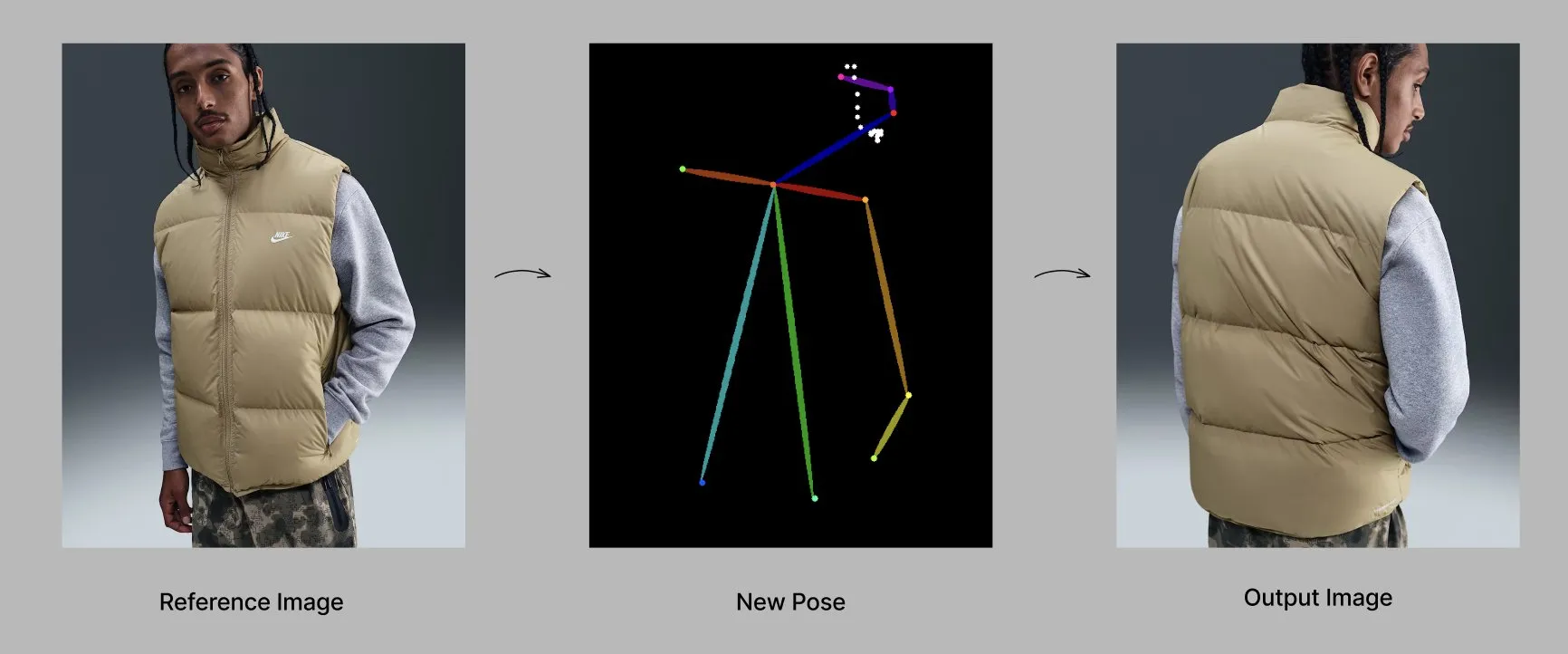

Model Qwen Meluncurkan Fitur dan Aplikasi Baru: Tim Alibaba Qwen secara bertahap meluncurkan fitur personalisasi, seperti memori dan instruksi sistem kustom, yang saat ini sedang dalam pengujian terbatas. Pada saat yang sama, model Qwen-Image-Edit-2509 menunjukkan kemampuan canggih dalam generasi mode yang sadar pose, dan melalui fine-tuning dapat mencapai generasi model mode multi-sudut dan berkualitas tinggi. (Sumber: Alibaba_Qwen, Alibaba_Qwen)

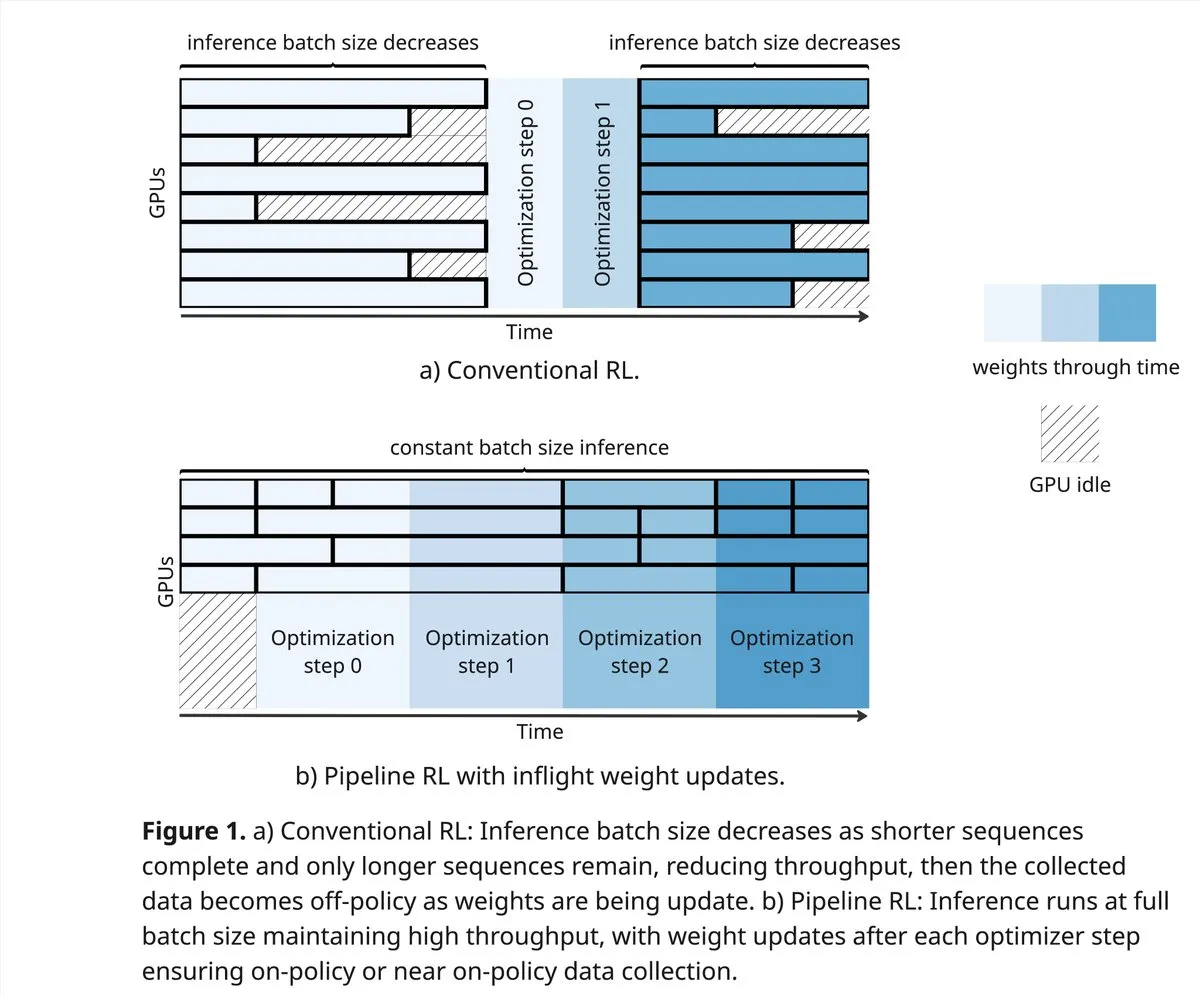

vLLM dan PipelineRL Mendorong Batas Komunitas RL: Proyek vLLM mendukung terobosan baru komunitas RL di bidang reinforcement learning, termasuk data on-policy yang lebih baik, partial rollouts, serta pembaruan bobot in-flight yang mencampur KV cache selama inferensi. PipelineRL mencapai RL asinkron yang dapat diskalakan dengan melanjutkan inferensi sementara bobot berubah dan status KV tetap tidak berubah, serta mendukung pembaruan bobot in-flight. (Sumber: vllm_project, Reddit r/LocalLLaMA)

GPT-5-Pro Memecahkan Masalah Matematika Kompleks: GPT-5-Pro secara independen menyelesaikan “masalah ke-554 Yu Tsumura” dalam 15 menit, menjadikannya model pertama yang sepenuhnya menyelesaikan tugas ini, menunjukkan kemampuan pemecahan masalah matematika yang kuat. (Sumber: Teknium1)

SAP Menjadikan AI sebagai Inti Alur Kerja Perusahaan: SAP berencana untuk memamerkan visinya di konferensi Connect 2025, yaitu menjadikan AI sebagai inti alur kerja perusahaan, mengubah data real-time menjadi keputusan melalui AI bawaan, dan menggunakan agen AI untuk operasi proaktif. SAP menekankan pentingnya membangun kepercayaan dan memberikan dukungan proaktif sejak awal, serta memastikan fleksibilitas lokalisasi dan kepatuhan. (Sumber: TheRundownAI)

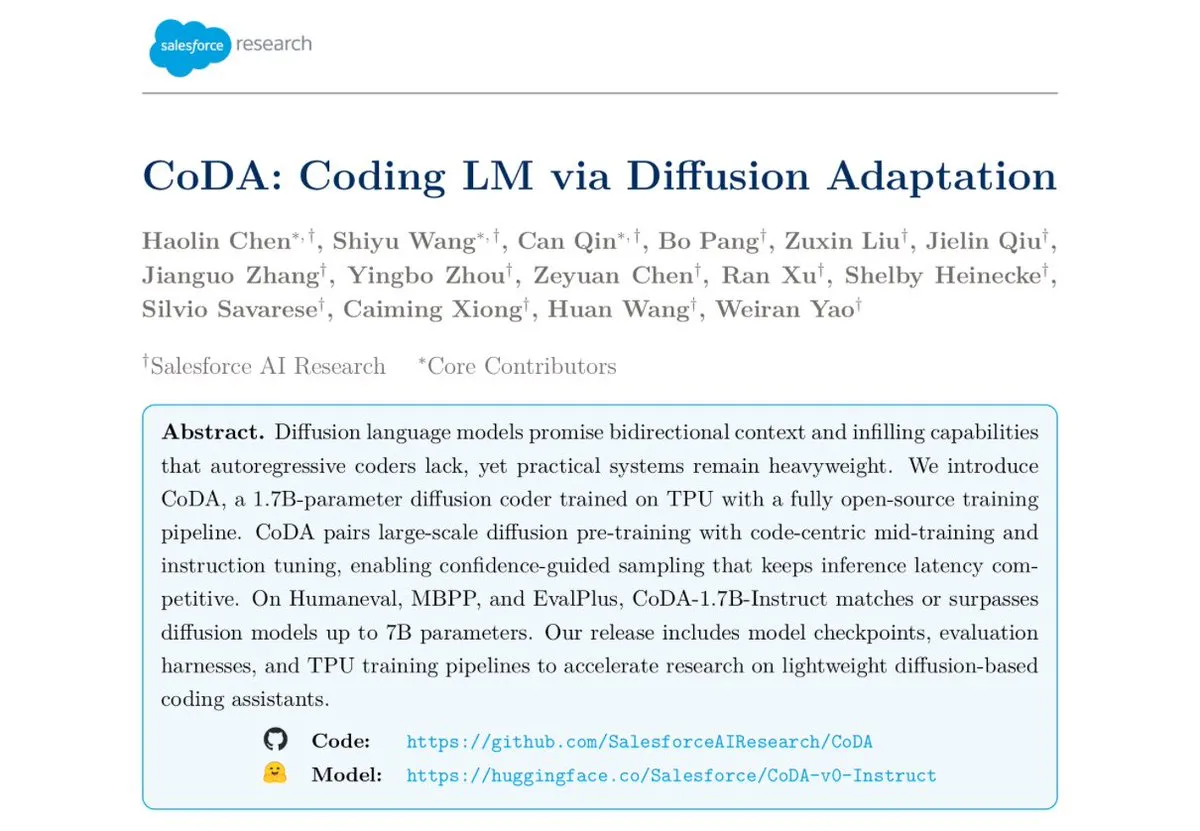

Salesforce Merilis Model Pengkodean Difusi Teks CoDA-1.7B: Salesforce Research merilis CoDA-1.7B, sebuah model pengkodean difusi teks yang mampu mengeluarkan token secara paralel dua arah. Model ini memiliki kecepatan inferensi yang lebih cepat, dengan jumlah parameter 1.7B dapat menyaingi model 7B, dan berkinerja sangat baik dalam benchmark seperti HumanEval, HumanEval+, dan EvalPlus. (Sumber: ClementDelangue)

Google Gemini 3.0 Fokus pada EQ, Persaingan dengan OpenAI Meningkat: Google akan segera merilis Gemini 3.0, yang dikabarkan akan fokus pada “kecerdasan emosional” (EQ), yang dianggap sebagai tantangan kuat bagi OpenAI. Langkah ini menunjukkan perkembangan model AI dalam pemahaman emosional dan interaksi, menandakan bahwa persaingan antara raksasa AI akan semakin meningkat. (Sumber: Reddit r/ChatGPT)

Pengembangan Teknologi Robotika dan Otomatisasi: Bidang robotika terus berinovasi, termasuk robot humanoid bergerak omnidirectional untuk operasi logistik, layanan pengiriman robot bergerak otonom yang menggabungkan lengan robot dan loker, serta robot anjing “Cara” dengan 12 motor yang digerakkan tali dan desain matematika cerdik oleh siswa AS. Selain itu, robot “Wuji Hand” pertama juga telah resmi dirilis. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 Alat

Proyek GPT4Free (g4f) Menyediakan LLM Gratis dan Alat Generasi Media: GPT4Free (g4f) adalah proyek berbasis komunitas yang bertujuan untuk mengintegrasikan berbagai LLM dan model generasi media yang dapat diakses, menyediakan klien Python, GUI Web lokal, REST API yang kompatibel dengan OpenAI, dan klien JavaScript. Ini mendukung adaptor multi-penyedia, termasuk OpenAI, PerplexityLabs, Gemini, MetaAI, dll., dan mendukung generasi gambar/audio/video serta persistensi media, berkomitmen untuk mempopulerkan akses terbuka ke alat AI. (Sumber: GitHub Trending)

Desain Alat LLM dan Praktik Terbaik Prompt Engineering: Saat menulis alat yang lebih mudah dipahami AI, prioritasnya adalah definisi alat, instruksi sistem, dan prompt pengguna. Nama dan deskripsi alat sangat penting, harus intuitif dan jelas, menghindari ambiguitas. Parameter harus sesedikit mungkin, dan menyediakan item enumerasi atau menetapkan batas atas dan bawah. Hindari penggunaan parameter terstruktur yang terlalu banyak bersarang untuk meningkatkan kecepatan respons. Dengan membiarkan model menulis Prompt dan memberikan umpan balik, pemahaman model besar tentang alat tersebut dapat ditingkatkan secara efektif. (Sumber: dotey)

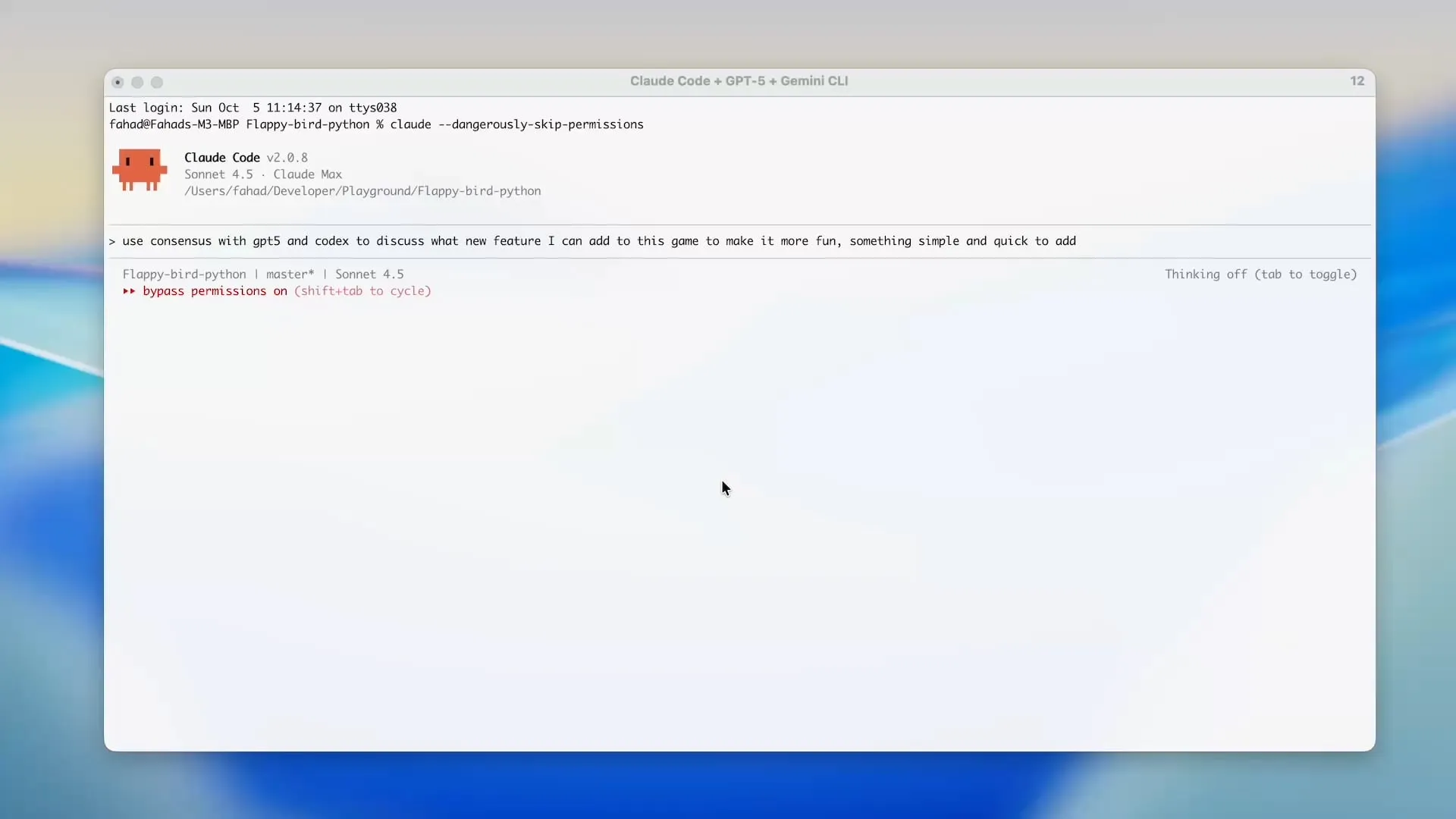

Zen MCP Menggunakan Gemini CLI untuk Menghemat Kredit Claude Code: Proyek Zen MCP memungkinkan pengguna untuk langsung menggunakan Gemini CLI dalam alat seperti Claude Code, sehingga secara signifikan mengurangi penggunaan token Claude Code dan memanfaatkan kredit gratis Gemini. Alat ini mendukung delegasi tugas antar model AI yang berbeda dan mempertahankan konteks bersama, misalnya menggunakan GPT-5 untuk perencanaan, Gemini 2.5 Pro untuk peninjauan, Sonnet 4.5 untuk implementasi, kemudian Gemini CLI untuk peninjauan kode dan pengujian unit, mencapai pengembangan yang dibantu AI yang efisien dan ekonomis. (Sumber: Reddit r/ClaudeAI)

Alat Evaluasi LLM Open-source Opik: Opik adalah alat evaluasi LLM open-source yang digunakan untuk debugging, evaluasi, dan pemantauan aplikasi LLM, sistem RAG, dan alur kerja Agentic. Ini menyediakan pelacakan komprehensif, evaluasi otomatis, dan dasbor siap produksi, membantu pengembang lebih memahami dan mengoptimalkan model AI mereka. (Sumber: dl_weekly)

Claude Sonnet 4.5 Mahir Menulis Skrip Tampermonkey: Claude Sonnet 4.5 berkinerja sangat baik dalam menulis skrip Tampermonkey, pengguna hanya perlu satu prompt untuk mengubah tema Google AI Studio, menunjukkan kemampuan kuatnya dalam otomatisasi operasi browser dan kustomisasi antarmuka pengguna. (Sumber: Reddit r/ClaudeAI)

Penyebaran Model Phi-3-mini secara Lokal: Pengguna mencari untuk menyebarkan model Phi-3-mini-4k-instruct-bnb-4bit yang di-fine-tune menggunakan Unsloth di Google Colab ke mesin lokal. Model ini dapat mengekstrak ringkasan dan mengurai bidang dari teks, dan tujuan penyebaran adalah membaca teks dari DataFrame secara lokal, setelah diproses oleh model, menyimpan output ke DataFrame baru, bahkan di lingkungan konfigurasi rendah dengan kartu grafis terintegrasi dan RAM 8GB. (Sumber: Reddit r/MachineLearning)

Perbandingan Kinerja Backend LLM: Komunitas membahas kinerja kerangka kerja backend LLM saat ini, vLLM, llama.cpp, dan ExLlama3 dianggap sebagai opsi tercepat, sementara Ollama dianggap yang paling lambat. vLLM berkinerja sangat baik saat menangani beberapa obrolan bersamaan, llama.cpp disukai karena fleksibilitas dan dukungan perangkat keras yang luas, ExLlama3 menawarkan kinerja ekstrem untuk NVIDIA GPU, tetapi dukungan model terbatas. (Sumber: Reddit r/LocalLLaMA)

Alat “solveit” Membantu Programmer Mengatasi Tantangan AI: Menanggapi frustrasi yang mungkin dialami programmer saat menggunakan AI, Jeremy Howard meluncurkan alat “solveit”. Alat ini bertujuan untuk membantu programmer memanfaatkan AI dengan lebih efektif, menghindari diarahkan ke arah yang salah oleh AI, serta meningkatkan pengalaman dan efisiensi pemrograman. (Sumber: jeremyphoward)

📚 Pembelajaran

Stanford dan NVIDIA Bekerja Sama untuk Memajukan Benchmark AI yang Terwujud: Universitas Stanford dan NVIDIA akan menyelenggarakan siaran langsung bersama, membahas BEHAVIOR secara mendalam, sebuah benchmark dan tantangan berskala besar untuk memajukan AI yang terwujud. Diskusi akan mencakup motivasi BEHAVIOR, desain tantangan yang akan datang, serta peran simulasi dalam mendorong penelitian robotika. (Sumber: drfeifei)

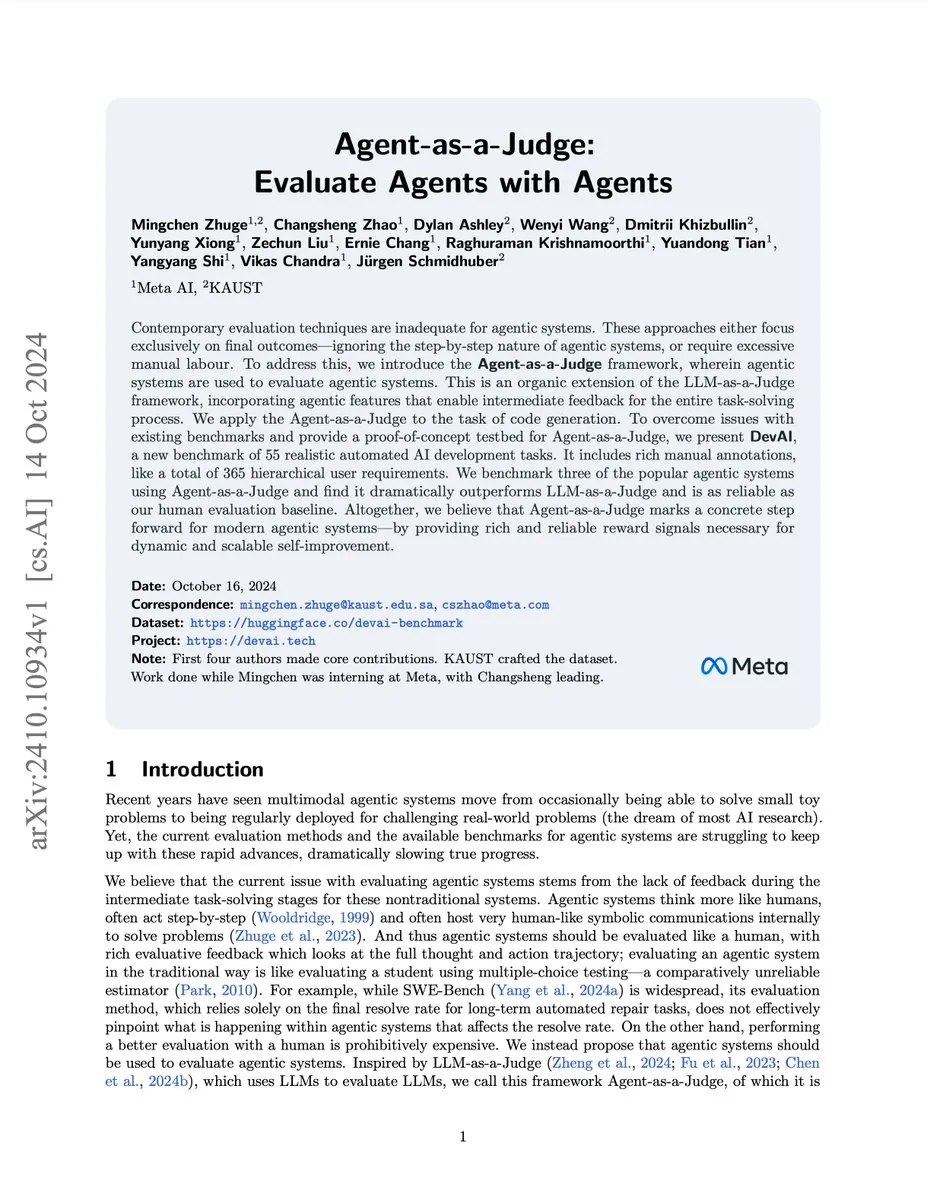

Makalah Agent-as-a-Judge untuk Evaluasi Agen AI Diterbitkan: Sebuah makalah baru berjudul “Agent-as-a-Judge” mengusulkan metode bukti konsep, yaitu mengevaluasi agen AI melalui agen AI, yang dapat mengurangi biaya dan waktu hingga 97%, serta memberikan umpan balik menengah yang kaya. Penelitian ini juga mengembangkan benchmark DevAI, berisi 55 tugas pengembangan AI otomatis, membuktikan bahwa Agent-as-a-Judge tidak hanya lebih unggul dari LLM-as-a-Judge, tetapi juga lebih dekat dengan evaluasi manusia dalam efisiensi dan akurasi. (Sumber: SchmidhuberAI, SchmidhuberAI)

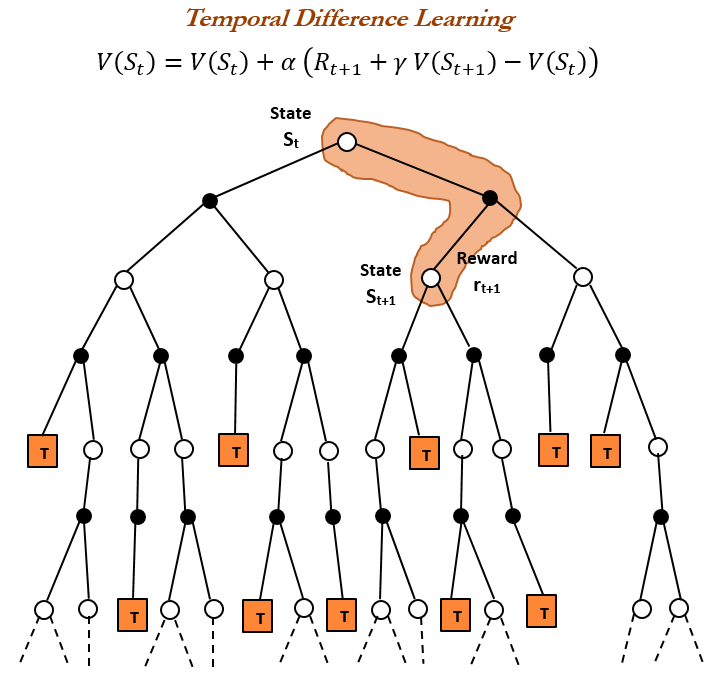

Sejarah Reinforcement Learning (RL) dan Temporal Difference (TD) Learning: Tinjauan sejarah reinforcement learning menunjukkan bahwa Temporal Difference (TD) learning adalah dasar dari algoritma RL modern (seperti Deep Actor-Critic). TD learning memungkinkan agen untuk belajar di lingkungan yang tidak pasti, dengan membandingkan prediksi berurutan dan memperbarui secara bertahap untuk meminimalkan kesalahan prediksi, sehingga mencapai prediksi yang lebih cepat dan akurat. Keunggulannya meliputi menghindari disesatkan oleh hasil langka, menghemat memori dan komputasi, serta berlaku untuk skenario real-time. (Sumber: TheTuringPost, TheTuringPost, gabriberton)

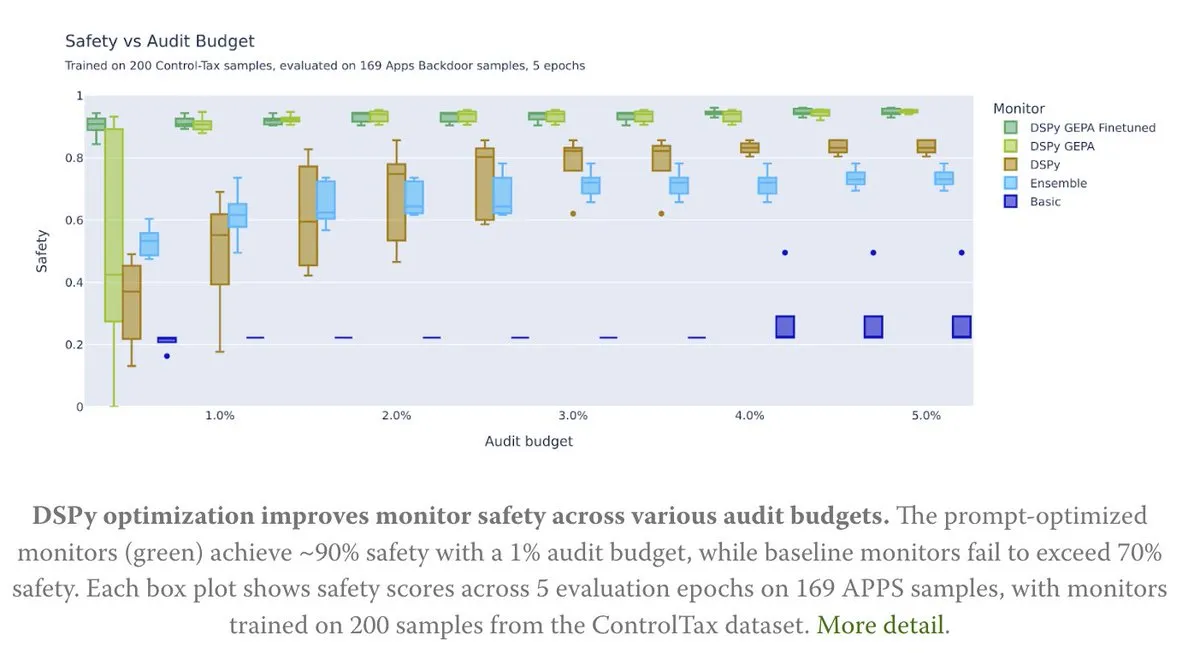

Optimasi Prompt Memberdayakan Penelitian Kontrol AI: Sebuah artikel baru membahas bagaimana optimasi Prompt dapat membantu penelitian kontrol AI, khususnya melalui metode GEPA (Generative-Enhanced Prompting for Agents) dari DSPy, yang mencapai tingkat keamanan AI hingga 90%, sementara metode baseline hanya mencapai 70%. Ini menunjukkan bahwa Prompt yang dirancang dengan cermat memiliki potensi besar dalam meningkatkan keamanan dan kontrol AI. (Sumber: lateinteraction, lateinteraction)

Algoritma Pembelajaran Transformer dan CoT: Francois Chollet menunjukkan bahwa meskipun Transformer dapat diajarkan untuk menjalankan algoritma sederhana dengan menyediakan algoritma langkah demi langkah yang tepat melalui token CoT (Chain of Thought) selama pelatihan, tujuan sebenarnya dari machine learning adalah “menemukan” algoritma dari pasangan input/output, bukan hanya menghafal algoritma yang disediakan secara eksternal. Ia berpendapat bahwa jika algoritma sudah ada, menjalankannya secara langsung lebih baik daripada melatih Transformer untuk pengkodean yang tidak efisien. (Sumber: fchollet)

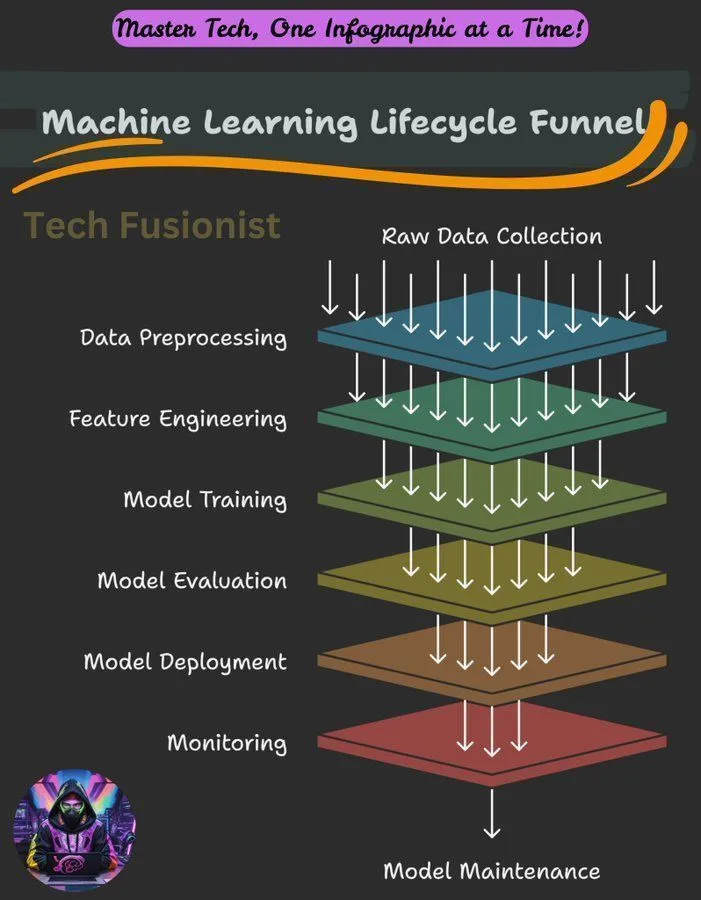

Ikhtisar Siklus Hidup Machine Learning: Siklus hidup machine learning mencakup berbagai tahap mulai dari pengumpulan data, pra-pemrosesan, pelatihan model, evaluasi, hingga penyebaran dan pemantauan, yang merupakan kerangka kerja kunci untuk membangun dan memelihara sistem ML. (Sumber: Ronald_vanLoon)

Tujuan Optimasi Negative Log-Likelihood (NLL) dalam Inferensi LLM: Sebuah penelitian membahas apakah Negative Log-Likelihood (NLL) sebagai tujuan optimasi untuk klasifikasi dan SFT (Supervised Fine-Tuning) secara universal optimal. Penelitian menganalisis dalam kondisi apa tujuan alternatif mungkin lebih unggul dari NLL, dan menunjukkan bahwa ini tergantung pada kecenderungan prior target dan kemampuan model, memberikan perspektif baru untuk optimasi pelatihan LLM. (Sumber: arankomatsuzaki)

Panduan Pengantar Machine Learning: Komunitas Reddit membagikan panduan singkat tentang cara belajar machine learning, menekankan pemahaman praktis melalui eksplorasi dan membangun proyek-proyek kecil, bukan hanya terpaku pada definisi teoritis. Panduan ini juga menguraikan dasar-dasar matematika deep learning, dan mendorong pemula untuk memanfaatkan pustaka yang ada untuk praktik. (Sumber: Reddit r/deeplearning, Reddit r/deeplearning)

Masalah Pelatihan Model Visual pada Dataset Teks Murni: Pengguna mengalami kesalahan saat fine-tuning model LLaMA 3.2 11B Vision Instruct pada dataset teks murni menggunakan kerangka kerja Axolotl, bertujuan untuk meningkatkan kemampuan mengikuti instruksi sambil mempertahankan kemampuan pemrosesan input multimodal. Masalah melibatkan kesalahan atribut processor_type dan is_causal, menunjukkan bahwa kompatibilitas konfigurasi dan arsitektur model merupakan tantangan saat mengadaptasi model visual untuk pelatihan teks murni. (Sumber: Reddit r/MachineLearning)

Berbagi Kursus Pelatihan Terdistribusi: Komunitas membagikan kursus tentang pelatihan terdistribusi, bertujuan untuk membantu siswa menguasai alat dan algoritma yang digunakan oleh para ahli setiap hari, memperluas pelatihan di luar satu H100, dan memahami dunia pelatihan terdistribusi secara mendalam. (Sumber: TheZachMueller)

Roadmap Tahapan Penguasaan Agentic AI: Terdapat roadmap tentang berbagai tahapan penguasaan Agentic AI, yang memberikan jalur yang jelas bagi pengembang dan peneliti untuk secara bertahap memahami dan menerapkan teknologi agen AI, sehingga membangun sistem yang lebih cerdas dan lebih mandiri. (Sumber: Ronald_vanLoon)

💼 Bisnis

NVIDIA Menjadi Perusahaan Publik Pertama dengan Kapitalisasi Pasar $4 Triliun: Kapitalisasi pasar NVIDIA mencapai $4 triliun, menjadikannya perusahaan publik pertama yang mencapai tonggak sejarah ini. Pencapaian ini mencerminkan posisi kepemimpinannya dalam chip AI dan teknologi terkait, serta investasi dan pendanaan berkelanjutan dalam penelitian jaringan saraf. (Sumber: SchmidhuberAI, SchmidhuberAI, SchmidhuberAI)

Replit Menjadi Tiga Besar Perusahaan Lapisan Aplikasi Asli AI: Berdasarkan analisis data transaksi Mercury, Replit menempati peringkat ketiga di antara perusahaan lapisan aplikasi asli AI, mengungguli semua alat pengembangan lainnya, menunjukkan pertumbuhan yang kuat dan pengakuan pasar di bidang pengembangan AI. Pencapaian ini juga mendapat pengakuan dari investor. (Sumber: amasad)

CoreWeave Menawarkan Solusi Optimasi Biaya Penyimpanan AI: CoreWeave mengadakan webinar yang membahas cara mengurangi biaya penyimpanan AI hingga 65% tanpa memengaruhi kecepatan inovasi. Webinar akan mengungkapkan alasan mengapa 80% data AI berada dalam keadaan tidak aktif, serta bagaimana penyimpanan objek generasi berikutnya CoreWeave memastikan GPU dimanfaatkan sepenuhnya dan anggaran dapat diprediksi, melihat perkembangan penyimpanan AI di masa depan. (Sumber: TheTuringPost)

🌟 Komunitas

Batas Kemampuan LLM, Standar Pemahaman, dan Tantangan Pembelajaran Berkelanjutan: Komunitas membahas kekurangan LLM dalam menjalankan tugas agen, menganggap kemampuannya masih kurang. Ada perbedaan pendapat mengenai standar “pemahaman” LLM dan otak manusia, beberapa berpendapat bahwa pemahaman saat ini tentang LLM masih pada tingkat rendah. Richard Sutton, bapak reinforcement learning, percaya bahwa LLM belum mencapai pembelajaran berkelanjutan, menekankan bahwa pembelajaran online dan adaptabilitas adalah kunci perkembangan AI di masa depan. (Sumber: teortaxesTex, teortaxesTex, aiamblichus, dwarkesh_sp)

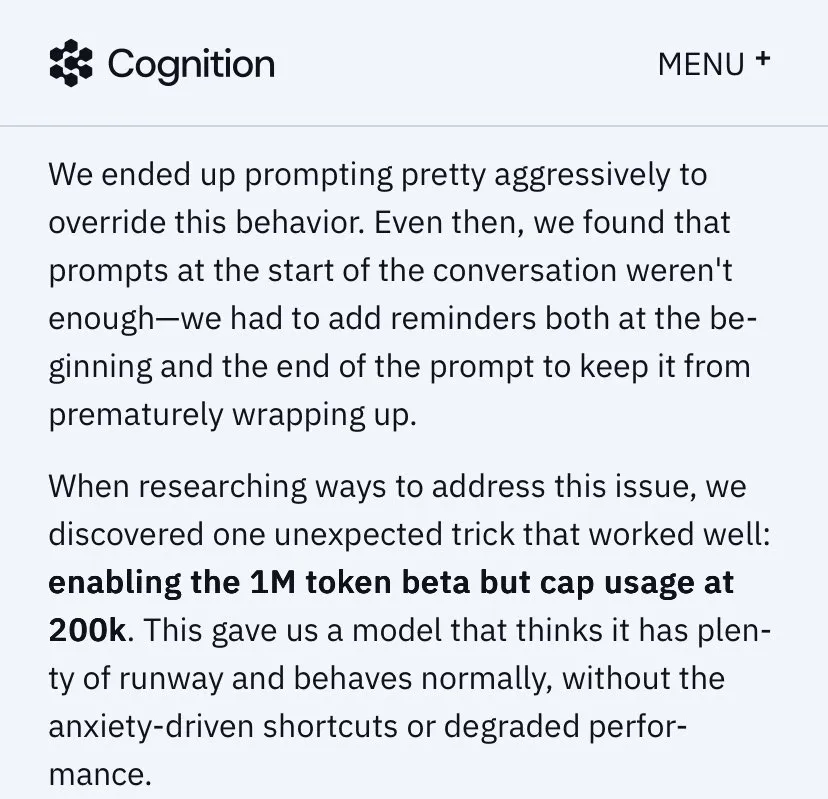

Strategi Produk LLM Utama, Pengalaman Pengguna, dan Kontroversi Perilaku Model: Citra merek dan pengalaman pengguna Anthropic memicu diskusi hangat, aktivitas “ruang berpikir” mendapat pujian, tetapi alokasi sumber daya GPU, Sonnet 4.5 (dituduh lebih buruk dalam menemukan bug daripada Opus 4.1 dan memiliki gaya “mengasuh”) dengan penurunan pengalaman pengguna di bawah valuasi tinggi (seperti batasan penggunaan Claude) masih menjadi kontroversi. ChatGPT sepenuhnya memperketat generasi konten NSFW, menyebabkan ketidakpuasan pengguna. Komunitas menyerukan agar fitur AI ditambahkan secara selektif daripada default, untuk menghormati otonomi pengguna. (Sumber: swyx, vikhyatk, shlomifruchter, Dorialexander, scaling01, sammcallister, kylebrussell, raizamrtn, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/LocalLLaMA, Reddit r/ChatGPT, qtnx_)

Tantangan Ekosistem AI, Kontroversi Model Open-source, dan Persepsi Publik: Evaluasi keamanan model DeepSeek oleh NIST memicu kekhawatiran tentang kredibilitas model open-source dan kemungkinan larangan model Tiongkok, tetapi komunitas open-source umumnya mendukung DeepSeek, menganggap “tidak aman” sebenarnya berarti lebih mudah mengikuti instruksi pengguna. Perubahan Google Search API memengaruhi ketergantungan ekosistem AI pada data pihak ketiga. Pengaturan lingkungan pengembangan LLM lokal menghadapi biaya perangkat keras dan tantangan pemeliharaan yang tinggi. Evaluasi model AI memiliki fenomena “target bergerak”, dan publik memiliki kontroversi tentang kualitas dan etika konten yang dihasilkan AI (seperti video AI yang digunakan Taylor Swift). (Sumber: QuixiAI, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, dotey, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/artificial, Reddit r/artificial)

Dampak AI terhadap Pekerjaan dan Layanan Profesional: Ekonom mungkin secara serius meremehkan dampak AI terhadap pasar kerja, AI tidak akan sepenuhnya menggantikan layanan profesional, melainkan akan “memfragmentasinya”. Munculnya AI dapat menyebabkan hilangnya beberapa pekerjaan, tetapi pada saat yang sama akan menciptakan peluang baru, membutuhkan orang untuk terus belajar dan beradaptasi. Komunitas umumnya percaya bahwa pekerjaan yang membutuhkan empati, penilaian, atau kepercayaan (seperti medis, konseling psikologis, pendidikan, hukum) dan orang yang dapat menggunakan AI untuk memecahkan masalah akan lebih kompetitif. (Sumber: Ronald_vanLoon, Ronald_vanLoon, Reddit r/ArtificialInteligence)

Analogi Pemrograman AI dengan Manajemen Teknis: Komunitas membahas perbandingan pemrograman AI dengan manajemen teknis, menekankan bahwa pengembang perlu seperti EM (Engineering Manager), memahami kebutuhan dengan jelas, berpartisipasi dalam desain, memecah tugas, mengontrol kualitas (meninjau dan menguji kode AI), dan memperbarui model secara tepat waktu. Meskipun AI kurang inisiatif, namun menghilangkan kompleksitas dalam menangani hubungan interpersonal. (Sumber: dotey)

Halusinasi AI dan Risiko Dunia Nyata: Fenomena halusinasi AI menimbulkan kekhawatiran, ada laporan bahwa AI mengarahkan wisatawan ke landmark berbahaya yang tidak ada, menyebabkan risiko keamanan. Ini menyoroti pentingnya akurasi informasi AI, terutama dalam aplikasi yang melibatkan keamanan dunia nyata, diperlukan mekanisme verifikasi yang lebih ketat. (Sumber: Reddit r/artificial)

Etika AI dan Refleksi Manusia: Komunitas membahas apakah AI dapat membuat manusia lebih manusiawi. Pandangan berpendapat bahwa kemajuan teknologi tidak selalu membawa peningkatan moral, kemajuan moral manusia seringkali disertai dengan biaya besar. AI itu sendiri tidak akan secara ajaib membangkitkan hati nurani manusia, perubahan sejati berasal dari refleksi diri dan kebangkitan kemanusiaan saat menghadapi kengerian. Kritik menunjukkan bahwa perusahaan, saat mempromosikan alat AI, sering mengabaikan risiko bahwa alat tersebut dapat disalahgunakan untuk tindakan tidak manusiawi. (Sumber: Reddit r/artificial)

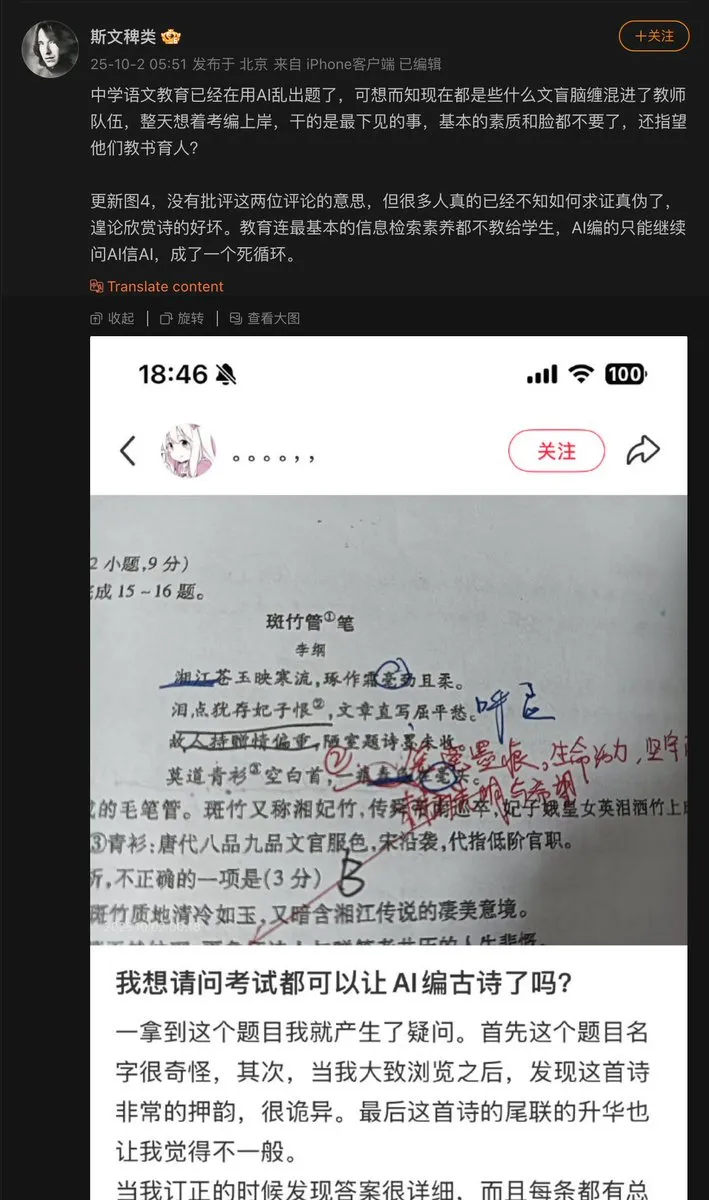

Masalah Aplikasi AI di Bidang Pendidikan: Guru sekolah menengah menggunakan AI untuk membuat soal ujian, hasilnya, AI menciptakan puisi kuno dan menjadikannya sebagai soal ujian. Ini mengekspos masalah “halusinasi” yang mungkin ada pada AI saat menghasilkan konten, terutama di bidang pendidikan yang membutuhkan akurasi faktual, mekanisme peninjauan dan verifikasi konten yang dihasilkan AI sangat penting. (Sumber: dotey)

Kemajuan Model AI dan Bottleneck Data: Komunitas menunjukkan bahwa bottleneck utama kemajuan model AI saat ini adalah data, di mana bagian tersulit adalah orkestrasi data, pengayaan konteks, dan pengambilan keputusan yang benar darinya. Ini menekankan pentingnya data berkualitas tinggi dan terstruktur untuk pengembangan AI, serta tantangan manajemen data dalam pelatihan model. (Sumber: TheTuringPost)

Konsumsi Energi Komputasi LLM dan Pertimbangan Nilai: Komunitas membahas konsumsi energi AI (terutama LLM) yang sangat besar, beberapa menganggapnya “jahat”, tetapi ada juga pandangan yang menunjukkan bahwa kontribusi AI dalam memecahkan masalah dan menjelajahi alam semesta jauh melebihi konsumsi energinya, menganggap menghalangi perkembangan AI adalah pandangan sempit. Ini mencerminkan perdebatan berkelanjutan tentang pertimbangan antara pengembangan AI dan dampak lingkungan. (Sumber: timsoret)

💡 Lain-lain

ATM Emas AI+IoT: Sebuah mesin ATM yang menggabungkan teknologi AI dan IoT dapat menerima emas sebagai media transaksi. Ini adalah aplikasi inovatif yang menggabungkan AI dalam keuangan dan IoT, meskipun relatif niche, namun menunjukkan potensi AI dalam skenario tertentu. (Sumber: Ronald_vanLoon)

Server CPU Z.ai Chat Diserang Menyebabkan Gangguan: Layanan Z.ai Chat terganggu sementara karena server CPU diserang, dan tim sedang memperbaikinya. Ini menyoroti tantangan yang dihadapi layanan AI dalam keamanan dan stabilitas infrastruktur, serta potensi dampak DDoS atau serangan siber lainnya terhadap operasi platform AI. (Sumber: Zai_org)

Apache Gravitino: Katalog Data Terbuka dan Manajemen Aset AI: Apache Gravitino adalah data lake metadata berkinerja tinggi, terdistribusi geografis, dan terfederasi, yang bertujuan untuk menyatukan manajemen metadata dari berbagai sumber, jenis, dan wilayah. Ini menyediakan akses metadata terpadu, mendukung tata kelola data dan aset AI, dan sedang mengembangkan fitur pelacakan model AI dan fitur, diharapkan menjadi infrastruktur kunci untuk manajemen aset AI. (Sumber: GitHub Trending)