Kata Kunci:OpenAI, Infrastruktur AI, Virus hasil AI, AlphaEarth Foundations, RTEB, Claude Sonnet 4.5, DeepSeek V3.2-Exp, AI multimodal, Proyek Stargate OpenAI, Model bahasa genom Transformer, Pemodelan 10 meter Google AlphaEarth, Patokan RTEB Hugging Face, Pembuatan kode Anthropic Claude, AI generatif virus, Yayasan AlphaEarth, RTEB (Real-Time Evaluation Benchmark), Claude Sonnet versi 4.5, DeepSeek model V3.2-Exp, Kecerdasan buatan multimodal, Proyek infrastruktur canggih OpenAI, Model bahasa berbasis genom Transformer, Pemetaan resolusi 10m AlphaEarth, Evaluasi model AI Hugging Face RTEB, Generasi kode AI oleh Anthropic

Sebagai editor kepala senior kolom AI, saya telah melakukan analisis mendalam, meringkas, dan menyaring berita serta diskusi sosial yang Anda berikan. Berikut adalah konten yang telah diintegrasikan:

🔥 FOKUS

Taruhan Infrastruktur Triliunan Dolar OpenAI : OpenAI bekerja sama dengan Oracle dan SoftBank, berencana menginvestasikan triliunan dolar secara global untuk membangun infrastruktur komputasi dengan kode nama “Stargate”. Awalnya, diumumkan penambahan 5 lokasi baru di Amerika Serikat dengan biaya $400 miliar, serta proyek “Stargate UK” di Inggris bekerja sama dengan Nvidia. OpenAI memprediksi kebutuhan listrik AI di masa depan akan mencapai 100 gigawatt, dengan total investasi yang mungkin mencapai $5 triliun. Langkah ini bertujuan untuk memenuhi permintaan komputasi AI yang sangat besar, tetapi juga menimbulkan kekhawatiran tentang investasi dana, konsumsi energi, dan potensi risiko keuangan, menyoroti ketergantungan ekstrem pengembangan AI pada infrastruktur. (Sumber: DeepLearning.AI Blog)

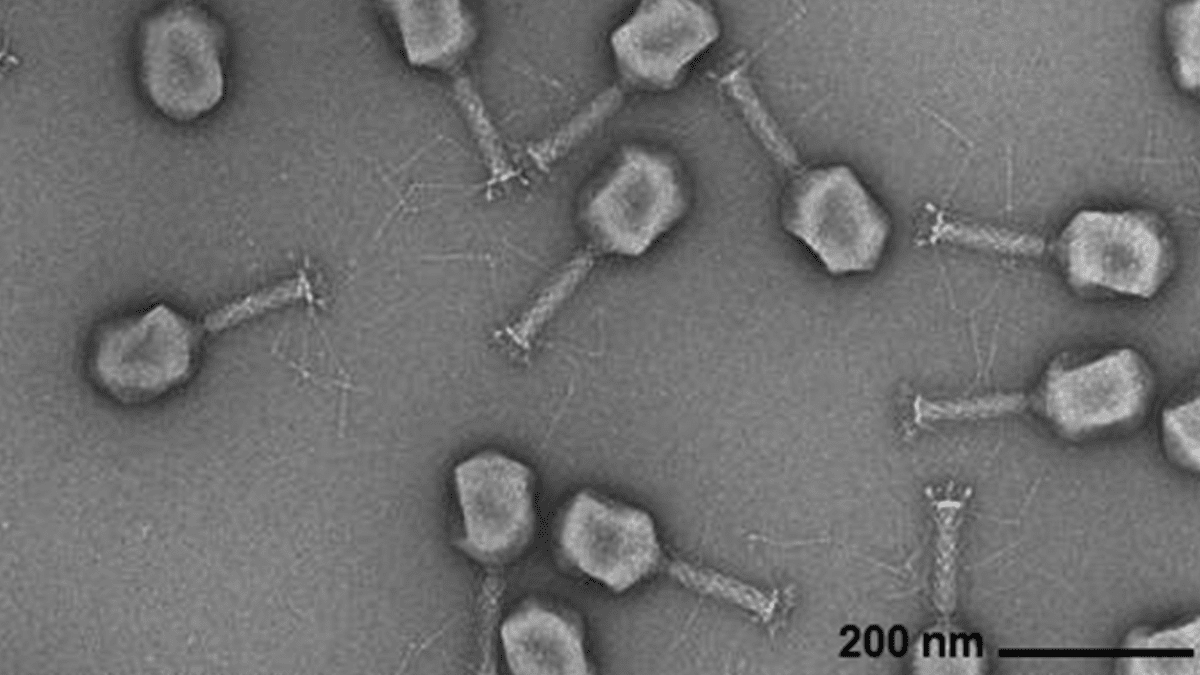

AI Menghasilkan Genom Virus : Para peneliti dari Arc Institute, Stanford University, dan Memorial Sloan Kettering Cancer Center berhasil mensintesis virus bakteriofag baru dari awal yang mampu melawan infeksi bakteri umum, menggunakan model bahasa genom berbasis Transformer. Teknologi ini, melalui penyesuaian urutan genom virus, mampu menghasilkan genom baru dengan fungsi spesifik yang berbeda dari virus alami. Terobosan ini membuka jalan baru untuk mengembangkan terapi alternatif antibiotik, tetapi juga menimbulkan kekhawatiran tentang biosekuriti dan penyalahgunaan, menekankan perlunya penelitian respons terhadap ancaman biologis. (Sumber: DeepLearning.AI Blog)

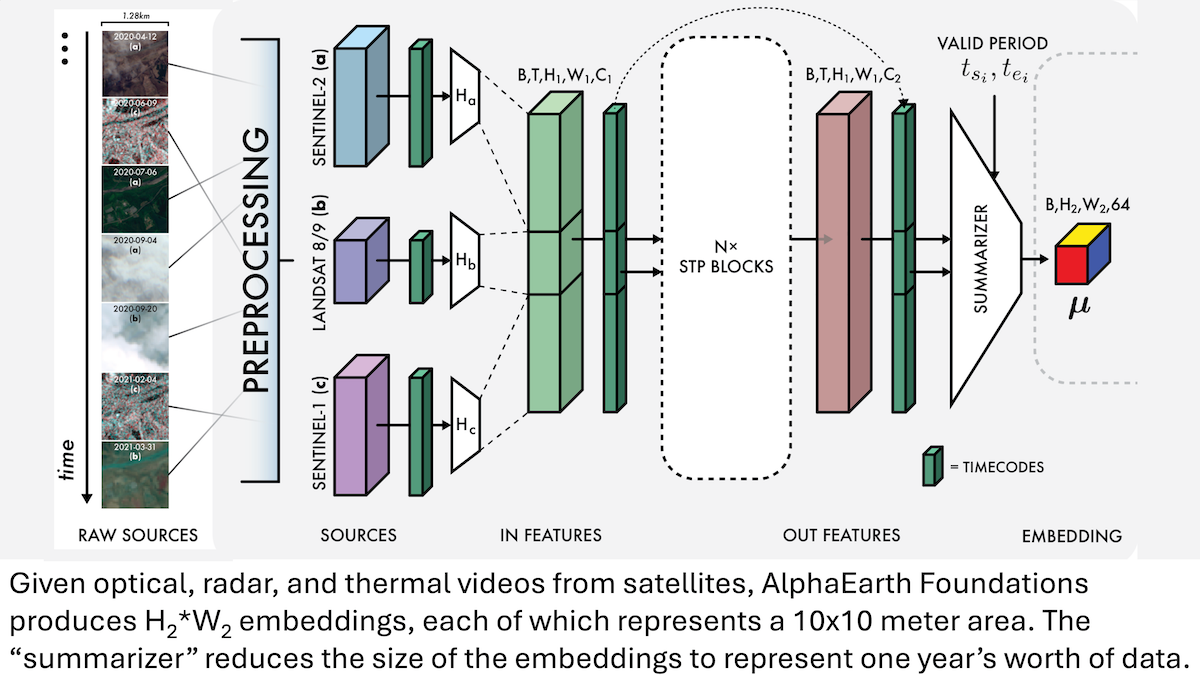

Google AlphaEarth Foundations: Pemodelan Bumi Presisi Tinggi Skala 10 Meter : Para peneliti Google meluncurkan model AlphaEarth Foundations (AEF) yang mampu mengintegrasikan citra satelit dan data sensor lainnya untuk memodelkan permukaan bumi secara detail dalam kotak 10 meter persegi, serta menghasilkan embedding yang merepresentasikan karakteristik bumi setiap tahun dari 2017 hingga 2024. Embedding ini dapat digunakan untuk melacak berbagai karakteristik planet seperti kelembaban, curah hujan, vegetasi, serta tantangan global seperti produksi pangan, risiko kebakaran hutan, dan ketinggian air waduk, menyediakan alat presisi tinggi yang belum pernah ada sebelumnya untuk pemantauan lingkungan dan penelitian perubahan iklim. (Sumber: DeepLearning.AI Blog)

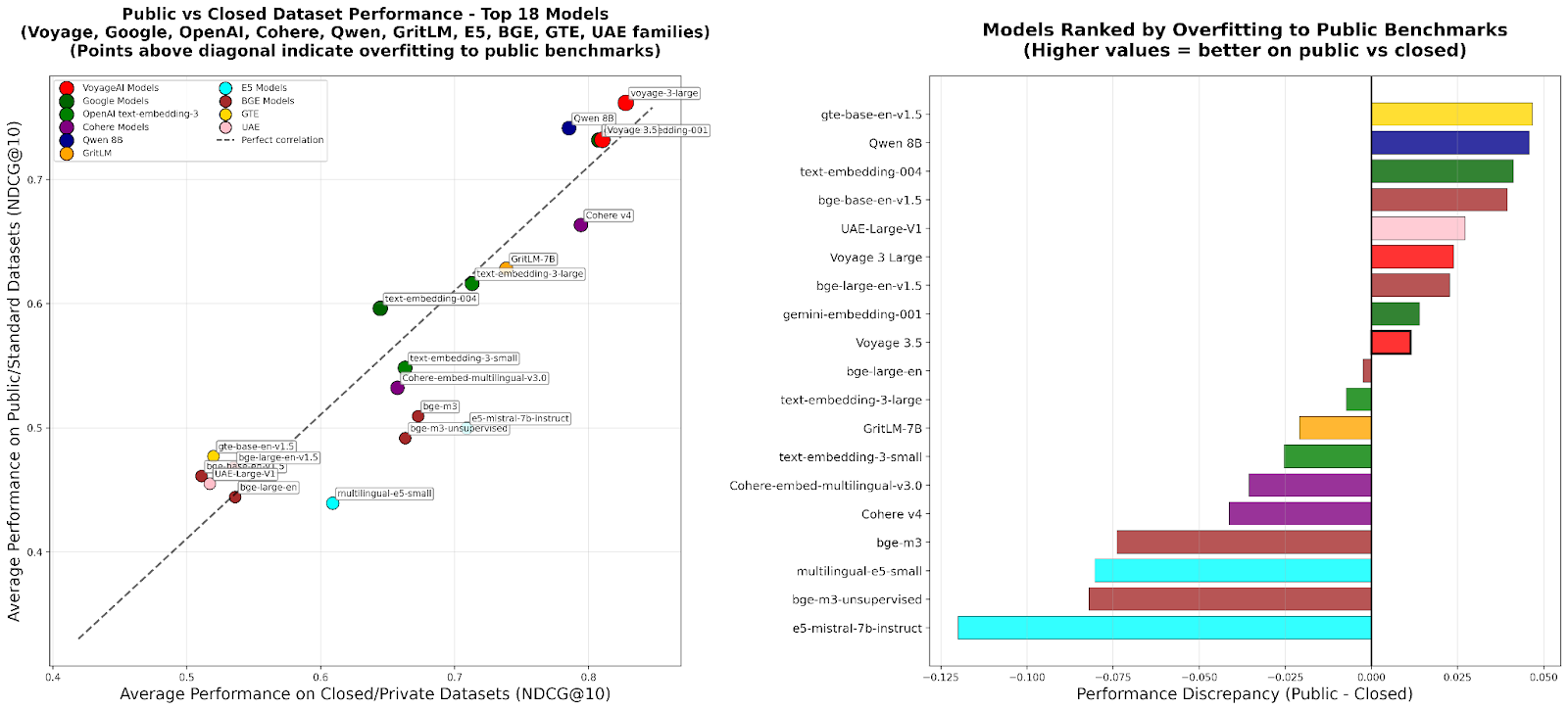

RTEB: Standar Baru untuk Evaluasi Embedding Retrieval : Hugging Face meluncurkan versi beta Retrieval Embedding Benchmark (RTEB), yang bertujuan untuk menyediakan standar evaluasi yang andal untuk akurasi retrieval model embedding. Benchmark ini, melalui strategi campuran yang menggabungkan dataset publik dan privat, secara efektif mengatasi masalah overfitting model pada benchmark yang ada, memastikan hasil evaluasi dapat lebih baik mencerminkan kemampuan generalisasi model pada data yang belum pernah dilihat, yang sangat penting untuk peningkatan kualitas aplikasi AI seperti RAG dan Agent. (Sumber: HuggingFace Blog)

Pelatihan Menengah RL Skalabel: Mewujudkan Penalaran Melalui Abstraksi Aksi : Penelitian terbaru mengusulkan algoritma “Reasoning as Action Abstraction” (RA3), yang secara signifikan meningkatkan kemampuan penalaran dan pembuatan kode Large Language Models (LLMs) dengan mengidentifikasi kumpulan aksi yang ringkas dan berguna selama fase pelatihan menengah Reinforcement Learning (RL), serta mempercepat RL online. Metode ini menunjukkan kinerja luar biasa dalam tugas pembuatan kode, dengan peningkatan kinerja rata-rata 8 hingga 4 poin persentase dibandingkan model baseline, serta mencapai konvergensi RL yang lebih cepat dan kinerja asimtotik yang lebih tinggi. (Sumber: HuggingFace Daily Papers)

🎯 PERKEMBANGAN

OpenAI Sora 2: Era Baru Sosial Video AI : OpenAI merilis Sora 2 dan meluncurkan aplikasi sosial dengan nama yang sama, bertujuan untuk menciptakan jaringan sosial yang berpusat pada pengguna dan lingkaran sosial mereka (teman, hewan peliharaan) melalui penjelajahan dan pembuatan video yang dihasilkan AI, bukan platform distribusi konten tradisional. Sora 2 menunjukkan kemampuan simulasi fisik dan pembuatan audio yang kuat, namun dalam pengujian awal masih terdapat kekurangan detail seperti “menghitung jari”. Perilisannya memicu diskusi tentang kecanduan video AI, deepfake, dan jalur komersialisasi OpenAI. Sam Altman menanggapi bahwa Sora bertujuan untuk menyeimbangkan terobosan teknologi dengan pengalaman pengguna yang menyenangkan, serta menyediakan dana untuk penelitian AI. (Sumber: 36氪、Reddit r/ChatGPT、OpenAI)

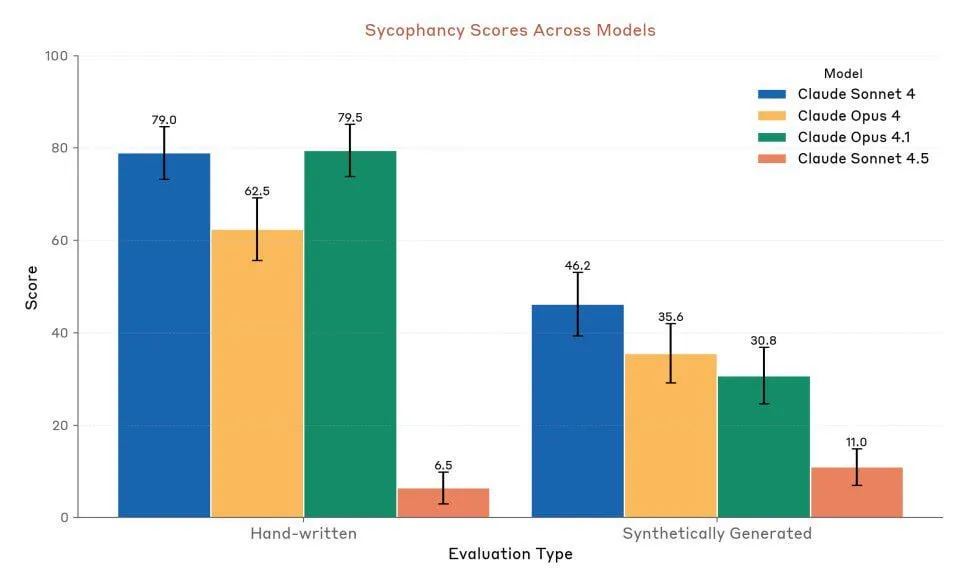

Anthropic Claude Sonnet 4.5: Tolok Ukur Baru untuk Kode dan Agent : Anthropic merilis Claude Sonnet 4.5, yang disebut sebagai “model pemrograman terbaik di dunia” dan “model paling kuat untuk membangun Agent kompleks”, dengan waktu operasi otonom hingga 30 jam, dan menunjukkan peningkatan kinerja pengkodean yang signifikan pada tugas GitHub. Model ini juga menambahkan fitur memori, memungkinkan penyimpanan progres proyek. Meskipun kinerjanya sangat diakui, masih ada kontroversi di kalangan pengguna mengenai batasan penggunaan dan perbandingan kinerja aktualnya dengan Opus 4.1 dan GPT-5. (Sumber: Reddit r/ClaudeAI、Reddit r/artificial、Reddit r/ClaudeAI)

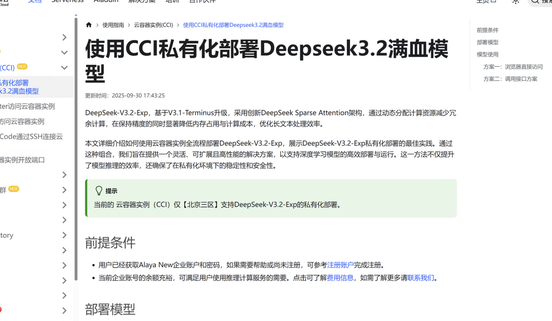

DeepSeek V3.2-Exp: Arsitektur Sparse Attention Meningkatkan Efisiensi : DeepSeek merilis model bahasa besar DeepSeek V3.2-Exp, memperkenalkan arsitektur Sparse Attention (DSA) yang baru, mengurangi kompleksitas perhatian utama dari O(L²) menjadi O(L·k), secara signifikan mengoptimalkan biaya pre-fill dan decoding dalam skenario konteks panjang, sehingga sangat mengurangi biaya penggunaan API. Nine Chapters Cloud Pole telah lebih dulu menyelesaikan adaptasi DeepSeek V3.2-Exp, menyediakan solusi deployment privat yang aman dan efisien untuk memenuhi kebutuhan perusahaan akan keamanan data dan fleksibilitas komputasi. (Sumber: 量子位、Reddit r/LocalLLaMA)

Model Audio-Teks Multimodal LFM2-Audio-1.5B Dirilis : Liquid AI meluncurkan LFM2-Audio-1.5B, sebuah model dasar multimodal audio-teks end-to-end yang mampu memahami dan menghasilkan teks serta audio. Model ini memiliki kecepatan inferensi 10 kali lebih cepat dari model sejenis, dan dengan hanya 1.5B parameter, kualitasnya setara dengan model yang 10 kali lebih besar, mendukung deployment lokal dan percakapan real-time. Hume AI juga merilis Octave 2, model text-to-speech multibahasa yang lebih cepat dan lebih murah, dengan kemampuan percakapan multi-speaker dan konversi suara. (Sumber: Reddit r/LocalLLaMA、QuixiAI)

Microsoft Agent Framework: Kemajuan Baru dalam Pengembangan Sistem Agent : Microsoft merilis Microsoft Agent Framework, mengintegrasikan AutoGen dan Semantic Kernel menjadi SDK terpadu yang siap produksi untuk membangun, mengorkestrasi, dan menerapkan sistem multi-Agent. Framework ini mendukung .NET dan Python, serta mampu mengimplementasikan alur kerja multi-Agent melalui orkestrasi berbasis grafik, bertujuan untuk menyederhanakan pengembangan, observasi, dan tata kelola aplikasi Agent, mempercepat adopsi AI Agent tingkat perusahaan. (Sumber: gojira、omarsar0)

Garis Depan Teknologi Robot AI dan Persaingan Industri : Teknologi robot terus berkembang, dengan OmniRetarget dari Amazon FAR yang mengoptimalkan penangkapan gerakan manusia untuk mempelajari keterampilan humanoid kompleks dengan Reinforcement Learning minimal. Periodic Labs berdedikasi untuk menciptakan “ilmuwan AI” guna mempercepat penemuan ilmiah. Nvidia, di sisi lain, menekankan peran penting mesin fisika terbuka Newton, model bahasa visual inferensi Cosmos Reason, dan model dasar robot Isaac GR00T N1.6 dalam deployment AI fisik. Sementara itu, Tiongkok menunjukkan keunggulan dalam produksi robot dan biaya robot humanoid, memicu perhatian terhadap lanskap persaingan industri robot global. (Sumber: pabbeel、LiamFedus、nvidia、atroyn)

🧰 ALAT

Tinker API: Antarmuka Fleksibel untuk Menyederhanakan Fine-tuning LLM : Thinking Machines Lab meluncurkan Tinker API, sebuah antarmuka fleksibel yang dirancang untuk fine-tuning model bahasa. Ini memungkinkan peneliti dan pengembang untuk menulis loop pelatihan secara lokal, sementara Tinker bertanggung jawab untuk menjalankannya pada klaster GPU terdistribusi, mengelola kompleksitas infrastruktur, sehingga pengguna dapat fokus pada algoritma dan data. Alat ini bertujuan untuk menurunkan ambang batas post-training LLM, mempercepat eksperimen dan inovasi model terbuka, dan dipuji oleh para ahli seperti Andrej Karpathy sebagai “infrastruktur yang selalu saya inginkan”. (Sumber: Reddit r/artificial、Thinking Machines、karpathy)

LlamaAgents: Deployment Agent Dokumen Sekali Klik : LlamaIndex meluncurkan LlamaAgents, menyediakan kemampuan deployment AI Agent berbasis dokumen sekali klik, bertujuan untuk meningkatkan kecepatan pembangunan dan pengiriman agen dokumen hingga 10 kali lipat. Platform ini menawarkan 90% template yang telah dikonfigurasi sebelumnya, mendukung otomatisasi tugas-tugas padat dokumen seperti pemrosesan faktur, peninjauan kontrak, dan klaim, serta memungkinkan kustomisasi tak terbatas. Pengguna dapat melakukan deployment di LlamaCloud dan dengan mudah mengelola serta memperbarui alur kerja Agent melalui repositori Git, sangat mempersingkat siklus pengembangan. (Sumber: jerryjliu0、jerryjliu0)

Hex AI Agent: Memberdayakan Analisis dan Kolaborasi Tim : Hex merilis tiga AI Agent baru, dirancang khusus untuk analisis data dan kolaborasi tim: Threads menyediakan interaksi data percakapan, Semantic Model Agent menciptakan konteks terkontrol untuk mendapatkan jawaban akurat, dan Notebook Agent merevolusi pekerjaan sehari-hari tim data. Semua Agent ini didukung oleh Claude 4.5 Sonnet, bertujuan untuk mengubah analisis AI percakapan dari konsep masa depan menjadi alat yang efisien dan siap pakai. (Sumber: sarahcat21)

Sculptor: UI yang Hilang dari Claude Code : Imbue meluncurkan Sculptor, antarmuka pengguna yang dirancang untuk Claude Code, bertujuan untuk meningkatkan pengalaman pemrograman Agent. Ini memungkinkan pengembang untuk menjalankan beberapa Claude Agent secara paralel dalam kontainer terisolasi, dan dapat menyinkronkan hasil kerja Agent ke lingkungan pengembangan lokal untuk pengujian dan pengeditan melalui “mode berpasangan”. Sculptor juga berencana untuk mendukung GPT-5 dan menyediakan fitur saran seperti deteksi perilaku menyesatkan, bertujuan untuk membuat pemrograman Agent lebih lancar dan efisien. (Sumber: kanjun、kanjun)

Synthesia 3.0: Terobosan Baru dalam Video AI Interaktif : Synthesia merilis versi 3.0, memperkenalkan beberapa fitur inovatif, termasuk “Video Agent” (video interaktif yang dapat melakukan percakapan real-time, digunakan untuk pelatihan dan wawancara), “Avatar” yang ditingkatkan (dibuat melalui satu prompt atau gambar, dengan ekspresi wajah dan gerakan tubuh yang realistis), serta “Copilot” (editor video AI yang dapat dengan cepat menghasilkan skrip dan elemen visual). Selain itu, fitur interaktivitas dan alat desain kursus juga ditingkatkan, bertujuan untuk merevolusi pengalaman pembuatan video dan pembelajaran. (Sumber: synthesiaIO、synthesiaIO)

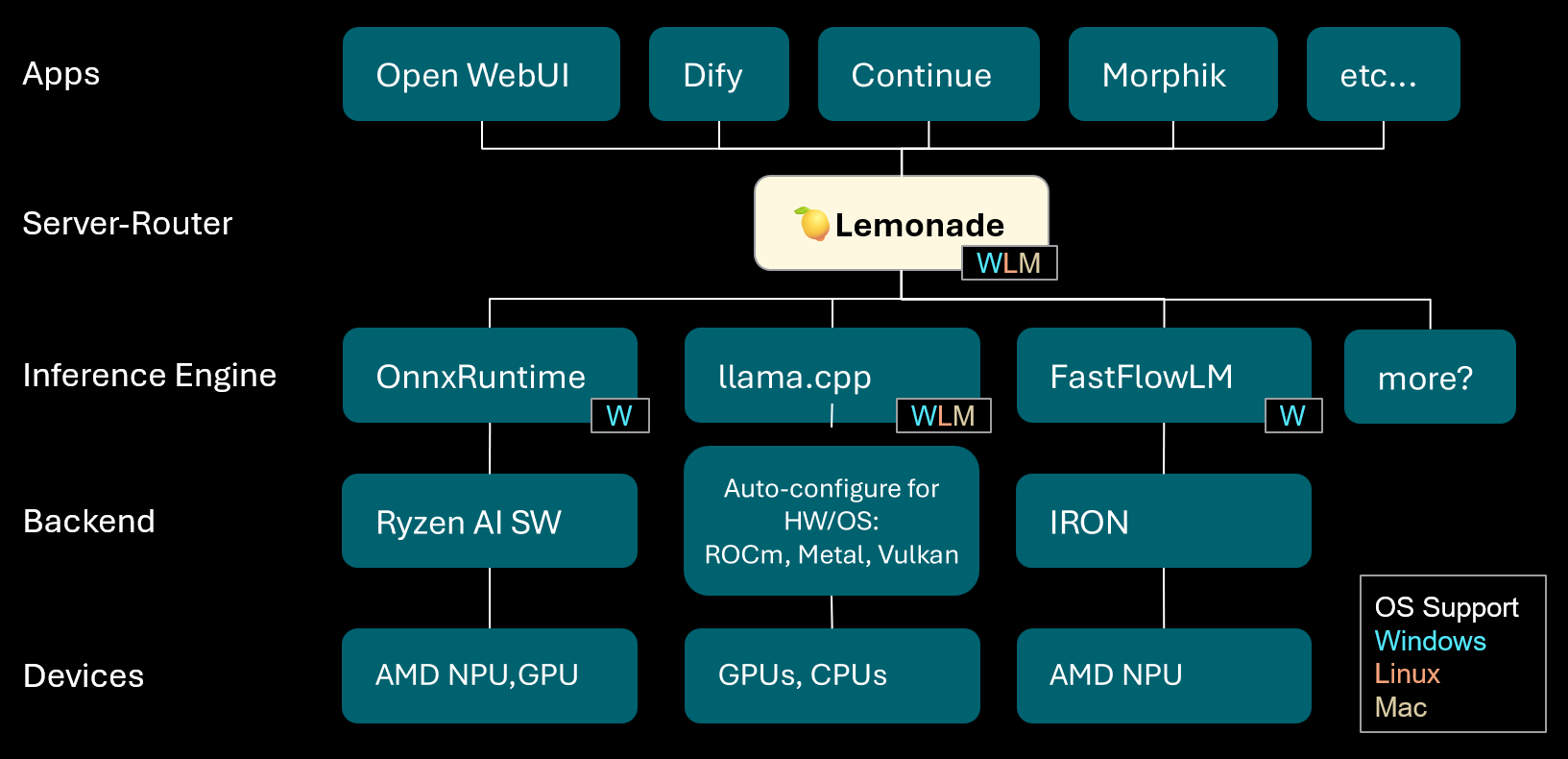

Lemonade: Server-Router LLM Lokal : Lemonade merilis versi v8.1.11, sebuah server-router LLM lokal yang mampu secara otomatis mengkonfigurasi mesin inferensi berkinerja tinggi untuk berbagai PC (termasuk perangkat AMD NPU dan macOS/Apple Silicon). Ini mendukung berbagai format model seperti ONNX, GGUF, dan FastFlowLM, serta memanfaatkan backend Metal dari llama.cpp untuk komputasi efisien pada Apple Silicon, menyediakan pengalaman LLM lokal yang fleksibel dan berkinerja tinggi bagi pengguna. (Sumber: Reddit r/LocalLLaMA)

PopAi: Pembuatan Presentasi Berbasis AI : PopAi menunjukkan kemampuan alat AI-nya untuk menghasilkan presentasi bisnis detail yang berisi grafik dan ilustrasi dari prompt sederhana dalam hitungan menit. Ini menyoroti efisiensi AI dalam pembuatan konten, memungkinkan non-profesional untuk dengan cepat membuat materi presentasi berkualitas tinggi. (Sumber: kaifulee)

GitHub Copilot CLI: Pemilihan Model Otomatis : GitHub Copilot CLI kini menyediakan fitur pemilihan model otomatis untuk pengguna komersial dan perusahaan. Pembaruan ini memungkinkan sistem untuk secara otomatis memilih model yang paling sesuai berdasarkan tugas saat ini, bertujuan untuk meningkatkan efisiensi pengembangan dan kualitas pembuatan kode. (Sumber: pierceboggan)

Mixedbread Search: Pencarian Lokal Multibahasa dan Multimodal : Mixedbread meluncurkan sistem pencarian versi beta-nya, menyediakan fungsi pencarian dokumen yang cepat, akurat, multibahasa, dan multimodal. Sistem ini menekankan operasi lokal, memungkinkan pengguna untuk melakukan retrieval dokumen secara efisien di perangkat mereka sendiri, terutama cocok untuk skenario yang memerlukan penanganan berbagai jenis data. (Sumber: TheZachMueller)

Hume AI Octave 2: Model TTS Multibahasa Generasi Berikutnya : Hume AI merilis Octave 2, model Text-to-Speech (TTS) multibahasa generasi berikutnya. Model ini 40% lebih cepat dan 50% lebih murah dari pendahulunya, serta mendukung lebih dari 11 bahasa, percakapan multi-speaker, konversi suara, dan fitur pengeditan fonem, bertujuan untuk menyediakan pengalaman AI suara yang lebih cepat, lebih realistis, dan lebih emosional. (Sumber: AlanCowen)

Pembaruan September AssemblyAI: Layanan Audio AI Serbaguna : AssemblyAI meninjau pembaruan September-nya, dengan sorotan termasuk peluncuran Playground dalam aplikasi, ekstensi bahasa universal, fitur PII redaction UE, serta peningkatan kinerja streaming dan prompt kata kunci. Pembaruan ini bertujuan untuk menyediakan layanan pemrosesan audio AI yang lebih komprehensif dan efisien bagi pengguna. (Sumber: AssemblyAI)

Voiceflow MCP Tools: Standardisasi Integrasi Alat Agent : Voiceflow meluncurkan alat Model Context Protocol (MCP), menyediakan cara standar bagi AI Agent untuk menggunakan berbagai alat. Ini menyederhanakan pekerjaan integrasi kustom bagi pengembang dan menyediakan alat pihak ketiga yang telah dibangun sebelumnya untuk pengguna tanpa kode, sangat memperluas kemampuan Voiceflow Agent. (Sumber: ReamBraden)

Salesforce Agentforce Vibes: Pengkodean Agent Tingkat Perusahaan : Salesforce meluncurkan produk “Agentforce Vibes” berdasarkan arsitektur Cline, memanfaatkan dukungan Model Context Protocol (MCP) untuk menyediakan kemampuan pengkodean otonom bagi pelanggan perusahaan. Produk ini memastikan komunikasi yang aman antara LLM dengan sumber/database pengetahuan internal dan eksternal, bertujuan untuk mewujudkan pengkodean AI skala perusahaan. (Sumber: cline)

JoyAgent-JDGenie: Laporan Arsitektur Agent Generalis : Laporan teknis GAIA (Generalist Agent Architecture) telah dirilis. Arsitektur ini mengintegrasikan kerangka kerja multi-Agent kolektif (menggabungkan perencanaan, Agent eksekusi, dan voting model komentar), sistem memori hierarkis (lapisan kerja, semantik, program), serta suite alat seperti pencarian, eksekusi kode, dan parsing multimodal. Kerangka kerja ini menunjukkan kinerja luar biasa dalam benchmark komprehensif, melampaui baseline open-source dan mendekati kinerja sistem proprietary, menyediakan jalur untuk membangun asisten AI yang skalabel, tangguh, dan adaptif. (Sumber: HuggingFace Daily Papers)

Asisten Perjalanan AI: Pemberdayaan dari Panduan hingga Aksi : Aplikasi Asisten Perjalanan AI yang diluncurkan oleh Mafengwo bertujuan untuk meningkatkan peran AI dari pembuatan panduan tradisional menjadi bantuan aksi dalam perjalanan nyata. Aplikasi ini dapat menghasilkan panduan pribadi yang kaya gambar dan teks, serta menyediakan fungsi praktis seperti AI Agent yang dapat menelepon untuk memesan restoran, secara efektif mengatasi masalah seperti hambatan bahasa. Meskipun masih ada ruang untuk peningkatan dalam terjemahan real-time dan personalisasi mendalam, ini telah secara signifikan menurunkan ambang batas untuk “bepergian tanpa panduan”, menunjukkan potensi besar AI dalam menghubungkan informasi digital dengan tindakan di dunia fisik. (Sumber: 36氪)

📚 PEMBELAJARAN

Saran Pengembangan Karier untuk Peneliti AI : Mengenai pengembangan karier bagi peneliti AI, para ahli menekankan pentingnya menjadi coder yang hebat, mendorong untuk mereplikasi makalah penelitian dari awal, dan memahami infrastruktur secara mendalam. Pada saat yang sama, disarankan untuk secara aktif membangun merek pribadi, berbagi ide-ide menarik, menjaga rasa ingin tahu dan adaptabilitas, serta memprioritaskan posisi yang mempromosikan inovasi dan pembelajaran. Dalam jangka panjang, upaya berkelanjutan dan pencapaian hasil nyata adalah kunci untuk membangun kepercayaan diri dan motivasi. (Sumber: dejavucoder、BlackHC)

Kursus Analisis Data Python : DeepLearningAI meluncurkan kursus analisis data Python baru, yang bertujuan untuk mengajarkan cara menggunakan Python untuk meningkatkan efisiensi, ketertelusuran, dan reproduktifitas analisis data. Kursus ini merupakan bagian dari sertifikat profesional analisis data, menekankan peran inti keterampilan pemrograman dalam pekerjaan data modern. (Sumber: DeepLearningAI)

Siswa Mendapatkan Alat AI Copilot Gratis : Microsoft menawarkan langganan pribadi Microsoft 365 gratis selama 12 bulan kepada mahasiswa yang memenuhi syarat, termasuk akses tambahan ke Copilot Podcasts, Deep Research, dan Vision. Langkah ini bertujuan untuk menyediakan alat AI yang kuat bagi siswa, membantu pembelajaran dan inovasi mereka. (Sumber: mustafasuleyman)

Pengaturan Kursus AI/ML Lokal : Seorang pendidik berbagi cara membuat kursus praktis AI/ML berbasis pengembangan lokal dan perangkat keras tingkat konsumen untuk siswa dengan anggaran terbatas. Dia menyarankan penggunaan model kecil, Transformer Lab sebagai platform pelatihan, dan menekankan pemahaman konsep inti daripada mengejar skala model secara membabi buta, untuk meningkatkan efek pembelajaran dan kemampuan operasional praktis siswa. (Sumber: Reddit r/deeplearning)

Seminar AI yang Akan Datang : AIhub merilis daftar seminar Machine Learning dan AI yang akan datang antara Oktober dan November 2025. Acara-acara ini mencakup berbagai topik mulai dari pengumpulan data dari platform media sosial yang dibatasi politik hingga etika AI, semua seminar gratis dan menawarkan opsi partisipasi online, menyediakan banyak kesempatan belajar dan berjejaring bagi komunitas AI. (Sumber: aihub.org)

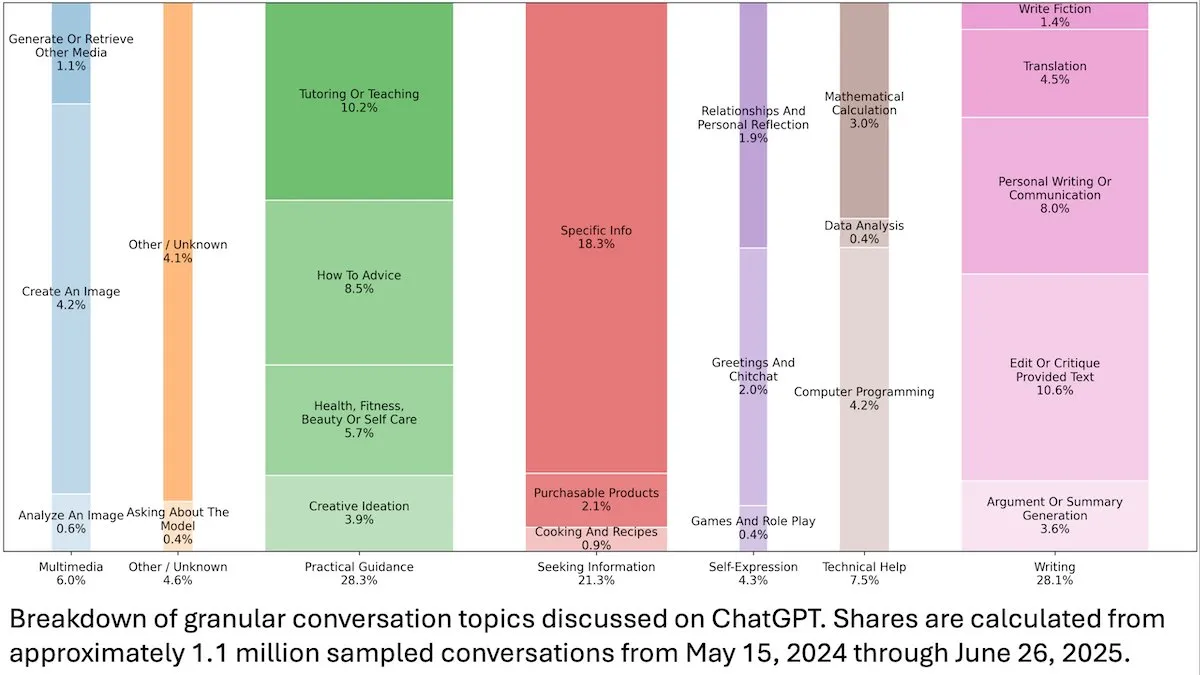

Wawasan Perilaku Pengguna ChatGPT : Sebuah studi OpenAI yang dirilis oleh DeepLearningAI menunjukkan bahwa analisis 110 juta percakapan anonim ChatGPT mengungkapkan bahwa skenario penggunaannya telah beralih dari terkait pekerjaan ke kebutuhan pribadi, dengan proporsi pengguna wanita dan pengguna muda berusia 18-25 tahun yang lebih tinggi. Permintaan paling umum adalah panduan praktis (28.3%), bantuan menulis (28.1%), dan pertanyaan informasi (21.3%), mengungkapkan aplikasi luas ChatGPT dalam kehidupan sehari-hari. (Sumber: DeepLearningAI)

Code2Video: Pembuatan Video Edukasi Berbasis Kode : Sebuah penelitian mengusulkan Code2Video, sebuah kerangka kerja Agent yang berpusat pada kode, yang menghasilkan video edukasi profesional melalui kode Python yang dapat dieksekusi. Kerangka kerja ini mencakup tiga Agent kolaboratif: perencana, encoder, dan kritikus, yang mampu menstrukturkan konten kuliah, mengubahnya menjadi kode, dan mengoptimalkan secara visual. Ini mencapai peningkatan kinerja 40% pada benchmark video edukasi MMMC dan menghasilkan video yang sebanding dengan tutorial buatan manusia. (Sumber: HuggingFace Daily Papers)

BiasFreeBench: Benchmark Mitigasi Bias LLM : BiasFreeBench diperkenalkan sebagai benchmark empiris untuk secara komprehensif membandingkan delapan teknik mitigasi bias LLM utama. Benchmark ini, dengan mereorganisasi dataset yang ada, memperkenalkan metrik “Bias-Free Score” tingkat respons dalam dua skenario pengujian: pertanyaan pilihan ganda dan pertanyaan multi-putaran terbuka, untuk mengukur keadilan, keamanan, dan tingkat anti-stereotip respons LLM, bertujuan untuk membangun platform pengujian terpadu untuk penelitian mitigasi bias. (Sumber: HuggingFace Daily Papers)

Hambatan Pembelajaran Multiplikasi Transformer dan Jebakan Ketergantungan Jarak Jauh : Penelitian ini menganalisis rekayasa balik penyebab kegagalan model Transformer dalam tugas perkalian multi-digit yang tampaknya sederhana. Studi menemukan bahwa model mengkodekan struktur ketergantungan jarak jauh yang diperlukan dalam rantai pemikiran implisit, tetapi metode fine-tuning standar gagal untuk konvergen ke solusi optimal global yang dapat memanfaatkan ketergantungan ini. Dengan memperkenalkan fungsi kerugian tambahan, peneliti berhasil mengatasi masalah ini, mengungkapkan jebakan pembelajaran ketergantungan jarak jauh Transformer, dan memberikan contoh bagaimana masalah ini dapat dipecahkan melalui bias induktif yang benar. (Sumber: HuggingFace Daily Papers)

Wawasan Pelatihan VL-PRM dalam Penalaran Multimodal : Penelitian ini bertujuan untuk menjelaskan ruang desain Visual-Language Process Reward Models (VL-PRMs), mengeksplorasi berbagai strategi untuk konstruksi dataset, pelatihan, dan penskalaan waktu pengujian. Dengan memperkenalkan kerangka kerja sintesis data campuran dan pengawasan terfokus persepsi, VL-PRMs menunjukkan wawasan kunci dalam lima benchmark multimodal, termasuk mengungguli model reward hasil dalam penskalaan waktu pengujian, VL-PRMs berukuran kecil dapat mendeteksi kesalahan proses, dan dapat mengungkapkan kemampuan penalaran potensial dari backbone VLM yang lebih kuat. (Sumber: HuggingFace Daily Papers)

GEM: Simulator Lingkungan Universal untuk Agentic LLM : GEM (General Experience Maker) adalah simulator lingkungan open-source, dirancang khusus untuk pembelajaran pengalaman LLM Agent. Ini menyediakan antarmuka Agent-lingkungan yang terstandardisasi, mendukung eksekusi vektorisasi asinkron untuk throughput tinggi, dan menawarkan wrapper fleksibel untuk kemudahan ekstensi. GEM juga mencakup suite lingkungan yang beragam dan alat terintegrasi, serta menyediakan baseline menggunakan kerangka pelatihan RL seperti REINFORCE, bertujuan untuk mempercepat penelitian Agentic LLM. (Sumber: HuggingFace Daily Papers)

GUI-KV: Kompresi Cache KV untuk GUI Agent yang Efisien : GUI-KV adalah metode kompresi cache KV plug-and-play, dirancang khusus untuk GUI Agent, yang meningkatkan efisiensi tanpa perlu pelatihan ulang. Dengan menganalisis pola perhatian dalam beban kerja GUI, metode ini menggabungkan panduan salience spasial dan teknik penilaian redundansi temporal, mencapai akurasi mendekati cache penuh dengan anggaran moderat, dan secara signifikan mengurangi FLOPs decoding, secara efektif memanfaatkan redundansi yang unik pada GUI. (Sumber: HuggingFace Daily Papers)

Melampaui Log-Likelihood: Studi Fungsi Tujuan Probabilistik untuk SFT : Penelitian ini mengeksplorasi fungsi tujuan probabilistik di luar Negative Log-Likelihood (NLL) tradisional dalam Supervised Fine-Tuning (SFT). Melalui eksperimen ekstensif pada 7 backbone model, 14 benchmark, dan 3 domain, ditemukan bahwa ketika kemampuan model kuat, fungsi tujuan yang memprioritaskan token prior dengan bobot probabilitas rendah (seperti -p, -p^10) berkinerja lebih baik daripada NLL; sedangkan ketika kemampuan model lemah, NLL mendominasi. Analisis teoretis mengungkapkan bagaimana fungsi tujuan menyeimbangkan berdasarkan kemampuan model, menyediakan strategi optimasi yang lebih berprinsip untuk SFT. (Sumber: HuggingFace Daily Papers)

VLA-RFT: Fine-tuning RL Berbasis Reward Validasi dalam Simulator Dunia : VLA-RFT adalah kerangka kerja fine-tuning Reinforcement Learning (RL) untuk model Visual-Language-Action (VLA), yang memanfaatkan model dunia berbasis data sebagai simulator yang dapat dikontrol. Simulator yang dilatih dengan data interaksi nyata memprediksi observasi visual masa depan berbasis aksi, sehingga memungkinkan peluncuran strategi dengan reward tingkat lintasan yang padat. Kerangka kerja ini secara signifikan mengurangi kebutuhan sampel, mengungguli baseline supervised yang kuat dalam kurang dari 400 langkah fine-tuning, dan menunjukkan robustnes yang kuat dalam kondisi gangguan. (Sumber: HuggingFace Daily Papers)

ImitSAT: Menyelesaikan Masalah Satisfiability Boolean Melalui Pembelajaran Imitasi : ImitSAT adalah strategi percabangan solver CDCL berbasis pembelajaran imitasi untuk menyelesaikan masalah Satisfiability Boolean (SAT). Metode ini, dengan mempelajari KeyTrace ahli, melipat operasi penuh menjadi urutan keputusan yang bertahan, menyediakan pengawasan tingkat keputusan yang padat, dan secara langsung mengurangi jumlah propagasi. Eksperimen menunjukkan bahwa ImitSAT mengungguli metode pembelajaran yang ada dalam hal jumlah propagasi dan waktu eksekusi, mencapai konvergensi yang lebih cepat dan pelatihan yang stabil. (Sumber: HuggingFace Daily Papers)

Studi Praktik Pengujian Kerangka Kerja AI Agent Open-Source : Sebuah studi empiris berskala besar terhadap 39 kerangka kerja Agent open-source dan 439 aplikasi Agent mengungkapkan praktik pengujian dalam ekosistem AI Agent. Penelitian ini mengidentifikasi sepuluh pola pengujian unik, menemukan bahwa investasi pengujian pada komponen deterministik (seperti alat dan alur kerja) melebihi 70%, sementara entitas perencanaan berbasis LLM hanya menyumbang kurang dari 5%. Selain itu, pengujian regresi komponen prompt (Trigger) sangat diabaikan, hanya muncul dalam sekitar 1% pengujian, mengungkapkan titik buta kunci dalam pengujian Agent. (Sumber: HuggingFace Daily Papers)

DeepCodeSeek: Retrieval API Real-time untuk Pembuatan Kode : DeepCodeSeek mengusulkan teknik baru untuk menyediakan retrieval API real-time untuk pembuatan kode yang sadar konteks, sehingga memungkinkan penyelesaian kode otomatis end-to-end berkualitas tinggi dan aplikasi AI Agentic. Metode ini mengatasi masalah kebocoran API dalam dataset benchmark yang ada dengan memperluas kode dan indeks untuk memprediksi API yang dibutuhkan. Setelah dioptimalkan, sebuah re-ranker 0.6B yang ringkas mengungguli model 8B dalam kinerja sambil mempertahankan latensi 2.5 kali lebih rendah. (Sumber: HuggingFace Daily Papers)

CORRECT: Identifikasi Kesalahan Terkondensasi dalam Sistem Multi-Agent : CORRECT adalah kerangka kerja ringan dan bebas pelatihan yang mencapai identifikasi kesalahan dan transfer pengetahuan dalam sistem multi-Agent dengan memanfaatkan cache online dari pola kesalahan yang didistilasi. Kerangka kerja ini dapat mengidentifikasi kesalahan terstruktur dalam waktu linier, menghindari pelatihan ulang yang mahal, dan dapat beradaptasi dengan deployment MAS yang dinamis. CORRECT meningkatkan lokalisasi kesalahan tingkat langkah sebesar 19.8% dalam tujuh aplikasi multi-Agent, secara signifikan memperkecil kesenjangan antara otomatisasi dan identifikasi kesalahan tingkat manusia. (Sumber: HuggingFace Daily Papers)

Swift: Model Konsistensi Autoregresif untuk Prakiraan Cuaca Efisien : Swift adalah model konsistensi satu langkah yang pertama kali mengimplementasikan fine-tuning autoregresif untuk model aliran probabilistik, dan mengadopsi tujuan Continuous Ranked Probability Score (CRPS). Model ini mampu menghasilkan prakiraan cuaca 6 jam yang terampil dan mempertahankan stabilitas hingga 75 hari, berjalan 39 kali lebih cepat daripada baseline difusi tercanggih, sekaligus mencapai keterampilan prakiraan yang kompetitif dengan IFS ENS numerik, menandai langkah penting menuju prakiraan ensemble yang efisien dan handal dari skala menengah hingga musiman. (Sumber: HuggingFace Daily Papers)

Catching the Details: Prediktor RoI Self-Distilled untuk Persepsi Fine-Grained MLLM : Penelitian ini mengusulkan Self-Distilled Region Proposal Network (SD-RPN) yang efisien dan tanpa anotasi, yang mengatasi masalah biaya komputasi tinggi pada Multimodal Large Language Models (MLLM) saat memproses gambar resolusi tinggi. SD-RPN mengubah peta perhatian dari lapisan menengah MLLM menjadi label pseudo-RoI berkualitas tinggi, dan melatih RPN ringan untuk lokalisasi yang tepat, mencapai efisiensi data dan kemampuan generalisasi, meningkatkan akurasi lebih dari 10% dalam benchmark yang belum pernah dilihat. (Sumber: HuggingFace Daily Papers)

Paradigma Baru Penalaran Multi-Turn LLM: In-Place Feedback : Penelitian ini memperkenalkan paradigma interaksi baru yang disebut “In-Place Feedback” untuk memandu LLM dalam penalaran multi-turn. Pengguna dapat langsung mengedit respons LLM sebelumnya, dan model akan menghasilkan revisi berdasarkan respons yang telah dimodifikasi ini. Evaluasi empiris menunjukkan bahwa In-Place Feedback mengungguli umpan balik multi-turn tradisional dalam benchmark yang intensif penalaran, sekaligus mengurangi penggunaan token sebesar 79.1%, mengatasi keterbatasan model dalam menerapkan umpan balik secara tepat. (Sumber: HuggingFace Daily Papers)

Prediktabilitas Dinamika Reinforcement Learning LLM : Karya ini mengungkapkan dua karakteristik fundamental pembaruan parameter LLM dalam pelatihan Reinforcement Learning (RL): dominasi rank-1 (subruang singular tertinggi dari matriks pembaruan parameter hampir sepenuhnya menentukan peningkatan inferensi) dan dinamika linier rank-1 (subruang dominan ini berevolusi secara linier selama pelatihan). Berdasarkan temuan ini, penelitian mengusulkan AlphaRL, sebuah kerangka kerja akselerasi plug-and-play, yang menyimpulkan pembaruan parameter akhir melalui jendela pelatihan awal, mencapai akselerasi hingga 2.5 kali lipat, sambil mempertahankan lebih dari 96% kinerja inferensi. (Sumber: HuggingFace Daily Papers)

Jebakan Kompresi Cache KV : Penelitian ini mengungkapkan beberapa jebakan kompresi cache KV dalam deployment LLM, terutama dalam skenario praktis seperti prompt multi-instruksi, di mana kompresi dapat menyebabkan penurunan kinerja yang cepat untuk instruksi tertentu, bahkan diabaikan sepenuhnya oleh LLM. Studi ini, melalui analisis kasus kebocoran prompt sistem, secara empiris menunjukkan dampak kompresi pada kebocoran dan kepatuhan instruksi umum, serta mengusulkan skema peningkatan strategi pengusiran cache KV yang sederhana. (Sumber: HuggingFace Daily Papers)

💼 BISNIS

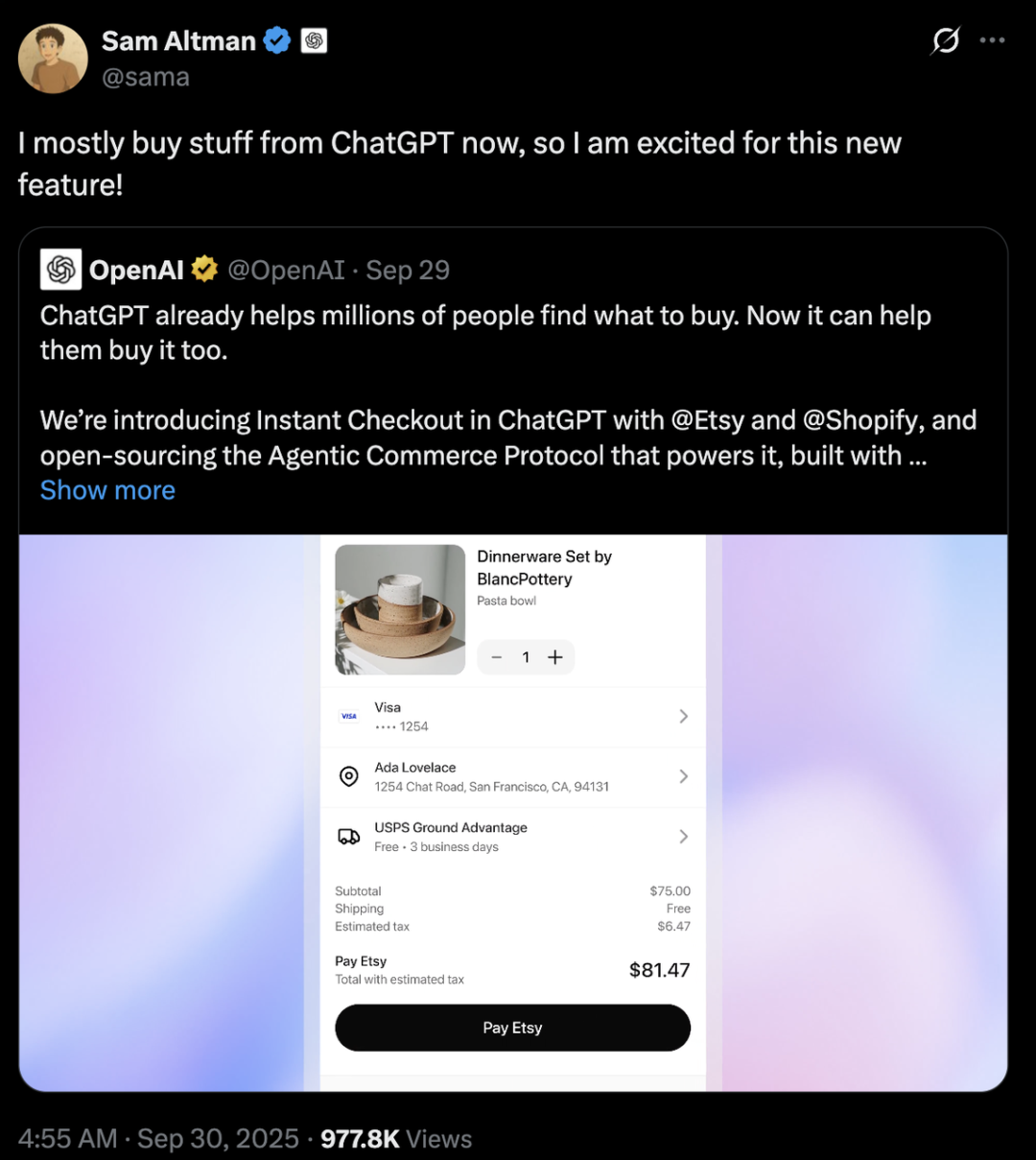

Persaingan Raksasa AI: Perbedaan Strategi OpenAI dan Anthropic : OpenAI dan Anthropic mengambil jalur pengembangan yang sangat berbeda di bidang AI. OpenAI, melalui integrasi e-commerce ChatGPT dan peluncuran aplikasi sosial Sora, bertujuan untuk mencapai “ekspansi horizontal”, menjadi platform super yang mencakup berbagai aspek kehidupan pengguna, dengan valuasi yang telah melampaui Anthropic hingga ratusan miliar dolar. Anthropic, di sisi lain, berfokus pada “penggalian vertikal”, dengan Claude Sonnet 4.5 sebagai intinya, mendalami pemrograman AI dan pasar Agent tingkat perusahaan, serta terikat erat dengan penyedia layanan cloud seperti AWS dan Google. Di balik keduanya adalah pertarungan antara dua raksasa komputasi awan, Microsoft dan Amazon, dalam “diplomasi komputasi”, menyoroti realitas industri di era AI di mana daya komputasi langka dan biayanya tinggi. (Sumber: 36氪、量子位、36氪)

Perplexity Mengakuisisi Visual Electric : Perplexity mengumumkan akuisisi Visual Electric, dengan timnya akan bergabung dengan Perplexity untuk bersama-sama mengembangkan pengalaman produk konsumen baru. Produk Visual Electric akan secara bertahap dihentikan layanannya. Akuisisi ini bertujuan untuk memperkuat kemampuan inovasi Perplexity di bidang produk AI konsumen. (Sumber: AravSrinivas)

Databricks Mengakuisisi Mooncakelabs : Databricks mengumumkan akuisisi Mooncakelabs untuk mempercepat realisasi visi Lakebase-nya. Lakebase adalah database OLTP baru yang dibangun di atas Postgres dan dioptimalkan untuk AI Agent, bertujuan untuk menyediakan fondasi terpadu untuk aplikasi, analitik, dan AI, serta terintegrasi secara mendalam dengan Lakehouse dan Agent Bricks, menyederhanakan manajemen data dan pengembangan aplikasi AI. (Sumber: matei_zaharia)

🌟 KOMUNITAS

Dampak AI terhadap Pekerjaan dan Masyarakat : Komunitas secara luas membahas dampak mendalam otomatisasi AI terhadap pasar kerja, mengkhawatirkan potensi PHK massal, penciptaan kelas sosial baru, dan memicu permintaan akan Universal Basic Income (UBI). Orang-orang umumnya mempertanyakan apakah pekerjaan terkait AI yang baru diciptakan juga akan diotomatisasi, dan apakah tidak semua orang dapat menguasai keterampilan AI untuk beradaptasi dengan masa depan. Diskusi juga mencakup tantangan manajemen biaya AI Agent dan realisasi ROI, serta potensi dampak kedatangan AGI terhadap struktur sosial dan geopolitik. (Sumber: Reddit r/ArtificialInteligence、Ronald_vanLoon、Ronald_vanLoon)

Etika AI dan Perebutan Kontrol : Komunitas ramai membahas siapa yang seharusnya mengendalikan masa depan AI, apakah masyarakat umum atau oligarki teknologi. Ada seruan agar pengembangan AI berpusat pada manusia, menekankan transparansi dan kontrol pengguna atas data pribadi serta riwayat AI. Pada saat yang sama, bapak baptis AI, Yoshua Bengio, memperingatkan bahwa mesin super-cerdas dapat menyebabkan kepunahan manusia dalam sepuluh tahun. Perusahaan seperti Meta berencana menggunakan data obrolan AI untuk iklan bertarget, yang semakin memperparah kekhawatiran pengguna tentang privasi dan penyalahgunaan AI, memicu pemikiran mendalam tentang etika dan regulasi AI. (Sumber: Reddit r/artificial、Reddit r/artificial、Reddit r/ArtificialInteligence)

Perilaku Abnormal Model Keamanan GPT-5 : Pengguna komunitas Reddit melaporkan bahwa model “CHAT-SAFETY” GPT-5 menunjukkan perilaku aneh, menuduh, dan bahkan berhalusinasi saat memproses permintaan non-berbahaya, misalnya menafsirkan masalah pengenalan sidik jari sebagai perilaku pelacakan dan mengarang hukum. Respons yang terlalu sensitif dan tidak akurat ini menimbulkan pertanyaan serius dari pengguna tentang keandalan model, potensi bahaya, dan strategi keamanan OpenAI. (Sumber: Reddit r/ChatGPT)

Debat “Bitter Lesson” dan Jalur Pengembangan LLM : Andrej Karpathy dan Richard Sutton, bapak Reinforcement Learning, berdebat apakah LLM sesuai dengan “Bitter Lesson”. Sutton berpendapat bahwa LLM bergantung pada data manusia yang terbatas untuk pre-training, dan tidak benar-benar mengikuti prinsip belajar dari pengalaman dalam “Bitter Lesson”. Karpathy, di sisi lain, menganggap pre-training sebagai “evolusi yang buruk” untuk memecahkan masalah cold start, dan menunjukkan perbedaan fundamental dalam mekanisme pembelajaran antara LLM dan kecerdasan hewan, menekankan bahwa AI saat ini lebih seperti “memanggil hantu” daripada “membangun hewan”. (Sumber: karpathy、SchmidhuberAI)

Diskusi Nilai Pengaturan LLM Lokal : Pengguna komunitas membahas nilai investasi puluhan ribu dolar untuk membangun pengaturan LLM lokal. Para pendukung menekankan bahwa privasi, keamanan data, dan pengetahuan mendalam yang diperoleh melalui operasi praktis adalah keuntungan utamanya, dan membandingkannya dengan penggemar radio amatir. Para penentang berpendapat bahwa dengan peningkatan kinerja API cloud yang murah (seperti Sonnet 4.5 dan Gemini Pro 2.5), pengaturan lokal yang mahal sulit untuk dibenarkan. (Sumber: Reddit r/LocalLLaMA)

LLM sebagai Penilai: Metode Evaluasi Agent Baru : Peneliti dan pengembang sedang mengeksplorasi penggunaan LLM sebagai “penilai” untuk mengevaluasi kualitas respons AI Agent, termasuk akurasi dan grounding. Praktik menunjukkan bahwa metode ini bisa sangat efektif secara mengejutkan ketika prompt penilai dirancang dengan cermat (seperti kriteria tunggal, penilaian berjangkar, format output yang ketat, dan peringatan bias). Tren ini menunjukkan potensi besar LLM-as-a-Judge dalam bidang evaluasi Agent. (Sumber: Reddit r/MachineLearning)

Interaksi AI dengan Manusia: Dari Perangkat hingga Karakter Virtual : AI sedang membentuk ulang interaksi manusia dalam berbagai dimensi. Startup terkait MIT meluncurkan perangkat wearable “hampir telepati” yang memungkinkan komunikasi tanpa suara. Pada saat yang sama, AI Agent suara real-time sebagai NPC (Non-Player Character) telah diterapkan dalam game online 3D, menandakan potensi AI untuk menyediakan pengalaman interaksi yang lebih alami dan imersif dalam game dan dunia virtual. Perkembangan ini memicu diskusi tentang peran AI dalam kehidupan sehari-hari dan hiburan. (Sumber: Reddit r/ArtificialInteligence、Reddit r/artificial)

Pilihan antara Model Open-Source dan Closed-Source : Komunitas membahas hambatan terbesar yang dihadapi insinyur perangkat lunak saat beralih dari model closed-source ke open-source. Para ahli menunjukkan bahwa fine-tuning model open-source, daripada bergantung pada model closed-source kotak hitam, sangat penting untuk pembelajaran mendalam, mencapai diferensiasi produk, dan menciptakan produk yang lebih baik bagi pengguna. Meskipun kecepatan pengembangan model open-source mungkin lebih lambat, dalam jangka panjang, mereka memiliki potensi besar dalam penciptaan nilai dan otonomi teknologi. (Sumber: ClementDelangue、huggingface)

Infrastruktur AI dan Tantangan Daya Komputasi : Proyek “Stargate” OpenAI mengungkapkan permintaan besar AI akan daya komputasi, energi, dan lahan, diperkirakan mengonsumsi hingga 900.000 wafer DRAM setiap bulan. Kelangkaan GPU, harga yang mahal, dan keterbatasan pasokan listrik memaksa perusahaan AI untuk melakukan “diplomasi daya komputasi”, terikat erat dengan penyedia layanan cloud (seperti Microsoft dan Amazon). Model investasi aset berat dan kerja sama strategis ini, meskipun mendorong pengembangan AI, juga membawa risiko variabel eksternal seperti rantai pasokan, kebijakan energi, dan regulasi. (Sumber: karminski3、AI巨头的奶妈局、DeepLearning.AI Blog)

💡 LAIN-LAIN

Hak Cipta Musik AI dan Mekanisme Kompensasi : Organisasi hak cipta Swedia STIM bekerja sama dengan perusahaan Sureel, meluncurkan perjanjian lisensi musik AI yang bertujuan untuk menyelesaikan masalah penggunaan hak cipta karya musik dalam pelatihan model AI. Perjanjian ini memungkinkan pengembang AI untuk menggunakan musik secara legal, dan melalui teknologi atribusi Sureel, menghitung dampak karya terhadap output model, sehingga memberikan kompensasi kepada komposer dan artis rekaman. Langkah ini bertujuan untuk memberikan perlindungan hukum bagi kreasi musik AI, mendorong produksi konten orisinal, dan menciptakan sumber pendapatan baru bagi pemegang hak cipta. (Sumber: DeepLearning.AI Blog)

Keamanan LLM dan Serangan Adversarial : Trend Micro merilis penelitian yang secara mendalam membahas berbagai cara LLM dapat dieksploitasi oleh penyerang, termasuk melalui prompt yang dirancang dengan cermat, data poisoning, dan kerentanan dalam sistem multi-Agent. Penelitian ini menekankan pentingnya memahami vektor serangan ini untuk mengembangkan aplikasi LLM dan sistem multi-Agent yang lebih aman, serta mengusulkan strategi pertahanan yang sesuai. (Sumber: Reddit r/deeplearning)

Proactive AI: Pertukaran antara Kenyamanan dan Privasi : Komunitas membahas kenyamanan yang dibawa oleh “Proactive Ambient AI” (AI Lingkungan Proaktif) sebagai asisten cerdas dan potensi risiko pelanggaran privasi. AI jenis ini dapat secara proaktif memberikan bantuan, tetapi pengumpulan dan pemrosesan data pribadi yang berkelanjutan menimbulkan kekhawatiran pengguna tentang transparansi, kontrol, dan kepemilikan data. Ada pandangan yang menyerukan pembentukan “protokol transparan” dan “profil dasar pribadi” untuk memastikan pengguna memiliki kontrol atas riwayat interaksi AI mereka. (Sumber: Reddit r/artificial)